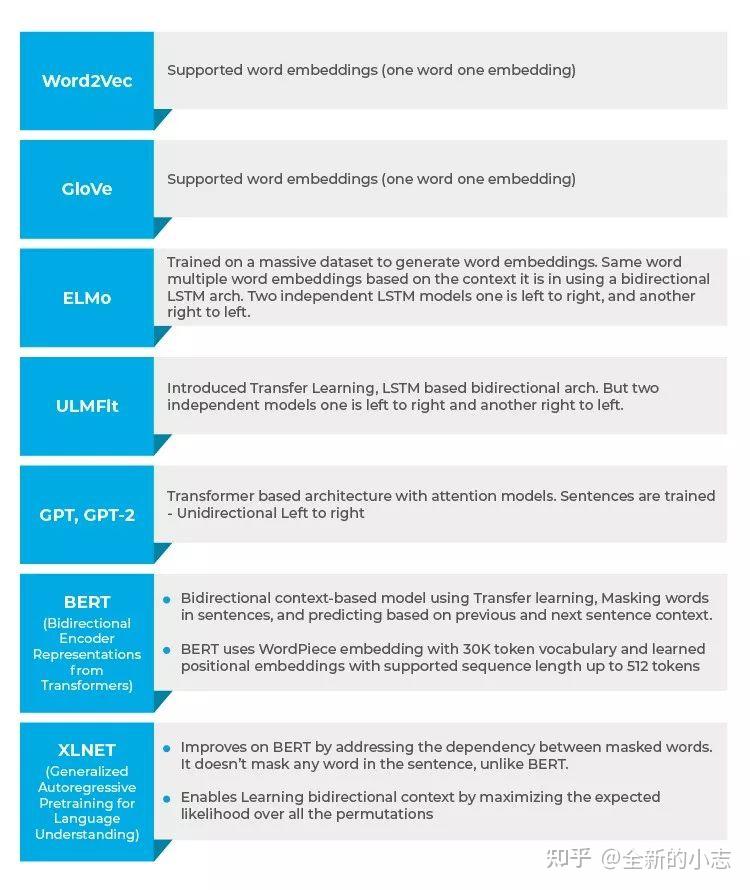

自然语言处理面试题,更至105题,持续更新…. 对象看我在搜集面试题,对我投来不解和疑惑:“你丫刚上岸,刚找到份像样的工作就不消停了?”“面试也会上瘾的吗?” “我属松鼠的哦”没错,松鼠本鼠开始囤货了。 刚上岸,当然不会想着立即跳槽,除了敲代码,日常整理些面试题,顺便自己再过一遍,说不准哪天就用得上了呢。本帖持续不定期更新,欢迎大家评论区交流。 1. 什么是GBDT算法? 在介绍gbdt算法前,有必要先简单介绍一下boosting算法,它每步会产生一个弱预测模型,最后会将所有的弱预测模型累加汇总得到一个总模型,每个弱预测模型的生成都会依赖损失函数梯度递减的方式生成的,boosting被称为提升学习。 gdbt和adaboost都是boosting提升学习中的方法,不同的adaboost可以采用的弱分类器可以有很多。但是gbdt只能采用决策树(CART)作为弱分类器。GBDT采用的损失函数依然是最小二乘的损失函数。 2. 什么是xgboost算法? xgboost本身就是GBDT算法,它是在gbdt算法的基础上进行了一系列的优化,从而使算法拥有了更好的性能。 下面简单总结一下,GBDT算法和xgboost之间的不同点: 除了算法上与传统的GBDT有一些不同外,XGBoost还在工程实现上做了大量的优化。总的来说,两者之间的区别和联系可以总结成以下几个方面。 GBDT是机器学习算法,XGBoost是该算法的工程实现。 在使用CART作为基分类器时,XGBoost显式地加入了正则项来控制模 型的复杂度,有利于防止过拟合,从而提高模型的泛化能力。 GBDT在模型训练时只使用了代价函数的一阶导数信息,XGBoost对代 价函数进行二阶泰勒展开,可以同时使用一阶和二阶导数。 传统的GBDT采用CART作为基分类器,XGBoost支持多种类型的基分类 器,比如线性分类器。 传统的GBDT在每轮迭代时使用全部的数据,XGBoost则采用了与随机 森林相似的策略,支持对数据进行采样。 传统的GBDT没有设计对缺失值进行处理,XGBoost能够自动学习出缺 失值的处理策略。弱分类器采用决策树 3. 什么是随机森林算法? 在了解随机森林算法前,我们先来了解一下bagging算法。bagging算法是集成算法下面的一个分支,与boosting方法合称为集成学习算法下面的两大分支。bagging它综合多个弱分类器形成一个强分类器,弱分类器之间没有联系,它的多样性体现在分类器的选择和样本的选择上。而随机森林算法,它是在bagging的算法基础上做了改动,引入了特征的随机选择。相对于bagging而言,它的效率和准确率都会更高。 boosting集成学习,由多个相关联的决策树联合决策,什么叫相关联,举个例子,有一个样本[数据->标签]是[(2,4,5)-> 4],第一棵决策树用这个样本训练得预测为3.3,那么第二棵决策树训练时的输入,这个样本就变成了[(2,4,5)-> 0.7],也就是说,下一棵决策树输入样本会与前面决策树的训练和预测相关。 与之对比的是random foreast(随机森林)算法,各个决策树是独立的、每个决策树在样本堆里随机选一批样本,随机选一批特征进行独立训练,各个决策树之间没有啥毛线关系。 4. 深度学习优化算法用过哪些?讲讲Sgd和gd,bgd的区别? sgd是随机梯度下降,使用一个样本来求梯度,很省内存,但是不稳定。 gd是梯度下降,使用所有的样本来求梯度。 bgd是小批量梯度的下降,使用一部分样本来求梯度,普遍采用bgd比较多。 5.下列哪些技术能被用于关键词归一化(keyword normalization),即把关键词转化为其基本形式? A. 词形还原(Lemmatization) B. 探测法(Soundex)C. 余弦相似度(Cosine Similarity) D. N-grams 答案:A 词形还原有助于得到一个词的基本形式,例如:playing -> play, eating -> eat等;其他选项的技术都有其他使用目的。 6.下列哪些技术能被用于计算两个词向量之间的距离? A. 词形还原(Lemmatization) B. 欧氏距离(Euclidean Distance) C. 余弦相似度(Cosine Similarity) D. N-grams 答案:B与C两个词向量之间的距离可以用余弦相似度和欧氏距离来计算。余弦相似度在两个词的向量之间建立一个余弦角,两个词向量之间的余弦角接近表示词相似,反之亦然。例如,与“Football”、“NewDelhi”这2个词相比,“Football”、“Cricket” 这两个词之间的余弦角将更接近于1。通常,文档相似度是通过文档中的内容(或单词)在语义上的接近程度来衡量的;当它们接近时,相似度指数接近于1,否则接近于0。两点之间的欧氏距离是连接这两点的最短路径的长度。通常用毕达哥拉斯定理计算三角形。 7.文本语料库的可能特征是什么? A. 文本中词计数 B. 词的向量标注 C. 词性标注(Part of Speech Tag) D. 基本依存语法 E. 以上所有 答案:E 以上所有这些都可以作为文本语料库的特征。 8.你在20K文档的输入数据上为机器学习模型创建了文档-词矩阵(document-term matrix)。以下哪项可用于减少数据维度? (1)关键词归一化(Keyword Normalization) (2)潜在语义索引(Latent Semantic Indexing) (3)隐狄利克雷分布(Latent Dirichlet Allocation) A. 只有(1) B. (2)、(3) C. (1)、(3) D. (1)、(2)、(3) 答案:D 9.哪些文本分析技术可被用于名词短语检测、动词短语检测、主语检测和宾语检测? A. 词性标注(Part of Speech Tagging) B. Skip Gram 和N-Gram 提取 C. 连续性词袋(Bag of Words) D. 依存句法分析(Dependency Parsing)和成分句法分析(Constituency Parsing) 答案:D 10.用余弦相似度表示的词之间的差异将显著高于0.5 A. 正确 B. 错误 答案:A 11.下列哪项是关键词归一化技术? A. 词干提取(Stemming) B. 词性标注(Part of Speech) C. 命名实体识别(Named Entity Recognition) D. 词形还原(Lemmatization) 答案:A与 D 词性标注(POS)与命名实体识别(NER)不是关键词归一化技术。 12.下面哪个是NLP用例? 从图像中检测物体面部识别语音生物识别文本摘要 答案:D A和B是计算机视觉应用案例,C是语音应用案例。 13.在包含N个文档的语料库中,随机选择的一个文档总共包含T个词条,词条“hello”出现 K 次。如果词条“hello”出现在全部文档的数量接近三分之一,则TF(词频)和 IDF(逆文档频率)的乘积的正确值是多少? A. KT * Log(3)B. T * Log(3) / KC. K * Log(3) / TD. Log(3) / KT答案:C 14. 下列算法中减少了常用词的权重,增加了文档集合中不常用词的权重的是? A. 词频(TF) B. 逆文档频率(IDF) C. Word2Vec D. 隐狄利克雷分布(Latent Dirichlet Allocation) 答案:B 15.从句子中删除“and”、“is”、“a”、“an”、“the” 这样的词的过程被称为? A. 词干提取(Stemming)b. 词形还原(Lemmatization)C. 停用词(Stop Words) D. 以上所有 答案:C 16.将句子或段落转换为tokens的过程称为词干提取(Stemming) A. 正确 B. 错误 答案:B 这是分词(tokenization),而不是词干提取。 17.在给到任何神经网络之前,Tokens都会被转换成数字 A. 正确 B. 错误 答案:A 在自然语言处理中,所有的词在输入到神经网络之前都被转换成数字。 18.找出其中的异类 A. nltk B. scikit learn C. SpaCy D. BERT 答案:D除了BERT是一个词嵌入方法以外,其它都是NLP库。 19.TF-IDF帮你建立 A. 文档中出现频率最高的词 B. 文档中最重要的词 答案:B TF-IDF有助于确定特定词在文档语料库中的重要性。TF-IDF考虑了该词在文档中出现的次数,并被出现在语料库中的文档数所抵消。 20.从给定的句子、段落中识别人名、组织名的过程称为? A. 词干提取(Stemming)B. 词形还原(Lemmatization)C. 停用词消除(Stop Word Removal)D. 命名实体识别(Named Entity Recognition)答案:D 21.下列哪一项不是预处理技术? A. 词干提取和词形还原(Stemming and Lemmatization) B. 转换成小写(Converting to Lowercase) C. 删除标点符号(Remove Punctuation) D. 删除停用词(Removal of Stop Words) E. 情绪分析(Sentiment Analysis) 答案:E 情绪分析不是一种预处理技术。它是在预处理之后完成的,是一个NLP用例。所有其他列出的都用作语句预处理的一部分。 22.在文本挖掘中,可以使用以下哪项命令完成将文本转换为tokens,然后将其转换为整数或浮点向量的操作? A. CountVectorizer B. TF-IDF C. 词袋模型(Bag of Words) D. NERs 答案:A CountVectorizer可帮助完成上述操作,而其他方法则不适用。 23.将词表示成向量被称为神经词嵌入(Neural Word Embeddings)? 正确错误 答案:A 24.下列哪种词嵌入支持上下文建模(Context Modeling)? A. Word2Vec B. GloVe C. BERT D. 以上所有 答案:C只有BERT(Bidirectional Encoder Representations from Transformer)支持上下文建模。 25.下列哪种嵌入方式支持双向上下文(Bidirectional Context)? Word2VecBERTGloVe以上所有 答案:B只有BERT支持双向上下文。Word2Vec和GloVe是词嵌入,它们不提供任何上下文。 26.下列哪种词嵌入可以自定义训练特定主题? A. Word2Vec B. BERT C. GloVeD. 以上所有 答案:B 27.词嵌入捕获多维数据,并表示为向量? 正确错误 答案:A 28.词嵌入向量有助于确定2个tokens之间的距离? 正确错误 答案:A 可以使用余弦相似度来确定通过词嵌入来表示的两个向量之间的距离。 29.语言偏见是由词嵌入训练中使用的历史数据引入的,下面哪项不是偏见的示例? 新德里之于印度,北京之于中国男人之于电脑,女人之于家庭主妇 答案:A 陈述B是一种偏见,因为它把女人变成了家庭主妇,而陈述A不是一种偏见。 30. 以下哪项是解决NLP用例(如语义相似性、阅读理解和常识推理)的更好选择? A. ELMoB. Open AI’s GPTC. ULMFit答案:B Open AI的GPT能够通过使用Transformer模型的注意力机制(Attention Mechanism)来学习数据中的复杂模式,因此更适合于诸如语义相似性、阅读理解和常识推理之类的复杂用例。 31. Transformer架构首先是由下列哪项引入的? A. GloVeB. BERTC. Open AI’s GPTD. ULMFit答案:C ULMFit拥有基于LSTM的语言建模架构;这之后被Open AI的GPT的Transformer架构所取代。 32. 以下哪种架构可以更快地训练,且需要更少的训练数据? A. 基于LSTM的语言建模 b. Transformer架构 答案:B 从GPT开始,Transformer架构就得到了支持,而且训练速度更快,所需的数据量也更少。 33. 相同的词可以通过___________来实现多个词嵌入? GloVeWord2VecELMoNltk 答案:C ELMo(Embeddings from Language Models)词嵌入支持同一个词的多个嵌入,这有助于在不同的上下文中使用同一个词,从而捕获上下文而不仅仅是词的意思,这与GloVe、Word2Vec不同。Nltk不是词嵌入。

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们 举报,一经查实,本站将立刻删除。

文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/35248.html

![Goland2024.1.5激活码([免费] 2023 GoLand激活码,亲测有效,支持配置到永久)缩略图 Goland2024.1.5激活码([免费] 2023 GoLand激活码,亲测有效,支持配置到永久)](https://sigusoft.com/wp-content/uploads/2024/08/L3vj0tO-480x300.jpg)