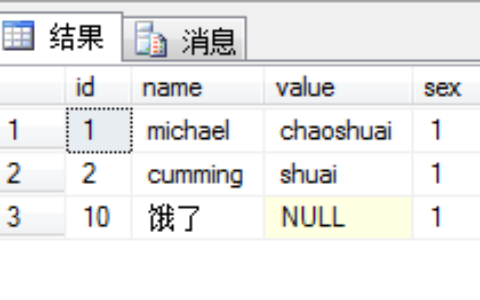

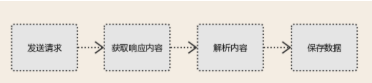

spider基础 一:互联网简介 互联网是由各种计算机设备,通过连接介质相互连接而成的,目的是在不同的计算机之间传输数据,并且在互联网上有大量的数据是免费的。互联网的目的就是微辣方便彼此之间的数据共享,没有互联网,只能用U盘拷贝了。而爬虫就是用于从互联网中有价值的数据,从本质上来看,爬虫是一种应用程序,属于客户端的程序。 二:爬虫原理 爬虫是一种应用程序,用于从互联网中有价值的数据,从本质上来看,属于client客户端程序。我们所谓的上网便是由用户端计算机发送请求给目标计算机,将目标计算机的数据下载到本地的过程。 此时用户网络数据的方式为: 浏览器提交请求 —– 下载网页代码 —– 解析/渲染成页面 而使用爬虫程序需要做的事情便是: 模拟浏览器发送请求 —– 下载网页代码 —– 只提取有用的数据 —– 存放于数据库或者文件中 爬虫的核心便是只提取网页代码中对我们有用的数据,最终保存得到有价值的数据。 三:爬虫的基本流程

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/75412.html