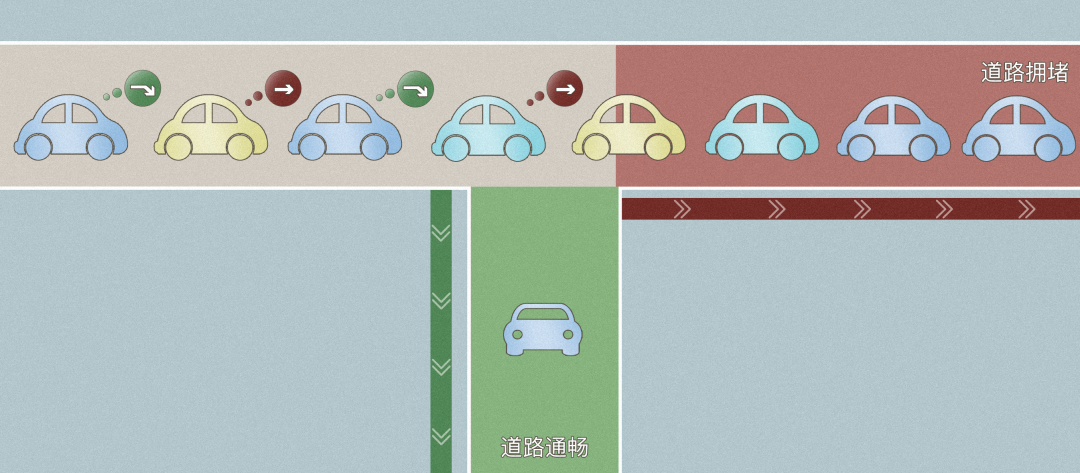

infiniband相与以太网的优势在哪里? 之前也没有接触过这方面的内容,所以不是很懂。最近看了一些infiniband的资料,发现在数据中心等高性能计算场景Infiniband相较以太网来说有很大优势?例如带宽(目前好像都是100G),低延时(infiniband好像是100ns),RDMA技术方面(以太网目前也有类似功能),另外价格方面两者不是很清楚。。照目前来看是不是说Infiniband网络已经没什么优势了?如果仍然有优势为什么普及率会这么低?希望各位大神能够帮我分析一下,谢谢!

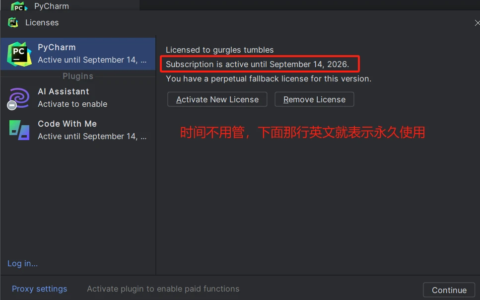

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/61002.html