余弦相似度公式及推导案例 反向传播算法是一种用于训练人工神经网络的常用方法。它基于链式法则,通过计算每个神经的误差梯度,将误差从输出层向前传播,以更新网络权重。以下是反向传播算法的过程和公式推导。 1. 前向传播 对于一个神经网络,从输入层开始,通过一系列的矩阵乘法和非线性函数(如sigmoid函数或ReLU函数)的组合,计算出输出层的预测值。这个过程称为前向传播。 2. 计算误差 将预测值与真实值进行比较,计算误差。常用的误差函数包括均方误差和交叉熵等。 3. 反向传播 接下来,需要计算每个神经的误差梯度,从输出层向前传播误差。假设网络有L层,第l层神经的误差梯度可以表示为: $$delta^{(l)}= frac{partial E}{partial z^{(l)}}$$ 其中,$E$是误差函数,$z^{(l)}$是第$l$层的加权输入。根据链式法则,可以将误差梯度从输出层向前传播: $$delta^{(L)} = abla_a E odot sigma'(z^{(L)})$$ 其中,$ abla_a E$是误差函数对输出层激活值$a^{(L)}$的梯度,$odot$表示素级别的乘法,$sigma’$表示sigmoid函数的导数。 对于隐藏层$l$,误差梯度可以表示为: $$delta^{(l)} = ((W^{(l+1)})^T delta^{(l+1)}) odot sigma'(z^{(l)})$$ 其中,$W^{(l+1)}$是从第$l$层到第$l+1$层的权重矩阵,$(W^{(l+1)})^T$表示其转置。这个公式表明,误差从上一层传递下来,并且乘以激活函数的导数。 4. 更新权重 最后,可以使用误差梯度更新每个权重。假设网络有$L$层,第$l$层到第$l+1$层的权重矩阵为$W^{(l+1)}$,学习率为$eta$,则权重的更新公式为: $$W^{(l+1)} = W^{(l+1)} – eta delta^{(l+1)} (a^{(l)})^T$$ 其中,$(a^{(l)})^T$表示第$l$层的输出值的转置。这个公式表明,权重的更新与误差梯度和输出值有关。 整个反向传播算法就是通过前向传播计算预测值,并通过反向传播计算误差梯度和更新权重的过程。通过多次迭代,最小化误差函数,就能训练出一个神经网络模型。

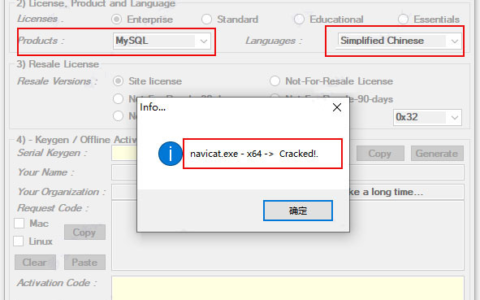

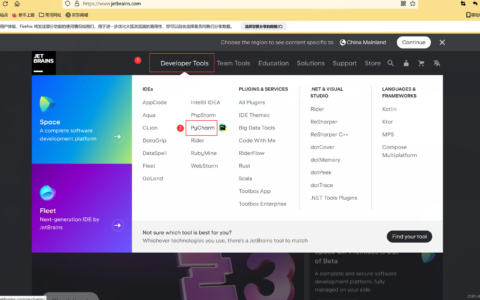

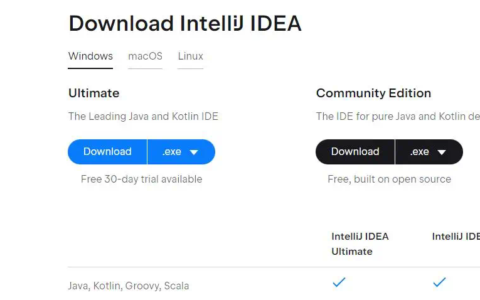

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/42191.html