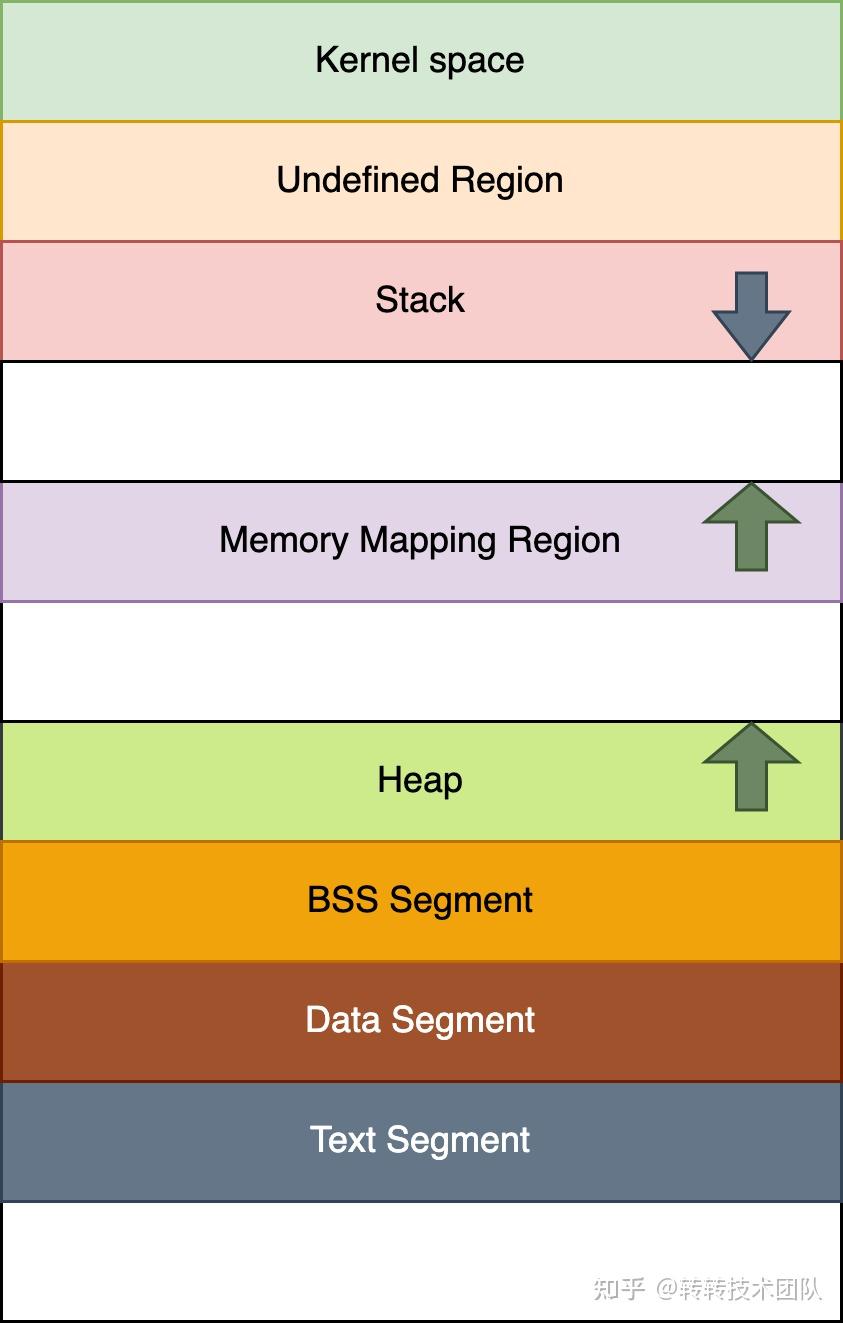

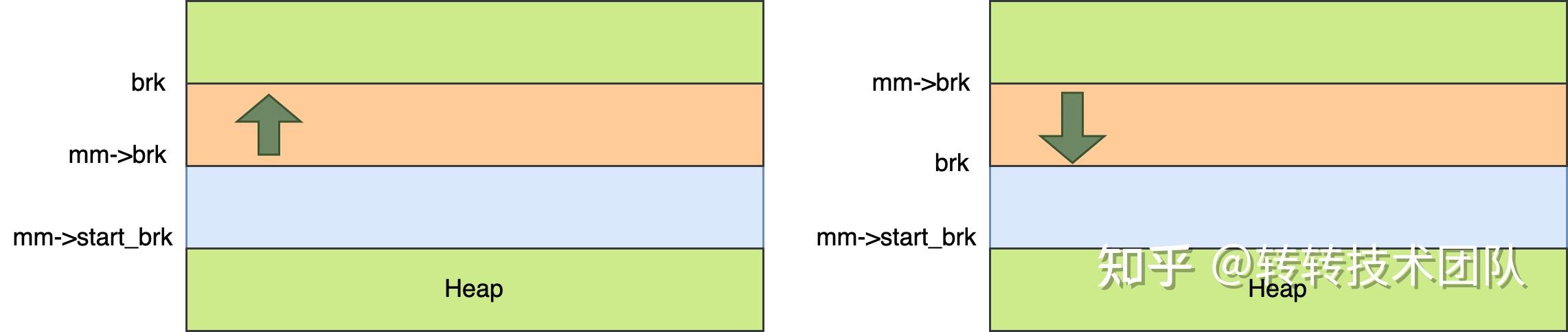

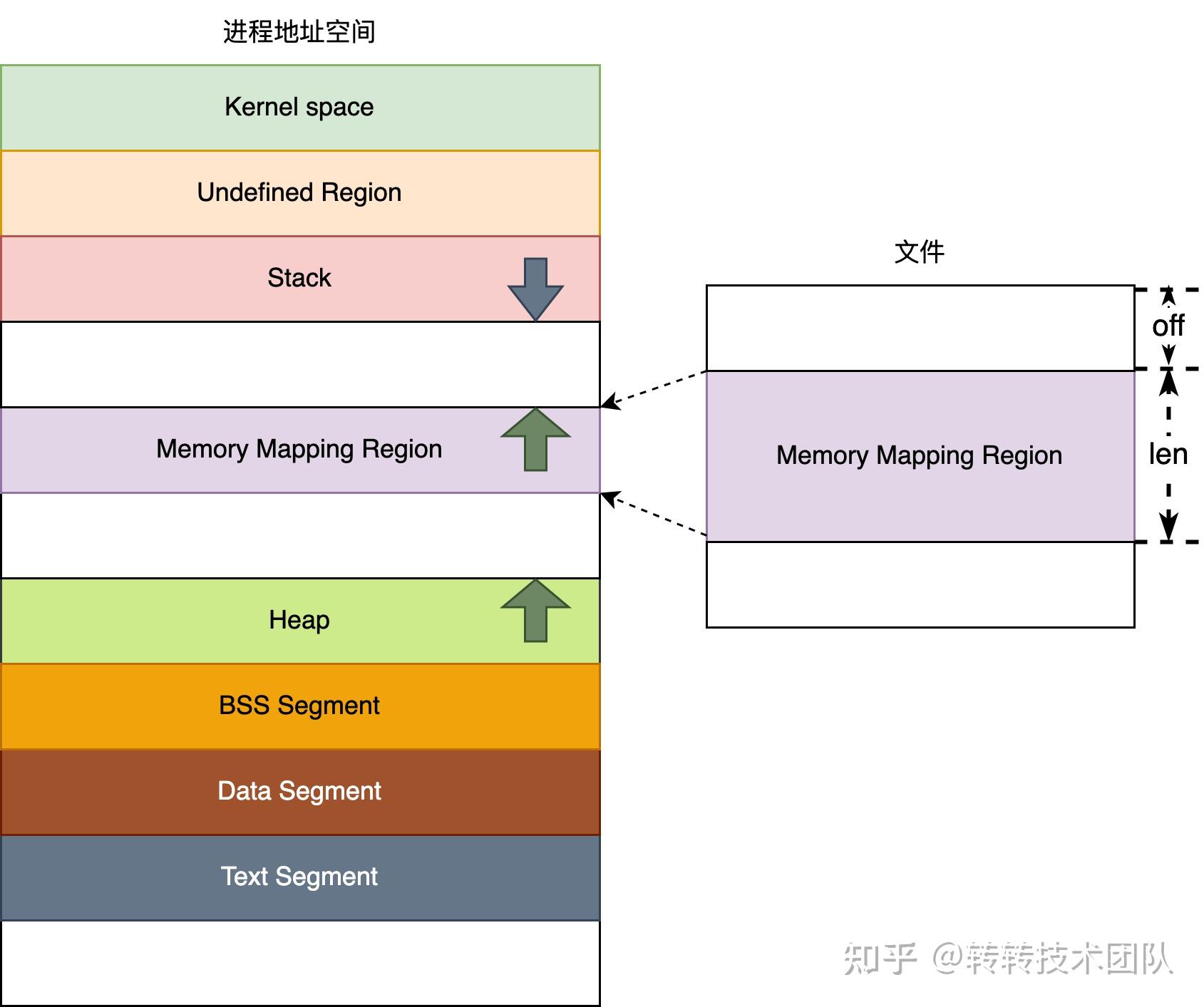

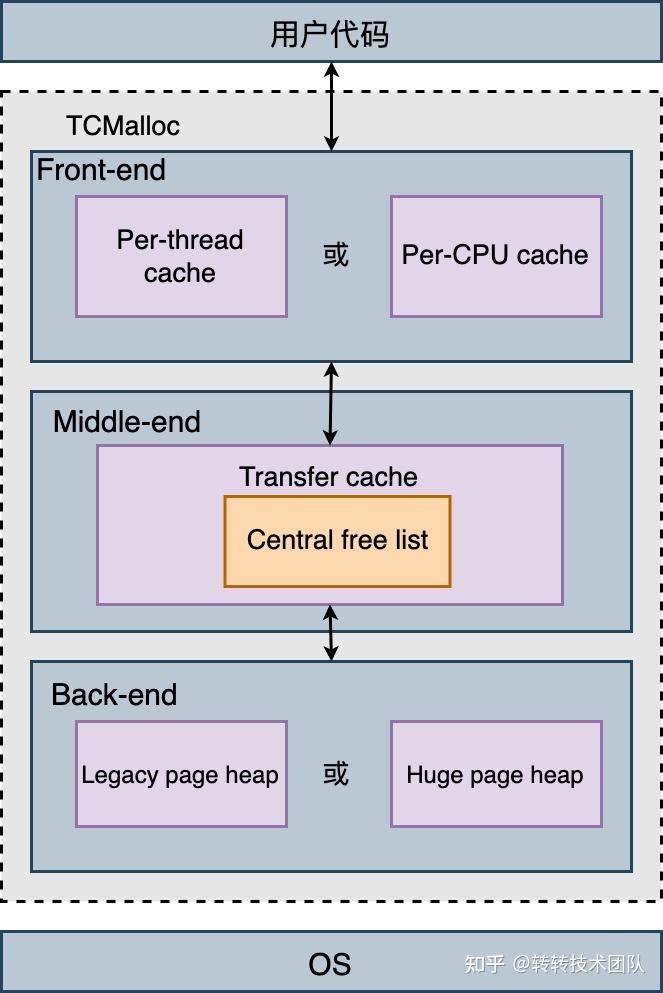

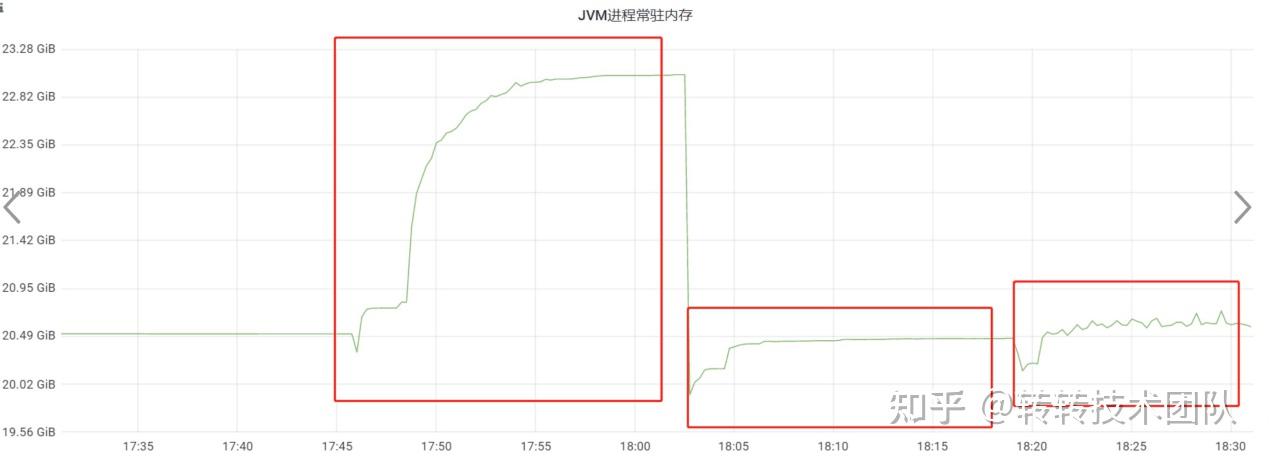

Malloc技术原理解析以及在转转搜索业务上的实践 1 导读 内存管理在三个不同的层面上发挥作用:用户程序层、C运行时库层以及内核层。其中,内存分配器allocator是C运行时库中的一个关键组件,其主要任务是响应用户程序的内存分配请求。分配器负责向操作系统内核请求适当大小的内存块,并将这些内存块分配给用户程序。 为了提高内存分配的效率,分配器通常会预先分配一块稍大于用户请求的内存空间,并使用特定的算法来管理这块内存,以满足用户的内存需求。不同之处在于,用户释放的内存并不会立即返回给操作系统,而是由分配器来管理这些空闲内存空间,以备将来用户的内存分配请求。简而言之,分配器的任务不仅仅是管理已分配的内存块,还包括有效地管理可用的空闲内存块。当需要响应用户的内存分配请求时,分配器会首先在已有的空闲内存中查找合适大小的内存块,只有在空闲内存不足时才会申请新的内存。系统的物理内存是有限的,而对内存的需求是变化的, 程序的动态性越强,内存管理就越重要,选择合适的内存分配库会带来明显的性能提升。 在转转的服务中,许多服务存在较高的堆外内存使用问题,例如转转搜索业务的排序服务,堆外内存的使用超出了预期,这已经导致了许多物理机内存的不足。初步分析表明,这些内存占用较高的转转服务内部使用TensorFlow进行推断,Linux默认使用的glibc的malloc实现在内存池资源回收方面存在缺陷,导致已分配的内存无法有效地返还给操作系统,根据此现状,需要对现有的可选malloc进行原理分析和合理选择,优化服务的内存占用表现,缓解服务器内存不足的现状。常见的内存分配库包括ptmalloc(作为glibc标准库的一部分)、tcmalloc(由Google开发)、jemalloc(由Facebook开发),由于篇幅较长,下文将对ptmalloc和tcmalloc的基本原理和相关参数进行介绍,并只介绍jemalloc的参数部分。 2 内存管理与系统调用 在介绍ptmalloc、tcmalloc等内存分配库之前,让我们先了解一下内存布局:

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/87839.html