余弦相似度的取值范围_向量余弦相似度关于Attention的总结学习NLP的同学,Bert可以认为是必学的一个模型,而Bert中self-attention同样是必不可少的一个知识点。接下来,咱们就对self-attention和其他attention结构

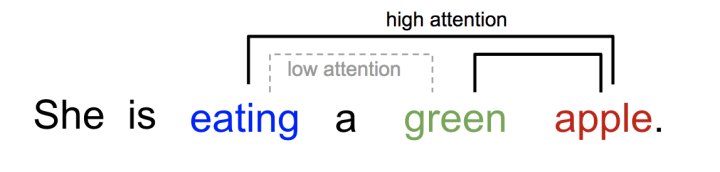

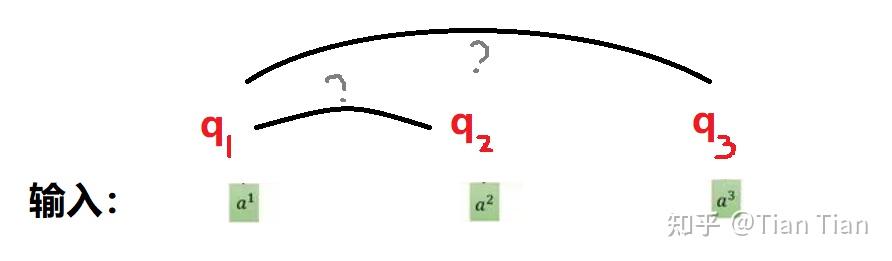

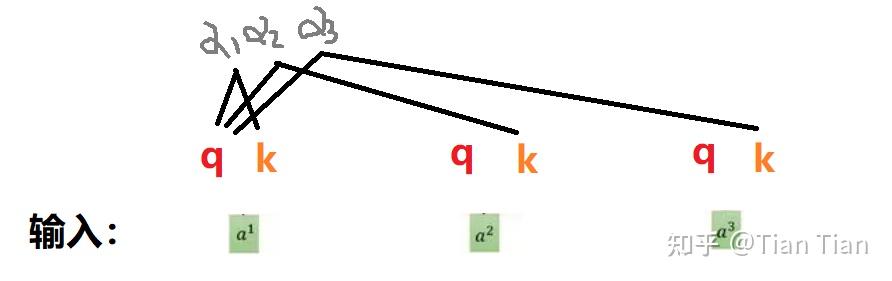

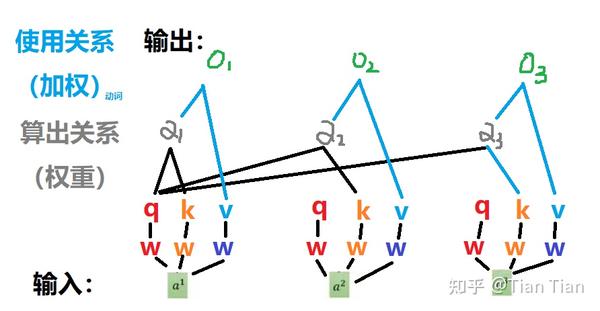

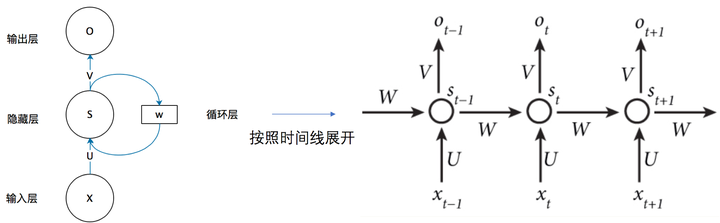

关于Attention的总结 学习NLP的同学,Bert可以认为是必学的一个模型,而Bert中self-attention同样是必不可少的一个知识点。接下来,咱们就对self-attention和其他attention结构进行总结。 1、什么是Attention Attention机制最早是在视觉图像领域提出来的(上世纪90年代),但是真正热门起来是由google mind团队于2014年的论文《Recurrent Models of Visual Attention》,他们在RNN模型上使用了Attention机制来进行图像分类。 Recurrent Models of Visual Attention Attention机制也叫注意力机制,之所以在图像分类中起作用,主要是模拟人类看图片的逻辑,当我们看一张图片的时候,其实并没有看清图片的全部内容,而是将注意力集中在了图片的焦点上。看一下下面这张图:

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们 举报,一经查实,本站将立刻删除。

文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/42440.html