低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

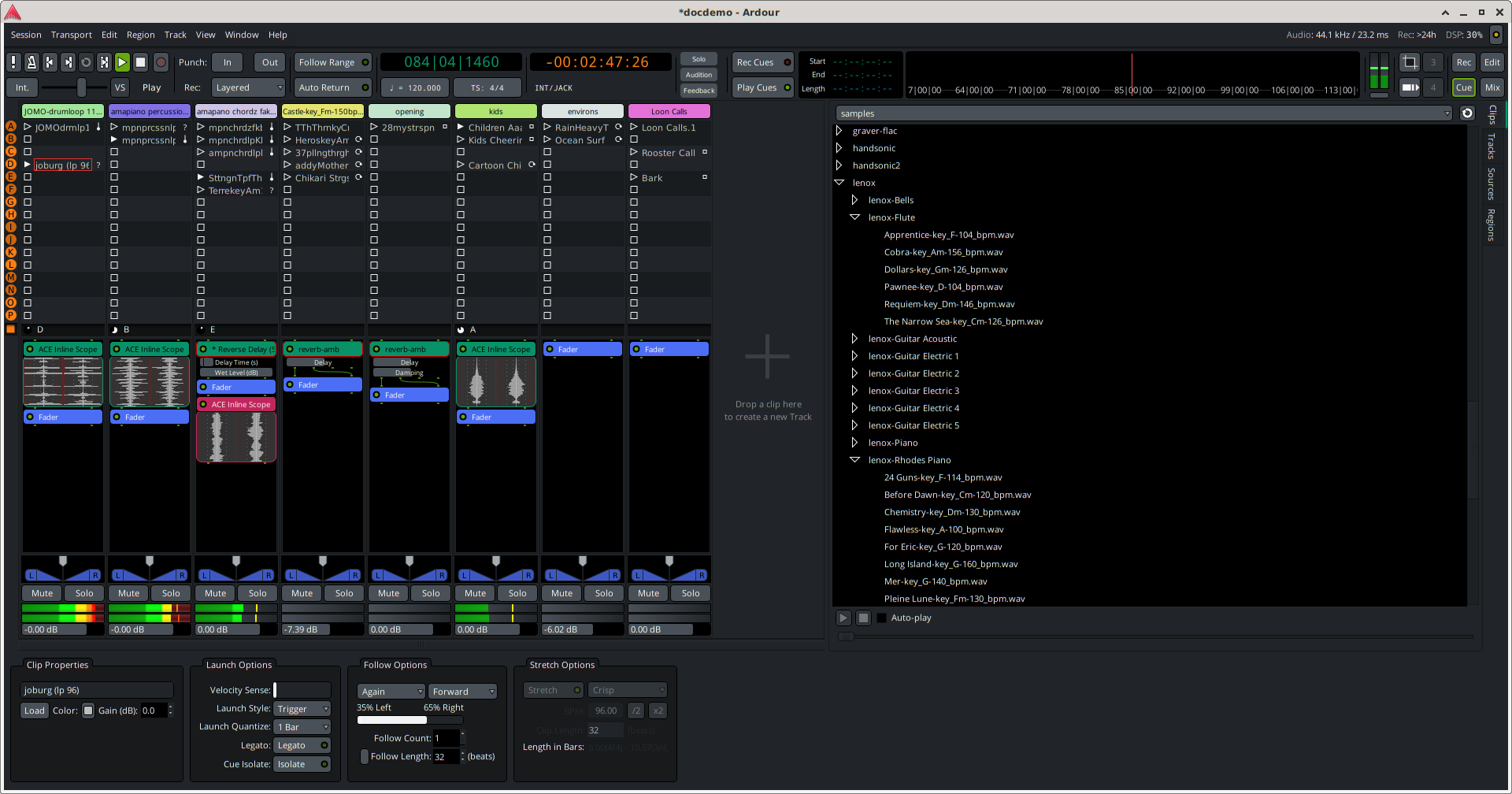

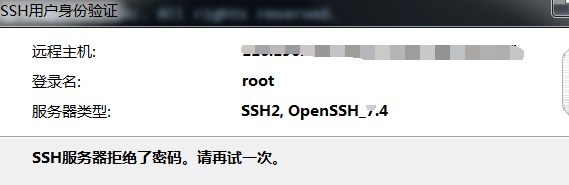

Linux Mint 团队确认了 21.1 版本会在圣诞节前发布,代号“Vera”。这延续了该发行版的传统,即同一系列中的每个版本取一个以相同字母开头的女性名称(例如 Linux Mint 21 是”Vanessa”)。

项目负责人 Clem 介绍了 Linux Mint 21.1 的部分变化:

- 改进驱动管理器

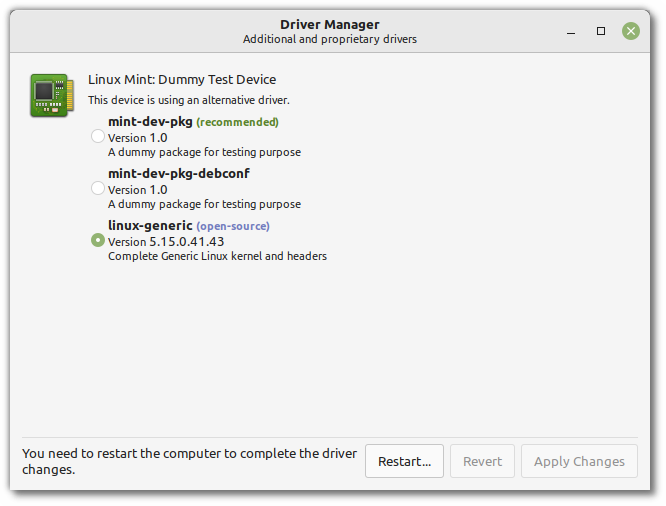

添加”Dummy Test Device”模式,可轻松地对各种不同的场景进行故障排除。

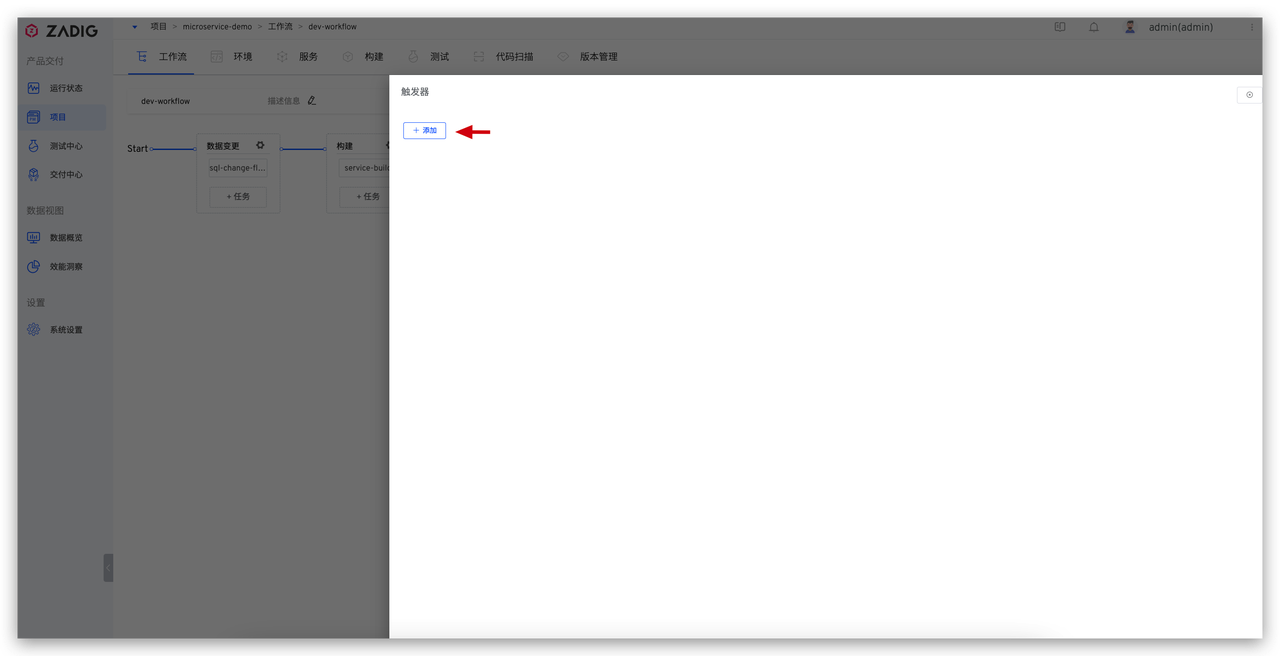

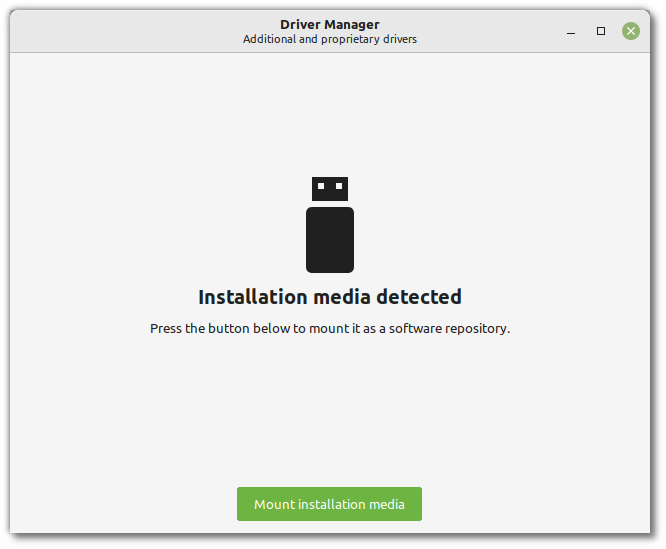

重新设计离线支持界面。如果处于离线状态,驱动程序管理器现在会显示一个专用界面:

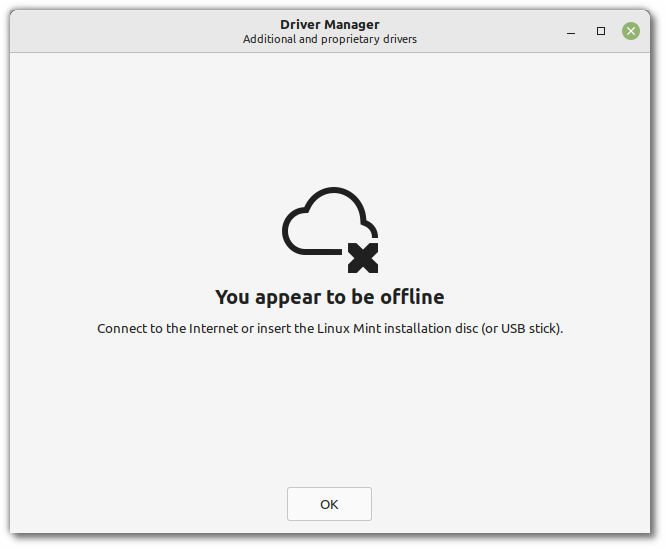

如果它检测到 live USB 设备(或 DVD),则会出现不同的界面:

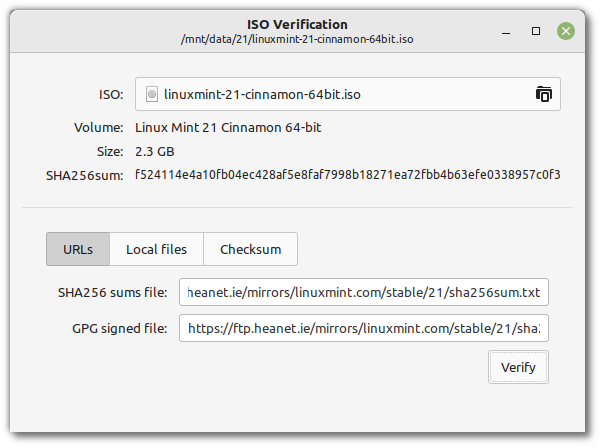

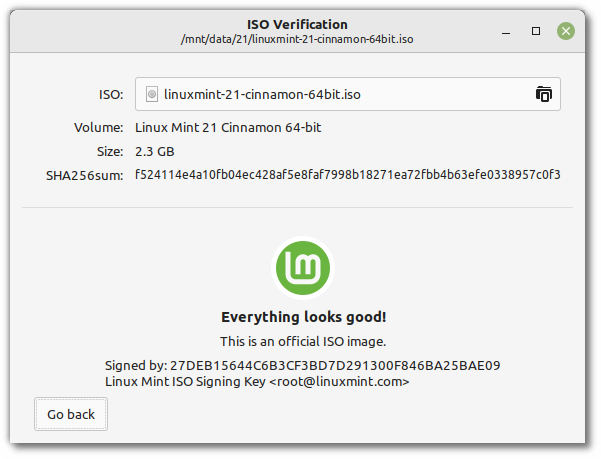

- ISO 验证工具

该工具用于检查和校验文件的真实性和 ISO 的完整性。

- 隐藏部分桌面图标

在未来的版本中,以下桌面图标将默认隐藏:

- Computer

- Home

- Trash

- Network

原因是这些快捷方式在用户界面中重复出现,例如:通过面板、Mint 菜单中的链接,或 Nemo文件管理器。

详情查看公告。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

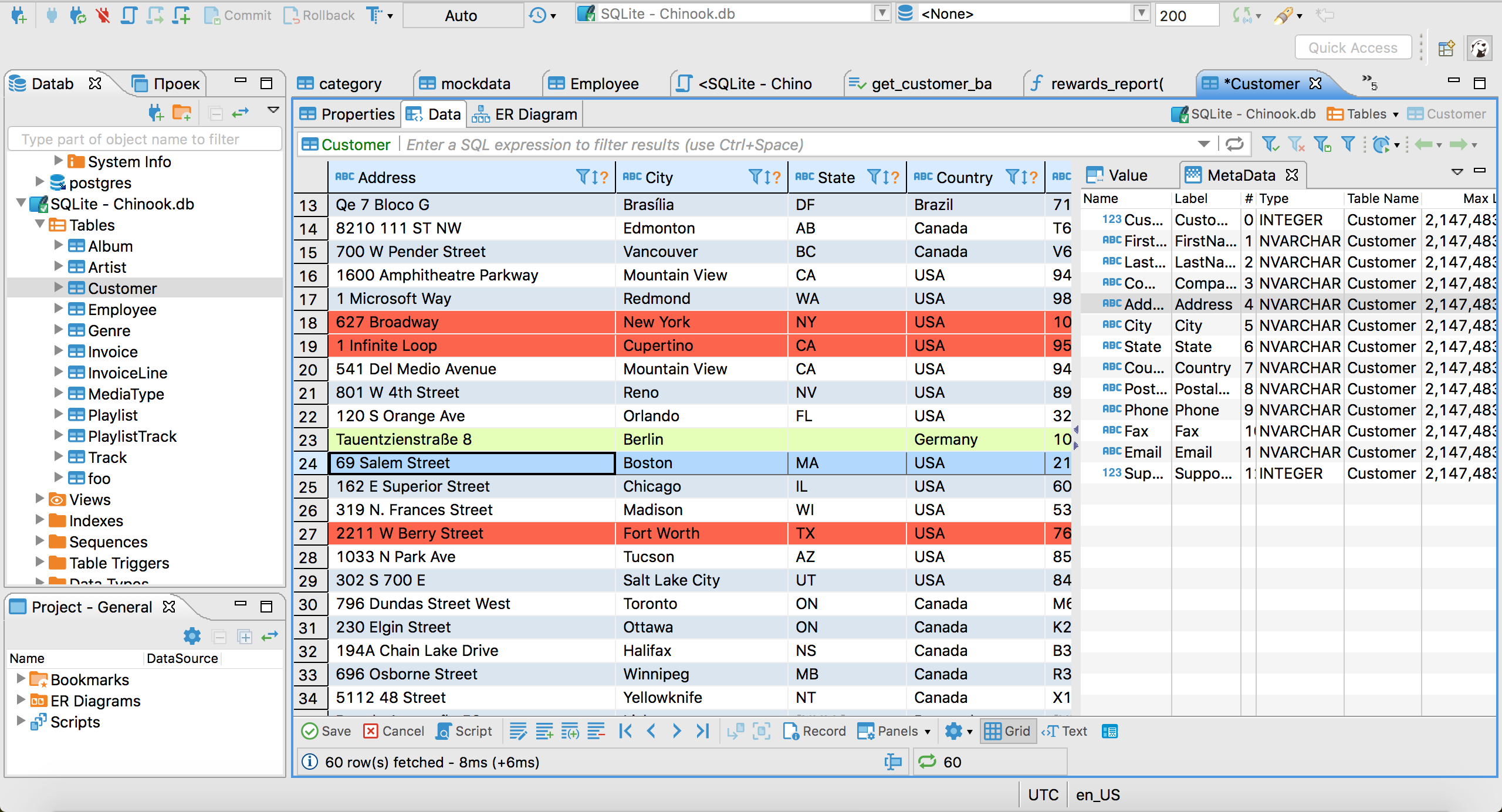

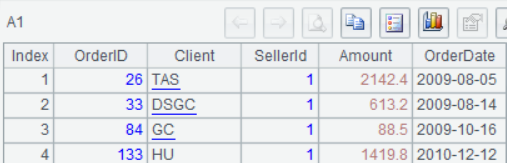

DBeaver 22.2.2 现已发布。DBeaver 是免费的多平台数据库工具,适用于开发人员、数据库管理员、分析师和所有需要使用数据库的人,并且支持所有流行的数据库:MySQL、PostgreSQL、SQLite、Oracle、DB2、SQL Server、Sybase、MS Access、Teradata、Firebird、Apache Hive、Phoenix、Presto 等。

更新内容如下:

- 数据编辑器:

- 添加了“隐藏所有空列”操作

- References panel 现在有一个按钮来打开 target table

- 修复了按多列排序的问题

- 修复了按空间列过滤的问题

- URL transformer 已修复(现在支持原始值编辑)

- LOB 编辑器打开性能显着提升

- SQL 终端现在显示服务器输出日志

- 列注释现在在 record mode 下可见

- 修复了 record mode 的复杂数据类型可视化

- 数据传输:修复了自定义标题格式的 CSV export 中的错误

- SQL 编辑器:

- 自定义查询中的 NULL 列名问题已修复

- 数据库驱动程序:

- 修复了重新下载驱动程序 jar 的问题

- 现在可以禁用 Windows 证书存储使用

- Athena:驱动版本更新到 2.0.30

- Clickhouse:添加了 datetime64 数据类型支持

- DB2:驱动版本更新到 11.5.7

- Exasol:用户列表读取已修复

- Greenplum:准备好的语句使用被禁用

- MySQL:

- 默认数据库客户端已更改为版本 8+

- JSON 列现在可以在过滤器和 keys 中使用

- Oracle:添加了架构完整 DDL

- PostgreSQL:

- 修复了新表中缺少主键的问题

- 已修复分区表的 Table DDL

- Role comments 现在可见/可编辑

- 改进了德语本地化

下载地址 | 发布说明

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

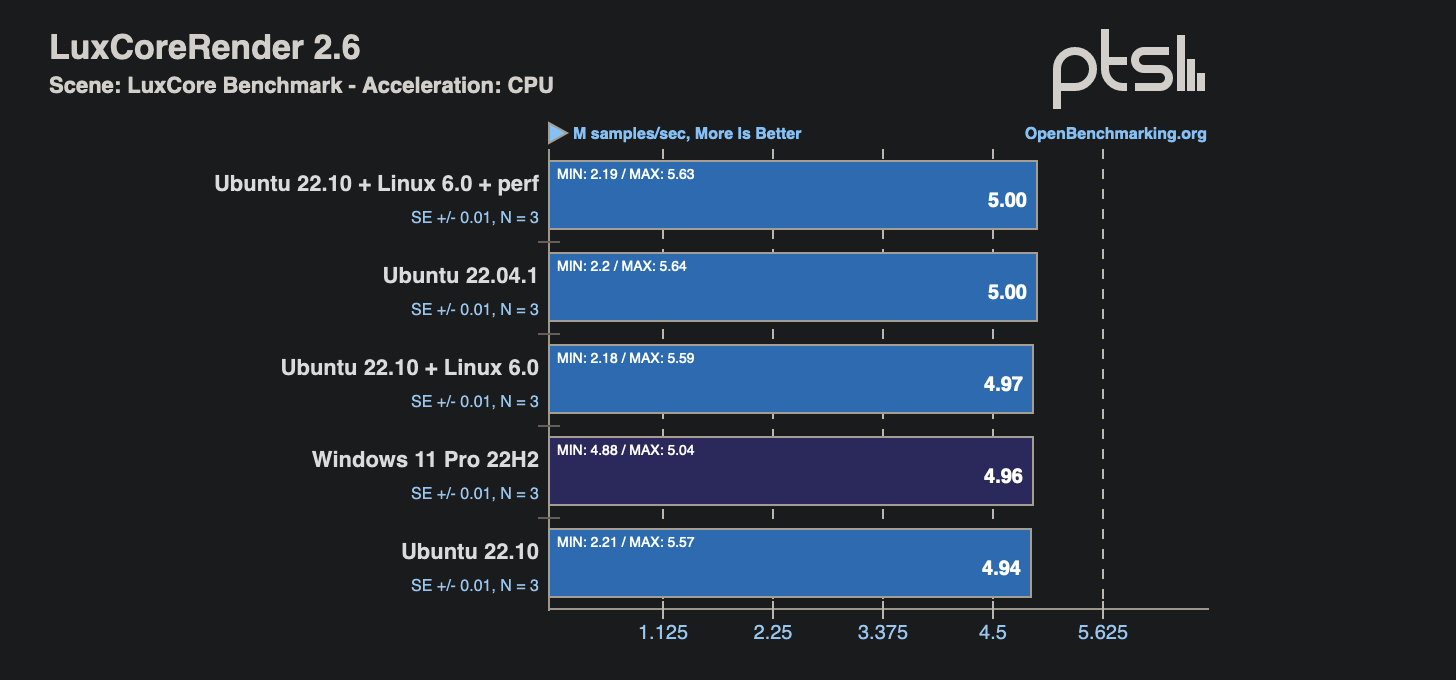

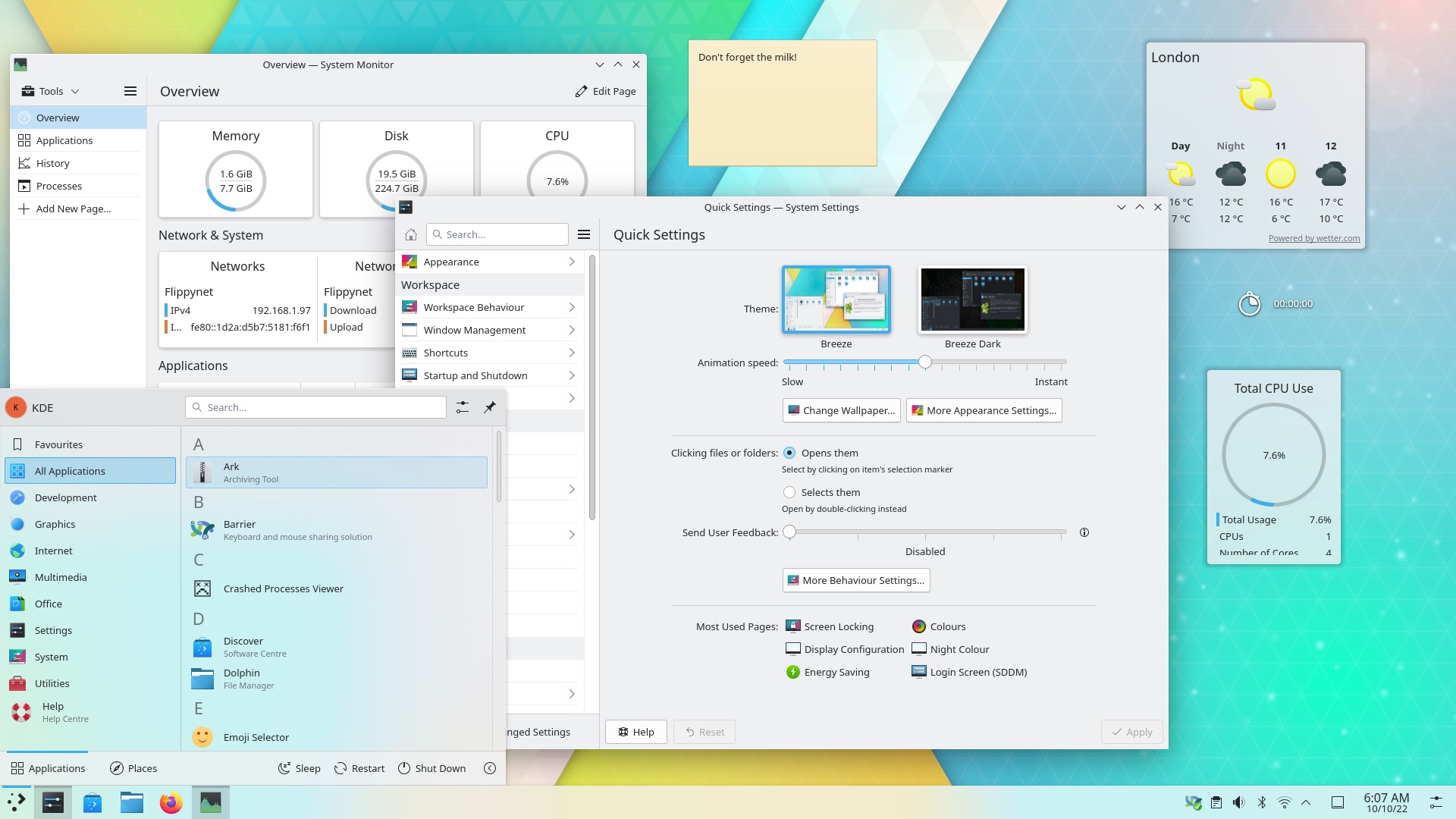

KDE 社区已发布了 Plasma 5.26 桌面环境。

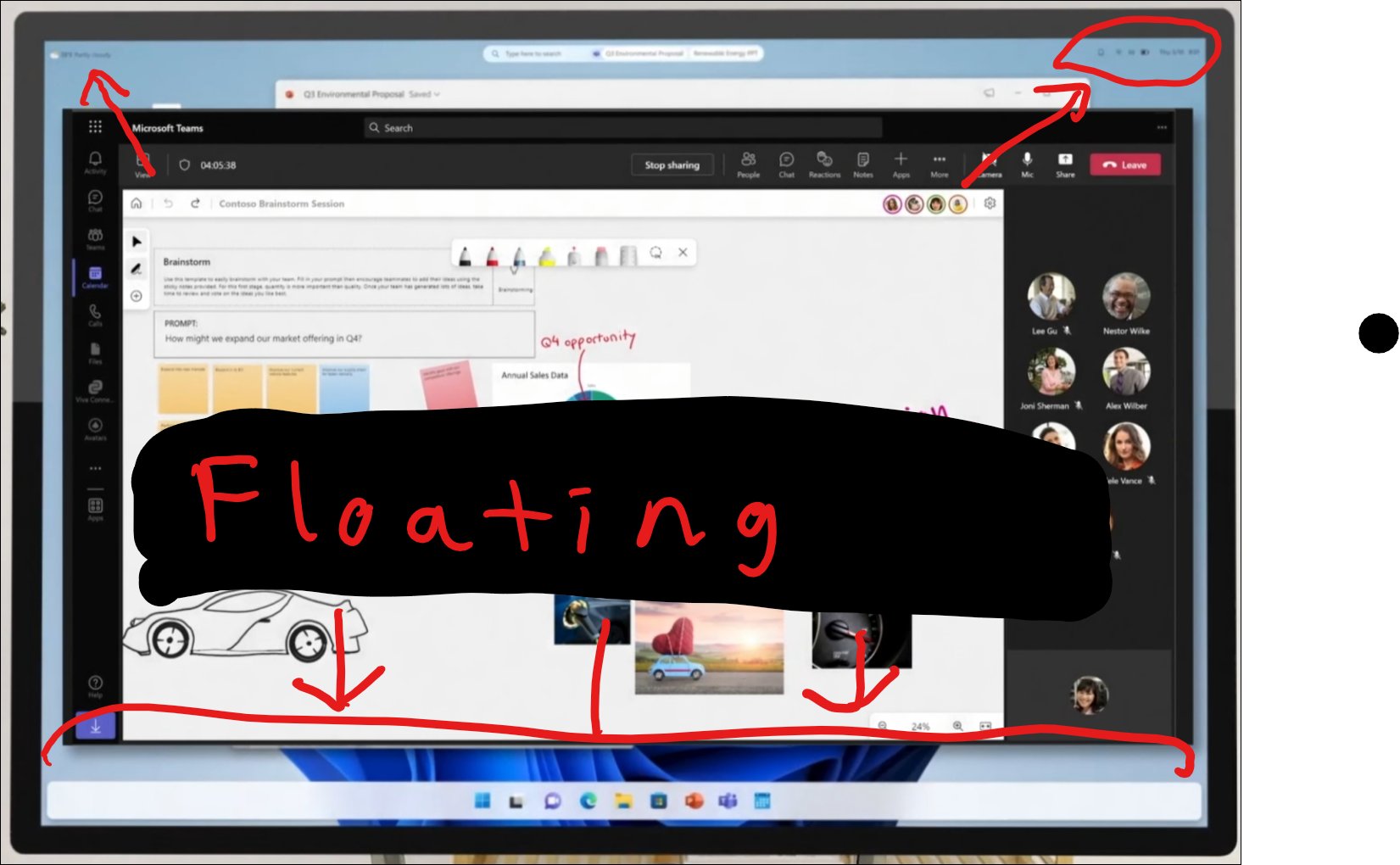

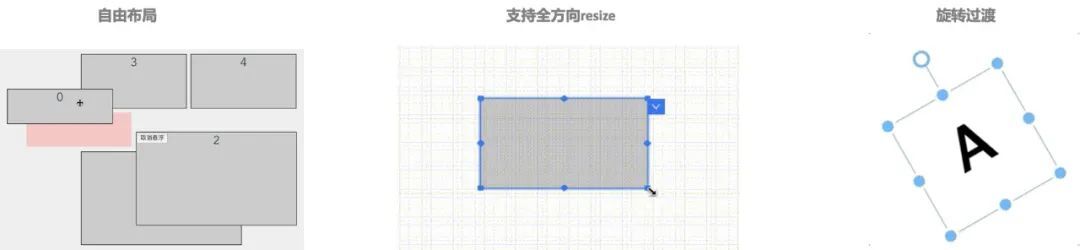

这个版本进一步完善了桌面小部件,面板中的时钟和日历、通知器、KDE Connect 监视器、音量控制… 现在这些都属于小部件,可以在桌面的任何地方添加、移动、删除,并随时调整大小,甚至可以旋转、浮动放在桌面上的小部件。

这个版本还有一个新的计时器小部件,可以将其放到桌面上进行倒计时。除了提醒功能,Timer 还可以在倒计时结束时运行命令或操作。比如设置

Timer 倒计时结束时,就会自动关掉正在摸鱼的 Firefox 浏览器…

此外,Plasma 5.26 最明显的改进之一是引入适用于大屏幕的 Aura 浏览器,这个新的 Aura 浏览器适用于电视和其他大型显示器,可以用兼容的遥控器操控。看起来是这样的:

其他方面,KDE Plasma 的软件工具 Discover 可以设置新更新通知的频率、显示应用的内容评级,且有一个新的“分享”按钮,可以轻松分享 KDE Plasma 的软件。

最后,KDE Plasma 5.26 优化了对 Wayland 支持,Plasma Wayland 会话现在能够处理图形输入板配置、中键单击粘贴首选项,以及在 XWayland 上运行的精美缩放应用程序。

其他内容可以在 KDE 的官方更新公告中查看。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

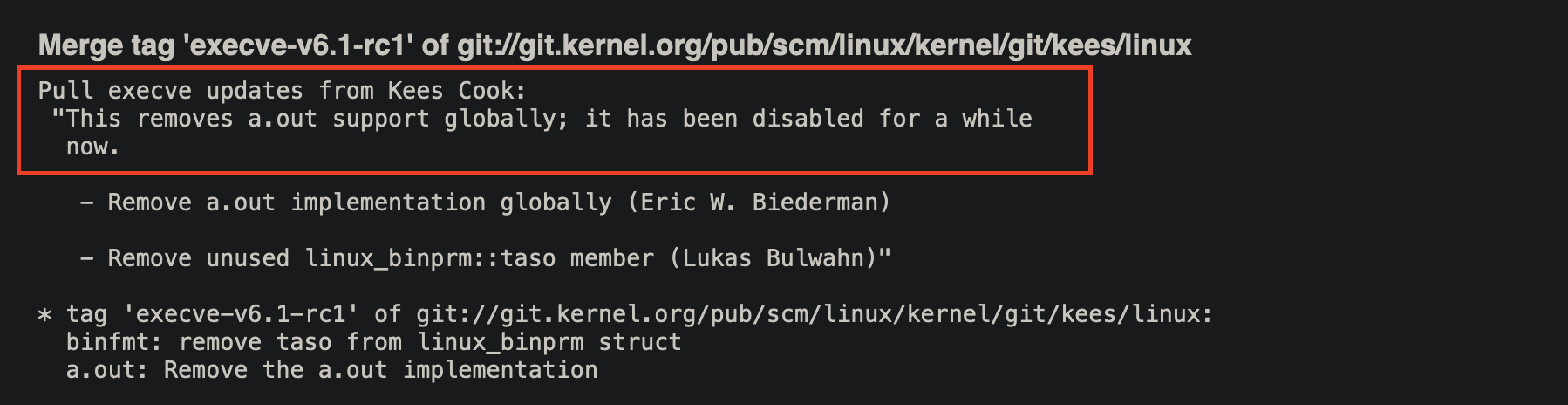

漏洞描述

Scala是Scala开源的一个 Scala 2 编译器和标准库。

Scala 2.13.9之前的2.13.x版本存在安全漏洞,反序列化方法会调用 tail.prependedAll(init) 来重构 lazy 列表,攻击者伪造序列化流可以使 prependedAll 调用 tail 对象的 lazyState 方法,可以包含 lazyState 字段的任何 Function0 实例,这可能会修改任意文件,建立网络连接,或者可能通过使用 Function0 方法的小工具链运行任意代码 。

影响范围

org.scala-lang:scala-library@[2.13.0, 2.13.9)

修复方案

将组件 org.scala-lang:scala-library 升级至 2.13.9 及以上版本

参考链接

https://www.oscs1024.com/hd/MPS-2022-52625

https://nvd.nist.gov/vuln/detail/CVE-2022-36944

PR

Commit

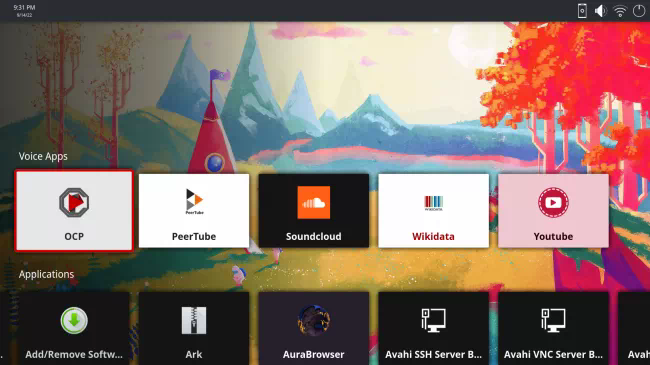

情报订阅

OSCS(开源软件供应链安全社区)通过最快、最全的方式,发布开源项目最新的安全风险动态,包括开源组件安全漏洞、事件等信息。同时提供漏洞、投毒情报的免费订阅服务,社区用户可通过配置飞书、钉钉、企业微信机器人,及时获得一手情报信息推送:

https://www.oscs1024.com/cm/?src=osc

具体订阅方式详见:

https://www.oscs1024.com/docs/vuln-warning/intro/?src=osc

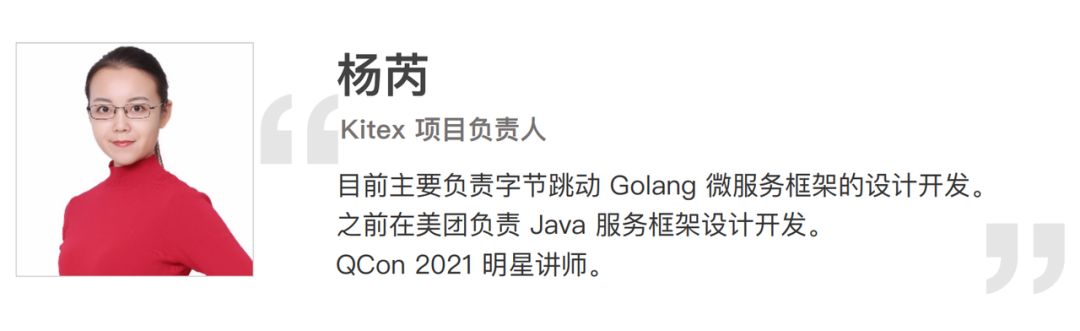

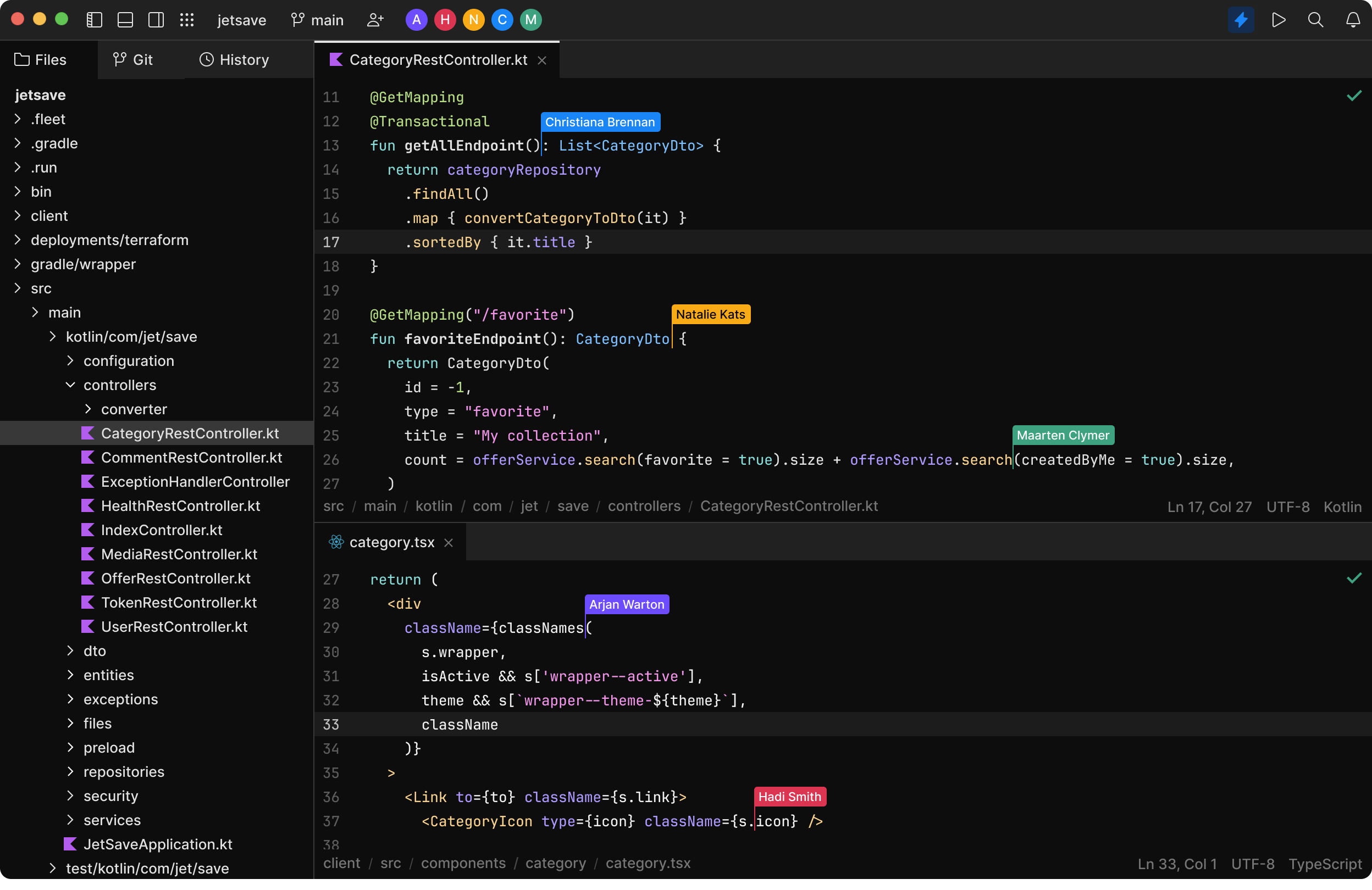

日前,字节跳动技术社区 ByteTech 举办的第七期字节跳动技术沙龙圆满落幕,本期沙龙以《字节高性能开源微服务框架:CloudWeGo》为主题。在沙龙中,字节跳动字节跳动基础架构服务框架资深研发工程师杨芮,跟大家分享了《高性能 RPC 框架 Kitex 内外统一的开源实践》,本文根据分享整理而成。>

本文将从以下四个方面介绍 CloudWeGo 高性能 RPC 框架 Kitex 的实践及开源:

由内至外 – 开源过渡;

开源一年变更回顾;

社区共建完善生态及企业落地;

总结和展望。

由内至外 – 开源过渡

很多同学可能刚刚了解 CloudWeGo,先介绍一下 CloudWeGo 和 Kitex 的关系。

CloudWeGo 和 Kitex

Kitex 是 CloudWeGo 开源的第一个微服务框架,它是一个支持多协议的 Golang RPC 框架,从网络库、序列化库到框架的实现基本完全自研的。特别地,Kitex 对 gRPC 协议的支持使用了 gRPC 官方的源码,但是我们对 gRPC 的实现做了深度且定制的优化,所以 Kitex 支持的 gRPC 协议性能优于 gRPC 官方框架。同时这也是 Kitex 与目前已经开源的、支持 gRPC 协议的其他 Golang 框架的主要差异。如果用户想使用 gRPC 又对性能有很高的要求,那么 Kitex 框架将会是一个很不错的选择。

继 Kitex 开源后,今年 CloudWeGo 又陆续开源了 Golang HTTP 框架 Hertz,Rust RPC 框架 Volo,同时围绕这些微服务框架和微服务的一些通用能力,我们还开源了一些高性能的基础库。关于更多 CloudWeGo 开源的子项目,可以进入 CloudWeGo 官网详细了解。

CloudWeGo 官网:https://www.cloudwego.io/

根据社区同学反馈,在一些开源群里大家会讨论 Kitex 会不会是一个字节跳动的开源 KPI 项目呢?它的稳定性、持续性能够得到保障吗?我可以负责任地讲,Kitex 不是一个 KPI 项目,它是来自字节跳动内部大规模实践的真实项目。在 Kitex 开源后始终保持内外统一,基于内外代码的统一我们保证了 Kitex 的持续迭代。为了进一步消除大家的顾虑,下面具体介绍一下 Kitex 的诞生和开源历程。

Kitex 发展历史

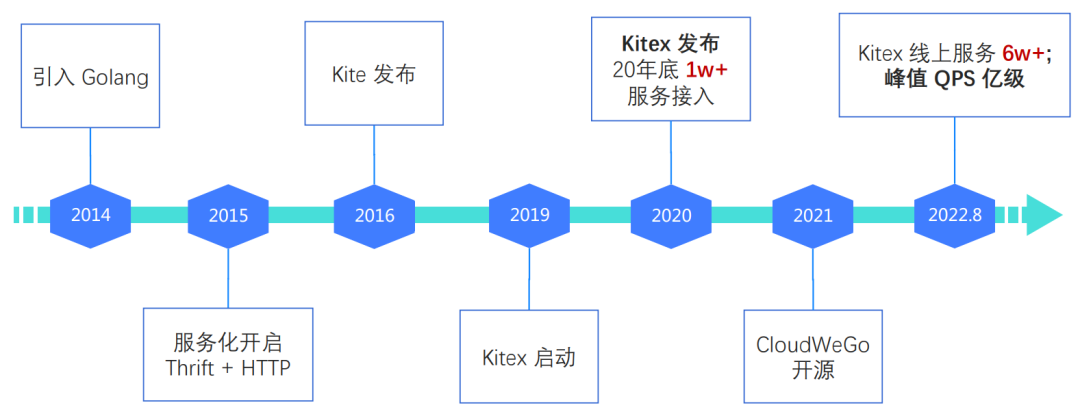

2014 年,字节跳动开始引入 Golang。2015 年,字节跳动内部的服务化开启。在 RPC 调用的场景选择了 Thrift 协议,在内部开始支持 RPC 框架。2016 年,第一个 Golang RPC 框架 Kite 正式发布。通常在一个公司高速发展的初期,基础能力都是为了快速支持需求落地,面对的需求场景也较单一,设计上不会有较多考量,其实这也是合理的,因为探索阶段并不完全清楚还需要支持哪些场景,过多的考虑反而会出现过度设计的问题。

但是,随着业务场景复杂化,需求也会多样化,而且接入服务及调用量逐年增长,Kite 已经不足以支持后续的迭代,在线上服役三年多后,2019 年我们开启了新的项目 Kitex,2020 年初发布了正式版本,在 2020 年底字节内部已经有 1w+ 服务接入 Kitex。

从 2014 年到 2020 年,Golang 已经是字节跳动内部主要的业务开发语言,应该是业界 Golang 应用最多的公司。我们的服务框架支持着数万个 Golang 微服务的可靠通信,经过数量众多的微服务和海量流量的验证,我们已经有了较为成熟的微服务最佳实践,于是考虑将内部的实践开源出去丰富云原生社区的 Golang 产品体系。在 2021年,我们以 CloudWeGo 品牌正式开源了第一个服务框架 Kitex。截至今年 8 月,Kitex 已经为字节跳动内部 6w+ 的服务提供支持,峰值 QPS 达到上亿级别。

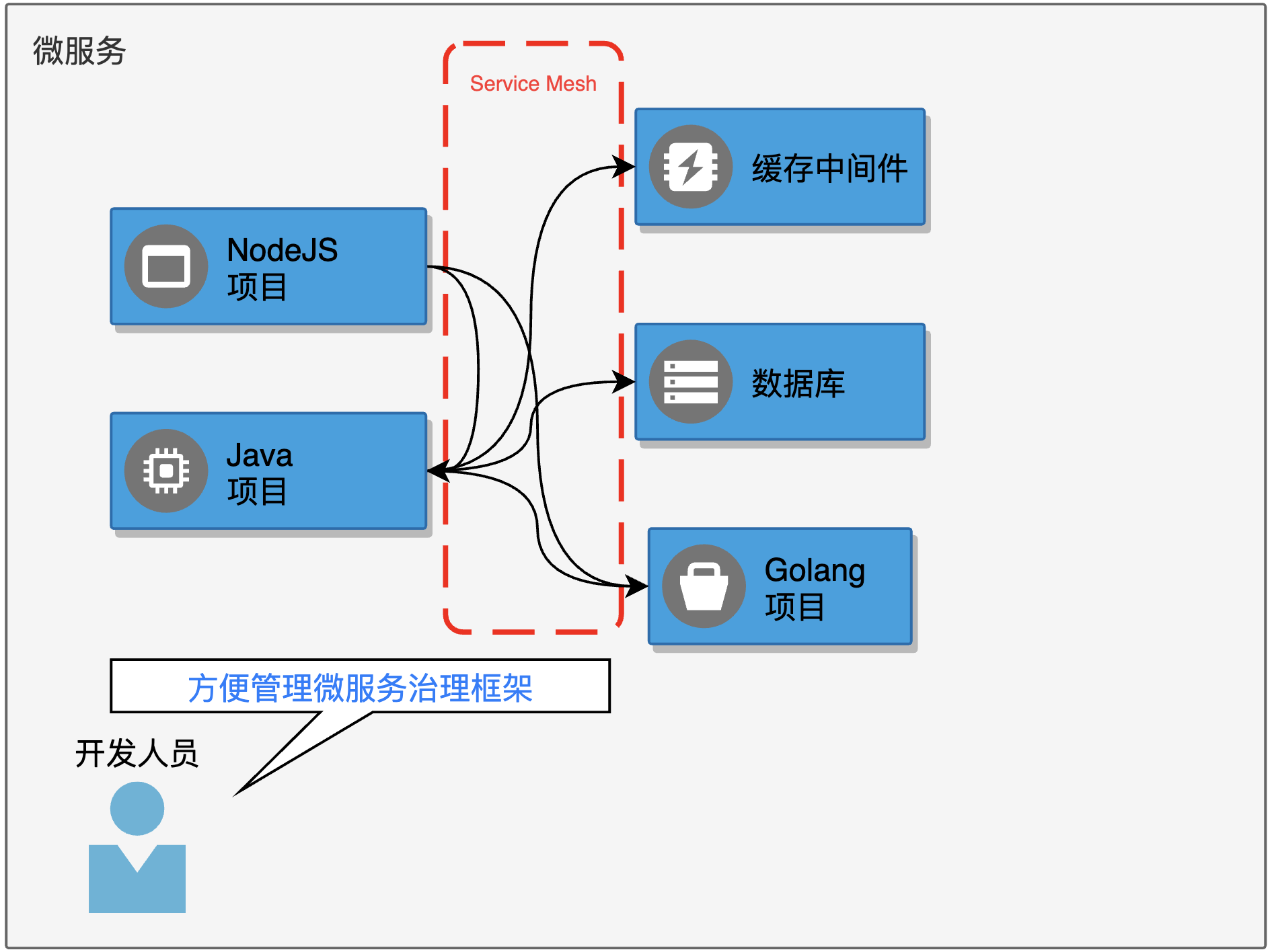

大家或许还有疑问,完整的微服务体系离不开基础的云生态,无论在公有云、私有云,都需要搭建额外的服务以很好地支持微服务的治理,比如治理平台、注册中心、配置中心、监控、链路跟踪、服务网格等,而且还存在一些定制的规范。字节跳动自然也有完善的内部服务支持微服务体系,但这些服务短期还无法开源,那 CloudWeGo 如何内外维护一套代码,统一迭代呢?

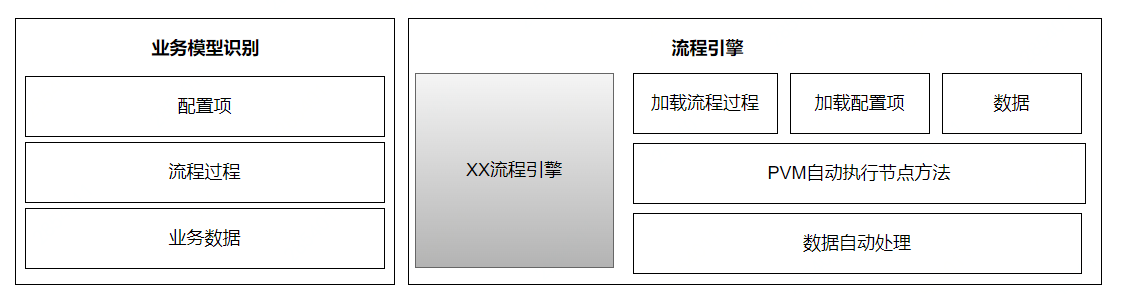

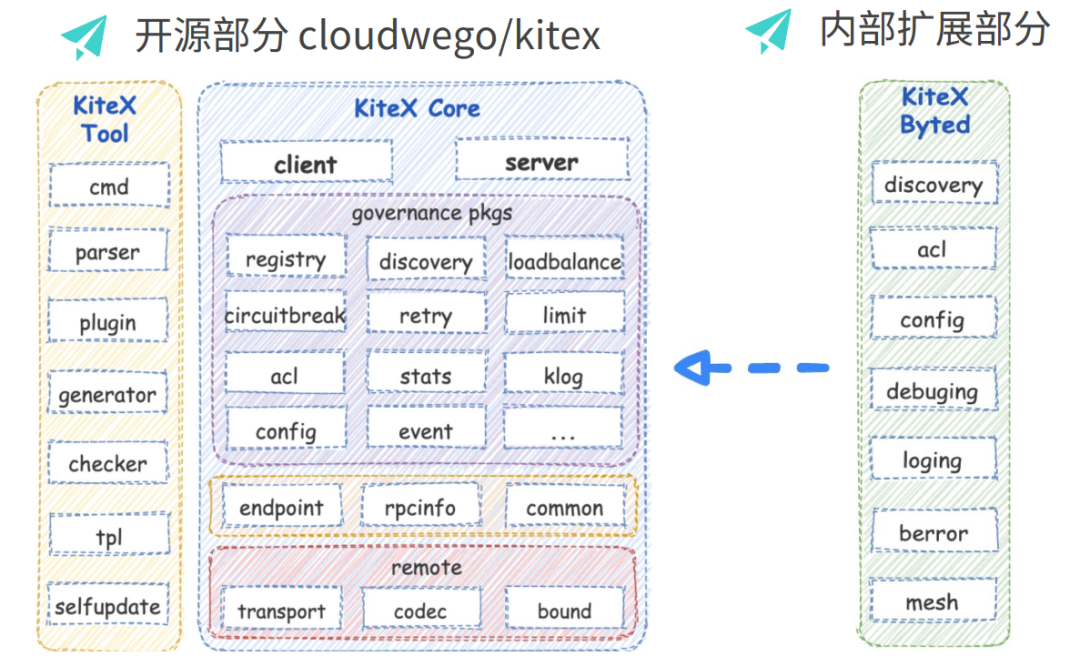

关于这个问题,我们看一下 Kitex 的模块划分。Kitex 的模块分为三个部分:中间是 Kitex 主干部分 Kitex Core,它定义了框架的层次结构、接口核心逻辑的实现以及接口的默认实现;左边的 Kitex Tool 则是与生成代码相关的实现,我们的生成代码工具就是编译这个包得到的,其中包括 IDL 的解析、校验、代码生成、插件支持等。不过为了便于用户使用同时提供更友好的扩展,主要能力也做了拆分作为基础库独立开源,如 Thriftgo、Thrift-validator 插件、Fastpb;右边的 Kitex Byted 是对字节内部基础能力集成的扩展实现,我们在开始就将内部的能力作为扩展收敛到一个 package 下。

如此,我们就可以将 Kitex Core 和 Tool 部分开源出去。我们将代码做了拆分,Kitex 的核心代码和工具部分迁移到开源库,集成内部扩展的模块作为 Kitex 的扩展保留在内部库,同时内部库封装一层壳保证内部用户可以无感知地升级。

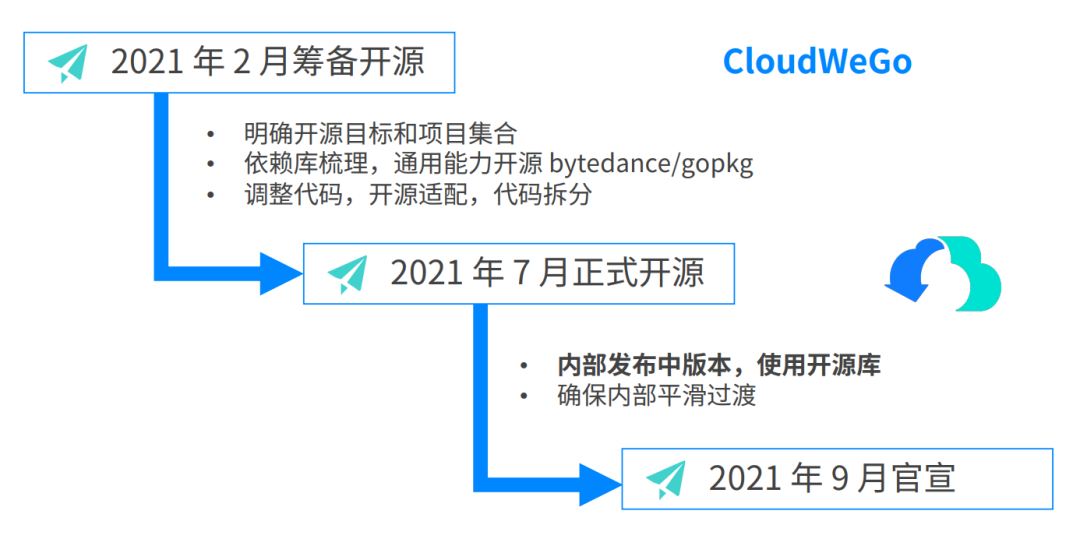

那么 Kitex 的开源就只是代码拆分这么简单吗?显然不是。2021 年 2 月,我们开始筹备 Kitex 的开源,虽然基于 Kitex 的扩展性,我们可以与内部基础设施集成的能力解耦,但是 Kitex 仍然依赖内部的一些基础库,如果要开源必须先开源基础库的能力。所以我们首先做了依赖库的梳理,与相关的同学合作首先开源了 bytedance/gopkg 库。这个库由 CloudWeGo 与字节跳动的语言团队合作维护,里面包含也了对 Golang 标准库能力的增强,感兴趣的同学可以关注使用。

bytedance/gopkg: https://github.com/bytedance/gopkg

在 gopkg 库开源后,我们调整代码进行开源适配。2021 年 7 月,Kitex 正式开源,在内部发布中版本使用开源库。但 Kitex 毕竟支持了内部几万的微服务,我们必须要确保内部服务在这个变更后可以平滑过渡,所以在开源初我们没有对外官宣,在确认稳定性后,2021 年 9 月,Kitex 正式对外官宣开源。

介绍了Kitex诞生、开源的历程,希望能够解除外部同学关于“Kitex 会不会是一个 KPI 项目?”的顾虑。

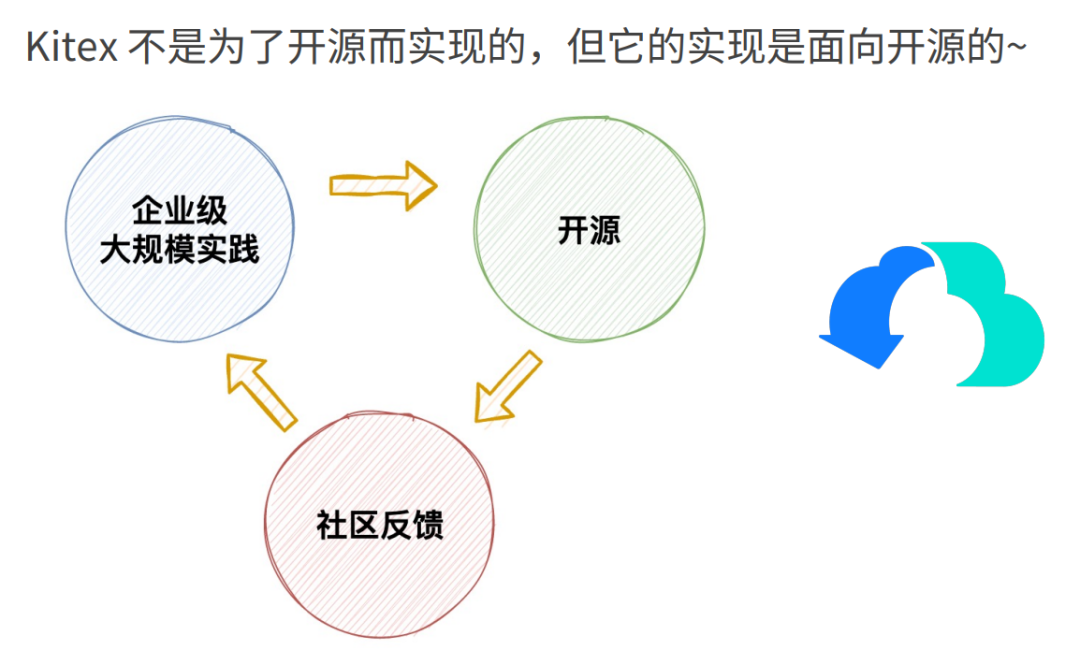

开源的价值

第一部分的最后,简单讲一下开源能为我们带来的价值。Kitex 不是为了开源而实现的,但它的实现是面向开源的。Kitex 本身是一个经过内部大规模实现的项目,我们希望 Kitex 开源后能帮助更多用户在内部快速搭建微服务,同时开源能让我们收集更多社区和企业的反馈,也能吸引外部开发者共建,促进 Kitex 面向多场景支持的演进,丰富产品能力,然后能在更多场景和企业得到落地,这是一个正向循环,互利共赢的过程。

开源一年变更回顾

框架的衡量指标

在介绍 Kitex 开源一年变更前,先分享一下框架的衡量指标,这是大家在选择一个框架时要考虑的。

- 扩展性

如果一个框架与内部能力强耦合,就无法移植到其他平台,或框架的支持场景单一也无法进行扩展,这样的框架很难得到外部的使用。

- 易用性

框架的易用性体现在两个方面。第一是面向业务开发者,如果一个框架在使用过程中需要让用户关注很多框架的细节,那么对研发效率要求很高的团队可能无法接受。第二是面向框架的二次开发者,他们需要对框架做一些定制支持,如果框架提供的扩展能力过于宽泛,扩展成本很高,或者可扩展的能力不够多,那么这个框架也是存在局限性的。

- 功能的丰富度

虽然基于扩展性可以对框架进行定制,但不是所有开发者都有足够的精力做定制开发,如果框架本身对各种扩展能力提供了不同选择的支持,对于开发者来说只需要根据自己的基础设施进行组合就能在自己的环境中运行。

- 高性能

前面三点是初期选择框架需要重点关注的指标,但随着服务规模和资源消耗变大,性能就成了不容忽视的问题。从长期的角度来说,选择框架的时候一定要关注性能,否则后续只能面临框架替换的问题,或者被迫对这个框架做定制维护。

关于以上四点框架的衡量指标,虽然 Kitex 目前还没做到最好,但是这四个要素都是 Kitex 设计和实现中一直在兼顾的,我们不会顾此失彼。

功能特性

下面就几个开源一年来重要的功能特性进行介绍。

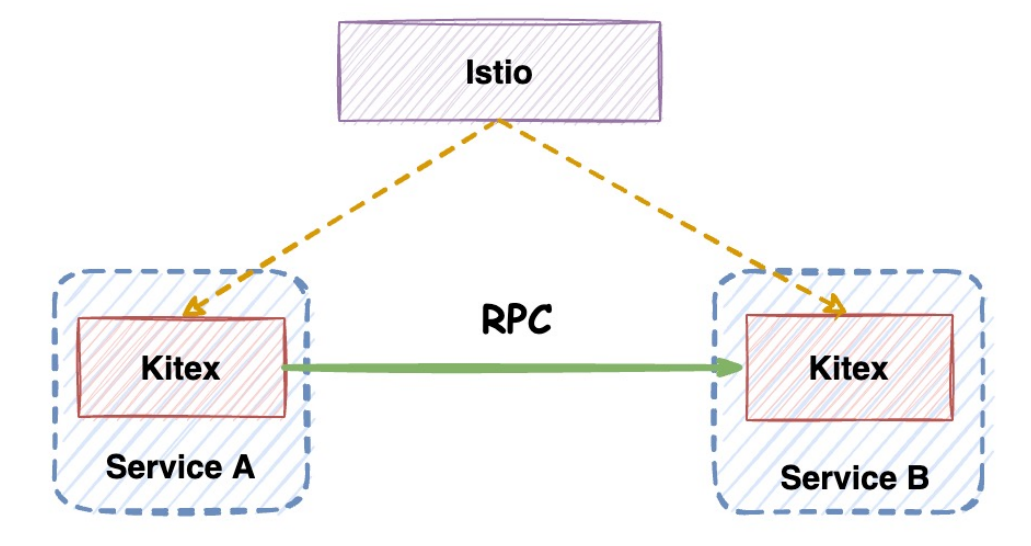

Proxyless Proxyless

是 Kitex 面向开源场景提供的支持。在 Kitex 开源初期,我们内部讨论过是否要支持 xDS 对接 Istio,对于外部用户来说,使用 Istio 可以快速搭建一套基本的微服务架构,解决服务发现、流量路由、配置下发等问题,但是如果使用完整的 Istio 的解决方案,就要引入 Envoy,这会增加运维成本,而且直接使用官方的 Envoy 方案对性能有损,会引入额外的 CPU 开销且增加延迟。如果 Kitex 能直接对接 Istio,既能让用户享受到部分 Istio 的能力,又可以避免 Envoy 带来的性能损失和部署运维成本。但是在开源初期,我们没有看到很明确的用户诉求,因此没有对此做高优的支持。

后来 gRPC 官方也发布了 Proxyless 的支持,同时 Istio 的官方也将 Proxyless 作为使用 Istio 的一种方式。Kitex 现在也已完成支持,目前主要是对接服务发现,xDS 支持的扩展单独开源到了 kitex-contrib/xds 库中,后续还会完善。大家可以根据 README 了解如何使用 Kitex 对接 Istio。

xDS Support: https://github.com/kitex-contrib/xds

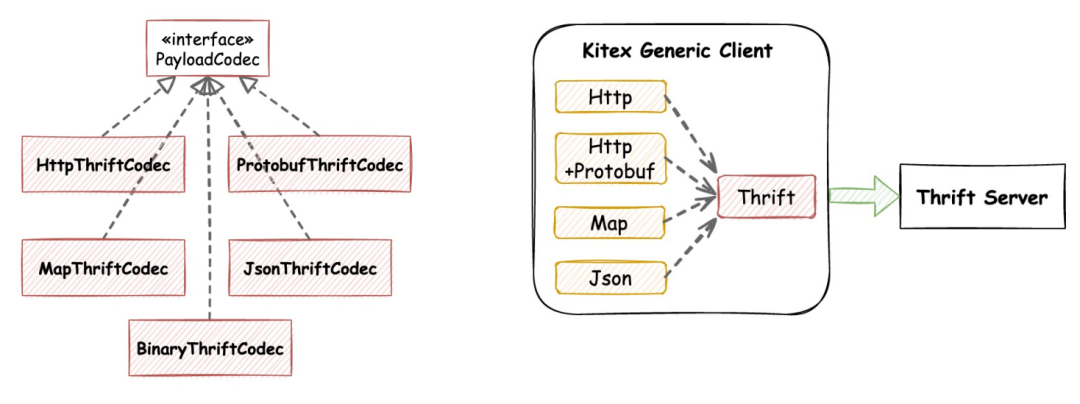

JSON 和 Protobuf 泛化调用支持

之前,Kitex 支持了应用在网关场景的 HTTP 泛化,以及支持了应用在一些通用服务场景的 Map 和二进制泛化。开源后,根据用户的需求反馈又新增了 JSON 和 Protobuf 的泛化。

Protobuf 的泛化也是应用在 API 网关的场景。原来的 HTTP 泛化传输的数据格式是 JSON,但是 JSON 的序列化体积大、效率低,对性能有影响,所以很多移动端的接口选择使用 Protobuf 传输数据,因此增加了 Protobuf 泛化的支持。

目前 Kitex 的泛化主要针对后端的 Thrift 服务,无论是 Protobuf、Map 还是 JSON,Kitex 都会在调用端结合 IDL 解析,将这些数据映射编码为 Thrift 包发给后端服务。

那么为什么把泛化放在调用端而不是服务端呢?大家广泛了解的泛化都是服务端对泛化请求做了解析处理,当然调用端也要相应地提供泛化的 Client。但是泛化面向的是通用服务,泛化使用成本其实是比较高的,它并不适用于普通的 RPC 场景,而通用服务面向的是所有后端的服务,有 Golang/Java/C++/Python/Rust,如果每一种语言框架都支持泛化,成本是非常高的。就算各个语言都对泛化做了支持,框架版本收敛又是一个漫长的过程,对于通用服务来说,对接所有的服务就显得不太现实。综合以上原因,泛化放在调用端支持。

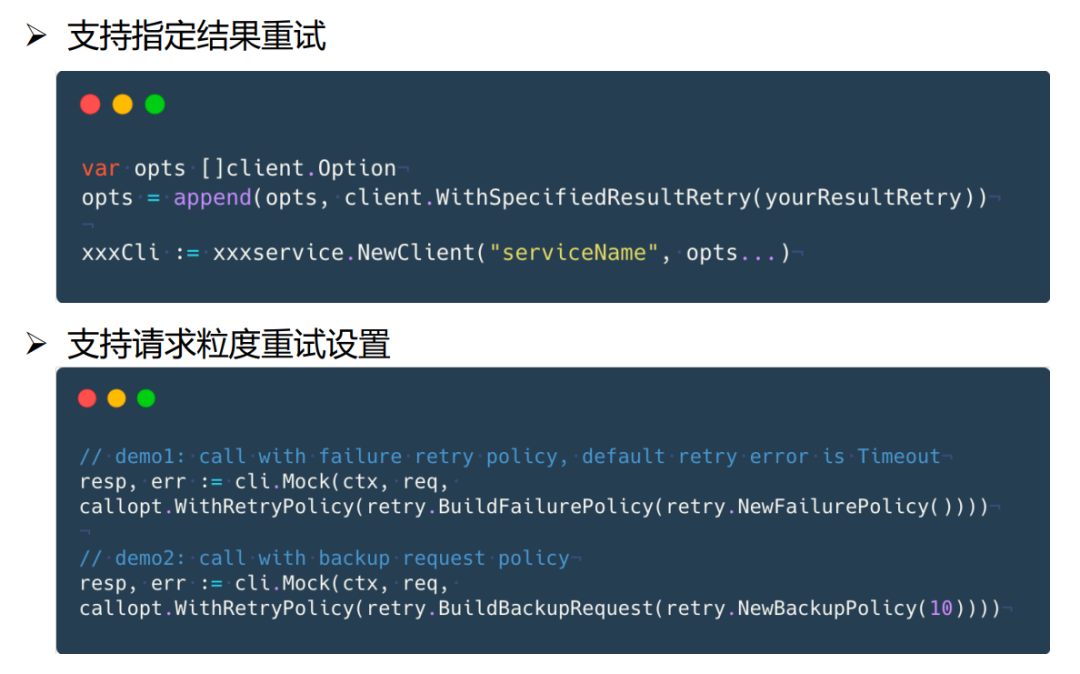

重试能力增强

去年开源时,Kitex 已经支持了重试功能。之前支持的重试有两类,一个是超时重试,一个是 Backup Request。

对于超时来重试来说,我们只会对超时这一种异常进行重试,但为了进一步提高请求成功率,用户希望对其他的异常也进行重试,或者用户可能会定义一些用户请求的状态码,结合用户状态码进行重试,在这种情况下,显然我们只支持超时重试是不满足用户需求的。基于这个背景,Kitex 新增了指定结果重试,用户可以指定其他异常或指定某一类 Response,框架会结合用户指定的结果进行重试。

其次,用户在配置重试时,如果通过代码配置的方式设置重试,它会对整个 Client 的所有 RPC 方法生效,但是用户希望针对不同的 RPC 方法应用不同的重试策略,甚至同一个方法也希望可以采用不同的重试策略,因为不同链路上发起的同一个方法的请求对指标要求也会不同。比如有些想使用 Backup Request 减少延迟,有些想做异常重试提高成功率,对于这种情况,Kitex 新的版本支持了请求粒度配置重试。

下图是使用示例。以请求粒度重试配置为例,比如 RPC 方法是 ,那么我们在发起 RPC 调用的时候,在后面可以配置一个 指定重试策略,此次请求就会使用这个重试策略。

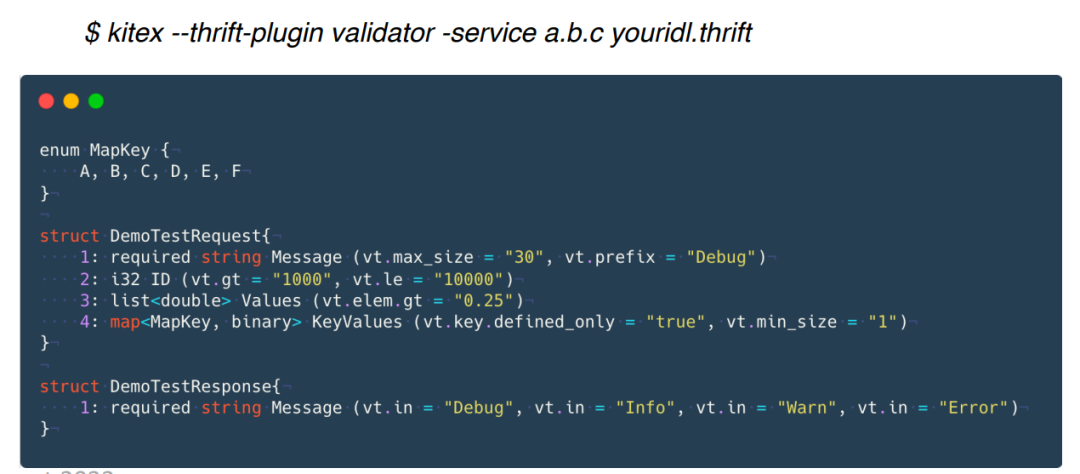

Thrift Validator

Thrift-gen-validator 是 Thriftgo 的一个工具插件,它可以根据 Thrift IDL 中定义的注解描述约束给对应的 生成 方法,校验值的合法性。通常做 RPC 调用的时候,用户可能会对一些字段校验合法性,用户如果直接写这些校验代码,投入的成本会很高。所以我们就提供了注解支持,只要用户在 IDL 中根据规范定义注解,Kitex 就可以帮助用户生成校验代码。

下图是代码生成的命令和一个 IDL 注解定义示例,在生成代码的时候指定 Thrift Validator 的插件,我们的插件工具就会解析注解,为用户生成这一套合法性校验的代码。目前我们也将 Thrift Validator 的功能贡献给了 Apache Thrift。

性能优化

介绍完几个重要的功能特性,再介绍几个在性能上的优化特性。

Thrift 高性能编解码

Frugal 是一个无需生成编解码代码、基于 JIT 的高性能动态 Thrift 编解码器。虽然我们针对官方 Thrift 编解码已经做了优化,支持了 FastThrift,这个在我们开源前发布的优化实践里也有介绍,但我们希望能有进一步的性能提升,参考我们开源的高性能 JSON 库 Sonic 的设计,实现了 Thrift JIT 编解码器。下图中的表格是 Frugal 结合 Kitex 与 FastThrift 的性能对比。

可以看到在大部分场景 RPC 性能表现都较优。除了性能上的优势,Frugal 还有另一个优势是无需生成编解码生成代码。Thrift 的生成代码比 Protobuf 繁重,一个复杂的 IDL 代码生成文件可以达到几万行,而这些代码本来对用户来说无需关注,却需要由用户来维护。Frugal 只需要生成结构体代码,不需生成编解码代码,就大大解决了这个问题。

关于如何在 Kitex 中使用 Frugal,可以参考仓库的 Readme。当然用户也可以单独使用 Frugal 作为 Thrift 高性能编解码器,Kitex 后续也会考虑默认使用 Frugal。

Frugal: https://github.com/cloudwego/frugal#readme

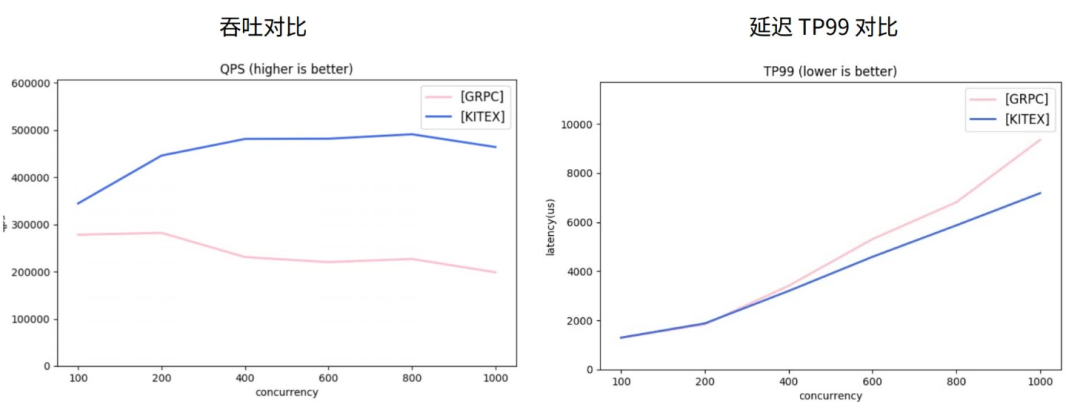

Protobuf 高性能编解码

虽然我们内部主要支持 Thrift,但开源之后我们发现外部用户对于 Protobuf 或 gRPC 的关注会更多,所以参考 Kitex FastThrift 的优化思路,重新实现了 Protobuf 的生成代码。在 v0.4.0 版本,如果用户使用 Kitex 的工具生成 Protobuf 的代码,就会默认生成 Fastpb 的编解码代码,在发起 RPC 调用的时候,Kitex 也会默认使用 Fastpb。

下图是 Fastpb 与官方 Protobuf 序列化的性能对比,可以看到无论是编码还是解码,在效率和内存分配上,Fastpb 都远远优于官方 Protobuf 序列化库。

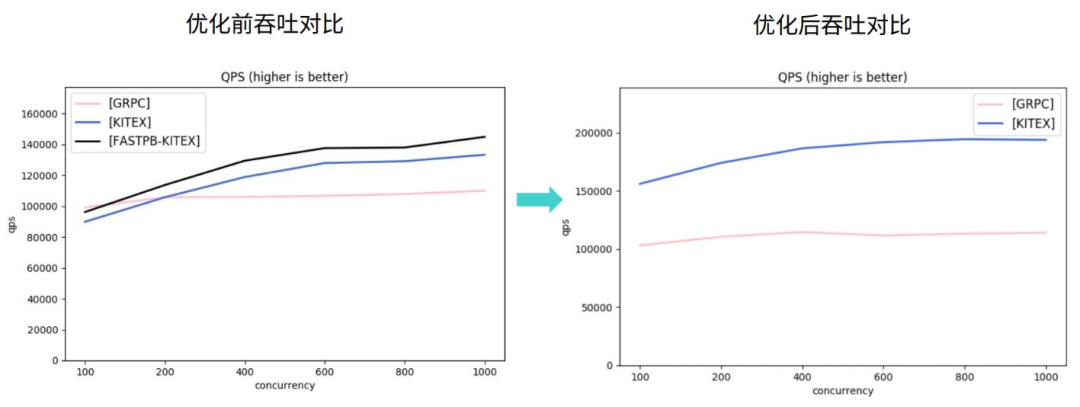

gRPC 性能优化

开源初期,我们对 gRPC 整体稳定性和性能的关注是比较少的。因为内部使用的场景不是很多。开源后收到了很多外部同学的反馈,所以我们针对 gRPC 做了一个专项的问题治理以及性能优化。今年中旬我们已经把相关的优化正式提交到开源库,在 v0.4.0 版本发布。

Kitex v0.4.0: https://sigusoft.com/s/ezifbQkHcZQP6MygmJABYA

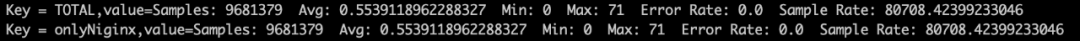

下图中左侧是优化前 Kitex-gRPC 和官方 gRPC 框架对 Unary 请求的压测吞吐对比,在并发比较低的情况下,Kitex 的吞吐并不具有优势,使用 Fastpb 的时候,Kitex 的吞吐表现会好一些,但低并发的吞吐依然低于官方 gRPC。在优化之后,吞吐对比如右图所示。相比优化前吞吐提升 46% – 70%,相比官方 gRPC 框架,吞吐高 51% – 70%。

下图中右侧是优化后 Unary 请求的延迟对比,在吞吐比官方 gRPC 高出很多的情况下,Kitex 的延迟也显著低于官方的 gRPC。同时就 Kitex 自身而言,在优化后延迟表现也好了很多。

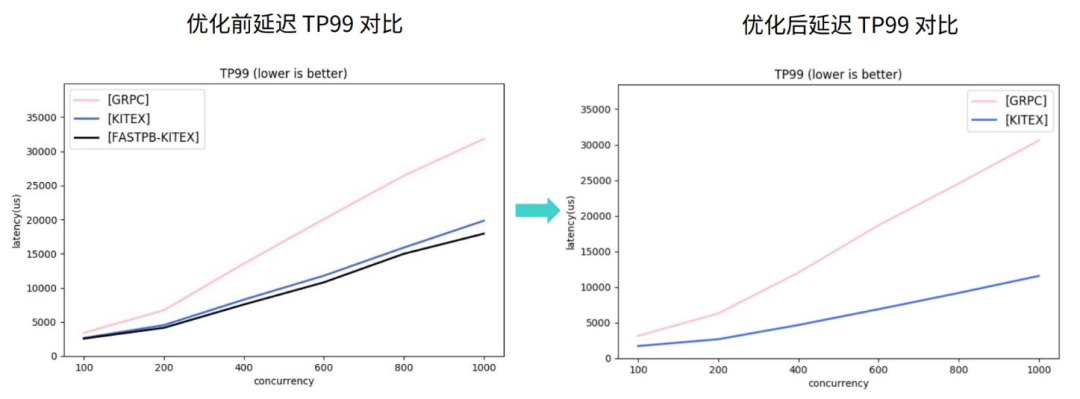

我们再看下 Streaming 请求的压测性能对比,优化前 Streaming 请求的表现同样在低并发的情况下,相对 gRPC 框架没有优势。经过优化后,Kitex 吞吐显著高于官方 gRPC,如下图,同时低并发下吞吐高但延迟持平,增加并发后能看到延迟出现分叉。所以在性能上, Kitex 支持的 gRPC 协议相对官方有明显的优势。

虽然在部分功能上,Kitex 还没有完全对齐,但是目前已经可以满足大部分的场景需求,我们后续也会继续进行功能对齐。

社区共建完善生态及企业落地

社区共建的 Kitex 扩展生态

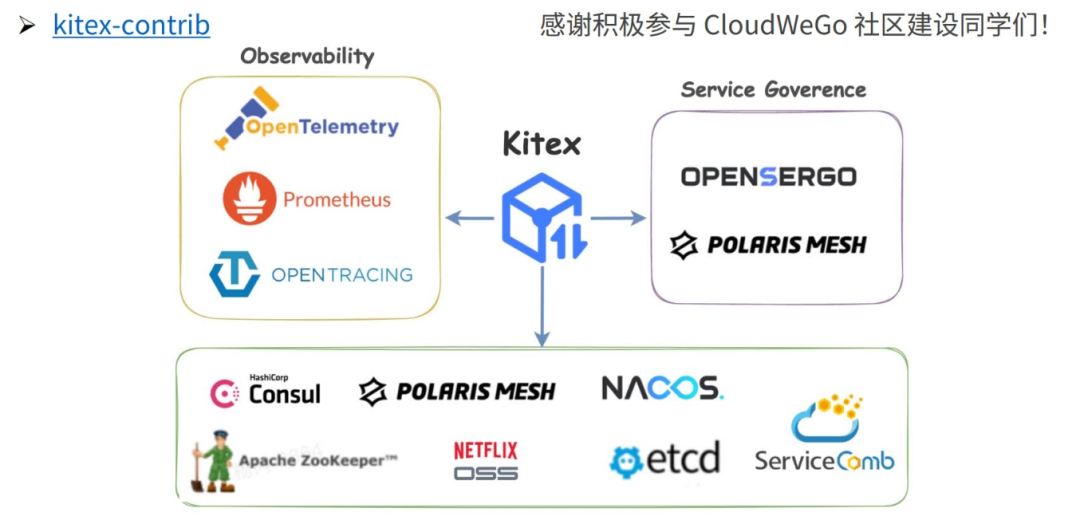

开源后,我们很欣慰得到了很多开发者的关注,坦白说内部团队精力有限,无法快速建立起面向外部用户的 Kitex 扩展生态。但是一年以来借助社区的力量,Kitex 在服务注册/发现、可观测性、服务治理几部分的扩展得到了很多补充,尤其是服务注册/发现相关的扩展,目前开源的主流注册中心都已完成对接,虽然在功能丰富度上我们还有待加强,但结合已有的支持,对于外部用户已经具备了搭建微服务架构的能力。

衷心感谢积极参与 CloudWeGo 社区建设的同学们!关于 Kitex 相关的生态支持,大家可以进入 Kitex-contrib 了解更多的开源仓库。

Kitex-contrib: https://github.com/kitex-contrib

对接外部企业,协助落地

我们开源的初衷是为了助力其他外部企业快速地搭建企业级的云原生架构。开源后,森马、华兴证券、贪玩游戏、禾多科技先后主动与我们联系,反馈使用问题、提出需求,的确让我们发现了一些和内部场景不一样的问题,需要我们去关注、支持和优化,我们很开心 Kitex 能在这些企业内部得到应用。在今年 6 月 25 日的 CloudWeGo Meetup 中,森马和华兴证券的研发同学也分享了他们使用 Kitex 的内部实践。

森马:https://sigusoft.com/s/JAurW4P2E3NIduFaVY6jew

华兴证券:https://sigusoft.com/s/QqGdzp-7rTdlxedy6bsXiw

除了以上企业,还有一些公司也私下向我们咨询过使用问题,我们非常感谢这些企业用户的支持,以及向我们提出的反馈信息。如第一部分所讲,收集社区和企业的反馈可以促进 Kitex 面向多场景支持的演进,企业用户如果有相关需求,欢迎联系我们。

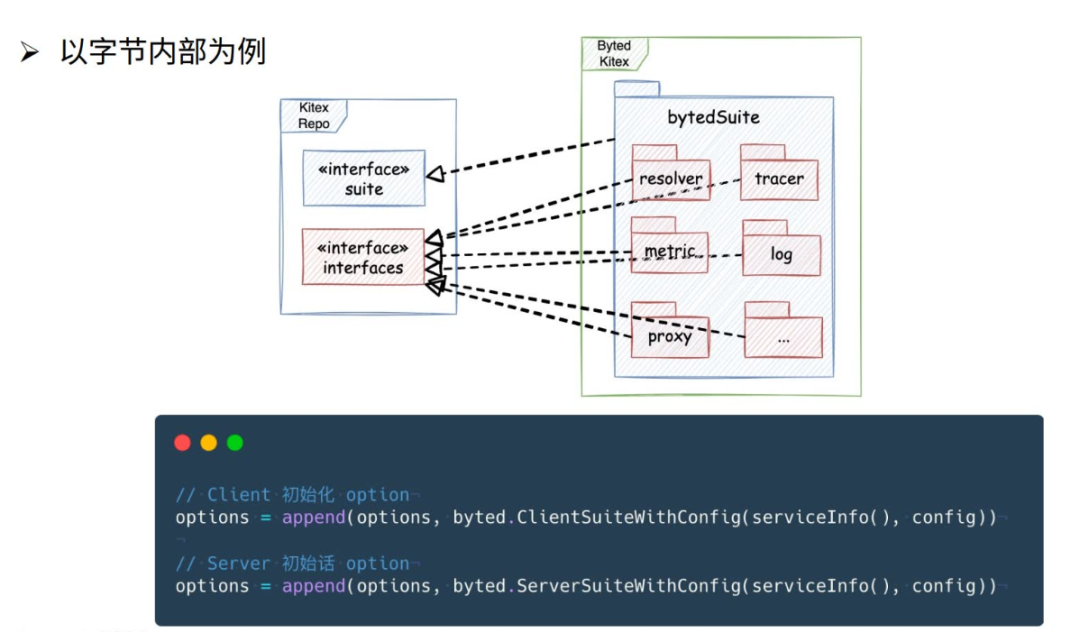

如何使用 Kitex 与内部基础设施集成

这里再简单介绍下如何使用 Kitex 与大家的内部基础设施集成。以字节内部为例,内部仓库里有开源库中的扩展实现,集成内部的能力,在 bytedSuite 中,我们针对不同场景对 Kitex 进行初始化。如下面的代码示例,用户只需要在构造 Client 和 Server 时增加一个 option 配置就可以完成集成,不过为了让用户完全不需关注内部能力的集成,我们将该配置放在了生成的脚手架代码中,关于配置如何内嵌在生成代码中,后续我们也会开放出来,方便外部的框架二次开发者能以同样的方式为业务开发同学提供集成能力。

总结和展望

总结

本次分享主要介绍了以下内容:

Kitex 如何保持内外统一地从内部应用较广的框架转为开源框架;

开源一年以来发布了哪些重要的功能特性,做了哪些性能优化;

借助社区的力量现在 Kitex 的周边生态如何、企业落地情况以及如何使用 Kitex 优雅地集成内部能力。

展望

与社区同学共建,持续丰富社区生态;

结合工程实践,为微服务开发者提供更多便利;

完善好 BDThrift 生态,持续优化 Protobuf/gRPC;

更多特性支持或开源,ShmIPC、QUIC、Protobuf 泛化…

以上内容整理自第七期字节跳动技术沙龙《字节高性能开源微服务框架:CloudWeGo》,获取讲师 PPT 和回放视频,请关注 CloudWeGo 公众号,并在后台回复关键词 “一周年”。

项目地址

GitHub:https://github.com/cloudwego

官网:www.cloudwego.io

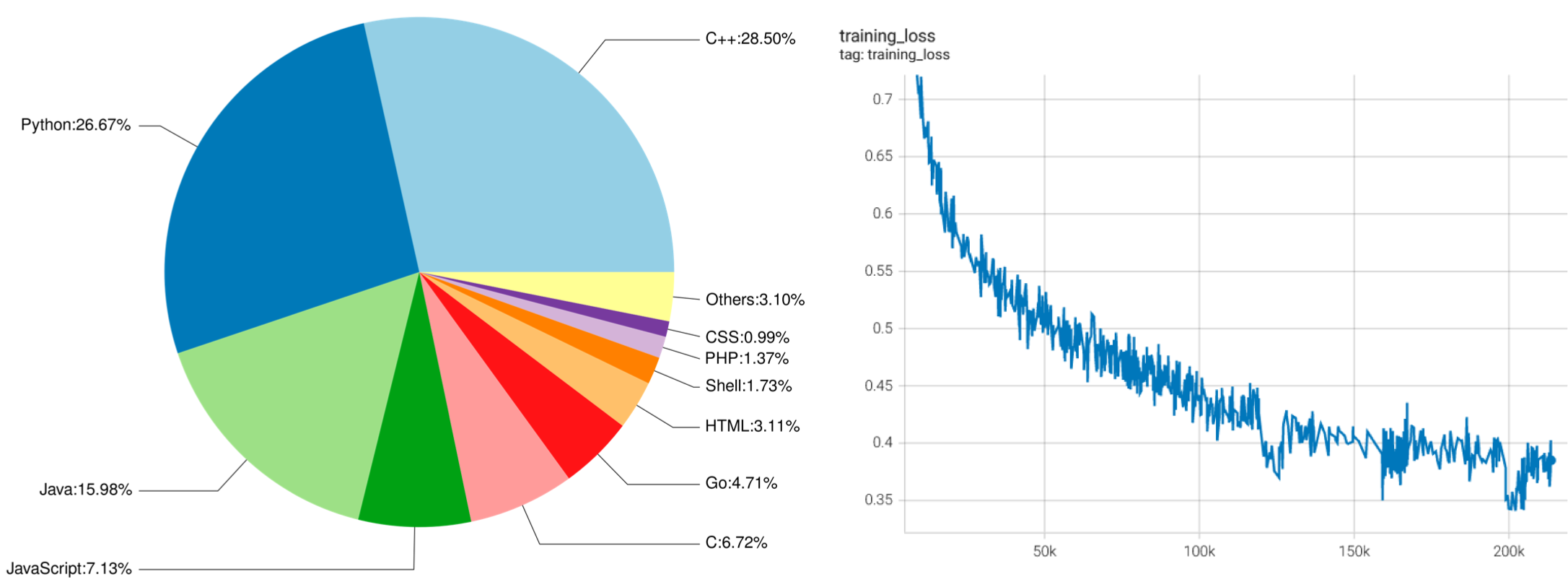

CodeGeeX是一个具有130亿参数的多编程语言代码生成预训练模型。CodeGeeX采用华为MindSpore框架实现,在鹏城实验室“鹏城云脑II”中的192个节点(共1536个国产昇腾910 AI处理器)上训练而成。

截至2022年6月22日,CodeGeeX 在20多种编程语言的代码语料库(>8500亿Token)上预训练得到。

CodeGeeX有以下特点:

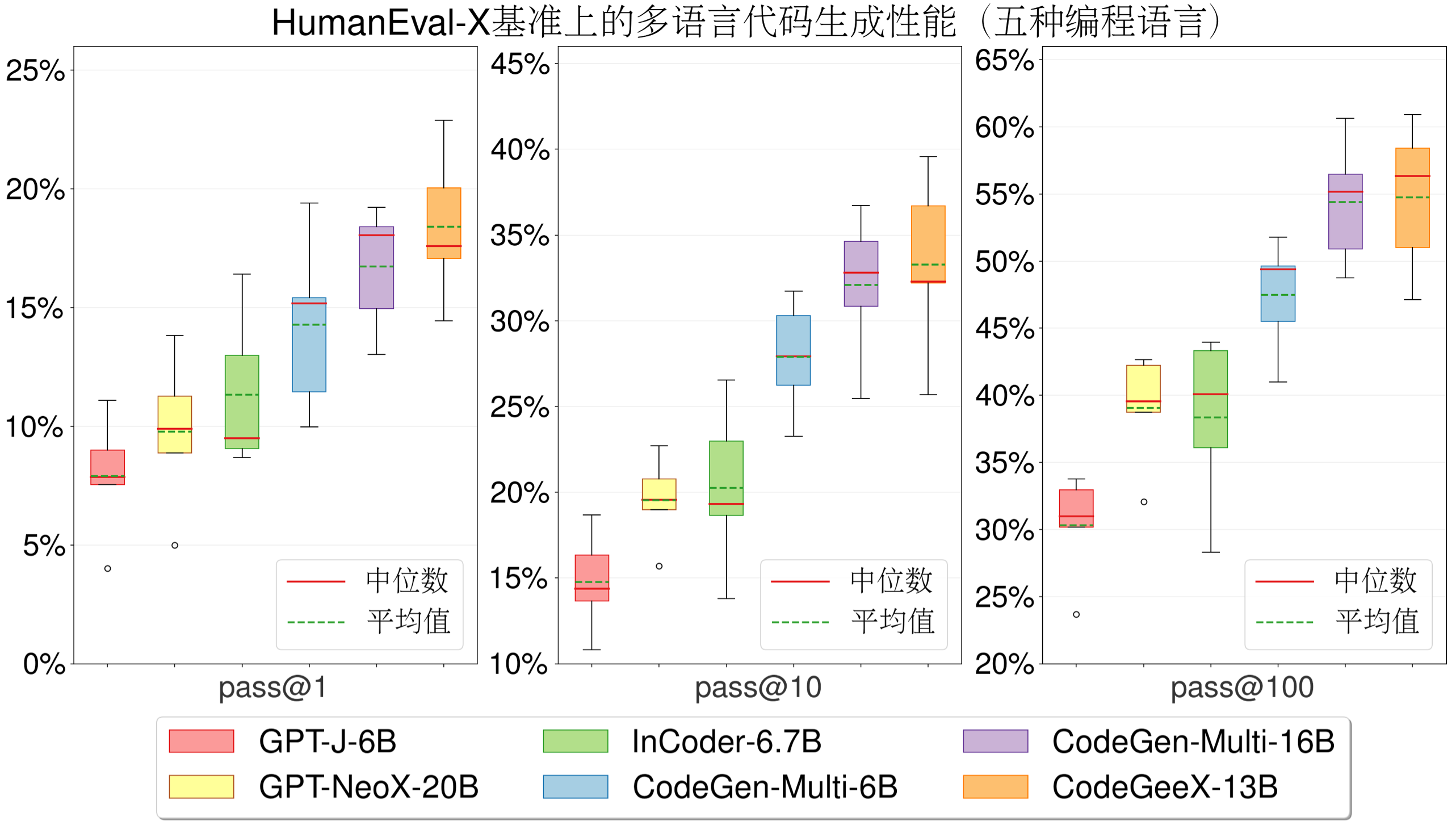

- 高精度代码生成:支持生成Python、C++、Java、JavaScript和Go等多种主流编程语言的代码,在HumanEval-X代码生成任务上取得47%~60%求解率,较其他开源基线模型有更佳的平均性能。代码生成示例

- 跨语言代码翻译:支持代码片段在不同编程语言间进行自动翻译转换,翻译结果正确率高,在HumanEval-X代码翻译任务上超越了其它基线模型。代码翻译示例

- 自动编程插件:CodeGeeX插件现已上架VSCode插件市场(完全免费),用户可以通过其强大的少样本生成能力,自定义代码生成风格和能力,更好辅助代码编写。插件下载

- 模型跨平台开源: 所有代码和模型权重开源开放,用作研究用途。CodeGeeX同时支持昇腾和英伟达平台,可在单张昇腾910或英伟达V100/A100上实现推理。申请模型权重

全新多编程语言评测基准HumanEval-X:HumanEval-X是第一个支持功能正确性评测的多语言、多任务的基准,包含820个人工编写的高质量代码生成题目、测试用例与参考答案,覆盖5种编程语言(Python、C++、Java、JavaScript、Go),支持代码生成与代码翻译能力的评测。如何使用

在HumanEval-X代码生成任务上,与其它开源基线模型相比,CodeGeeX取得了最佳的平均性能。

使用指南

CodeGeeX最初使用Mindspore框架实现,并在昇腾910AI芯片上进行训练。为适配更多平台,官方将其转换到Megatron-LM框架,支持Pytorch+GPU环境。

安装

需要Python 3.7+ / CUDA 11+ / PyTorch 1.10+ / DeepSpeed 0.6+,通过以下命令安装 :

git clone git@github.com:THUDM/CodeGeeX.git cd CodeGeeX pip install -e .

模型权重

通过该链接申请权重,您将收到一个包含临时下载链接文件的邮件。推荐使用aria2通过以下命令快速下载(请保证有足够的硬盘空间存放权重(~26GB)):

aria2c -x 16 -s 16 -j 4 --continue=true -i urls.txt

使用以下命令合并得到完整的权重:

cat codegeex_13b.tar.gz.part.* > codegeex_13b.tar tar xvf codegeex_13b.tar.gz

用GPU进行推理

尝试使用CodeGeeX模型生成第一个程序吧!首先,在配置文件中写明存放权重的路径。其次,将提示(可以是任意描述或代码片段)写入文件,运行以下脚本即可开始推理(需指定GPU序号):

bash https://www.xujun.org/scripts/test_inference.sh <GPU_ID> https://www.xujun.org/tests/test_prompt.txt

VS Code插件使用指南

基于CodeGeeX 开发了一款免费的VS Code插件,在应用市场搜索“codegeex”或通过该链接安装。详细的使用指南在CodeGeeX插件使用指南.

左侧:CodeGeeX训练数据中各编程语言占比。 右侧:CodeGeeX训练损失函数随训练步数下降曲线。

全球最大的汽车制造商丰田近日承认,他们意外地将能够访问近 30 万用户资料的访问密钥公开在了 GitHub 上,并且长达 5 年时间,用户的部分个人信息可能已经发生了泄漏。

丰田在发布的道歉声明中表示,一个负责构建 T-Connect 的外包开发商于 2017 年 12 月将 T-Connect 网站的部分源代码错误地发布在了 GitHub 上,其中还包含了存储客户电子邮件地址和管理号码的数据服务器的访问密钥。

这个问题直到今年 9 月份才被丰田注意到,也就是说在这近 5 年时间里,未经授权的第三方可以毫无障碍地访问客户信息。

注:丰田 T-Connect 是该汽车制造商的官方项目,允许丰田汽车的车主将他们的智能手机与车辆的信息娱乐系统连接起来,以获得电话、音乐、导航、通知集成、驾驶数据、发动机状态、油耗等功能和信息的控制与访问。

发现问题后,丰田第一时间将该仓库设为私有,并及时修改了数据库的密钥,目前已经解决了潜在的问题。

此次事件中涉及的数据库仅存储了用户的电子邮件地址和客户管理号码,由于客户姓名、信用卡数据和电话号码等数据是存储在另一个数据库中的,因此这些数据并没有泄漏。

虽然那些敏感信息没有发生泄漏,但用户也需要留意近期收到的电子邮件,不要随意未知发件人的邮件,以防黑客伪装成丰田官方人员向用户发送钓鱼邮件。

丰田表示:

我们将单独向任何可能泄露电子邮件地址或客户管理号码的客户发送致歉信息和通知。此外,我们在网站上准备了一个特殊的表格,可以让用户检查你的电子邮件地址是否受此活动的影响,我们还设立了专门的呼叫中心来回答客户的问题和疑虑。

这一事件是由开发承包公司对源代码的不当处理造成的,我们将与承包公司合作,确保对客户个人信息的处理进行彻底管理,并加强安全。丰田公司重申,妥善处理客户的个人信息是一项重要的企业社会责任,并将进一步努力确保客户个人信息的保护和管理,以实现客户可信赖的服务。

继呼吁停用 C/C++ 开发新项目并使用 Rust 之后,Microsoft Azure CTO、Sysinternals 的主要开发者 Mark Russinovich 的一条吐槽 Git 的新社交动态又引起了广泛讨论。他表示:

Git 又一次让我想拔掉我的头发。这是我使用过的所有软件中最不直观、最笨重的界面之一。

事实上,Mark Russinovich 并不是第一个也不是唯一一个有此感想的人,很多人在评论表达了自己的共鸣。有人指出,“据我所知,连 Linus 都讨厌它”。其中一条高赞评论还指向了一个吐槽 Git 的网页(ohshitgit.com),这个吐槽页面甚至被不同国家的几十名开发者自发翻译成了不同的语言版本。

“用好 Git 很难: 很容易就犯错了,然后想自己弥补犯下的错,简直太难了。查阅 Git 文档简直就像是个先有鸡还是先有蛋的问题,你得知道你要的是啥 ,但如果我知道的话,我还他妈查个毛文档啊!”

网页作者还详细分享了自己在使用 Git 时所遇到的一些抓狂瞬间,并提供了所采用的解决办法:

- Oh shit,我刚才好像犯了个大错,能不能给我台时光机啊!?!

- Oh shit,我刚提交 commit 就发现还有一个小改动需要添加!

- Oh shit,我要修改我刚刚 commit 提交的信息!

- Oh shit,我不小心把本应在新分支上提交的东西提交到了 master!

- Oh shit,我把这个 commit 提交错分支了!

- Oh shit,我想用 diff 命令看下改动内容,但啥都没看到?!

- Oh shit,我想撤回一个很早以前的 commit!

- Oh shit,我想撤回某一个文件的改动!

- Fuck this noise, I give up(指那些 untracked 的文件)

针对 Mark Russinovich 的发言,也有人激动地表示自己已经因为 Git 烦扰多时,现在则终于有权威人士出来发声了。

根据维基百科,Mark Eugene Russinovich(生于 1966 年 12 月 22 日)是西班牙裔美国软件工程师,现任 Microsoft Azure CTO。在 2006 年被微软收购之前, 他是软件生产商 Winternals 的联合创始人。

Mark Russinovich 首次接触电脑是在 20 世纪 70 年代,源于他朋友的父亲得到了一台 Apple II。彼时,他就能够对其 ROM 进行逆向工程以及为其编写程序。15 岁时,他给自己买了第一台电脑 —— 德州仪器的 TI99/4A。他还是小说 Rogue Code、Zero Day and Trojan Horse、Windows Internals、Sysinternals tools 的作者。2005 年,在业界引起巨大反响的索尼 DRM 反拷贝程序事件也是他发现的。

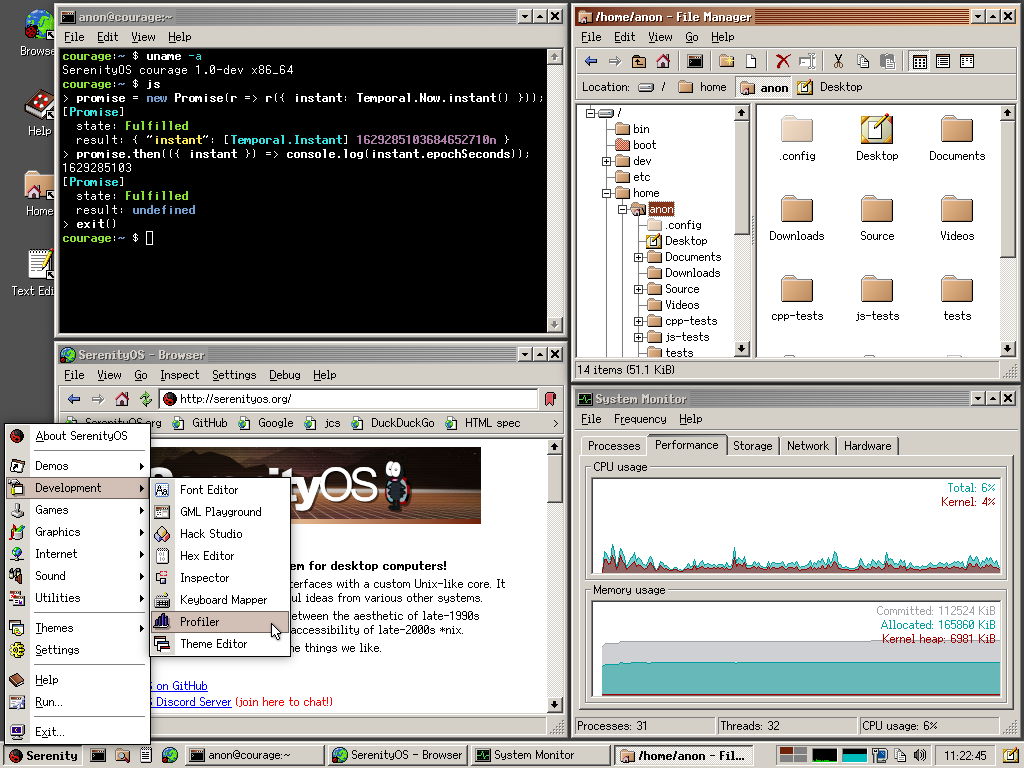

据 SerenityOS 博客介绍:自 2018 年 10 月 10 日 SerenityOS 存储库迎来第一次提交 ,距今已满四周年。

SerenityOS 是一个类似 Unix 的操作系统,但是带有图形化界面,适合 x86 计算机。SerenityOS 结合了类 Unix 内核和 1990 年代生产力软件的外观和体验,其界面类似 90 年代的Win98/NT。SerenityOS 的作者是来自瑞典的程序员 Andreas Kling ,在 2018 年完成了为期 3 个月的毒瘾康复计划后,Andreas 发现“自己有很多时间,没有什么可以做的“,接着就用了将近三年的时间全职创建 SerenityOS 。

SerenityOS 项目最初只是想做一个操作系统内核,但随着社区的壮大和贡献者的增加,现在已经诞生了属于 SerenityOS 的内存安全的编程语言 jakt ,以及 跨平台 Web 浏览器 Ladybird。

SerenityOS 项目最初使用 C++ 语言开发,但随着系统本身的壮大和普及,内存安全成为了一个大问题。社区最初尝试了 Rust 等用多种语言进行了原型设计,却发现它们都不适合这个项目,只好创建了属于自己的 jakt 编程语言。最初的 Jakt 原型使用 Rust 编写,如今 jakt 已实现自举:Jakt 编译器本身也用 Jakt 编写。

目前 SerenityOS 已可以满足基本的办公需求(虽然内核还不太稳定),还移植了一些经典的 PC 游戏。游戏运行在 LibGL (SerenityOS 社区对 OpenGL API 的实现) 之上。游戏的渲染由 LibSoftGPU 完成,这也是 SerenityOS 社区自研的一款使用 SIMD 的软件光栅化器。

如今 SerenityOS 已有 750+ 贡献者,社区在持续壮大中。作者称最新的目标是在 SerenityOS 内部构建所有组件和工具,不依赖任何第三方库,我愿称之为轮子王。

Hadoop是Apache基金会旗下最知名的基础架构开源项目之一。自2006年诞生以来,逐步发展成为海量数据存储、处理最为重要的基础组件,形成了非常丰富的技术生态。

作为国内顶尖的 Hadoop 开源生态技术峰会,第四届 China Apache Hadoop Meetup于 2022年9月24日在上海成功举办。

围绕“云数智聚 砥柱笃行”的主题,来自华为、阿里、网易、字节跳动、bilibili、平安银行、袋鼠云、英特尔、Kyligence、Ampere等多所企业单位,以及来自Spark、Fluid、ChunJun、Kyuubi、Ozone、IoTDB、Linkis、Kylin、Uniffle等开源社区的多位嘉宾均参与了分享讨论。

作为此次Meetup参与社区之一,也是大数据领域的项目,ChunJun也带来了一些新的声音:

ChunJun框架在实时数据采集和还原上的实现和原理是怎样的?这段时间以来,ChunJun有哪些新发展,对于未来发展又有着怎样的新想法?

作为袋鼠云资深大数据引擎开发专家,徐超带来了他的分享,将从一个独特的角度来介绍ChunJun数据集成在数据还原上的探索和实践。

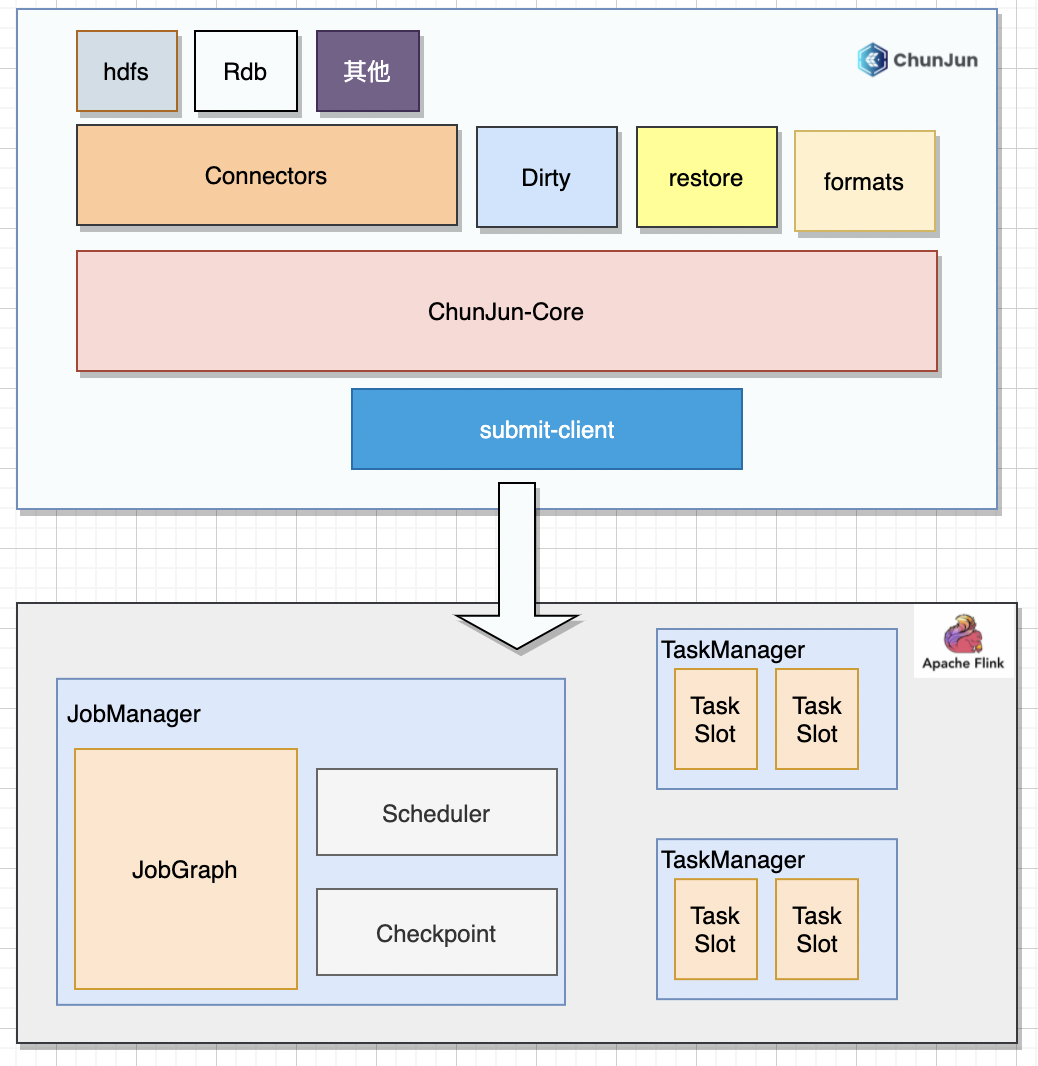

一、ChunJun框架介绍

第一个问题:ChunJun这个框架是什么?能干啥?

ChunJun(原FlinkX) 是袋鼠云基于Flink 基座自研的数据集成框架,经过4年多的迭代,已经成为一个稳定,高效,易用的批流一体的数据集成工具,可实现多种异构数据源高效的数据同步,目前已有3.2K+Star。

开源项目地址:

https://github.com/DTStack/chunjun

https://gitee.com/dtstack_dev_0/chunjun

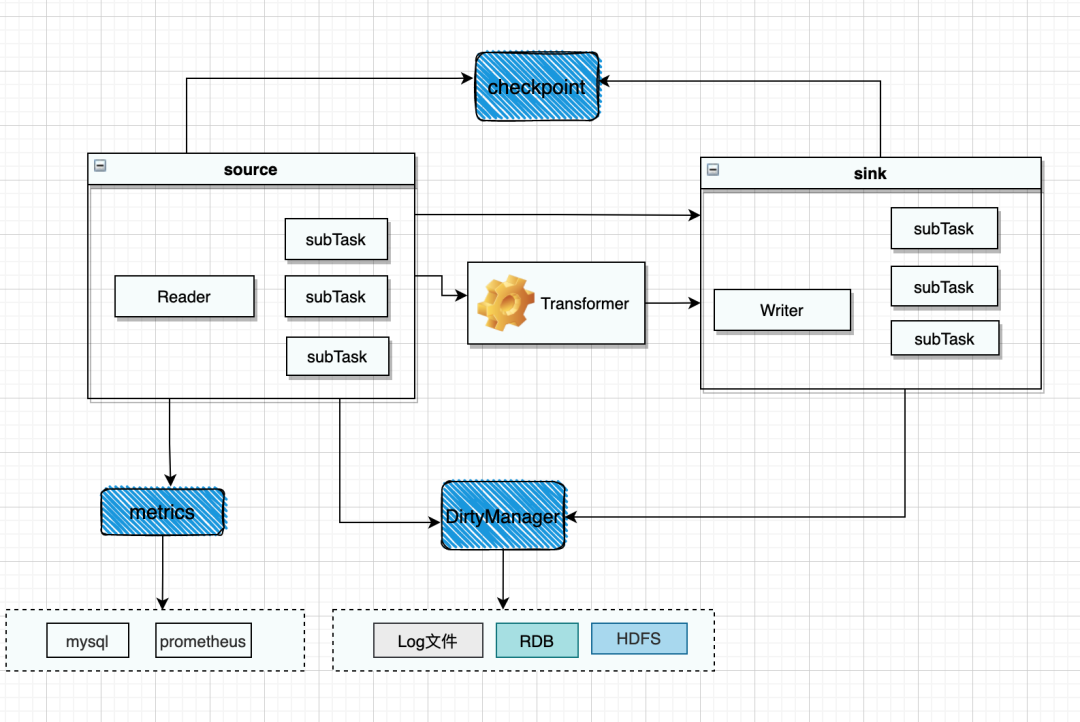

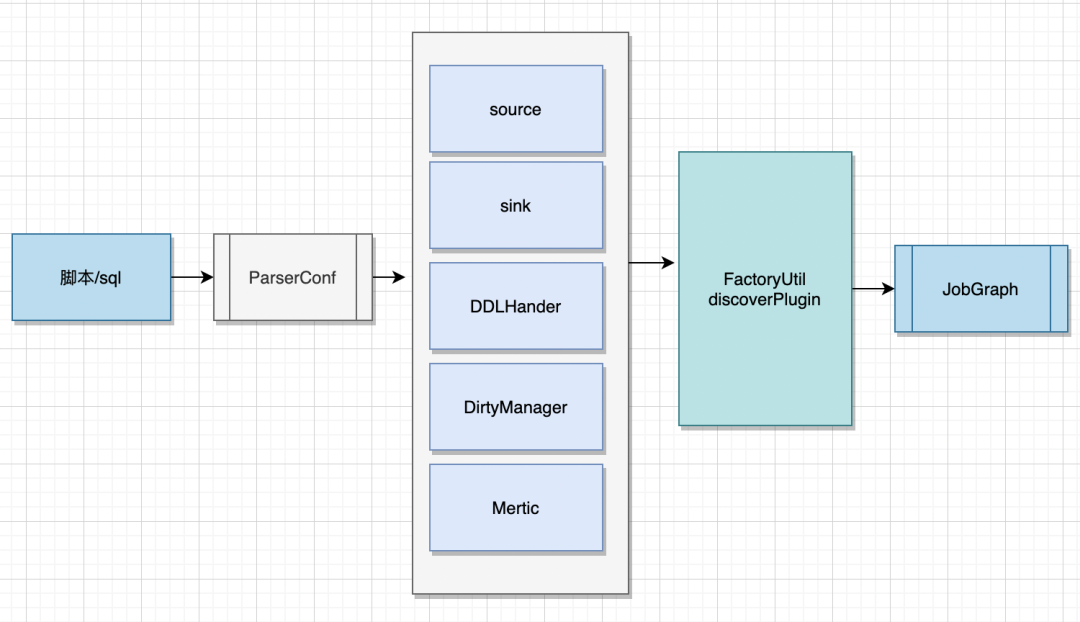

01 ChunJun框架结构

ChunJun 框架基于Flink 进行开发,提供了丰富的插件,同时添加了断点续传、脏数据管理、数据还原等特性。

02 ChunJun批量同步

• 支持增量同步

• 支持断点续传

• 支持多通道&并发

• 支持脏数据(记录和控制)

• 支持限流

• 支持transformer

03 ChunJun离线

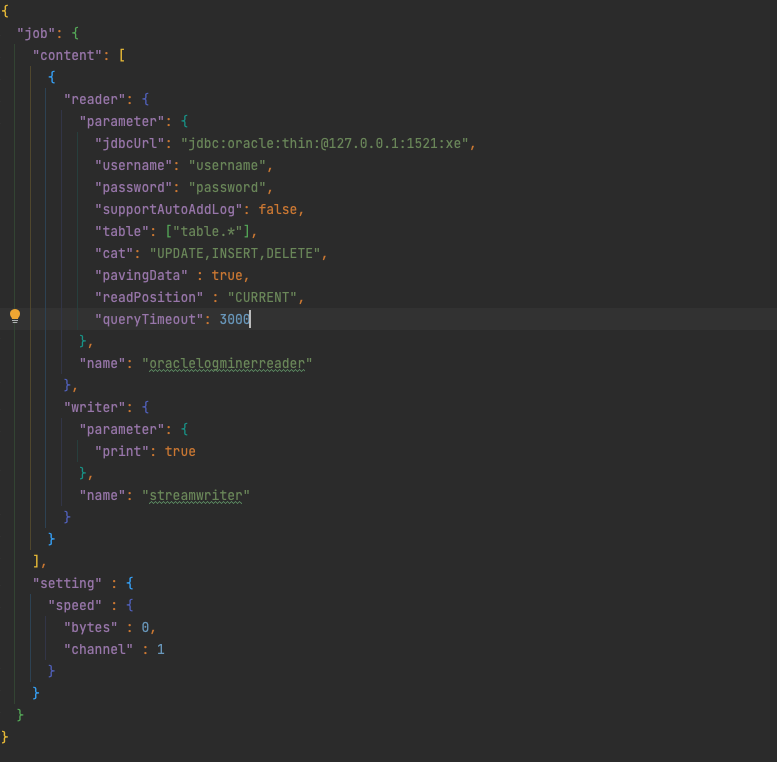

二、实时数据采集上的实现和原理

01 一个样例

02 ChunJun插件装载逻辑

03 ChunJun插件定义

04 ChunJun数据流转

05 ChunJun动态执行

面对监听多个表的情况,包括新添加表的数据,我们如何执行下游的写入:

• 支持Update 转换 before,after

• 添加扩展参数,DB,Schema,Table, ColumnInfo

• 支持动态构建PreparedStatement

06 ChunJun间隔轮询

什么是间隔轮询?我们是如何做的?

• 校验轮询字段类型,如果不是数值类型且source并行度大于1,报错不支持

• 创建三个数据分片,startlocation为null或者配置的值,mod分别为0,1,2

• 构造SQL:不同SQL的取余函数不同,各自插件实现

select id,name,age from table where (id > ? and ) mod(id, 3) = 0 order by id;

select id,name,age from table where (id > ? and ) mod(id, 3) = 1 order by id;

select id,name,age from table where (id > ? and ) mod(id, 3) = 2 order by id;

• 执行SQL,查询并更新lastRow

• 第一次result查询完后,若脚本中没有配置startlocation,则之前的查询SQL为:

select id,name,age from table where mod(id, 3) = 1 order by id;

将其更新为:

select id,name,age from table where id > ? and mod(id, 3) = 1 order by id;

• CP时获取lastRow中的id值,保存到state中

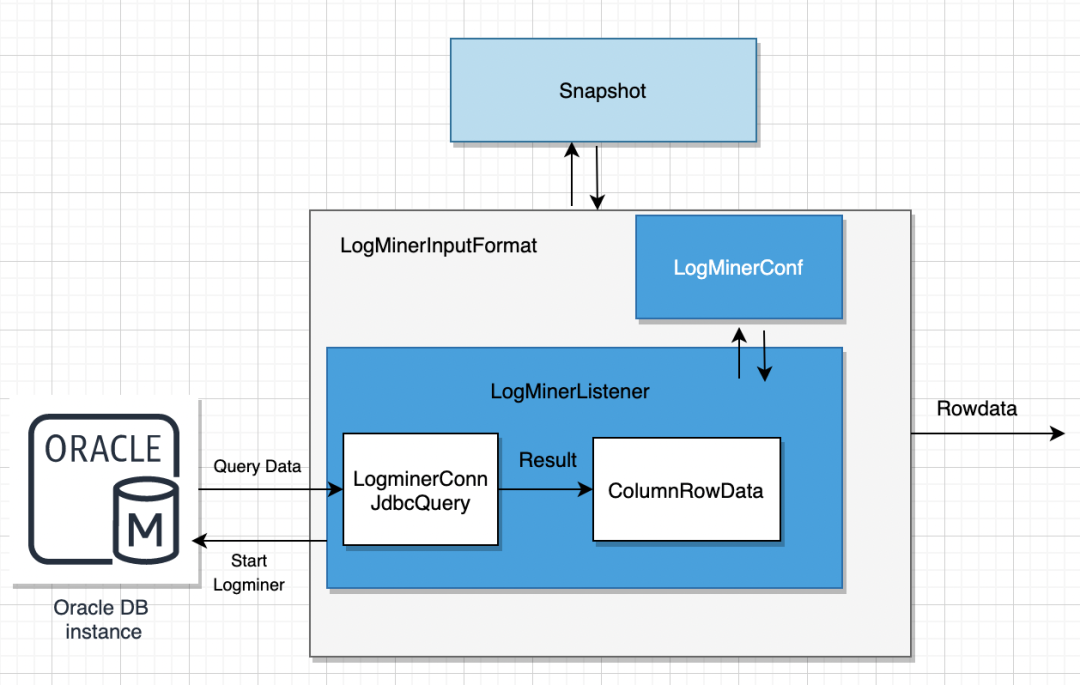

三、实时数据还原上的实现和原理

01 数据还原介绍

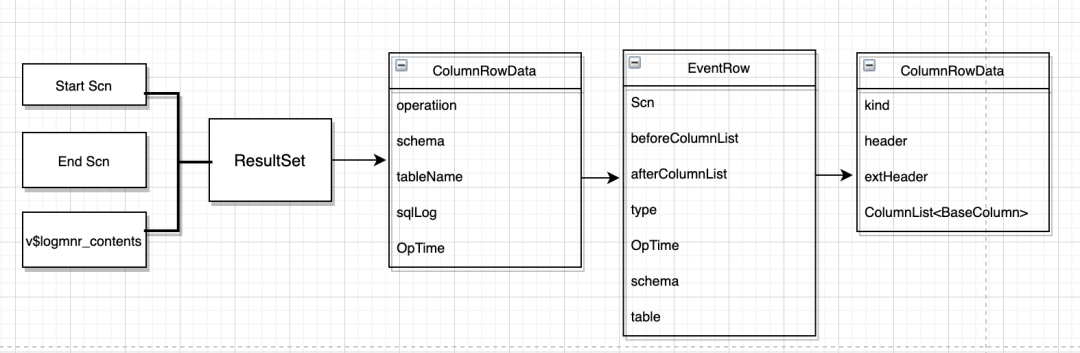

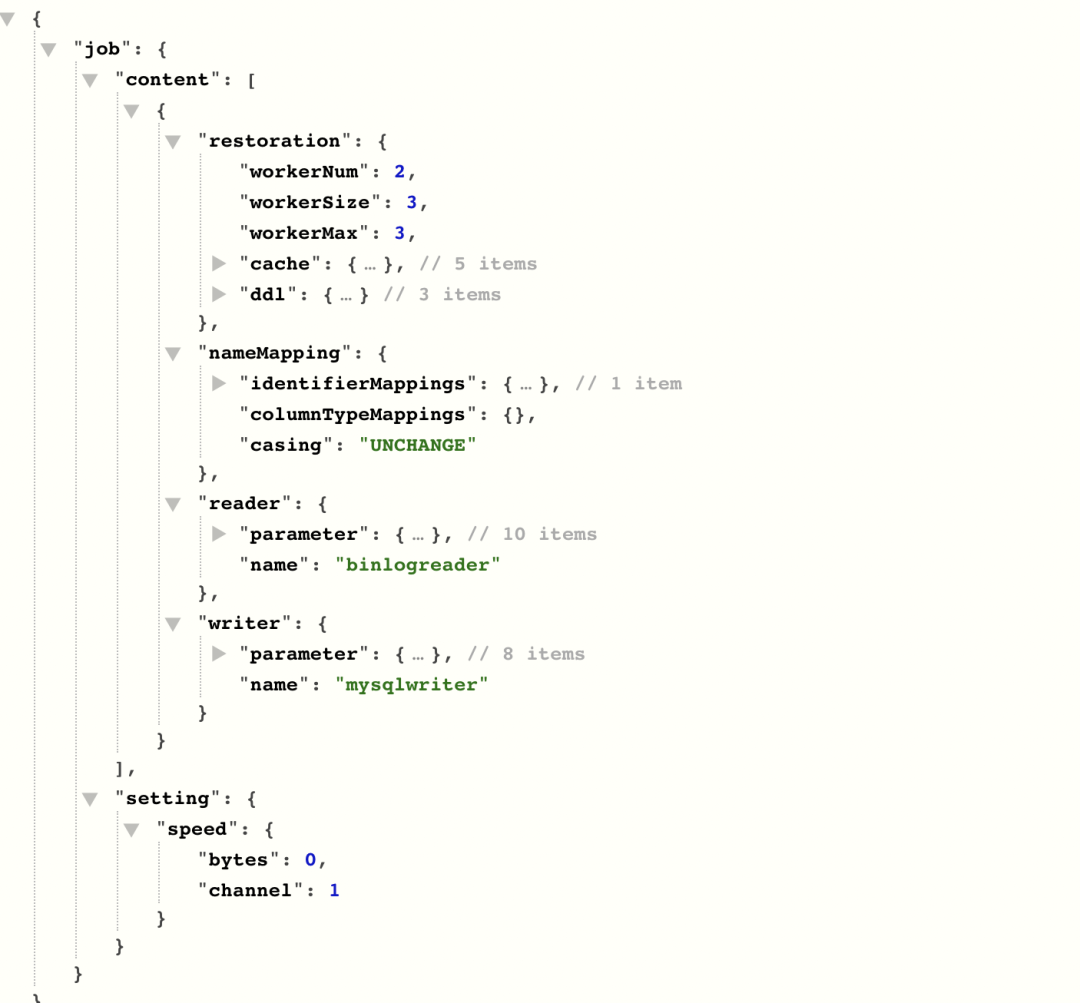

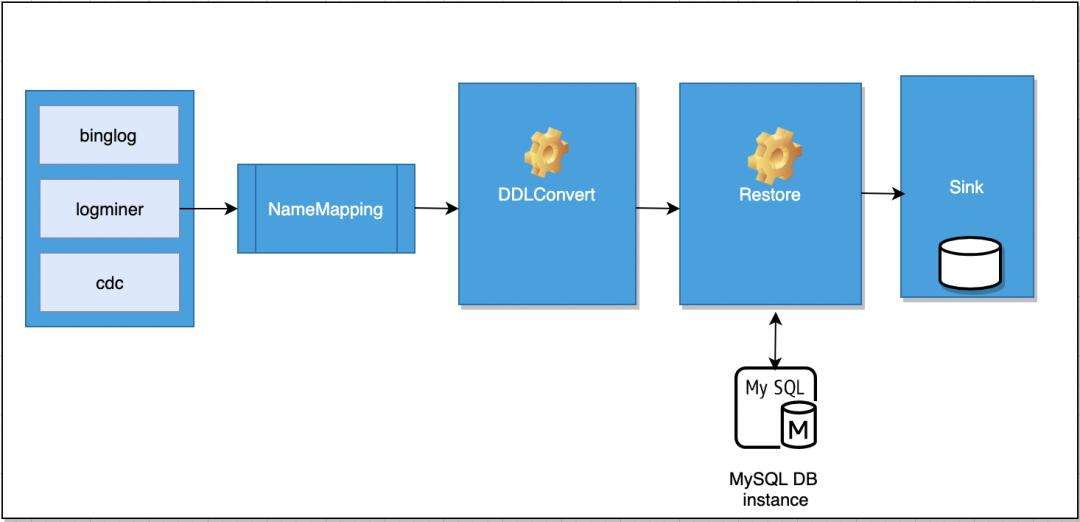

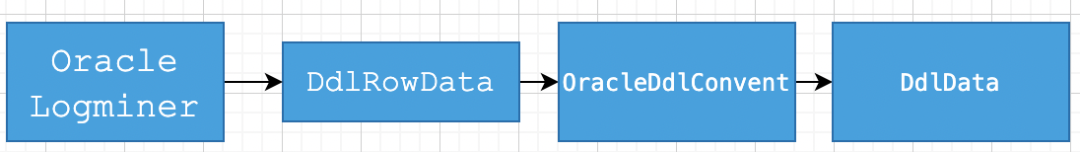

数据还原基于对应的数据库的CDC采集功能,比如上面提到的Oracle Logminer,MySQL binglog,支持将捕获到的数据完整的还原到下游,所以不仅仅包括DML,而且也需要对DDL进行监听,将上游数据源的所有变更行为发送到下游数据库的还原。

难点

· DDL,DML 如何有序的发送到下游

· DDL 语句如何根据下游数据源的特性进行对应的操作(异构数据源间DML 的转换)

· DML 语句中的insert update, delete 如何进行处理

02 一个样例

03 整体流程

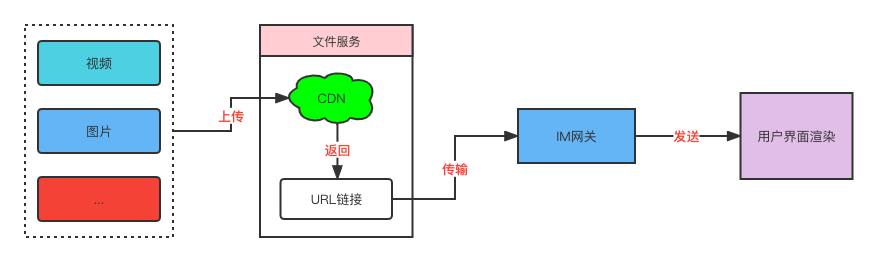

数据从上游的数据源获取之后经过一些列的算子的处理之后按数据在原始表中的顺序准确的还原到目标数据源,完成数据的实时获取链路。

04 DDL解析

数据还原- DDL转换

· 基于Calcite解析数据源DdlSql转为SqlNode

· SqlNode转为中间数据DdlData

· ddlData转为sql:不同语法之间互相转换;不同数据源字段类型互相转换

05 名字映射

在实时还原中,当前上下游表字段对应关系必须是相同的,即上游的database schema table 对应的表只能写入下游database schema table相同的表,同时字段名称也必须是相同的。本次迭代将针对表路径可以进行一个自定义映射以及字段类型进行自定义映射。

• db or schema 转换

• 表名称转换

• 字段名(提供大小写转换),类型隐式转换

06 中间数据缓存

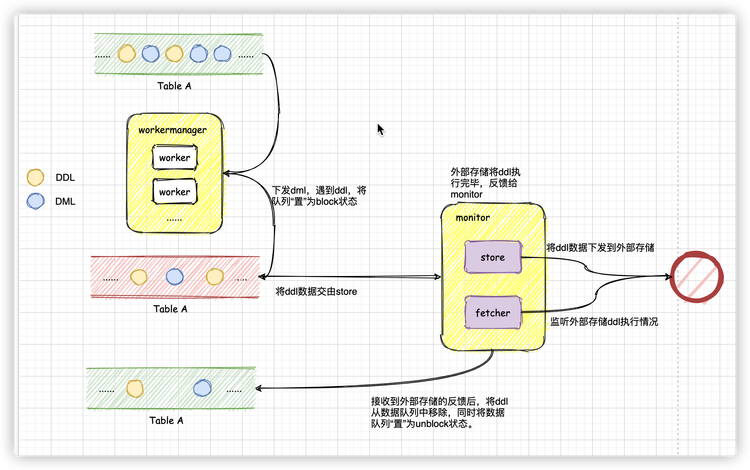

数据(不论ddl还是dml数据)下发到对应表名下的unblock队列中,worker在轮询过程中,处理unblock数据队列中的数据,在遇到ddl数据之后,将数据队列置为block状态,并将队列引用交给store处理。

store在拿到队列引用之后,将队列头部的ddl数据下发到外部存储中,并监听外部存储对ddl的反馈情况(监听工作由store中额外的线程来执行),此时,队列仍然处于block状态。

在收到外部存储的反馈之后,将数据队列头部的ddl数据移除,同时将队列状态回归为unblock状态,队列引用还给worker。

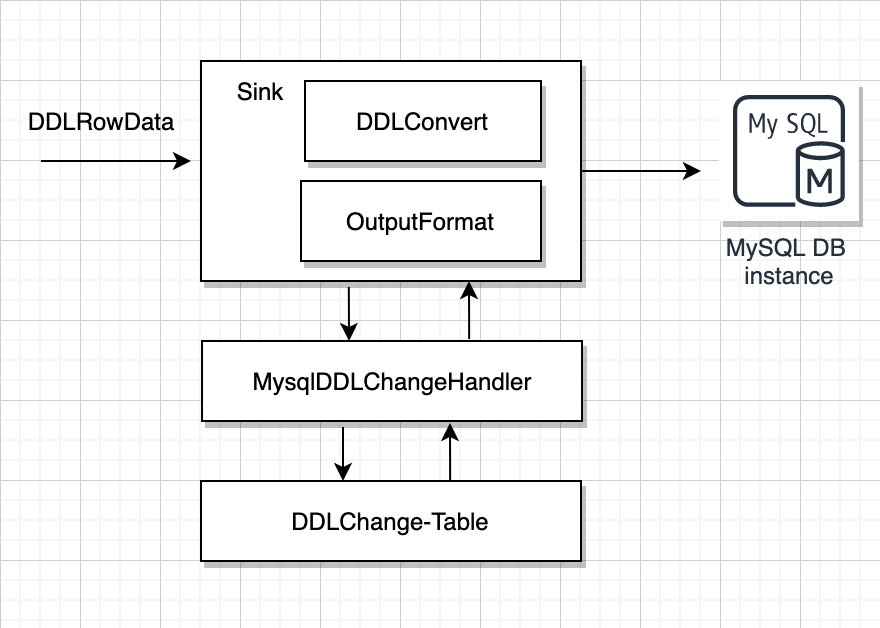

07 目标端接收数据

• 获取到DdlOperator 对象

• 根据目标数据源对应的DDLConvertImpl解析器转换为目标数据源sql

• 执行对应的sql,比如删除表

• 触发调整DDLChange 表,修改对应的DDL 状态

• 中间存储Restore算子,监听状态变更,执行后续数据下发操作

四、ChunJun未来规划

• 提供对Session 进行管理

• 提供restful 服务,ChunJun 本身作为一个服务,便于外围系统进行集成

• 对实时数据还原进行加强,包括扩展支持更多的数据源的DDL 解析

此外,本次分享的全文视频内容也可以随时观看,如果您有兴趣,欢迎前往袋鼠云B站平台观看。

Apache Hadoop Meetup 2022

ChunJun视频回顾:

https://www.bilibili.com/video/BV1sN4y1P7qk/?spm_id_from=333.337.search-card.all.click

袋鼠云开源框架钉钉技术交流群(),欢迎对大数据开源项目有兴趣的同学加入交流最新技术信息,开源项目库地址:https://github.com/DTStack/Taier

不同行业之间,都会存在一些业务属性上的差距。对于金融领域的应用软件来说,因其涉及到钱等因素,所以在业务上会有以下独特属性:

-

稳定性。 金融领域跟钱强相关,这对于业务稳定性就有着非常严格的要求,稳定性一旦出现问题,它将影响整个交易系统的成败。

-

强监管。 强监管一般是针对生物医药领域、医疗领域和金融领域,因为它们所呈现的内容都与人的生命相关。所以,更高层面的强监管要求势必会影响一些业务层面的选型和架构呈现。

-

准确性和有效性。 由于跟钱强相关,所以在数字层面的呈现更是要求零偏差。就像股票价格一样,它的数字呈现都是精确到了每分每秒和固定数位的。

基于以上这些特点,金融行业软件系统在进行系统设计、机房拓扑以及中间件选型时,就会出现一些与其他通用行业不太一样的地方。

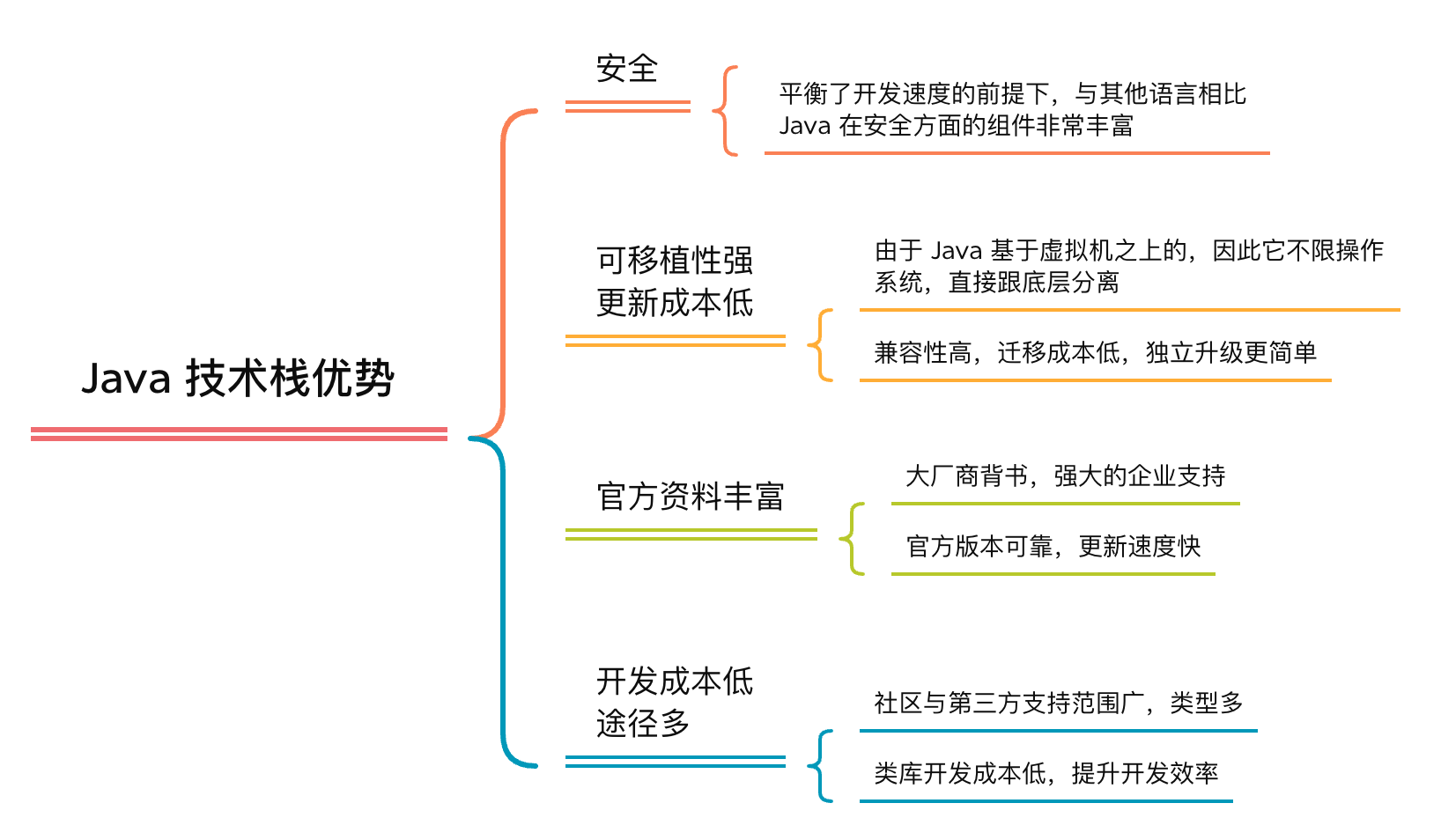

对 Java 的那些爱与恨

金融系统为何独爱 Java

Java 自诞生以来就深受开发者的喜爱。在中国有将近 50% 的开发者在使用 Java 作为开发语言。这不单单是因为其语言的优势,也因为 Java 相关的生态非常庞大,尤其是国内的金融系统很多都是基于 Java 的,这导致有段时间大家都误以为所有的系统都是用 Java 做的。

近 15~20 年以来,大部分金融系统基本都选择了 Java 技术栈,深究其原因,我们认为主要是因为 Java 技术栈有以下几点优势。

正是如此,Java 逐渐得到了金融类软件系统的青睐。

云原生时代下的 Java 现状

随着技术行业的快速发展,单体架构逐渐被淘汰,微服务和云原生时代正在风靡四海。然而在近几年的技术大环境下,作为面向对象的高级语言,Java 也在一些业务场景中开始略显疲惫:

首先,Java 性能较低,这点对比一下 C 语言相关技术栈就会明白。Java 是基于虚拟机,它的内存管理是交给虚拟机来解决的,所以当面对一些高性能或动态变化的业务场景时,Java 语言在处理上没有那么强势。

其次,Java 语言需要更多的资源。一个架构的打造如果不考虑成本,很多问题都很好解决,但在云原生时代下,所有的资源计算变得越来越细、越来越颗粒化。Java 在运作时需要消耗大量的资源,由于 Java 分量重和需要重启的基础特性,因此在高 QPS 或者业务连续性要求较高的场景下,该语言会更容易出现问题。

最后就是指针变量的问题。习惯于写 C/C++ 语言的同学都知道,指针是一个非常好的资源。但 Java 是基于虚拟机,它把内存管理交给了 GC(Garbage Collection),而不是由手动程序进行管理,所以对于一些特定情况或者高并发、高访问量和高性能的场景下,Java 的实际性能可能就略显不足了。

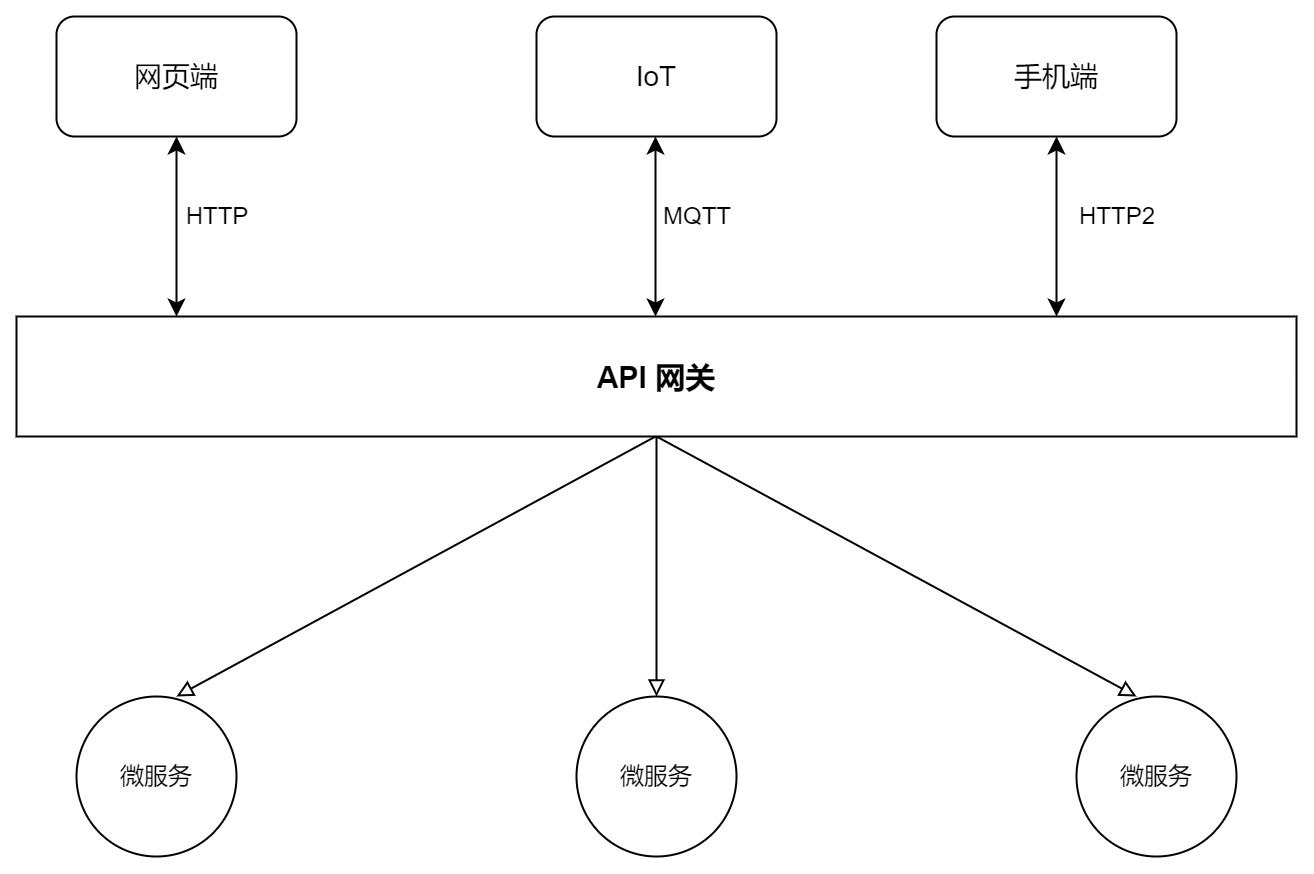

还呗为何选择 APISIX?

数禾科技是一家提供智能化金融的服务平台,旗下主要产品有还呗、还享花等。还呗 APP 是一款基于消费多场景的分期服务平台,通过与持牌金融机构合作,为大众提供个人消费信贷服务,并为小微企业主提供贷款资金支持。在业务架构层面,还呗的产品实现一直是依赖 Java 技术栈的。

Spring Cloud Gateway 是 Spring Cloud 生态下为更好管理微服务而诞生的网关项目,对于公司业务以 Java 为主要开发语言的情况下,Spring Cloud Gateway 通常是个不错的 API 网关选择。但在近期的 API 网关迭代过程中,还呗放弃了使用已久的 Spring Cloud Gateway,而是选择了 Apache APISIX。

架构的前后变化

在架构层面,还呗在使用 APISIX 前后呈现了如下图所示的变化。

在左侧的使用前架构中,还呗一共使用了三套网关系统,并把网关分为入口网关和出口网关两大类。其中在运营系统网关和出口系统网关中,都使用了 Spring Cloud Gateway 作为网关,而在业务系统网关中则使用了 OpenRestry 作为业务系统网关。

对于一开始使用 Spring Cloud Gateway 作为运营和出口系统网关,主要是看中了 Spring Cloud 庞大的生态系统,以及简单易部署和易维护的分布式系统开发框架,所以在早期进行业务架构部署时,为了更快搭建起业务而选择使用 Spring Cloud 全家桶。

但随着业务慢慢发展,原先架构中的网关开始出现一些稳定性的问题,比如内存溢出、CPU 使用率过高等情况。为了升级网关性能及统一多个网关,还呗将架构中的网关全部统一替换为了 Apache APISIX。

在新网关架构中,业务系统网关会优先把请求流量通过服务发现的方式直接转发到业务系统。如果后端应用在 Consul 中没有健康 Pod 或者后端应用不支持服务发现等,就会把流量转发到以前的内网 K8s Ingress,作为兜底的上游来使用。

新架构同时也统一了出口网关的两个应用,新出口网关部署在 K8s 集群外的外联区。同时也在出口网关集群前新增一个 SLB,可以统一出口网关的入口 ,方便没有服务发现能力的应用或者其他 VPC 内的系统调用。

基于 APISIX 的应用实践

实际业务情况下,由于内部已存在多种网关架构,没办法直接使用 Apache APISIX,于是还呗基于 APISIX 进行了一些改造和构建。

APISIX 构建部署

在内部进行开发时,将 APISIX 网关的代码和定制代码存放在不同路径下,两者协同工作,各自可独立迭代。在部署时则采用 Docker 镜像方式部署,构建一个 APISIX 指定版本的基础镜像,然后再把自定义代码打包形成新镜像。

自定义代码打包时没有使用 来指定代码目录,而是直接覆盖基础镜像 源码目录,如果有同名文件则覆盖源码文件。Dockerfile 如下所示:

APISIX 的日志默认存储在本地(也可以通过 Syslog 等插件收集),通过调整 配置模板和判断启用的 Profile 来决定日志存储在本地还是通过 Syslog 存储到 FLUENTD 中。同时在构建镜像时替换模板中 变量。如下所示:

在 配置模板中,还呗不光修改了日志存储,还调整了循环添加 ENV 环境变量、循环添加 lua_shared_dicts 配置及写死一些 NGINX 其他调优参数。

因为公司是按照业务流量划分为多种网关,这些网关的基本功能都差不多,因此还呗内部采取了「一套代码部署多个网关应用」方案。通过 Profile 功能配置各个网关的 config-xxx.yaml 文件,然后通过公司 DEVOPS 平台构建镜像时,根据应用名构建不同网关的 Docker 镜像即可。

公司级定制插件

在内部访问运营系统页面时,会调用很多后端的 API 获取数据,这些 API 都需要在 API 网关中配置对应的白名单。在页面中根据登录运营系统用户的角色不同,能够访问的 API 范围也不一样,因此权限系统也需要维护相关 API 列表。每当在页面上新增后端 API 调用时 ,都需要开发人员在网关页面及权限系统页面配置两次,工作冗余且重复。

为此,还呗把网关配置与权限系统配置打通,只保留权限配置系统的配置入口,网关配置管理系统则定时拉取权限 API,之后转换成网关 API 白名单配置。这样做不仅能减少用户一次配置操作,同时也协助权限系统进行了权限管控。可以保证在运营页面调用的后端 API,一定是在权限系统配置了相关权限。

在公司的实际业务中,经常会遇到原生插件不能满足实际需求的情况,就需要定制开发。好在 APISIX 提供了很多工具类,参照原生插件就可以轻松实现,开发过程也非常简单。以下列举了还呗内部基于 APISIX 进行的其他定制插件:

网关流量灰度

之前还呗使用的 K8s 容器是 OpenShift(现已升级为 ACK 集群),其中 Ingress 是 Haproxy 搭建。由于公网 K8s Ingress 的 Haproxy 不能把一个域名的流量转发到两个 Namespace 的路由中,因此考虑把新网关部署在和老网关相同的 Namespace 下。即域名的路由下挂载多个服务,之后便可以通过路由调整流量比例,控制流量走新网关还是老网关。

具体实施流程如下图所示,在老网关的 Namespace 下新增 c、d 组用于部署新网关,通过路由控制新老网关的流量比例。

Java 层面网关的考虑因素

很多 Java 工程师在微服务架构中都会选择 Spring Cloud,主要是语言绑定,并用类库的方式放在代码里。但是在实践过程中可能会出现升级困难的情况,如果团队是多语言就需要维护多个类库,假设有 10 个版本与 10 种语言,就需要维护 100 个类库。

此时就可以通过代理的方式(即 API 网关)把多版本和多语言的问题轻松解决。那 Java 技术栈公司选择 APISIX 作为 API 网关后都有哪些收益?我们根据还呗的实践经历,从以下两个角度进行了总结。

公司角度

- 功能与性能兼具

还呗在内部使用 4 核虚拟机无插件空跑压测 APISIX 的 QPS 可以达到 80K,很好地解决了 Spring Cloud Gateway 在承接 C 端流量时出现的性能问题,而且在生产环境中发现 APISIX 相较于之前网关性能提升了 30% 以上。

其次,得益于云原生属性,APISIX 在实际的测试中完全可以满足公司的需求,比如认证鉴权、可观测性、服务发现、限流限速以及四层和七层流量转发。而在功能扩展方面,APISIX 也支持了 70 余款插件,大部分的业务可以使用其原生插件,很大程度上减少了开发工作。

- 业务支出成本下降

在使用 APISIX 之前,如果性能出现了瓶颈,公司只能通过不断的增加服务器来解决这个问题,因此相应的硬件成本也会非常的高。

还呗在进行成本计算时发现,使用 APISIX 后,服务器的数量大概减少了 60% 左右。统一技术栈后,业务上也可以很轻松地基于 APISIX 原生框架实现功能的扩展,节省了开发成本,加快了项目上线时间速度。

开发者角度

- 满足业务需求

业务中所使用的软件或技术都应该是为需求而服务。从实际测试结果及调研数据来看,APISIX 的稳定性、可观测性、可扩展性会更好。

软件最终服务于业务。如果业务需要,可以为公司节约资源,那么无论公司的技术栈是什么,都会使用最符合公司业务的组件。

- 降低维护成本

相比之前使用的 OpenResty,APISIX 的学习成本相对较低,维护起来也比较省心。同时,APISIX 丰富的插件简化了一些通用功能的实现与部署,大大节约了项目上线的时间。

同时利用 APISIX 强大的日志和动态调试功能,业务可以很轻松地排查出故障点,从而快速定位、节约时间。

总结:金融业务发展趋势

在过去的十年里,互联网金融从「野蛮生长」开始逐渐向「精耕细作」模式转变,这个转变主要涉及到的就是系统的变革。

在野蛮生长阶段,业务讲究的是效率。为了业务更快速地建设,在基础架构选择的时候,负责人更多是选择自己熟悉的语言架构进行搭建。不同的负责人便会选择使用不同的技术栈,因此留下了很多技术债务。从 2017 年开始,依旧活跃的金融企业或服务公司大多都会面临同样的技术现状,那就是存在多套技术组件。这时就需要进行基础设施的统一。

来到精耕细作阶段,企业就需要对系统进行垂直拆分,由以前的烟囱式拆分成前台、中台及后台等模式。系统到达一个稳定阶段时,就需要把一些东西夯实下来。

而系统建设的根本目的其实就是为了共用。重复性使用越强,系统的运维成本就越低。所以很多公司到了精耕细作阶段,要么是进行系统的垂直拆分,要么就是进行基础组件的下沉,进而控制运维成本。

作为企业来说,成本优先依旧是需要考虑的原则。野蛮生长阶段可能只需要尽快实现业务,而在目前大环境下,预算范围之内肯定是成本优先。这样的话,效率和成本永远只能保住一项。因此在成本有限的情况下,企业就会少谈技术的先进性。技术人员在选型的过程中,就不会考虑当下选择的这个技术对团队有多大冲击、对现有的运维和架构带来多少收益等等,更多是从成本角度考虑。

项目背景

MAUI的出现,赋予了广大Net开发者开发多平台应用的能力,MAUI 是Xamarin.Forms演变而来,但是相比Xamarin性能更好,可扩展性更强,结构更简单。但是MAUI对于平台相关的实现并不完整。所以MASA团队开展了一个实验性项目,意在对微软MAUI的补充和扩展,

项目地址:https://github.com/BlazorComponent/MASA.Blazor/tree/main/src/Masa.Blazor.Maui.Plugin

每个功能都有单独的demo演示项目,考虑到app安装文件体积(虽然MAUI已经集成裁剪功能,但是该功能对于代码本身有影响),届时每一个功能都会以单独的nuget包的形式提供,方便测试,现在项目才刚刚开始,但是相信很快就会有可以交付的内容啦。

前言

本系列文章面向移动开发小白,从零开始进行平台相关功能开发,演示如何参考平台的官方文档使用MAUI技术来开发相应功能。

介绍

之前两篇文章我们实现了安卓蓝牙BLE的相关功能,本文我们将IOS的BLE功能实现一下。 ,考虑到Swift语法对于c#开发人员更友好,本文示例代码参考Swift,相关代码来自苹果开发者官网

https://developer.apple.com/documentation

开发步骤

修改项目

在Masa.Blazor.Maui.Plugin.Bluetooth项目中的Platforms->iOS文件夹下,添加一个部分类MasaMauiBluetoothService,在安卓中有BluetoothManager,在ios中对应的是CBCentralManager,但是不同有安卓还有个适配器Adapter的概念,在ios中关于设备扫描、连接和管理外围设备的对象,都是通过CBCentralManager直接管理的,我们看一下他的初始化方法

delegate:接收中心事件的委托。相当于我们在安装中实现的DevicesCallback

queue:用于调度中心角色事件的调度队列。如果该值为 nil,则中央管理器将使用主队列分派中心角色事件。这个我们可以简单的理解为和安卓的UI线程或者后台线程对应,更详尽的说明请参考 https://developer.apple.com/documentation/dispatch/dispatchqueue

options:配置信息,我们这里只用到了ShowPowerAlert,代表蓝牙设备如果不可用,给用户提示信息。就好比你用了不符合标准的数据线,iphone会给你提示是一个意思。

我们将MasaMauiBluetoothService修改为静态类, 我们自定义的BluetoothDelegate 继承自CBCentralManagerDelegate,篇幅问题我们这里先只重写DiscoveredPeripheral和 UpdatedState,我们这次的演示不需要实现UpdatedState,但是这里的重写必须先放上去,否则调试过程会出现下面的报错

ObjCRuntime.ObjCException: ‘Objective-C exception thrown. Name: NSInvalidArgumentException Reason: -[Masa_Blazor_Maui_Plugin_Bluetooth_MasaMauiBluetoothService_BluetoothDelegate centralManagerDidUpdateState:]: unrecognized selector sent to instance 0x284bfe200

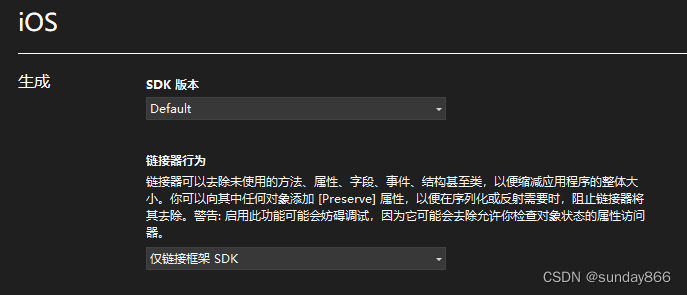

另外有一点需要特别注意,这个UpdatedState方法我没有实现的代码,那么我就需要添加一个[Preserve],这样是为了防止链接器 在生成nuget包的时候把这个方法帮我优化掉。

实现发现附近设备功能,_eventWaitHandle和安卓一样,我这里只是实现了一个异步转同步方便直接通过Devices拿到结果,如果小伙伴不喜欢后期我会添加不阻塞的方式。 这里之所以可以Devices.Contains和Devices.Add是因为我们在BluetoothDevice类中实现了隐式转换 如下是iOS目录下BluetoothDevice.ios.cs的部分代码

ios扫描外围设备是通过scanForPeripherals 我们继续在MasaMauiBluetoothService添加一个扫描附件设备的方法,我们看一下Swift的文档

serviceUUIDs:代表需要过滤的服务UUID,类似安卓的scanFilter对象。 option:提供扫描的选项,我们这里用到了AllowDuplicatesKey,该值指定扫描是否应在不重复筛选的情况下运行 我们参照实现以下我们的PlatformScanForDevices方法

通过 _cbCentralManager.IsScanning来判断是否处于扫描状态,如果没有,那就就通过ScanForPeripherals扫描外围设备,扫描5秒之后(BluetoothDelegate 内部控制)通过StopScan停止扫描,并通过 _discoveredDevices 保存结果。 我们还需实现PlatformIsEnabledIsEnabled和PlatformCheckAndRequestBluetoothPermission方法,用来在扫描之前检查蓝牙是否可用并且已经经过用户授权

在PlatformIsEnabledIsEnabled方法中通过 _cbCentralManager.State == CBManagerState.PoweredOn 来判断蓝牙是否可用。该状态一共有如下枚举,从字面意思很好理解 Unknown, //手机没有识别到蓝牙 Resetting, //手机蓝牙已断开连接 Unsupported, //手机蓝牙功能没有权限 Unauthorized, //手机蓝牙功能没有权限 PoweredOff,//手机蓝牙功能关闭 PoweredOn //蓝牙开启且可用

权限检查这里和安卓有一些区别,在重写的RequiredInfoPlistKeys方法中指定了需要检查的蓝牙权限,BasePlatformPermission的EnsureDeclared方法用来检查是否在Info.plist文件添加了需要的权限,GetBleStatus方法通过 _cbCentralManager 的状态,来检查授权情况。

我们在Masa.Blazor.Maui.Plugin.Bluetooth的根目录添加部分类MasaMauiBluetoothService.cs,向使用者提供ScanForDevicesAsync等方法,方法内部通过PlatformScanForDevices来调用具体平台的实现。

使用

右键Masa.Blazor.Maui.Plugin.Bluetooth项目,打包,生成一个nuget包,在Masa.Blazor.Maui.Plugin.BlueToothSample项目中离线安装即可,代码的使用与安卓完全一样,只是权限配置方式不同 在Masa.Blazor.Maui.Plugin.BlueToothSample项目的Platforms->iOS->Info.plist中添加蓝牙相关权限

NSBluetoothAlwaysUsageDescription对应iOS 13以上版本,对于iOS 13之前的版本,需要将NSBluetoothAlwaysUsageDescription和NSBluetoothPeripheralUsageDescription同时添加。

蓝牙扫描的效果和安卓机是完全一样的,这里就不展示了。[前文详情]

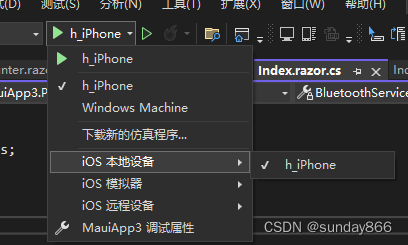

iOS调试及错误排查

目前在windows的vs环境调试MAUI的ios程序,是不需要mac电脑支持的,数据线连上后会显示一个本地设备,但是你仍然需要一个开发者账号,vs会调用apple开发者api自动帮你配置好需要的证书。

1、如果没有显示检查Xamarin->iOS设置,热重启是否开启

2、调试过程如果提示类似 Could not find executable for C:UsersxxxAppDataLocalTemphbjayi2h.ydn 找不到文件的情况,右键选择清理项目即可,如果无法解决手动删除bin和obj目录重试

3、调试过程如果app无故退出,排查一下考虑APP的启动和调试断点时间,iOS要求所有方法必须在17秒之内返回,否则iOS系统将停止该应用

4、调试过程出现Deploy Error: An Lockdown error occurred. The error code was “MuxError”的错误,请检查你的数据线,重新插拔或者更换原装线。

本文到此结束。

如果你对我们MASA感兴趣,无论是代码贡献、使用、提 Issue,欢迎联系我们

- WeChat:MasaStackTechOps

- :

一、引言

Presto是开源分布式SQL查询引擎,可以对从GB到PB级大小的数据源进行交互式分析查询。Presto支持Hive、Cassandra、关系型数据库甚至专有数据存储等多种数据源,允许跨源查询。(详见参考[1] )

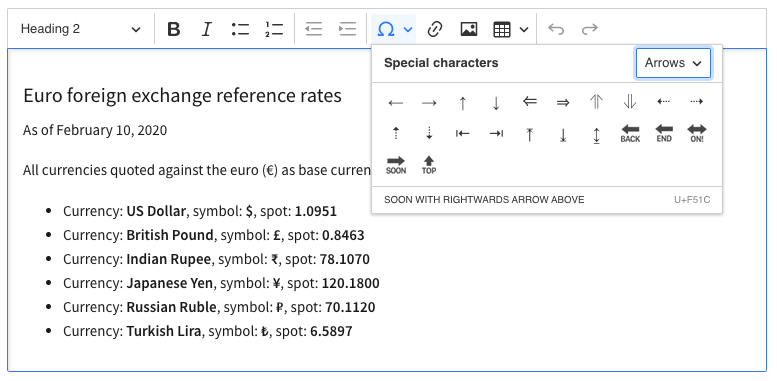

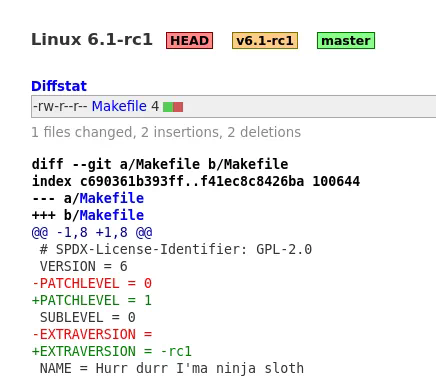

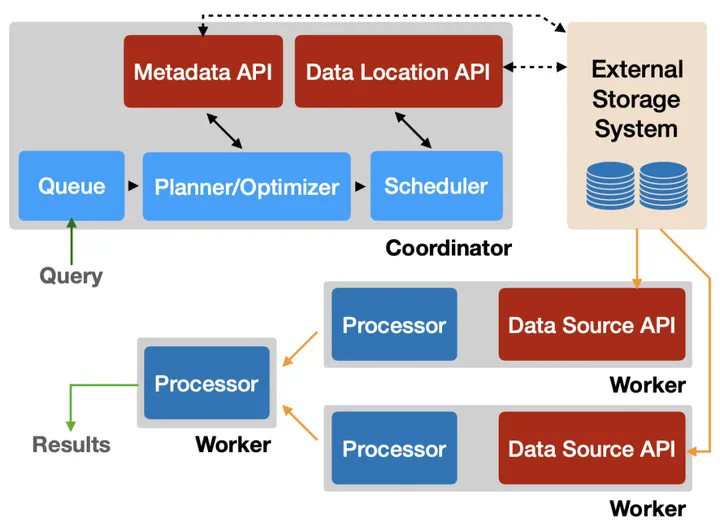

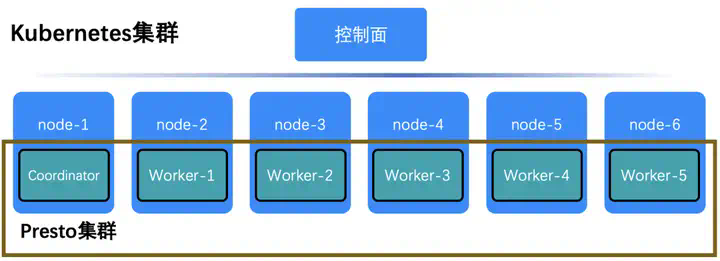

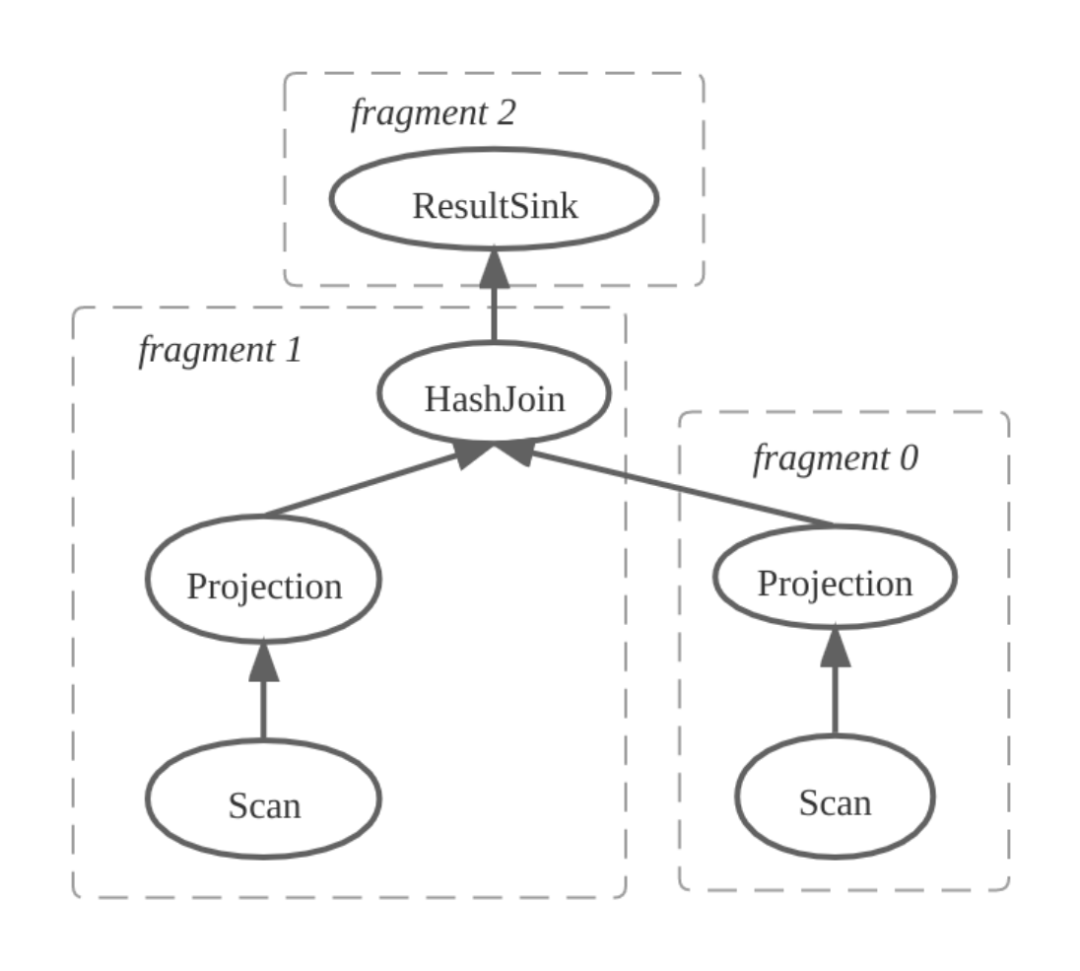

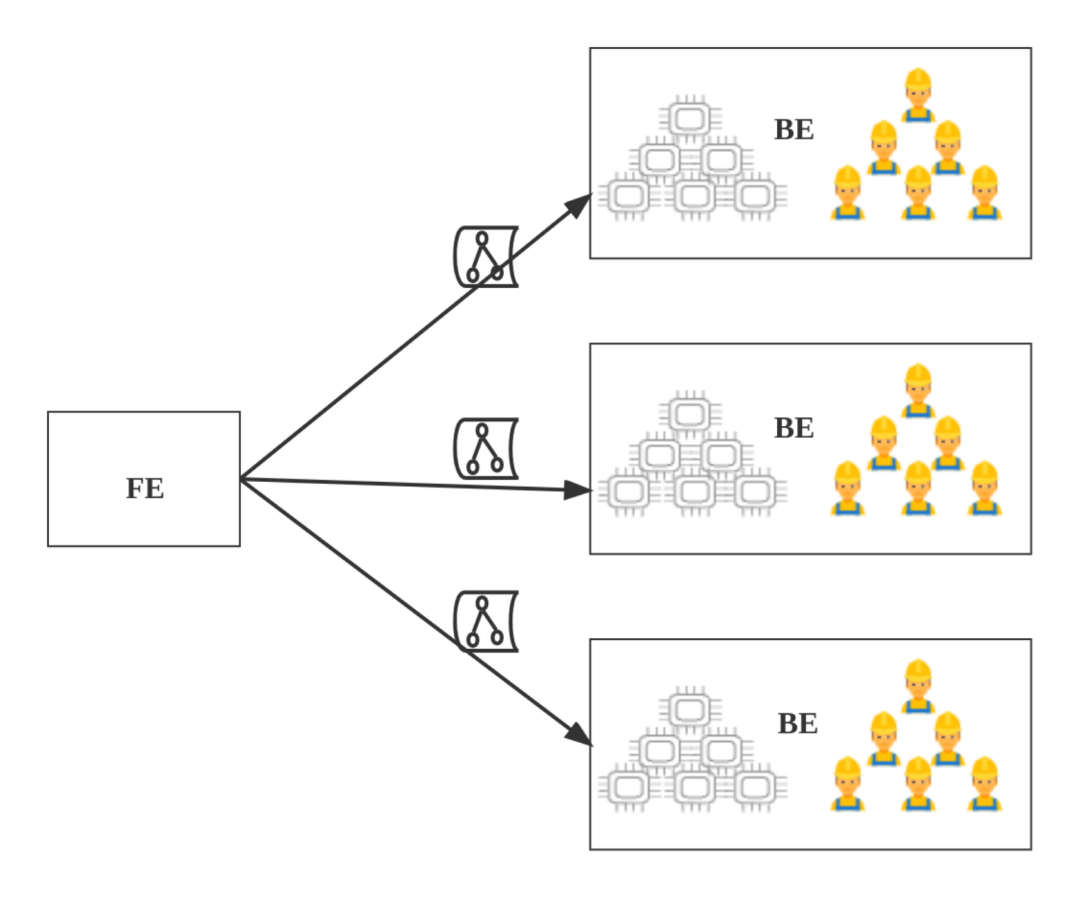

图1 Presto层次架构图(图源Presto官网)

无处不在的Presto

当今大规模的互联网公司都在使用Presto。

Uber将Presto用于SQL数据湖,每周有超过7000名活跃用户,每天在超过50PB 的HDFS(Hadoop Distributed File System)数据上运行50万次查询。

字节跳动对Presto 进行了广泛的应用,例如数据仓库、BI 工具、广告等。字节跳动的 Presto 集群拥有上万个计算核心,每天处理约 100 万次查询,涵盖 90% 以上的交互式查询。这极大地减少了查询延迟并节省了大量计算资源。

Meta公司(Facebook)使用 Presto 对多个内部数据存储进行交互式查询,包括300PB 数据湖。每天有超过 1,000 名 Facebook 员工使用 Presto 运行 30,000 多个查询,平均每个查询扫描超过 1 PB。

腾讯将Presto 应用于内部的不同业务场景,包括微信支付、、游戏等关键业务。日均处理数据量 PB 级,P90 查询耗时为 50s,全面提升各业务数据实时分析性能,有效助力业务增长。

阿里数据湖分析集成了Presto的联合查询引擎能力,不仅让阿里云众多用户体验了大规模的 Serverless 云服务,也积累了许多成功的业务用例,比如日志数据分析和基因数据分析等,这些案例表明了Presto应用广泛,分析能力强大。

图2 各大互联网公司Presto性能展示数据部分来源Presto官网

Presto系统架构

Presto 集群由一个Coordinator和一个或多个Worker组成。Coordinator负责接纳、解析、规划和优化查询以及查询编排,Worker负责查询处理。Presto通过Connector适应底层不同类型的数据源,以便访问各种数据源中的数据。如图3显示了 Presto 架构的简化视图(详见参考[2] )。

图3 Presto 架构图

传统方式部署Presto存在的问题

作为一个分布式架构的系统,Presto为数据查询和处理提供了高效便捷的方法。随着数据量增大,为了保证数据查询处理的效率,Presto集群规模也要扩大。例如上文提到的Uber、字节跳动和Meta等公司每天查询的数据量是PB级别,一个Presto集群的节点数量已经上千。当数据量远超单机处理能力时,分布式架构相比于集中式架构的优势就体现出来了,但是对于一个规模庞大的分布式集群,持续高效地处理数据,将会面临一系列的问题:

- 对于一个规模庞大、节点数量上千的Presto集群,如果没有自动化部署工具,采用传统方式一个一个部署Presto节点,耗费的时间是难以想象的。此外对于部署好的Presto集群根据业务进行调优,需要不断修改Presto节点的配置信息,按照传统方式逐个修改配置信息,耗费的人力和时间成本也是难以忍受的。

2. 传统部署Presto集群,当其中某个节点发生故障时,无法做到自动重启或者动态加入新的节点以维持集群数量,此时如果正好发生故障的是Coordinator节点,则整个集群将陷入瘫痪,导致服务不可用。

3. Presto主要应用场景是即席查询,比如Uber和滴滴等网约车公司,查询业务高峰时段主要在白天,晚上基本没有查询。如果晚上闲置的资源不能加以回收利用,将会产生很大的资源浪费。此外,当业务高峰期的查询负载超过当前集群的承载能力时,如果不对集群立刻按需扩容,也会对业务产生很大的影响。

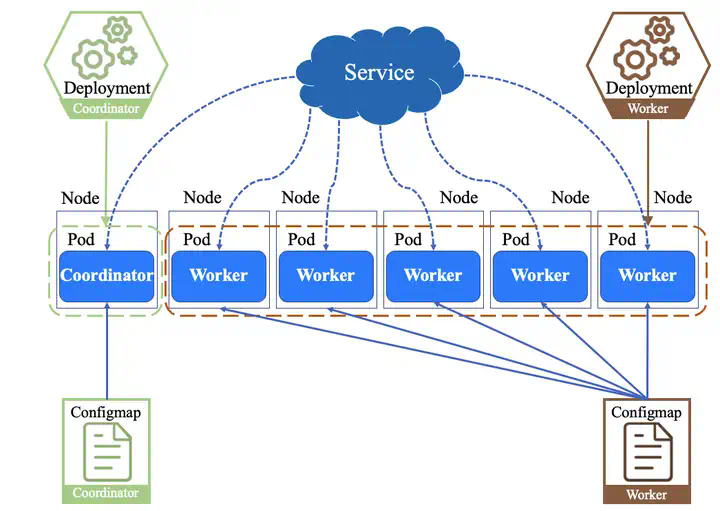

使用Kubernetes部署Presto集群,将云原生与Presto相结合,借助Kubernetes便捷部署、自动化运维和弹性伸缩等优点,解决上述提到的一系列问题。

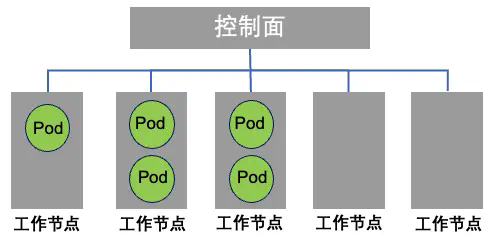

二、使用Kubernetes部署Presto

Kubernetes,也被称为K8s,是一个用于自动化部署、扩展和管理容器化应用程序的开源系统,目前已被业界广泛接受并得到了大规模的应用。Kubernetes集群由控制平面和node组成。其中node上运行由Kubernetes所管理的容器化应用,也就是Pod。控制平面管理集群中的node和Pod,为集群提供故障转移和高可用性,而集群也会跨多个主机运行(详见参考[3] )。

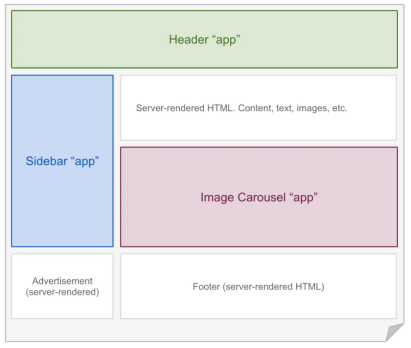

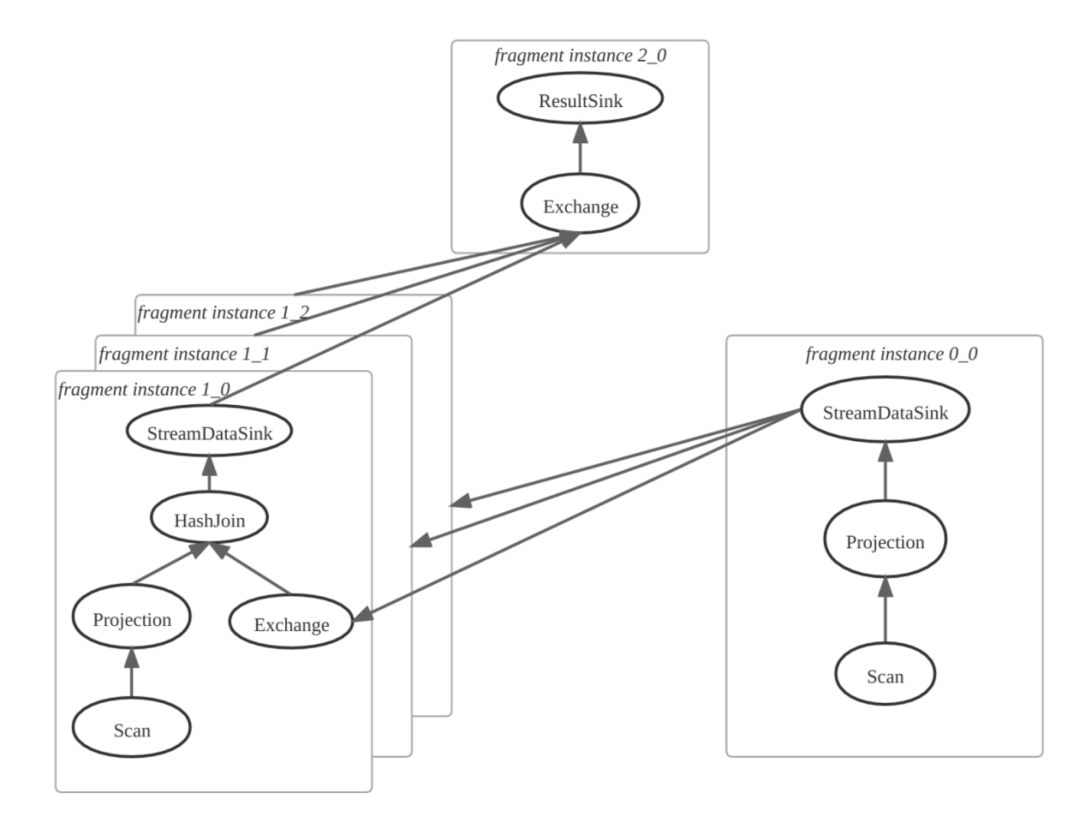

图4 Kubernetes部署Presto集群方案

如图4所示为本次测试所部署方案,Deployment负责创建、更新、维护其所管理的所有Pods。Presto Coordinator和Worker进程分别运行在Pod中,针对Presto集群内Coordinator和Worker分别配置不同类型的Deployment来进行管理。Deployment可以保证集群内可用Pod的数量,实现弹性伸缩,维持集群可用性和稳定性。

Configmap用来存储配置文件,Coordinator和Worker的配置信息分别通过Configmap进行存储,每次进行配置更改,只需要修改Configmap里面的配置信息,Coordinator和Worker就会更新相应的配置信息。

Service会对同一个服务的多个Pod进行聚合,向集群提供一个统一的入口地址,通过访问Service的入口地址就能访问到后面的Pod服务,实现负载均衡和服务发现。在Kubernetes部署的Presto集群中,Coordinator将自己的地址注册到Service,Worker通过Service中的域名地址与Coordinator连接,从而实现Presto集群的服务注册与发现。

在Kubernetes部署Presto方案中,Deployment负责创建和管理Pods,Configmap负责存储配置信息,Service负责服务注册与发现。Deployment、Configmap和Service三类资源相互配合,保证了Presto集群持续高效工作。

Kubernetes部署方案的优点

通过合理设置Deployment、Configmap和Service等资源对象,使用Kubernetes部署Presto集群,将Kubernetes的运营优势与Presto技术优势相结合:

便捷部署:在Deployment中设置Coordinator和Worker的副本数量,Configmap设置配置信息,Service设置Presto集群提供服务的入口地址。将上述三类资源对象提交到Kubernetes中即可完成Presto集群配置,比如设置Worker副本数量为1000,提交之后即可创建1000个Worker Pod,每一个节点的配置信息从Configmap文件中读取。只需要编写好资源对象文件,提交到Kubernetes,即可创建Presto集群,后续可以通过修改Configmap文件更新各个节点的配置信息。通过Kubernetes部署Presto集群减轻了配置、部署、管理和监控容器化Presto应用程序的负担和复杂性。

自动化运维:可以更方便地和Prometheus结合,通过Prometheus可以实现对整个集群的监控数据采集、存储、分析以及可视化。有效监控Presto集群,当发生故障时可以针对性修复,从而维持集群稳定,保证高可用性。

弹性伸缩:当业务量激增,自动扩容Presto Worker节点,满足业务需求;当业务量处于低谷,自动缩容Presto Worker节点,节省运行成本。

Kubernetes部署方案的问题

传统方式部署Presto集群是以物理机的方式运行,相比之下,在Kubernetes上部署Presto集群是以容器的方式运行。尽管Kubernetes部署方式带来了很多优点,但是容器方式和物理机方式的性能差异仍然未知,下面的测试将重点对比分析两种不同部署方式的性能差异。

三、对比测试评估

测试介绍

基准测试的目的是比较物理机的 Presto 集群和部署在 Kubernetes 的 Presto 集群的性能差异。因此,测试方案分为物理机方案和Kubernetes方案。Presto 物理机集群的结构是1个Coordinator和5个Worker;Kubernetes集群是在6个node之间分配了1个Coordinator和5个Worker。在物理机集群中,用户直接通过Presto客户端向Coordinator发起查询请求,Coordinator将任务分配给Worker;如图5所示,在Kubernetes集群中,首先利用6个node部署Presto集群,Presto客户端向Kubernetes中的Coordinator发起SQL查询,Coordinator将任务分配给Worker。

图5 基准测试系统架构图

TPC-DS

沿用目前业内的普遍测评方法,本次测试采用TPC-DS 作为benchmark,它在多个普遍适用的商业场景基础上进行了建模,包括查询和数据维护等场景(详见参考[4] ),同时提供了一系列能够代表系统性能的评估指标。简单来说,TPC-DS使用了一个真实的商品零售业务场景来测试系统性能。它构建了一个大型跨国零售公司的业务模型,模型里不仅包含了多家专卖店,同时还包含了线上销售业务,以及库存管理系统和促销系统(详见参考[5] )。由于TPC-DS是以真实场景为原型,在业内能够起到比较好的测评效果,从而成为了当前SQL引擎测试最常用的benchmark(详见参考[6] )。

集群配置

四、测试结果

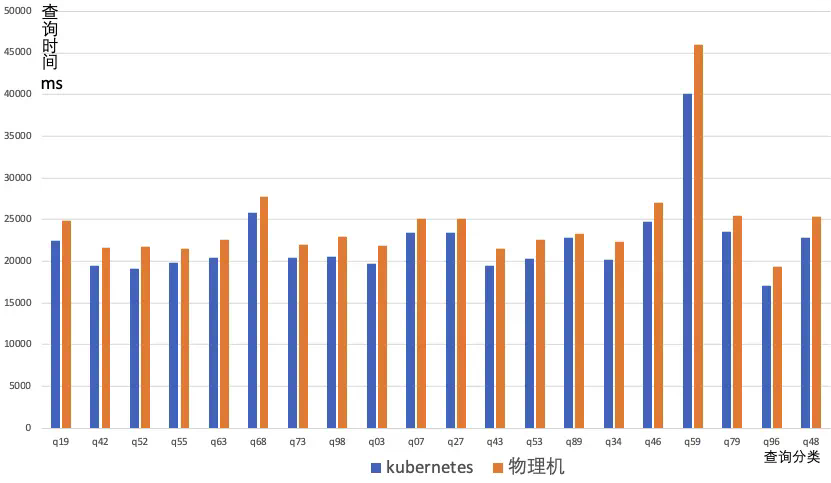

为了保证本次测试的结果具有更加广泛的意义,分别选取了TPC-DS不同的查询类型进行测试,包括即席查询、报告查询和迭代OLAP查询三种类型:

即席查询:这类查询主要的应用场景是通过查询来回答即时和特定的业务问题。即席查询和报告查询之间的主要区别在于系统管理员在规划即席查询时可用的预知程度有限。图表中为q19, q42, q52, q55, q63, q68, q73, q98。

报告查询:定期执行的查询,这类查询主要是定期获取到有关企业财务和运营状况。图表中为q3, q7, q27, q43, q53, q89。

迭代OLAP查询:OLAP 查询通常用于探索和分析业务数据以发现新的和有意义的关联关系和趋势。图表中为q34, q46, q59, q79, q96, q48。

图6 Kubernetes VS 物理机查询时间对比图

如图6所示,纵坐标为查询时间,单位是毫秒;横坐标为查询任务分类,图表中所显示的每个查询任务的时间实际为4次查询时间的平均值。可以看出,在不同的查询分类中,Kubernetes部署的Presto集群的平均查询时间稍微短于物理机部署,两者时间差基本保持在几秒之间,考虑到本次测试环境部署在云服务器上,不同时段使用云服务器,性能会有不同程度的偏差,几秒之间的性能波动是可以容忍的。排除本次测试使用的云服务器产生的波动,可以说明Kubernetes部署与物理机部署在性能和效率上几乎相差无几。所以针对不同类型的查询,Kubernetes部署的Presto集群相比物理机部署在查询速度上并没有损耗,性能与效率几乎没有损失。

五、结论

Kubernetes部署Presto集群的方案减轻了配置、部署、管理和监控容器化Presto应用程序的负担和复杂性。实现了Presto集群的自动配置以及工作节点自动扩展,保证了Presto Coordinator的高可用,通过与Prometheus集成可以更好地实现集群监控。在Kubernetes上部署Presto集群将这两种技术的架构优势和运维优势结合在一起,相比于传统方案,在没有性能损耗的情况下,实现了对Presto集群的动态扩展、便捷部署管理和稳定维护。

六、问题排查

在性能对比测试的过程中,并非一帆风顺,前期测试中出现了一些问题,导致Kubernetes部署的Presto集群性能无法完全释放,与物理机部署的Presto集群性能相差很多。现将测试过程中遇到的一系列问题以及相应的解决方法单开一节进行总结,方便读者在实际部署过程中遇到类似问题时可以得到借鉴与参考。

节点分配不均

Kubernetes 部署 Presto Pod(Master 或 Worker)时,如果使用了Deployment而非DaemonSet进行部署,会集中在几台物理机上(多个 Presto Pod 会同时运行在一台物理机上),有些物理机没有 Pod 运行。

图7 Presto Pod 分布情况

解决方法:出现这种现象的原因是 Presto Pod 所需的 CPU 和内存远远小于主机的上限,因此可以在一台物理机上运行多个 Presto Pod。造成的影响包括同一主机中的Pod互相抢占资源,导致效率下降,以及部分主机(没有Presto Pod)闲置,造成资源浪费。解决方案是可以通过resources requests 和 limits 合理设置 Presto Pod 运行所需的资源,使其均匀分布到各个主机上。

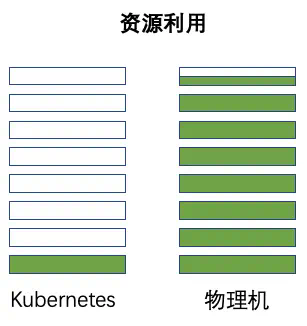

资源利用率过低

与物理机相比,Kubernetes 部署的 Presto 无法使用所有 CPU,只使用一个 CPU 核,每个节点的吞吐量有限,导致查询时间明显变慢。

图8 Kubernetes vs 物理机资源利用情况

解决方法:出现这种现象的原因是没有设置Presto Pod调用主机资源的最大限制。最大限制可能是默认值,无法达到主机的理想资源配额。影响是 Presto Pod 使用的资源严重受限,导致查询任务执行效率低下。解决的办法是合理设置 Presto Pod 可以调用的宿主机的最大资源限制。

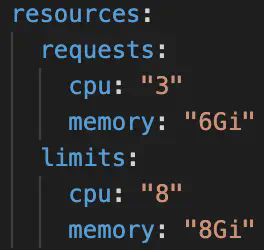

针对上述两个问题,在Kubernetes中采用requests和limits两种限制类型来对资源进行容器粒度的分配。这 2 个参数是通过每个容器 containerSpec 的 resources 字段进行设置的。requests定义了对应容器需要的最小资源量。limits定义了这个容器最大可以消耗的资源上限,防止过量消耗资源导致资源短缺甚至宕机。设置为 0 表示对使用的资源不做限制。如下图所示,设置request的cpu为3,memory为6Gi,这样保证一个pod运行在一个节点上,解决了Pod在节点上分配不均的问题;设置limit的cpu为8,memory为8Gi,为节点的最大资源配置,解决了性能受限的问题,同时也避免了使用资源超过节点最大资源引起的Pod崩溃重启问题。

图9 资源配置

Presto性能如何调优

解决方法:对于Kubernetes部署集群,需要设置CpuCoreRequests、CpuCoreLimits、MemoryRequests和MemoryLimits。CpuCoreLimits 和 MemoryLimits 需要设置为宿主机配置的最大值,这样在执行任务时就不会受到限制。在此基础上,在Presto应用层面还需要设置一个合理的 query.max-memory-per-node。query.max-memory-per-node:查询可以在任何一台机器上使用的最大用户内存量,如果不进行设置,默认值为jvm * 0.1。在本次测试中,如果单个查询在节点上的使用内存最大值过小,会导致查询无法完成,建议将内存值设置足够大,以避免查询失败的情况。

七、参考

[1]

https://prestodb.io/

[2] R. Sethi et al., “Presto: SQL on Everything,” 2019 IEEE 35th International Conference on Data Engineering (ICDE), 2019, pp. 1802-1813, doi: 10.1109/ICDE.2019.00196.

[3]

https://kubernetes.io/

[4]

https://www.tpc.org/tpcds/

[5]

https://zhuanlan.zhihu.com/p/46

[6]

https://bbs.huaweicloud.com/blogs/

想要获取更多有趣有料的【活动信息】【技术文章】【大咖观点】,请关注[Alluxio智库]:

现如今,手机录屏是必不可少的能力之一。对于游戏领域作者来说,在平时直播玩游戏、制作攻略、操作集锦时,不方便切屏,这时在游戏内如果有一个录制按钮就可以随时开启,记录下每个精彩瞬间,减少后期剪辑工作量;在直播App中开启一键录屏,不光方便主播后续的账号运营与复盘,用户也能随时截取有意思的片段传播在社交媒体上;在会议App里,通常因为要点太多而来不及记录,此时录屏按钮,后续再进行会议的回顾、总结与摘要就十分便利;在上网课时,用户可以直接在课程页面录屏,方便及时学习和批注;和亲朋好友视频聊天,也可在社交App里直接录制,记录下每个相见的时光。

那么,如何在App里集成录屏能力呢?HMS Core视频编辑服务屏幕录制SDK提供全屏录制手机桌面、实时录音、后台录制等能力,集成简单,支持自定义录屏通知、多分辨率选择、多存储路径选择等,无需切屏,助力游戏、直播等App快速、轻松实现录屏功能。

功能特点

30行代码就可以简单集成;

支持自定义通知栏样式;

支持横竖屏切换;

支持多分辨率选择;

录屏结束后,支持自定义存储位置。

Demo

开发步骤

1.开发准备

详细准备步骤可参考华为开发者联盟官网。

2. 集成屏幕录制

- 创建屏幕录制事件监听器HVERecordListener实例,重写监听器的方法。

- 使用应用上下文和HVERecordListener实例,初始化HVERecord。

3.(可选)创建HVERecordConfiguration.Builder实例,设置录屏配置。

- 自定义录屏通知。在自定义录屏通知前,先创建用来指定通知布局的XML文件。XML文件需包含按钮等通知组件的ID。以下为指定录屏通知布局的XML文件使用示例。将自定义录屏通知的按钮对应ID命名为“btn_1”。可根据实际需要决定通知中的按钮数量。

a. 将自定义通知布局传入HVENotificationConfig的初始化方法。

b. 使用XML文件中定义的按钮、textView等组件的ID及事件。调用addClickEvent可新建事件。

c. 调用setDurationViewId设置textView ID,用来指定录屏时长显示位置。

d. 调用setCallingIntent设置录屏通知时返回的intent。在示例中,intent用来打开一个Activity,这是intent的常见用法。

e. 在HVERecord中设置通知配置。

- 开始录屏。

- 停止录屏。

了解更多详情>>

访问华为开发者联盟官网

获取开发指导文档

华为移动服务开源仓库地址:GitHub、Gitee

关注我们,第一时间了解 HMS Core 最新技术资讯~

作者:伝迹 谦言 夕陌 临在

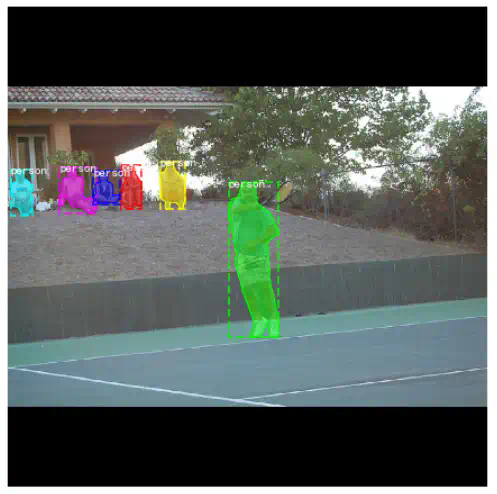

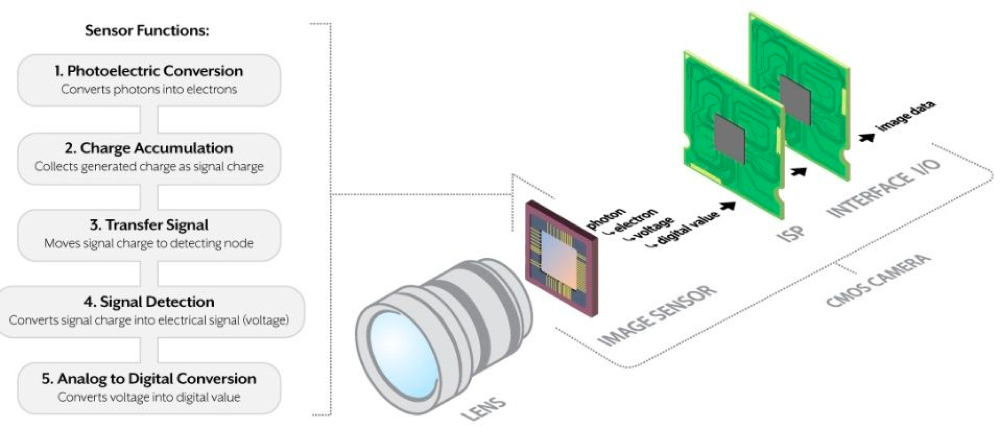

在人工智能广泛应用的今天,深度学习技术已经在各行各业起到了重要的作用。在计算机视觉领域,深度学习技术在大多数场景已经替代了传统视觉方法。如果说深度学习是一项重要的生产工具,那么数据就是不可或缺的生产资料,巧妇难为无米之炊,数据对于视觉模型生产起到了至关重要的作用。

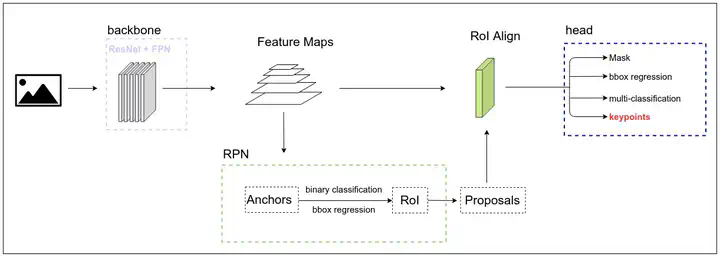

EasyCV是阿里云机器学习平台团队开源的基于Pytorch的all-in-one视觉算法建模工具,搭建了丰富完善的自监督算法体系,提供了效果SOTA的视觉Transformer预训练模型,modelzoo覆盖图像自监督训练、图像分类、度量学习、物体检测、实例分割、语义分割、关键点检测等领域。

EasyCV提供了不同数据源(data_source)的抽象,支持直接读取多种开源数据集格式例如Cifar、ImageNet、CoCo等,同时也支持PAI智能标注平台Itag标注格式和Tfrecord格式数据。 TFrecord格式数据支持使用DALI进行数据处理加速,Itag标注格式图片支持通过缓存机制加速数据读取。

为了方便EasyCV的用户进行模型指标复现、在实际场景训练使用模型,EasyCV汇总了不同领域的常用数据集的介绍和下载地址,当前涵盖图像分类、目标检测、图像分割、姿态估计等方向, 并针对较大且常用的数据集例如imagenet在原许可证允许的情况下提供了国内网盘地址,方便用户快速下载数据集进行论文指标对齐、模型效果对比、以及实际场景下的模型训练。

主要数据集介绍

下面按领域介绍一下EasyCV当前整理提供的数据集, 其中加粗部分的数据集可以通过网盘链接下载。

datahub的使用细节可参考:https://github.com/alibaba/EasyCV/blob/master/docs/source/data_hub.md

图像分类

数据集汇总: ImageNet1K、ImageNet21K、Cifar10、Cifar100、MNIST、Fashion-MNIST、Flower102、Caltech101、Caltech256

ImageNet

官网链接:https://image-net.org/download.php

网盘链接:

ImageNet1k https://sigusoft.com/s/13pKw0bJbr-jbymQMd_YXzA 提取码:0zas

ImageNet1k TFrecord https://sigusoft.com/s/153SY2dp02vEY9K6-O5U1UA 提取码:5zdc

ImageNet21k https://sigusoft.com/s/1eJVPCfS814cDCt3-lVHgmA 提取码:kaeg

ImageNet是市场上最大、最受欢迎的开源数据集之一。ImageNet拥有超过1400万张已手动标注的图像。数据库按WordNet层次结构予以组织,对象级标注通过边界框完成。

目标检测

数据集汇总:COCO2017、VOC2007、VOC2012、LVIS、Cityscapes、Object365、CrowdHuman、OpenImages、WIDER FACE、DeepFashion、Fruit Images、Oxford-IIIT Pet、Arthropod Taxonomy Orders、African Wildlife、AI-TOD航空图、TinyPerson、WiderPerson、Caltech Pedestrian Dataset、DOTA

COCO2017

官网链接:https://cocodataset.org/#home

网盘链接:https://sigusoft.com/s/14rO11v1VAgdswRDqPVJjMA 提取码:bcmm

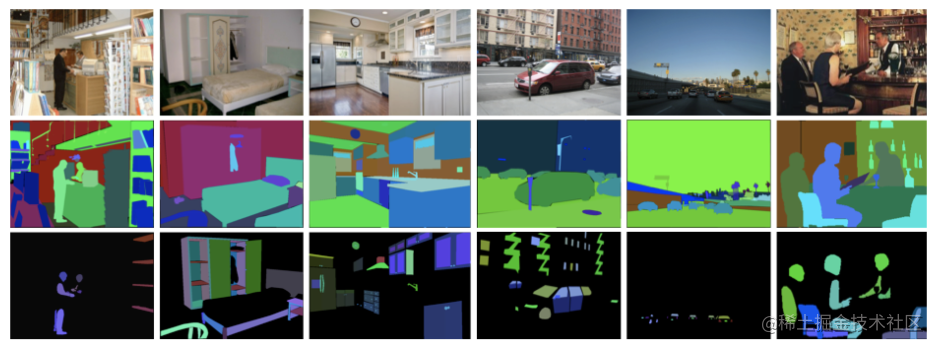

COCO 是一个大型图像数据集,其被用于机器视觉领域的对象检测与分割、人物关键点检测、填充分割与字幕生成。该数据集以场景理解为主,图像中的目标则通过精确的分割进行位置标定。

该数据集具有目标分割、情景感知和超像素分割三个特征,其包含 33 万张图像、150 万目标实例、80 个目标类、91 个物品类以及 25 万关键点人物。

LVIS

官网链接:https://www.lvisdataset.org/dataset

网盘链接:https://sigusoft.com/s/1UntujlgDMuVBIjhoAc_lSA 提取码:8ief

大规模的词汇实例分割数据集(Large Vocabulary Instance Segmentation,LVIS ),包含了164k图像,并针对超过1000类物体进行了约200万个高质量的实例分割标注。由于数据集中包含自然图像中的物体分布天然具有长尾属性。

Objects365

官网链接:https://www.objects365.org/overview.html

该数据集总共包含63万张图像,覆盖365个类别,高达1000万框数,具有规模大、质量高、泛化能力强的特点,远超Pascal VOC、COCO等传统数据集。

分割

数据集汇总:VOC2007、VOC2012、Pascal Context、COCO-Stuff 10K、Cityscapes、ADE20K

Cityscapes

官网链接:https://www.cityscapes-dataset.com/

该数据集拍摄了国外多个城市街道场景图片,构建数据集,其分为三个部分,包括训练集,验证集和测试集,一共 19 个类别。

ADE20K

官网链接:http://groups.csail.mit.edu/vision/datasets/ADE20K/

网盘链接:https://sigusoft.com/s/1ZuAuZheHHSDNRRdaI4wQrQ 提取码:dqim

ADE20K涵盖了场景、对象、对象部分的各种注释,在某些情况下甚至是部分的部分。有25k张复杂日常场景的图像,其中包含自然空间环境中的各种对象。每个图像平均有19.5个实例和10.5个对象类。

姿态估计

数据集汇总: COCO2017、MPII、CrowdPose、OCHuman

MPII

官网链接:http://human-pose.mpi-inf.mpg.de/

网盘链接:https://sigusoft.com/s/1uscGGPlUBirulSSgb10Pfw 提取码:w6af

MPII人体姿态数据集是评价关节人体姿态估计的最先进的基准。该数据集包括大约25K张图片,其中包括超过40K名带有标注身体关节的人。这些图像是根据人类日常活动的既定分类系统收集的。总体而言,数据集涵盖410项人类活动,每张图像都有活动标签。每张图片都是从YouTube视频中提取的,并提供了前后未注释的帧。

EasyCV数据集接口使用示例

设计思路

EasyCV抽象了data_source来封装不同格式的数据集,data_source输出图像相关的信息,然后通过指定dataset_type来创建不同任务类型的数据集对象进行训练。其中data_source类型包括ClsSourceImageList、DetSourceCoco、DetSourceVOC、PoseTopDownSourceCoco和SegSourceRaw等等,dataset_type类型包括RawDataset、ClsDataset、DetDataset和SegDataset等等。

以ImageNet数据集为例:

其他和Imagenet格式相似的数据集,都可以通过替换data_train_list、data_train_root、data_test_list和data_test_root进行配置使用,详细的config配置方式可参考https://github.com/alibaba/EasyCV/blob/master/configs/classification/imagenet/resnet/resnet50_b32x8_100e_jpg.py。

项目开源地址:https://github.com/alibaba/EasyCV

EasyCV往期分享

- EasyCV带你复现更好更快的自监督算法-FastConvMAE

- YOLOX-PAI:加速YOLOX,比YOLOV6更快更强

- 基于EasyCV复现DETR和DAB-DETR,Object Query的正确打开方式

- 基于EasyCV复现ViTDet:单层特征超越FPN

- MAE自监督算法介绍和基于EasyCV的复现

- EasyCV开源|开箱即用的视觉自监督+Transformer算法库

本文介绍了几个常见的匹配算法,通过算法过程和算法分析介绍了各个算法的优缺点和使用场景,并为后续的搜索文章做个铺垫;读者可以通过比较几种算法的差异,进一步了解匹配算法演进过程以及解决问题的场景;KMP算法和Double-Array TireTree是其中算法思想的集大成者,希望读者重点关注。

1 前言

上文探究了数据结构和算法的一些基础和部分线性数据结构和部分简单非线性数据结构,本文我们来一起探究图论,以及一些字符串模式匹配的高级数据结构和算法。【搜索中常见数据结构与算法探究(一)】(https://developer.jdcloud.com/article/2153)

搜索作为企业级系统的重要组成部分,越来越发挥着重要的作用,ES已经成为每个互联网企业必备的工具集。而作为搜索的基础部分,文本匹配的重要性不言而喻。文本匹配不仅为精确搜索提供了方法,而且为模糊匹配提供了算法依据。比如相似度算法,最大搜索长度算法都是在匹配算法的基础上进行了变种和改良。

2 图论基础

2.1 图的基本概念

以我们物流的抽象模型为例:每个配送中心是一个顶点,由两个顶点表示的配送中心间如果存在一条干线运输线,那么这两个顶点就用一条边连接。边可以由一个权,表示时间、距离和运输的成本。我们愿意迅速确定任何两个配送中心的最佳线路。这里的“最佳”可以是指最少边数的路径,也即经过的配送中心最少;也可以是对一种或所有权总量度所算出的最佳者。

2.2 图的表示方法

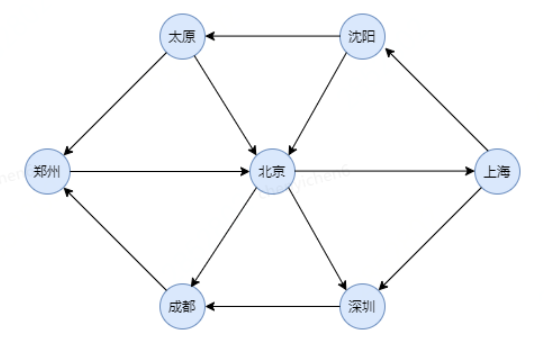

我们考虑实用情况,以有向图为例:

我们假设可以以省会城市开始对顶点编号。如下图

1)邻接矩阵

表示图的一种简单的方法是使用一个二维数据,称为邻接矩阵表示法。有一个二维数组A,对于每条边(u,v),置A[u][v]等于true;否则数组素就是false。如果边有一个权,那么可以置A[u][v]等于该权,而使用很大或者很小的权作为标记表示不存在的边。虽然这种表示方法的优点是简单,但是,它的空间复杂度为θ(|V|^2),如果图的边不是很多(稀疏的),那么这种表示的代价就太大了。代码如下:

2)邻接表

如果图是稀疏的,那么更好的解决办法是使用邻接表。

2.3 图的搜索算法

从图的某个订单出发,访问途中的所有顶点,并且一个顶点只能被访问一次。图的搜索(遍历)算法常见的有两种,如下:

- 深度优先搜索算法(DFS)

- 广度优先搜索算法(BFS)

3 数据结构与算法

3.1 BF(Brute Force)算法

3.1.1 算法介绍

BF(Brute Force)算法也可以叫暴力匹配算法或者朴素匹配算法。

3.1.2 算法过程

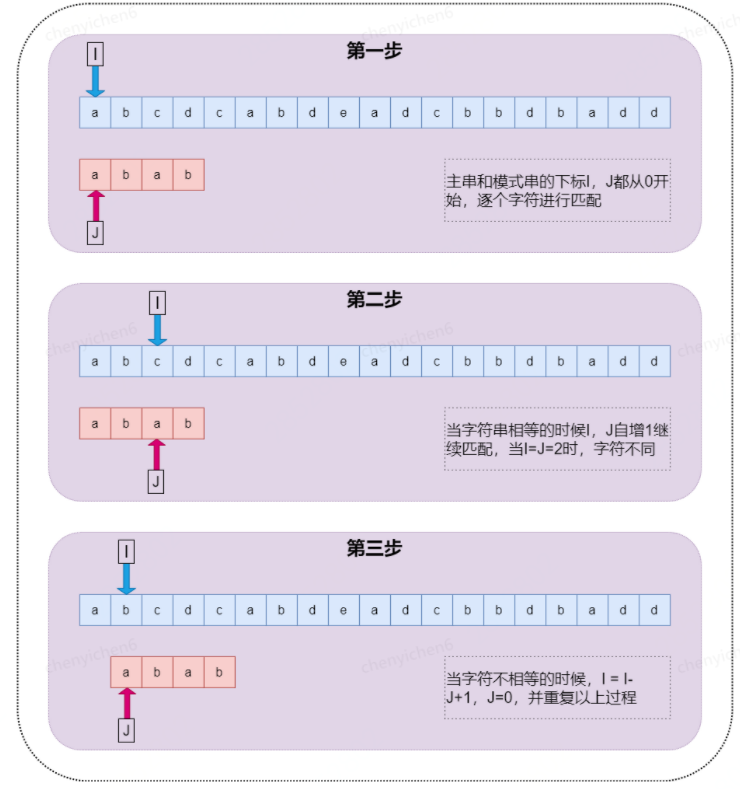

在讲解算法之前,我们先定义两个概念,方便后面讲解。他们分别是主串(S)和模式串(P)。比如说要在字符串A中查找字符串B,那么A就是主串,B就是模式串。我们把主串的长度记作n,模式串的长度记作m,并且n>m。算法过程如下图:

3.1.3 算法分析

BF算法从很“暴力”,当然也就比较简单,好懂,但是响应的性能也不高极端情况下时间复杂度函数为O(m*n)。

尽管理论上BF算法的时间复杂度很高,但在实际的开发中,它却是一个比较常用的字符串匹配算法,主要原因有以下两点:

- 朴素字符串匹配算法思想简单,代码实现也非常简单,不容易出错,容易调试和修改。

- 在实际的软件开发中,模式串和主串的长度都不会太长,大部分情况下,算法执行的效率都不会太低。

3.2 RK(Rabin-Karp)算法

3.2.1 算法介绍

RK算法全程叫Rabin-Karp算法,是有它的两位发明者Rabin和Karp的名字来命名,这个算法理解并不难,他其实是BF算法的升级版。

3.2.2 算法过程

3.2.3 算法分析

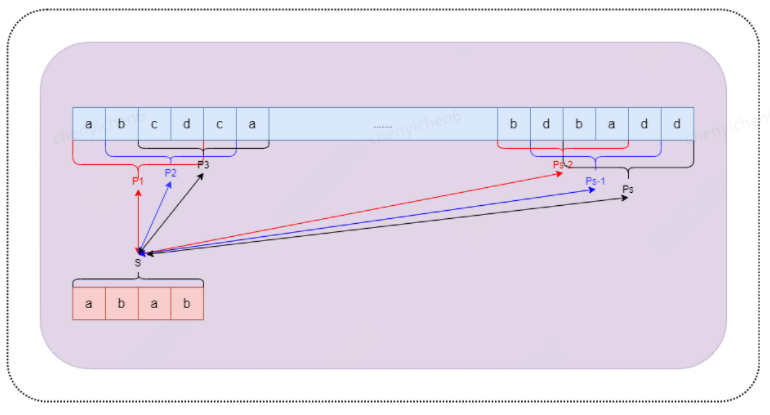

在BF算法中当字符串不匹配时,需要比对每一个字符,如果不能匹配则重新调整I,J的值重新比对每一个字符,RK的思路是将模式串进行哈希算法得到s=hash(P),然后将主串分割成n-m+1个子串,分别对其进行hash算法,然后逐个和s进行比对,减少逐个字符串比对的次数。其中hash函数的具体实现可自行选择。

整个RK算法包含两部分:

- 计算模式串哈希和子串的哈希;

- 模式串哈希和子串哈希的比较;

第一部分的只需要扫描一遍主串就能计算出所有子串的哈希值,这部分的时间复杂度是O(n)。模式串哈希值与每个子串哈希之间的比较的时间复杂度是O(1),总共需要比对n-m+1次,所以这部分的时间复杂度为O(n)。所以RK算法的整体时间复杂度为O(n)。

3.3 KMP算法

3.3.1 算法介绍

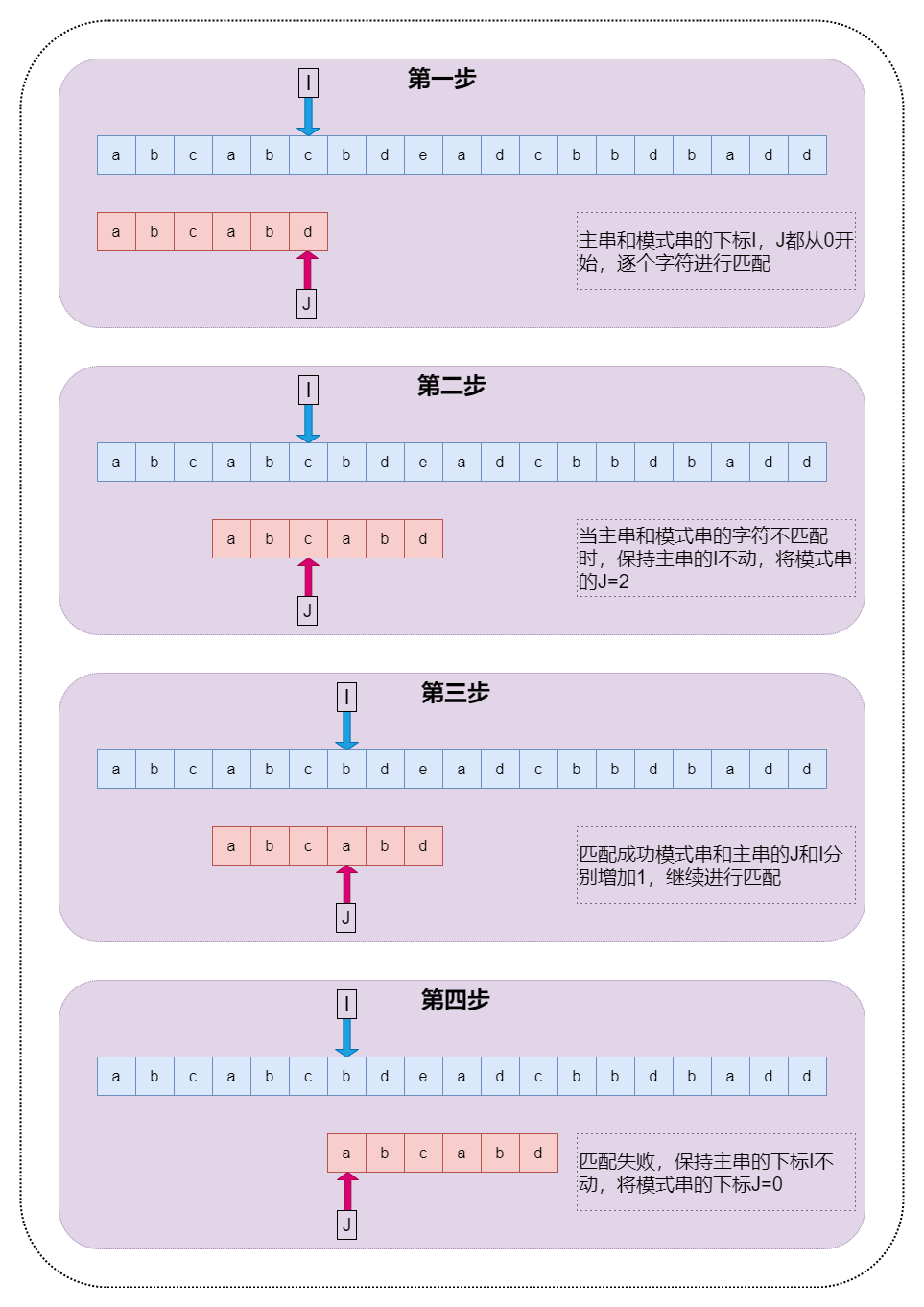

KMP算法是一种线性时间复杂度的字符串匹配算法,它是对BF(Brute-Force)算法的改进。KMP算法是由D.E.Knuth与V.R.Partt和J.H.Morris一起发现的,因此人们称它为Knuth-Morris-Pratt算法,简称KMP算法。

前面介绍了BF算法,缺点就是时间消耗很大,KMP算法的主要思想就是:在匹配过程中发生匹配失败时,并不是简单的将模式串P的下标J重新置为0,而是根据一些匹配过程中得到的信息跳过不必要的匹配,从而达到一个较高的匹配效率。

3.3.2 算法过程

在介绍KMP算法之前,首先介绍几个字符串的概念:

- 前缀:不包含最后一个字符的所有以第一个字符开头的连续子串;

- 后缀:不包含第一个字符的所有以最后一个字符结尾的连续子串;

- 最大公共前后缀:前缀集合与后缀集合中长度最大的子串;

例如字符串abcabc

前缀集合是a,ab,abc,abca,abcab

后缀集合为bcabc,cabc,abc,bc,c

最大公共前后缀为abc

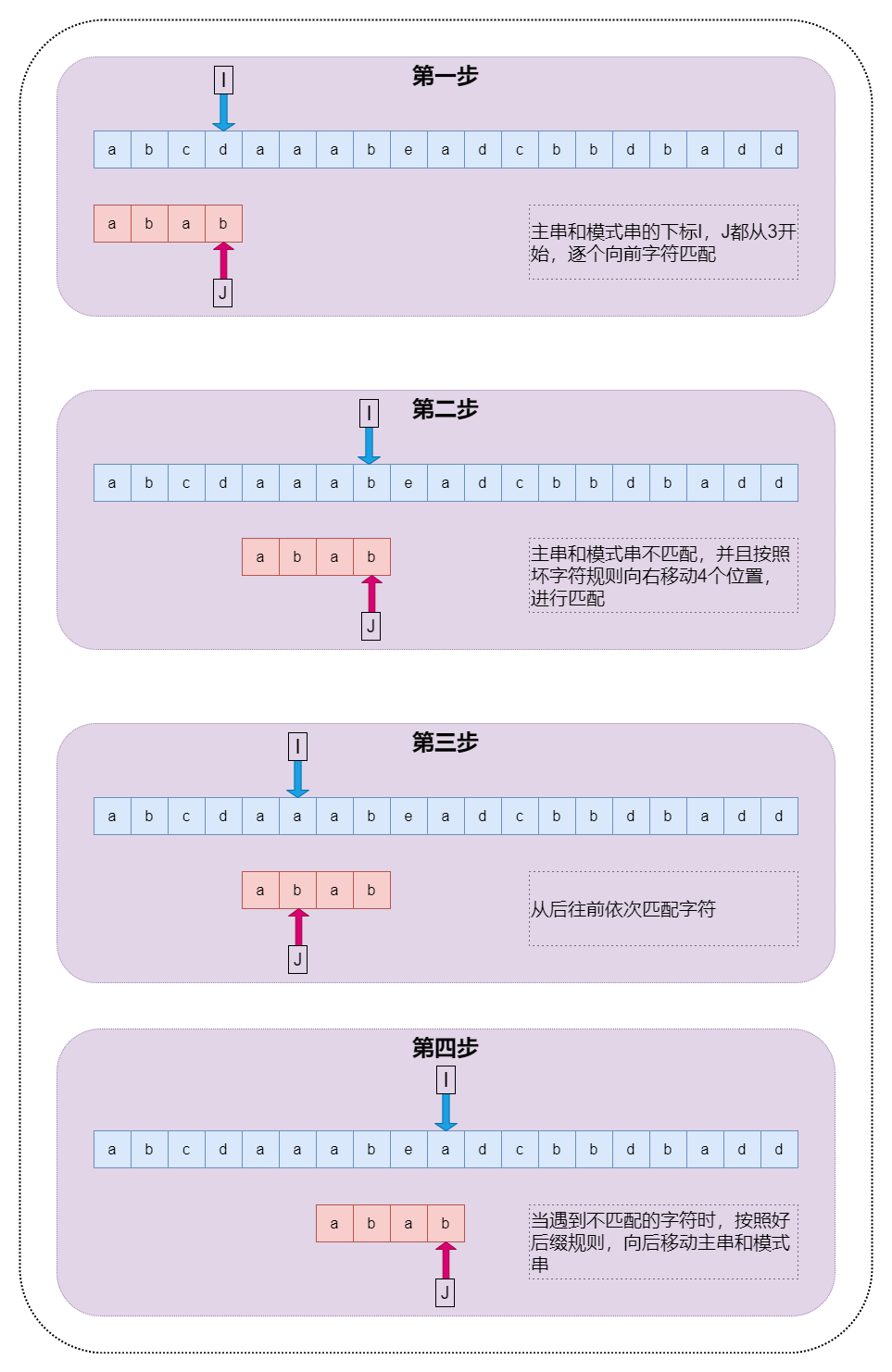

KMP算法的过程如下图:

那么为什么KMP算法会知道在匹配失败时下标J回溯的那个位置呢?其实KMP算法在匹配的过程中将维护一些信息来帮助跳过不必要的匹配,这个信息就是KMP算法的重点,next数组也叫做fail数据或者前缀数据。下面我们来分析next数组的由来

对于模式串P的每个素P[j],都存在一个实数k,使得模式串P开头的k个字符(P[0]P[1]…P[k-1])依次于P[j]前面的k(P[j-k]P[j-k+1]…P[j-1])个字符相同。如果这样的k有多个,则取最大的一个。模式串P中的每个位置j的字符都存在这样的信息,采用next数组表示,即next[j]=MAX{k}。

从上述定义中可看到next(j)的逻辑意义就是求P[0]P[1]…P[j-1]的最大公共前后缀长度。代码如下:

下面分析next的求解过程:

1)特殊情况

当j的值为0或者1的时候,它们的k值都为0,即next(0) = 0 、next(1) = 0。为了后面k值计算的方便,我们将next(0)的值设置为-1。

2)当P[j]==P[k]的情况

当P[j]==P[k]时,必然有P[0]…P[k-1]==P[j-k]…P[j-1],因此有P[0]…P[k]==P[j-k]…P[j],这样就有next(j+1)=k+1。

3)当P[j]!=P[k]的情况

当P[j]!=P[k]时,必然后next(j)=k,并且next(j+1)<k;也就是说P[0]…P[k-1]=P[j-k]…P[j-1],因此此时k值需要向左移动重新进行匹配,next数组的作用就是在匹配失败时进行下标左移,所以k=next(k)进行下一轮循环。

4)算法优化

上述算法有一个小问题就是当P[k]匹配失败后会跳转到next(k)继续进行匹配,但是此时有可能P[k]=P[next(k)],此时匹配肯定是失败的所以对上述代码进行改进如下:

3.3.3 算法分析

KMP算法通过消除主串指针的回溯提高匹配的效率,整个算法分为两部分,next数据的求解,以及字符串匹配,从上一节的分析可知求解next数组的时间复杂度为O(m),匹配算法的时间复杂度为O(n),整体的时间复杂度为O(m+n)。KMP算法不是最快匹配算法,却是名气最大的,使用的范围也非常广。

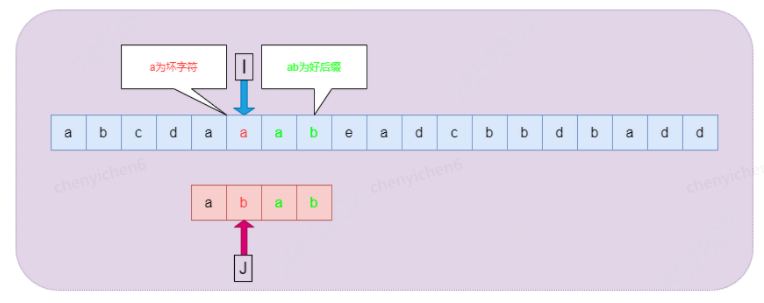

3.4 BM算法

3.4.1 算法介绍

Boyer-Moore字符串搜索算法是一种非常高效的字符串搜索算法。它由Bob Boyer和J Strother Moore发明,有实验统计它的性能是KMP算法的3-4倍。

3.4.2 算法过程

前面介绍的BF,KMP的算法的匹配过程虽然模式串的回溯过程不同,但是相同点都是从左往右逐个字符进行匹配,而BM算法则是采用的从右向左进行匹配,借助坏字符规则(SKip(j))和好后缀(Shift(j))规则,能够进行快速匹配。其中坏字符和好后缀示意如下图

1)坏字符规则:在BM算法从右向左扫描的过程中,若发现某个字符S[i]不匹配时,则按照如下两种情况进行处理:

- 如果字符S[i]在模式串P中没有出现,那么从字符S[i]开始的m个文本显然是不可能和P匹配成功,直接全部跳过该区域。

- 如果字符S[i]在模式串P中出现,则以该字符进行对齐。

2)好后缀规则:在BM算法中,若发现某个字符不匹配的同时,已有部分字符匹配成功,则按照如下两种情况进行处理:

- 如果已经匹配的子串在模式串P中出现过,且子串的前一个字符和P[j]不相同,则将模式串移动到首次出现子串的前一个位置。

- 如果已经匹配的子串在模式串P中没有出现过,则找到已经匹配的子串最大前缀,并移动模式串P到最大前缀的前一个字符。

BM算法过程如下:

3.4.3 算法分析

在BM算法中,如果匹配失败则取SKip(j)与Shift(j)中的较大者作为跳跃的距离。BM算法预处理阶段的复杂度为O(m+n),搜索阶段的最好的时间复杂度为O(n/m),最坏的时间复杂为为O(n*m)。由于BM算法采用的是后缀匹配算法,并且通过坏字符和好后缀共同作用下,可以跳过不必要的一些字符,具体Shift(j)的求解过程可参看KMP算法的next()函数过程。

3.5 TireTree

3.5.1 算法介绍

在《搜索中常见的数据结构与算法探究(一)》中,我们介绍过一种树状的数据结构叫做HashTree,本章介绍的TireTree就是HashTree的一个变种。TireTree又叫做字典树或者前缀树,典型的应用是用于统计和排序大量的字符串,所以经常被搜索系统用于文本的统计或搜索。

TireTree的核心思想是空间换时间。TrieTree是一种高效的索引方法,它实际上是一种确定有限自动机(DFA),利用字符串的公共前缀来降低查询时间的开销以达到提高查询效率的目的,非常适合多模式匹配。TireTree有以下基本性质:

- 根节点不包含字符,除根节点外每个节点都包含一个字符。

- 从根节点到某一个节点,路径上经过的字符连接起来,为该节点对应的字符串。

- 每个节点对应的所有子节点包含的字符都不相同。

3.5.2 算法过程

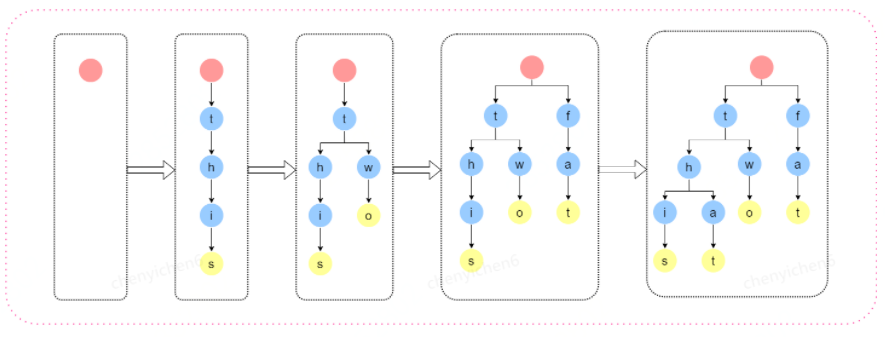

TireTree构建与查询

我们以《搜索中常见的数据结构与算法探究(一)》案例二中提到的字谜单词为例,共包含this、two、fat和that四个单词,我们来探究一下TireTree的构建过程如下图:

上述过程描述了that,two,fat,that四个单词的插入TireTree的过程,其中黄色的节点代表有单词存在。由于TireTree的构建的过程是树的遍历,所以查询过程和创建过程可以视为一个过程。

3.5.3 算法分析

TireTree由于本身的特性非常适合前缀查找个普通查找,并且查询的时间复杂度为O(log(n)),和hash比较在一些场景下性能要优于甚至取代hash,例如说前缀查询(hash不支持前缀查询)。

虽然TireTree的查询速度会有一定的提升但是缺不支持后缀查询,并且TireTree对空间利用率不高,且对中文的支持有限。

3.6 AC自动机

3.6.1 算法介绍

AC自动机(Aho-Corasick automation)该算法在1975年产生于贝尔实验室,是著名的多模匹配算法之一。要搞懂AC自动机,先得有TireTree和KMP模式匹配算法的基础知识,上述章节有TireTree和KMP算法的详细介绍。

3.6.2 算法过程

AC自动机的构建过程需要如下步骤:

- TireTree的构建,请参看TireTree章节

- fail指针的构建 – 使当前字符失配时跳转到具有最长公共前后缀的字符继续匹配。如同 KMP算法一样, AC自动机在匹配时如果当前字符匹配失败,那么利用fail指针进行跳转。由此可知如果跳转,跳转后的串的前缀,必为跳转前的模式串的后缀并且跳转的新位置的深度一定小于跳之前的节点。fail指针的求解过程可是完全参照KMP算法的next指针求解过程,此处不再赘述。

- AC自动机查找 – 查找过程和TireTree相同,只是在查找失败的时候感觉fail指针跳转到指定的位置继续进行匹配。

3.6.3 算法分析

AC自动机利用fail指针阻止了模式串匹配阶段的回溯,将时间复杂度优化到了O(n)。

3.7 Double-Array-TireTree

3.7.1 算法介绍

前面提到过TireTree虽然很完美,但是空间利用率很低,虽然可以通过动态分配数组来解决这个问题。为了解决这个问题我们引入Double-Array-TireTree,顾名思义Double-Array-TireTree就是TireTree压缩到两个一维数组BASE和CHECK来表示整个树。Double-Array-TireTree拥有TireTree的所有优点,而且刻服了TireTree浪费空间的不足,使其应用范围更加广泛,例如词法分析器,图书搜索,拼写检查,常用单词过滤器,自然语言处理 中的字典构建等等。

3.7.2 算法过程

在介绍算法之前,我们提前简单介绍一个概念DFA(下一篇详细介绍)。DFA(Deterministic Finite State)有限自动机,通俗来讲DFA是指给定一个状态和一个输入变量,它能转到的下一个状态也就确定下来,同时状态是有限的。

Double-Array-TireTree构建

Double-Array-TireTree终究是一个树结构,树结构的两个重要的要素便是前驱和后继,把树压缩在双数组中,只需要保持能查到每个节点的前驱和后继。首先要介绍几个重要的概念:

- STATE:状态,实际是在数组中的下标

- CODE:状态转移值,实际为转移字符的值

- BASE:标识后继节点的基地址数组

- CHECK:标识前驱节点的地址

从上面的概念的可以理解如下规则,假设一个输入的字符为c,状态从s转移到t

- state[t] = base[state[s]] + code[c]

- check[state[t]] = state[s]

构建的过程大概也分为两种:

- 动态输入词语,动态构建双数组

- 已知所有词语,静态构建双数组

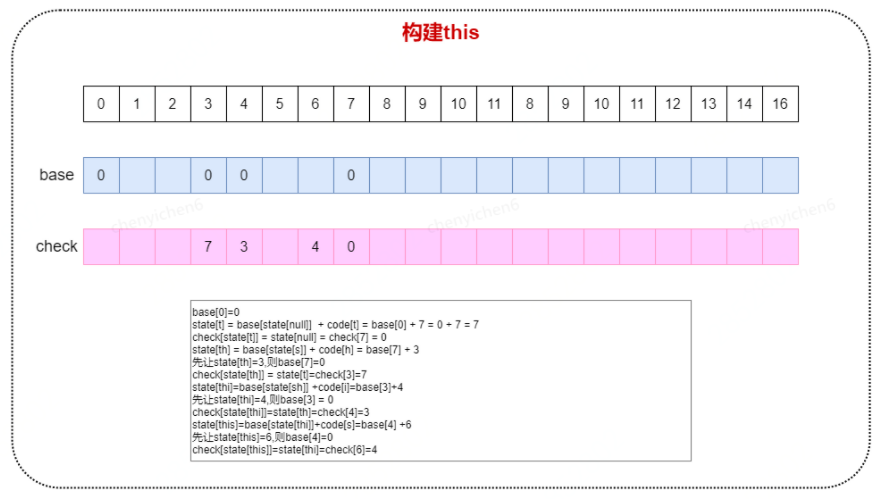

我们以静态构建过为核心,我们以《搜索中常见的数据结构与算法探究(一)》案例二中提到的字谜单词为例,共包含this、two、fat和that四个单词为例,其中涉及都的字符集{a,f,h,i,o,s,t,w}共8个字符,为了后续描述方便,我们对这个八个字符进行编码,分别是a-1,f-2,h-3,i-4,o-5,s-6,t-7,w-8

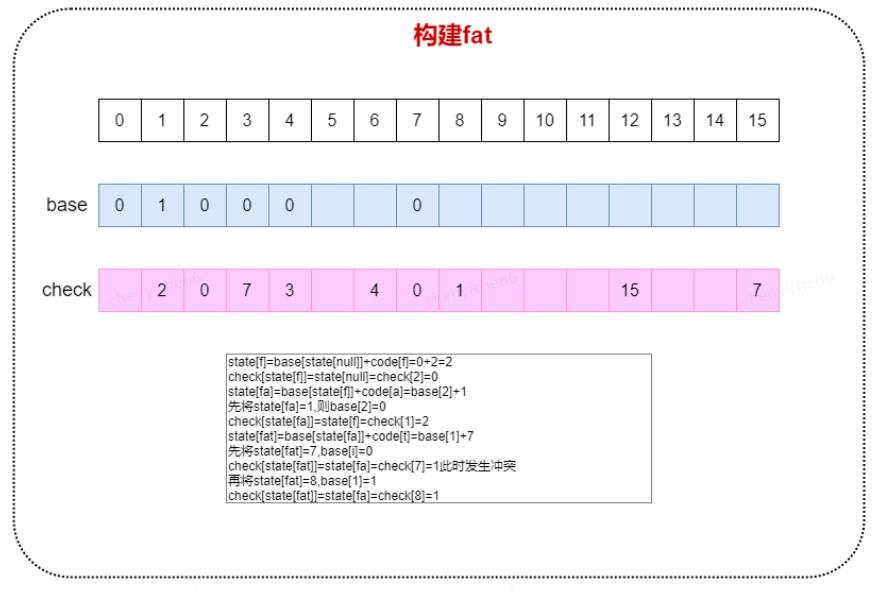

构建this,如下图

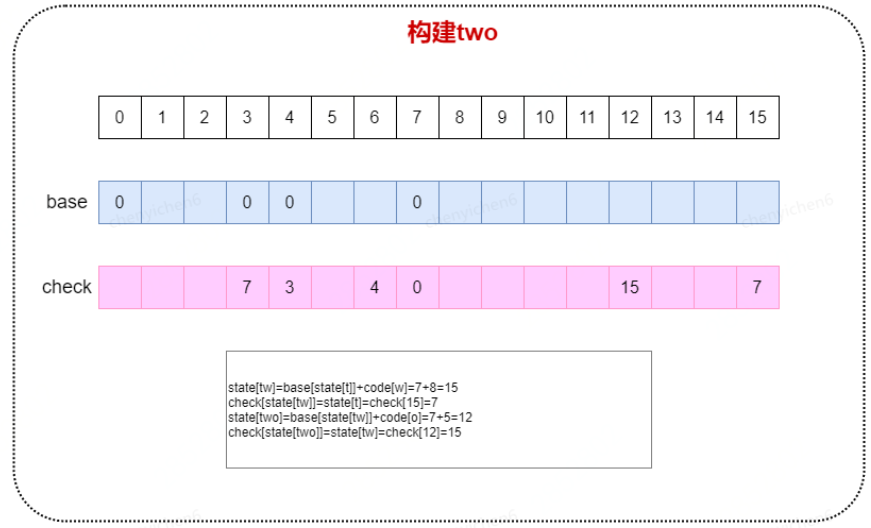

构建two,如下图

构建fat,如下图

构建that,如下图

Double-Array-TireTree查询

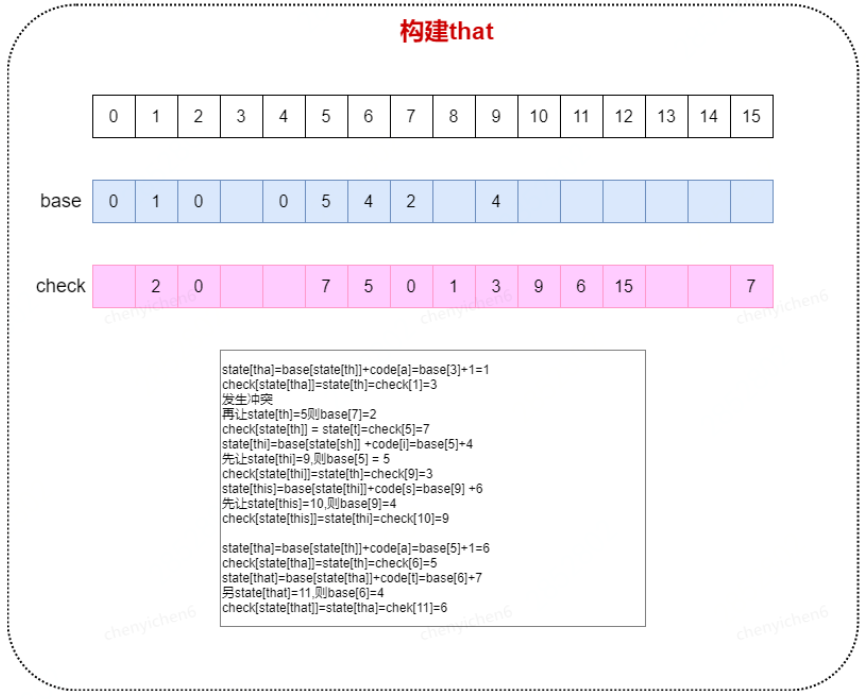

验证this是否在范围内如下过程

1)state[t] = base[state[null]]+code[t]= 0 + 7=7

check[7]=state[null]=0通过

2)state[th] = base[state[t]]+code[h]=base[7]+3 =2+3=5

check[5]= state[t] = 7通过

3)state[tha] = base[state[th]]+ code[a]=base[5]+1=5+1=6

check[6]=state[th]=5通过

4)state[that] = base[state[tha]]+t = base[6]+7=11

check[11]=state[tha]=6通过

3.7.3 算法分析

通过两个数据base和check将TireTree的数据压缩到两个数组中,既保留了TireTree的搜索的高效,又充分利用了存储空间。

3.8 其他数据结构

鉴于篇幅有限,DFA,FSA以及FST将在下一篇文章中再来一起讨论,敬请期待!

4 参考资料

参考书籍

《数据结构与算法分析:java语言描述》

《自动机理论、语言和计算导论》

本篇文章对本系列的上一篇文章的常见数据结构做了补充,介绍了非线性数据结构的最后一种,图数据结构作为基本数据结构最复杂的一种,在多种企业级应用中都有使用,如网络拓扑,流程引擎,流程编排;另外本文重点介绍了几种常见的匹配算法,以及算法的演进过程和使用场景,为下一篇的主题,也是本系列的重点探究的目标,“搜索”做一个铺垫,敬请期待!

作者: 潘坤 郑冰 曹东杰

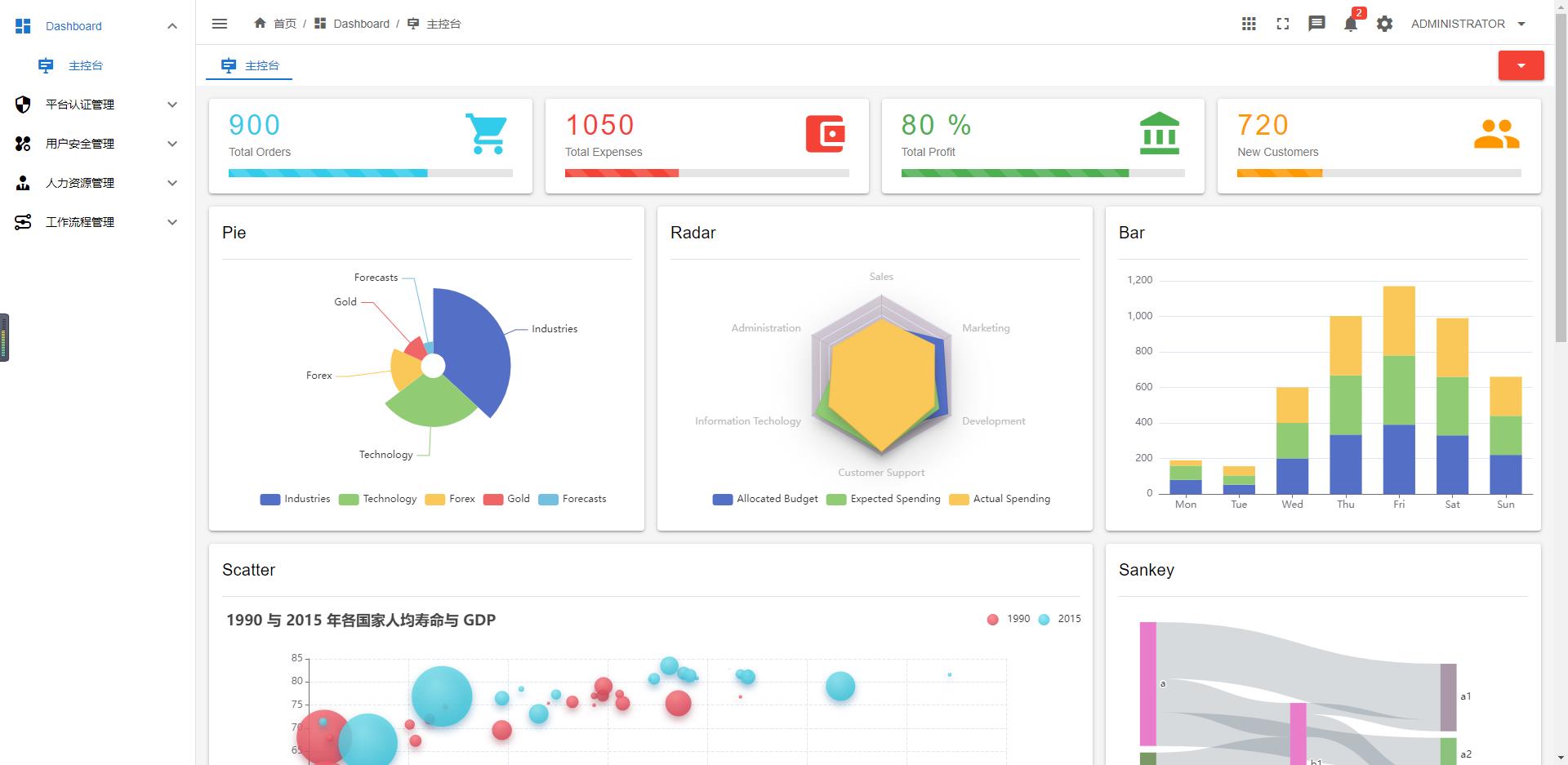

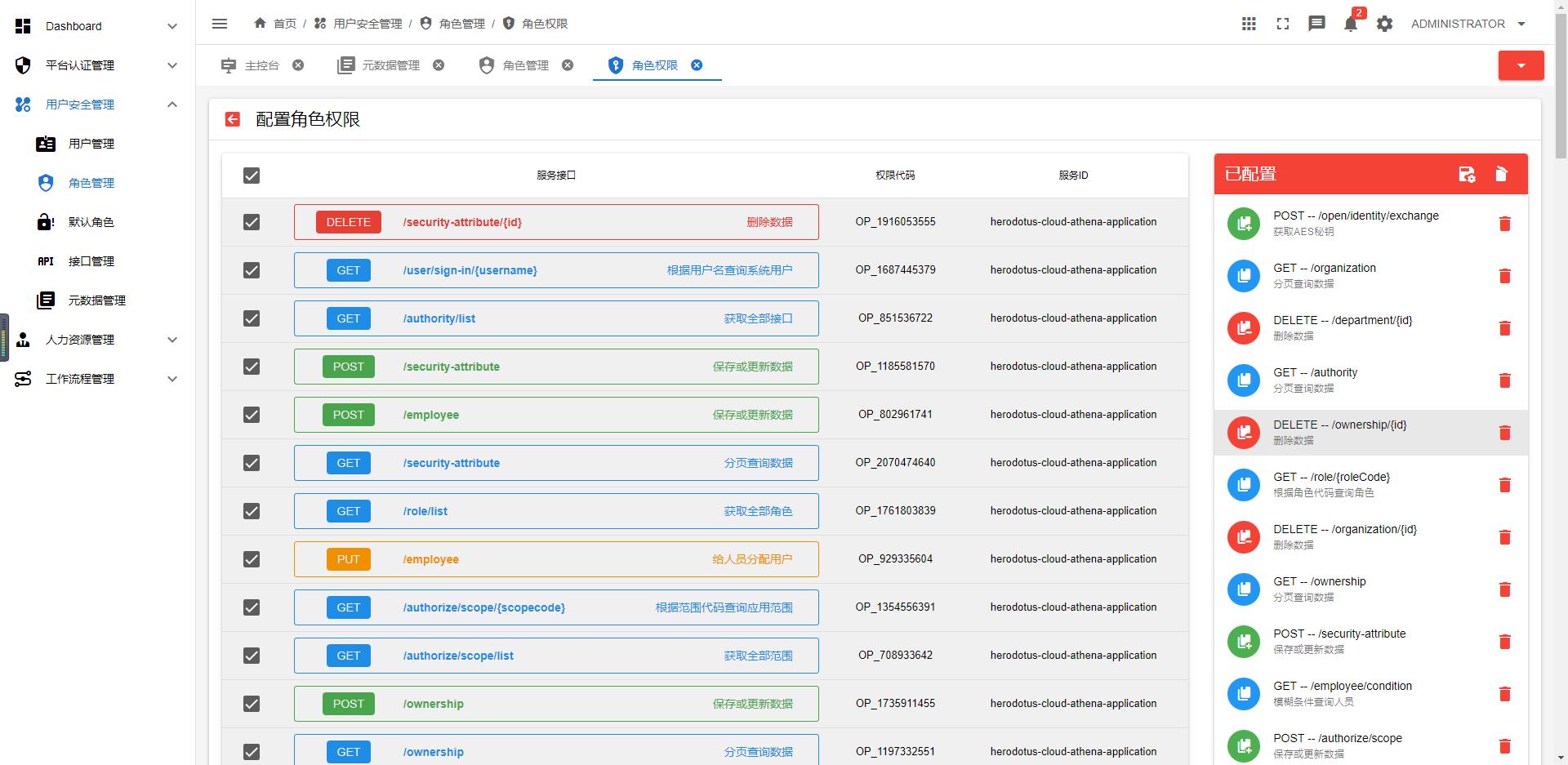

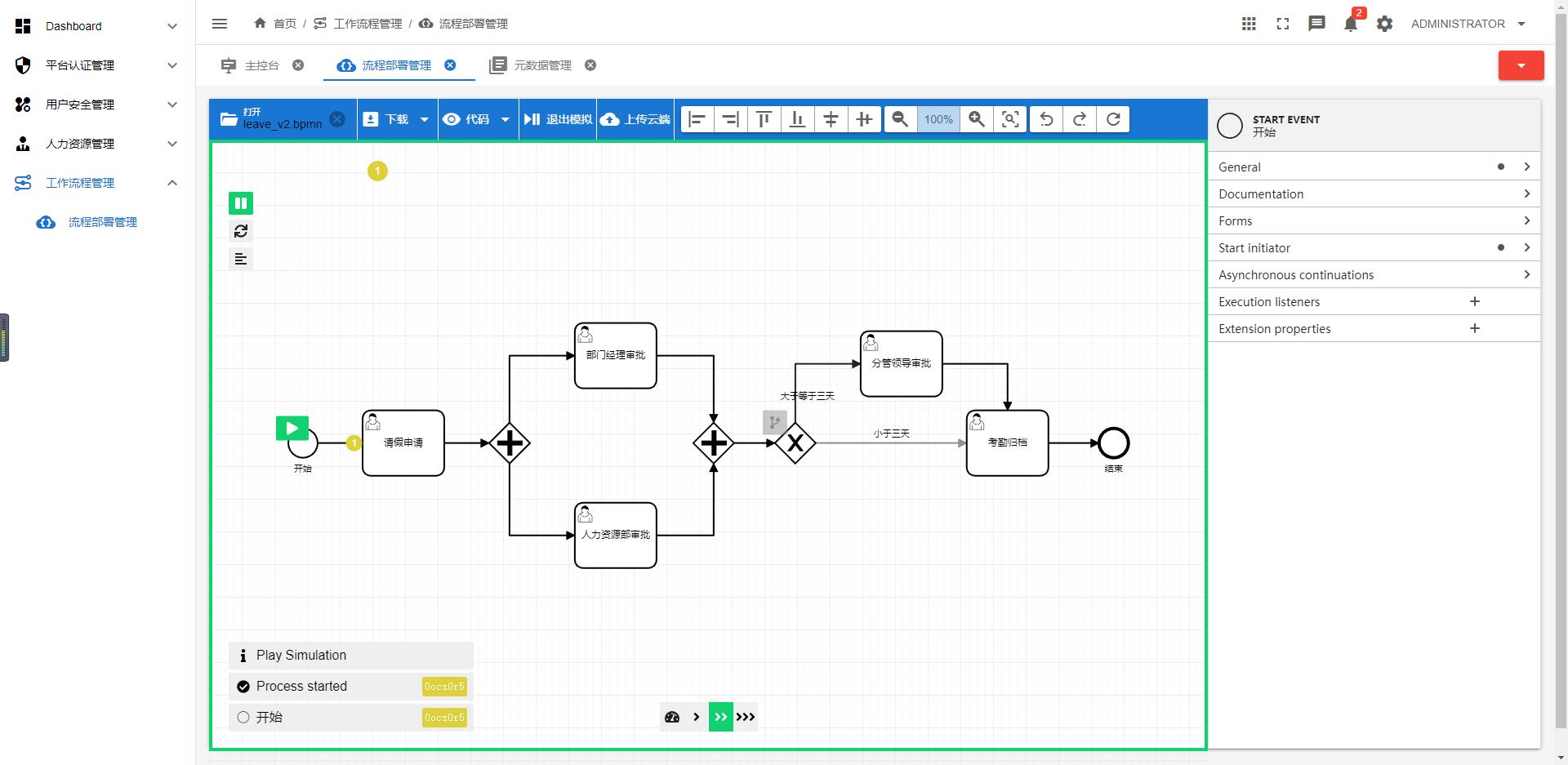

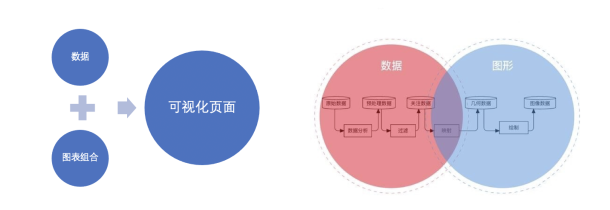

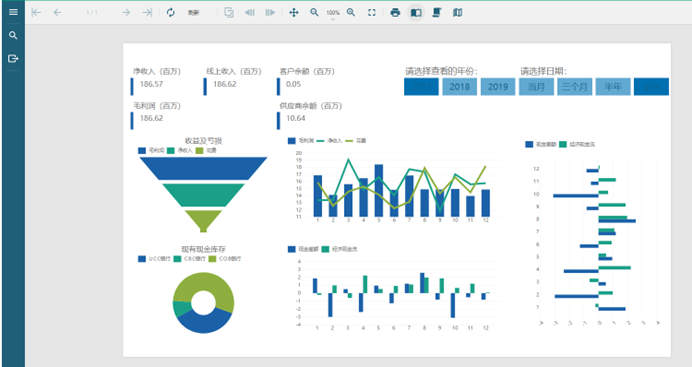

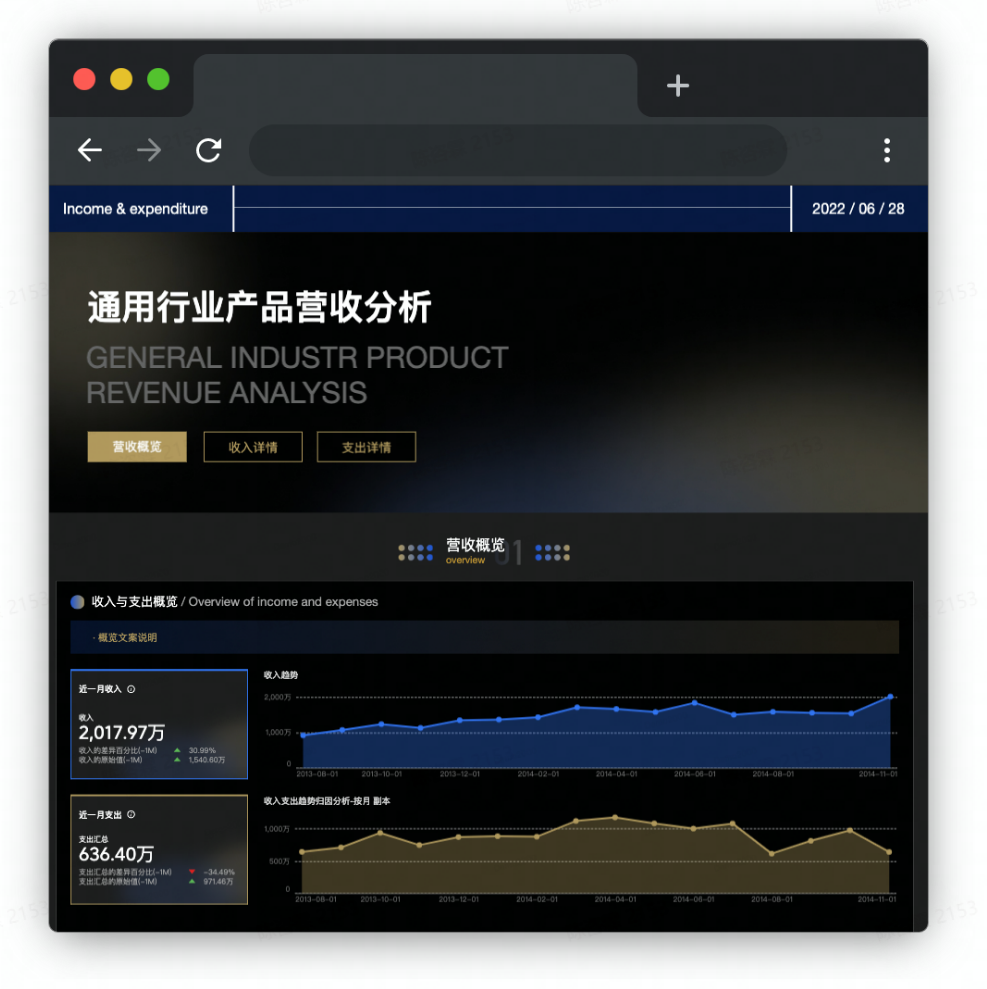

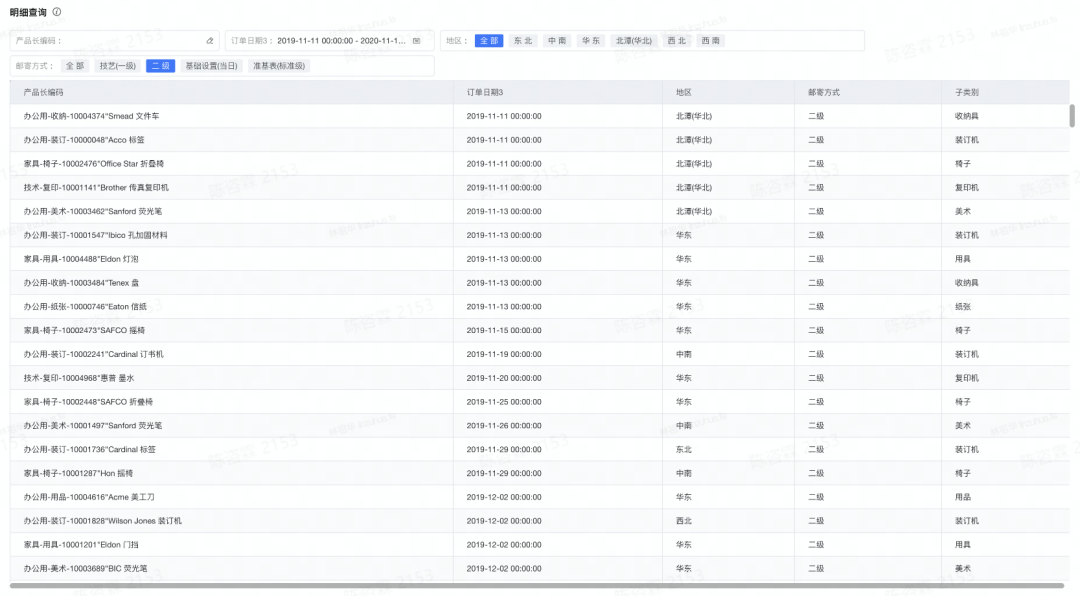

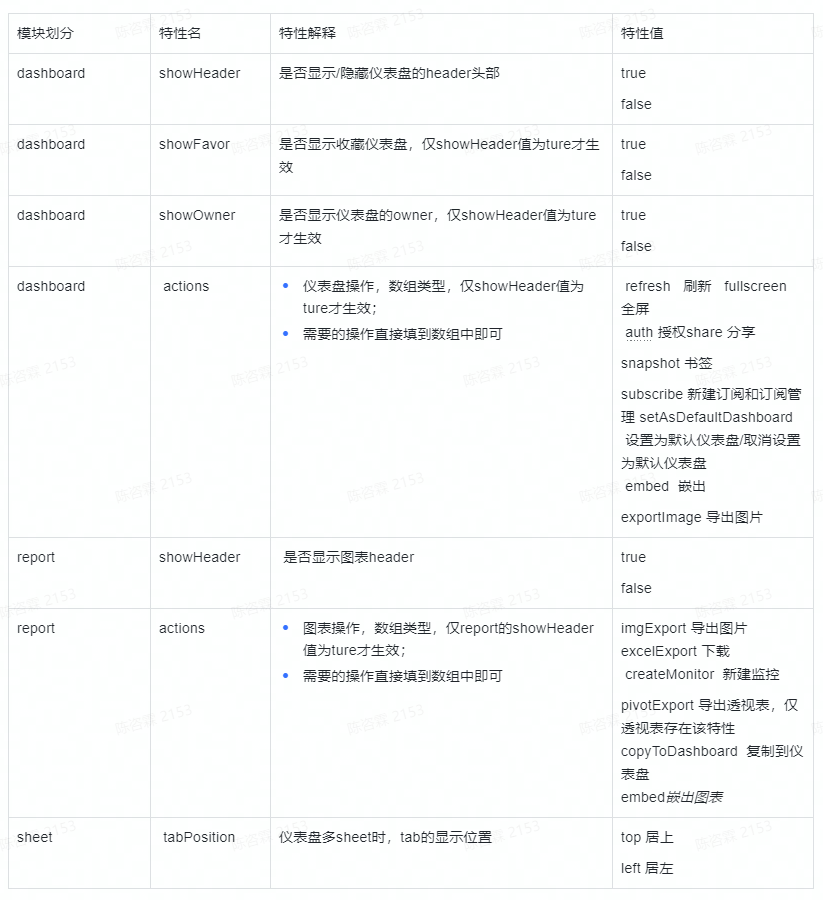

嵌入式分析是使任何应用程序或用户更容易获得数据分析和商业智能的技术。 商业智能是通过分析业务数据辅助决策获取数据背后的 0信息。 商业智能软件和技术包含了报表查询,OLAP,数据挖掘及高级数据分析,最终用户自助分析及仪表板监控舱等功能。 嵌入式商业智能是一种技术能力,囊括了商业智能的功能和特征,并且成为了业务系统的一个重要的构成。

嵌入式商业智能发展背景

“商业智能”一词最早出现是在Richard Millar Devens,1865的Cyclopaedia of Commercial and Business Anecdotes一书中,用它来描述“银行家亨利·弗兰西斯爵士的成功方式”。

起源

1958年IBM的计算机科学家Hans Peter Luhn 撰写的一片文章《A Business Intelligence System》中,开始描述BI的价值和潜力,今天他被公认为“商业智能之父”。

演变:20世纪80年代末 1956年,IBM发明的硬盘彻底改变了数据存储,越来越多的数据被创建和存储。也就在这个阶段产生了第一个数据库管理系统,统称为决策支持系统(DSS)。 20世纪70年代,出现了几家BI厂商。 1988年,在罗马举办的数据分析联盟会议是一个商业智能的里程碑。

转折点:20世纪80年代-90年代 1988年会议后,商业智能就开始向现代化演进。1989年,分析师Howard Dresner再次将“商业智能”带入大家的视野,他将商业智能作为涵盖数据存储和数据分析的统称,避免了繁琐的名称,如DSS或EIS等。数据仓库技术的发展大大推动了商业智能的发展,传统存储在各个地方的业务数据开始集中在一起。应运而生的技术还包括ETL(数据抽取、转换、加载)和OLAP(联机分析处理),该阶段被称为-商业智能1.0。

商业智能1.0 20世纪90年代末和2000年初,数十家BI厂商进入市场,在此期间,BI包含两个基本功能:生成数据和报告,并以可视化的方式展示。商业智能1.0面临的两大问题:复杂性和时效性。 当时存在两个主要难点: 1、大多数人无法自助使用,强依赖IT 2、由于数据沉默,制定和提交报告给决策者需要更多的时间

商业智能2.0 二十一世纪是一个明显的转折点,随着技术的发展,解决了复杂性和时效性的问题。 BI2.0的实时处理技术允许企业依据最新的信息作出决策。 互联网社交的发展,也让商业智能广泛的传播,越来越多的人知道并理解商业智能。 BI 已经不再是一个锦上添花的软件,它代表的是一种企业竞争力,只是这种竞争力还没有被更多企业感知。

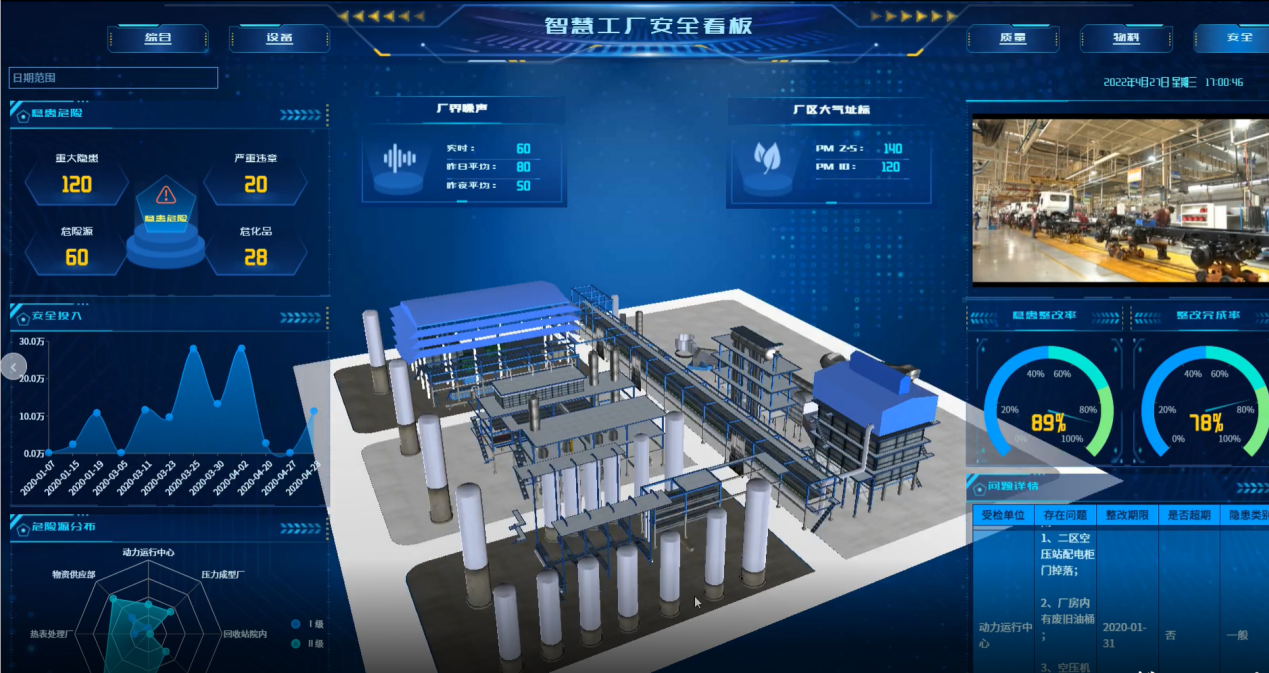

现代商业智能3.0

实现自助式和增强数据可视化,结合数字孪生,3D建模,GIS 地图实现数据可视化,并结合当下最新发展的AI技术进行AI交互挖掘很深层次信息。是BI的发展领域和现代化特征。 随着云计算、SaaS(软件即服务)、大数据的发展和成熟,商业智能开始被更多的企业使用,高度易用的设计让业务人员也可以使用,无需IT的支持。

2022 年及以后的嵌入式商业智能 (BI) 采用趋势

所有公司都在努力建立一种数据驱动的文化,预计到 2025 年大多数企业的数据量将达到 175 泽字节。如此大量的数据,意味着我们需要更加强有力的手段去组织管理。为了挖掘这些数据的价值,公司必须收集、组织、分析、整合和分发这些数据。这就是业务分析的用武之地,也是为什么越来越多的公司采用它并利用 BI 来发挥自己的优势。 让我们看一下 2022 及未来几年的嵌入式BI 发展趋势

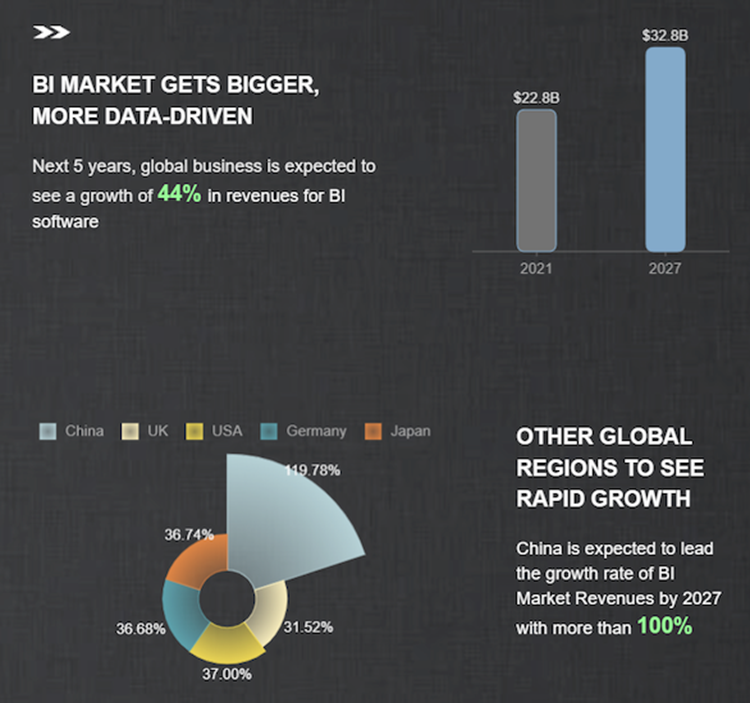

BI 市场规模统计 BI 市场由其他相互交织的行业发展推动,特别是在分析、大数据和人工智能市场。美国仍然是最赚钱的市场,但中国的增长率最高。

2021 年,BI 软件市场规模在全球范围内的收入为 228 亿美。预计 2027 年将增长 44%,收入预计将达到 328 亿美。到 2027 年,中国的增长率最高达到 119.8%,其次是美国(37%),紧随其后的是德国和日36.7%,然后是英国(31.5%)。

BI 投资 BI 是组织技术堆栈中较为成熟的业务系统之一。越来越多的员工正在使用 BI,与此同时,越来越多的公司正计划雇用全职 IT 人员来管理商业智能计划。2021 年,BI 在 B2B 技术买家 (38%) 的支出中排名第四。网络和视频会议以 64% 位居榜首,其次是在线协作和项目管理以及营销,分别占 53% 和 41%。这些数字可以在很大程度上归因于疫情居家办公影响的。尽管目前的员工可以访问和使用 BI,但到 2021 年,73% 的 CIO 正在考虑为分析平台招聘全职 IT 员工,这在 CIO 全职技术职位计划中排名第二。

虽然统计数据显示公司计划雇用 IT 员工来管理 BI,但自助式 BI 解决方案对用户非常友好。授权员工使用 BI 可以带来更快的洞察力、增强的团队协作、员工的整体满意度等。 即将到来的趋势确实表明,未来几年每位员工的 BI 支出预计将增加 30%:

- 2022 年 6.96 美

- 2023 年 7.35 美

- 2024 年 7.76 美

- 2025 年 8.17 美

- 2026 年 8.57 美

- 2027 年 8.96 美

BI 软件的成本差异很大。使用嵌入式商业智能,可节省采购成本及维护成本,可扩展许可模式为您的业务提供了增长空间,而无需增加许可费用。

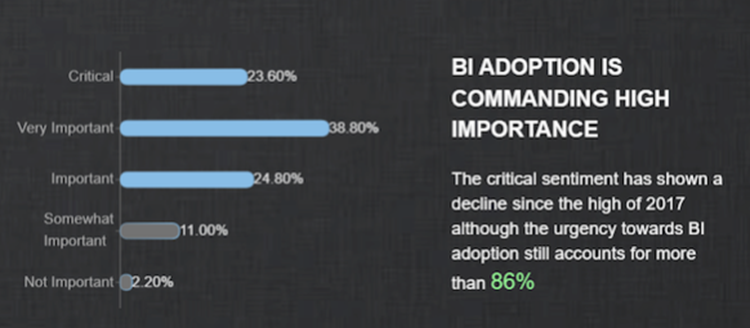

BI 感知到的重要性

许多行业(即商业、金融和保险)多年来一直在使用 BI,并且已经部署了成熟的 BI 集成。不过,展望未来,更多利基行业开始看到实施 BI 软件的必要性和好处。由于行业需求和流程千差万别,因此在搜索 BI 系统时,必须找到能够支持所有业务类型的嵌入式 BI 解决方案。嵌入式商业智能需包括仪表板和报告,满足各行各业的特定需求。尽管在过去三年中感知到的重要性有所下降,但对于采用 BI 解决方案而言仍然很重要。

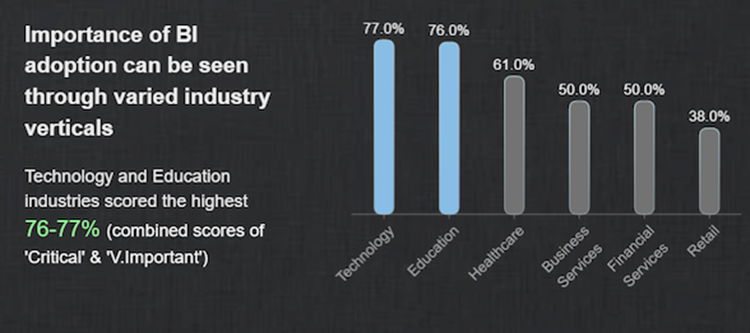

行业BI BI 被认为是满足许多行业业务目标的必备条件。但是,某些行业比其他行业更重视 BI。 按行业划分,云 BI 作为一个关键且非常重要的系统,在以下方面最为明显:

- 技术 (77%)

- 教育 (76%)

- 医疗保健 (61%)

- 商业服务 (50%)

- 金融服务 (50%)

- 零售 (38%)

另一方面,政府(42%)和制造业(28%)在采用率方面得分最低。这些数字可能是由于各种原因造成的,但政府的一个明显原因是数据的敏感性。在搜索 BI 系统时,找到具有可扩展安全性的系统至关重要,这样IT 团队就可以轻松管理角色、权限、许可证、用户和安全性。

移动BI变成企业产品选型的加分点,随时随地的洞察数据变得重要。新一代的商业智能产品涌现,传统商业智能被迫淘汰或者转型“敏捷BI”。

总结

本文从嵌入式BI的发展历程讲起,为大家详细介绍了嵌入式BI出现的背景、发展现状、市场应用与不同行业中BI的重要性,大家如果想了解针对不同行业的BI在线demo体验一下:

https://www.grapecity.com.cn/solutions/wyn/demo

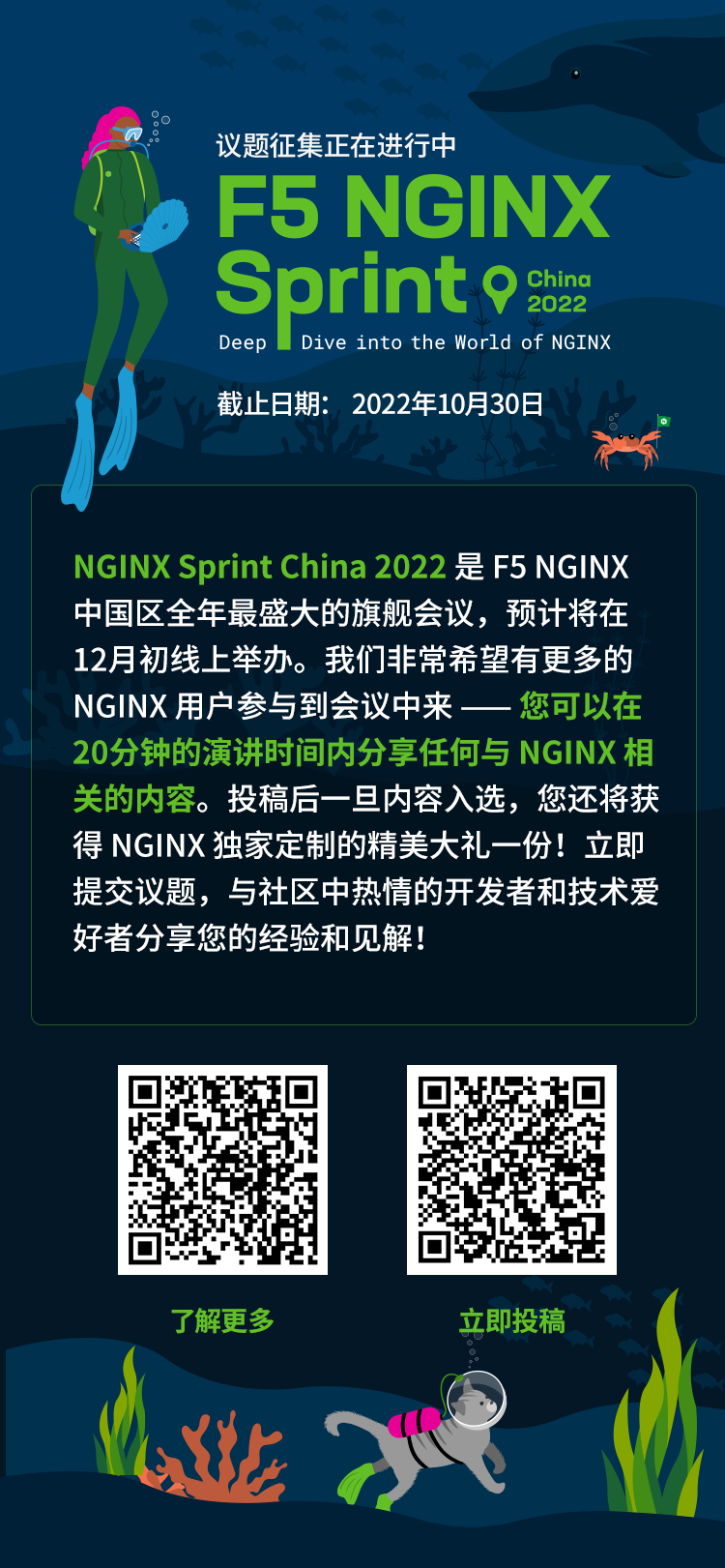

带上您的潜水服、调节器、潜水电脑表和水下摄像机,跟随我们在 NGINX Sprint China 2022 年度线上会议期间,一起深潜到 NGINX 的斑斓世界吧!

NGINX Sprint China 2022 是一年一度 NGINX Sprint 全球线上大会的本地分支版本,也是 F5 NGINX 中国区全年最盛大的线上旗舰会议。

本次会议预计将于 2022 年 12 月初举办,我们将分享最热门的行业趋势以及 NGINX 的最新动态,并且探讨与 NGINX 以及更多热门开源项目相关的行业案例和最佳实践。NGINX 官方团队也会借此机会与社区进行深入交流,期待听到您的声音和反馈。

我们非常希望有更多的 NGINX 用户参与到会议中来——您可以在 20 分钟的演讲时间内分享任何与 NGINX 相关的内容,并与社区中的开发者和技术爱好者共同探讨交流。

议题方向包括但不限于:

- 使用经验及用户案例

- 技术干货及深入解析

-

实践分享及运维调优

- 行业趋势及周边生态

参与到本次活动,意味着您将参与到一个观看量将过万的线上会议。2022 年 10 月 30 日前提交您的议题,一旦内容入选,您还将获得 NGINX 独家定制的精美大礼一份!

立即通过扫描下方二维码提交议题

有任何问题或是建议,请在本文下方回复评论,或通过 contactme_nginxapac@f5.com 与我们取得联系。

我们期待着与您相约 NGINX Sprint China 2022 线上大会,一同畅游 NGINX 的斑斓世界!

原文作者:Amir Rawdat of F5

原文链接:更新:为NGINX配置免费的Let’s Encrypt SSL/TLS 证书

转载来源:NGINX 官方网站

众所周知,网站的 SSL/TLS 加密会为您的用户带来更靠前的搜索排名和更出色的安全性。但目前有许多障碍阻碍了网站所有者采用 SSL。

其中两个最大障碍是证书获取成本高昂和所涉人工流程繁琐。而现在,有了 Let’s Encrypt,这些都不再是问题。Let’s Encrypt 支持所有人免费使用 SSL/TLS 加密。

Let’s Encrypt 是一家免费、开放、自动化的证书颁发机构 (CA)。是的,没错Let’s Encrypt颁发的 SSL/TLS 证书是免费的。现今的大多数浏览器都信任 Let’s Encrypt 颁发的证书,包括旧版浏览器,例如 Windows XP SP3 上的 Internet Explorer。此外,Let’s Encrypt 实现了证书颁发和更新的全自动化。

NGINX 对于成为 Let’s Encrypt 的赞助者之一感到非常骄傲。

本文介绍了如何使用 Let’s Encrypt 客户端生成证书,以及如何自动配置 NGINX 开源版和 NGINX Plus 以使用这些证书。

Let’s Encrypt 的工作原理

在颁发证书之前,Let’s Encrypt 会验证域名的所有权。在您的主机上运行的 Let’s Encrypt 客户端将创建一个临时文件(一个令牌),其中包含所需的信息。然后,Let’s Encrypt 验证服务器会发出 HTTP 请求以检索文件并验证令牌,从而验证您域名的 DNS 记录是否解析到运行 Let’s Encrypt 客户端的服务器。

准备工作

在开始使用 Let’s Encrypt 之前,您需要:

- 安装NGINX开源版或NGINX Plus。

- 如果没有注册域名,可以在域名注册商处申请。

- 创建一条DNS记录,将您的域名和服务器的IP地址关联。

_现在可以使用NGINX版本或NGINX_开源设置设置(为了便于阅读NGINX Plus,您可以方便地使用密码统称为)。

注:我们在 Ubuntu 16.04 (Xenial) 上测试了本文所述的程序。

1、下载 Let’s Encrypt 客户端

首先,下载 Let’s Encrypt 客户端。

1. 上面那个,我们在 Ubuntu6.04 测试相关指令,下面是在平台上运行的相应命令:

使用 Ubuntu 18.04 和更高版本,替代 Python 3 版本:

2、设置NGINX

可以自动完成 NGINX 的 SSL/TLS 配置修改。它会在您的 N 配置中查找并包含指令(包含您的委托请求的域名)在我们的示例中,域名为www.example.com。

-

您在全新的 NGINX 安装上进行设置,请使用文本编辑器在/etc/nginx/conf.d目录中创建一个名为域名的.conf文件(在我们的示例中为www.example。 com.conf)。

-

使用指令指定您的域名(如果域名有变体的话请指定):

-

保存文件,然后运行以下命令来验证配置的语法并重新启动 NGINX:

3、获取 SSL/TLS 证书

certbot 的 NGINX 插件负责重新配置 NGINX,并在必要时重新加载其配置。

-

运行以下命令,使用 NGINX 插件生成证书:

-

根据 certbot 的提示配置 HTTPS 设置,包括输入您的电子邮件地址并同意 Let’s Encrypt 服务条款。

证书生成后,NGINX 重新加载新设置。certbot 生成一条消息,显示证书成功生成,并指示证书在服务器上的位置。

注: Encrypt 90 节后让在证书中(在本例中,自动时间为 2017 年 12 月 12 日)。让更新证书的信息,请参阅“更新加密证书”。

如果查看域名.conf,您会发现已经进行了修改:

4、自动更新 Let’s Encrypt 证书

Let’s Encrypt 证书 90 天后将执行更新操作文件。我们建议您自动在此处,我们将一个添加到现有的cron中,以这一点。

-

打开crontab文件。

-

添加示例,命令设置为每天运行中,我们每天运行该命令。该命令检查服务器上的证书未来 30 是否正常使用本协议,如果是,则不要更新指示建议生成输出。

-

保存并文件。所有已安装的证书将自动更新并重新加载。

总结

那么,我们用SSL/来加密SSL/来注册域名证书,然后配置加密证书,更新更新更新。借助GINX和NGINX Encrypt Encrypt’s’s,您可以在加密证书中轻松安装Nx一个安全的网站。

更多资源

想要更及时全面地获取 NGINX 相关的技术干货、互动问答、系列课程、活动资源?

请前往 NGINX 开源社区:

-

官网:https://www.nginx.org.cn/

-

微信公众号:https://sigusoft.com/s/XVE5yvDbmJtpV2alsIFwJg

-

微信群:https://www.nginx.org.cn/static/pc/images/homePage/QR-code.png?v=

-

B 站:https://space.bilibili.com/

目录

前言

1、数据表介绍

2、初始化(创建表并插入测试数据)

SQL习题

1、统计各科成绩>=70 de 人数:课程编号,课程名称, 人数及所占百分比

2、查询各科成绩前三名的记录

3、查询每门课程被选修的学生数

4、查询出只选修两门课程的学生学号和姓名

5、查询男生女生人数

6、查询名字中含有「风」字的学生信息

7、查询同名学生名单,并统计同名人数

8、查询 1990 年出生的学生名单

9、查询每门课程的平均成绩,结果按平均成绩降序排列,平均成绩相同时,按课程编号升序排列

10、查询平均成绩大于等于 85 的所有学生的学号、姓名和平均成绩

11、查询课程名称为「数学」,且分数低于 60 的学生姓名和分数

12、查询所有学生的课程及分数情况(存在学生没成绩,没选课的情况)

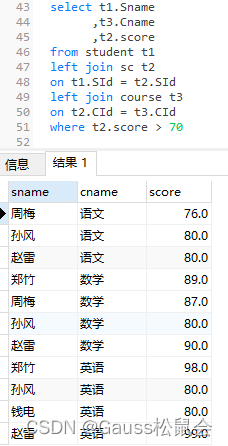

13、查询任何一门课程成绩在 70 分以上的姓名、课程名称和分数

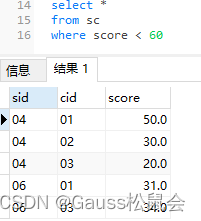

14、查询不及格的课程

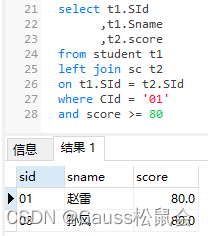

15、查询课程编号为 01 且课程成绩在 80(含80) 分以上的学生的学号和姓名

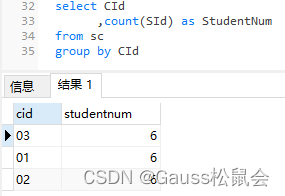

16、求每门课程的学生人数

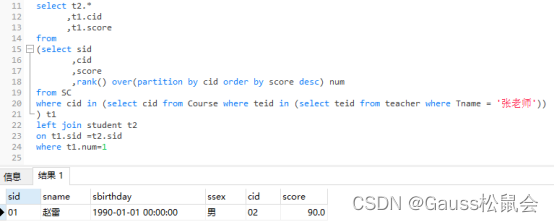

17、查询选修「张老师」所授课程的学生中,成绩最高的学生信息及其成绩

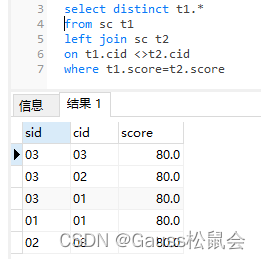

18、查询不同课程 但成绩相同的 学生的学生编号、课程编号、学生成绩

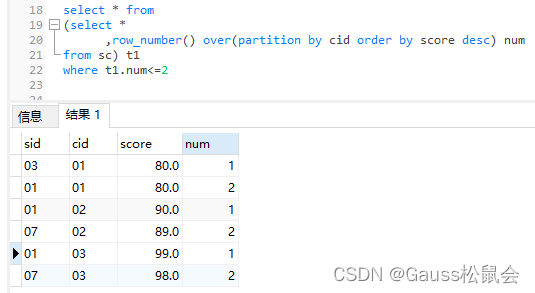

19、查询每门功课成绩最好的前两名

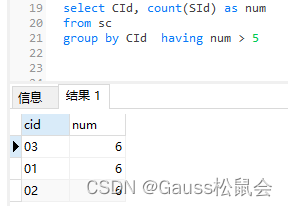

20、统计每门课程的学生选修人数(超过 5 人的课程才统计)

21、检索至少选修三门课程的学生的学生信息

24、按照出生日期来算

25、查询本周过生日的学生

实验小结

1、to_char(datetime/interval [, fmt]) 函数

2、获取系统当前的时间(日期)

3、TIMESTAMPDIFF 函数

4、age函数

5、EXTRACT函数

前言 数据库方向的研究和开发大致可以分为三个方向:一是数据库内核开发(自研等)、二是数据库系统管理(类似DBA的角色)、三是数据库应用开发(业务+SQL)。 内核开发可能需要有钻研创新的能力,比如一些数据库产品本身的自研工作等;DBA可能需要有系统架构、实施经验、以及整体管理的解决方案能力;应用开发则需要具有将业务快速转换成SQL的实现能力。所以说,以上三点纵贯“数据库的整个生命周期” 。

本文将在上一篇《SQL经典练习题(上)》 的基础上继续练习。 因为SQL的学习途径之一就是练习,俗话说,熟能生巧嘛!

1、数据表介绍 –学生表:Student(SId,Sname,Sage,Ssex) –SId 学生编号,Sname 学生姓名,Sage 出生年月,Ssex 学生性别

–课程表:Course(CId,Cname,TeId) –CId 课程编号,Cname 课程名称,TId 教师编号

–教师表Teacher(TeId,Tname) –TId 教师编号,Tname 教师姓名

–成绩表:SC(SId,CId,score) –SId 学生编号,CId 课程编号,score 分数

2、初始化(创建表并插入测试数据) 学生表Student

create table Student(SId varchar(10),Sname varchar(10),Sbirthday date,Ssex varchar(10));

insert into Student values(’01’ , ‘赵雷’ , date ‘1990-01-01’ , ‘男’);

insert into Student values(’02’ , ‘钱电’ , date ‘1990-12-21’ , ‘男’);

insert into Student values(’03’ , ‘孙风’ , date ‘1990-12-20’ , ‘男’);

insert into Student values(’04’ , ‘李云’ , date ‘1990-12-06’ , ‘男’);

insert into Student values(’05’ , ‘周梅’ , date ‘1991-12-01’ , ‘女’);

insert into Student values(’06’ , ‘吴兰’ , date ‘1992-01-01’ , ‘女’);

insert into Student values(’07’ , ‘郑竹’ , date ‘1989-01-01’ , ‘女’);

insert into Student values(’09’ , ‘张三’ , date ‘2017-12-20’ , ‘女’);

insert into Student values(’10’ , ‘李四’ , date ‘2017-12-25’ , ‘女’);

insert into Student values(’11’ , ‘李四’ , date ‘2012-06-06’ , ‘女’);

insert into Student values(’12’ , ‘赵六’ , date ‘2013-06-13’ , ‘女’);

insert into Student values(’13’ , ‘孙七’ , date ‘2014-06-01’ , ‘女’);

课程表 Course

create table Course(CId varchar(10),Cname varchar(10),TeId varchar(10));

insert into Course values(’01’ , ‘语文’ , ’02’);

insert into Course values(’02’ , ‘数学’ , ’01’);

insert into Course values(’03’ , ‘英语’ , ’03’);

教师表 Teacher

create table Teacher(Teid varchar(10),Tname varchar(10));

insert into Teacher values(’01’ , ‘张老师’);

insert into Teacher values(’02’ , ‘李老师’);

insert into Teacher values(’03’ , ‘王老师’);

成绩表 SC

create table SC(SId varchar(10),CId varchar(10),score decimal(18,1));

insert into SC values(’01’ , ’01’ , 80);

insert into SC values(’01’ , ’02’ , 90);

insert into SC values(’01’ , ’03’ , 99);

insert into SC values(’02’ , ’01’ , 70);

insert into SC values(’02’ , ’02’ , 60);

insert into SC values(’02’ , ’03’ , 80);

insert into SC values(’03’ , ’01’ , 80);

insert into SC values(’03’ , ’02’ , 80);

insert into SC values(’03’ , ’03’ , 80);

insert into SC values(’04’ , ’01’ , 50);

insert into SC values(’04’ , ’02’ , 30);

insert into SC values(’04’ , ’03’ , 20);

insert into SC values(’05’ , ’01’ , 76);

insert into SC values(’05’ , ’02’ , 87);

insert into SC values(’06’ , ’01’ , 31);

insert into SC values(’06’ , ’03’ , 34);

insert into SC values(’07’ , ’02’ , 89);

insert into SC values(’07’ , ’03’ , 98);

SQL习题

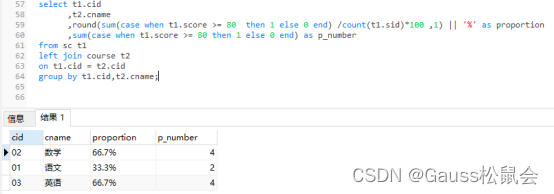

1、统计各科成绩>=70 de 人数:课程编号,课程名称, 人数及所占百分比

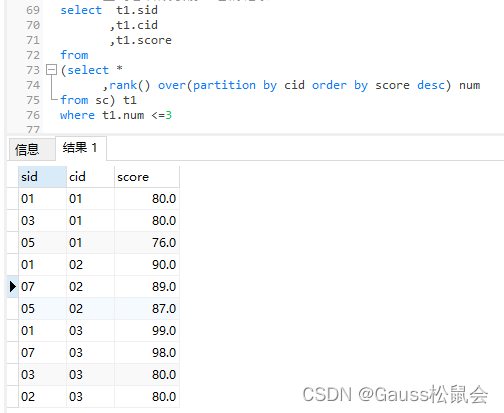

2、查询各科成绩前三名的记录

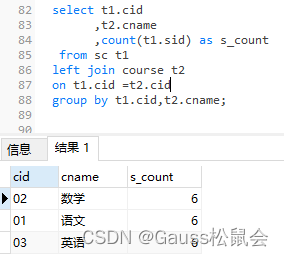

3、查询每门课程被选修的学生数

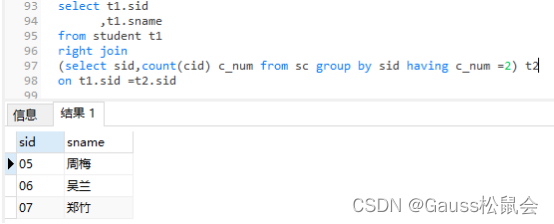

4、查询出只选修两门课程的学生学号和姓名

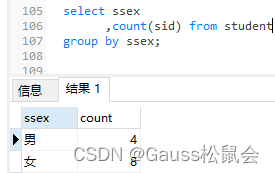

5、查询男生女生人数

6、查询名字中含有「风」字的学生信息

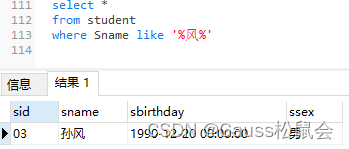

7、查询同名学生名单,并统计同名人数

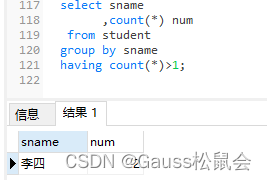

8、查询 1990 年出生的学生名单

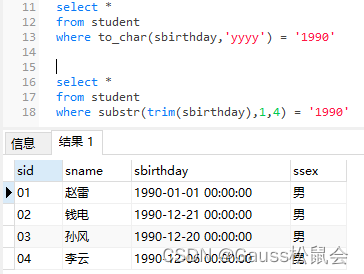

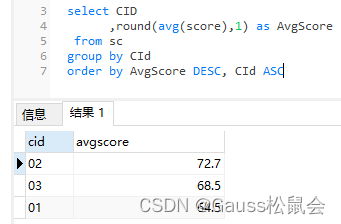

9、查询每门课程的平均成绩,结果按平均成绩降序排列,平均成绩相同时,按课程编号升序排列

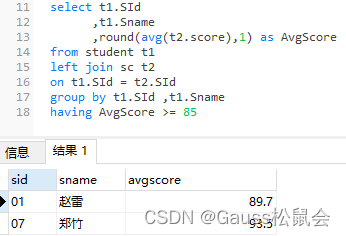

10、查询平均成绩大于等于 85 的所有学生的学号、姓名和平均成绩

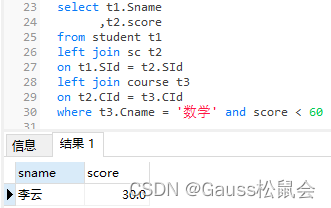

11、查询课程名称为「数学」,且分数低于 60 的学生姓名和分数

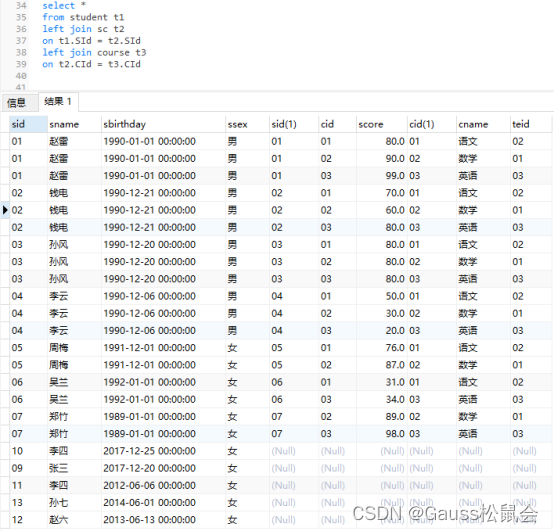

12、查询所有学生的课程及分数情况(存在学生没成绩,没选课的情况)

13、查询任何一门课程成绩在 70 分以上的姓名、课程名称和分数

14、查询不及格的课程

15、查询课程编号为 01 且课程成绩在 80(含80) 分以上的学生的学号和姓名

16、求每门课程的学生人数

17、查询选修「张老师」所授课程的学生中,成绩最高的学生信息及其成绩

18、查询不同课程 但成绩相同的 学生的学生编号、课程编号、学生成绩

19、查询每门功课成绩最好的前两名

20、统计每门课程的学生选修人数(超过 5 人的课程才统计)

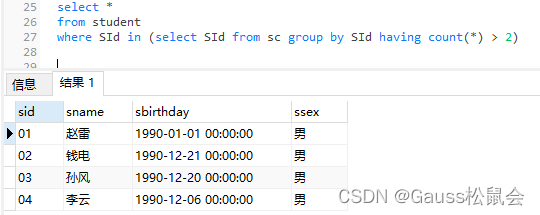

21、检索至少选修三门课程的学生的学生信息

22、查询选修了全部课程的学生信息

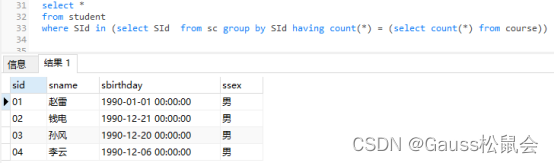

23、查询各学生的年龄,只按年份来算

24、按照出生日期来算

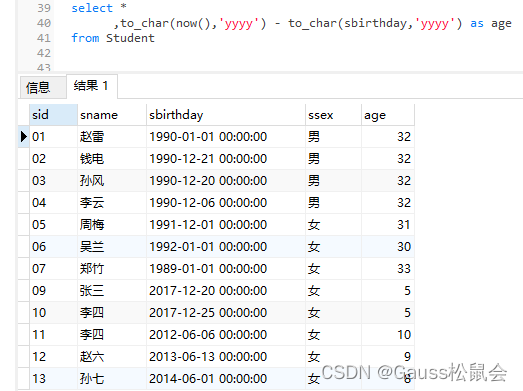

25、查询本周过生日的学生

实验小结 根据上文的测试过程, 如下整理了一些openGauss数据库相关的函数:

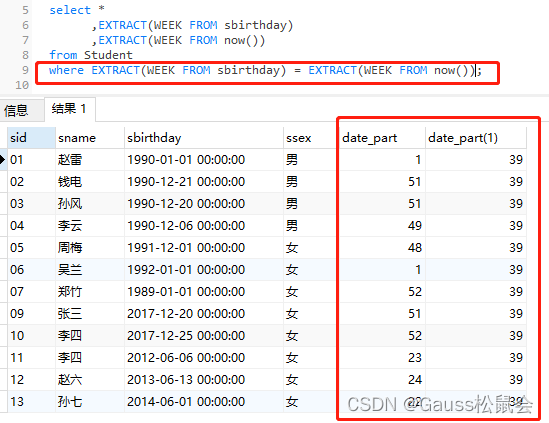

1、to_char(datetime/interval [, fmt]) 函数

描述:将一个DATE、TIMESTAMP、TIMESTAMP WITH TIME ZONE或者TIMESTAMP WITH LOCAL TIME ZONE类型的DATETIME或者INTERVAL值按照fmt指定的格式转换为VARCHAR类型。

可选参数fmt可以为以下几类:日期、时间、星期、季度和世纪。每类都可以有不同的模板,模板之间可以合理组合,常见的模板有:HH、MI、SS、YYYY、MM、DD。 模板可以有修饰词,常用的修饰词是FM,可以用来抑制前导的零或尾随的空白。 返回值类型:varchar

2、获取系统当前的时间(日期) clock_timestamp() ,

描述:实时时钟的当前时间戳。返回值类型:timestamp with time zone current_date, 描述:当前日期。返回值类型:date current_time,描述:当前时间。返回值类型:time with time zone current_timestamp ,描述:当前日期及时间。返回值类型:timestamp with time zone pg_systimestamp() , 描述:当前日期及时间。返回值类型:timestamp with time zone localtime,描述:当前时间。返回值类型:time localtimestamp,描述:当前日期及时间。返回值类型:timestamp now(),描述:当前日期及时间。返回值类型:timestamp with time zone timenow,描述:当前日期及时间。返回值类型:timestamp with time zone

3、TIMESTAMPDIFF 函数

TIMESTAMPDIFF(unit , timestamp_expr1, timestamp_expr2)

timestampdiff函数是计算两个日期时间之间(timestamp_expr2-timestamp_expr1)的差值,并以unit形式返回结果。timestamp_expr1,timestamp_expr2必须是一个timestamp、timestamptz、date类型的值表达式。unit表示的是两个日期差的单位。

说明:该函数仅在openGauss兼容MY类型时(即dbcompatibility = ‘B’)有效,其他类型不支持该函数。(dbcompatibility的取值: A、B、C、PG ,具体对应是Oracle、MySql、Teradata、PostgreSql 数据库)

4、age函数 age(timestamp, timestamp),

描述:将两个参数相减,并以年、月、日作为返回值。若相减值为负,则函数返回亦为负。 返回值类型:interval age(timestamp),描述:当前时间和参数相减。返回值类型:interval 5、EXTRACT函数 EXTRACT(field_ _FROM source),extract函数从日期或时间的数值里抽取子域,比如年、小时等。source必须是一个timestamp、time或interval类型的值表达式(类型为date的表达式转换为timestamp,因此也可以用)。field是一个标识符或者字符串,它指定从源数据中抽取的域。extract函数返回类型为double precision的数值。

示例:

openGauss: 一款高性能、高安全、高可靠的企业级开源关系型数据库。

🍒如果您觉得博主的文章还不错或者有帮助的话,请关注一下博主,如果三连点赞评论收藏就更好啦!谢谢各位大佬给予的支持!

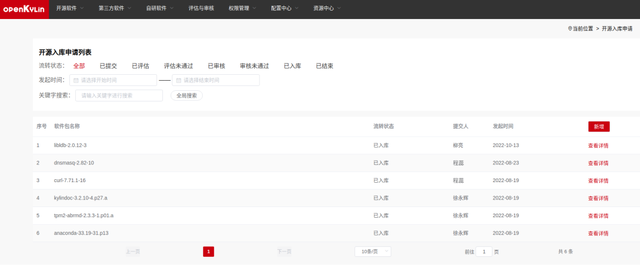

2022年9月,经openKylin社区技术委员会审议通过,由openKylin个人开发者张文涛主导发起的QuarkAI SIG正式成立。

QuarkAI SIG(QuarkAISpecial Interest Group)以openKylin操作系统为基础,主要负责openKylin社区的AI生态、AI平台开发。在当今世界,AI技术正在飞速发展、不断创新,未来在这一领域将有无数机遇和挑战,QuarkAI SIG组将紧跟前沿技术,不忘初心,立志把openKylin社区的AI生态、AI平台做大做强!

01

SIG职责及当前工作规划

1、AI语音助手,开发、维护以及规范化;

2、AI编程助手平台,编译器开发、相应编程语言开发;

3、AI物联网功能平台,开发、生态维护。

02

SIG成员介绍

QuarkAI SIG Owner张文涛,一个精通C、Java、Python的小伙,爱好运动,闲暇时间喜欢钻研单片机。

【个人标签】

- 码而生,码而立。

- 仰慕「优雅编码的艺术」。

- 坚信熟能生巧,努力改变人生。

03

欢迎加入QuarkAI SIG

1、订阅SIG组邮件列表

QuarkAI SIG组内的各种会议信息、重要结论等都会通过邮件列表通知。欢迎大家订阅我们的邮件列表:quarkai@lists.openkylin.top

2、参加SIG组会议

QuarkAI SIG组将会通过邮件列表或者官方交流群即时公布本SIG组的各项会议的议题、会议时间、参与方式等会议信息。

3、参与SIG组贡献

- 注册 gitee 账号

- 签署 openKylin CLA:https://cla.openkylin.top/

- 前往项目仓库贡献:https://gitee.com/openkylin/quarkai

openKylin(开放麒麟)社区旨在以“共创”为核心,在开源、自愿、平等、协作的基础上,通过开源、开放的方式与企业构建合作伙伴生态体系,共同打造桌面操作系统顶级社区,推动Linux开源技术及其软硬件生态繁荣发展。

社区首批理事成员单位包括麒麟软件、普华基础软件、中科方德、麒麟信安、凝思软件、一铭软件、中兴新支点、心科技、中国电科32所、技德系统、北京麟卓、先进操作系统创新中心等13家产业同仁和行业机构。

通讯来源:QuarkAI SIG

审核:openKylin

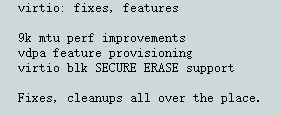

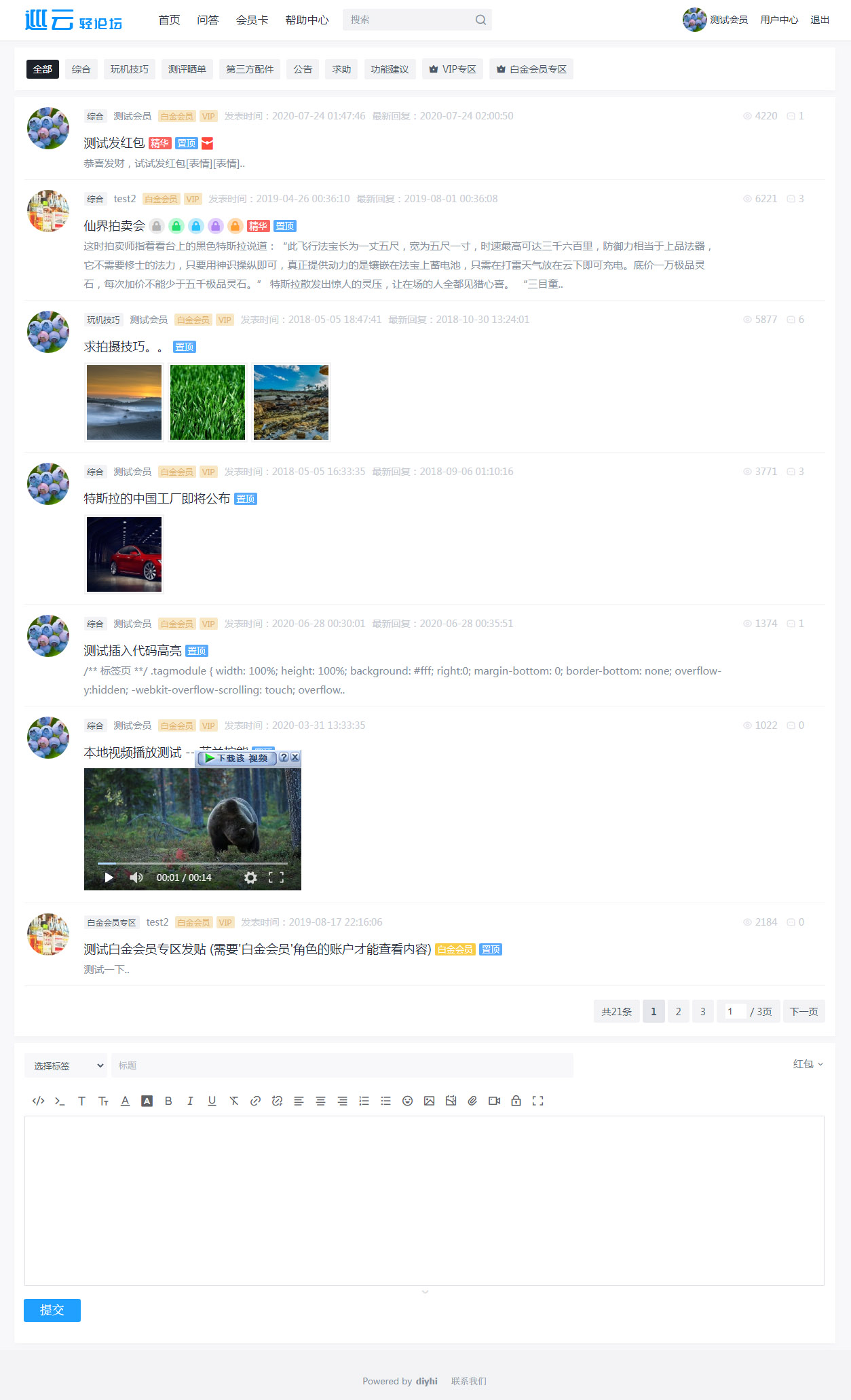

v5.8 主要更新

1、新增电脑版前后端分离模板。

2、升级spring boot版本。

3、修复论坛初始安装版本和正在运行版本相同时,管理后台误点‘升级’按钮会执行升级任务。

4、修复搜索页输入空字符时丢失样式

5、修复管理后台排序输入框没失去焦点时修改值不生效的问题

6、修复手机端输入验证码错误后再次输入时没清空上次错误信息

7、修复手机端用户中心页动态列表滚动到最后一页时懒图片闪烁的问题

8、修复支付查询参数显示限制

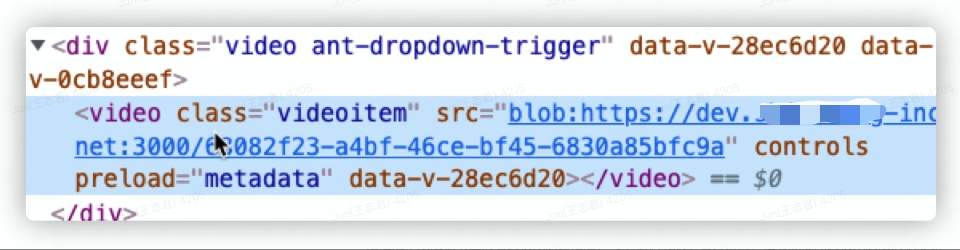

9、修复电脑端用户中心视频无法播放错误

10、修复管理后台代码高亮的复制按钮失效问题

11、修复修改话题超过指定次数不显示验证码的问题

12、修复修改评论超过指定次数不显示验证码的问题

13、修复引用员工发评论或答案时异步执行会员卡赠送任务错误

14、修复移动端用户中心引用评论图片地址没有解析错误

15、修复评论引用数据删除状态时显示不正确

16、json允许出现特殊字符和转义符

轻论坛系统简介

巡云轻论坛系统包含论坛、问答模块。系统采用 JAVA+MYSQL 架构,自适应手机端和电脑端,界面简洁,性能高效。数据库表结构设计使用分表方案,提高系统的负载能力。 后台数据库备份 / 还原、全站指定目录打包、一键自动升级等功能使维护简单方便。

演示网站:http://www.diyhi.com/cms.html页面可获取前后台演示地址、登录账号和密码 (Spring 版)

开源代码托管平台

码云 (Spring 版):https://gitee.com/diyhi/bbs

码云 (Spring Boot 版):https://gitee.com/diyhi/bbs-pro

github (Spring 版):https://github.com/diyhi/bbs

码云 (前台前后端分离电脑版前端):https://gitee.com/diyhi/bbs-web-pc

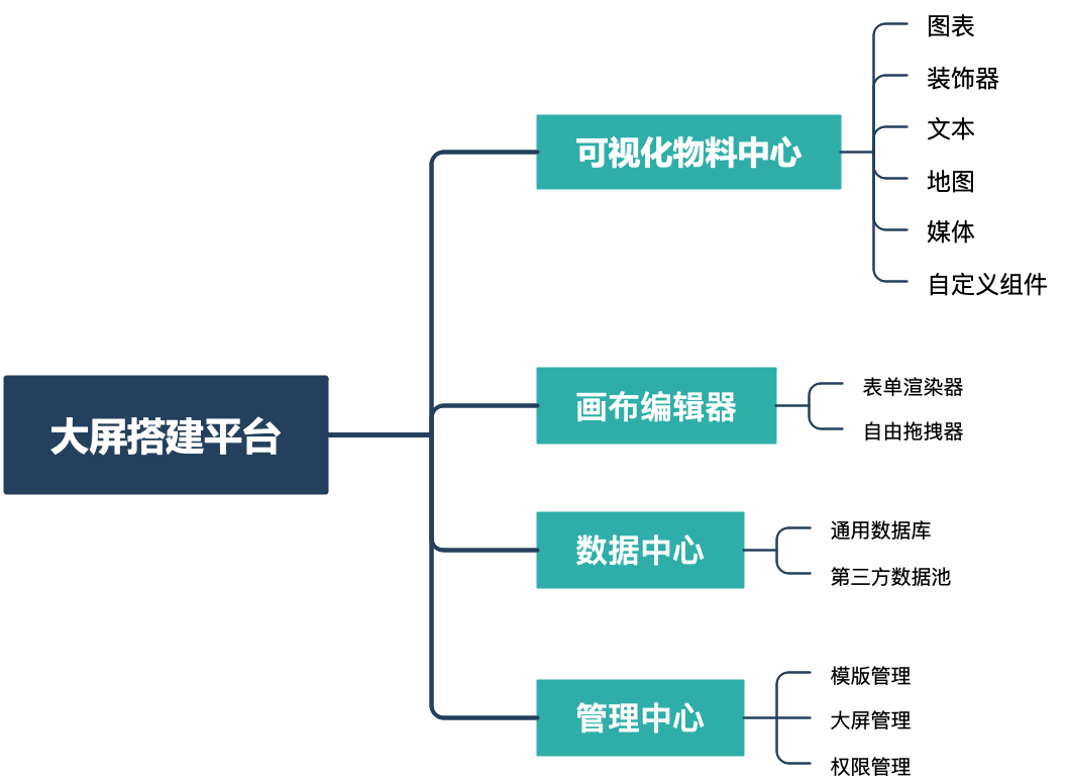

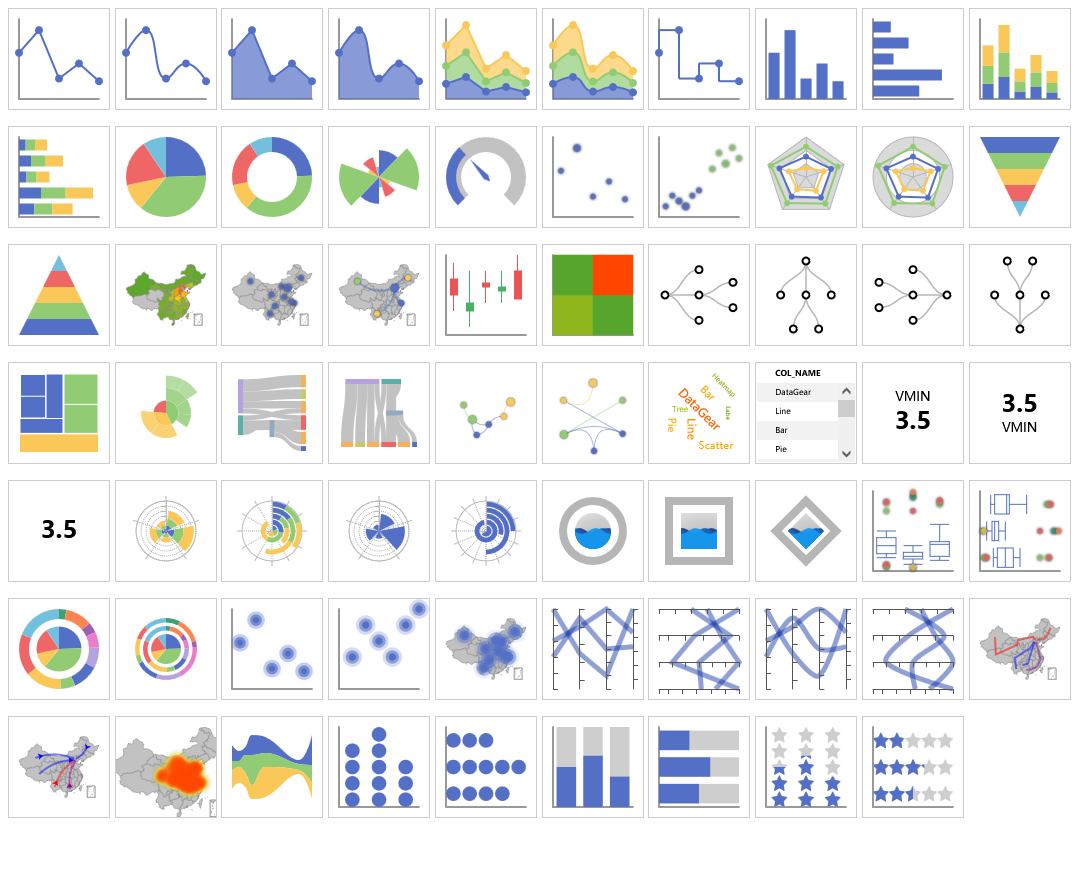

DataGear 4.1.0 发布,增强自定义图表插件支持功能,具体更新内容如下:

- 新增:看板可视编辑模式新增插入弹性布局、插入标题功能;

- 新增:看板新增dg-loadable-chart-widgets素属性,用于控制异步加载图表权限;

- 新增:自定义图表插件支持附带资源文件;

- 新增:自定义图表插件新增renderer.js文件规范,用于独立定义图表渲染器逻辑;

- 新增:图表JS对象新增pluginResources()函数,用于为渲染插件资源的图表提供支持;

- 新增:图表JS对象新增pluginResourceURL()函数,用于为渲染插件资源的图表提供支持;

- 新增:Excel数据集新增工作表名称设置功能,并支持参数化语法;

- 新增:数据源模块新增设置连接属性功能;

- 新增:数据源模块新增复制数据源基本信息功能;

- 新增:数据源模块新增查看表结构基本信息功能;

- 改进:看板分享密码改为默认以明文方式存储,并支持配置为加密方式;

- 改进:图表展示页面自动适配当前系统主题;

- 改进:图表表单页面可查看选定插件描述信息;

- 改进:数据集资源目录隐藏目录信息,避免服务端信息泄露;

- 改进:数据源URL帮助添加部分常用国产数据库类型;

- 改进:数据源模块数据表、SQL工作台、导入/导出数据选项卡标题悬浮显示所属数据源信息;

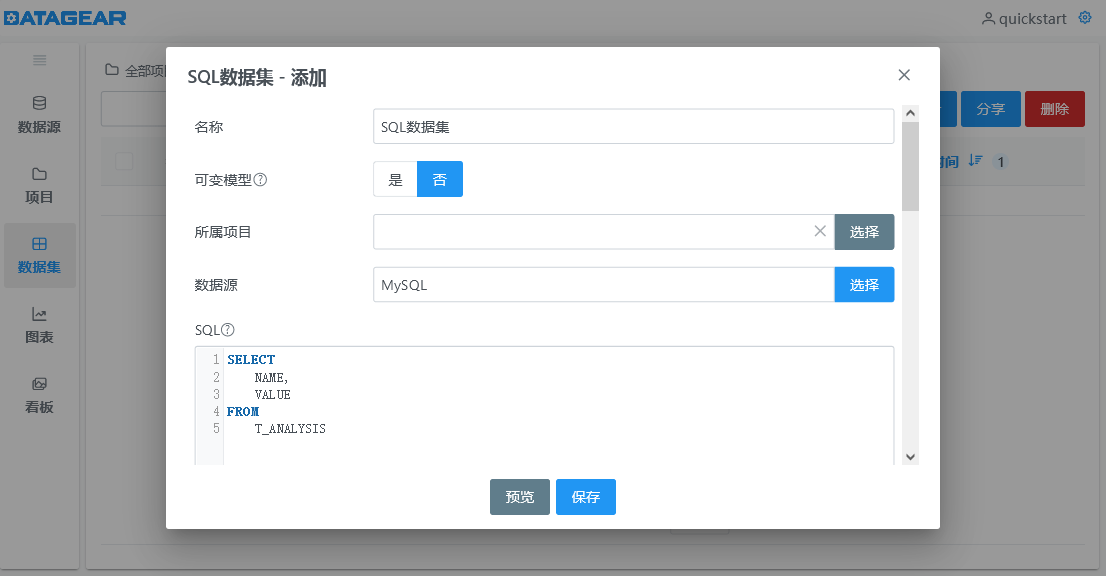

- 改进:SQL工作台、SQL数据集编辑器提示列类型、描述等信息;

- 改进:系统所有管理模块表格可调整列宽;

- 改进:图表支持库ECharts版本由5.3.2升级至5.3.3;

DataGear是一款开源免费的数据可视化分析平台,支持自由制作任何您想要的数据可视化看板。

系统特点:

-

友好接入的数据源

支持运行时接入任意提供 JDBC 驱动的数据库,包括 MySQL、Oracle、PostgreSQL、SQL Server 等关系数据库,以及 Elasticsearch、ClickHouse、Hive 等大数据引擎

-

多样动态的数据集

支持创建 SQL、CSV、Excel、HTTP 接口、JSON 数据集,并可设置为动态的参数化数据集,可定义文本框、下拉框、日期框、时间框等类型的数据集参数,灵活筛选满足不同业务需求的数据

-

强大丰富的数据图表

数据图表可聚合绑定多个不同格式的数据集,轻松定义同比、环比图表,内置折线图、柱状图、饼图、地图、雷达图、漏斗图、散点图、K 线图、桑基图等 70 + 开箱即用的图表,并且支持自定义图表配置项,支持编写和上传自定义图表插件

-

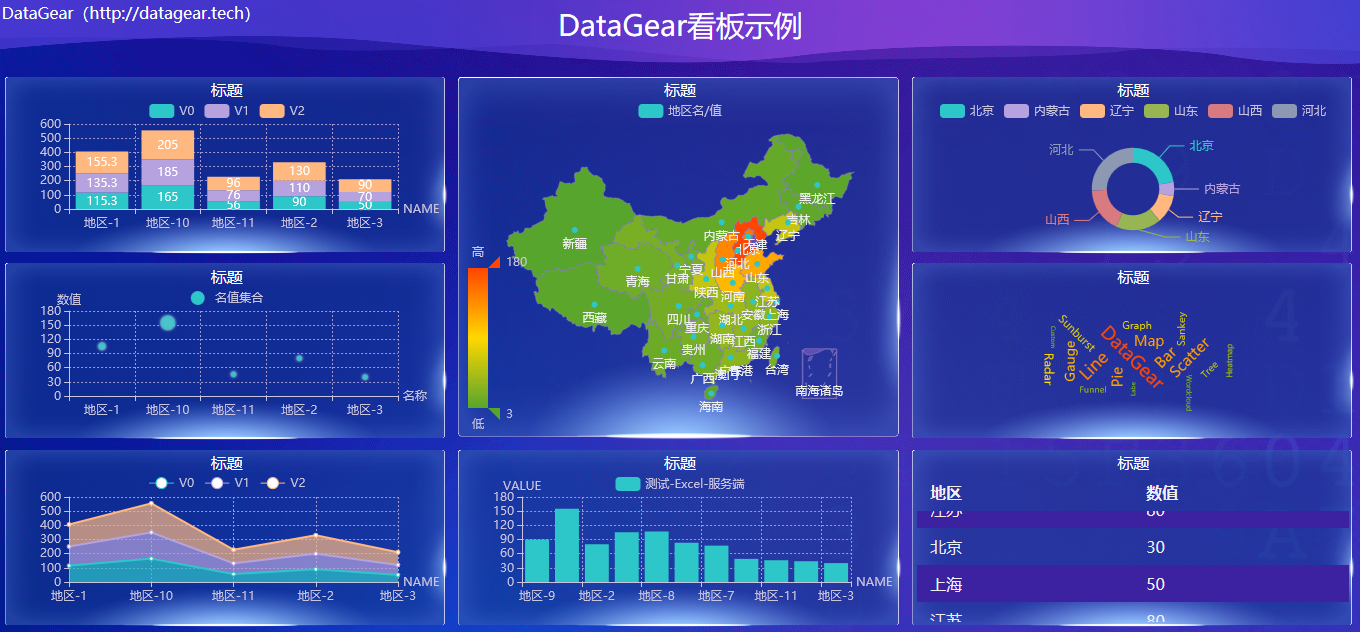

自由开放的数据看板

数据看板采用原生的 HTML 网页作为模板,支持导入任意 HTML 网页,支持以可视化方式进行看板设计和编辑,也支持使用 JavaScript、CSS 等 web 前端技术自由编辑看板源码,内置丰富的 API,可制作图表联动、数据钻取、异步加载、交互表单等个性化的数据看板

官网地址:

http://www.datagear.tech

源码地址:

Gitee:https://gitee.com/datagear/datagear

Github:https://github.com/datageartech/datagear

系统截图:

图表类型

数据源管理

SQL数据集

看板编辑

制作看板

数据钻取

地图联动

看板表单

实时图表

异步加载

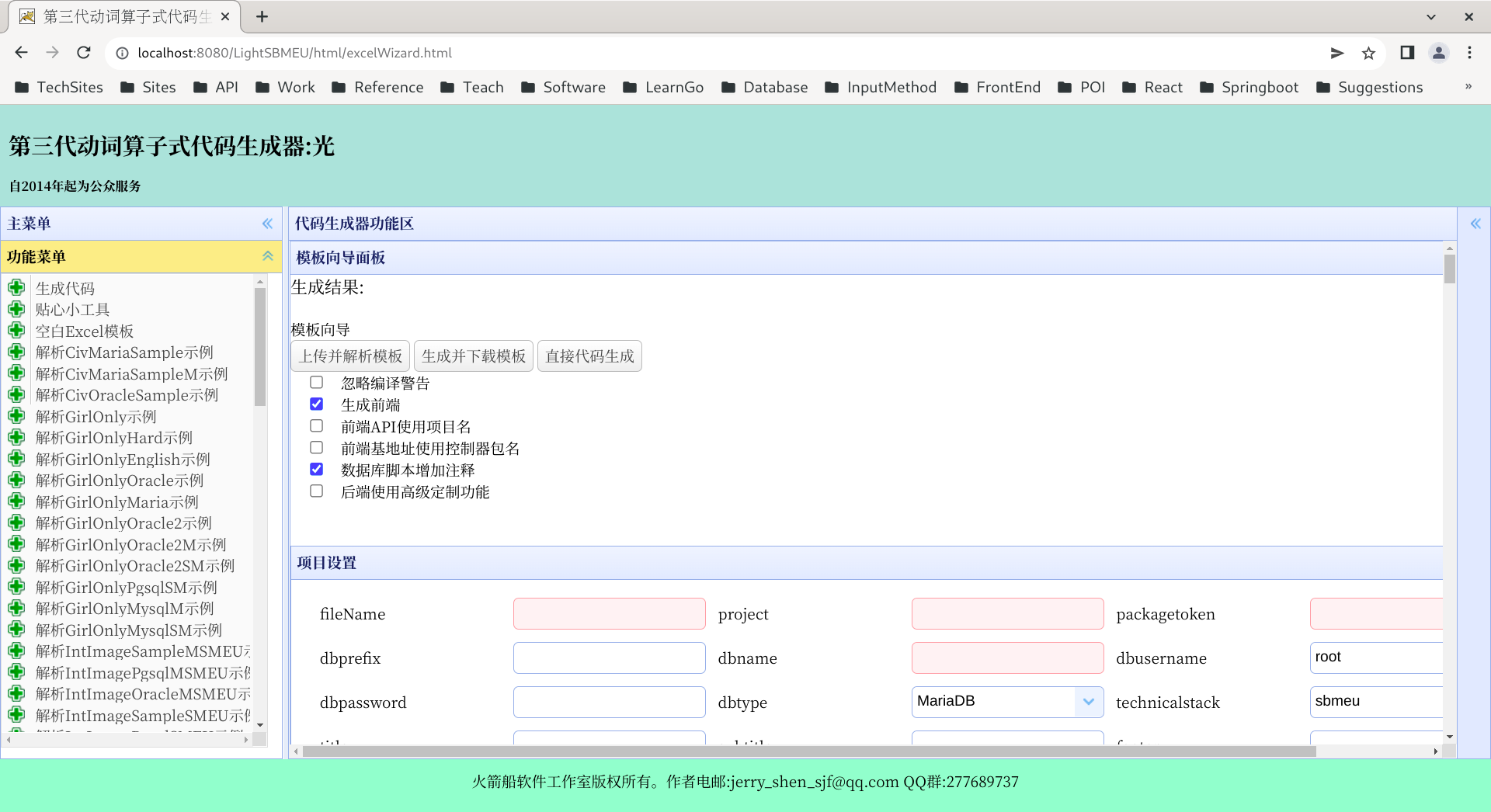

开源 Java 低代码开发平台光2.3.0文明Beta4版,程序员的曲速引擎

开源 Java 低代码开发平台光2.3.0文明Beta4版已发布最新技术讲座视频,详细介绍了光的操作,尤其是从零开始使用的介绍。请参考如下视频:

介绍视频:

Beta4版 B站介绍视频

https://www.bilibili.com/video/BV1Jm4y1A7nW/

Beta2版 B站介绍视频

https://www.bilibili.com/video/BV1H44y1u75P/

Beta版 B站介绍视频

https://www.bilibili.com/video/BV1z34y1Y77Q/

B站技术直播间

https://live.bilibili.com/

光是java开发的曲速引擎是前期和快速原型的神器。欢迎大家使用,反馈。最近,学习了西门子和微软低代码平台的视频。发现大家的低代码平台都基于 Excel 模版。动词算子式代码生成器阵列是市面上最早这么做的低代码平台。我们在和平之翼代码生成器 3.0 时代就实现了这项功能。时间是在 2017 年底。和其他商业的低代码的运行时实现不同。动词算子式代码生成器是一种编译时实现。它将 Excel 模版编译为一套 Java 源码。这套源码是可读的,也是可改的。最大限度满足用户拥有和控制自己的软件的便利。所以,动词算子式代码生成器是低代码和传统开发模式之间的连心桥。

外包程序员的开源 Java 低代码开发平台光 2.3.0 文明版本 Beta4 版已公布,更多测试,更多修错。 显著提升前端权限和复杂版面生成物质量,欢迎使用。本版本对前端的登录权限系统及前后端的复杂版面功能进行了广泛的测试和修错,软件质量大有提升。

光是为外包程序员开发的开源低代码平台。可以完成任何类型的 java 软件 50% 的工作量。却不会显著降低程序员的职位。因为它和市面的低代码平台不同。它不是完成一个一个模块。即横向切入软件开发。它是任何模块都可以完成 50%。即以纵向切入软件开发。

光可以自动匹配前端设置,前端支持图片功能,前端支持 Excel,PDF,Word,PPT 数据导出格式。光目前支持 sbmeu,smeu 和 msmeu 三种技术栈。即支持 SpringBoot 和经典 Spring 构架,支持 MyBatis 技术。其独立前端用 Vue 和 ElementUI 写成。运行于 Node.js 平台上。光支持 MariaDB,MySQL,Oracle,PostgreSQL 四种数据库。光支持弹性登录模块。支持图形报表,支持复杂版面。EasyUI 升级至最新。

请部署在 Tomcat9 webapps 目录下。Beta4 版有更多更新。并更多测试。

项目地址:https://gitee.com/jerryshensjf/LightSBMEU

二进制发布版地址:https://gitee.com/jerryshensjf/LightSBMEU/attach_files

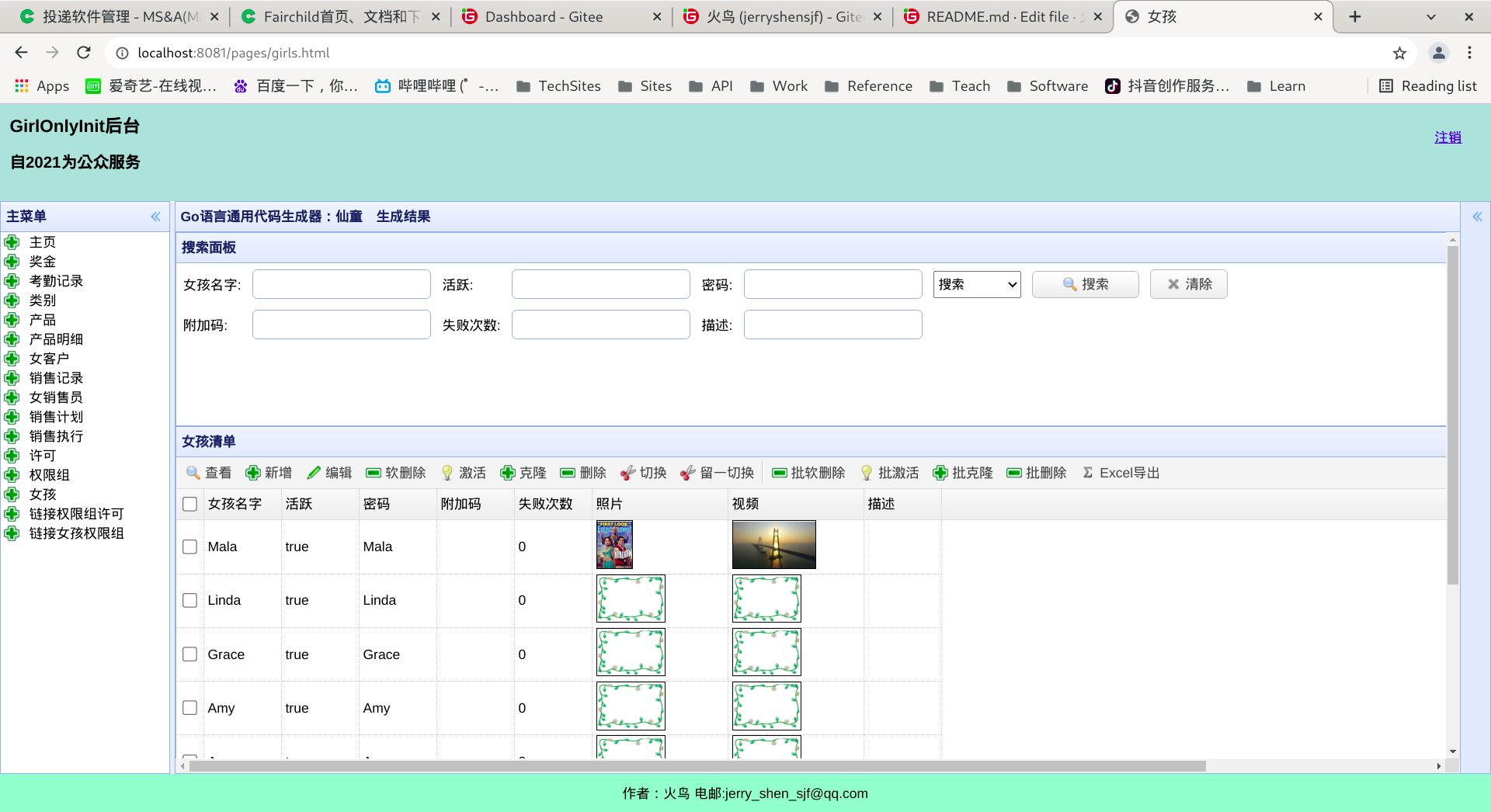

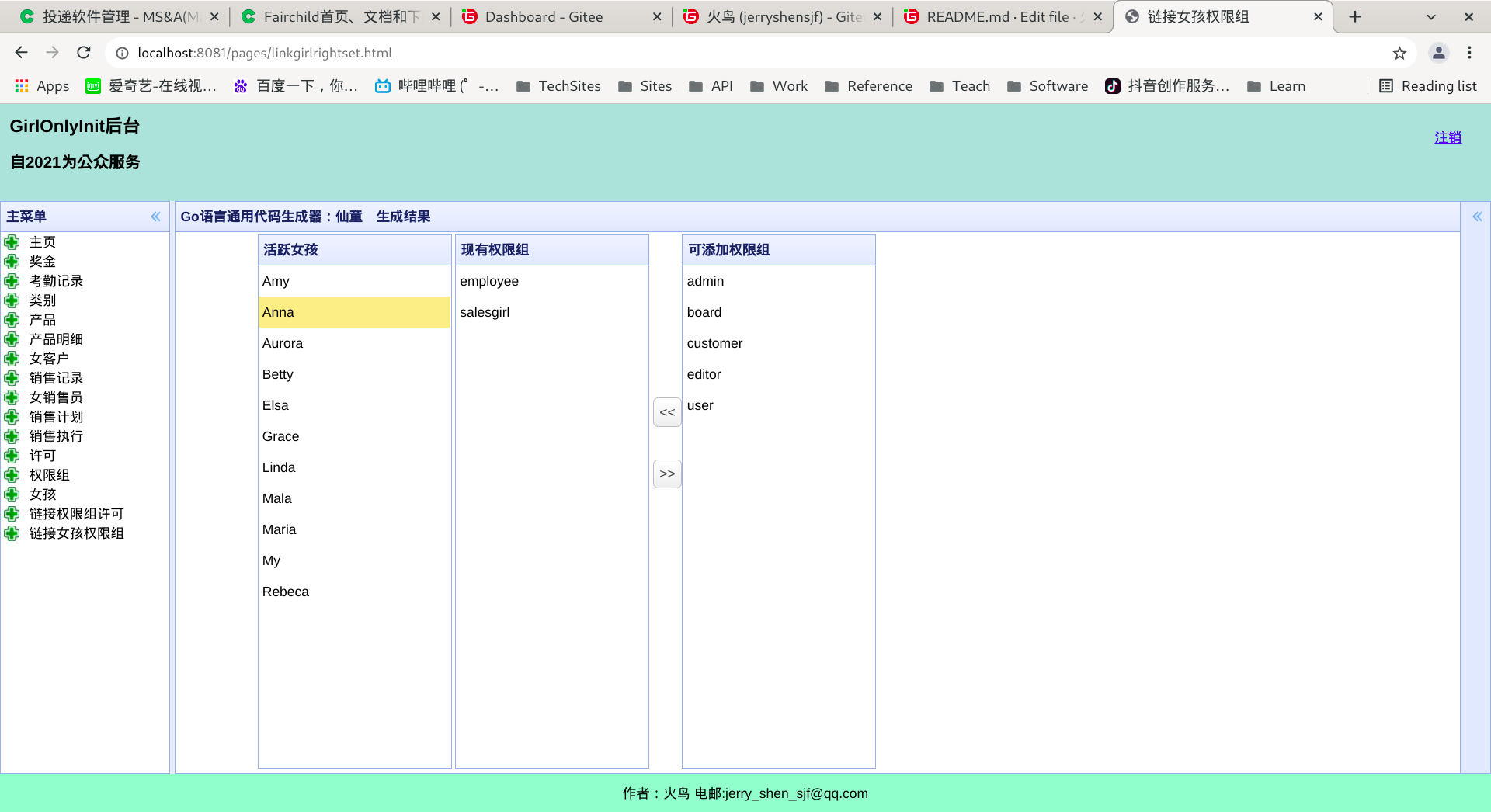

项目图片:

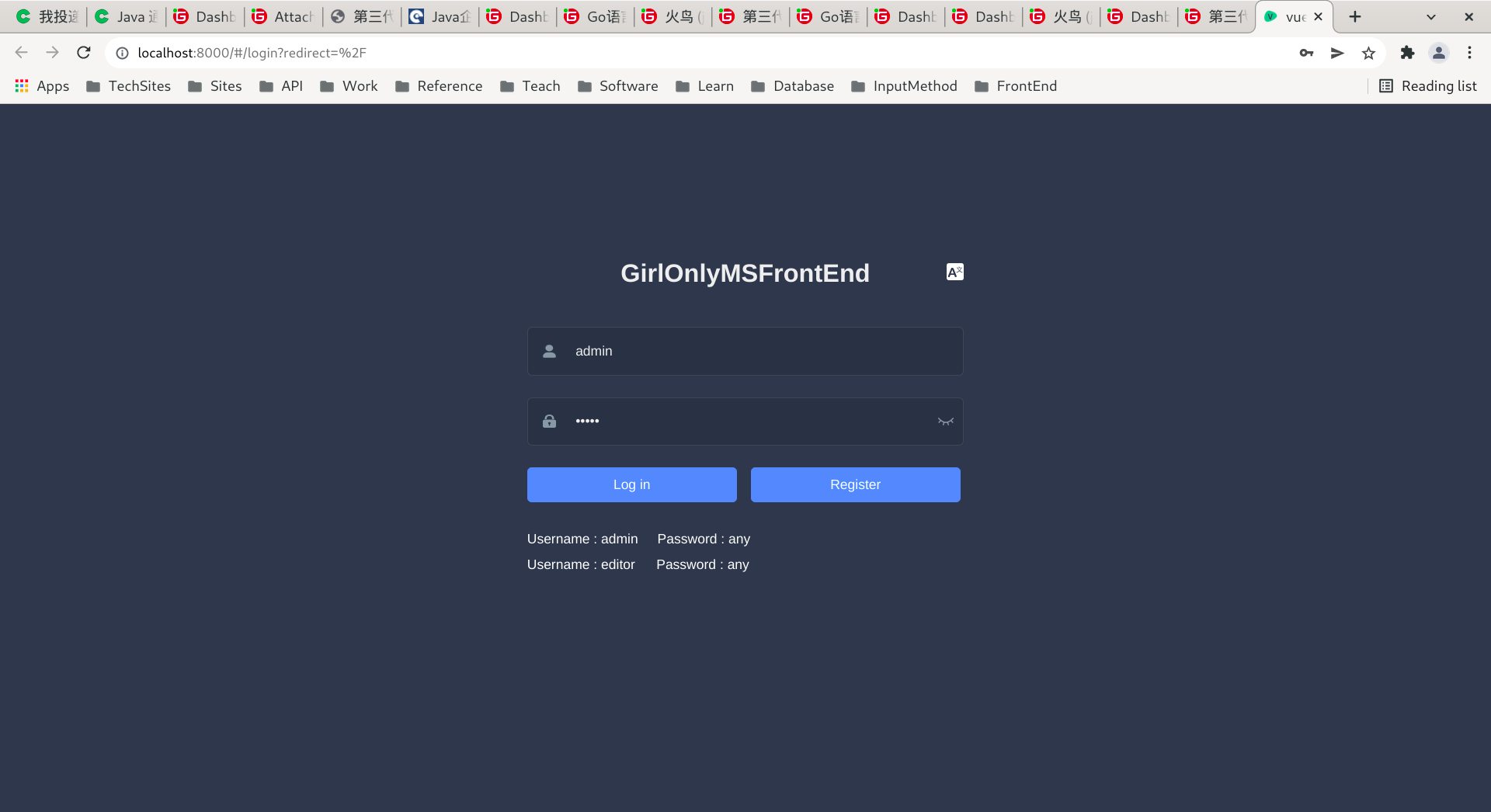

独立前端的登录界面,此界面现在是有功能的

独立前端的内页:

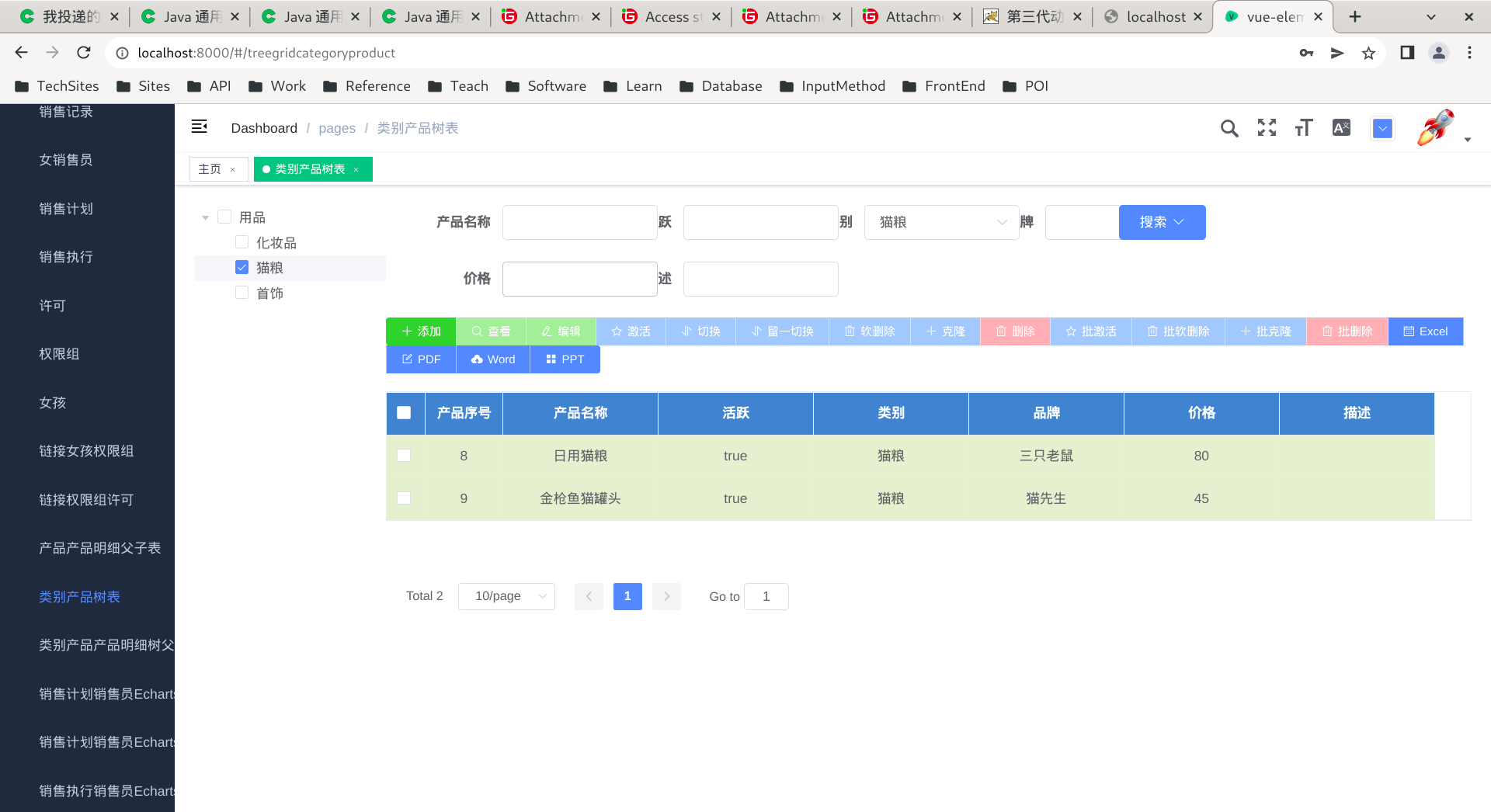

vue 前端复杂版面:树表

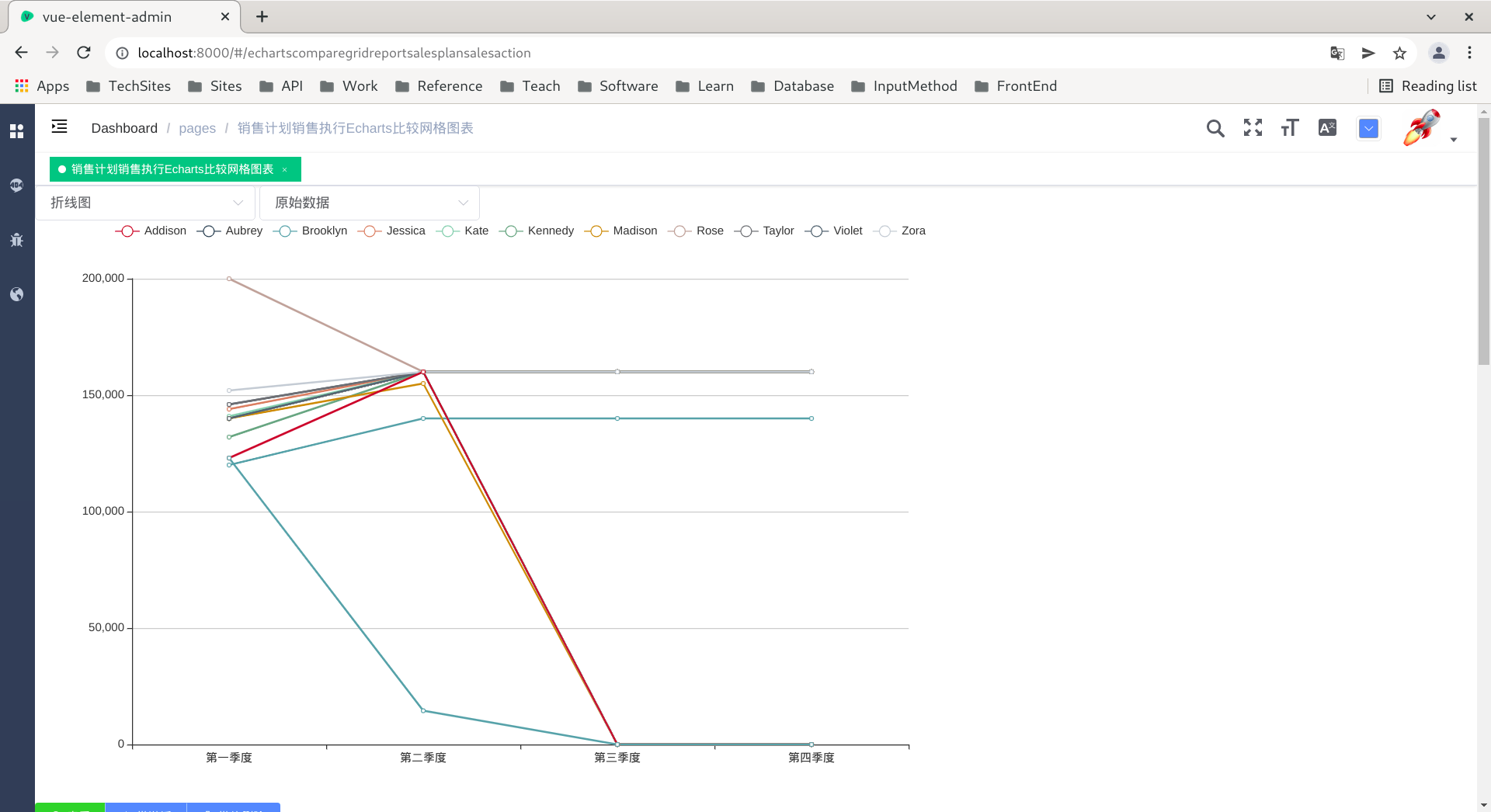

vue 前端图形报表

柱状图:

折线图:

数据库注释的开关复选框请见截图:

后端代码生成物界面截图:

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

漏洞描述

Apache Shiro是 Apache 基金会的一套用于执行认证、授权、加密和会话管理的Java安全框架。

1.10.0 之前的 Apache Shiro,当通过 RequestDispatcher 进行转发或包含时存在身份验证绕过漏洞。

影响范围

org.apache.shiro:shiro-web@[1.0.0-incubating, 1.10.0)

修复方案

将组件 org.apache.shiro:shiro-web 升级至 1.10.0 及以上版本

参考链接

https://www.oscs1024.com/hd/MPS-2022-56931

https://nvd.nist.gov/vuln/detail/CVE-2022-40664

Commit

情报订阅

OSCS(开源软件供应链安全社区)通过最快、最全的方式,发布开源项目最新的安全风险动态,包括开源组件安全漏洞、事件等信息。同时提供漏洞、投毒情报的免费订阅服务,社区用户可通过配置飞书、钉钉、企业微信机器人,及时获得一手情报信息推送:

https://www.oscs1024.com/cm/?src=osc

具体订阅方式详见:

https://www.oscs1024.com/docs/vuln-warning/intro/?src=osc

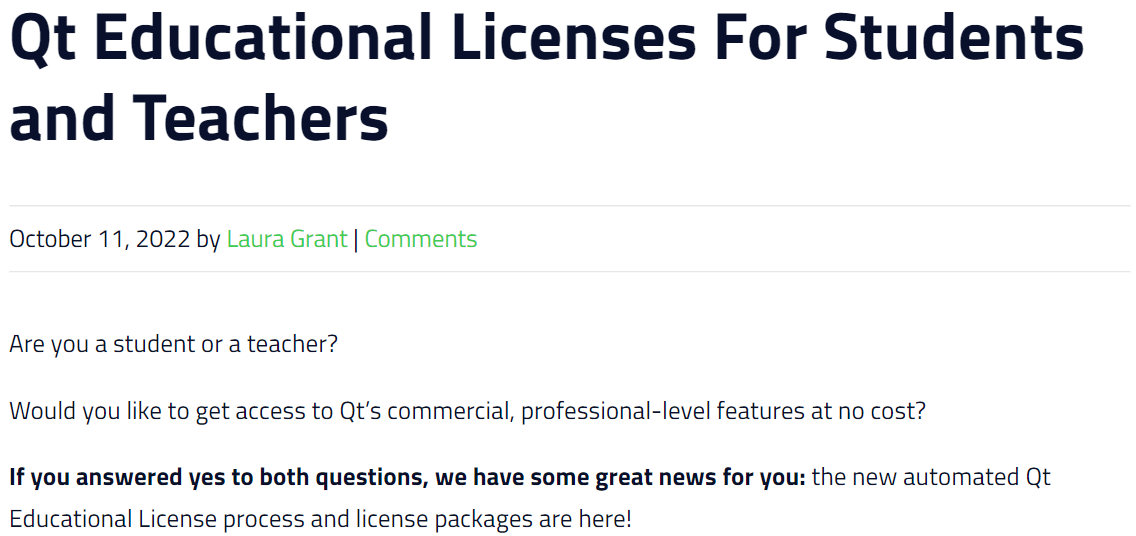

Qt 宣布推出教育版 License,专门面向教育机构的学生和教师(以及其他工作人员)提供,仅用于学习用途,禁止任何商业用途或分发。

根据官方的介绍,学生和教师可免费申请教育版 License,获得教育版 License 后即可使用 Qt 的商业功能,并能够:

- 创建功能丰富和具有视觉吸引力的用户界面

- 从各种设计工具中导入已有的用户界面,如 Figma、Sketch、Adobe XD

- 使用完整的 Python、C++ 和 JavaScript、HTML5 和 QML 框架

- ……

教育版 License 包提供了企业版 Qt Design Studio 和专业版 Qt Device Creation(仅支持 Raspberry Pi),以及 Qt 5.15 LTS 和 Qt 6 的所有版本。

教育版 License 的有效期为 12 个月。到期后,凭借有效的教育邮箱即可每年更新 License。

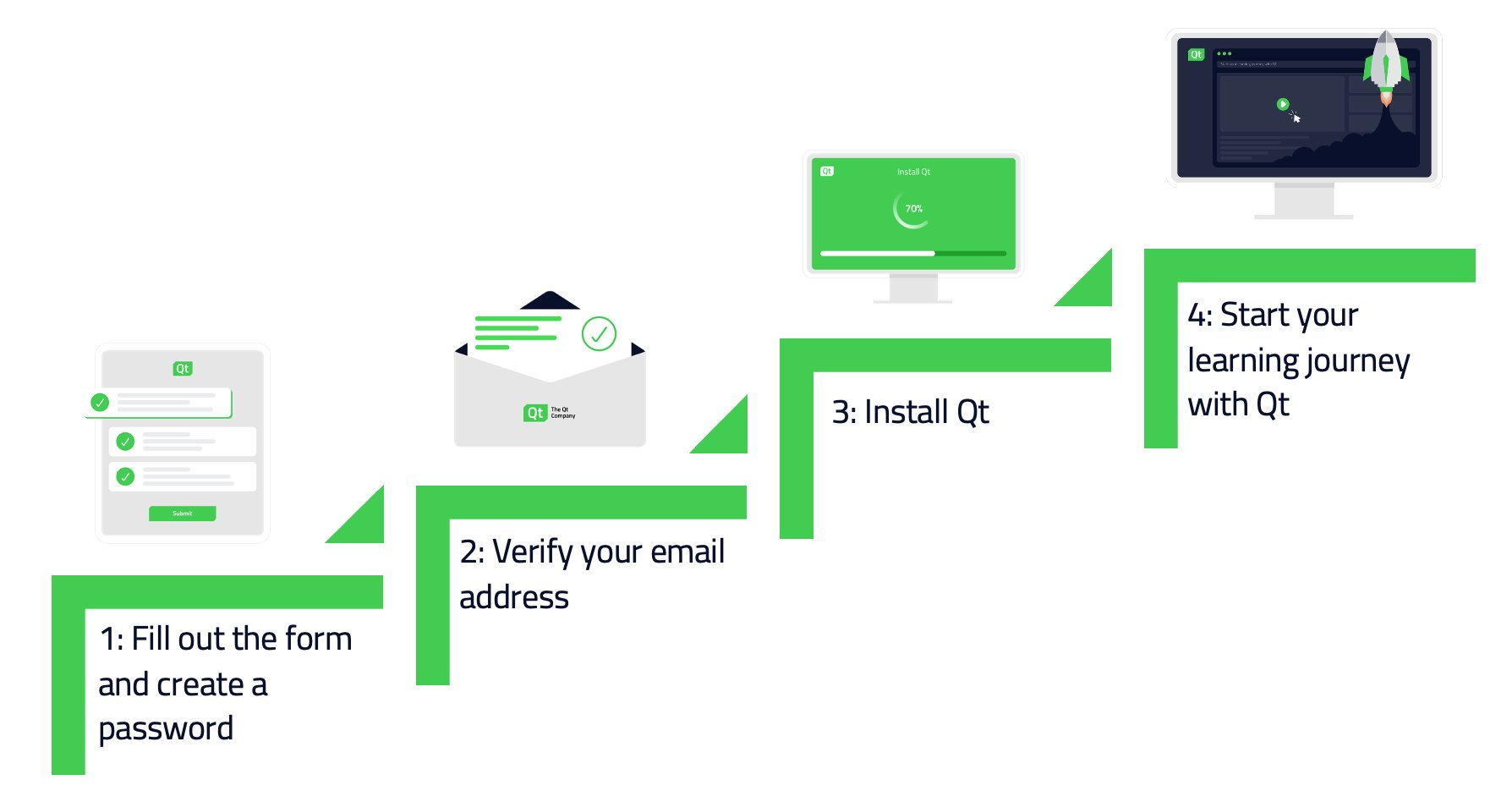

申请地址:https://www.qt.io/qt-educational-license?hsLang=en,申请流程如下:

摘要:本文以华为云软件开发平台DevCloud为例,展示飞机大战游戏开发的DevOps实践流程。

DevOps实践

DevOps实践是一种开发、测试运维一体化的模式,其实践的外在表现一般包括了如代码仓库、构建、测试、发布、配置、监控等工具形成的一个完整的工具链或者说开发平台,以华为云软件开发平台DevCloud为例,展示飞机大战游戏开发的DevOps实践流程。

实践手册下载>>>

提交实践结果赢奖品>>>

实验介绍

项目名称:飞机大战游戏

项目简介:一个用 Cocos Creator 开发的 Web 游戏,可以进行飞机大战。

开发语言:JavaScript(49.3%)、CSS(36.6%)、Html(14%)

部署环境:CentOS 7.6 64bit for Kai1s +jdk1.8

涉及云服务:华为云 DevCloud、华为云弹性云服务器 ECS

操作流程

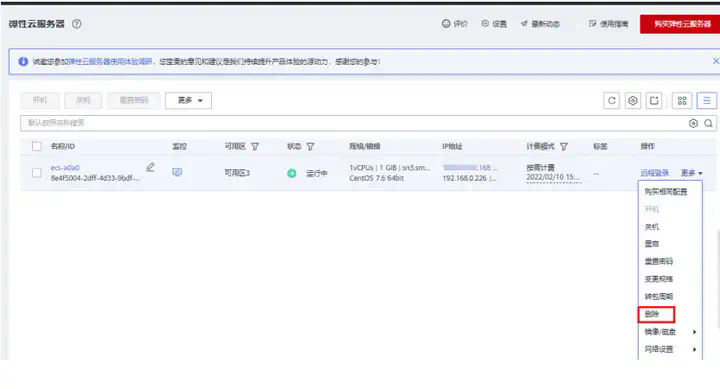

操作步骤

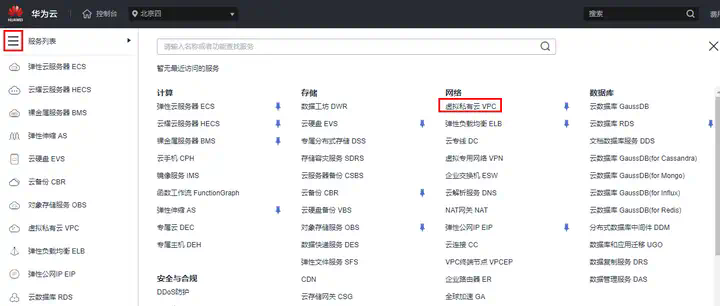

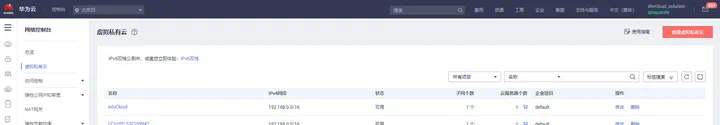

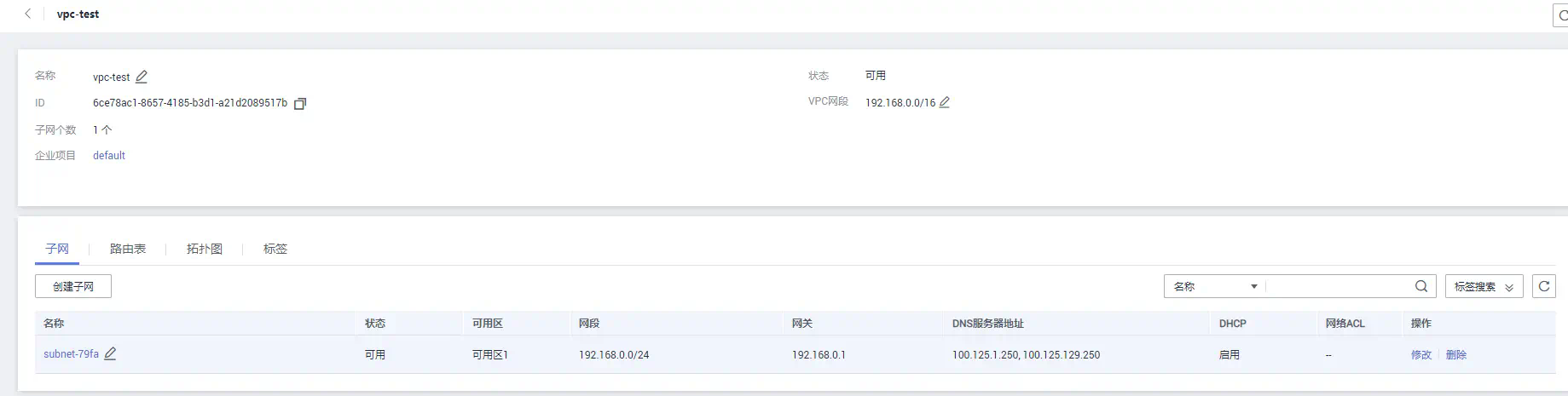

创建私有云

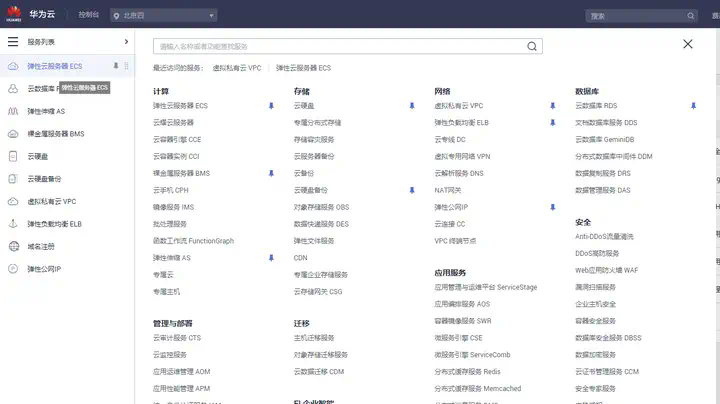

步骤1:在华为云服务列表找到“服务列表”,进入华为云“虚拟私有云VPC”,创建虚拟私有云,配置虚拟私有云名称和子网名称,其他默认配置,立即创建;

步骤2:创建安全组并添加规则

创建安全组

- 名称:sg-plane

- 企业:default

- 模板:通用Web服务器

- 描述:无

添加规则:添加入向规则

- 优先级:1

- 协议端口:TCP

- 输入:8080

创建项目

在华为云官网产品列表中,前往“软件开发平台DevCloud”的管理控制台,新建项目;

- 项目流程:看板

- 项目名称:自定义

创建代码仓库

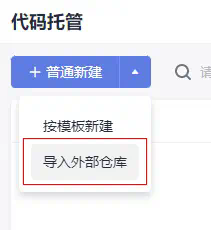

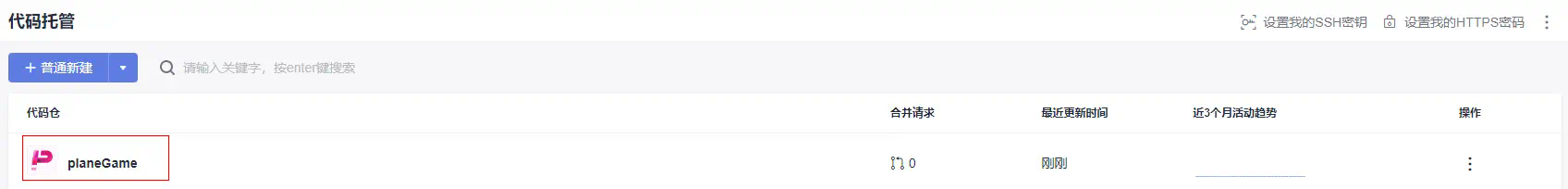

进入代码->代码托管,导入外部仓库:

- 源仓库地址:https://codehub.devcloud.cn-north4.huaweicloud.com/yxdmmsymbgl00001/planeGame.git

- 源仓库访问权限:不需要用户名/密码

- 勾选“我已阅读并同意 《隐私政策声明》 和 《软件开发服务使用声明》”

- “下一步”按钮

- 自定义代码仓库名称

- 其他默认值,最后确认

新建编译构建任务

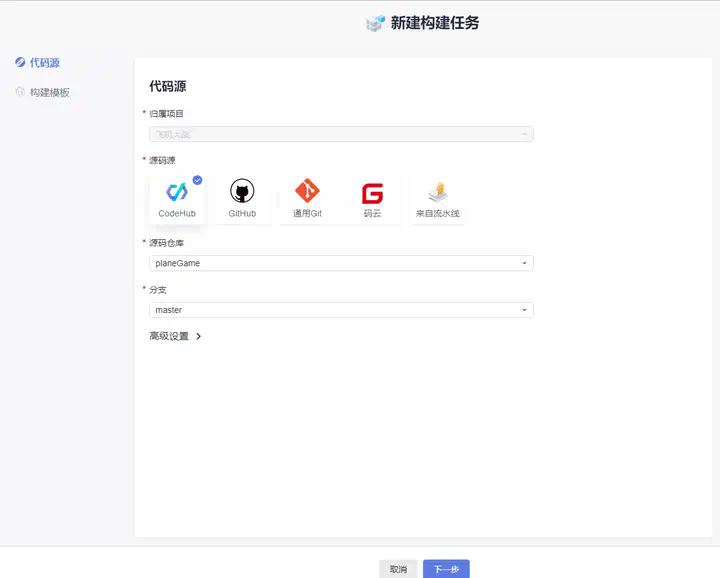

在“构建&制品”中选择“编译构建”后,新建任务:

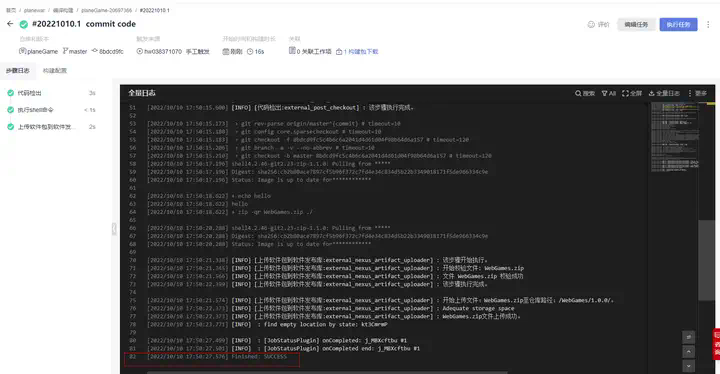

步骤1:选择Shell模板,在命令行中输入zip -qr WebGames.zip https://www.xujun.org/

步骤2:在Shell下方增加“上传软件包到软件发布库”

- 构建包路径:WebGames.zip

- 发布版本号:1.0.0

- 包名:WebGames

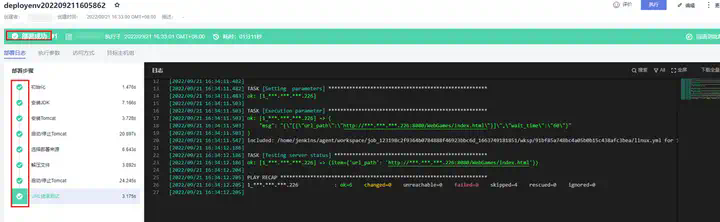

步骤3:新建并执行

新建部署任务

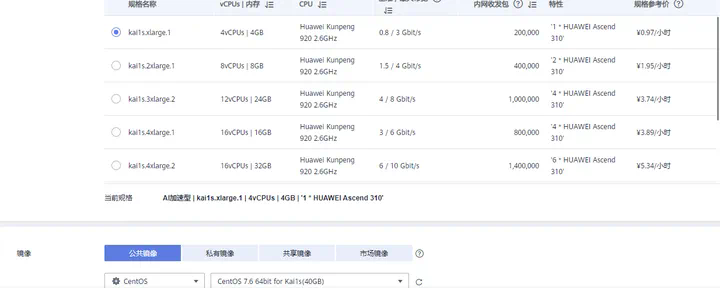

步骤1:进入“控制台”选择“服务列表”购买弹性云服务器ECS,并进行配置;

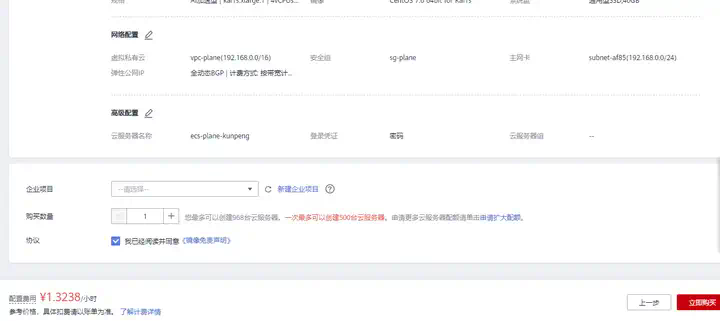

计费模式:按需收费

区域:华北-北京四

可用区:随机分配

CPU 架构:鲲鹏计算

规格:kai1s.xlarge.1(4 核 4G)

镜像:CentOS 7.6 64bit for Kai1s(40GB)

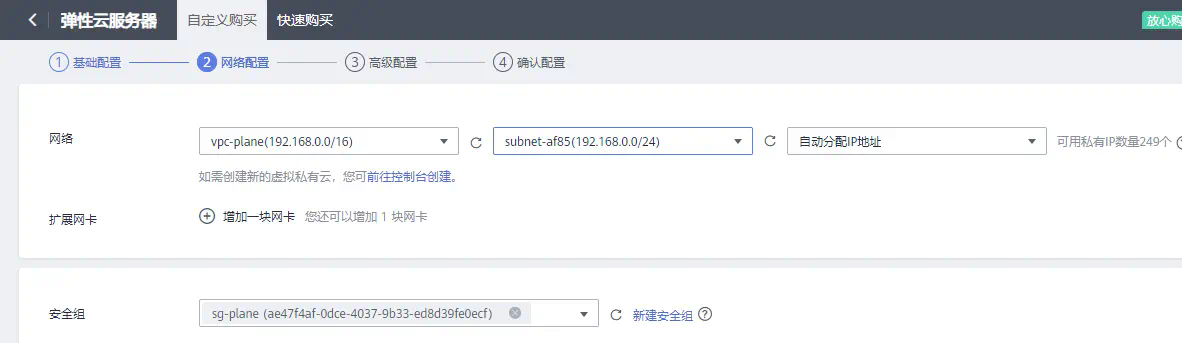

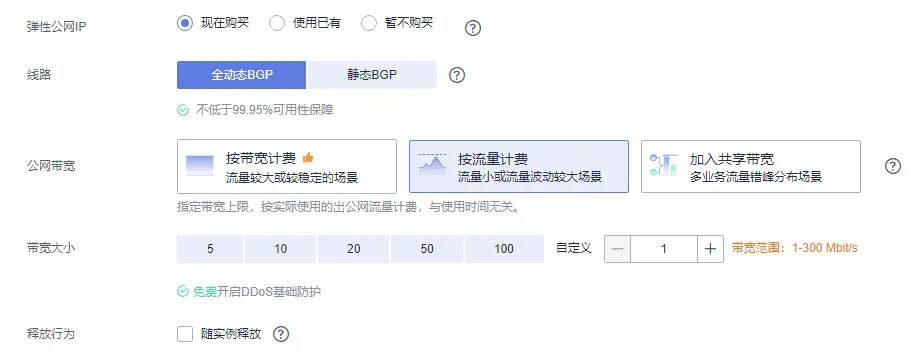

网络:选择本实验创建的虚拟私有云

安全组:选择本实验创建的安全组

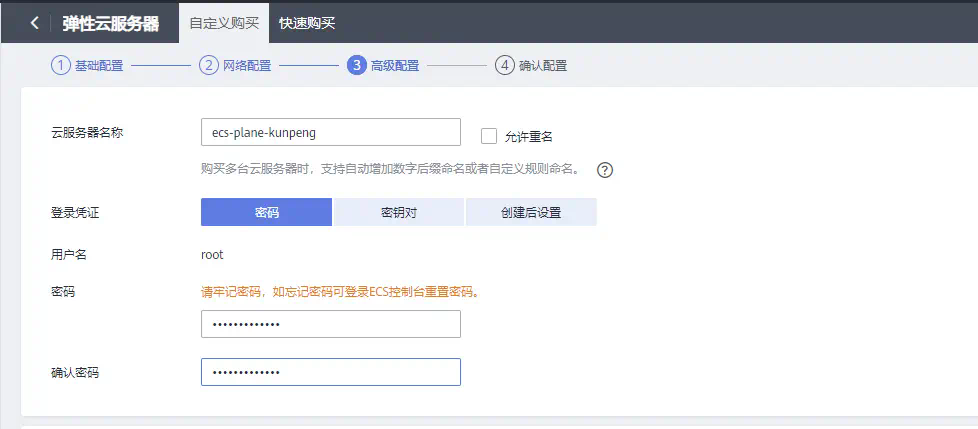

云服务器名称:自定义(如:ecs-plane-kunpeng)

密码:自定义

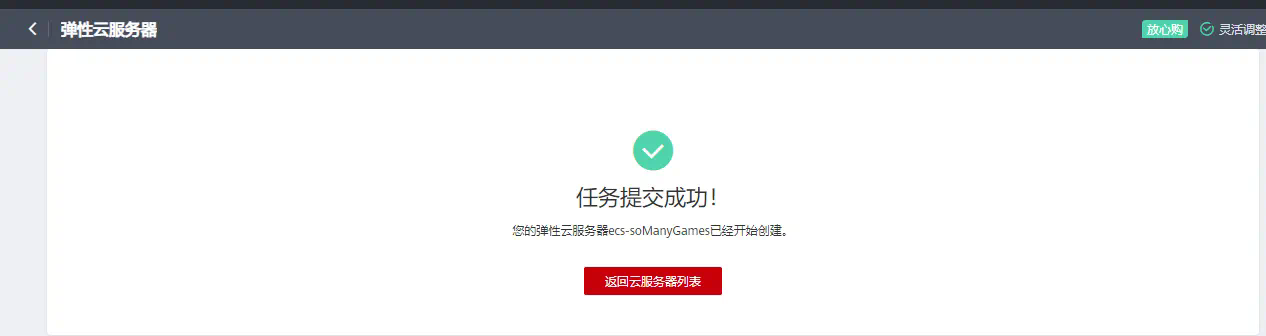

步骤2:进入华为云DevCloud控制台,选择“部署”->“主机管理”;

添加主机组,输入主机名,选择linux操作系统,保存;

添加主机;

- 输入自定义主机名称,如planewar

- IP(云服务弹性公网IP)

- 认证方式:密码

- 用户名:root

- 密码:自己云服务器ECS的密码

- ssh端口:22

- 勾选我已阅读…,添加

添加成功后,显示验证成功。

步骤3:重新进入部署服务,新建任务,选择Tomcat应用部署模板

“选择部署来源”下方的加号,添加“解压文件”,配置:

- 压缩文件路径:${download_path}/WebGames.zip,

- 解压目录:${download_path}/WebGames;

“参数设置”页中,将以下参数进行修改,其余参数保持默认不变

- ${host_group}:ecs_group_planewar(即本实验中创建的主机组)

- ${package_url}:/WebGames/1.0.0/WebGames.zip

- Service_port:8080

步骤4:访问应用

释放云资源

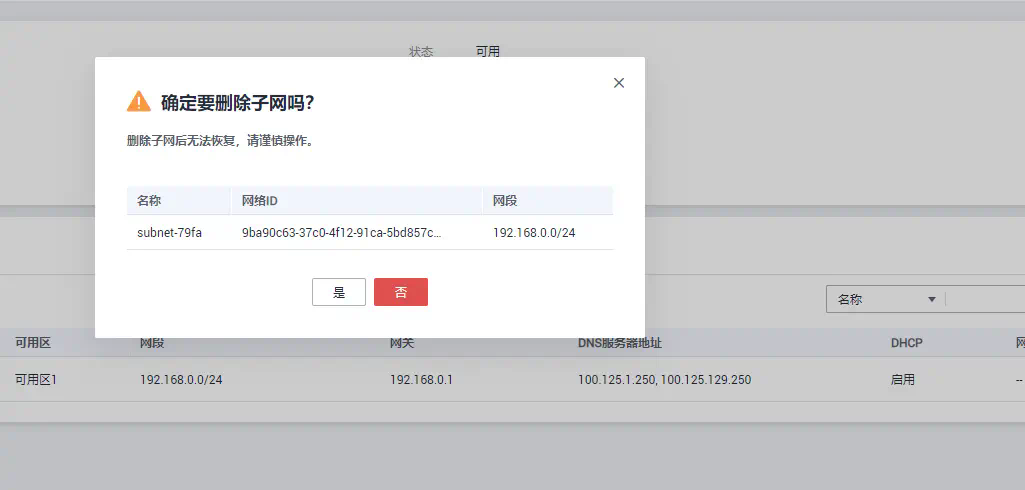

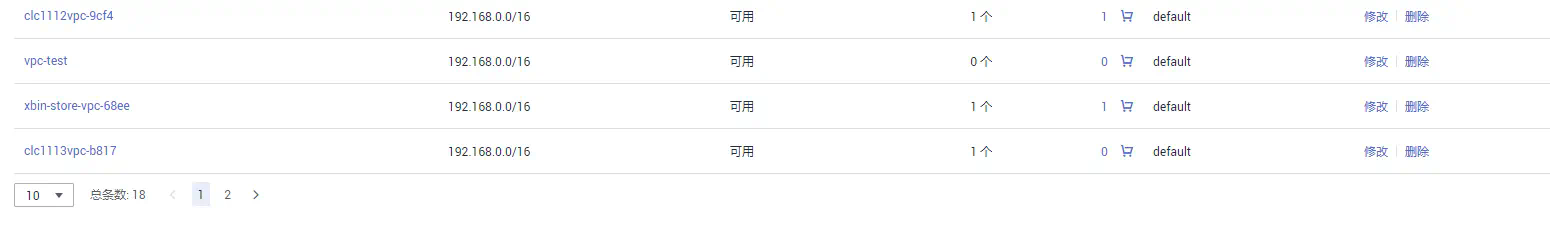

本实验需要释放的资源有:弹性云服务器ECS、虚拟私有云和安全组。

步骤1:前往“弹性云服务器ECS”管理控制台,释放资源;

步骤2:前往“虚拟私有云 VPC”管理控制台,先删除所有子网,再删除虚拟私有云;

步骤3:进入“访问控制”中的安全组,删除需要删除的安全组。

关注,第一时间了解华为云新鲜技术~

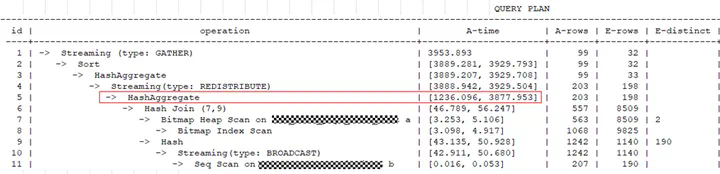

摘要:本文重点介绍单个SQL语句持续执行慢的场景。

本文分享自华为云社区《GaussDB(DWS) SQL性能问题案例集》,作者:黎明的风。

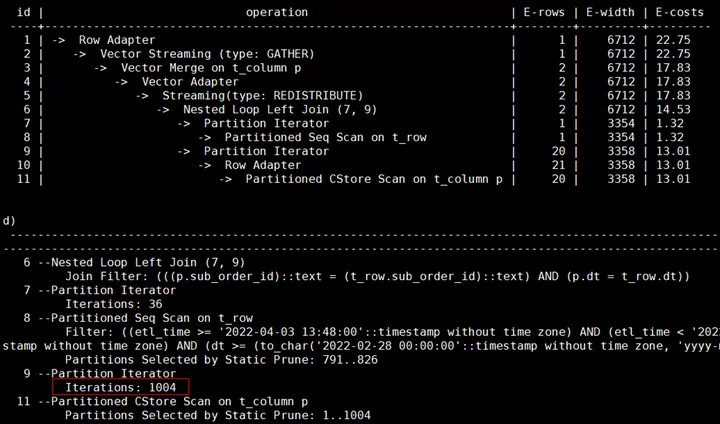

本文重点介绍单个SQL语句持续执行慢的场景。我们可以对执行慢的SQL进行单独分析,SELECT、INSERT、UPDATE等语句都可以使用explain verbose + SQL语句输出查询计划来进行分析,这样只输出查询计划,语句不会被实际的执行。

如果查询计划只出现__REMOTE_FQS_QUERY__或__REMOTE_LIGHT_QUERY__,看不到具体的计划,可以先执行set enable_fast_query_shipping to off; 然后再重新打印执行计划。

经常遇到的问题有以下几个:

【案例1】语句中包含不下推的函数

检查查询计划中是否包含_REMOTE_TABLE_QUERY_关键字, 如果有则表示语句没有下推,数据需要从DN上收取到CN上,然后语句在CN上执行。语句不下推原因,要从CN的日志中查找,搜索的关键字为:SQL can’t be shipped,以下为函数造成的不下推例子:

LOG: SQL can’t be shipped, reason: Function Fun1() can not be shipped

此外如果出现以下几种不下推的关键字:__REMOTE_GROUP_QUERY__、__REMOTE_LIMIT_QUERY__、

__REMOTE_SORT_QUERY__。这种需要检查enable_stream_operator参数是否处于关闭状态,一般来说打开STREAM开关后,语句就可以下推执行了。

如果出现以下两种关键字,表示语句可以下推执行:

__REMOTE_FQS_QUERY__:表明语句走了Fast Query Shipping(FQS),SQL语句会下发到DN上执行,并且各DN之间没有数据交互,常见的场景有过滤条件为等值查询(where id = 1),或者关联的列是表的分布列的查询(where t1.id = t2.id)。

__REMOTE_LIGHT_QUERY__:表明语句走了Light Proxy(CN轻量化),将语句下发给了单个DN去处理,常见的场景过滤条件是分布列的等值查询(where id = 1),或者向一个DN插入数据的INSERT语句。

【案例2】表上有索引但没有走索引扫描,进行了全表扫描

从查询计划中可以看到Seq Scan或CStore Scan这样的关键字,如下所示:

对于行存表:-> Seq Scan on t1

对于列存表:-> CStore Scan on col_t1

出现这种问题通常有以下几种情况:

没有对所查询的表收集统计信息

如果表的实际行数很大,而估算行数很小,查询时可能会走全表顺序扫描,造成执行速度慢。此时通过analyze表更新统计信息,让优化器选择最佳的查询计划,一般就可以解决执行慢的问题。

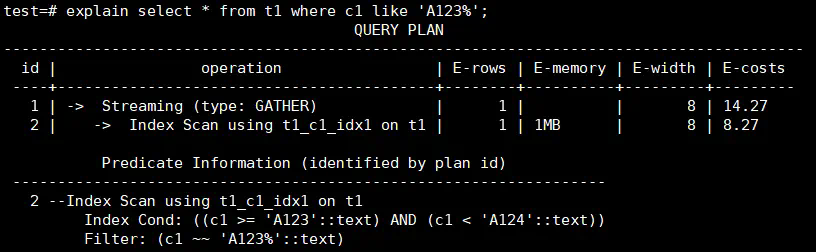

【案例3】模糊匹配没有走索引

后模糊匹配查询可以通过建立一个BTREE索引来实现,需要根据数据类型设置索引的operator,对于text,varchar和char分别设置和text_pattern_ops,varchar_pattern_ops和bpchar_pattern_ops。

例如c1列的类型为text,创建索引时增加text_pattern_ops。

CREATE INDEX ON t1 (c1 text_pattern_ops);

创建索引后,可以看到语句执行时会使用到前面创建的索引,执行速度会变快。

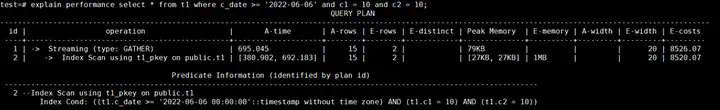

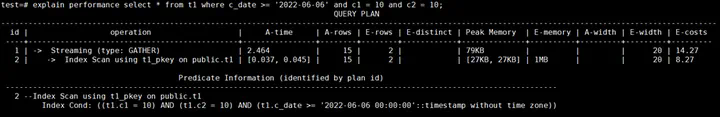

【案例4】创建索引时所指定列的顺序问题

多列复合索引的组织结构与单列字段索引结构类似,按索引内表达式指定的顺序编排。当创建多列复合索引时,选择什么样的列的顺序,对查询性能会带来一定的影响。

例如按照c_date,c1和c2列的顺序建立检索,如果符合c_date条件的数据很多,通过这个索引扫描的数据就很会很多,造成执行时间长。

新建多列复合索引,将查询条件里的等值条件的列放到索引列的前面,先使用等值进行过滤,需要扫描的数据变少,查询变快。

【案例5】分区表没有分区剪枝进行了全表扫描

问题背景:XSYX局点使用MERGE INTO语句将每天的数据入库到表里,目标表为分区表,业务上线运行一段时间后发现MERGE INTO速度逐渐变慢。

原因分析:MERGE INTO语句的源表和目标表都是分区表,当前仅对源表增加了时间的过滤条件,可以进行分区剪枝。目标表由于没有指定时间过滤条件,进行的是全表扫描,随着每日的入库业务运行,目标表的数据量越来越大,造成执行速度越来越慢。

解决方案:由于源表的数据在MERGE INTO时会导入到目标表的对应分区里,可以对目标表增加时间的过滤条件进行分区剪枝。

业务修改前的查询计划:

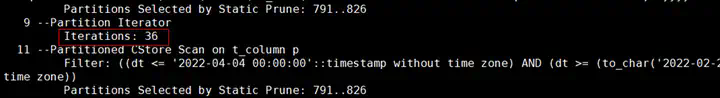

对目标表增加了时间过滤条件后的计划显示可以走分区剪枝:

【案例6】表数据在DN节点上有存储倾斜

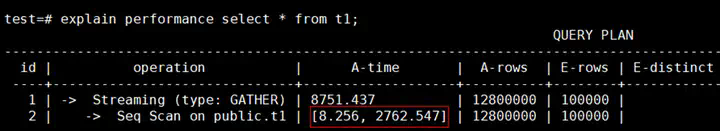

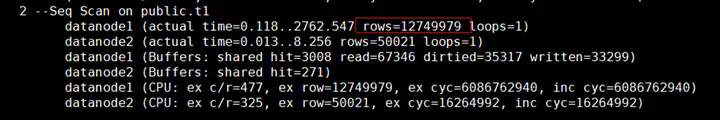

从查询计划中的A-time可以看到最长和最短的执行时间相差很大,说明在不同DN上扫描数据的时间不同。

在查询计划的DN信息中,通过rows可以看出在datanode1上扫描的数据量明显多于datanode2,说明有存储倾斜,这种情况建议对表进行合理的设计,选择合适的分布列,将数据均匀分布到所有的DN上。

【案例7】自定义函数引起执行慢

问题现象:查询语句比较简单,两个表做关联后输出了其中一列的值,在输出前增加了一个自定义函数对数据进行了处理。

原因分析:自定义函数里逻辑相对复杂,包含了对表的查询及数据计算逻辑,造成执行变慢。

解决方案;业务上对自定义函数进行性能优化。

【案例8】查询视图执行时间长

问题现象:某YD局点从C80版本迁移数据到8.1.1版本后,查询PG_STAT_USER_TABLES视图的时间由几分钟变成半个小时都不出结果。

原因分析:8.1.1版本中的PG_STAT_USER_TABLES视图在获取插入、更新、删除的行数的字段数值时,每一条记录都涉及到CN和DN的交互,在数据量和集群规模大的情况下耗时较多。

解决方案:建议根据应用的实际需要,将视图定义中不需要的函数注释掉以提升查询效率。

【案例9】关闭indexscan和bitmapscan后可以使用并行提升性能

问题现象: 查询计划中显示走了Index Scan,通过索引查询出的数据量比较大,速度慢。

原因分析:由于使用索引扫描时无法使用并行查询,当索引访问的数据量大时执行速度较慢。

解决方案:将enable_indexscan和enable_bitmapscan参数关闭,设置query_dop后走并行查询。

关注,第一时间了解华为云新鲜技术~

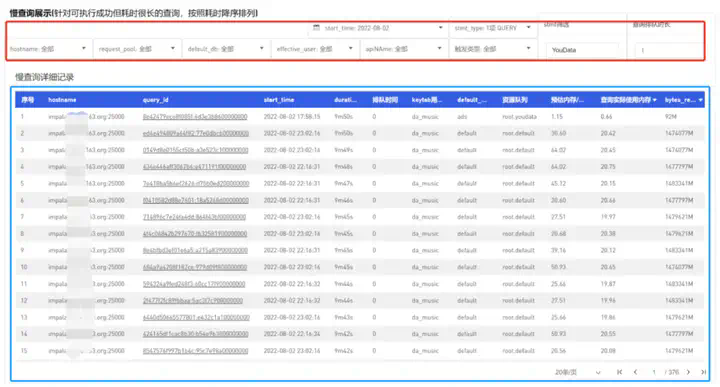

本文将主要介绍NDH Impala的物化视图实现。

接上篇,前两篇分别讲了执行引擎和虚拟数仓,它们是让一个SQL又快又好地执行的关键。但如果某些SQL过于复杂,比如多张大表进行Join并有大量的聚合类操作,那么再优秀的执行引擎也无法保证能够秒级执行完成,虚拟数仓的弹性扩展能力也很难及时跟上,这正是物化视图能够发挥作用的场景。

1 物化视图简介

在计算机领域,物化视图是一个数据库对象,结构化保存了一个SQL查询的结果集,创建物化视图的过程可称为物化,是预计算的一种形式。物化视图是一个比较宽泛的概念,可能是远端数据的一份本地拷贝,也可能是一个表或多表Join后某些行/列的子集,也可以是将聚合函数作用到表或Join结果后的汇总类信息。

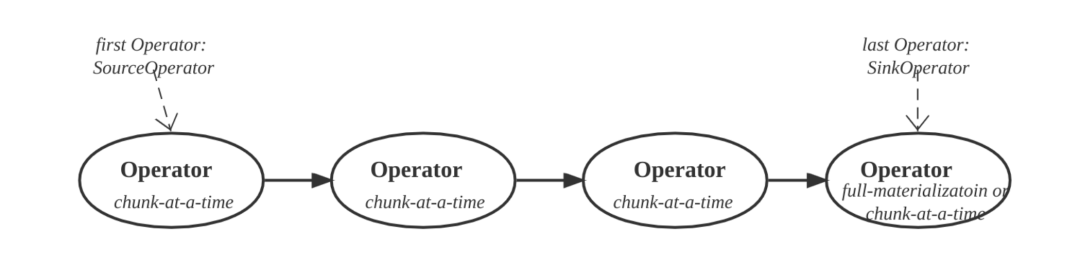

1.1 物化视图分类

根据物化视图中原始数据表的个数,可分为单表和多表物化视图;根据物化视图SQL中是否存在聚合类操作,可分为明细和聚合物化视图;根据物化视图的结果集在更新时是否需要全量刷新,可将其分为全量和增量物化视图,后者又可称为分区物化视图,增量数据写入新分区中。

1.2 特点与作用

普通视图仅表示一个SQL语句,是个逻辑概念,而物化视图则有实体对象/表与之对应。这样在执行查询时,就可以通过查询对应的物化视图表数据,从而快速得到查询结果。物化视图使用查询重写机制,当执行查询时,引擎自动选择合适的物化视图进行查询重写,完全对应用透明。

一般用于进行性能加速,具有比较广泛的使用场景,如果业务查询存在如下特征,即可尝试用物化视图进行加速:比如查询耗时较多且查询频次较高、相同或相似的查询多并发或周期性发生、业务对查询结果的数据实时性没有过于严格的要求,允许分钟或小时级的延迟等。具体业务方面,在数仓领域,T+1类BI报表是典型的可以通过物化视图进行优化查询的场景。

1.3 使用效果评估

物化视图使用得当能够数倍,甚至数十倍提升查询性能,但其也不是万能的,如果不分场景盲目创建物化视图,其结果可能适得其反。一方面是因为物化视图的创建和更新有成本,另一方面,判定SQL是否命中的逻辑也在性能敏感的代码路径上引入了额外的耗时。

笔者认为,使用物化视图的效果评价需要考虑2个方面:首先,其是否带来了查询的性能提升。这是最基本的目标;其次,是否降低了集群总的资源消耗,包括计算资源和存储资源。这是进阶目标,在每个物化视图都有大量的查询命中时,将会明显减少每个查询对CPU和内存资源的需求,同时也不再需要访问原始表,减少IO资源消耗。

1.4 使用现状

物化视图是进行查询性能优化的重要手段,传统的商业数据库,比如Oracle、IBM和SQL Server,以及目前商业数仓系统,比如Snowflake、AnalyticDB等,均具有强大的物化视图能力。

目前开源的数仓系统,在物化视图支持程度上相对不足,Doris、Clickhouse、Druid等暂时仅支持单表聚合类物化视图(或称为聚合索引),也有数仓引擎已经在开发多表物化视图,比如Meta的PrestoDB等。网易NDH Impala在物化视图能力建设上投入较早,目前已在生产环境上规模使用,本章的后续小节主要介绍NDH Impala的物化视图实现和实践。

2 Impala物化视图

2.1 设计架构

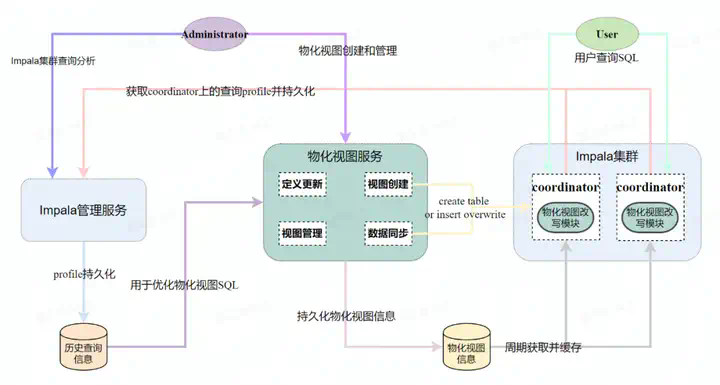

在设计Impala物化视图系统时,秉持了尽可能通用的原则,希望其不仅仅能够用于改写Impala查询SQL,未来能够方便的集成到其他的查询引擎上。下图所示为物化视图设计架构图,包括独立的物化视图服务、嵌入在Impala Coordinator中的物化视图改写模块和用于优化物化视图的Impala管理服务器。

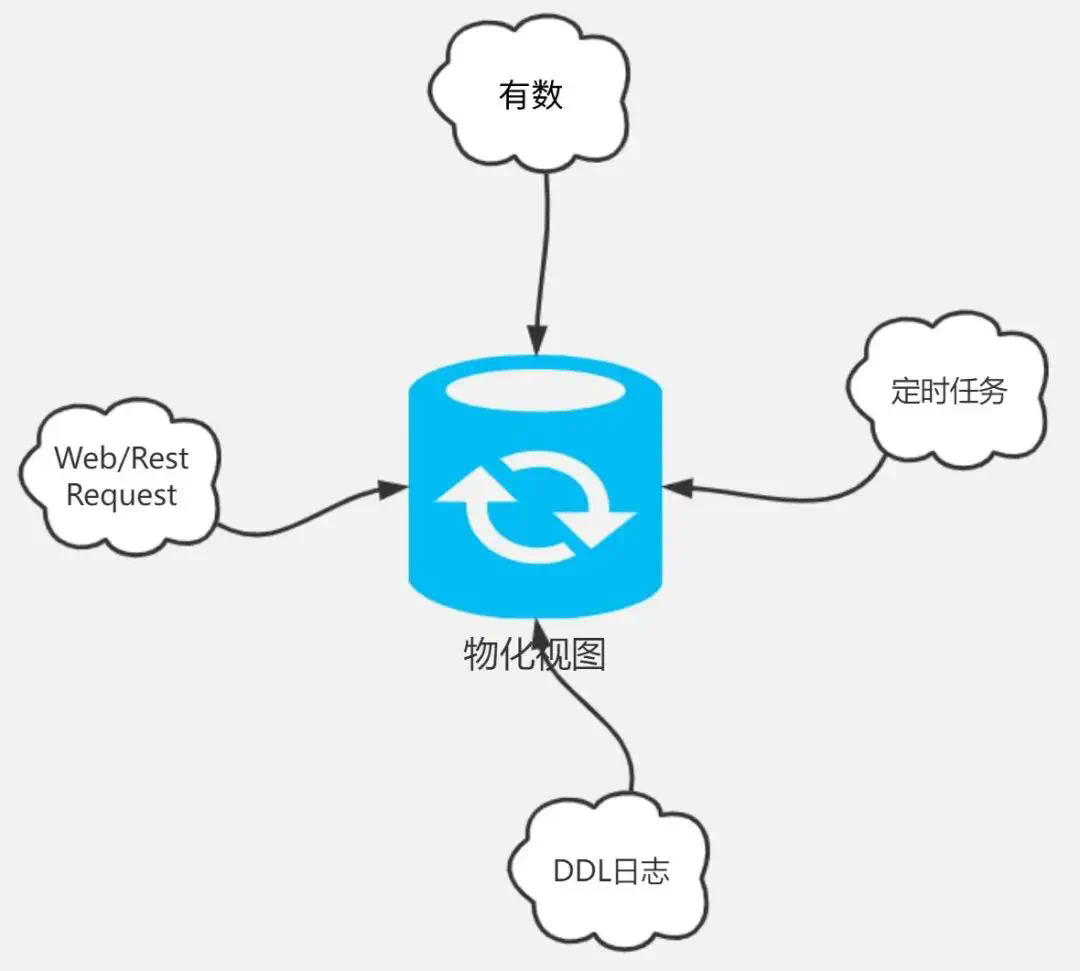

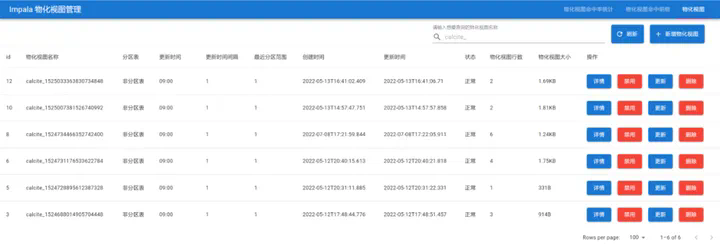

物化视图服务提供了多种物化视图管理的API,包括视图的创建、定义更新、数据更新/同步、启用/禁用、视图信息展示、视图使用统计和视图删除等。Impala管理服务器保存的历史查询信息为物化视图服务的视图创建、定义更新和视图管理提供数据支撑。物化视图服务使用MySQL作为数据库,包括了视图定义、状态和使用统计等信息。Impala Coordinator节点集成了物化视图透明改写模块,用于判断查询SQL是否能够命中某个/某些物化视图,若命中,则对其进行透明改写。

2.2 视图创建

NDH Impala提供两种物化视图创建模式,分别适用于网易数帆的有数BI场景和通用场景,两者均需使用NDH Impala专有的管理服务器,通过历史查询信息优化来物化视图定义。前者基于有数BI的数据模型和图表历史查询行为来生成物化视图SQL,后者则是通过分析历史查询信息来提取SQL模板信息,为满足要求的SQL模板创建物化视图。下面主要介绍有数BI场景下的视图创建,包括预检查、物化视图SQL优化和更新。

预检查

预检查用于在物化视图创建之前,提前剔除掉不合理或暂不支持的创建请求。主要有以下几种情况:

(1)判断是否为实时或准实时表。Impala物化视图服务暂不支持实时场景,所以,如果待优化的BI数据模型或SQL模板中存在Kudu表或Arctic/Iceberg表,则拒绝创建请求。

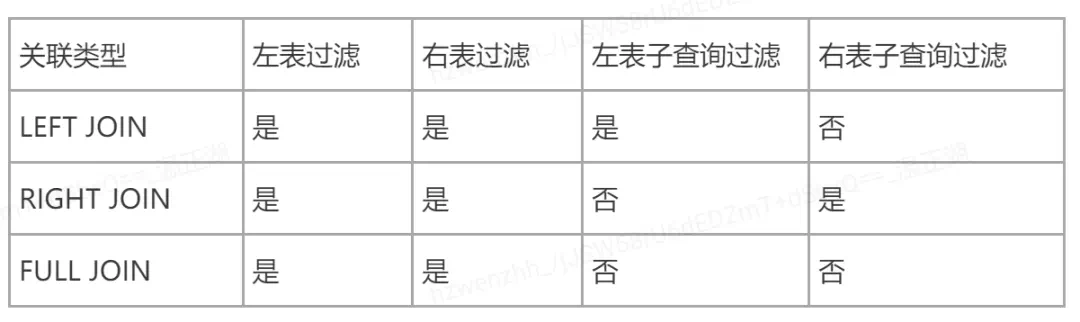

(2)判断是否能够进行模糊匹配。主要包括聚合或多表关联时条件自由筛选场景,举多表外关联为例,假设表t1和t2均为分区表,分区字段均为dt,但两表并没有通过dt字段进行关联,用户在查询时会灵活地为t1和t2进行dt分区各取不同的值/范围,由于外连接的非关联字段过滤在关联前和关联后进行是不等价的,因此无法模糊匹配。对于聚合场景,若物化视图对表user的age列取平均值,若查询对user进行了筛选,显然age列的平均值会失效。

(3)判断是否适合用物化视图进行优化。引起查询慢的原因很多,物化视图适合对查询本身慢进行优化,对于偶发或波动类的因素,其优化效果并不明显。这些因素包括存储层性能抖动(比如HDFS的DN或NN性能波动)、HMS数据加载(未命中catalog缓存导致查询时需即时加载)、排队执行(查询并发超阈值或内存资源不够)、集群网络抖动(网络拥塞等)。物化视图服务通过从Impala管理服务器获取该数据模型或SQL模板的历史查询profile信息来进行前述因素的判定。

对于上述情况,物化视图创建请求直接拒绝,并返回拒绝的原因。

SQL优化

若是BI的数据模型场景,对通过了预检查的创建请求,还需要对其传入的“裸”物化视图SQL(模型SQL)进行优化。我们先说原因,再说如何进行优化。

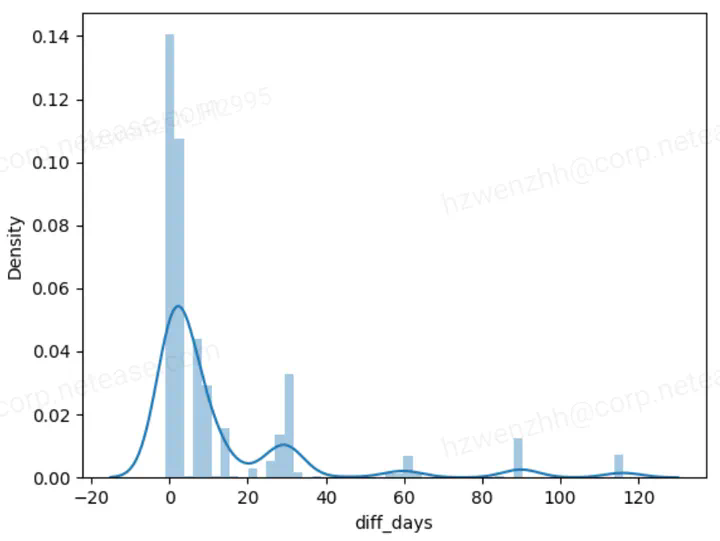

为什么要进行物化视图SQL优化?本质上说是为了提升前述的物化视图使用效果。从实践经验看,数据模型SQL中可能涉及TB甚至PB级别的大表,这些表一般是按日期,比如天进行分区,模型中会对多个分区表按分区字段进行关联。大部分情况下,在数据模型层面并没有约束大表的分区范围,也就是说,如果完全按数据模型SQL进行物化视图构建,所需消耗的计算和存储资源可能是单个图表查询的数十、上百倍甚至更高倍数。为了提升数个图表查询的性能而消耗过多的资源显然是不可取的。而现实情况是,图表查询中的分区范围往往是有明显的规律性的,一般集中在最近一个季度,大部分都是一个星期内的时间,如下图所示:

本着最优的投入产出比,我们就可以基于以往的查询规律,将物化视图的作用域缩短到某个分区范围内,比如昨天、最近一周、最近一个月等等。

那么具体是如何做的呢?NDH Impala做的很多优化都用到了Impala查询Profile,在实现物化视图系统时也不例外。在进行物化视图SQL优化时,会从历史查询中筛选出属于该数据模型的所有图表查询SQL,分析其Profile信息,进一步过滤出待优化的SQL集合。这些SQL一般满足如下一个或多个条件:查询耗时超过阈值(已排除队列等待、数据加载等因素)、消耗的内存资源超过阈值、扫描数据量超阈值、扫描的行数超阈值等。

经过前述条件筛选后,还可根据图表查询的触发类型等维度区分优化的优先级,比如用户触发的图表查询优先级高于BI后台进行结果预缓存的查询。

对于筛选出来的SQL集合,逐个解析SQL语句,提取各事实和维度表的分区范围,并按大小进行排序。默认取最大的分区范围作为物化视图的有效范围,若该范围过大,则根据配置的参数选择更加合适的分区范围,比如选择90%以上查询都在其中的范围值。

多物化视图