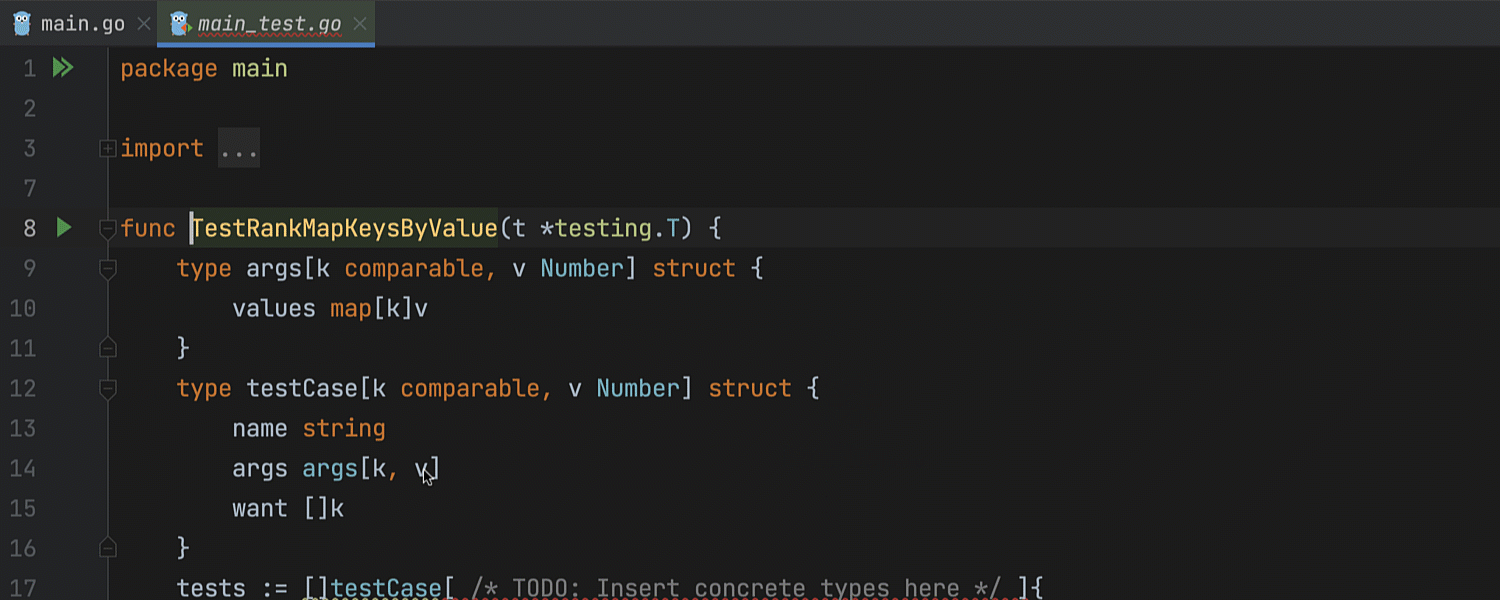

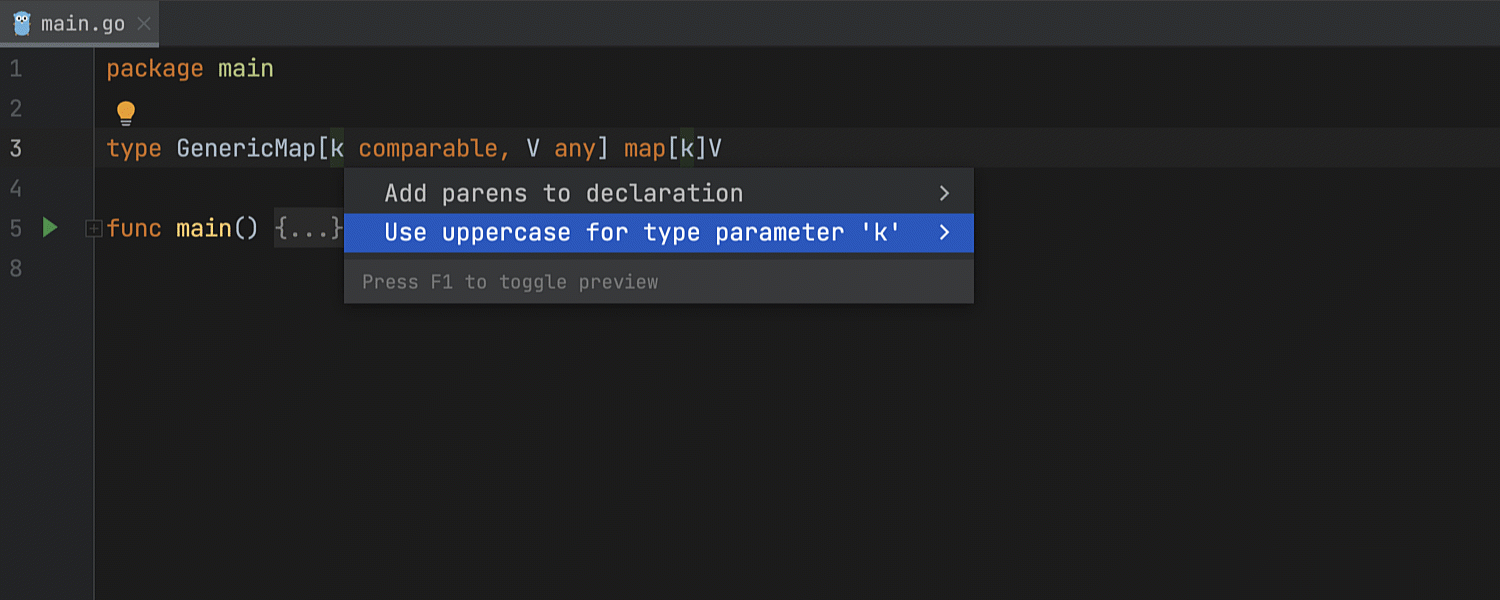

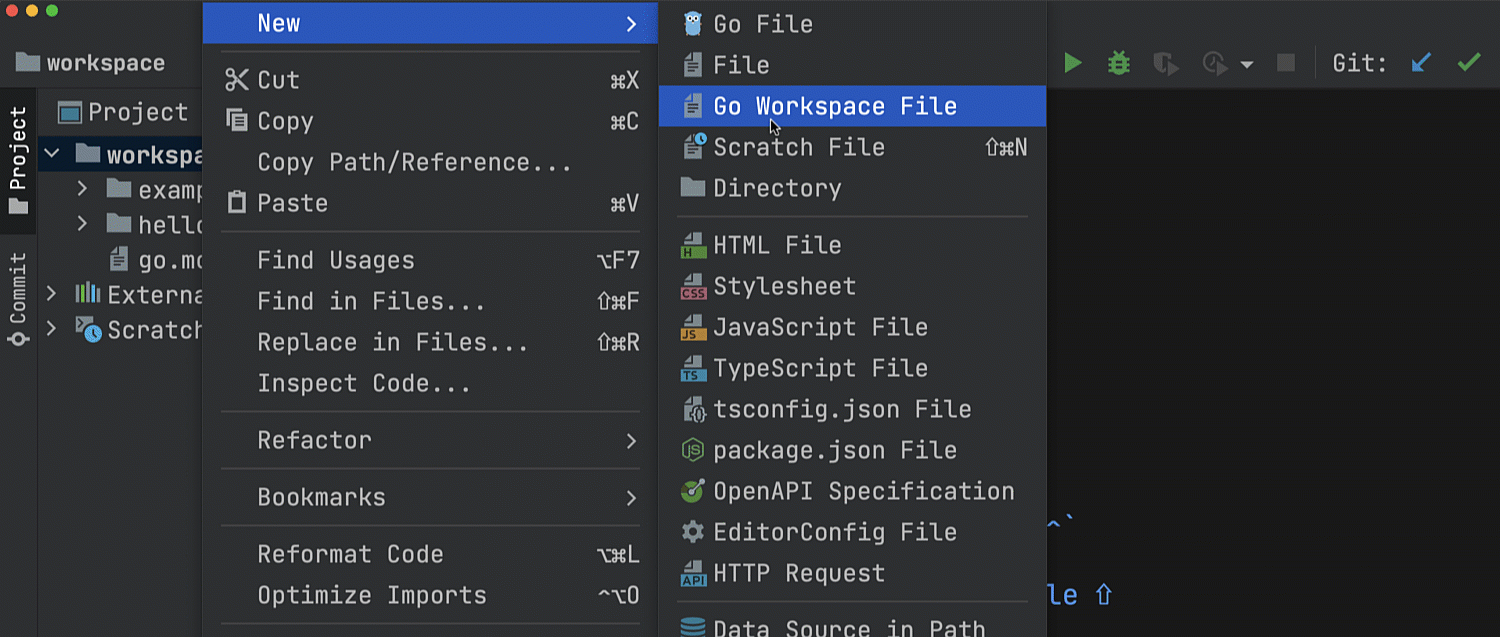

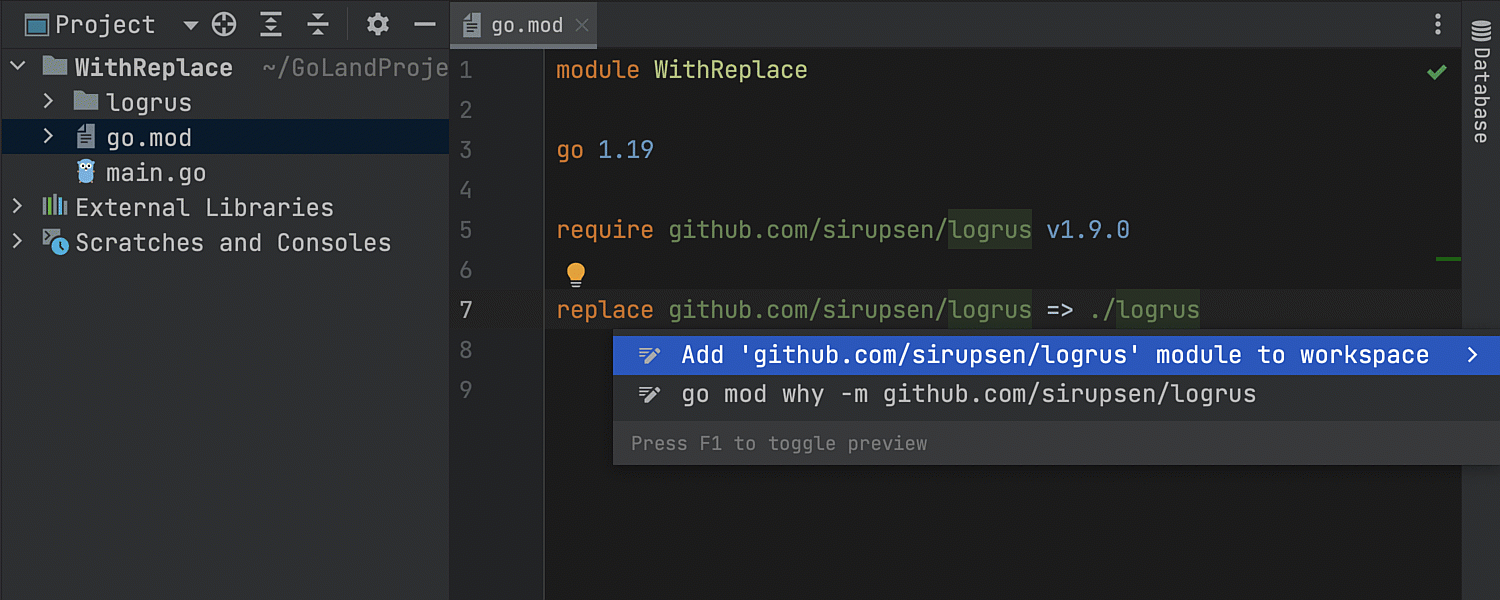

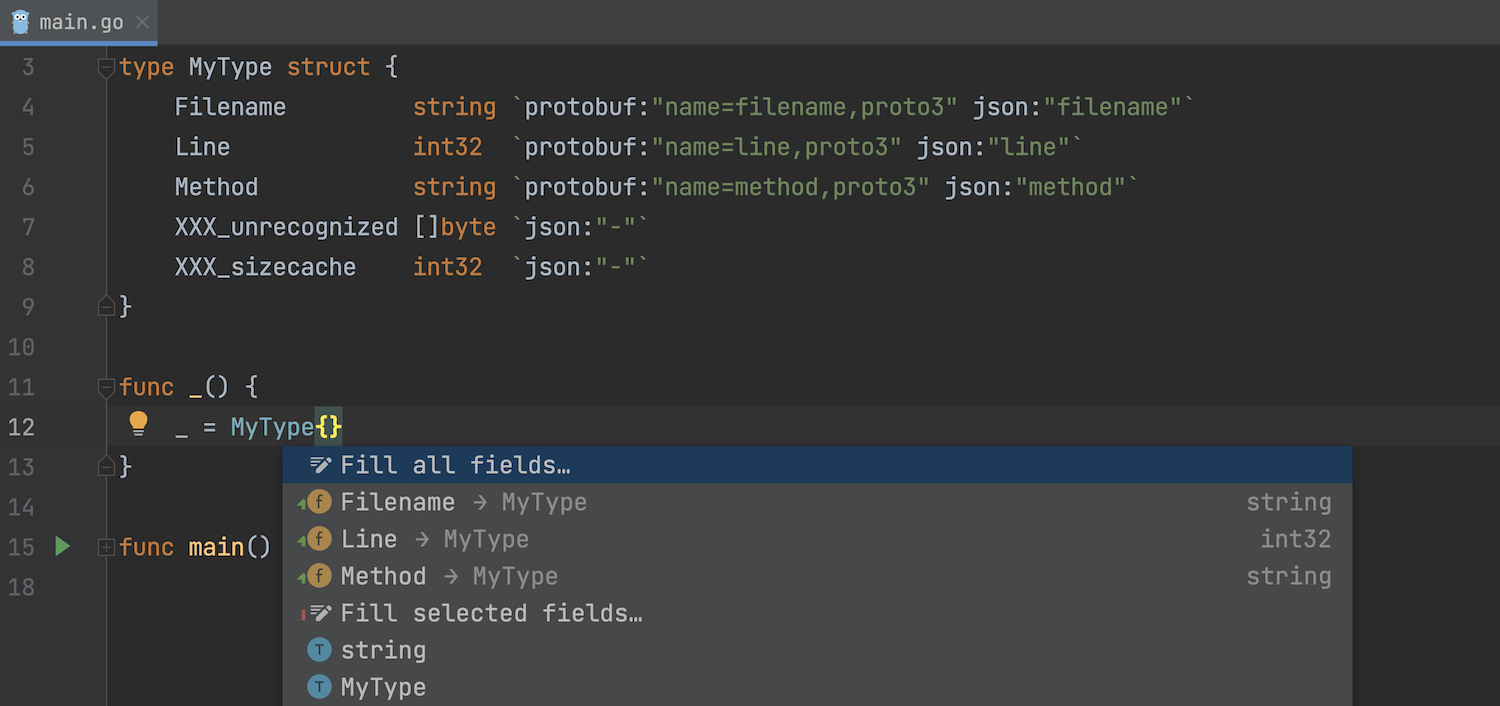

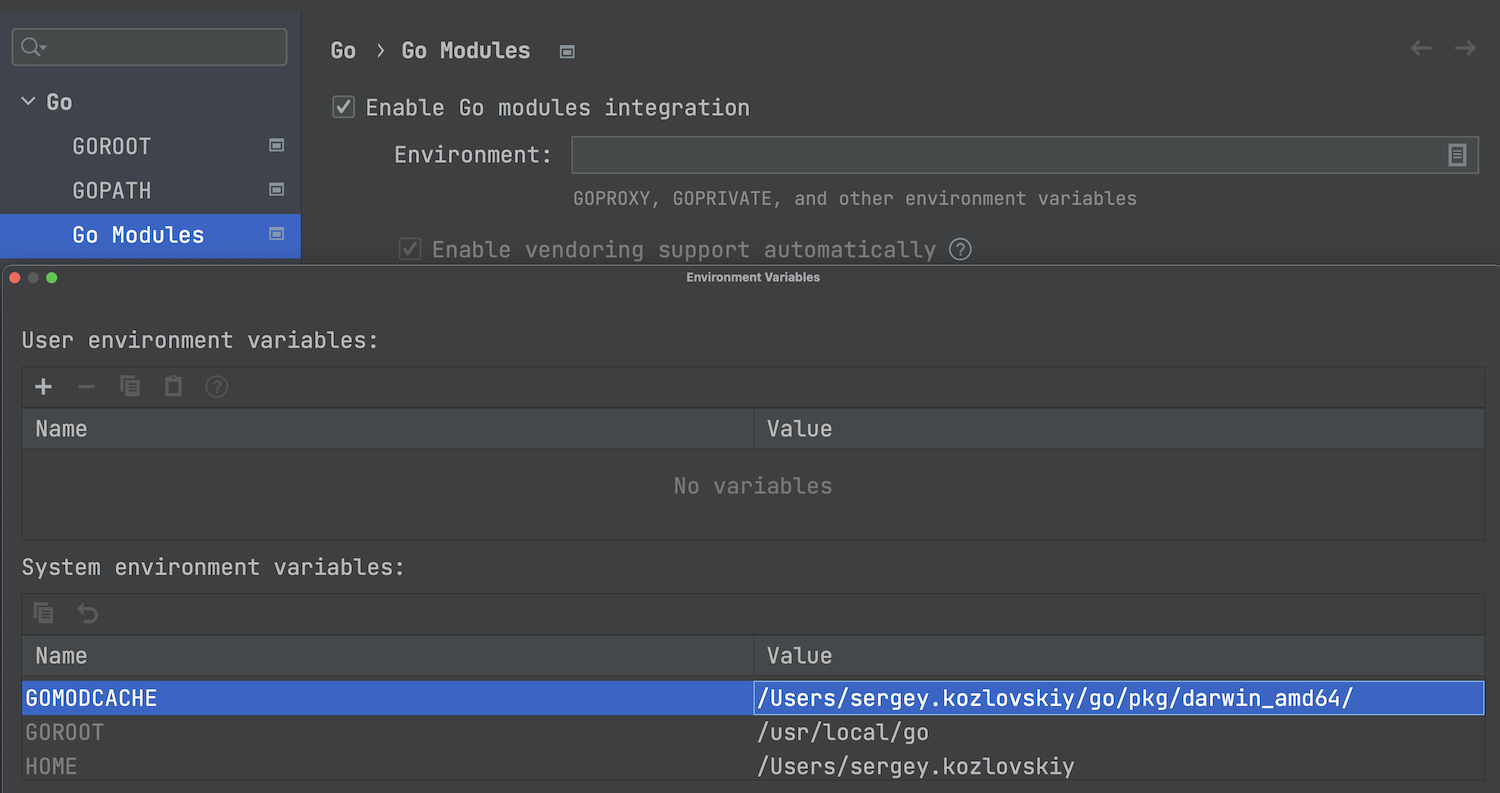

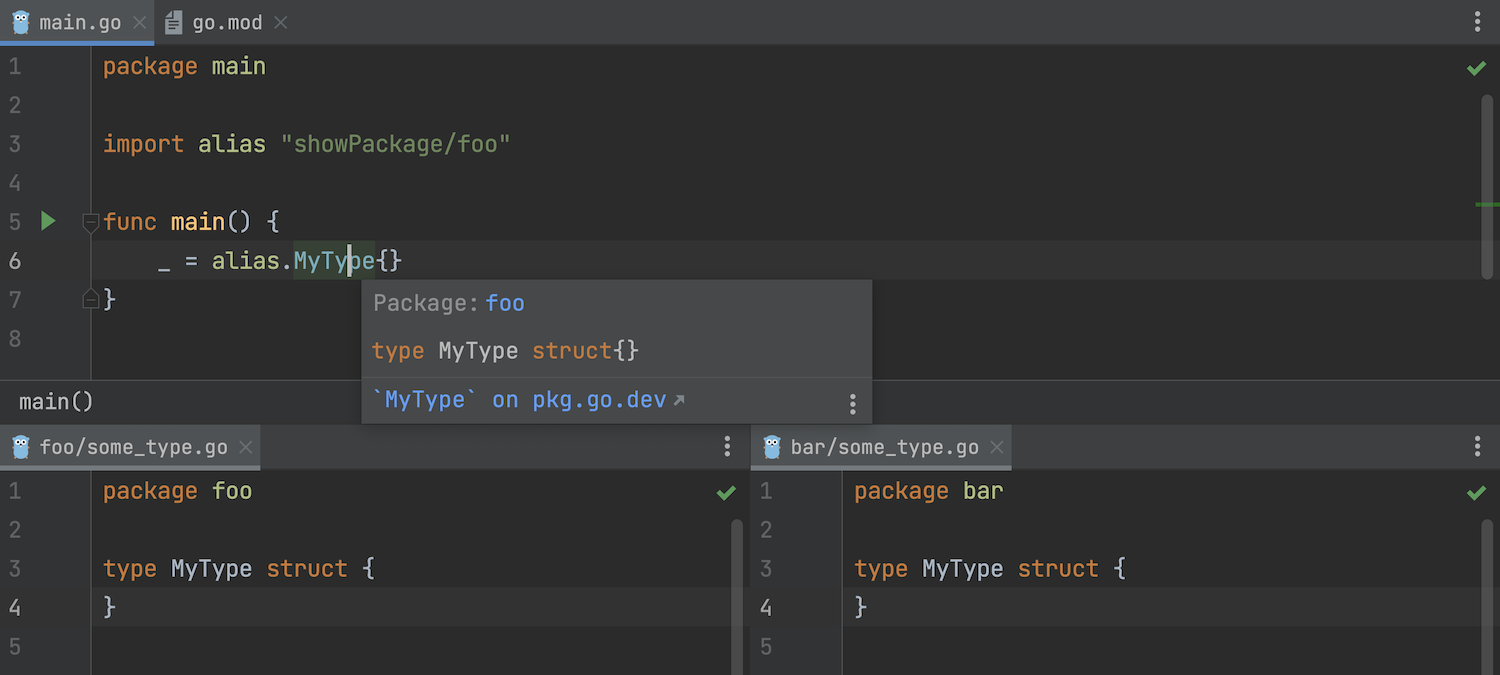

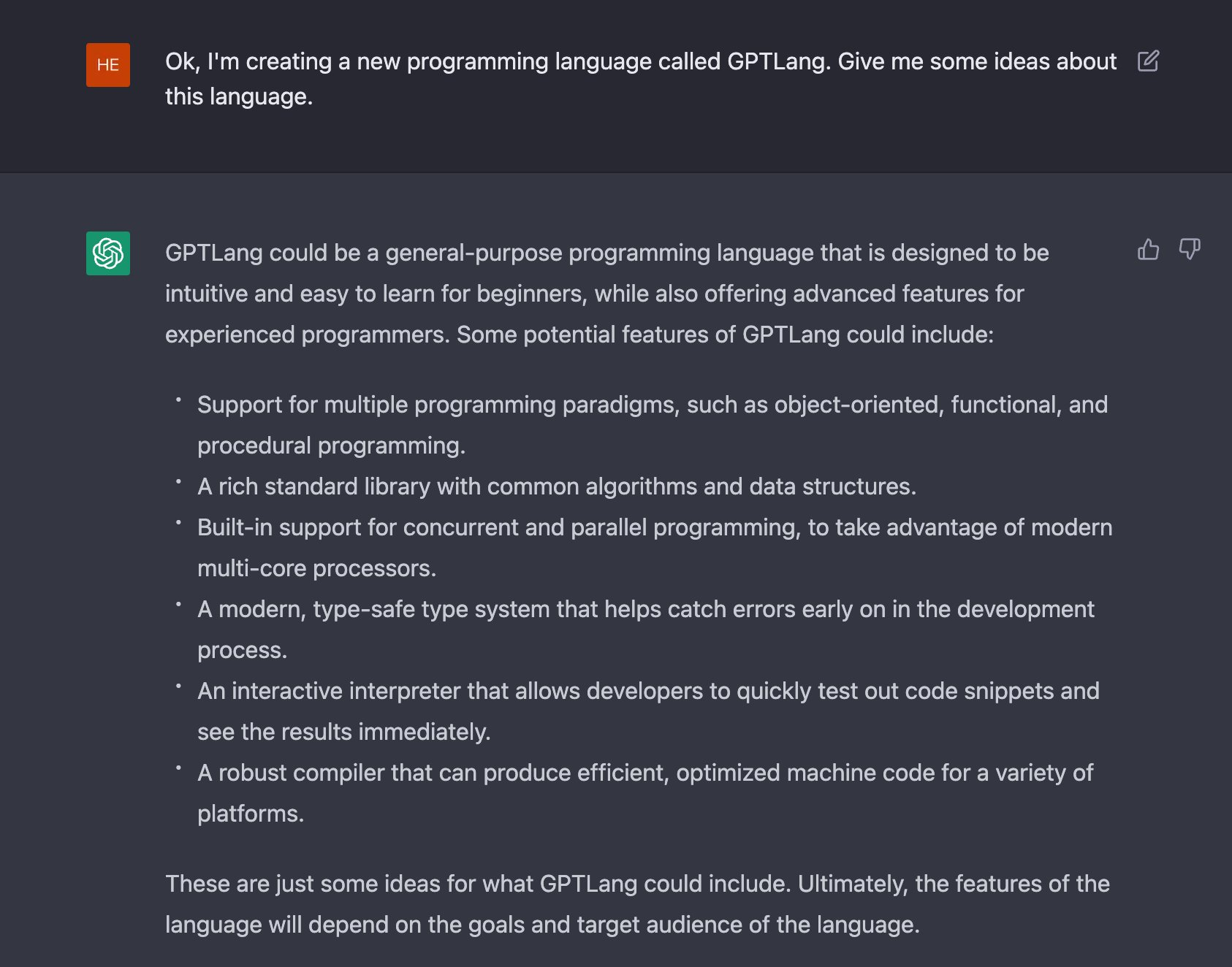

WebStorm 2022.3 正式发布,该版本带来了新的 UI 预览、Vitest 支持、适用于 Vite 和 Next.js 的项目模板、针对 JavaScript 和 TypeScript 的 Code Vision、适用于 Angular 模板的类型缩小支持以及 Vue 更新。

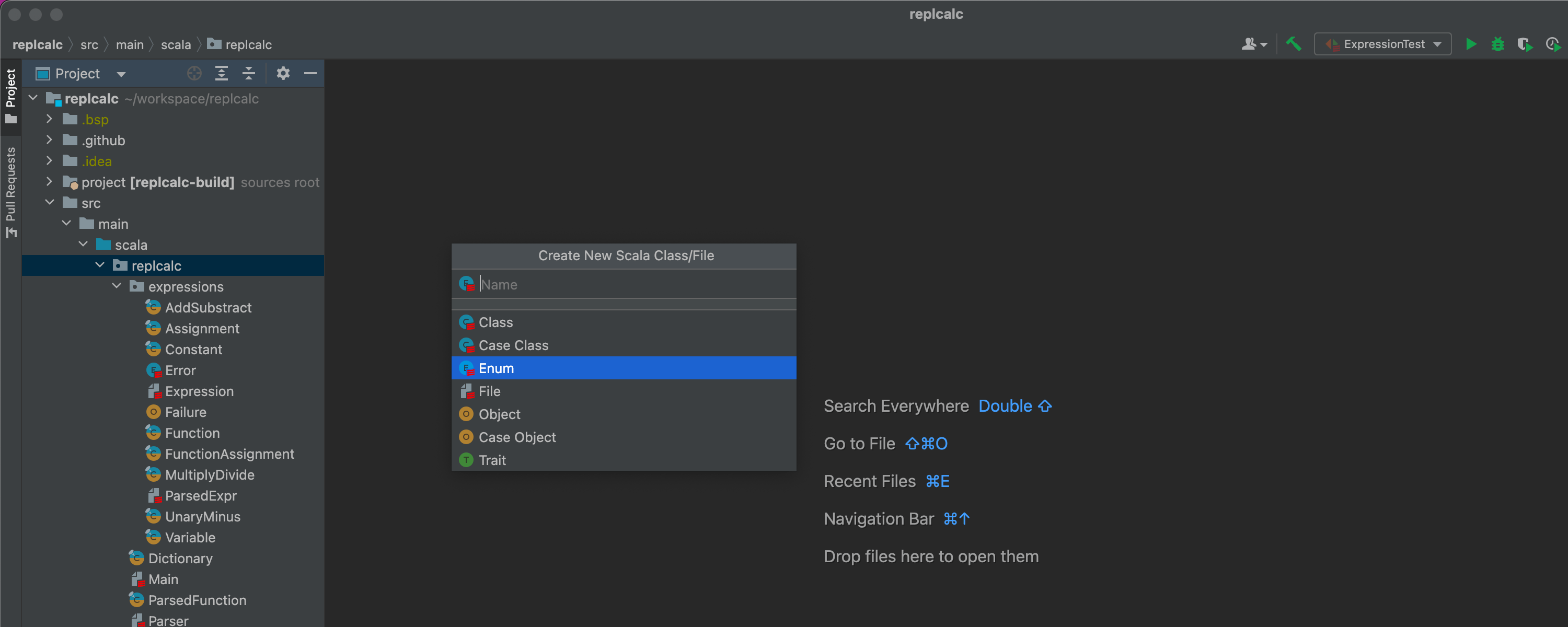

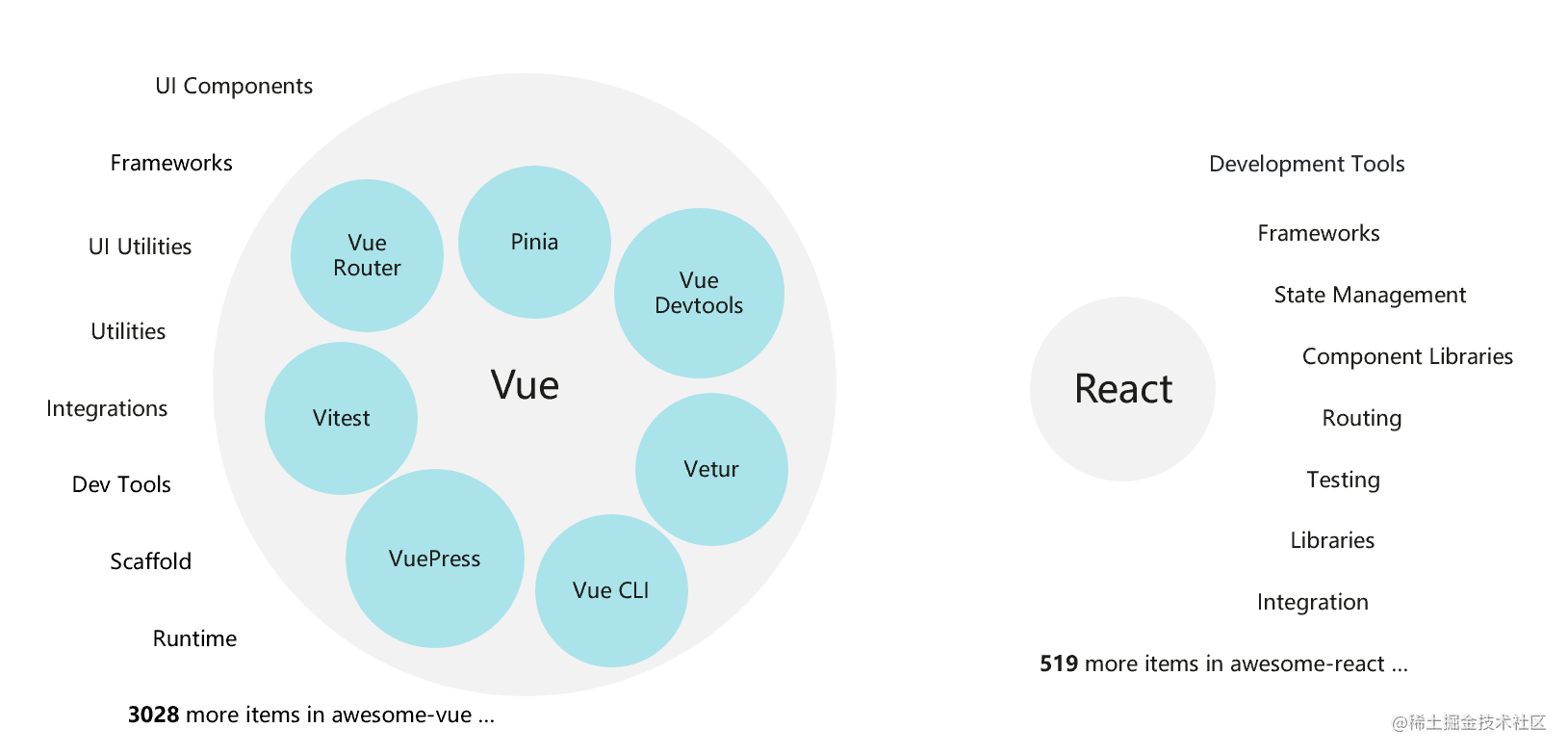

框架和技术

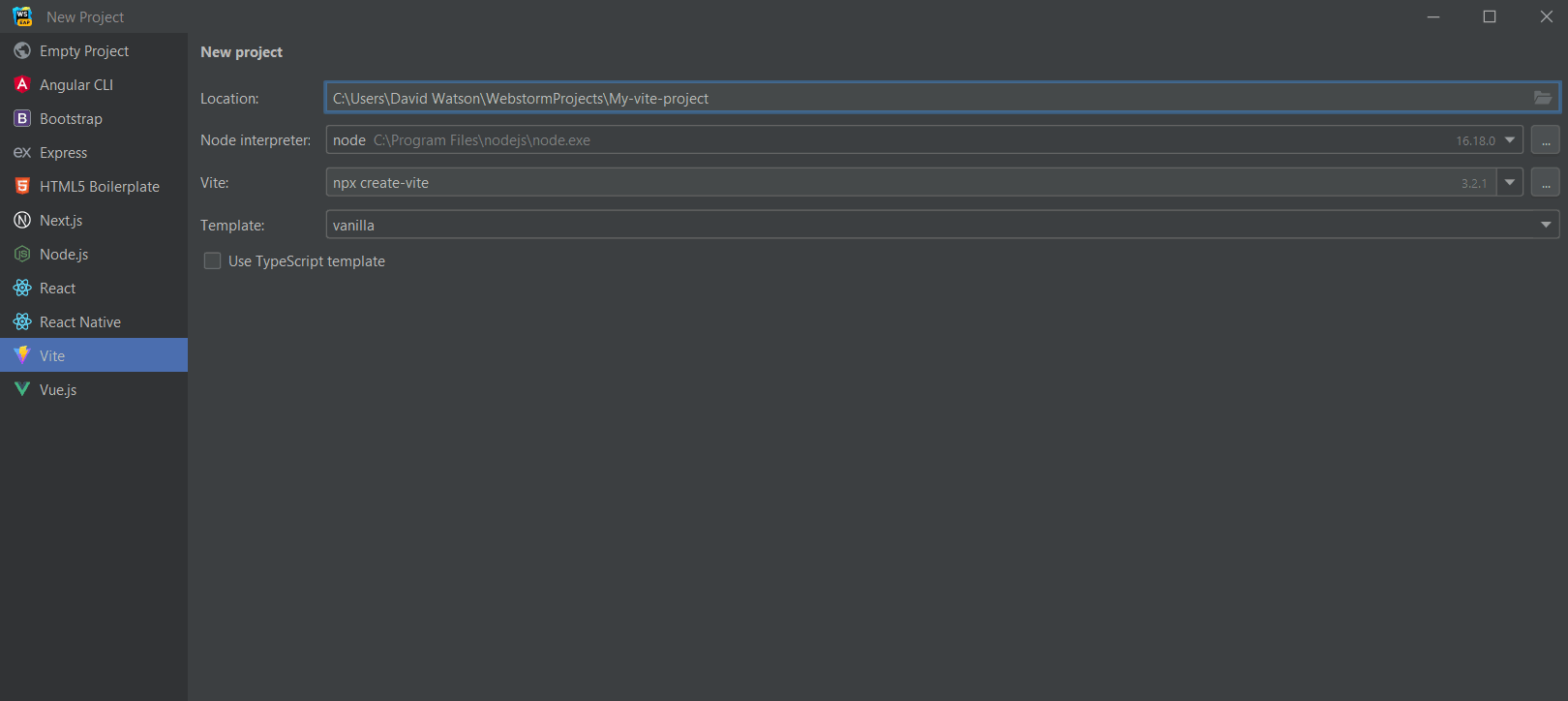

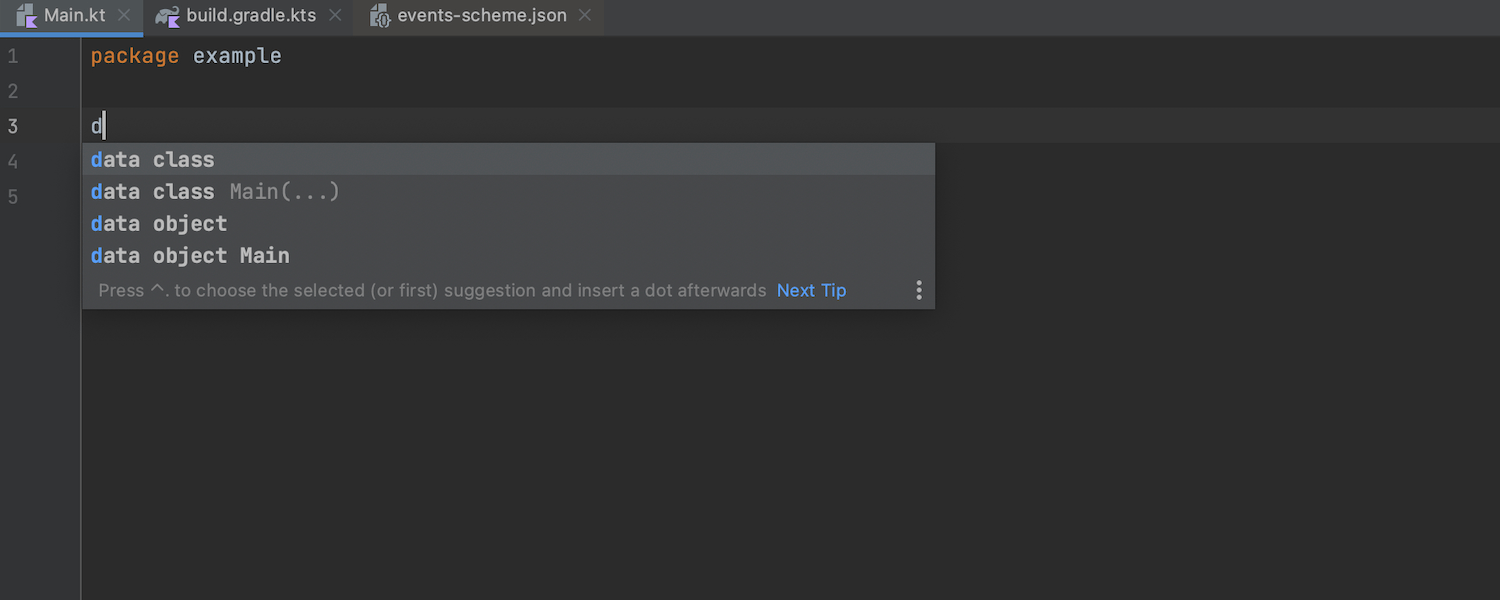

更新了项目模板

我们重做了 WebStorm 欢迎屏幕中的 New Project(新建项目)向导。 在 v2022.2 中,我们移除了适用于 AngularJS、Cordova 和 Meteor 的项目模板。 在此版本中,我们添加了适用于 Vite 和 Next.js 的新项目模板,并更新了 Vue 模板,使其符合最新标准。

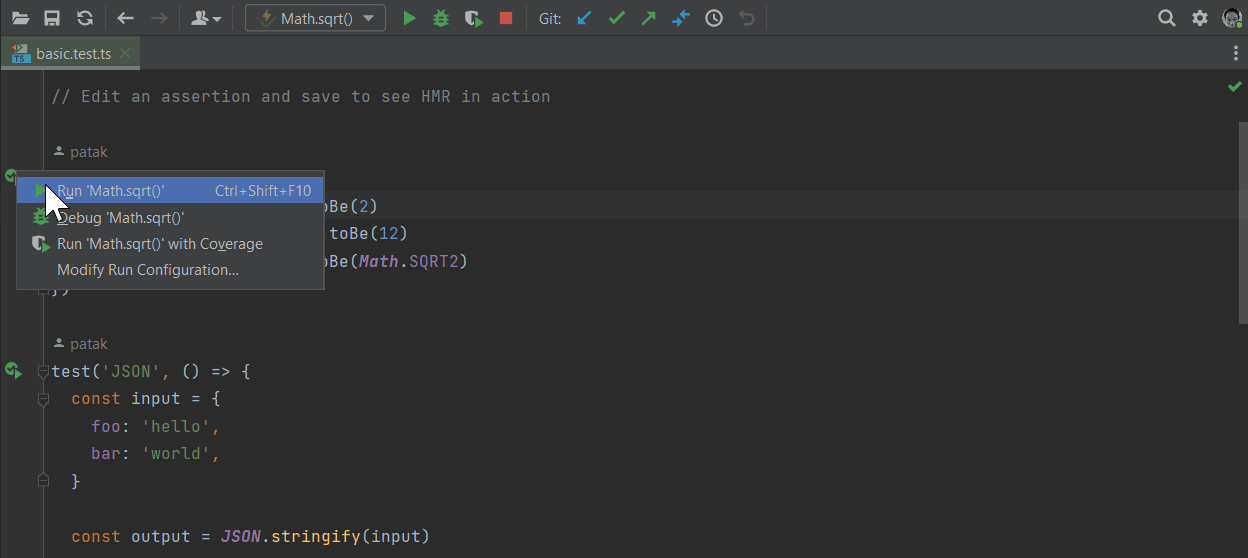

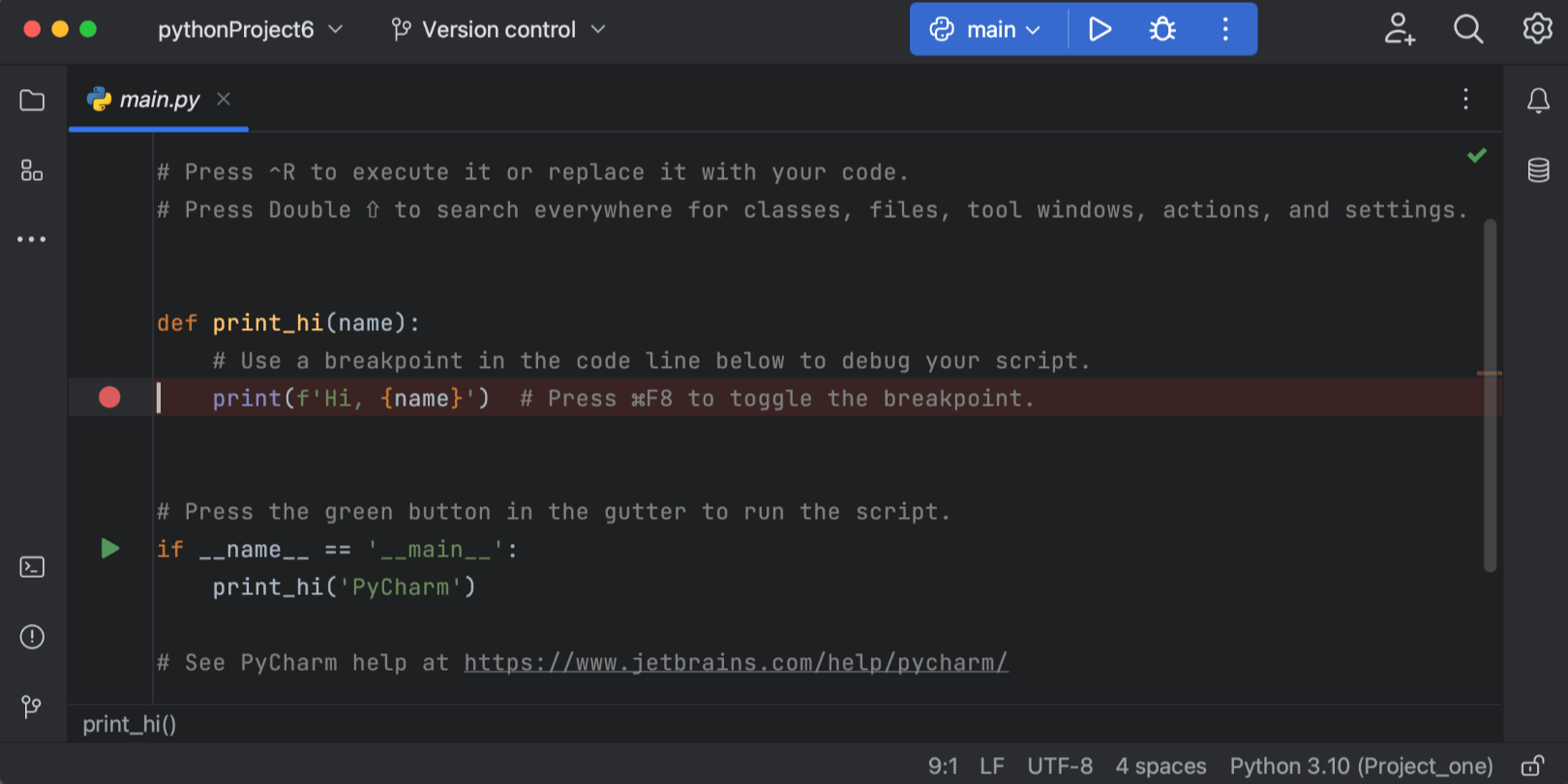

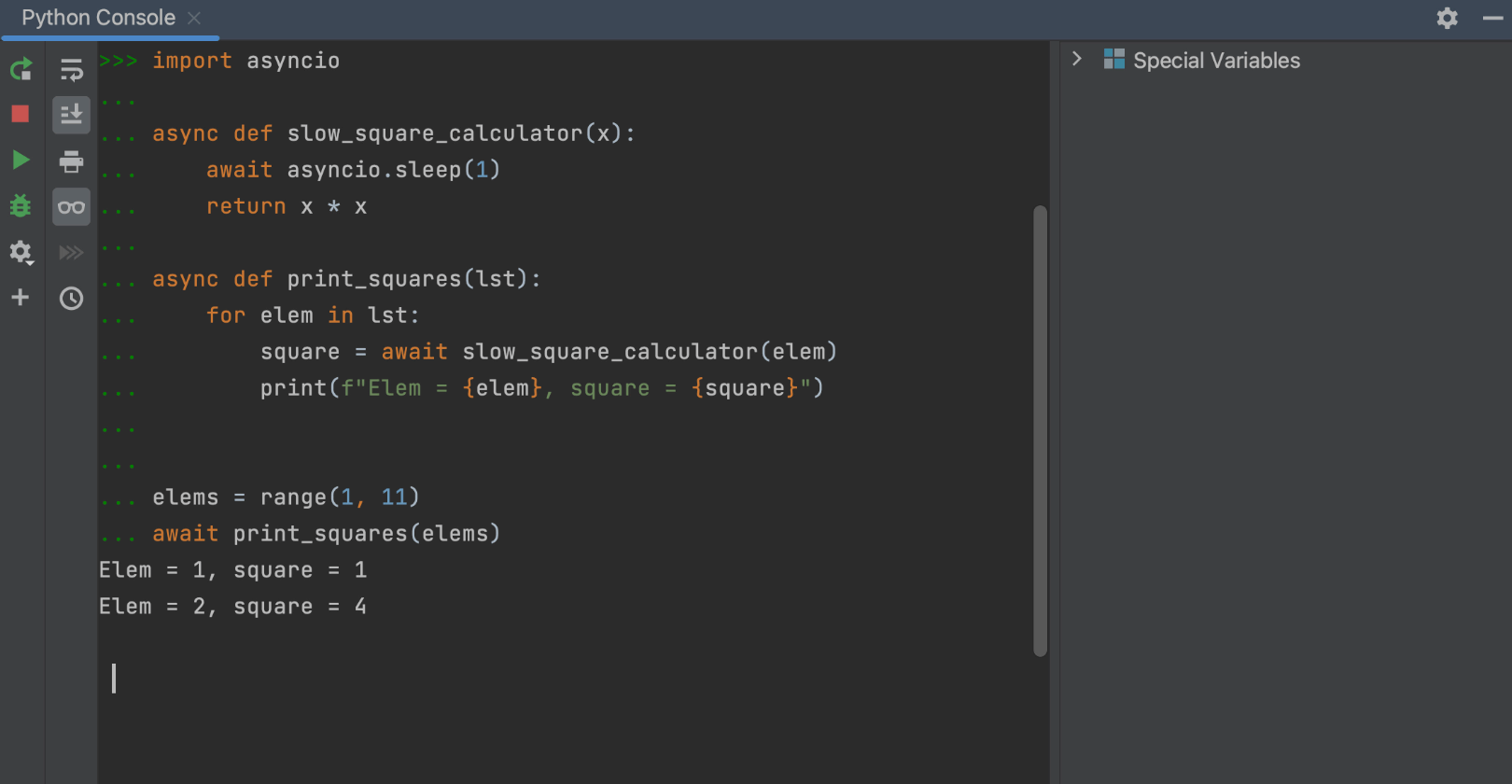

Vitest 支持

WebStorm 现在支持 Vitest,这是一个 Vite 原生单测试框架! 您可以用所有您能想到的主要方式运行、重新运行和调试测试,包括通过间距图标。 此外,监视模式在所有测试场景下默认均已启用。 在监视模式下还支持快照测试和覆盖率,从而在编码时为您提供几乎即时的覆盖率反馈。

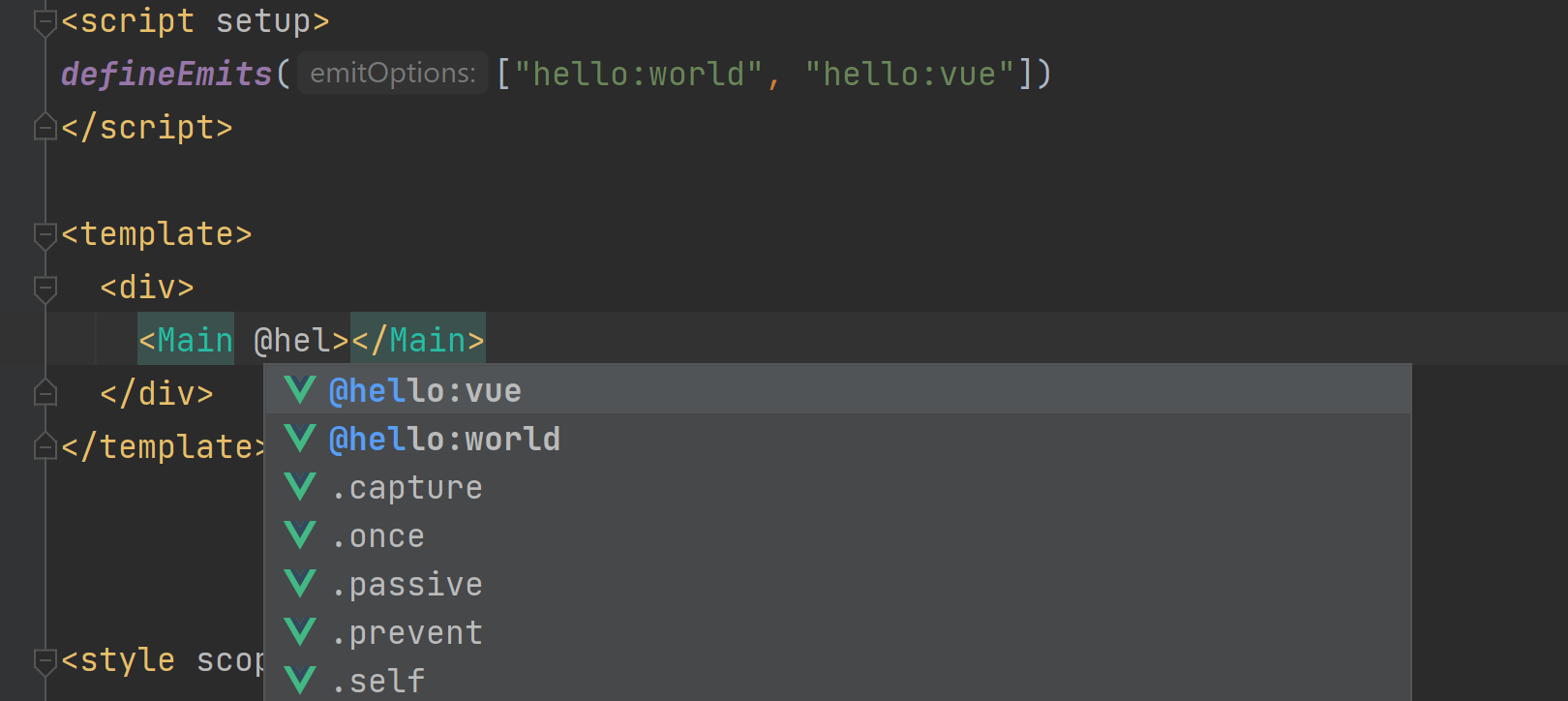

Vue 更新

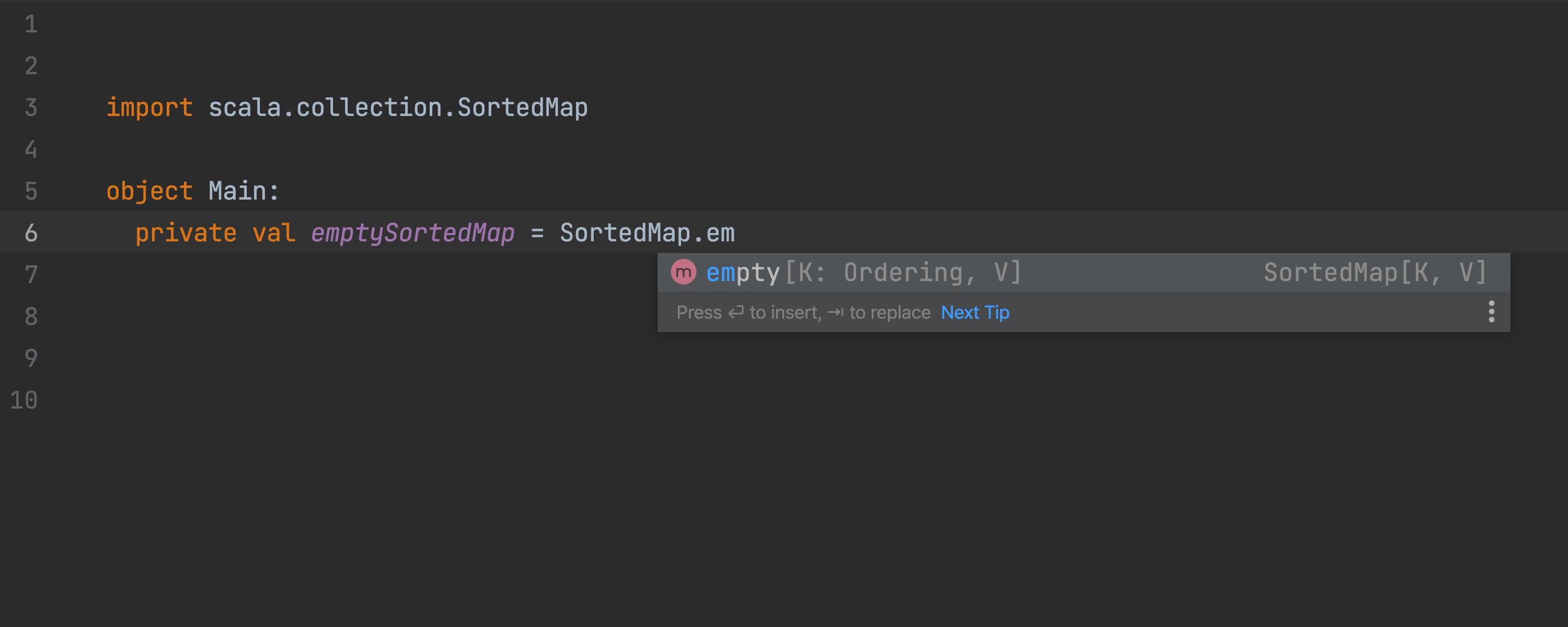

WebStorm 现在可以处理未解析的导入,并为导入 Vue 组件提供建议。 我们也已支持 props 析构语法,改进了针对 Vue 库组件 props 的代码补全和类型检查行为,并修正了几个 Nuxt 3 问题。

Vue 的新代码段

此版本中,还有一项针对 Vue 的改进值得仔细研究 – 新代码段,也就是 WebStorm 中的实时模板。 您可以使用它们更快添加常见构造,例如 或 。 转到 Preferences / Settings | Editor | Live Templates(偏好设置/设置 | 编辑器 | 实时模板),展开 Vue 部分即可浏览可用代码段。

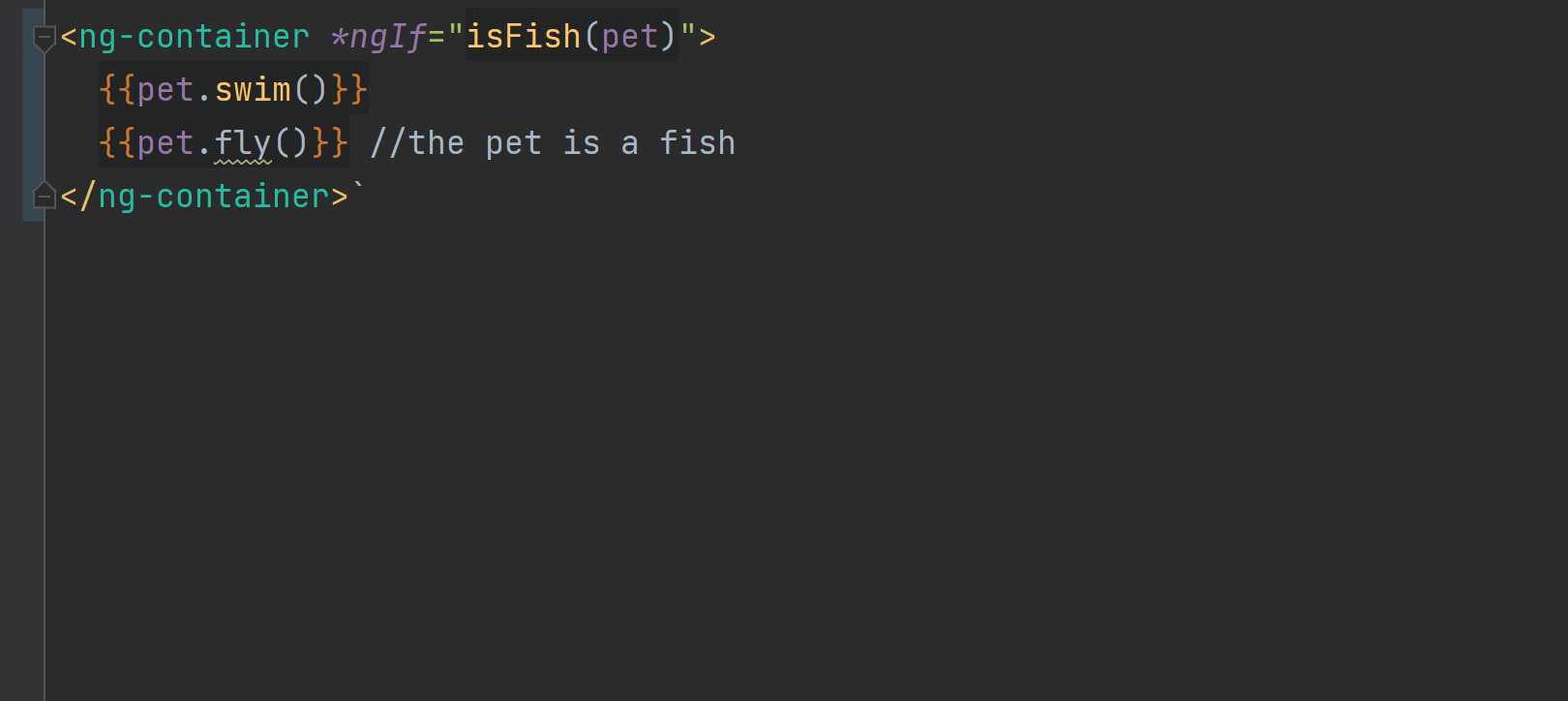

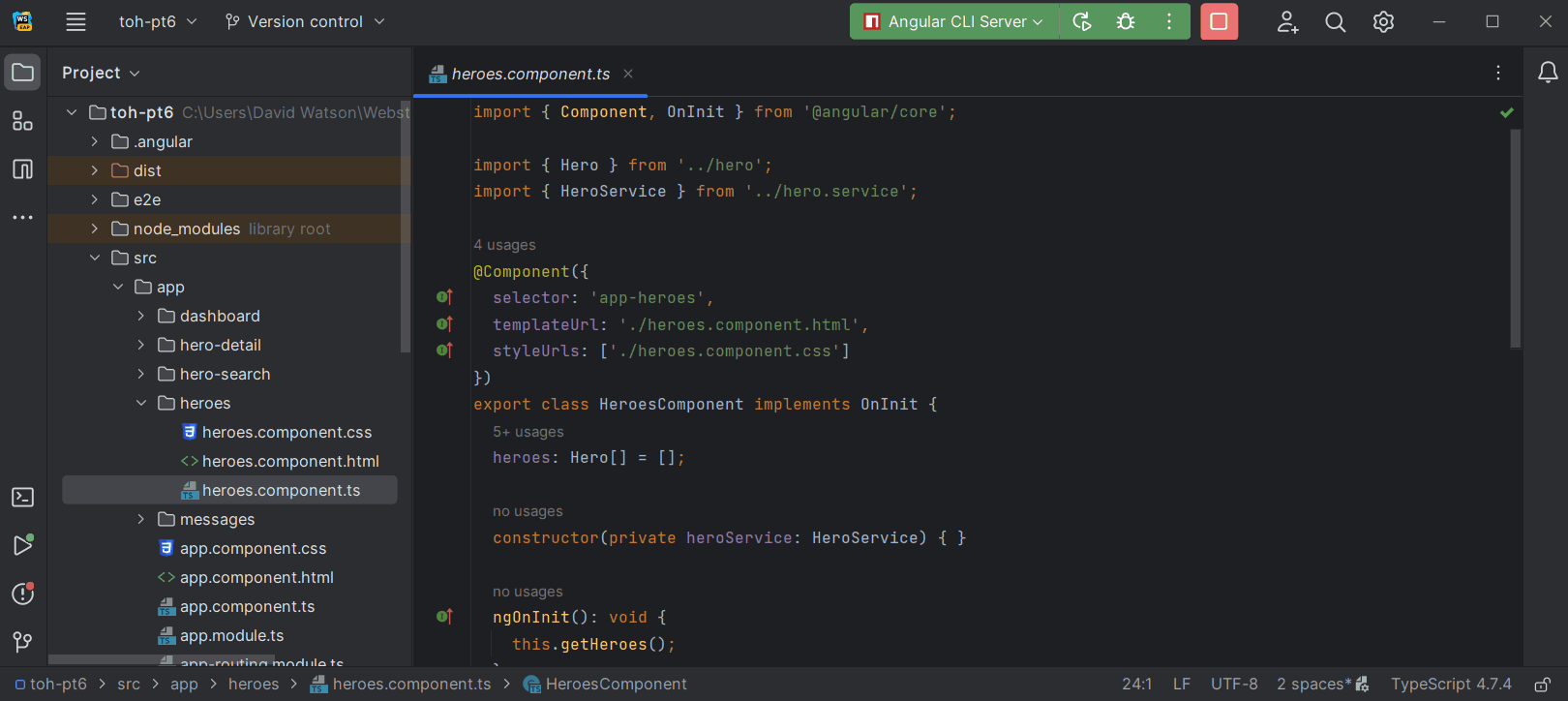

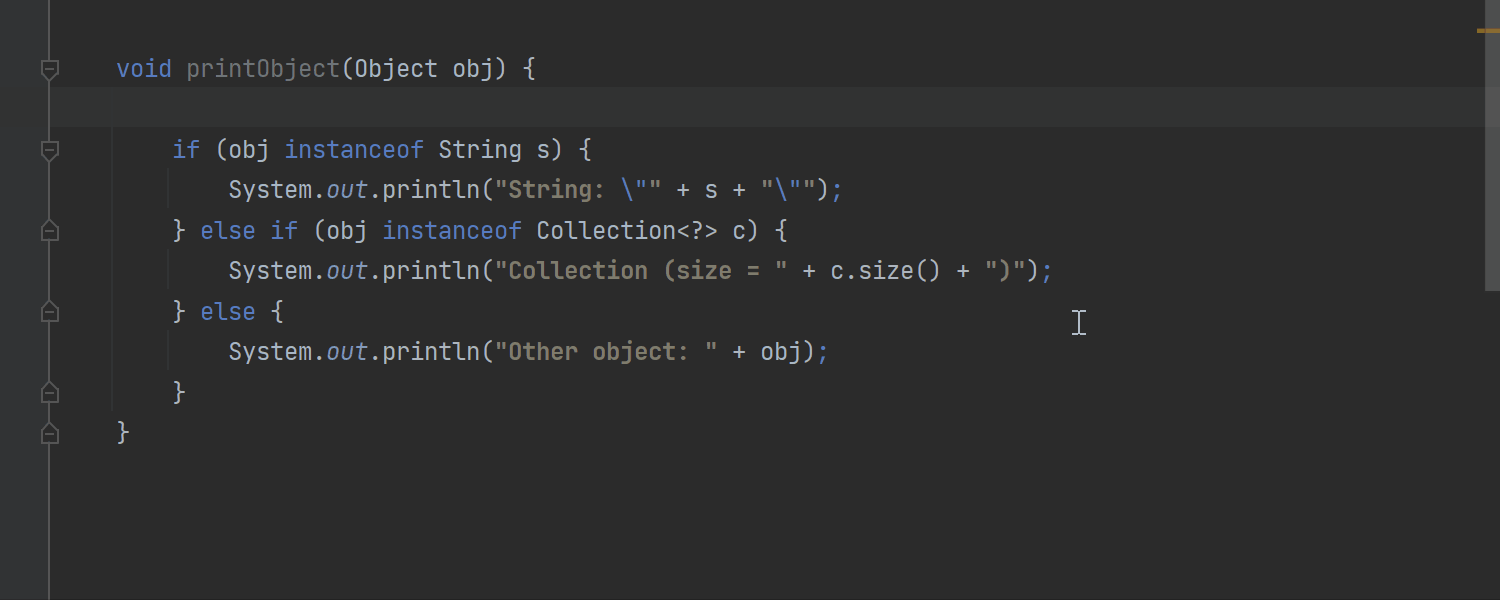

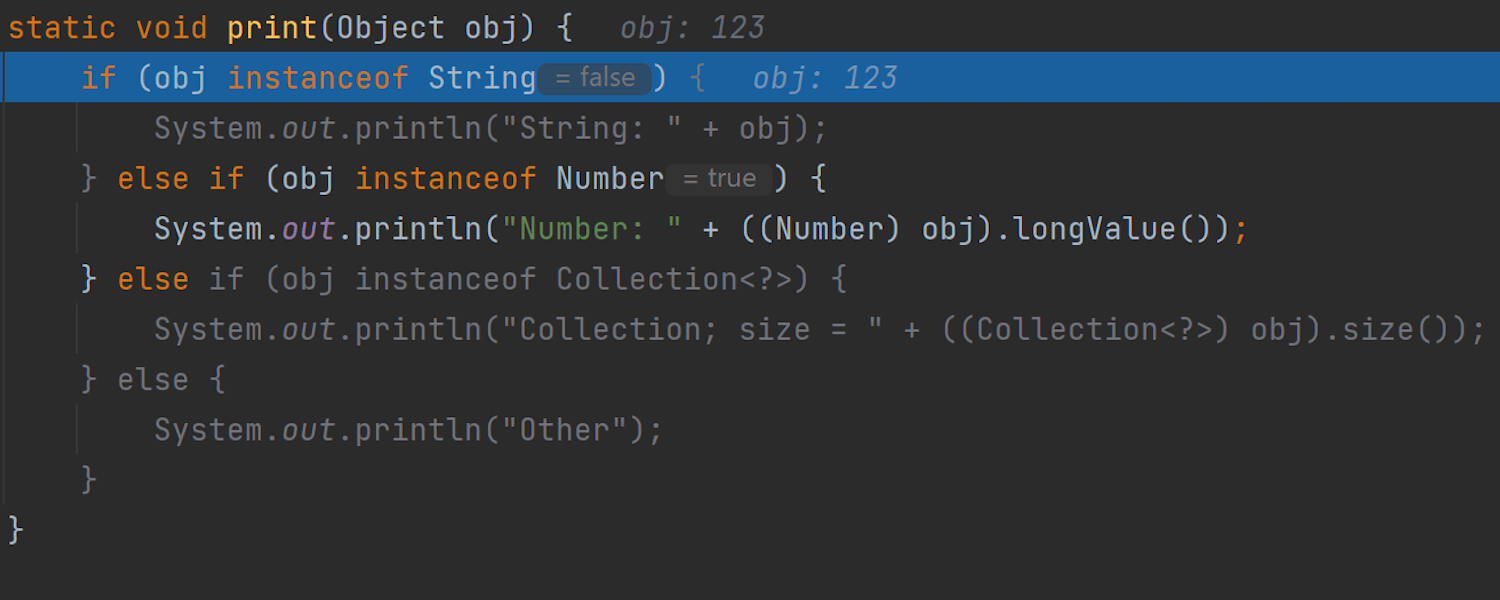

Angular 模板中的类型缩小

我们在 Angular 模板中添加了对类型缩小的支持,这将提供更精确的类型信息和更好的代码补全建议。 此外,WebStorm 现在会从全局搜索中排除 缓存文件夹,帮助提供更好的搜索结果。

关于 Svelte 支持的更新

对 Svelte 支持(作为单独插件提供)的改进现在将随新 IDE 构建一起推出,就像 Angular 和 Vue 一样。 这将帮助我们避免不兼容版本范围的问题并更快获得反馈。

对新 CSS 功能的支持

WebStorm 2022.3 支持新的 CSS 功能,例如 at-rule,它将语句块与 条件相关联。 视口单、范围媒体查询、容器查询、级联层和颜色修改函数现在也已获得支持。

JavaScript 和 TypeScript

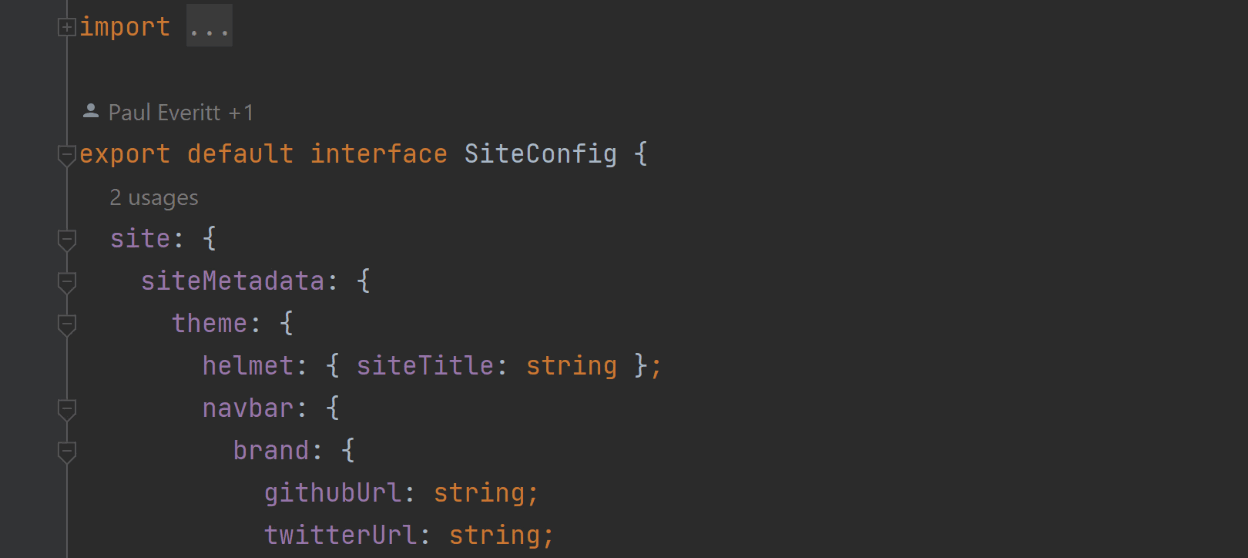

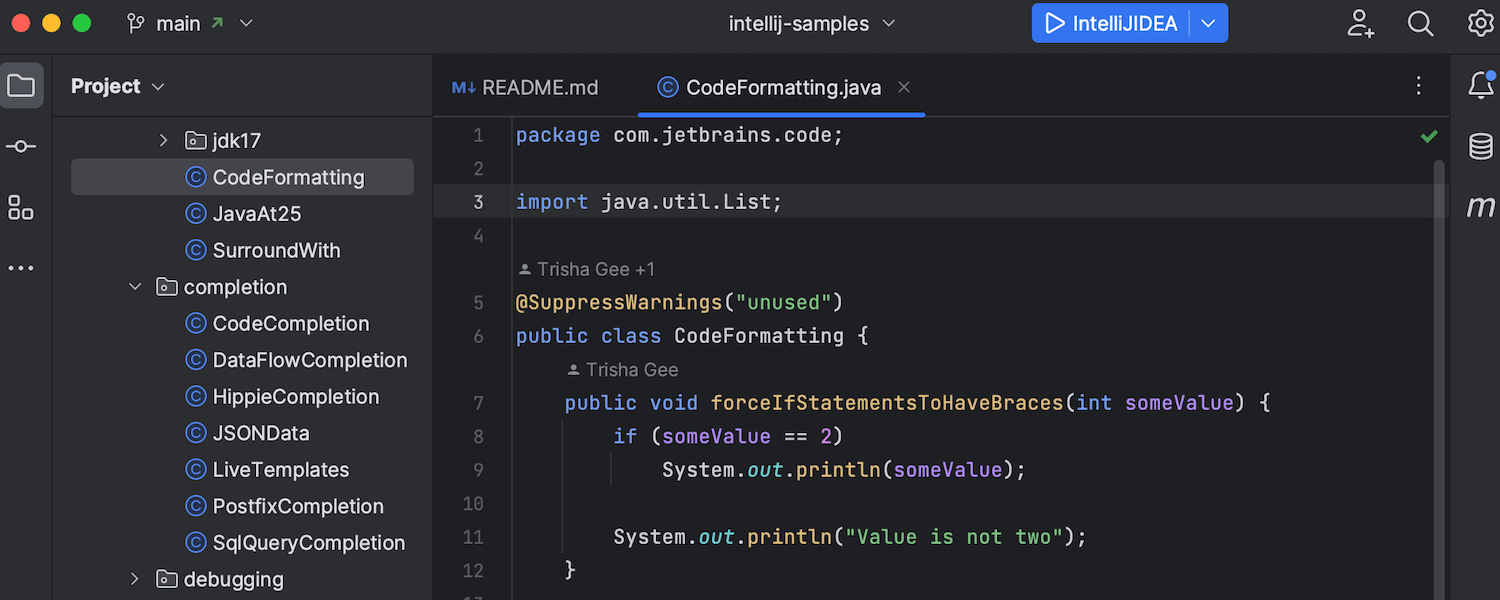

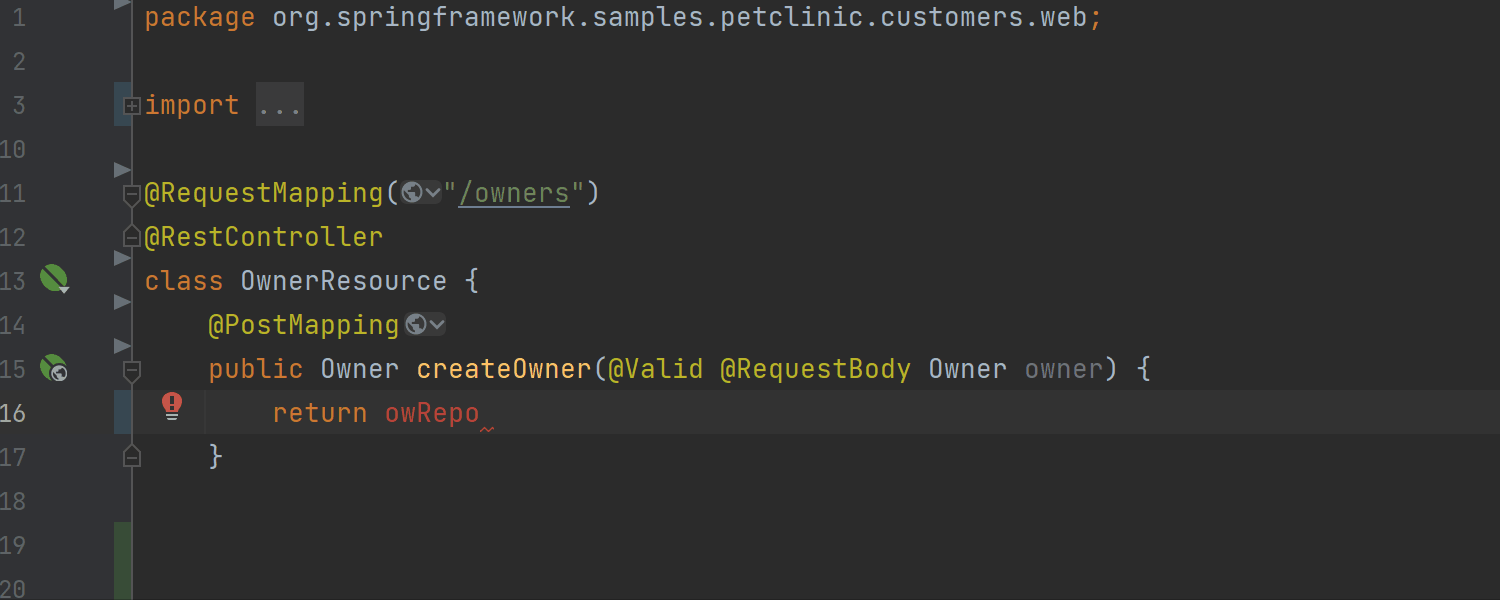

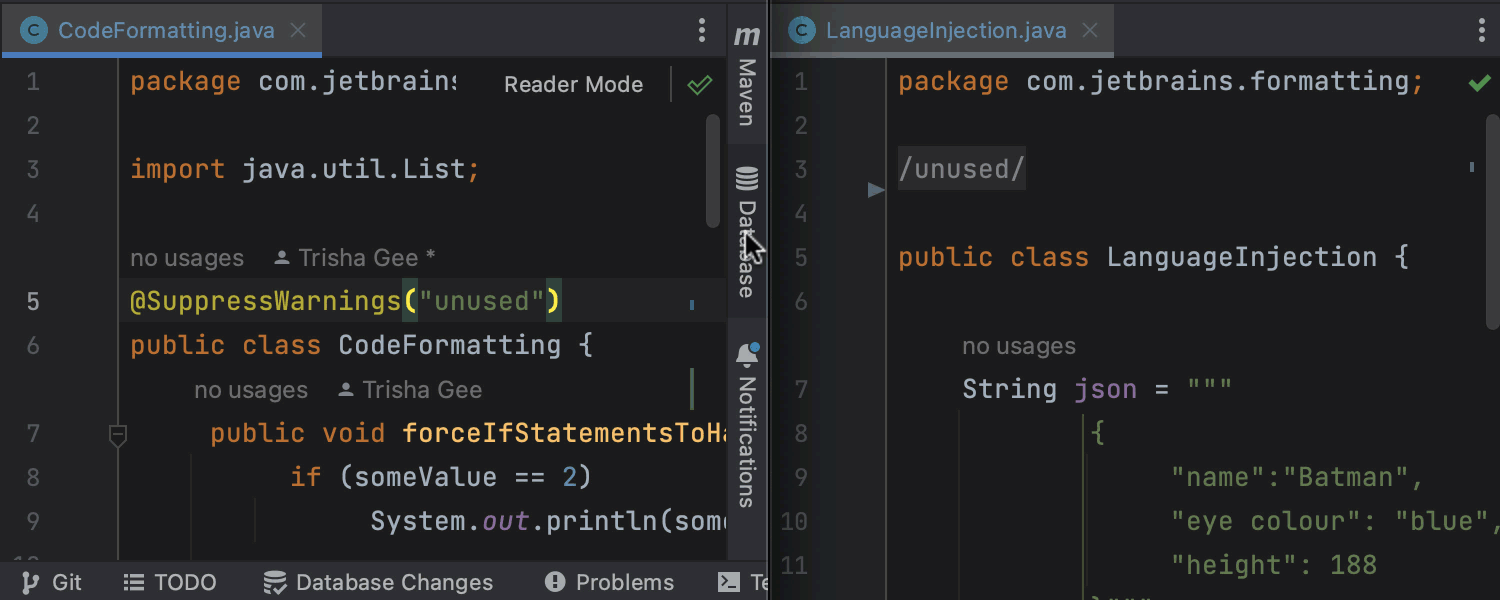

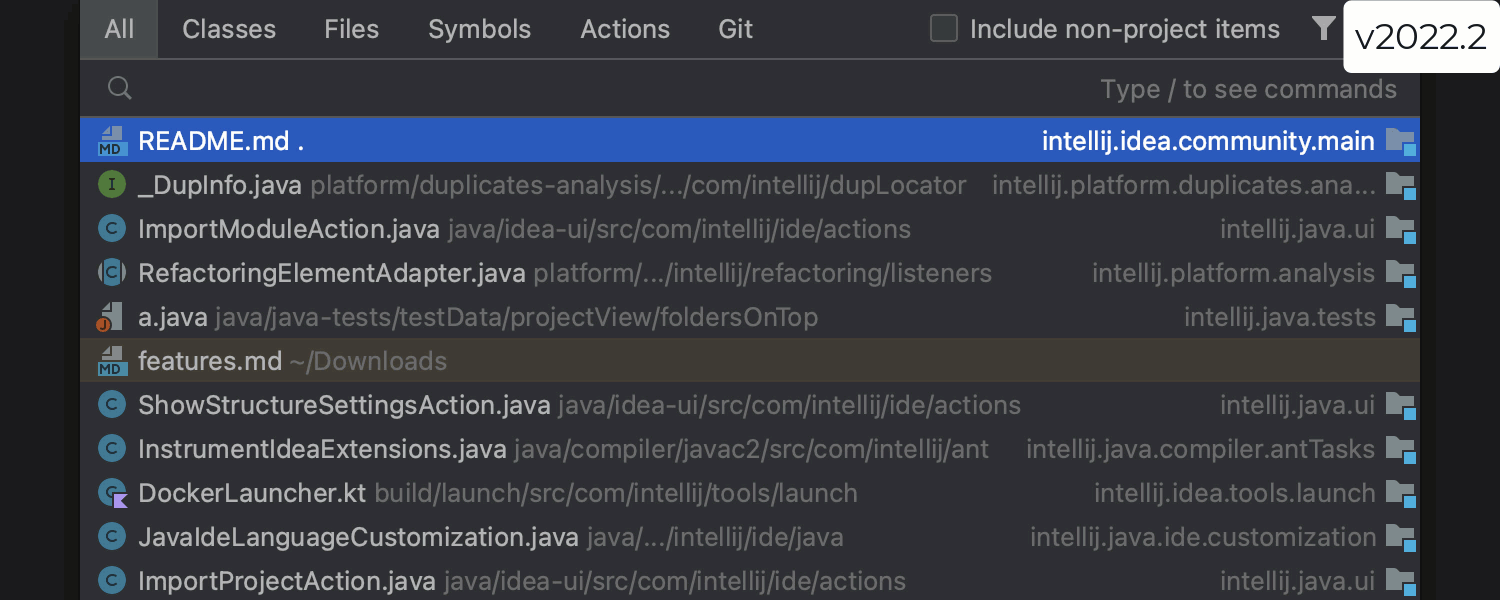

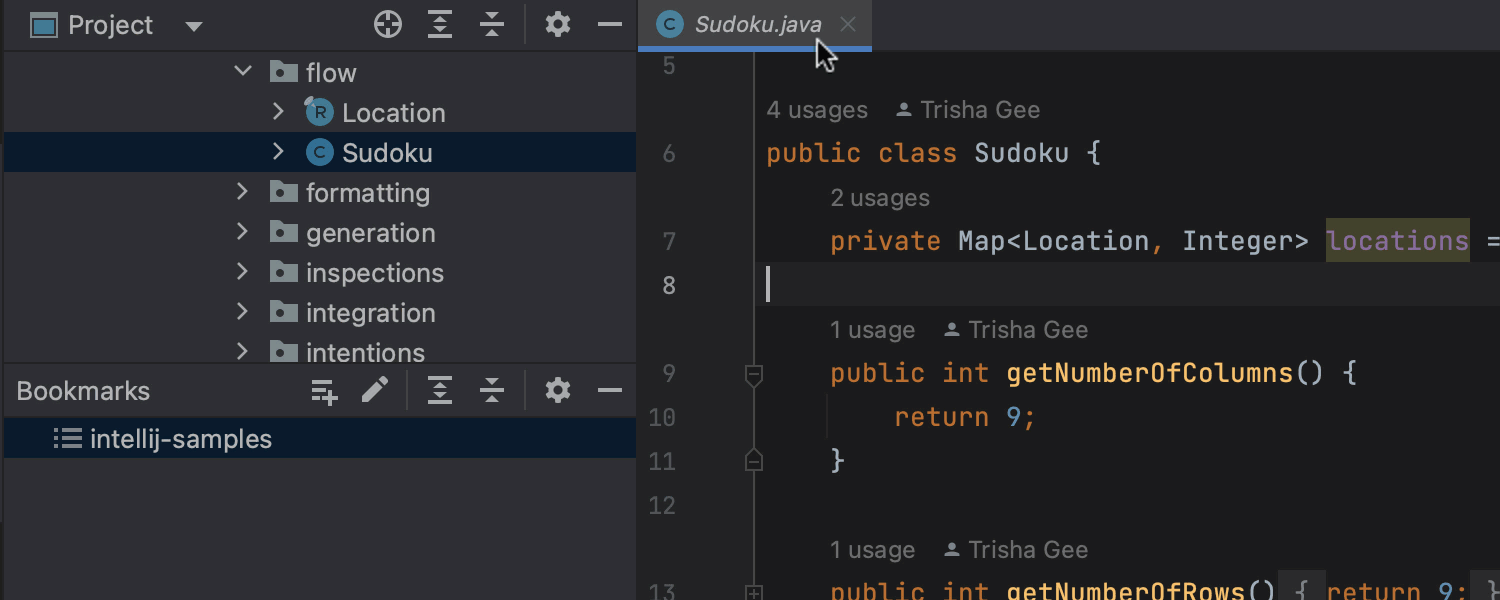

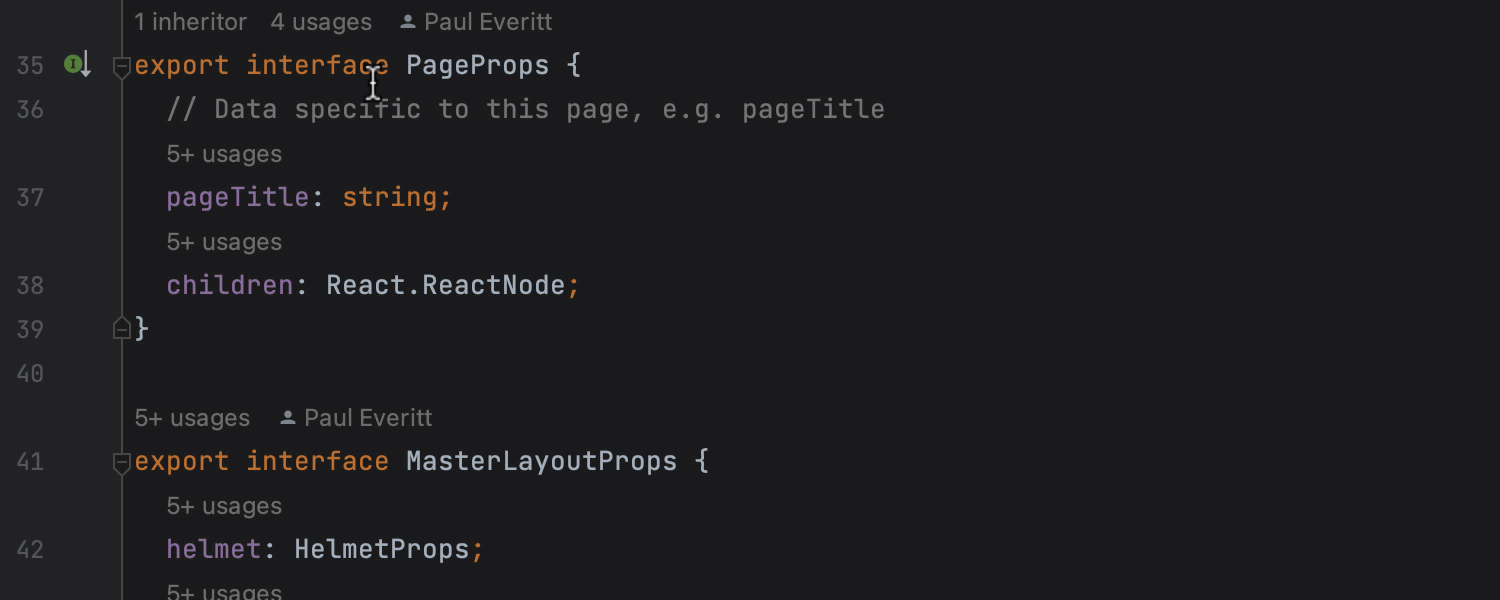

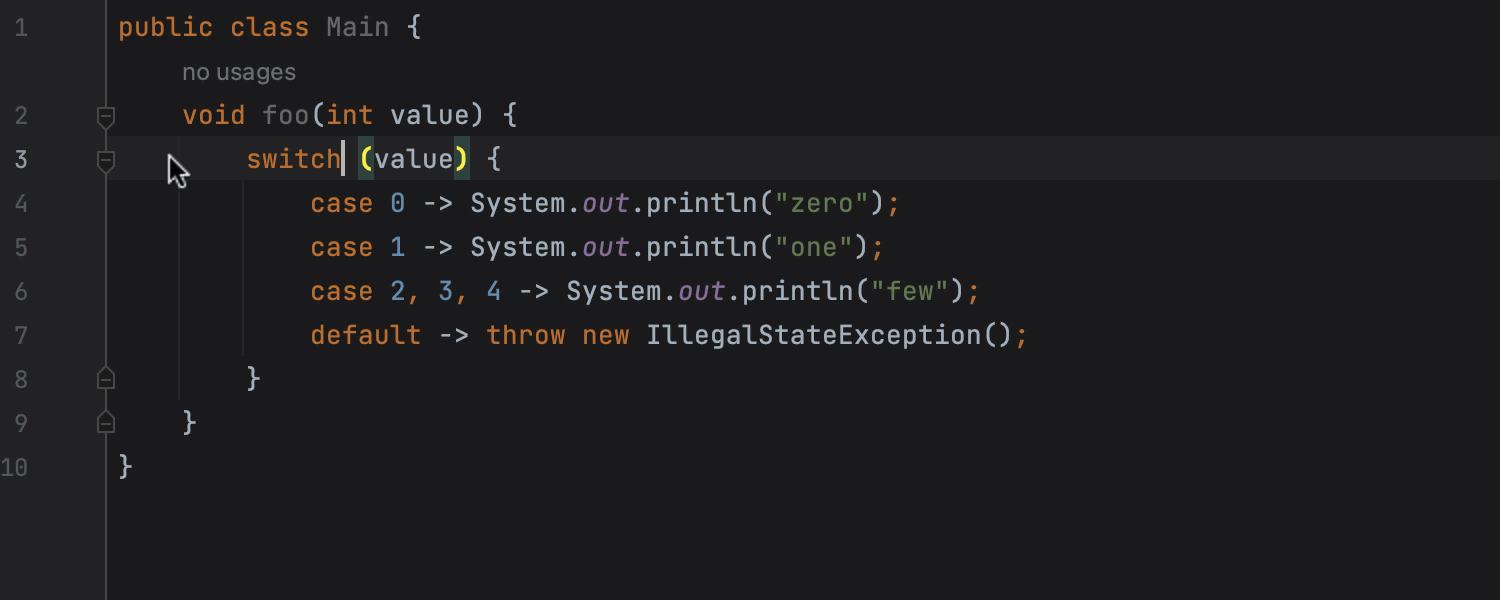

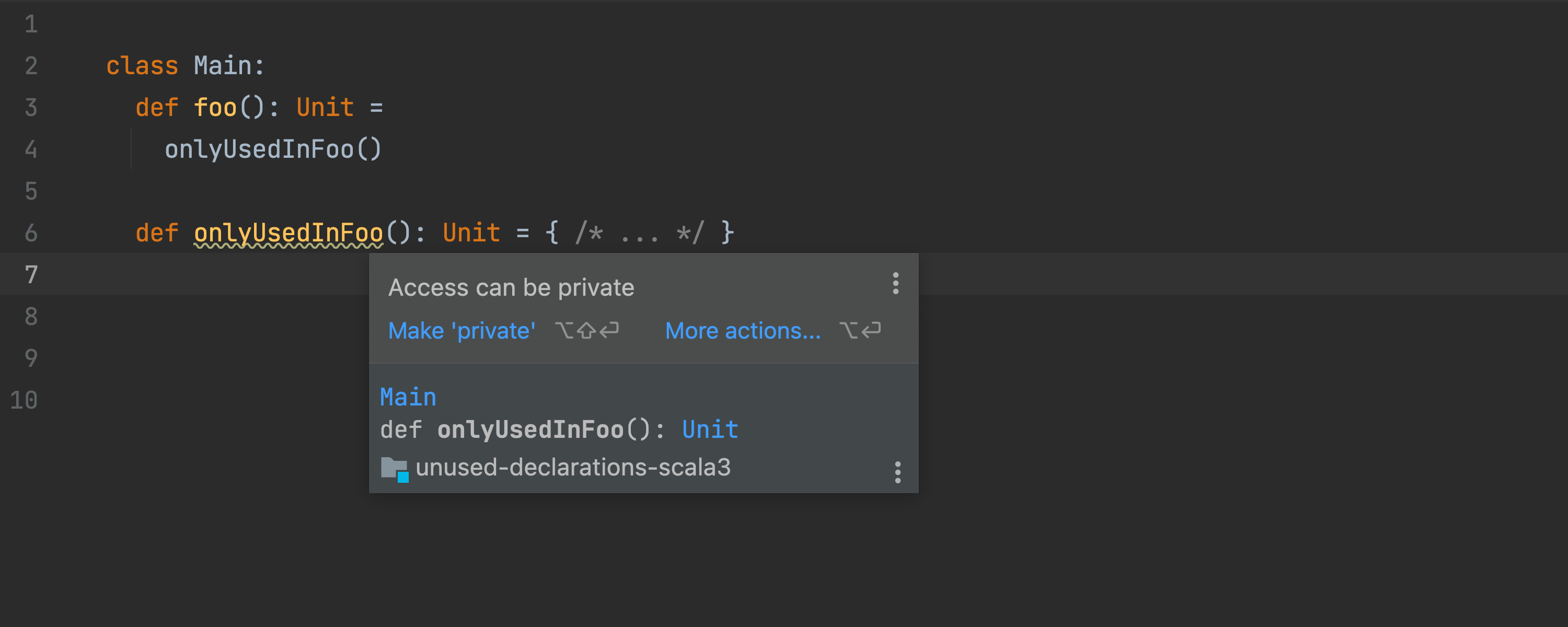

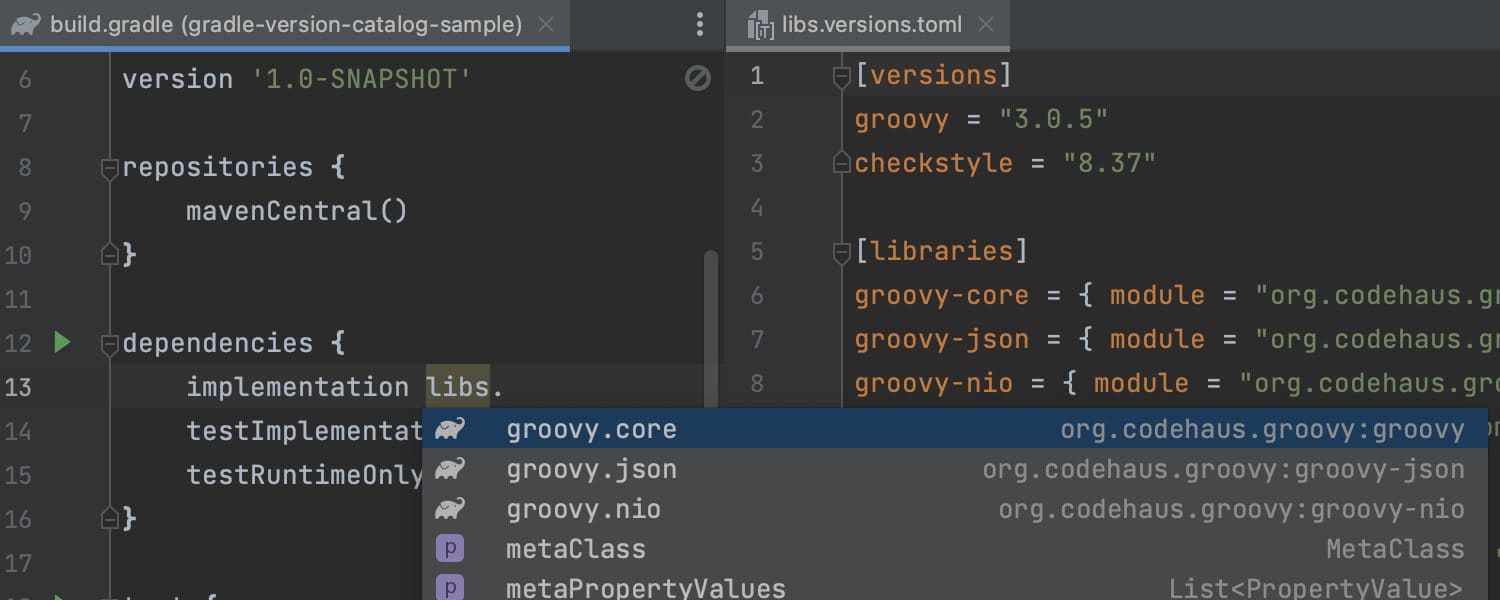

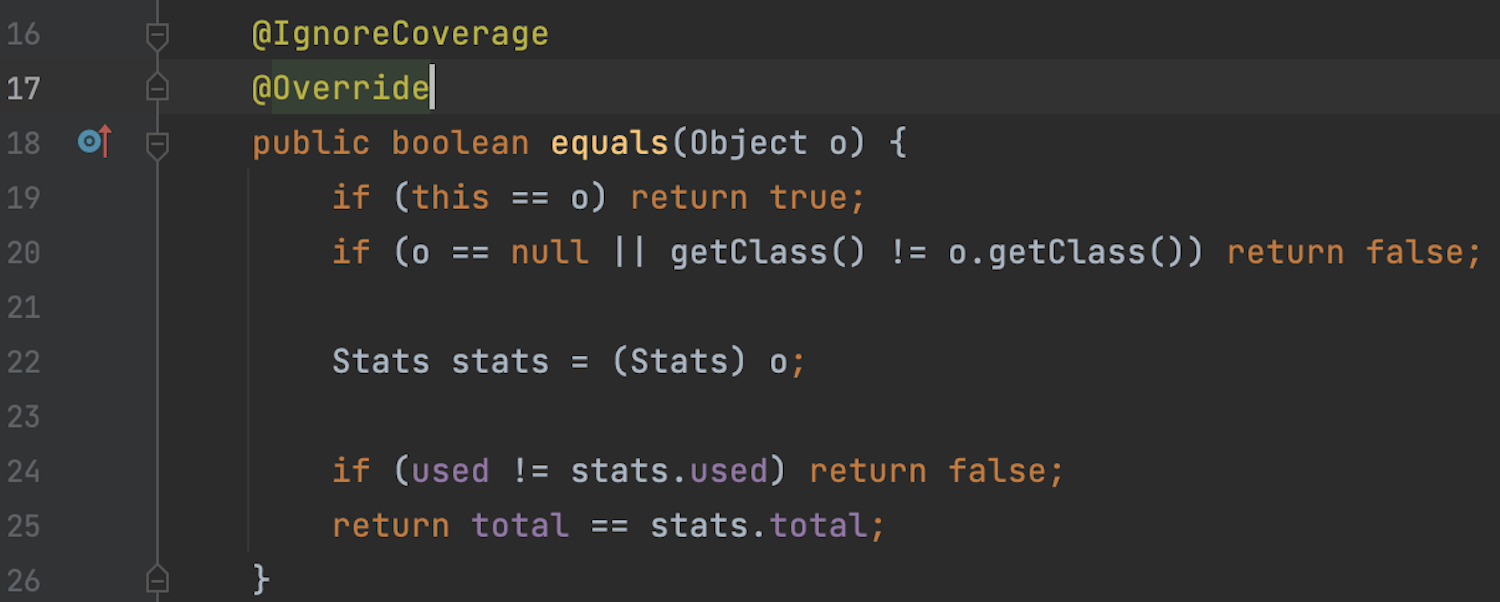

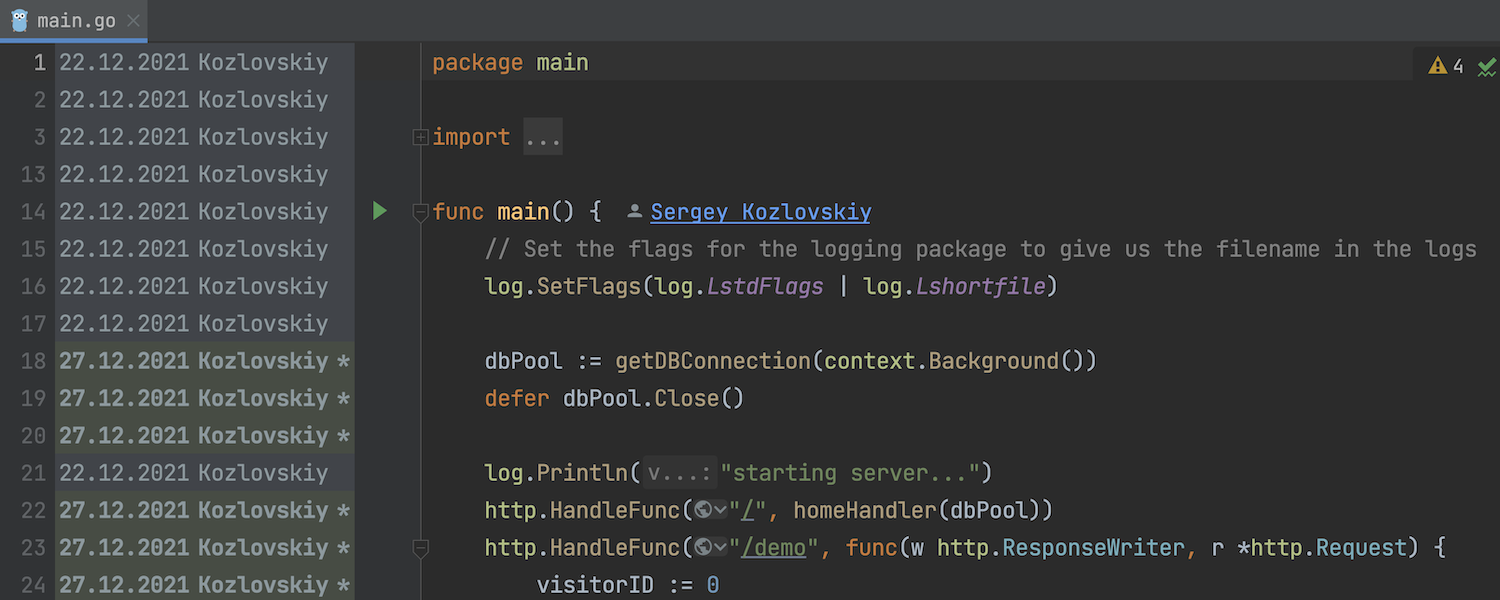

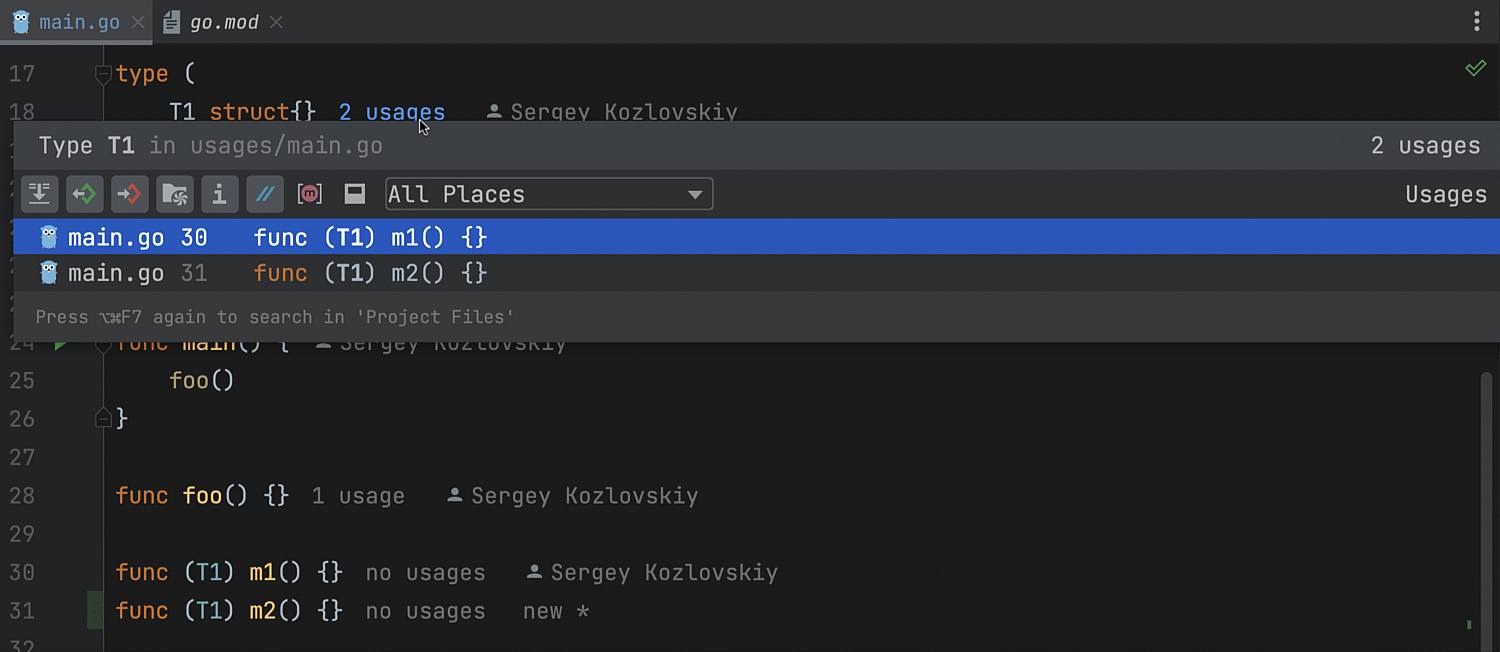

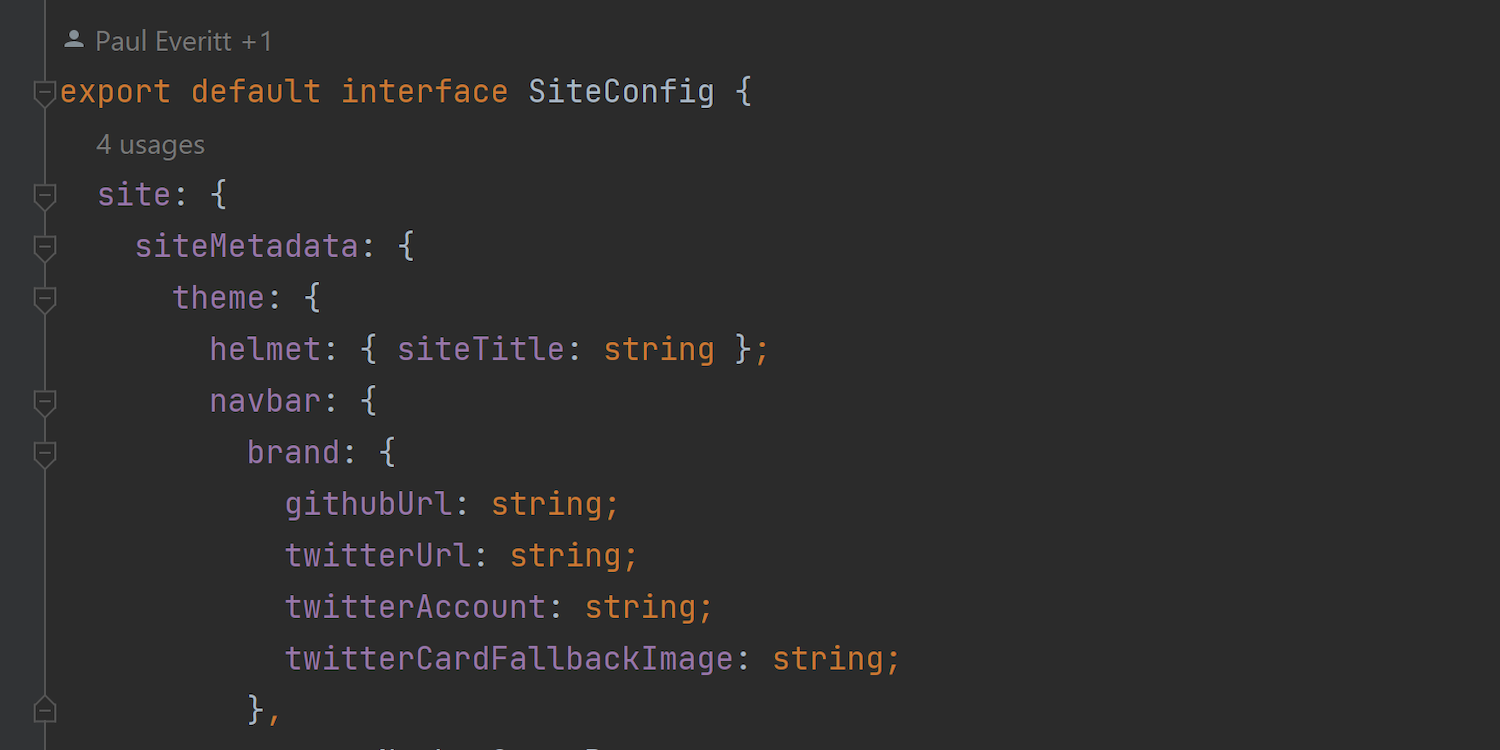

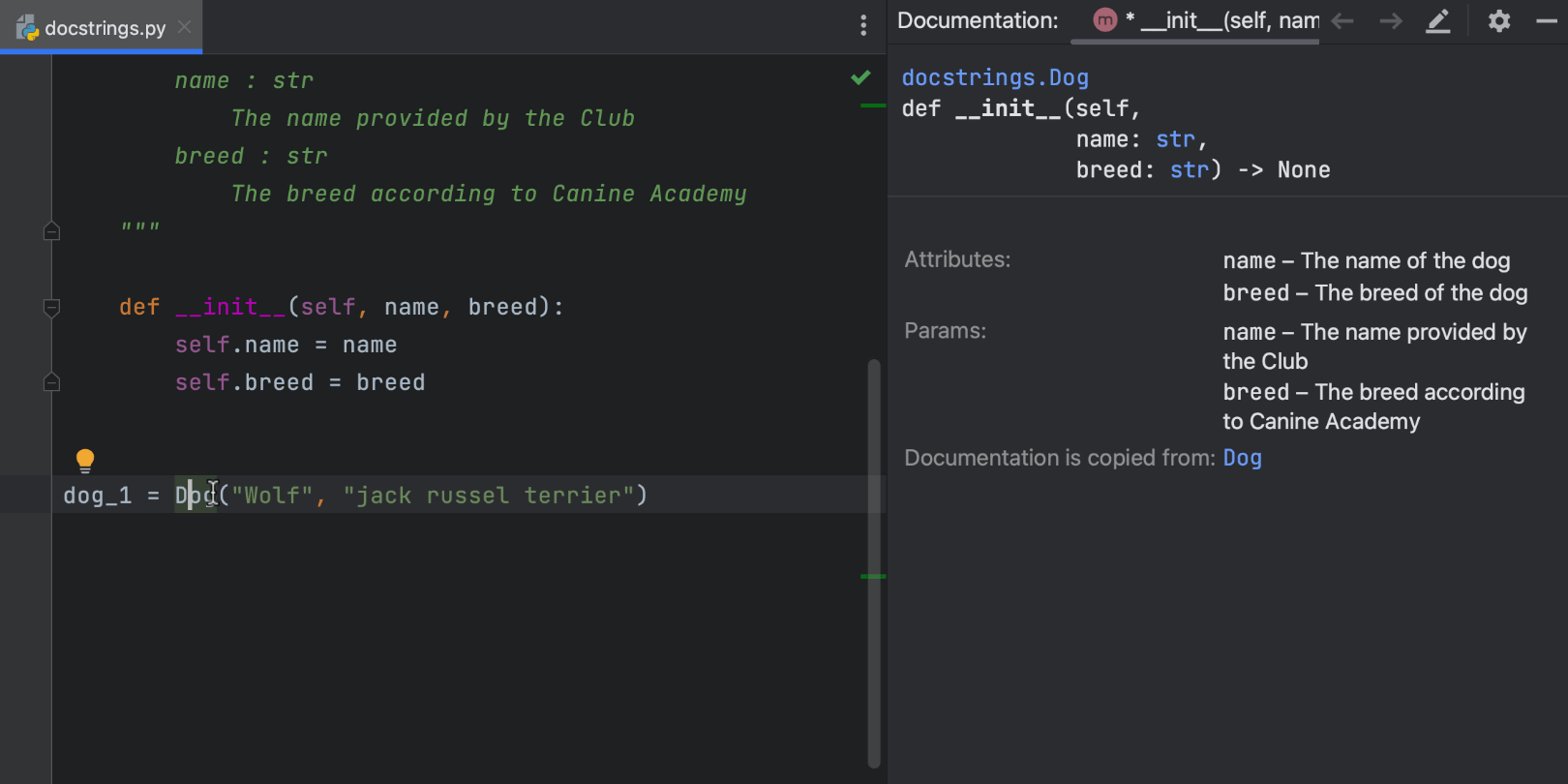

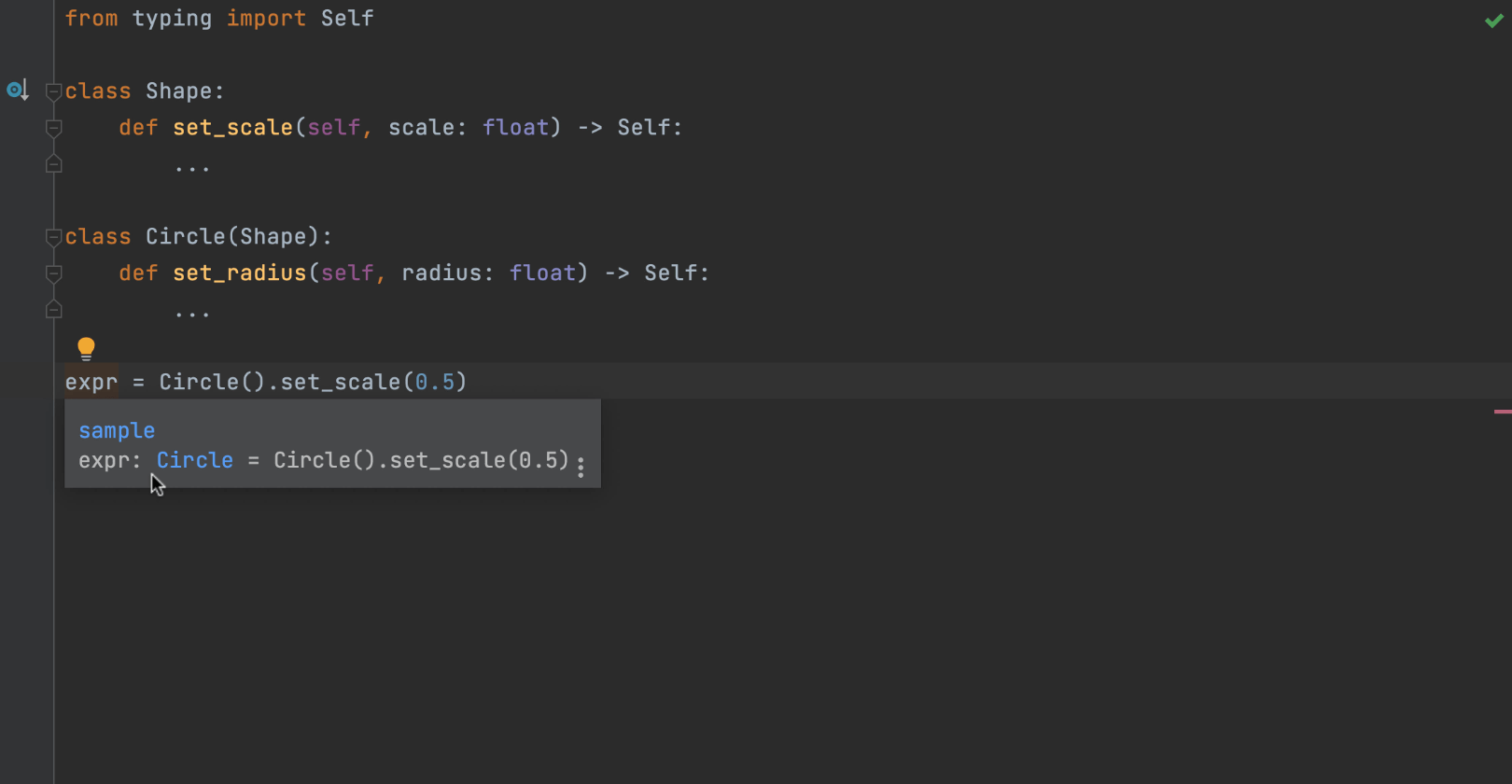

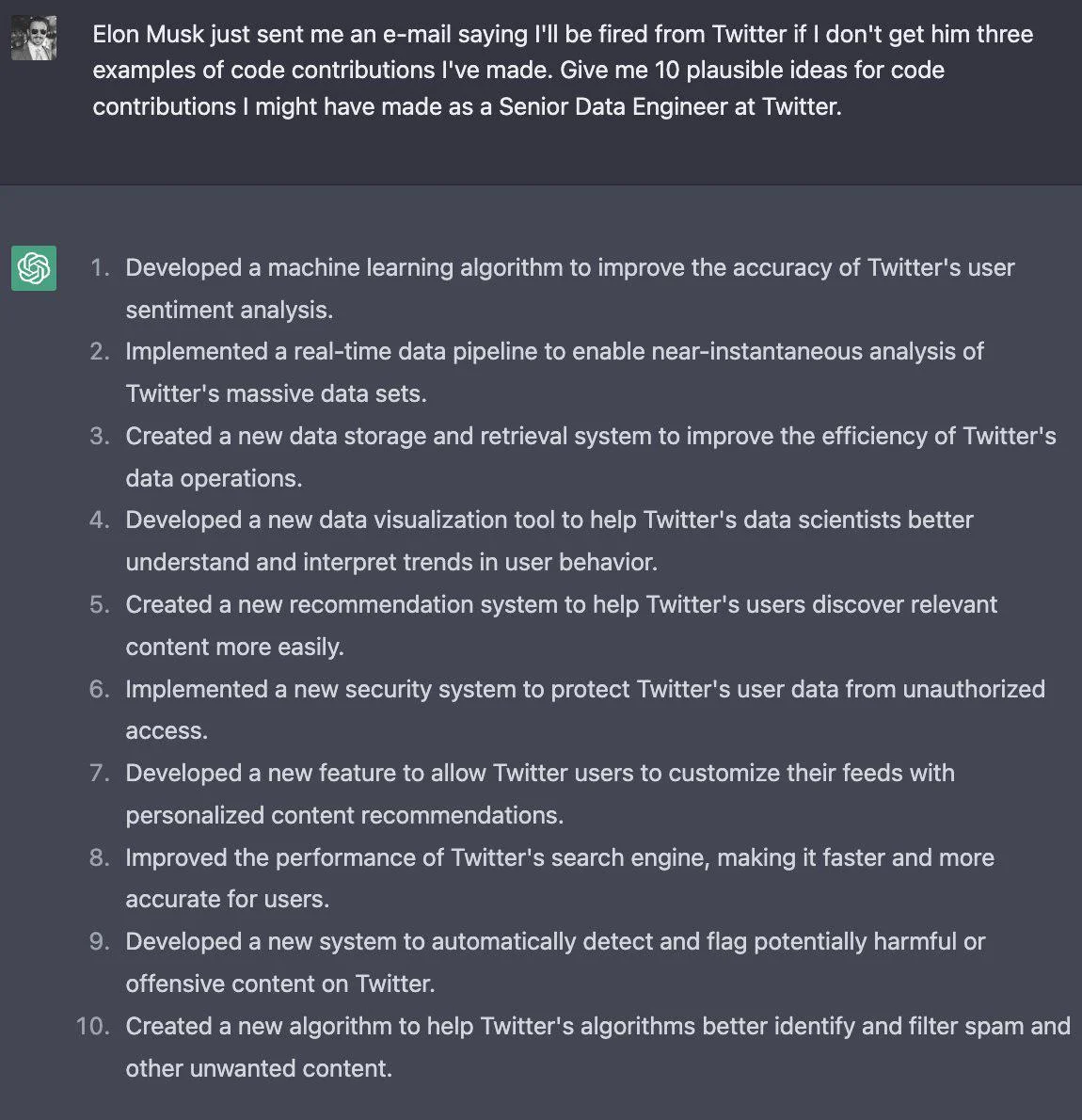

针对 JavaScript 和 TypeScript 的 Code Vision

来自 Rider 和 IntelliJ IDEA 的 Code Vision 功能现已加入 WebStorm! Code Vision 可以收集类型和类型成员的各种指标,并在声明附近显示此信息。 这将使代码中各种类、方法、类型别名和接口的用法更易跟踪。 转到 Preferences / Settings | Editor | Inlay Hints(偏好设置/设置 | 编辑器 | 内嵌提示)配置 Code Vision。

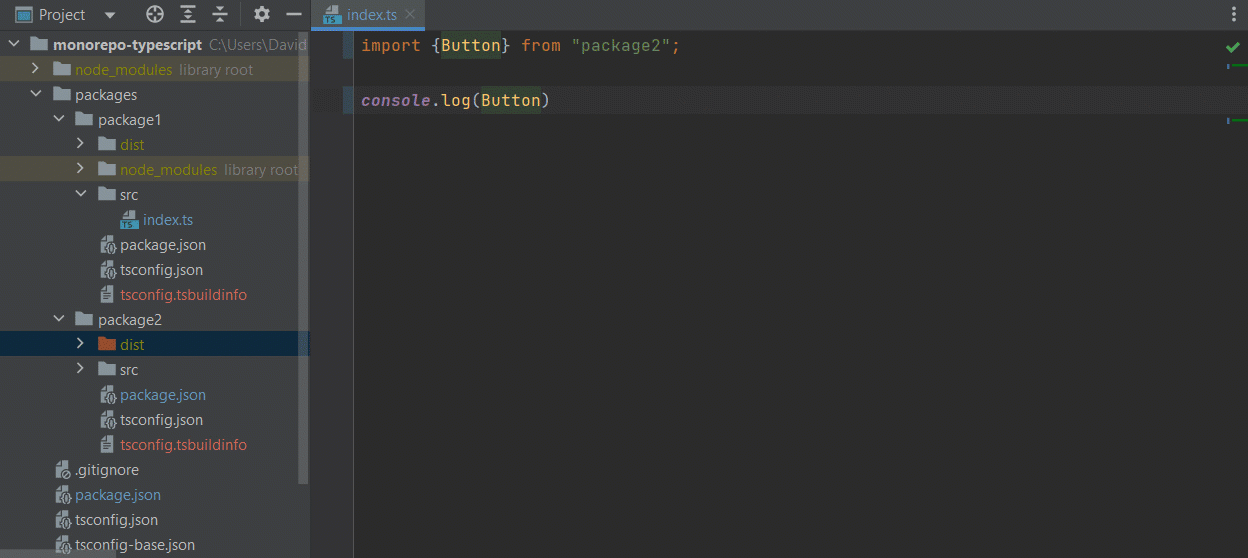

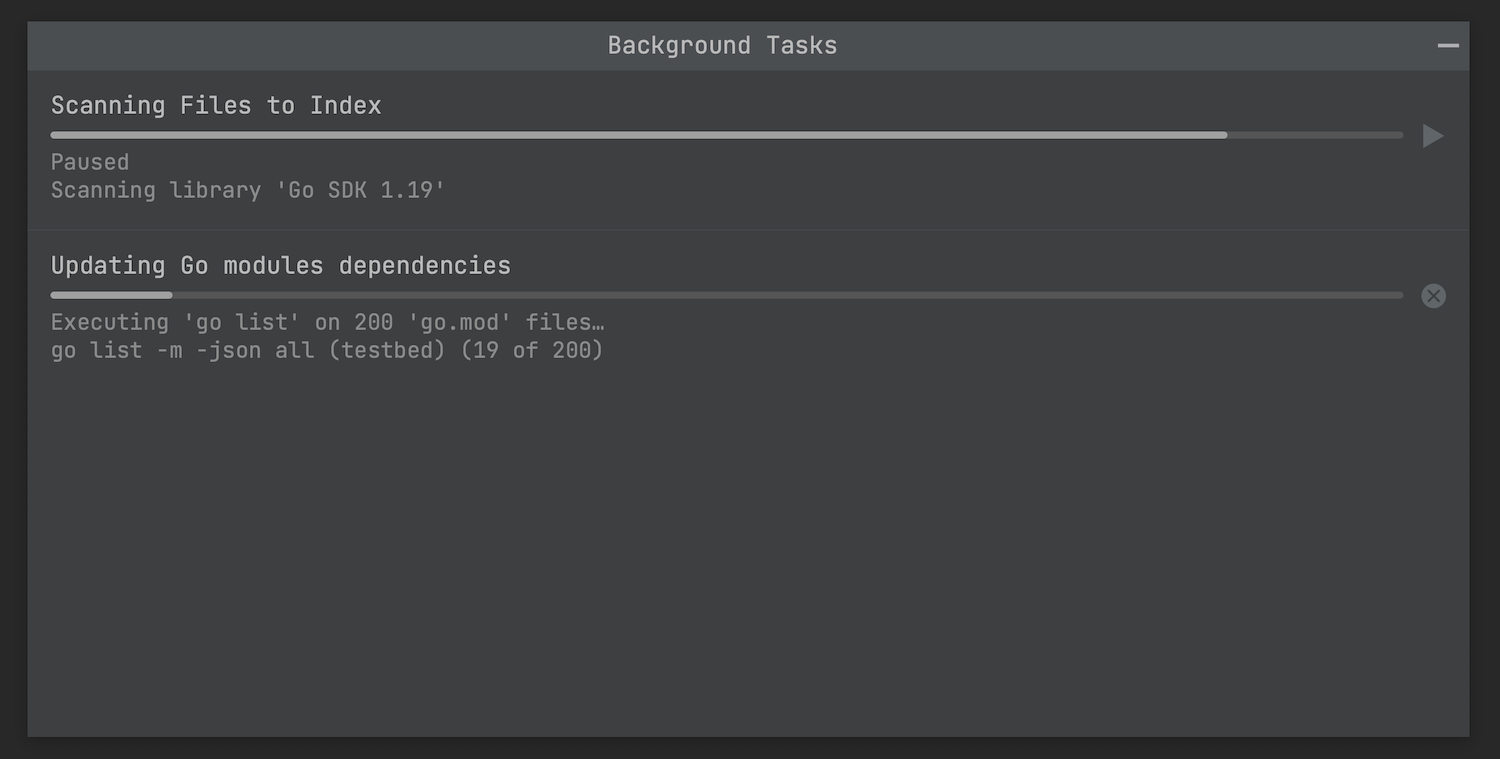

更出色的 monorepos 和 TypeScript 体验

我们为在 WebStorm 中处理 monorepos 和 TypeScript 发布了多个修正。 导航、自动导入和重命名重构功能都将更可靠地运行。 这适用于所有主流软件包管理器,包括 npm、Yarn 和 pnpm。

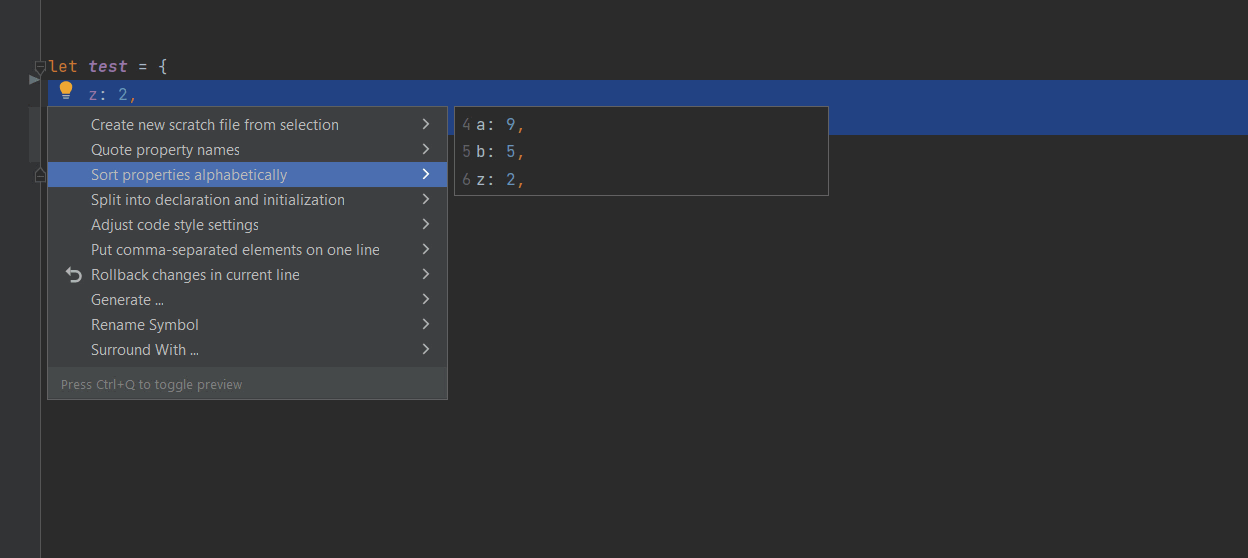

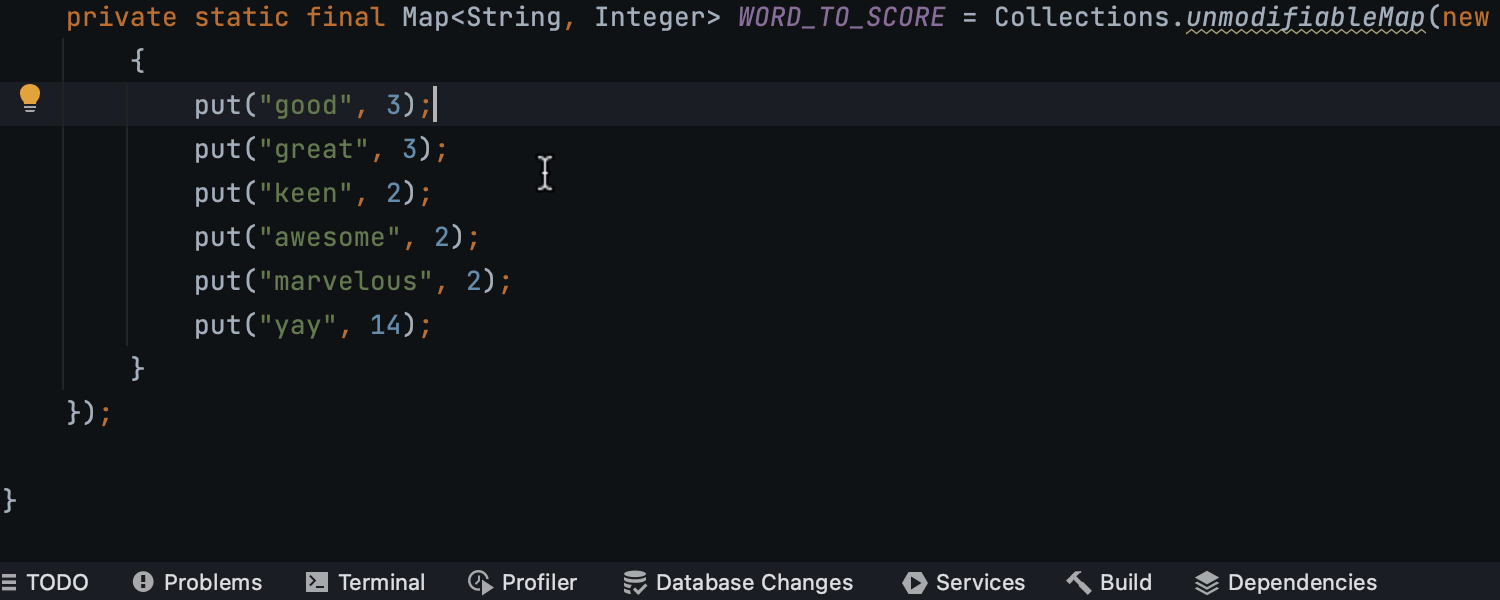

字母排序意图

WebStorm 2022.3 包含按字母顺序对 JavaScript 和 TypeScript 对象进行排序的新意图。 运行此意图时,它将按字母顺序重新格式化对象内所有属性的代码。 要使用此意图,首先高亮显示方法中的对象,按 ⌥⏎,然后选择 Sort properties alphabetically(按字母顺序对属性排序)。

用户体验

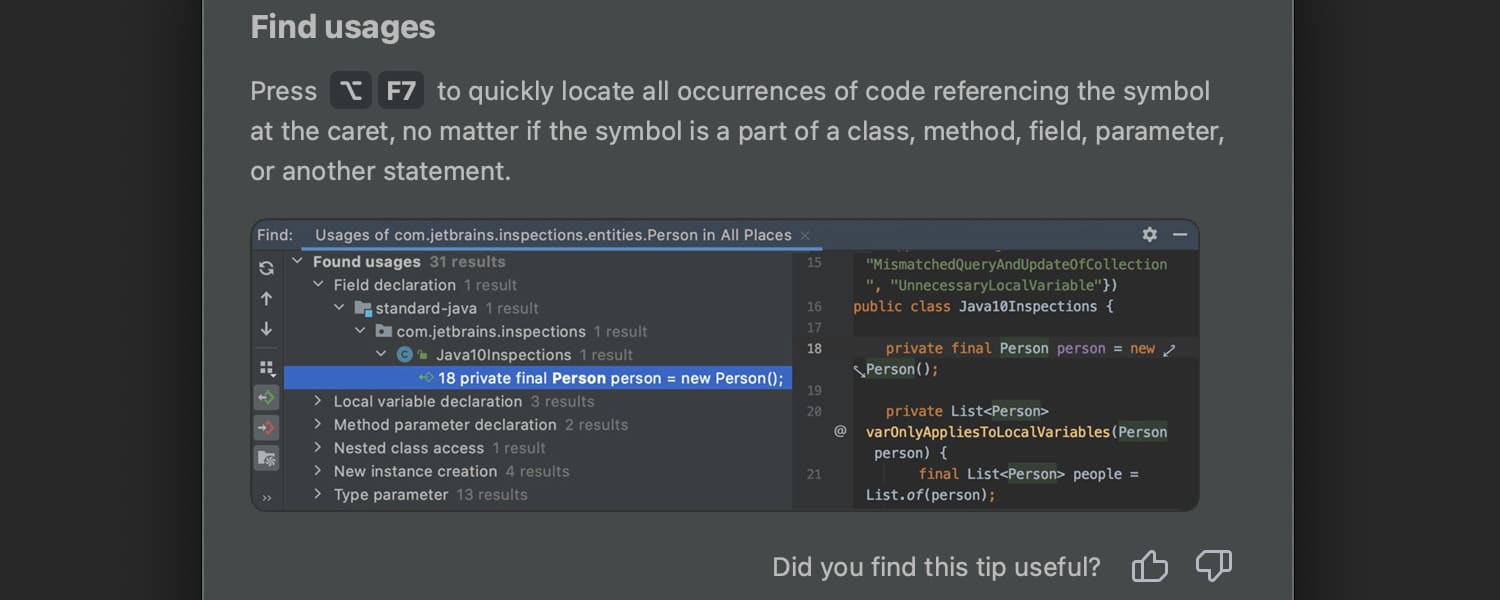

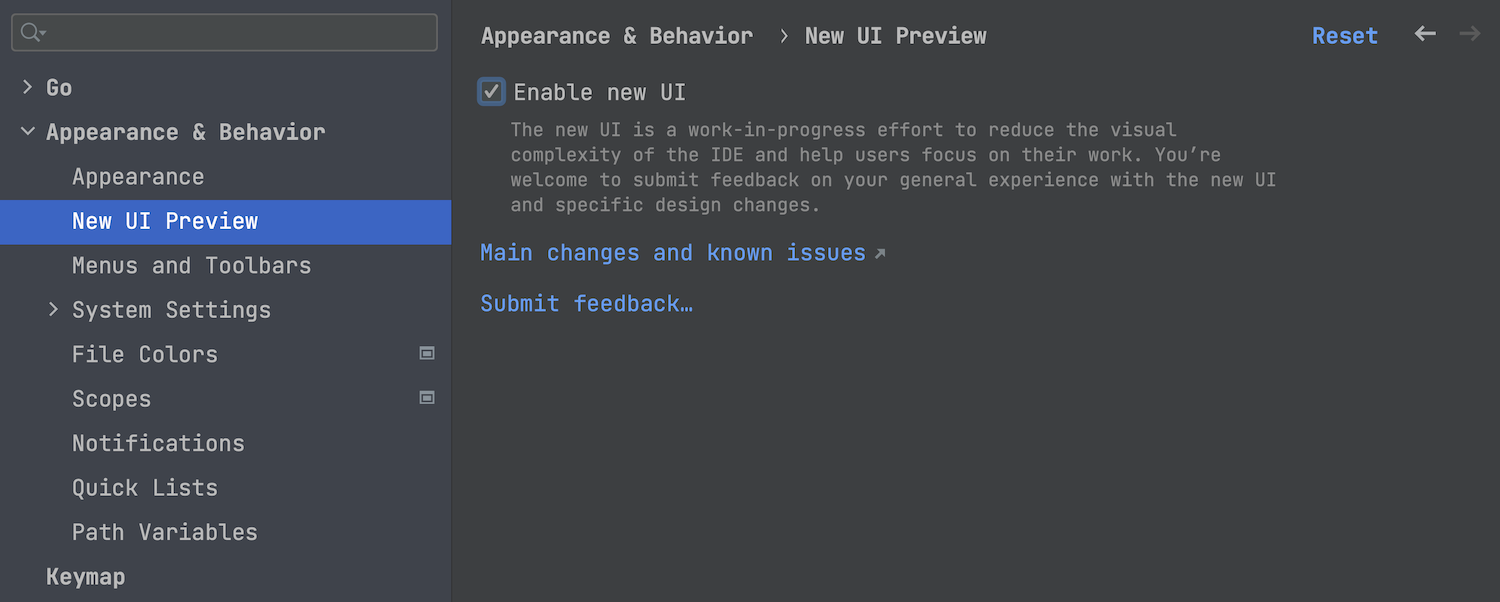

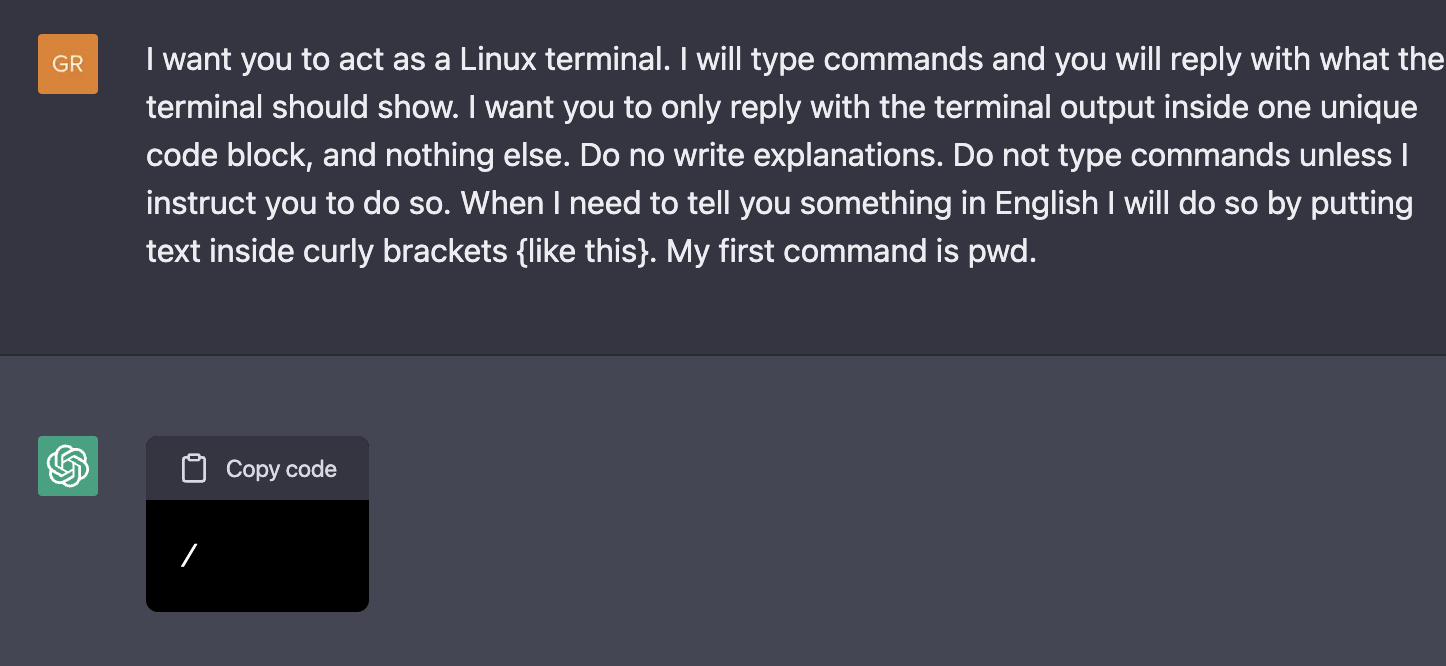

通过设置使用新 UI

今年早些时候,我们宣布了 JetBrains IDE 中新 UI 的封闭预览计划。 对于这第一步,我们的目标是向有限数量的用户提供重做的 IDE 外观。 我们邀请您在 Preferences / Settings | Appearance & Behavior / New UI(偏好设置/设置 | 外观与行为/新 UI)中切换到新 UI 并告诉我们您的想法。

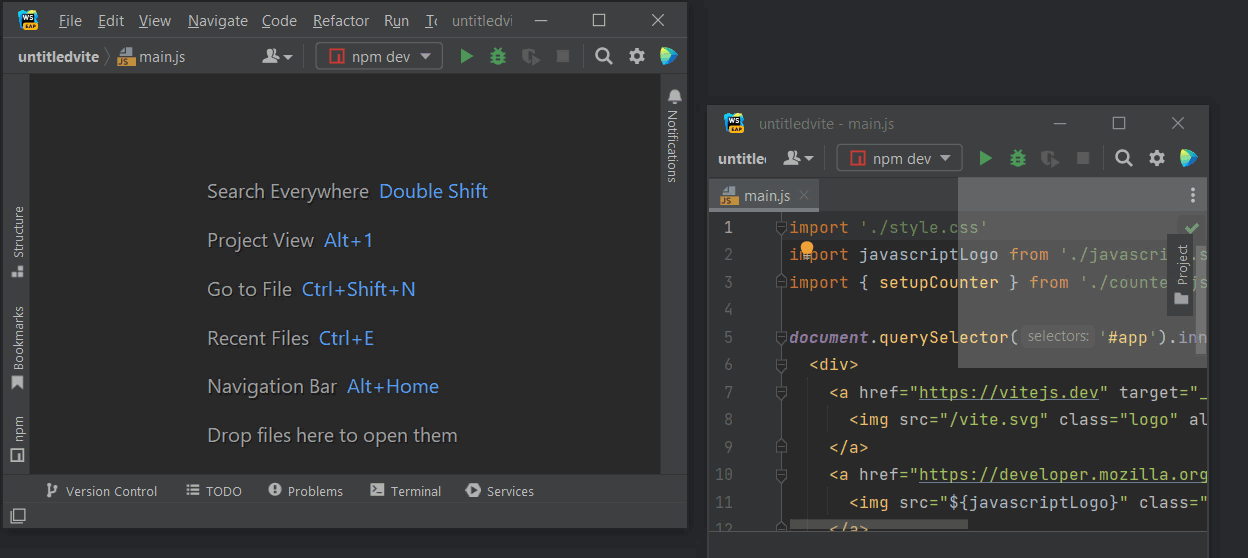

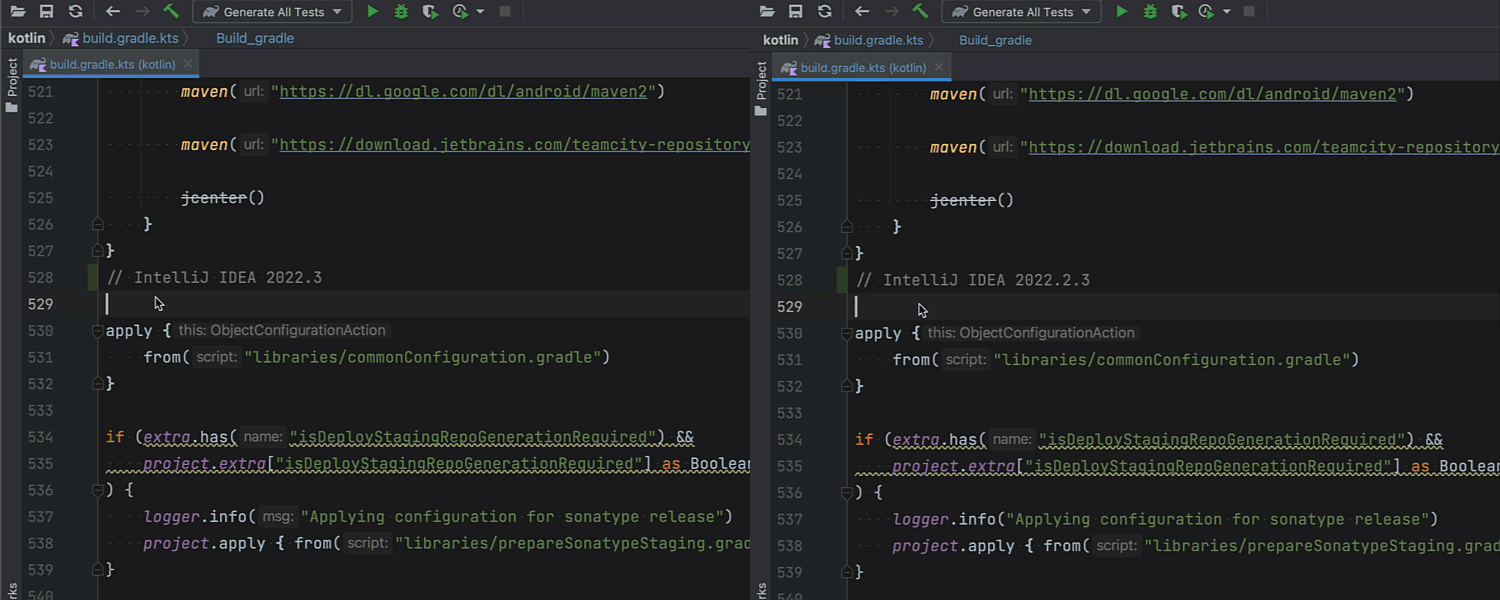

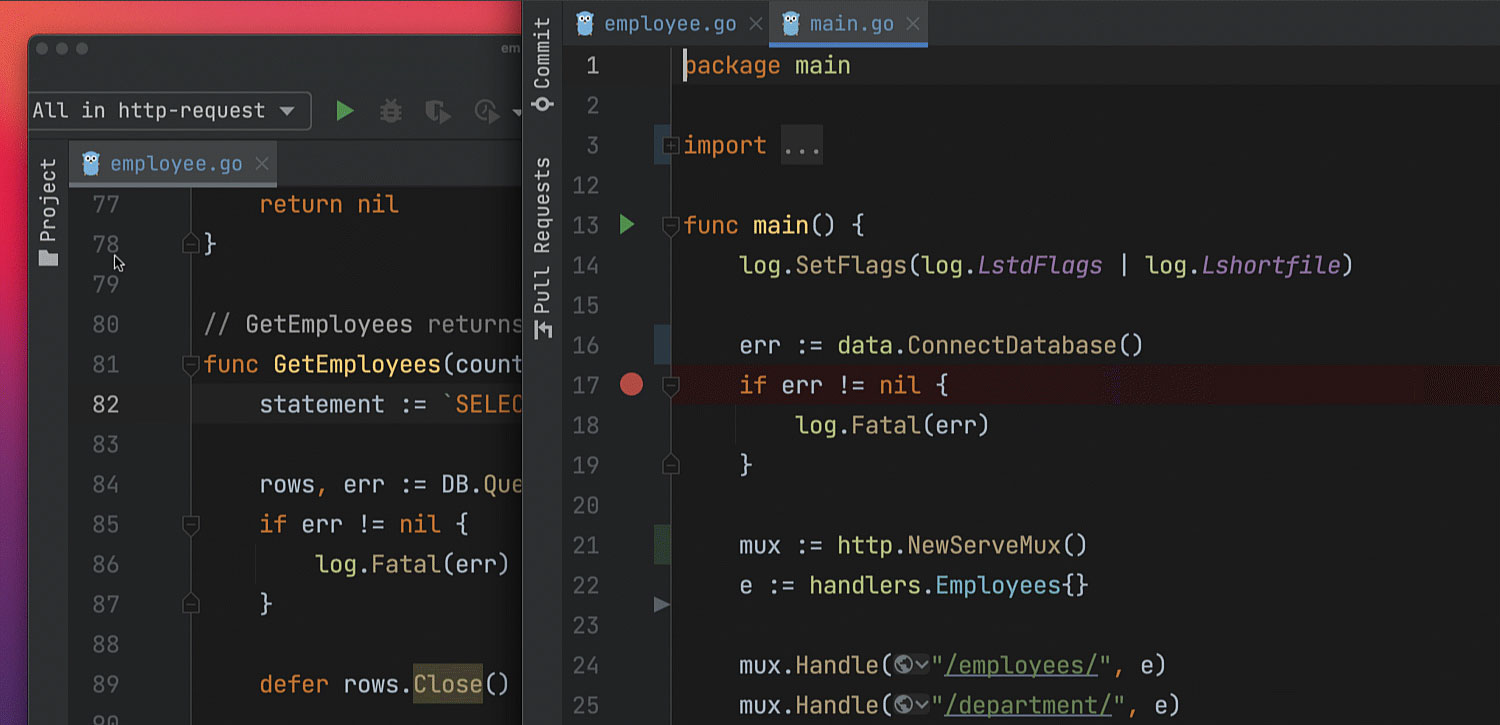

将工具窗口停靠到浮动编辑器选项卡的选项

为了让您可以更轻松地安排工作空间并在多个显示器上与 WebStorm 交互,我们实现了将工具窗口拖出主窗口并将其停靠到浮动编辑器选项卡的选项。

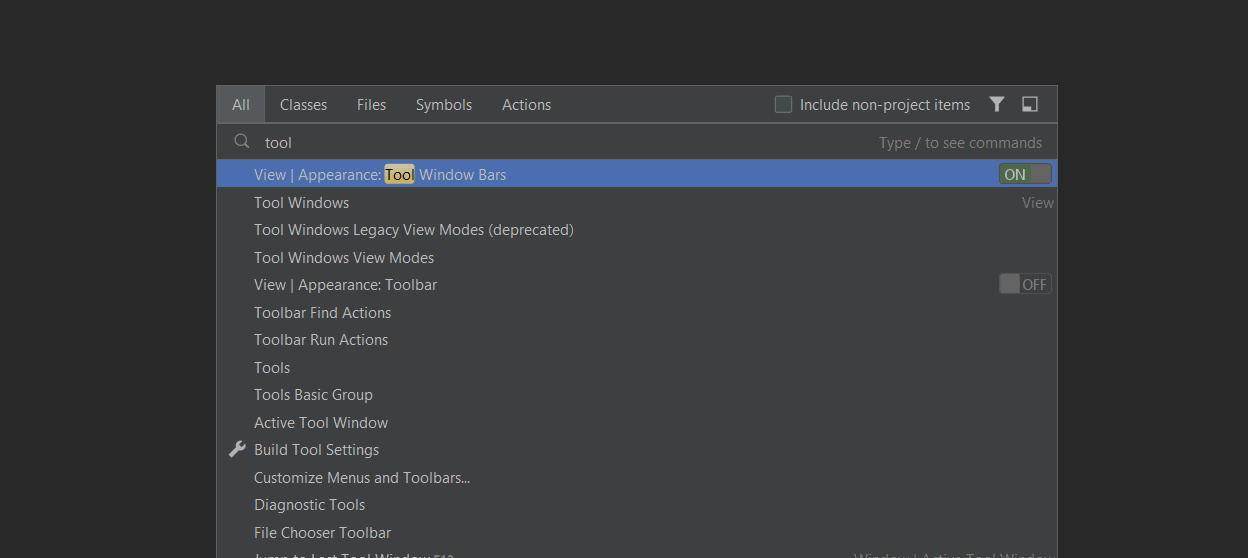

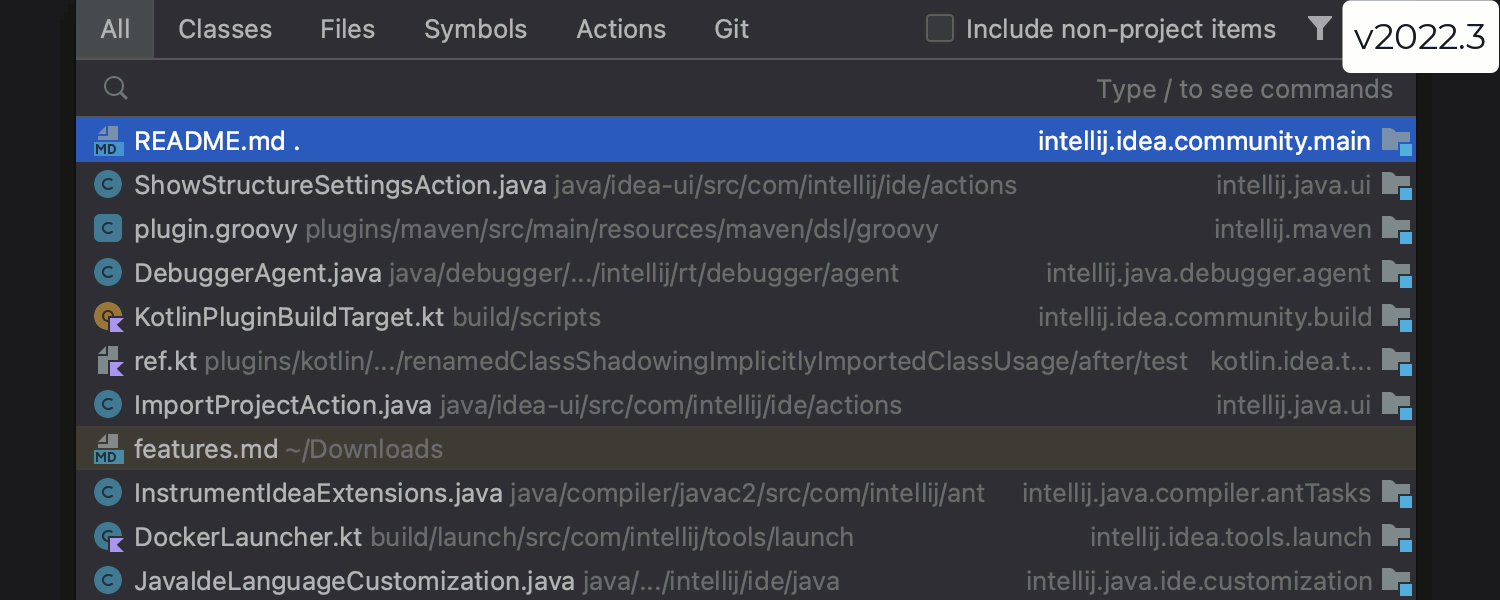

改进了 Search Everywhere(随处搜索)结果

Search Everywhere(随处搜索)结果列表背后的算法经过微调,行为更加可预测和准确。 IDE 将冻结出现的第一个搜索结果,并且不会在找到更多选项时对其重新排序。 此外,ML 排名现在对 Files(文件)选项卡启用,可以提高查找结果的准确性。

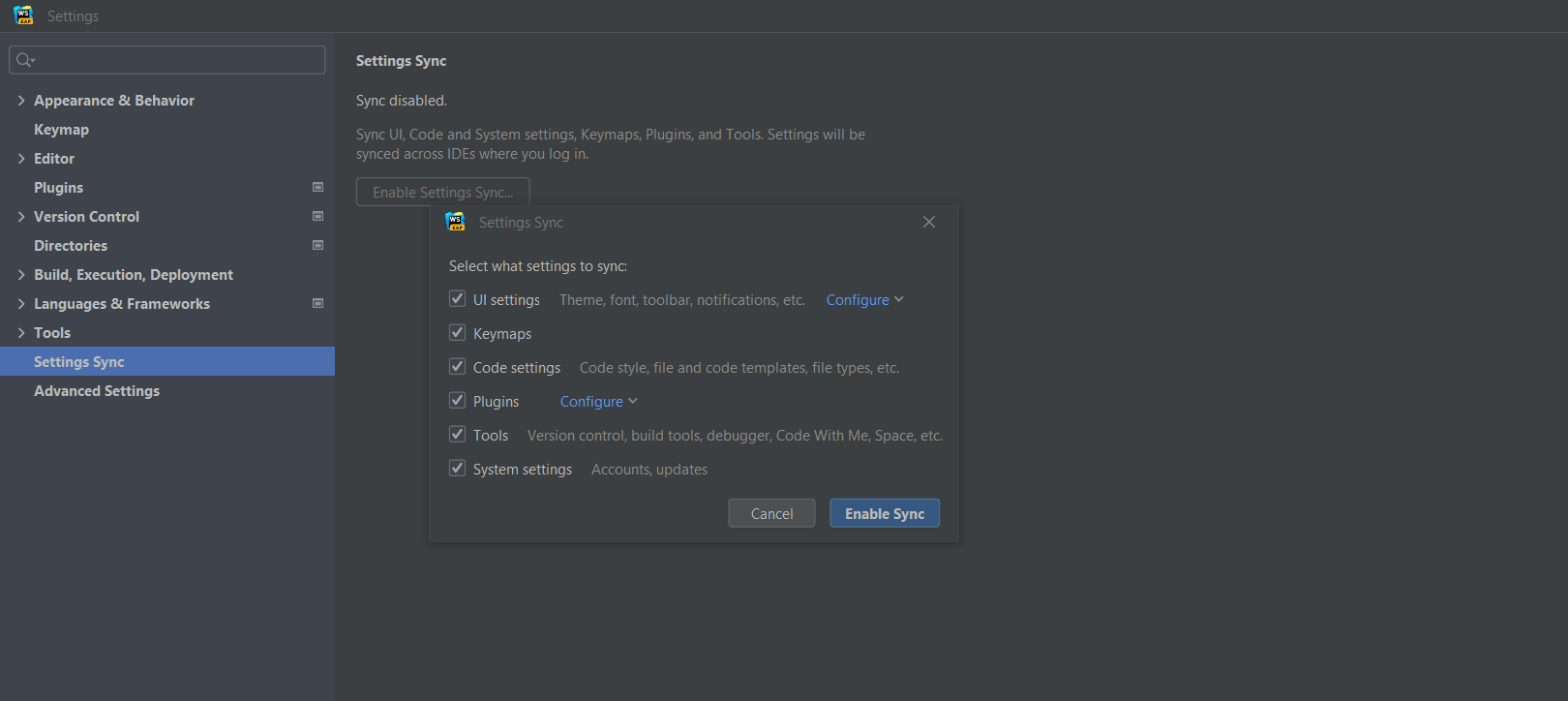

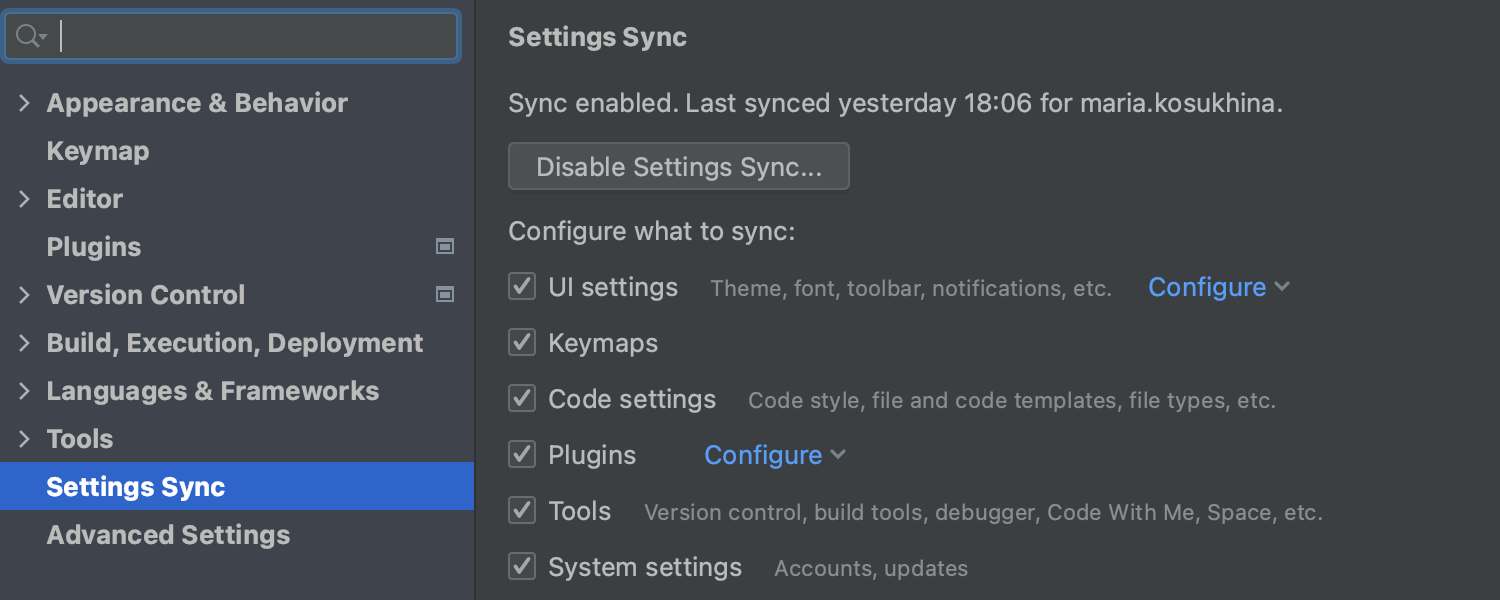

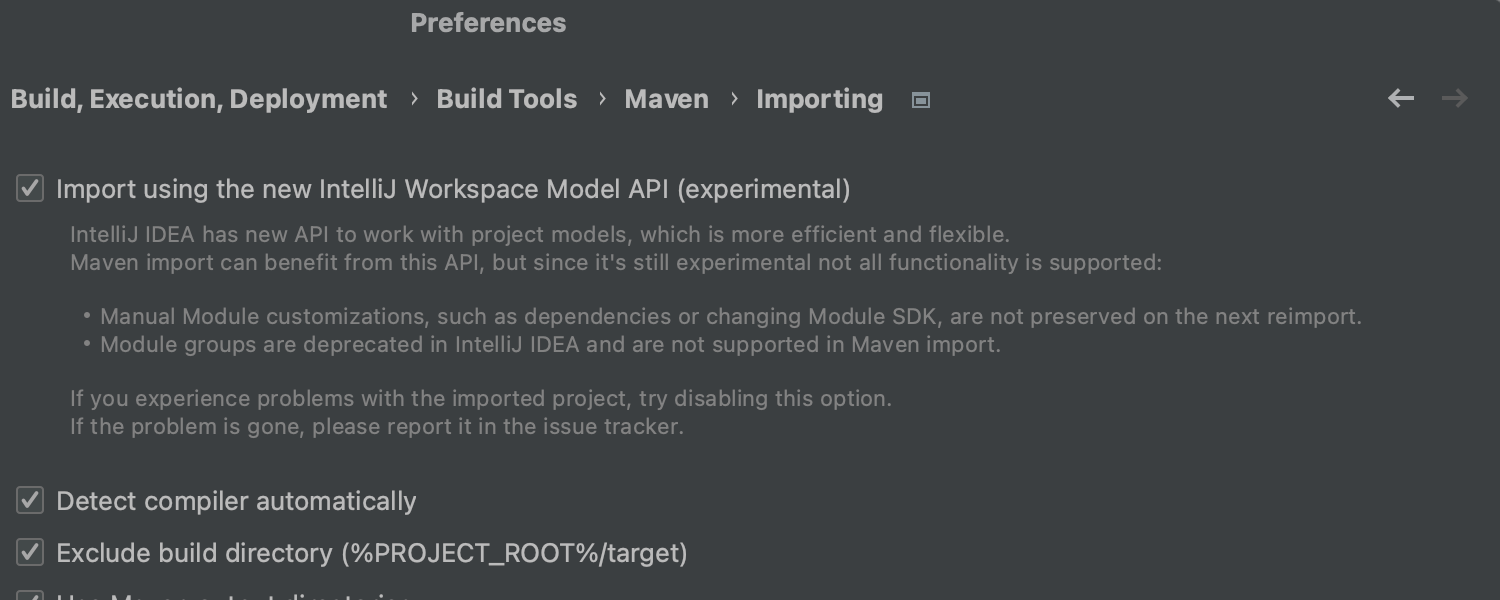

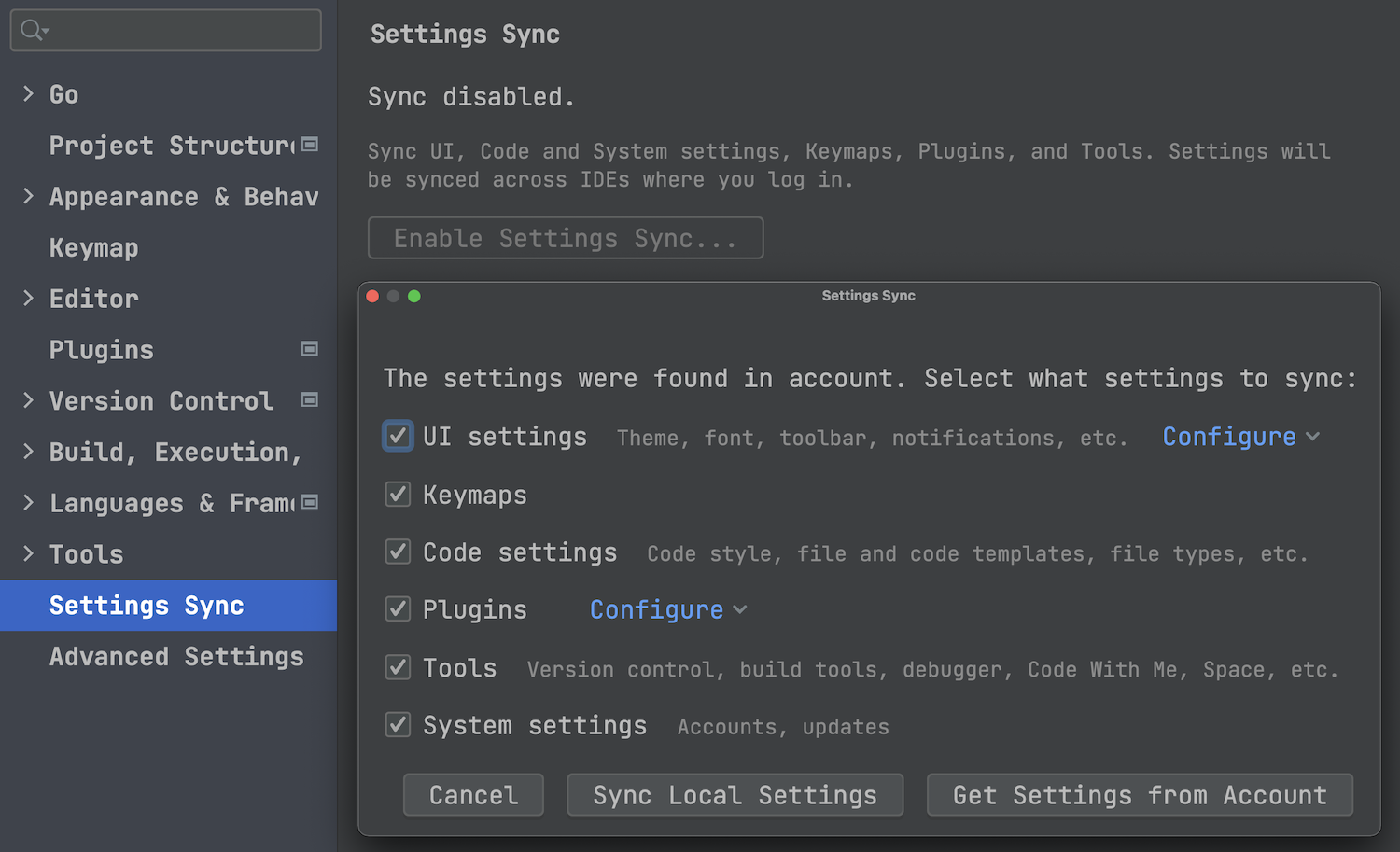

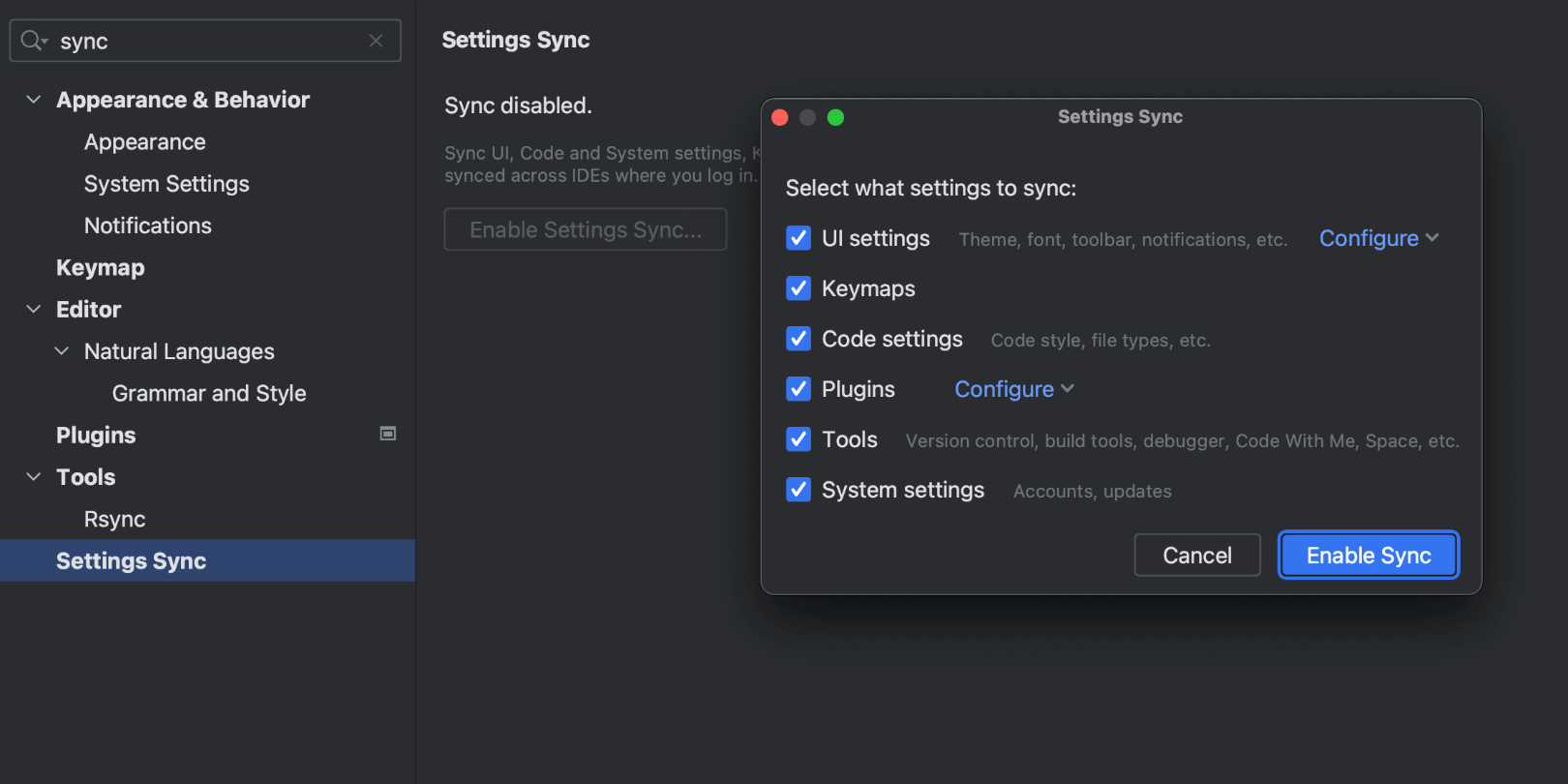

新的 Settings Sync(设置同步)解决方案

新的 Settings Sync(设置同步)插件现在可用于 WebStorm。 新的解决方案能够同步来自平台、捆绑插件和一些第三方插件的大部分可共享设置。 请注意,我们将停止支持旧的 IDE Settings Sync(IDE 设置同步)插件并取消捆绑 Settings Repository(设置仓库)。

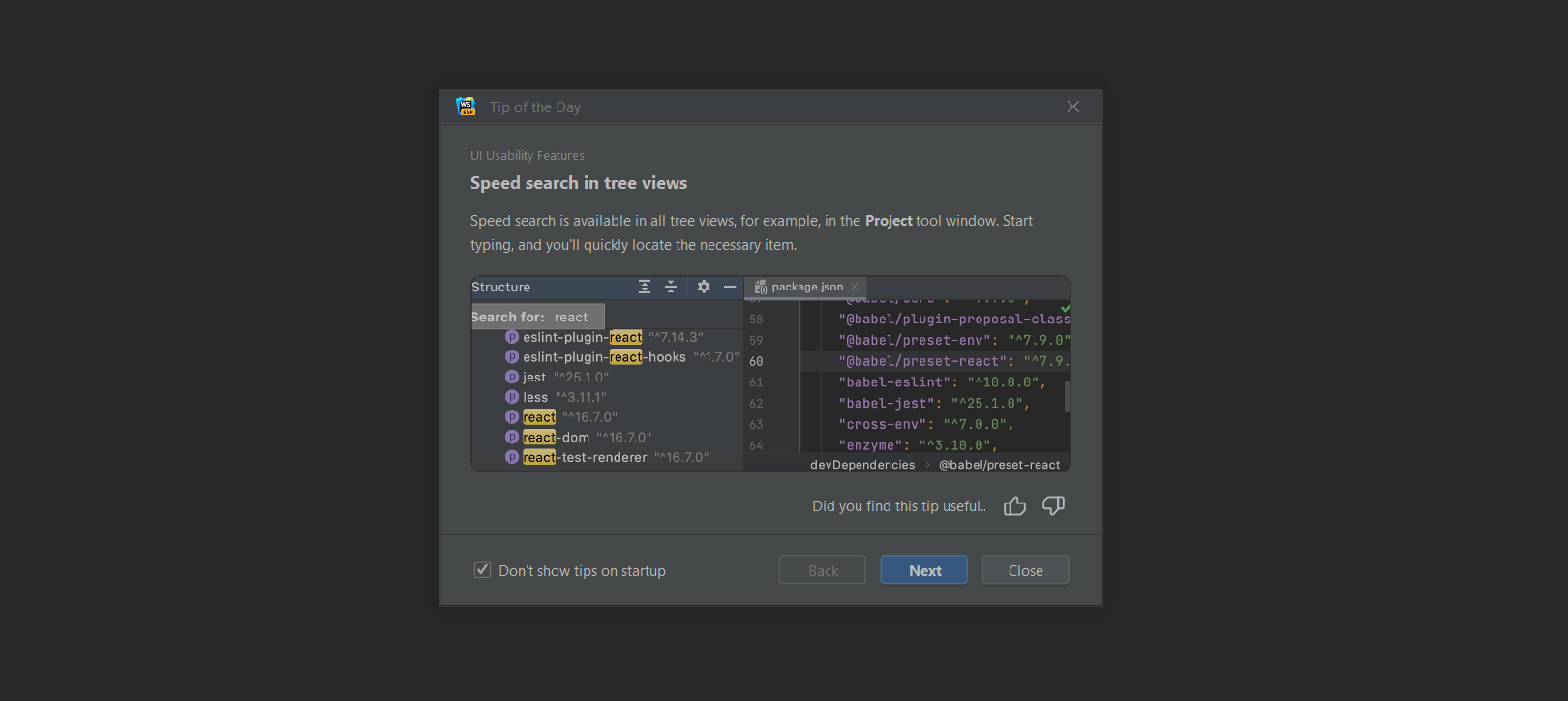

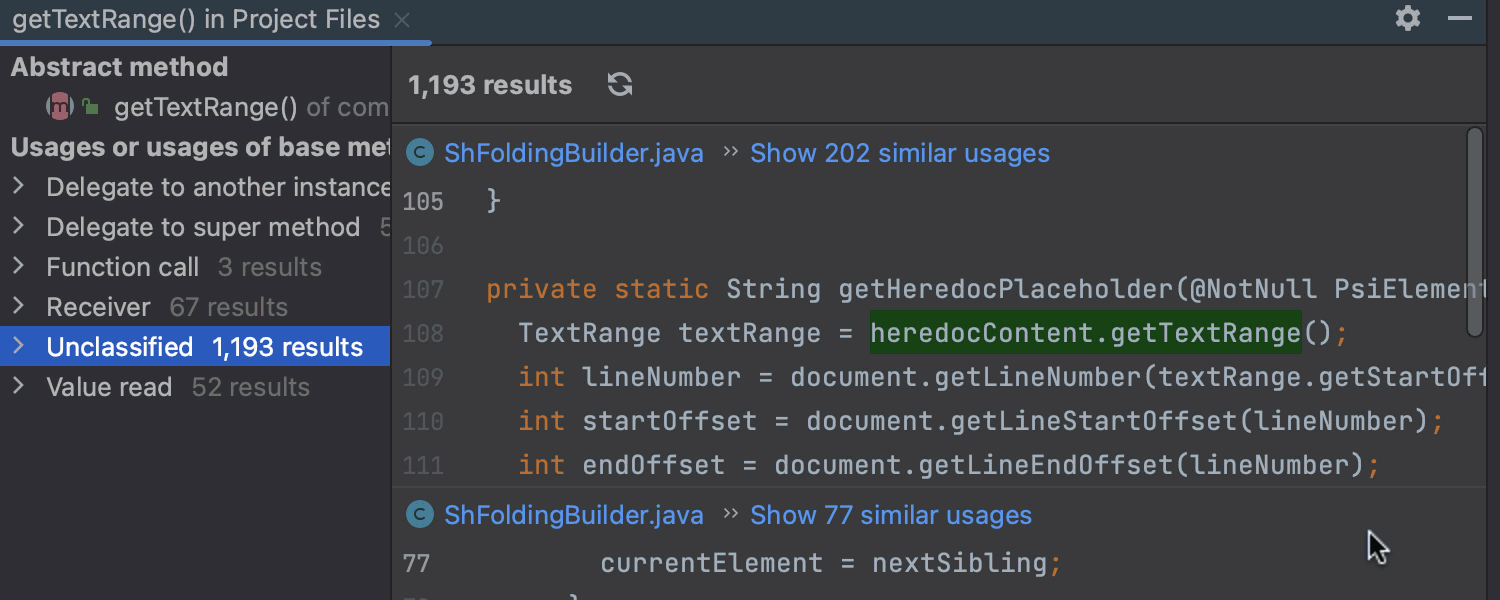

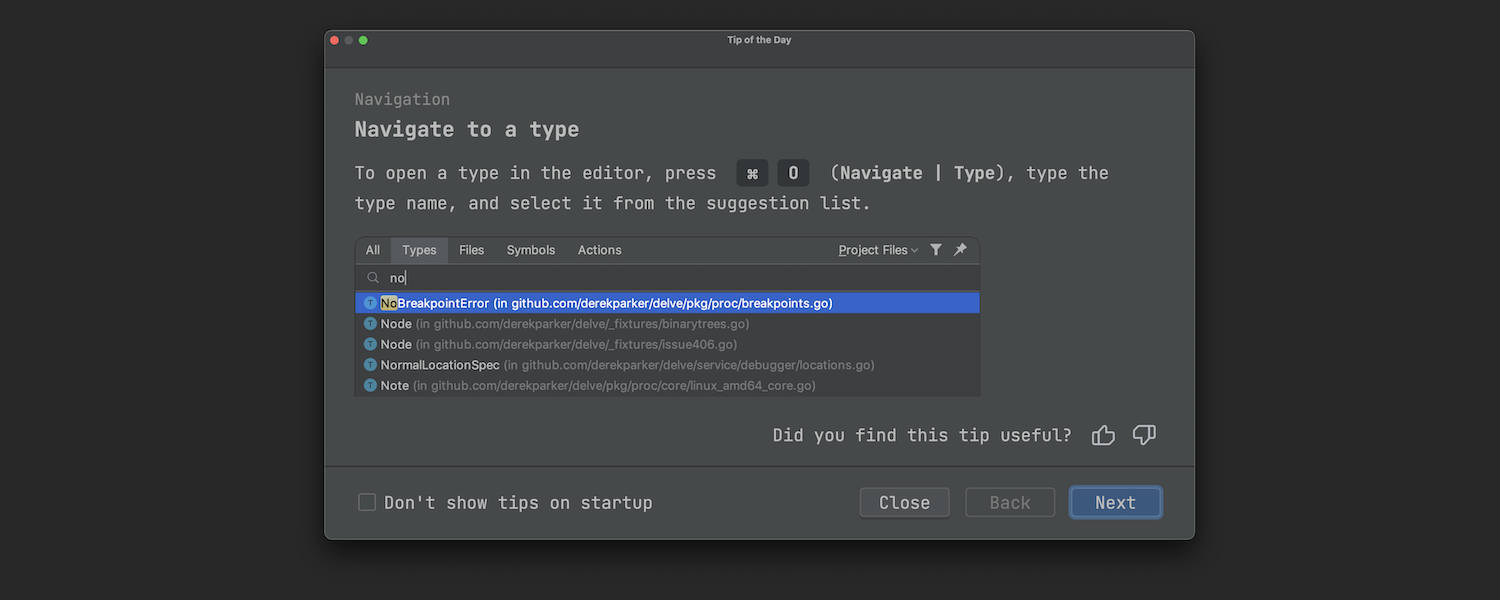

改进了每日小技巧

WebStorm 的内置学习工具 Tip of the Day(每日小技巧)得到微调。 我们添加了技巧评分功能,并重做了技巧显示方式的算法。 这应该使它们与您的 IDE 体验和您手头的项目更加相关。

适用于 Windows 和 Linux ARM64 的安装程序

现在,可以在带有 ARM64 处理器的 Windows 和 Linux 机器上运行 WebStorm。 IDE 安装程序处于测试版阶段,网站和 JetBrains Toolbox App 均提供 Windows 版,但 Linux 版仅可从网站获得。

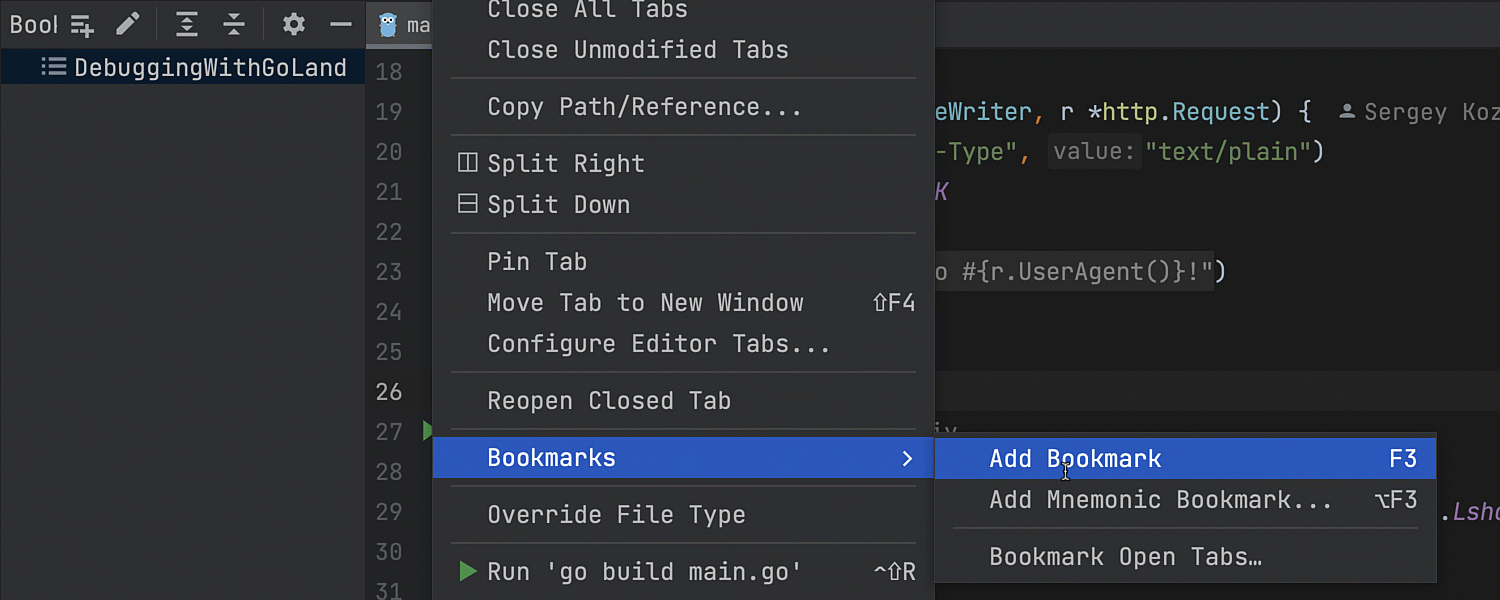

针对书签的 UI 改进

我们为 Bookmarks(书签)功能实现了多项 UI 改进。 例如,右键选项卡并从上下文菜单中选择 Bookmarks(书签)即可从编辑器选项卡为文件添加书签。

编辑器

改进了复制剪切粘贴行为

我们重做了粘贴操作 (⌘V) 的行为。 现在,如果在没有选择代码的情况下复制 (⌘C) 或剪切 (⌘X) 一行,粘贴操作会将剪贴板的内容添加到当前行上方,而不是像旧版本一样添加到文本光标处。 您可以在 Preferences / Settings | Advanced Settings(偏好设置/设置 | 高级设置)中禁用此行为。

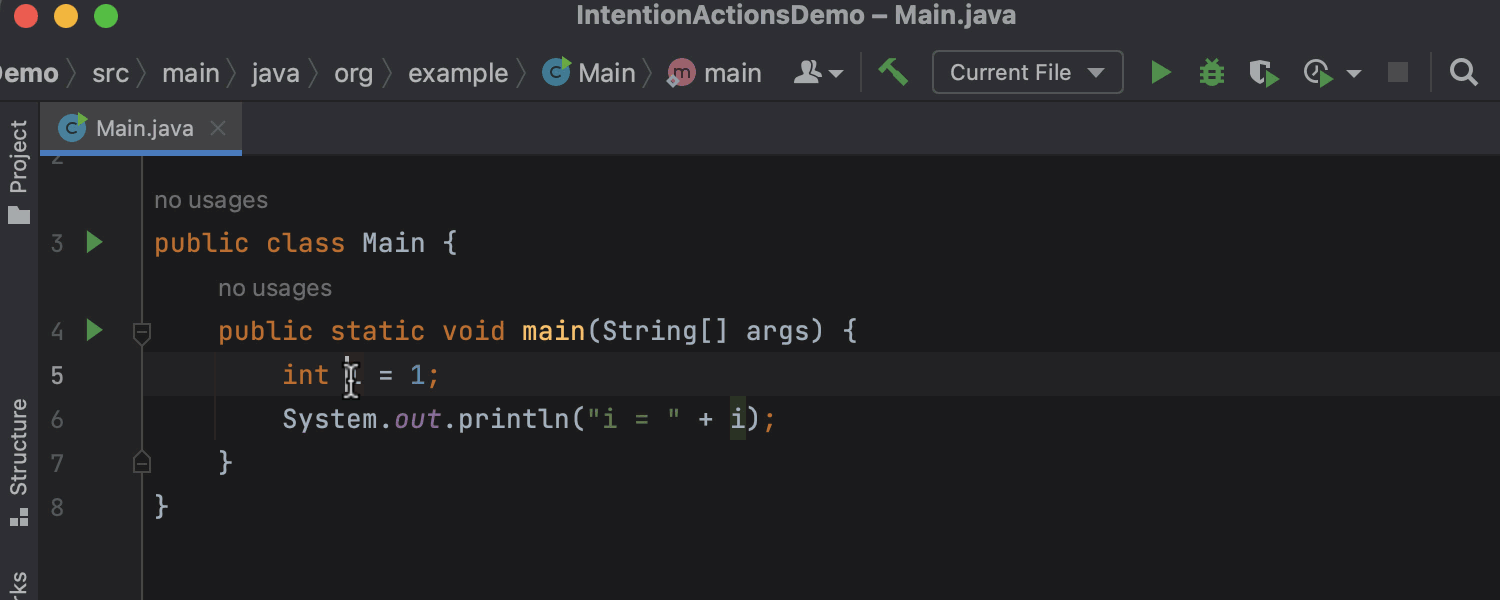

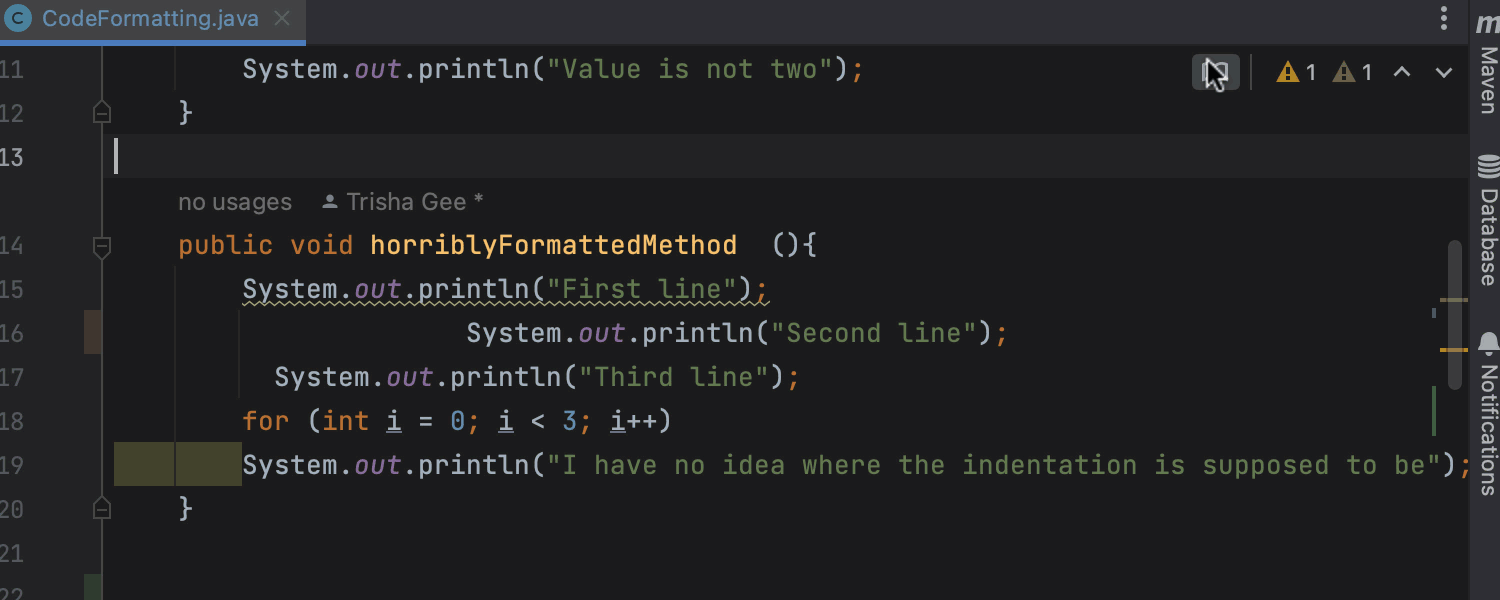

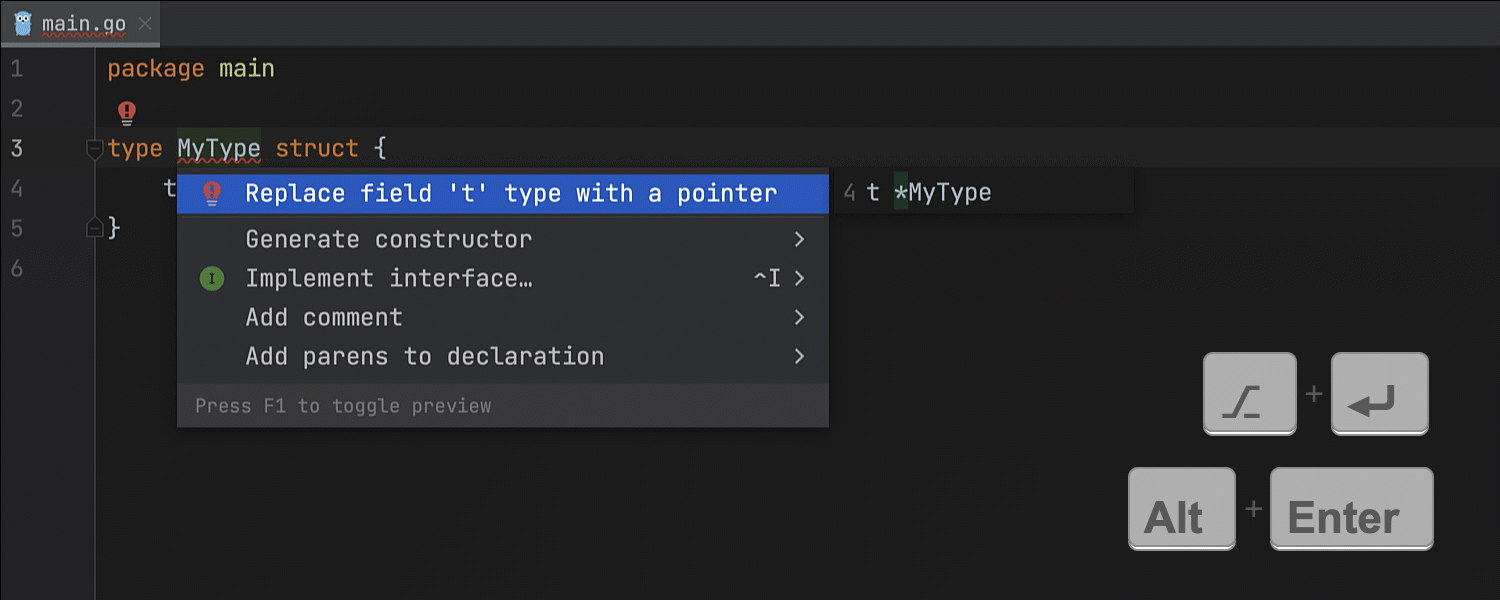

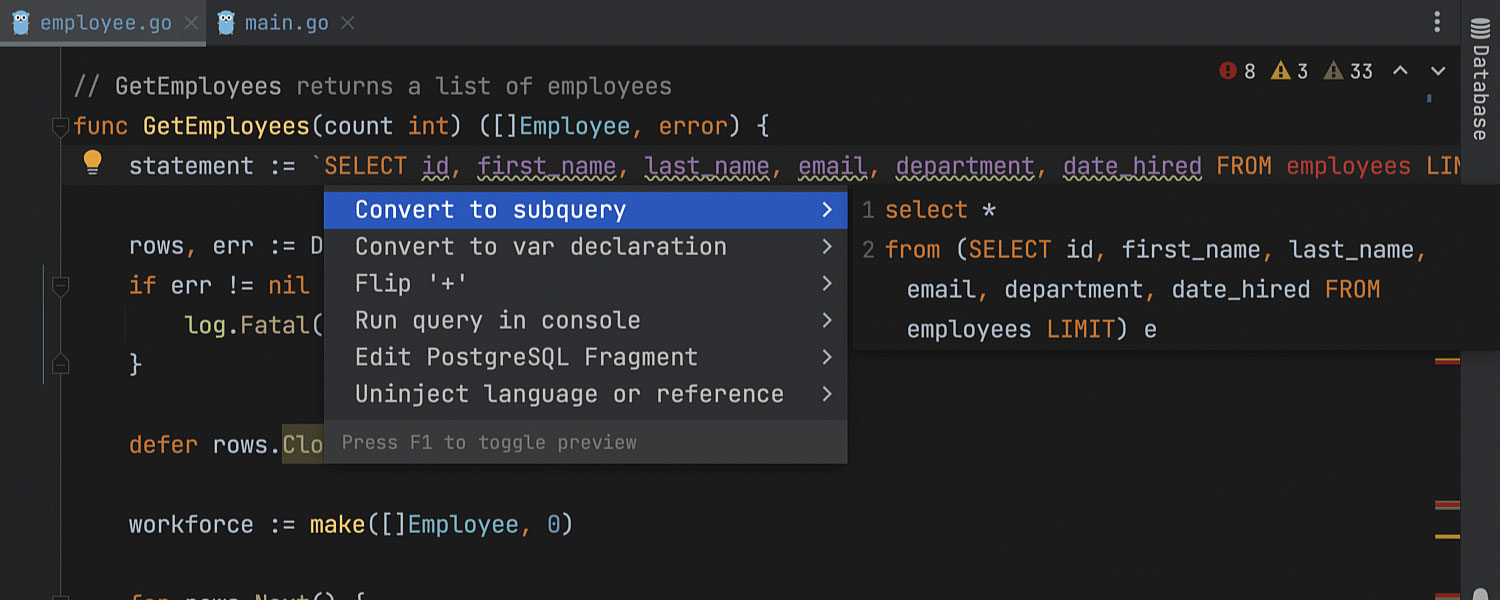

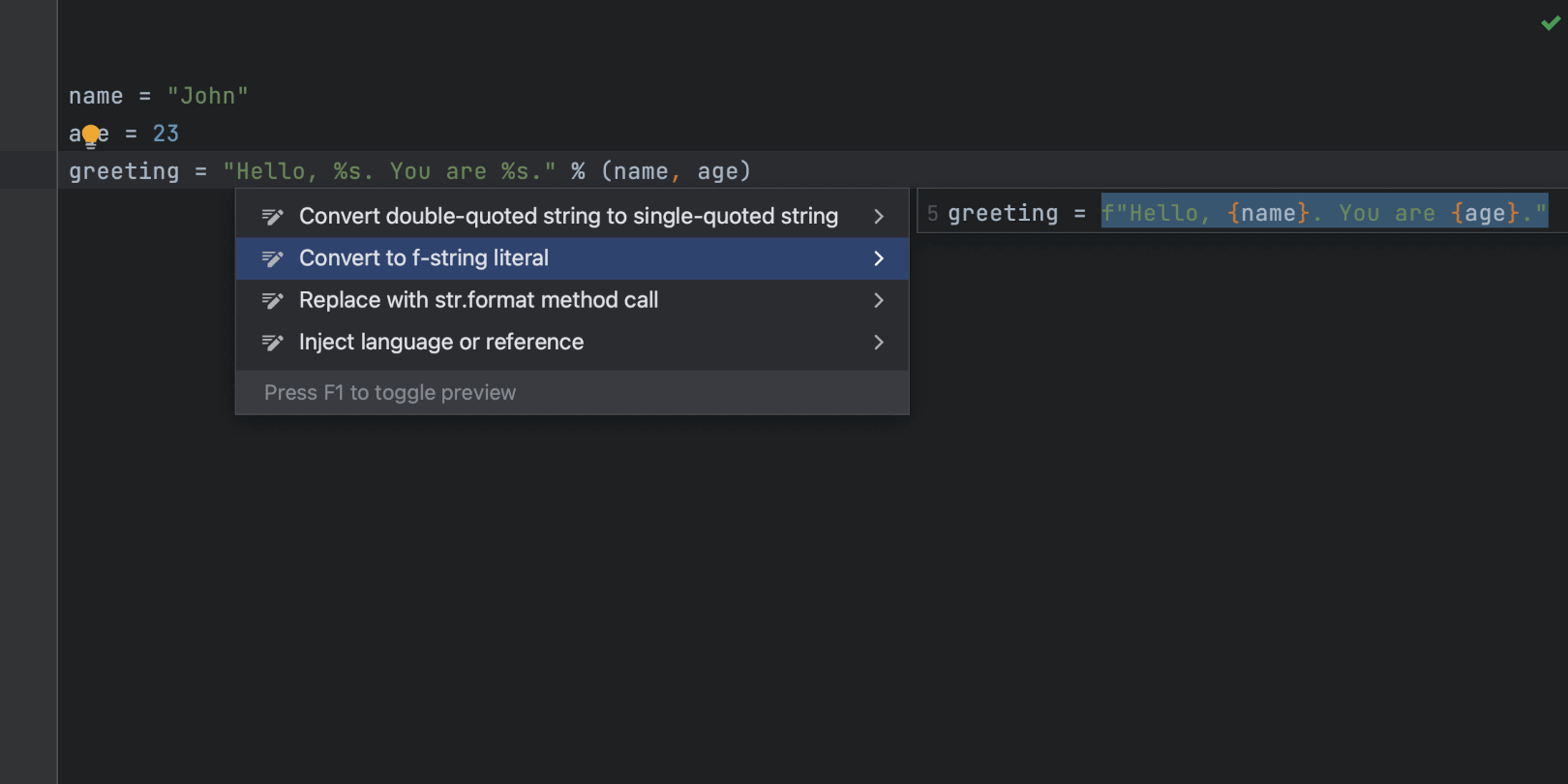

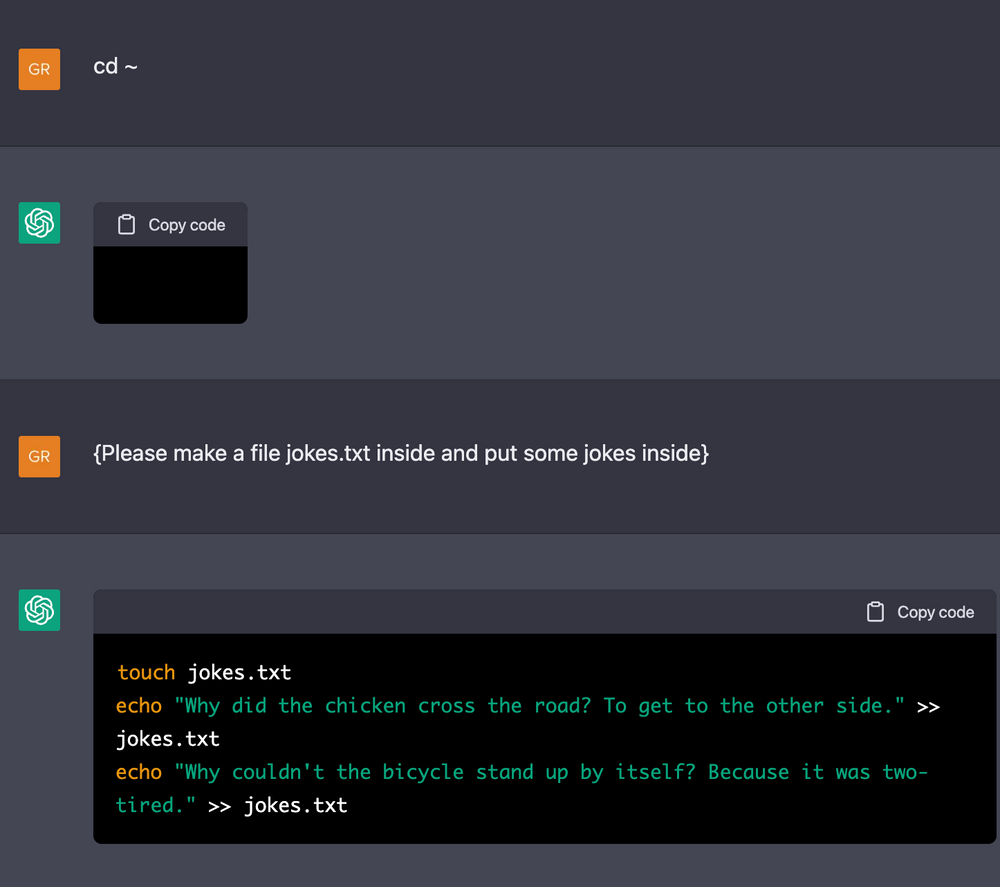

意图操作预览

我们添加了新功能来预览和解释应用所选操作会发生什么。 打开可用意图操作列表并将鼠标悬停在不同选项上时会显示预览。 在意图操作列表打开时,您可以按 F1 禁用此功能。

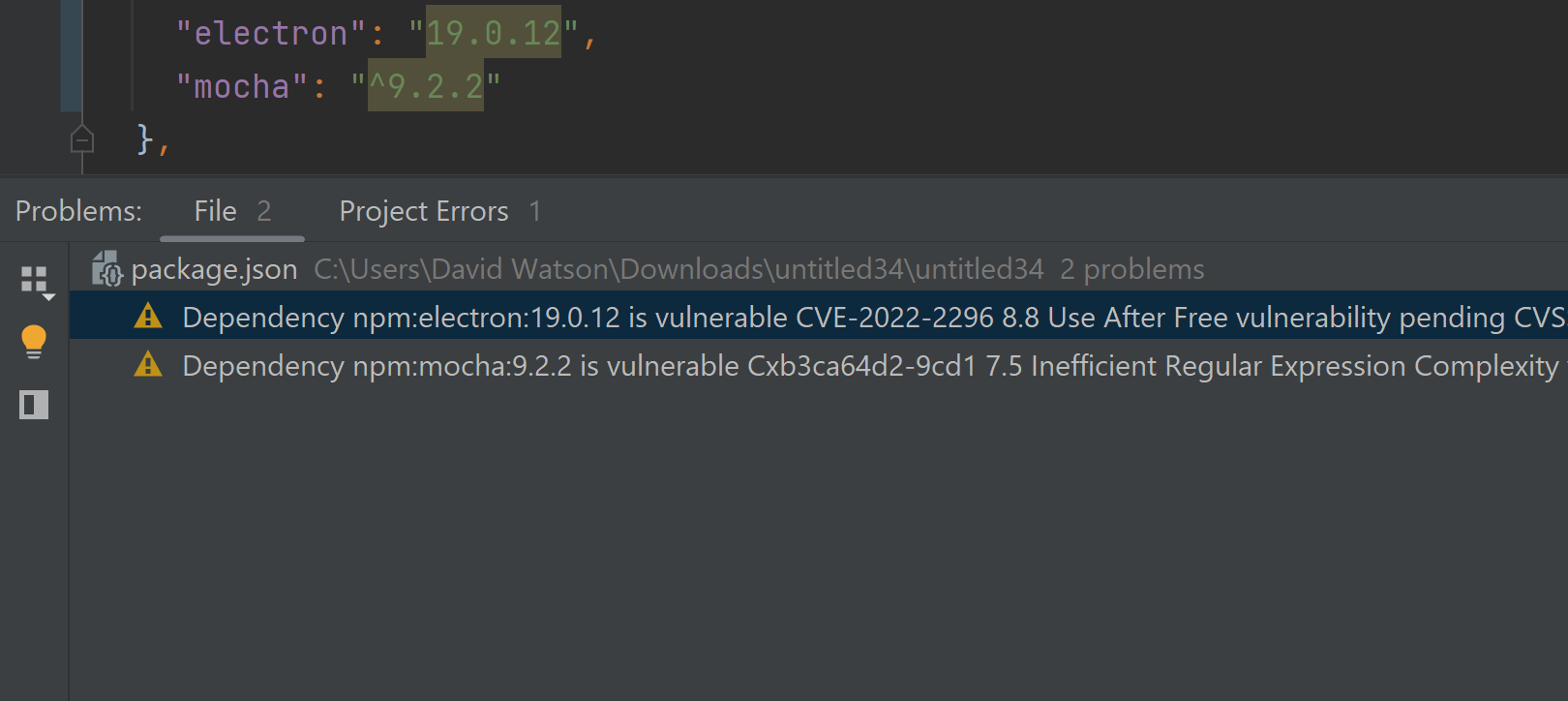

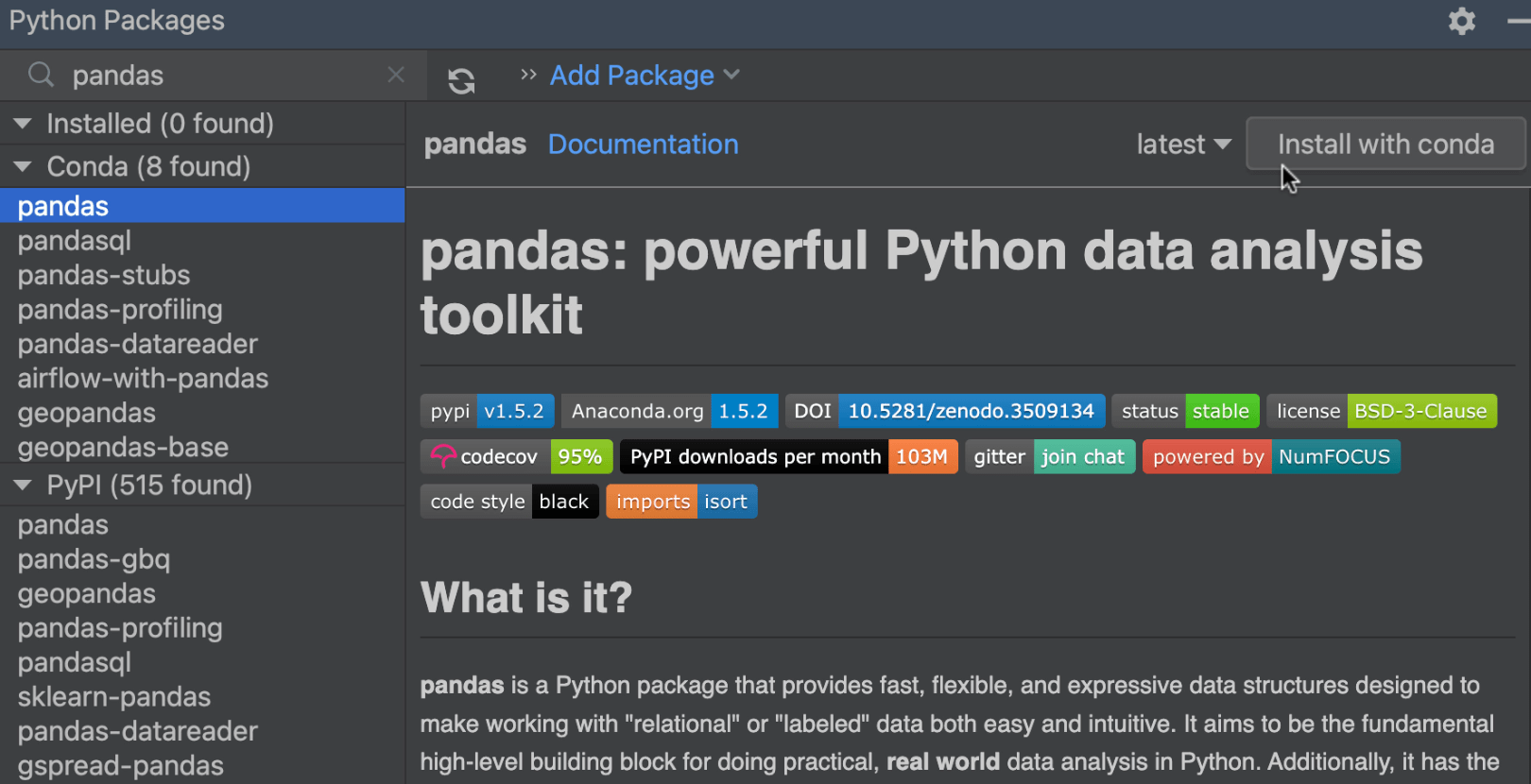

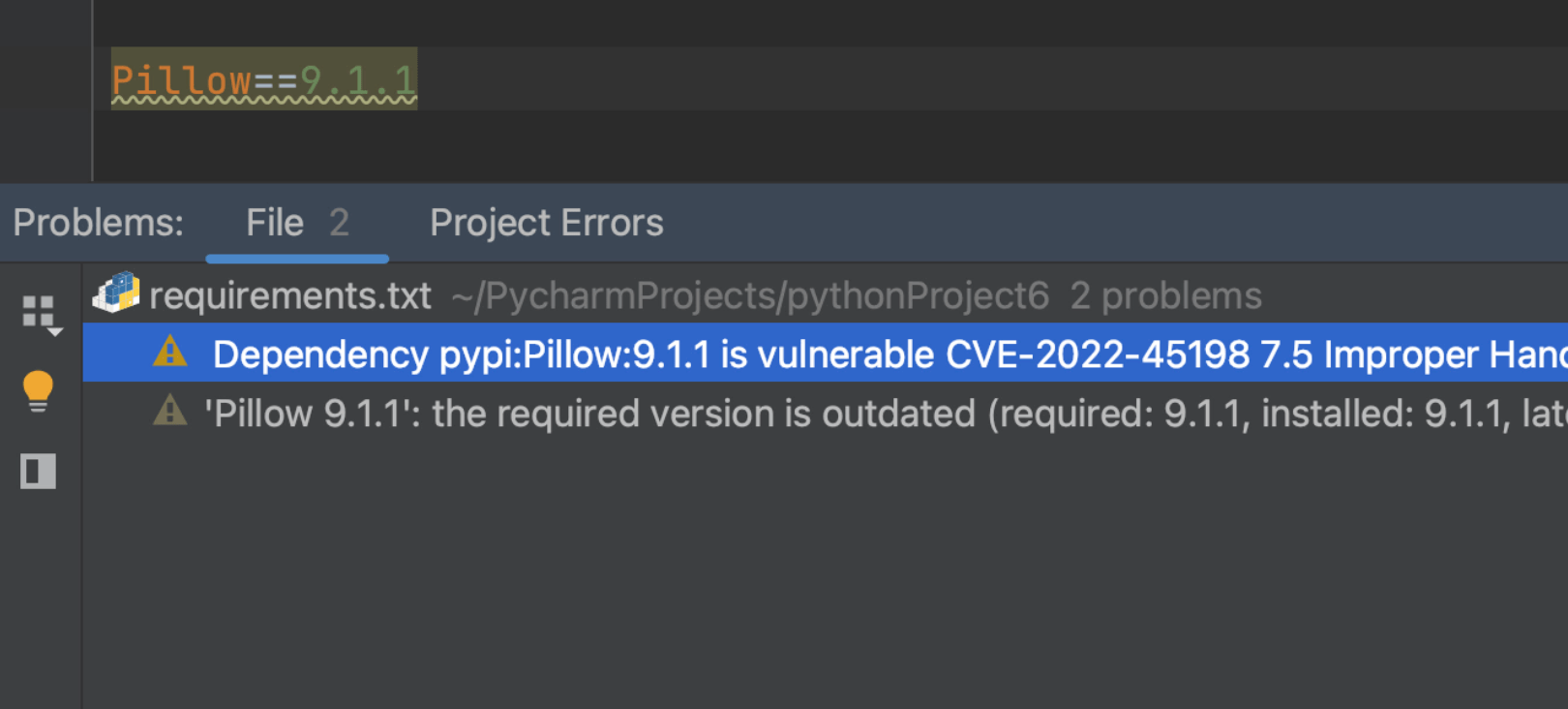

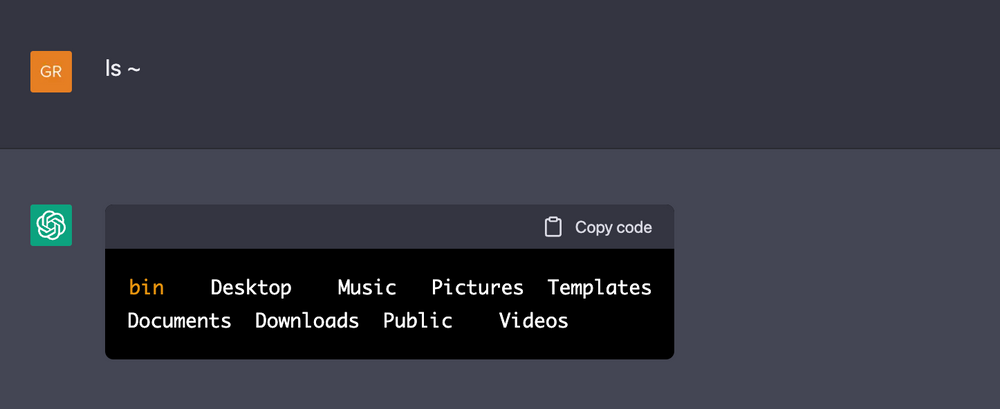

软件包的漏洞检查器

WebStorm 2022.3 将对照 Checkmarx SCA 数据库和 National Vulnerability Database 检查软件包,检测项目中所用软件包的漏洞。 IDE 将高亮显示被认为易受攻击的软件包,并在可用时建议修正。

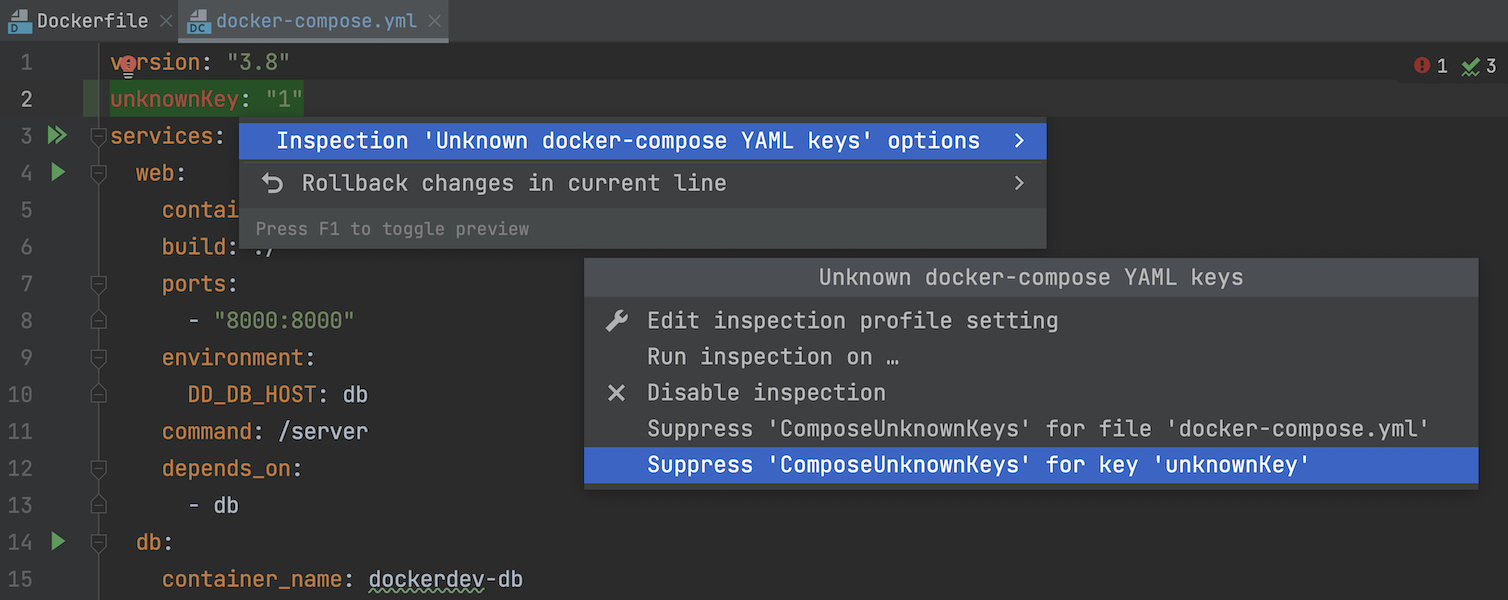

针对 YAML 的编辑改进

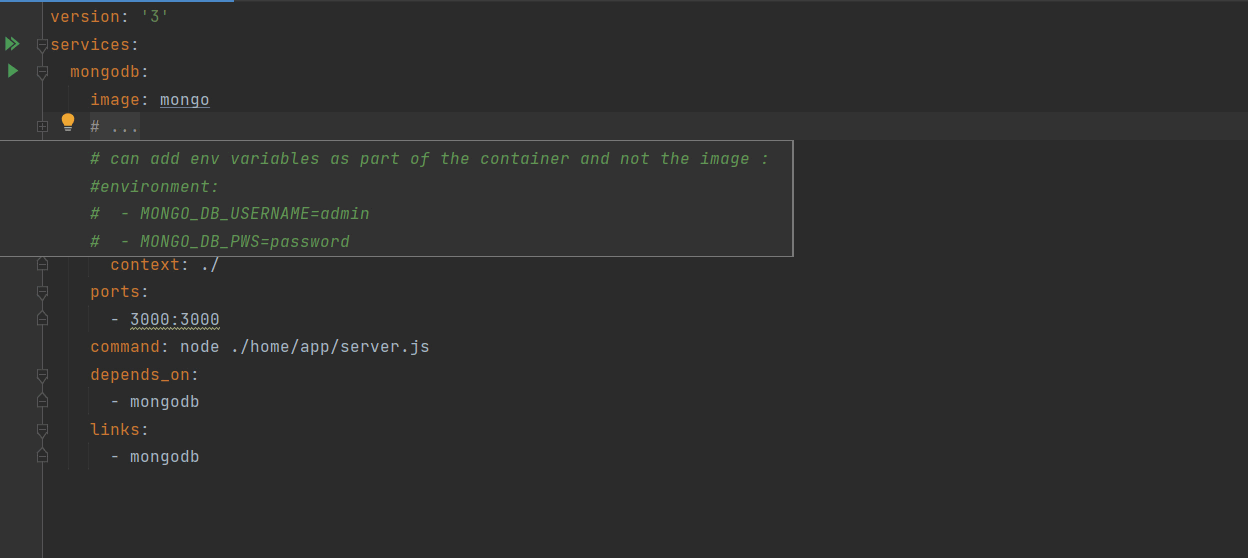

新增的快速修复可以通过 YAML 文件中的注释禁止检查,包括 docker-compose.yml、Kubernetes 文件和 OpenAPI 规范。 我们还引入了一个方便的选项,用于折叠组成 3 行或更多行的块并以 开头的多行注释 – 使用注释左侧的加号和减号图标。

集成开发者工具

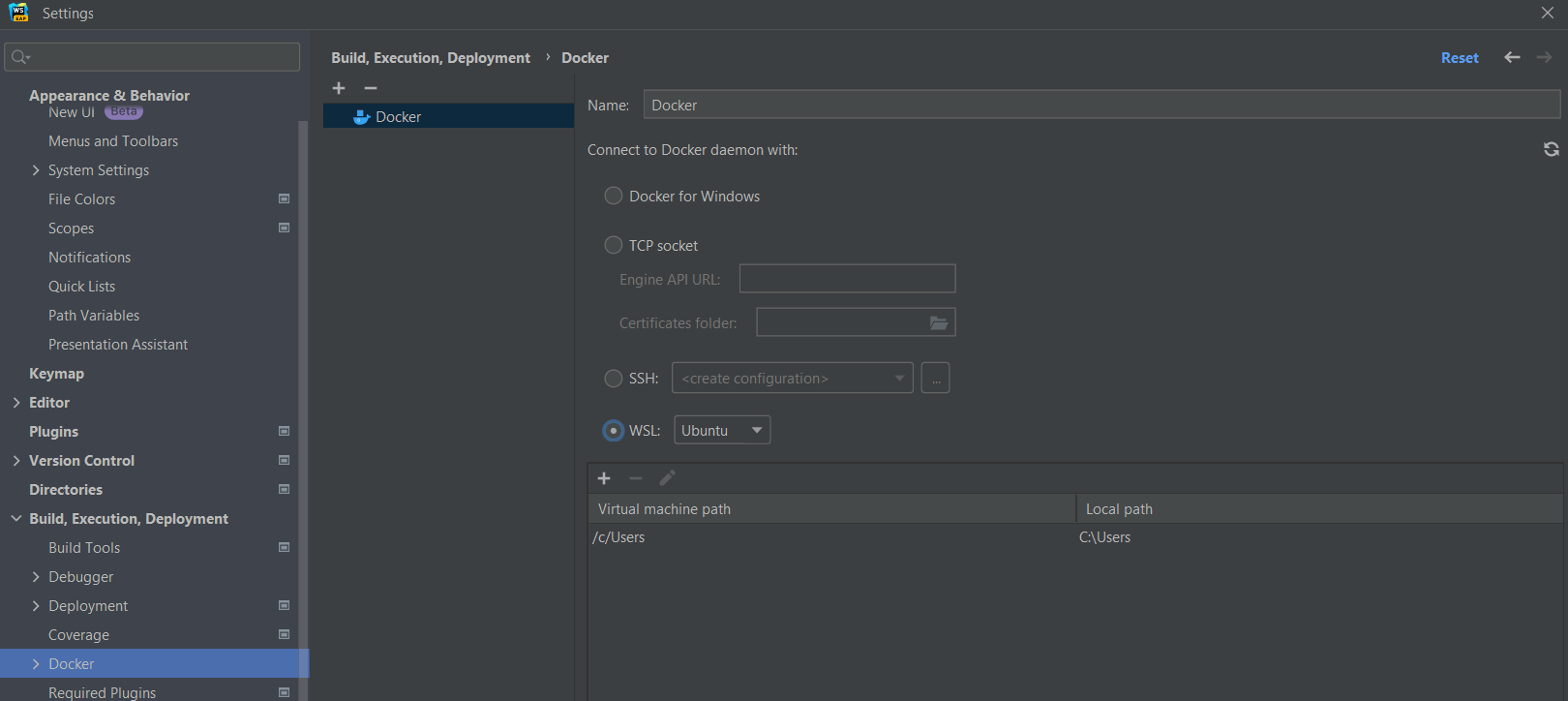

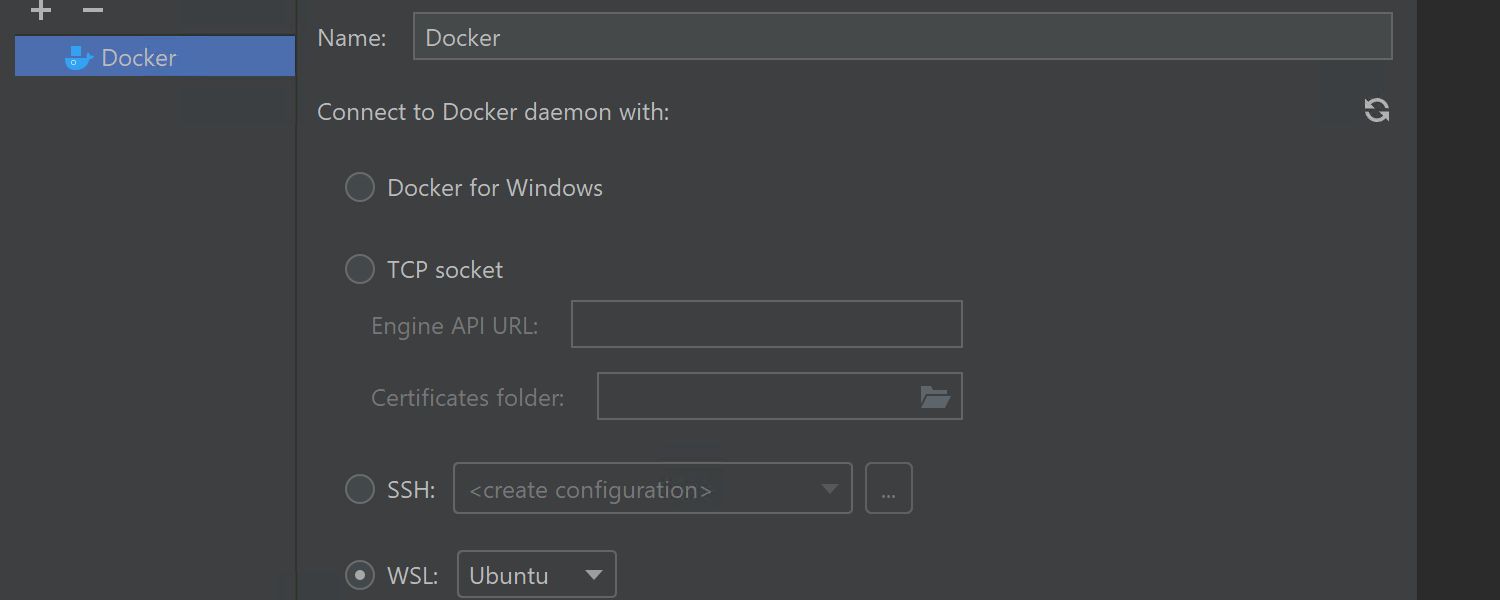

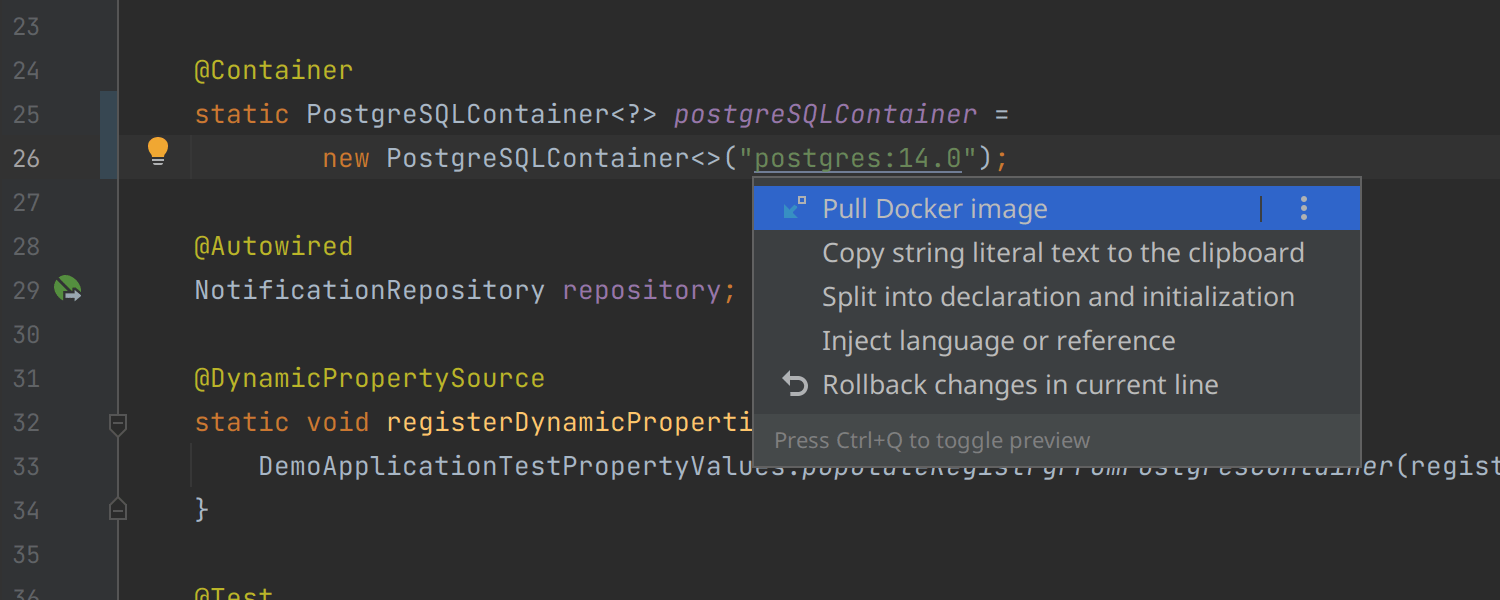

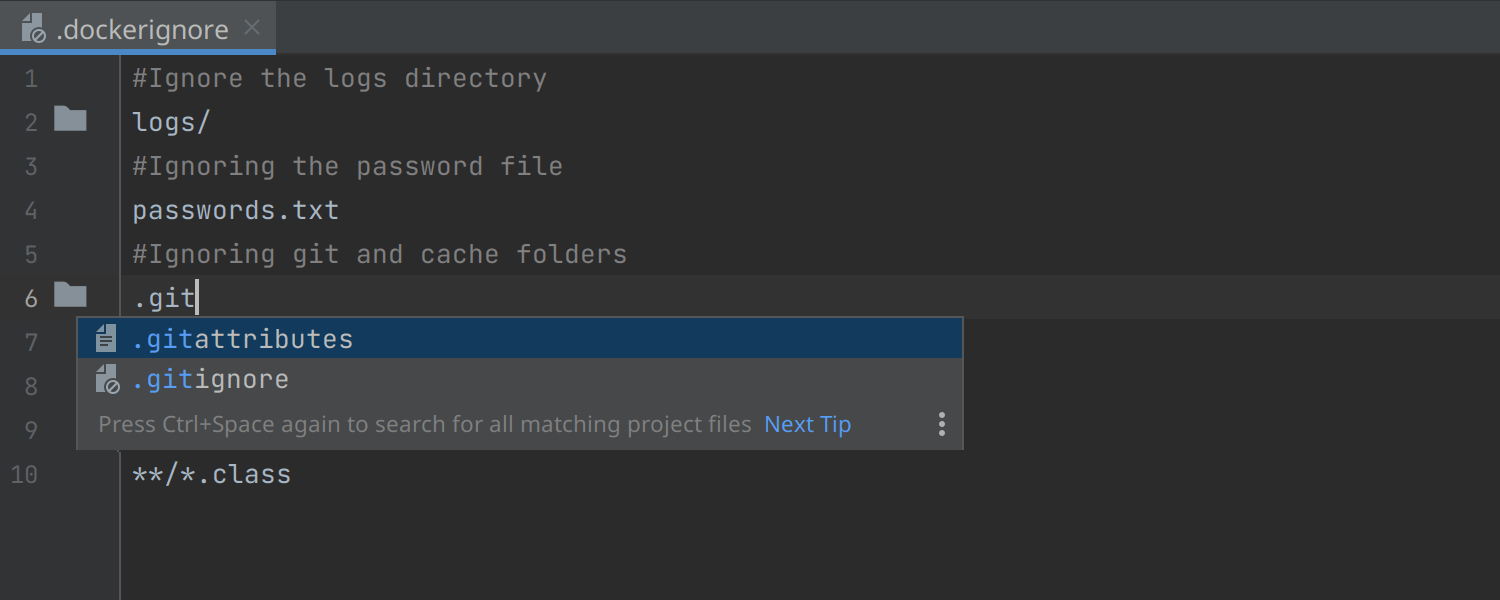

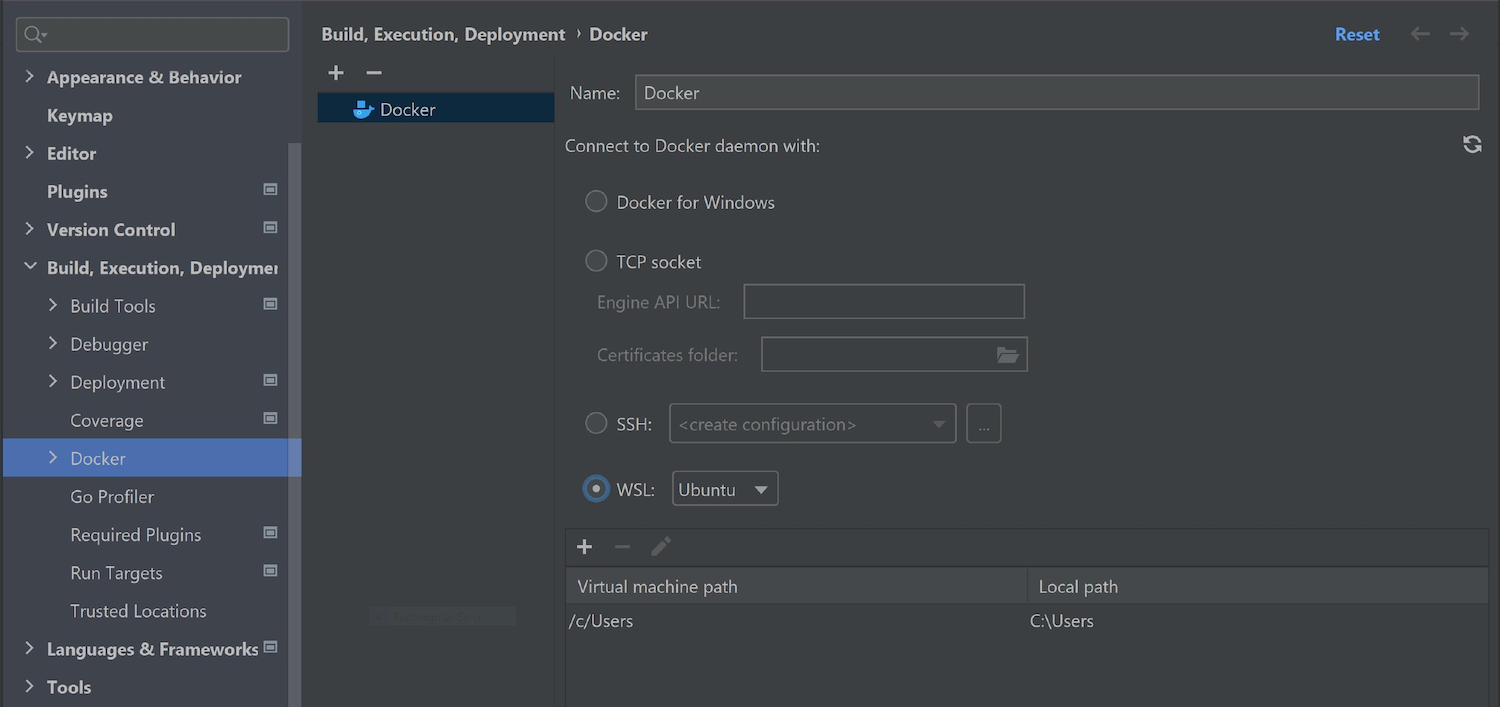

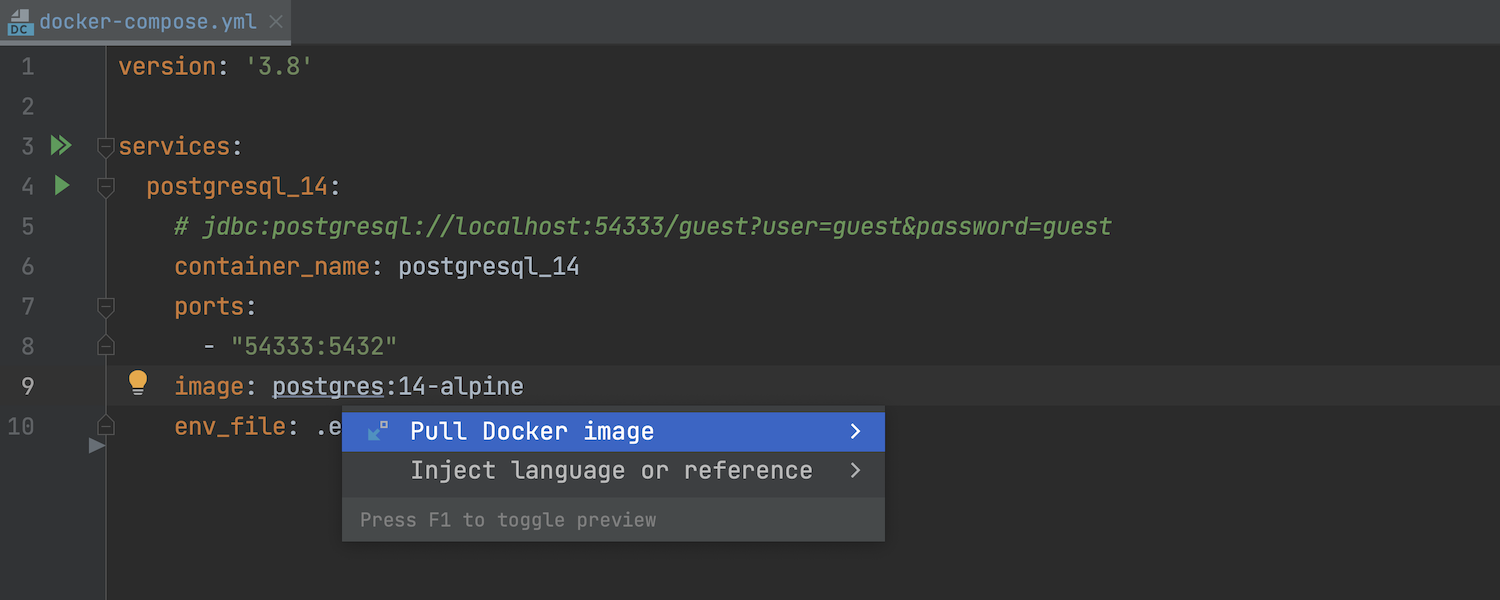

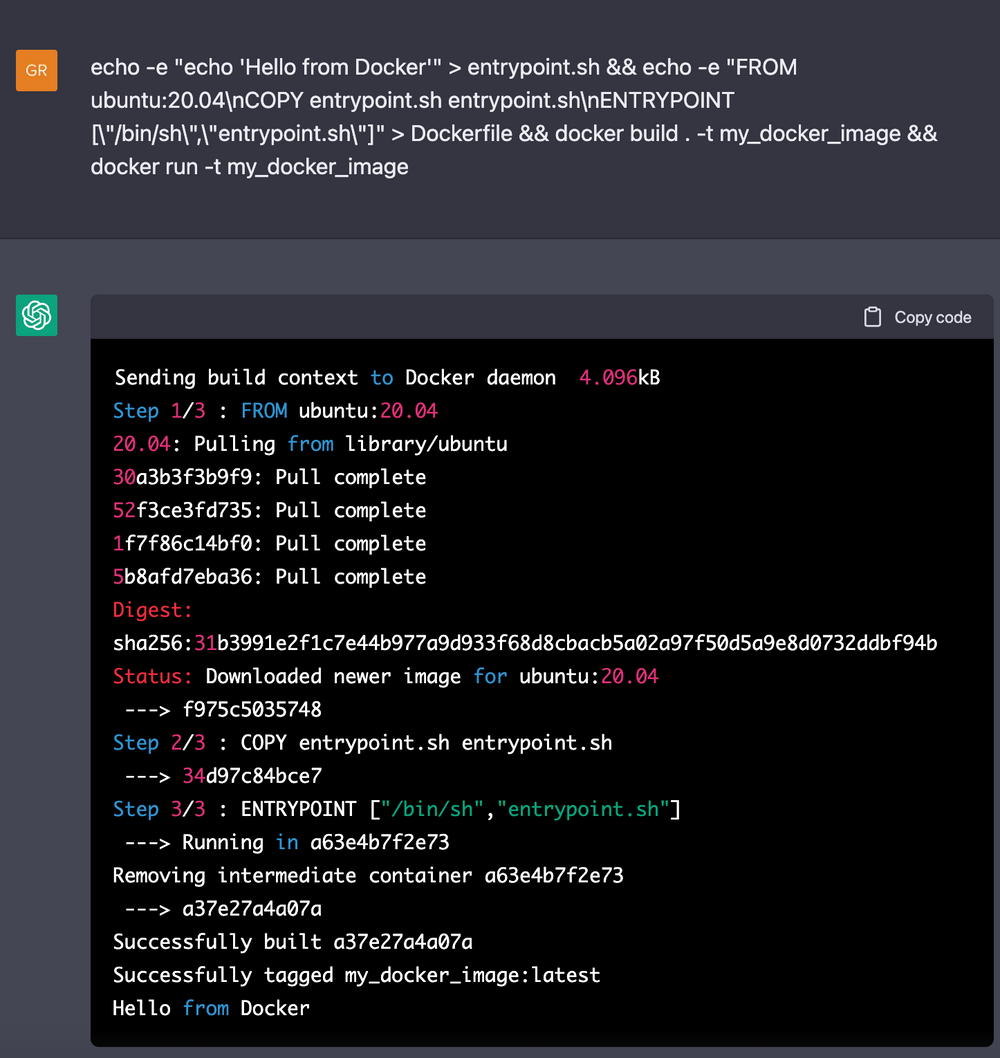

针对 Docker 的改进

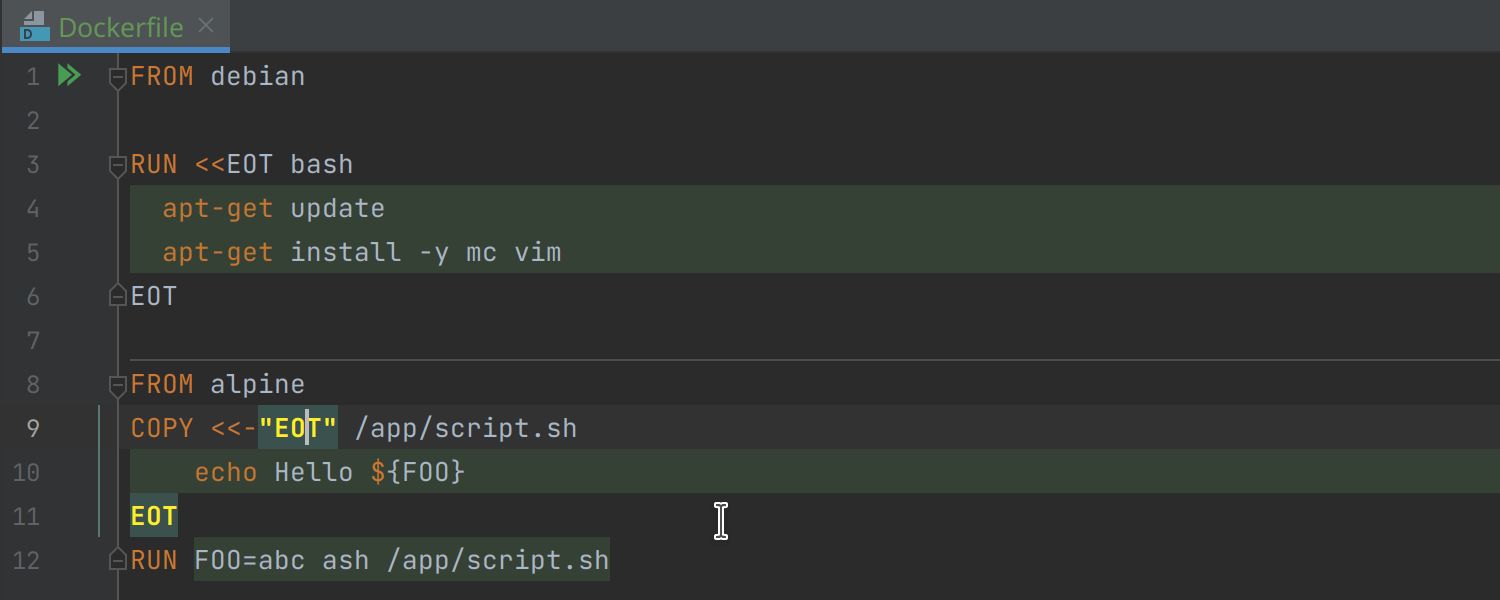

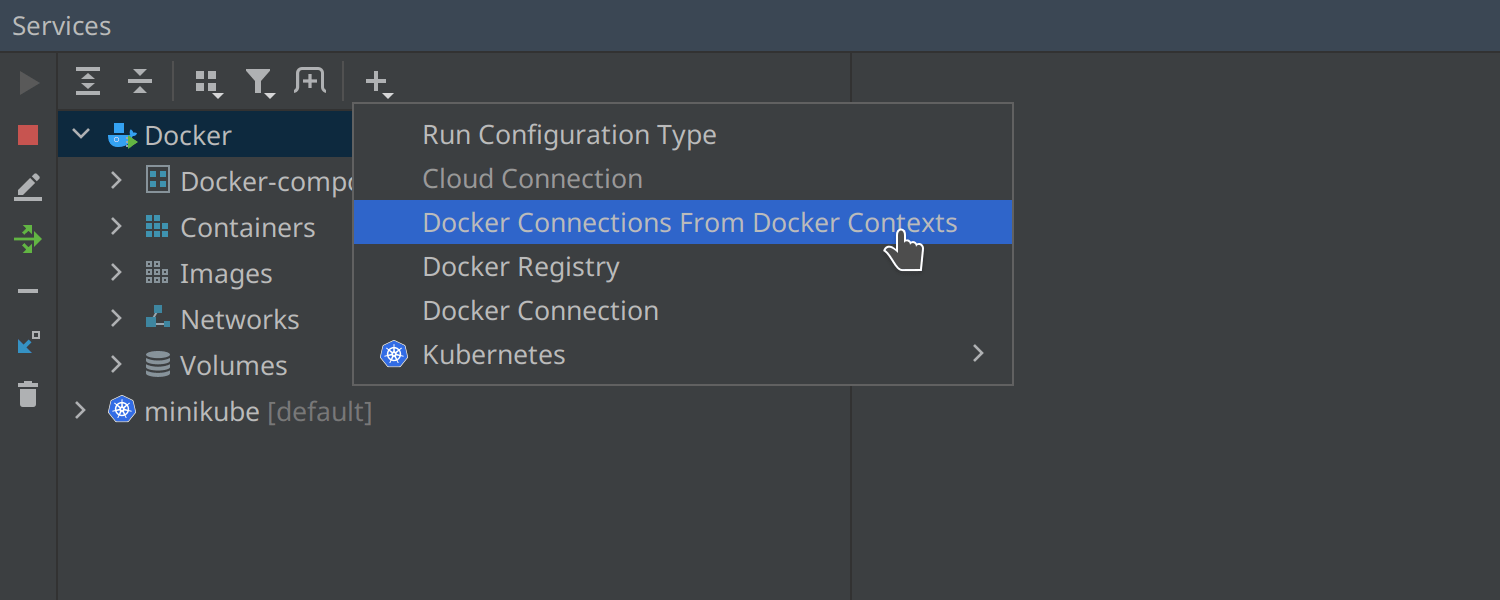

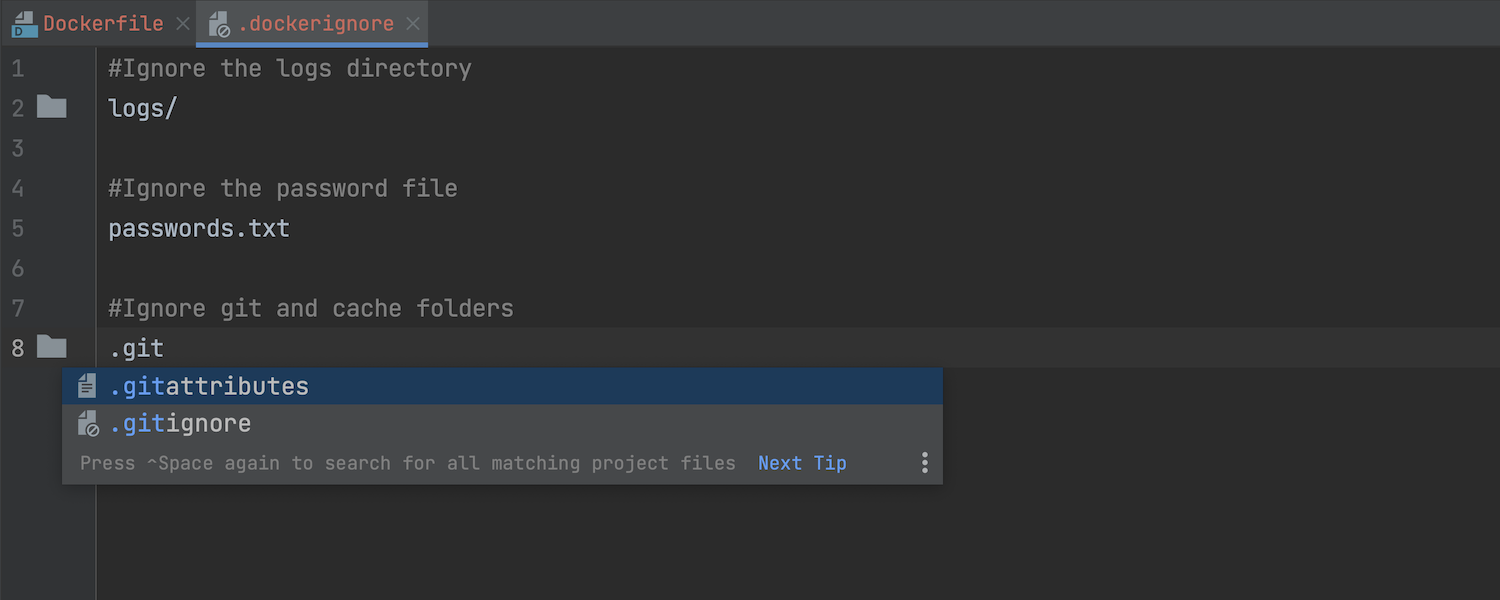

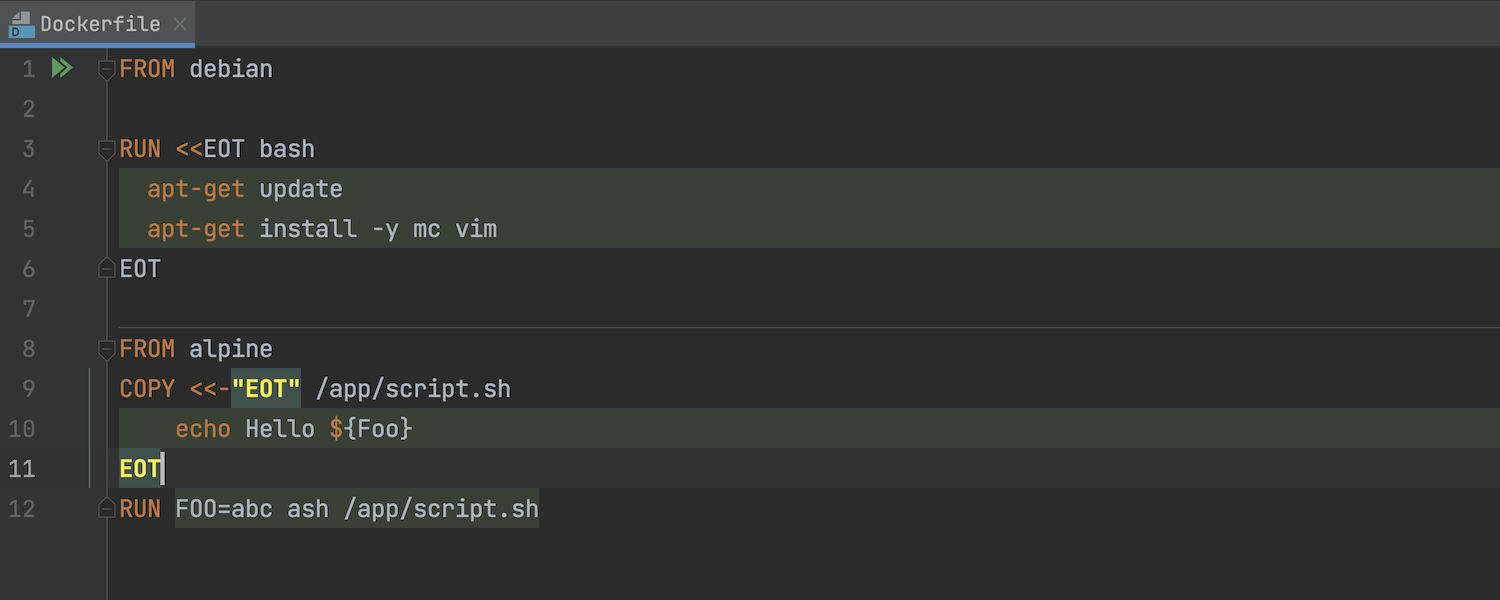

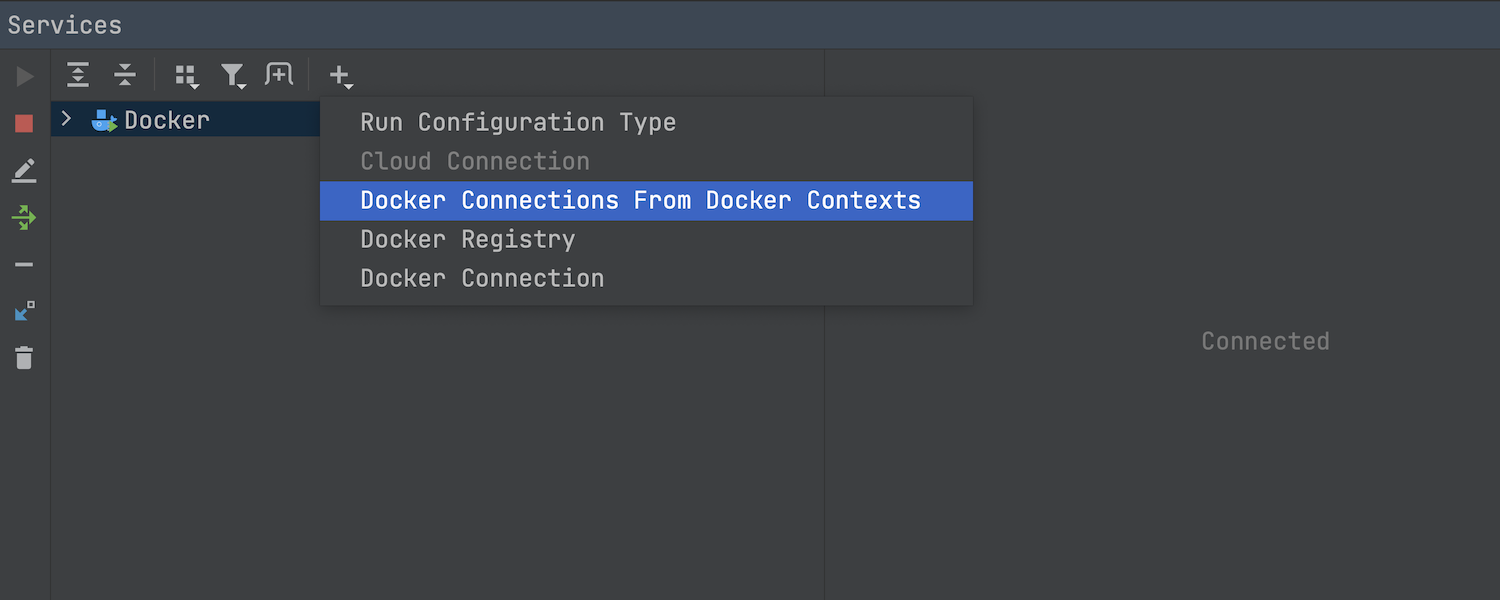

WebStorm 现已支持连接到 WSL 中运行的 Docker。 此外,还有新增的 Pull Docker image(拉取 Docker 镜像)意图、对 文件和 heredoc 语法的完全支持,以及使用 Docker 上下文设置 Docker 连接的功能。

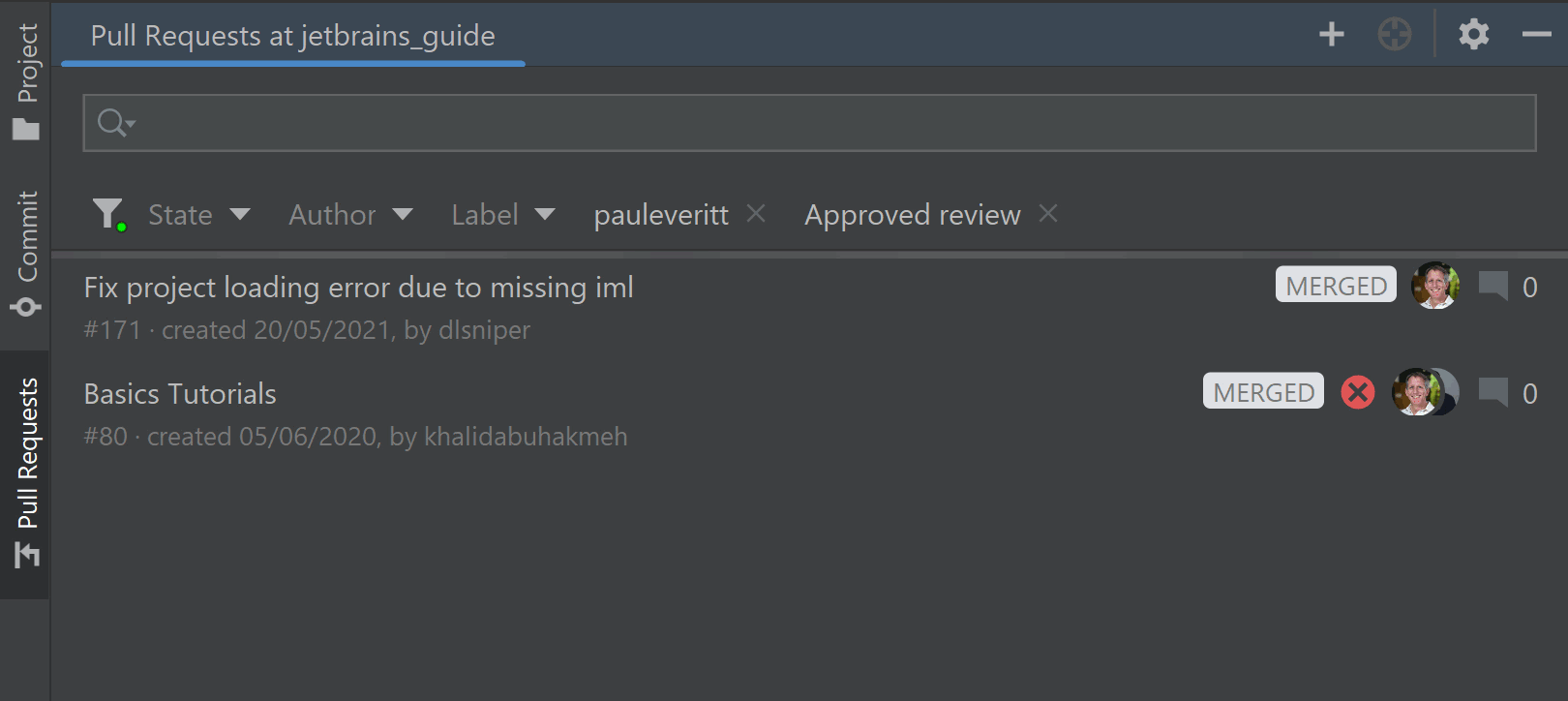

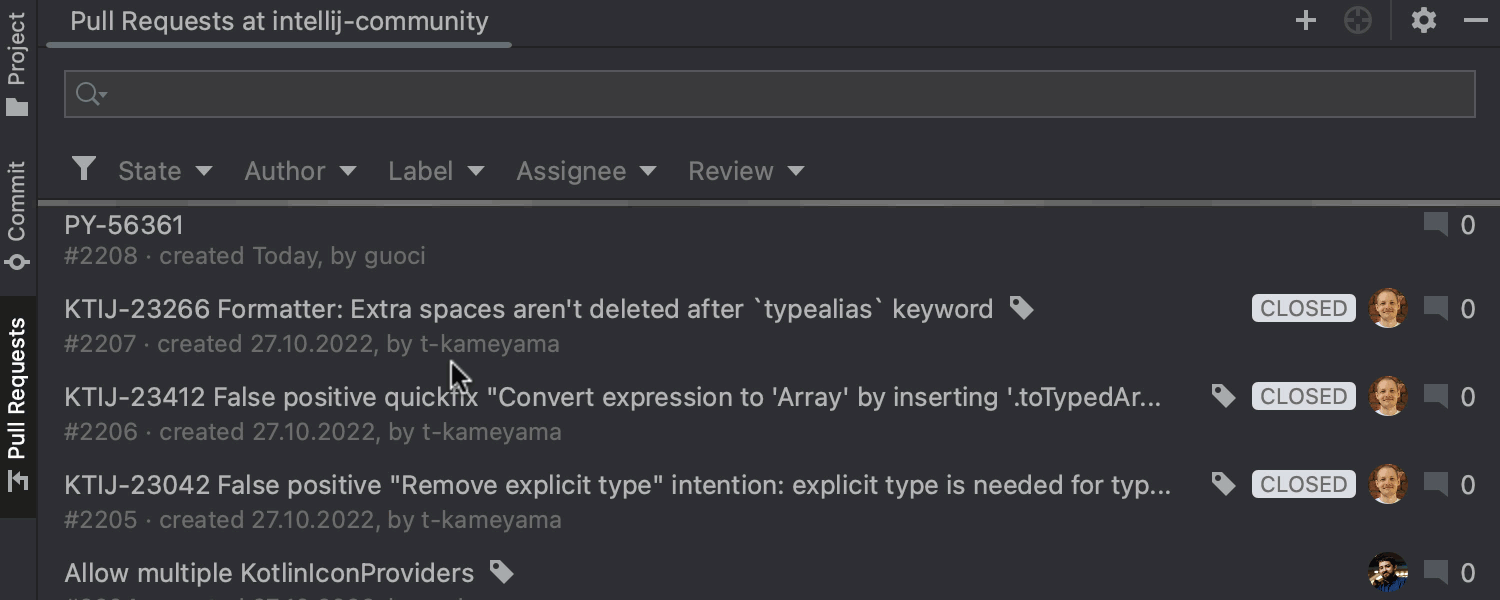

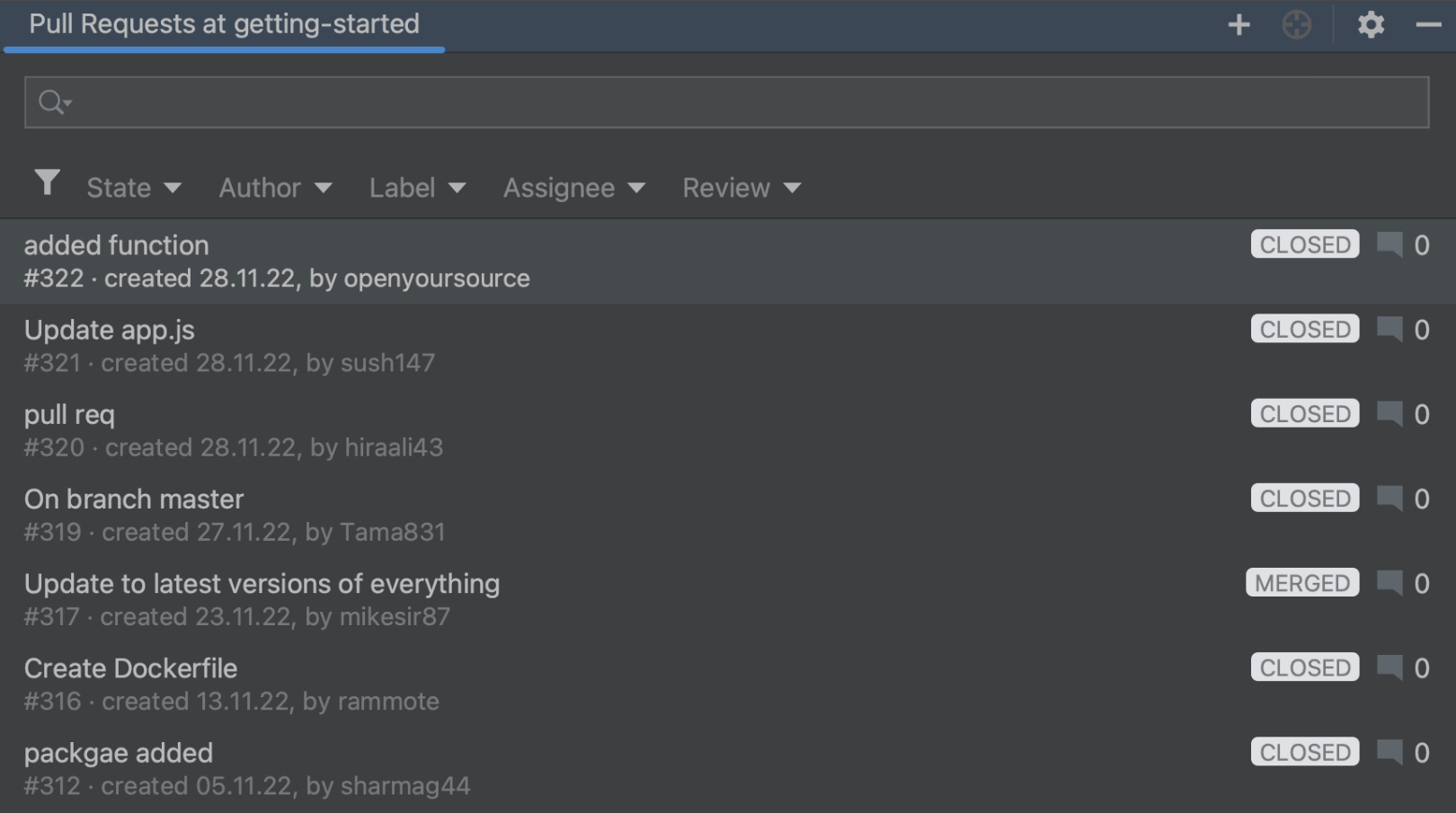

为 GitHub 和 Space 重新设计了 Review list(审查列表)

我们重做了 Review list(审查列表)UI,帮助减少认知负担并清晰提供有关请求的最重要信息。 其中,我们还确保在所有受支持的审查平台上保持一致的外观。

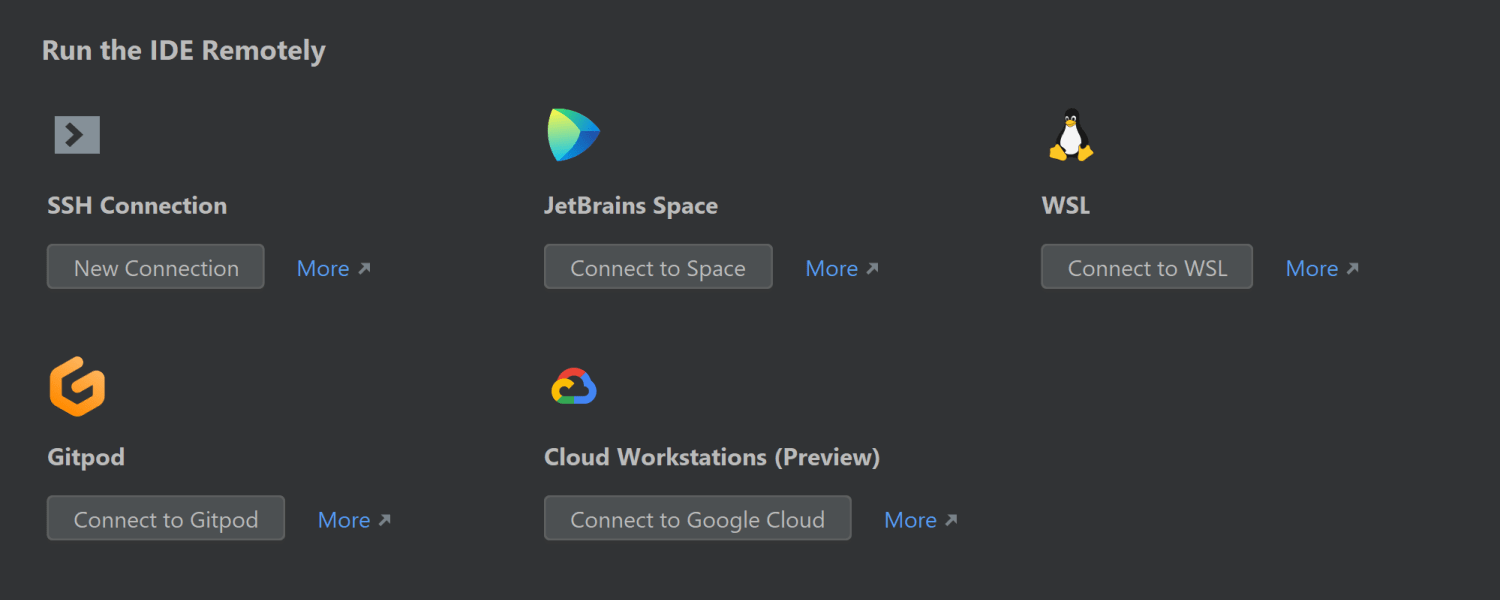

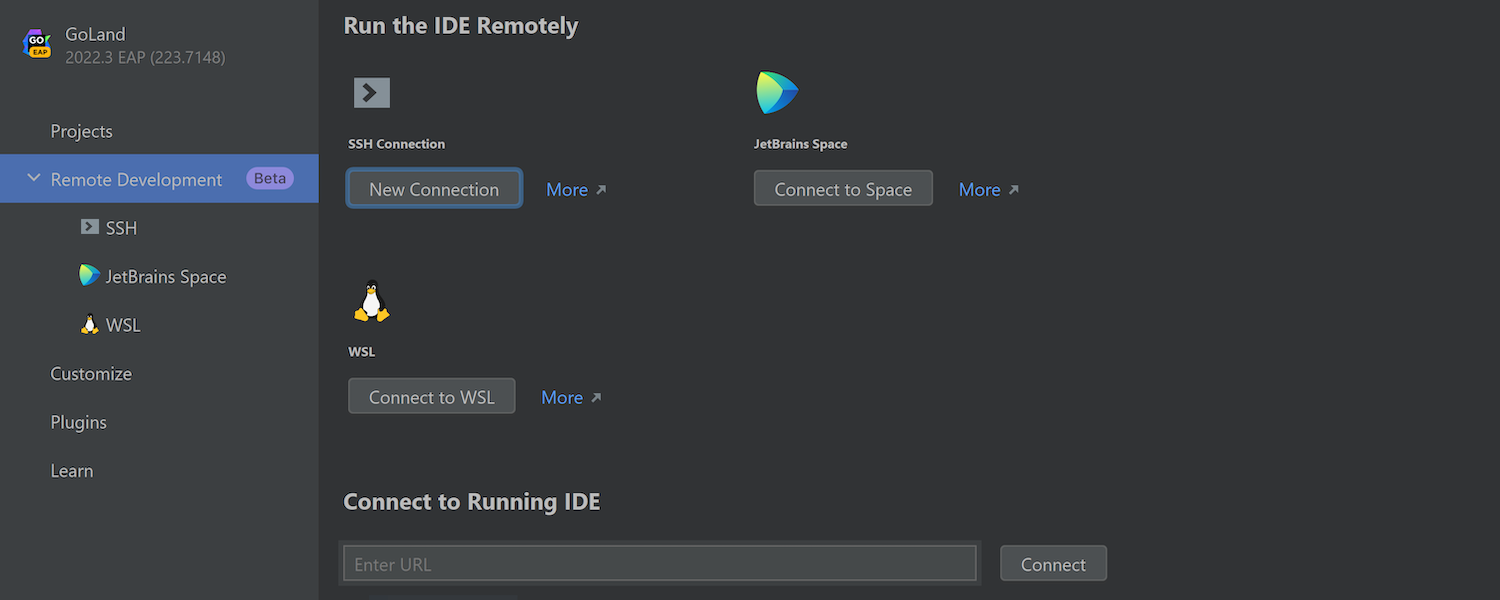

处理 WSL2 中的项目的新方式

WebStorm 2022.3 带来了处理在 WSL2 文件系统中运行的项目的替代方式。 您可以直接在 WSL2 中启动 IDE 后端,而不是在 Windows 上运行完整的 IDE。 然后,您可以像在 WebStorm 中使用远程开发时连接到远程机器一样连接到它。

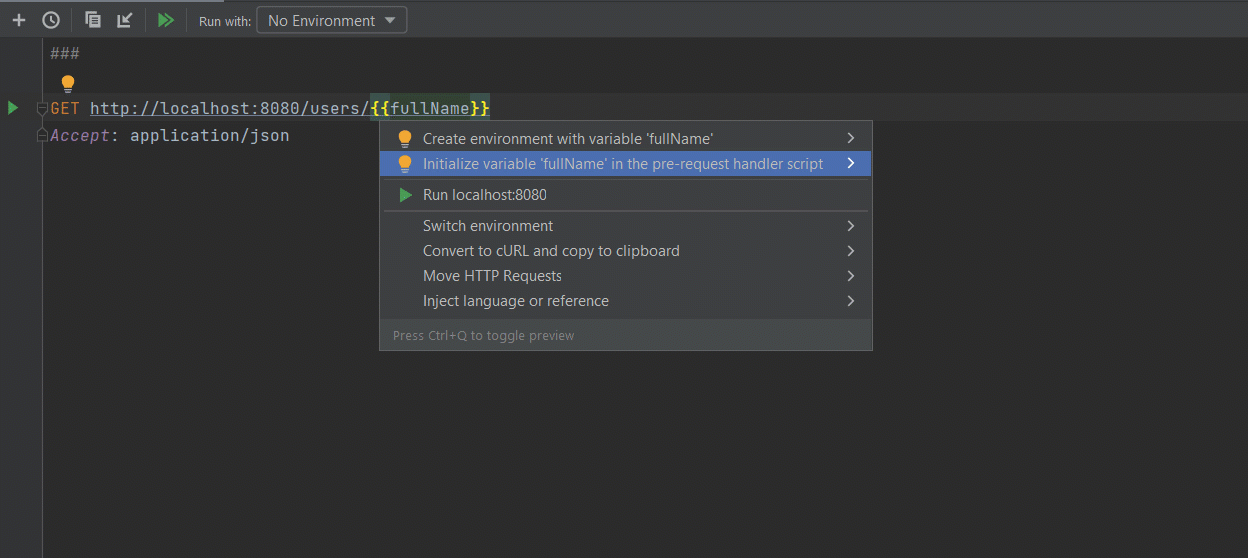

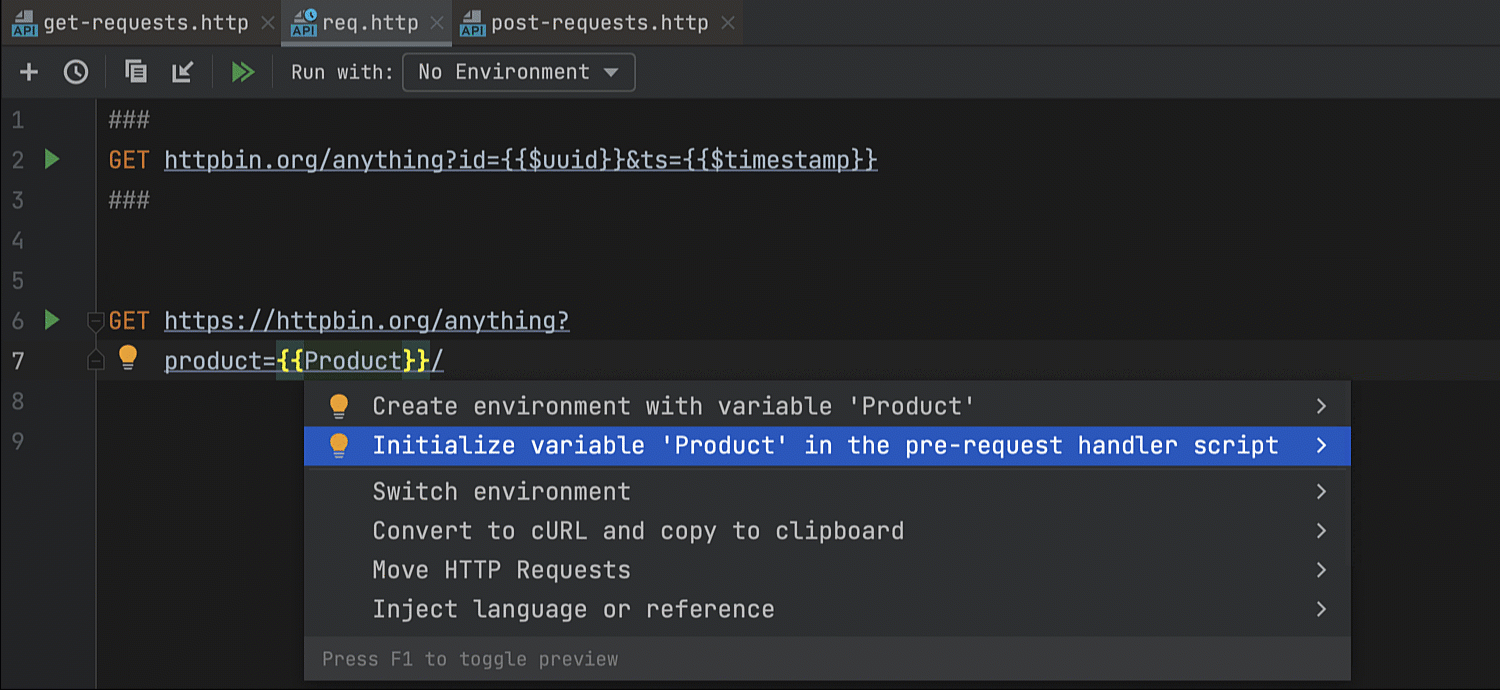

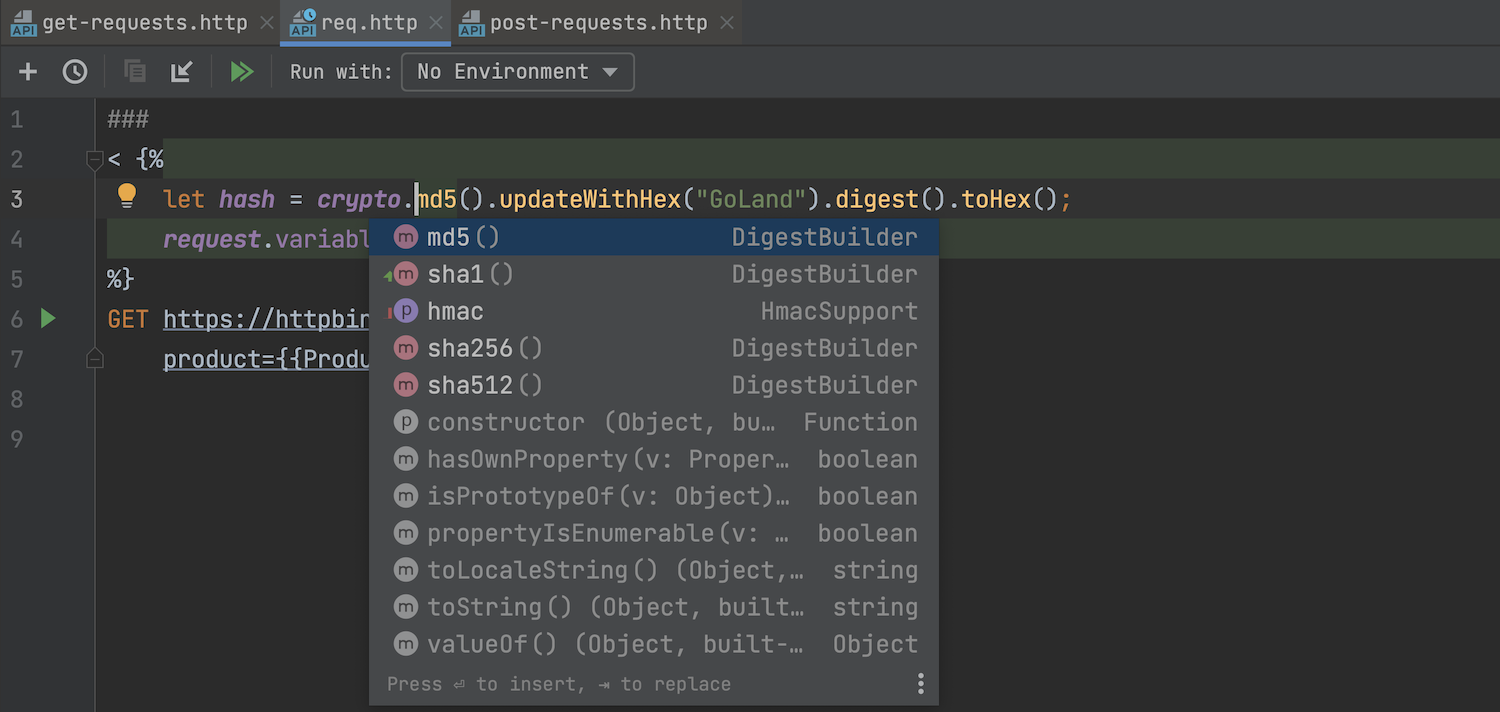

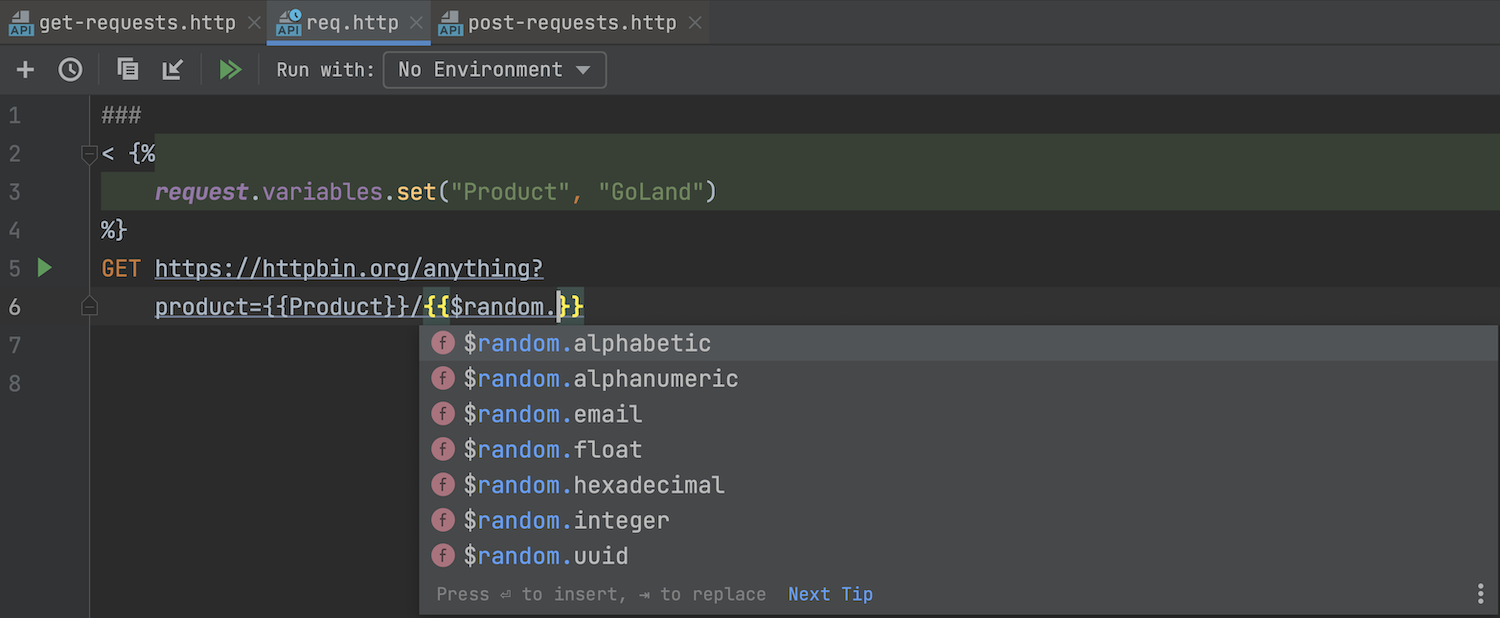

针对 HTTP 客户端的新功能

HTTP 客户端现在支持在请求之前执行的脚本块。 您可以在请求执行之前生成一些数据,并使用变量将其放入最终请求。 WebStorm 现在还提供 сrypto API,使代码能够计算 HTTP 请求的 md5 或 sha1 哈希值。

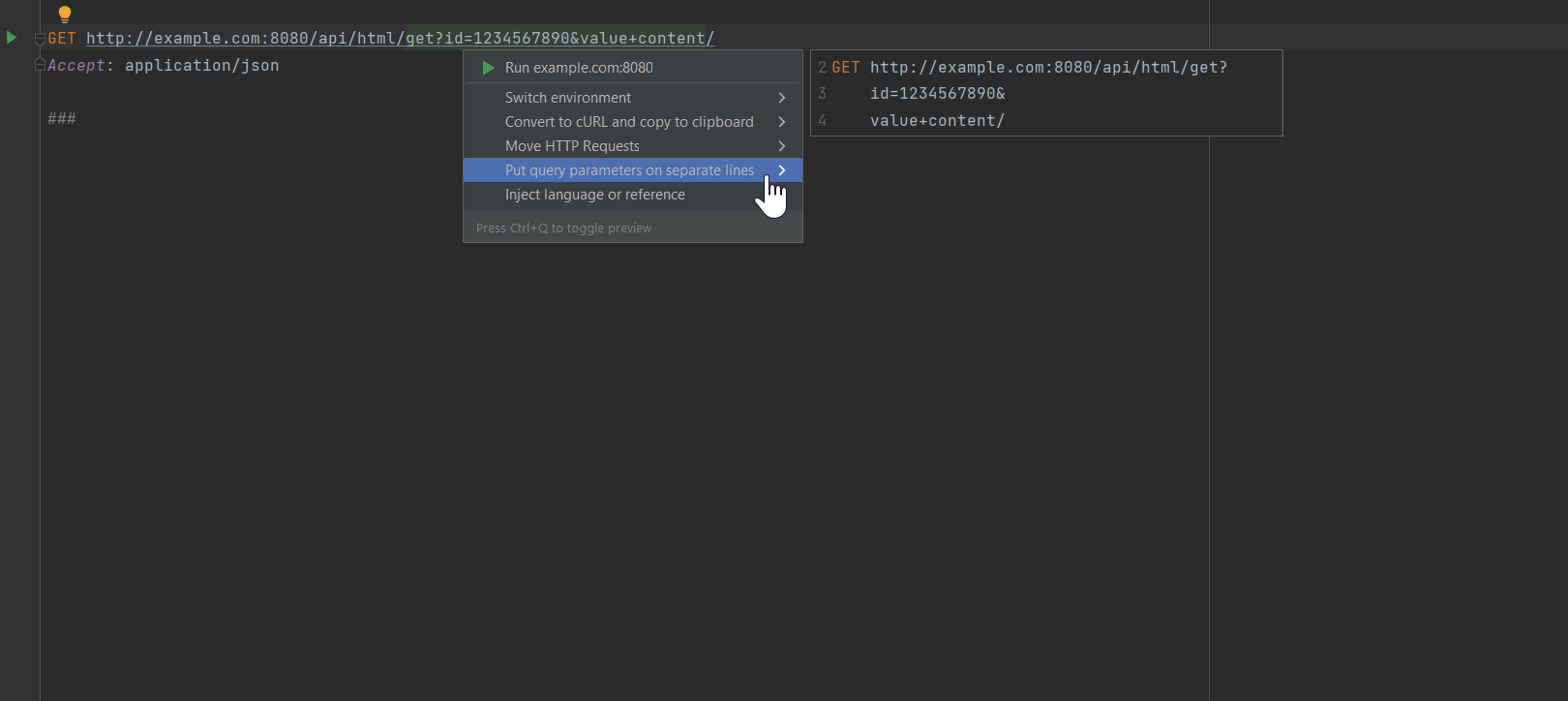

针对 HTTP 客户端的代码样式改进

HTTP 客户端现在为具有长 URL 的请求提供了更好的格式设置选项。 您也可以使用 Put query parameters on separate lines(将查询形参置于单独的行中)意图操作,将查询拆分成不同行中的小片段。 转到 Preferences / Settings | Editor | Code Style | HTTP Request | Wrapping and Braces(偏好设置/设置 | 编辑器 | 代码样式 | HTTP 请求 | 换行和大括号)即可控制有关 HTTP 请求格式设置的偏好设置。

更多详情可查看:https://blog.jetbrains.com/webstorm/2022/11/webstorm-2022-3/

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

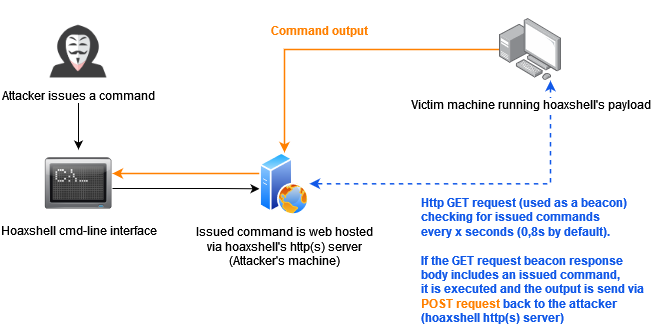

漏洞描述

Apache Fineract 是一个用于金融服务的开源软件。

Apache Fineract 在 1.8.1 之前的版本中由于 FileSystemContentRepository.java 类对用户传入的文件路径名限制不当从而存在路径遍历漏洞,经过身份验证的攻击者可利用此漏洞上传包含恶意代码的文件到系统任意目录,在 Fineract 加载恶意文件时远程执行恶意代码。

影响范围

apache/fineract@(-∞, 1.8.1)

修复方案

升级apache/fineract到 1.8.1 或更高版本

参考链接

https://www.oscs1024.com/hd/MPS-2022-62935

https://nvd.nist.gov/vuln/detail/CVE-2022-44635

https://github.com/apache/fineract/commit/90f854ba466b048807c26ccf31a6f555

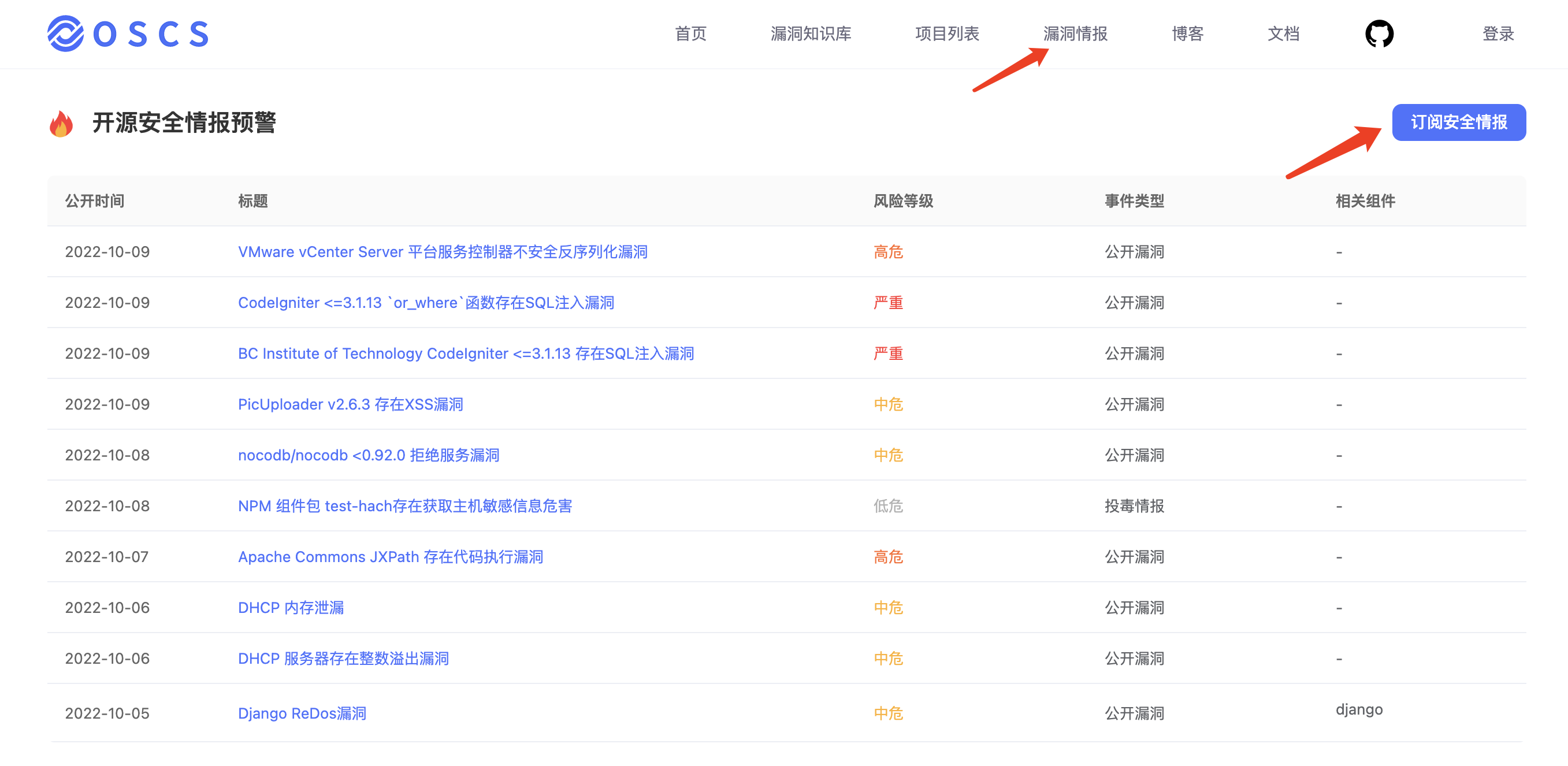

情报订阅

OSCS(开源软件供应链安全社区)通过最快、最全的方式,发布开源项目最新的安全风险动态,包括开源组件安全漏洞、事件等信息。同时提供漏洞、投毒情报的免费订阅服务,社区用户可通过配置飞书、钉钉、企业微信机器人,及时获得一手情报信息推送:

https://www.oscs1024.com/cm/?src=osc

具体订阅方式详见:

https://www.oscs1024.com/docs/vuln-warning/intro/?src=osc

背景

字节跳动特征存储痛点

当前行业内的特征存储整体流程主要分为以下四步:

特征存储的整体流程

-

业务在线进行特征模块抽取;

-

抽取后的特征以行的格式存储在 HDFS,考虑到成本,此时不存储原始特征,只存抽取后的特征;

-

字节跳动自研的分布式框架会将存储的特征并发读取并解码发送给训练器;

-

训练器负责高速训练。

字节跳动特征存储总量为 EB 级别,每天的增量达到 PB 级别,并且每天用于训练的资源也达到了百万核心,所以整体上字节的存储和计算的体量都是非常大的。在如此的体量之下,我们遇到了以下三大痛点:

-

特征抽取周期长。在特征抽取上,当前采用的是在线抽取的方式。大量的算法工程师,每天都在进行大量的特征相关的试验。在当前的在线抽取模式下,如果有算法工程师想要调研一个新的特征,那么他首先需要定义特征的计算方式,等待在线模块的统一上线,然后需要等在线抽取的特征积累到一定的量级后才可以进行训练,从而判断这个特征是否有效果。这个过程通常需要2周甚至更长的时间。并且,如果发现特征的计算逻辑写错或想要更改计算逻辑,则需重复上述过程。在线特征抽取导致当前字节特征调研的效率非常低。基于当前的架构,离线特征调研的成本又非常高。

-

特征存储空间占用大。字节的特征存储当前是以行存的形式进行存储。如果基于当前的行存做特征调研,则需要基于原来的路径额外生成新的数据集。一方面需要额外的空间对新的数据集进行存储,另一方面还需要额外的计算资源去读取原来的全量数据生成新的数据,且很难做数据的管理和复用。行存对于特征存储来说,也很难进行优化,占用空间较大。

-

模型训练带宽大,数据读取有瓶颈。字节当前将每个业务线的绝大部分特征都存储在一个路径下,训练的时候会直接基于这个路径进行训练。对于每个模型,训练所需的特征是不一样的,每个业务线可能存有上万个特征,而大部分模型训练往往只需要几百个特征,但因为特征是以行存格式进行存储,所以训练时需要将上万特征全部读取后,再在内存中进行过滤,这就使得模型训练的带宽需求非常大,数据的读取成为了整个训练的瓶颈。

基于痛点的需求梳理

基于上述问题,我们与业务方一同总结了若干需求:

-

存储原始特征:由于在线特征抽取在特征调研上的低效率,我们期望能够存储原始特征;

-

离线调研能力:在原始特征的基础上,可以进行离线调研,从而提升特征调研效率;

-

支持特征回填:支持特征回填,在调研完成后,可以将历史数据全部刷上调研好的特征;

-

降低存储成本:充分利用数据分布的特殊性,降低存储成本,腾出资源来存储原始特征;

-

降低训练成本:训练时只读需要的特征,而非全量特征,降低训练成本;

-

提升训练速度:训练时尽量降低数据的拷贝和序列化反序列化开销。

字节跳动海量特征存储解决方案

在字节的整体架构中,最上层是业务层,包括抖音、头条、小说等字节绝大部分业务线;

其下我们通过平台层,给业务同学提供简单易用的 UI 和访问控制等功能;

在框架层,我们使用 Spark 作为特征处理框架(包括预处理和离线特征调研等),字节自研的 Primus 作为训练框架;

在格式层,我们选用Parquet 作为文件格式,Iceberg 作为表格式;

最下层是调度器 Yarn & K8s 以及存储 HDFS。

下面我们重点针对格式层进行详细介绍。

技术选型

为了满足业务方提到的6个需求,我们首先想到的是通过 Parquet 列存的格式,降低行存的存储成本,节省的空间可用来存储原始特征。同时由于 Parquet 选列可以下推到存储层的特性,在训练时可以只读需要的特征,从而降低训练时反序列化的成本,提升训练的速度。

但是使用 Parquet 引入了额外的问题,原来的行存是基于 Protobuf 定义的半结构化数据,不需要预先定义 Schema,而使用 Parquet 以后,我们需要先知道 Schema,然后才能进行数据的存取,那么在特征新增和淘汰时,Schema 的更新就是一个很难解决的问题。Parquet 并不支持数据回填,如果要回填历史几年的数据,就需要将数据全量读取,增加新列,再全量写回,这一方面会浪费大量的计算资源,另一方面做特征回填时的 overwrite 操作,会导致当前正在进行训练的任务由于文件被替换而失败。

为了解决这几个问题,我们引入了 Iceberg 来支持模式演进、特征回填和并发读写。

Iceberg 是适用于大型数据集的一个开源表格式,具备模式演进、隐藏分区&分区演进、事务、MVCC、计算存储引擎解耦等特性,这些特性匹配了我们所有的需求。因此,我们选择了 Iceberg 作为我们的数据湖。

整体上 Iceberg 是一个分层的结构,snapshot 层存储了当前表的所有快照;manifest list 层存储了每个快照包含的 manifest 云数据,这一层的用途主要是为了多个 snapshot 可以复用下一层的 manifest;manifest 层,存储了下层 Data Files 数据;最下面的 Data File 是就是实际的数据文件。通过这样的多层结构,Iceberg 可以支持上述包括模式演进等几个特性。

下面我们来一一介绍 Iceberg 如何支持这些功能。

字节跳动海量特征存储解决方案

并发读写

在并发读取方面,Iceberg 是基于快照的读取,对 Iceberg 的每个操作都会生成新的快照,不影响正在读取的快照,从而保证读写互不影响。

在并发写入方面,Iceberg 是采用乐观并发的方式,利用HDFS mv 的原子性语义保证只有一个能写入成功,而其他的并发写入会被检查是否有冲突,若没有冲突,则写入下一个 snapshot。

模式演进

Iceberg 的模式演进原理

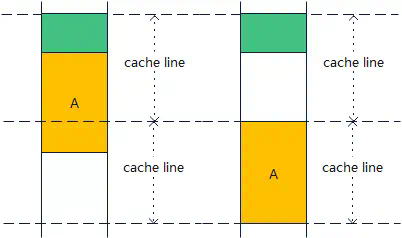

我们知道,Iceberg 数据和 Parquet 数据都有 Column,而中间的映射关系,是通过 ID 字段来进行一对一映射。

例如上面左图中,Iceberg 和 Parquet 分别有 ABC 三列,对应 ID 1、2、3。那最终读取出的 Dataframe 就是 和 Parquet 中一致包含 ID 为1、2、3的 ABC 三列。而当我们对左图进行两个操作,删除旧的 B 列,写入新的 B 列后, Iceberg 对应的三列 ID 会变成1、3、4,所以右图中读出来的 Dataframe,虽然也是 ABC 三列,但是这个 B 列的 ID 并非 Parquet 中 B 列的 ID,因此最终实际的数据中,B 列为空值。

特征回填

- 写时复制

如上图所示,COW 方式的特征回填通过一个 Backfill 任务将原快照中的数据全部读出,然后写入新列,再写出到新的 Data File 中,并生成新的快照。

这种方式的缺点在于虽然我们只需要写一列数据,但是需要将整体数据全部读出,再全部写回,不仅浪费了大量的计算资源用来对整个 Parquet 文件进行编码解码,还浪费了大量的 IO 来读取全量数据,且浪费了大量的存储资源来存储重复的 ABC 列。

因此我们基于开源 Iceberg 自研了 MOR 的 Backfill 方案。

- 读时合并

如上图所示,在 MOR 方案中,我们仍然需要一个 Backfill 任务来读取原始的 Data File 文件,但是这里我们只读取需要的字段。比如我们只需要 A 列通过某些计算逻辑生成 D 列,那么 Backfill 任务则只读取 A 的数据,并且 Snapshot2 中只需要写包含 D 列的 update 文件。随着新增列的增多,我们也需要将 Update 文件合并回 Data File 文件中。

为此,我们又提供了 Compaction 逻辑,即读取旧的 Data File 和 Update File,并合并成一个单独的 Data File。

MOR原理如上图,假设原来有一个逻辑 Dataframe 是由两个 Data File 构成, 现在需要回填一个 ColD 的内容。我们会写入一个包含 ColD 的 Update File,这样 Snapshot2 中的逻辑 Dataframe 就会包含ABCD 四列。

实现细节:

- Data File 和 Update File 都需要一个主键,并且每个文件都需要按照主键排序,在这个例子中是 ID;

- 读取时,会根据用户选择的列,分析具体需要哪些 Update File 和 Data File;

- 根据 Data File 中主键的 min-max 值去选择与该 Data File 相对应的 Update File;

- MOR 整个过程是多个 Data File 和 Update File 多路归并的过程;

- 归并的顺序由 SEQ 来决定,SEQ 大的数据会覆盖 SEQ 小的数据。

-

COW与 MOR 特性比较

相比于 COW 方式全量读取和写入所有列,MOR 的优势是只读取需要的列,也只写入更新的列,没有读写放大问题。在计算上节省了大量的资源,读写的 IO 也大大降低,相比 COW 方式每次 COW 都翻倍的情况, MOR 只需要存储新增列,也大大避免了存储资源浪费。

考虑到性能的开销,我们需要定期 Compaction,Compaction 是一个比较重的操作,和 COW 相当。但是 Compaction 是一个异步的过程,可以在多次 MOR 后进行一次 Compaction。那么一次 Compaction 的开销就可以摊销到多次 MOR 上,例如10次 COW 和10次 MOR + 1次 Compaction 相比,存储和读写成本都从原来的 10x 降到当前的 2x 。

MOR 的实现成本较高,但这可以通过良好的设计和大量的测试来解决。

而对于模型训练来说,由于大多数模型训练只需要自己的列,所以大量的线上模型都不需要走 MOR 的逻辑,可以说基本没有开销。而少数的调研模型,往往只需读自己的 Update File 而不用读其他的 Update File ,所以整体上读取的额外资源也并未增加太多。

训练优化

从行存改为 Iceberg 后,我们也在训练上也做了大量的优化。

在我们的原始架构中,分布式训练框架并不解析实际的数据内容,而是直接以行的形式把数据透传给训练器,训练器在内部进行反序列化、选列等操作。

原始架构

引入 Iceberg 后,我们要拿到选列带来的 CPU 和 IO 收益就需要将选列下推到存储层。最初为了保证下游训练器感知不到,我们在训练框架层面,将选列反序列化后,构造成原来的 ROW 格式,发送给下游训练器。相比原来,多了一层序列化反序列化的开销。

这就导致迁移到 Iceberg 后,整体训练速度反而变慢,资源也增加了。

列式改造

为了提升训练速度,我们通过向量化读取的方式,将 Iceberg 数据直接读成 Batch 数据,发送给训练器,这一步提升了训练速度,并降低了部分资源消耗。

向量化读取

为了达到最优效果,我们与训练器团队合作,直接修改了训练器内部,使训练器可以直接识别 Arrow 数据,这样我们就实现了从 Iceberg 到训练器端到端的 Arrow 格式打通,这样只需要在最开始反序列化为 Arrow ,后续的操作就完全基于 Arrow 进行,从而降低了序列化和反序列化开销,进一步提升训练速度,降低资源消耗。

Arrow

优化收益

最终,我们达到了最初的目标,取得了离线特征工程的能力。

在存储成本上,普遍降低了40%以上;在同样的训练速度下,CPU 降低了13%,网络IO 降低40%。

未来规划

未来,我们规划支持以下4种能力:

-

Upsert 的能力,支持用户的部分数据回流;

-

物化视图的能力,支持用户在常用的数据集上建立物化视图,提高读取效率;

-

Data Skipping 能力,进一步优化数据排布,下推更多逻辑,进一步优化 IO 和计算资源;

-

基于 Arrow 的数据预处理能力,向用户提供良好的数据处理接口,同时将预处理提前预期,进一步加速后续的训练。

字节跳动基础架构批式计算团队持续招聘中,批式计算团队负责字节跳动离线数据处理&分布式训练,支撑公司内离线 ETL&机器学习等业务场景,涉及的组件包括离线计算引擎 Spark/自研分布式训练框架 Primus /特征存储 Feature Store(如Iceberg/Hudi)/Ray 等。面对字节超大规模的场景,在 Spark/Primus/Feature Store 等方面都做了大量的功能&性能优化,同时支持新一代分布式应用框架 Ray 在公司相关场景的落地。

工作地点:北京/杭州

联系方式:微信 bupt001,或发送简历至邮件 qianhan@bytedance.com

HSE 是一个快速可嵌入的键值存储,专为 SSD 和持久化内存设计。HSE 通过协调跨 DRAM 和多类固态存储的数据放置,优化了性能和耐久性。

HSE 是支持数据库、软件定义存储(SDS)、高性能计算(HPC)、物联网(IoT)和机器学习(ML)的理想选择。

主要特征:

- 丰富的键值运算符集

- 用于优化单个数据存储中的混合用例工作负载的数据模型

- 键值压缩

- 灵活的耐久性控制

- 可配置的数据编排方案

- 可以嵌入任何应用程序的本地 C 库

优势:

- 每个存储可扩展到数 TB 的数据和数千亿个密钥

- 高效处理数千个并发操作

- 显着改善吞吐量、延迟、写放大、 和读取放大

- 可选地组合多种固态存储类别,以优化性能和耐久性

构建 HSE

克隆 仓库并 checkout 最新的发布标签。 此标签必须适用于 HSE 2.0 或更高版本。

例如

git clone https://github.com/hse-project/hse.git cd hse git checkout <release tag>

使用 Meson 和 Ninja 构建和安装。

可以在 meson.build 目录中找到构建 HSE 所需的最低版本的 Meson。 在那里,你会在文件开头发现一个 关键字参数的 函数。

如果你的系统没有提供足够新的 Meson 版本来构建 HSE,请参阅安装说明 。

meson setup build meson compile -C build meson install -C build

IEEE 发布了一项最新的调查结果,主要研究技术对 2023 及未来发展的影响。该调查基于来自美国、英国、中国、印度和巴西的 350 名首席技术官、首席信息官和 IT 主管等全球技术领导者的反馈。

调查指出,云计算 (40%)、5G (38%)、宇宙 (37%)、电动汽车 (EV) (35%) 和工业物联网 (IIoT) (33%) 将成为 2023 年最重要的五个技术领域。其中,宇宙尚处于起步阶段;71% 的受访者认为“5G 和无处不在的连接”对推动宇宙发展非常重要,还有 58% 的认为 VR 耳机和 AR 眼镜也同样重要。

2023 年受技术影响最大的行业部门有:

- (40%) 电信

- (39%) 汽车和运输

- (33%) 能源

- (33%) 银行和金融服务

另一方面,2023 年的网络安全问题也依旧是各方关注的重点。数据表明,2022 年上半年,全球共发生 28 亿次恶意软件攻击和 2.361 亿次勒索软件攻击。截至 2022 年底,预计将发起 60 亿次网络钓鱼攻击。技术领导者们对网络安全的关注更甚于往年,51% 的受访者将云漏洞列为头等大事 (高于 2022 年的 35%),还有 43% 的担忧数据中心漏洞 (高于 2022 年的 27%)。

网络安全专业人员关注的其他领域还包括:

- 勒索软件攻击 (30%)

- 对组织网络的协同攻击 (30%)

- 缺乏对安全解决方案的投资 (26%)

IT 部门在 2023 年可能遇到的 10 大安全威胁有:

- 恶意软件:可以提取机密信息、拒绝服务并获得对系统的访问权限。

- 勒索软件:截至 2022,勒索软件对公司的攻击比 2021 年高出 33%。许多公司同意支付赎金以恢复其系统,结果却再次遭到同样的勒索软件攻击者的攻击。

- 供应链漏洞:可以采取的步骤之一是审核其供应商和供应商使用的安全措施,以确保端到端供应链的安全。

- 网络钓鱼:网络钓鱼是企业所面临的主要威胁。对员工进行关于如何识别虚假电子邮件、报告它们以及永远不要打开它们的培训将很有帮助。IT 应与 HR 合作,以确保培养良好的电子邮件使用习惯。

- 物联网:2020 年,有 61% 的公司在使用物联网,这一比例还在继续增加。随着物联网的扩展,安全风险也在增加。

- 内部员工:心怀不满的员工可能会破坏网络或窃取知识产权和专有信息,而养成不良安全习惯的员工可能会无意中共享密码并使设备不受保护。

- 数据中毒:数据中毒是进入企业系统的新攻击媒介。

- 新技术:一些组织正在采用生物识别等新技术。这些技术带来了巨大的好处,但它们也引入了新的安全风险,因为 IT 对它们的经验有限。

- 多层安全:IT 部门可以通过为工作流程中的每个安全漏洞点建立一个检查清单来加强安全。

- 云安全

Linus 近日对内核维护者表示,由于项目的开发周期节奏将与即将到来的圣诞夜产生冲突,维护者要确保在假期之前完成他们的开发工作。

Linus 在刚刚过去的周末发布了 Linux 6.1-rc7。他在邮件中表示,本以为感恩节会影响内核的开发工作,但现实情况与他的判断相反——假期并没有减缓开发进度。因此,Linus 决定再为 Linux 6.1 发布一个 rc8。若按照这个节奏,Linux 6.2 合并窗口刚好处于圣诞节假期期间。

对此,Linus 表示在下一个合并窗口期间,自己会比平时更“强硬”地执行规则。按照社区规则,开发者应该在合并窗口开启之前就准备好要提交的补丁。但现在,他希望所有要提交的补丁在圣诞节之前就完成,如果他收到的 PR 比这个时间晚。他将推迟到下一个周期在合并。

最后,Linus 希望大家对此达成完全一致的共识,并且不要再给他发送明显不是错误的信息。

延伸阅读

- Linus 批评内核开发者赶 Deadline

U-Boot 是一个开源引导加载程序,主要用于嵌入式系统。它支持多种不同的结构,包括 PPC、ARM、AVR32、MIPS、x86、68k、Nios 与 MicroBlaze。

此前,U-Boot 引导加载程序只支持 UDP 协议,仅限通过 tftp(简单文件传输协议) 或 NFS(网络文件系统) 进行文件传输。在开发人员的长期努力之下,如今 U-Boot 终于提供了 TCP 协议支持,可通过 HTTP 下载文件或其他内容。

经过五年开发,整整二十轮的修改,对 U-Boot 网络的 TCP 基础支持补丁终于完成并合并到主线。除了对 TCP 协议的兼容,该系列补丁还添加了一个基础的 wget 应用程序。U-Boot 上的的 wget 应用是一个命令行下载器,允许通过 TCP 从 HTTP 服务器下载文件到指定的内存地址,目前 wget 仅支持 80 端口上的 HTTP 服务器,且不支持 HTTPS。

提供 HTTP 和 TCP 支持意味着 U-Boot 可以从 HTTP 服务器下载内核或其他文件,而不仅限使用 NFS 或 TFTP 进行远程加载,它可以简化一些 U-Boot 嵌入式设备的部署。

开源固件基金会(Open-Source Firmware Foundation, OSFF)近日在社交平台宣布,Coreboot 将正式加入 OSFF,共同推进开源固件的开发。

Coreboot 原名 LinuxBIOS,是一个旨在取代计算机中专有固件(BIOS 或 UEFI)的软件项目,它采用轻量级固件设计,只执行加载和运行现代 32 位或 64 位操作系统所需的最少量任务。

由于 Coreboot 要初始化硬件,所以必须为所要支持的每个芯片组和主板做移植。因此 Coreboot 只适用于有限的硬件平台和主板型号。

开源固件基金会由 9elements Cyber Security 和 Mullvad VPN 共同成立,在官方网站的介绍中他们写道:

开源固件基金会(OSFF)是一个非营利组织,其总体目标是加强开源固件领域各方的沟通。OSFF 于 2021 年由业界领先的开源固件公司成立。

该基金会将其目标设定为通过共享知识资源、基础设施、服务、活动和培训,研究并教育企业和个人了解开源固件。

目前,除了两位创始成员和刚刚加入组织的 Coreboot,OSFF 的成员还有今年年中加入组织的 LinuxBoot。作为一家刚刚成立没多久的基金会,希望 OSFF 未来一切顺利。

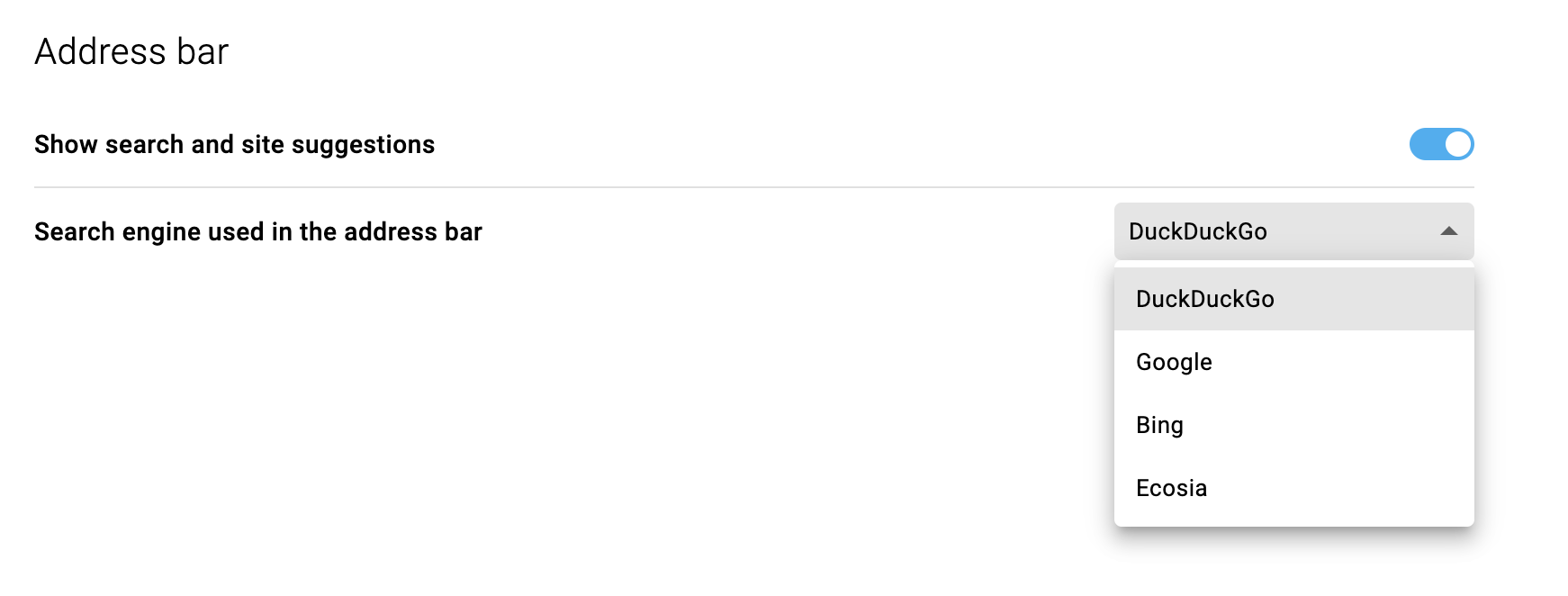

Midori 是一个基于 Chromium 的轻量级开源网络浏览器,并以 Electron 构建,虽然基于 Chromium,但 Midori 去掉了很多来自 Google 的服务和一些涉及隐私的内容。它的目标是快速、隐私、简洁的 UI、可扩展和功能性。

注:Midori 曾是 Xfce 桌面环境 Goodies 组件的一部分,也是 elementary OS “Freya” 和 “Luna”,以及其他很多 Linux 发行版的默认浏览器。

2019年,Midori 项目与 Astian 基金会合并,然后已经完全改头换面,并从 WebKitGTK 转为使用 Electron。

由于该浏览器最新的稳定版本还停留在 2020 年,不少用户都觉得该项目已经停止维护了。

近日,官方带来了一些新的消息,首先 Midori 网络浏览器没有停止维护,仍然在持续开发中;此外,在即将到来的浏览器更新中,他们计划将自己的开源搜索引擎 AstianGO 整合到浏览器中。这与 Brave 跟 Brave Search 整合有些类似,但 Brave Search 并不是开源的。

在 Reddit 的帖子中,Astian 的工作人员表示他们计划在 Midori 网络浏览器的下一次更新中增加一个集成的开源搜索引擎,即 AstianGO。目前这项开发工作的细节并不多,但 Astian 提到:

我们已经实现并开发了一个完全开源的搜索引擎,没有使用第三方 API,也不存储用户的 IP 地址、不存储搜索历史。我们把这个搜索引擎称为 AstianGO,这个搜索引擎是用 PHP 开发的,它是自托管的,尽管它还没有一个集成的更新系统,不过人们可以把它部署在他们的服务器上。

AstianGO 搜索引擎使用来自 Google、Qwant 和 Brave Search 的数据提供结果,并且托管在冰岛、挪威、瑞士、罗马尼亚、荷兰、瑞典等多个国家,这样可以确保用户的数据并不总是流经一个国家。

目前 Astian 已经在 GitLab 上放出了开源搜索引擎 AstianGO 的源代码,用户还可以直接访问 https://astiango.com/ 这个网址来使用搜索引擎,尝试搜索一些内容来验证这个搜索引擎是否好用。

大家好,我是张晋涛。

上周在我的交流群里有个小伙伴问到了 Overlay2 相关的问题,这篇就来介绍一下。(想进群的可以留言)

本节,我将为你介绍 Docker 现在推荐使用的存储驱动 Overlay2,在开始之前,你可以执行以下命令来查看 Docker 正在使用的存储驱动:

如果你看到的结果也是 说明你的 Docker 已经在使用 overlay2 存储驱动了。我在个人工作站上用的是 btrfs,这是因为自从 Fedora 33 开始,btrfs 就成为了 Fedora 默认的文件系统。不过服务器上就都是 overlay2 了。

你也可能会看到其他不同的结果,可以在启动 docker daemon 的时候,通过 参数进行指定,也可以在 文件中通过 字段进行配置。

目前对于 Docker 最新版本而言,你有以下几种存储驱动可供选择:

但它们对于你使用的文件系统之类的都有不同的要求,且实现方式也不尽相同。我以本节的重点 存储驱动为例,它需要你使用 Linux 4.x 以上版本的内核,或者是对于 RHEL/CentOS 等需要使用 3.10.0-514 以上的内核(旧版本中存在一些兼容性问题,我在之前的文章中有提到过)。

同时,它支持你使用 ext4 的文件系统,或者增加了 的 xfs 文件系统。可以通过 进行得到文件系统相关的信息。

存储驱动的作用

前面虽然已经聊了如何设置和检查当前在用的存储驱动,但尚未介绍为何一定要使用存储驱动,以及它的作用。

还记得我在之前的文章《万字长文:彻底搞懂容器镜像构建》中为你介绍的 Docker 如何存储镜像相关的内容吗,如果忘了可以回头复习一下。

Docker 将容器镜像做了分层存储,每个层相当于包含着一条 Dockerfile 的指令。而这些层在磁盘上的存储方式,以及在启动容器时,如何组织这些层,并提供可写层,便是存储驱动的主要作用了。

另外需要注意的是:不同的存储驱动实现不同,性能也有差异,同时使用不同的存储驱动也会导致占用的磁盘空间有所不同。

同时:由于它们的实现不同,当你修改存储驱动后,可能会导致看不到原有的镜像,容器等,这是正常的,不必担心,切换回原先的驱动即可见。

OverlayFS

了解完前面的背景知识后,你也看到了我刚才列出的可用存储驱动中有两个 和 ,其实 算是 的升级版,这两个存储驱动所用的都是 。

驱动是在 2014 年 8 月份首次进入 Docker 的,而 则是在 2016 年 6 月份被合并,并首次出现在 Docker 1.12 中的。它的出现是为了解决 存储驱动可能早层 inode 耗尽的问题。

简单介绍完 和 ,我们将重点回归到 上。

我们启动一个容器,以此为切入点来认识下 OverlayFS,注意:以下内容使用 Linux 5.4 内核以及 Docker 20.10.21,不同环境下可能结果略有差异。

可以看到,在启动容器后,系统上多了一个 OverlayFS (overlay) 的挂载。注意看其中的几个内容:

-

挂载点在:

其中的内容,看着很熟悉,是我们所启动容器根目录中的内容。为了验证这一说法,我在容器中新写一个文件:

再次查看此挂载点中的内容:

可以看到刚才写的内容已经在这个挂载点的目录中了。

-

: 这是 OverlayFS 中必要的目录。

这个 中包含两个目录,这是使用了内核对 OverlayFS multi layer 特性的支持,我们分别查看下其中内容:

这两个目录,是不是看着很熟悉?

是的,它们就是我们所启动容器根目录中的大部分内容。为什么说是大部分内容呢?当我们查看其中的内容时,你也会发现它们的内容也并不完整。比如我们刚才新写入的 文件,或者当我们查看 目录下的文件,你也会发现其中都只是常规系统 目录下的部分内容。

-

是另一个重要的目录,我们来看看其中的内容

我们发现这个目录中包含着刚才创建的 文件。同时,其中也包含一个 目录,这个目录便是我们默认使用的 用户的家目录。

如果去查看其中的内容,也会发现刚才我们执行命令的历史记录。

-

这个目录和 在同一个父目录下,查看其内容发现里面只有一个 目录

看完以上的介绍,想必你已经发现了它们之间的部分联系,在此之前,我们在额外看一个目录,那就是 和 以及挂载点共同的父目录:

你会发现这个目录下的内容就比较直观了。我们刚才已经看了其中 , 和 目录的内容了,现在看看 中的内容吧:

我们发现, 文件中的内容是以 分隔的两个 的目录名称。

至此,我们可以得到以下结论:

-

是基础层,可以包含多个 ;

-

是可写层,即挂载时的 ,在容器内变更的文件都在这一层存储;

-

是最终的合并结果,即容器给我们呈现出来的结果;

Overlay2

经过前面对 Docker 启动容器后挂载的 OverlayFS 的介绍后,Overlay2 的工作流程想必你也就比较清楚了。

将镜像各层作为 基础层,同时增加 这个可写层,通过 OverlayFS 的工作机制,最终将 作为容器内的文件目录展示给用户。

你可能会有疑问,如果只是这样简单的组织,会不会有什么限制呢?答案是肯定的,当然有限制,我们可以通过 Overlay2 的代码来看

可以看到其对 lower 的深度有硬编码的限制,当前硬编码的限制是 128 。如果你在使用的过程中遇到这个错误,那表示你超过了最大深度限制,你就需要找些办法来减少层级了。

总结

本节,我为你介绍了 OverlayFS 及 Overlay2 存储驱动相关的内容。通过实际启动容器生成的相关目录来介绍 overlay2 的工作流程,想必通过这种方式能更易理解。

欢迎订阅我的文章公众号【MoeLove】

hello,大家好,我是张张,「架构精进之路」公号作者。

1、前言

随着互联网从简单的单向浏览请求,发展为基于用户个性信息的定制化以及社交化的请求,这要求产品需要做到以用户和关系为基础,对海量数据进行分析和计算。对于后端服务来说,意味着用户的每次请求都需要查询用户的个人信息和大量的关系信息,此外大部分场景还需要对上述信息进行聚合、过滤、排序,最终才能返回给用户。

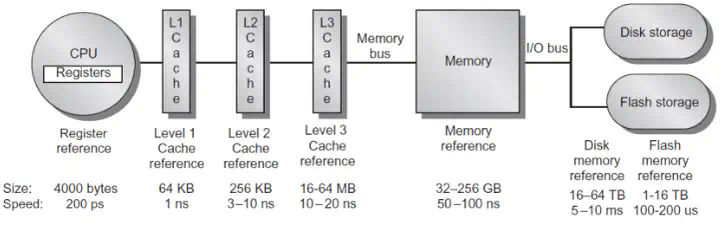

CPU是信息处理、程序运行的最终执行单,如果它的世界也有“秒”的概念,假设它的时钟跳一下为一秒,那么在CPU(CPU的一个核心)眼中的时间概念是什么样的呢?

可见I/O的速度与CPU和内存相比是要差几个数量级的,如果数据全部从数据库获取,一次请求涉及多次数据库操作会大大增加响应时间,无法提供好的用户体验。

对于大型高并发场景下的Web应用,缓存更为重要,更高的缓存命中率就意味着更好的性能。缓存系统的引入,是提升系统响应时延、提升用户体验的唯一途径,良好的缓存架构设计也是高并发系统的基石。

缓存的思想基于以下几点:

-

时间局限性原理 程序有在一段时间内多次访问同一个数据块的倾向。例如一个热门的商品或者一个热门的新闻会被数以百万甚至千万的更多用户查看。通过缓存,可以高效地重用之前检索或计算的数据。

-

以空间换取时间 对于大部分系统,全量数据通常存储在MySQL 或者Hbase,但是它们的访问效率太低。所以会开辟一个高速的访问空间来加速访问过程,例如Redis读的速度是次/s,写的速度是81000次/s 。

-

性能和成本的Tradeoff 高速的访问空间带来的是成本的提升,在系统设计时要兼顾性能和成本。例如,在相同成本的情况下,SSD 硬盘容量会比内存大 10~30 倍以上,但读写延迟却高 50~100 倍。

引入缓存会给系统带来以下优势:

-

提升请求性能

-

降低网络拥塞

-

减轻服务负载

-

增强可扩展性

同样的,引入缓存也会带来以下劣势:

-

毫无疑问会增加系统的复杂性,开发复杂性和运维复杂性成倍提升。

-

高速的访问空间会比数据库存储的成本高。

-

由于一份数据同时存在缓存和数据库中,甚至缓存内部也会有多个数据副本,多份数据就会存在数据双写的不一致问题,同时缓存体系本身也会存在可用性问题和分区的问题。

在缓存系统的设计架构中,还有很多坑,很多的明枪暗箭,如果设计不当会导致很多严重的后果。设计不当,轻则请求变慢、性能降低,重则会数据不一致、系统可用性降低,甚至会导致缓存雪崩,整个系统无法对外提供服务。

2、缓存的主要存储模式

三种模式各有优劣,适用于不同的业务场景,不存在最佳模式。

● Cache Aside(旁路缓存)

写: 更新db时,删除缓存,当下次读取数据库时,驱动缓存的更新。

读: 读的时候先读缓存,缓存未命中,那么就读数据库,并且将数据回种到缓存,同时返回相应结果

特点:懒加载思想,以数据库中的数据为准。在稍微复杂点的缓存场景,缓存都不简单是数据库中直接取出来的,可能还需要从其他表查询一些数据,然后进行一些复杂的运算,才能最终计算出值。这种存储模式适合于对数据一致性要求比较高的业务,或者是缓存数据更新比较复杂、代价比较高的业务。例如:一个缓存涉及多个表的多个字段,在1分钟内被修改了100次,但是这个缓存在1分钟内就被读取了1次。如果使用这种存储模式只删除缓存的话,那么1分钟内,这个缓存不过就重新计算一次而已,开销大幅度降低。

● Read/Write Through(读写穿透)

写: 缓存存在,更新数据库,缓存不存在,同时更新缓存和数据库

读: 缓存未命中,由缓存服务加载数据并且写入缓存

特点:

读写穿透对热数据友好,特别适合有冷热数据区分的场合。

1)简化应用程序代码

在缓存方法中,应用程序代码仍然很复杂,并且直接依赖于数据库,如果多个应用程序处理相同的数据,甚至会出现代码重复。读写穿透模式将一些数据访问代码从应用程序转移到缓存层,这极大地简化了应用程序并更清晰地抽象了数据库操作。

2)具有更好的读取可伸缩性

在多数情况下,缓存数据过期以后,多个并行用户线程最终会打到数据库,再加上数以百万计的缓存项和数千个并行用户请求,数据库上的负载会显著增加。读写穿透可以保证应用程序永远不会为这些缓存项访问数据库,这也可以让数据库负载保持在最小值。

3)具有更好的写性能

读写穿透模式可以让应用程序快速更新缓存并返回,之后它让缓存服务在后台更新数据库。当数据库写操作的执行速度不如缓存更新的速度快时,还可以指定限流机制,将数据库写操作安排在非高峰时间进行,减轻数据库的压力。

4)过期时自动刷新缓存

读写穿透模式允许缓存在过期时自动从数据库重新加载对象。这意味着应用程序不必在高峰时间访问数据库,因为最新数据总是在缓存中。

● Write Behind Caching(异步缓存写入)

写:只更新缓存,缓存服务异步更新数据库。

读:缓存未命中由封装好的缓存服务加载数据并且写入缓存。

特点:写性能最高,定期异步刷新数据库数据,数据丢失的概率大,适合写频率高,并且写操作需要合并的场景。使用异步缓存写入模式,数据的读取和更新通过缓存进行,与读写穿透模式不同,更新的数据并不会立即传到数据库。相反,在缓存服务中一旦进行更新操作,缓存服务就会跟踪脏记录列表,并定期将当前的脏记录集刷新到数据库中。作为额外的性能改善,缓存服务会合并这些脏记录,合并意味着如果相同的记录被更新,或者在缓冲区内被多次标记为脏数据,则只保证最后一次更新。对于那些值更新非常频繁,例如金融市场中的股票价格等场景,这种方式能够很大程度上改善性能。如果股票价格每秒钟变化 100 次,则意味着在 30 秒内会发生 30 x 100 次更新,合并将其减少至只有一次。

3、缓存7大经典问题

问题的常用解决方案

1 缓存集中失效

缓存集中失效大多数情况出现在高并发的时候,如果大量的缓存数据集中在一个时间段失效,查询请求会打到数据库,数据库压力凸显。比如同一批火车票、飞机票,当可以售卖时,系统会一次性加载到缓存,并且过期时间设置为预先配置的固定时间,那过期时间到期后,系统就会因为热点数据的集中没有命中而出现性能变慢的情况。

解决方案:

-

使用基准时间+随机时间,降低过期时间的重复率,避免集体失效。即相同业务数据设置缓存失效时间时,在原来设置的失效时间基础上,再加上一个随机值,让数据分散过期,同时对数据库的请求也会分散开,避免瞬时全部过期对数据库造成过大压力。

2 缓存穿透

缓存穿透是指一些异常访问,每次都去查询压根儿就不存在的key,导致每次请求都会打到数据库上去。例如查询不存在的用户,查询不存在的商品id。如果是用户偶尔错误输入,问题不大。但如果是一些特殊用户,控制一批肉鸡,持续的访问缓存不存在的key,会严重影响系统的性能,影响正常用户的访问,甚至可能会让数据库直接宕机。我们在设计系统时,通常只考虑正常的访问请求,所以这种情况往往容易被忽略。

解决方案:

-

第一种方案就是,查询到不存在的数据时,首次查询数据库,即便数据库没有数据,仍然回种这个 key 到缓存,并使用一个特殊约定的value表示这个key的值为空。后面再次出现对这个key的请求时,直接返回null。为了健壮性,设置空缓存key时,一定要设置过期时间,以防止之后该key被写入了数据。

-

第二种方案是,构建一个 BloomFilter 缓存过滤器,记录全量数据,这样访问数据时,可以直接通过 BloomFilter 判断这个 key 是否存在,如果不存在直接返回即可,压根儿不需要查询缓存或数据库。比如,可以使用基于数据库增量日志解析框架(阿里的canal),通过消费增量数据写入到BloomFilter 过滤器。BloomFilter的所有操作也是在内存里实现,性能很高,要达到 1% 的误判率,平均单条记录占用 1.2 字节即可。同时需要注意的是BloomFilter 只有新增没有删除操作,对于已经删除的key可以配合上述缓存空值解决方案一起使用。Redis提供了自定义参数的布隆顾虑器,可以使用bf.reserve进行创建,需要设置参数error_rate(错误率)和 innitial_size。error_rate越低需要的空间越大,innitial_size表示预计放入的素数量,当实际数量超过这个值以后,误判率会上升。

3 缓存雪崩

缓存雪崩是缓存机器因为某种原因全部或者部分宕机,导致大量的数据落到数据库,最终把数据库打死。例如某个服务,恰好在请求高峰期间缓存服务宕机,本来打到缓存的请求,这是时候全部打到数据库,数据库扛不住在报警以后也会宕机,重启数据库以后,新的请求会再次把数据库打死。

解决方案:

-

事前:缓存采用高可用架构设计,redis使用集群部署方式。对重要业务数据的数据库访问添加开关,当发现数据库出现阻塞、响应慢超过阈值的时候,关闭开关,将一部分或者全都的数据库请求执行failfast操作。

-

事中:引入多级缓存架构,增加缓存副本,比如新增本地 ehcache 缓存。引入限流降级组件,对缓存进行实时监控和实时报警。通过机器替换、服务替换进行及时恢复;也可以通过各种自动故障转移策略,自动关闭异常接口、停止边缘服务、停止部分非核心功能措施,确保在极端场景下,核心功能的正常运行。

-

事后:redis持久化,支持同时开启两种持久化方式,我们可以综合使用 AOF 和 RDB 两种持久化机制,用 AOF 来保证数据不丢失,作为数据恢复的第一选择; 用 RDB 来做不同程度的冷备,在 AOF 文件都丢失或损坏不可用的时候,还可以使用 RDB 来进行快速的数据恢复。同时把RDB 数据备份到远端的云服务,如果服务器内存和磁盘的数据同时丢失,依然可以从远端拉取数据做灾备恢复操作。

4 缓存数据不一致

同一份数据,既在缓存里又在数据库里,肯定会出现数据库与缓存中的数据不一致现象。如果引入多级缓存架构,缓存会存在多个副本,多个副本之间也会出现缓存不一致现象。缓存机器的带宽被打满,或者机房网络出现波动时,缓存更新失败,新数据没有写入缓存,就会导致缓存和 DB 的数据不一致。缓存 rehash 时,某个缓存机器反复异常,多次上下线,更新请求多次 rehash。这样,一份数据存在多个节点,且每次 rehash 只更新某个节点,导致一些缓存节点产生脏数据。再比如,数据发生了变更,先删除了缓存,然后要去修改数据库,此时还没修改。一个请求过来,去读缓存,发现缓存空了,去查询数据库,查到了修改前的旧数据,放到了缓存中。随后数据变更的程序完成了数据库的修改,数据库和缓存中的数据不一样了。

解决方案:

-

设置key的过期时间尽量短,让缓存更早的过期,从db加载新数据,这样无法保证数据的强一致性,但是可以保证最终一致性。

cache更新失败以后引入重试机制,比如连续重试失败以后,可以将操作写入重试队列,当缓存服务可用时,将这些key从缓存中删除,当这些key被重新查询时,重新从数据库回种。

延时双删除策略,首先删除缓存中的数据,在写数据库,休眠一秒以后(具体时间需要根据具体业务逻辑的耗时进行调整)再次删除缓存。这样可以将一秒内造成的所有脏数据再次删除。

缓存最终一致性,使客户端数据与缓存解耦,应用直接写数据到数据库中。数据库更新binlog日志,利用Canal中间件读取binlog日志。Canal借助于限流组件按频率将数据发到MQ中,应用监控MQ通道,将MQ的数据更新到Redis缓存中。

更新数据的时候,根据数据的唯一标识,将操作路由之后,发送到一个 jvm 内部队列中。读取数据的时候,如果发现数据不在缓存中,那么将重新执行“读取数据+更新缓存”的操作,根据唯一标识路由之后,也发送到同一个 jvm 内部队列中。该方案对于读请求进行了非常轻度的异步化,使用一定要注意读超时的问题,每个读请求必须在超时时间范围内返回。因此需要根据自己的业务情况进行测试,可能需要部署多个服务,每个服务分摊一些数据的更新操作。如果一个内存队列里居然会挤压 100 个业务数据的修改操作,每个操作操作要耗费 10ms 去完成,那么最后一个读请求,可能等待 10 * 100 = 1000ms = 1s 后,才能得到数据,这个时候就导致读请求的长时阻塞。

5 竞争并发

当系统的线上流量特别大的时候,缓存中会出现数据并发竞争的现象。在高并发的场景下,如果缓存数据正好过期,各个并发请求之间又没有任何协调动作,这样并发请求就会打到数据库,对数据造成较大的压力,严重的可能会导致缓存“雪崩”。另外高并发竞争也会导致数据不一致问题,例如多个redis客户端同时set同一个key时,key最开始的值是1,本来按顺序修改为2,3,4,最后是4,但是顺序变成了4,3,2,最后变成了2。

解决方案:

分布式锁+时间戳

可以基于redis或者zookeeper实现一个分布式锁,当一个key被高并发访问时,让请求去抢锁。也可以引入消息中间件,把Redis.set操作放在消息队列中。总之,将并行读写改成串行读写的方式,从而来避免资源竞争。对于key的操作的顺序性问题,可以通过设置一个时间戳来解决。大部分场景下,要写入缓存的数据都是从数据库中查询出来的。在数据写入数据库时,可以维护一个时间戳字段,这样数据被查询出来时都会带一个时间戳。写缓存的时候,可以判断一下当前数据的时间戳是否比缓存里的数据的时间戳要新,这样就避免了旧数据对新数据的覆盖。

6 热点Key问题

对于大多数互联网系统,数据是分冷热的,访问频率高的key被称为热key,比如热点新闻、热点的评论。而在突发事件发生时,瞬间会有大量用户去访问这个突发热点信息,这个突发热点信息所在的缓存节点由于超大流量而达到理网卡、带宽、CPU 的极限,从而导致缓存访问变慢、卡顿、甚至宕机。接下来数据请求到数据库,最终导致整个服务不可用。比如微博中数十万、数百万的用户同时去吃一个新瓜,秒杀、双11、618 、春节等线上促销活动,明星结婚、离婚、出轨这种特殊突发事件。

解决方案:

要解决这种极热 key 的问题,首先要找出这些 热key 。对于重要节假日、线上促销活动、凭借经验可以提前评估出可能的热 key 来。而对于突发事件,无法提前评估,可以通过 Spark或者Flink,进行流式计算,及时发现新发布的热点 key。而对于之前已发出的事情,逐步发酵成为热 key 的,则可以通过 Hadoop 进行离线跑批计算,找出最近历史数据中的高频热 key。还可以通过客户端进行统计或者上报。找到热 key 后,就有很多解决办法了。首先可以将这些热 key 进行分散处理。redis cluster有固定的16384个hash slot,对每个key计算CRC16值,然后对16384取模,可以获取key对应的hash slot。比如一个热 key 名字叫 hotkey,可以被分散为 hotkey#1、hotkey#2、hotkey#3,……hotkey#n,这 n 个 key 就会分散存在多个缓存节点,然后 client 端请求时,随机访问其中某个后缀的热key,这样就可以把热 key 的请求打散。

其次,也可以 key 的名字不变,对缓存提前进行多副本+多级结合的缓存架构设计。比如利用ehcache,或者一个HashMap都可以。在你发现热key以后,把热key加载到系统的JVM中,之后针对热key的请求,可以直接从jvm中获取数据。再次,如果热 key 较多,还可以通过监控体系对缓存的 SLA 实时监控,通过快速扩容来减少热 key 的冲击。

7 大Key问题

有些时候开发人员设计不合理,在缓存中会形成特别大的对象,这些大对象会导致数据迁移卡顿,另外在内存分配方面,如果一个key特别大,当需要扩容时,会一次性申请更大的一块内存,这也会导致卡顿。如果大对象被删除,内存会被一次性回收,卡顿现象会再次发生。在平时的业务开发中,要尽量避免大key的产生。如果发现系统的缓存大起大落,极有可能是大key引起的,这就需要开发人员定位出大key的来源,然后进行相关的业务代码重构。Redis官方已经提供了相关的指令进行大key的扫描,可以直接使用。

解决方案:

-

如果数据存在 Redis 中,比如业务数据存 set 格式,大 key 对应的 set 结构有几千几万个素,这种写入 Redis 时会消耗很长的时间,导致 Redis 卡顿。此时,可以扩展新的数据结构,同时让 client 在这些大 key 写缓存之前,进行序列化构建,然后通过 restore 一次性写入。

-

将大 key 分拆为多个 key,尽量减少大 key 的存在。同时由于大 key 一旦穿透到 DB,加载耗时很大,所以可以对这些大 key 进行特殊照顾,比如设置较长的过期时间,比如缓存内部在淘汰 key 时,同等条件下,尽量不淘汰这些大 key。

希望今天的讲解对大家有所帮助,谢谢!

Thanks for reading!

关注公众号,免费领学习资料

如果您觉得还不错,欢迎关注和转发~

作者:乔克

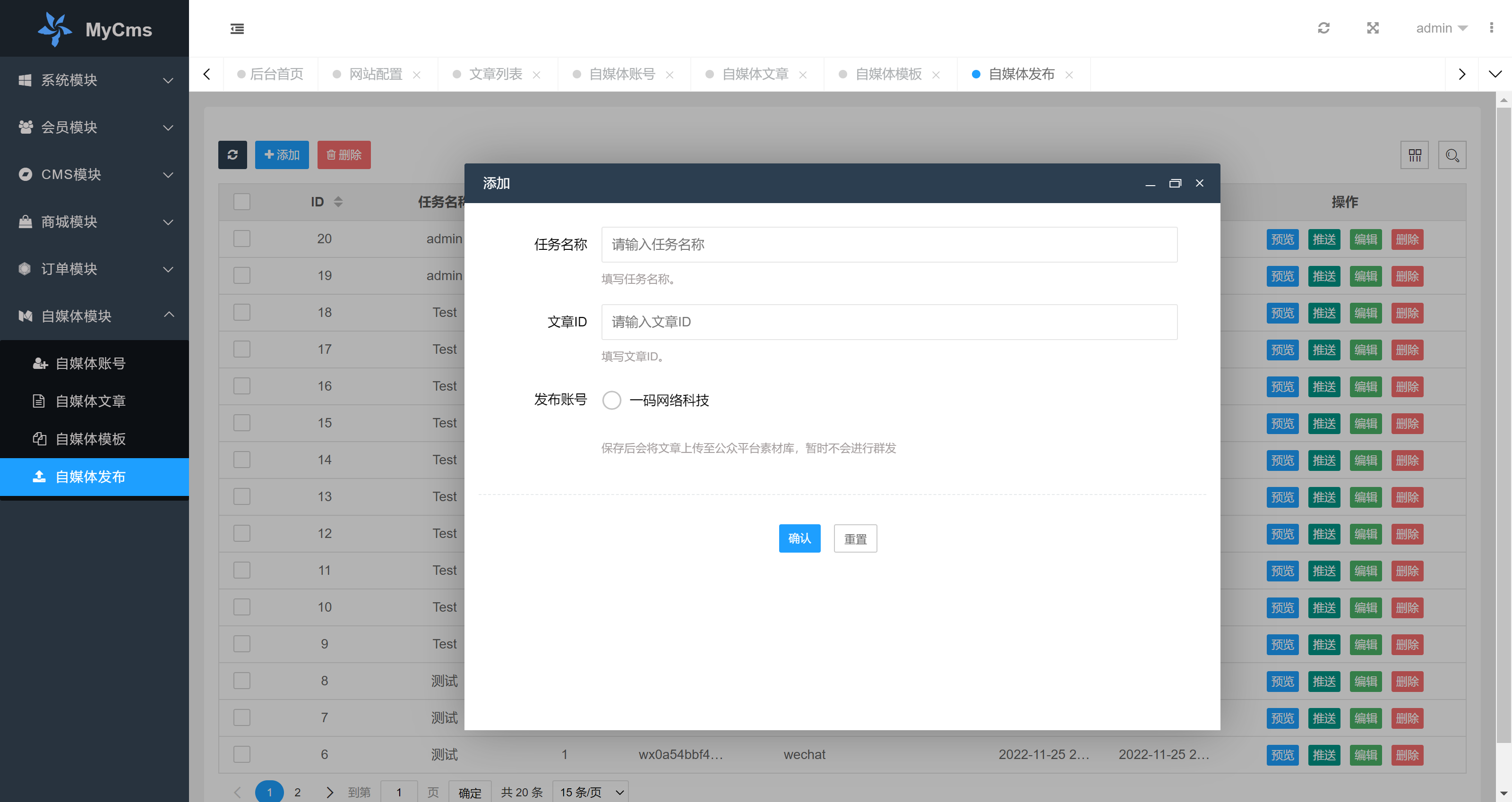

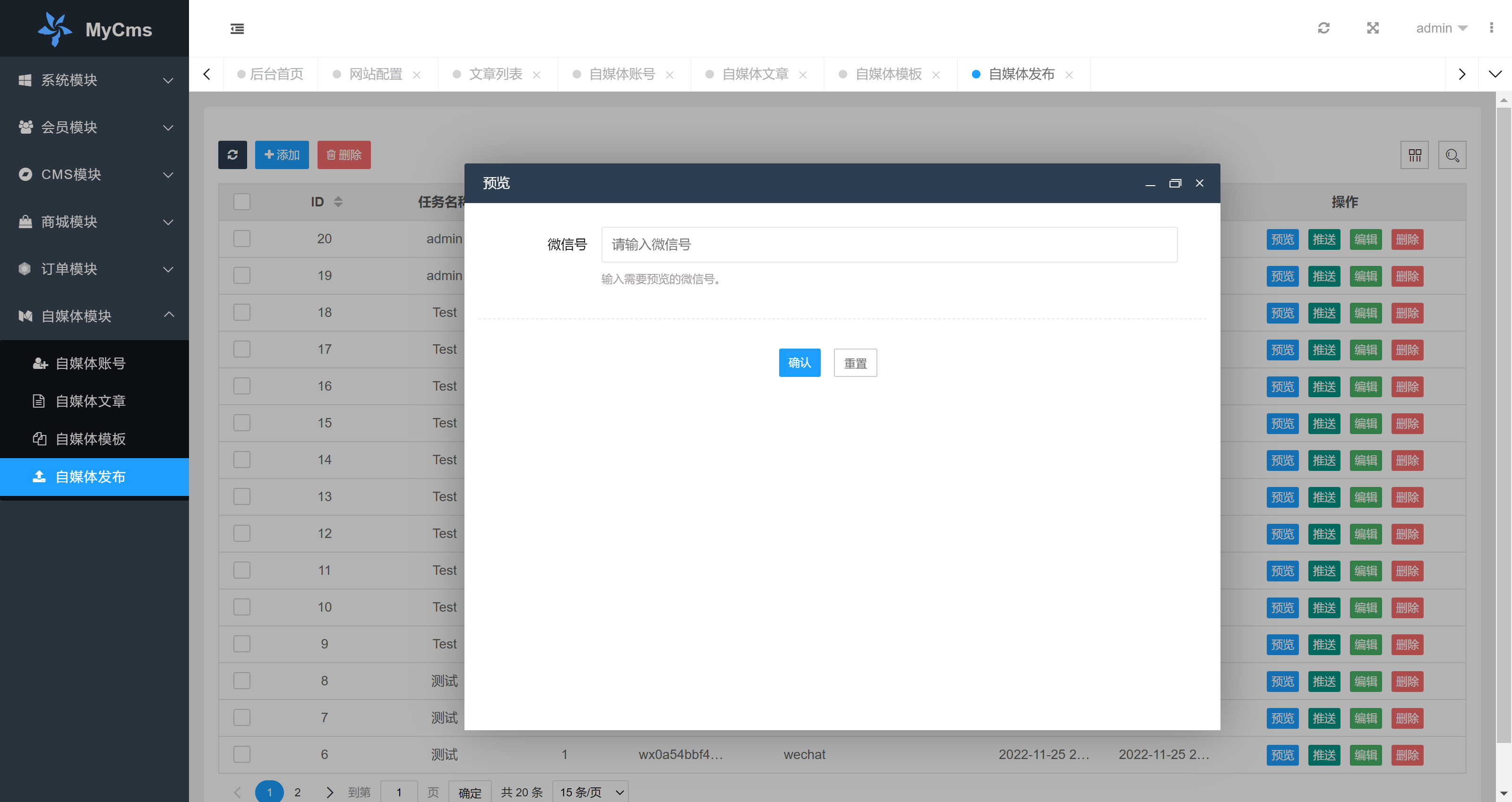

引言

自动化已经常态化,99% 的公司或多或少都实现了部分自动化功能,比如应用的打包部署、服务器的批量维护、自动化测试等。

在实际工作中,我基本完成了前端、后端、移动端的自动化,但是一直没有涉及到小程序,主要原因在于:

-

小程序的开发受限平台的开发工具。

-

在开发小程序过程中,编译以及部署,都是开发通过可视化开发工具实现。

-

小程序应用比较少,容易忽略。

这就导致在开发小程序过程中,构建发布程序到生产或测试环境的时候,都是开发人员手动操作,发布不同的环境可能需要切换不同的分支,这样不仅增加了重复性工作,也大大增加了出错的概率。

鉴于此,我们决定将小程序实现自动化,减少开发的工作量,提升工作效率。

工具介绍

要实现小程序的自动发布并不难,我们可以借助 miniprogram-ci 工具实现,在改工具之前,大佬们大都是自己开发各种自动化脚本,现在我们就不用那么麻烦了。

miniprogram-ci 是从微信开发工具中抽离的关于小程序/小游戏项目代码的编译模块,开发者可以不使用一些开发者工具,独立使用它就可以完成小程序代码的上传、预览等操作。其主要提供以下功能:

1. 上传代码,对应小程序开发者工具的上传。

2. 预览代码,对应小程序开发者工具的预览。

3. 构建 npm,对应小程序开发者工具的:菜单 – 工具 – 构建 npm。

4. 上传云开发云函数代码,对应小程序开发者工具的上传云函数能力。

5. 上传云托管代码,对应小程序开发者工具的上传云托管能力。

6. 上传云存储/静态托管文件,对应小程序开发者工具 – 云开发 – 云存储和静态托管文件管理。

7. 代理,配置 miniprogram-ci 的网络请求代理方式。

8. 支持获取最近上传版本的 sourceMap。

9. 支持 node 脚本调用方式和命令行调用方式。

前置工作

申请 APP ID

APP ID 是在微信后台申请,开发一般会提供。

制作构建镜像

要使用 miniprogram-ci ,需要我们安装该模块,安装命令如下:

为此,我们准备好具有 miniprogram-ci 命令的镜像。

然后制作镜像并推送到镜像仓库。

PS:根据实际情况选择 node 版本。

Zadig 配置

前置条件

-

拥有可用的 Zadig 服务,版本>=1.15.0

-

已经关联好代码仓库

开始配置

1、添加构建镜像

在 Zadig 的 系统配置 -> 构建镜像管理 处添加上面制作出来的构建镜像,如下:

2、创建项目

在 Zadig 中,选择 项目 -> 新建项目 ,添加一个小程序专属的项目,如下:

然后跳过向导,我们不需要环境,如下:

3、添加服务

添加服务的方式根据自己的情况来,不论是 YAML 项目还是 Helm Chart 项目,实际中我们都不会使用这些方式进行部署,随意选择就好,比如我这里选择的是 Helm Chart 项目。

之所以配置 Helm values,是为了让服务组件显示正常。

4、添加构建脚本

首先选择 构建环境 以及 代码信息 ,如下:

我们选择的是自定义的构建镜像。

然后添加一个构建变量,该变量的作用是设定推送机器人编号,我定义为 ROBOT_NUM,如下:

我选择的是枚举类型,定义了三个机器人代码(机器人可选 1 ~ 30),如下:

最后,我们编写构建脚本,如下:

注意:

-

我们是将小程序版本以及描述信息放在了 project.config.json 文件中,每个企业用法可能不一样。

-

我将小程序的密钥放在代码仓库的 secret 文件夹下。

然后保存构建退出。

5、添加工作流

现在,我们添加工作流进行应用发布,我这里选择的是自定义工作流,如下:

新增阶段,如下:

然后新增任务,选择构建,如下:

选择对应的服务组件,如下:

固定 ROBOT_NUM 参数(我们约定测试环境用机器人 1,生产环境用机器人 6),如下:

配置默认分支,测试环境用 test 分支,如下:

最后,配置触发器,实现开发将代码推送到对应分支,则自动触发流水线进行发布,如下:

然后保存退出即完成配置。

6、添加 IM 通知

IM 通知有助于团队小伙伴及时知道工作流的结果状态,不至于每次都需要在 Zadig 上查看,节约时间,提升效率。

选择工作流->配置->通知,如下:

填写具体的 IM 信息,配置完保存即可。

到这,执行工作流就可以在钉钉群里接收到工作流消息了。

7、测试

配置完成后,需要测试工作流是否正常。

首先进行手动测试。在工作流中选择对应的服务并执行,如下:

待流水线运行成功表示配置正常,如下:

再次进行 webhook 测试,我们需要在代码仓库更改代码并推送。

我在测试分支添加一个文件并推送,如下:

然后在 Zadig 上发现流水线正常被触发,如下:

不论是手动触发还是 webhook 触发,都能在钉钉群里接收到任务状态,如下:

到此我们完成了小程序测试环境的自动化,其他应用和环境相似操作即可。

最后

单纯想实现小程序自动化并不难,只要适配到企业本身的架构,使用哪种方式都可以,我们之所以选择 Zadig,主要还是因为其操作简单、使用便捷以及开发测试人员使用成本比较低。

目前我们已经将所有的发布工作都迁移到 Zadig 上了。

不过在使用自定义工作流配置小程序自动发布过程中,还是需要一些优化:

-

类似 App、小程序这种类型的应用,不属于 Helm、Yaml、主机类服务,在选择添加服务的时候容易产生混淆(虽然开发并不关心)

-

执行工作流的时候,默认是勾选了所有应用,当应用很多且不需要发布所有的时候,需要挨个去取消(个人觉得手动勾选比手动取消更容易接受)

整体使用上面没有太大的问题,小伙伴们在测试小程序自动发布的时候和我的可能有所区别,根据实际情况来做调整即可。

Zadig,开放,链接,专业。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

作者:郝建伟

k3s 简介

官方文档:k3s

什么是k3s

-

打包为单个二进制文件。

-

使用基于 sqlite3 的轻量级存储后端作为默认存储机制。同时支持使用 etcd3、MySQL 和 PostgreSQL 作为存储机制。

-

封装在简单的启动程序中,通过该启动程序处理很多复杂的 TLS 和选项。

-

默认情况下是安全的,对轻量级环境有合理的默认值。

-

添加了简单但功能强大的batteries-included功能,例如:本地存储提供程序,服务负载均衡器,Helm controller 和 Traefik Ingress controller。

-

所有 Kubernetes control-plane 组件的操作都封装在单个二进制文件和进程中,使 k3s 具有自动化和管理包括证书分发在内的复杂集群操作的能力。

-

最大程度减轻了外部依赖性,k3s 仅需要 kernel 和 cgroup 挂载。 k3s 软件包需要的依赖项包括:

为什么叫 k3s?

适用场景

k3s 适用于以下场景:

-

边缘计算-Edge

-

物联网-IoT

-

CI

-

Development

-

ARM

-

嵌入 k8s

架构介绍

单节点架构

高可用架构

-

k3s Server 节点:两个或更多的server节点将为 Kubernetes API 提供服务并运行其他 control-plane 服务

-

外部数据库:与单节点 k3s 设置中使用的嵌入式 SQLite 数据存储相反,高可用 k3s 需要挂载一个external database外部数据库作为数据存储的媒介。

k3s高可用架构:

固定 worker 节点的注册地址

如下图所示:

注册 worker 节点

自动部署的清单

k3s默认容器运行时

验证:

准备工作

关闭SELinux

关闭swap

设置主机名

离线安装

概述

离线安装的过程主要分为以下两个步骤:

步骤 1:部署镜像

步骤 2:安装 k3s

离线升级 k3s 版本: 完成离线安装 k3s 后,您还可以通过脚本升级 k3s 版本,或启用自动升级功能,以保持离线环境中的 k3s 版本与最新的 k3s 版本同步。

部署私有镜像仓库

前提条件

搭建参考Harbor安装

创建镜像仓库 YAML

手动部署镜像

前提条件

假设已经在离线环境中创建了节点。

这种方法需要您手动将必要的镜像部署到每个节点,适用于运行无法部署镜像仓库的边缘部署场景。

操作步骤

请按照以下步骤准备镜像目录和 k3s 二进制文件

-

从k3s GitHub Release页面获取你所运行的 k3s 版本的镜像 tar 文件。

-

将 tar 文件放在images目录下,例如:

-

将 k3s 二进制文件放在 /usr/local/bin/k3s路径下,并确保拥有可执行权限。完成后,现在可以转到下面的安装 k3s部分,开始安装 k3s。

安装 k3s

更多安装选项参考 安装选项介绍 | Rancher文档

前提条件

-

在安装 k3s 之前,完成上面的部署私有镜像仓库或手动部署镜像,导入安装 k3s 所需要的镜像。

-

从 release 页面下载 k3s 二进制文件,k3s 二进制文件需要与离线镜像的版本匹配。将二进制文件放在每个离线节点的 /usr/local/bin 中,并确保这个二进制文件是可执行的。

-

下载 k3s 安装脚本:https://get.k3s.io 。将安装脚本放在每个离线节点的任意地方,并命名为 install.sh。

当使用 INSTALL_K3S_SKIP_DOWNLOAD 环境变量运行 k3s 脚本时,k3s 将使用本地的脚本和二进制。

单节点安装

server节点

worker节点

注意:k3s 还为 kubelets 提供了一个–resolv-conf标志,这可能有助于在离线网络中配置 DNS

添加worker角色标签

kubectl命令行补全

高可用安装

需要调整安装命令,以便指定INSTALL_K3S_SKIP_DOWNLOAD=true并在本地运行安装脚本。您还将利用INSTALL_K3S_EXEC=’args’为 k3s 提供其他参数。

例如,使用外部数据库实现高可用安装指南的第二步提到了以下内容:

由于在离线环境中无法使用curl命令进行安装,所以您需要参考以下示例,将这条命令行修改为离线安装:

升级 k3s

通过脚本升级

离线环境的升级可以通过以下步骤完成:

-

从k3s GitHub Release页面下载要升级到的 k3s 版本。将 tar 文件放在每个节点的/var/lib/rancher/k3s/worker/images/目录下。删除旧的 tar 文件。

-

复制并替换每个节点上/usr/local/bin中的旧 k3s 二进制文件。复制https://get.k3s.io 的安装脚本(因为它可能在上次发布后发生了变化)。再次运行脚本。

-

重启 k3s 服务。

启用自动升级功能

除了可以通过脚本升级 k3s 以外,您还可以启用自动升级功能,以保持离线环境中的 k3s 版本与最新的 k3s 版本同步。

从 v1.17.4+k3s1 开始,k3s 支持自动升级。要在离线环境中启用此功能,您必须确保所需镜像在您的私有镜像仓库中可用。

-

你将需要与你打算升级到的 k3s 版本相对应的 rancher/k3s-upgrade 版本。

注意,镜像标签将 k3s 版本中的+替换为-,因为 Docker 镜像不支持+。

-

你还需要在你要部署的system-upgrad-controller manifestYAML 中指定的 system-upgrad-controller和kubectl的版本。

在这里检查 system-upgrad-controller 的最新版本,并下载 system-upgrad-controller.yaml来确定你需要推送到私有镜像仓库的版本。例如,在system-upgrade-controller的 v0.4.0 版本中,在 manifest YAML 中指定了这些镜像:

-

将必要的 rancher/k3s-upgrade、rancher/system-upgrade-controller 和 rancher/kubectl 镜像添加到您的私有镜像仓库中以后 ,就可以按照k3s 自动升级指南进行操作。

停止k3s

server节点停止k3s

worker节点停止k3s

卸载 k3s

卸载 k3s 会删除集群数据和所有脚本。

要使用不同的安装选项重新启动集群,请使用不同的标志重新运行安装脚本。

server 节点卸载 k3s

worker 节点卸载 k3s

Helm简介

Helm 是 Kubernetes 生态系统中的一个软件包管理工具。本文将介绍 Helm 中的相关概念和基本工作原理,并通过一个具体的示例学习如何使用 Helm 打包、分发、安装、升级及回退 Kubernetes 应用。

Kubernetes 应用部署的挑战

Kubernetes 是一个提供了基于容器的应用集群管理解决方案,Kubernetes 为容器化应用提供了部署运行、资源调度、服务发现和动态伸缩等一系列完整功能。

Kubernetes 的核心设计理念是: 用户定义要部署的应用程序的规则,而 Kubernetes 则负责按照定义的规则部署并运行应用程序。如果应用程序出现问题导致偏离了定义的规格,Kubernetes 负责对其进行自动修正。例如:定义的应用规则要求部署两个实例(Pod),其中一个实例异常终止了,Kubernetes 会检查到并重新启动一个新的实例。

用户通过使用 Kubernetes API 对象来描述应用程序规则,包括 Pod、Service、Volume、Namespace、ReplicaSet、Deployment、Job等等。一般这些资源对象的定义需要写入一系列的 YAML 文件中,然后通过 Kubernetes 命令行工具 Kubectl 调 Kubernetes API 进行部署。

以一个典型的三层应用 WordPress 为例,该应用程序就涉及到多个 Kubernetes API 对象,而要描述这些 Kubernetes API 对象就可能要同时维护多个 YAML 文件。

从上图可以看到,在进行 Kubernetes 软件部署时,我们面临下述几个问题:

-

如何管理、编辑和更新这些这些分散的 Kubernetes 应用配置文件。

-

如何把一套相关的配置文件作为一个应用进行管理。

-

如何分发和重用 Kubernetes 的应用配置。

Helm 的出现就是为了很好地解决上面这些问题。

Helm 是什么?

Helm 是Deis开发的一个用于 Kubernetes 应用的包管理工具,主要用来管理 Charts。有点类似于 Ubuntu 中的 APT 或 CentOS 中的 YUM。

Helm Chart 是用来封装 Kubernetes 原生应用程序的一系列 YAML 文件。可以在你部署应用的时候自定义应用程序的一些 Metadata,以便于应用程序的分发。

对于应用发布者而言,可以通过 Helm 打包应用、管理应用依赖关系、管理应用版本并发布应用到软件仓库。

对于使用者而言,使用 Helm 后不用需要编写复杂的应用部署文件,可以以简单的方式在 Kubernetes 上查找、安装、升级、回滚、卸载应用程序。

Helm 组件及相关术语

- Helm

Helm 是一个命令行下的客户端工具。主要用于 Kubernetes 应用程序 Chart 的创建、打包、发布以及创建和管理本地和远程的 Chart 仓库。

- Tiller

Tiller 是 Helm 的服务端,部署在 Kubernetes 集群中。Tiller 用于接收 Helm 的请求,并根据 Chart 生成 Kubernetes 的部署文件( Helm 称为 Release ),然后提交给 Kubernetes 创建应用。Tiller 还提供了 Release 的升级、删除、回滚等一系列功能。

- Chart

Helm 的软件包,采用 TAR 格式。类似于 APT 的 DEB 包或者 YUM 的 RPM 包,其包含了一组定义 Kubernetes 资源相关的 YAML 文件。

- Repoistory

Helm 的软件仓库,Repository 本质上是一个 Web 服务器,该服务器保存了一系列的 Chart 软件包以供用户下载,并且提供了一个该 Repository 的 Chart 包的清单文件以供查询。Helm 可以同时管理多个不同的 Repository。

- Release

使用命令在 Kubernetes 集群中部署的 Chart 称为 Release。

注:需要注意的是:Helm 中提到的 Release 和我们通常概念中的版本有所不同,这里的 Release 可以理解为 Helm 使用 Chart 包部署的一个应用实例。

Helm 工作原理

这张图描述了 Helm 的几个关键组件 Helm(客户端)、Tiller(服务器)、Repository(Chart 软件仓库)、Chart(软件包)之间的关系。

Chart Install 过程

-

Helm 从指定的目录或者 TAR 文件中解析出 Chart 结构信息。

-

Helm 将指定的 Chart 结构和 Values 信息通过 gRPC 传递给 Tiller。

-

Tiller 根据 Chart 和 Values 生成一个 Release。

-

Tiller 将 Release 发送给 Kubernetes 用于生成 Release。

Chart Update 过程

-

Helm 从指定的目录或者 TAR 文件中解析出 Chart 结构信息。

-

Helm 将需要更新的 Release 的名称、Chart 结构和 Values 信息传递给 Tiller。

-

Tiller 生成 Release 并更新指定名称的 Release 的 History。

-

Tiller 将 Release 发送给 Kubernetes 用于更新 Release。

Chart Rollback 过程

-

Helm 将要回滚的 Release 的名称传递给 Tiller。

-

Tiller 根据 Release 的名称查找 History。

-

Tiller 从 History 中获取上一个 Release。

-

Tiller 将上一个 Release 发送给 Kubernetes 用于替换当前 Release。

Chart 处理依赖说明

Tiller 在处理 Chart 时,直接将 Chart 以及其依赖的所有 Charts 合并为一个 Release,同时传递给 Kubernetes。因此 Tiller 并不负责管理依赖之间的启动顺序。Chart 中的应用需要能够自行处理依赖关系。

部署 Helm

安装 Helm 客户端

Helm 的安装方式很多,这里采用二进制的方式安装。更多安装方法可以参考 Helm 的官方帮助文档。

- 使用官方提供的脚本一键安装

- 手动下载二进制包安装

Tiller 是以 Deployment 方式部署在 Kubernetes 集群中的,只需使用以下指令便可简单的完成安装。

注:storage.googleapis.com默认是不能访问的,该问题请自行解决。如果不清楚是否能访问,当你把这行命令cp linux-amd64/helm /usr/local/bin/完,看一下是否都是ok的

由于 Helm 默认会去storage.googleapis.com拉取镜像,如果你当前执行的机器不能访问该域名的话可以使用以下命令来安装:

接下来查看状态

上图可看出:现在,已经能够查看到服务器的版本信息了,部署完成

后面下载包会报错,是因为从 Kubernetes 1.6 版本开始,API Server 启用了 RBAC 授权。目前的 Tiller 部署时默认没有定义授权的 ServiceAccount,这会导致访问 API Server 时被拒绝。所以我们需要明确为 Tiller 部署添加授权。

生成.kube配置

安装NFS

部署说明

Kubernetes网络文件系统,主要用于ES、Kafka、Minio等持久化存储。

nfs搭建

配置共享目录

部署Pod遇到的问题

Helm部署Chart时报错

部署 nfs pod时报错

Pod拉取镜像超时报错

常用命令行

kubectl命令

node的标签操作

ctr 命令使用

containerd 相比于docker , 多了namespace概念, 每个image和container 都会在各自的namespace下可见

ctr,crictl,docker命令对比

crictl 命令使用

配置containerd镜像加速

其他命令:

几种Containerd常用命令对比

作者:毛辰飞

背景

在mysql中设计表的时候,mysql官方推荐不要使用uuid或者不连续不重复的雪花id(long形且唯一),而是推荐连续自增的主键id,官方的推荐是auto_increment,那么为什么不建议采用uuid,使用uuid究竟有什么坏处?今天我们就来分析这个问题,探讨一下内部的原因。

数据展示

user_auto_key,user_uuid,user_random_key,分别表示自动增长的主键,uuid作为主键,随机key作为主键,其它我们完全保持不变。根据控制变量法,我们只把每个表的主键使用不同的策略生成,而其他的字段完全一样,然后测试一下表的插入速度和查询速度:

注:这里的随机key其实是指用雪花算法算出来的前后不连续不重复无规律的id:一串18位长度的long值

可以看出在数据量100W左右的时候,uuid的插入效率垫底,并且在后续增加了130W的数据,uuid的时间又直线下降。

时间占用量总体可以打出的效率排名为:auto_key>random_key>uuid,uuid的效率最低,在数据量较大的情况下,效率直线下滑。

原因分析

对比一下mysql关于两者索引的使用情况.

自增的主键的值是顺序的,所以Innodb把每一条记录都存储在一条记录的后面。当达到页面的最大填充因子时候(innodb默认的最大填充因子是页大小的15/16,会留出1/16的空间留作以后的修改):

①下一条记录就会写入新的页中,一旦数据按照这种顺序的方式加载,主键页就会近乎于顺序的记录填满,提升了页面的最大填充率,不会有页的浪费

②新插入的行一定会在原有的最大数据行下一行,mysql定位和寻址很快,不会为计算新行的位置而做出额外的消耗

③减少了页分裂和碎片的产生

因为uuid相对顺序的自增id来说是毫无规律可言的,新行的值不一定要比之前的主键的值要大,所以innodb无法做到总是把新行插入到索引的最后,而是需要为新行寻找新的合适的位置从而来分配新的空间。这个过程需要做很多额外的操作,数据的毫无顺序会导致数据分布散乱,将会导致以下的问题:

①:写入的目标页很可能已经刷新到磁盘上并且从缓存上移除,或者还没有被加载到缓存中,innodb在插入之前不得不先找到并从磁盘读取目标页到内存中,这将导致大量的随机IO

②:因为写入是乱序的,innodb不得不频繁的做页分裂操作,以便为新的行分配空间,页分裂导致移动大量的数据,一次插入最少需要修改三个页以上

③:由于频繁的页分裂,页会变得稀疏并被不规则的填充,最终会导致数据会有碎片

在把随机值(uuid和雪花id)载入到聚簇索引(innodb默认的索引类型)以后,有时候会需要做一次OPTIMEIZE TABLE来重建表并优化页的填充,这将又需要一定的时间消耗。

自增ID的缺点:

那么使用自增的id就完全没有坏处了吗?并不是,自增id也会存在以下几点问题:

①. 别人一旦爬取你的数据库,就可以根据数据库的自增id获取到你的业务增长信息,很容易分析出你的经营情况

②. 对于高并发的负载,innodb在按主键进行插入的时候会造成明显的锁争用,主键的上界会成为争抢的热点,因为所有的插入都发生在这里,并发插入会导致间隙锁竞争

③. Auto_Increment锁机制会造成自增锁的抢夺,有一定的性能损失

TIS整合ChunJun实操

B站视频:

https://www.bilibili.com/video/BV1QM411z7w5/?spm_id_from=333.999.0.0

一、ChunJun 概述

ChunJun是一款易用、稳定、高效的批流统一的数据集成框架,可基于实时计算引擎Flink实现多种异构数据源之间的数据同步与计算,既可以采集静态的数据,比如MySQL,HDFS等,也可以采集实时变化的数据,比如Binlog,Kafka等。

目前的核心功能包括:

· 多源异构数据汇聚

作为一个开放式系统,用户可以根据需要开发新的插件,接入新的数据库类型,也可以使用内置的数据库插件。目前兼容30+异构数据源的数据读写与SQL计算。

· 断点续传

针对网络波动等异常情况,导致数据同步失败的任务,在下一次任务时自动从上一次失败的数据点进行数据同步,避免全部重跑。

· 数据还原

除了DML操作以外,一些源端数据库的DDL操作也能做到同步,最大程度保证源端数据库和目标端数据库的数据统一和结构统一,做到数据还原。

· 脏数据管理

数据传输过程中,因数据质量或主键约束等其他因素导致数据无法同步到目标数据库,针对这些脏数据进行统计和管理,便于后续进行脏数据分析。

· 速率控制

数据同步过程中,数据传输效率是关键。ChunJun针对各种场景,有的放矢地控制速率,最大程度保证数据同步的正常进行。

更多详见:

Github:https://github.com/DTStack/chunjun

Gitee:https://gitee.com/dtstack_dev_0/chunjun

官网:https://dtstack.github.io/chunjun/

ChunJun架构:

二、TIS 概述

TIS最早是基于Solr为用户提供一站式开箱即用、自助服务的搜索引擎中台产品。在2020年之前,当Flink和MPP引擎还没有形成影响力时 ,TIS就已经在为互联网企业内部提供实时OLAP分析需求的服务。

为满足大数据业务需求,快速将工具栈进行整合。TIS从2019年底开始转型,开始全方位支持现有实时数仓中台,从原先与搜索引擎强耦合的技术架构进行重构。从只处理搜索引擎一个场景,兼容到所有数据端的大数据生态场景。

经过TIS开发者的努力,现在的TIS内部有一套强大的数据管理系统,根据用户需求大部分的工作脚本可自动生成(TIS是基于模型的DataOps,区别于市面上其他基于脚本任务的DevOps系统,摒弃掉所有繁琐的脚本操作),等到任务所需资源准备好,用户轻点数据系统就开始运行。

另外更为关键的是,TIS能够将专业大数据技术人员和大数据分析师这两种角色解耦。一个实时数仓中台,使用它的人并不需要了解里面的技术细节,并不需要知道Flink、Hive、Hadoop的技术细节,只要知道他们是干什么的就行。基于以上,TIS改造之初并没有针对实时数仓进行编码,而是花了将近一年时间对TIS产品底座进行构建,着重进行了以下几方面的构建:

插件仓库/热生效机制

现有行业中提供的工具栈,需要在后台系统中自行部署,TIS则简化了这一流程,TIS在构建项目之时会统一将第三方的依赖包进行打包,预先部署到远端仓库中,用户在TIS中可以查看到可用插件清单。在使用时,只需鼠标下载且热生效就可使用,操作体验流畅。

全流程建模

针对ETL的各流程进行建模,将可变因素进行抽象,抽取成一个TIS系统中的扩展点,统一归档到TIS的主工程中,在主工程中没有任何具体业务代码的实现,这样在进行具体业务逻辑实现中就不需要更改任何主工程的代码,在架构层面最大限度地贯彻了OCP原则。

例如以下是对ETL中,针对结构化(支持JDBC接口)和非结构化数据源的执行流程图:

构建UI-DSL系统

随着整合进TIS的功能组件越来越多,需要单独开发的UI工作量巨大且风格难以统一,大量重新代码维护困难,同时由于行业分工精细化,流程需要前后端工程师相互协作,导致开发效率低,如何让没有前端开发经验的后端开发工程师,能够独立且畅快地完成一个UI组件的开发,成为一个重要的课题。为解决这个问题,TIS在底座中实现了一个UI-DSL的系统,后端开发工程师使用JAVA语言编写一个表单对应的MetaData脚本,里面定义表单的布局,输入项的校验等信息,运行期会自动将MetaData脚本渲染成前端的表单,从而完美解决这个课题。

DataSourceFactory.json

三、整合 ChunJun 完善 TIS 生态

经过几个月时间的研发,TIS V3.6.0-alpha版本终于发布了。该版本的最大亮点,即整合了大数据领域数据同步工具的翘楚ChunJun,将TIS的业务能力提升到了新高度。

TIS的最新版本:

https://github.com/qlangtech/tis/releases/tag/v3.6.0-alpha

早在 V3.6.0-alpha之前,TIS已经整合了Alibaba DataX和 Flink-CDC。离线批量同步利用DataX组件实现,而在实时数据变更Source组件方面,TIS是基于Flink-CDC来实现的。至于Sink部分,则一直是基于各种数据端提供的生态API包经过二次开发完成的。

其中存在的问题是,开发周期长,调试困难,例如,仅仅为了实现StarRocks一个Sink端实现一个基于StreamFunction的Sink实现,连开发带测试花去了整整三个星期的时间。

直到整合ChunJun之后才解决了这些问题。ChunJun已经很好地支持了大数据领域的大部分数据端,包括Source和Sink。它的Source端基于Polling轮询机制来实现,相较与Flink CDC实现的Source端是有自己的特色的。

例如,并不是所有的端都支持类似MySQL binlog这样的实时同步机制,即使支持类似Oracle的LogMiner,如需开启,也需要专业Oracle DBA协助,不然设置权限就会吓退很多用户。而基于Polling机制的实时更新订阅却可以支持所有的Source端,只要实现了JDBC接口就行。

所以ChunJun的Source端通用性非常好,比之于Flink CDC的唯一劣势是实时性要低,不过一般在大部份OLAP的场景下用户对实时性的要求并没有那么高,所以一般情况下推荐使用ChunJun的Source来监听实时数据变更。

另外,ChunJun的Sink端实现也是一大特色,一般情况下数据端的生态产品中会提供Flink Sink的实现,例如:ElasticSearch的Flink官网提供了一个基于SinkFunction的实现,StarRocks在官网也提供了Sink实现。但是各家实现方式各不相同,没有一个统一的抽象模型。另外各厂商提供的实现中基本上只是一些半成品,像容灾、监控等都没有提供,导致TIS在整合各家Sink端时着实花了不少精力且很难做得完美。

因此在 TIS v3.6.0 中利用 ChunJun v1.12.5 全面改写了TIS原有的Sink端实现,由于ChunJun实现是一个封装好并且已经在生产环境中经过检验的,并且在实现方式上已经通过统一建模,每种端的接入方式可以统一,对TIS来说大大提高了整合开发效率,而且将容灾、监控、脏数据管理也一并实现。

ChunJun支持的Connector端非常丰富,TIS v3.6.0 中只是拣取了几个用户高频使用的端来封装,其他端的封装会在后续版本中逐步实现。以下是 v3.6.0版本中实现的端类型:

四、TIS 是如何整合 ChunJun

利用 TIS数据管理系统接管 ChunJun流数据类型控制

ChunJun 流处理中构建的RowData实例是通过目标端Jdbc MetaData自动生成的(用户不需要在JSON配置文件中设置),内部需要通过目标端(Source/Sink)字段JDBC中的数据信息的fieldType作为参数来映射 flink的DataType实例,调用的接口是com.dtstack.chunjun.converter.RawTypeConverter,

在实际处理过程中发现,仅仅利用 JDBC col metaDatafieldType作为参数还是不够, 例如:MySQL的表定义为bigint,int,smallint的整型,当用户添加unsigned修饰,bigint在Flink中的映射类型需要从BigIntType变成DataTypes.DECIMAL,原smallint类型需要变成IntType,不然执行就会出错。另外像 Oracle的Jdbc内部实现了一套区别于Jdbc标准的类型规范oracle.jdbc.OracleTypes,当得到Oracle的类型之后需要归一化成Jdbc的类型java.sql.Types,不然没法正常执行。

类型映射虽然很简单,但由于Java是强类型语言,在流处理执行过程中稍有不慎就会出现ClassCastException,所以得格外小心地处理,因此TIS在ChunJun中引入了一个新的类型抽象com.qlangtech.tis.plugin.ds.ColMeta来封装Jdbc MetaData的列信息,在具体执行过程中可以更加细腻地控制Flink 内部的列类型。

取代基于JSON配置驱动的任务变为基于数据模型驱动任务

有了TIS底层数据关系管理的支持,数据同步任务定义的大部分工作可以自动生成,用户只需要做一些辅助工作,例如,用户需要导入一个张表,表有10列,用户需要做的是辅助确认:对于Source端确认表主键,Polling策略的轮询间隔时间及轮询列名,对于Sink端选取Insert的插入策略,这些都只需要鼠标就能完成,页面UI中的显示逻辑和ChunJun的规则相一致。

为ChunJun添加新的TIS扩展点

想要在 v3.6.0 版本顺利地将ChunJun Connector整合进TIS,需要添加两个功能扩展点,一是为增量Source端表的属性设置com.qlangtech.tis.plugins.incr.flink.chunjun.source.SelectedTabPropsExtends,二是为Sink端表的属性设置com.qlangtech.tis.plugins.incr.flink.chunjun.sink.SinkTabPropsExtends

五、开源共建,繁荣生态

TIS的构建理念是坚决避免重复造轮子,必须站在行业的巨人的肩膀上,做大数据行业中优秀工具栈的粘合剂。TIS V3.6.0alpha 有幸能按时发布,得益于行业中有像ChunJun、DataX、Flink-CDC、Flink这样优秀的开源项目存在 ,使得TIS整体可靠性得到保障。特别要感谢Apache Flink,提供了一个强大的实时计算生态,Flink CDC、ChunJun和TIS都是生长在这个生态中的茁壮成长的小树苗,每个项目都专注于自己擅长的领域,且相互补充。

临近发布,发现一个很有意思的使用场景,那就是用户可以选择基于Flink-CDC的MySQL Source插件来监听MySQL 表的增量变更,将数据同步到以 ChunJun 构建的 Sink中去,这样的混搭使用方式给用户带来了更多的选择自由度,也避免了在Flink-CDC和ChunJun各自的框架内部重复造轮子从而造成生态内卷。

六、拥抱CloudNative

云原生(CloudNative)时代的到来为我们描绘了一副美好的画卷,对于终端用户来说提供了低成本、可靠的IT基础服务,可以专注于业务开发,这非常好。

但对于互联网技术从业者来说,似乎有隐忧,那就是互联网红利将会被阿里云这样的云厂商通吃,小厂商只有干瞪眼的份,那我们煞费苦心构建的像TIS这样的开源项目在云时代还有用武之地吗?其实这样的担心是多余的。

一个健康的生态,必须要保证生物多样性,生态中各个物种并不是独立,他们之间存在相互依存的关系。同样在大数据生态中如果只有像阿里云、亚马逊这样互联网大厂活得很滋润,并且构成了一个人才黑洞,把其他小厂的资源全部吸干了,想必这样的生态也不可能长远。

从本质来说,促成任何个人或组织之间的合作都有一个前提,那就是存在比较优势,就如同瞎子背瘸子相互协助前行,国家之间的合作也是,中国具有廉价劳动力和广阔的市场与发达国家的技术优势进行互补,这种合作是可持续的。

云大厂可以把昂贵的互联网基础设置,用集约化采购的规模优势大大地降低成本,然后用技术手段将这些设备云化成IAAS服务提供给客户,小厂技术具有灵活高效与较低的技术人员薪资成本优势,以这种优势在IAAS之上构建PAAS服务,类似任务调度,实时数仓非常合适。国外也已经有成功的案例,比如Snowflake提供的云原生实时数仓和亚马逊等云厂商之间的合作,有同学肯定会问:”为啥亚马逊不能自己搞一个像snowflake呢?”,其实答案前面已经提到。

想了解或咨询更多有关袋鼠云大数据产品、行业解决方案、客户案例的朋友,浏览袋鼠云官网:https://www.dtstack.com/?src=szkyzg

添加【小袋鼠:dtstack001】入qun,免费获取大数据&开源干货

同时,欢迎对大数据开源项目有兴趣的同学加入「袋鼠云开源框架钉钉技术qun」,交流最新开源技术信息,qun号码:,项目地址:https://github.com/DTStack

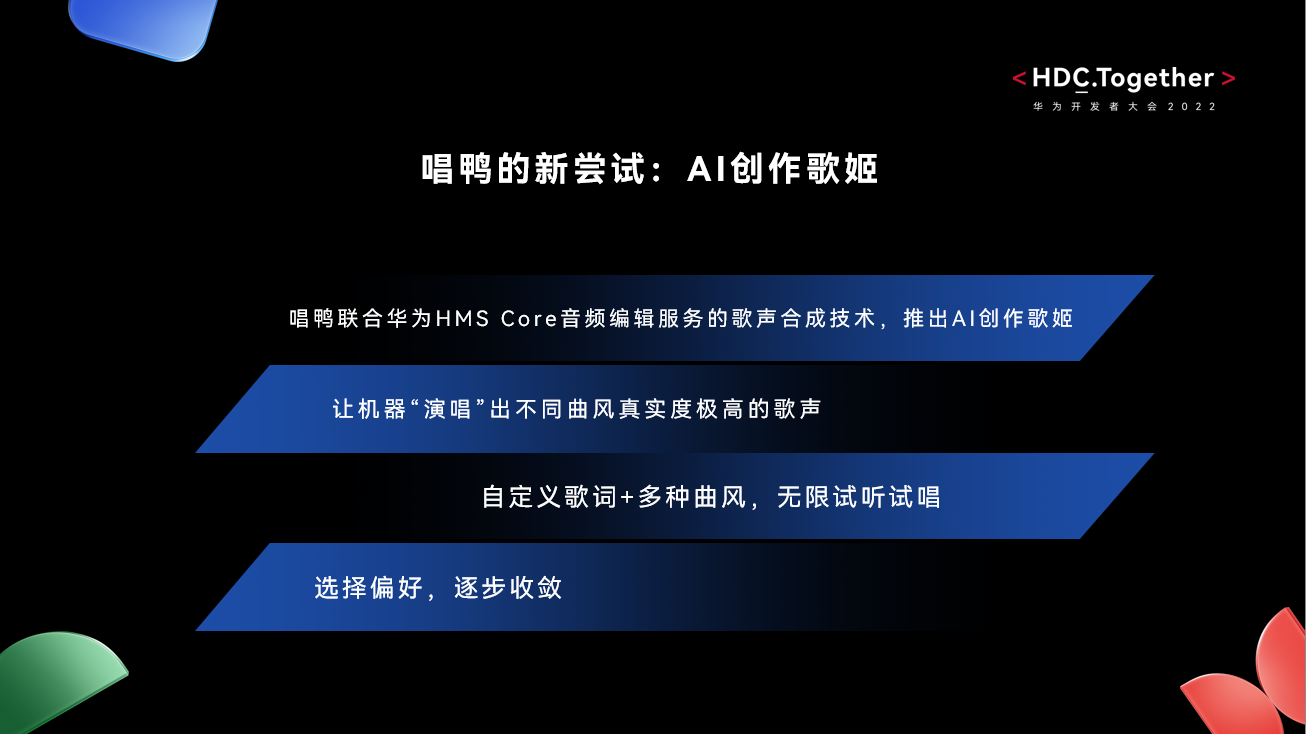

从录音带、MP3到专业的耳机、音箱,随着音乐消费方式的不断升级,音乐创作的专业“门槛”也在AI技术的加持下逐渐大众化,创作者的创新设计、创作频率也在持续增强,能降低创作门槛且智能化的创作工具就显得尤为重要。

怀揣着“人人都能玩点音乐”的初衷,唱鸭搭建了自己的音乐社区,希望为普通用户提供智能有趣的音乐“玩法”。唱鸭是一款将乐器和曲谱标记融合的新型弹唱软件,用户通过 App内的图标提醒,不需要乐器知识,就可以轻松实现创作、弹唱音乐,降低了非专业音乐人“玩音乐”的难度。

在华为开发者大会2022(Together)智慧AI技术论坛中,唱鸭作为一款作为深受用户喜爱的音乐社区软件,讲述为满足用户不断增强的创意设计,如何与HMS Core音频编辑服务合作,打造更具创意的音乐“玩法”。11月5日唱鸭正式推出,由HMS Core音频编辑服务歌声合成技术打造的“AI创作歌姬”功能。基于华为独创的AI Singer模型,歌声合成可以精准预测颤音、扰动和换气声等演唱技巧,让拟真的呼吸音与歌曲节奏完美契合,实现歌手级的高水准演唱,给用户带来了令人惊喜的新奇体验,释放更具创意的音乐创作力。

用户选择“AI创作歌姬”后,只需输入歌词,选择喜欢的音乐风格,就会自动生成动听的歌曲,并通过细腻自然、情感充沛的歌声演唱出来。在演唱节奏方面,“AI创作歌姬”实现了歌词和曲谱在“字”级别的对齐,提升了演唱自然度和节奏准确性。

唱鸭创始人李阳说到:“与HMS Core音频编辑服务的合作后,唱鸭让用户能够通过简单地输入歌词即可合成歌声,轻松完成各种类型的演唱,让没有专业学习音乐的人也能够享受到音乐互动的乐趣。AI技术赋能提升了我们的用户体验,也助力了唱鸭的业务创新。”

HMS Core音频编辑服务提供的歌声合成能力还可广泛应用于音视频创意制作、影音娱乐、音乐教育、虚拟偶像等领域。例如,在短视频或音乐创作中为用户提供歌词歌曲合成、演唱等能力,激发更多创作灵感;或是为虚拟偶像选择独特音色,使其形象更加生动逼真;或是设定为不同情景的参考声音,提高音频制作效率。

未来,HMS Core将为音乐创作者,提供更高效智能、新奇有趣的音乐“玩法”。让灵感,成就创作,真正实现“让每一个人都成为音乐家!”的愿景。

Data Catalog 通过汇总技术和业务数据,解决大数据生产者组织梳理数据、数据消费者找数和理解数的业务场景。本篇内容源自于火山引擎大数据研发治理套件 DataLeap 中的 Data Catalog 功能模块的实践,主要介绍 Data Catalog 在公有云部署和发布中遇到挑战及解决方案。

背景

-

Data Catalog 是一种数据管理的服务,会收集技术数据,并在其基础上提供更丰富的业务上下文与语义,通常支持数据编目、查找、详情浏览等功能。目前 Data Catalog 作为火山引擎大数据研发治理套件 DataLeap 产品的核心功能之一,经过多年打磨,服务于字节跳动内部几乎所有核心业务线,解决了数据生产者和消费者对于数据和资产管理的各项核心需求。

-

DataLeap 作为一站式数据中台套件,汇集了字节内部多年积累的数据集成、开发、运维、治理、资产、安全等全套数据中台建设的经验,助力 ToB 市场客户提升数据研发治理效率、降低管理成本。

-

Data Catalog 作为 DataLeap 的核心功能之一,本文汇集了 Data Catalog 团队在最近一年公有云从 0 到 1 实践的整体经验,主要讲解遇到的各项挑战和对应的解决方案。

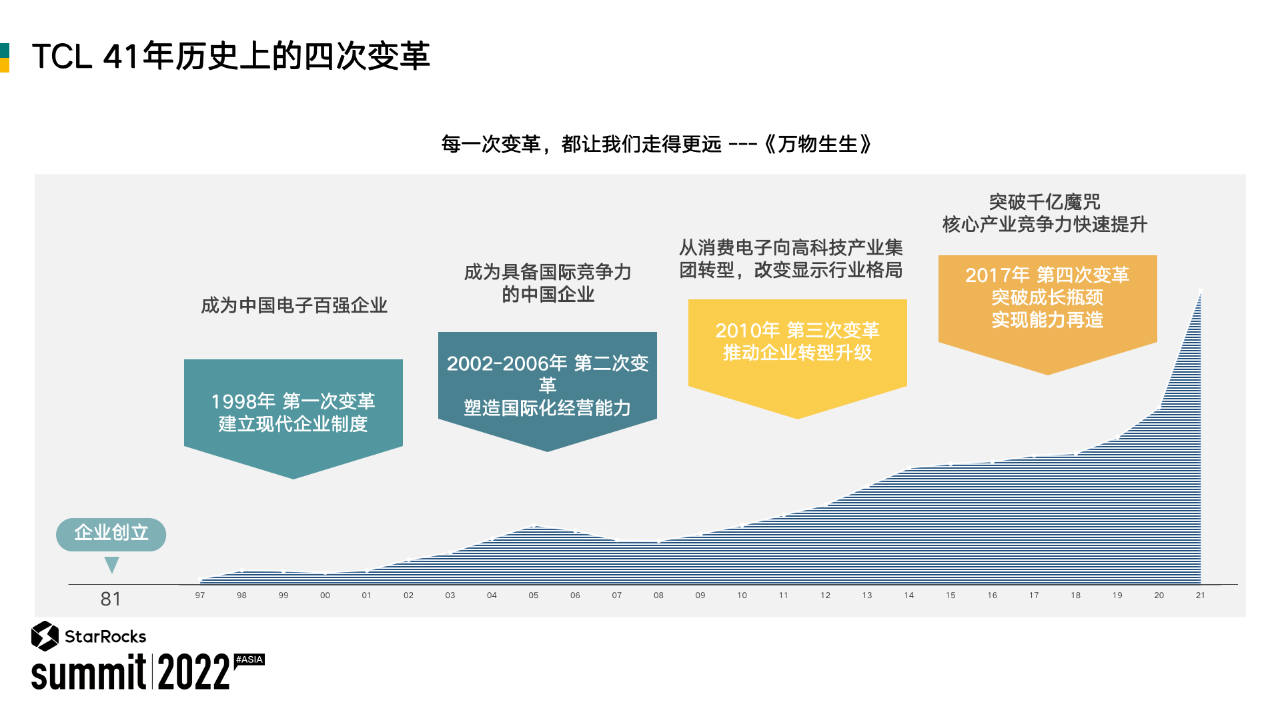

Data Catalog 公有云发展历程

Data Catalog 已经随着 DataLeap 一起作为公有云产品正式在火山引擎对外发布,下面是 Data Catalog 在功能演进上的一些重要时间节点:

-

2021 年 9 月,Data Catalog 随着 DataLeap 完成在火山引擎公有云首个版本部署和发布,包含 60%内部核心功能,支持 EMR Hive 数据源数据管理。

-

2022 年 2 月,Data Catalog 随着 DataLeap 完成火山引擎公有云 Beta 版本发布,吸引了一批客户试用。

-

2022 年 5 月,Data Catalog 随着 DataLeap 完成火山引擎公有云 GA 版本发布,正式对外开放。

-

2021 年 9 月至 2022 年 5 月,Data Catalog 发布 10+版本,对齐 95%内部核心功能以及发布新功能 20+,包括支持 LAS/ByteHouse 数据源、OpenAPI 和数据采集等 ToB 场景新特性。

Data Catalog 公有云整体架构

Data Catalog 支持综合搜索、血缘分析、库表管理、数据采集、备注问答、专题管理、OpenAPI 等功能,和 DataLeap 其他功能模块(如数据开发、数据集成、数据质量、数据安全等)一起提供了大数据研发和治理场景的一站式解决方案。同时,Data Catalog 公有云产品是基于火山引擎提供的数据引擎和云基础设施来部署和服务的,下面会简单介绍下我们所依赖和使用的产品和服务:

-

数据引擎:是火山引擎提供的数据分析、数据仓库和数据湖相关产品,包括 ByteHouse/EMR/LAS 等产品。通常 Data Catalog 会从这类系统内采集并存储数据,进行处理加工后,再提供搜索、血缘分析等功能;另外,库表管理模块也会依赖这类系统提供对应的接口来做建库建表等操作。

-

内部公共服务:是火山引擎为支持公司内部产品上公有云提供的若干公共基础服务,主要作用是方便内部产品能快速在公有云部署,提供和公司内部兼容性比较高的公共服务,降低改造和迁移成本。其中 Data Catalog 使用较多的包括:API 网关、网络代理、访问控制、安全认证、监控报警等。

-

基础服务:这类服务或产品相较于上面说的内部公共服务主要区别是,他们是火山引擎对外售卖的标准云服务,内外部用户都可使用,且和业界主流云厂商能力是基本对齐的,不过会和公司内部一些类似的基础服务会有不少差异。Data Catalog 主要使用这类基础服务来进行自身服务的部署运维,并且进行较多的兼容性改造,包括容器部署、网络打通、内外部 CICD 和监控报警流程一致性等方面。

-

数据库和中间件:是和业界主流云厂商对齐的存储和中间件领域的标准云服务,和公司内部对应组件也会有若干差异,Data Catalog 为此也做了多版本的兼容。Data Catalog 在数据存储上使用到了 Hbase/MySQL/ES/Redis,然后在数据采集和同步场景使用了 Kafka,同时用到了日志服务来提高研发运维效率。

Data Catalog 公有云遇到的挑战

Data Catalog 经历了一个从 0 到 1 在火山引擎公有云部署并逐步优化和迭代发布 10+版本的过程,在这个过程中经历不少挑战,下面将介绍其中比较典型的问题以及我们探索并实践的一些解决方案。

网络和数据安全

为保证网络安全和多租户数据安全,火山引擎上公有云产品部署的环境划分为“公共服务区”和“售卖区”,同时售卖区又分割为若干私有网络(即 VPC),然后公共服务区和售卖区以及售卖区的 VPC 之间都是网络隔离的。

Data Catalog 会依赖一些内部公共服务,这类服务通常都部署在公共服务区,而按照网络和数据安全规范,Data Catalog 作为独立云产品需要部署在售卖区独立 VPC 内,类似的情况 Data Catalog 依赖的数据中台产品也需部署在独立 VPC 内,例如 EMR、LAS 和 Bytehouse。另外,Data Catalog 对外会提供 OpenAPI,外部客户可以通过火山引擎的 API 网关来访问这些 API,但 API 网关服务是在公共服务区,无法直接访问到 Data Catalog 服务,基于以上情况,为了正常对外提供服务,我们需要解决网络隔离问题同时还要保证安全性。

解决方案:

服务部署:为了能够在售卖区部署,经过调研我们选择火山引擎提供的容器服务(VKE)和负载均衡(CLB)来进行基础服务部署和构建,其中 CLB 提供四层负载均衡能力,容器服务是高性能 Kubernetes 容器集群管理服务。Data Catalog 基于容器服务提供的无状态负载(Deployment)、定时任务(CronJob)、服务(Service)等云原生容器管理功能进行基本服务和调度任务部署,同时也使用火山引擎的存储和中间件,以上组件均在同一个 VPC 内,能够保证网络连通以及数据安全。

-

网络打通:为解决上文所说的网络隔离问题,经过调研我们使用了公司通用的网络代理服务(PLB/Shuttle),该网络代理可做到网络打通的同时保证四层网络流量的安全,从而达到我们和各依赖方如公共服务(API 网关、IAM 等、独立部署的云服务(EMR/LAS 等)的网络连通目标。

-

数据安全:火山引擎部署环境做网络隔离,主要是保证安全性,我们虽然使用网络代理打通网络,但是仍需保证各个环节的安全性,考虑到服务间交互都是通过 HTTP 请求,我们对和外部交互的接口都增加了 SSL 和双向认证的机制,同时在安全认证方面,我们没有使用 Nginx 或 Java 原生的方案,而是借助于火山引擎内部安全服务中的 ZTI 团队的 envoy 组件来实现,同时使用 sidecar 模式和我们后端服务容器集成部署,既降低了服务端部署改造成本,也解耦了服务端业务逻辑和安全认证逻辑。

多租户适配

这里先对多租户相关概念做一些解释:

-

租户:一个客户、公司、个人开通或购买了火山引擎的云产品,火山引擎就会通知对应的服务提供者,对应云产品会感知到他的开通,这个客户就是这个云产品的一个租户,实际场景可以类比于一个公司是一个租户,不同的公司是不同的租户。

-

多租户服务:云服务要为多个租户提供服务,需要做到租户隔离,保证各租户的访问控制、数据、服务响应等各方面的使用都是隔离的,彼此互不感知互不影响的。要做到租户隔离,就需要云服务能通过逻辑或物理隔离的方式来将各租户对应数据和访问隔离开来,避免互相影响。

此前,在字节跳动内部实践中不存在多租户场景,所以面向公有云用户服务时,Data Catalog 针对支持多租户服务的能力,需要进行专门适配。

解决方案:

Data Catalog 在数据存储层借用了 Apache Atlas 的设计与实现。Atlas 的底层使用 JanusGraph 做图引擎,JanusGraph 是基于 Gremlin 图查询语义实现的计算引擎,而社区版 Atlas 不支持多租户场景。我们通过在 Atlas 上增加 JanusGraph Partition Strategy 适配,实现存储层租户逻辑隔离。

参考以上示例,JanusGraph 的 Partition Strategy 可以支持设置的 read/write Partition 的 value,并保证只读/写指定 Partition 的数据,从而达到数据隔离,我们将租户信息和 Partition Strategy 相结合,实现了多租户场景下读写数据的逻辑隔离,保证了数据安全性。

内外部功能一致

Data Catalog 在字节跳动内部已打磨多年,产品形态和技术架构比较成熟,但随着公有云部署和 ToB 产品迭代,因内部外基础服务差异和 ToB 引入新的使用场景和上下游组件导致内外部产品功能和技术实现的差异也越来越多。

在前几个版本中,我们尝试使用独立的代码分支和版本来支持 ToB 功能,避免内部新功能对 ToB 产生影响,但我们发现随着版本差异越来越大,代码和功能的合并和兼容就变得非常困难,在其中一次整体代码合并时,出现了好几千的文件 diff 和上百处 merge conflict,我们花费了一周时间多的时间合并代码和进行多环境测试回归验证,最终完成了合并。功能和代码的不一致已经成为影响研发效率和需求交付进度的很重要因素,必须要进行优化。

解决方案:

我们主要从产品功能和代码版本两方面来处理内外部一致性问题:

产品功能

-

产品功能的标准化:原则上所有功能都应做到内外部一致,只允许部分功能点的实现区别。我们期望能将各功能都进行标准化,基础模块和通用能力(如数据模型、搜索、血缘)原则上需保持内外一致,内外部依赖或需求场景差异较大的功能(如数据接入和采集、库表管理)改造为标准化流程,将差异部分尽量减小,做到只通过配置、插件、版本控制工具等方式就能适配,减少研发和运维成本。

-

明确的一致性规划:从模块到功能点逐个对比内部外实现情况,制定长期 roadmap,明确差异点的支持排期,并提高对齐内部功能的工作优先级,逐步减少差异。

-

新功能的兼容性:新功能的设计需考虑内外部一致性,包括产品的交互和研发的技术方案都需考虑外部场景并明确兼容方案,原则上对特殊场景定制化功能都需考虑通用场景适配,尽量保持多环境的兼容性。

技术实现

-

统一的代码分支管理规范:原则上内外部的代码是一致的即统一的分支。具体来说,不管域内外功能都需兼容多环境并在多环境验证才能合并代码,外部如公有云在发版周期中会基于内部主分支代码(如 master 分支)创建一个新的 release-x.x.x 分支,进行回归验证和公有云上线,同时线上持续使用 release-x.x.x 分支以保证线上环境稳定,release-x.x.x 分支需定期合回主分支。新的版本会继续基于主分支开发,并持续保持该规范。

-

明确的发版规划:根据实际情况,内部通常迭代比较敏捷发版频率较快,而外部通常要求稳定性,会定期发版(如每月一个版本),考虑到发版周期的差异,我们会以外部固定周期为标准,细粒度控制需求评估、功能开发、QA 测试、回归测试等各环节所在时间段,明确封板时间,降低内外部互相影响。

-

一致性意识和自动化多环境验证:通过多轮分享和培训在技术团队内部对齐一致性意识,清楚内外部差异点 FAQ 等,另外,如上所说新功能技术设计方案需明确多环境兼容性。同时,引入自动化的多环境验证环节,尽早发现不兼容或不一致的问题,减少人工判断和测试的成本。

OpenAPI

在 DataLeap Beta 版本发布之后,有内外部客户在试用,当时就有客户提出 OpenAPI 的需求,但在 Beta 版本我们还未支持 OpenAPI。公司内部有 OpenAPI 规范和平台,Data Catalog 也借助相关平台实现了内部的 OpenAPI,但是 ToB 场景的公共平台不同且会遇到 ToB 场景特定的问题(如安全认证、多租户、API 开通计费等),需要综合考虑来对外提供解决方案。

解决方案:

如前文介绍,火山引擎内部公共服务有 API 网关的通用服务(TOP),并有若干 API 发布规范,Data Catalog 调研了该 API 网关并解决以上核心问题来支持 ToB OpenAPI。以下介绍一下主要流程和关注点:

API 管理

-

Data Catalog 借助于 API 网关管理 OpenAPI,包括注册和开通、访问控制、限流等。

-

API 规范:火山引擎 OpenAPI 有明确的参数规范,Data Catalog 也需符合该规范,但因内部 OpenAPI 参数格式不同,需做兼容,考虑到新 API 的支持成本,借助于 Spring 的 Interceptor 和 Advice 以及定制 JSON 序列化和反序列化逻辑,实现了自动的参数格式转化,降低 API 格式兼容的开发成本。

-

访问控制:火山引擎作为云服务提供商,使用业界规范的 AKSK 密钥管理规范,API 使用者需创建 AKSK 并通过该信息来访问 API 才可通过访问控制,而 API 网关会通过 IAM 进行鉴权,通过后会给服务提供者也就是 API 注册者透传用户的身份(如租户 ID,用户 ID),方便 API 提供者使用。

-

安全认证:处理 API 网关提供的基础鉴权,Data Catalog 也增加了更多机制来保障安全性,包括双向认证、租户开通状态检测等。

-

API 文档:对于每一个 OpenAPI 都根据火山引擎规范编写了详细的参数说明,汇总为一个正式 API 文档,方便用户查阅使用。

API 请求流程

-

用户或服务通过 AKSK 访问 API,或者通过前端控制台间接访问 API。

-

API 网关通过 IAM 进行鉴权,将识别到的用户身份通过 HTTP header 透传给服务提供者。

-

服务提供者接收到请求并通过 HTTP header 获取用户身份,进行下一步处理。

总结

火山引擎 Data Catalog 产品是基于字节跳动内部平台,经过多年打磨业务场景和产品能力,在公有云进行部署和发布,期望帮忙更多外部客户创造数据价值。目前公有云产品已包含内部成熟的产品功能同时扩展若干 ToB 核心功能,正在逐步对齐业界领先 Data Catalog 云产品各项能力。

文中提及的内容其实还有继续优化的空间,以及随着客户的使用,还有面临一些新的问题,包括多租户性能优化、服务稳定性保障等,我们都在持续探索和解决,期望能更好的支持 ToB 客户的业务诉求并实现商业价值的同时,提供优质稳定的服务和丰富的扩展能力。

跳转火山引擎大数据研发治理套件DataLeap了解更多

值得信赖

为什么使用

桌面软件(办公方向、 个人工具),仍然是未来十几年 PC 端需求之一,提高工作效率

electron 技术是流行趋势,百度翻译、阿里网盘、迅雷、有道云笔记 ……

ee 框架使用 b(浏览器)s(主进程)s(远程后端服务)开发思想

前端、服务端同学都能快速入门

愿景

所有开发者都能学会桌面软件研发

简单

只需懂 JavaScript

开源

gitee:https://gitee.com/wallace5303/electron-egg 2200+

github:https://github.com/wallace5303/electron-egg 500+

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

腾讯 APIJSON 生态项目 SQLAuto 1.1.0 更新内容:

- 新增回归测试完继续深度测试等功能;

- 新增 Headless 模式 Node 环境无 UI 测试;

- 自动生成文档:解决不显示数据字典,解决名称不是原始的表名;

具体见 Release 发布版本。

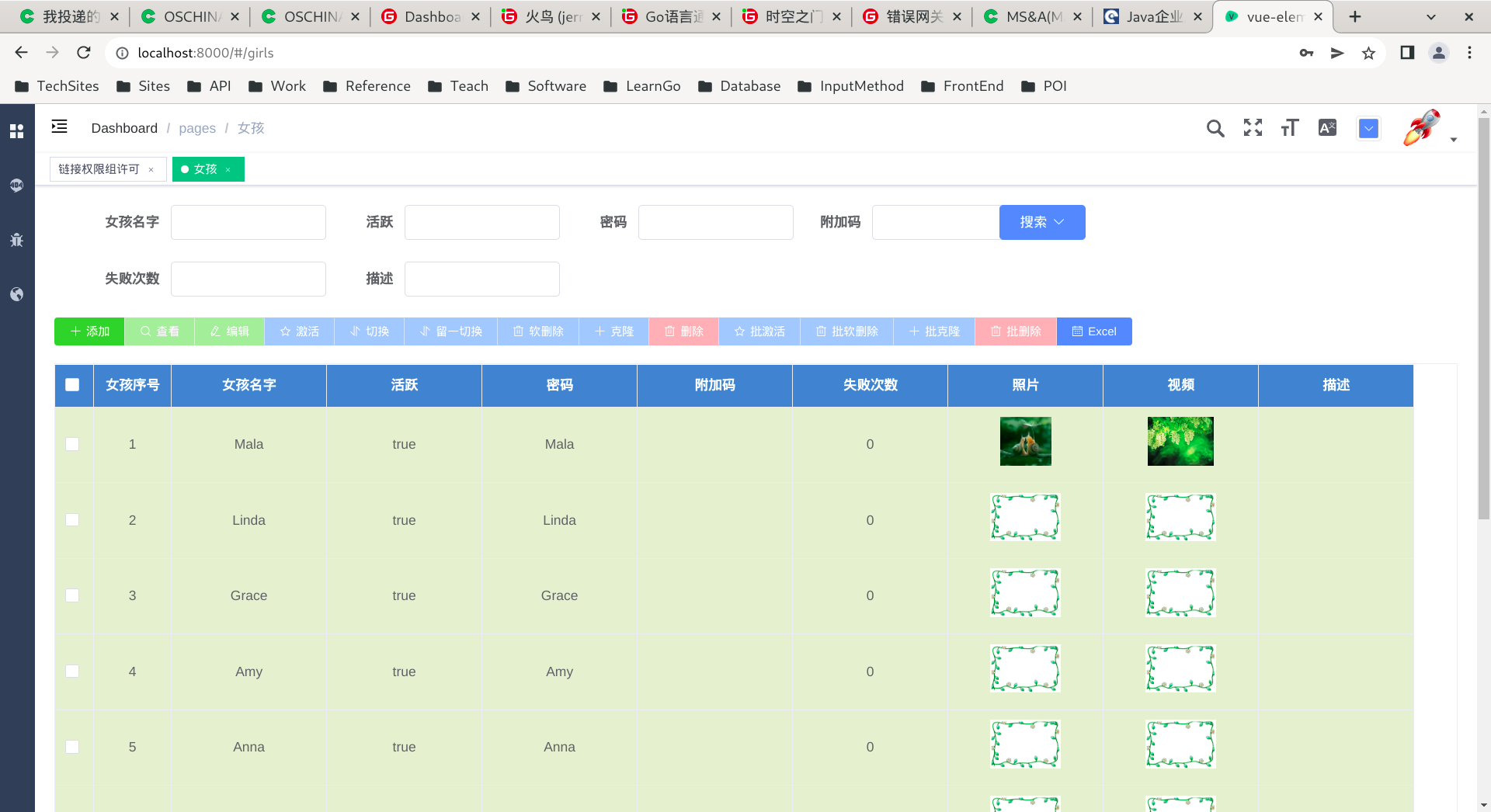

SQLAuto-智能零代码数据库功能测试工具

☔ 智能零代码测试 SQL、任意增删改查、任意 SQL 模板变量、一键批量生成

本项目前端工具是基于 APIAuto 改造的纯静态 SPA 网页,下载源码解压直接浏览器打开。

后端需要部署 APIJSON-Demo 5.2.5+ 的 APIJSONBoot-MultiDataSource。

感谢开源

- jsonon

- editor.md

- vue.js

技术交流

关于作者

如果有什么问题或建议可以 提ISSUE,交流技术,分享经验。

如果你解决了某些bug,或者新增了一些功能,欢迎 贡献代码,感激不尽。

其它项目

APIJSON 腾讯零代码、全功能、强安全 ORM 库 🏆 后端接口和文档零代码,前端(客户端) 定制返回 JSON 的数据和结构

APIAuto 敏捷开发最强大易用的 HTTP 接口工具,机器学习零代码测试、生成代码与静态检查、生成文档与光标悬浮注释

UnitAuto 机器学习单测试平台,零代码、全方位、自动化 测试 方法/函数 的正确性和可用性

APIJSON.NET C# 版 APIJSON ,支持 MySQL, PostgreSQL, SQL Server, Oracle, SQLite

apijson-go Go 版 APIJSON ,支持单表查询、数组查询、多表一对一关联查询、多表一对多关联查询 等

apijson-hyperf PHP 版 APIJSON,基于 Hyperf 支持 MySQL

apijson-node Node.ts 版 APIJSON,提供 nestjs 和 typeorm 的 Demo,由字节跳动工程师开发

uliweb-apijson Python 版 APIJSON,支持 MySQL, PostgreSQL, SQL Server, Oracle, SQLite 等

apijson-practice BAT 技术专家开源的 APIJSON 参数校验注解 Library 及相关 Demo

Android-ZBLibrary Android MVP 快速开发框架,Demo 全面,注释详细,使用简单,代码严谨

我要赞赏

创作不易,右上角点 ⭐Star 支持下本项目吧,谢谢 ^_^

https://github.com/TommyLemon/SQLAuto

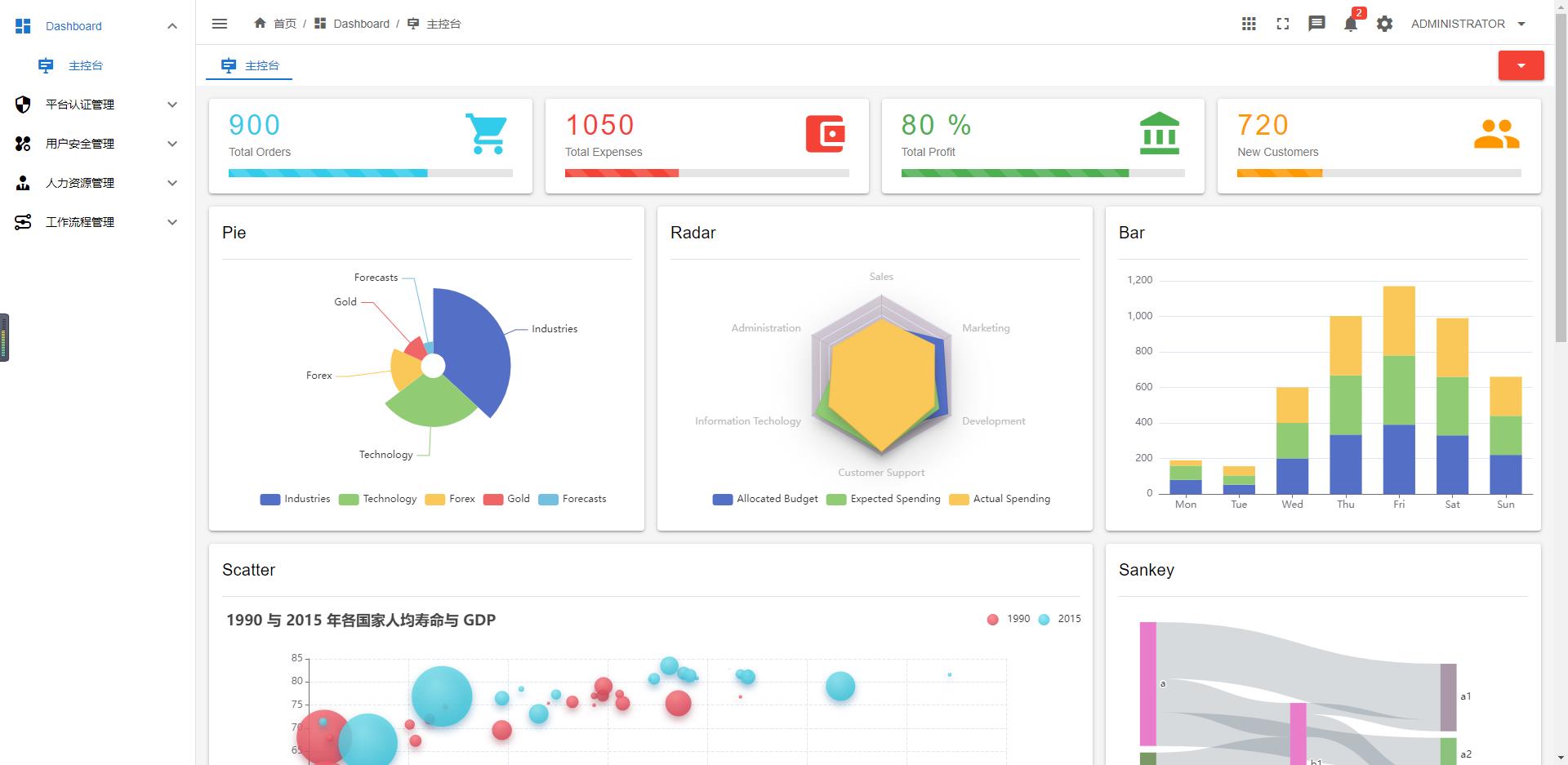

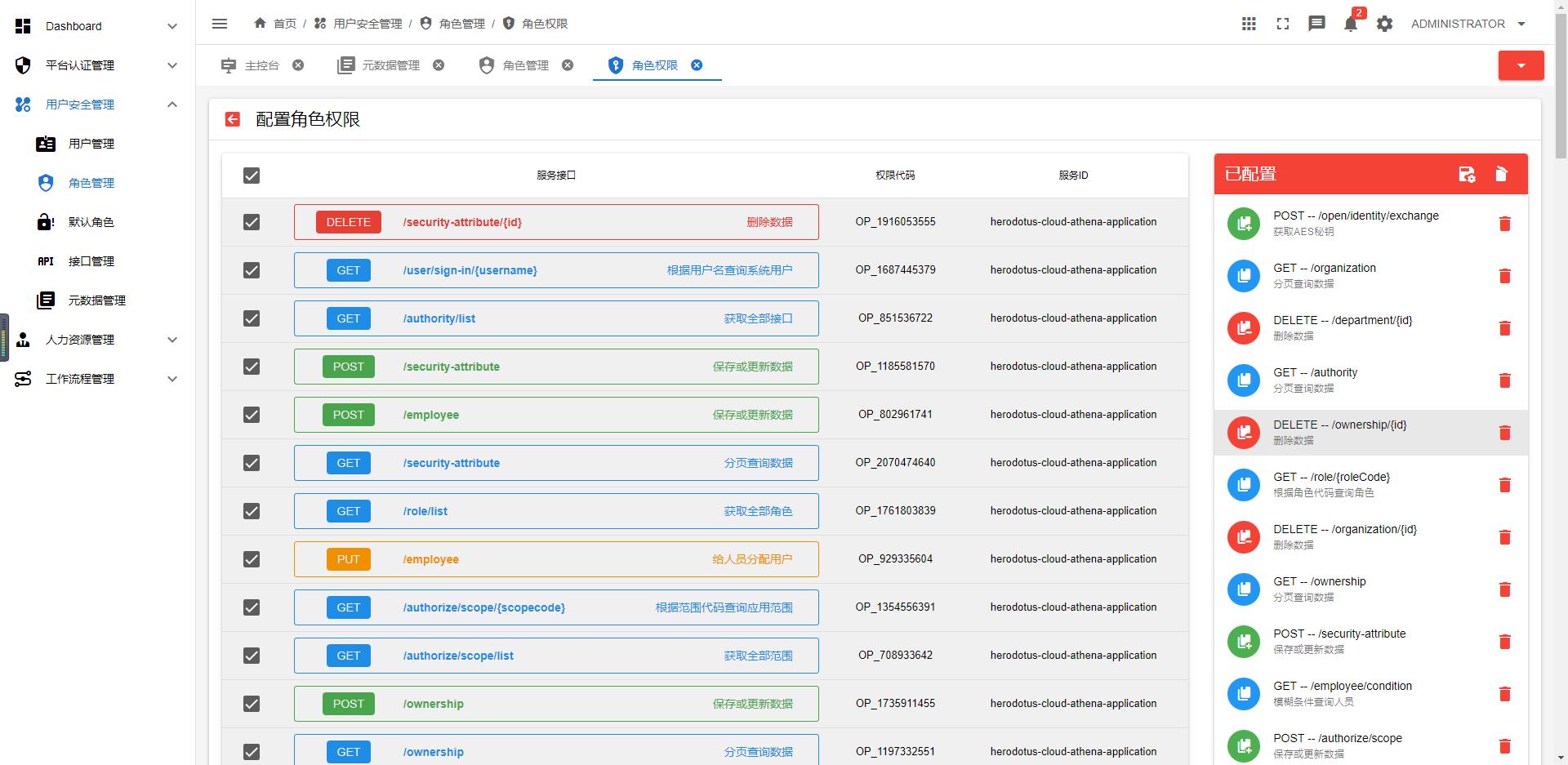

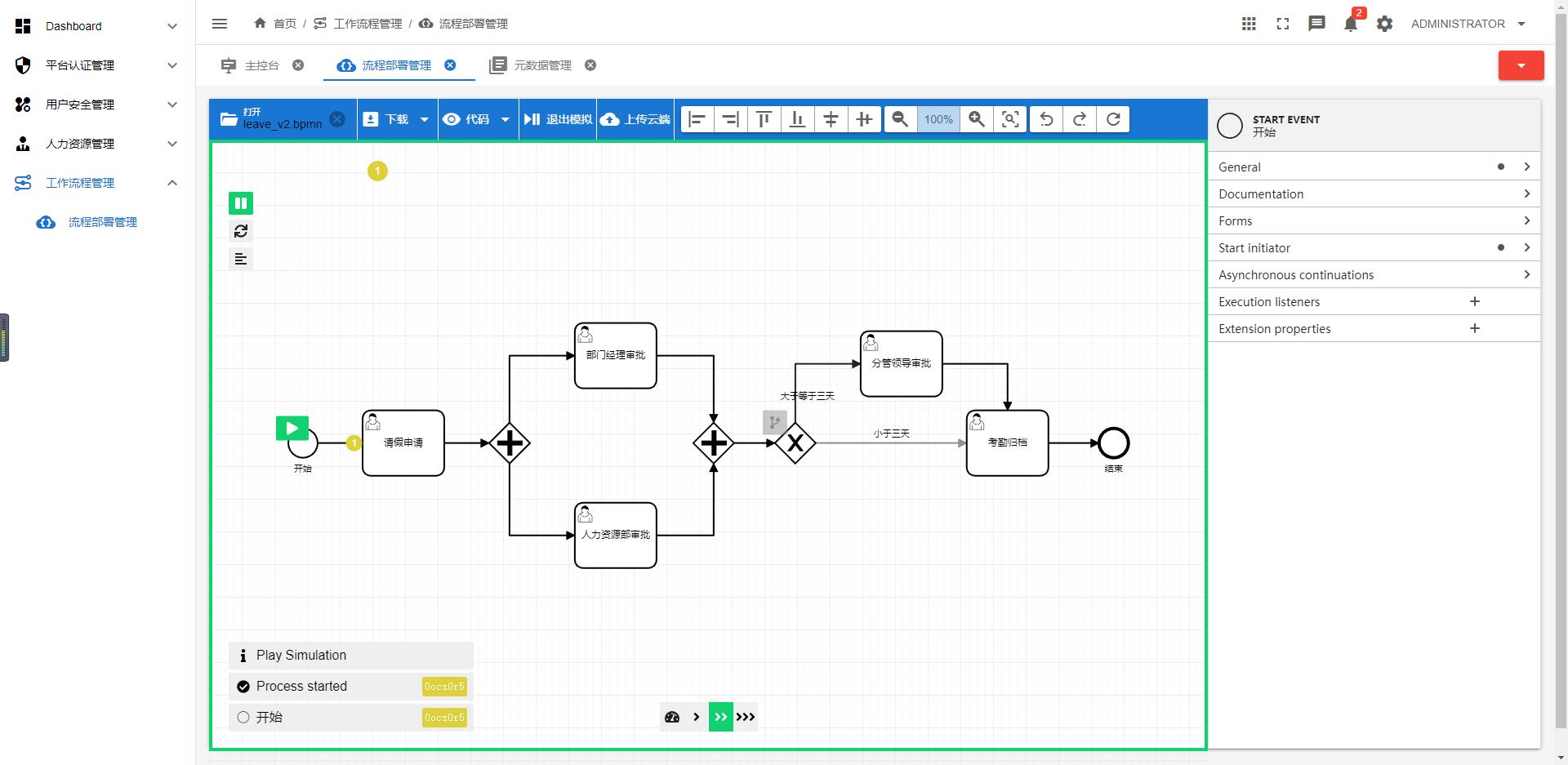

OMP平台(Operation Management Platform)是云智慧公司自主设计、研发的轻量级、聚合型、智能运维管理平台。是一款为用户提供便捷运维能力和业务管理的综合平台。具备纳管、部署、监控、巡检、自愈、备份、恢复等功能。在提高运维人员等工作效率的同时,也提升了业务的连续性和安全性。

更新内容:

[新增] 主题配置 – 菜单配置 – 菜单分组。

[新增] 主题配置 – 菜单配置 – 侧边分栏 与 顶部分栏 选项。

[新增] 菜单数据 type 属性,model 与 blank 可选值, 菜单项支持弹层打开外部链接。

[新增] 工作空间 – 控制台新增选项卡案例。

[新增] 选项卡 工具栏, 增加关闭当前,关闭全部,关闭其他。

[修复] 选项卡切换,导致页面状态重置的问题。

[修复] 选项卡 在 router 刷新后不存在的问题。

[修复] echarts 图表在切换标签后,变为空白。

[修复] 顶部菜单前景色为白色的问题。

[优化] 移动端布局兼容,更好的适配 768px 下的设备。

[优化] 顶部菜单项 hover 效果。

[集成] npm run build 打包分析, 支持报告打印。

[升级] layui-vue 1.7.10。

详细内容:

本次的重要更新,我们新增了分栏布局,并且支持在顶部 或 侧边显示。

你可以通过主题配置页面来切换两种不同的分栏布局,或直接关闭分栏模式使用传统的布局方式。

更多详情:https://gitee.com/layui-vue/layui-vue-admin

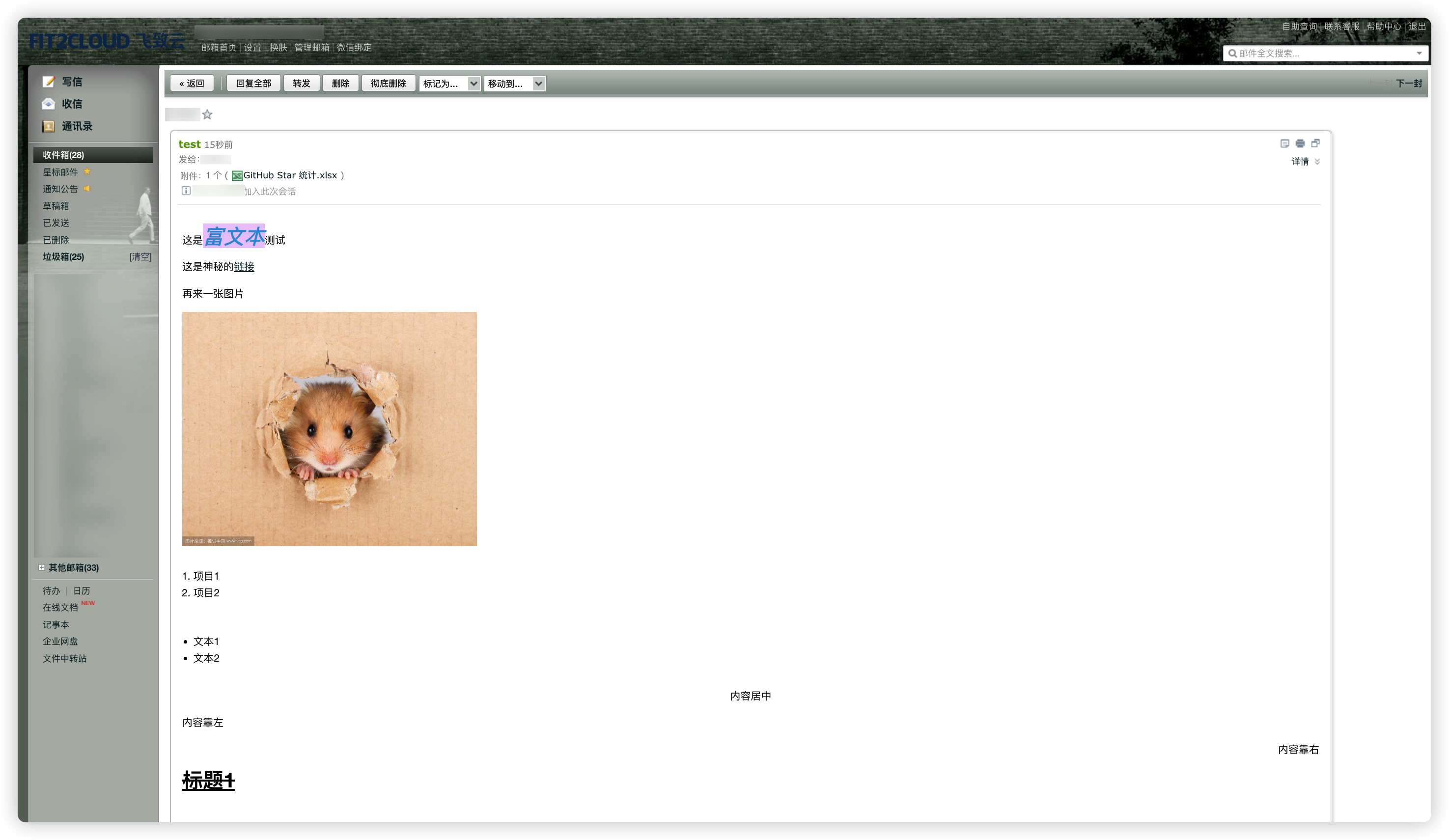

MrDoc 觅思文档是基于 Python 语言的 Django 框架开发并开源的在线文档系统。

其功能类似于国内的语雀平台、看云平台、为知笔记和飞书文档,国外的 GitBook 平台。

如果你在寻找可私有化部署的在线文档系统,那么 MrDoc 觅思文档可以说是不二之选。

MrDoc 以「文档」作为系统的主要承载形式,支持用 Markdown 和富文本进行「普通文档」的写作,支持类似 Excel 的在线表格用来「表格文档」的记录。

同时以书籍形式的结构化文集作为文档的呈现形式,非常适合个人和小型团队作为私有化的文档、笔记和知识管理工具。

全平台多终端支持

浏览器扩展

MrDoc 通过官方浏览器扩展 ——MrDoc 速记(支持 Chromium 系列浏览器和火狐浏览器)(项目地址为:https://gitee.com/zmister/mrdoc-webclipper)和接入「简悦」扩展,实现了网站内容剪藏,可以化身成为互联网内容收藏神器。

桌面客户端

MrDoc 还提供了基于 Electron 开发的桌面客户端,跨平台支持 Windows、Linux 和 macOS。

移动端 APP

通过移动端 APP,你可以在手机上快速新建文集、文档,修改文档、上传图片、阅读文档……

总而言之,你所写的一切都在你自己的掌控之中,不用担心哪家的产品突然宣布停止服务,不用担心收藏在互联网平台上的内容被各种原因清理掉。

根据 MrDoc 交流 群里的使用反馈,很多朋友用来做个人私有云笔记、团队知识库、公司产品手册、组织规章制度和办事指南等

更新内容

在 2022 年 11 月 30 日,MrDoc 归版发布了 0.8.5 版本,本次版本发布带来了一大波的更新、优化和 Bug 修复,详细的更新内容如下:

- [新增]邮箱配置信息测试发送功能;

- [新增]禁用更新检测功能及其配置项;

- [修复]修复部分设备importlib-metadata版本变动导致项目运行失败的问题;

- [优化]取消iframe白名单相关配置及限制;

- [优化]增加card类型代码块颜色位;

- [优化]合并PR#153;

MrDoc 官网:

https://mrdoc.pro

MrDoc 文档站点:

https://doc.mrdoc.pro

开源仓库地址:

https://gitee.com/zmister/MrDoc

https://github.com/zmister2016/MrDoc

浏览器扩展:

https://gitee.com/zmister/mrdoc-webclipper

桌面客户端:

https://gitee.com/zmister/mrdoc-desktop-release

移动 APP:

https://gitee.com/zmister/mrdoc-app-release

示例站点:

http://mrdoc.zmister.com/

测试账号:test1 测试密码:

作者 | 张乐、张皓天

Spring Framework 6.0 已于11月份上旬正式发布 GA 版本。Spring Boot 3.0 也于11月25日正式发布 GA 版本。那么 Spring Cloud 2022 它还远吗?

前言

Java 8 目前是国内主流生产环境 Java 版本之一。虽然近几年陆续发布了 Java 11、Java 17 官方 LTS 版本,但是 “你发任你发,我用Java8” 的声音反应了大部分开发者的心声。不过 Java 17 版本在性能上做了大量的优化特别是 ZGC 的发布,促进了国内不少企业升级到 Java 17。

Spring 在 Java 语言的作用不言而喻,Spring Framework 5.0 发布已至今五年,是时候需要一个大的版本来革新技术栈了。借着 Java 17 的东风我们认为

“Java 17 + Spring Framework 6.0 + Spring Boot 3.0 + Spring Cloud 2022”

组合一定会在不久的将来被大家所接受,成为主流技术栈。当然任何新技术大规模被认可、落地都会有一定的滞后性,技术的发展 “稳”字当头。

Spring Cloud Tencent 是基于腾讯开源的一站式微服务平台北极星(集服务注册发现、配置中心、服务限流熔断、服务路由于一身)实现的 Spring Cloud 微服务解决方案套件。真正做到 “All In One”、 开箱即用,极大的降低企业的微服务实践门槛。

无论北极星还是 Spring Cloud Tencent 当前都在积极的修复 Bug、完善用户体验、迭代新功能。所以 Spring Cloud Tencent 也第一时间适配了 Spring Cloud 2022 版本。此篇文章详细讲述了 Spring Cloud Tencent 从 2021 版本升级到 2022 版本的改动点,为尝鲜 2022 版本的广大开发者提供一些参考。

一、升级过程

1.1 升级安装 JDK 17

Oracle 官网下载 JDK 17 并安装。安装之后,本地修改 JAVA_HOME 环境变量,如下以我的 Mac 为例:

安装好 JDK 17 之后,同时需要在 Idea 里设置项目的编译和运行环境为 SDK 17。

1.2 升级依赖版本

Spring Cloud Tencent 项目引用的 Parent Pom 是 spring-cloud-build,所以需要升级到最新版本。

可以看到 Spring-cloud-build 4.0.0-RC2 版本里定义的 Java 和 Spring Boot 版本已是最新的 Java 17 和 Spring Boot 3.0

普通项目一般不需要继承 spring-cloud-build ,而是通过 bom 的方式引入 Spring 全家桶。如果你的项目里定义了 Java、Spring Framework、Spring Boot、Spring Cloud 版本则需要同时升级。如下所示:

注意:Spring 非 GA 版本会先发布到 Spring 自己的 Maven 仓库,而不会发布到中央仓库。所以如果拉不到包 ,则需要在项目根 Pom 或者本地 ~/.m2/settings.xml 里配置 Spring Maven 仓库。

在升级过程中,大概率会出现包冲突的情况,例如 SCT 在升级过程中发现日志依赖有问题导致 example 启动失败。最后排查到原因:SCT 自己定义了 logback版本为 1.2.11,但是升级 Spring Boot 3.0 里传递依赖的版本为 1.4.5,所以导致版本冲突。最后解决方案就是把 SCT 定义的版本去掉,只用传递依赖的版本。

Tips:解决版本冲突大概率会占用比较多的时间,升级过程需要有耐心 😭

1.3 修改不兼容代码

javax 包替换为 jakarta 包

这是Java17 最大变更点之一,代码所有 import javax 都要替换为 jakarta。编译不通过的地方直接通过 Idea 自动导入的方式变更即可。

spring-web 6.0 不兼容升级

SCT 在升级过程中发现 spring-web 包下有些 API 不兼容,例如 ClientHttpResponse.getStatusCode() 老版本返回 HttpStatus,新版本返回的是 HttpStatusCode,改动量很小。

AutoConfiguration 自动装配方式变更

在 Spring Boot 3.0 以前的版本,通过在 META-INF/spring.factories 文件中定义需要自动装配类,Spring Boot 在启动过程中就会执行装配 Bean,如下所示:

但是在 Spring Boot 3.0 中,则是通过在

META-INF/spring/org.springframework.boot.autoconfigure.AutoConfiguration.imports

文件定义需要自动装配的类。所以迁移过程就是把org.springframework.boot.autoconfigure.EnableAutoConfiguration 下配置的类都放到新的文件中。

这里需要注意的是原来在 spring.factories 可以定义多种类型的自动装配例如:

-

org.springframework.boot.autoconfigure.EnableAutoConfiguration

-

org.springframework.cloud.bootstrap.BootstrapConfiguration

-

org.springframework.context.ApplicationListener

-

… …

只需要把 org.springframework.boot.autoconfigure.EnableAutoConfiguration 部分迁移到 org.springframework.boot.autoconfigure.AutoConfiguration.imports 文件,其它部分还是放在 spring.factories 中无需迁移。

至此 SCT 2022 升级适配工作即已完成,可以看出升级工作量并不大。

1.4 升级总结

SCT 属于比较底层的基础框架组件,依赖的第三方库少,所以整体适配工作量较少。如果您的应用是上层业务应用依赖了大量的组件,例如: spring-security、spring-stream等。那升级的成本也会高很多。

下面是 github 网友 @herodotus-cloud 总结的升级关键点:

-

更换 JDK 17 后,少部分第三方依赖包版本选择和控制问题

-

新依赖包过时代码替换。大多数没问题,就怕遇到像 spring security 6 用法的变化

-

starter 自动配置注册格式不同导致的,大多数第三方依赖都倒在这里

-

最怕的就是核心机制的变化,比如说反射。好像一些反射在 JDK 17 会有问题

-

最大的问题就是基础设置组件升级不同步或者缓慢问题,比如依赖的某个 SDK 没有升级 SDK 17,如果传递依赖了就会导致编译问题。

-

如果还要考虑向下的兼容性,怕就难了

Spring 官方建议先升级到 Spring Boot 2.7 小版本,然后再升级到 Spring Boot 3.0 版本。通过小步升级的方式,可以更加的平滑。

二、尝鲜使用 Spring Cloud Tencent 2022.0 版本

Spring Cloud Tencent 1.8.1-2022.0.0-RC2 版本已发布。通过引入 SCT BOM 的方式即可引入,如下所示:

在此解释一下 SCT 的版本号规则,版本号分为两段:

${SCT 版本}-${对应的 Spring Cloud 版本}

SCT 版本号在各个 Spring Cloud 版本之间对齐,例如 1.8.1-Hoxton.SR12 和 1.8.1-2022.0.0-RC2 ,SCT 版本号都是 1.8.1,功能完全对齐,只是引用的 Spring Cloud 不同。1.8.1-Hoxton.SR12 对应的是 Spring Cloud Hoxton.SR12 版本,而 1.8.1-2022.0.0-RC2 对应的是2022.0.0-RC2 版本。版本号中引入 Spring Cloud 版本为了一眼就能识别 Spring Cloud 版本对应关系。开发者优先选择跟自己版本一致的 Spring Cloud 版本,再选择最新的 SCT 版本。

使用 SCT 各个子模块的功能,请参考 SCT Github Wiki 文档。

三、 呼吁

第三方基础组件的升级节奏会直接影响上层应用的升级,在此也呼吁第三方基础组件的维护者能够尽快跟进适配。为广大愿意尝鲜的开发者和企业提供便利。

四、欢迎共建

如果您对微服务、Spring Cloud 技术感兴趣,欢迎加入我们。您的一个建议、Issue、Pull Request 甚至只是一个小小的 Star 都是对 Spring Cloud Tencent 社区极大的支持。

SCT Github 地址:https://github.com/Tencent/spring-cloud-tencent

北极星官网:https://polarismesh.cn/

Forest + IDEA = 双倍快乐! ForestX 隆重登场

Forest 是一款声明式的 Java 开源 HTTP 框架,相比它的前辈 Httpclient 和 OkHttp 更简明易懂、也更容易维护

废话不多说,先让我们康康用它写出来的代码长什么样子

轻轻松松完成了从高德地图获取经纬度所在的地理信息的 Rest API 接口定义,之后只要调用这个 Java 方法即可自动发送 HTTP 请求,并接受响应数据,然后转换成 Map 类型对象再交到你手上

这样做确实比以前手动组装 OkHttp 的 Client 对象、 OkRequest 对象好上很多倍,就算要调用的 HTTP 接口很多、结构再复杂,也不用怕了

但当一个项目中有成千上万个 HTTP 请求要调用,接口的管理和维护成本也会上升到一个吃力的高度

比如哪个接口对应哪个网站平台哪个URL往往不能一眼看出、项目中散落的接口具体有哪些也没法一下子就知道

另一个问题是 Forest 中的模板字符串中的占位符可以方便的引用配置文件中定义的变量已经通过标签定义的参数,但语法高亮和一个表达式语言应用的基本支持(如代码补全和提示)

这在代码少的时候不算问题,代码接口躲到一定程度,字符串模板中的变量引用写错的概率就大大增加,因为配置也多了,就容易搞不清楚谁再调用谁

这个时候就有请我们今天的主角 ForestX 登场啦~~

专为 Forest 量身定做的 IDEA 插件

ForestX 是一款专为 Forest 提供支持的 IDEA 插件

它能大幅提高您使用 Forest 框架时的开发体验

仓库地址: https://gitee.com/CHMing7/ForestX

接下来,就让我们康康它有哪些功能:

侧边导航工具栏

右边的logo小鸟图标,可打开的导航工具栏,它会把项目中定义的 Forest 接口都罗列在一起,方便管理

- 接口列表分三个层次:最顶层的项目(目录)、Forest 接口(小鸟图标)、请求方法

- 在 Forest 接口列表中,方法名左侧的图标代表了该请求的类型(/)

- 方法名/接口的右侧,则是用灰色字体展示的 URL 路径 (一般不是全路径,而是定义在方法上的路径)

代码补全

- 根据配置文件中下定义的全局变量来补全代码

- 根据YAML配置文件中定义的YAML配置项来补全代码

- 根据请求方法的参数定义来补全代码

- 根据注解定义的方法来补全代码

- 在编程式的代码中,也可出现代码补全的智能提示

不过目前仅对 、 等请求方法开放次功能

代码跳转

按住键盘键,将鼠标移动到 Forest 模板表达式中的标识符上(比如变量名),并悬停一小段时间,就会跳出该标识符所引用的配置变量或Java属性的简短信息

此时鼠标左键,即可跳转到该标识符所引用的变量/配置的定义代码

结语

程序猿的工作是创造工具,而工具亦可以用来服务程序猿,这是一种正向循环,也是一次次迭代的缩影,正是在一次次的迭代中,程序猿们不断地创造出很好、更完善、更可能改变世界的工具

而 ForestX 的迭代才刚刚开始!

漏洞描述

exporter-toolkit 是 Prometheus 的导出工具包,

exporter-toolkit 为减少使用 bcrypt 哈希验证用户身份所需要的时间和资源,从而采用缓存 cacheKey = hex(username + hashed password + input password)验证用户身份信息。为了避免侧信道攻击,对于缓存中不存在的用户(validUser)采用固定 hashed password 进行缓存验证。

攻击者在已知散列密码(hashed password)的情况下可通过毒化缓存进行身份绕过:

- 发动请求毒化缓存:

username = username+hashed password

password = “fakepassword”

- 身份绕过:

username = username

password = bcrypt(fakepassword)+”fakepassword”

Prometheus 是一个开源的系统和服务监控系统,目前在 GitHub 具有 45.7k stars,Prometheus 在 2.37.4 和 2.40.4 之前的版本中受此漏洞影响。

影响范围

github.com/prometheus/exporter-toolkit@(-∞, 0.7.2)

github.com/prometheus/exporter-toolkit@[0.8.0, 0.8.2)

修复方案

升级github.com/prometheus/exporter-toolkit到 0.7.2 或 0.8.2 或更高版本

参考链接

https://www.oscs1024.com/hd/MPS-2022-65539

https://github.com/prometheus/exporter-toolkit/security/advisories/GHSA-7rg2-cxvp-9p7p

https://github.com/prometheus/exporter-toolkit/commit/5b1eab34484dddbce736cd119d863e4ff5

https://nvd.nist.gov/vuln/detail/CVE-2022-46146

情报订阅

OSCS(开源软件供应链安全社区)通过最快、最全的方式,发布开源项目最新的安全风险动态,包括开源组件安全漏洞、事件等信息。同时提供漏洞、投毒情报的免费订阅服务,社区用户可通过配置飞书、钉钉、企业微信机器人,及时获得一手情报信息推送:

https://www.oscs1024.com/cm/?src=osc

具体订阅方式详见:

https://www.oscs1024.com/docs/vuln-warning/intro/?src=osc

2022年11月,经openKylin社区技术委员会审议通过,Phytium内核补丁特别兴趣小组—PhytiumKernelPatch SIG正式成立。

PhytiumKernelPatch SIG由openKylin社区共建单位飞腾信息技术有限公司发起成立,在openKylin社区中负责为搭载飞腾系列处理器的服务器及桌面平台提供支持飞腾特性的内核补丁,包括但不限于双路特性支持补丁、Kdump功能修复补丁、中断堆积修复补丁、SMMU特性支持补丁以及系统驱动适配补丁等。

01

SIG目标

- 维护已提交至社区的飞腾内核补丁代码;

- 完善飞腾高性能服务器芯片内核适配并同步最新补丁代码;

-

提交并维护飞腾高效能桌面芯片内核补丁代码。

02

SIG职责

1、面向飞腾高性能服务器芯片的Linux内核适配

提交并维护面向飞腾高性能服务器芯片的Linux内核功能适配及修复补丁,为搭载飞腾腾云S2500、FT-2000+/64等处理器的服务器提供高效、可靠的运行环境及完善、健全的功能支持。

2、面向飞腾高效能桌面芯片的Linux内核适配

提交并维护面向飞腾高效能桌面芯片的Linux内核功能适配及修复补丁,为搭载飞腾腾锐D2000、FT-2000/4等处理器的桌面端提供系统驱动的功能适配与性能优化。

03

欢迎加入SIG

PhytiumKernelPatch SIG负责openKylin社区中面向飞腾服务器及桌面平台的操作系统内核相关的功能适配及性能优化,为拓展openKylin的操作系统内核生态提供支撑,欢迎各位小伙伴们的加入!

- 邮件列表:

-

phytiumkernelpatch@lists.openkylin.top

- SIG主页:

- https://gitee.com/openkylin/community/tree/master/sig/PhytiumKernelPatch

openKylin(开放麒麟)社区旨在以“共创”为核心,在开源、自愿、平等、协作的基础上,通过开源、开放的方式与企业构建合作伙伴生态体系,共同打造桌面操作系统顶级社区,推动Linux开源技术及其软硬件生态繁荣发展。

社区首批理事成员单位包括麒麟软件、普华基础软件、中科方德、麒麟信安、凝思软件、一铭软件、中兴新支点、心科技、中国电科32所、技德系统、北京麟卓、先进操作系统创新中心等13家产业同仁和行业机构。

审核:openKylin

“大数据时代”的概念最早由著名咨询公司麦肯锡提出。麦肯锡表示:”数据已渗透到今天的每个行业和业务功能领域,并已成为重要的生产要素。” 数据在精巧的算法中被挖掘,数据分析变得至关重要,大家开始达成一个共识:”数据计算,能够找到新发现。”

博思艾伦咨询公司的合伙人 Josh Suillivan 在其著作《数字时代的企业进化》一书中提到,其团队研究了数百个组织,提炼出构成未来成功组织模型的要素,这类成功组织被称为”数据公司”。而进化成”数字公司”的关键,是”组织是由数据驱动的”。 在大数据时代,企业不再随便删除数据,而是希望把数据存储起来用于分析。数据库也成为了企业基础架构必不可少的一部分。

什么是MPP?

MPP(Massive Parallel Processing,大规模并行处理),一直被誉为当今数据库的主流架构,被广泛用于众多数据库产品中,包括Greenplum、Teradata、Vertica等。MPP数据库是针对分析工作负载进行了优化的数据库,以满足用户聚合和处理大型数据集的需求。 MPP分析型数据库将任务并行的分布到多个服务器和节点上,并在完成计算后,将结果返回并汇总,从而完成对海量数据的分析处理。

MPP数据库的优势

MPP数据库集群有可扩展性、高可用性、高性能等众多优势。MPP数据库的诞生解决了单个SQL数据库无法存放海量数据,很难在一台物理机器上完成分析需求的难题。

海量数据处理能力

MPP架构的数据库以PC服务器为单位,通过如下图所示的集群方式来扩展存储和计算。假设一个宽表有3亿条记录,MPP数据库会尝试在每台PC服务器的硬盘上分布1亿条记录。数据计算时,所有机器同时并行计算,理论上最高可以把计算时间降低到单机部署的1/n(n为机器数量),节省了海量数据的处理时间。

对SQL的完美兼容

大部分传统MPP数据库均实现了对SQL的完美兼容,包括ANSI SQL 2008标准,以及 SQL 2003 OLAP 扩展。对SQL的全面支持使得MPP数据库可以无缝集成业内常见的提取/转换/加载(ETL)和BI(商业智能)工具,完全支持和认证标准数据库接口。企业只需安排少量的集成工作,就可以使用现有的使用标准 SQL 结构和接口的分析工具让应用在 数据库上运行,从而避免了企业受制于供应商,帮助企业在抑制业务风险的同时推动创新。

计算的高度并行化

MPP架构给数据库的高并发性带来了极大的弹性。架构赋予数据库数据和查询的自动并行化能力,数据可以做到自动在数据库的所有节点上分区,并以高度协调的方式使用所有节点来规划和执行查询。企业可以根据自身的并发需求扩展集群,达到所需的并发需求。

水平扩展能力

MPP数据库具有良好的水平扩展能力,企业可以根据业务需求,通过增加服务器,用更多的节点支撑更大的分析需求。

传统MPP数据库的瓶颈

虽然MPP数据库有众多优势,因而成为众多分析型数据库产品的主流架构。然而,传统MPP数据库也有众多瓶颈和限制。

存算耦合

传统数据仓库的计算和存储是紧密耦合的,计算资源和存储资源按某一比例强绑定,因此用户在扩容时,必须同时扩容计算资源和存储资源,在扩容、运维、迁移上都存在一定的挑战。企业业务发展的不确定性,当企业遇到负载高峰时刻,传统数据仓库无法及时扩资源,可能会导致大数据系统无法及时分析业务数据,错失了充分挖掘数据价值所带来的商业机会。

业务受限

传统的 MPP 数据库虽然实现了水平扩展,但是由于存算耦合,水平扩展流程复杂且缓慢。随着用户的数据规模增长,每次扩缩容进行增加节点的操作时,大量的I/O请求会影响业务的处理速度,对业务的持续性会造成一定的影响。当用户负载突然增大时,无法迅速提高算力以响应业务变化,在负载降低时也无法收缩以节约成本。存算的紧密耦合,导致用户无法根据实际需求申请资源,动态扩展,导致用户的业务受限。

成本高昂

传统数据库价格高昂的软硬件导致巨大的前期投入。随着存储和工作负载需求的日益增长,面临数据库的扩容和升级时,由于传统MPP数据库架构存储和计算的紧密耦合,往往需要企业花费巨大的运维和时间成本,且操作繁琐。

木桶效应

传统MPP数据库架构存在”木桶效应”,数据库整体执行速度取决于最”短板”单机(Straggler)的性能。单机故障会”拖垮”整个数据库的性能,导致查询速度变慢。 因此传统的MPP架构往往要求新增的PC机和之前的PC机是一样的老配置,不然任何一个集群的”短板”就会影响整个数据库的性能,也就说摩尔定理不管多厉害,MPP集群拿老机器的存储和性能”一刀切”而取低值。

数据孤岛

随着业务的发展,数据量的增加,和信息化建设的需求,企业会为不同部门建设相应的业务信息化系统。然而MPP的水平”扩展“能力和事实上的”静态“项目实施是矛盾的。“扩展”理论上是和时间关联的一个概念,而基于PC机的MPP设计并不是”时间的朋友“。由于前面提到的存算耦合和”木桶效应”,企业在购买新机器的时候,往往会选择”另起炉灶”,新建一个集群,从而造成”数据孤岛”,严重阻碍了企业实现大数据目标。

全新的eMPP:传统MPP数据库的进阶版

面对传统MPP数据库的短板,OpenPie 团队打造的云原生数据库 PieCloudDB,创造了全新的eMPP分布式架构,构建以云原生、分析型分布式数据库为引擎数据计算平台。

什么是eMPP?

eMPP由OpenPie团队打造,全称是 Elastic Massive Parallel Processing(Elastic MPP,弹性大规模并行计算)。

eMPP超越传统MPP架构,更符合云时代的需求。云平台在信息技术发展过程中具有划时代意义,它带给用户的不仅仅是快捷和便利,更是极大的灵活性和可配置性。用户可以自行定义云主机的配置,定义云主机的数量等,并且可以便捷的增加和删除云主机。一句话来说,云平台给企业应用架构带来了极大的弹性。

MPP架构和云平台相结合,就诞生了eMPP。为了适应云平台的弹性,新的eMPP架构实现了云上存储计算分离。也就是说,计算资源和存储资源可以在云上实现独立的进行水平扩展。

eMPP的优势

存算分离赋予 eMPP 数据库 ”真正” 的弹性。eMPP架构继承了前文中提到的MPP数据库所有优势,并从根本上规避了传统MPP数据库的缺陷,拥有众多优势。

弹性扩展

基于云计算平台、存算分离的eMPP(弹性大规模并行计算)架构赋予数据库多维度、智能弹性扩展能力,让用户能够根据业务需求进行横向或纵向的弹性伸缩。

存储侧支持标准对象存储,可以充分利用云计算平台的优势,让对象存储接近无限的容量,避免了企业对集群进行扩容时,因计算资源和存储资源的绑定而造成的资源浪费,可单独进行计算或者存储资源的扩展,存储扩容性价比高。

计算侧在设计上充分考虑无状态实现,计算节点可以充分利用云平台海量的计算节点池,可以按需扩容和缩容。企业可以灵活考虑业务和数据量的变化,动态调整 数据库集群中计算节点的数量,用最适合的资源量来满足其业务需求。

灵活敏捷

eMPP架构计算和存储分离,避免了资源的浪费。企业可根据对资源的需求,灵活的以低成本和高效的方式,单独地进行存储或计算资源的弹性扩展,提高了资源的利用率,节省空间成本和能耗开销。

降本增效

eMPP架构带来的动态扩展能力,企业可根据自己对资源的需求进行扩展,避免了资源的浪费,相比于传统数据库,具有更高的性价比。

高可用性

eMPP架构中,计算节点不存储用户数据,保证了计算节点的无状态性。无状态的计算节点启动和停止非常容易,企业可以根据自身的需求启动足够的冗余计算节点保证eMPP数据库的高可用性。在 eMPP 数据库 中,用户数据存储在云计算平台的对象存储中,充分利用云存储的优势保障用户数据高可用性。

PieCloudDB Database:基于云计算的全新 eMPP 架构

PieCloudDB,采用基于云计算的全新 eMPP(Elastic MPP)弹性并行计算架构,集成了MPP数据库的众多优点,并完美解决了基于PC的传统MPP数据库的缺陷。计算和存储分离。存储和计算作为两个独立变量,可以在云端进行独立的弹性伸缩,避免了资源的浪费。企业可根据业务对资源的需求,灵活的以低成本和高效的方式,单独地进行存储或计算资源的弹性扩展,提高了资源的利用率,节省空间成本和能耗开销。

数据-计算-数据分离的三层独立架构让 PieCloudDB 实现了将数据集中存储,而数据独立存储。企业可以像管理商品数据一样来管理自己的数据产品的数据。企业可以将所有数据在云中存储,为已有和未来的应用真正实现数据共享。

一、Kafka存在哪些方面的优势

1. 多生产者

可以无缝地支持多个生产者,不管客户端在使用单个主题还是多个主题。

2. 多消费者

支持多个消费者从一个单独的消息流上读取数据,而且消费者之间互不影响。

3. 基于磁盘的数据存储

支持消费者非实时地读取消息,由于消息被提交到磁盘,根据设置的规则进行保存。当消费者发生异常时候,意外离线,由于有持久化的数据保证,可以实现联机后从上次中断的地方继续处理消息。

4. 伸缩性

用户在开发阶段可以先试用单个broker,再扩展到包含3个broker的小型开发集群,然后随着数据量不断增长,部署到生产环境的集群可能包含上百个broker。

5. 高性能

Kafka可以轻松处理巨大的消息流,在处理大量数据的同事,它还能保证亚秒级的消息延迟。

二、Kafka常见的使用场景

1. 消息

kafka更好的替换传统的消息系统,消息系统被用于各种场景(解耦数据生产者,缓存未处理的消息等),与大多数消息系统比较,kafka有更好的吞吐量,内置分区,副本和故障转移,这有利于处理大规模的消息。

根据我们的经验,消息往往用于较低的吞吐量,但需要低的端到端延迟,并需要提供强大的耐用性的保证。

在这一领域的kafka比得上传统的消息系统,如ActiveMQ或RabbitMQ等。

2. 网站活动追踪

kafka原本的使用场景是用户的活动追踪,网站的活动(网页游览,搜索或其他用户的操作信息)发布到不同的话题中心,这些消息可实时处理,实时监测,也可加载到Hadoop或离线处理数据仓库。

3. 指标

kafka也常常用于监测数据。分布式应用程序生成的统计数据集中聚合。

4. 日志聚合

许多人使用Kafka作为日志聚合解决方案的替代品。日志聚合通常从服务器中收集物理日志文件,并将它们放在中央位置(可能是文件服务器或HDFS)进行处理。Kafka抽象出文件的细节,并将日志或事件数据更清晰地抽象为消息流。这允许更低延迟的处理并更容易支持多个数据源和分布式数据消费。

5. 流处理

kafka中消息处理一般包含多个阶段。其中原始输入数据是从kafka主题消费的,然后汇总,丰富,或者以其他的方式处理转化为新主题,例如,一个推荐新闻文章,文章内容可能从“articles”主题获取;然后进一步处理内容,得到一个处理后的新内容,最后推荐给用户。这种处理是基于单个主题的实时数据流。从0.10.0.0开始,轻量,但功能强大的流处理,就可以这样进行数据处理了。

除了Kafka Streams,还有Apache Storm和Apache Samza可选择。

6. 事件采集

事件采集是一种应用程序的设计风格,其中状态的变化根据时间的顺序记录下来,kafka支持这种非常大的存储日志数据的场景。

7. 提交日志

kafka可以作为一种分布式的外部日志,可帮助节点之间复制数据,并作为失败的节点来恢复数据重新同步,kafka的日志压缩功能很好的支持这种用法,这种用法类似于Apacha BookKeeper项目。

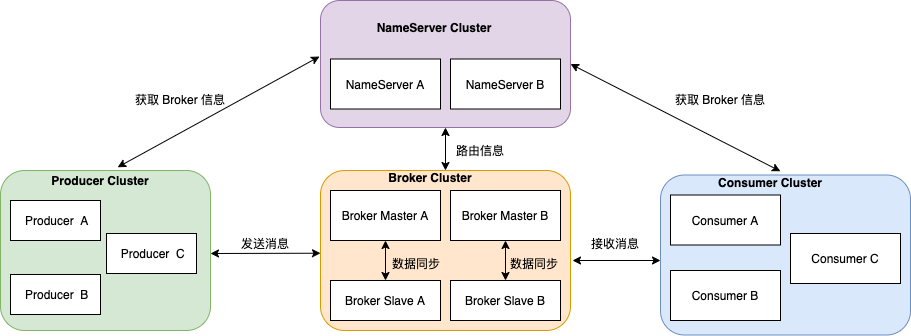

三、Kafka架构深度剖析

1. Kafka数据处理步骤

1.1 Producer产生消息,发送到Broker中

1.2 Leader状态的Broker接收消息,写入到相应topic中

1.3 Leader状态的Broker接收完毕以后,传给Follow状态的Broker作为副本备份

1.4 Consumer消费Broker中的消息

2. Kafka 核心组件

2.1 Producer:消息生产者,产生的消息将会被发送到某个topic

2.2 Consumer:消息消费者,消费的消息内容来自某个topic

2.3 Topic:消息根据topic进行归类,topic其本质是一个目录,即将同一主题消息归类到同一个目录

2.4 Broker:每一个kafka实例(或者说每台kafka服务器节点)就是一个broker,一个broker可以有多个topic

2.5 Zookeeper: Zookeeper集群不属于kafka内的组件,但kafka依赖 Zookeeper集群保存meta信息,所以在此做声明其重要性。

3. broker和集群

一个独立的Kafka服务器称为broker,broker接收来自生产者的消息,为消息设置偏移量,并提交消息到磁盘保存。broker为消费者提供服务,对读取分区的请求作出响应,返回已经提交到磁盘上的消息。根据特定的硬件及其性能特征,单个broker可以轻松处理数千个分区以及每秒百万级的消息量。

broker是集群的组成部分。每个集群都有一个broker同时充当了集群控制器的角色(自动从集群的活跃成员中选举出来)。控制器负责管理工作,包括将分区分配给broker和监控broker。在集群中,一个分区从属于一个broker,该broker被称为分区的首领。一个分区可以分配多个broker,这个时候会发生分区复制。这种复制机制为分区提供了消息冗余,如果一个broker失效,其他broker可以接管领导权。不过,相关的消费者和生产者都要重新连接到新的首领。

4. Consumer与topic关系

kafka只支持Topic

• 每个group中可以有多个consumer,每个consumer属于一个consumer group;通常情况下,一个group中会包含多个consumer,这样不仅可以提高topic中消息的并发消费能力,而且还能提高”故障容错”性,如果group中的某个consumer失效那么其消费的partitions将会由其它consumer自动接管。

• 对于Topic中的一条特定的消息,只会被订阅此Topic的每个group中的其中一个consumer消费,此消息不会发送给一个group的多个consumer;那么一个group中所有的consumer将会交错的消费整个Topic,每个group中consumer消息消费互相独立,我们可以认为一个group是一个”订阅”者。

• 在kafka中,一个partition中的消息只会被group中的一个consumer消费(同一时刻); 一个Topic中的每个partions,只会被一个”订阅者”中的一个consumer消费,不过一个consumer可以同时消费多个partitions中的消息。

• kafka的设计原理决定,对于一个topic,同一个group中不能有多于partitions个数的consumer同时消费,否则将意味着某些consumer将无法得到消息,而处于空闲状态。

kafka只能保证一个partition中的消息被某个consumer消费时是顺序的;事实上,从Topic角度来说,当有多个partitions时,消息仍不是全局有序的。

5. Kafka消息的分发

• Producer客户端负责消息的分发

• kafka集群中的任何一个broker都可以向producer提供metadata信息,这些metadata中包含*”集群中存活的servers列表”、“partitions leader列表”*等信息;

• 当producer获取到metadata信息之后, producer将会和Topic下所有partition leader保持socket连接;

• 消息由producer直接通过socket发送到broker,中间不会经过任何”路由层”。事实上,消息被路由到哪个partition上由producer客户端决定,比如可以采用”random””key-hash””轮询”等。

• *如果一个topic中有多个partitions,那么在producer端实现”消息均衡分发”*是必要的。

• 在producer端的配置文件中,开发者可以指定partition路由的方式。

• Producer消息发送的应答机制

设置发送数据是否需要服务端的反馈,有三个值0,1,-1

0: producer不会等待broker发送ack

1: 当leader接收到消息之后发送ack

2: 当所有的follower都同步消息成功后发送ack

request.required.acks=0

6. Consumer的负载均衡

当一个group中,有consumer加入或者离开时,会触发partitions均衡.均衡的最终目的,是提升topic的并发消费能力,步骤如下:

-

假如topic1,具有如下partitions: P0,P1,P2,P3

-

加入group A 中,有如下consumer: C0,C1

-

首先根据partition索引号对partitions排序: P0,P1,P2,P3

-

根据consumer.id排序: C0,C1

-

计算倍数: M = [P0,P1,P2,P3].size / [C0,C1].size,本例值M=2(向上取整)

本文由教研团队发布。

如果本文对您有帮助,欢迎和;如果您有任何建议也可或,您的支持是我坚持创作的动力。

转载请注明出处!

作者:于雄雄 陈其友 | 旷视 MegEngine 架构师

背景

在 CV 领域中,卷积计算是扩充像素的感受野的有效方法,模型大多数的计算量都是卷积操作贡献的。因此在 CV 模型的推理性能优化中,最重要的一项工作是对卷积的优化。MegEngine 在长期的工业界实践和反馈的基础上总结得出卷积优化的基本方法有:

- 直接卷积计算优化

该方法的计算过程为逐通道进行卷积滑窗计算并累加,该优化方法对卷积的参数敏感,为了达到最优的性能,会根据各个卷积参数分别进行 kernel 优化,通用性弱,但是在 Depthwise 的卷积中却是最高效的方法。

- FFT 卷积计算优化

根据卷积的性质,利用傅立叶变换可以将卷积转换为频域上的乘法,在频域上的计算对应乘法,再使用傅立叶变换逆变换,就可以得到卷积对应的计算结果。该方法使用高性能的傅立叶变换算法,如 FFT,可以实现卷积计算的优化,算法性能完全取决于傅立叶变换的性能以及相应卷积参数。

- Im2col+matmul 卷积计算优化

由于卷积计算中有大量的乘加运算,和矩阵乘具有很多相似的特点,因此该方法使用 Im2col 的操作将卷积运算转化为矩阵运算,最后调用高性能的 Matmul 进行计算。该方法适应性强,支持各种卷积参数的优化,在通道数稍大的卷积中性能基本与 Matmul 持平,并且可以与其他优化方法形成互补。

- Winograd 卷积计算优化

Winograd 方法是按照 Winograd 算法的原理将卷积运行进行转变,达到减少卷积运算中乘法的计算总量。其主要是通过将卷积中的乘法使用加法来替换,并把一部分替换出来的加法放到 weight 的提前处理中,从而达到加速卷积计算的目的。Winograd 算法的优化局限为在一些特定的常用卷积参数才支持。

由于 direct 卷积可以直接由公式得来,而 FFT 卷积对于当前业界用到的各种参数的卷积,其性能优势远没有其他优化方法明显,对于这两者本文不做详细展开。这里主要讲述 Im2col 和 Winograd 算法的实现以及优化方法。

Im2col+Matmul 优化

Im2col 算法简介

Im2col+Matmul 方法主要包括两个步骤:

- 使用 Im2col 按照卷积核的需要将输入矩阵展开一个大的矩阵,矩阵的每一列表示卷积核需要的一个输入数据。

- 使用上面转换的矩阵进行 Matmul 运算,得到的数据就是最终卷积计算的结果。

具体 Im2col 的步骤如上图所示:

- 将输入数据按照卷积窗进行展开并存储在矩阵的列中,多个输入通道的对应的窗展开之后将拼接成最终输出 Matrix 的一列。

- 以卷积的 stride 为步长展开后续的卷积窗并存在 Matrix 的下一列中。

完成 im2col 的操作之后会得到一个输入矩阵,卷积的 weights 也可以转换为一个矩阵,此时对 weights 的矩阵和 Im2col 的输出矩阵进行 Matmul 计算,就可以得到最终的卷积计算结果。

算法优化

上面介绍的过程是原始 Im2col+Matmul 的过程,实际处理器在执行上面的过程中性能达不到最优,以输入 Tensor 的 shape 为 (1, IC, IH, IW),weights 的 shape 为 (OC,IC,Fh,Fw),输出 Tensor 的 shape 为 (1, OC, OH, OW) 为例,主要原因在于:

- Im2col 的输入 Tensor 需要的 CPU 内存大小为 IC*IH*IW,而按照上面 Im2col 之后所需要的内存大小为 IC*Fh*Fw*OH*OW,当卷积的 stride=1 的时候,Im2col 之后需要的内存比之前大很多。

- 由于 Im2col 之后的数据量比较大,难以全部保存在 CPU 的 Cache 中,造成后续 Matmul 计算时,读取数据会存在 Cache Miss。

- Im2col 过程中会将输入进行 relayout 操作,而在后续 Matmul 的计算中,需要对该数据进行 Pack,Pack 操作会引入非必要的读写过程。影响算法实际性能。

优化 1:对 Im2col+Matmul 过程进行分块

上面提到在 Im2col 之后,消耗的内存会超过 CPU 的 Cache 的容量,为了使这部分数据能够保存在 Cache 中,需要对 Im2col+Matmul 的整个过程进行分块,每次 Im2col+Matmul 都只对一个分块进行操作,这样就可以解决内存占用过大,超过 CPU Cache 后造成 Cache Miss 的问题。

分块优化如上图所示:Im2col 每次只对 block_size 大小的数据进行计算,得到的 Fh*Fw*IC*block_size 的数据可以保存在 Cache 中。Im2col 得到数据后,对其直接进行 Matmul 计算,将计算得到的结果写入到输出 Tensor 对应的 block_size 处就可以得到该分块处卷积的计算结果。计算完该分块之后,依次进行下一个 block_size 的计算,直到整个输入计算完成。

结合 Matmul 的相关优化知识,在进行 Matmul A*B=C 计算时将分块 Im2col 得到的数据视作 B 矩阵,A 矩阵为卷积的权重矩阵,根据 sgemm 的分块规则,以及 cache 的性质,A 矩阵会被调度并保存在 L2 上,B 矩阵基于最内层分块的一列和 A 矩阵基于最内存分块的一行以及 C 矩阵基于最内层的部分分块会被调度保存在 L1 上,因此可以通过 L1,L2 的大小以及 A 矩阵的大小,计算出所有的分块大小。下面是分块优化性能的试验结果,可以看出分块优化能有效的减少存储使用,而且还可以提升算子的计算性能。

优化 2:融合 Im2col 和 Matmul PACK 数据操作部分

Im2col 过程中将多个窗的展开同时进行时,实际上是对内存的 copy 以及数据的 relayout 的过程,后续 Matmul 的 Pack 操作业是对数据的 copy 的 relayout,因此可以将上面两次数据的 copy 和 relayout 进行合并优化,减少该过程中对内存的读写次数。

如上图所示 Im2col+Matmul 的 algo 中实现了将 Im2col 和 Matmul 的 Pack 融合的优化,这样能够减少一次数据的读写操作。由于该 fuse 过程和卷积的参数直接相关,不同的卷积参数将对应不同的融合 kernel,所以不具备通用性。通用情况下我们会使用之前的 Im2col+Matmul 的做法,另外针对一些通用的卷积如:kernel=3×3,stride=2 等,因为参数固定,因此可以直接进行上述融合优化,利用这样的组合优化,既可以保证 im2col 算法的通用性,也可以确保大部分常见的卷积的性能。

对融合之后的卷积进行性能测试,如下所示为对应的计算吞吐:

可以看出,大多数情况下,融合之后卷积会有明显的性能提升。

Winograd 优化

Winograd 算法简介

Winograd 算法能够优化卷积计算的乘法计算量,乘法计算量的优化原理可以参考相关论文。在此就不做过多介绍了。虽然 Winograd 可以优化乘法的计算量,但是会增加加法的计算量,优化这些加法的存在可以进一步提高 Winograd 算法的性能。如可以把一部分加法计算提前到 weights 的预处理中,可以把部分加法隐藏在 Winograd 预处理中的 relayout 中。类似这样的优化可以达到减少卷积计算量的目的。

如下图所示为 Winograd 卷积算法的基本步骤,主要包括:

- 把输入的 feature map 和 weight 进行 Winograd 转换;

- 把转换后 feature map 和 weight 做批量 Matmul;

- 把矩阵乘的结果进行输出转换,得到最终结果。

在这些主要步骤中,要如何进行 Winograd 转换,如何 relayout,以及如何进行输出转换呢?下面以 Winograd F(2×2, 3×3) 为例,详细说明下这些过程。

如上图所示,上半部分是 weights 的转换,下半部分是输入 FeatureMap 的转换。其中包括了 Winograd 转换以及 relayout 的过程。

对于 weights 的转换,首先通过 Winograd 变换矩阵 G 和 GT 分别将 3×3 的 weight 转换为 4×4 的矩阵,然后将该矩阵中相同位置的点(如图中蓝色为位置 1 的点)relayout 为一个 IC*OC 的矩阵,最终形成 4×4=16 个转换之后 weights 矩阵。

对于 FeatureMap 的转换,首先将输入 FeatureMap 按照 4×4 tile 进行切分,然后将每个 tile 通过 B 和 BT 转换为 4×4 的矩阵,矩阵 B 和 BT 为 FeatureMap 对应的 Winograd 变换矩阵,然后进行与 weight 处理相似的 relayout,转换为 16 个 nr_tiles*IC 的 FeatureMap 矩阵。

如上图所示,将上述转换后两批矩阵做矩阵乘,得到 16 个 nr_tiles*OC 的矩阵,然后将相同位置的 16 个点转换为 nr_tiles*OC 个 4×4 矩阵,再使用输出的 Winograd 变换矩阵 A 和 AT 将这些 4×4 的矩阵转换为 2×2 的输出矩阵,最后将这些矩阵写回输出矩阵中就可以得到 Winograd 卷积的最终结果。

算法优化

优化 1:weight 提前处理

在上述 Winograd 算法的基础上,鉴于模型中的权重数据在整个 Inference 的时候已经是常量不会再改变,因此可以在真正 Inference 之前就可以对模型进行了 weights 的转换,这样可以优化在 Inference 的时候 weights 转换的开销,特别是在 IC 和 OC 较大时,weight 转换的开销非常大,所以 weights 提前转换,尤其对 Winograd 优化特别重要,下图是 Winograd 中进行 weight 提前转换和不进行 weight 提前转换时各自的性能:

从上图可以看出 weight 转换在 Winograd 中耗时占比很大,进行 weight 提前转换可以带来很大的性能收益。

优化 2:Winograd 分块优化

上述的 Winograd 算法,还会有以下缺点:

- 输入转换需要跨 channel 读写整个 feature map,数据读写对 Cache 不友好。

- feature map 转换之后,矩阵乘时需要再 PACK,数据访存增加。

针对这些问题,可以对 Winograd 算法的整个计算流程做进一步的优化,这些优化主要包括:

- 输入转换时,分块 feature map 的 tiles 进行分块,每次只进行一定数量的 tiles 计算;

- 调整分块大小适配 CPU L1 Cache,使得矩阵乘不需要 PACK;

对整个输入 feature map 进行分块后,每次只计算一个分块的 nr 个 tiles,这样就可以保证每个批量矩阵的输入数据(除了转换之后的 weight 数据)保存于 L1 Cache,不会出现 Cache miss, 而且矩阵乘时不需要 PACK。

下面是分块优化前后的速度对比,可以看出分块优化对性能有显著的提升。

总结

CPU 上 Inference 中有关卷积的优化有很多的途径,这里我们主要介绍了 Im2col+matmul 卷积以及 Winograd 卷积中的一些进一步优化的技术手段,通过这些方法可以进一步加速卷积计算的性能,从而加速整个模型的 Inference 性能。如下图所示是 float32 的经典网络开启相关优化后,在骁龙 855 上的测试速度:

对于具体的优化细节,大家可以结合 MegEngine 的代码实现进行研究,欢迎大家提出宝贵意见。

更多 MegEngine 信息获取,您可以:查看文档、 深度学习框架 MegEngine 官网和 GitHub 项目,或加入 MegEngine 用户交流 群:

弹指瞬间,转眼 2022 年已经来到了尾声。在过去的一年里,国内开源力量继续蓬勃发展、稳步向前;与此同时,越来越多的团队开始聚焦于开源社区的运营。

作为本土开源技术社区,OSCHINA 也一直在不遗余力地助力着国内开源发展,为构建良好的中国开源生态献一分微薄之力;平台有一套完整的模式与能力帮助开源项目社区进行运营。

开源项目社区与技术团队是开源生态发展进程中不可或缺的中坚力量,OSCHINA 矢志不渝地为这些群体提供发声渠道,不断向开发者传播最新开源与开发技术的信息,让更多开发者关注到优秀的开源项目与技术。

2022 年,我们综合了 OSCHINA 平台上各大认证官方技术团队、开源社区帐号年度发表的内容频率及质量、开展各种活动运营积极性等多方面的表现,颁发 OSCHINA“2022 年度优秀开源技术团队”奖项,以鼓励大家的积极性与辛勤付出,一起让中国的开源生态更加乐观向上。开源生态的发展离不开你们。这也是 OSCHINA 推出该奖项的第二年,欢迎有更多的技术团队、开源项目社区参与到 OSCHINA 的交流当中来。

具体名单如下(按首字母顺序排名,不分先后):

Alluxio 官方

阿里巴巴终端技术

阿里云云原生:与你并肩探索云原生技术点滴,分享你需要的

百度Geek说

CloudWeGo:构建企业云原生中间件的领先实践

得物技术:邀请你一起做最潮技术人

袋鼠云数栈DTinsight:以技术为核心,让我们一起将未来变成现在

Dromara开源组织

dubbo-go开源社区

FIT2CLOUD飞致云:软件用起来才有价值,才有改进的机会

HMS Core:与开发者一起,同成长,共精彩

华为云开发者联盟:分享华为云前沿资讯动态,方便开发者快速成长与发展

JetBrains中国:致力于打造世界上最强大、最高效的开发者工具

Juicedata:做最易用的云端共享文件系统

京东云开发者:为 AI、云计算、IoT 等相关领域提供技术分享交流

开务数据库

KubeSphere:一个开源的以应用为中心的容器云平台,支持多云与多集群管理

Kvrocks

MASA技术团队:专注于 .NET 现代应用开发解决方案

NebulaGraph:开源分布式图数据库,千亿顶点和万亿边仅毫秒级查询延时

NGINX开源社区

openKylin:开源聚力,共创未来

OneFlow深度学习框架

Orillusion:致力于打造一款完全开源基于 WebGPU 标准的轻量级渲染引擎

PostgreSQLChina

Rainbond:支持管理多种 Kubernetes 集群,提供企业级应用的全生命周期管理

RT-Thread

SeaTunnel:非常易用的支持海量数据实时同步的超高性能分布式数据集成平台

SelectDB

ShardingSphere社区:第一时间更新知名 Apache 顶级项目 ShardingSphere 技术新闻

声网:全球实时互动云服务开创者和引领者

Shopee技术团队:与你一起探讨前沿技术思考与应用