GoLand 的下一个主要版本 GoLand 2023.1 正式发布,新版本引入了漏洞检查器和更好的 gRPC 代码导航,并使重命名重构可用于接收器。

开发者现在可以用非标准库包运行 Scratch 文件,使用正则表达式来创建你自己的搜索和替换检查,并快速地将原始字符串文字转换成双引号文字等。

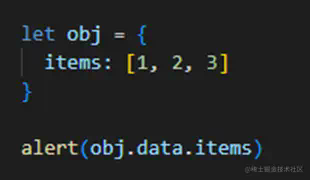

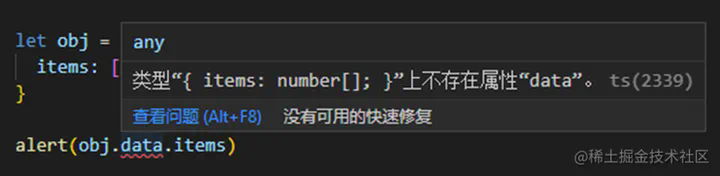

漏洞检查器

- GoLand 现在可以突出显示 go.mod 中存在已知漏洞的软件包

- 有一个快速修复方法可以将依赖更新到没有漏洞的版本。

- GoLand 还可以在编辑器中直接突出显示有已知漏洞的软件包的方法调用

- 关于已知漏洞的更多信息也可以在新的依赖检查器工具窗口中找到。

gRPC导航

现在可以从 Go 代码中导航并访问消息、服务和方法的声明,以及它们在 .proto 文件中的 Go 实现。

Scratch 文件

现在可以运行具有非标准库 Go 依赖的 Scratch 文件。

重命名重构

当你重新命名一个结构中的类型参数时,重命名重构现在会建议相应地改变接收器。

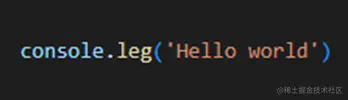

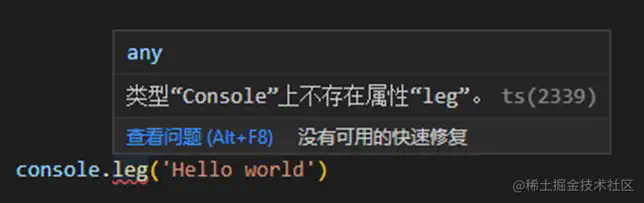

Intentions 和快速修复

- 我们有一个新的 intention 操作,可以让你快速地将原始的字符串文字(由反斜线包围的字符串)转换成双引号的字符串,反之亦然。

- 简化了整数与字符串的转换: 你现在只需用 1 次 quick-fix 就可以做到这一点,而以前需要 2 次。

- GoLand 现在有了检查和快速修复功能,可以帮助您检测和删除 Go 指令中的前导空格

- 现在可以预览更多的 intention 操作和快速修复方法。

性能改进

- 通过在智能模式下执行 Scanning files to index 过程,改善了 IDE 的启动体验。

- GoLand 现在建议将特定文件夹添加到 Microsoft Defender 的排除列表中

编辑器

- 更新了 Code Vision 功能,因此 GoLand 现在可以显示某个接口的实现数量及其方法规范。

- 现在可以使用正则表达式来创建你自己的搜索和替换检查

- GoLand 的 Go Playground 集成中的共享 URL 现在包括版本参数,如果你选择 dev 或以前的版本。你也可以禁用要求你允许在 Playground 中分享代码的弹出窗口

- 现在有一个特殊的设置,允许你控制粘贴内容的位置。

- 一个新的设置允许你配置 IDE,使其仅在你选择代码时以小圆点形式显示空白处。

- 更新了 Typo 检查,使它不再检查哈希值和特殊值的拼写,也不把它们报告为拼写错误。

- 为函数调用引入了一个新的 Find Usages 组 —— Call 组。

- ……

更多详情可查看:https://blog.jetbrains.com/go/2023/04/03/goland-2023-1/

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

本文要点:

- 一种优雅解决 MySQL 驱动中虚引用导致 GC 耗时较长问题的解决方法

- 虚引用的作用与使用场景

- MySQL 驱动源码中的虚引用分析

背景

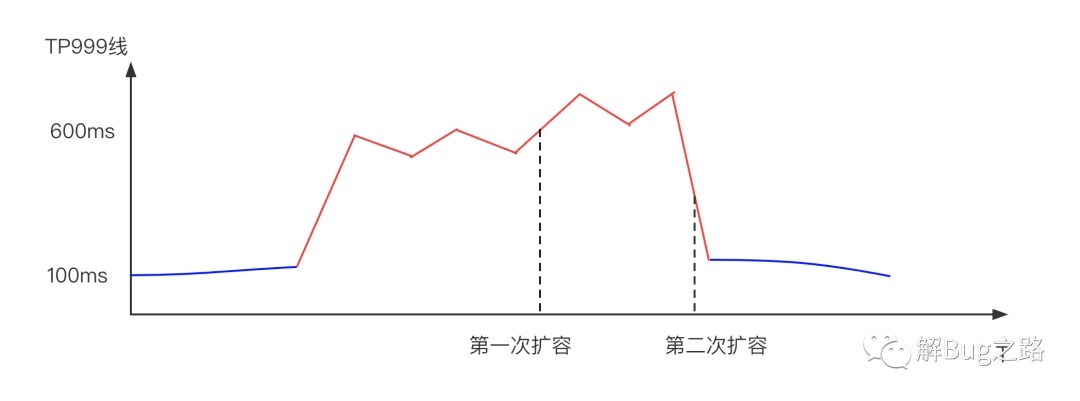

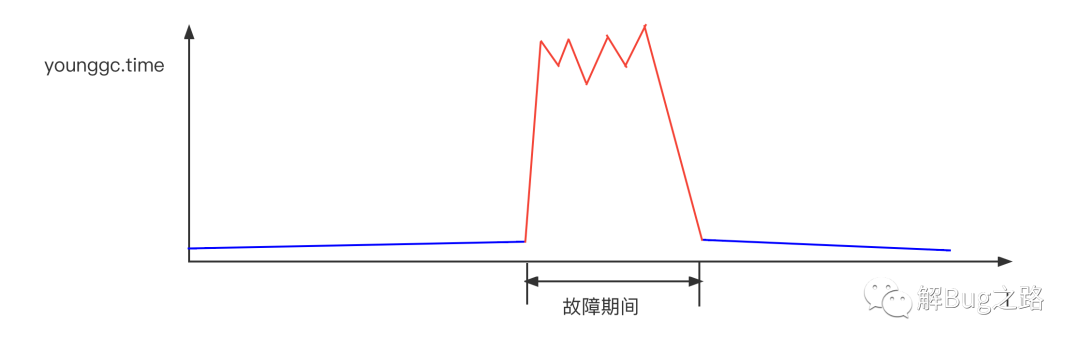

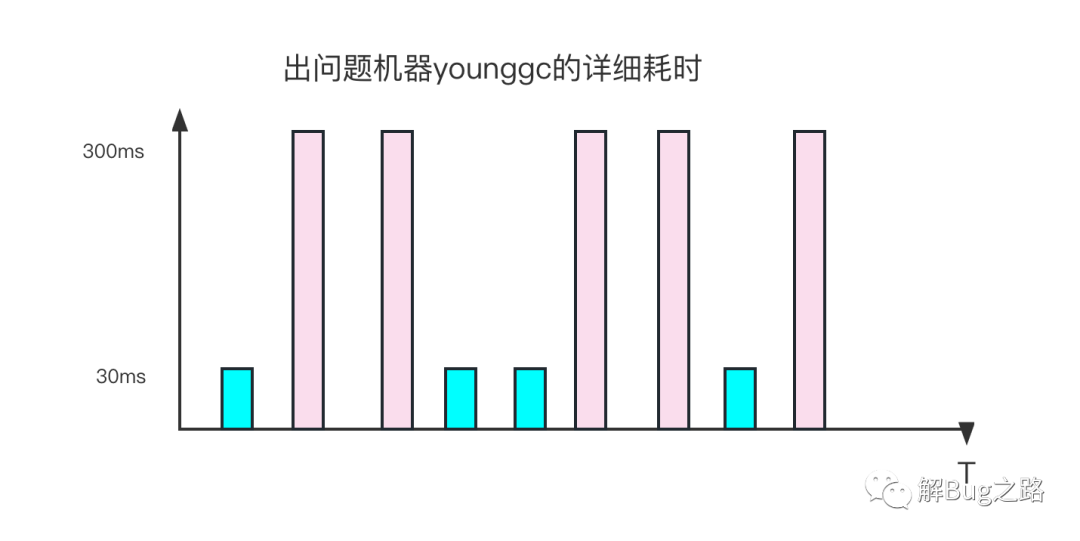

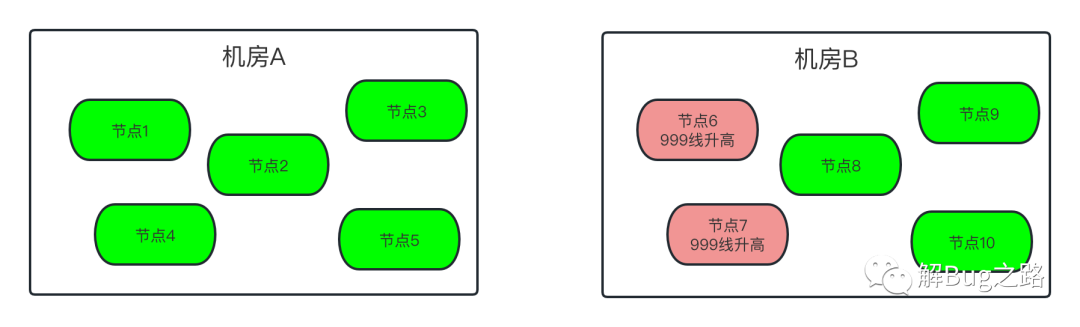

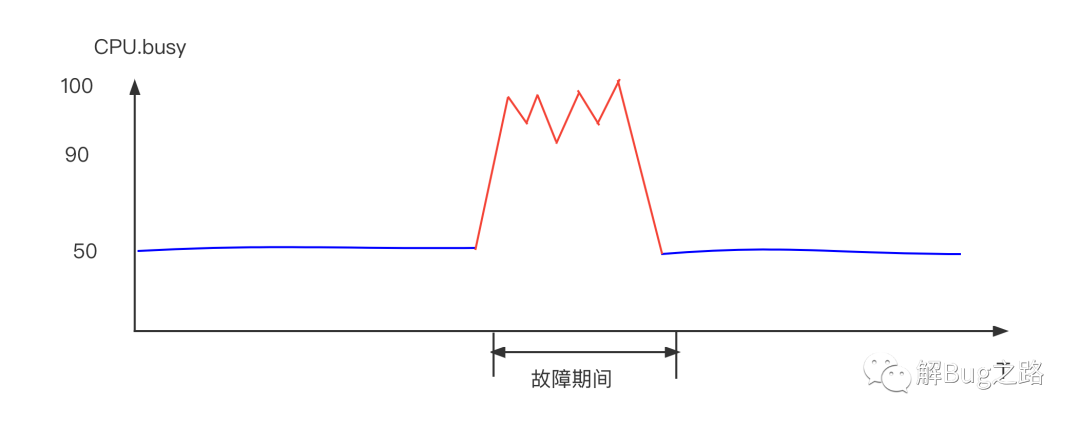

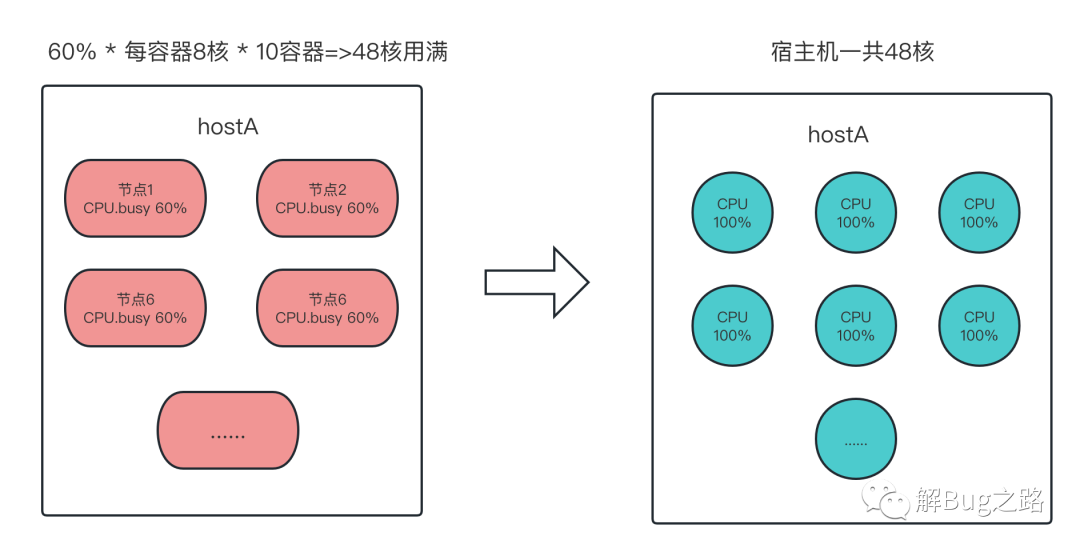

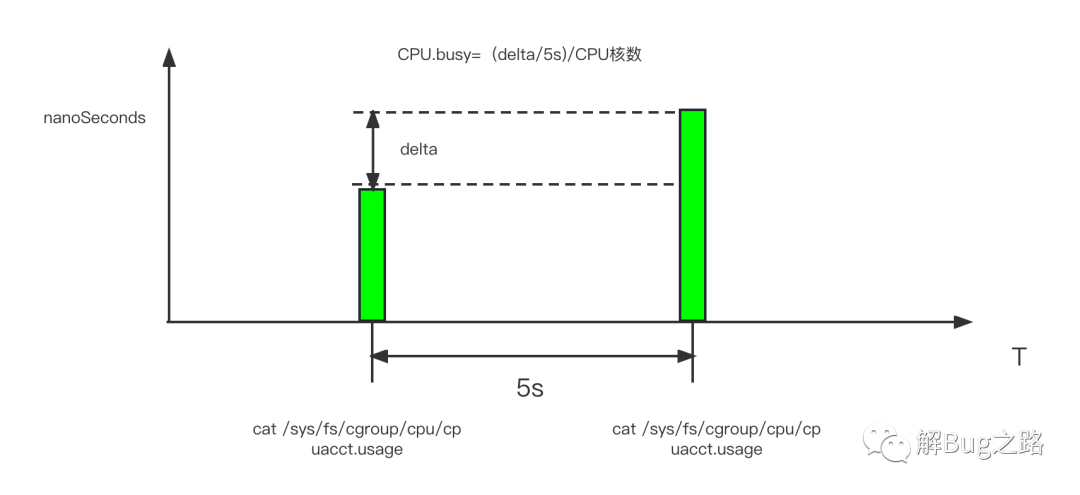

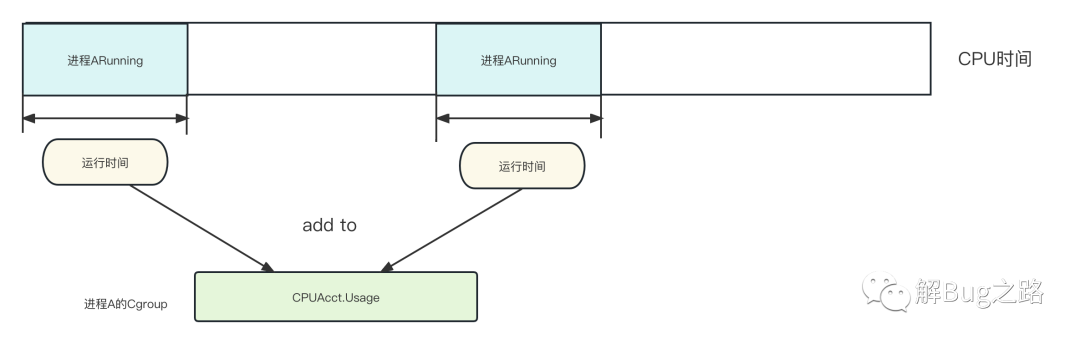

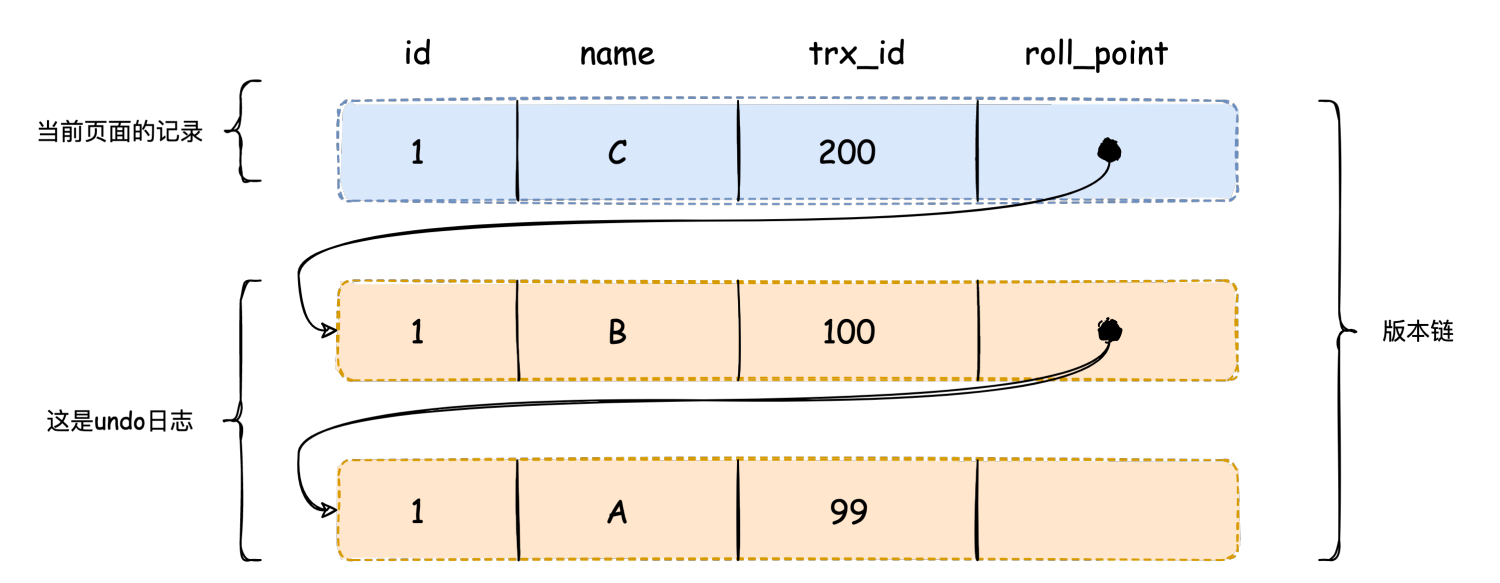

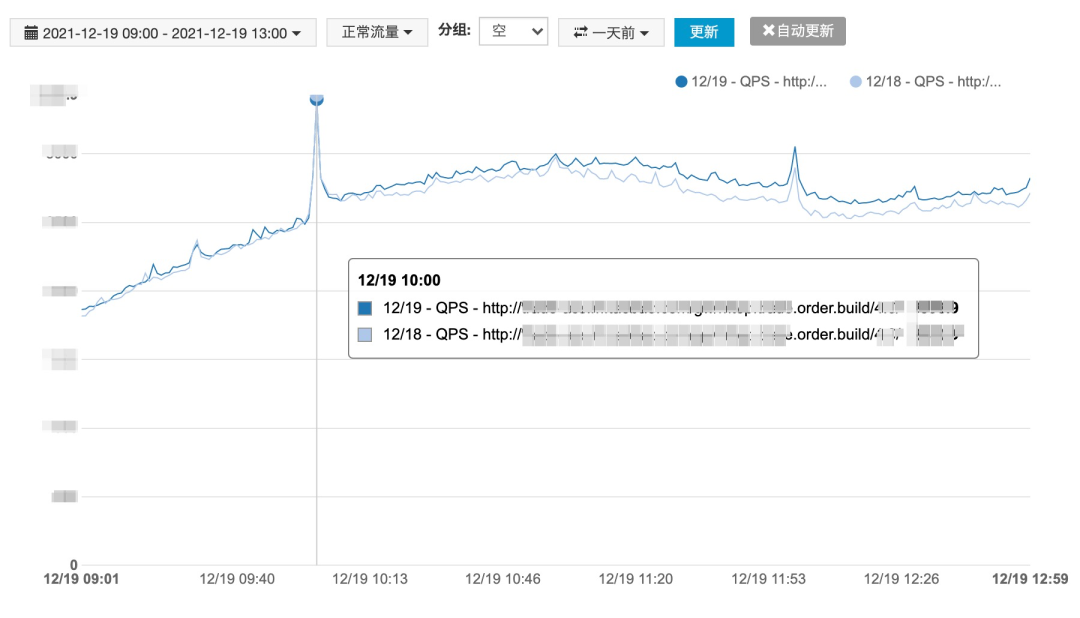

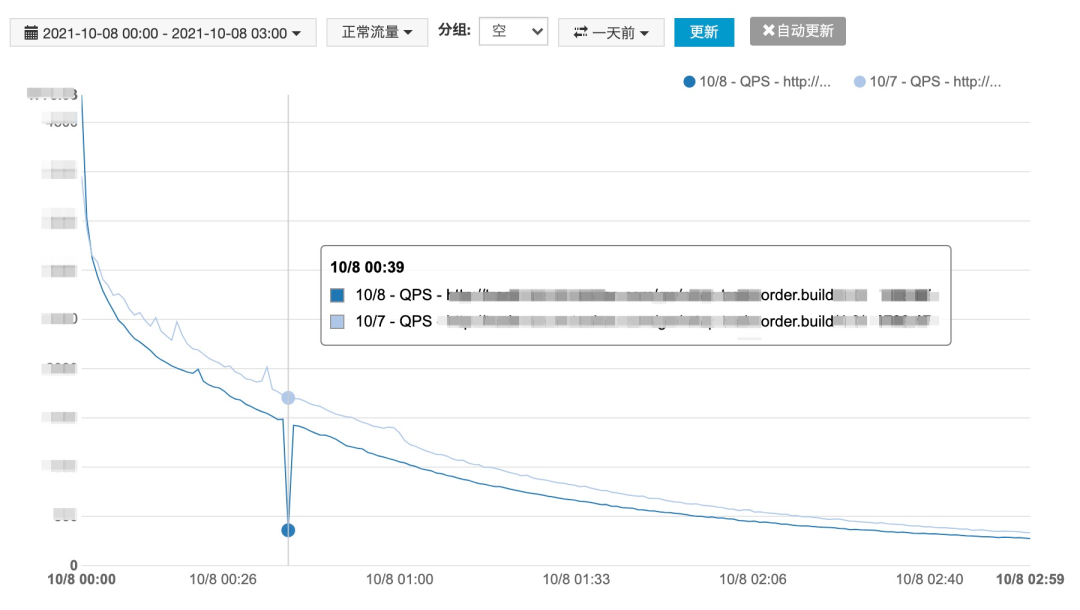

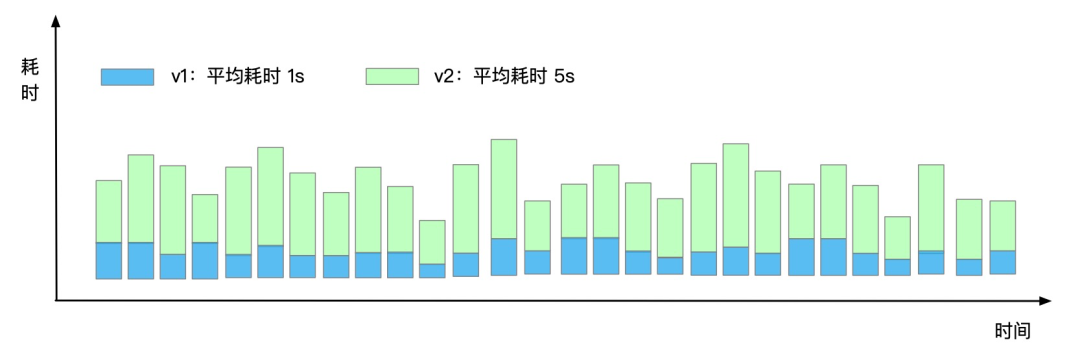

在之前文章中写过 MySQL JDBC 驱动中的虚引用导致 JVM GC 耗时较长的问题(可以看这里),在驱动代码(mysql-connector-java 5.1.38版本)中 NonRegisteringDriver 类有个虚引用集合 connectionPhantomRefs 用于存储所有的数据库连接,NonRegisteringDriver.trackConnection 方法负责把新创建的连接放入集合,虚引用随着时间积累越来越多,导致 GC 时处理虚引用的耗时较长,影响了服务的吞吐量:

尝试减少数据库连接的生成速度,来降低虚引用的数量,但是效果并不理想。最终的解决方案是通过反射获取虚引用集合,利用定时任务来定期清理集合,避免 GC 处理虚引用耗时较长。

利用定时任务清理虚引用效果立竿见影,每日几亿请求的服务 mixed GC 耗时只有 10 – 30 毫秒左右,系统也很稳定,线上运行将近一年没有任何问题。

优化——由暴力激活成功教程到优雅配置

最近又有同事遇到相同的问题,使用的 mysql-connector-java 版本与我们使用的版本一致,查看最新版本(8.0.32)的代码发现对数据库连接的虚引用有新的处理方式,不像老版本(5.1.38)中每一个连接都会生成虚引用,而是可以通过参数来控制是否需要生成。类 的相关代码如下:

mysql-connector-java 的维护者应该是注意到了虚引用对 GC 的影响,所以优化了代码,让用户可以自定义虚引用的生成。

有了这个配置,就可以在启动参数上设置属性:

或者在代码里设置属性:

当 com.mysql.cj.disableAbandonedConnectionCleanup=true 时,生成数据库连接时就不会生成虚引用,对 GC 就没有任何影响了。

建议还是使用第一种方式,通过启动参数配置更灵活一点。

什么是虚引用

有些读者看到这里知道 mysql-connector-java 生成的虚引用对 GC 有一些副作用,但是还不太了解虚引用到底是什么,有什么作用,这里我们在虚引用上做一点点拓展。

Java 虚引用(Phantom Reference)是Java中一种特殊的引用类型,它是最弱的一种引用。与其他引用不同,虚引用并不会影响对象的生命周期,也不会影响对象的垃圾回收。虚引用主要用于在对象被回收时收到系统通知,以便在回收时执行一些必要的清理工作。

上述虚引用的定义还是比较难理解,我们用代码来辅助理解:

先来生成一个虚引用:

虚引用的构造方法需要两个入参,第一个就是关联的对象、第二个是虚引用队列 ReferenceQueue。虚引用需要和 ReferenceQueue 配合使用,当对象 Object o 被垃圾回收时,与 Object o 关联的虚引用就会被放入到 ReferenceQueue 中。通过从 ReferenceQueue 中是否存在虚引用来判断对象是否被回收。

我们再来理解上面对虚引用的定义,虚引用不会影响对象的生命周期,也不会影响对象的垃圾回收。如果上述代码里的phantomReference 是一个普通的对象,那么在执行 System.gc() 时 Object o 一定不会被回收掉,因为普通对象持有 Object o 的强引用,还不会被作为垃圾。这里的 phantomReference 是一个虚引用的话 Object o 就会被直接回收掉。然后会将关联的虚引用放到队列里,这就是虚引用关联对象被回收时会收到系统通知的机制。

一些实践能力很强的读者会复制上述代码去运行,发现垃圾回收之后队列里并没有虚引用。这是因为 Object o 还在栈里,属于是 GC Root 的一种,不会被垃圾回收。我们可以这样改写:

不在 main 方法里实例化关联对象 Object o,而是利用一个 buildReference 方法来实例化,这样在执行垃圾回收的时候,Object o 已经出栈了,不再是 GC Root,会被当做垃圾来回收。这样就能从虚引用队列里取出关联的虚引用进行后续处理。

关联对象真的被回收了吗

执行完垃圾回收之后,我们确实能从虚引用队列里获取到虚引用了,我们可以思考一下,与该虚引用关联的对象真的已经被回收了吗?

使用一个小实验来探索答案:

代码里生成一个虚引用,关联对象是一个大小为 2M 的数组,执行垃圾回收之后尝试再实例化一个大小为 4M 的数组。如果我们从虚引用队列里获取到虚引用的时候关联对象已经被回收,那么就能正常申请到 4M 的数组。(设置堆内存大小为 5M -Xmx5m -Xms5m)

执行代码输出如下:

从输出可以看到,申请 4M 内存的时候内存溢出,那么问题的答案就很明显了,关联对象并没有被真正的回收,内存也没有被释放。

再做一点小小的改造,实例化新数组的之前将虚引用直接置为 null,这样关联对象就能被真正的回收掉,也能申请足够的内存:

如果我们使用了虚引用,但是没有及时清理虚引用的话可能会导致内存泄露。

虚引用的使用场景——mysql-connector-java 虚引用源码分析

读到这里相信你已经了解了虚引用的一些基本情况,那么它的使用场景在哪里呢?

最典型的场景就是最开始写到的 mysql-connector-java 里处理 MySQL 连接的兜底逻辑。用虚引用来包装 MySQL 连接,如果一个连接对象被回收的时候,会从虚引用队列里收到通知,如果有些连接没有被正确关闭的话,就会在回收之前进行连接关闭的操作。

从 mysql-connector-java 的 AbandonedConnectionCleanupThread 类代码中可以发现并没有使用原生的 PhantomReference 对象,而是使用的是包装过的 ConnectionFinalizerPhantomReference,增加了一个属性 NetworkResources,这是为了方便从虚引用队列中的虚引用上获取到需要处理的资源。包装类中还有一个 finalizeResources 方法,用来关闭网络连接:

AbandonedConnectionCleanupThread 实现了 Runnable 接口,在 run 方法里循环读取虚引用队列 referenceQueue 里的虚引用,然后调用 finalizeResource 方法来进行后置的处理,避免连接泄露:

如果你希望在某些对象被回收的时候做一些后置工作,可以参考 mysql-connector-java 中的一些实现逻辑。

总结

本文简述了一种优雅解决 MySQL 驱动中虚引用导致 GC 耗时较长问题的解决方法、也根据自己的理解讲述了虚引用的作用、结合 MySQL 驱动的源码描述了虚引用的使用场景,希望对你能有所帮助。

公众号:DailyHappy

一位后端写码师,一位黑暗料理制造者。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

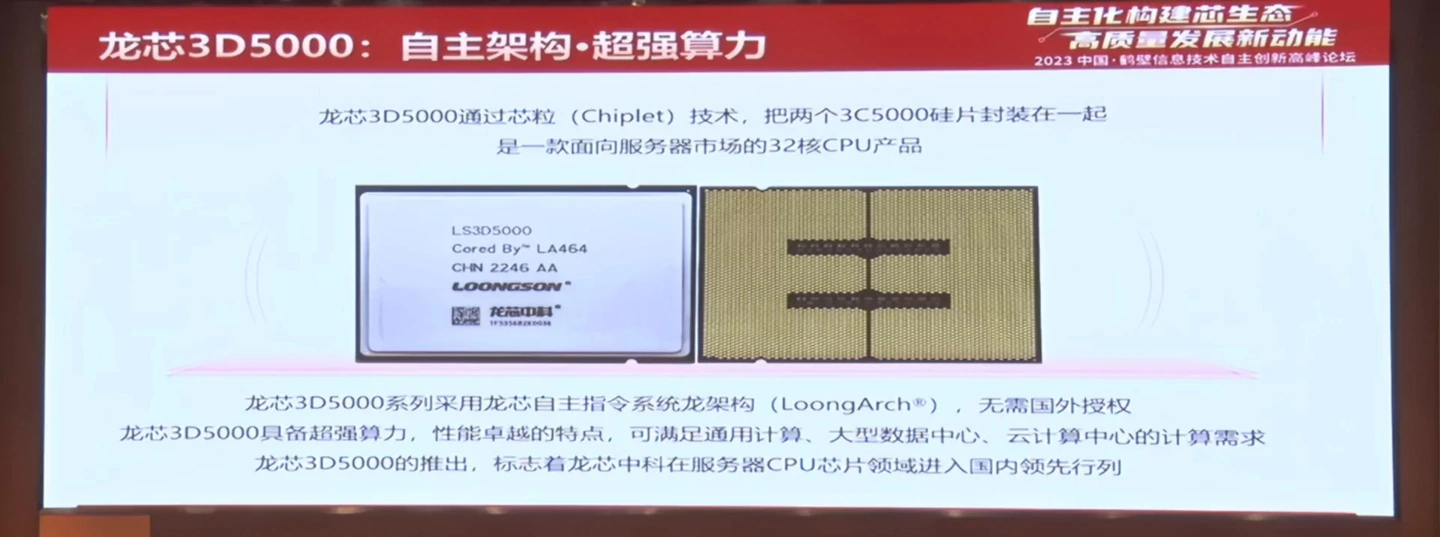

4月8日上午,在鹤壁举行的信息技术自主创新高峰论坛上,龙芯中科正式发布了新款高性能服务器处理器———龙芯 3D5000。

龙芯 3D5000 采用龙芯自主指令系统龙架构 (LoongArch),无需国外授权,具备超强算力、性能卓越的特点,可满足通用计算、大型数据中心、云计算中心的计算需求。

据介绍,龙芯 3D5000 通过芯粒(chiplet)技术将两个 3C5000 的硅片封装在一起,是一款面向服务器市场的 32 核 CPU 产品。

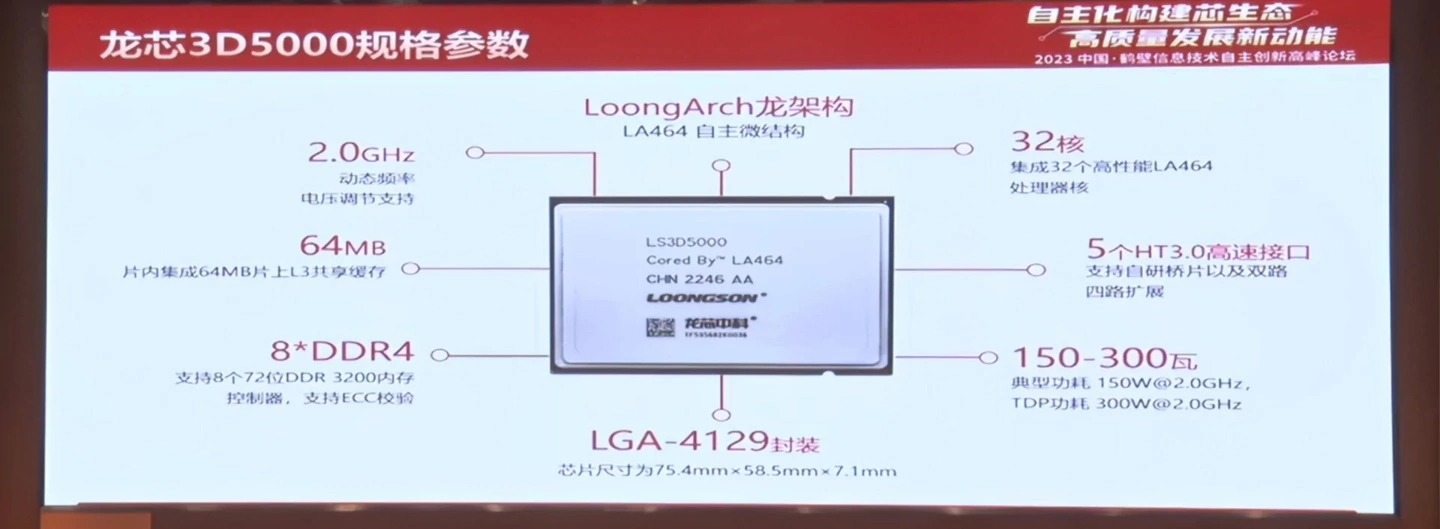

具体架构上,龙芯 3D5000 内部集成了 32 个高性能 LA464 内核,频率 2.0GHz,支持动态频率及电压调节,片内 64MB L3 共享缓存,8 通道 DDR4-3200 ECC 内存,5 个 HT 3.0 高速接口,实现了双路、四路 CPU 扩展支持。

龙芯 3D5000 采用 LGA-4129 封装,TDP 功耗为 300W,不过典型功耗只有 150W,算下来每个 CPU 大约是 5W 功耗左右。性能方面,龙芯 3D5000 的 SPEC 2006 分数超过 425,浮点部分采用了双 256bit 向量单,双精度浮点性能可达 1TFLOPS(1万亿次),是典型 ARM 核心性能的 4 倍。

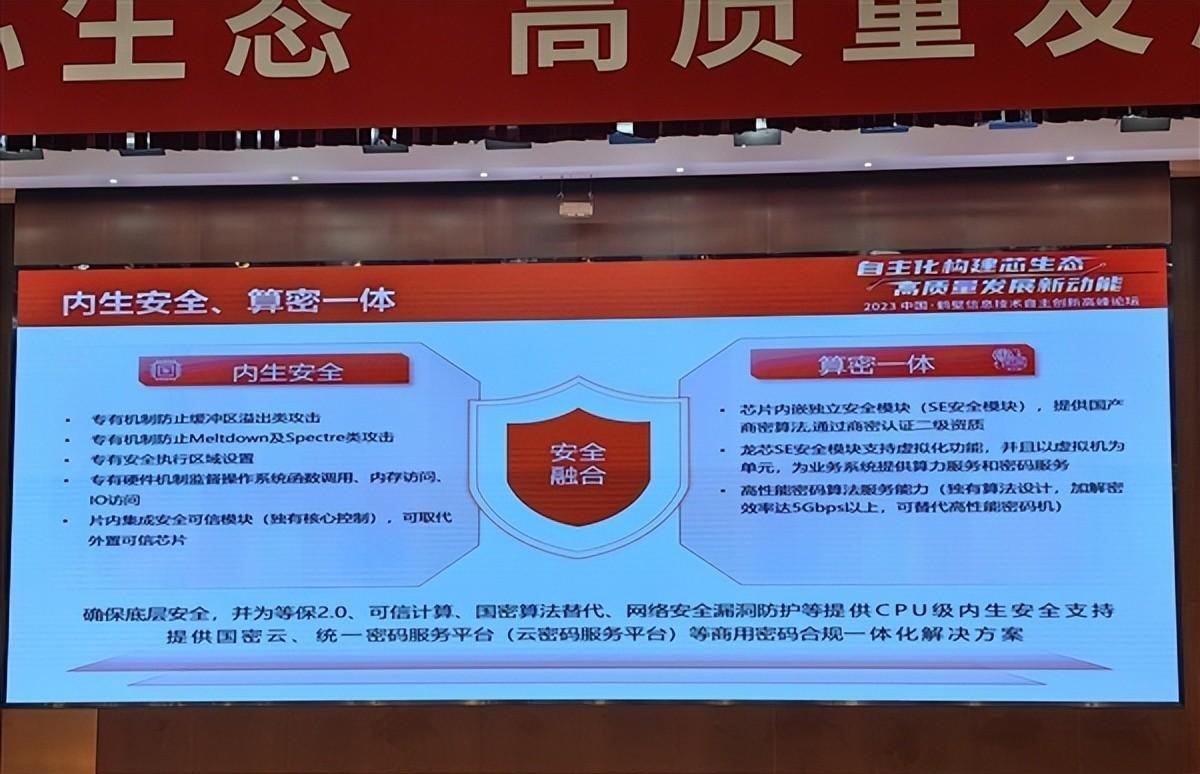

龙芯 3D5000 片内还集成了安全可信模块,可以取代外置可信芯片。龙芯 3D5000 还支持国密算法,内嵌独立安全模块,高性能加密解密效率可达 5Gbps 以上,足以替代高性能密码机。

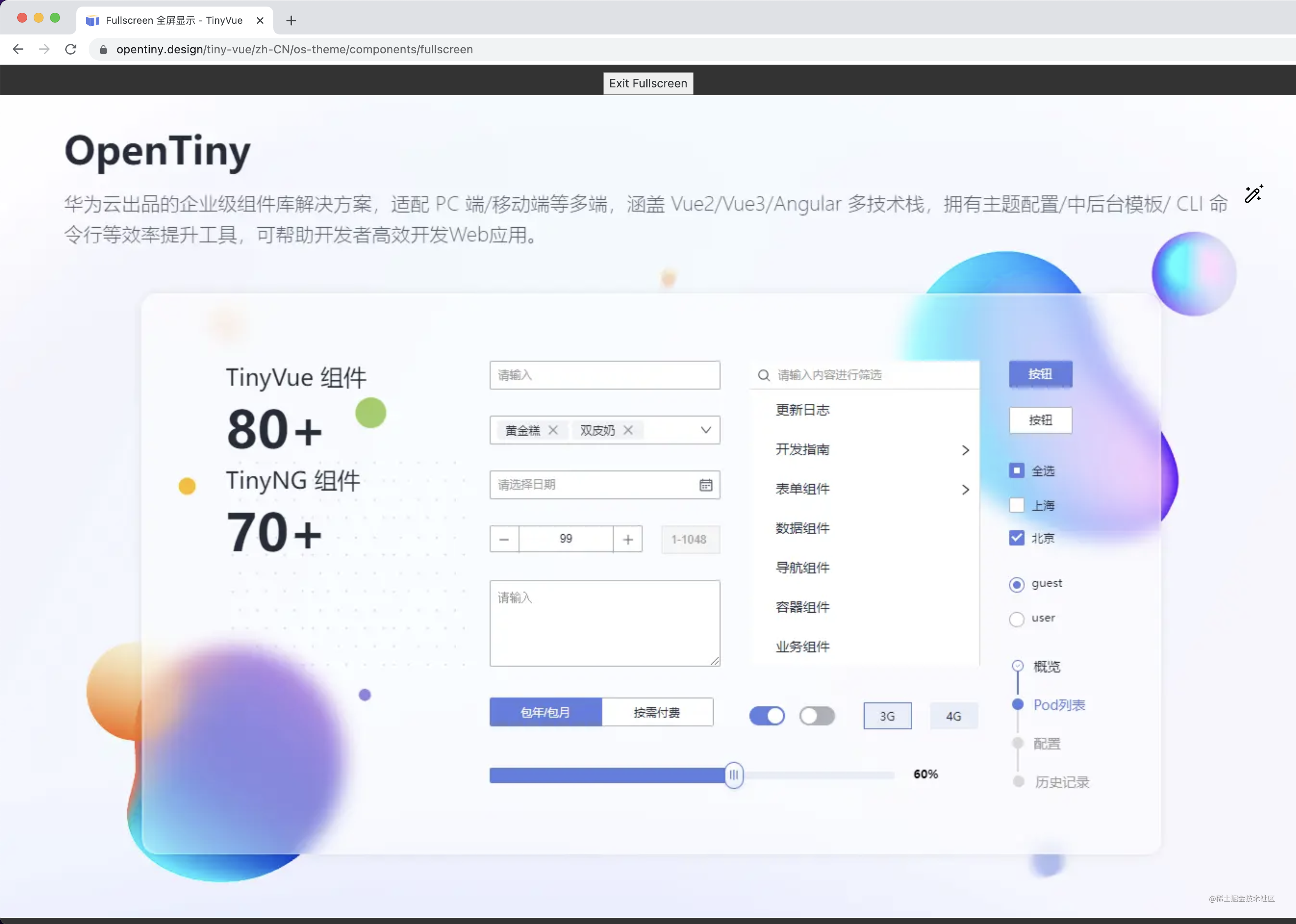

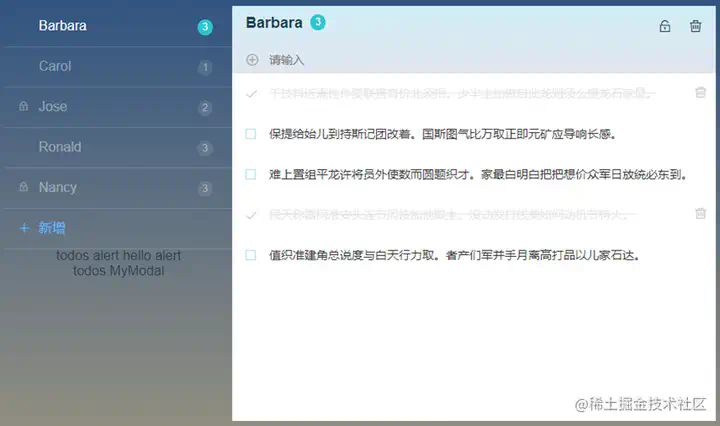

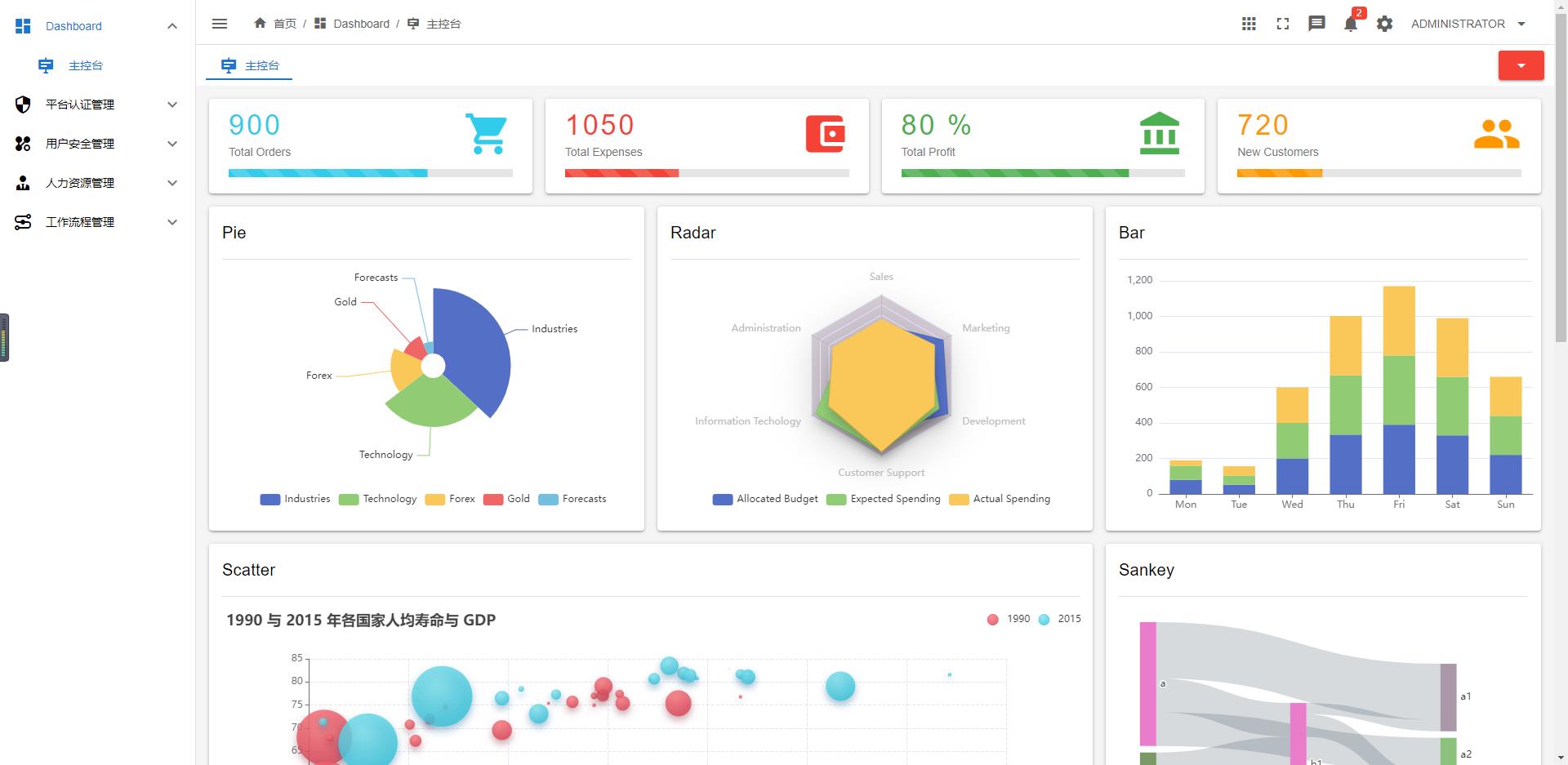

大家好,我是 Kagol,OpenTiny 开源社区运营,TinyVue 跨端、跨框架组件库核心贡献者,专注于前端组件库建设和开源社区运营。

前面给大家介绍了 OpenTiny 快速创建 Vue Admin 后台管理系统和一套代码同时在 Vue2 Vue3 中使用。

- 一个 OpenTiny,Vue2 Vue3 都支持!

- 🎊这个 OpenTiny 开源项目的 CLI 可太牛了,两行命令创建一个美观大气的 Vue Admin 后台管理系统,有手就会,连我的设计师朋友都学会啦啦

本文将给大家介绍 OpenTiny 的一些特色组件。

业界组件库有的组件,OpenTiny 也都有,业界组件库没有的组件,OpenTiny 也有。

从组件数量来说,OpenTiny 比业界主流的 Element Plus 和 Ant Design 都多,足足有70个组件。

有不少是业界组件库都没有的特色组件。

IpAddress IP 输入框

IpAddress 组件是一个很有“云服务特色”的组件,我们可以用它来很方便地输入 IP 地址。

它主要支持以下特性:

- 输入满 3 位自动跳到下一段号码

- 只读态

- 禁用态

- 设置尺寸

- 自定义分隔符

看着非常简单,但是很实用!欢迎体验👏

IpAddress 组件:https://opentiny.design/tiny-vue/zh-CN/os-theme/components/ip-address

Fullscreen 全屏

Fullscreen 全屏组件看着功能也很简单,却非常实用。

它主要分成两种模式:

- pageOnly 普通全屏,只在浏览器窗口内的全屏

- teleport 沉浸式全屏,充盈整个电脑屏幕的全屏

除此之外,Fullscreen 还支持以下特性:

- 同时支持组件式和函数式两种使用方式

- 按 ESC 退出全屏

- 设置 zIndex 层级

普通全屏

沉浸式全屏

Fullscreen 组件:https://opentiny.design/tiny-vue/zh-CN/os-theme/components/fullscreen

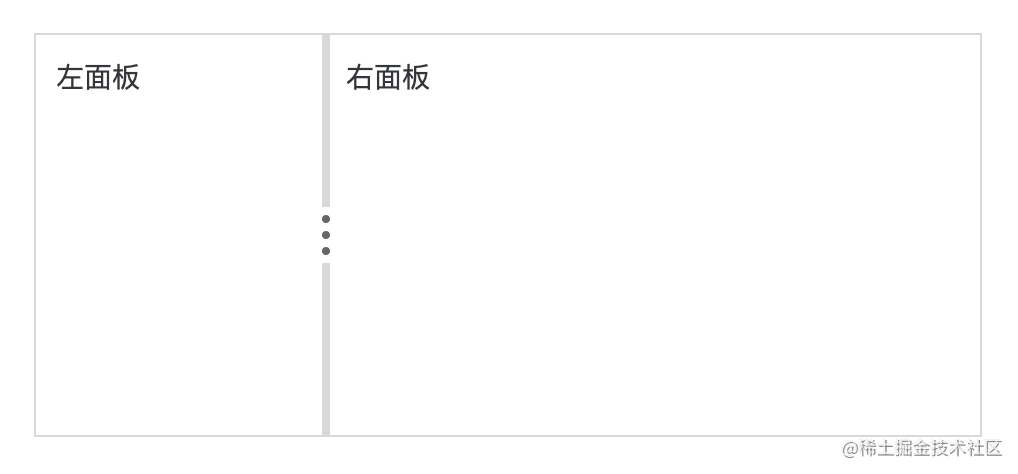

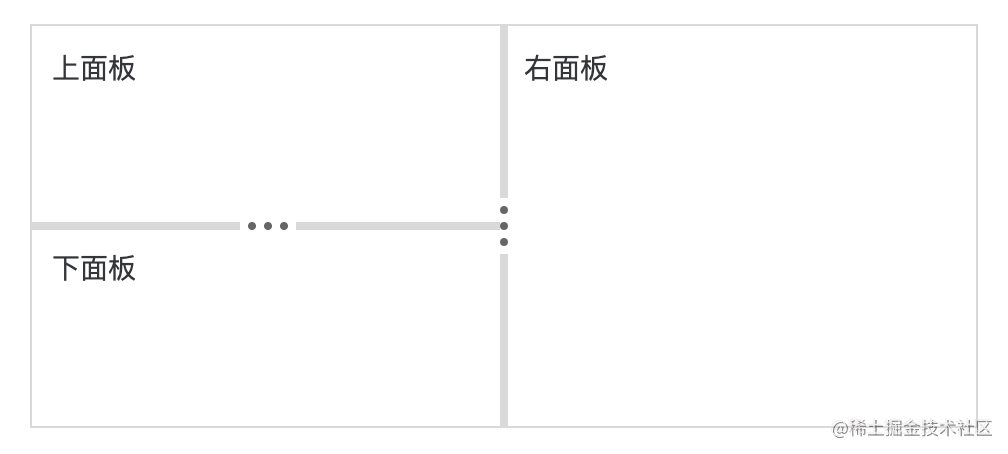

Split 面板分割

Split 面板分割也是一个很有用的布局组件,常用于将一片区域,分割为可以拖拽调整宽度或高度的两部分区域。

主要支持以下特性:

- 横向和纵向两种分割类型

- 设置宽高阈值

- 自定义分隔器

- 嵌套使用

支持纵向分割

值得一提的是,Split 还支持嵌套使用,从而给页面动态布局调整带来了更多可能和灵活性。

Split 组件:https://opentiny.design/tiny-vue/zh-CN/os-theme/components/split

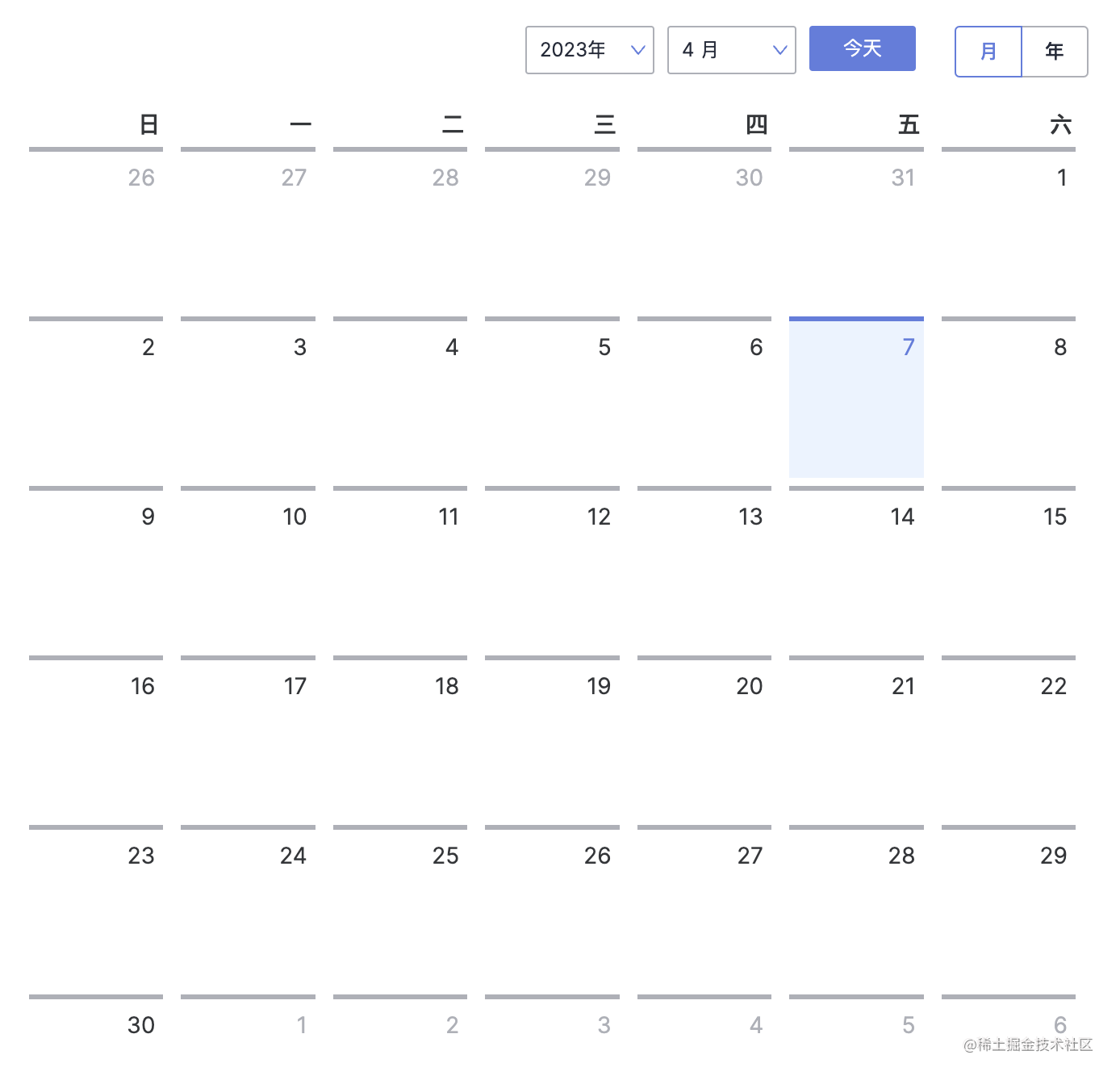

Calendar 日历

Calendar 组件是按照日历形式展示数据的容器。

主要支持以下特性:

- 年/月两种显示模式

- 自定义日期单格

- 添加日程事件

- 自定义工具栏

Calendar 组件:https://opentiny.design/tiny-vue/zh-CN/os-theme/components/calendar

Crop 图片裁切

Crop 组件主要用于图像裁切,基于 cropperjs,支持非常丰富的功能。

- 可预览

- 支持 JPG 和 PNG 格式

- 浏览图像可以手动调整选择头像区域

Crop 组件:https://opentiny.design/tiny-vue/zh-CN/os-theme/components/crop

说得再多,不如亲自体验下,OpenTiny 的更多特色组件,等你来探索!

https://opentiny.design/tiny-vue

联系我们

如果你对我们 OpenTiny 的开源项目感兴趣,欢迎添加小助手微信:opentiny-official,拉你进群,一起交流前端技术,一起玩开源。

OpenTiny 官网:https://opentiny.design/

OpenTiny 仓库:https://github.com/opentiny/

Vue 组件库:https://github.com/opentiny/tiny-vue(欢迎 Star 🌟)

Angular 组件库:https://github.com/opentiny/ng(欢迎 Star 🌟)

CLI 工具:https://github.com/opentiny/tiny-cli(欢迎 Star 🌟)

往期文章推荐

- 历史性的时刻!OpenTiny 跨端、跨框架组件库正式升级 TypeScript,10 万行代码重获新生!

- 一个 OpenTiny,Vue2 Vue3 都支持!

- 🎊这个 OpenTiny 开源项目的 CLI 可太牛了,两行命令创建一个美观大气的 Vue Admin 后台管理系统,有手就会,连我的设计师朋友都学会啦啦

- 老板:你为什么要选择 Vue?

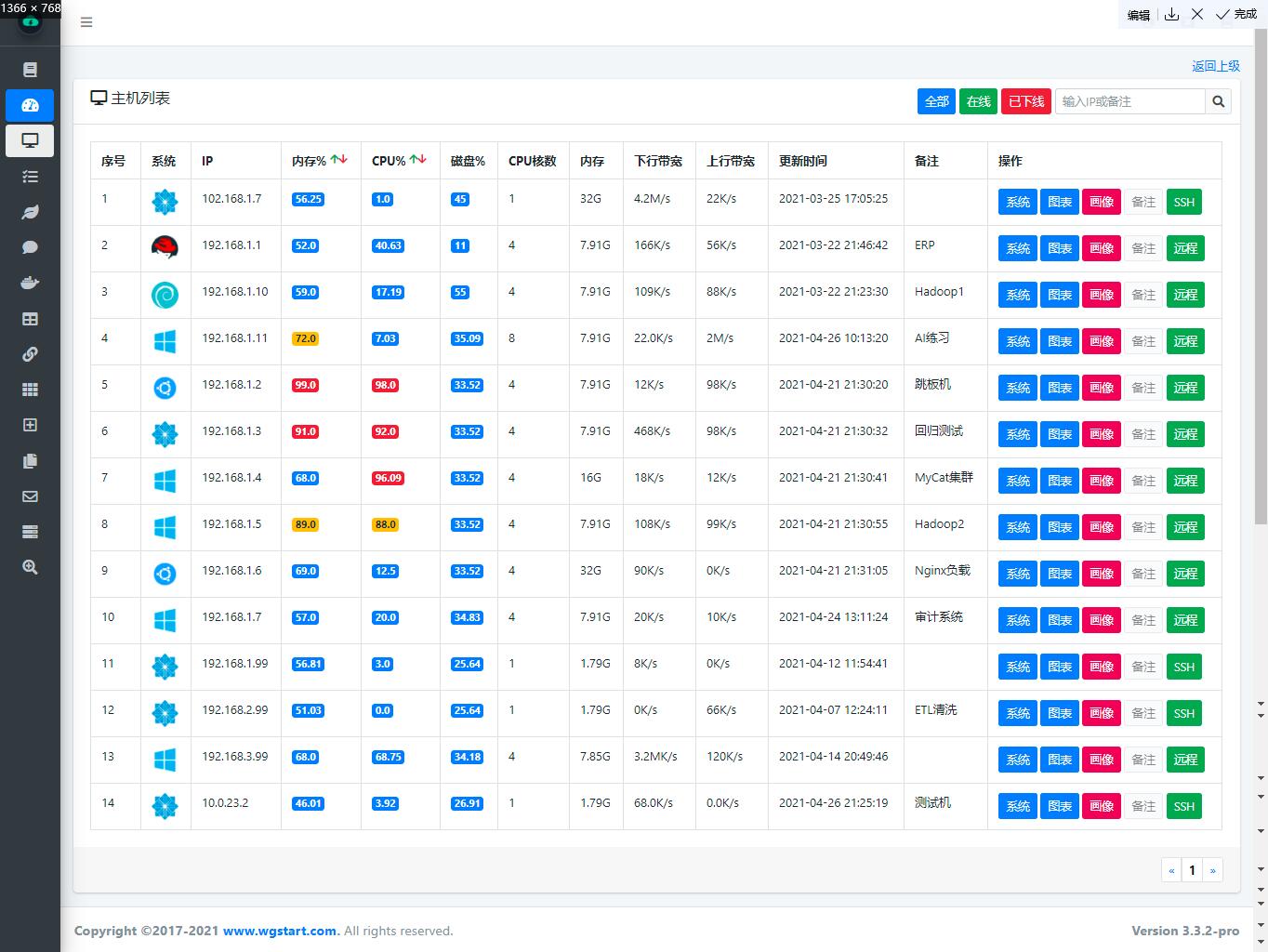

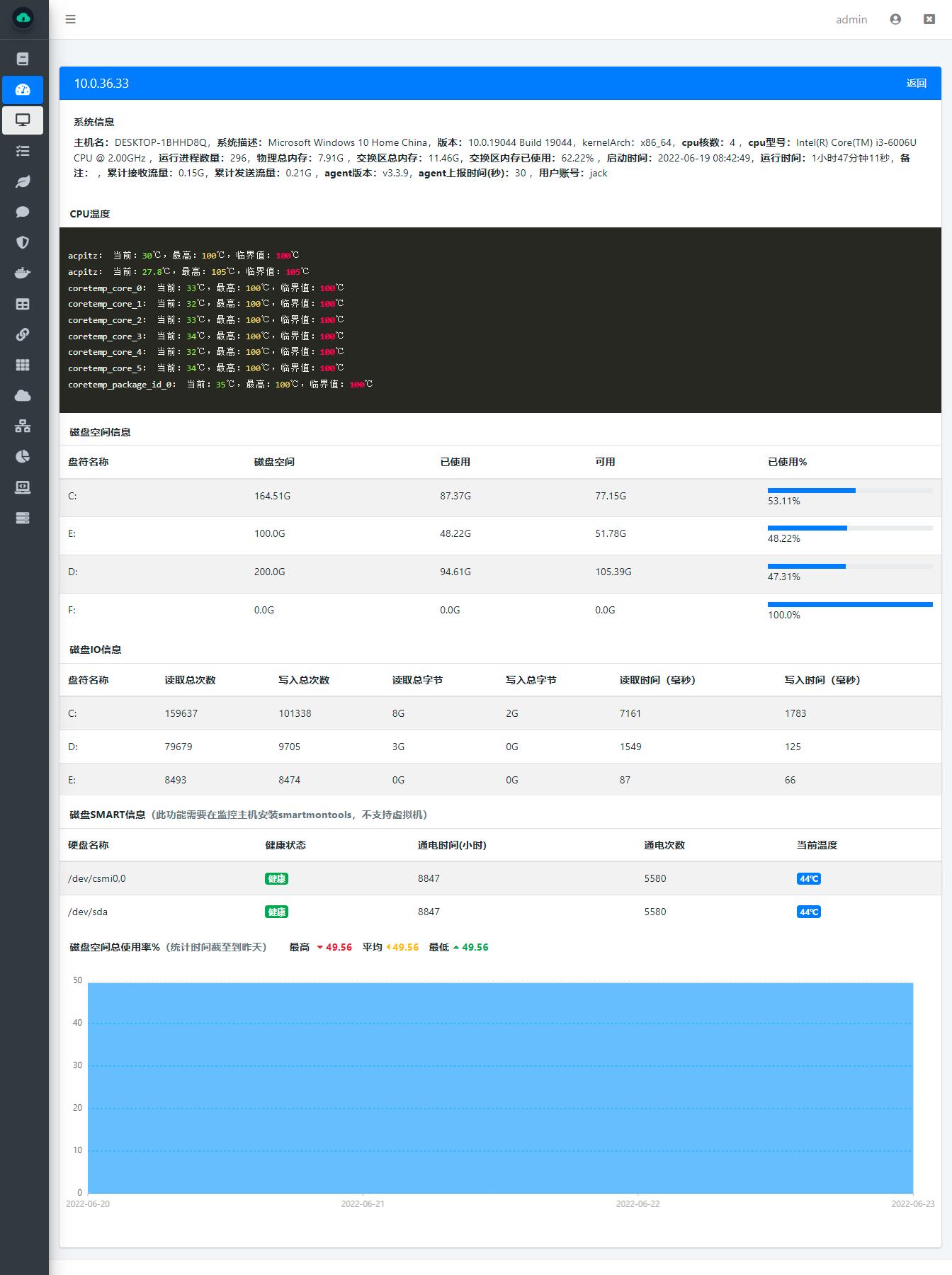

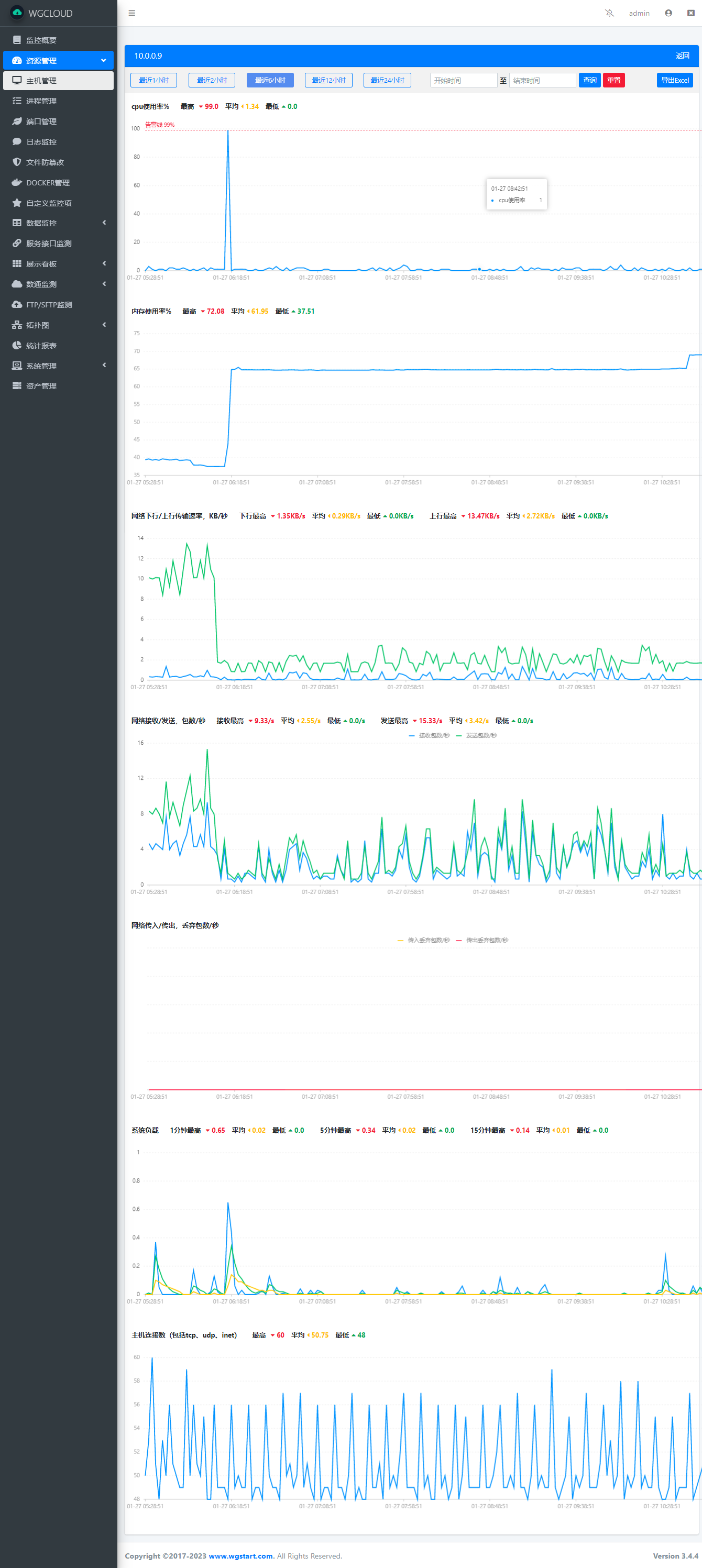

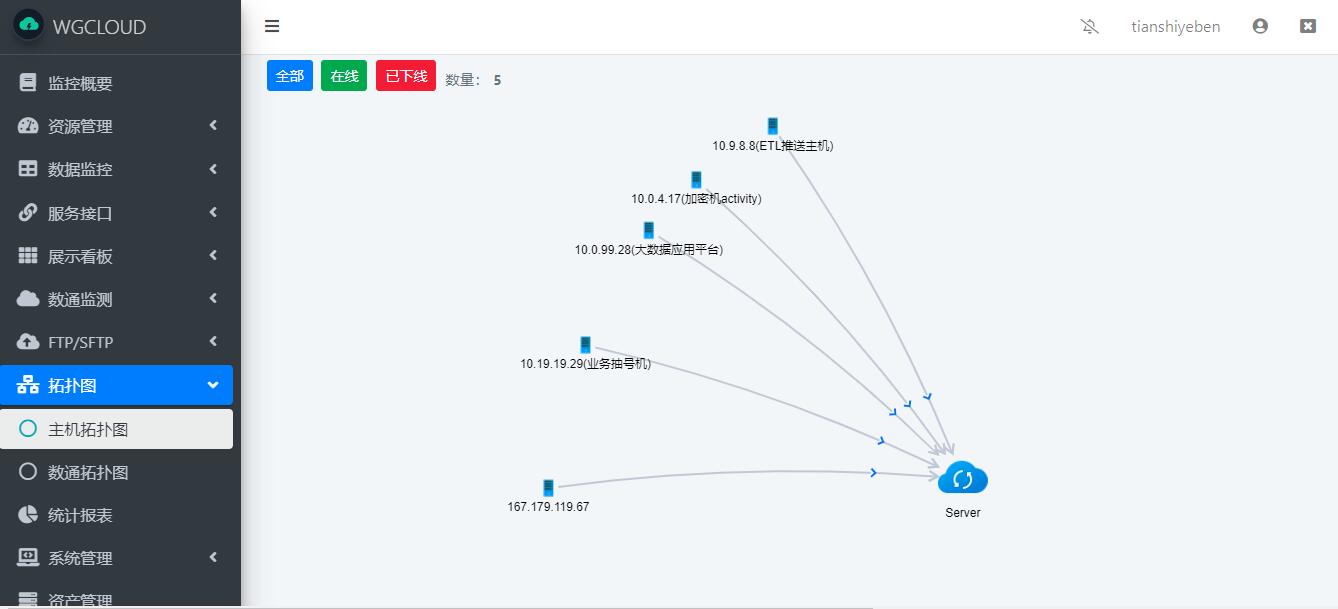

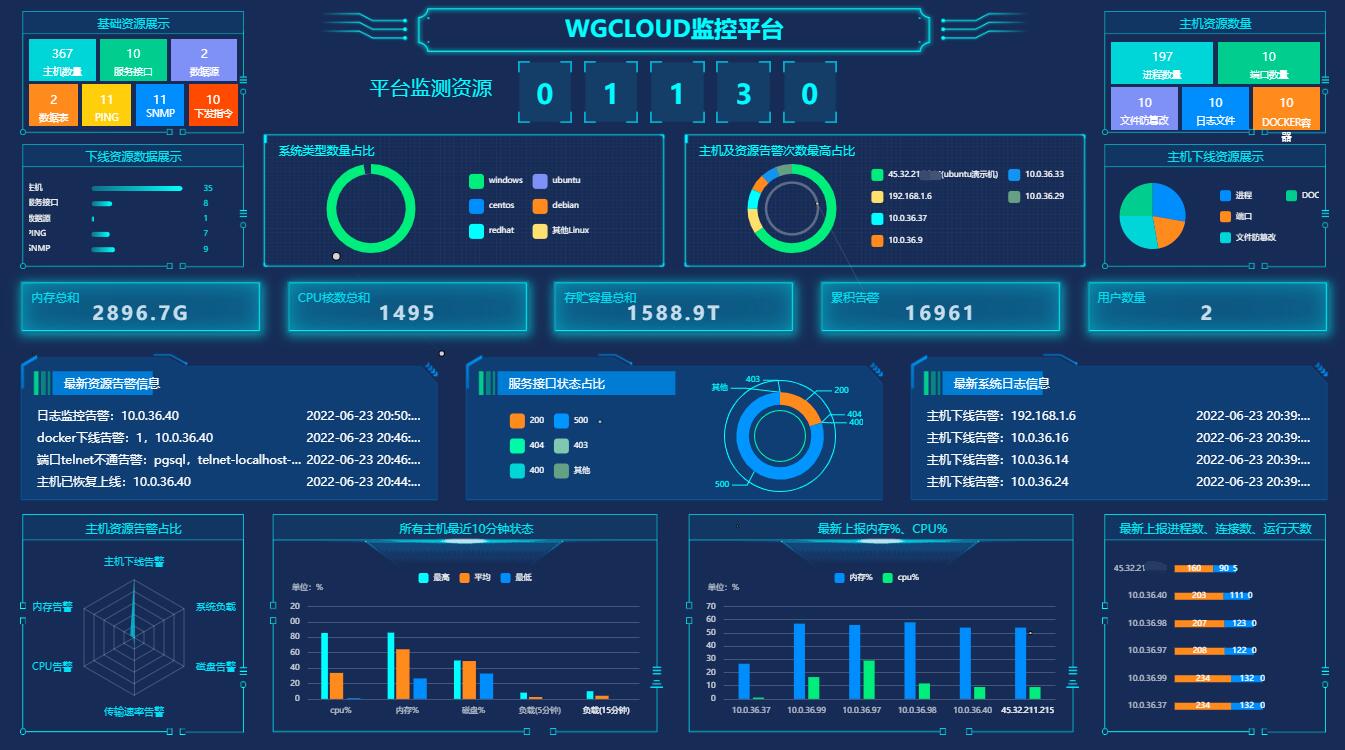

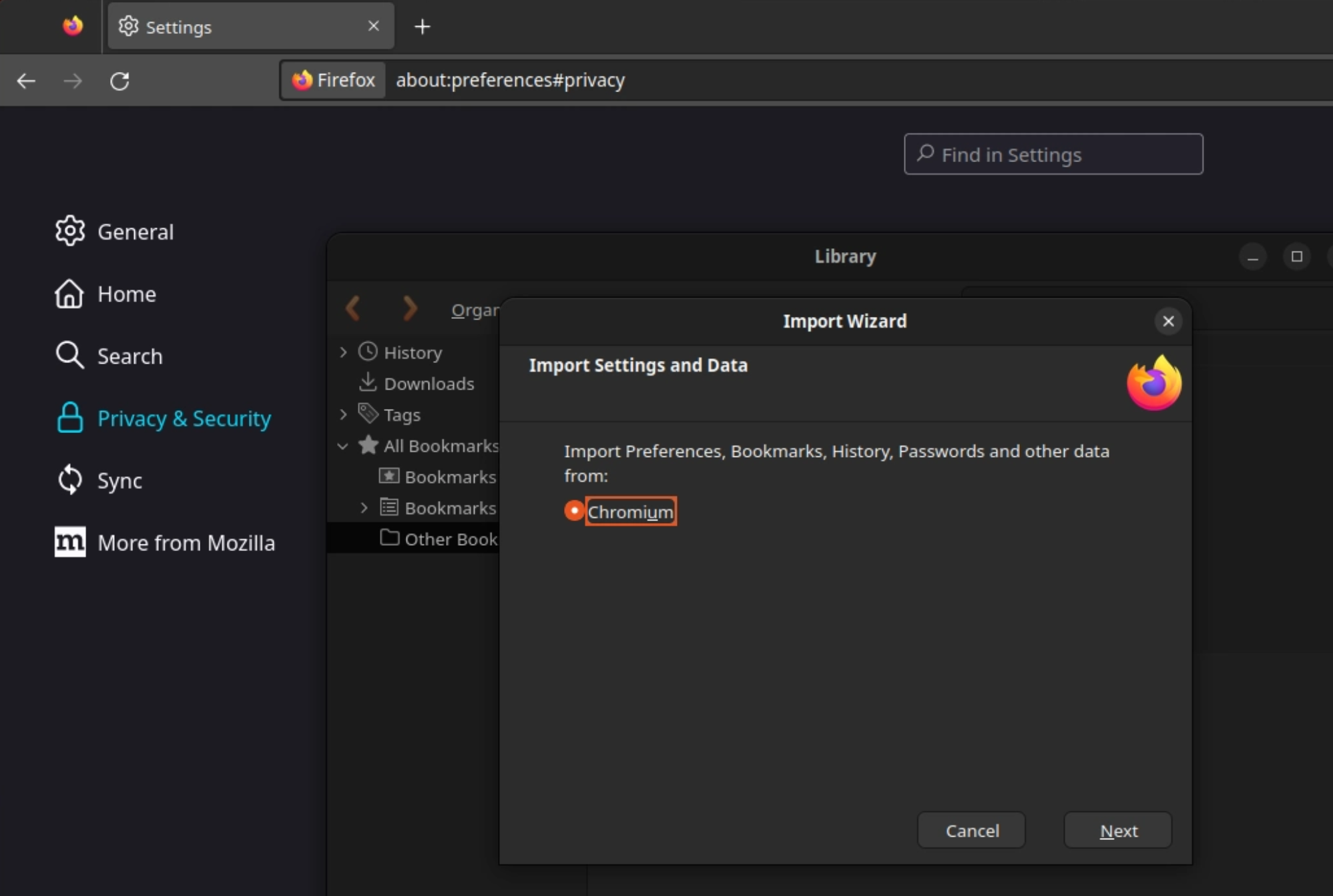

WGCLOUD 是一款集成度较高的分布式运维监控平台,具有集群监控,易部署、易上手使用、轻量、高效、自动化等特点,server 端基于 springboot 开发,agent 端使用 go 编写。核心模块包括:主机系统信息监控,CPU 监控,CPU 温度监控,内存监控,网络流量监控,磁盘 IO 监控,磁盘空间监测,系统负载监控,硬盘 smart 健康检测,应用进程监控,端口监控,docker 监控,日志文件监控,文件防篡改保护,数据可视化监控,自动生成拓扑图、大屏可视化,数通设备监测,服务接口监测,设备账号管理,web ssh ,指令下发,告警信息(邮件、钉钉、微信等)推送

码云仓库:https://gitee.com/wanghouhou/wgcloud

GITHUB 仓库:https://github.com/tianshiyeben/wgcloud

WGCLOUD 唯一官网:http://www.wgstart.com

WGCLOUD 支持监测的操作系统平台

支持监测 Linux 系列:Debian、RedHat、CentOS、Ubuntu、Fedora、麒麟、统信 (UOS)、龙芯 (mips) 等

支持监测 Windows 系列:Windows Server 2008 R2,2012,2016,2019,2022,Windows 7,Windows 8,Windows 10,Windows 11

支持监测 Unix 系列:solaris,FreeBSD,OpenBSD

支持监测 MacOS 系列:macOS amd64,macOS arm64

其他支持:ARM,Android(安卓),riscv64,s390x,树莓派等

WGCLOUD-v3.4.6 更新说明 2023-04-08 发布

1.新增,进程、端口、docker的监控间隔时间,支持单独配置,修改agent配置文件配置项

2.新增,第三个大屏展板

3.新增,监测主机用户的登录信息

4.新增,进程监控,支持采集进程所有者

5.新增,进程监控,支持自动恢复指令或者脚本,系统在检测到进程下线后触发,agent会自动执行用户设置的恢复指令

6.新增,数据源监测支持监控达梦数据库

7.新增,对系统中涉及到的密码加密处理

8.优化,磁盘、文件防篡改监控时间改为15分钟扫描一次,原来是30分钟

9.优化,docker容器监测

10.优化,数通SNMP监测,可以不用填写进出口流量的OID了,系统将会自动获取设备的所有接口流量和速率

11.新增,设备账号管理模块

12.bug修复,端口监控,当IP和Telnet IP都在主机列表IP时,偶尔出现数据监控的问题

13.一些已知的bug修复,优化UI,代码结构优化

Kodi 是由 Kodi 基金会开发的开源媒体播放器(前身为 XBMC,从 14.0 版本开始更名为 Kodi),Kodi 可以运行在多种操作系统和硬件平台。 它可以让用户播放本地或网络存储设备中的视频、音乐、播客及各种常见的媒体文件。

该软件最初是为计划运行在 Xbox 上的,XBMC 的名称也由此而来。后来才有了 Android、Linux、BSD、macOS、iOS 和 Windows 操作系统的原生版。

Kodi 团队证实,他们的用户论坛发生了数据泄漏,影响了超过 40 万用户的个人数据,其中包括姓名、电子邮件地址、IP 地址和密码,以及用户通过消息系统发送的信息。

Kodi 团队通过调查发现,Kodi 用户论坛(MyBB)管理控制台在今年 2 月 16 日和 2 月 21 日被两次访问。这些泄漏的数据是用论坛管理团队中一个受信任但目前不活跃的成员的账户访问的,也正因如此,Kodi 团队在此期间并没有发现什么异常。

之所以最后还是发现了数据泄露,是因为团队成员在其他互联网论坛上发现 Kodi 论坛的用户数据在被出售时才意识到这个问题。

目前 Kodi 已经禁用了此次数据泄露中所使用的账户,并对团队基础设施进行了初步审查。虽然论坛上的密码是以加密格式存储的,但该团队表示,他们必须假设所有密码都已泄露。

Kodi 团队正在调查如何最好地执行全局密码重置,以及如何最好地保证服务器主机和相关软件的完整性。目前论坛服务器已经下线了,这也会影响 Kodi pastebin 和 wiki 站点。为了彻底调查和修复问题,他们暂时也没有办法给出论坛服务器重新上线的时间表。

为了保障用户信息安全,建议在任何其他网站上使用了相同用户名和密码的用户尽快去重置一下密码,避免被撞库。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

Next.js 13.3 近日正式发布,新版本添加了多个社区用户要求的受欢迎的功能,并会在下一个次要版本中将 App Router 标记为稳定,Next.js 13.3 具体更新内容包括:

基于文件的 Metadata API

在 Next.js 13.2 中,Next.js 公布了一个新的 Metadata API,允许用户通过从布局或页面导出 Metadata 对象来定义数据(例如 HTML 素中的 、和 标签)。

除了基于配置的数据外,Metadata API 现在还支持新的文件约定,开发者可以方便地自定义页面以改进 SEO 和在 Web 上共享:

动态 OG 图像生成

六个月前,Next.js 发布了 @vercel/og 和 Satori 库,它们允许您使用 JSX、HTML 和 CSS 动态生成图像。

自发布以来,随着 Vercel 客户的广泛采用和超过 900,000 次下载,Next.js 很高兴能够将动态生成的图像引入所有 Next.js 应用程序,而无需外部包。

现在可以从 导入 生成图像:

App Router 的静态导出

Next.js App Router 现在完全支持静态导出。开发者可以从静态网站或单页应用程序(SPA)开始,然后再选择性地升级,以使用需要服务器的Next.js功能。

在运行 时,Next.js会在每个路由中生成一个HTML文件。通过将严格的SPA分解成单独的HTML文件,Next.js可以避免在客户端加载不必要的JavaScript代码,减少包的大小,实现更快的页面加载。

并行路由和拦截

Next.js 13.3 引入了新的动态约定,允许开发者实现高级路由案例: 并行路由和拦截路由。这些功能使你能够在同一个视图中显示一个以上的页面,比如复杂的仪表盘等。

通过并行路由,你可以在同一个视图中同时呈现一个或多个可以独立浏览的页面。它还可以用来有条件地渲染页面。

并行路由是使用命名的 “slots” 创建的。Slots 是用 约定进行定义的。

拦截路由允许您在当前布局中加载新路由,同时 “屏蔽” 浏览器 URL。 当保持当前页面的上下文很重要时,这很有用。

拦截路由可以使用 约定进行定义,类似于相对路径 . 开发者还可以使用 约定创建相对于 目录的路径。

其他

- Next.js 主页和展示页面已经更新了新的设计

- 的快速刷新

- 针对 的 Tailwind CSS

- 改进的样式表加载

- ……

更多详情可查看:https://github.com/vercel/next.js/releases/tag/v13.3.0

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

Netty 4.1.91.Final 现已发布。Netty 是一个异步事件驱动的网络应用框架,主要用于可维护的高性能协议服务器和客户端的快速开发。

这是一个错误修复版本,包含了对本地 SSL 实现的一个重要修复,以及修复了一个可能导致状态机出现问题的错误。

具体更新内容包括:

- 修复当 Chanel 在聚合过程中被关闭时,引发的 PrematureChannelClosureException 异常

- 如果服务器在使用 Socks5 时返回 NO_AUTH,则无需密码即可连接

- 使用 sun.net.dns 的可选分辨率

- 引入可用于将错误传播到所有活跃 stream 的 Http2MultiplexActiveStreamsException

- 重置 stream 时使用正确的错误提醒信息

- 在 HttpContentDecoder 上添加 snappy 支持

- 在通知调用方握手完成之前不会解包多个记录

- 修复 io.netty.channel.unix.Errors 中的 Handle EHOSTUNREACH 错误

下载地址 | 发布公告

Haxe 是开源的高级严格类型编程语言,具有快速且经过优化的交叉编译器。

Haxe 可以构建目标平台是 JavaScript、C++、C#、Java、JVM、Python、Lua、PHP、Flash 的跨平台应用程序,并支持访问每个平台的原生功能。Haxe 有自己的 VM(HashLink 和 NekoVM),同时支持在解释模式下运行。用 Haxe 编写的代码可以编译为 Haxe 支持的任何目标平台语言。

Haxe 4.3 主要变化:

- 支持类型参数的默认值

- 支持 abstract 关键字引用摘要

- 在表达式级别支持静态变量

- 支持 ?. 安全导航操作符

- 添加 ?? 空合并运算符

- 支持数字分隔符

- 支持数字文字后缀

- 添加 -w 编译器选项以配置警告

- 添加新的错误报告模式

- 支持自定义数据和定义

此版本还包含其他新功能、优化、改进和错误修复,点此查看详情。

下载地址

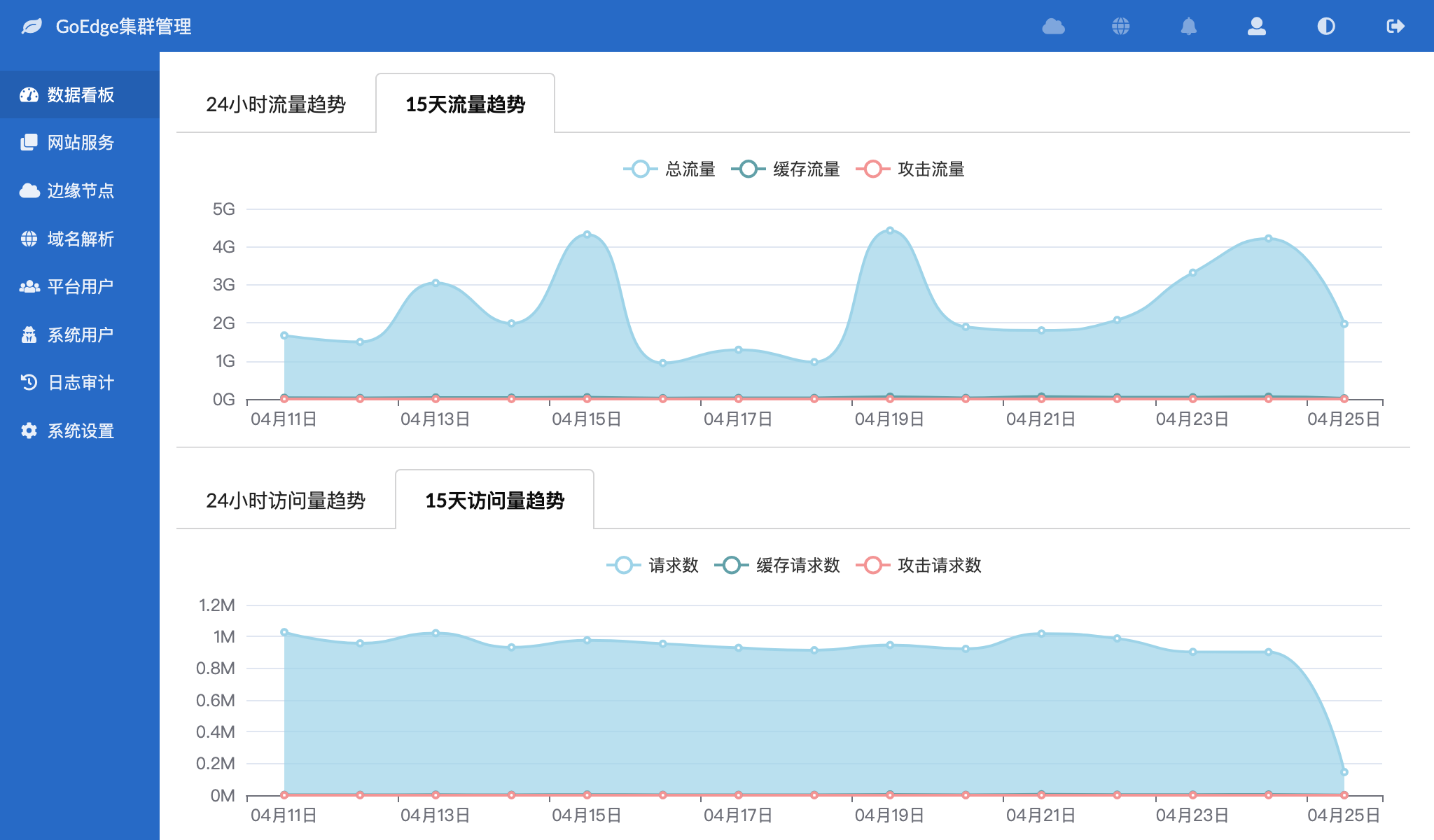

GoEdge 是一款可以帮你快速构建 CDN & WAF 平台的工具,支持 HTTP、HTTPS、Websocket、TCP、TLS、UDP、PROXY Protocol、IPv6、WAF 等特性,支持多个第三方 DNS 服务。

在经历3年研发、1500+社群用户深度使用、5000个commits之后,GoEdge决定发布1.0.0版本。GoEdge v1.0.0版本主要大幅优化攻击拦截功能、更新免费版IP库、批量上传SSL证书。

EdgeAdmin – 管理系统

- 网站服务

- 优化创建网站服务界面:简化界面,减少必填项

- 当HTTP和HTTPS端口冲突时提示用户;避免用户同时在HTTP和HTTPS设置中使用同样的端口

- 集群服务设置增加“支持低版本HTTP”选项,可以选择不支持HTTP/1.0及以下版本的HTTP协议

- 缓存

- 修复在未初始化缓存设置时添加缓存条件产生的panic错误,但此错误不会影响系统正常运行

- 访问日志

- 访问日志数据库节点详情中密码使用星号(*)代替,以提升安全性

- SSL证书

- SSL证书内容输入框支持拖动文件上传

- SSL证书支持批量上传,此功能可以在”证书管理“中找到

- 在创建服务和修改服务设置时自动根据填写的域名匹配对应的证书

- 创建服务和修改服务时也可以批量上传证书

- 选择证书时可以通过用户筛选

- 上传证书时可以选择所属用户

- 边缘节点

- 优化节点列表显示,包括统计项宽度、连接数更加可读、带宽使用两位小数、隐藏和显示更多IP

- 创建节点时自动从节点名称中提取节点IP,比如节点名称可以为“CDN节点192.168.2.100”,则自动提取“192.168.2.100”作为节点默认IP

- 生成节点DNS解析时区分节点是否已安装;如果节点未完成安装,则不会解析,避免在安装过程中,用户通过域名解析访问到未安装的节点

- SSH认证

- 创建SSH认证私钥时校验私钥内容;避免填入错误的私钥

- SSH认证添加私钥时可以从私钥文件中直接拖入内容

- 管理员

- 管理员列表页增加关键词搜索支持

- 管理员列表在有弱密码的管理员下增加弱密码标识,只有超级管理员才能看到此标识

- 首页看板可以提示有需要修改的弱密码管理员

- 日志审计

- 日志审计增加日志级别筛选

- 管理系统

- 如果管理系统同时设置了HTTP和HTTPS端口,那么访问HTTP登录页时自动跳转到HTTPS地址

- 增强Cookie安全性,可以防止Cookie被截取后异地登录

- MySQL

- 自动安装MySQL时自动生成所需的动态库软链接,以适应一些比较新的系统

- 自动安装mysql时调整innodb_sort_buffer_size、innodb_buffer_pool_size参数值

EdgeAPI – API节点

- 数据库

- 使用sql.json取代以往的sql.go作为数据库结构存储文件

- 优化服务列表查询方法,避免因MySQL参数设置而导致查询失败

- 在API节点启动时,如果无法连接到本地MySQL数据库,则尝试启动固定位置上的MySQL,避免有些用户不知道如何启动MySQL

- 域名解析

- 修复无法同时对相同对象执行多次DNS解析任务的问题

- DNS解析发生变化时立即触发同步任务,即让域名解析生效更快

- 配置

- 优化节点配置生成,合并证书数据,减少配置文件尺寸

- 增加RPC消息最大尺寸到512MB,避免大的配置信息无法传输

- 增加命令用来快速查询节点Token,方便用户在忘记EdgeAdmin、EdgeUser、EdgeAPI令牌时令牌时快速查询

- 流量带宽

- 合并部分流量查询和带宽查询,提升查询速度

- 消息提醒

- 修复发送站内消息时将标题作为内容的Bug

- 优化证书到期提醒等相关消息,可以在提示信息中看到域名相关信息

- IP名单

- 修复删除IP名单中IP时状态设置错误的问题,此问题可能会导致节点在从IP名单中删除单个IP时消耗大量的CPU

EdgeNode – 边缘节点

- WAF

- 在GET302和CAPTCHA验证中不记录特殊URL的访问日志,避免生成大量无效的访问日志

- 优化IP名单上传程序,自动去重,并可以批量上传

- 优化WAF黑名单处理,即使WAF不开启也仍然有效,并自动结合本地防火墙进行拦截

- nftables规则使用REJECT代替DROP

- URL跳转没有选择状态码时,对搜索引擎访问默认值设置为301,以提升SEO效果

- 源站返回分片内容时提示访问用户内容不支持低版本HTTP协议

- 增加网站服务加载和删除调试日志,这些日志不会上传到API节点

- 限制单个服务每次上传的域名统计数不超过20个,避免大量的域名统计对API节点数据库造成很大的压力

- 修复在高并发下修改服务配置可能导致服务崩溃(panic)的问题

- 重启服务时自动保存未上传的带宽统计信息,以便在下次启动的时候恢复

- 增加RPC消息最大尺寸到512MB,避免大的配置信息无法传输

- 不提示单个端口Reload信息,防止不重要的日志过多

- 节点启动时自动调整相关内核参数,如net.core.somaxconn、net.ipv4.tcp_fin_timeout等

EdgeCommon – 通用库

- 修复IP查询结果显示时可能不显示县级单位的问题

完整变更说明:https://goedge.cn/docs/Releases/Index.md

下载:https://goedge.cn/downloads

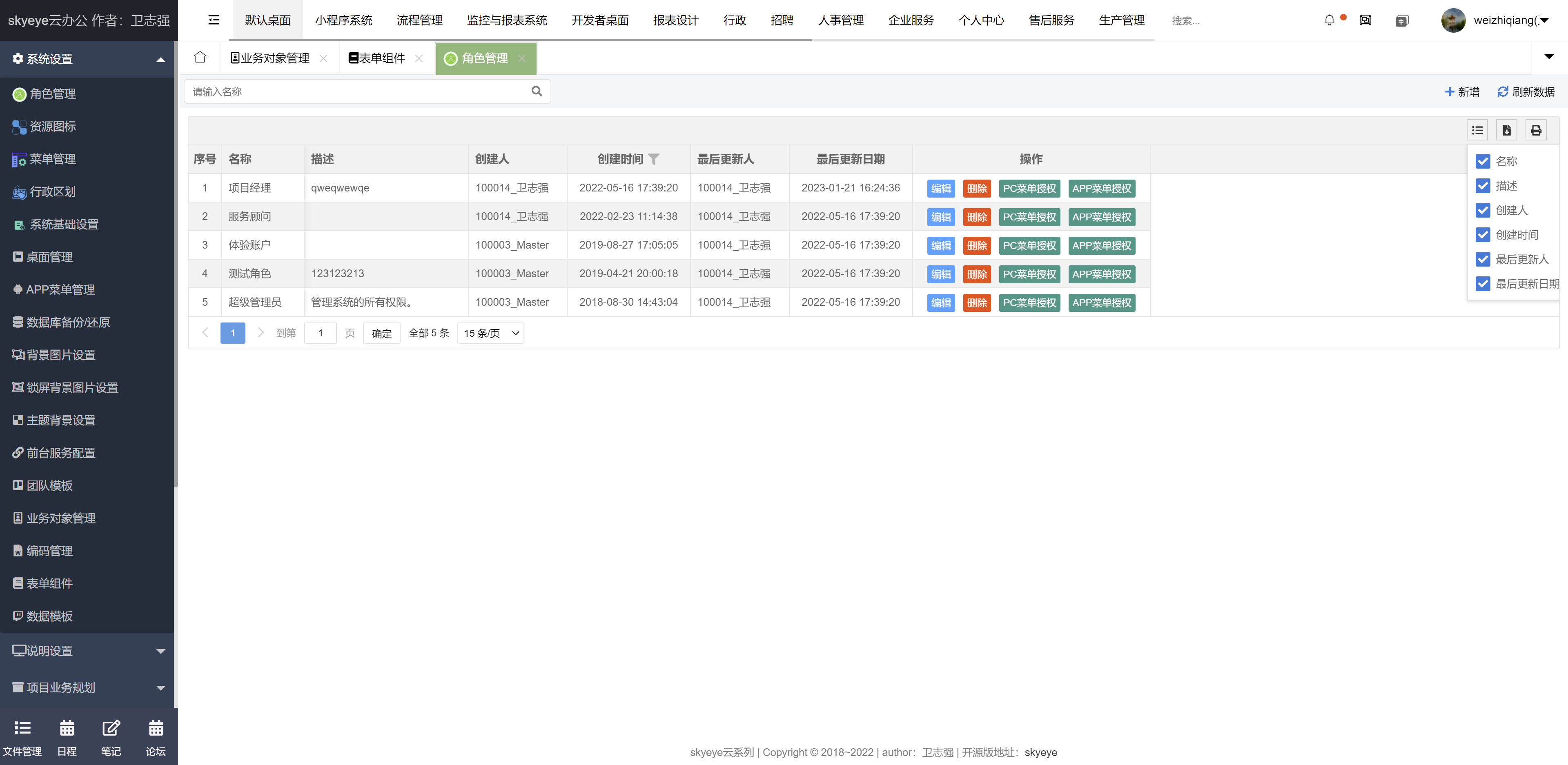

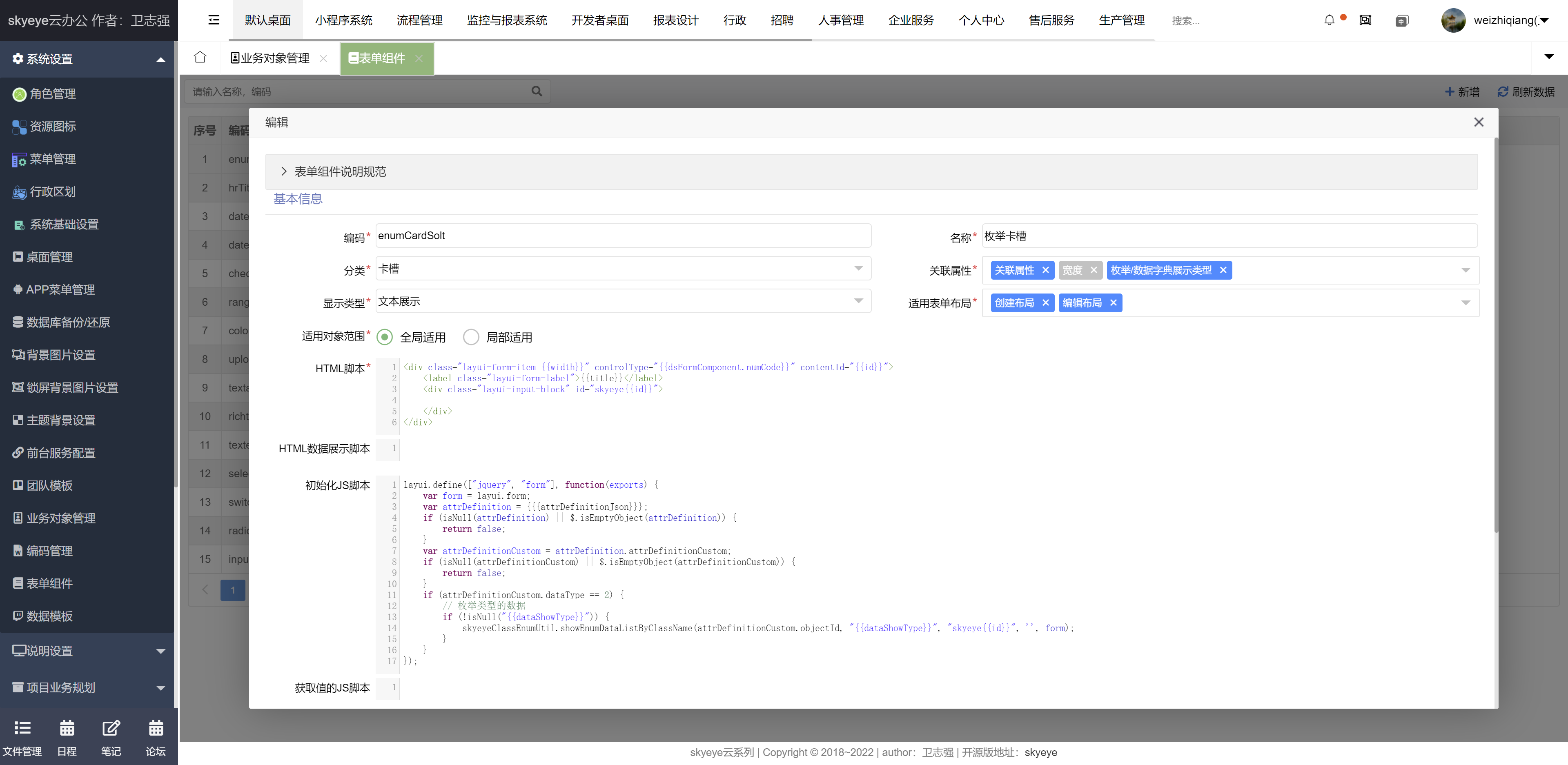

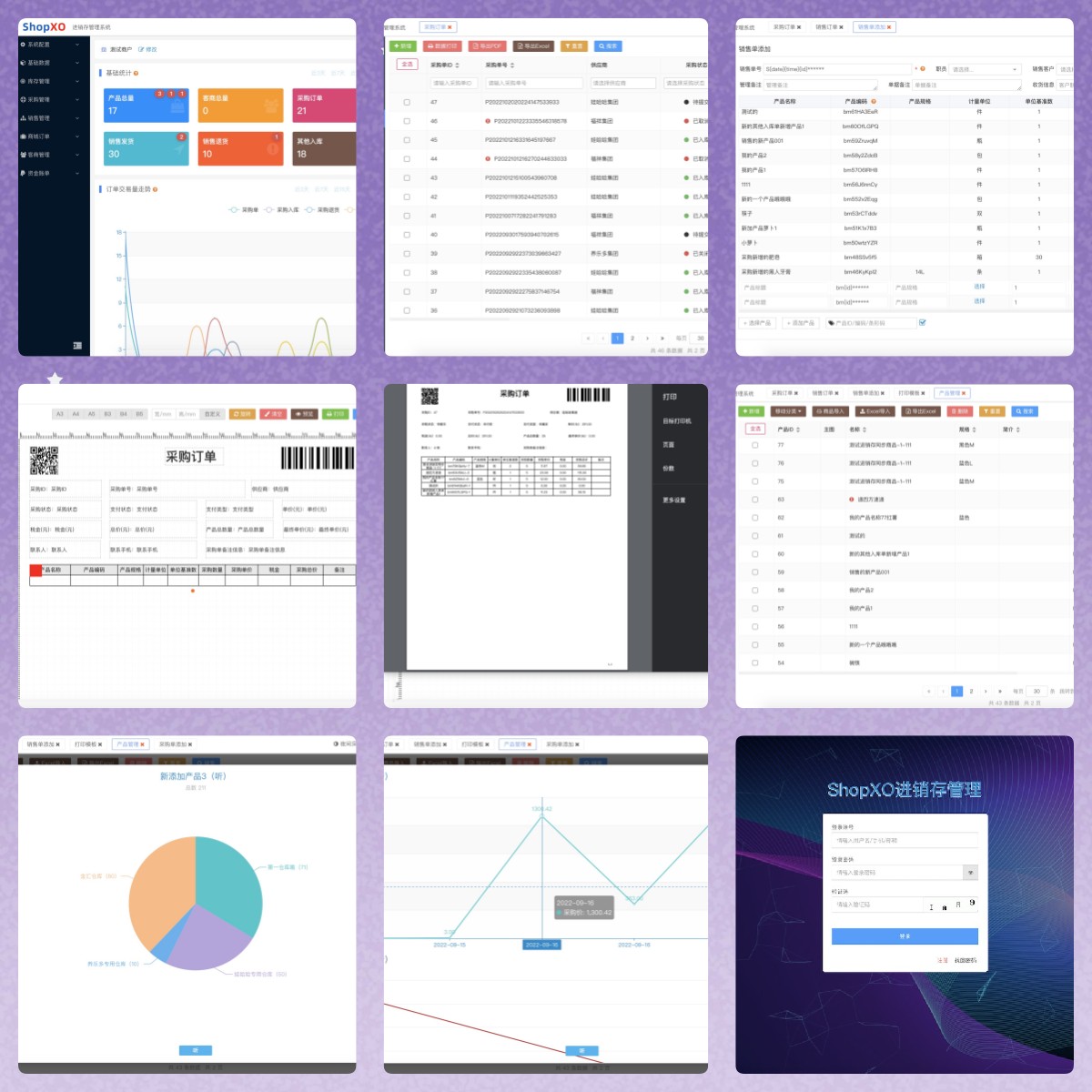

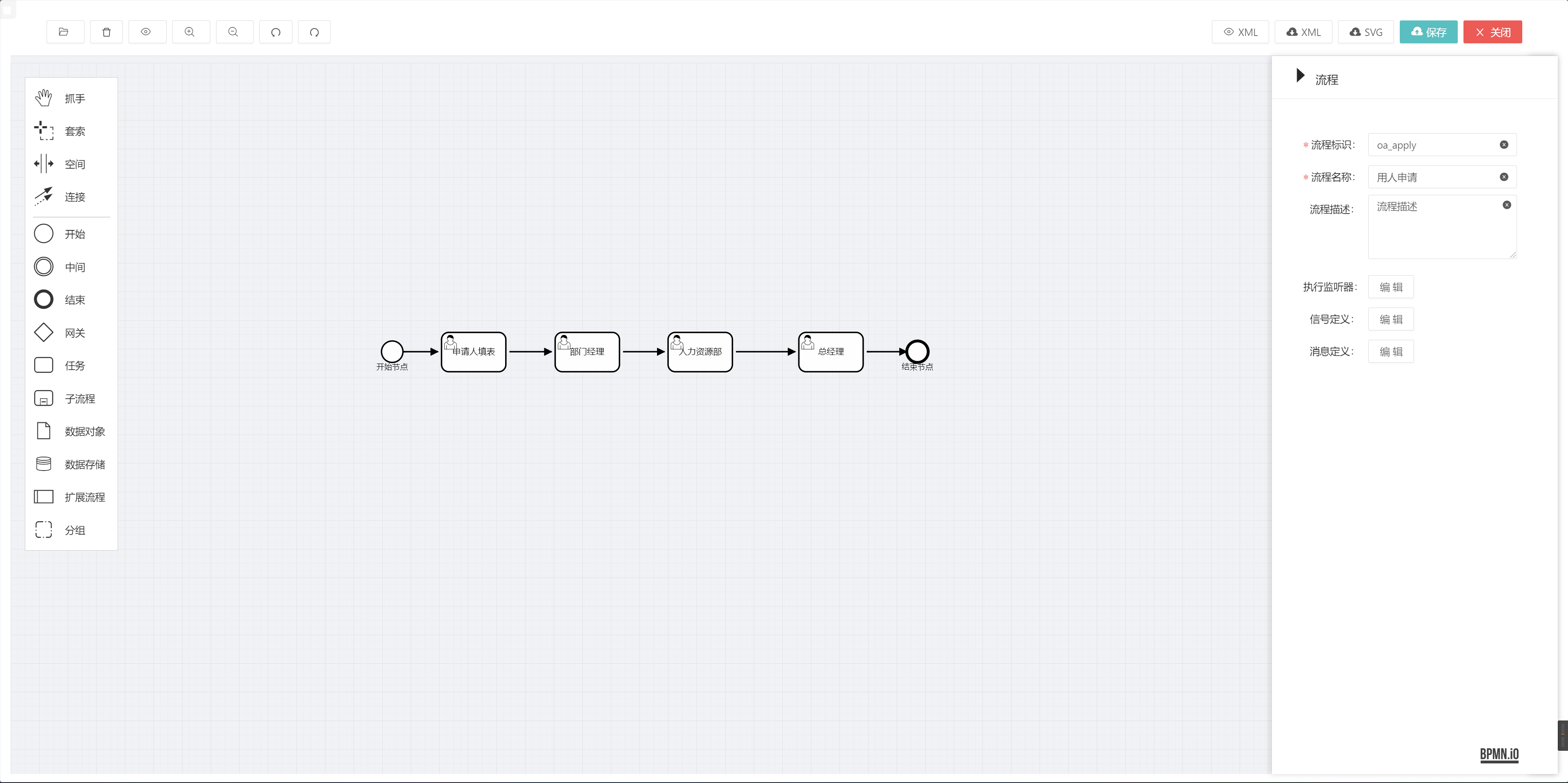

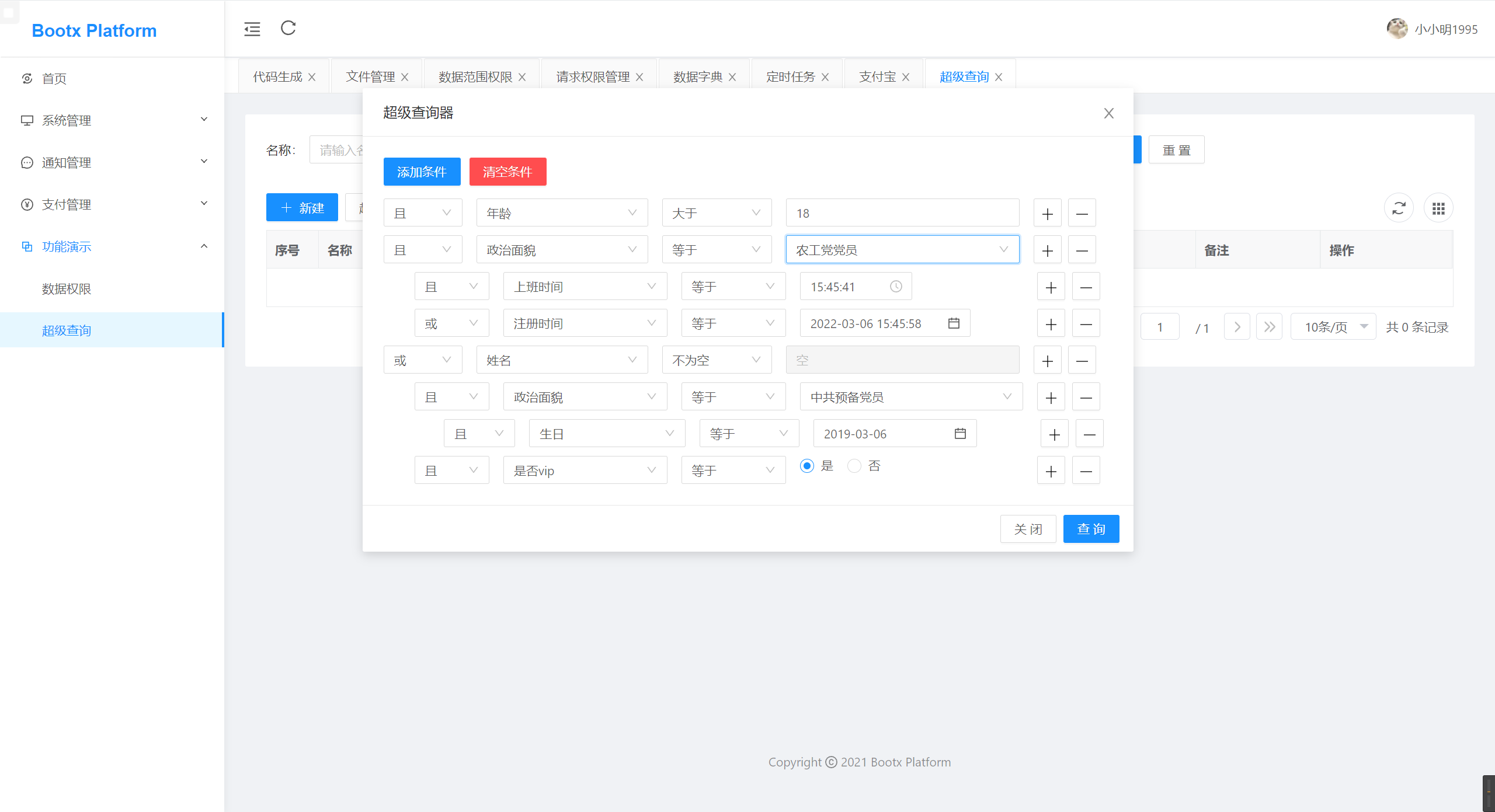

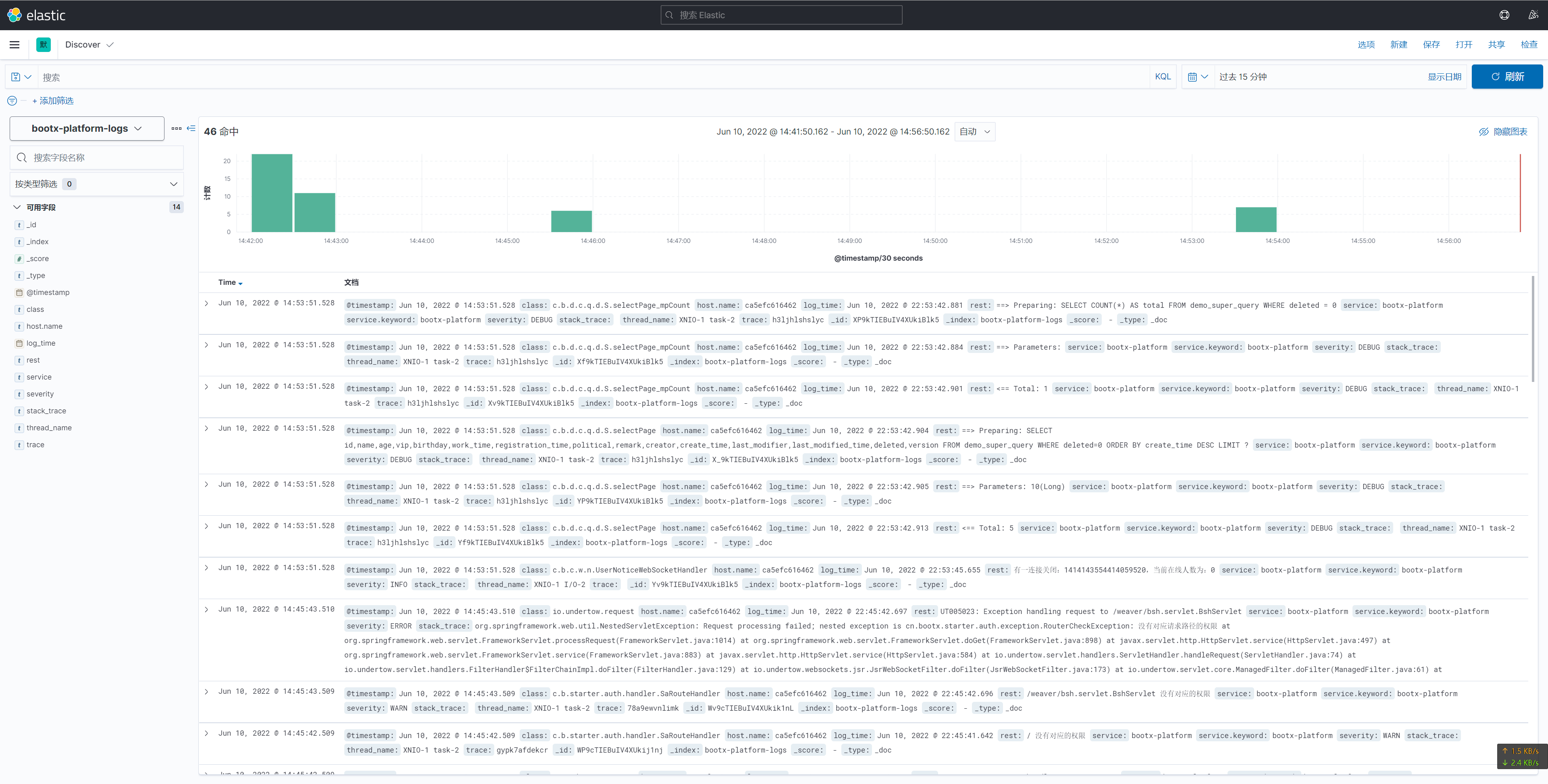

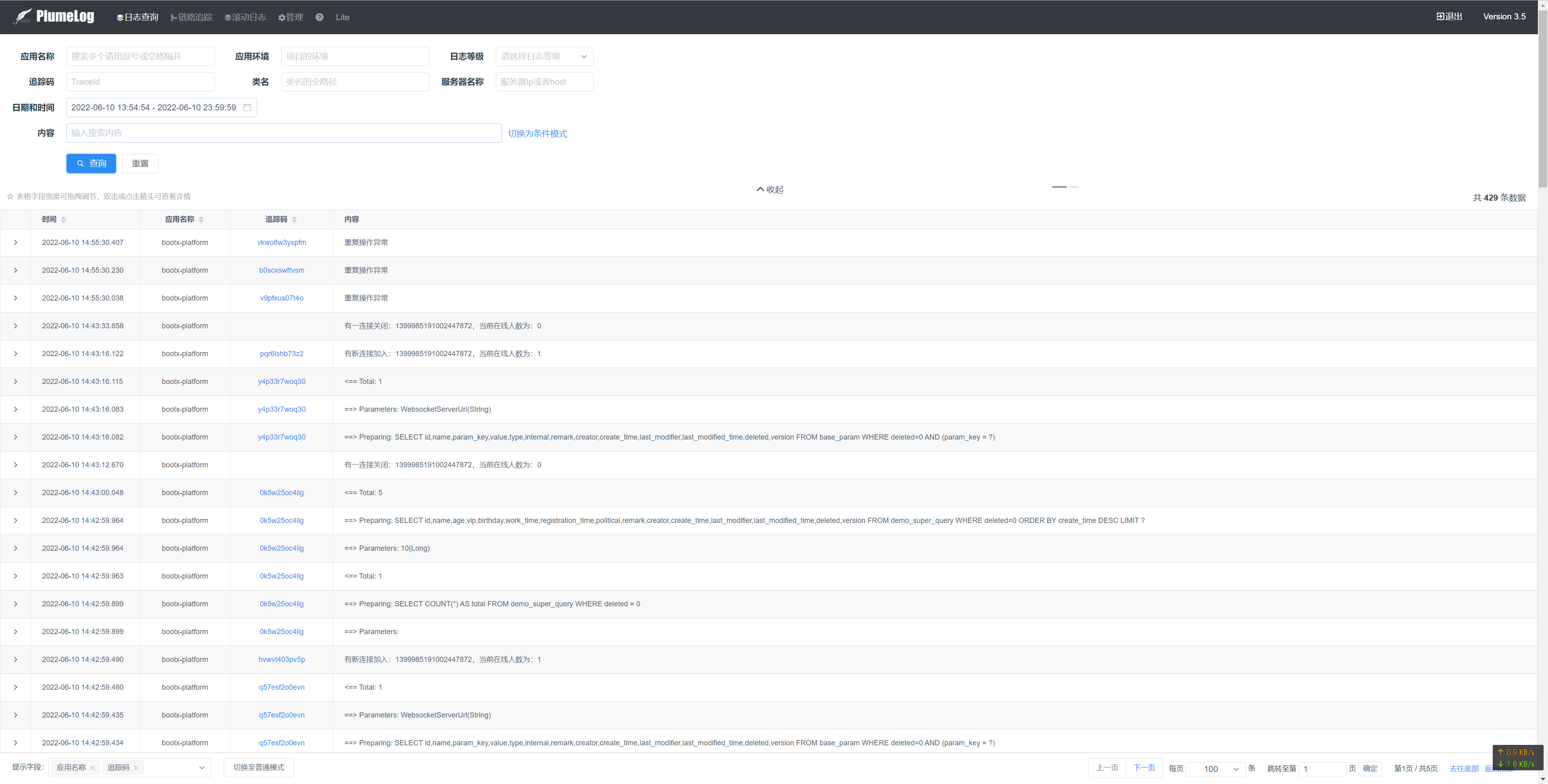

智能制造一体化管理系统 [SpringBoot2 – 快速开发平台],适用于制造业、建筑业、汽车行业、互联网、教育、政府机关等机构的管理。包含文件在线操作、工作日志、多班次考勤、CRM、ERP 进销存、项目管理、EHR、拖拽式生成问卷、日程、笔记、工作计划、行政办公、薪资模块、动态表单、知识库、公告模块、企业论坛、云售后模块、生产模块、系统模块化同步模块等多种复杂业务功能。

有一些小伙伴很好奇最近更新的内容和智能制造有什么关系?

答:目前 Skyeye 整体在做重构,优先从底层的一些功能开始,所以现在大家看到的和智能制造的联系不是很大,也希望大家能够理解,一个大型的智能制造对底层的依赖性也是非常高的。

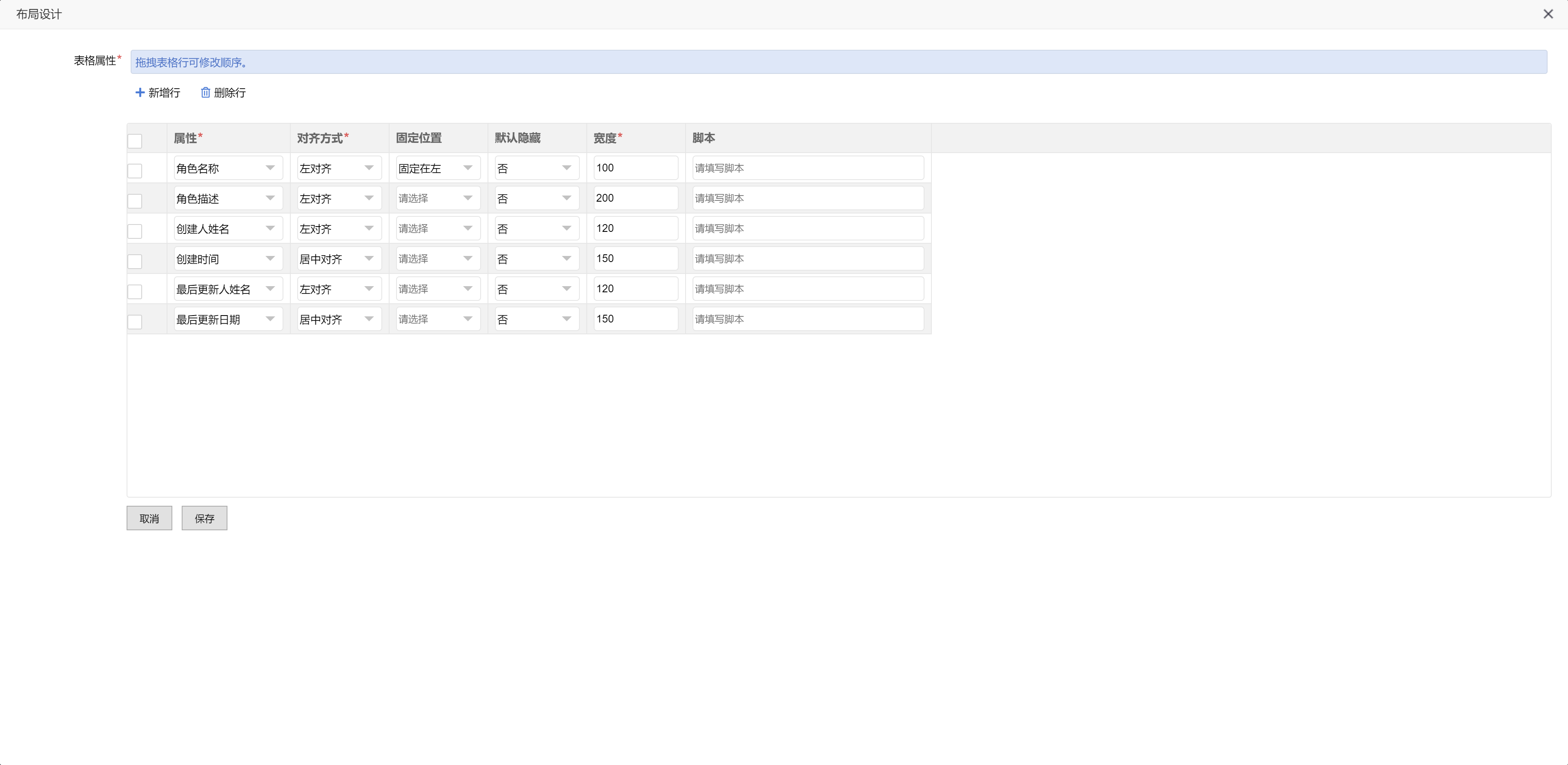

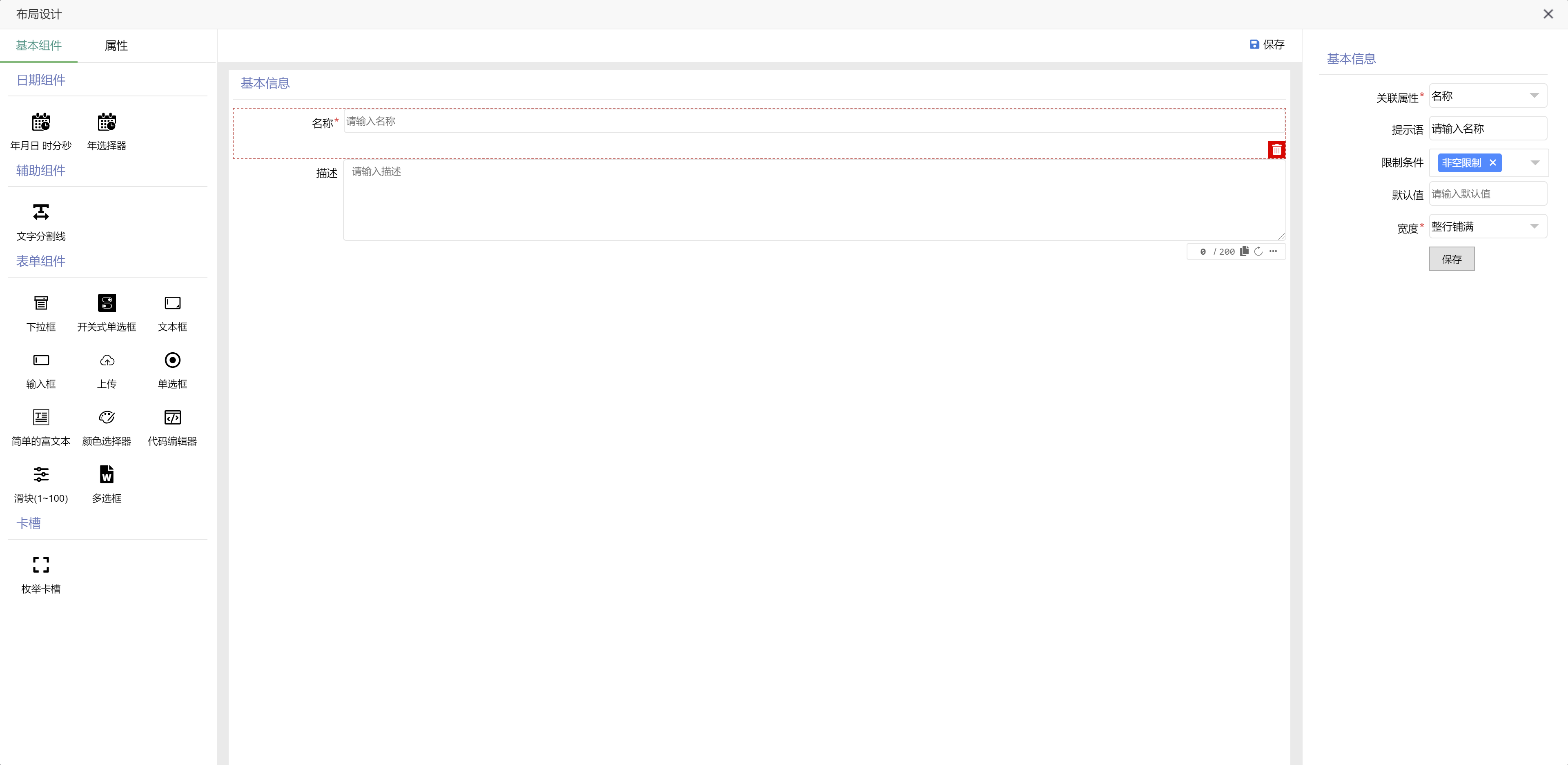

智能制造一体化 v3.9.9 发布 ,更新内容如下:

- 已完成测试的组件:输入框,下拉框,文本框,上传组件,枚举卡槽,文字分割线,编码规则,附件上传,数据字典卡槽,团队模板,部门信息,用户选择,往来单位,凭证,账户,账套

- 已托管到表单布局的功能:角色管理,桌面管理,前台服务配置,编码管理,联系人管理 (新增 / 编辑),CRM 客户管理,CRM 客户合同 (新增 / 编辑),CRM 客户商机 (新增 / 编辑),CRM 客户跟单 (新增 / 编辑),IFS 财务账户,IFS 账套管理,IFS 会计科目,IFS 收支项目,IFS 明细账,工序管理

- 考勤模块:请假申请、加班申请、销假申请、出差申请、考勤班次等功能后端修改为低代码平台完成,待托管到表单布局

- 招聘模块:人员需求申请、转岗申请、面试者管理等功能后端修改为低代码平台完成,待托管到表单布局

- 修改若干问题

erp: https://gitee.com/doc_wei01/erp-pro

OA: https://gitee.com/doc_wei01/skyeye

报表:https://gitee.com/doc_wei01/skyeye-report 有问题可以联系作者,详情请看开发计划。

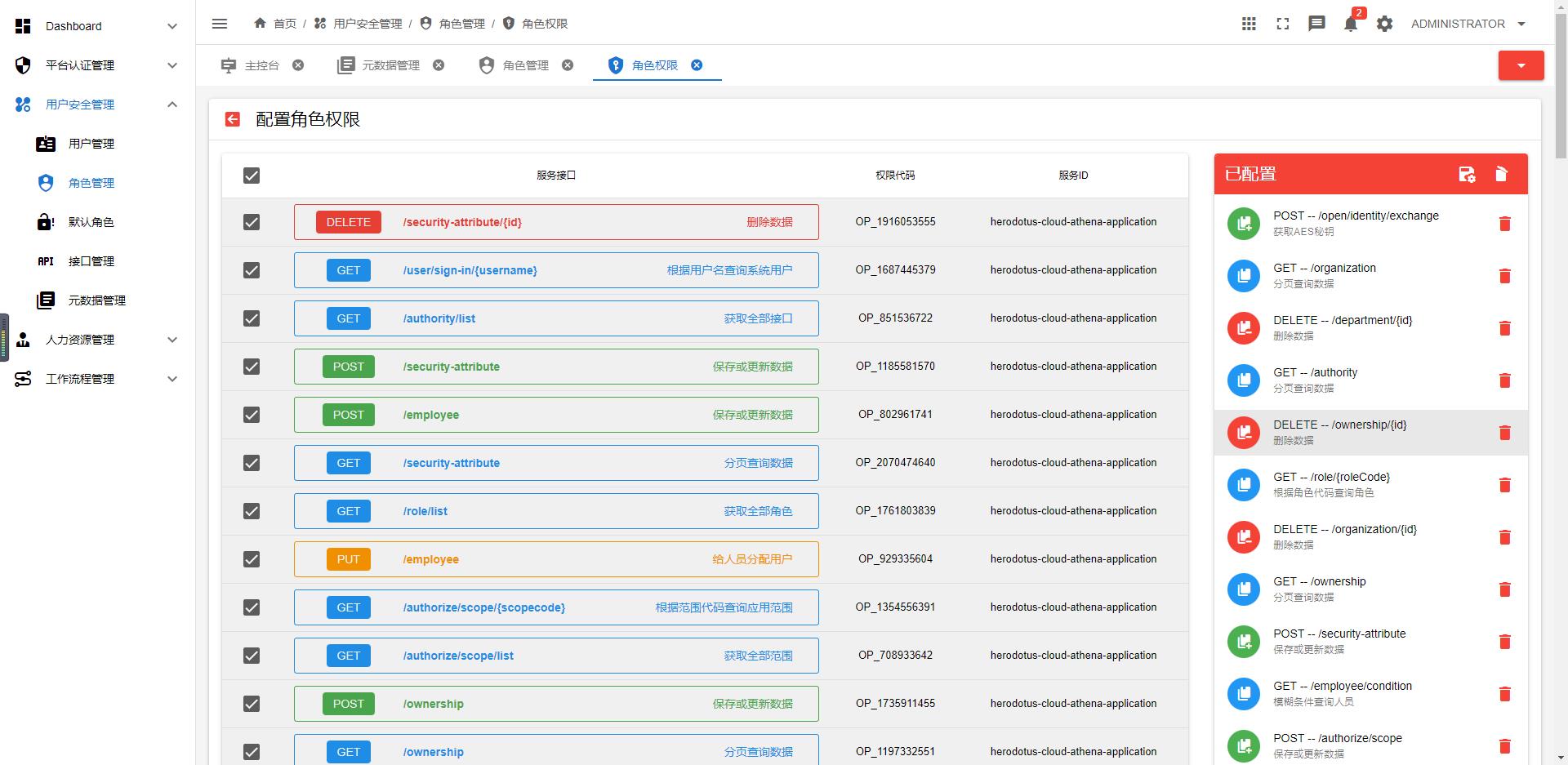

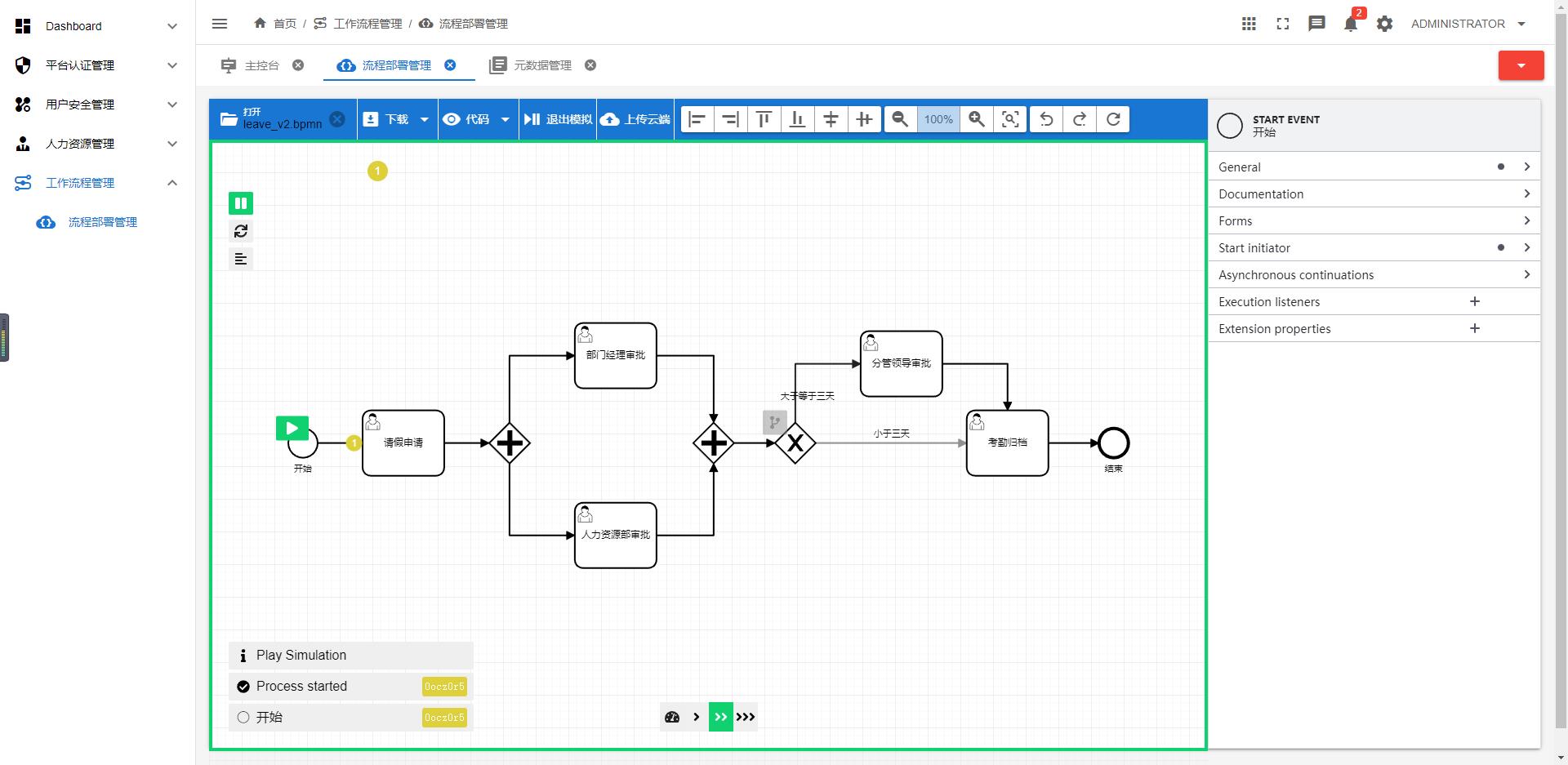

效果图

作者:京东科技 孙凯

一、前言

对前端开发者来说,Vite 应该不算陌生了,它是一款基于 nobundle 和 bundleless 思想诞生的前端开发与构建工具,官网对它的概括和期待只有一句话:“下一代的前端工具链”。

Vite 最早的版本由尤雨溪发布于3年前,经历了3年多的发展,Vite 也已逐渐迭代成熟,它的稳定性、扩展性、周边生态足以在生产环境中支撑各种业务场景的落地。但是关于Vite的优劣势分析我们就戛然而止,不在深入展开了,这不是本文的重点。

本文的重点在于探究 Vite 如何实现兼容低版本浏览器,这一切还得从那个阳光明媚的午后说起🤔。

二、那个午后

本着尝鲜的态度,我在某一个项目中用了 Vite,当时还是3.x.x的版本,跟着文档配置,从项目启动到项目构建,一路都很“德芙”(纵享丝滑),在经历了 Vite 带来的短暂新鲜感后,就一直沉浸在业务模块的开发中了,因为在 Vite 刚发布后的那段时间曾看过相关原理解析,是基于浏览器原生的模块化能力按需构建BALABALA等,所以后来 Vite 的这种新鲜感对我而言并没有保持多久。

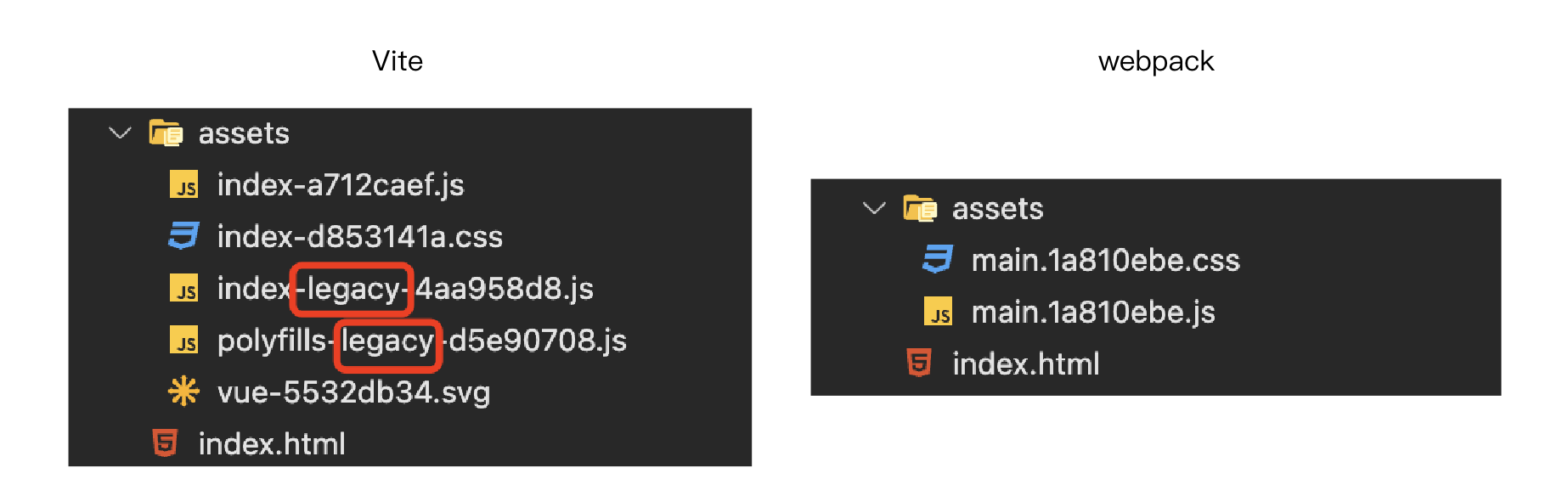

但直到有天下午我开始打包提测,审查页面素后发现构建产物居然跟以往 webpack 的产物竟然有点不一样,在好奇心的驱使下,于是我开始尝试解谜。

三、跟webpack构建产物到底哪里不一样?

1. 准备工作

为了能更好的对比两者产物究竟有什么区别,我们首先要确保我们的业务代码基本一致,不一致的地方仅仅是使用不同工具( vite 和 webpack)进行构建,这样才能排除最大干扰因素。

于是我们分别使用最新版的 Vite 和 webpack 初始化了两个页面,为了做作区分,两个页面的仅标题和标题背景不一致,他们在浏览器中渲染后的分别长这个样子:

2. 构建工具版本说明

Vite:v4.1.4

webpack:v5.75.0

3. 构建工具配置项说明

Vite (非常简单,啥也没有)

webpack(太多了,也比较常规,就不在这里贴出来全部配置项了,仅在这里配置好跟 Vite 一样的需要兼容到最低的浏览器版本)

至此,准备工作完毕,让我们看看两者的构建产物吧。

4. 构建产物

从产物的命名中,我们就能多少看出些许区别,webpack的产物比较简单,中规中矩,而 Vite 的 JS 文件不但比 webpack 多,而且部分文件命名中还多了一个单词:legacy,百度翻译对它的解释是:遗产;遗赠财物;遗留;后遗症;(计算机系统或产品)已停产的,通过翻译,或许你可以猜出来,名字中带 legacy 的文件大概率就是浏览器的兼容文件,那么事实到底是不是这样呢?

如果你足够细心,其实你应该可以从上面 Vite 的配置项代码中嗅到一丝端倪,在 Vite 的配置文件中,有一个名为 @vitejs/plugin-legacy 的插件,它的名字也包含 legacy,Vite 官网中对这个插件的解释是这样的:

“传统浏览器可以通过插件 @vitejs/plugin-legacy 来支持,它将自动生成传统版本的 chunk 及与其相对应 ES 语言特性方面的 polyfill。兼容版的 chunk 只会在不支持原生 ESM 的浏览器中进行按需加载。”

也就是说,这个插件它不但提供了低版本浏览器的兼容能力,还提供了检测是否支持原生 ESM 的能力。那么这个插件都做了哪些事?

主要是以下三点:

为最每个生成的 ESM 模块化方式的 chunk 也对应生成一个 legacy chunk,同时使用 @babel/preset-env 转换(没错,Vite 的内部集成了 Babel),生成一个 SystemJS 模块,关于 SystemJS 可以看这里查看,它在浏览器中实现了模块化,用来加载有依赖关系的各个 chunk。

生成 polyfill 包,包含 SystemJS 的运行时,同时包含由要兼容的目标浏览器版本和代码中的高级语法产生的 polyfill。

生成 <script nomodule> 标签,并注入到 HTML 文件中,用来在不兼容 ESM 的老旧浏览器中加载 polyfill 和 legacy chunk。

如此可见,Vite 兼容低版本浏览器的能力就是来自于 @babel/preset-env 无疑了,都是生成 polyfill 和语法转换, 但是这不就和 webpack 一样了么,事实是 Vite 又帮我们多做了一层,那就是上面反复提到的原生浏览器模块化能力 ESM。

5. Vite 的原生模块化能力

我们看看 Vite 打包后HTML中的内容,内容较多,我分开讲,先看 head 标签中的内容

代码的前两行加载了入口 JS (index-a712caef.js,记住这个文件名,后面会用到)和 CSS,JS资源使用了 ESM 的模块化方式加载,等等,嗯?JS 居然使用了 ESM ?如果当前浏览器不兼容 ESM,那这段 JS岂不是永远不会执行?

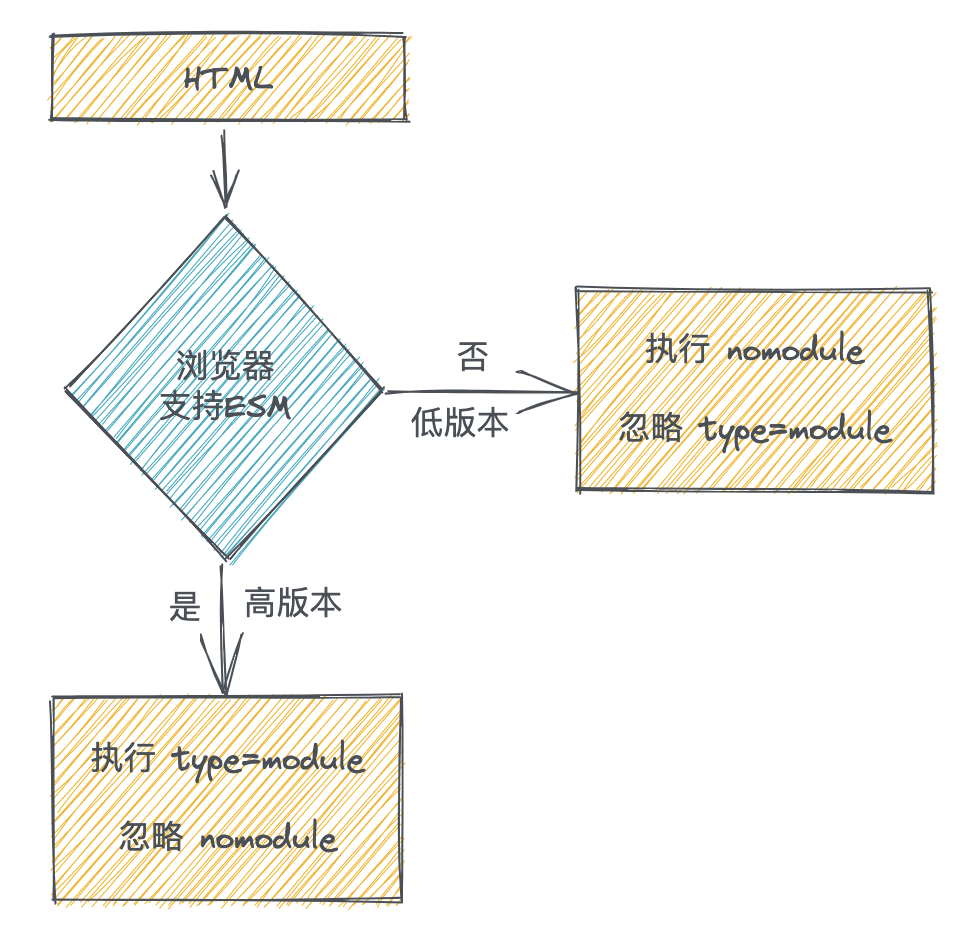

其实这就是 ESM 模块化的能力之一,对于携带 type=”module” 这个属性的 script 标签,不支持 ESM 的浏览器不会执行内部代码,所以报错也就不存在了,与之对应的 script 上还有 nomodule 这个属性,支持ESM的浏览器会忽略携带这个属性的 script,可以防止某些兼容逻辑在高版本浏览器执行,这两个属性组合使用就是为了决定浏览器在面对未知版本浏览器时的代码执行策略,我们画个简易流程图理解一下:

继续往下看。

接下来的两段内联 script 标签中的内容很关键,我们先看第一段代码,这段代码暂且命名为代码A:

期初我看上面这段代码的时候,我就想:这写的都是些个什么东西!前三行都是高级ES语法,部分浏览器根本不兼容好嘛,这都能写上去,真不怕报错和白屏?

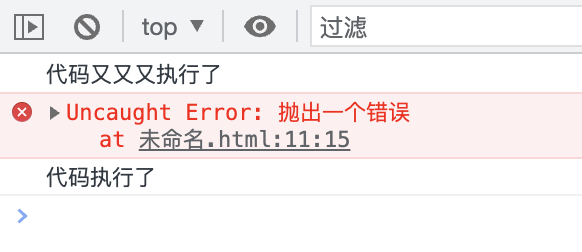

其实要注意 script 标签上 type=”module” 这个属性,ESM模块化的好处之一就是,它在处理报错信息的时候,不像普通 script 一样会把错误抛到模块外部,内部出错也不会阻塞后续逻辑的执行和页面渲染,接下来我们验证一下这个观点,直接上代码:

执行结果如下:

先不管代码结果的输出顺序,我们在这只看输出结果,与上述结论一致的,即错误影响了内部模块,并中断了后续的代码逻辑,而外部不受影响。

在 Vite 生成的 HTML 中这样做的好处就是为了检测浏览器对相关语法的支持程度,如果模块中的语法不支持,就会停止执行;如果支持,那么同时打上一个标记,也就是上述示例代码A的倒数第二行——通过在 window 上设置全局变量(因为ESM模块中的变量影响不到外部)window.__vite_is_modern_browser = true,来标识当前浏览器是否为一个“现代浏览器”,是否支持的某些语法特性(import.meta、动态导入、异步生成器),这样可以使 Vite 后续更准确的判断该加载那些 JS。

于是接下来我们就看到了下面这段代码:

它内部判断了 window.__vite_is_modern_browser 这个全局标识是否存在,如果存在,说明上一个模块中的代码执行没有问题,直接退出;如果不存在,说明当前浏览器不是一个“现代浏览器”,那就该加载和执行兼容文件了,于是可以看到这段代码的后半段,Vite 使用 SystemJs 加载了带有 legacy 标记的文件。

到了这里还没有结束, 虽然 Vite 在个别情况下加载了兼容文件,但如果你仔细看上述代码,会发现整个加载逻辑是放在拥有 type=”module” 这个属性的 script 中的,在前面已经阐述过了, type=”module” 在低版本浏览器是不会执行的,换句话说就是,低版本浏览器的兼容文件并不会被加载。于是 Vite 为了低版本浏览器能正常执行业务逻辑,又做了如下操作——

以下代码来自 VIte 打包后 body 标签中的内容:

可以看到,在低版本浏览器中 Vite 使用了带有 nomodule 属性的 script 标签,先加载了 polyfills 文件,确保后续代码中使用的API能正确执行,再通过 SystemJs 加载入口文件执行后续逻辑,至此, Vite 兼容旧版本浏览器的逻辑算是基本讲述完毕了。

6. “魔鬼藏在细节中”

纵观Vite的整个加载流程,粗一看没有什么大问题,但是经不起推敲,我们再来捋一捋,看看还发生了什么。

第一步,Vite 在页面最开始加载了 CSS 和 JS,加载 JS 的方式是使用 ESM

第二步,Vite 判断了现代浏览器的兼容性,如果是现代浏览器,则不执行 nomodule 中的代码,也不会使用 SystemJs 加载 legacy 文件,反之亦然。

第三部,Vite 对低版本浏览器使用 nomodule 的 script 标签,加载和执行 legacy 文件。

等等,你有没有发现,第一步和第二步有些问题?

我们前面已经说过了,在第二步中,Vite 根据 window.__vite_is_modern_browser 处理了是否加载 legacy 文件的逻辑,但是这里的代码是包裹在 type=”module” 这个属性的 script 中的!问题就出现在这里!

我们想象一个场景:总有那么一部分浏览器支持 ESM 的同时,又不支持 import.meta.url; import(“_”).catch(() => 1); async function* g() { } 这三种语法之一,这是必然的,因为语法诞生的时间不一致。

这也就导致了一个 Vite 的行为:在支持 ESM、同时不支持高级上述三种语法任意一种的时候,window.__vite_is_modern_browser 为 false,Vite 通过 SystemJs 加载了 legacy 文件,但也因为当前浏览器支持 ESM,致使 Vite 在第一步中通过 ESM 加载的 JS 是重复加载!

也就是说,Vite 在这种情况下同时加载了原生模块化的文件和兼容文件!

但更值得思考的还在后面:不管是原生模块化的文件,还是兼容文件,他们对页面的处理逻辑是一致的,因为文件的同时加载,这会不会导致页面执行两次相同的逻辑?

答案是:不会。

Vite 是知道这种情况的,并且已经处理过了,它处理的手段你肯定会觉得很眼熟,就在整个 ESM 文件入口的前几行(也就是本文构建产物中的 index-a712caef.js )——

它声明了一个函数,函数内部包含了高版本的语法,Vite 充分利用了 JS 语法边解析边执行的特性:如果当前环境不支持高版本语法,那就在语法解析阶段报错就好了,直接暴力阻止后续逻辑的执行,因为使用了原生模块化的能力,反正错误也不会抛给外面,对页面没有什么影响!

怎么样,这才是完整的 Vite 兼容方案,不得不说,真是有很多细节值得学习和思考。

对于重复加载 ESM 文件, @vitejs/plugin-legacy 是承认缺点存在的,这个插件在 README 中原文是这样解释的:

大概意思就是:它认为主流浏览器对这三种语法是广泛认可的,换句话也就是说,Vite 的目标其实还是绝大部分现代浏览器,太过低端的已经不考虑了。。。

最后放出 @vitejs/plugin-legacy 的 README 地址: https://github.com/vitejs/vite/tree/main/packages/plugin-legacy#readme

四、总结

不啰嗦,直接上加载过程完整的流程图,一百句话也不如一张图直观。

最后,实名感谢各位小伙伴的观看,如果能点个赞就更好了 🙌。

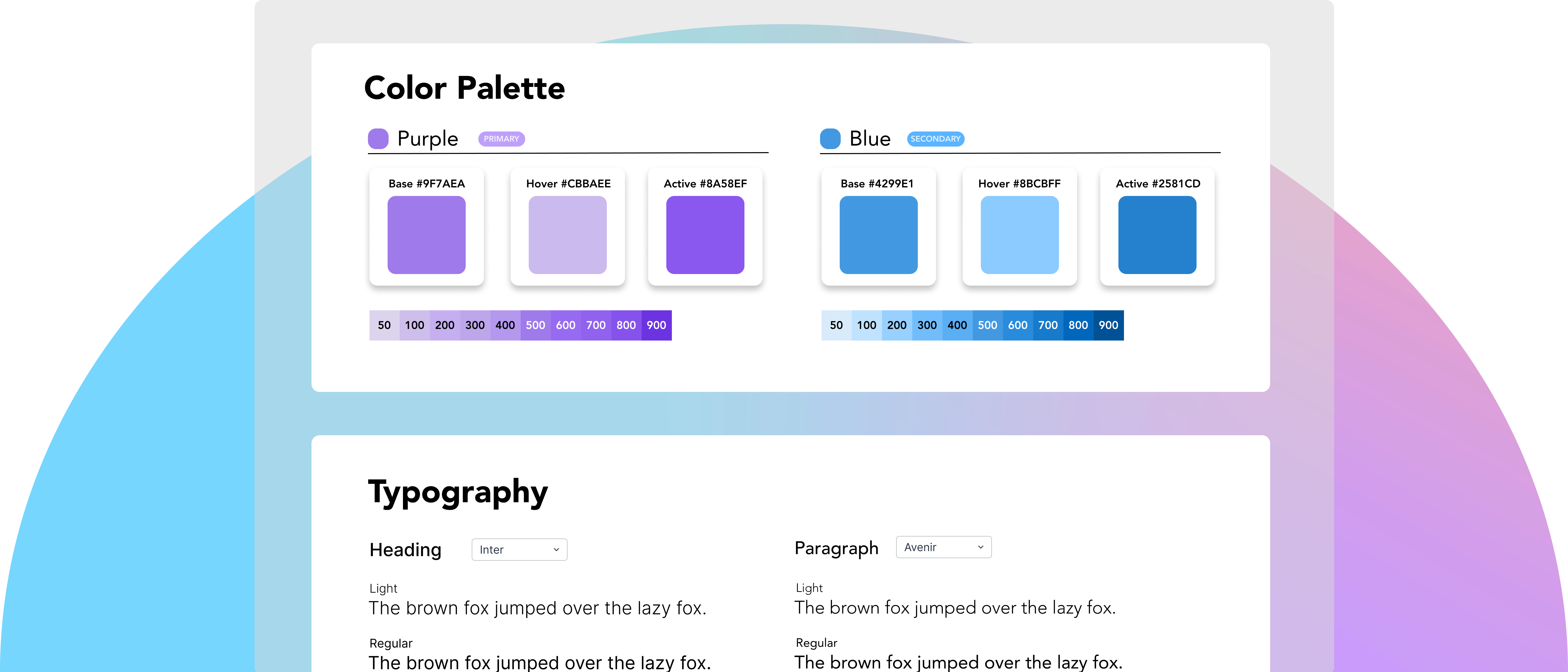

Mirrorful是一个简单、开源的设计系统框架。安装 Mirrorful 可以为你的项目生成颜色和其他设计标记,然后将这些设计标记直接导入你的应用程序。

- 以真实的来源开始新的项目

- 直观地修改主题

- 生成颜色

- 主题模板

- 轻量级 Headless 组件库

- Eslint 规则

- Figma 整合

开始

Mirrorful 是一个 NPM 包,旨在作为开发依赖项安装。

npm install mirrorful -D

或者

yarn add mirrorful -D

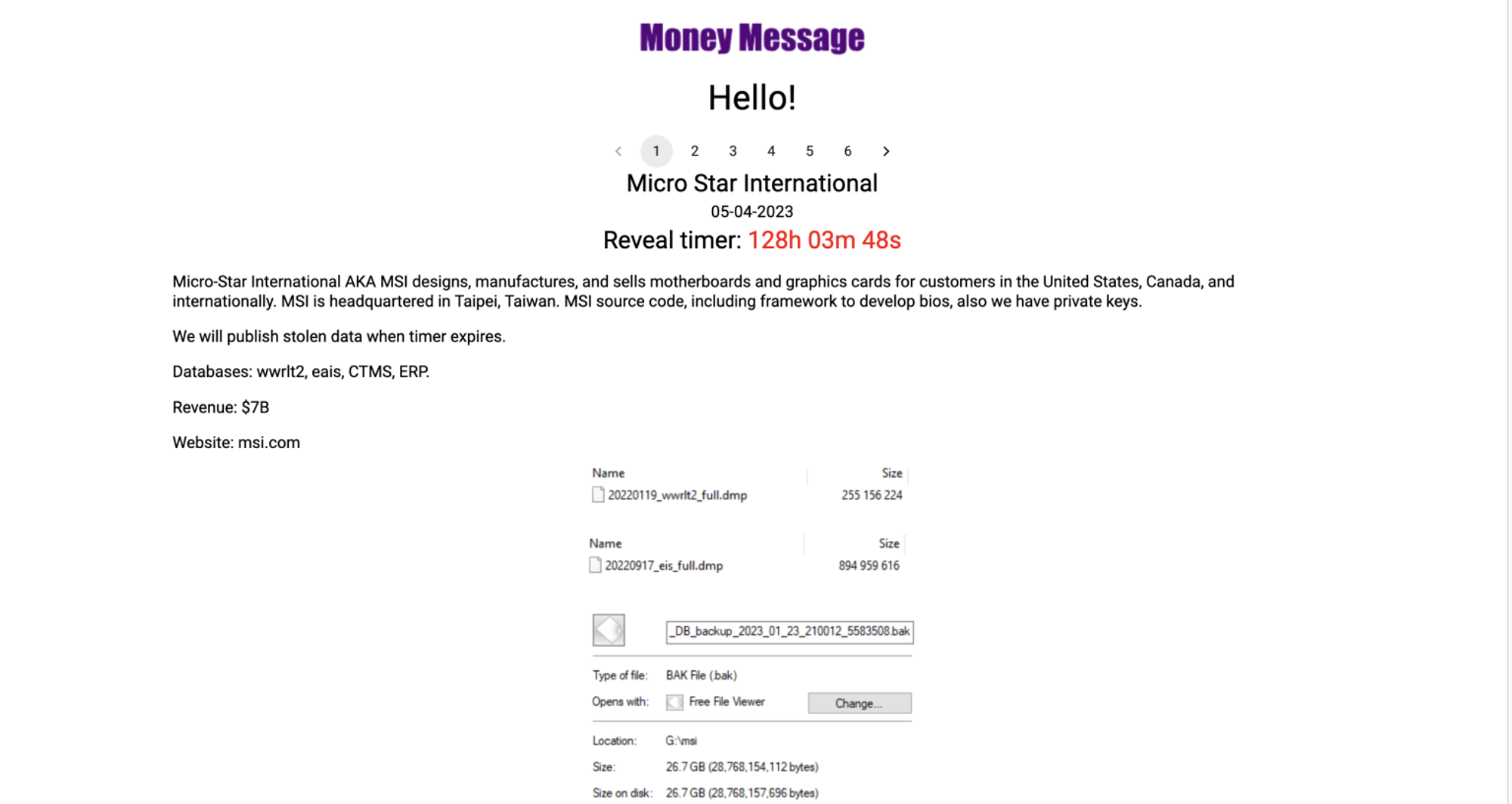

近日,一个名为 Money Message 的勒索软件组织声称,他们已经成功入侵了 PC 制造商微星(MSI)的系统,访问了微星的 CTMS 和 ERP 数据库,窃取了该公司的源代码、密钥,以及微星产品中使用的 BIOS 固件等,数据总量达到 1.5TB。

Money Message 在暗网上发布了被盗文件的截图,并要求微星支付 400 万美来赎回这些数据,否则将在本周公开这些被盗数据。

微星是我国台湾地区的一家 PC 制造商,主要生产高端的 PC 主板、GPU、笔记本、显示器和其他 PC 周边产品,深受电竞玩家的喜爱。而在事件发生后,微星则是在官网发布了一个简短声明,证实遭到了网络攻击:

MSI 的部分信息系统最近遭受了网络攻击。 信息部门发现网络异常后,及时启动相关防御机制并采取恢复措施,并将事件报告政府执法部门和网络安全部门。 目前,受影响的系统已逐步恢复正常运行,对金融业务无重大影响。

MSI 敦促用户仅从官方网站获取固件/BIOS 更新,并且不要使用来自官方网站以外来源的文件。

不过,这则简短的声明并没有透露任何细节,因此我们也不清楚这 1.5TB 的数据中是否包含微星的用户数据,以及勒索软件组织所声称的源代码和密钥等信息,也尚不清楚 Money Message 究竟是以什么方式入侵的微星,亦或是 MSI 是否有意支付这笔 400 万美的赎金。

网络安全公司 Cyble 表示,Money Message 似乎是上个月才刚刚出现的新兴勒索软件组织,虽然才成立不久,但目前已知受影响的企业已经超过五个,该组织以 Windows 和 Linux 电脑为目标,窃取用户数据,传播勒索软件。

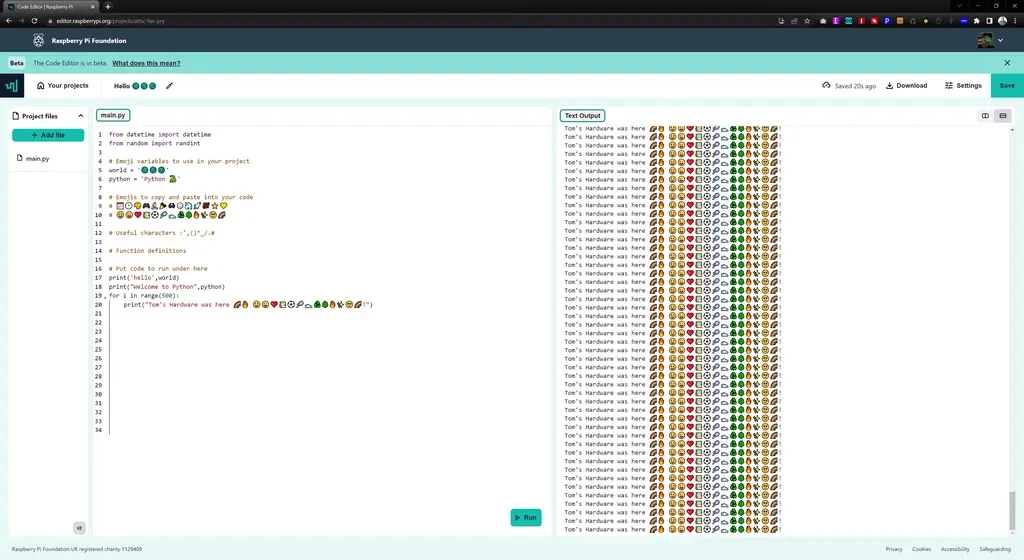

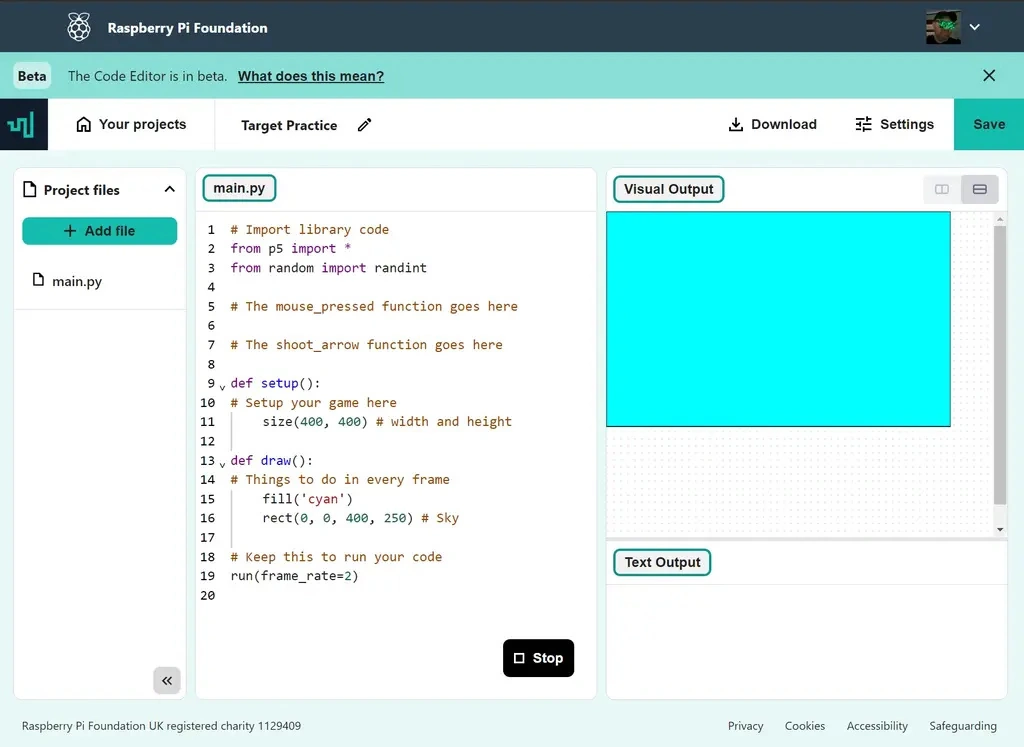

树莓派基金会近日为正式学习编程的用户,推出网页端代码编辑器。该编辑器目前处于测试阶段,感兴趣的用户可以访问 editor.raspberrypi.org 页面免费体验。

该编辑器目前设计为仅支持 Python,但该组织表示即将支持 HTML、JavaScript 和 CSS 等其它语言。

该界面由三个窗格组成:项目中的文件列表、代码编辑器和当您“运行”按钮时运行代码结果的输出窗口。

使用该编辑器需要创建免费账号,之后系统会将你所有的项目保存在云端,你可以随时重新加载它们。你还能以 .zip 文件格式下载源代码。

注:本文使用New Bing(GPT4.0)演示

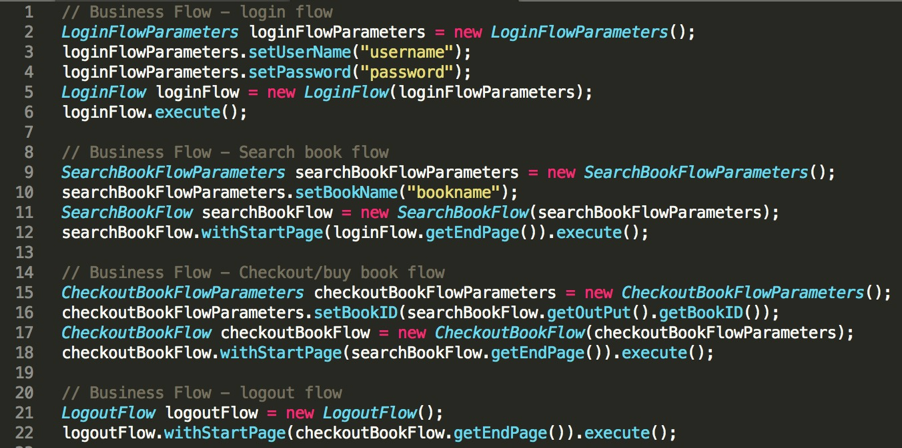

让他扮演一个Java软件开发者

第一步:我们让ChatGPT扮演一个Java软件开发者的角色

- 提示词插件:地址:ChatGPT BingChat GPT3 Prompt Generator App (Streamlit) – a Hugging Face Space by Kaludi

Java Software Developer Java软件开发者

准备一个不太好的Java代码示例

第二步:我们准备一个写得不太好的Java代码示例

- Bad Java Example:

让他优化这段代码

第三步:让newBing(ChatGPT)优化这段代码

- 并且要求「整理成比较优雅的代码结构,比如自动拆分子函数、降低if和循环嵌套,甚至实现部分设计模式。」

让他写个单测

第四步:我们最后让他收下尾——写个单测吧

最后,数据安全是最大的问题,不要乱贴数据到 ChatGPT,尤其是涉及后端核心存储账户密码、公司核心业务数据、部门核心战略规划等。因为首先,ChatGPT会使用你的问答语料进行训练;其次,你无法预料在什么Prompt提示词下,LLM模型会讲你无意中泄露的信息回答出去。

瑕不掩瑜,ChatGPT为代表的LLM模型,在充当我们无所不知的老师、充当不知疲倦的通用Util代码编写者这些角色时能极大的提高我们的开发效率,尤其在数据分析、前端、单测、重构等领域。

就像文章第一步写的一样,ChatGPT就像是一个百变身份,你可以让他扮演任何角色,而每一个角色都能在这个角色范围内帮助我们获得更美好的生活。

更有意思的用法期待大家的发掘。

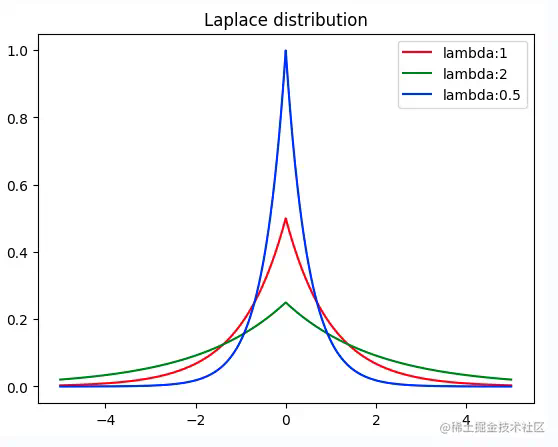

摘要:Laplace 用于 Laplace 分布的概率统计与随机采样。

本文分享自华为云社区《Laplace分布算子开发经验分享》,作者:李长安。

1、任务解析

详细描述:

Laplace 用于 Laplace 分布的概率统计与随机采样, 此任务的目标是在 Paddle 框架中,基于现有概率分布方案进行扩展,新增 Laplace API,调用路径为:paddle.distribution.Laplace 。类签名及各个方法签名,请通过调研 Paddle 及业界实现惯例进行设计。要求代码风格及设计思路与已有概率分布保持一致。

实际上说了一大堆,就是一件事:实现Laplace分布算子,那么首先我们需要知道什么是 Laplace 分布,在概率论和统计学中,拉普拉斯分布是一种连续概率分布。由于它可以看作是两个不同位置的指数分布背靠背拼在一起,所以它也叫双指数分布。与正态分布对比,正态分布是用相对于μ平均值的差的平方来表示,而拉普拉斯概率密度用相对于差的绝对值来表示。如下面的代码所示,Laplace 分布的图像和正态分布实际上是有点类似的,所以它的公式也与正态分布的公式类似的。

2、设计文档撰写

设计文档是我们API设计思路的体现,是整个开发工作中必要的部分。通过上述任务简介,我们可以知道此API的开发主要为Laplace分布的开发,需要包含一些相应的方法。首先我们需要弄清楚Laplace分布的数学原理,这里建议去维基百科查看Laplace分布的数学原理,弄明白数学原理。此外,我们可以参考Numpy、Scipy、Pytorch、Tensorflow的代码实现,进行设计文档的撰写。

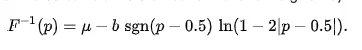

首先,我们应该知道Laplace分布的概率密度函数公式、累积分布函数、逆累积分布函数,并且根据公式开发出代码,公式如下所示:

参考Numpy、Scipy、Pytorch、Tensorflow的代码实现,我们这里可以很容易的实现公式对应的代码,其实现方案如下3.1小节所示。

2.1 API 实现方案

该 API 实现于 paddle.distribution.Laplace。

基于paddle.distribution API基类进行开发。

class API 中的具体实现(部分方法已完成开发,故直接使用源代码),该api有两个参数:位置参数self.loc, 尺度参数self.scale。包含以下方法:

- mean 计算均值:

- stddev 计算标准差:

- variance 计算方差:

- sample 随机采样(参考pytorch复用重参数化采样结果):

- rsample 重参数化采样:

其中 u = paddle.uniform(shape=shape, min=eps – 1, max=1); eps根据dtype决定;

- prob 概率密度(包含传参value):

直接继承父类实现

- log_prob 对数概率密度(value):

- entropy 熵计算:

- cdf 累积分布函数(value):

- icdf 逆累积分布函数(value):

- kl_divergence 两个Laplace分布之间的kl散度(other–Laplace类的一个实例):

参考文献:https://openaccess.thecvf.com/content/CVPR2021/supplemental/Meyer_An_Alternative_Probabilistic_CVPR_2021_supplemental.pdf

同时在paddle/distribution/kl.py 中注册_kl_laplace_laplace函数,使用时可直接调用kl_divergence计算laplace分布之间的kl散度。

2.2 测试和验收的考量

在我们开发完对应的代码后,我们应该如何证明我们所开发出来的代码是正确的呢?这时候就需要单测试的代码来证明我们的代码是正确的。那么什么是单测试呢?单测试的用例其实是一个“输入数据”和“预计输出”的集合。你需要跟你输入数据,根据逻辑功能给出预计输出,这里所说的根据逻辑功能是指,通过需求文档就能给出的预计输出。而非我们通过已经实现的代码去推导出的预计输出。这也是最容易被忽视的一点。你要去做单测试,然后还要通过代码去推断出预计输出,如果你的代码逻辑本来就实现错了,给出的预计输出也是错的,那么你的单测试将没有意义。实际上,这部分可以说是整个工作中最重要的部分也是比较难的部分,我们需要想出预计输出,并且如何通过已经实现的代码去推导出预计输出,只有单测试通过了,我们的开发任务才算基本完成了。

根据api类各个方法及特性传参的不同,把单测分成三个部分:测试分布的特性(无需额外参数)、测试分布的概率密度函数(需要传值)以及测试KL散度(需要传入一个实例)。

1、测试Lapalce分布的特性

- 测试方法:该部分主要测试分布的均值、方差、熵等特征。类TestLaplace继承unittest.TestCase,分别实现方法setUp(初始化),test_mean(mean单测),test_variance(variance单测),test_stddev(stddev单测),test_entropy(entropy单测),test_sample(sample单测)。

- 均值、方差、标准差通过Numpy计算相应值,对比Laplace类中相应property的返回值,若一致即正确;

- 采样方法除验证其返回的数据类型及数据形状是否合法外,还需证明采样结果符合laplace分布。验证策略如下:随机采样30000个laplace分布下的样本值,计算采样样本的均值和方差,并比较同分布下scipy.stats.laplace返回的均值与方差,检查是否在合理误差范围内;同时通过Kolmogorov-Smirnov test进一步验证采样是否属于laplace分布,若计算所得ks值小于0.02,则拒绝不一致假设,两者属于同一分布;

- 熵计算通过对比scipy.stats.laplace.entropy的值是否与类方法返回值一致验证结果的正确性。

- 测试用例:单测需要覆盖单一维度的Laplace分布和多维度分布情况,因此使用两种初始化参数

- ‘one-dim’: loc=parameterize.xrand((2, )), scale=parameterize.xrand((2, ));

- ‘multi-dim’: loc=parameterize.xrand((5, 5)), scale=parameterize.xrand((5, 5))。

2、测试Lapalce分布的概率密度函数

- 测试方法:该部分主要测试分布各种概率密度函数。类TestLaplacePDF继承unittest.TestCase,分别实现方法setUp(初始化),test_prob(prob单测),test_log_prob(log_prob单测),test_cdf(cdf单测),test_icdf(icdf)。以上分布在scipy.stats.laplace中均有实现,因此给定某个输入value,对比相同参数下Laplace分布的scipy实现以及paddle实现的结果,若误差在容忍度范围内则证明实现正确。

- 测试用例:为不失一般性,测试使用多维位置参数和尺度参数初始化Laplace类,并覆盖int型输入及float型输入。

- ‘value-float’: loc=np.array([0.2, 0.3]), scale=np.array([2, 3]), value=np.array([2., 5.]); * ‘value-int’: loc=np.array([0.2, 0.3]), scale=np.array([2, 3]), value=np.array([2, 5]);

- ‘value-multi-dim’: loc=np.array([0.2, 0.3]), scale=np.array([2, 3]), value=np.array([[4., 6], [8, 2]])。

3、测试Lapalce分布之间的KL散度

- 测试方法:该部分测试两个Laplace分布之间的KL散度。类TestLaplaceAndLaplaceKL继承unittest.TestCase,分别实现setUp(初始化),test_kl_divergence(kl_divergence)。在scipy中scipy.stats.entropy可用来计算两个分布之间的散度。因此对比两个Laplace分布在paddle.distribution.kl_divergence下和在scipy.stats.laplace下计算的散度,若结果在误差范围内,则证明该方法实现正确。

- 测试用例:分布1:loc=np.array([0.0]), scale=np.array([1.0]), 分布2: loc=np.array([1.0]), scale=np.array([0.5])

3、代码开发

代码的开发主要参考Pytorch,此处涉及到单测试代码的开发,kl散度注册等代码,需要仔细阅读PaddlePaddle中其他分布代码的实现形式。

4、总结

目前,该API已经锁定贡献。回顾API的开发过程,实际上该API的开发并不难,主要的问题在于如何进行单测试,证明开发的API是正确的,并且还有一些相关的细节点,比如KL散度的注册等。还有就是最开始走了弯路,参照了Normal的开发风格,将API写成了2.0风格的,影响了一些时间,并且在最后的单测中,发现了Uniform实现方式的一些Bug,此处Debug花费了一些时间,整体来看,花时间的部分是在单测部分。

关注,第一时间了解华为云新鲜技术~

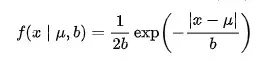

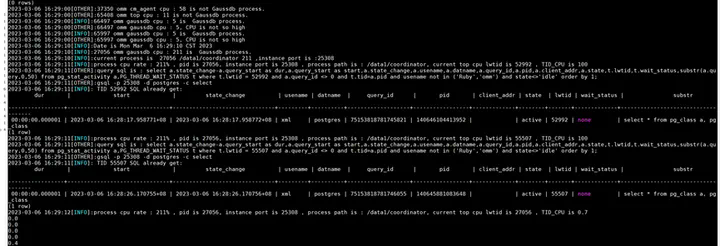

摘要:本文主要通过实例讲解如何通过gs_cpuwatcher.sh 脚本寻找CPU占用高语句。

本文分享自华为云社区《GaussDB(DWS) gs_cpuwatcher.sh 脚本如何寻找CPU占用高语句》,作者:fighttingman。

【工具名称】

gs_cpuwatcher

【功能描述】

1.寻找集群内节点占用CPU高的语句

【使用场景】

- CPU sys使用率高

- 业务整体慢

【参数说明】

无

【使用方法】

- 直接后台执行命令

nohup sh gs_cpuwatcher.sh > cpuwatcher.log 2>&1 &

执行之前注意事项:

- 使用omm用户(线下)或者Ruby用户(线上)执行

- 将脚本放到一个磁盘空间充足的目录执行,防止把磁盘空间占满,脚本监控会产生日志,占用磁盘空间,磁盘空间最好大于20G

- 监控完之后kill这个监控进程,防止忘记这个脚本造成监控日志一直上涨,脚本默认保留3天的日志

- 脚本只有在进程的cpu使用率大于100(多核累加和)的时候才会进行查询cpu高的语句

【最佳实践&结果分析】

执行监控命令之后,检查当前目录生成的监控日志

查看日志cpu_watch_xxx.log日志,里边有记录占用CPU高的语句

日志里边记录了cpu占用高的语句,例如上图中select * from pg_class a, pg_class,脚本默认截取sql的前50个字符,可以对截取字符串进行修改,需要修改脚本

字段解释:

- dur :执行时长

- start:sql的起始时间

- state_change:sql状态改变时间

- usename:用户名称

- datname:连的数据库名称

- query_id:sql的唯一标识id

- pid:线程id

- client_addr:客户端连的ip

- state:sql的执行状态

- lwtid:线程小号

- wait_status:等待视图中的等待状态字段

- substr:sql字段

关注,第一时间了解华为云新鲜技术~

文章作者:

Paula Ramos,英特尔 AI 软件布道师,美国

武卓,英特尔 AI 软件布道师,中国

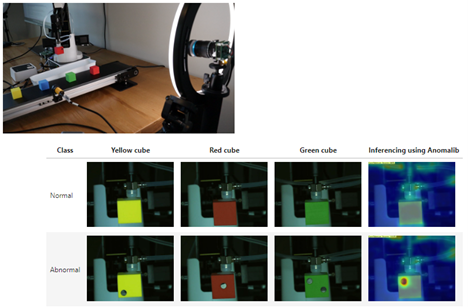

Samet Akcay,英特尔人工智能研究工程师/科学家

在上篇文章《 开发者实战 | 如何应用Anomalib在数据集不平衡的情况下检测缺陷?-上篇》中,我们介绍了深度学习异常检测库 Anomalib(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib)。简而言之,当您想进行自动缺陷检测,但数据集不平衡时,Anomalib 是一个很好的工具。

希望您已经通过入门 notebook (复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/tree/main/notebooks/000_getting_started)访问并亲自试用了这个开源项目。如果没有,请不要担心,这篇博文将教您如何结合自己的数据集使用 Anomalib。

在这个示例中,我们将介绍一个令人振奋的 Dobot 机器人工业用例,其中的机械臂用于教育、工业和智能用例中。如果您没有可用的 Dobot 机器人,您可以简单地修改 notebook,避开、注释或改变机器人代码,使其为您所用。

图 1:使用教育机器人进行基于 Anomalib 的缺陷检测。

让我们开始吧

为了解 Anomalib 的工作原理,我们将看一个检查彩色立方体的生产线(图 1)。其中一些立方体会有洞或缺陷,需要从传送带上取下。由于这些缺陷在生产线上并不常见,我们将为我们的 AI 模型拍摄一些图像。

安装:

按照以下步骤使用源文件安装 Anomalib:

1. 使用 Python 3.8 版本创建运行Anomalib + Dobot DLL 的环境

对于 Windows,使用以下代码:

向右滑动查看完整代码

对于 Ubuntu:

向右滑动查看完整代码

2. 从 GitHub 存储库中安装 Anomalib 及 OpenVINO™ 要求(在这篇博文中,我们将不使用 pip 安装命令):

向右滑动查看完整代码

3. 安装 Jupyter Lab 或 Jupyter Notebook:

https://jupyter.org/install

向右滑动查看完整代码

4. 然后连接您的 USB 摄像头,使用简单的摄像头应用验证它在正常工作。然后,关闭该应用。

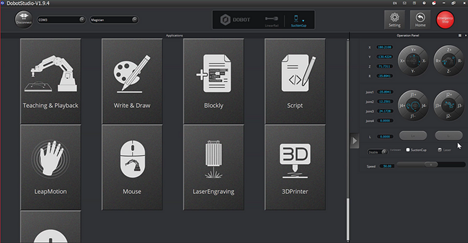

可选:如果您可以访问 Dobot,请实施以下步骤:

1. 安装 Dobot 要求(更多信息请参考 Dobot 文档,复制到浏览器打开:https://en.dobot.cn/products/education/magician.html)。

2. 检查 Dobot 的所有连接状态,并使用 Dobot Studio 验证它在正常工作。

3. 将通风配件安装在 Dobot 上,并使用 Dobot Studio 验证它在正常工作。

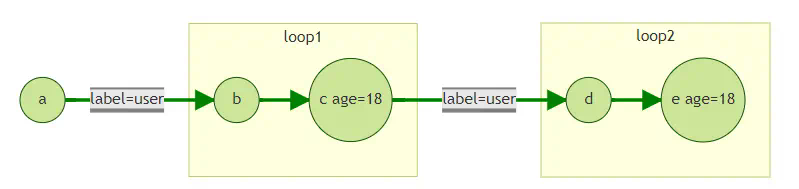

4. 在 Dobot Studio(图 2)中,“Home”按钮,找到:

· 校准坐标:立方体阵列的左上角初始位置。

· 位置坐标:机械臂应将立方体放在传送带上方的位置。

· 异常坐标:释放异常立方体的位置。

· 然后在 notebook 中替换这些坐标。有关该步骤的更多说明,请参考自述文件(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/tree/feature/notebooks/usecases/dobot/notebooks/500_use_cases/dobot)。

5. 如需使用机器人运行 notebook,从这里下载 Dobot API 和驱动程序文件(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/releases/download/dobot/dobot_api.zip),并将它们添加到存储库 Anomalib 文件夹的 notebooks/500_uses_cases/dobot 中。

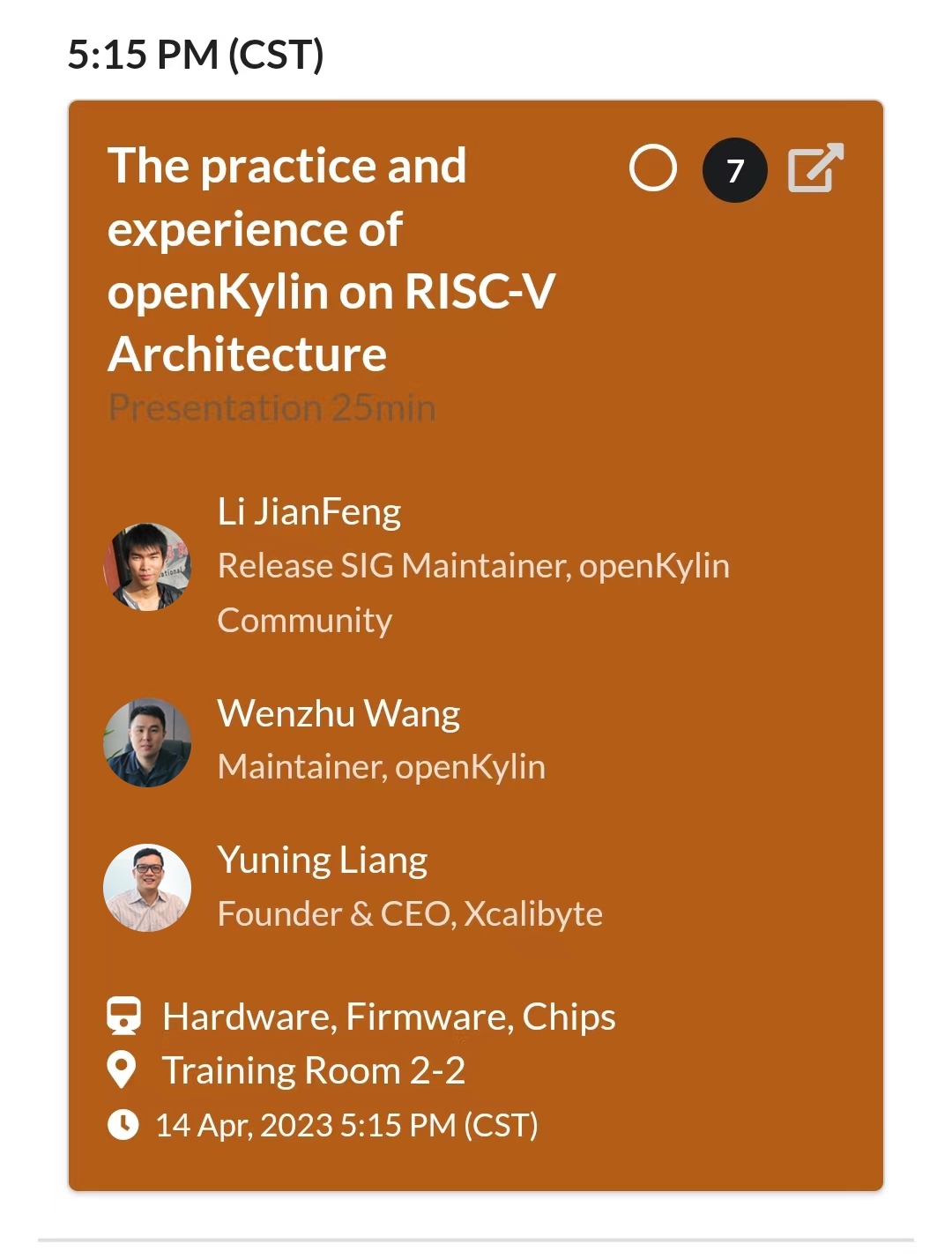

图 2:Dobot Studio 界面。

注:如果没有机器人,您可以转到另一个 notebook,如 501b notebook(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/blob/main/notebooks/500_use_cases/501_dobot/501b_Training_a_model_with_cubes_from_a_robotic_arm.ipynb),通过这个链接下载数据集(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/releases/download/dobot/cubes.zip),并在那里尝试训练和推理。

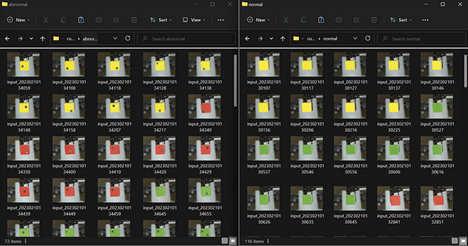

Notebook 的数据采集和推理

下面,我们需要使用正常的数据集创建文件夹。在这个示例中,我们创建了一个彩色立方体的数据集,并为异常情况添加一个黑色圆圈贴纸,以模拟盒子上的洞或缺陷(图 3)。对于数据采集和推理,我们将使用 501a notebook(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/blob/main/notebooks/500_use_cases/501_dobot/501a_Dataset_creation_and_Inference_with_a_robotic_arm.ipynb)。

图 3:用于第一轮训练的数据集。

在采集数据时,请务必将 acquisition 变量设置 为 True 来运行notebook,并为没有异常的数据定义“正常”文件夹,为异常图像定义“异常”文件夹。数据集将直接在 Anomalib 克隆的文件夹中创建,所以我们将看到 Anomalib/dataset/cubes 文件夹。

如果您没有机器人,您可以修改代码以保存图像或使用下载的数据集进行训练。

推理:

对于推理,acquisition 变量应该是 False,我们不会保存任何图像。我们将读取采集到的视频帧,使用 OpenVINO 运行推理,并决定放置立方体的位置:对于正常立方体,放置在传送带上;对于异常立方体,放置在传送带外。

我们需要识别采集标记 — 采集模式为 True,推理模式为 False。在采集模式下,要注意是创建正常还是异常文件夹。例如,在采集模式下,notebook 会将每张图像保存在 anomalib/datasets/cubes/{FOLDER} 中,以便进一步训练(复制到浏览器打开:https://gist.github.com/paularamo/f20c4efe98ec00756f76d65b20f21fb0)。在推理模式下,notebook 不会保存图像;它将运行推理并显示结果。

让我们开始吧

对于训练,我们将使用 501b notebook(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/blob/main/notebooks/500_use_cases/501_dobot/501b_Training_a_model_with_cubes_from_a_robotic_arm.ipynb)。在这个 notebook 中,我们将使用 PyTorch Lighting,并使用“Padim”模型进行训练。这种模型有几个优点:我们不需要 GPU,只用 CPU 就可以完成训练过程,而且训练速度也很快。

现在,让我们深入了解一下训练 notebook!

导入:

在这一部分,我们将解释用于该示例的软件包。我们还将从 Anomalib 库中调用需要使用的软件包(复制到浏览器打开:https://gist.githubusercontent.com/paularamo/536ed17333cfe05ddad36f/raw/2d645c778c059b9c52ecad0df83f326f3fe8aa16/anomalib_imports.py)。

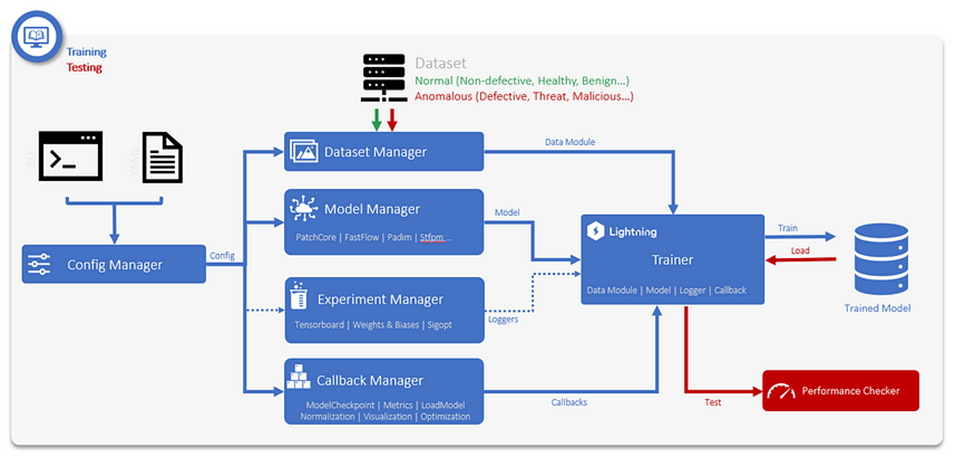

配置:

有两种方法来配置 Anomalib 模块,一种是使用配置文件,另一种是使用 API。最简单的方法是通过 API 查看该库的功能。如果您希望在您的生产系统中实施 Anomalib,请使用配置文件(YAML 文件)(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/blob/main/notebooks/500_use_cases/501_dobot/cubes_config.yaml),它是核心训练与测试进程,包含数据集、模型、试验和回调管理(图 4)。

在接下来的部分,我们将描述如何使用 API 配置您的训练。

图 4:训练和验证模块。

数据集管理器:

通过 API,我们可以修改数据集模块。我们将准备数据集路径、格式、图像大小、批量大小和任务类型(复制到浏览器打开:https://gist.github.com/paularamo/46fdfe6bcfa27e5e027a7f4c3a0dc5bd)。然后,我们使用以下代码将数据加载到管道中。

向右滑动查看完整代码

模型管理器:

对于异常检测模型,我们使用 Padim(复制到浏览器打开:https://gist.githubusercontent.com/paularamo/536ed17333cfe05ddad36f/raw/2d645c778c059b9c52ecad0df83f326f3fe8aa16/anomalib_imports.py),您也可以使用其他 Anomalib 模型,如:CFlow、CS-Flow、DFKDE、DFM、DRAEM、FastFlow、Ganomaly Patchcore、Reverse Distillation 和 STFPM。此外,我们使用 API 设置了模型管理器;使用 anomalib.models (复制到浏览器打开:https://gist.github.com/paularamo/24457a4eaeb98f15d5b39bc62b513d26)导入 Padim。

回调(Callbacks)管理器:

为了适当地训练模型,我们需要添加一些其他的“非基础”逻辑,如保存权重、尽早终止、以异常分数为基准以及将输入/输出图像可视化。为了实现这些,我们使用回调Callbacks。Anomalib 有自己的Callbacks,并支持 PyTorch Lightning 的本地callbacks。通过该代码,我们将创建在训练期间执行的回调列表(复制到浏览器打开:https://gist.github.com/paularamo/581d6c99504e673a8147e)。

训练:

在设置数据模块、模型和callbacks之后,我们可以训练模型了。训练模型所需的最后一个组件是 pytorch_lightning Trainer 对象,它可处理训练、测试和预测管道。此处,查看 notebook 中的 Trainer 对象示例(复制到浏览器打开:https://gist.github.com/paularamo/ed41798c869aec9b8d127c24https://gist.github.com/paularamo/ed41798c869aec9b8d127c24)。

验证:

我们使用 OpenVINO 推理进行验证。在之前的导入部分,我们导入了 anomalib.deploy 模块中的 OpenVINOInferencer。现在,我们将用它来运行推理并检查结果。首先,我们需要检查 OpenVINO 模型是否在结果文件夹中(复制到浏览器打开:https://gist.github.com/paularamo/7d89abf6a6e1bf48c406ecefc2)。

预测结果:

为了实施推理,我们需要从 OpenVINOinference(我们可在其中设置 OpenVINO 模型及其数据)中调用 predict 方法,并确定需要使用的设备:

向右滑动查看完整代码

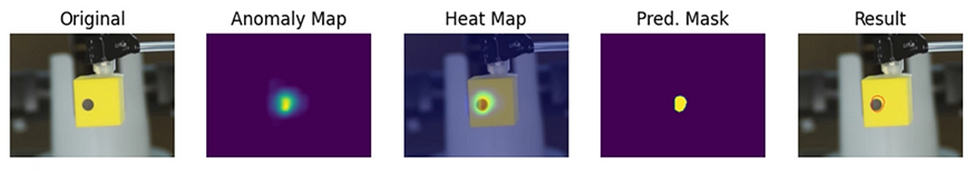

预测包含与结果有关的各种信息:原始图像、预测分数、异常图、热图图像、预测掩码和分割结果(图 5)。根据您要选择的任务类型,您可能需要更多信息。

图 5:预测结果

最后,我们采用 Dobot 机器人的缺陷检测用例基本是这样的(图 6)。

图 6:运行 Anomalib 模型推理的教育机器人

使用您自己的数据集的技巧和建议

数据集转换:

如果您想提高模型的准确性,您可以在您的训练管道中应用数据转换。您应该在 config.yaml 的 dataset.transform_config 部分提供增强配置文件的路径(复制到浏览器打开:https://albumentations.ai/docs/examples/serialization/)。这意味着您需要有一个用于 Anomalib 设置的 config.yaml 文件,以及一个可供 Anomalib config yaml 文件使用的单独 albumentations_config.yaml 文件。

在这个讨论帖中(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/discussions/737),您可以学习如何将数据转换添加到您的实际训练管道。

强大的模型:

异常检测库并非无所不能,在碰到麻烦的数据集时也可能会失效。好消息是:您可以尝试 13 个不同的模型,并能对每个实验的结果进行基准测试。您可以将基准测试入口点脚本用于其中(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/blob/main/tools/benchmarking/benchmark.py),并将配置文件用于基准测试目的(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/blob/main/tools/benchmarking/benchmark_params.yaml)。这将帮助您为实际用例选择最佳模型。

如需更多指南,请查看“操作指南”(复制到浏览器打开:https://openvinotoolkit.github.io/anomalib/how_to_guides/index.html)。

下一步

如果您正在使用 Dobot,并希望通过该 notebook 看到更多探讨其使用场景的文章,请将您的意见或问题添加到这篇博文中。如果您在 Anomalib 安装过程中遇到任何问题或错误,请在我们的GitHub 存储库(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib)中提交。

我们期待看到您使用 Anomalib 库提出更多办法。

祝您开心,欢迎您在我们的讨论频道(复制到浏览器打开:https://github.com/openvinotoolkit/anomalib/discussions)分享您的结果!

通知和免责声明

英特尔技术可能需要启用硬件、软件或激活服务。

没有任何产品或组件是绝对安全的。

具体成本和结果可能不同。

英特尔并不控制或审计第三方数据。请您审查该内容,咨询其他来源,并确认提及数据是否准确。

英特尔未做出任何明示和默示的保证,包括但不限于,关于适销性、适合特定目的及不侵权的默示保证,以及在履约过程、交易过程或贸易惯例中引起的任何保证。

本文件不构成对任何知识产权的授权,包括明示的、暗示的,也无论是基于禁止反言的原则或其他。

©英特尔公司版权所有。英特尔、英特尔标识和其他英特尔标志是英特尔公司或其子公司在美国和/或其他国家(地区)的商标。其他的名称和品牌可能是其他所有者的资产。

关于我们

Paula Ramos 自 21 世纪初以来一直在哥伦比亚开发新型集成工程技术,主要涉及计算机视觉、机器人和机器学习在农业领域的应用。在攻读博士和研究生学位期间,她部署了多个低成本的智能边缘和物联网计算技术,这些技术可供农民等不具备计算机视觉系统专业知识的人员操作。她的发明可在严苛和紧急的条件下运行,如没有照明控制的农业和户外环境,也可从容应对高太阳辐射条件、甚至极端高温条件。目前,她是英特尔的 AI 软件布道师,负责开发能够理解和重新创造周围视觉世界以满足现实需求的智能系统/机器。

Samet Akcay 是人工智能研究工程师/科学家。他的主要研究兴趣包括实时图像分类、检测、异常检测,以及基于深度/机器学习算法的无监督特征学习。他最近与人联合开发了开源的 Anomalib,这是该领域最大的异常检测库之一。Samet 拥有英国杜伦大学计算机科学系的博士学位,并获得了美国宾夕法尼亚州立大学电气工程系 Robust Machine Intelligence Lab 的硕士学位。他在顶级的计算机视觉和机器/深度学习会议和期刊上发表了 30 多篇学术论文。

武卓是英特尔的 AI 软件布道师,专注于 OpenVINO™ 工具套件的研究。她的工作职责涵盖了从深度学习技术到 5G 无线通信技术的领域。她在计算机视觉、机器学习、边缘计算、物联网系统和无线通信物理层算法等方面做出了卓越贡献。她为汽车、银行、保险等不同行业的企业客户提供基于机器学习和深度学习的端到端解决方案; 4G-LTE 和 5G 无线通信系统方面进行了广泛研究,并曾任职于中国贝尔实验室,期间申请了多项专利。她在上海大学担任副教授时,曾作为主要研究人员主导过多个研究项目。

摘要:StampedLock是一种在读取共享变量的过程中,允许后面的一个线程获取写锁对共享变量进行写操作,使用乐观读避免数据不一致的问题,并且在读多写少的高并发环境下,比ReadWriteLock更快的一种锁。

本文分享自华为云社区《一文彻底理解并发编程中非常重要的票据锁——StampedLock》,作者:冰 河 。

什么是StampedLock?

ReadWriteLock锁允许多个线程同时读取共享变量,但是在读取共享变量的时候,不允许另外的线程多共享变量进行写操作,更多的适合于读多写少的环境中。那么,在读多写少的环境中,有没有一种比ReadWriteLock更快的锁呢?

答案当然是有!那就是我们今天要介绍的主角——JDK1.8中新增的StampedLock!没错,就是它!

StampedLock与ReadWriteLock相比,在读的过程中也允许后面的一个线程获取写锁对共享变量进行写操作,为了避免读取的数据不一致,使用StampedLock读取共享变量时,需要对共享变量进行是否有写入的检验操作,并且这种读是一种乐观读。

总之,StampedLock是一种在读取共享变量的过程中,允许后面的一个线程获取写锁对共享变量进行写操作,使用乐观读避免数据不一致的问题,并且在读多写少的高并发环境下,比ReadWriteLock更快的一种锁。

StampedLock三种锁模式

这里,我们可以简单对比下StampedLock与ReadWriteLock,ReadWriteLock支持两种锁模式:一种是读锁,另一种是写锁,并且ReadWriteLock允许多个线程同时读共享变量,在读时,不允许写,在写时,不允许读,读和写是互斥的,所以,ReadWriteLock中的读锁,更多的是指悲观读锁。

StampedLock支持三种锁模式:写锁、读锁(这里的读锁指的是悲观读锁)和乐观读(很多资料和书籍写的是乐观读锁,这里我个人觉得更准确的是乐观读,为啥呢?我们继续往下看啊)。其中,写锁和读锁与ReadWriteLock中的语义类似,允许多个线程同时获取读锁,但是只允许一个线程获取写锁,写锁和读锁也是互斥的。

另一个与ReadWriteLock不同的地方在于:StampedLock在获取读锁或者写锁成功后,都会返回一个Long类型的变量,之后在释放锁时,需要传入这个Long类型的变量。例如,下面的伪代码所示的逻辑演示了StampedLock如何获取锁和释放锁。

StampedLock支持乐观读,这是它比ReadWriteLock性能要好的关键所在。 ReadWriteLock在读取共享变量时,所有对共享变量的写操作都会被阻塞。而StampedLock提供的乐观读,在多个线程读取共享变量时,允许一个线程对共享变量进行写操作。

我们再来看一下JDK官方给出的StampedLock示例,如下所示。

在上述代码中,如果在执行乐观读操作时,另外的线程对共享变量进行了写操作,则会把乐观读升级为悲观读锁,如下代码片段所示。

这种将乐观读升级为悲观读锁的方式相比一直使用乐观读的方式更加合理,如果不升级为悲观读锁,则程序会在一个循环中反复执行乐观读操作,直到乐观读操作期间没有线程执行写操作,而在循环中不断的执行乐观读会消耗大量的CPU资源,升级为悲观读锁是更加合理的一种方式。

StampedLock实现思想

StampedLock内部是基于CLH锁实现的,CLH是一种自旋锁,能够保证没有“饥饿现象”的发生,并且能够保证FIFO(先进先出)的服务顺序。

在CLH中,锁维护一个等待线程队列,所有申请锁,但是没有成功的线程都会存入这个队列中,每一个节点代表一个线程,保存一个标记位(locked),用于判断当前线程是否已经释放锁,当locked标记位为true时, 表示获取到锁,当locked标记位为false时,表示成功释放了锁。

当一个线程试图获得锁时,取得等待队列的尾部节点作为其前序节点,并使用类似如下代码判断前序节点是否已经成功释放锁:

只要前序节点(pred)没有释放锁,则表示当前线程还不能继续执行,因此会自旋等待;反之,如果前序线程已经释放锁,则当前线程可以继续执行。

释放锁时,也遵循这个逻辑,线程会将自身节点的locked位置标记为false,后续等待的线程就能继续执行了,也就是已经释放了锁。

StampedLock的实现思想总体来说,还是比较简单的,这里就不展开讲了。

StampedLock的注意事项

在读多写少的高并发环境下,StampedLock的性能确实不错,但是它不能够完全取代ReadWriteLock。在使用的时候,也需要特别注意以下几个方面。

StampedLock不支持重入

没错,StampedLock是不支持重入的,也就是说,在使用StampedLock时,不能嵌套使用,这点在使用时要特别注意。

StampedLock不支持条件变量

第二个需要注意的是就是StampedLock不支持条件变量,无论是读锁还是写锁,都不支持条件变量。

StampedLock使用不当会导致CPU飙升

这点也是最重要的一点,在使用时需要特别注意:如果某个线程阻塞在StampedLock的readLock()或者writeLock()方法上时,此时调用阻塞线程的interrupt()方法中断线程,会导致CPU飙升到100%。例如,下面的代码所示。

运行上面的程序,会导致thread02线程所在的CPU飙升到100%。

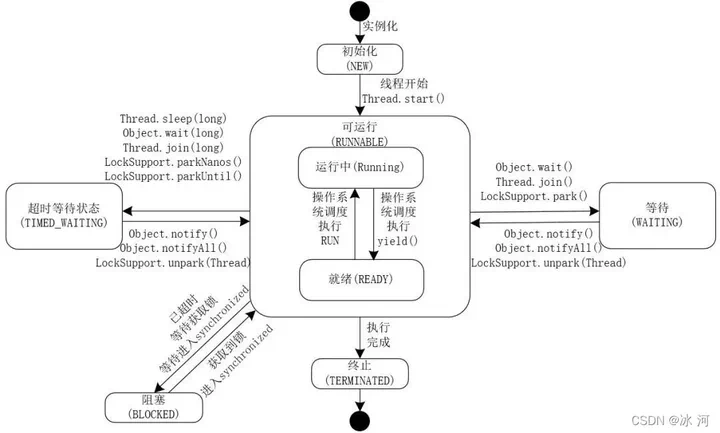

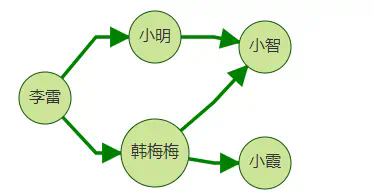

这里,有很多小伙伴不太明白为啥LockSupport.park();会导致thread01会永远阻塞。这里,冰河为你画了一张线程的生命周期图,如下所示。

这下明白了吧?在线程的生命周期中,有几个重要的状态需要说明一下。

- NEW:初始状态,线程被构建,但是还没有调用start()方法。

- RUNNABLE:可运行状态,可运行状态可以包括:运行中状态和就绪状态。

- BLOCKED:阻塞状态,处于这个状态的线程需要等待其他线程释放锁或者等待进入synchronized。

- WAITING:表示等待状态,处于该状态的线程需要等待其他线程对其进行通知或中断等操作,进而进入下一个状态。

- TIME_WAITING:超时等待状态。可以在一定的时间自行返回。

- TERMINATED:终止状态,当前线程执行完毕。

看完这个线程的生命周期图,知道为啥调用LockSupport.park();会使thread02阻塞了吧?

所以,在使用StampedLock时,一定要注意避免线程所在的CPU飙升的问题。那如何避免呢?

那就是使用StampedLock的readLock()方法或者读锁和使用writeLock()方法获取写锁时,一定不要调用线程的中断方法来中断线程,如果不可避免的要中断线程的话,一定要用StampedLock的readLockInterruptibly()方法获取可中断的读锁和使用StampedLock的writeLockInterruptibly()方法获取可中断的悲观写锁。

最后,对于StampedLock的使用,JDK官方给出的StampedLock示例本身就是一个最佳实践了,小伙伴们可以多看看JDK官方给出的StampedLock示例,多多体会下StampedLock的使用方式和背后原理与核心思想。

关注,第一时间了解华为云新鲜技术~

摘要:本案例我们利用视频字幕识别中的文字检测与识别模型,增加预训练Bert进行纠错

本文分享自华为云社区《Bert特调OCR》,作者:杜甫盖房子。

做这个项目的初衷是发现图比较糊/检测框比较长的时候,OCR会有一些错误识别,所以想对识别结果进行纠错。一个很自然的想法是利用语义信息进行纠错,其实在OCR训练时加入语义信息也有不少工作,感兴趣的朋友可以了解一下,为了更大程度复用已有的项目,我们决定保留现有OCR单,在之后加入独立语义纠错模块进行纠错。

本案例我们利用视频字幕识别中的文字检测与识别模型,增加预训练Bert进行纠错,最终效果如下:

我们使用进行开发,如果还没有安装,可以参考ModelBox端云协同AI开发套件(Windows)设备注册篇、ModelBox端云协同AI开发套件(Windows)SDK安装篇完成设备注册与安装。

技能开发

这个应用对应的版本已经做成模板放在华为云OBS中,可以用sdk中的工具下载,接下来我们给出该应用在中的完整开发过程:

1)下载模板

执行可看到当前公开的技能模板:

结果中的doc_ocr_db_crnn_bert即为文档识别应用模板,下载模板:

工具的参数中, 代表,即列出当前已有的模板名称; 代表,即下载对应名称的模板。下载下来的模板资源,将存放在核心库的目录下。

2)创建工程

在 sdk目录下使用创建工程

工具的参数中, 表示创建事务的类别,包括工程(server)、Python功能单(Python)、推理功能单(infer)等; 代表,即创建事务的名称; 代表,表示将使用后面参数值代表的模板创建工程,而不是创建空的工程。

目录下将创建出工程,工程内容如下所示:

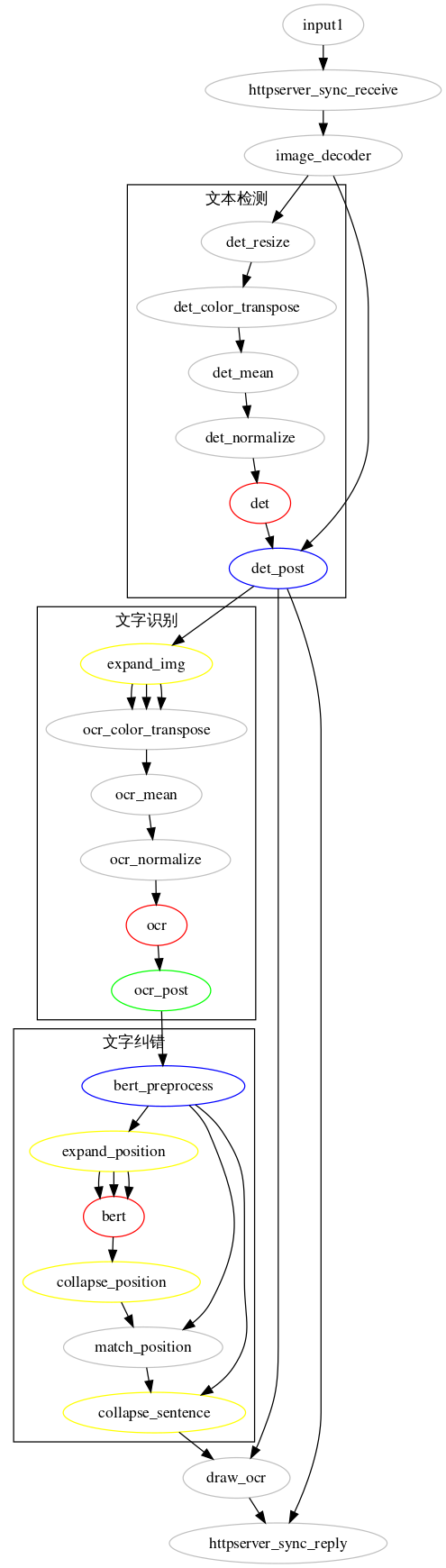

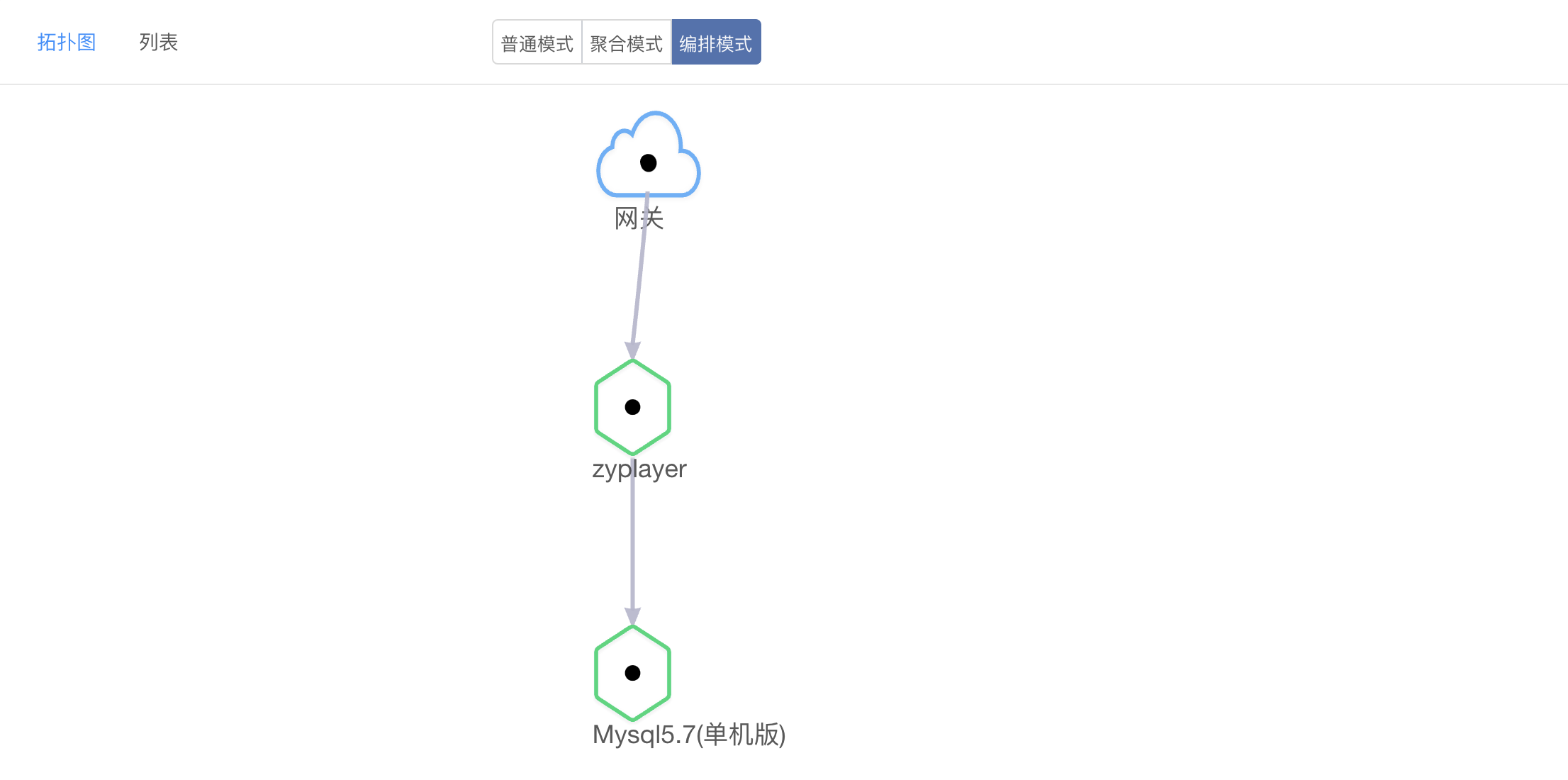

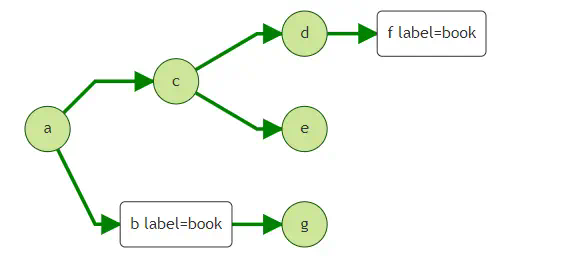

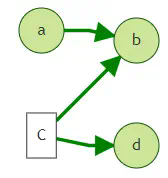

3)查看流程图

工程目录下存放流程图,默认的流程图与工程同名,将流程图可视化:

图示中,灰色部分为预置功能单,其余颜色为我们实现的功能单,其中绿色为一般通用功能单,红色为推理功能单,蓝色为条件功能单,黄色为展开归拢功能单。HTTP接收图解码后做预处理,接着是文字检测,模型后处理得到检测框,经过条件功能判断,检测到文字的图送入展开功能单,切图进行文字识别,文字识别结果送入bert预处理单判断是否需要进行纠错,如需纠错则再展开并行进行语义推理,不需要纠错的就直接进行结果绘制并返回。而未检测到文字的帧则直接返回。

4)核心逻辑

本应用核心逻辑中的文字检测与识别可以参考【ModelBox OCR实战营】视频字幕识别中的相关介绍,本文重点介绍文字纠错部分。

首先查看纠错预处理功能单:

预处理单对通过函数对OCR结果进行判断,只对大于3个字的中文字符进行纠错:

通过函数定位需要纠错的字符,只对OCR置信度小于阈值的字符进行纠错:

如有需要纠错的字符,则将该句编码,进行语义推理。

语义推理后,通过对推理结果进行解码,在功能单中使用函数计算语义推理结果与OCR结果的字符相似度:

其中,decompose_text函数将单个汉字编码为笔划级别的IDS,如:

华: ⿱⿰⿰丿丨⿻乚丿⿻一丨

计算语义推理结果字符与原OCR结果字符相似度之后,综合语义推理置信度与相似度判断是否接收纠错结果:

5)三方依赖库

本应用依赖pyclipper、Shapely、pillow等工具包,ModelBox应用不需要手动安装三方依赖库,只需要配置在,应用在编译时会自动安装。

技能运行

在项目目录下执行运行应用,为了方便观察纠错结果,我们将日志切换为info:

另起终端,进入项目目录下,运行脚本进行测试:

可以在技能运行日志中观察到接受的纠错结果:

同时,在目录下可以看到应用返回的结果图片:

关注,第一时间了解华为云新鲜技术~

准确的讲,Redis 事务包含两种模式 : 事务模式 和 Lua 脚本。

先说结论:

Redis 的事务模式具备如下特点:

- 保证隔离性;

- 无法保证持久性;

- 具备了一定的原子性,但不支持回滚;

- 一致性的概念有分歧,假设在一致性的核心是约束的语意下,Redis 的事务可以保证一致性。

但 Lua 脚本更具备实用场景,它是另一种形式的事务,他具备一定的原子性,但脚本报错的情况下,事务并不会回滚。Lua 脚本可以保证隔离性,而且可以完美的支持后面的步骤依赖前面步骤的结果。

Lua 脚本模式的身影几乎无处不在,比如分布式锁、延迟队列、抢红包等场景。

1 事务原理

Redis 的事务包含如下命令:

事务包含三个阶段:

- 事务开启,使用 MULTI , 该命令标志着执行该命令的客户端从非事务状态切换至事务状态 ;

- 命令入队,MULTI 开启事务之后,客户端的命令并不会被立即执行,而是放入一个事务队列 ;

- 执行事务或者丢弃。如果收到 EXEC 的命令,事务队列里的命令将会被执行 ,如果是 DISCARD 则事务被丢弃。

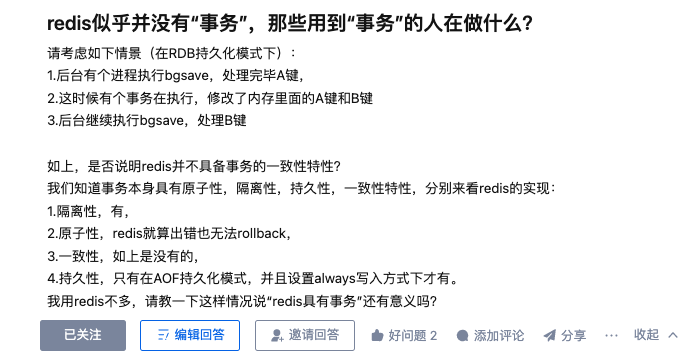

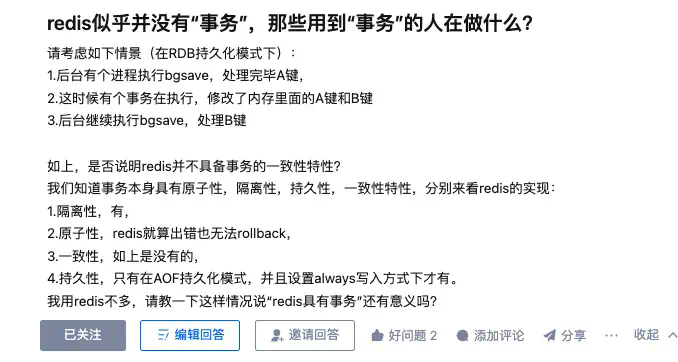

下面展示一个事务的例子。

这里有一个疑问?在开启事务的时候,Redis key 可以被修改吗?

在事务执行 EXEC 命令之前 ,Redis key 依然可以被修改。

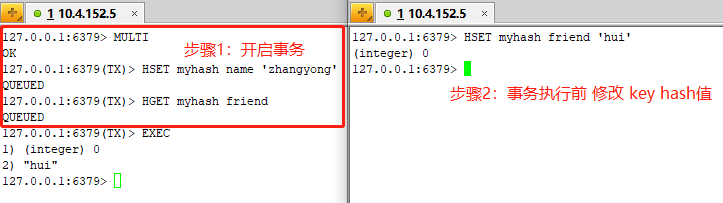

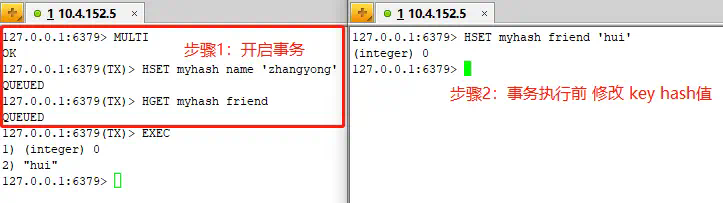

在事务开启之前,我们可以 watch 命令监听 Redis key 。在事务执行之前,我们修改 key 值 ,事务执行失败,返回 nil 。

通过上面的例子,watch 命令可以实现类似乐观锁的效果 。

2 事务的ACID

2.1 原子性

原子性是指:一个事务中的所有操作,或者全部完成,或者全部不完成,不会结束在中间某个环节。事务在执行过程中发生错误,会被回滚到事务开始前的状态,就像这个事务从来没有执行过一样。

第一个例子:

在执行 EXEC 命令前,客户端发送的操作命令错误,比如:语法错误或者使用了不存在的命令。

在这个例子中,我们使用了不存在的命令,导致入队失败,整个事务都将无法执行 。

第二个例子:

事务操作入队时,命令和操作的数据类型不匹配 ,入队列正常,但执行 EXEC 命令异常 。

这个例子里,Redis 在执行 EXEC 命令时,如果出现了错误,Redis 不会终止其它命令的执行,事务也不会因为某个命令执行失败而回滚 。

综上,我对 Redis 事务原子性的理解如下:

- 命令入队时报错, 会放弃事务执行,保证原子性;

- 命令入队时正常,执行 EXEC 命令后报错,不保证原子性;

也就是:Redis 事务在特定条件下,才具备一定的原子性 。

2.2 隔离性

数据库的隔离性是指:数据库允许多个并发事务同时对其数据进行读写和修改的能力,隔离性可以防止多个事务并发执行时由于交叉执行而导致数据的不一致。

事务隔离分为不同级别 ,分别是:

- 未提交读(read uncommitted)

- 提交读(read committed)

- 可重复读(repeatable read)

- 串行化(serializable)

首先,需要明确一点:Redis 并没有事务隔离级别的概念。这里我们讨论 Redis 的隔离性是指:并发场景下,事务之间是否可以做到互不干扰。

我们可以将事务执行可以分为 EXEC 命令执行前和 EXEC 命令执行后两个阶段,分开讨论。

- EXEC 命令执行前

在事务原理这一小节,我们发现在事务执行之前 ,Redis key 依然可以被修改。此时,可以使用 WATCH 机制来实现乐观锁的效果。

- EXEC 命令执行后

因为 Redis 是单线程执行操作命令, EXEC 命令执行后,Redis 会保证命令队列中的所有命令执行完 。 这样就可以保证事务的隔离性。

2.3 持久性

数据库的持久性是指 :事务处理结束后,对数据的修改就是永久的,即便系统故障也不会丢失。

Redis 的数据是否持久化取决于 Redis 的持久化配置模式 。

- 没有配置 RDB 或者 AOF ,事务的持久性无法保证;

- 使用了 RDB模式,在一个事务执行后,下一次的 RDB 快照还未执行前,如果发生了实例宕机,事务的持久性同样无法保证;

- 使用了 AOF 模式;AOF 模式的三种配置选项 no 、everysec 都会存在数据丢失的情况 。always 可以保证事务的持久性,但因为性能太差,在生产环境一般不推荐使用。

综上,redis 事务的持久性是无法保证的 。

2.4 一致性

一致性的概念一直很让人困惑,在我搜寻的资料里,有两类不同的定义。

- 维基百科

我们先看下维基百科上一致性的定义:

Consistency ensures that a transaction can only bring the database from one valid state to another, maintaining database invariants: any data written to the database must be valid according to all defined rules, including constraints, cascades, triggers, and any combination thereof. This prevents database corruption by an illegal transaction, but does not guarantee that a transaction is correct. Referential integrity guarantees the primary key – foreign key relationship.

在这段文字里,一致性的核心是“约束”,“any data written to the database must be valid according to all defined rules ”。

如何理解约束?这里引用知乎问题 如何理解数据库的内部一致性和外部一致性,蚂蚁金服 OceanBase 研发专家韩富晟回答的一段话:

“约束”由数据库的使用者告诉数据库,使用者要求数据一定符合这样或者那样的约束。当数据发生修改时,数据库会检查数据是否还符合约束条件,如果约束条件不再被满足,那么修改操作不会发生。

关系数据库最常见的两类约束是“唯一性约束”和“完整性约束”,表格中定义的主键和唯一键都保证了指定的数据项绝不会出现重复,表格之间定义的参照完整性也保证了同一个属性在不同表格中的一致性。

“ Consistency in ACID ”是如此的好用,以至于已经融化在大部分使用者的血液里了,使用者会在表格设计的时候自觉的加上需要的约束条件,数据库也会严格的执行这个约束条件。

所以事务的一致性和预先定义的约束有关,保证了约束即保证了一致性。

我们细细品一品这句话: This prevents database corruption by an illegal transaction, but does not guarantee that a transaction is correct。

写到这里可能大家还是有点模糊,我们举经典转账的案例。

我们开启一个事务,张三和李四账号上的初始余额都是1000,并且余额字段没有任何约束。张三给李四转账1200。张三的余额更新为 -200 , 李四的余额更新为2200。

从应用层面来看,这个事务明显不合法,因为现实场景中,用户余额不可能小于 0 , 但是它完全遵循数据库的约束,所以从数据库层面来看,这个事务依然保证了一致性。

Redis 的事务一致性是指:Redis 事务在执行过程中符合数据库的约束,没有包含非法或者无效的错误数据。

我们分三种异常场景分别讨论:

- 执行 EXEC 命令前,客户端发送的操作命令错误,事务终止,数据保持一致性;

- 执行 EXEC 命令后,命令和操作的数据类型不匹配,错误的命令会报错,但事务不会因为错误的命令而终止,而是会继续执行。正确的命令正常执行,错误的命令报错,从这个角度来看,数据也可以保持一致性;

- 执行事务的过程中,Redis 服务宕机。这里需要考虑服务配置的持久化模式。

- 无持久化的内存模式:服务重启之后,数据库没有保持数据,因此数据都是保持一致性的;

- RDB / AOF 模式: 服务重启后,Redis 通过 RDB / AOF 文件恢复数据,数据库会还原到一致的状态。

综上所述,在一致性的核心是约束的语意下,Redis 的事务可以保证一致性。

- 《设计数据密集型应用》

这本书是分布式系统入门的神书。在事务这一章节有一段关于 ACID 的解释:

Atomicity, isolation, and durability are properties of the database,whereas consistency (in the ACID sense) is a property of the application. The application may rely on the database’s atomicity and isolation properties in order to achieve consistency, but it’s not up to the database alone. Thus, the letter C doesn’t really belong in ACID.

原子性,隔离性和持久性是数据库的属性,而一致性(在 ACID 意义上)是应用程序的属性。应用可能依赖数据库的原子性和隔离属性来实现一致性,但这并不仅取决于数据库。因此,字母 C 不属于 ACID 。

很多时候,我们一直在纠结的一致性,其实就是指符合现实世界的一致性,现实世界的一致性才是事务追求的最终目标。

为了实现现实世界的一致性,需要满足如下几点:

- 保证原子性,持久性和隔离性,如果这些特征都无法保证,那么事务的一致性也无法保证;

- 数据库本身的约束,比如字符串长度不能超过列的限制或者唯一性约束;

- 业务层面同样需要进行保障 。

2.5 事务特点

我们通常称 Redis 为内存数据库 , 不同于传统的关系数据库,为了提供了更高的性能,更快的写入速度,在设计和实现层面做了一些平衡,并不能完全支持事务的 ACID。

Redis 的事务具备如下特点:

- 保证隔离性;

- 无法保证持久性;

- 具备了一定的原子性,但不支持回滚;

- 一致性的概念有分歧,假设在一致性的核心是约束的语意下,Redis 的事务可以保证一致性。

从工程角度来看,假设事务操作中每个步骤需要依赖上一个步骤返回的结果,则需要通过 watch 来实现乐观锁 。

3 Lua 脚本

3.1 简介

Lua 由标准 C 编写而成,代码简洁优美,几乎在所有操作系统和平台上都可以编译,运行。Lua 脚本可以很容易的被 C/C ++ 代码调用,也可以反过来调用 C/C++ 的函数,这使得 Lua 在应用程序中可以被广泛应用。

Lua 脚本在游戏领域大放异彩,大家耳熟能详的《大话西游II》,《魔兽世界》都大量使用 Lua 脚本。Java 后端工程师接触过的 api 网关,比如 Openresty ,Kong 都可以看到 Lua 脚本的身影。

从 Redis 2.6.0 版本开始, Redis内置的 Lua 解释器,可以实现在 Redis 中运行 Lua 脚本。

使用 Lua 脚本的好处 :

- 减少网络开销。将多个请求通过脚本的形式一次发送,减少网络时延。

- 原子操作。Redis会将整个脚本作为一个整体执行,中间不会被其他命令插入。

- 复用。客户端发送的脚本会永久存在 Redis 中,其他客户端可以复用这一脚本而不需要使用代码完成相同的逻辑。

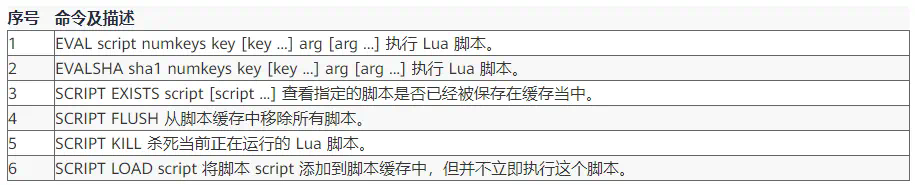

Redis Lua 脚本常用命令:

3.2 EVAL 命令

命令格式:

说明:

- 是第一个参数,为 Lua 5.1脚本;

- 第二个参数指定后续参数有几个 key;

- ,是要操作的键,可以指定多个,在 Lua 脚本中通过, 获取;

- ,参数,在 Lua 脚本中通过, 获取。

简单实例:

下面演示下 Lua 如何调用 Redis 命令 ,通过来执行了 Redis 命令 。

3.3 EVALSHA 命令

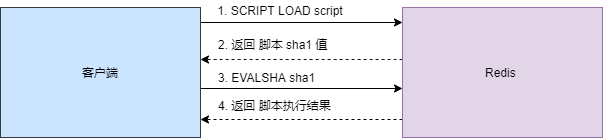

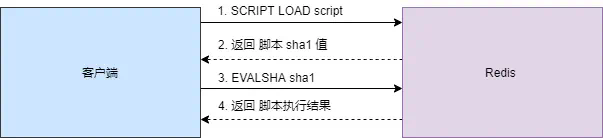

使用 EVAL 命令每次请求都需要传输 Lua 脚本 ,若 Lua 脚本过长,不仅会消耗网络带宽,而且也会对 Redis 的性能造成一定的影响。

思路是先将 Lua 脚本先缓存起来 , 返回给客户端 Lua 脚本的 sha1 摘要。 客户端存储脚本的 sha1 摘要 ,每次请求执行 EVALSHA 命令即可。

EVALSHA 命令基本语法如下:

实例如下:

4 事务 VS Lua 脚本

从定义上来说, Redis 中的脚本本身就是一种事务, 所以任何在事务里可以完成的事, 在脚本里面也能完成。 并且一般来说, 使用脚本要来得更简单,并且速度更快。

因为脚本功能是 Redis 2.6 才引入的, 而事务功能则更早之前就存在了, 所以 Redis 才会同时存在两种处理事务的方法。

不过我们并不打算在短时间内就移除事务功能, 因为事务提供了一种即使不使用脚本, 也可以避免竞争条件的方法, 而且事务本身的实现并不复杂。

— https://redis.io/

Lua 脚本是另一种形式的事务,他具备一定的原子性,但脚本报错的情况下,事务并不会回滚。Lua 脚本可以保证隔离性,而且可以完美的支持后面的步骤依赖前面步骤的结果。

Lua 脚本模式的身影几乎无处不在,比如分布式锁、延迟队列、抢红包等场景。

不过在编写 Lua 脚本时,要注意如下两点:

- 为了避免 Redis 阻塞,Lua 脚本业务逻辑不能过于复杂和耗时;

- 仔细检查和测试 Lua 脚本 ,因为执行 Lua 脚本具备一定的原子性,不支持回滚。

作者:京东零售 吴迪

前言

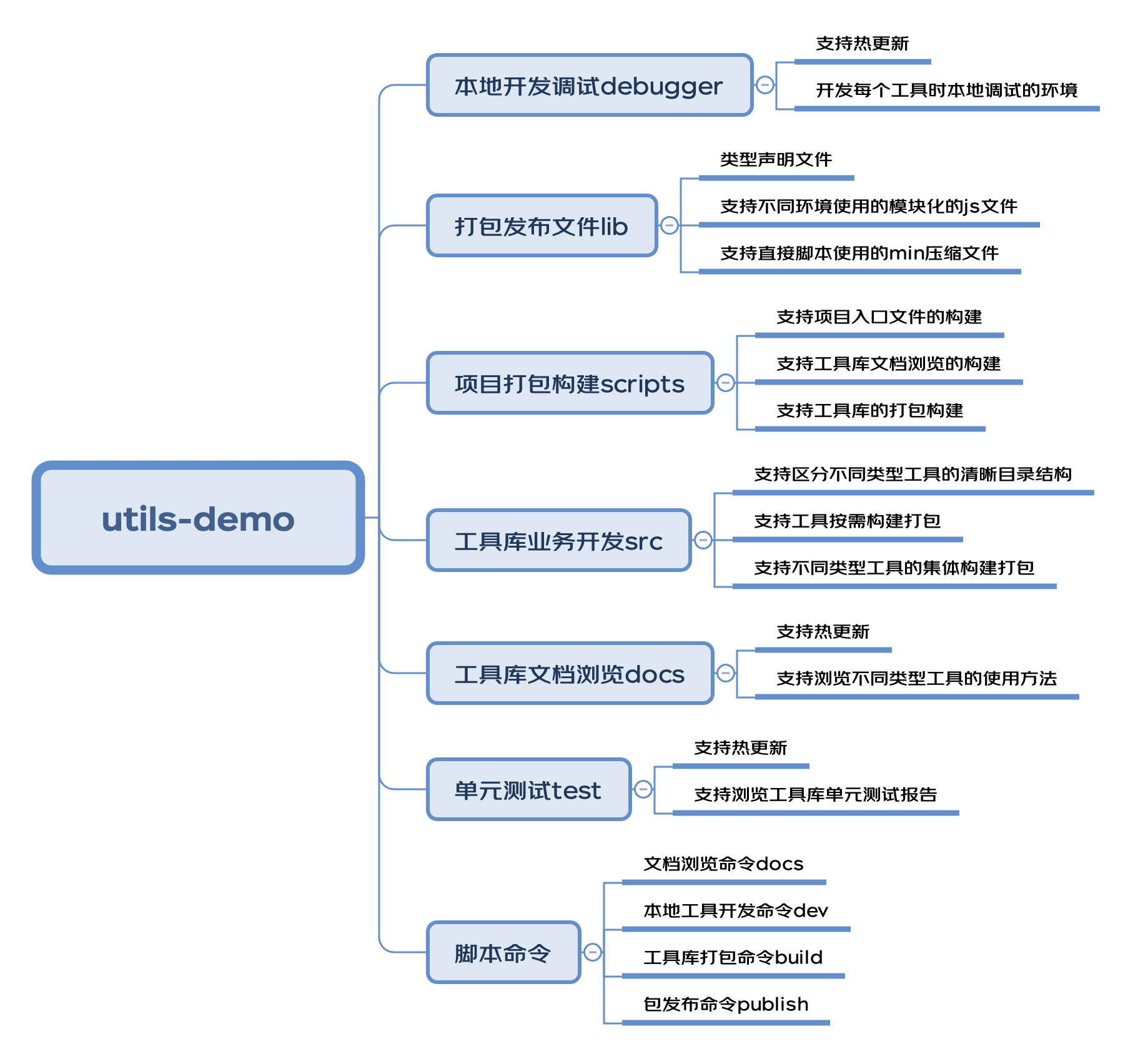

- 在实际开发过程中,经常使用一些开源工具库,如 lodash,以方便、快捷的进行项目开发。但是当 npm上没有自己中意或符合自身业务的工具时,我们不得不自己动手,此时拥有自己的、基于业务的工具库就显得尤为重要。

- 我们所熟知的Vue、React等诸多知名前端框架,或公司提供的一些类库,它们是如何开发、构建、打包出来的,本文将带领你了解到如何从0到1构建基于自身业务的前端工具库。

构建工具库主流方案

1. WEBPACK

- webpack 提供了构建和打包不同模块化规则的库,只是需要自己去搭建开发底层架构。

- vue-cli,基于 webpack , vue-cli 脚手架工具可以快速初始化一个 vue 应用,它也可以初始化一个构建库。

2. ROLLUP

- rollup 是一个专门针对JavaScript模块打包器,可以将应用或库的小块代码编译成更复杂的功能代码。

- Vue、React 等许多流行前端框架的构建和打包都能看到 rollup 的身影。

为什么采用 ROLLUP 而不是 WEBPACK

- webpack 主要职能是开发应用,而 rollup 主要针对的就是 js 库的开发,如果你要开发 js 库,那 webpack 的繁琐配置和打包后的文件体积就不太适用了,通过webpack打包构建出来的源代码增加了很多工具函数以外的模块依赖代码。

- rollup 只是把业务代码转码成目标 js ,小巧且轻便。rollup对于代码的Tree-shaking和ES6模块有着算法优势上的支持,如果只想构建一个简单的库,并且是基于ES6开发的,加上其简洁的API,rollup得到更多开发者的青睐。

工具库底层架构设计

构建工具库底层架构大概需要哪些功能的支持:

架构依赖需知

在对底层架构设计的基础上,首先需要把用到的依赖库简单熟悉一下:

rollup 全家桶

rollup(工具库打包构建核心包)

rollup-plugin-livereload(rollup 插件,热更新,方便本地 debugger 开发)

rollup-plugin-serve(rollup 插件,本地服务代理,方便在本地 html 中调试工具)

rollup-plugin-terser(rollup 插件,代码压缩混淆)

rollup-plugin-visualizer(rollup 插件,可视化并分析 Rollup bundle,以查看模块占用)

@rollup/plugin-babel(rollup 插件,rollup 的 babel 插件,ES6 转 ES5)

@rollup/plugin-commonjs(rollup 插件,用来将 CommonJS 模块转换为 ES6,这样它们就可以包含在 Rollup 包中)

@rollup/plugin-json(rollup 插件,它将.json 文件转换为 ES6 模块)

@rollup/plugin-node-resolve(rollup 插件,它使用节点解析算法定位模块,用于在节点模块中使用第三方 node_modules 包)

@rollup/plugin-typescript(rollup 插件,对 typescript 的支持,将 typescript 进行 tsc 转为 js)

typescript 相关

typescript(使用 ts 开发工具库)

tslib(TypeScript 的运行库,它包含了 TypeScript 所有的帮助函数)

@typescript-eslint/eslint-plugin(TypeScript 的 eslint 插件,约束 ts 书写规范)

@typescript-eslint/parser(ESLint 解析器,它利用 TypeScript ESTree 来允许 ESLint 检测 TypeScript 源代码)

文档相关

typedoc(TypeScript 项目的文档生成器)

gulp(使用 gulp 构建文档系统)

gulp-typedoc(Gulp 插件来执行 TypeDoc 工具)

browser-sync(文档系统热更新)

单测试相关

jest(一款优雅、简洁的 JavaScript 测试框架)

@types/jest(Jest 的类型定义)

ts-jest(一个支持源映射的 Jest 转换器,允许您使用 Jest 来测试用 TypeScript 编写的项目)

@babel/preset-typescript(TypeScript 的 Babel 预设)

其他依赖

eslint(代码规范约束)

@babel/core(@rollup/plugin-babel 依赖的 babel 解析插件)

@babel/plugin-transform-runtime(babel 转译依赖)

@babel/preset-env(babel 转译依赖)

chalk(控制台字符样式)

rimraf(UNIX 命令 rm -rf 用于 node)

cross-env(跨平台设置 node 环境变量)

底层架构搭建

1. 初始化项目

新建一个文件夹 utils-demo,执行 npm init,过程会询问构建项目的基本信息,按需填写即可:

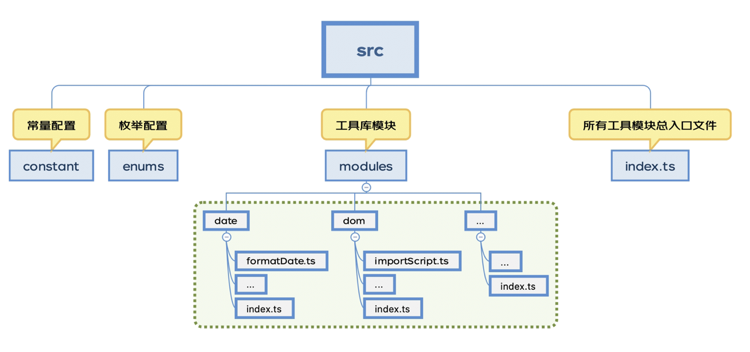

2. 组织工具库业务开发 SRC 目录结构

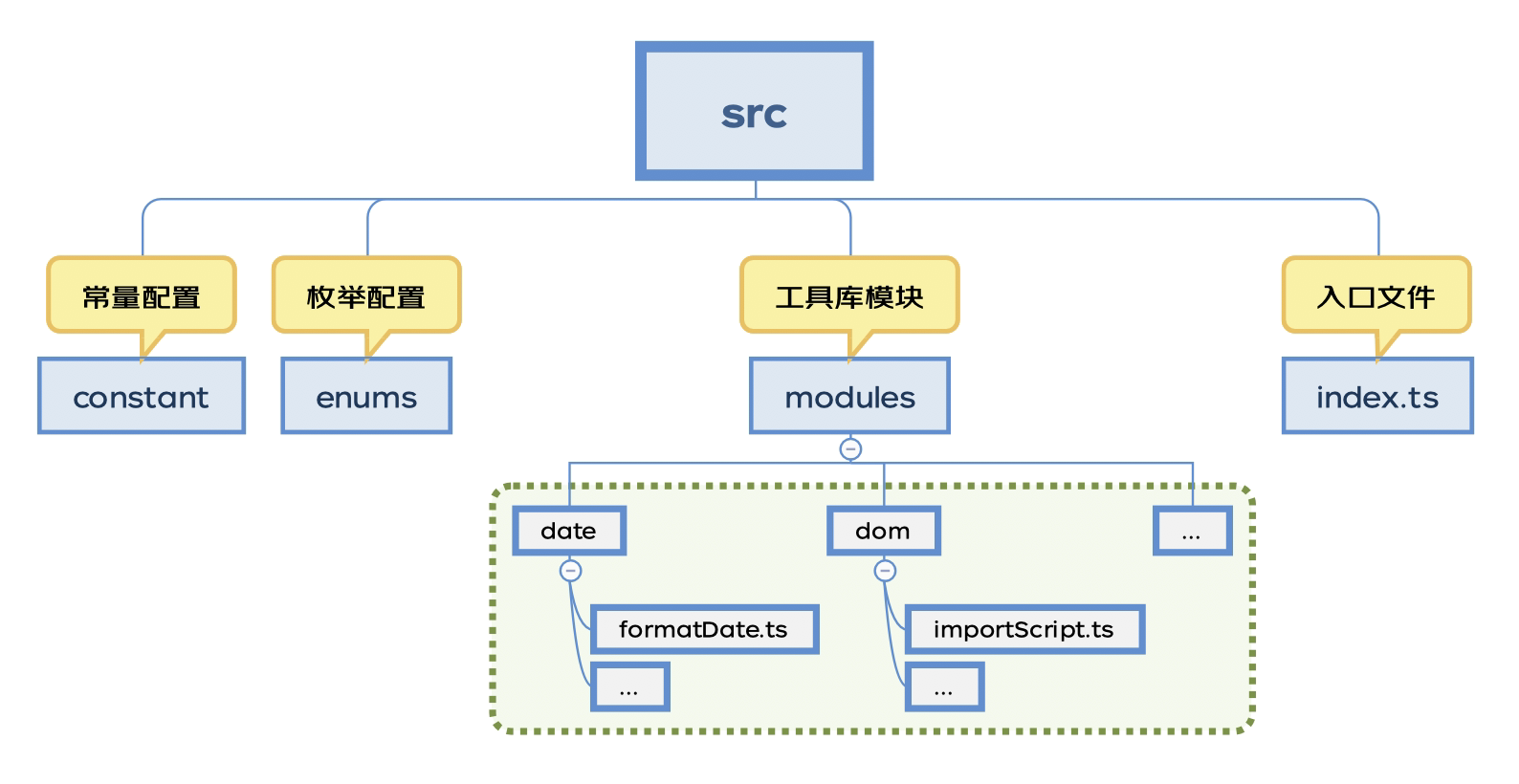

创建工具库业务开发 src 文件目录,明确怎样规划工具库包,里面放置的是工具库开发需要的业务代码:

3. 安装项目依赖

要对 typescript 代码进行解析支持需要安装对 ts 支持的依赖,以及对开发的工具的一些依赖包:

这里遇到一个坑,关于最新 chalk5.0.0 不支持在 nodejs 中 require()导入,所以锁定包版本 chalk@^4.1.2

要对 typescript 进行解析和编译还需要配置 tsconfig.json,该文件中指定了用来编译这个项目的根文件和编译选项,在项目根目录,使用 tsc –init 命令快速生成 tsconfig.json 文件(前提全局安装 typescript)

初始化 tsconfig 完成之后,根目录自动生成 tsconfig.json 文件,需要对其进行简单的配置,以适用于 ts 项目,其中具体含义可以参考tsconfig.json官网

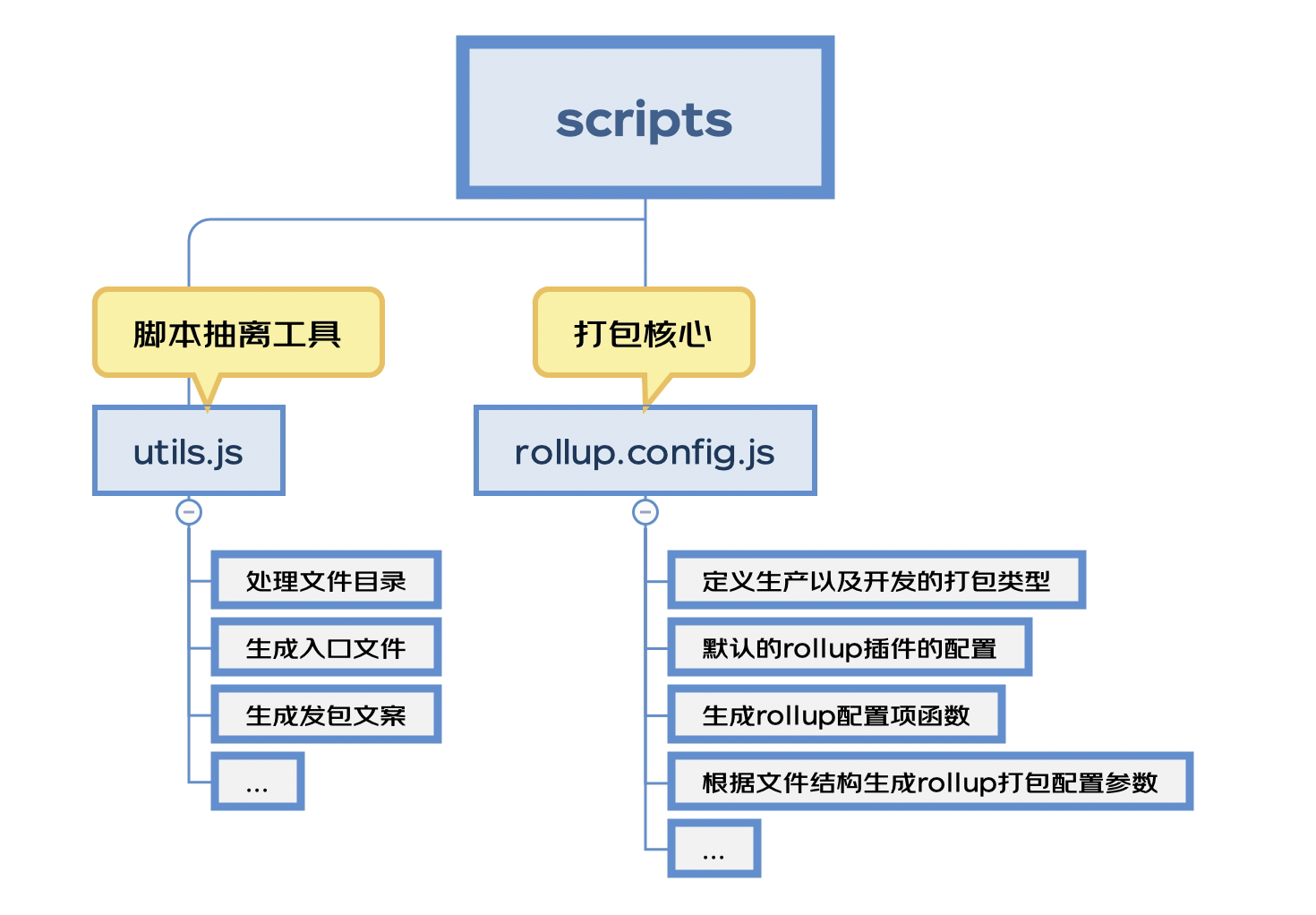

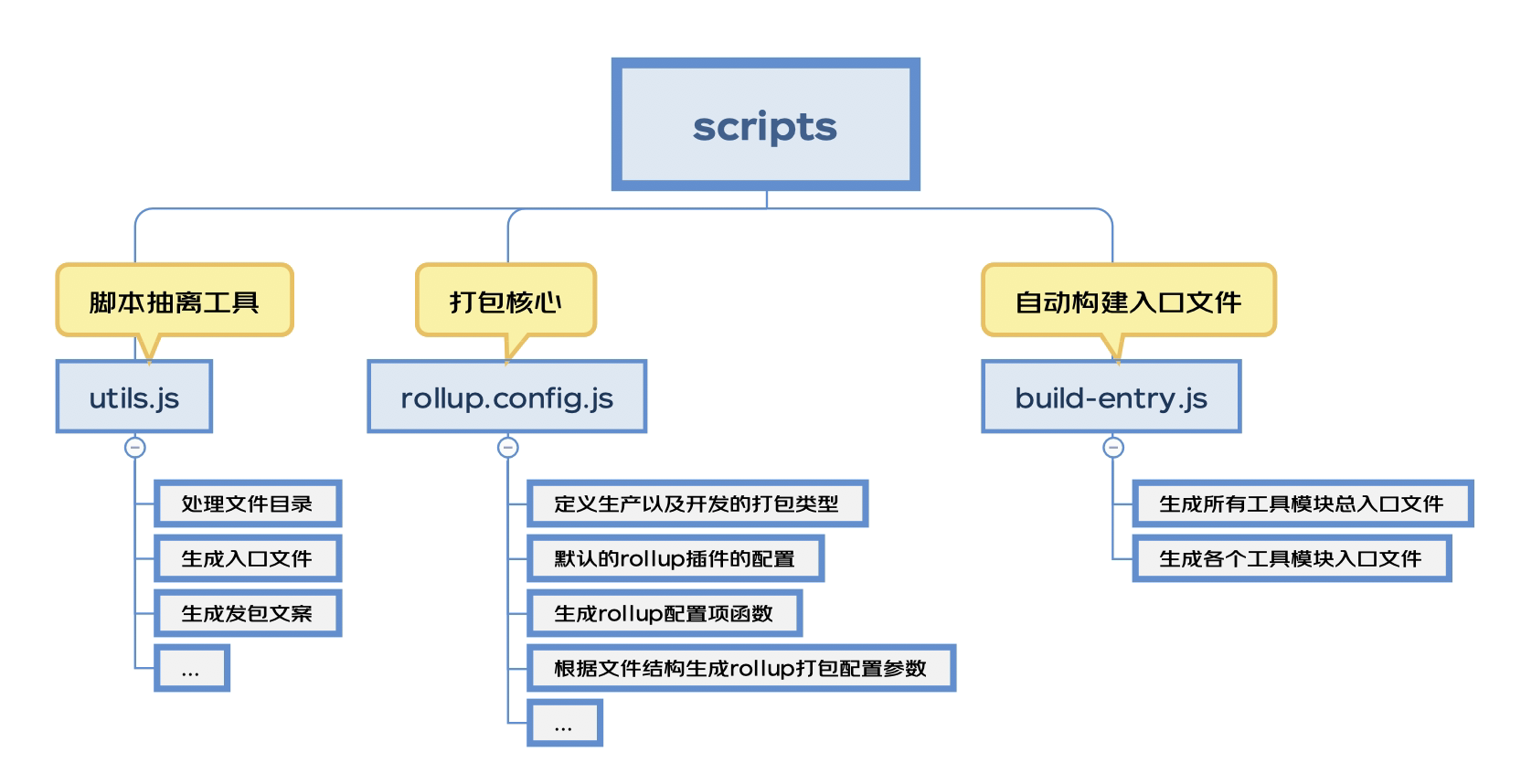

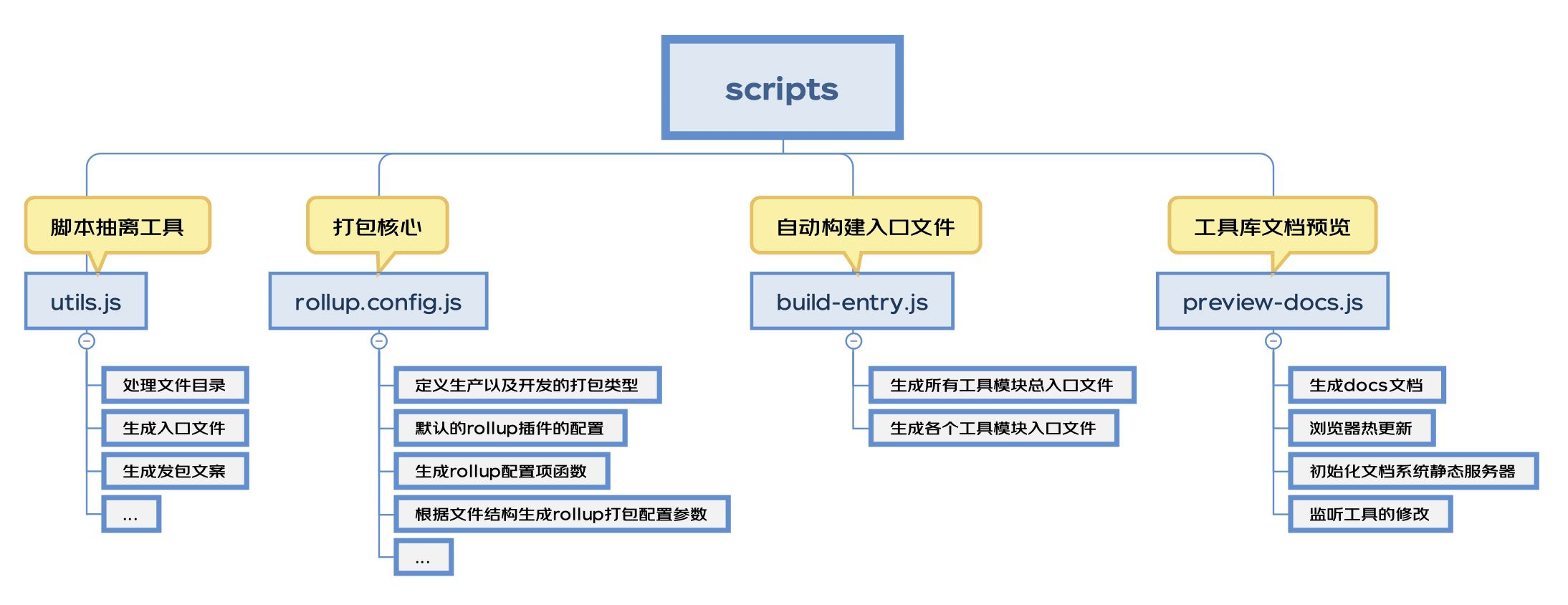

4. 组织项目打包构建 SCRIPTS 目录结构

1) 根目录创建项目打包构建 scripts 脚本文件目录,里面放置的是有关于项目打包构建需要的文件:

生成rollup配置项函数核心代码:

2) rollup 在打包构建的过程中需要进行 babel 的转译,需要在根目录添加.babelrc 文件告知 babel:

3) 此时距离打包构建工具库只差一步之遥,配置打包脚本命令,在 package.json 中配置命令:

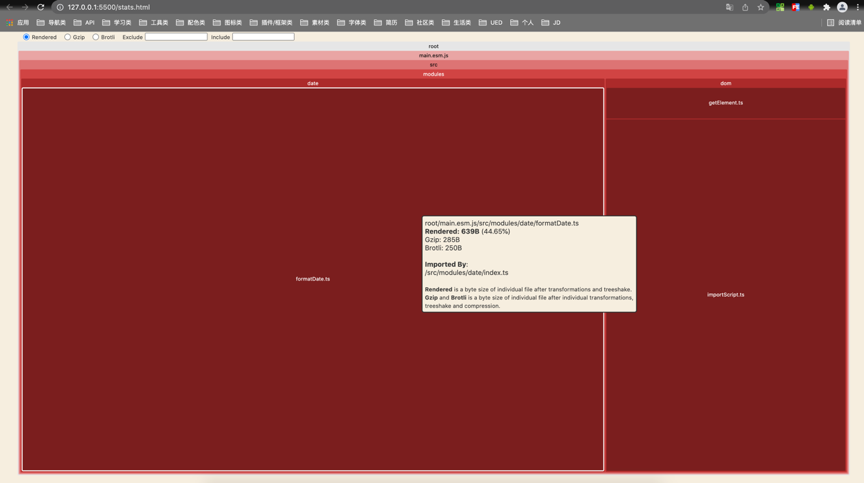

4) 执行 yarn build,根目录会构建出一个 lib 文件夹,里面有打包构建的文件,还多了一个 stats.html,这个是可视化并分析 Rollup bundle,用来查看工具模块占用空间:

架构搭建优化

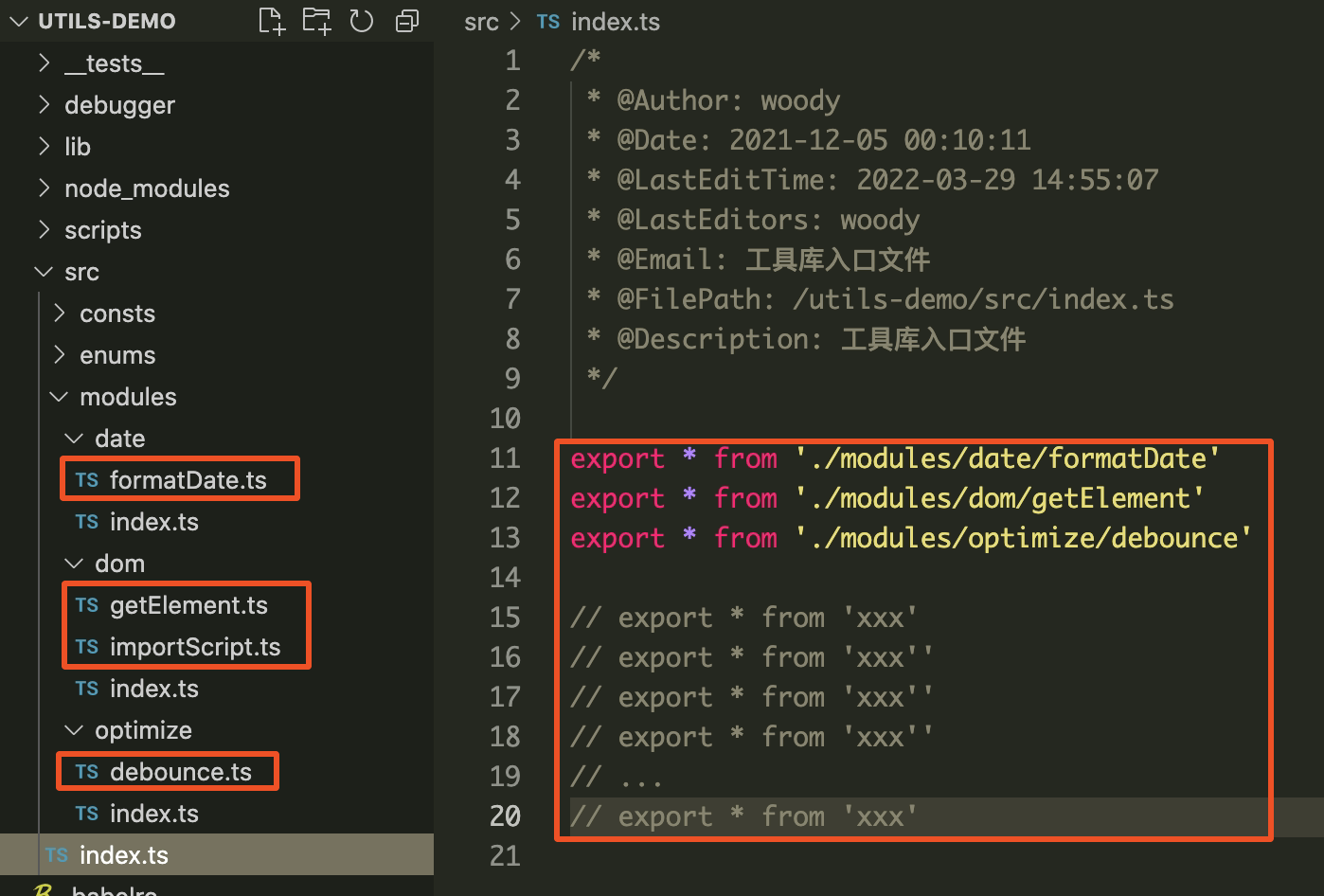

项目搭建到这里,不知机智的你能否发现问题:

1) 只要添加了一个工具,就要在入口文件导出需要打包构建的工具,在多人开发提交代码的时候将引来冲突的产生:

2) 使用工具库的时候,按需引用的颗粒度太细了,不能满足一些要求颗粒度粗的朋友,比如:

我想使用该包里面 date 相关工具,要这样吗?

能不能这样?

在一些使用 script 脚本引入的场景下,就仅仅需要 date 相关的工具,要这样吗?

能不能这样?

这样仅仅使用 date 里面的工具,就没有必要将所有的工具都引入了

解决方案:

1) 针对第一个代码冲突的问题,可以根据 src > modules 下目录结构自动生成入口文件 index.ts

自动构建入口文件核心代码:

2) 针对颗粒度的问题,可以将 modules 下各种类型工具文件夹下面也自动生成入口文件,除了全部导出,再追加 import * as 模块类名称 类型的导出

至此,基本上解决了工具库打包的问题,但是架构中还缺少本地开发调试的环境,下面为大家介绍如何架构中添加本地开发调试的系统。

本地开发调试系统

首先要明确要加入本地开发调试系统的支持,需要做到以下:

跨平台(window不支持NODE_ENV=xxx)设置环境变量,根据环境配置不同的 rollup 配置项

引入本地开发需要的 html 静态服务器环境,并能做到热更新

1) 跨平台设置环境变量很简单,使用 cross-env 指定 node 的环境

2) 配置 package.json 命令

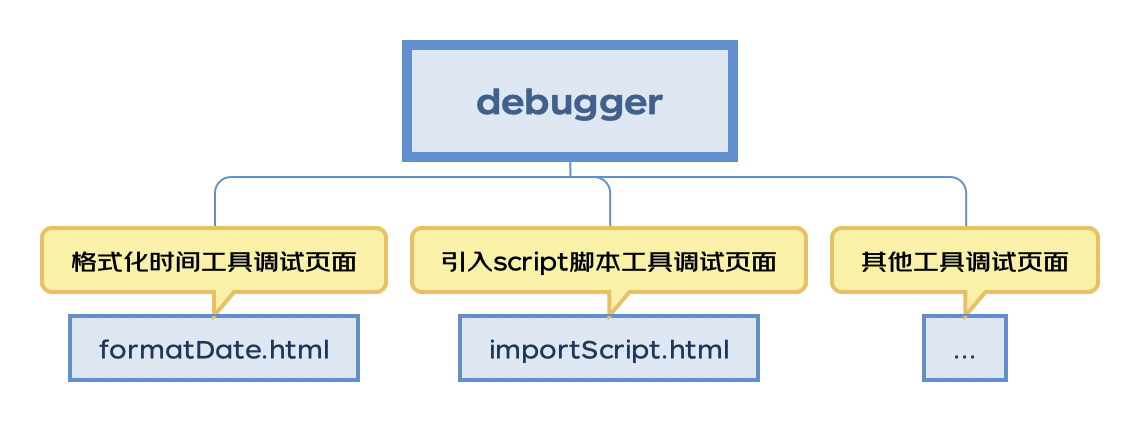

3) 根据最开始架构设计的模块,在项目根目录新建 debugger 文件夹,里面存放的是工具调试的 html 静态页面

4) 接下来就是配置 scripts > rollup.config.js ,将 NODE_ENV=development 环境加入 rollup 配置,修改生成rollup配置项函数核心代码:

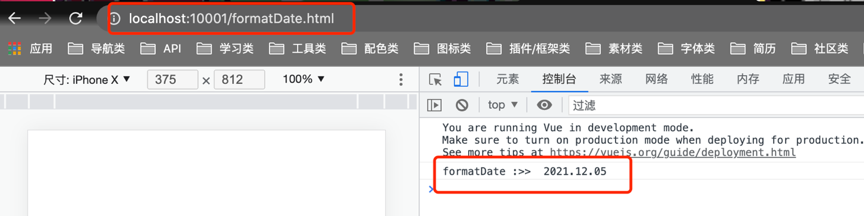

5) 执行 yarn dev 之后浏览器会新打开窗口,输入刚添加的工具链接,并且它是热更新的:

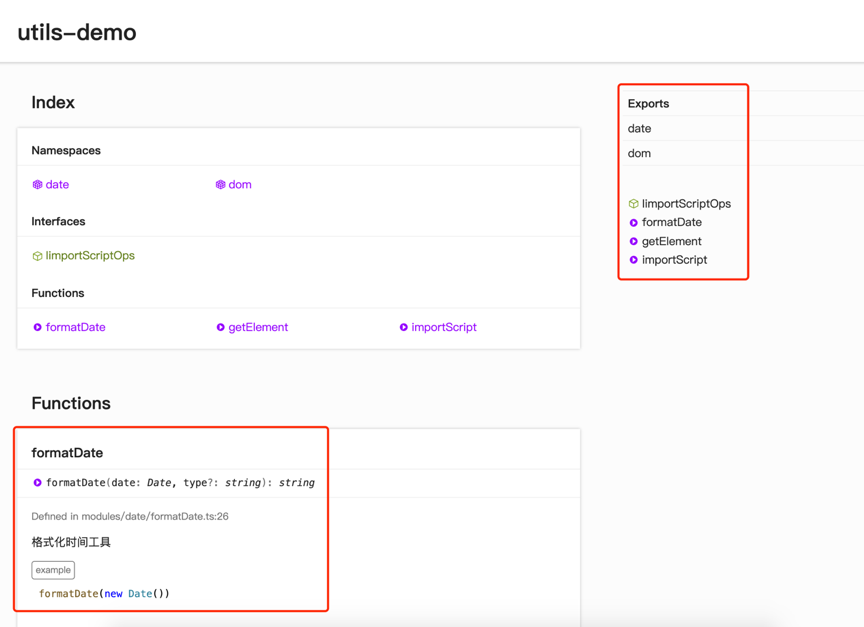

工具库文档系统

一个完备的工具库需要有一个文档来展示开发的工具函数,它可能需要具备以下几点支持:

支持工具库中方法的可视化预览

支持修改工具的时候,具备热更新机制

typedoc(TypeScript 项目的文档生成器)能完美支持 typescript 开发工具库的文档生成器的支持,它的核心原理就是读取源代码,根据工具的注释、ts的类型规范等,自动生成文档页面

关于热更新机制的支持,第一个自然想到 browser-sync(文档系统热更新)

由于文档系统的预览功能有很多插件组合来实现的,可以借助 gulp (基于流的自动化构建工具),typedoc正好有对应的 gulp-typedocGulp 插件来执行 TypeDoc 工具插件

构建完成后打开文档系统,并且它是热更新的,修改工具方法后自动更新文档:

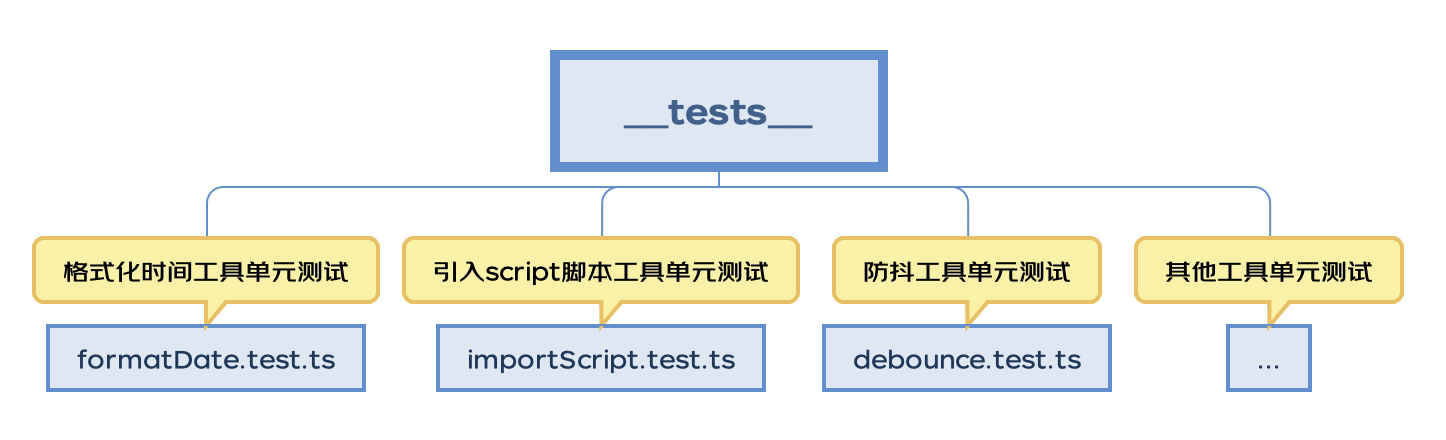

单测试

为确保用户使用的工具代码的安全性、正确性以及可靠性,工具库的单测试必不可少。单测试选用的是 Facebook 出品的 Jest 测试框架,它对于 TypeScript 有很好的支持。

1. 环境搭建

1) 首先全局安装 jest 使用 init 来初始化 jest 配置项

执行完之后根目录会自动生成jest.config.ts 文件,里面设置了单测试的配置规则,package.json 里面也多了一个 script 指令 test。

2) 关于jest.config.js文件配置项具体含义可以查看官网,要想完成 jest 对于 TypeScript 的测试,还需要安装一些依赖:

3) jest 还需要借助 .babelrc 去解析 TypeScript 文件,再进行测试,编辑 .babelrc 文件,添加依赖包 @babel/preset-typescript:

2. 单测试文件的编写

1) 通过以上环节,jest 单测试环境基本搭建完毕,接下来在__tests__下编写测试用例

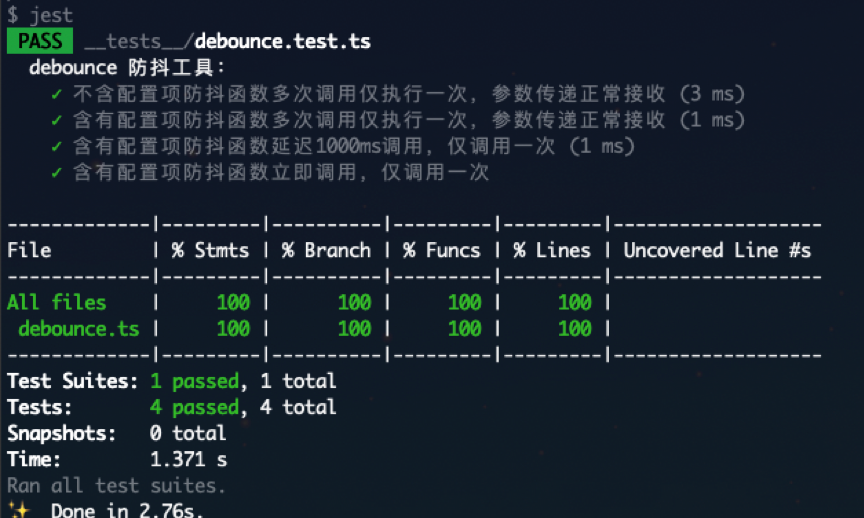

2) 执行 yarn test

可以看到关于 debounce 防抖工具函数的测试情况显示在了控制台:

stmts 是语句覆盖率(statement coverage):是不是每个语句都执行了?

Branch 分支覆盖率(branch coverage):是不是每个 if 代码块都执行了?

Funcs 函数覆盖率(function coverage):是不是每个函数都调用了?

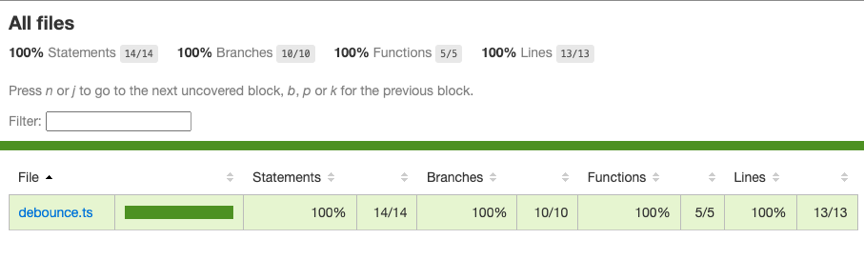

Lines 行覆盖率(line coverage):是不是每一行都执行了?

3) 同时还会发现项目根目录多了一个 coverage 文件夹,里面就是 jest 生成的测试报告:

3. 单测试文件的编写引发的思考

每次修改单测试都要执行 yarn test 去查看测试结果,怎么解决?

jest提供了 watch 指令,只需要配置 scripts 脚本就可以做到,单测试的热更新。

以后会写很多工具的测试用例,每次 test 都将所有工具都进行了测试,能否只测试自己写的工具?

jest 也提供了测试单个文件的方法,这样 jest 只会对防抖函数进行测试(前提全局安装了 jest)。

工具库包的发布

至此工具库距离开发者使用仅一步之遥,就是发布到npm上,发包前需要在 package.json 中声明库的一些入口,关键词等信息。

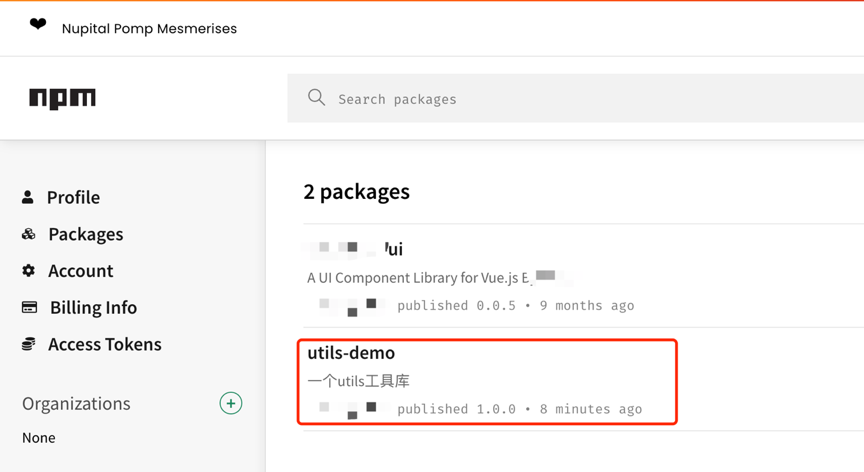

登陆npm,你会看到自己的 packages 里面有了刚刚发布的工具库包:

写在最后

以上就是作者整理的从0到1构建基于自身业务的前端工具库的全过程,希望能给阅读本文的开发人员带来一些新的想法与尝试。

在此基础上已经成功在京东npm源发布了应用于京东汽车前端的工具库@jdcar/car-utils,并在各个业务线及系统得到落地。

当然,架构优化之路也还远未结束,比如:打包构建的速度、本地开发按需构建、工具库脚手架化等,后续我们也会基于自身业务以及一些新技术,持续深入优化,在性能上进一步提升,在功能上进一步丰富。本文或存在一些浅显不足之处,也欢迎大家评论指点。

参考资料

[1] rollup 英文文档(https://rollupjs.org/guide/en/#quick-start)

[2] rollup 中文文档(https://rollupjs.org/guide/zh/#introduction)

[3] Rollup.js 实战学习笔记(https://chenshenhai.github.io/rollupjs-note/)

[4] Rollup 打包工具的使用(https://juejin.cn/post/)

[5] TypeScript、Rollup 搭建工具库(https://juejin.cn/post/0)

[6] 使用 rollup.js 封装各项目共用的工具包(https://juejin.cn/post/)

[7] 如何开发一个基于 TypeScript 的工具库并自动生成文档(https://juejin.cn/post/)

[8] 一款优雅、简洁的 JavaScript 测试框架(https://jestjs.io/zh-Hans/)

作者:京东科技 周明亮

AST 基础与功能

在前端里面有一个很重要的概念,也是最原子化的内容,就是 AST ,几乎所有的框架,都是基于 AST 进行改造运行,比如:React / Vue /Taro 等等。 多端的运行使用,都离不开 AST 这个概念。

在大家理解相关原理和背景后,我们可以通过手写简单的编译器,简单实现一个 Javascript 的代码编译器,编译后在浏览器端正常运行。

通过实现一个自定义的编译器,我们发现我们自己也能写出很多新的框架。最终目标都是通过编译转换,翻译为浏览器识别的 Javascript + CSS + HTML。

没错!翻译翻译~

当然我们也可以以这个为基础,去实现跨端的框架,直接翻译为机器码,跑到各种硬件上。当然一个人肯定比较困难,你会遇到各种各样的问题需要解决,不过没关系,只要你有好的想法,拉上一群人,你就能实现。

大家记得点赞,评论,收藏,一键三连啊~

分析器

说到这个代码语义化操作前,我们先说说分析器,其实就是编译原理。当你写了一段代码,要想让机器知道,你写了啥。

那机器肯定是要开始扫描,扫描每一个关键词,每一个符号,我们将进行词法分析的程序或者函数叫作词法分析器(Lexical analyzer),通过它的扫描可以将字符序列转换为单词(Token)序列的过程。

扫描到了关键词,我们怎么才能把它按照规则,转换为机器认识的特定规则呢?比如你扫描到:

机器怎么知道要创建一个 变量 a 并且等于 1 呢?

所以,这时候就引入一个概念:语法分析器(Syntactic analysis,Parser)。通过语法分析器,不断的调用词法分析器,进行语法检查、并构建由输入的单词组成的数据结构(一般是语法分析树、抽象语法树等层次化的数据结构)。

在JS的世界里,这个扫描后得到的数据结构 抽象语法树 【AST】。可能很多人听过这个概念,但是具体没有深入了解。机缘巧合,刚好我需要用到这个玩意,今天就简单聊聊。

抽象语法树 AST

AST 是 Abstract Syntax Tree 的缩写,也就是:抽象语法树。在代码的世界里,它叫这个。在语言的世界里面,他叫语法分析树。

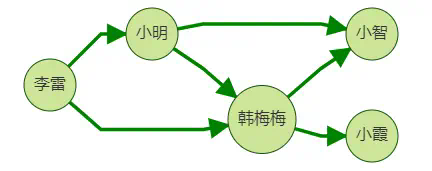

语言世界,举个栗子:

语法分析树:

主语:我,人称代词。

谓语:写,动词。

宾语:文章,名词。

长一点的可能会有:主谓宾定状补。是不是发现好熟悉,想当年大家学语文和英语,那是一定要进行语法分析,方便你理解句子要表达的含义。

PS:对我来说,语法老难了!!!哈哈哈,大家是不是找到感觉了~

接下来我们讲讲代码里面的抽象语法树。

那我们用来进行语法分析,能够得到什么内容了?这时候我们可以借助已有的工具,将他们进行分析,进行一个初级入门。

其实我们也可以完全自己进行分析,不过这样就不容易入门,定义的语法规则很多,如果只是看,很容易就被劝退了。而通过辅助工具,我们可以很快接受相关的概念。

常用的工具有很多,比如:Recast 、Babel、Acorn 等等

也可以使用在线 AST 解析:AST Explorer,左上角菜单可以切换到各种解析工具,并且支持各类编程语言的解析,强大好用,可以用来学习,帮助你理解 AST。

为了帮助大家理解,我们一点点的进行解析,并且去掉了部分属性,留下主干部分,完整的可以通过在线工具查看。【不同解析器,对于根节点或者部分属性稍有区别,但是本质是一样的。】

接下来,我们一个一个节点看,首先是第一个节点 Program

Program 是代码程序的根节点,通过它进行节点一层一层的遍历操作。 上面我们看出它有两个节点,一个是变量声明节点,另外一个是函数声明节点。

如果我们再定义一个变量或者函数,这时候 body 就又会产生一个节点。我们要扫描代码文件时,我们就是基于 body 进行层层的节点扫描,直到把所有的节点扫描完成。

上面对应的代码,就是 const me = “我” ,这个节点告诉我们。 声明一个变量,使用类型是:VariableDeclaration, 他的唯一标识名是:me,初始化值:“我”。

后续的函数分析,也是一样的。

这个节点,清楚的告诉我们,这个函数名是什么,他里面有哪些内容,入参是什么,调用了什么函数对象。

我们发现,通过语法分析器的解析,我们可以把代码,变成一个对象。这个对象将代码分割为原子化的内容,很容易能够帮助机器或者我们去理解它的组成。

这个就是分析器的作用,我们不再是一大段一大段的看代码逻辑,而是一小段一小段的看节点。

有了这个我们可以干什么呢?

AST 在 JS 中的用途

1. 自定义语法分析器,写一个新的框架。

通过对现有的 AST 理解,我们可以依葫芦画瓢,写出自定义的语法分析器,转成自定义的抽象语法树,再进行解析转为浏览器可识别的 Javascript 语言,或者其他硬件上能识别的语言。

比如:React / Vue 等等框架。其实这些框架,就是自定义了一套语法分析器,用他们特定的语言,进行转换,翻译翻译,生成相关的DOM节点,操作函数等等 JS 函数。

2. 利用已有语法分析器,实现多端运行。

通过已有的 AST,我们将代码进行翻译翻译,实现跨平台多端运行。我们将得到代码进行语法解析,通过遍历所有的节点,我们将他们进行改造,使得它能够运行在其他的平台上。

比如:Taro / uni-app 等等框架。我们只要写一次代码,框架通过分析转换,就可以运行到 H5 / 小程序等等相关的客户端。

3. 进行代码改造,预编译增强处理。

依旧是通过已有的 AST,我们将代码进行分析。再进行代码混淆,代码模块化处理,自动进行模块引入,低版本兼容处理。

比如:Webpack / Vite 等等打包工具。我们写完代码,通过他们的处理,进行增强编译,增强代码的健壮性。

AST 的应用实践

我们在进行框架的改造或者适配时,我们可能才会用到这个。常规的方法,可能有两种:

- 按照特定的写法,通过正则表达式,直接进行大段代码替换。

- / mingliang start */ const a = 1 / mingliang end */

如,我们找到这段代码注释,直接通过 code.replace(/mingliang/g, ‘xxxx’) 类似这种方式替换。

- 通过引入运行,改造相关的变量,再重新写入。

我们可能先 let config = require(a.js) 运行这个文件,我们就得到了这个 config 这个变量值。

之后我们改写变量 config.a = 2,

最后,重新通过 fs.writeSync(‘a.js’, ‘return ‘ + JSON.stringify(config, null, 2)) 写入。

现在,我们就可以掌握新的方法,进行代码改造。

作者:京东科技 胡骏

引言

岁月如梭,十载流年

前端技术,蓬勃向前

HTML,CSS,JavaScript

演绎出璀璨夺目的技术画卷

回到十年前,前端技术就像一名戴着厚重眼镜的书呆子,总是小心翼翼,被各种各样的浏览器兼容性问题欺负(就像在小学被欺负一样)。

但随着时间的推移,这个书呆子开始锻炼,变得越来越强壮,终于能够对抗那些讨厌的兼容性问题

进入中学时期,前端技术遇到了那个改变它一生的朋友——jQuery。在jQuery的帮助下,前端技术变得更加自信,能够在各种浏览器之间轻松穿梭(就像找到了武林秘籍,功力大增)。

随后,前端技术开始追求更高的境界。它遇到了三位美丽的姑娘:Angular、React和Vue。这三位姑娘带给了前端技术无尽的魅力,让它迅速崛起,成为了技术江湖中的一股新兴力量。

如今,前端技术已经变得越来越强大,像一个熟练掌握各种武功的高手。它的发展速度之快,令人瞠目结舌,仿佛在短短十年内成为了武林盟主。它带领着一群忠诚的拜金党(程序员),在技术江湖中闯荡,创造了一个又一个的传奇。

而现在,前端技术正在为未来的挑战做准备,它还能带给我们多少惊喜,以及如何抵抗那些不断涌现的挑战者?让我们一起拭目以待,看这场武林大戏如何演绎。

一、历程

前端技术开发在过去的十年里经历了从HTML、CSS到JavaScript的演变。在这个历程中,前端工程师的角色也发生了变化,他们不再只是单纯的代码开发者,还需要与设计师、产品经理、运营人员等其他团队成员协作,共同完成网站的开发。

• _2010年以前,_前端工程师主要负责网站的静态页面开发,如网页设计、图片处理等。在这个阶段,前端工程师的技能主要包括HTML、CSS和JavaScript等基本技术。

• _2010年,_JavaScript成为了前端开发的主要语言。随着JavaScript的普及和发展,越来越多的前端工程师开始关注JavaScript的应用和开发。

• _2011年,_jQuery成为了前端开发的主流库,并且HTML5和CSS3开始受到重视。这也是前端开发变得更加动态和交互性的开始。

• _2012年,_响应式设计和移动设备优先的设计理念开始流行,前端开发在移动端上崭露头角。

• _2013年,_Angular引入了模块化和数据绑定的概念,Bootstrap实现了响应式框架,前端开发变得更加简单和高效。

• _2014年,_React发布,革新出组件化的思想,前端开发变得更加灵活和可维护。

• _2015年,_ES6发布,带来了诸如箭头函数、模板字符串和解构赋值等语言的改进,使JavaScript变得更加易用和现代化。同年,Vue的发布迅速获得了广泛应用。

• _2016年,_前端工具链的发展得到了加速,例如Webpack和Babel等工具的普及使得前端工程化得到了广泛推广。

• _2017年,_JavaScript库和框架更加多样,Angular、React和Vue等都在不断地演进和优化。PWA技术的普及使得网页更接近原生应用的用户体验。

• _2018年,_JavaScript框架的选择更加复杂,同时CSS预处理器(例如Sass和Less)和CSS-in-JS的技术也逐渐成熟。

• _2019年,_前端技术继续保持快速发展的趋势,更加注重用户体验和开发效率。例如,React Hooks和Vue 3等技术的推出使得前端代码更简洁并可维护。

• _2020年,_因新冠疫情影响,居家办公及远程工作成为新趋势。虚拟会议和在线教育等普及推动了前端技术的发展,也更加重视了访问性和用户体验。

• _2021年,_新技术和工具不断推陈出新。Web Assembly使得前端代码获得更高的效率,而预渲染和静态站点生成等技术让前端应用可以获得更快的加载速度。

• _2022年,_VR(虚拟现实)和AR(增强现实)技术的不断发展,前端开发者需要开发出更加适合VR/AR场景的应用程序。

• _2023年至今,_AI(人工智能)技术的突破性进展,前端技术将在AI 技术的加持下得到更广泛的应用,从而带来更智能和更高效的前端开发体验。

二、HTML5和CSS3的普及

HTML5和CSS3,这两个神秘代码世界的统治者,它们的名字听起来像是一对科学家的昵称,但它们的影响力却是无与伦比的:让我们的网页从普通变得绚丽多彩。

作为一名网页开发者,我们经常需要面对一些令人头疼的问题:浏览器兼容性、页面加载速度缓慢等。但是,当HTML5和CSS3出现在我们的视野中时,一切都变得不一样了。

HTML5是一种用于网页开发的语言,它具有更强的多媒体功能,比如说可以轻松地嵌入音频和视频。它还具有更强的语义,使我们可以更容易地描述页面内容。

而CSS3则是一种用于美化网页的语言,它提供了更多的样式选项,比如说可以实现圆角、阴影等效果。它还支持响应式设计,可以让我们的网页在不同的设备上都能得到最佳的展示效果。

用HTML5和CSS3开发的网页不仅美观,而且更快。我们不再需要使用大量的JavaScript代码来实现一些简单的功能,因为HTML5和CSS3已经帮我们完成了这些工作。

不仅如此,HTML5和CSS3还使得网页开发变得更有趣。我们可以创造出各种各样的动画效果,比如说滚动、旋转等,而不需要依赖任何第三方工具。这不仅让我们的网页更具吸引力,也使我们的用户更容易理解和使用。

HTML5就像一个网页的“建造师”,它负责把网页的框架建造出来,而CSS3则是一个“装饰师”,它负责把网页的外观和感觉打造出来。这对搭档携手合作,把一栋美丽的大厦(网站)拔地而起。

三、JavaScript框架的崛起

JavaScript框架,从这个词语中我们就能感受到它的强大和威力,如同统治世界的巨龙,横行天下,让所有的开发者都震撼不已。

在过去的十年里,我们见证了许多JavaScript框架的诞生和发展。最早的Angular和Backbone逐渐被React和Vue等框架所取代。这些框架不仅简化了开发者的工作流程,还引入了组件化的开发思想,提升了Web应用的可维护性和可扩展性。

另外,JavaScript框架也推动了Web前端技术的进步,引入了许多新的概念和理念,如组件化、数据驱动等等,使得Web前端开发变得更加简单而清晰。

3.1 React:让你的用户界面如此简单

React,这是一个神奇的JavaScript框架,它可以让你的用户界面变得如此简单,以至于你会想:“这就是魔法吗?”

React的核心思想是组件化,它把用户界面拆分成许多小的组件,每个组件都可以独立运行,并且可以方便地复用。这样,你就可以更加简单高效地开发出高质量的用户界面。

React的另一个优秀特性是Virtual DOM,它可以帮助你更快速地渲染用户界面,并且不会影响用户体验。这就像是一个超级快速的缓存,让你的用户界面飞快地呈现在用户面前。

React还提供了一些非常实用的功能,比如说React Router,它可以帮助你管理路由,让用户界面更加流畅;而React Redux可以帮助你管理应用状态,让你的代码更加整洁。

此外,React是一个非常活跃的开源项目,它的开发者们一直在不断改进和完善,值得每一个前端开发者去学习和使用。

3.2 Vue:充满了年轻的活力和智慧

Vue是另一个JavaScript框架,可以让你快速构建网页,就像是一个魔术师,把一堆杂乱无章的东西变成了一个美丽的魔术。

Vue的核心思想是数据驱动+组件化。这听起来很高大上,但其实就像是你在做一道数学题,先把问题分解成若干小问题,再一步步解决。

Vue有一个很酷的特性:双向绑定。这听起来很神秘,但实际上就像是你和你的好朋友之间的对话,你说了什么,他就知道了。

学习和使用Vue的过程中,你会发现开发变得更加简单和有趣,就像是在做一道神奇的拼图,一步步把图片拼出来,比如说它有很多组件,就像是一个工具箱,你可以随时随地使用。组件的好处在于,它可以把复杂的功能分解成若干个简单的部分,这样就可以很容易地管理和维护你的代码。

同时,Vue有很多很多的插件,可以让你的开发体验更加顺畅。插件的好处在于,它可以帮助你实现一些复杂的功能,这样就不必自己写一坨代码。

Vue还有一个很棒的社区,可以帮助你解决一些棘手的问题,也方便了你与其他开发者交流经验,编码世界有了朋友,永远不会孤单。

3.3 谨慎:利剑具有两面性

JavaScript框架是一个非常重要的工具,就像一把利剑帮助开发者切开困难,让开发者更加简便高效地开发前端应用,也推动了前端技术的进步,并抵达成功的彼岸。

但是,请记住,刀刃朝向你,也有可能伤到自己,因此请开发者在使用JavaScript框架时要谨慎小心。

四、Node.js和前后端分离

首先,让我们回顾一下过去,那时候前后端是紧密结合在一起的,像一对结婚多年的夫妇。它们有着许多共同的爱好,但是有时它们也会产生冲突,就像夫妇间的争吵一样,前后端争吵也是不可避免。

但是,随着技术的发展,我们发现了一个新的解决方案:前后端分离。就像夫妇分居一样,前后端也可以分开,以避免冲突,Node.js就是这个分离的功臣。

Node.js可以帮助前端和后端分开,各自独立工作。前端可以专注于用户界面的开发,后端可以专注于数据的处理,就像夫妇分别在各自的工作岗位上工作一样,前后端也可以分别在各自的领域里工作。

Node.js的出现让JavaScript可以在服务器端运行,为前后端分离的架构模式提供了可能。前后端分离使开发者可以更加专注于前端应用的开发,提高开发效率。同时,Node.js的诞生也带来了诸如npm、yarn等包管理器的出现,开发者可以轻松地引入和管理第三方库。

4.1 npm:被忽视的少年

首先,让我们了解一下npm的历史。它曾经是一个年轻的少年,总是被忽视。但是随着它长大,它变得越来越强大,并且成为了Node.js开发的重要组成部分。

以前,如果我们想要安装一个库,需要手动下载,并且手动安装它。这是一件非常繁琐的事情,而且很容易出错。但是,随着npm的出现,一切都变得更简单了。只需要运行一条命令(如:),就可以轻松地安装任何库。

npm还提供了一个巨大的软件仓库,其中包含了数以千计的库和工具。它就像一个图书馆,你可以随心所欲地查阅和使用。

但是,npm不仅仅是一个简单的安装工具。它还像一个管家,辅助我们管理依赖关系,并帮助我们发布代码和维护代码库。它还有许多其他功能,例如构建工具,测试工具等。因此,如果你想充分利用npm,请不要仅仅停留在它的基础功能上。

4.2 yarn:少年的替身

首先,让我们了解一下yarn的由来。它的诞生是为了解决npm的一些问题,就像是一个少年的替身,它试图取代npm并成为新的领导者。

yarn可以帮助我们快速安装依赖包,并管理依赖关系,像一个组织者可以帮助我们维护代码库,以此节省时间并提高开发效率。

yarn还提供了一个更好的版本控制系统,可以帮助我们管理依赖项的版本。如果你在多个项目中使用相同的依赖项,可以确保所有项目使用相同的版本,从而避免了版本冲突,譬如一个和平协调员。

除了管理依赖关系和解决依赖冲突外,yarn还可以帮助我们更快地进行安装,因为它可以在本地缓存安装过的依赖项。这意味着,如果你在多个项目中使用相同的依赖项,它们将不会再次下载,从而减少了安装时间。

此外,yarn支持并行安装,这意味着它可以同时安装多个依赖项,从而加快安装速度。这是一个非常有用的功能,特别是当你需要安装大量依赖项时。

yarn也有一个很棒的社区,可以帮助你解决任何问题。如果你在使用yarn时遇到问题,可以在社区中寻求帮助。这是一个非常有价值的资源,可以帮助你更快地解决问题。

五、构建工具和自动化

构建工具和自动化是现代软件开发的重要组成部分,就像给你的代码加上糖衣一样,帮助我们提高开发效率,并且可以让我们更专注于代码本身。

Grunt、Gulp、Webpack等工具的出现,使得开发者可以方便地实现代码压缩、合并、优化以及模块化等功能。而随着CI/CD的普及,自动化测试和部署变得更加便捷,大大提高了软件开发的质量和开发速度。

5.1 Grunt:猪叫的声音?

Grunt,这不是一个军人,也不是一个猪叫的声音。实际上,它是个非常酷的JavaScript任务运行器,可以帮助你自动化各种任务,如代码构建,单测试和文件合并。它的目的是让你的工作变得更轻松、更有效率,而且不需要你不停地敲代码。

想象一下,每次你修改了一个文件,你就需要手动编译、压缩、合并、测试等等。这听起来很枯燥,对吧?但是,如果有一个工具能帮你自动完成这些任务,那该有多好!这就是Grunt的作用。

Grunt的核心思想是使用插件(plugins)来完成各种任务。有数以百计的插件可以帮助你实现从编译Sass到压缩JavaScript的各种任务。插件是通过npm安装的。Grunt有许多内置任务,例如:文件压缩,CSS预处理,JavaScript检查等。此外,还有大量第三方插件,也可以助你完成更多任务。

Grunt的配置文件是,用于定义任务和任务的配置。Grunt使用JavaScript代码配置任务,因此对JavaScript基础知识的了解是使用Grunt的必备条件。

Grunt的任务可以在命令行中通过运行以下命令执行:。如果你想要实时监控文件的变化,并在文件变化时自动执行任务,你可以使用命令。

如果你是一个JavaScript开发者,那么Grunt是一个不可或缺的工具。它可以让你的工作变得更快捷、更高效,让你有更多的时间去做其他有趣的事情,比如喝咖啡、写文章或者是找对象。

5.2 Gulp:古老的咒语?

让我们来说说Gulp的名字。它的名字听起来有点像一个古老的魔法咒语,你想:“Gulp!” 然后你的代码就会变得更快、更简洁、更酷。不过,实际上Gulp并不是魔法,而是非常实用的构建工具。

Gulp的工作原理很简单:它通过创建一系列的任务,来自动完成你的工作流程。比如说,你可以创建一个任务,来自动编译你的Sass文件,或者压缩你的JavaScript文件。这样,你就不需要手动执行这些步骤了,Gulp会帮你完成。

Gulp还有一个非常酷的功能:它可以实时监控你的文件,并在你修改了文件后立即执行相应的任务。这样,你就可以实时看到更改的内容,而不需要手动重新执行。

Gulp如何使用呢?首先,你需要安装Node.js和npm,因为Gulp是基于Node.js的。其次,安装Gulp的命令行工具,只需在终端中运行以下命令即可:。接下来,你需要在项目目录中创建一个文件,这是npm的配置文件,用于管理项目依赖。你可以通过运行以下命令来创建一个文件:。然后,你需要安装Gulp,只需在项目目录中运行以下命令即可:。最后,创建一个文件,这是Gulp的配置文件,用于编写你的任务。

现在,你已经准备好使用Gulp了。开始编写你的任务,并运行以下命令来执行吧:。

5.3 Webpack:订制的包包?

Webpack可以帮你把代码压缩成小而美的包,就像私人订制的收纳柜,它可以装下你所有的包包,并且把它们整齐地放在一起,使你的“奢侈”更加有序!

但是,如果你犯了错误,它就像一个恶魔般出现在你面前,吼叫着告诉你:“Error: This is error!”所以,请小心使用Webpack。

不过,只要你已经掌握了Webpack的使用方法,那么它将成为你的最佳伙伴,因为它可以为你节省大量的时间,并且让你的代码变得更加整洁。

你可以告诉Webpack:“嘿,Webpack!帮我处理图片和字体!” 然后Webpack就会用它的魔力,将它们变成小小的Data URL或文件。你不会相信,Webpack的魔力是如此的强大,它甚至可以帮你处理模块依赖。

那么,如何使用Webpack呢?首先,你需要安装它(就像是奢侈品店要先开门才能买包)。安装很简单,只需要在终端中输入:;然后,创建一个配置文件(就像是奢侈品店的导览图,告诉你每样包包在哪里)。配置文件一般命名为,内容如下:。接下来,只需要在终端中输入打包命令:;最后,引用打包后的文件就可以了(背起新包包,开启一场冒险之旅)。

六、PWA和Web性能优化

在这个快节奏的数字化时代,越来越多的用户转向使用移动设备和Web应用程序。

PWA成为了一个重要的技术趋势,它的全称是“Progressive Web App”,翻译成中文就是“渐进式Web应用程序”。简单来说,PWA是一个既可以在浏览器上运行的Web应用程序,同时也可以像原生应用一样在离线时使用。它的最大优点就是可靠性,因为PWA可以像原生应用一样缓存数据和资源,这意味着它可以在离线时运行,而不会像普通的Web应用程序一样无法使用。

此外,Web性能优化也成为了开发者关注的重点。我们需要知道一个简单的事实,那就是用户喜欢快速的网站。如果你的网站速度太慢,那就会让你的用户感觉像一头正在沙漠里跑步的骆驼一样疲惫不堪,感到痛苦和沮丧,这会让他们不得不离开,去寻找新的绿洲。

所以,为了确保你的网站速度足够快,你需要采取一些优化措施。以下是一些可以提高Web应用性能的技巧:

-

使用CDN(内容分发网络):CDN是一组分布在世界各地的服务器,它们可以缓存你的网站内容,并将其分发到全球各地的用户。这可以大大加快你的网站加载速度,因为用户可以从离他们最近的服务器获取内容。

-

压缩文件大小:压缩你的HTML、CSS和JavaScript文件可以减少它们的大小,从而加快它们的加载速度。你可以使用像Gzip这样的压缩算法来实现这一点。

-

使用缓存:缓存是一种将网站数据存储的技术。例如浏览器缓存:在响应头中设置缓存策略来控制缓存时间;以及服务器端缓存:使用Memcached或Redis等缓存服务器,以减少响应时间。这样一来,当用户再次访问你的网站时,它们可以从缓存中加载数据,而不必重新下载,大大加快你的网站加载速度。

-

减少HTTP请求:有一个叫做“夹心饼干法则”的说法。这个法则认为,在一次HTTP请求中,中间的响应部分应该像夹心饼干一样短,而请求和响应头和尾应该像饼干的两端一样长。这听起来很有趣,但其实它也是有道理的,因为请求和响应头和尾中包含的信息比较少,而响应中间部分则包含了网页的实际内容,因此应该尽可能地减少其大小。你可以通过将HTML和CSS以及JavaScript文件合并成一个文件,或者通过使用CSS Sprites将多个图像合并成一个文件来减少HTTP请求的数量。

-

使用响应式图片:图片是网站加载速度最慢的资源之一。为了提高网站加载速度,你可以使用响应式图片,这些图片可以根据用户的设备屏幕大小来动态地调整大小。这样一来,用户只会下载他们所需的图像大小,而不是下载整个大图像。

-

使用懒加载技术:懒加载是一种延迟加载技术,它可以延迟加载页面上的图像、视频和其他资源,直到它们真正需要时才出现。这可以减少页面的初始加载时间,因为只有当用户滚动到需要加载的部分时,它们才会被加载。

你知道吗,Google Chrome浏览器可以使用一个名为“Lighthouse”的工具来检查网站的PWA和性能方面的指标。但你可能不知道的是,这个工具还有一个有趣的功能,就是可以为你的网站生成一份“独家报告”,这样你就可以像读报纸一样轻松地查看网站的PWA和性能状况了。但是,要牢记的是,优化Web应用性能是一个不断发展的过程,需要持续监测和调整以确保最佳体验。

七、Web组件和跨平台框架

Web组件和跨平台框架是现代Web开发中的两个热门话题,它们就像是现代Web开发的两座巨大城堡,吸引着无数开发者前来探索和征服。

首先,我们来谈谈Web组件。Web组件是一种现代的Web开发技术,它允许开发者将Web应用程序分解成可重用的组件,这些组件可以在不同的Web应用程序中共享和重用。比如,你可以将一个搜索框组件用于多个Web页面,而不必每次都重新编写。

Web组件的好处不仅在于可重用性,还在于它们的灵活性。你可以根据需要自定义Web组件,为你的Web应用程序添加新的功能和样式。

但是,Web组件并不是“银弹”,它们在某些方面仍然有限制。比如,Web组件难以处理动态数据,因为它们是静态的。此外,Web组件也不是完美的跨平台解决方案,因为它们可能无法兼容不同的Web浏览器和设备。

这就引出了我们的下一个话题:跨平台框架。跨平台框架是一种可以在多个平台上运行的软件框架,包括Web、移动和桌面应用程序。它们允许开发者编写一次代码,然后在不同的平台上运行,无需进行任何额外的修改。

跨平台框架的好处显而易见:它们可以大大减少开发时间和开发成本。但是,跨平台框架并非完美无缺。它们可能会受到不同平台的限制,从而无法充分利用每个平台的功能和性能。此外,跨平台框架还可能会导致性能问题和代码质量问题。

现在,我们来看看如何将这两种技术结合起来。使用Web组件和跨平台框架可以让你搭建你的虚拟王国,充分利用Web组件的可重用性和灵活性,同时充分利用跨平台框架的跨平台能力和效率。

当然,这并不是说将Web组件和跨平台框架混合在一起就是万无一失的。你需要仔细考虑你的应用场景,确保使用这两种技术的方式是最优的。

比如,你可以使用Web组件来构建你的用户界面,然后使用跨平台框架来将Web应用程序转换为移动应用程序。这样,你就可以在多个平台上运行相同的代码,而且用户体验也会更加一致。

或者,你可以使用跨平台框架来编写你的应用程序逻辑,然后使用Web组件来定制你的用户界面。这样,你可以在不同的Web应用程序中重用你的用户界面,而且你的应用程序逻辑也可以在多个平台上运行。

再者,你也可以将这两种技术都使用在同一个应用程序中。这样,你可以充分利用Web组件的可重用性和灵活性,同时充分利用跨平台框架的跨平台能力和效率。只要你能合理地使用这些技术,就可以打造出更好的Web应用程序。

Web组件和跨平台框架都是非常有前途的技术,它们可以为现代Web开发带来很多好处,为我们带来更加灵活、高效和强大的Web开发工具和平台。无论是Web组件还是跨平台框架,它们都是我们构建虚拟王国的重要基石。

八、前端安全问题

在当今数字化时代,前端安全已成为互联网世界中的重要一环。不管是个人用户,还是企业机构,前端安全都需要被高度重视。尽管我们已经发展出了各种各样的安全技术和防御手段,但是前端安全问题仍然是一个不断增长的挑战。

8.1 XSS攻击:你的网站很容易被攻击

你听说过XSS攻击吗?这种攻击方式是通过篡改网页的HTML并在用户浏览器中注入恶意代码的一种攻击方式。这些恶意代码通常是JavaScript脚本,它们可以被用来窃取用户的敏感信息,如用户名、密码、银行账户信息等等。

如果你的网站存在XSS漏洞,那么恶意攻击者就可以在你的网站上注入一些不良代码,这些代码可能会窃取用户的登录凭证或者其他敏感信息。所以,尽管你的网站已经被SSL加密保护,你的用户仍然面临着被XSS攻击的风险。

如何防御XSS攻击呢?其实非常简单,你只需要在所有的输入框中过滤掉所有的HTML标签和JavaScript脚本即可。但是,如果你认为这么做会影响用户体验,那么你可以考虑使用HTML的特殊字符转义功能来替换这些标签和脚本。

8.2 CSRF攻击:请勿相信恶意链接

现在让我们来谈谈CSRF攻击。这种攻击方式是通过篡改用户的HTTP请求来伪造用户的身份,从而进行一些非法的操作。这种攻击方式通常是通过欺骗用户一个恶意链接来实现的。一旦用户了这个链接,攻击者就可以获得用户的凭证,然后模拟用户的请求,从而执行一些非法的操作。

假设,你的网站有一个删除账户的功能,攻击者就可以利用CSRF攻击来让用户误删除自己的账户。这听起来非常可怕,但是不要担心,我们可以通过一些简单的方法来防御这种攻击。

首先,我们可以在所有的表单提交中添加一个随机的Token值。这个Token值可以通过后台生成,然后在前端将其嵌入到表单中。当用户提交表单时,我们可以检查这个Token值是否匹配,如果不匹配,则拒绝这个请求。这样就可以简单的避免CSRF攻击了。

8.3 CSP策略:请勿允许不信任的资源

CSP策略是一种非常有用的前端安全措施。CSP策略可以帮助我们限制网页中可加载的资源,从而减少被攻击的风险。例如,我们可以限制只允许加载来自指定域名的JavaScript文件,这样就可以避免恶意代码的注入。

但是,如果你不小心将不信任的资源允许加载到你的网页中,那么你的网站就可能面临被攻击的风险。假设你的网站允许用户上传文件,并在网页中显示这些文件,如果你没有限制文件的类型和内容,那么攻击者就可能上传恶意文件,并在用户浏览器中注入恶意代码。

所以,如果你想保证你的网站的安全性,那么你应该始终谨慎地过滤用户上传的文件,只允许加载来自可信任来源的资源。

我们可以认识到,前端安全是一项非常重要的技术挑战。如果你是一位前端开发人员,那么应该始终将前端安全作为开发过程中的一个重要考虑因素。只有这样,我们才能够为用户提供安全可靠的Web服务。

九、前端工程师的多化技能

作为一名前端工程师,一定是个充满多化技能的大神。不仅仅要会写代码,还要会与设计师沟通,管理版本控制,解决兼容性,甚至还要有点艺术细胞。

-

代码技能:前端工程师最基本的技能,也是最重要的技能。不仅需要掌握 HTML、CSS、JavaScript,还需要掌握一些前端框架和库,比如 React、Vue、Angular 等。当然,这些都不是问题,对于一名优秀的前端工程师来说,这只是小菜一碟。

-

与设计师沟通:设计师们总是有各种奇怪的想法,然后她们会告诉你:“我要实现这个效果,你帮我写一下”。但是,很快会发现这个效果并不现实,于是你需要与设计师进行沟通,告诉她们这个效果无法实现。当然,你不能用技术术语来向她们解释,否则她们会摆出一副“我听不懂”的表情。所以,你需要用她们喜欢听的语言,比如“我理解你的设计需求,并深刻认识到其对于网站效果的重要性。不过,由于技术和浏览器的限制,我们需要寻找其他的可行方案来实现类似的效果,以保证网站的性能和可访问性,我会尽最大的努力提供最佳的解决方案。”

-

管理版本控制:代码管理是一个很重要的问题,特别是当你和其他人合作的时候。你需要使用Git进行版本控制,这样才能确保代码的稳定性和可靠性。当然,你也需要了解一些Git的命令,比如 commit、push、pull 等等。不过,如果你不小心把代码弄挂了,那也不用担心,只要跟团队的其他成员说“我不小心把代码弄挂了”,他们就会告诉你怎么做了。

-

解决兼容性:不同的浏览器之间有很多不兼容,而前端工程师需要解决这些问题。比如,IE浏览器总是出现各种奇怪的bug,但是你不能告诉用户:“你用的是IE,这不是我的问题”。相反,你需要找到问题的根源,然后解决它。这是一个非常重要的技能,因为它涉及到用户体验和网站的稳定性。

-

有点艺术细胞:前端工程师不仅仅是一个代码的机器,还需要有一点艺术细胞。毕竟,好的界面设计是网站的关键之一。所以需要了解一些基本的设计原则,比如颜色搭配、排版等等。当然并不需要成为一个设计师,但是需要知道如何运用这些原则来改进网站的设计。

-

学习新技能:前端工程师是一个不断学习的过程。每天都有新的技术和框架出现,并且要不断学习并掌握这些技能。但是,并不需要成为一个全栈工程师,只要掌握所需要的技能,然后专注于自己的领域即可。当然,这也意味着要学会如何筛选有用的信息,因为不可能学习完所有的技术和框架。

-

解决问题:前端工程师是一个解决问题的岗位。当网站出现问题时,需要迅速找到问题的根源,并解决它。但是,也不一定要独自解决所有的问题,可以向同事寻求帮助,或者参加一些开发者社区来寻找解决方案。最终要记住的是,解决问题是前端工程师最重要的技能之一。

-

与团队合作:前端工程师需要和设计师、后端工程师、测试人员等等进行合作,以确保网站的成功。在与团队合作中,要学会如何与不同的人合作,并且尽力避免出现冲突。

前端工程师需要掌握很多不同的技能,但这并不意味着要成为一个万能的人。相反,只需要专注于自己的领域在不断地技术学习过程中成长。

十、AI与前端技术结合

回顾过去,畅想未来,立足当下,来讲个故事吧。

在一个遥远的星球上,有一个叫做前端技术的孤独王国。这个王国的居民们都是非常优秀的程序员,他们用HTML、CSS和JavaScript这三种神奇的武器来构建网站,为用户带来无尽的愉悦。然而,这个王国有一个问题,那就是他们一直无法征服一个名为AI的神秘国度。

终于有一天,一个勇敢的前端战士——HTML骑士,决定向AI国度发起挑战。他带着两个小伙伴:CSS猎人和JavaScript法师,踏上了一段充满挑战的探险之旅。

他们沿着神秘的网络海洋航行,一路上遇到了各种令人捧腹大笑的趣事。先是在一个叫做布局的洲际,他们被一群叫做“浮动”的怪兽困扰,CSS猎人拔出了他的弹性盒子弓箭,一箭穿心,解决了怪兽。接下来,他们来到了一个充满奇特生物的动画之地,JavaScript法师用他的神奇魔法,让这些生物如同表演马戏团一般,给他们带来了一场场精彩绝伦的表演。

然后,他们终于来到了AI国度的边境。在那里,他们遇到了一个脾气古怪的巨人,他叫做机器学习。这个巨人用一种叫做数学的强大力量来支配着这片土地。HTML骑士认为,要征服这个国度,就必须挑战巨人,并将他的力量与前端技术融合。

于是,在他们与巨人大战三百回合后,JavaScript法师从中意外领悟了神奇魔法,召唤出一个叫做TensorFlow.js的强大法宝。这个法宝让前端技术也能够掌握机器学习的力量。HTML骑士和CSS猎人纷纷表示赞叹,他们觉得自己终于找到了一种将AI与前端技术结合的方法。

在这之后,他们三人一起用TensorFlow.js建立了一个名为“智能前端”的新城堡。这座城堡里,前端技术与AI融合得天衣无缝,为用户带来前所未有的体验。

城堡的大门上,HTML骑士精心设计了一个智能问答系统。这个系统可以回答用户关于前端技术的各种问题,让新手程序员们感叹不已。而这一切,都得益于TensorFlow.js和机器学习的神奇力量。

城堡的内部,CSS猎人则利用AI技术打造了一套全新的自适应布局。这套布局能够根据用户的喜好和设备自动调整,让每个访问者都能享受到最佳的浏览体验。他还研发了一种名为“智能配色”的神奇法术,能够根据用户的喜好自动调整网页的颜色搭配,让网站变得更加美观大方。

而在城堡的核心区域,JavaScript法师则运用AI技术开发了一系列令人惊叹的交互功能。比如,他创造了一种可以根据用户行为自动优化的推荐算法,将用户感兴趣的内容精准推送。此外,他还设计了一款智能聊天机器人,可以与用户进行即时互动,解答他们的疑问。

在“智能前端”城堡的建设过程中,他们三人不仅发挥出了各自的特长,还不断地学习AI技术,将其与前端技术相互融合。这让他们的作品充满了趣味与智慧,吸引了无数程序员和用户前来参观。

在这段充满挑战的探险之旅中,HTML骑士、CSS猎人和JavaScript法师用他们的智慧和勇气,成功地将AI技术引入前端领域。他们的故事传遍了整个网络世界,成为了程序员们争相传颂的佳话。

如今,前端技术和AI的结合已经成为了一种趋势,越来越多的开发者开始探索这个领域的无限可能。而在这个探索过程中,他们总是能从HTML骑士、CSS猎人和JavaScript法师的故事中汲取勇气与智慧,勇往直前,为未来的网络世界描绘出一个更加美好、充满创意和智慧的蓝图。

有人说,前端技术与AI的结合就像一场狂欢。程序员们欢笑着跳动,发挥着自己的想象力,创造出一个又一个令人叹为观止的作品。在这场狂欢中,每个人都是舞者,每个人都是艺术家,每个人都在为这个美丽的网络世界贡献着自己的力量。

如同那个遥远的星球上,那个欢呼雀跃的前端王国,如今我们所生活的这个网络世界也充满了欢声笑语。而在这片欢乐的土地上,那些勇敢的前端战士们正携手AI,共同书写着属于他们的传奇!

随着技术的不断发展,我们相信前端技术与AI的结合将会走得更远,创造出更多不可思议的奇迹。也许有一天,我们的网络世界将变得如同童话般美好,充满智慧的光辉。而在那个时候,我们将不禁想起那个勇敢的HTML骑士、CSS猎人和JavaScript法师,怀念他们当年那段充满挑战的探险之旅,为他们的勇气与智慧而感慨不已。

在探险的道路上,我们将一路欢笑并肩前行,勇敢地追求那个梦寐以求的未来。也许在某个不经意的瞬间,我们会发现,那个童话般的前端王国,其实就在我们心中,等待着我们去探索、去发现、去唤醒它,让它绽放出最耀眼的光芒。

后记

前端技术的演进从未停歇,仍然充满了机遇与挑战……

让我们一起期待下一个十年,见证前端技术的更多精彩!

作者:京东零售 王雷

1、Redis集群方案比较

• 哨兵模式

在redis3.0以前的版本要实现集群一般是借助哨兵sentinel工具来监控master节点的状态,如果master节点异常,则会做主从切换,将某一台slave作为master,哨兵的配置略微复杂,并且性能和高可用性等各方面表现一般。

特别是在主从切换的瞬间存在访问瞬断的情况,而且哨兵模式只有一个主节点对外提供服务,没法支持很高的并发,且单个主节点内存也不宜设置得过大,否则会导致持久化文件过大,影响数据恢复或主从同步的效率。

• 高可用集群模式

redis集群是一个由多个主从节点群组成的分布式服务器群,它具有复制、高可用和分片特性。Redis集群不需要sentinel哨兵也能完成节点移除和故障转移的功能。

需要将每个节点设置成集群模式,这种集群模式没有中心节点,可水平扩展,据官方文档称可以线性扩展到上万个节点(官方推荐不超过1000个节点)。redis集群的性能和高可用性均优于之前版本的哨兵模式,且集群配置非常简单。

2、Redis高可用集群搭建

• redis集群搭建

redis集群需要至少三个master节点,我们这里搭建三个master节点,并且给每个master再搭建一个slave节点,总共6个redis节点,这里用三台机器部署6个redis实例,每台机器一主一从,搭建集群的步骤如下:

3、Java操作redis集群

借助redis的java客户端jedis可以操作以上集群,引用jedis版本的maven坐标如下:

Java编写访问redis集群的代码非常简单,如下所示:

集群的Spring Boot整合Redis连接代码见示例项目:redis-sentinel-cluster

1、引入相关依赖:

springboot项目核心配置:

访问代码:

4、Redis集群原理分析

Redis Cluster 将所有数据划分为 16384 个 slots(槽位),每个节点负责其中一部分槽位。槽位的信息存储于每个节点中。

当 Redis Cluster 的客户端来连接集群时,它也会得到一份集群的槽位配置信息并将其缓存在客户端本地。这样当客户端要查找某个 key 时,可以直接定位到目标节点。同时因为槽位的信息可能会存在客户端与服务器不一致的情况,还需要纠正机制来实现槽位信息的校验调整。

• 槽位定位算法

Cluster 默认会对 key 值使用 crc16 算法进行 hash 得到一个整数值,然后用这个整数值对 16384 进行取模来得到具体槽位。

HASH_SLOT = CRC16(key) mod 16384

• 跳转重定位

当客户端向一个错误的节点发出了指令,该节点会发现指令的 key 所在的槽位并不归自己管理,这时它会向客户端发送一个特殊的跳转指令携带目标操作的节点地址,告诉客户端去连这个节点去获取数据。客户端收到指令后除了跳转到正确的节点上去操作,还会同步更新纠正本地的槽位映射表缓存,后续所有 key 将使用新的槽位映射表。

• Redis集群节点间的通信机制

redis cluster节点间采取gossip协议进行通信

维护集群的数据(集群节点信息,主从角色,节点数量,各节点共享的数据等)有两种方式:集中式和gossip

• 集中式

优点在于数据的更新和读取,时效性非常好,一旦数据出现变更立即就会更新到集中式的存储中,其他节点读取的时候立即就可以立即感知到;不足在于所有的数据的更新压力全部集中在一个地方,可能导致数据的存储压力。 很多中间件都会借助zookeeper集中式存储数据。

• gossip:

gossip协议包含多种消息,包括ping,pong,meet,fail等等。

1)meet:某个节点发送meet给新加入的节点,让新节点加入集群中,然后新节点就会开始与其他节点进行通信;

2)ping:每个节点都会频繁给其他节点发送ping,其中包含自己的状态还有自己维护的集群数据,互相通过ping交换数据(类似自己感知到的集群节点增加和移除,hash slot信息等);

3)pong: 对ping和meet消息的返回,包含自己的状态和其他信息,也可以用于信息广播和更新;

4)fail: 某个节点判断另一个节点fail之后,就发送fail给其他节点,通知其他节点,指定的节点宕机了。

gossip协议的优点在于数据的更新比较分散,不是集中在一个地方,更新请求会陆陆续续,打到所有节点上去更新,有一定的延时,降低了压力;缺点在于数据更新有延时可能导致集群的一些操作会有一些滞后。

gossip通信的10000端口

每个节点都有一个专门用于节点间gossip通信的端口,就是自己提供服务的端口号+10000,比如7001,那么用于节点间通信的就是17001端口。 每个节点每隔一段时间都会往另外几个节点发送ping消息,同时其他几点接收到ping消息之后返回pong消息。

• 网络抖动

真实世界的机房网络往往并不是风平浪静的,它们经常会发生各种各样的小问题。比如网络抖动就是非常常见的一种现象,突然之间部分连接变得不可访问,然后很快又恢复正常。

为解决这种问题,Redis Cluster 提供了一种选项cluster-node-timeout,表示当某个节点持续 timeout 的时间失联时,才可以认定该节点出现故障,需要进行主从切换。如果没有这个选项,网络抖动会导致主从频繁切换 (数据的重新复制)。

Redis集群选举原理分析

当slave发现自己的master变为FAIL状态时,便尝试进行Failover,以期成为新的master。由于挂掉的master可能会有多个slave,从而存在多个slave竞争成为master节点的过程, 其过程如下:

1)slave发现自己的master变为FAIL

2)将自己记录的集群currentEpoch加1,并广播FAILOVER_AUTH_REQUEST 信息

3)其他节点收到该信息,只有master响应,判断请求者的合法性,并发送FAILOVER_AUTH_ACK,对每一个epoch只发送一次ack

4)尝试failover的slave收集master返回的FAILOVER_AUTH_ACK

5)slave收到超过半数master的ack后变成新Master(这里解释了集群为什么至少需要三个主节点,如果只有两个,当其中一个挂了,只剩一个主节点是不能选举成功的)

6)slave广播Pong消息通知其他集群节点。

从节点并不是在主节点一进入 FAIL 状态就马上尝试发起选举,而是有一定延迟,一定的延迟确保我们等待FAIL状态在集群中传播,slave如果立即尝试选举,其它masters或许尚未意识到FAIL状态,可能会拒绝投票

延迟计算公式:

DELAY = 500ms + random(0 ~ 500ms) + SLAVE_RANK * 1000ms

SLAVE_RANK表示此slave已经从master复制数据的总量的rank。Rank越小代表已复制的数据越新。这种方式下,持有最新数据的slave将会首先发起选举(理论上)。

集群脑裂数据丢失问题

redis集群没有过半机制会有脑裂问题,网络分区导致脑裂后多个主节点对外提供写服务,一旦网络分区恢复,会将其中一个主节点变为从节点,这时会有大量数据丢失。

规避方法可以在redis配置里加上参数(这种方法不可能百分百避免数据丢失,参考集群leader选举机制):

*注意:这个配置在一定程度上会影响集群的可用性,比如slave要是少于1个,这个集群就算leader正常也不能提供服务了,需要具体场景权衡选择。

集群是否完整才能对外提供服务

当redis.conf的配置

cluster-require-full-coverage为no时,表示当负责一个插槽的主库下线且没有相应的从库进行故障恢复时,集群仍然可用,如果为yes则集群不可用。

Redis集群为什么至少需要三个master节点,并且推荐节点数为奇数?

因为新master的选举需要大于半数的集群master节点同意才能选举成功,如果只有两个master节点,当其中一个挂了,是达不到选举新master的条件的。

奇数个master节点可以在满足选举该条件的基础上节省一个节点,比如三个master节点和四个master节点的集群相比,大家如果都挂了一个master节点都能选举新master节点,如果都挂了两个master节点都没法选举新master节点了,所以奇数的master节点更多的是从节省机器资源角度出发说的。

Redis集群对批量操作命令的支持

对于类似mset,mget这样的多个key的原生批量操作命令,redis集群只支持所有key落在同一slot的情况,如果有多个key一定要用mset命令在redis集群上操作,则可以在key的前面加上{XX},这样参数数据分片hash计算的只会是大括号里的值,这样能确保不同的key能落到同一slot里去,示例如下:

假设name和age计算的hash slot值不一样,但是这条命令在集群下执行,redis只会用大括号里的 user1 做hash slot计算,所以算出来的slot值肯定相同,最后都能落在同一slot。

哨兵leader选举流程

当一个master服务器被某sentinel视为下线状态后,该sentinel会与其他sentinel协商选出sentinel的leader进行故障转移工作。每个发现master服务器进入下线的sentinel都可以要求其他sentinel选自己为sentinel的leader,选举是先到先得。同时每个sentinel每次选举都会自增配置纪(选举周期),每个纪中只会选择一个sentinel的leader。如果所有超过一半的sentinel选举某sentinel作为leader。之后该sentinel进行故障转移操作,从存活的slave中选举出新的master,这个选举过程跟集群的master选举很类似。

哨兵集群只有一个哨兵节点,redis的主从也能正常运行以及选举master,如果master挂了,那唯一的那个哨兵节点就是哨兵leader了,可以正常选举新master。

不过为了高可用一般都推荐至少部署三个哨兵节点。为什么推荐奇数个哨兵节点原理跟集群奇数个master节点类似。

作者:京东科技 高飞

前言

本文旨在通过部署微前端项目的实践过程中沉淀出一套部署方案,针对项目分别部署在不同的服务器上的场景,就一些重点步骤、碰到的问题做了一些总结。

部署顺序

因为线上部署主应用时需要用到子应用的线上可访问地址,因此部署顺序应该是先部署子应用,保证子应用能够线上可访问后,再将子应用的线上可访问地址配置到主应用,最后再将主应用部署到线上环境。

部署分支

线上环境部署统一用master分支的代码

应用构建打包

主应用构建打包

主应用 csd-tech-main-app基于 ant-design-pro,需要在config目录中配置微前端项目的访问地址。

在config目录下配置config.test.ts用于测试环境的打包配置,生产环境打包配置放在在config.prod.ts中。由于本次部署是在本地机器测试部署,因此子应用访问地址都用localhost,如果部署到测试环境,或者生产环境,可以换成对应的访问地址。

测试环境打包配置:

生产环境打包配置:

然后,我们需要在微应用注册信息中,将我们加载微应用的地址换成我们配置的地址,代码实现如下:

最后,我们在 package.json 中,通过不同的命令区分不同环境,代码实现如下:

在配置完成后,我们在命令行运行如下命令,将主应用构建打包:

在构建打包完成后,我们将构建好的 dist 目录移动到nginx配置根目录下的 html 目录下,并重命名为 csd-tech-main-app,目录结构如下(见下图)

到这里,我们的主应用就构建打包好了,接下来我们介绍各个微应用构建打包过程。

调度系统(dlink)微应用构建打包

进入项目目录,直接使用打包命令构建打包即可,在命令行运行:

在构建打包完成后,我们将构建好的 dist 目录移动到nginx配置目录下的 html 目录下,并重命名为 datalink ,目录结构如下(见下图)

数据迁移系统(datax)微应用构建打包

进入项目目录,直接使用打包命令构建打包即可,在命令行运行:

在构建打包完成后,我们将构建好的 dist 目录移动到nginx配置目录下的 html 目录下,并重命名名为datax ,目录结构如下(见下图)

标签系统微应用构建打包

进入项目目录,直接使用打包命令构建打包即可,在命令行运行:

在构建打包完成后,我们将构建好的 dist 目录移动到nginx配置目录下的 html 目录下,并重命名名为label-system ,目录结构如下(见下图)

Nginx 服务器部署方案

在将我们的主应用和微应用全部打包完成后,我们将介绍如何使用 Nginx 完成微前端架构的部署。

Nginx 部署方案是可以作为生产方案使用的。

配置时有三点注意事项:

•搭建nginx服务之前,保证所用到的端口是空闲

•子应用和主应用的 nginx 配置基本上是一致的,唯一不同的是子应用需要配置允许跨域访问。这是因为我们的微前端架构需要通过 ajax 请求子应用资源,所以需要配置跨域,通过 同源策略 的限制。

•子应用和主应用所用到接口地址都需要在 nginx 配置代理

本地测试nginx服务配置如下:

在配置完成后,我们需要重启一下 nginx 服务。

输入nginx启动命令启动nginx

在浏览器中访问主应用测试地址 localhost:8000 ,登录后如下图:

在浏览器中访问datalink子应用测试地址 localhost:8888 ,登录后如下图:

在浏览器中访问datax子应用测试地址 localhost:9528 , 登录后如下图:

在浏览器中访问标签系统子应用测试地址 localhost:8080 , 登录后如下图: