点积相似度、余弦相似度、欧几里得相似度

看starspace的时候发现它实现了dot和cos两种similarity的度量方式,这里总结一下:

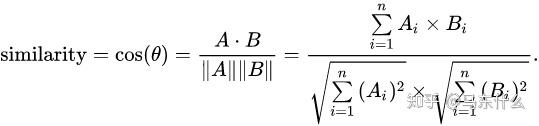

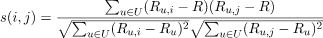

余弦相似度衡量两个向量在方向上的相似性,而不care两个向量的实际长度,A和B的长度即使是一个超级短一个超级长的情况下,二者的余弦相似性也可能为1(即theta=0,此时两个向量重合);存在的问题[1]: 。比如用户对内容评分,5分制。A和B两个用户对两个商品的评分分别为A:(1,2)和B:(4,5)。我们分别用两种方法计算相似度。使用余弦相似度得出的结果是0.98,看起来两者极为相似,但从评分上看X似乎不喜欢这两个东西,而Y比较喜欢。造成这个现象的原因就在于,余弦相似度没法衡量每个维数值的差异,对数值的不敏感导致了结果的误差。 需要修正这种不合理性,就出现了调整余弦相似度,即所有维度上的数值都减去一个均值。修正的余弦相似度可以说就是对余弦相似度进行归一化处理的算法,公式如下:

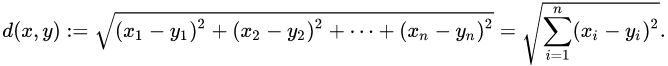

欧几里得相似度:

点积相似度:

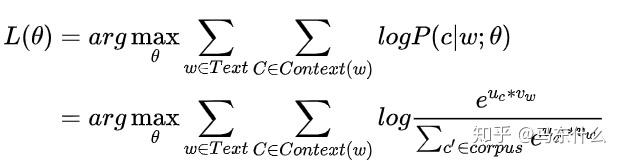

点积相似度是一个比较有意思的概念,我们在word2vec和deepwalk等模型的构建过程中都有它的身影;以word2vec的常规的softmax的损失函数为例

我们希望点积之后的结果(即Uc*Vw)经过softmax之后能够和真实的分布情况一样(也就是能够尽量为[0,0,0,…1…,0,0,0],其中1是中心词对应的index),那么这样整个word2vec的训练的过程就跃然纸上了:

对于点积的公式:

可以看到,我们在优化点积的时候实际上是在优化a b的模长和二者的夹角(a和b分别是embedding空间的a向量和b向量),以word2vec为例,使用负采样的方式,a和b在同一个窗口内,其对应标签为1,则模型训练肯定是希望|a|*|b|*costheta 越接近1越好,那么在优化的过程中:

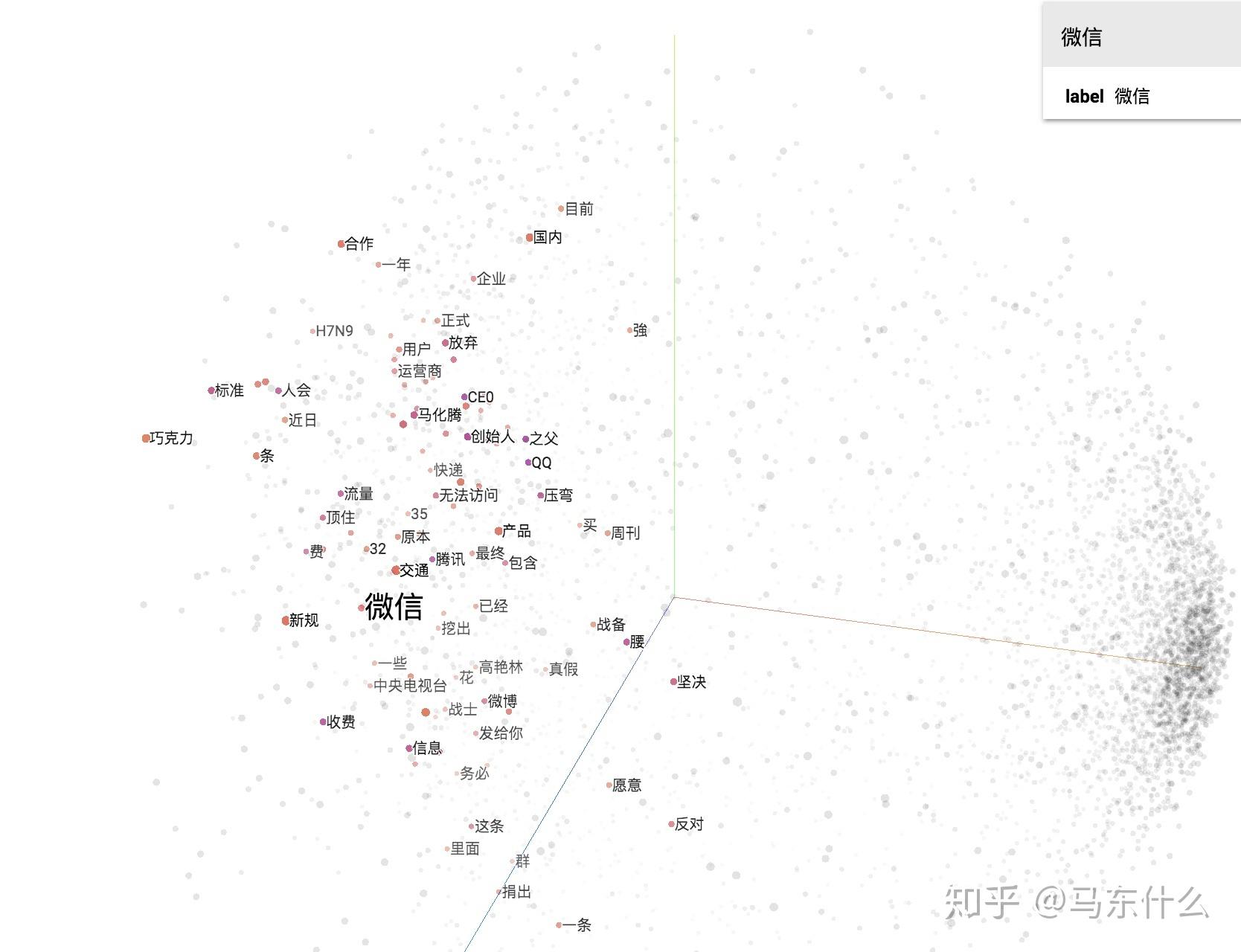

假设a和b的模长均为1且固定,则theta可能会越来越小(theta越小则costheta越接近于1,则整个a*b越接近于1),那么在embedding空间发生的事情就是,a和b向量越来越接近,这就和我们的目的达成一致,

当然这是理想的情况,一般来说|a|和|b|的模场也是会发生变化的,他们和cos theta共同决定最终的训练结果,所以一般来说,两个相近的词其最终的embedding向量比较不容易完全重合,而是相互之间相对于其它不相关的词更加靠近;

补充,一般我们进行点积相似性度量的时候,例如召回层用embedding点积进行相似度计算,会进行l2归一化处理,

归一化之后的embedding向量进行点积实际上就是计算夹角余弦值;

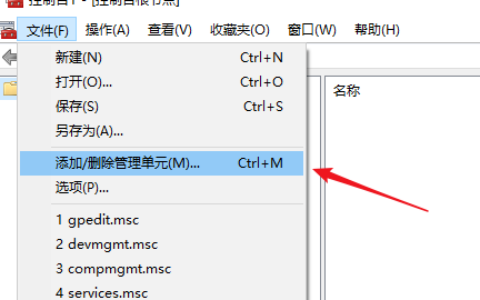

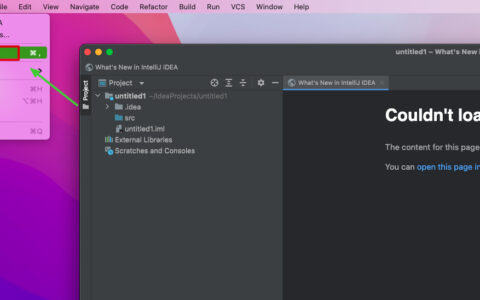

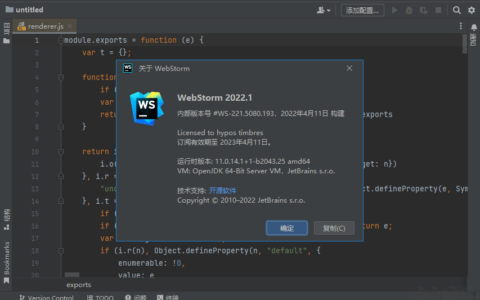

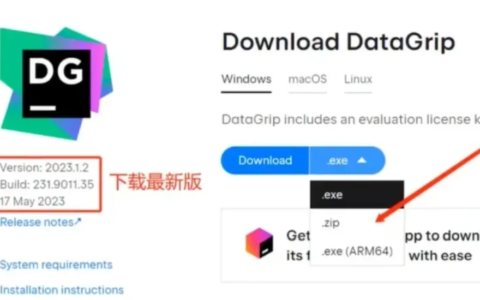

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/95959.html