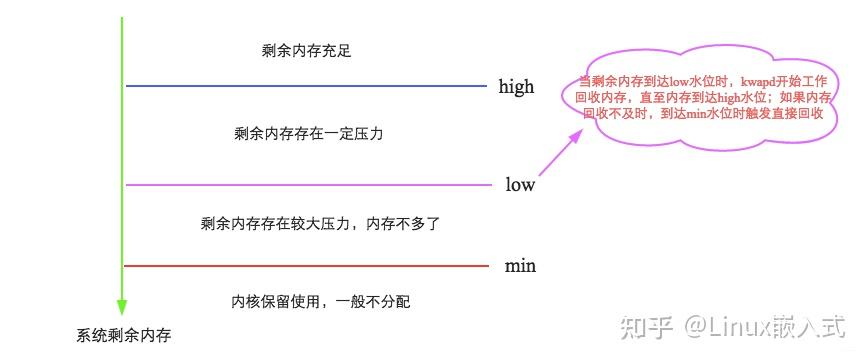

问题背景:CDH集群如何实现数据自动导入、数据自动提取和处理结果自动导出? 问题背景:目前本人大部分的工作是为业务部门开发周期性的数据报表,并定期发送给业务部门使用,而我们的数据主要开源于CDH集群,采用HUE作为CDH的shell接口,也可以结合CDSW这一数据科学工作台进行数据提取,我要解决的问题是在这样的办公场景下,我的开发需求要求导入电脑本地磁盘上的外部文件后,结合HUE上的HIVE代码提取处理后的数据,输出处理结果,并从HIVE中导出到电脑本地磁盘固定位置,并将导出的结果定期发送给业务,目前这些步骤都是我通过手动的方式在HDFS中导入外部文件、手动调度HIVE代码跑数并将结果集通过CDSW导出到本地电脑,再用SAS将数据发送给业务,这一路下来,运维的时间远远超过了需求开发的时间,这样运维一份需求还可以,但是运维几十份需求光是做运维一天的时间就这样耗费掉了,所以我想找到一个能将这一整套的流程用代码自动实现的方案。 系统版本为CentOS 7。 vm.swappiness 设置方法:echo 1 > /proc/sys/vm/swappiness,或sysctl -w vm.swappiness=1,或编辑/etc/sysctl.conf文件,加入vm.swappiness=1 swap即交换空间,作用类似于Windows中的虚拟内存,也就是当物理内存不足时,将硬盘上的swap分区当做内存来使用。但是,由于磁盘的读写速率与内存相比差太多,一旦发生大量交换,系统延迟就会增加,甚至会造成服务长期不可用,这对于大数据集群而言是致命的。 vm.swappiness参数用于控制内核对交换空间的使用积极性,默认是60。值越高,就代表内核越多地使用交换空间。 对于内存较大的CDH集群,我们一般将这个值设为0或1。0表示只有当可用物理内存小于最小阈值vm.min_free_kbytes(后面会提到)时才使用交换空间,1则表示最低限度地使用交换空间。 关于这个配置的具体机制,找到了两种解释:当物理内存占用率高于(100 – vm.swappiness)%时,开始使用交换分区。vm.swappiness通过控制内存回收时,回收的匿名内存更多一些还是回收的文件缓存更多一些来达到这个效果。如果等于100,表示匿名内存和文件缓存将用同样的优先级进行回收,默认60表示文件缓存会优先被回收掉。【文章福利】小编推荐自己的Linux内核源码交流群:【】整理了一些个人觉得比较好的学习书籍、视频资料共享在群文件里面,有需要的可以自行添加哦!!!前50名可进群领取!!!并额外赠送一份价值600的内核资料包(含视频教程、电子书、实战项目及代码)!!!

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/87272.html