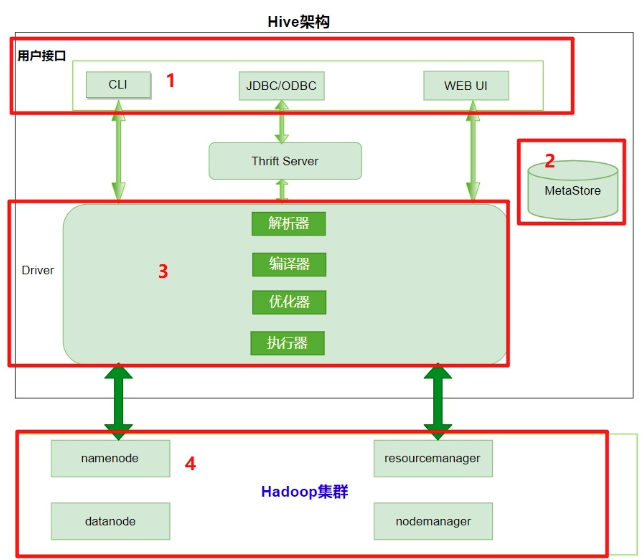

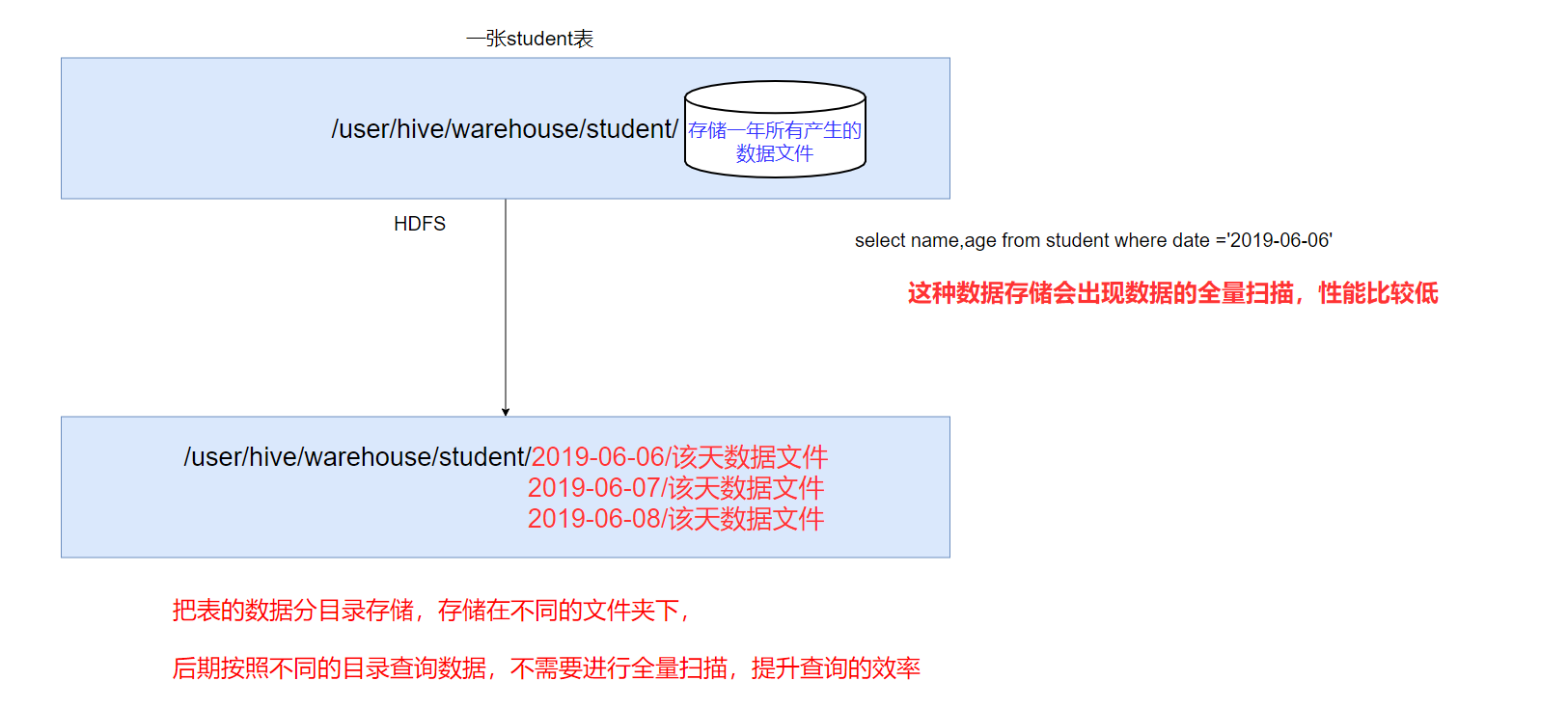

大数据面试题汇总之Hive 一、Hive是什么?跟数据仓库区别? 可回答:1)说下对Hive的了解;2)介绍下Hive 参考答案 Hive是由Facebook开源用于解决海量结构化日志的数据统计工具; Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张表,并提供类SQL查询功能。 Hive的本质是将HQL转化成MapReduce程序 Hive处理的数据存储在HDFS – Hive分析数据底层的实现是MapReduce – 执行程序运行在Yarn上 数据仓库是为企业所有级别的决策制定过程,提供所有类型数据支持的战略集合。它是单个数据存储, 出于分析性报告和决策支持目的而创建。为需要业务智能的企业,提供指导业务流程改进、监视时间、 成本、质量以及控制。 数据仓库存在的意义在于对企业的所有数据进行汇总,为企业各个部门提供统一的, 规范的数据出口。 二、Hive架构是怎样的? 可回答:Hive的基本架构,角色,与HDFS的关系? 参考答案

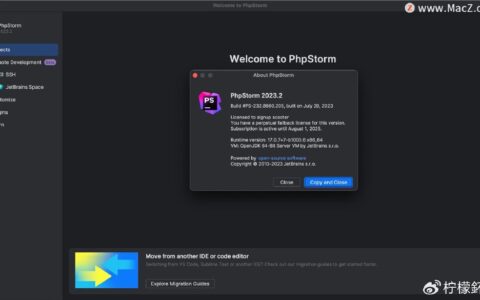

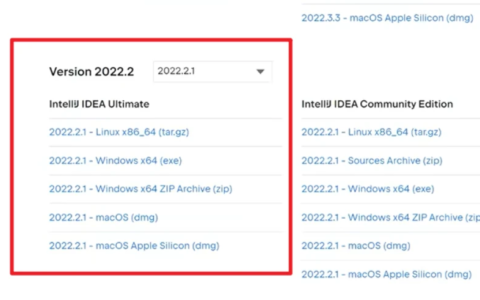

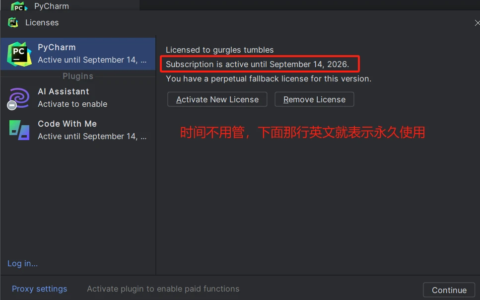

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/71447.html