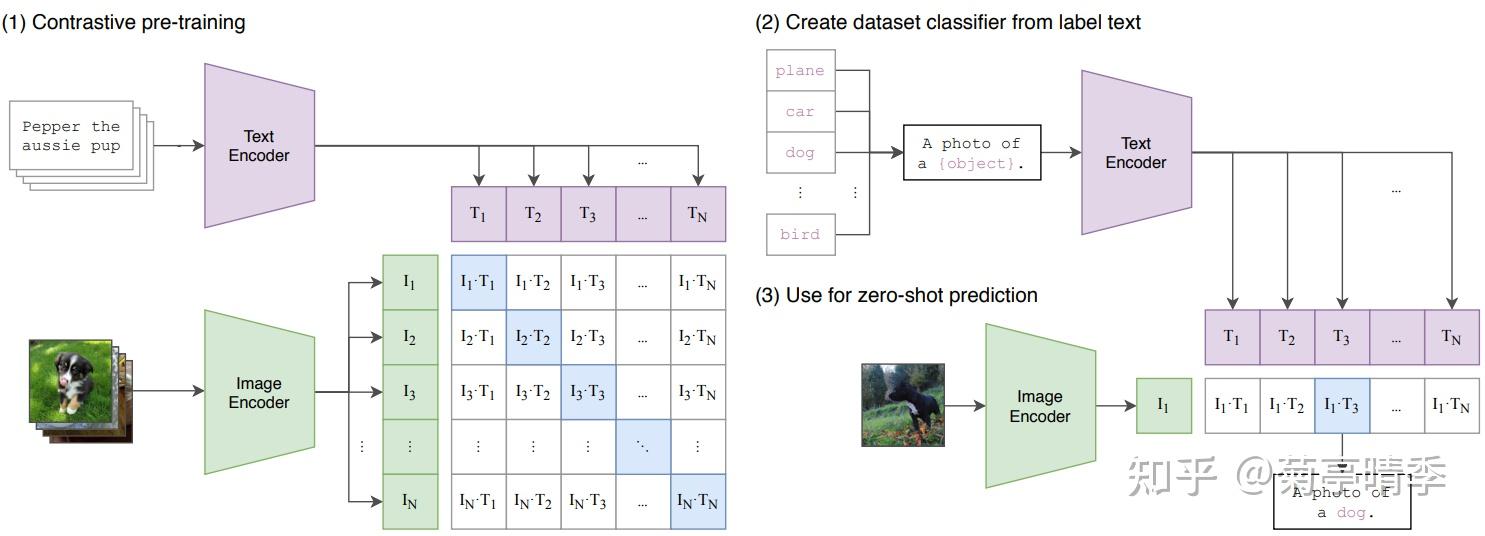

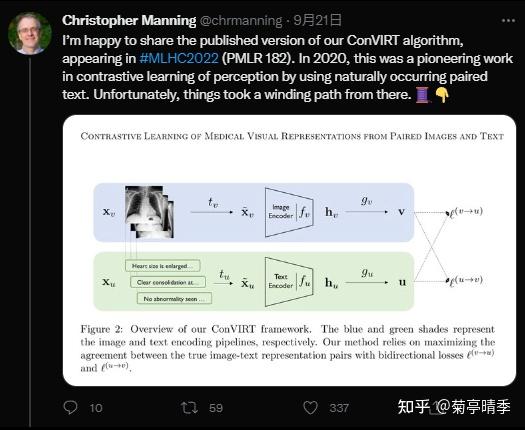

如何看待EMNLP 2022的审稿结果? upd:中了主会,还个愿 —— 带师弟投了一篇4 3.5 3.5 3.5。。虽然分数还行但这审稿质量多少有点拉胯啊,碰到一个问题宝宝什么都看不懂还提了十几个问题。。anyway还是希望师弟的第一篇paper能中个主会 更新:最后中了主会,2.5的哥们加到了3,感谢。 看了一下题下统计emnlp似乎现在中稿线得均分3.5+,基本不允许有borderline或以下的分数,感觉有点畸形啊。这样真的有点看运气,即使好文章碰到比较mean的就没了。 自己投了一篇 4 4 3 2.5 怎么说呢,这个审稿质量已经和ijcai aaai差不多了,我觉得我审的已经算一般了(因为分到的本身也没啥意思),还是写了很多不足和优点以及好几条改进意见,一看自己收到的都三两句没啥营养,全篇“我认为”“我觉得原理不清楚(好长一段没看懂也不愿意看)” “这个大模型的性质测出来的没有理论证明”(哥你看一下这个会的名字?)个个一句话评论也不给细节。。。anyway,emnlp也不能期望太多,我早上听到后面工位的小哥得了个1分我觉得我分数还行。 2022.10.7 更新,中了一篇主会,感谢涛哥吴学长带飞!这篇主要是做了一个结构化知识作为基础的任务的统一建模与分析,提供了一些比较有趣的视角,做了非常多的分析在里面,codebase大家也都觉得蛮好用,欢迎大家来玩!结构化知识的统一建模和多任务学习 另一篇和华盛顿大学合作的工作中了findings,感谢雨石学长和佳轩学长,再次感谢涛哥!这篇文章将DST预测问题形式化为SQL预测问题,将超大型语言模型高效地用到了对话建模中,几乎不需要标注就达到了最先进结果。欢迎!https://arxiv.org/abs/2203.08568 以后的工作就在香港大学继续开始了,继续加油,最好的工作永远在下一篇~ 分数还不错,占坑,中了来答 分享一个 data point 吧,投的 Efficient Track,paper 是一个无标签多 teacher knowledge integration 的方法。去年 11 月投的 ARR,4/3.5/3.5/3,meta 4 ,当时觉得还挺 positive 的,直接 commit 到了 NAACL,录了 Findings。感觉有点难受,遂撤稿。根据 meta 的意见,加实验 address 了一个 concern 之后再次 commit EMNLP,还是 Findings。因为是 SAC 直接给 decision ,邮件里也没有任何 feedback,不想再折腾就认命咯, lol。 也是第一次投 ARR ,整体感觉是 ARR 审稿质量其实还可以,但是(1)混合投稿的时候和 softconf 一起比较的机制不是很清楚(例如,会议和 ARR 评分的细则不对齐,甚至 ARR 不同月份的也有点 区别)(2)SAC 的 decision 是怎么做的不清楚,群里看到不少高分 ARR 被拒稿,被拒的不明不白的。个人看法,以后应该还是会优先 softconf 了。 EMNLP2022一共接收了我的三篇文章(两篇主会一篇findings),分别是 [1] MedCLIP: Contrastive Learning from Unpaired Medical Images and Texts [2] PromptEHR: Conditional Electronic Healthcare Records Generation with Prompt Learning [3] Trial2Vec: Zero-Shot Clinical Trial Document Similarity Search using Self-Supervision 今天介绍的是 [1] 这篇工作。做的内容是最近大火的图像文本联合预训练(Vision-Language pretraining)在医疗领域的应用。这篇文章的亮点主要是探索了如何处理False Negative样本对预训练的影响探索了怎么样在样本有限的情况下,最大化的扩充正负样本对来提高多模态预训练的data efficiency 那么接下来就是正文啦。 前情提要 CLIP[1](Contrastive Language-Image Pre-training)即图文对比预训练,是这推动这两年多模态领域大火的奠基之作。相信大家都已经比较熟悉了。

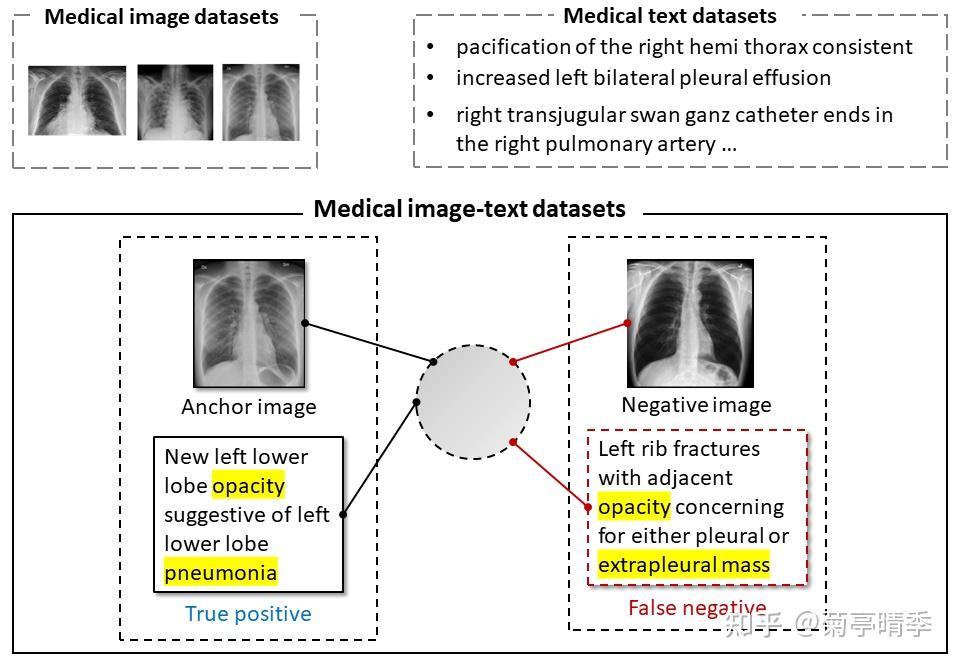

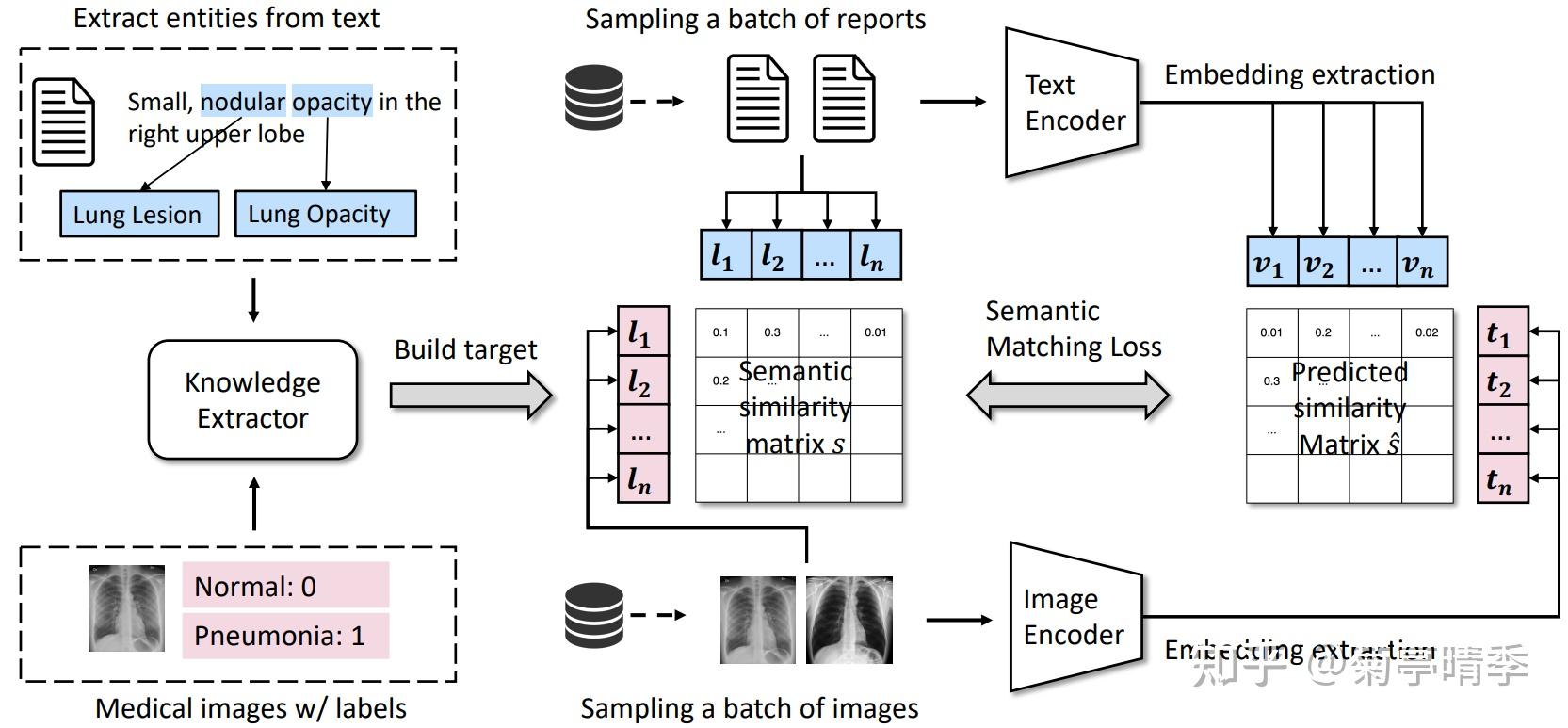

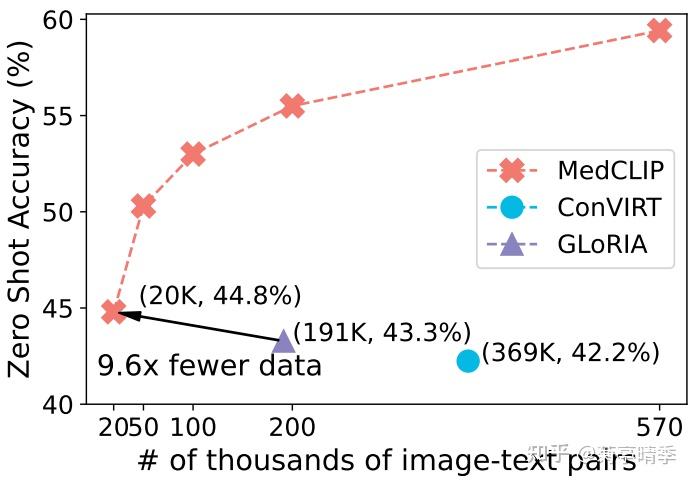

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/56844.html