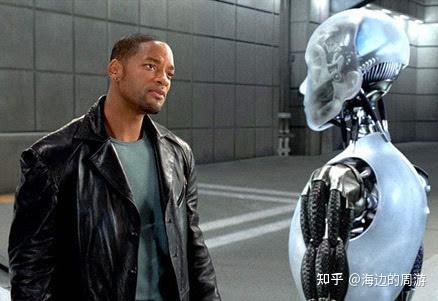

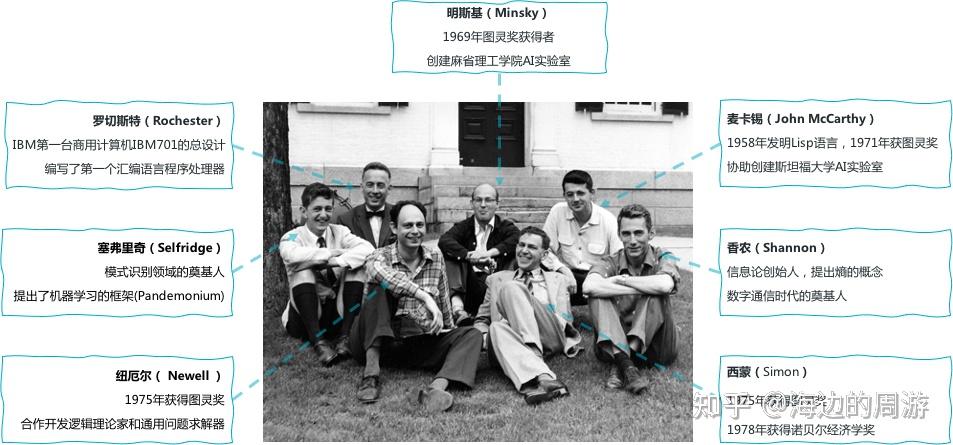

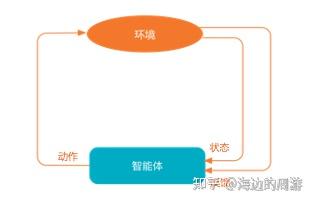

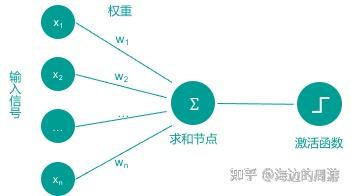

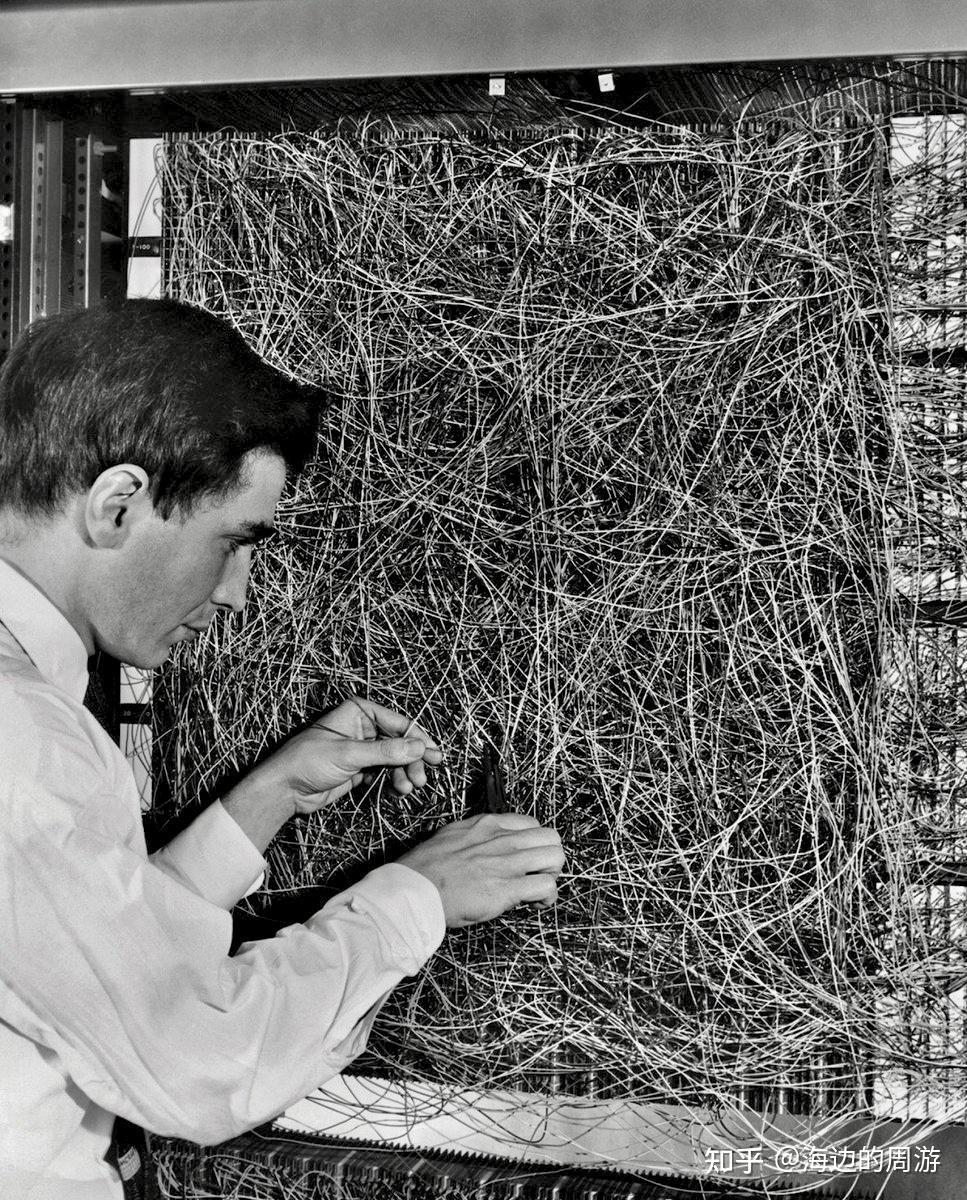

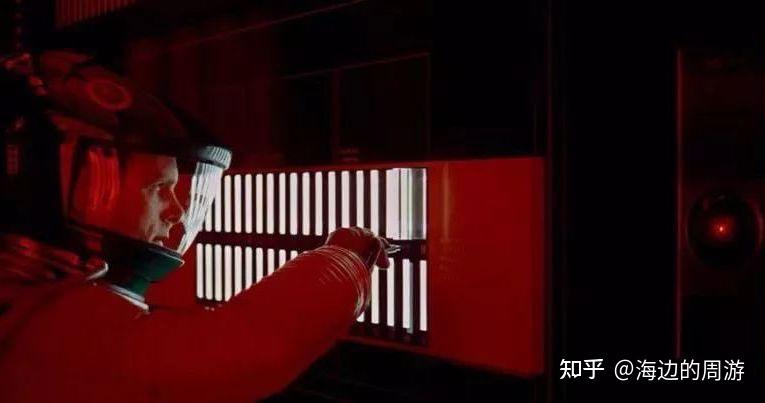

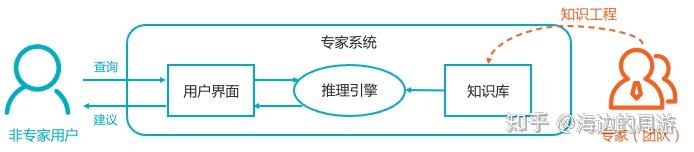

人工智能简史 人工智能 (Artificial Intelligence,AI) 是计算机科学的一个分支领域,致力于让机器模拟人类思维,执行学习、推理等工作。人工智能的发展经历了以下五个阶段。AI兴起:人工智能概念的出现(1950~1974)AI第一次寒冬:神经网络遇冷,研究经费减少(1974~1980)AI复兴:专家系统流行并商用(1980~1987)AI第二次寒冬:专家系统溃败,研究经费大减(1987~1993)AI崛起:深度学习理论和工程突破(1993至今) 下面对人工智能发展的五个阶段,分别进行简要的介绍。 第一阶段:AI兴起(1950~1974) 机器人三大定律 1942年,科幻作家阿西莫夫(Isaac Asimov)在小说《我, 机器人》中提出了机器人三定律: 第一:机器人不得伤害人,也不得见人受到伤害而袖手旁观;第二:机器人应服从人的一切命令,但不得违反第一定律;第三:机器人应保护自身的安全,但不得违反第一、第二定律。 但机器人三定律中隐含着两个逻辑悖论:机器人可以杀害正在行凶杀人的人吗?人类自我伤害时而不自知时,机器人该怎么做? 2004年,威尔•史密斯主演的同名电影《我,机器人》,对这两个悖论进行了深度的探索。在电影中,中央电脑Viki为了人类的整体利益,控制部分机器人“保护”人类,不允许他们出门,不允许他们做任何事情。最终人类与少数“正义”的机器人联手反抗Viki并取得成功。

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/43615.html