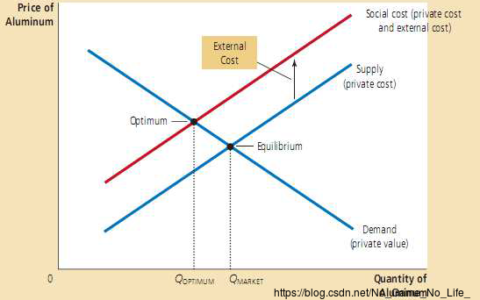

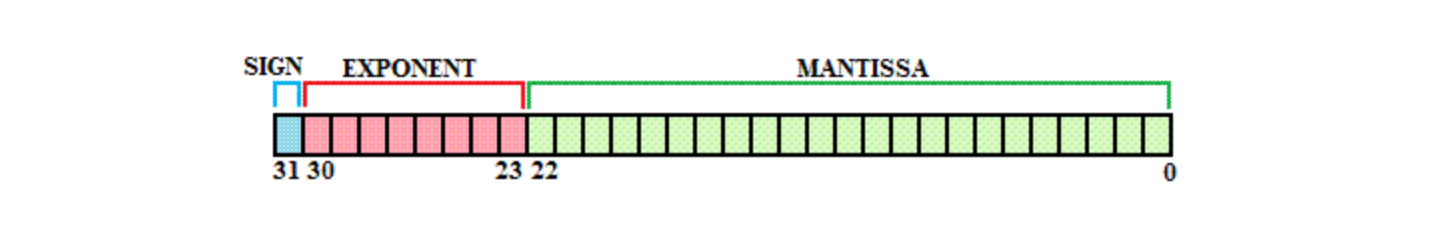

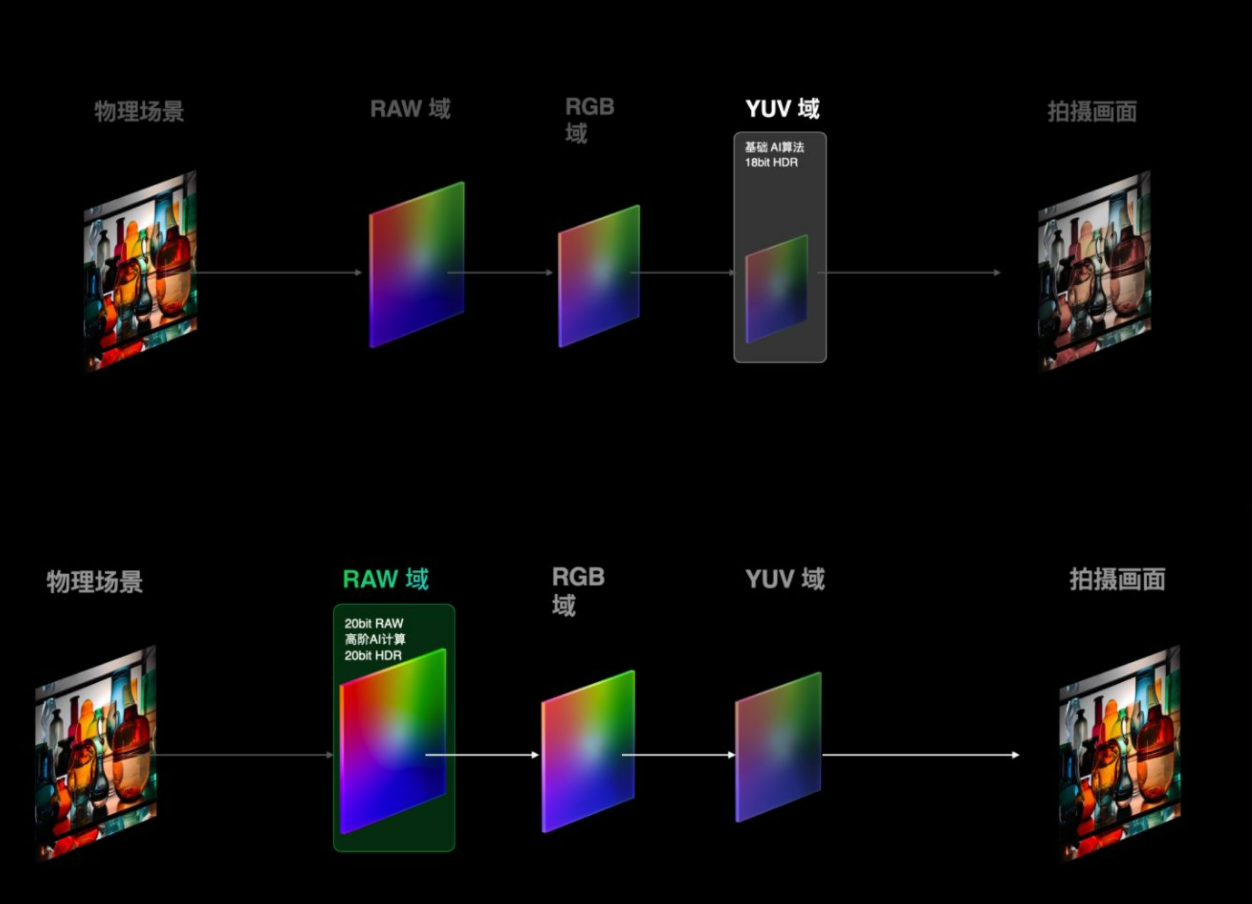

芯片的算力到底有什么用?算力是怎么评估的? 现在经常听到各种芯片的算力,从挖矿到车机,再到最近OPPO那个马里亚纳X和荣耀的AI-ISP啥的。那到底什么是芯片的算力呢?算力怎么评估?为什么手机厂商和智能电车甚至矿主们那么强调算力?能否科普一下例如手机或者汽车上的芯片算力到底有啥用啊? 算力是芯片单位时间里处理数据的能力,算力越高,单位时间里处理的数据量越大,而对于现代高算力要求的场景,算力成为了芯片能力的核心评价指标之一。 传统GPU算力的衡量单位是GFLOPS,FLoating-point Operations Per Second,每秒浮点操作次数,一般是32位精度的浮点运算,也就是FP32,32位二进制数,1位正负标识位、8位指数位和23位尾数位,占用四个字节。

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/33273.html