计算机系统: PGD详解,超全!!!

引言

PGD(Projected Gradient Descent)是一种非常重要的优化算法,在机器学习、深度学习、计算机视觉等领域中有着广泛的应用。在本篇博客中,我们将详细介绍PGD的原理和使用方法,并且给出一些实例来帮助读者更好地理解这个优化算法。

概述

PGD是一种迭代算法,主要用于寻找损失函数的最小值。它通过在每个迭代步骤中,根据梯度下降的方向进行参数更新,以达到损失函数最小化的目的。相对于其它优化算法,PGD拥有许多优点,例如它对初始点的选择不敏感,可以处理带约束的问题,而且它的运行速度也非常快。

在PGD中,每个迭代步骤中的参数更新公式如下:

x t + 1 = arg min x ′ [ f ( x t ) + ∇ f ( x t ) T ( x ′ − x t ) + 1 2 α ∣ ∣ x ′ − x t ∣ ∣ 2 2 ] x_{t+1} = \mathop{\arg\min}_{x’}[f(x_t)+\nabla f(x_t)^T(x’-x_t)+\frac{1}{2\alpha}||x’-x_t||^2_2] xt+1=argminx′[f(xt)+∇f(xt)T(x′−xt)+2α1∣∣x′−xt∣∣22]

其中 f ( x ) f(x) f(x)表示损失函数, ∇ f ( x t ) \nabla f(x_t) ∇f(xt)表示梯度, x t x_t xt表示当前的参数值, α \alpha α表示步长。

值得注意的是,PGD通过在每个迭代步骤中添加一个投影操作来实现 x ′ x’ x′的选择。这样可以确保在更新后的参数值更接近于原问题中的可行域,并且遵守一些特定约束条件。

实例

我们现在来看一个实际的例子,以更好地理解PGD算法。我们以线性回归为例,来展示PGD在求解最小二乘问题中的表现。

在这个问题中,我们需要找到一组系数,使每个输入向量对应的输出值与真实的输出值之间的差距最小化。我们可以使用PGD来求解这个问题。

首先,我们需要定义损失函数 f ( x ) f(x) f(x)和梯度 ∇ f ( x t ) \nabla f(x_t) ∇f(xt)。则:

f ( x ) = 1 2 ( y ^ − y ) 2 f(x) = \frac{1}{2}(\hat{y}-y)^2 f(x)=21(y^−y)2

其中 y ^ \hat{y} y^是模型预测的输出值, y y y是真实的输出值。

∇ f ( x t ) = ( y ^ − y ) x t \nabla f(x_t) = (\hat{y}-y)x_t ∇f(xt)=(y^−y)xt

然后,我们可以使用PGD算法来优化我们的目标函数。具体实现方法见下面代码:

def pgd_regression(X, y, alpha=0.1, max_iter=100): m, n = X.shape W = np.random.randn(n) for i in range(max_iter): grad = (X.dot(W) - y).dot(X) W -= alpha * grad return W 在本例中,我们使用随机梯度下降法来实现PGD算法,并设置最大迭代次数为100。我们使用numpy来简化计算。通过这种方式,我们可以找到最适合我们的模型参数。

结论

综上所述,PGD是一种非常实用的优化算法,在许多领域中都得到广泛的应用。它可以帮助我们寻找损失函数的最小化解,并且不受初始点选择的影响。通过对PGD算法的了解,我们可以更好地理解和应用机器学习、深度学习等相关领域的技术。

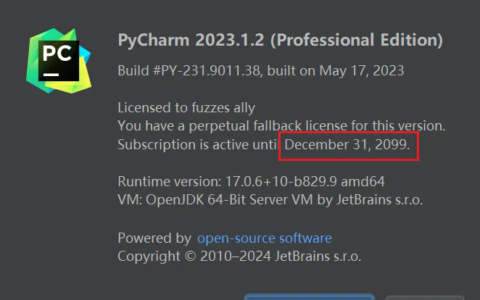

2024最新激活全家桶教程,稳定运行到2099年,请移步至置顶文章:https://sigusoft.com/99576.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请联系我们举报,一经查实,本站将立刻删除。 文章由激活谷谷主-小谷整理,转载请注明出处:https://sigusoft.com/147900.html