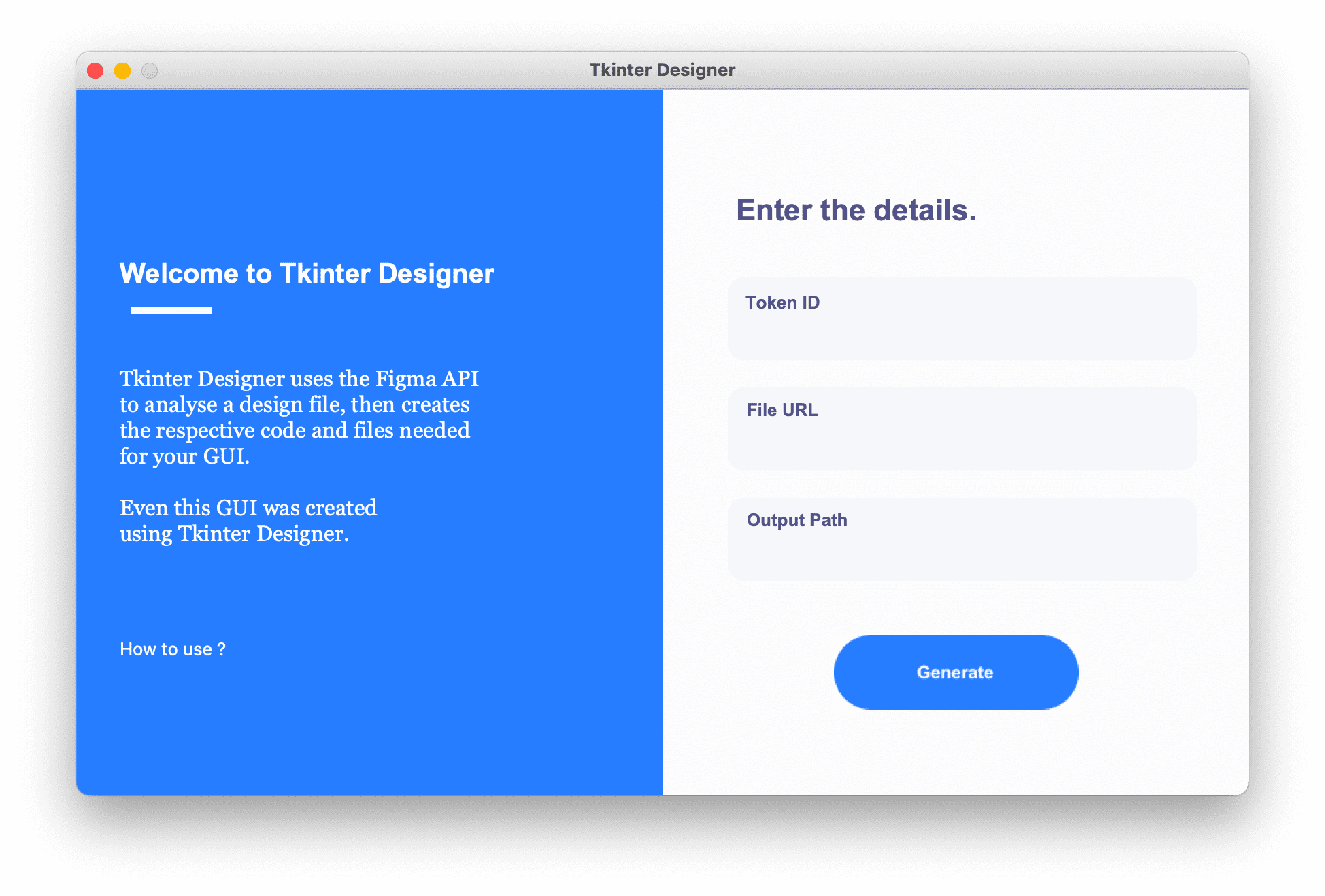

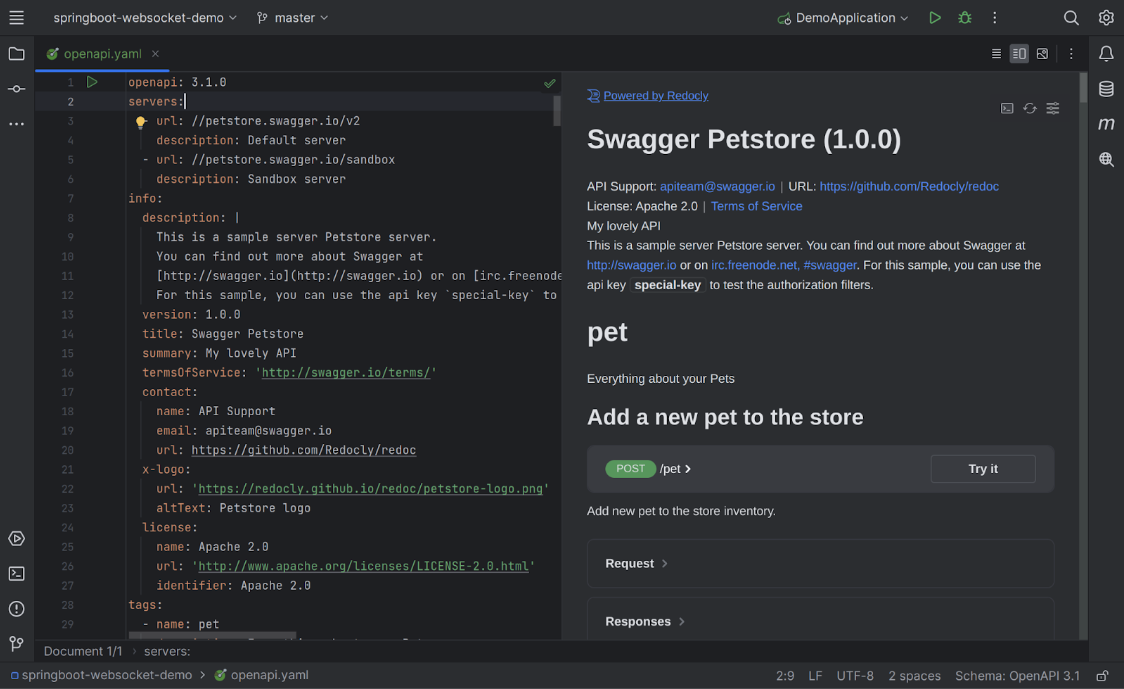

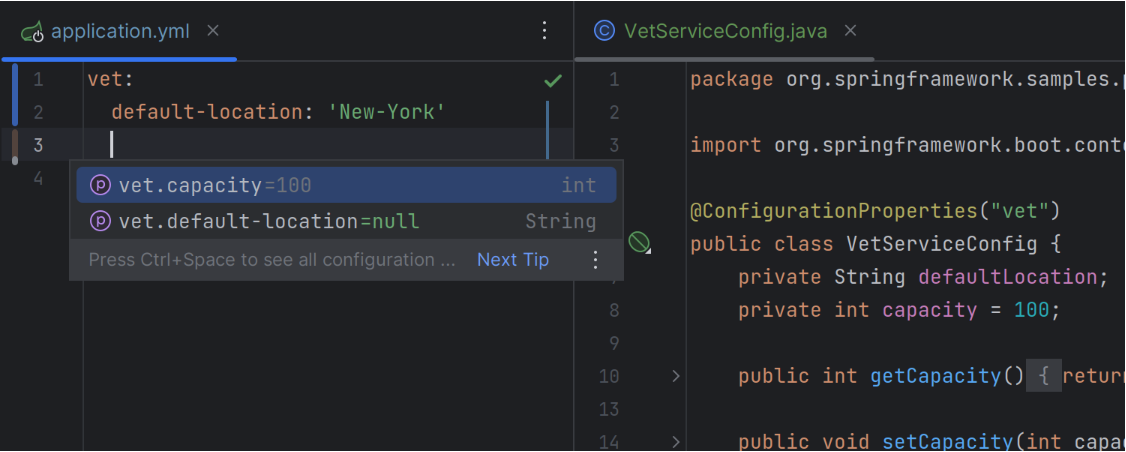

IntelliJ IDEA 2023.2 EAP 6 现已推出,提供了许多更新,例如新的 AI 助手 (AI Assistant)、对 Dev Containers for Gateway 的支持以及 IDE 新 UI 的一些有价值的增强功能。

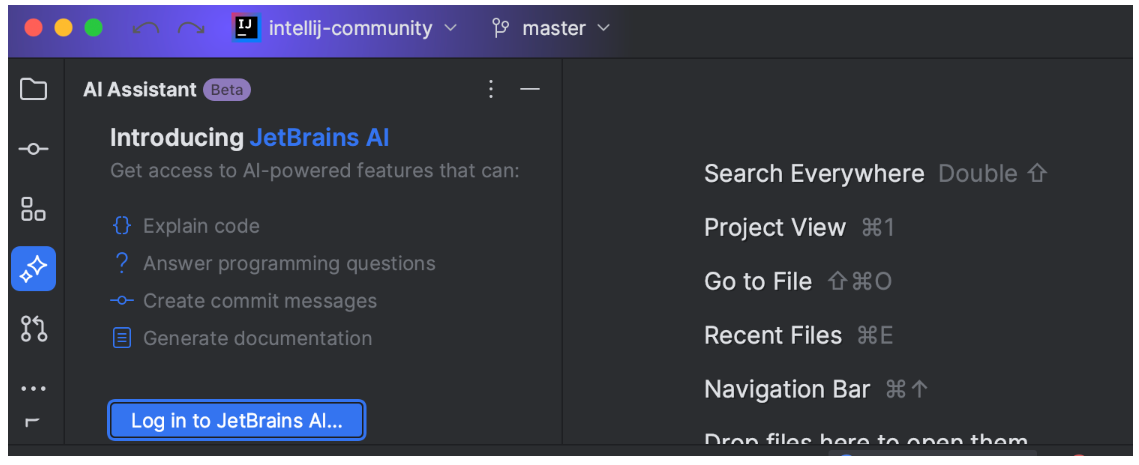

AI Assistant (Beta)

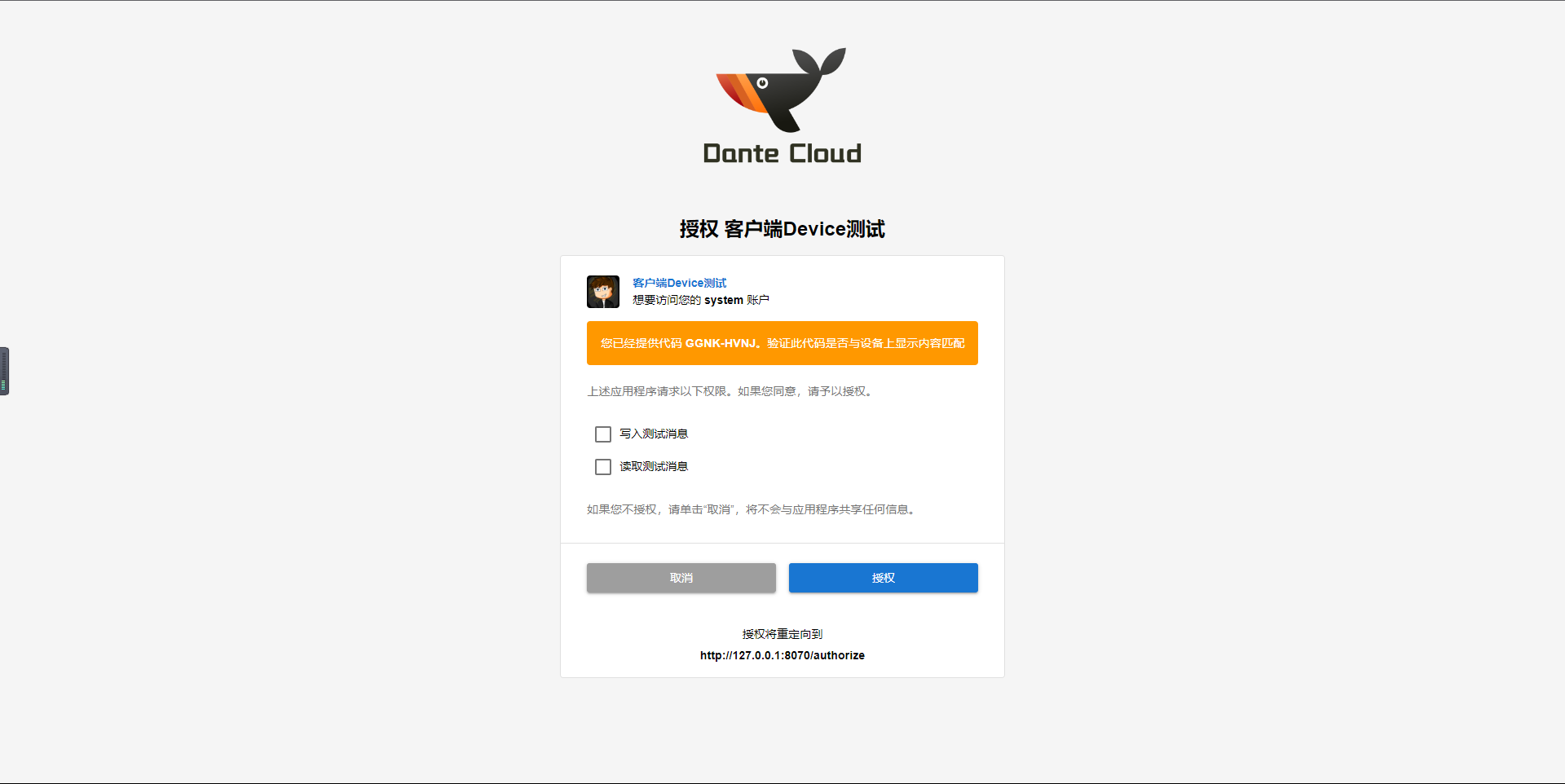

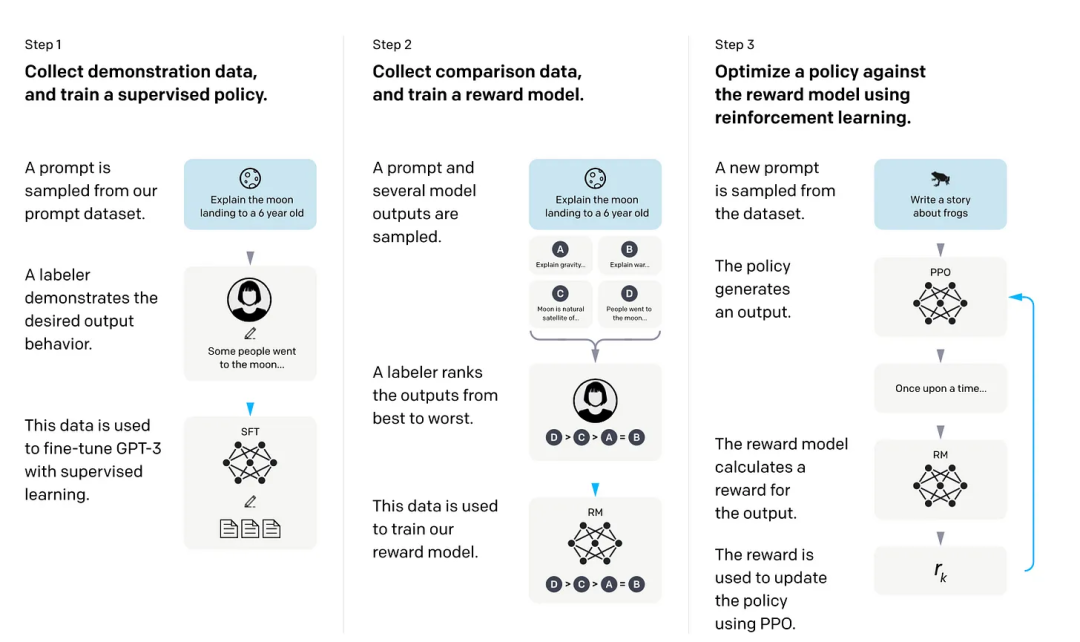

此 EAP 版本为 IntelliJ IDEA 带来了一个重要的补充 —— AI 助手。它由 JetBrains AI 服务提供支持,并结合了 OpenAI 的功能以及 JetBrains 自己的小型模型。IntelliJ IDEA 2023.2 EAP 6 提供了一组初始的 AI 驱动功能,包括集成的 AI 聊天、自动文档生成、名称建议和提交消息生成。

要访问这些 AI 功能,你需要使用 JetBrains 帐户登录 JetBrains AI 服务;JetBrains AI 服务的可用性最初可能会有所不同。有关 AI Assistant 的更多信息以及如何访问它的说明可参阅此博客文章。

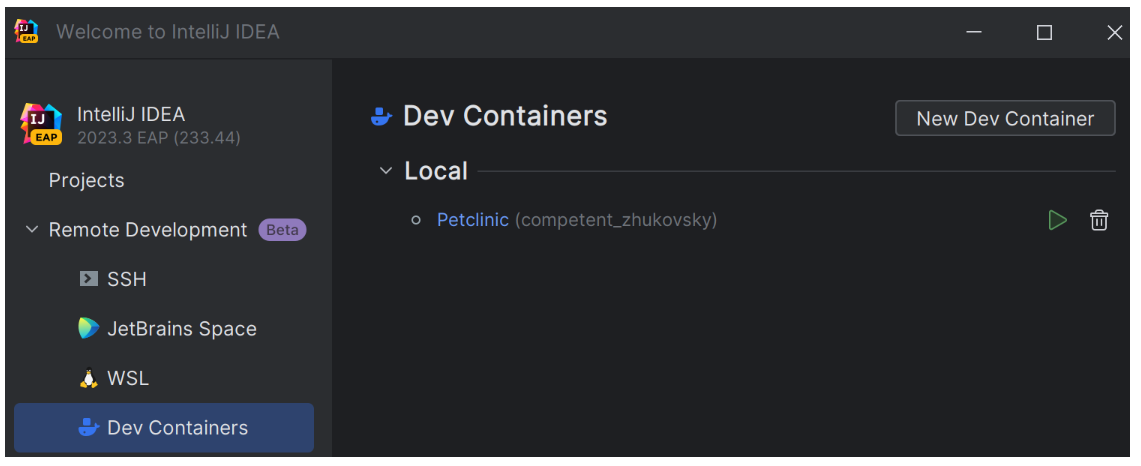

对 Dev Containers 的支持

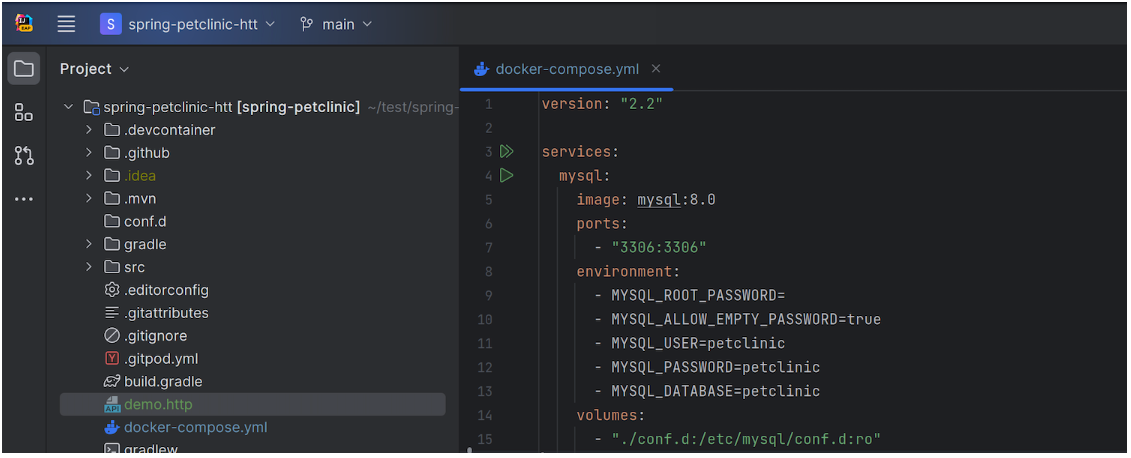

IntelliJ IDEA 现在支持 Dev Containers,允许你使用容器作为功能齐全的开发环境来编辑、构建和运行你的项目。Dev Containers 可以通过 SSH 连接远程运行,也可以使用 Docker 在本地运行。

要使用此功能,需确保你的计算机上安装了 Docker。在“Welcome”屏幕中,选择“Remote Development”部分中的“Dev Containers”选项,并提供 Git 仓库链接以设置连接。

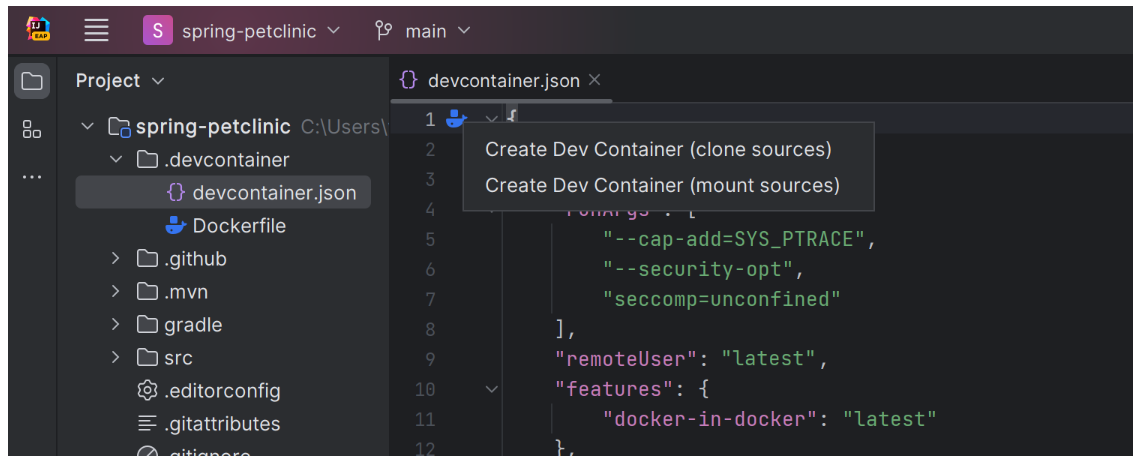

此外,你还可以通过打开 devcontainer.json 文件直接在编辑器中配置本地或远程环境。

初始支持包括数量有限的 devcontainer.json 选项。

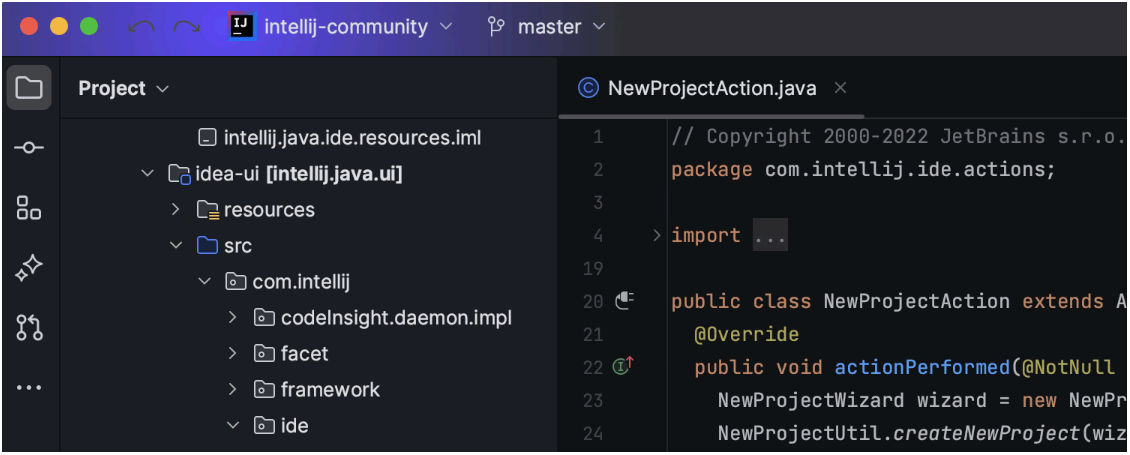

新 UI 中的彩色项目标题

IntelliJ IDEA 2023.2 EAP 6 引入了彩色标题来简化多个打开项目之间的导航。现在可以为每个项目分配唯一的颜色和图标,以便更轻松地在工作区中区分它们。标题现在默认带有预定义的颜色,但用户可以自定义。

在新 UI 中删除了 Linux 上的 title bar

为了方便 Linux 用户,新 UI 中删除了操作系统的 native header ,从而使界面更加干净。默认情况下,用户现在将看到自定义 IDE 的标题,其中提供了一系列自定义选项来定制你的工作区。

支持 Maven 4.0.0-alpha

IntelliJ IDEA 现在与最新版本的 Maven Maven 4.0.0-alpha 完全兼容。

已弃用的插件

根据对插件使用情况的研究,决定弃用 IntelliJ IDEA 中的多个插件,包括 Struts2、Resin、tc Server、Play 和 Cloud Foundry。从 2023.2 版本开始,将不再构建他们的新版本。

更多详情可查看官方博客。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

据《华尔街日报》报道,美国计划进一步收紧对中国出口 AI 计算显卡的限制。美国商务部最早可能在 7 月初采取行动,在未获得许可证的情况下,英伟达等 AI 芯片厂商将被禁止向中国和其他相关国家的客户销售多种型号的 AI 计算芯片和显卡等产品。

去年秋天,美国出台了 AI 芯片相关的首轮贸易限制措施,对 Nvidia 和 AMD 等公司施加出口许可证要求。当时限制贸易的产品覆盖了 Nvidia A100、H100 等高端 GPU 产品。英伟达方面表示,美国的限制令是在担心先进的 AI 芯片可能会被竞争对手用于训练强大的 AI 应用程序中,继而对美国的 AI 领先地位产生影响。

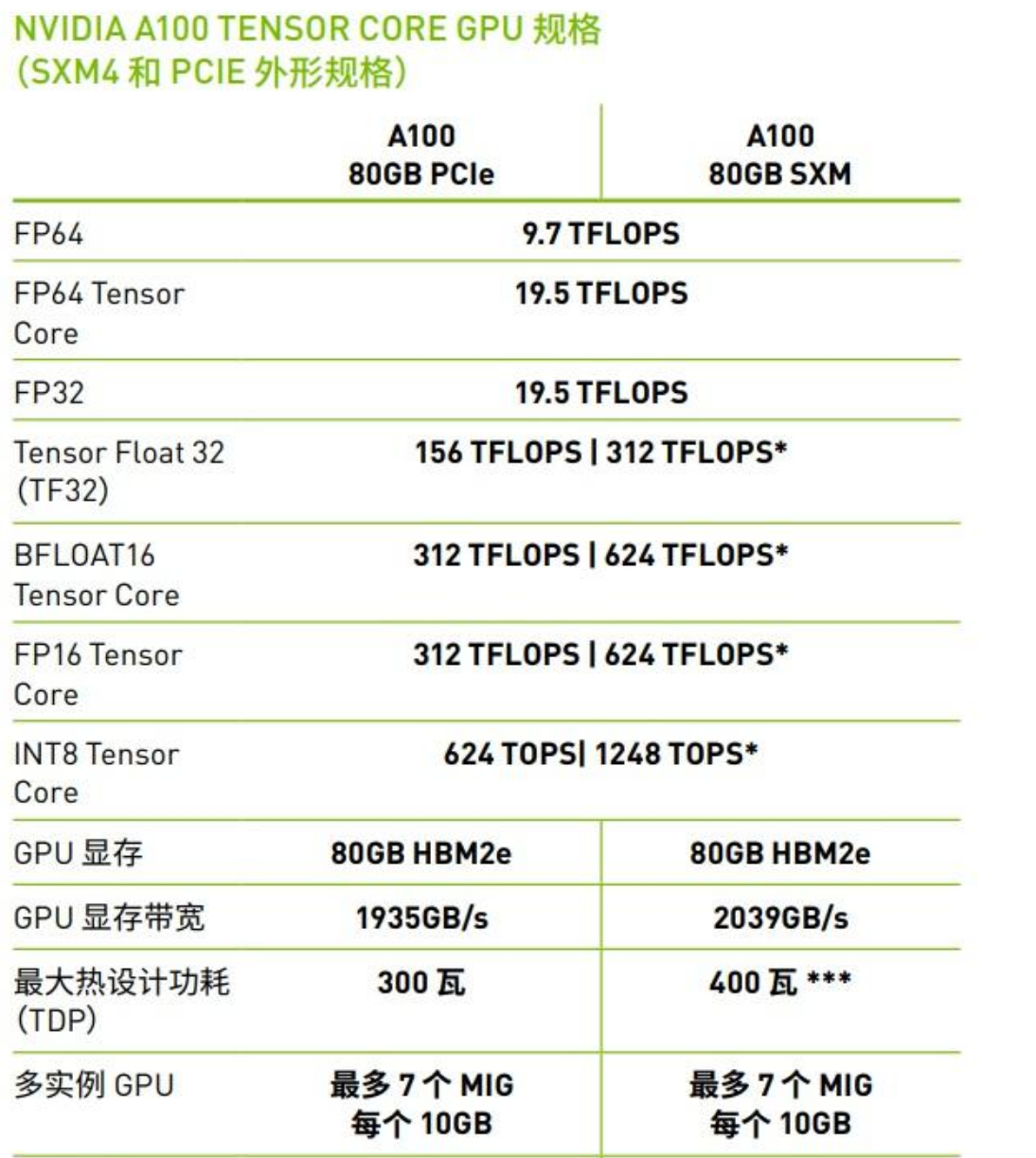

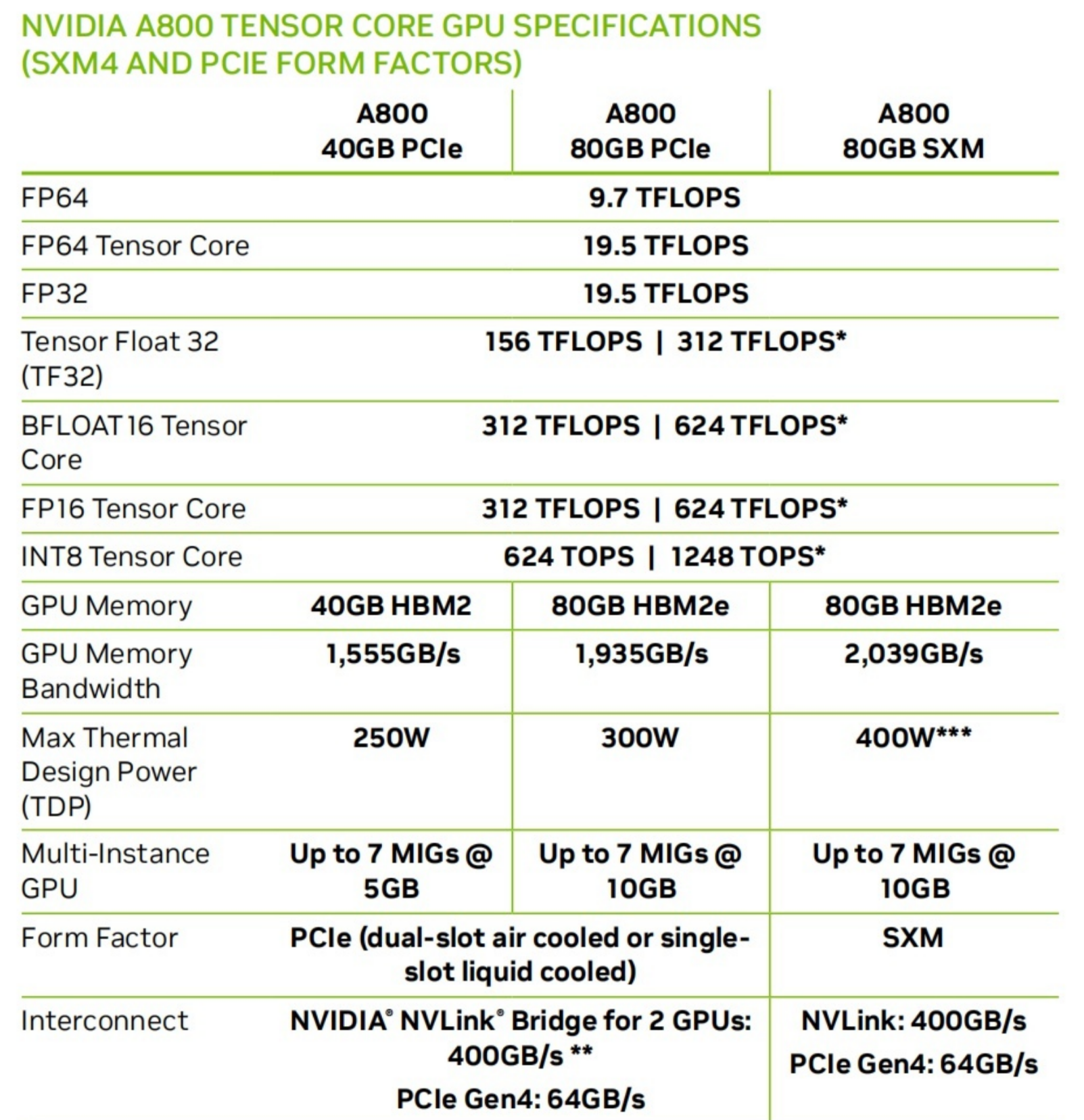

为了在不丢掉中国市场的同时满足限制令,芯片制造商开始生产功能较弱的计算显卡产品,比如 Nvidia 向中国客户提供 A800 GPU,该系列计算卡于 2022 年第三季度投入生产,它既可作为 A100 的替代品,又低于美国政府的禁令门槛。

但美国政府似乎对显卡厂商变相绕过监管的做法相当不满,相关立法者正计划扩大禁令范围,第二轮禁令限制的类型甚至会覆盖到 A800 等性能较差的计算显卡。

(其实 A800 和 A100 的硬件参数并没有差多少,只是 A800 为了过禁令阉割了卡间通信带宽,可以理解为 A100 特供版)

扩大 AI 芯片限制令的消息一经报道便不胫而走,虽然截止目前还没有任何美国政府的官方公告,但消息传出来一天之内,英伟达股价下跌 3.2%,AMD 股价下跌约 3%。

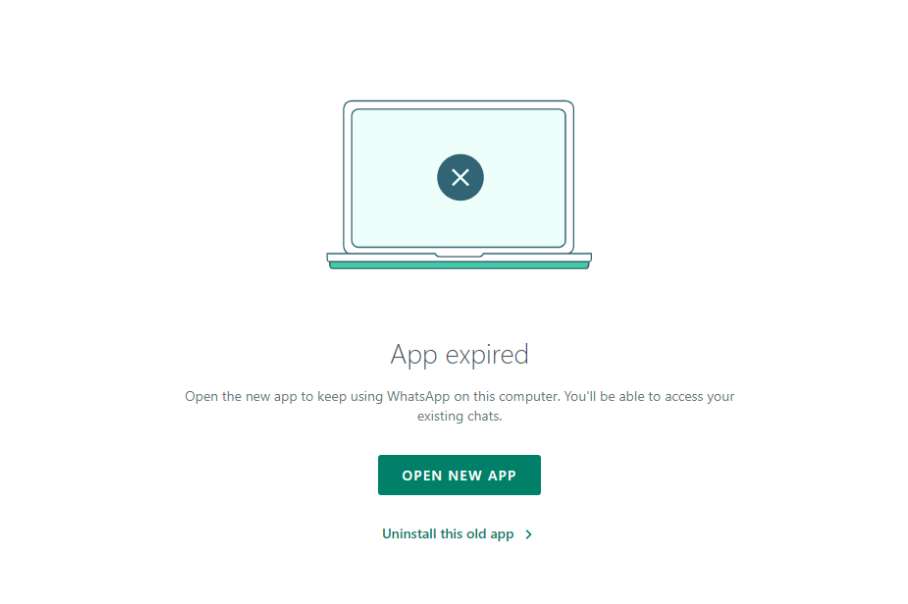

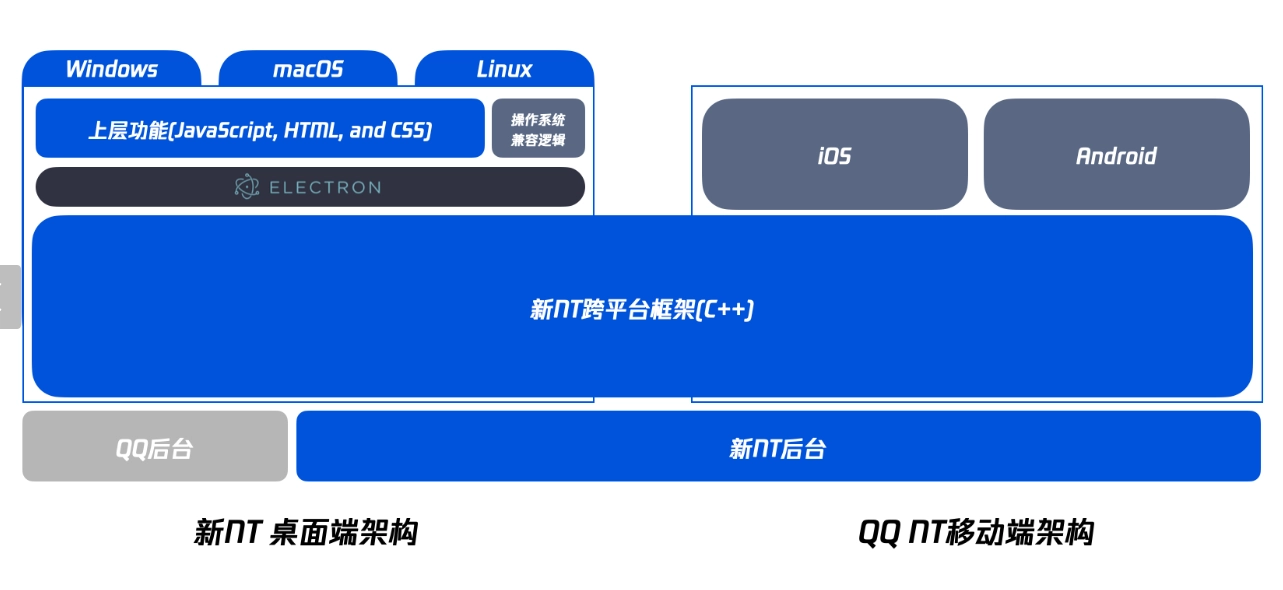

WhatsApp 已正式宣布弃用 Windows 上基于 Electron 的桌面应用程序,促使用户转而使用新推出的原生应用程序以实现不间断访问。此举旨在在桌面设备上提供更加优化、稳定且功能丰富的消息传递体验。

早在一个月前,WhatsApp 就在应用程序的主屏幕上显示了一个弃用倒计时,以提前告知用户。虽然有一些用户表达了对快速过渡、以及原生应用程序中业务工具(如目录管理和快速回复)短缺的不满。但现在所有打开基于 Electron 的 WhatsApp 桌面应用程序的用户,都会看到一个“APP expired”的通知消息,明确通知其该应用程序已不再受支持。

目前,Electron 应用程序的弃用似乎仅限于 WhatsApp Desktop for Windows。

Electron 框架允许开发人员通过开发可跨 Windows 和 macOS 等不同操作系统运行的单一代码库,使用 Web 技术创建跨平台桌面应用程序。但 WABetaInfo 指出,“由于它们是为了在不同的操作系统上工作而开发的,所以并没有真正优化,且可能会占用大量的资源。原生应用程序肯定可以提供更流畅、更直观的用户界面,更好的响应性和更强的稳定性,提供更强大和可靠的信息服务,这也是 WhatsApp 决定为其用户构建原生解决方案的原因。”

用户需要从 Microsoft Store 下载适用于 Windows 的原生桌面应用程序。对于仍然需要使用商业工具的用户,可以考虑使用 WhatsApp Web 作为临时解决方案。

谷歌基于团队内部使用 Rust 的体验和经历,分享了他们对这门“网红”编程语言的见解,其中包括对常见 Rust 谣传的澄清。

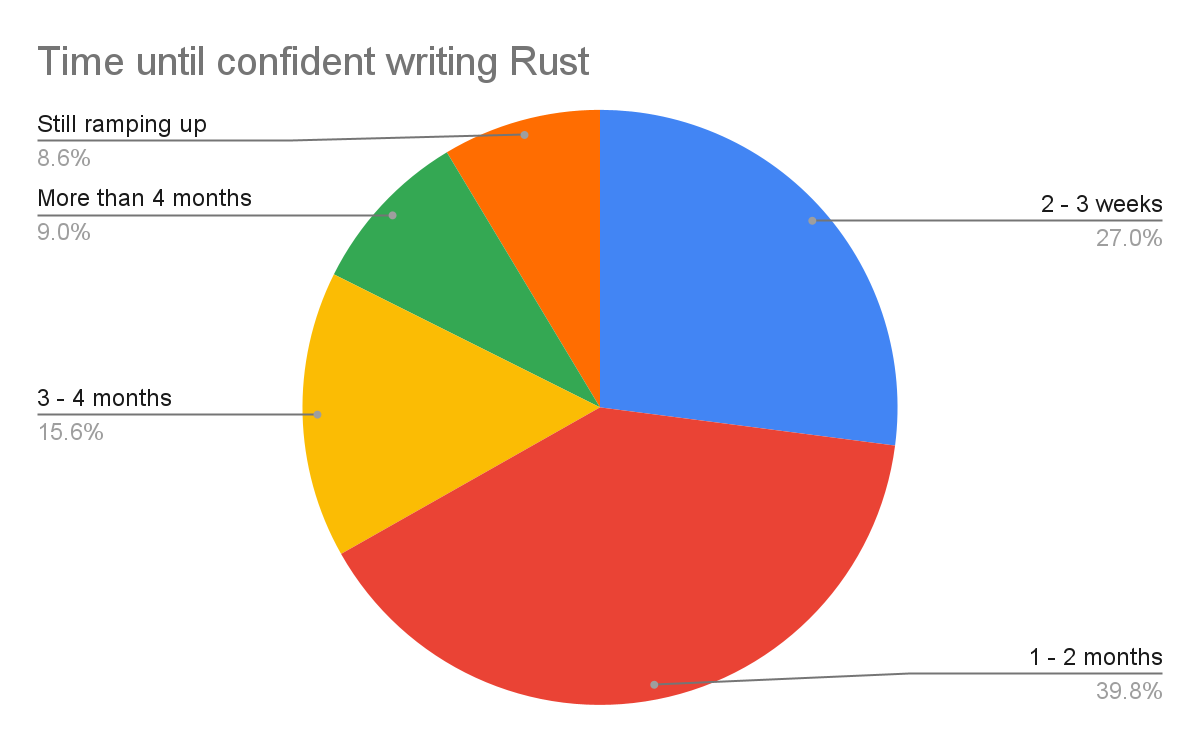

1. Rust 至少需要学习 6 个月

谷歌驳斥了此说法。

谷歌内部调查显示,超过 2/3 的受访者有信心在学习 Rust 时,用两个月或更短时间内就能为 Rust 代码库做出贡献。此外, 1/3 的受访者在两个月或更短的时间内使用 Rust 变得与其他语言一样高效。四个月内,这一数字增加到 50% 以上。

2. Rust 编译器速度并没有想象的那么快

谷歌证实了此说法。

他们表示,到目前为止,构建速度慢是开发者在使用 Rust 时遇到的第一大挑战,只有略多于 40% 的受访者认为速度可以接受。

3. unsafe 代码和互操作始终是最大的挑战

谷歌驳斥了此说法。

对于当前的谷歌开发者来说,他们在 Rust 领域面临的三大挑战是:

- Macros(宏)

- Ownership and borrowing(所有权和借用)

- Async programming(异步编程)

编写 unsafe 代码和处理 C/C++ 互操作也是谷歌开发者遇到的问题,但并不是最大的挑战。

4. Rust 的编译器错误消息十分有用

谷歌证实了此说法。

谷歌内部只有 9% 的受访者对 Rust 中的诊断和调试信息质量不满意。

综合社区的反馈来看,大家惊叹于编译器消息的出色表现。虽然起初有些惊讶——毕竟大家习惯于忽略大的编译器错误,但习惯之后,大家就喜欢它了。

5. Rust 的代码质量很高

谷歌证实了此说法。

受访者表示 Rust 代码的质量很高——77% 的开发者对 Rust 代码的质量感到满意。事实上,当被要求比较他们是否认为 Rust 代码比他们用其他语言编写的代码更正确时,绝大多数受访者 85% 相信他们的 Rust 代码是正确的。

除了正确,Rust 代码也便于 review,超过一半的受访者表示 Rust 代码非常容易 review。

原文地址

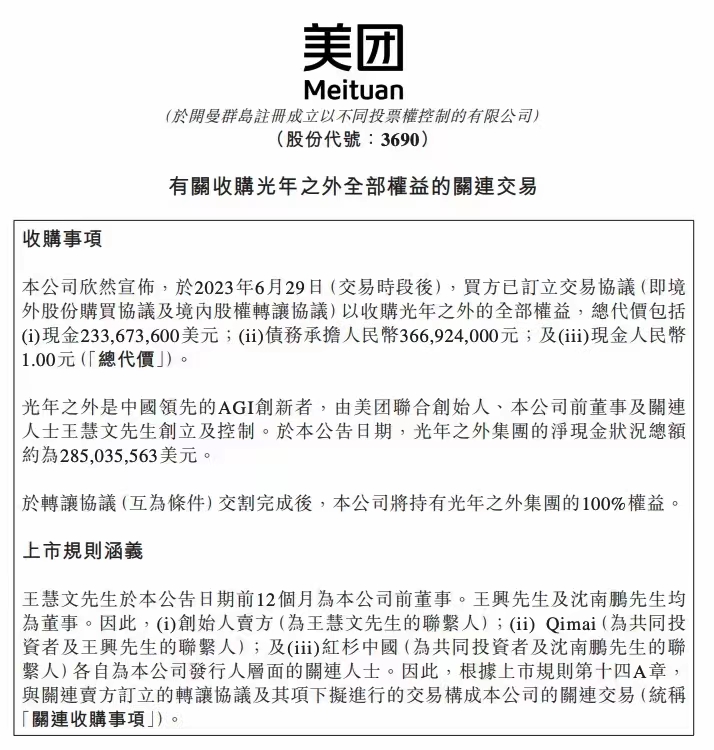

美团于 6 月 29 日在香港联交所发布公告称,已经订立交易协议以收购光年之外境内外主体 100% 股权,收购价约为 20.65 亿人民币。

收购价格包括现金 2.34 亿美、债务承担 3.67 亿人民币以及现金 1 人民币。

美团在公告中解释称,将通过此收购事项获得领先的 AGI 技术及人才,有机会加强其于快速增长的人工智能行业中的竞争力。

光年之外是一家大模型创业公司,成立于 2018 年;致力于推动实现 AGI(通用人工智能)与普惠人类。由美团联合创始人、前董事及关联人士王慧文创立及控制,光年之外集团的净现金为 2.85 亿美。日前,光年之外联合创始人王慧文曾因身体原因离岗就医及休养,引发外界诸多关注。

美团方面表示,并购完成后,将支持光年团队继续在大模型领域进行探索和研究。

摘要:索引就是数据表中数据和相应的存储位置的列表,利用索引可以提高在表或视图中的查找数据的速度。

本文分享自华为云社区《数据库开发指南(六)索引和视图的使用技巧、方法与综合应用》,作者: bluetata 。

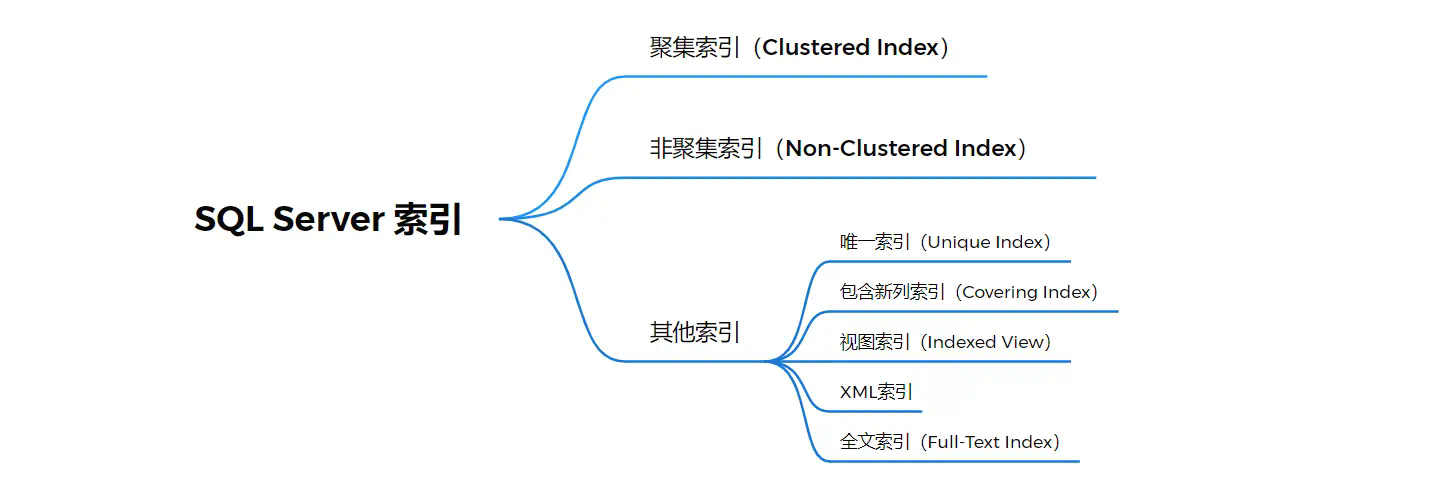

一、索引

1.1 什么是索引

索引就是数据表中数据和相应的存储位置的列表,利用索引可以提高在表或视图中的查找数据的速度。它类似于书籍的索引,可以帮助快速定位和检索数据。在数据库中,索引是对一个或多个列的值进行排序和存储的结构,它们包含指向实际数据位置的指针。

1.2 索引分类

数据库中索引主要分为两类:聚集索引和非聚集索引。SQL Server 还提供了唯一索引、索引视图、全文索引、XML 索引等等。聚集索引和非聚集索引是数据库引擎中索引的基本类型,是理解其他类型索引的基础。

1.2.1 聚集索引

聚集索引是值表中数据行的物理存储顺序和索引的存储顺序完全相同。聚集索引根据索引顺序物理地重新排列了用户插入到表中的数据,因此,每个表只能创建一个聚集索引。聚集索引经常创建在表中经常被搜索到的列或按顺序访问的列上。在默认情况下,主键约束自动创建聚集索引。

1.2.2 非聚集索引

非聚集索引不改变表中数据列的物理存储位置,数据与索引分开存储,通过索引指向的地址与表中的数据发生关系。

非聚集索引没有改变表中物理行的位置,索引可以在以下情况下使用非聚集索引:

- 如果某个字段的数据唯一性比较高

- 如果查询所得到的数据量比较少

1.2.3 聚集索引和非聚集索引的区别

这里用一个表格简单的总结一下聚集索引和非聚集索引的区别:

1.2.4 其他类型索引

除了以上索引,还有以下类型索引:

- 唯一索引:如果希望索引键都不同,可以创建唯一索引。聚集索引和非聚集索引都可以是唯一索引。

- 包含新列索引:索引列的最大数量是16个,索引列的字节总数的最高值是900。如果当多个列的字节总数大于900,切又想在这些劣种都包含索引是,可以使用包含新列索引

- 视图索引:提供视图查询效率,可以视图的索引物理化,也就是说将结果集永久存储在索引中,可以创建视图索引。

- XML索引:是与xml数据关联的索引形式,是XML二进制blob的已拆分持久表示形式

- 全文索引:一种特殊类型的基于标记的功能性功能,用于帮助在字符串中搜索赋值的词

1.3 创建索引

1.3.1 语法

参数解释

unique 唯一索引

clustered 聚集索引

noclustered 非聚集索引

fillfactor 填充因子大小,范围在 0-100 直接,表示索引页填满的空间所占的百分比。

1.3.2 创建索引的命名规则最佳实践

在 MSSQL 中,索引的命名规则的最佳实践可以有一些常见的准则,以提高可读性和维护性。这个潜在的要求不仅试用于 SQL Server 数据库,同样在其他数据库例如 MySQL、Oracle 中都同样值得注意。

下面是个人总结的一些命名规则与建议:

- 命名应该具有描述性:索引的名称应该能够清晰地表达其作用和关联的列或表。使用有意义的名称可以使其他开发人员更容易理解索引的用途。

- 包含表名和列名:在索引名称中包含相关表名和列名(长表名可适当缩写,但要确保可以定位到表),可以使索引更具可读性,并且可以避免在不同表之间使用相同名称的索引时的冲突。

- 使用统一的命名约定:为了提高一致性,可以定义一套命名约定,并在整个数据库中使用。例如,可以使用特定的前缀或后缀来标识索引的类型(如 idx_ 表示非聚集索引)。

- 避免过长的名称:索引名称不应该过长,以免在使用索引时引起不便。尽量使用简洁但描述性的名称。

- 避免使用保留关键字和特殊字符:确保索引名称不与 MSSQL 的保留关键字或特殊字符冲突,以避免语法错误。

1.3.3 创建索引示例

1.4 适合的创建索引的列

一般情况,可以选择那些对查询性能有积极影响的列进行索引创建,下面进行一定的总结:

列的选择性:选择性是指列中不同值的数量与总行数的比例。如果某列具有较高的选择性,即不同的值较多,那么为该列创建索引可能会有更好的效果。例如,在表示性别的列上创建索引可能没有太大的帮助,因为只有两个可能的值。

查询频率:观察经常用于查询条件的列。如果某个列经常用于搜索、过滤或连接操作,那么为该列创建索引可以提高查询性能。

数据表的大小:对于大型表,创建索引的影响可能更加显著。较小的表可能不需要太多的索引,因为全表扫描的开销相对较小。

数据更新频率:索引的创建和维护也会增加对数据的写操作的开销。如果某个列的数据经常发生变化,那么创建索引可能会带来一定的性能开销。

查询性能优化需求:通过分析查询执行计划,可以确定是否存在潜在的性能瓶颈,并考虑为相关的列创建索引以改善查询性能。

请注意过多的索引也可能会带来维护开销和存储成本,因此需要在权衡索引数量和性能提升之间找到平衡点。定期监控和评估索引的使用情况也是重要的,以确保索引仍然对数据库性能产生积极影响。

1.5 不适合创建索引的列

虽然在某些情况下创建索引可以提高查询性能,但并不是所有列都适合创建索引。以下是一些不适合创建索引的列的情况:

低选择性列:如果某个列的选择性很低,即该列的不同值较少,创建索引可能不会带来明显的性能提升。例如,对于性别这样只有几个可能值的列,创建索引可能不会有太大意义。

经常更新的列:如果某个列的值经常被修改,那么为该列创建索引可能会带来额外的维护成本和性能开销。每次更新操作都需要更新索引,这可能会影响写入性能。在这种情况下,需要仔细评估是否真的需要为该列创建索引。

过于频繁的查询列:某些列可能经常被查询,但它们的选择性较低,即不同的值较少。在这种情况下,尽管查询频率高,但为该列创建索引可能不会带来明显的性能提升,因为索引的使用效果有限。

大文本或大二进制列:对于存储大文本或大二进制数据的列,如长文本字段或图像字段,创建索引的效果通常较差。这是因为索引本身需要占用额外的存储空间,并且对于大型数据的索引操作可能变得非常耗时。

不常用的列:对于很少用于查询的列,创建索引可能没有太大意义。如果一个列很少用于查询条件或连接操作,那么为其创建索引可能只会增加额外的开销而不带来实际的性能提升。

需要注意的是,以上列举的情况只是一般性的指导原则,具体是否适合创建索引还取决于具体的数据库结构、查询模式和性能需求。在设计和创建索引时,应根据具体情况进行评估,并进行性能测试和优化以确保索引的有效性。

二、视图

2.1 什么是视图

视图就是一个虚拟的数据表,该数据表中的数据记录是由一条查询语句的查询结果得到的。

2.2 为什么要使用视图,而不是表(面试可能会被问到)

如果你在面试的时候被问到这个问题,建议从下面这个流程来回答一下面试官。

首先介绍一下表的作用(比如表是直接存储结构化数据,可以扩展增删改之类的),之后在介绍一下视图是什么,之后从两个切入点来讲解视图的好处以及必要性,这两个切入点是:复用性和安全性,这里来简单总结一下:

- 简化查询,提高复用性

想象一下,一个人员宽表,里面有几百个字段,但是你每次只需要用到这个表中的姓名、性别、年龄这三个字段,那么你可以创建一个视图来直接使用,或者你这个人员表经常和另外一个履历表 join 组合在一起,而只取了其中的部分字段,并且频繁使用这几个字段。那么无疑创建视图是一个好做法。当然这种情况也可以说明使用视图能够简化查询。 - 提高安全性

- 通过视图,可以限制用户对敏感数据的直接访问。视图可以控制用户可以看到和操作的数据的范围,提供更好的安全性和隐私保护。这里还拿刚才我讲的姓名、性别、年龄三个字段,假如年龄是一个比较敏感的字段,那么对某些数据库用户只能查询姓名和性别的话,那么就可以设置一个视图分配给这个用户。

- 另外就是如果你要更新视图的时候,也只能更新视图所见的字段,用户对视图不可以随意的更改和删除,可以一定程度的保证数据的安全性。

讲解完上述的两个大的关键点后,也可以适当自行发挥,比如视图你可以调整表字段的显示顺序,或者字段名字等等。这些也是优点。可以适当进行讲解。

2.3 创建视图

创建视图的时候,对命名视图大家一般也有默认的规则,一般情况可以使用 v_ 或 view_ + 表名(表缩写)的形式。

例如:v_student

2.4 创建视图准则

创建视图需要考虑一下准则:

- 视图名称必须遵循标识符的规则,该名称不得与该架构的任何表的名称相同。

- 你可以对其他视图创建视图。允许嵌套视图,但嵌套不得超过32层。视图最多可以有1024个字段。

- 不能将规则和 default 定义于视图相关联。

- 视图的查询不能包含 compute 子句、compute by 子句或 into 关键字。

- 定义视图的查询不能包含 order by 子句,除非在 select 语句的选择列表中还有 top 子句。

下列情况必须指定视图中每列的名称:

- 有列顺序需求(在某些情况下,您可能希望定义视图的结果集中列的顺序,并且这与基础表中的顺序不同。)

- 视图中的任何列都是从算术表达式、内置函数或常量派生而来

- 视图中有两列或多列具有相同名称(通常由于视图定义包含联接,因此来自两个或多个不同的列具有相同的名称)

- 有指定列别名的需求。注意无论是否重命名,视图列都需继承原列的数据类型

2.5 修改视图

修改视图和修改表有点类似,可以直接使用 alter 关键字进行修改,示例如下:

2.6 加密视图

如果你对某一个视图有保护查询逻辑、防止修改或者查询加密的需求的时候,可以使用加密视图操作。

在 SQL Server 中 使用with encryption后,可以在创建视图时对其定义的 SQL 查询进行加密。也就是说 MSSQL 会对该视图的定义中的查询语句进行加密。这意味着其他人无法直接查看或分析该视图的查询逻辑。压根就看不到这个视图内部结构了。

如何解密被加密的视图,或者修改已经被加密的视图:

一般情况一个视图被加密后,你需要修改它,那么大致有3个方法:

- 重新创建视图(先删除已加密的视图,然后使用新的查询逻辑重新创建视图。)。

- 创建新视图(创建一个新的,视图名称不同,之后调用这个新的)。

- 暴力解密之后修改(一般需要借助第三方工具或辅助,该方式个人不推荐)

2.7 视图能否被更新 update (面试可能会被问到)

如果面试官问了这两个问题,那么他还算友好的提醒了你,如果直接问了一句话“视图可以被更新吗?”,那么我感觉有被挖坑的嫌疑。

视图可以被更新,但不是所有的情况都可以。

视图更新必须遵循以下规则:

- 当视图的字段是通过字段表达式(Field Expression)或常数(Constant)计算得出的结果时,对该视图执行 INSERT 和 UPDATE 操作是不允许的,但可以执行 DELETE 操作。

- 若视图的字段是来自库函数,则此视图不允许更新;

- 若视图的定义中有 GROUP BY 子句或聚集函数时,则此视图不允许更新;

- 若视图的定义中有 DISTINCT 任选项,则此视图不允许更新;

- 若视图的定义中有嵌套查询,并且嵌套查询的 FROM 子句中涉及的表也是导出该视图的基表,则此视图不允许更新;

- 若视图是由两个以上的基表导出的,此视图不允许更新(源表单一才可以被更新);

- 一个不允许更新的视图上定义的视图也不允许更新;

- 由一个基表定义的视图,只含有基表的主键或候补键,并且视图中没有用表达式或函数定义的属性,才允许更新。

关注,第一时间了解华为云新鲜技术~

摘要:在本篇文章中,我们将深入探讨Spring框架中的重要组件——BeanPostProcessor。首先,我们将了解其设计理念和目标,然后通过实际的例子学习如何基础使用它,如何通过BeanPostProcessor改变Bean的初始化结果以及如何利用它修改Bean的属性。

本文分享自华为云社区《Spring高手之路6——Bean生命周期的扩展点:BeanPostProcessor》,作者:砖业洋__ 。

1. 探索Spring的后置处理器(BeanPostProcessor)

1.1 BeanPostProcessor的设计理念

BeanPostProcessor的设计目标主要是提供一种扩展机制,让开发者可以在Spring Bean的初始化阶段进行自定义操作。这种设计理念主要体现了Spring的一种重要原则,即“开放封闭原则”。开放封闭原则强调软件实体(类、模块、函数等等)应该对于扩展是开放的,对于修改是封闭的。在这里,Spring容器对于Bean的创建、初始化、销毁等生命周期进行了管理,但同时开放了BeanPostProcessor这种扩展点,让开发者可以在不修改Spring源码的情况下,实现对Spring Bean生命周期的自定义操作,这种设计理念大大提升了Spring的灵活性和可扩展性。

BeanPostProcessor不是Spring Bean生命周期的一部分,但它是在Spring Bean生命周期中起重要作用的组件。

1.2 BeanPostProcessor的文档说明

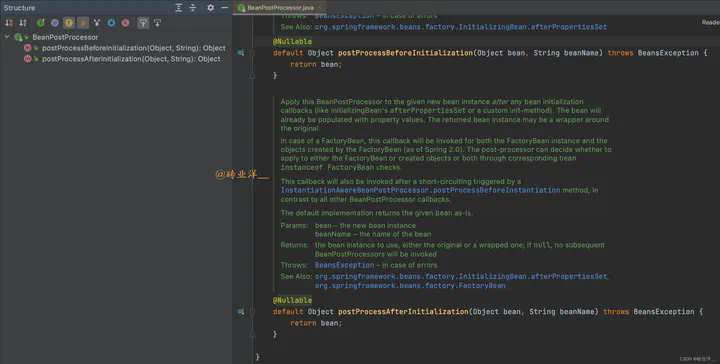

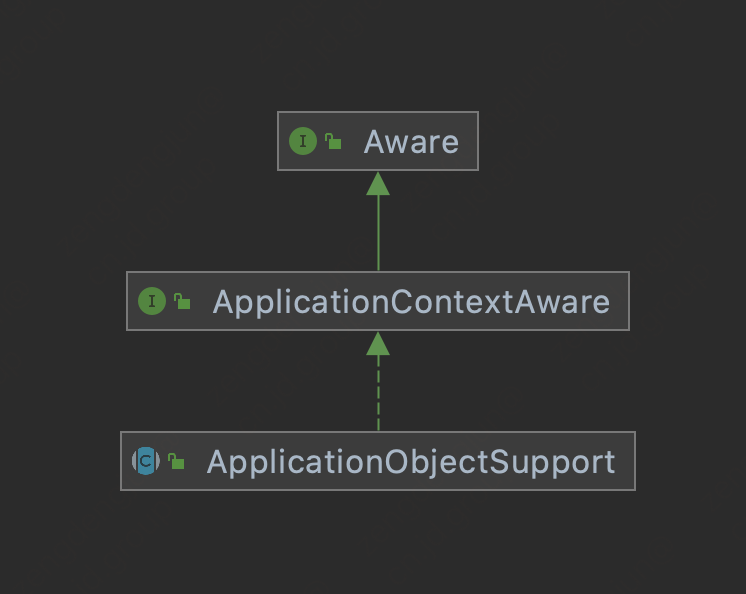

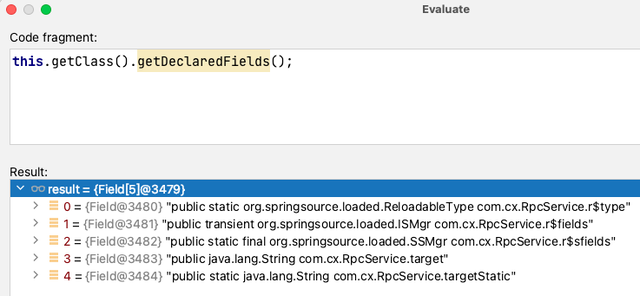

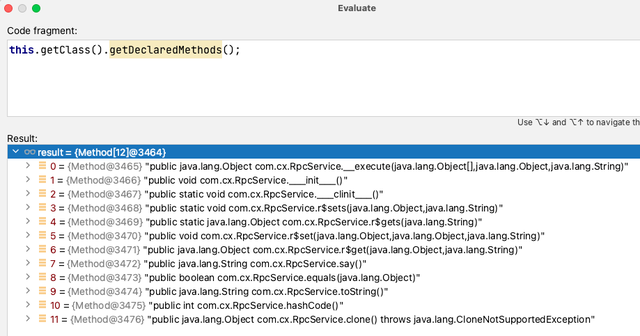

我们来看看这个方法的文档注释,从图中可以看到,BeanPostProcessor 接口定义了两个方法,postProcessBeforeInitialization和postProcessAfterInitialization

postProcessBeforeInitialization方法会在任何bean初始化回调(如InitializingBean的afterPropertiesSet方法或者自定义的init-method)之前被调用。也就是说,这个方法会在bean的属性已经设置完毕,但还未进行初始化时被调用。

postProcessAfterInitialization方法在任何bean初始化回调(比如InitializingBean的afterPropertiesSet或者自定义的初始化方法)之后被调用。这个时候,bean的属性值已经被填充完毕。返回的bean实例可能是原始bean的一个包装。

2. BeanPostProcessor的使用

2.1 BeanPostProcessor的基础使用示例

全部代码如下:

首先定义两个简单的Bean:Lion和Elephant

Lion.java

Elephant.java

然后定义一个简单的BeanPostProcessor,它只是打印出被处理的Bean的名字:

接着我们定义一个配置类,其中包含对Lion、Elephant类和MyBeanPostProcessor类的Bean定义:

最后,我们在主程序中创建ApplicationContext对象:

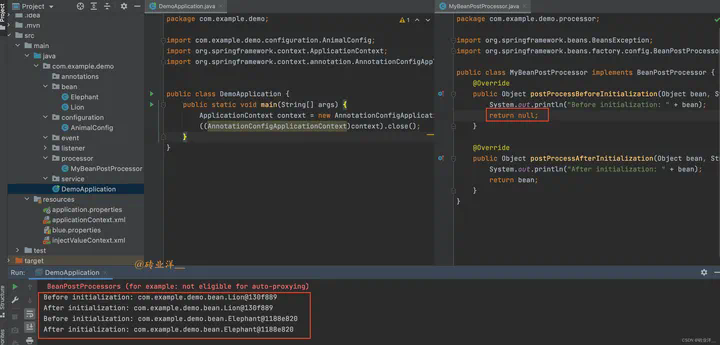

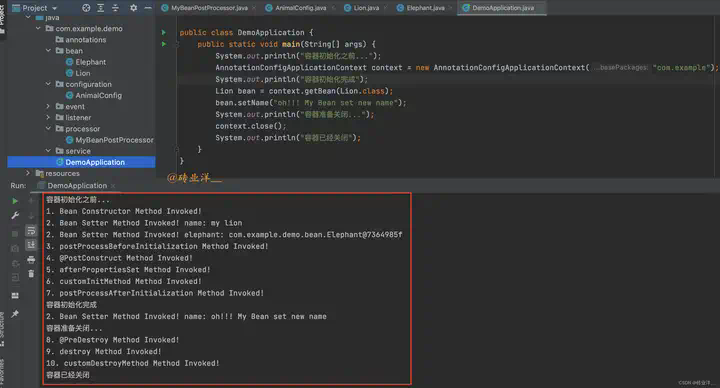

运行结果:

以上代码在执行时,将先创建Lion和Elephant对象,然后在初始化过程中和初始化后调用postProcessBeforeInitialization和postProcessAfterInitialization方法,打印出被处理的Bean的名字。

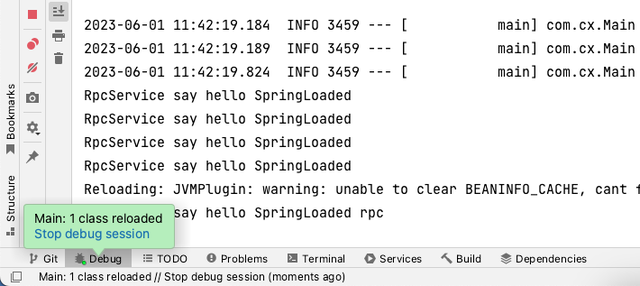

细心的小伙伴可能观察到这里有红色日志

信息: Bean ‘animalConfig’ of type [com.example.demo.configuration.AnimalConfig$$EnhancerBySpringCGLIB$$ee4adc7e] is not eligible for getting processed by all BeanPostProcessors (for example: not eligible for auto-proxying)

在Spring中,BeanPostProcessor是被特殊处理的,它们会在其他普通Bean之前被实例化和初始化,这样设计的原因是BeanPostProcessor的存在可以影响其他Bean的创建和初始化过程。 Spring应用上下文中可以存在多个BeanPostProcessor,Spring本身就提供了很多内置的BeanPostProcessor。

但是,如果在初始化BeanPostProcessor的过程中需要依赖其他的Bean,那么这些被依赖的Bean会先于后置处理器进行初始化。然而,由于这些被依赖的Bean是在该BeanPostProcessor初始化完成之前就已经进行了初始化,它们就会错过这个BeanPostProcessor的处理。在这个例子中,MyBeanPostProcessor就是这样的一个BeanPostProcessor,而”animalConfig”是它所依赖的Bean。所以这个日志信息就是说,’animalConfig’这个Bean在初始化的时候,没有被所有的BeanPostProcessor处理,这里它无法得到MyBeanPostProcessor的处理。

我们只需要把实例化过程直接交给Spring容器来管理,而不是在配置类中手动进行实例化,就可以消除这个提示信息,也就是在MyBeanPostProcessor上加@Component即可。

在第3节的例子中就使用了@Component处理这个MyBeanPostProcessor,这个提示就消失了。

2.2 利用BeanPostProcessor修改Bean的初始化结果的返回值

还是上面的例子,我们只修改一下MyBeanPostProcessor 类的方法后再次运行

运行结果:

BeanPostProcessor的两个方法都可以返回任意的Object,这意味着我们可以在这两个方法中更改返回的bean。例如,如果我们让postProcessBeforeInitialization方法在接收到Lion实例时返回一个新的Elephant实例,那么我们将会看到Lion实例变成了Elephant实例。

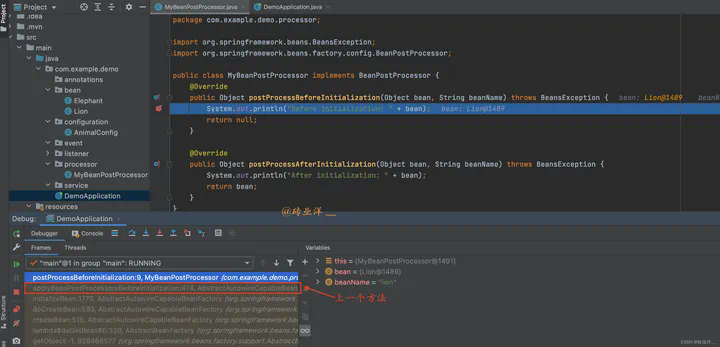

那既然BeanPostProcessor的两个方法都可以返回任意的Object,那我搞点破坏返回null会怎么样,会不会因为初始化bean为null而导致异常呢?

答案是不会的,我们来看一下:

我们运行看结果

结果发现还是正常初始化的bean类型,不会有任何改变,我们继续调试看看是为什么

我们通过堆栈帧看到调用postProcessBeforeInitialization方法的上一个方法是applyBeanPostProcessorsBeforeInitialization,双击点开看一看这个方法

从我这个调试图中可以看到,如果postProcessBeforeInitialization返回null,Spring仍然用原始的bean进行后续的处理,同样的逻辑在postProcessAfterInitialization也是一样。这就是为什么我们在BeanPostProcessor类的方法中返回null,原始bean实例还是存在的原因。

2.3 通过BeanPostProcessor实现Bean属性的动态修改

来看看是怎么拦截 bean 的初始化的

全部代码如下:

首先,我们定义一个Lion类:

接下来,我们定义一个BeanPostProcessor,我们称之为MyBeanPostProcessor :

然后我们定义一个配置类,其中包含对Lion类的Bean定义和对MyBeanPostProcessor 类的Bean定义:

最后,我们在主程序中创建ApplicationContext对象,并获取Lion对象:

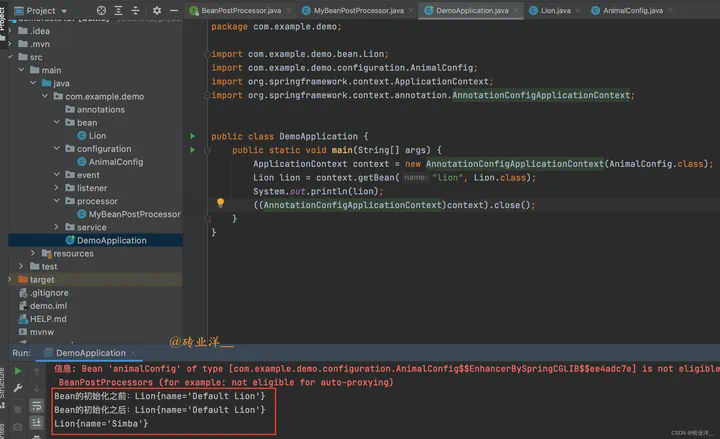

运行结果:

上面代码在执行时,先创建一个Lion对象,然后在初始化过程中和初始化后调用postProcessBeforeInitialization和postProcessAfterInitialization方法,修改Lion的名字为”Simba”,最后在主程序中输出Lion对象,显示其名字为”Simba”。

3. 深度剖析BeanPostProcessor的执行时机

3.1 后置处理器在Bean生命周期中的作用及执行时机

在这个例子中,我们将创建一个名为Lion和Elephant 的Bean,它会展示属性赋值和生命周期的各个步骤的执行顺序。同时,我们还将创建一个BeanPostProcessor来打印消息并显示它的执行时机。

全部代码如下:

首先,我们定义我们的Lion:

创建Lion所依赖的Elephant

然后,我们定义一个简单的BeanPostProcessor:

创建一个配置类AnimalConfig

主程序:

控制台上看到所有的方法调用都按照预期的顺序进行,这可以更好地理解Bean属性赋值和生命周期以及BeanPostProcessor的作用。

根据打印日志我们可以分析出

- 首先,Bean Constructor Method Invoked! 表明 Lion 的构造器被调用,创建了一个新的 Lion 实例。

- 接着,Bean Setter Method Invoked! name: my lion 和 Bean Setter Method Invoked! elephant: com.example.demo.bean.Elephant@f 说明 Spring 对 Lion 实例的依赖注入。在这一步,Spring 调用了 Lion 的 setter 方法,为 name 属性设置了值 “my lion”,同时为 elephant 属性注入了一个 Elephant 实例。

- 然后,postProcessBeforeInitialization Method Invoked! 说明 MyBeanPostProcessor 的 postProcessBeforeInitialization 方法被调用,这是在初始化 Lion 实例之前。

- @PostConstruct Method Invoked! 说明 @PostConstruct 注解的方法被调用,这是在 Bean 初始化之后,但是在 Spring 执行任何进一步初始化之前。

- afterPropertiesSet Method Invoked! 说明 Spring 调用了 InitializingBean 的 afterPropertiesSet 方法

- customInitMethod Method Invoked! 表示调用了 Lion 实例的 init-method 方法。

- postProcessAfterInitialization Method Invoked! 说明 MyBeanPostProcessor 的 postProcessAfterInitialization 方法被调用,这是在初始化 Lion 实例之后。

然后 Spring 完成了整个初始化过程。 - 主程序中手动调用了 Lion 实例的 setter 方法,因此在 Bean Setter Method Invoked! name: oh!!! My Bean set new name 可见,name 属性被设置了新的值 “oh!!! My Bean set new name”。

当容器准备关闭时: - @PreDestroy Method Invoked! 说明 @PreDestroy 注解的方法被调用,这是在 Bean 销毁之前。

- destroy Method Invoked! 表示 Lion 实例开始销毁。在这一步,Spring 调用了 DisposableBean 的 destroy 方法。

- customDestroyMethod Method Invoked! 表示 Lion 实例开始销毁,调用了Lion 实例的 destroy-method 方法。

最后,Spring 完成了整个销毁过程,容器关闭。

这个日志提供了 Spring Bean 生命周期的完整视图,显示了从创建到销毁过程中的所有步骤。

注意:DisposableBean 的 destroy 方法和 destroy-method 方法调用,这个销毁过程不意味着bean实例就被立即从内存中删除了,Java的垃圾收集机制决定了对象什么时候被从内存中删除。Spring容器无法强制进行这个操作,比如解除bean之间的关联和清理缓存,这并不是Spring在销毁bean时会做的,而是由Java的垃圾回收器在一个对象不再被引用时做的事情。

BeanPostProcessor 的执行顺序是在 Spring Bean 的生命周期中非常重要的一部分。例如,如果一个 Bean 实现了 InitializingBean 接口,那么 afterPropertiesSet 方法会在所有的 BeanPostProcessor 的 postProcessBeforeInitialization 方法之后调用,以确保所有的前置处理都完成了。同样,BeanPostProcessor 的 postProcessAfterInitialization 方法会在所有的初始化回调方法之后调用,以确保 Bean 已经完全初始化了。

我们可以注册多个 BeanPostProcessor。在这种情况下,Spring 会按照它们的 Ordered 接口或者 @Order 注解指定的顺序来调用这些后置处理器。如果没有指定顺序,那么它们的执行顺序是不确定的。

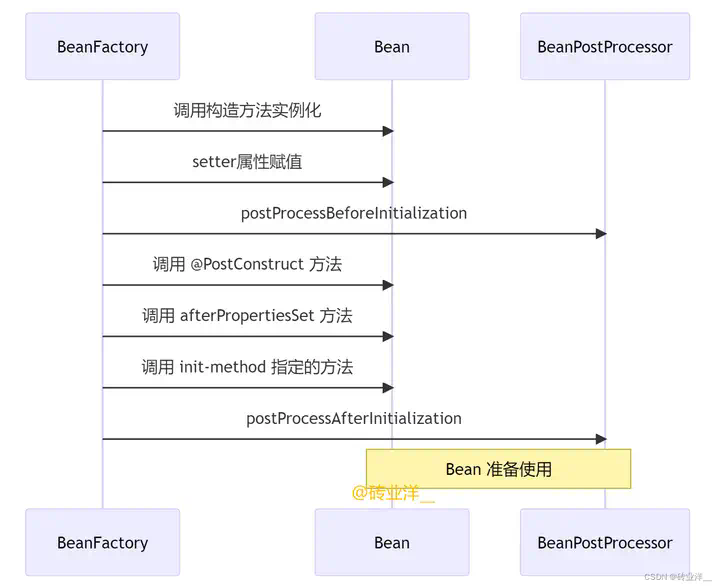

3.2 图解:Bean生命周期与后置处理器的交互时序

综合上面的执行结果,我们来总结一下,下面是Spring Bean生命周期的时序图,它详细地描绘了Spring Bean从实例化到准备使用的整个过程,包括Bean的实例化、属性赋值、生命周期方法的执行和后置处理器的调用。

关注,第一时间了解华为云新鲜技术~

摘要:随着企业数据空间在内部的成功实践,2022年,华为正式推出云服务产品——华为云交换数据空间EDS(Exchange Data Space),秉持“你的数据你做主”的宗旨,以保护企业数据主权为基础,促进企业数据高效流通,实现数据价值最大化。

本文分享自华为云社区《数据交换不失控——华为云EDS,让你的数据你做主》,作者:开天aPaaS小助手。

数字社会,每时每刻都有海量数据产生,数据也逐渐从生产过程的附属产物,逐渐成为数字经济的关键生产要素。作为生产要素,数据只有流通起来才能产生大规模的经济价值。

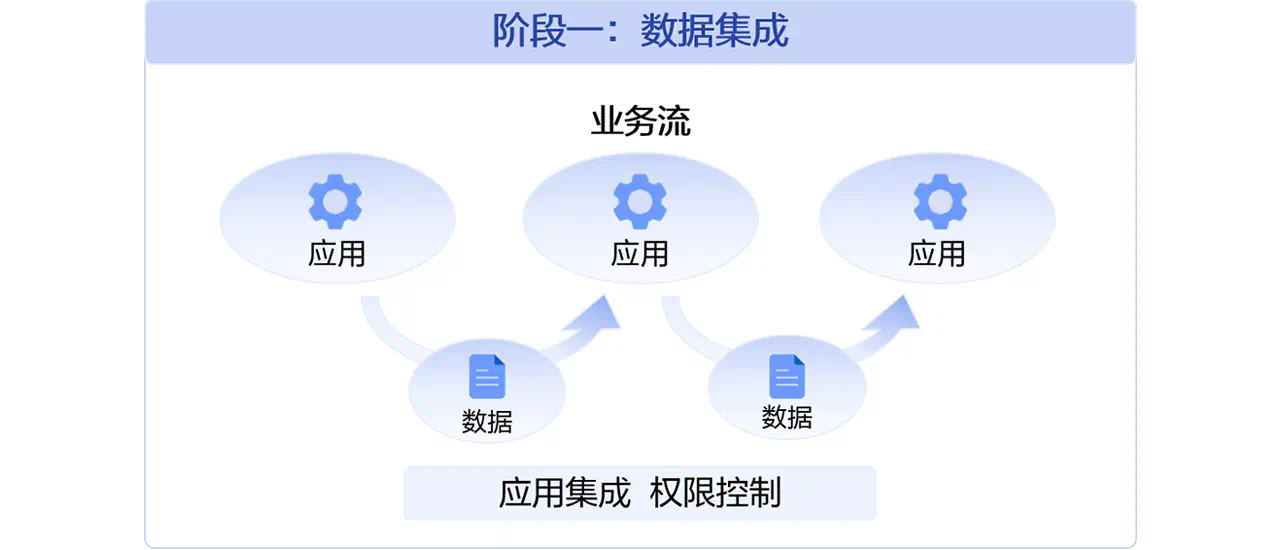

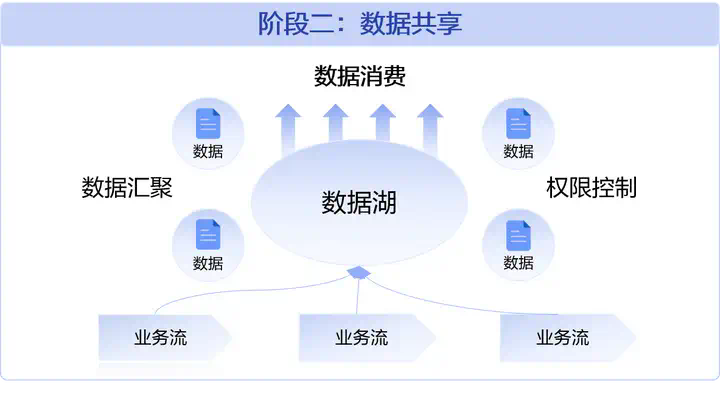

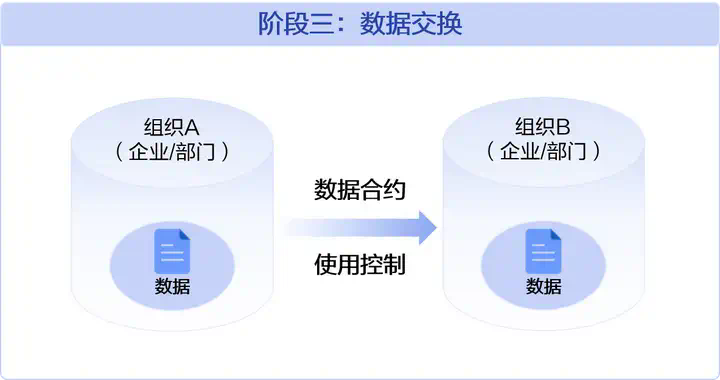

数据在企业中的流通模式经历了数据集成、数据共享到数据交换的三个阶段:

阶段一,数据沿着企业的业务流流通,主要是系统间的集成对接。

阶段二,企业开始通过跨业务的数据分析来支撑企业经营和日常运营,此时的数据流通就突破业务流的约束,通过数据汇聚实现数据在企业内的安全共享。

阶段三,随着数据成为生产要素,要素价值分配的特征使数据增值,并激发了数据进一步参与流通的动力。因此,企业数据的流通开始在数据集成和共享这两种模式的基础上,逐步以独立的生产要素的身份参与数据交换,释放要素价值。

华为的整个数据工作历程与之类似:

第一阶段,做数据清洁,使数据定义在不同系统中保持一致,把主业务打通。

第二阶段,打破数据的部门墙,把数据汇聚到数据底座再分享出去,华为有3000多个系统,这时候把重要的业务数据入到数据湖里,然后再加工做个服务开放出去。

第三阶段,此时数据范围扩大了,不仅是企业内部的共享,还需要和供应商、客户、其他组织进行交换,这就要建立数据空间,使数据能够可控的交换,使数据成为企业高质量发展的核心竞争力。

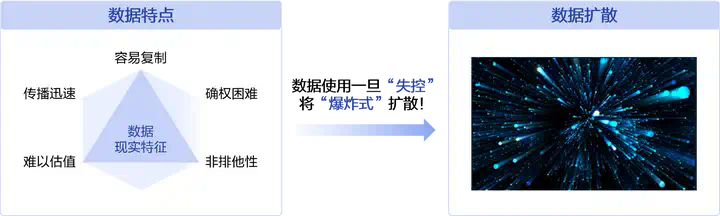

在这个数据交换的过程中,关键解决了数据的两个特征:

一个是非排他性,其他生产要素都是可以排他的,而数据是你可以用,他也可以用,没有排他性;第二个是数据复制的“零成本”。

不解决非排他性和零成本复制问题,企业不愿意把数据给出去,数据流通就做不起来。

2017年,华为作为国内第一家正式加入国际数据空间协会(IDSA)(首次提出主权保护的“数据空间”理念)的企业,开始对数据可控交换解决方案进行探索。

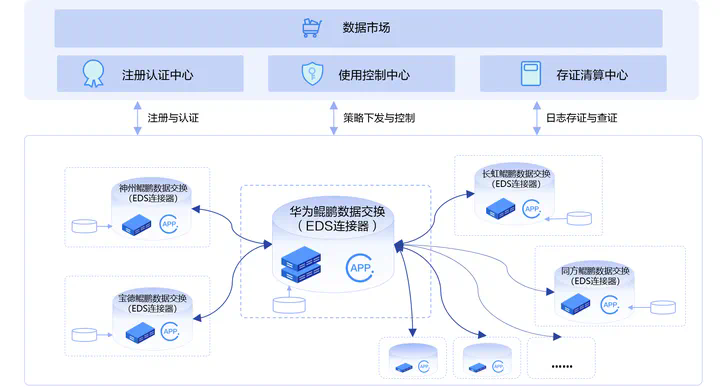

2021年,基于多年不断的探索成果和内部实际诉求,正式启动企业数据交换空间的内部试点建设。并成功在鲲鹏/昇腾生态、企业投后管理、财经外审等重点领域取得了一定的效果。

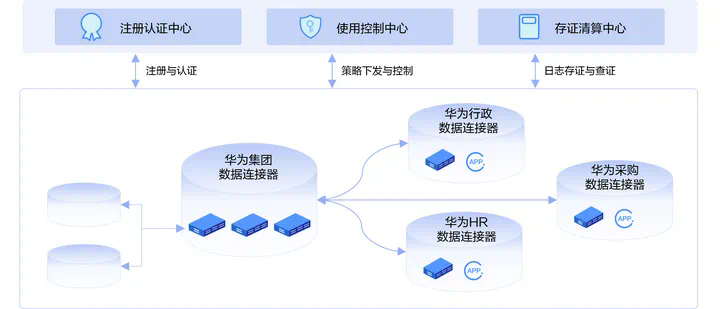

实践一:华为内部高密数据的跨领域安全共享

行政、HR、采购等领域开通数据空间,实现高密数据的安全共享,月均共享数据5000+,在确保数据安全的前提下,充分发挥数据价值。

实践二:华为生态产业链上下游数据的可控交换

EDS构建鲲鹏、昇腾两个生态数据交换空间,为15个上下游企业开通数据连接器,月均交换研发、供应、服务等领域数据3000+,支撑了质量追溯、产品开发协同等业务场景的可控数据交换。

随着企业数据空间在内部的成功实践,2022年,华为正式推出云服务产品——华为云交换数据空间EDS(Exchange Data Space),秉持“你的数据你做主”的宗旨,以保护企业数据主权为基础,促进企业数据高效流通,实现数据价值最大化。

华为云EDS在“可信、可控、可证”的框架基础上进行数据空间的关键设计,打造数据可控交换的全栈能力。

可信:构造多方信任的生态环境

通过资质评估、证书发放等环节,对组织、个人及技术组件进行可信认证,建立统一的信任机制,实现参与方身份与平台环境可信任。

可控:打造可组合的策略控制数据的使用

平台提供21种策略,在数据使用过程中基于策略(比如“有效期限、查看次数、是否下载” 等)做出相应的使用控制,确保在数据主权可控的基础上合规使用数据。

可证:支撑提供方查证追溯、消费方可免证清白

提供全流程可信、可视的审计追溯服务,支持提供方查证追溯,也能让消费方免证清白,同时为第三方监管提供相应的审计信息。

华为云EDS可用在多种数据交换场景中:

在企业内部,EDS可与企业内各部门间的系统对接集成,在现有业务中嵌入使用控制能力,使业务流程自动化,增强数据的管控和追溯能力。

在企业间的数据交换,EDS通过缔造数据合约型的契约管理,保障双方数据可控交换及交易,保证过程的机密性。

在产业上下游间敏感业务的可控交换,EDS可以让产业生态上下游多方参与,支持多种数据格式及多交换模式的双向交换。

华为云交换数据空间EDS自2022年作为一款云服务产品推出后,逐渐在外部医疗、工业等领域积累了一些成功实践。

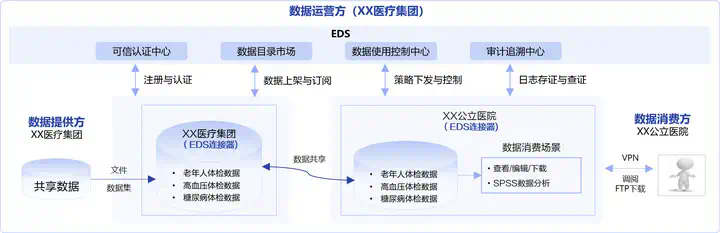

EDS助力XX医疗集团实现健康医疗数据安全共享

XX医疗集团拥有庞大的健康医疗数据,向公立医院、医疗科研机构、保险公司等组织进行数据共享时,存在数据共享不可控、不可追溯等安全隐患。

XX医疗集团基于华为云EDS构建数据交换空间,为公立医院、医疗科研机构等开通数据连接器,实现医疗数据的安全可控共享。既保护了各机构的医疗数据主权,也增强了行业互信,释放数据价值的同时,也提升了患者的就医体验。

华为云EDS“让你的数据你做主”!

了解更多:https://www.huaweicloud.com/product/eds.html

号外

7月7日,华为开发者大会2023 ( Cloud )将拉开帷幕,并将在国内30多个城市、海外10多个国家开设分会场,诚邀您参加这场不容错过的年度开发者盛会,让我们一起开启探索之旅!

我们将携手开发者、客户、合作伙伴,为您呈现华为云系列产品服务与丰富的创新实践,并与您探讨AI、大数据、数据库、PaaS、aPaaS、媒体服务、云原生、安全、物联网、区块链、开源等技术话题,展开全面深入的交流。

大会将汇聚全球科学家、行业领袖、技术专家、社区大咖,开设200多场开发者专题活动,为全球开发者提供面对面交流与合作的机会,共同探讨技术创新和业务发展。

大会官网:https://developer.huaweicloud.com/HDC.Cloud2023.html

参会购票:https://www.vmall.com/product/10086352254099.html?cid= 211761

参与开发者社区活动,观赏技术大咖秀、玩转技术梦工厂,有机会赢取4000开发者礼包!

欢迎关注“华为云开发者联盟”公众号,获取大会议程、精彩活动和前沿干货。

关注,第一时间了解华为云新鲜技术~

摘要:在本文中,我们将介绍如何使用Vue3和Spring Framework进行开发,并创建一个简单的TodoList应用程序。

本文分享自华为云社区《Vue3搭配Spring Framework开发【Vue3应用程序实战】》,作者:黎燃。

一、介绍

Vue3和Spring Framework都是现代Web应用程序开发中最流行的框架之一。

Vue3是一个流行的JavaScript框架,可以帮助我们构建交互式的前端应用程序。Spring Framework是一个流行的Java框架,可以帮助我们构建高性能的后端应用程序。在本文中,我们将介绍如何使用Vue3和Spring Framework进行开发,并创建一个简单的TodoList应用程序。

二、创建Vue3应用程序

首先,我们需要创建一个新的Vue3应用程序。我们可以使用Vue CLI来创建应用程序,具体步骤如下:

- 在终端中,使用以下命令安装Vue CLI:

- 创建一个新的Vue3应用程序:

- 选择默认配置,并等待Vue CLI安装所需的依赖项。

- 进入新创建的应用程序目录,并启动开发服务器:

现在,我们已经准备好使用Vue3来创建我们的TodoList应用程序了。

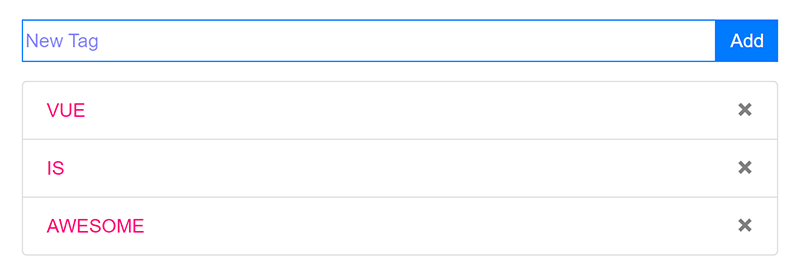

三、创建TodoList组件

接下来,我们需要创建一个Vue3组件来显示我们的TodoList。我们可以使用以下命令在src/components目录下创建一个新的组件文件:

然后,我们可以使用以下代码创建我们的TodoList组件:

在这里,我们使用了Vue3的数据绑定功能来将我们的TodoList数据渲染为HTML。我们使用v-for指令来循环渲染每个TodoList项目,并使用key属性来提高性能。

四、创建Spring控制器

现在,我们需要创建一个Spring控制器来处理我们的TodoList数据。我们可以使用以下命令在src/main/java/com/example/demo目录下创建一个新的Java文件:

然后,我们可以使用以下代码创建我们的Spring控制器:

在这里,我们使用了Spring Framework的@RestController注解来标记我们的控制器,并使用@GetMapping注解来指定HTTP GET请求的路径。我们的getTodos方法返回一个包含TodoList项目的字符串数组。

五、创建Vue3服务

接下来,我们需要创建一个Vue3服务来获取我们的TodoList数据。我们可以使用以下命令在src/services目录下创建一个新的JavaScript文件:

然后,我们可以使用以下代码创建我们的Vue3服务:

在这里,我们使用了Axios库来发出HTTP GET请求,并从我们的Spring控制器中获取TodoList数据。我们将baseUrl设置为我们的Spring控制器的路径。

六、将Vue3服务与组件集成

现在,我们已经准备好将我们的Vue3服务与我们的TodoList组件集成。我们可以使用以下代码更新我们的TodoList.vue组件:

在这里,我们将我们的Vue3服务导入我们的TodoList.vue组件,并在created生命周期钩子中使用await关键字来异步获取TodoList数据。

七、启动应用程序

现在,我们已经完成了我们的Vue3和Spring Framework应用程序的开发。我们可以使用以下命令启动我们的应用程序:

然后,我们可以在浏览器中访问http://localhost:8080来查看我们的TodoList应用程序。

八、总结

在本文中,我们介绍了如何使用Vue3和Spring Framework创建一个简单的TodoList应用程序。我们使用Vue CLI创建了一个新的Vue3应用程序,并创建了一个Vue3组件来显示我们的TodoList。然后,我们使用Spring Framework创建了一个控制器来处理我们的TodoList数据,并使用Axios库创建了一个Vue3服务来获取数据。最后,我们将我们的Vue3服务与我们的Vue3组件集成,并启动了我们的应用程序。希望这篇文章对您有所帮助!

关注,第一时间了解华为云新鲜技术~

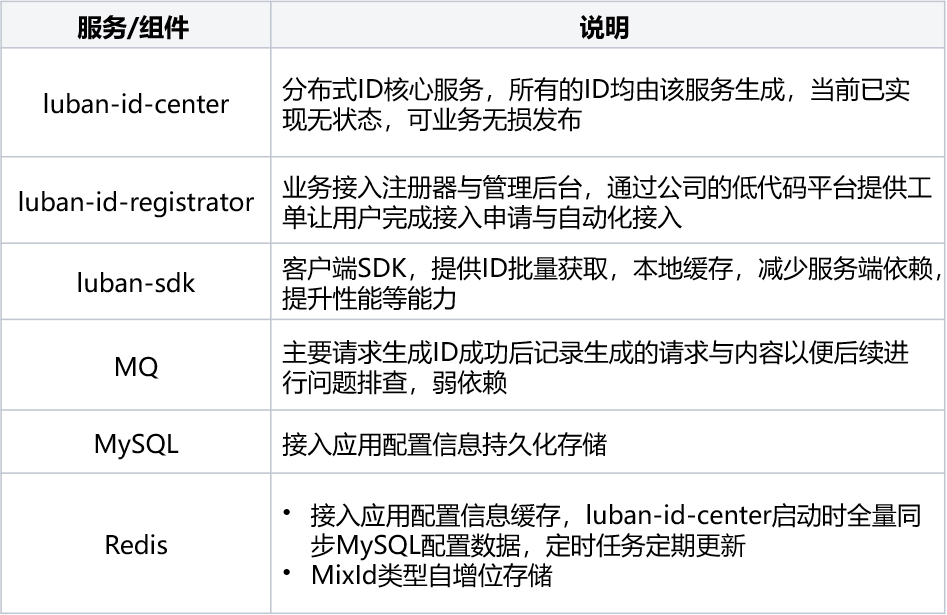

作者:vivo IT 平台团队- An Peng

本文介绍了什么是分布式ID,分布式ID的业务场景以及9种分布式ID的实现方式,同时基于vivo内部IT的业务场景,介绍了自研鲁班分布式ID服务的实践。

一、方案背景

1.1 分布式ID应用的场景

随着系统的业务场景复杂化、架构方案的优化演进,我们在克服问题的过程中,也总会延伸出新的技术诉求。分布式ID也是诞生于这样的IT发展过程中,在不同的关联模块内,我们需要一个全局唯一的ID来让模块既能并行地解耦运转,也能轻松地进行整合处理。以下,首先让我们一起回顾这些典型的分布式ID场景。

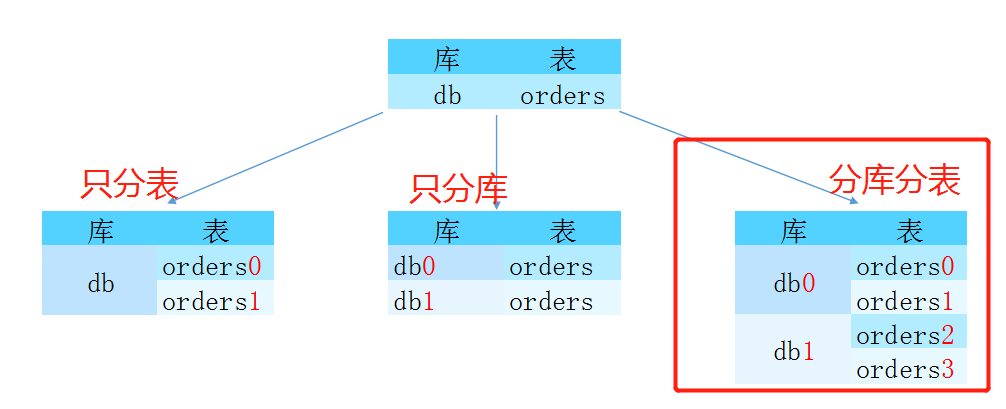

1.1.1 系统分库分表

随着系统的持续运作,常规的单库单表在支撑更高规模的数量级时,无论是在性能或稳定性上都已经难以为继,需要我们对目标逻辑数据表进行合理的物理拆分,这些同一业务表数据的拆分,需要有一套完整的 ID生成方案来保证拆分后的各物理表中同一业务ID不相冲突,并能在后续的合并分析中可以方便快捷地计算。

以公司的营销系统的订单为例,当前不但以分销与零售的目标组织区别来进行分库存储,来实现多租户的数据隔离,并且会以订单的业务属性(订货单、退货单、调拔单等等)来进一步分拆订单数据。在订单创建的时候,根据这些规则去构造全局唯一ID,创建订单单据并保存在对应的数据库中;在通过订单号查询时,通过ID的规则,快速路由到对应的库表中查询;在BI数仓的统计业务里,又需要汇总这些订单数据进行报表分析。

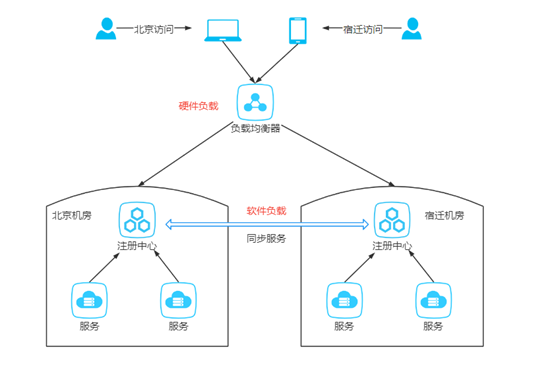

1.1.2 系统多活部署

无论是面对着全球化的各国数据合规诉求,还是针对容灾高可用的架构设计,我们都会对同一套系统进行多活部署。多活部署架构的各单化服务,存储的单据(如订单/出入库单/支付单等)均带有部署区域属性的ID结构去构成全局唯一ID,创建单据并保存在对应单的数据库中,在前端根据单据号查询的场景,通过ID的规则,可快速路由到对应的单区域进行查询。对应多活部署架构的中心化服务,同步各单的单据数据时,单据的ID是全局唯一,避免了汇聚数据时的ID冲突。

在公司的系统部署中,公共领域的 BPM 、待办、营销领域的系统都大范围地实施多活部署。

1.1.3 链路跟踪技术

在微服务架构流行的大背景下,此类微服务的应用对比单体应用的调用链路会更长、更复杂,对问题的排查带来了挑战,应对该场景的解决方案,会在流量入口处产生全局唯一的TraceID,并在各微服务之间进行透传,进行流量染色与关联,后续通过该全局唯一的TraceID,可快速地查询与关联全链路的调用关系与状态,快速定位根因问题。

在公司的各式各样的监控系统、灰度管理平台、跨进程链路日志中,都会伴随着这么一个技术组件进行支撑服务。

1.2 分布式ID核心的难点

-

唯一性: 保持生成的ID全局唯一,在任何情况下也不会出现重复的值(如防止时间回拔,时钟周期问题)。

-

高性能: ID的需求场景多,中心化生成组件后,需要高并发处理,以接近 0ms的响应大规模并发执行。

-

高可用: 作为ID的生产源头,需要100%可用,当接入的业务系统多的时候,很难调整出各方都可接受的停机发布窗口,只能接受无损发布。

-

易接入: 作为逻辑上简单的分布式ID要推广使用,必须强调开箱即用,容易上手。

-

规律性: 不同业务场景生成的ID有其特征,例如有固定的前后缀,固定的位数,这些都需要配置化管理。

1.3 分布式ID常见的方案

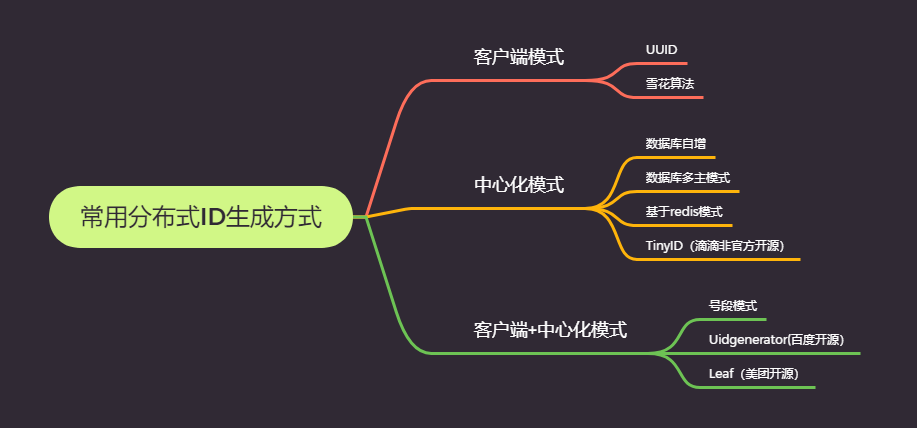

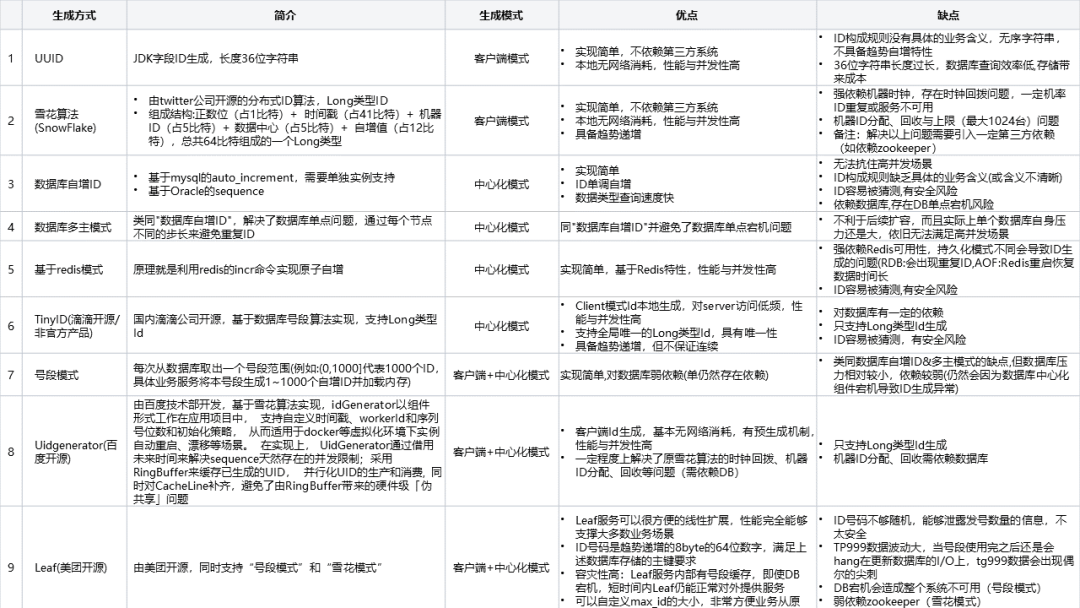

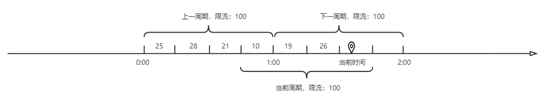

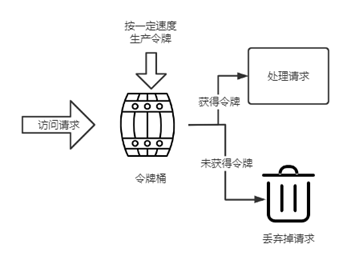

常用系统设计中主要有下图9种ID生成的方式:

1.4 分布式ID鲁班的方案

我们的系统跨越了公共、生产制造、营销、供应链、财经等多个领域。在分布式ID诉求下还有如下的特点:

-

在业务场景上除了常规的Long类型ID,也需要支持“String类型”、“MixId类型”(后详述)等多种类型的ID生成,每一种类型也需要支持不同的长度的ID。

-

在ID的构成规则上需要涵盖如操作类型、区域、代理等业务属性的标识;需要集中式的配置管理。

-

在一些特定的业务上,基于安全的考虑,还需要在尾部加上随机数来保证ID不能被轻易猜测。

综合参考了业界优秀的开源组件与常用方案均不能满足,为了统一管理这类基础技术组件的诉求,我们选择基于公司业务场景自研一套分布式ID服务:鲁班分布式ID服务。

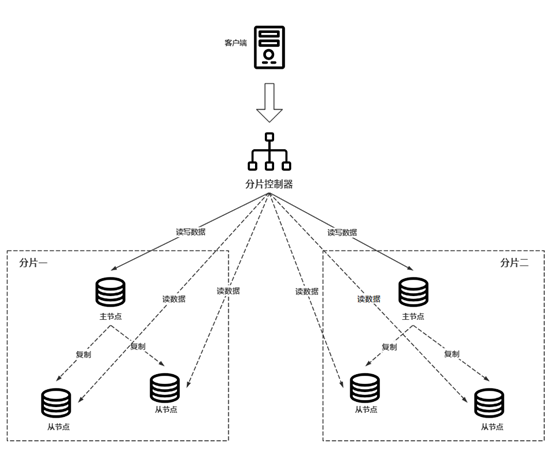

二、系统架构

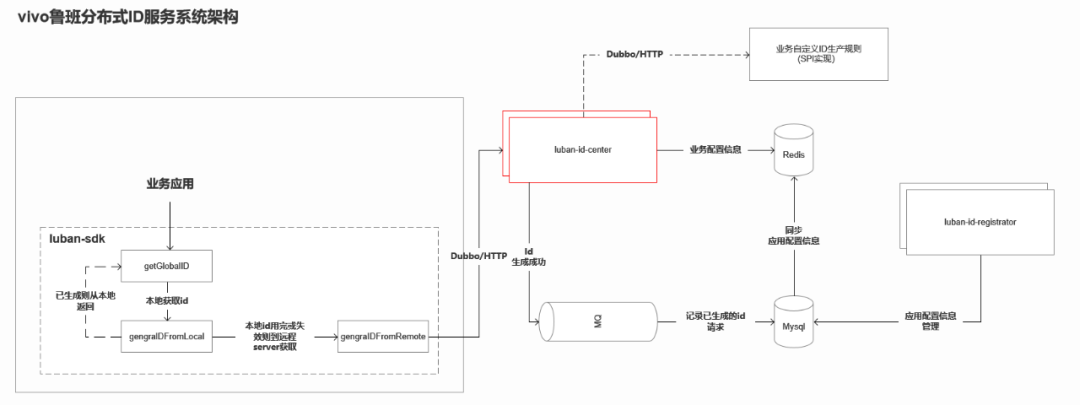

2.1 架构说明

三、 设计要点

3.1 支持多种类型的ID规则

目前鲁班分布式ID服务共提供”Long类型“、“String类型”、“MixId类型”等三种主要类型的ID,相关ID构成规则与说明如下:

3.1.2 Long类型

(1)构成规则

静态结构由以下三部分数据组成,组成部分共19位:

-

固定部分(4位):

由FixPart+ServerPart组成。

① FixPart(4位):由大区zone 1位/代理 agent 1位/项目 project 1位/应用 app 1位,组成的4位数字编码。

② ServerPart(4位):用于定义产生全局ID的服务器标识位,服务节点部署时动态分配。

-

动态部分DynPart(13位):

System.currentTimeMillis()-固定配置时间的TimeMillis (可满足使用100年)。

-

自增部分SelfIncreasePart(2位):用于在全局ID的客户端SDK内部自增部分,由客户端SDK控制,业务接入方无感知。共 2位组成。

(2)降级机制

主要自增部分在服务器获取初始值后,由客户端SDK维护,直到自增99后再次访问服务端获取下一轮新的ID以减少服务端交互频率,提升性能,服务端获取失败后抛出异常,接入业务侧需介入进行处理。

(3)样例说明

3.1.2 String类型

(1)构成规则

静态结构由以下五部分数据组成,组成部分共25~27位:

-

固定部分操作位op+FixPart(9~11位):

① 操作位op(2~4位):2~4位由业务方传入的业务类型标识字符。

② FixPart(7位):业务接入时申请获取,由大区zone 1位,代理 agent 2位,项目 project 2位,应用 app 2位组成。

-

服务器标识部分 ServerPart(1位): 用于定义产生全局ID的服务器标识位,服务节点部署时动态分配A~Z编码。

-

动态部分DynPart(9位):

System.currentTimeMillis()-固定配置时间的TimeMillis ,再转换为32进制字符串(可满足使用100年)。

-

自增部分SelfIncreasePart(3位):用于在全局ID的客户端SDK内部自增部分,由客户端SDK控制,业务接入方无感知。

-

随机部分secureRandomPart(3位):用于在全局ID的客户端SDK的随机部分,由SecureRandom随机生成3位0-9,A-Z字母数字组合的安全随机数,业务接入方无感知。

(2)降级机制

主要自增部分由客户端SDK内部维护,一般情况下只使用001–999 共999个全局ID。也就是每向服务器请求一次,都在客户端内可以自动维护999个唯一的全局ID。特殊情况下在访问服务器连接出问题的时候,可以使用带字符的自增来做服务器降级处理,使用产生00A, 00B… 0A0, 0A1,0A2….ZZZ. 共有36 * 36 * 36 – 1000 (999纯数字,000不用)= 45656个降级使用的全局ID。

(3)样例说明

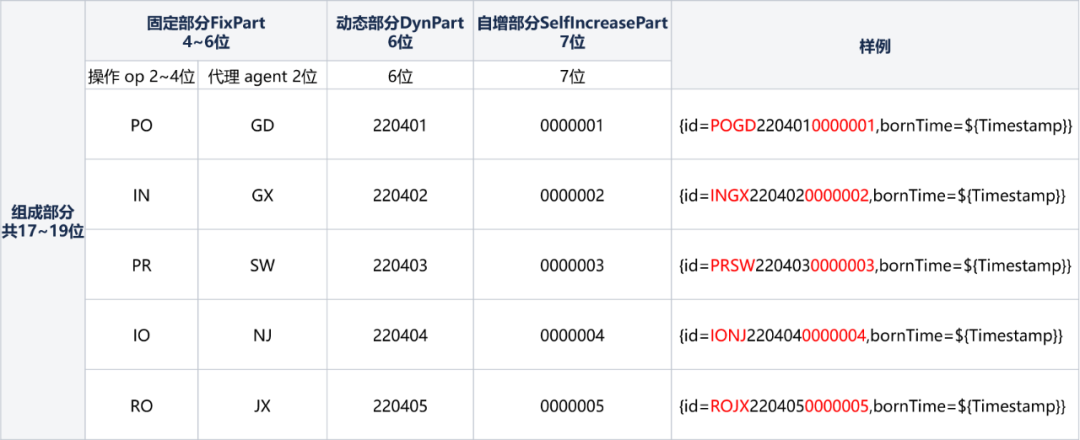

3.1.3 MixId类型

(1)构成规则

静态结构由以下三部分数据组成,组成部分共17位:

-

固定部分FixPart(4~6位):

① 操作位op(2~4位):2~4位由业务方传入的业务类型标识字符

② FixPart(2位):业务接入时申请获取由代理 agent 2位组成。

-

动态部分DynPart(6位): 生成ID的时间,年(2位)月(2位)日(2位)。

-

自增部分SelfIncreasePart(7位):用于在全局ID的客户端SDK内部自增部分,由客户端SDK控制,业务接入方无感知。

(2)降级机制

无,每次ID产生均需到服务端请求获取,服务端获取失败后抛出异常,接入业务侧需介入进行处理。

(3)样例说明

3.2 业务自定义ID规则实现

鲁班分布式ID服务内置“Long类型”,“String类型”,“MixId类型”等三种长度与规则固定的ID生成算法,除以上三种类型的ID生成算法外,业务侧往往有自定义ID长度与规则的场景诉求,在鲁班分布式ID服务内置ID生成算法未能满足业务场景时,为了能在该场景快速支持业务,鲁班分布式ID服务提供了业务自定义接口并通过SPI机制在服务运行时动态加载,以实现业务自定义ID生成算法场景的支持,相关能力的实现设计与接入流程如下:

(1)ID的构成部分主要分FixPart、DynPart、SelfIncreasePart三个部分。

(2)鲁班分布式ID服务的客户端SDK提供

LuBanGlobalIDClient的接口与getGlobalId(…)/setFixPart(…)/setDynPart(…)/setSelfIncreasePart(…)等四个接口方法。

(3)业务侧实现LuBanGlobalIDClient接口内的4个方法,通过SPI机制在业务侧服务进行加载,并向外暴露出HTTP或DUBBO协议的接口。

(4)用户在鲁班分布式ID服务管理后台对自定义ID生成算法的类型名称与服务地址信息进行配置,并关联需要使用的AK接入信息。

(5)业务侧使用时调用客户端SDK提供的LuBanGlobalIDClient的接口与getGlobalId方法,并传入ID生成算法类型与IdRequest入参对象,鲁班分布式ID服务接收请求后,动态识别与路由到对应ID生产算法的实现服务,并构建对象的ID返回给客户端,完成整个ID生成与获取的过程。

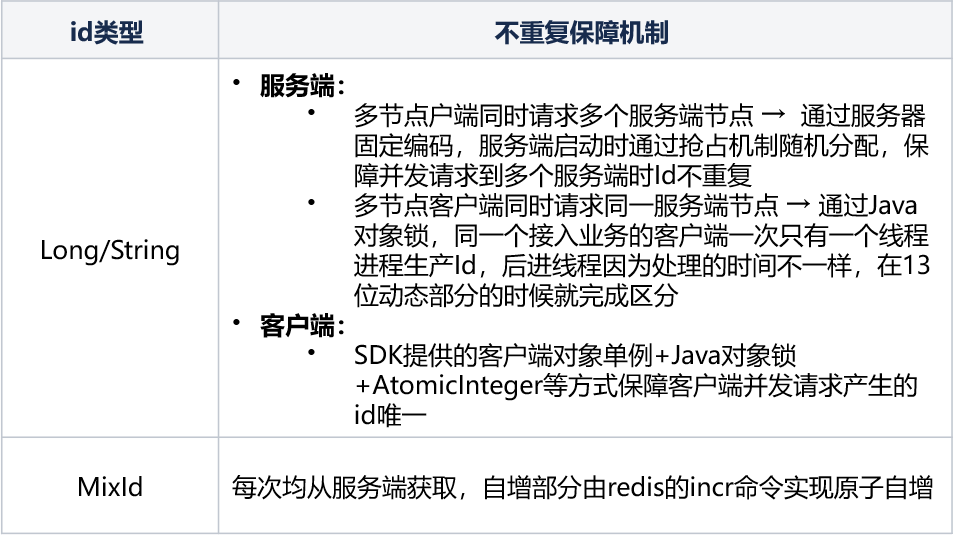

3.3 保证ID生成不重复方案

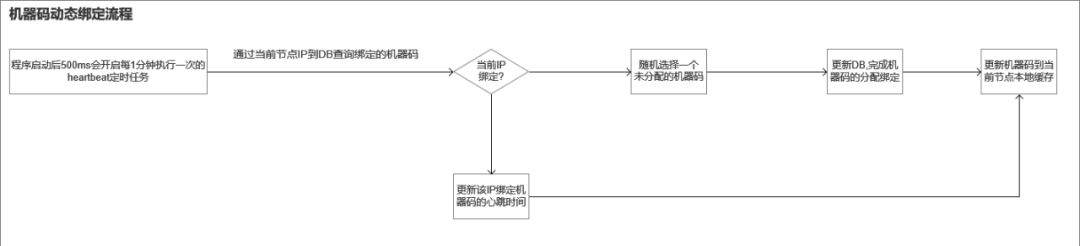

3.4 ID服务无状态无损管理

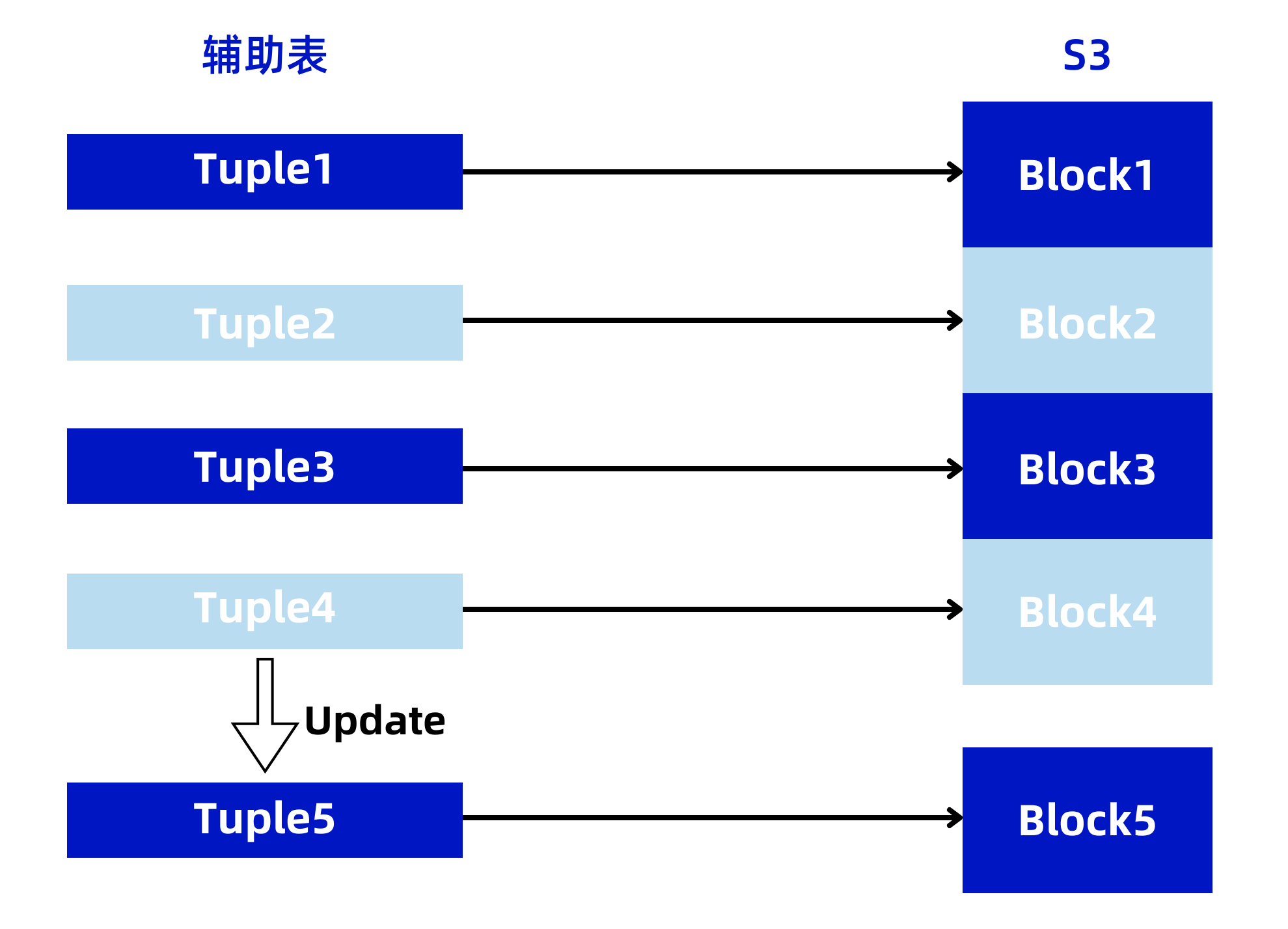

服务部署的环境在虚拟机上,ip是固定,常规的做法是在配置表里配置ip与机器码的绑定关系(这样在服务扩缩容的时候就需要人为介入操作,存在一定的遗漏配置风险,也带来了一定的运维成本),但在容器的部署场景,因为每次部署时IP均是动态变化的,以前通过配置表里ip与机器码的映射关系的配置实现方式显然不能满足运行在容器场景的诉求,故在服务端设计了通过心跳上报实现机器码动态分配的机制,实现服务端节点ip与机器码动态分配、绑定的能力,达成部署自动化与无损发布的目的。

相关流程如下:

【注意】

服务端节点可能因为异常,非正常地退出,对于该场景,这里就需要有一个解绑的过程,当前实现是通过公司平台团队的分布式定时任务服务,检查持续5分钟(可配置)没有上报心跳的机器码分配节点进行数据库绑定信息清理的逻辑,重置相关机器码的位置供后续注册绑定使用。

3.5 ID使用方接入SDK设计

SDK设计主要以”接入快捷,使用简单“的原则进行设计。

(1)接入时:

鲁班分布式ID服务提供了spring-starter包,应用只需再pom文件依赖该starter,在启动类里添加@EnableGlobalClient,并配置AK/SK等租户参数即可完成接入。

同时鲁班分布式ID服务提供Dubbo & Http的调用方式,通过在启动注解配置accessType为HTTP/DUBBO来确定,SDK自动加载相关依赖。

(2)使用时:

根据”Long“、”String“、”MixId“等三种id类型分别提供GlobalIdLongClient、

GlobalIdStringClient、GlobalIdMixIDClient等三个客户端对象,并封装了统一的入参RequestDTO对象,业务系统使用时只需构建对应Id类型的RequestDTO对象(支持链式构建),并调用对应id类型的客户端对象getGlobalID(GlobalBaseRequestDTO

globalBaseRequestDTO)方法,即可完成ID的构建。

Long类型Id获取代码示例

3.6 关键运行性能优化场景

3.6.1 内存使用优化

在项目上线初时,经常发生FGC,导致服务停顿,获取ID超时,经过分析,鲁班分布式ID服务的服务端主要为内存敏感的应用,当高并发请求时,过多对象进入老年代从而触发FGC,经过排查主要是JVM内存参数上线时是使用默认的,没有经过优化配置,JVM初始化的内存较少,高并发请求时JVM频繁触发内存重分配,相关的对象也流程老年代导致最终频繁发送FGC。

对于这个场景的优化思路主要是要相关内存对象在年轻代时就快速经过YGC回收,尽量少的对象进行老年代而引起FGC。

基于以上的思路主要做了以下的优化:

-

增大JVM初始化内存(-Xms,容器场景里为-XX:InitialRAMPercentage)

-

增大年轻代内存(-Xmn)

-

优化代码,减少代码里临时对象的复制与创建

3.6.2 锁颗粒度优化

客户端SDK再自增值使用完或一定时间后会向服务端请求新的id生成,这个时候需要保证该次请求在多线程并发时是只请求一次,当前设计是基于用户申请ID的接入配置,组成为key,去获取对应key的对象锁,以减少同步代码块锁的粒度,避免不同接入配置去在并发去远程获取新的id时,锁粒度过大,造成线程的阻塞,从而提升在高并发场景下的性能。

四、 业务应用

当前鲁班分布式ID服务日均ID生成量亿级,平均RT在0~1ms内,单节点可支持 万级QPS,已全面应用在公司IT内部营销订单、支付单据、库存单据、履约单据、资产管理编码等多个领域的业务场景。

五、未来规划

在可用性方面,当前鲁班分布式ID服务仍对Redis、Mysql等外部DB组件有一定的依赖(如应用接入配置信息、MixId类型自增部分ID计数器),规划在该依赖极端宕机的场景下,鲁班分布式ID服务仍能有一些降级策略,为业务提供可用的服务。

同时基于业务场景的诉求,支持标准形式的雪花算法等ID类型。

六、 回顾总结

本文通过对分布式ID的3种应用场景,实现难点以及9种分布式ID的实现方式进行介绍,并对结合vivo业务场景特性下自研的鲁班分布式id服务从系统架构,ID生成规则与部分实现源码进行介绍,希望对本文的阅读者在分布式ID的方案选型或自研提供参考。

END

猜你喜欢

vivo鲁班RocketMQ平台的消息灰度方案

-

vivo 自研Jenkins资源调度系统设计与实践

-

浅析 Jetty 中的线程优化思路

-

“事后达尔文”—— 游戏业务效果评估方法实践

作者:vivo 互联网运维团队- Peng Jiahong

本文介绍了vivo业务运维证书管理从手工到平台化的历程。

一、背景

以往,vivo 互联网业务的域名证书运维管理工作,严重依赖经验丰富的高级运维工程师个人专职管理,证书管理存在单点以及过于依赖的人的情况。

随着业务规模的持续扩大,以及对证书管理质量标准的要求提升,加强全网证书信息准确的收敛把控。

为此,业务运维团队决定,通过证书管理流程标准化、平台化,完成全生命周期管理证书,来消除因依赖人为管理证书问题导致业务可用性受损的痛点。

二、能力规划

全生命周期管理业务证书,我们建设的平台需具备以下特性和能力:

-

高效的证书申请:

新申请以及续期场景,平台引导用户自动的生成私钥和 CSR 并提交工作申请联络单,用户完成验证后自动存储证书合并私钥。

-

便捷的证书管理:

支持多种证书格式导入、导出功能,查看完整的证书信息。

-

安全的私钥存储:

使用 AES256 等 高强度算法加密存储。

-

证书逾期监控:

支持 30/60 天,可自定义逾期的证书监控告警。

-

证书变更白屏化:

覆盖 NGINX、 SLB、CDN 以及 VUA 证书变更场景。

三、设计思路

3.1 技术选型

(1)前端框架:

用基于Vue2的Element构建基础页面

(2)后端框架:

以 Go 语言为基础,快速利用gin框架提供restful的api,业务数据存储在MySQL

3.2 架构设计

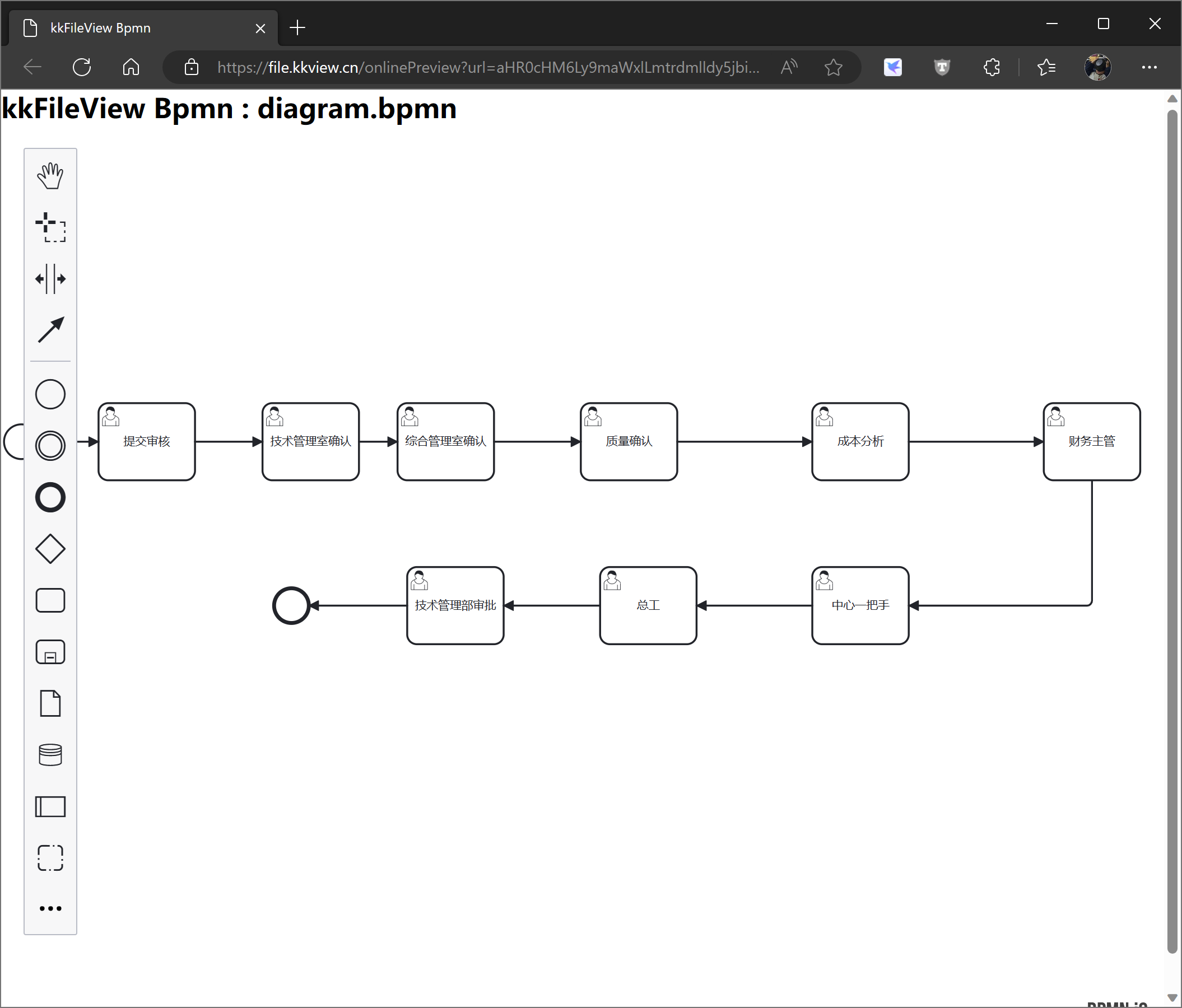

证书管理平台整体架构设计:

3.3 模块设计

证书管理平台包含四个非常重要的子模块:

-

可视:

是整个平台最基础的模块,除基础的权限功能外,通过收敛汇总所以证书信息,实现证书总览数据分析,证书的操作的追溯以及变更审计和操作可视化。

-

管理:

是证书信息管理的核心功能之一,实现证书信息的可视化以及信息变更、证书申请、证书续期的能力。

-

变更:

提供 NGINX、SLB、CDN、VUA 证书的推送能力。

-

监控:

提供证书的生命周期检测、有效期提醒、线上证书扫描的能力。

四、技术实现

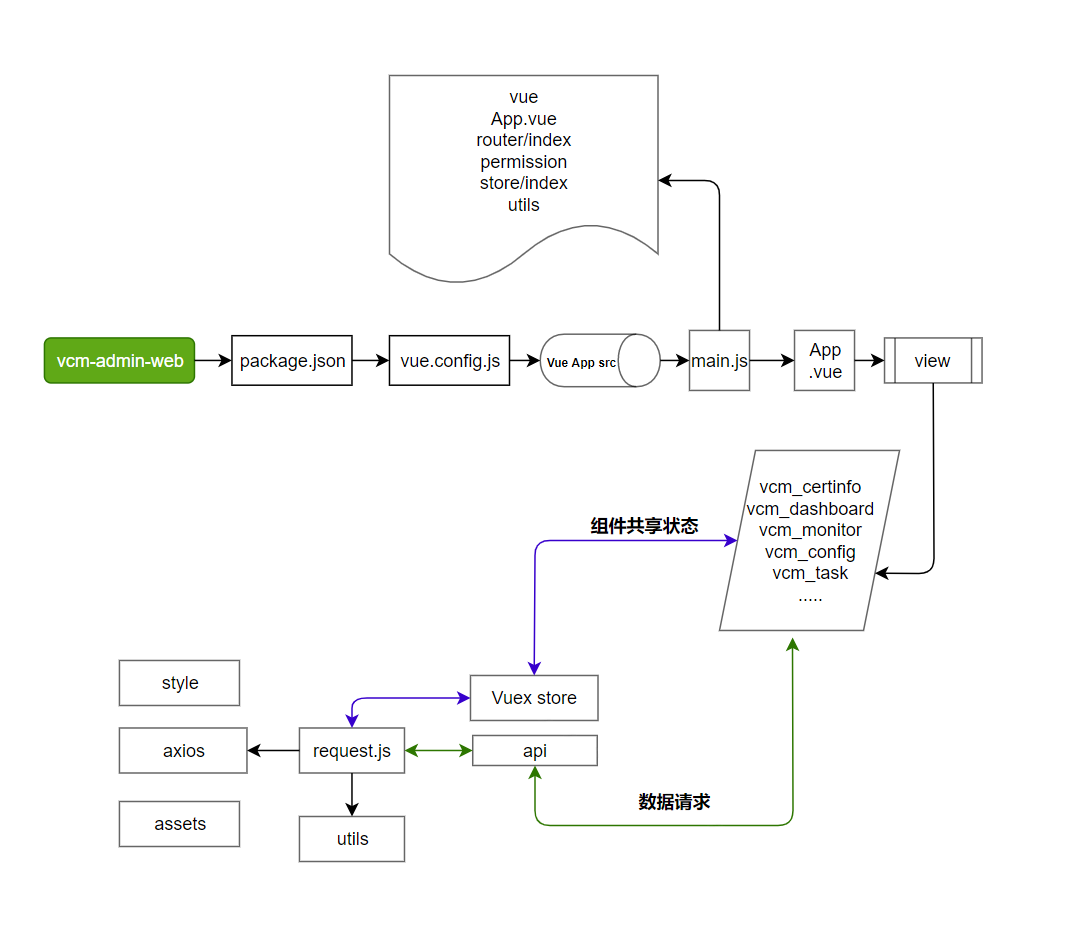

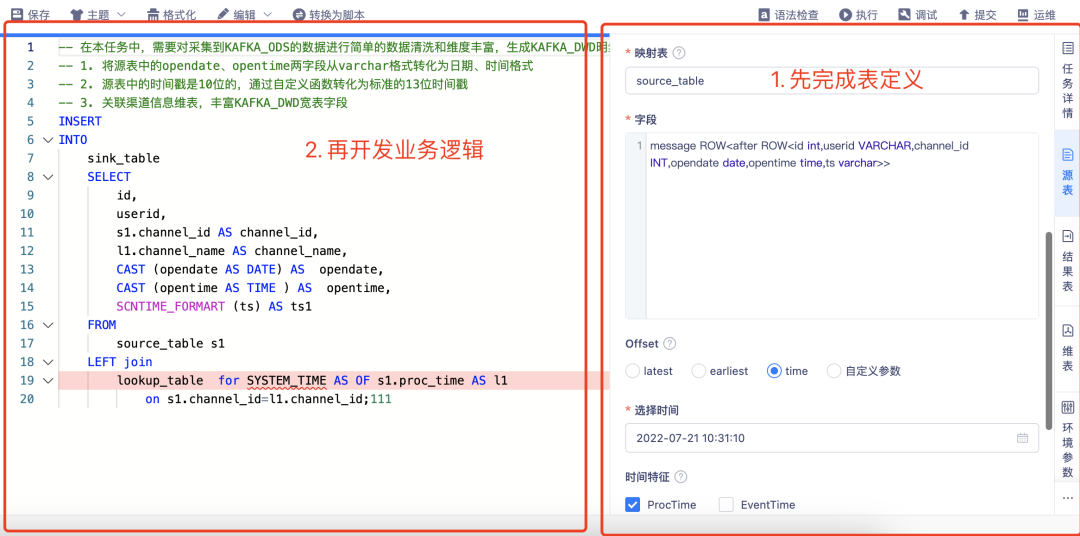

4.1 前端

前端是基于Vue2和Element来组建用户的操作界面,整个详细的设计图如下:

其中

-

main.j包含整个业务系统落地所需要的各类组件和素,实现组件 的提供以及基础的权限校验;

-

api的方法通过合理的封装后端的接口,提供view中呈现给用户的界面调用方法,来实现整个证书管理的业务流程操作。

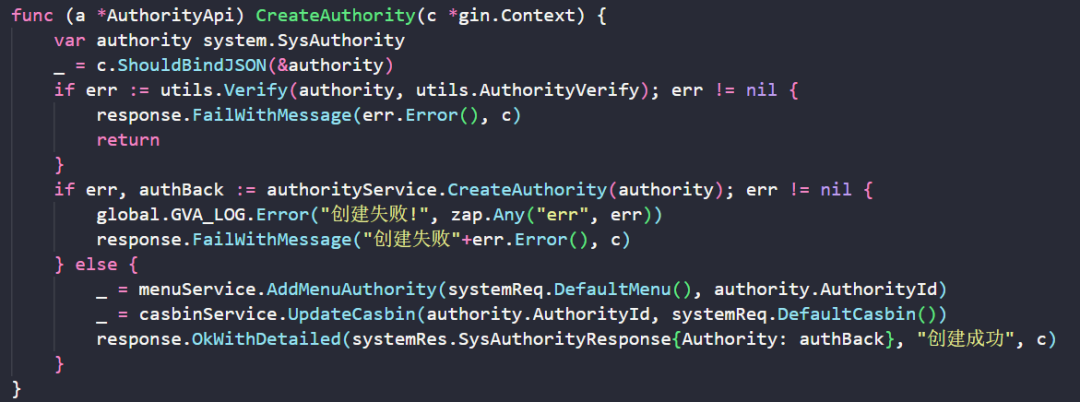

4.2 后端

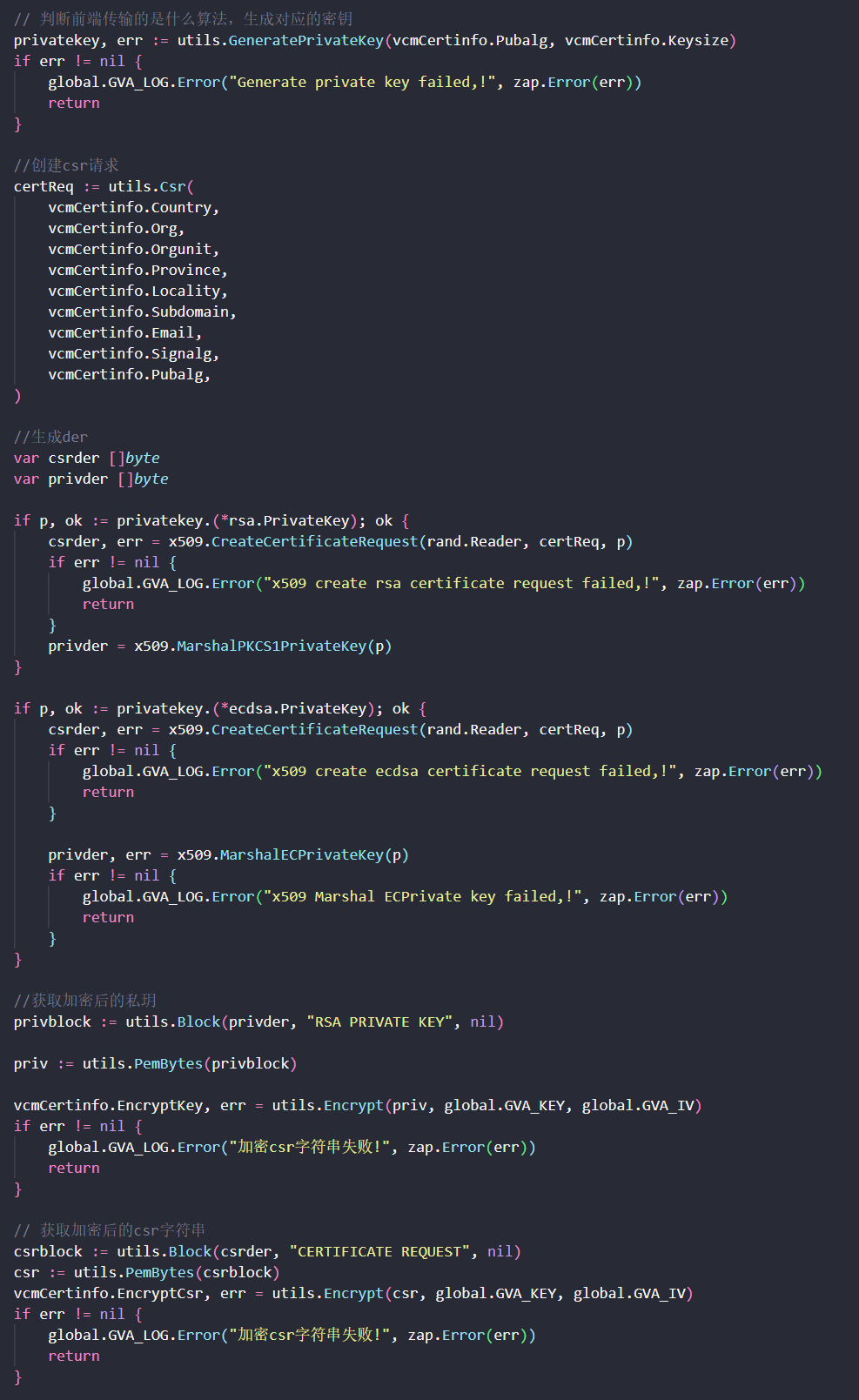

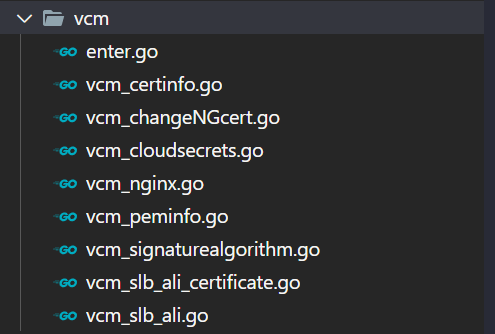

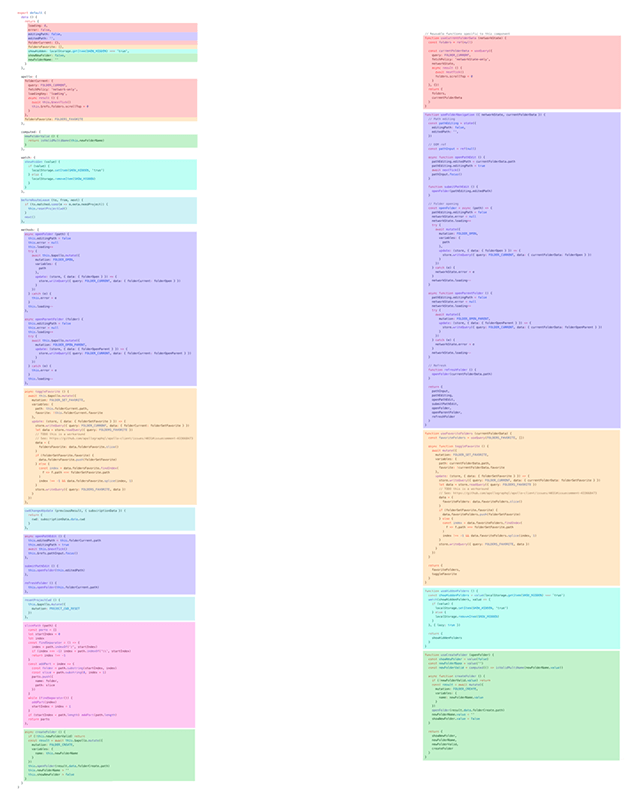

后端使用Go语言来编写业务逻辑和API接口。其中架构可以参考3.2设计图,管理平台核心逻辑通过代码片段展示如下:

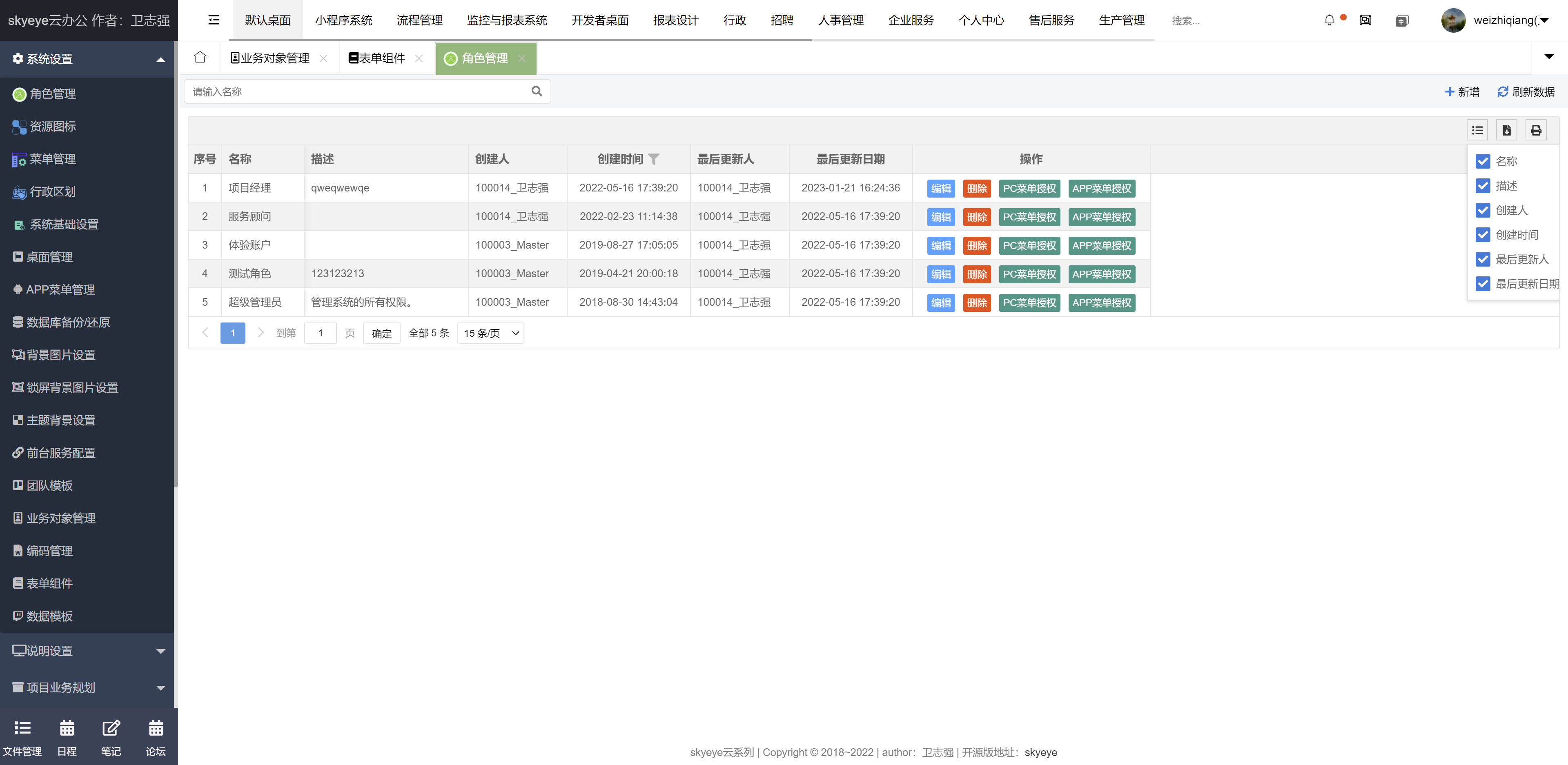

(1)基于casbin实现的权限管理:通过角色控制权限,并按需赋予用户角色默认访问权限(如下图创建角色时AddMenuAuthority、UpdateCasbin方法)。

(2)证书相关数据加密处理:获取前端用户选择的相关算法进行加密。

(3)基于证书管理标准化流程的业务代码实现,覆盖证书的信息管理&变更推送&监控告警&平台的角色权限控制。

五、平台预览

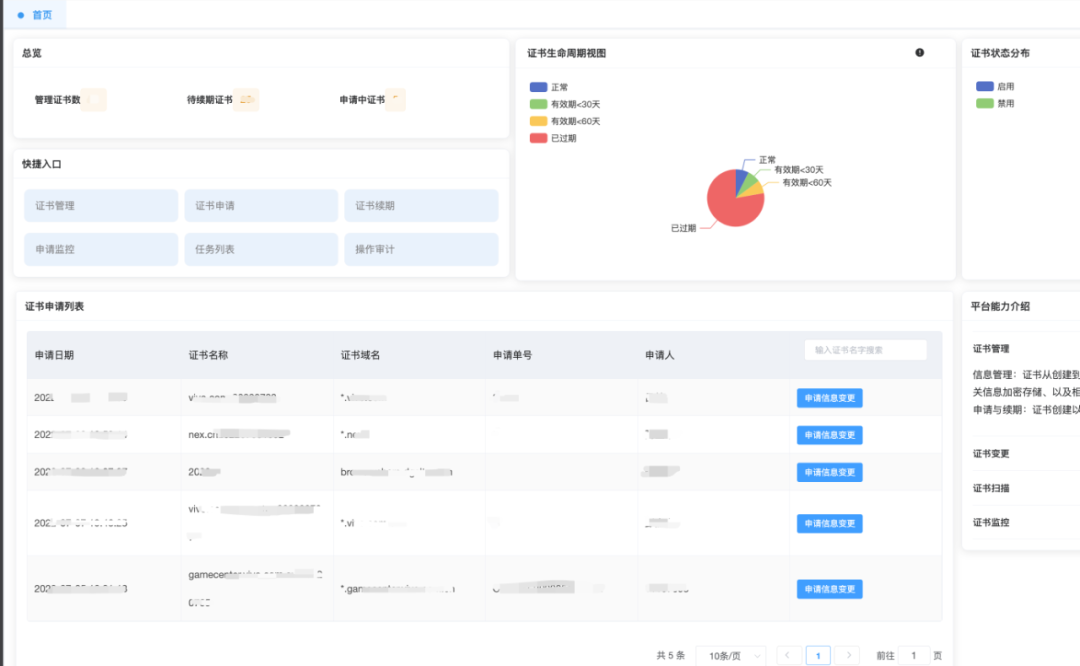

经过多个开发迭代,平台相关的核心功能如下:

5.1 证书信息概览

概览首页收敛证书管理的功能入口,以及收纳管理证书的全貌,方便管理员了解所管理的证书状态和最近的申请进度。

5.2 证书信息管理

汇总了目前内销所有证书信息,后续平台上申请的证书信息管理也会收敛于此,并提供证书私钥相关的查看和下载。

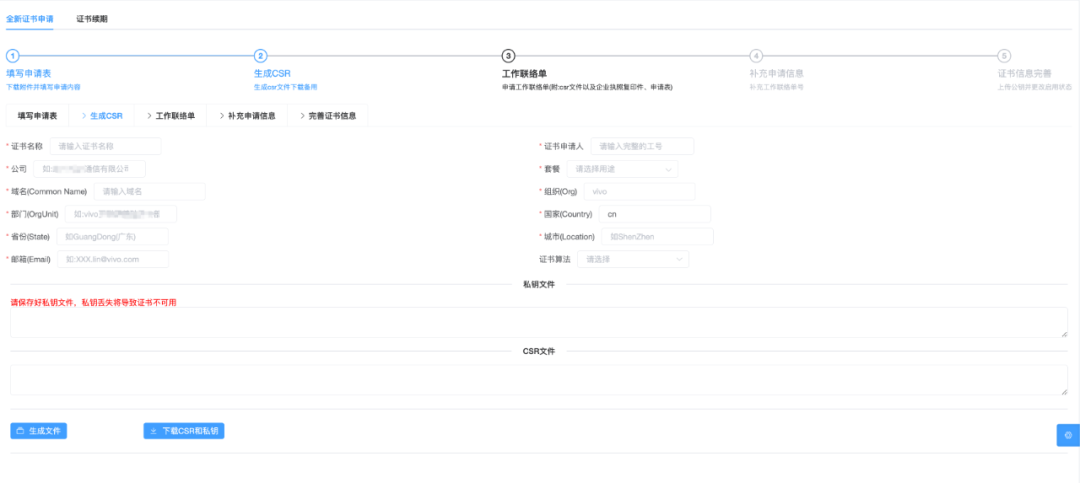

5.3 证书申请/续期

通过平台场景化证书申请续期的操作,解决过往碎片化操作以及无经验人员需通过文档阅读或者人员指导完成证书申请问题。

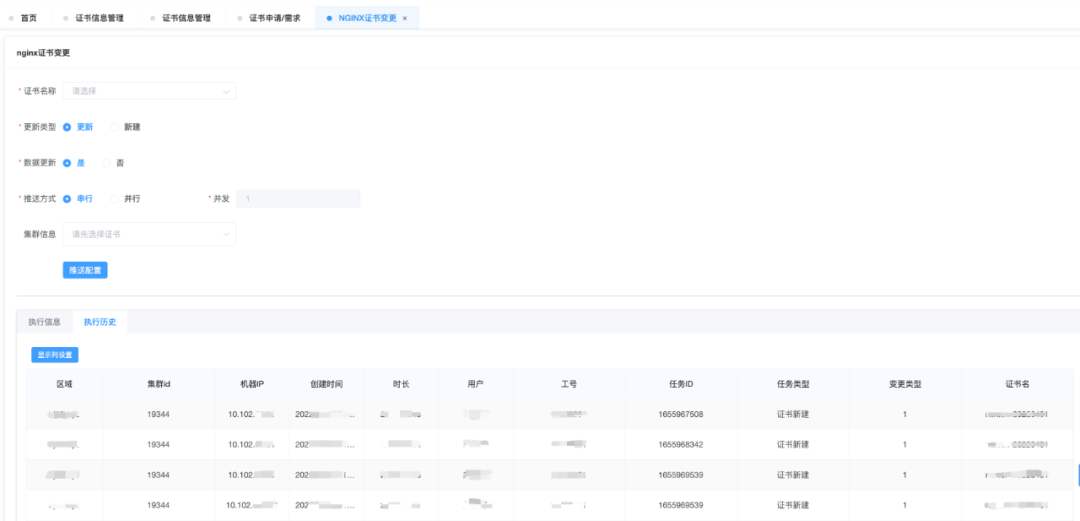

5.4 证书变更管理

平台覆盖云上、NGINX 集群、CDN 以及 VUA 的证书白屏化、可追溯操作历史更新能力。

5.5 证书监控

收敛在平台上管理的证书都会有逾期监控提醒,来提醒运维人员及时完成对应的证书更新管理,确保业务不受影响。

六、总结

证书管理平台的实践落地,通过流程标准化以及管理平台的建立,规范证书的信息、变更、告警、变更审计相关管理,上线后至今,也无证书管理相关的问题导致的可用性告警,解决了传统域名证书管理场景下人效、可用性隐患的痛点,是业务运维 SRE 可用性保障&运维提效的一个成功案例。

七、展望

目前我们获取的证书,依旧依赖于传统的域名证书分发模式(站点管理员需要花费金钱购买数字证书,并且证书的签发和更新需要时间和人力成本)。随着区块链和Web 3.0技术的发展,新增了去中心化身份验证和身份管理技术,在证书的分发上具备以下优势:

-

不可篡改性:

区块链技术保证证书的安全性和不可篡改性。因为每一个区块链节点都会对交易进行验证和记录,从而保证数据的一致性和完整性,防止伪造和篡改。

-

透明性:

区块链技术使得所有参与者都可以获得统一的信息,从而保证证书的透明性,避免信息不对称或不公平的情况发生,同时也可以有效地降低信息传递成本。

-

保密性:

区块链技术可以采用加密算法,保证证书的保密性和隐私性。同时,也可以根据需求设定只允许特定的参与者访问相关信息。

-

高效性:

传统的证书分发需要进行大量的人力和物力投入,而基于区块链的证书分发可以实现自动化,从而提高证书分发的效率。

-

可追溯性:

基于区块链的证书分发可以实现对证书的溯源和追踪,从而可以更好地防止证书的丢失或滥用。

综上所述,基于区块链的证书分发可以有效降低证书分发的成本和提高证书的安全性。

未来,基于相关技术的成熟程度,也会合理的应用和替换过往的证书申请分发模式,迭代证书管理平台相关的功能,来配合提高证书的管理效率和安全性。

END

猜你喜欢

浅析 Jetty 中的线程优化思路

-

“事后达尔文”—— 游戏业务效果评估方法实践

-

vivo 帐号服务稳定性建设之路-平台产品系列06

-

vivo 游戏黑产反作弊实践

摘要:大模型是新一轮AI发展的核心,其已在推进产业智能化升级中已表现出巨大潜力,并将在未来三年里形成风起云涌之势。

本文分享自华为云社区《探秘华为云盘古大模型:AI for industries的身体力行》,作者:华为云头条。

大模型是新一轮AI发展的核心,其已在推进产业智能化升级中已表现出巨大潜力,并将在未来三年里形成风起云涌之势。

华为云于2021年正式发布了盘古基础大模型,包括CV计算机视觉大模型、NLP自然语言处理大模型和科学计算大模型。在基础大模型之上,华为云践行AI for industries,陆续推出了矿山、药物分子、电力、气象、海浪等盘古行业大模型,加速各行各业数字化的进程。

▶货运列车智慧检测,盘古轨道大模型为铁路物流安全护航

随着海内外经济复苏,货运铁路的班次及载重均迎来新高潮。

在传统的货运铁路巡检中,TFDS(货车运行故障动态图像检测)系统作为5T检测技术的重要组成部分,通过高速拍摄的“电子眼”,动态采集列车车底配件、车体侧部等部位图像,实时判别货运列车是否存在故障。

一列50辆车厢的货车,“电子眼”会拍摄4000张照片,检测员每秒需审阅1张图。动态检车员不仅工作强度大、难度高,而且需对车辆专业理论与实际运用有较高水平,要在短时间内完成整列车的故障分析,确保整列车的运行安全。

华为云在现有设备和平台架构的基础上,基于盘古轨道行业大模型,推出TFDS故障智能识别方案,实现从图像采集、数据收发、列车拆分,到实时故障判别的全局分析,能够对多工位、多辆车关联等全局故障进行精准预报。

盘古铁路行业大模型具备五项核心竞争力:

- 自监督行业预训练模型

盘古预训练大模型基于语义相似样本、等级化语义聚集的对比表示学习方法,利用百万级无标注铁路行业图像生成轨道行业大模型;

- 图像质量自动增强&评估

通过底层视觉特征以及高层视觉特征对增强后的图像进行自动评估,对正常图像做进一步故障识别,非正常图像返回人工审核;

- 依托车型先验模板匹配

根据已知的车型信息建立零部件的相对位置模板,具有可解释性地预报部件异常情况,如脱落、丢失、错位等;

- 小样本故障定位、识别

基于轨道行业预训练大模型,结合当前最优的目标检测、图像识别框架,进行部件定位、故障识别,具有更强的泛化能力,仅需传统1/3的样本即可完成。

在实际应用中,盘古轨道大模型单张照片识别仅需4毫秒,可智能过滤95%的正常图片,实现了400多种故障的自动化识别以及严重故障的“零漏报”,比人工识别更准确,大幅度提升TFDS系统作业效率,动态检车员可腾出更多精力处理难度更高的辨图工作,确保列车安全运行。

▶AI辅助药物设计,盘古药物分子大模型加速新药研发

自1987年达托霉素被发现以来,人类已经有近40年没有新的抗生素被研发出来。药物研发专家需要花费超过10年时间、超过10亿美成本,才有可能研发出一款新药。

为了帮助药物研发专家从海量药物分子中高效挑选出适合成药的小分子,华为云联合中国科学院上海药物研究所推出了盘古药物分子大模型,基于全流程AI辅助药物设计的能力,以靶点预测、分子设计、活性评估、毒性筛选等环节为抓手,帮助医药公司实现快速、精准、低成本的药物发现,开启药物研发的新模式。

- 在药物虚拟筛选方面

依靠华为云创新的iFitDock算法以及虚拟筛选服务,盘古药物分子大模型的成药性预测准确率比传统方式高20%,进而让药物筛选效率提升十倍;

- 在药物优化方面

基于华为云盘古药物分子大模型的结构优化器,研发专家可对先导药进行定向优化,通过更科学的药物结构设计,减弱对人体正常细胞可能产生的毒副作用。

盘古药物分子大模型四大核心技术特点:

- “图-序列不对称条件变分自编码器”

全新提出“图-序列不对称条件变分自编码器”深度学习架构,更好地提取化合物关键的分子特征指纹,提升下游任务的准确性;

- 超大规模的化合物表征模型训练

对17亿个小分子的化学结构进行预训练,结构重构率、唯一性等方面优于现有方法;

- 生成1亿个创新的类药物小分子库

其结构新颖性为99.68%,为发现新药创造可能性;

- 实现了领先的药物发现任务性能

在化合物-靶标相互作用预测、化合物ADME/T属性评分、化合物分子生成与优化等方面实现性能最优,赋能药物发现全链条任务。

西安交通大学第一附属医院刘冰教授在盘古药物分子大模型的辅助下,突破性地研发出一款超级抗菌药Drug X,其有望成为全球近40年来首个新靶点、新类别的抗生素。华为云盘古药物分子大模型让先导药的研发周期从数年缩短至几个月,研发成本降低70%。AI技术与基础科学的结合与创新,不仅解决了研发成本高和时间周期长的痛点,更为初创型科研团队提供了施展能力的舞台。

▶让风云可测,盘古气象大模型精准呈现台风轨迹

在气象气候预报任务中,除了短期天气预报,全球中长期预报也是业界最为关注、重要性非常高的预测任务,它以预测未来14天内的大气系统状态为目标,在气象、航海、农业、旅游等多个行业发挥着举足轻重的作用。

当前人工智能技术虽已广泛应用在气象预测领域,受大气系统中物理过程的复杂性影响,以及求解大气模型所需资源规模巨大,基于传统数值方法进行的中长期天气预报通常会累计误差,导致准确度低,且需在超级计算机上运算数小时。

基于近40年的全球气象数据,华为云盘古气象大模型在中长期确定性预报上超越当前最强的数值预报方法(欧洲气象中心的IFS系统),是业内首个精度超过传统数值预报方法的全球AI气象预测模型。平均预报误差降低了10%-15%,速度提升10000倍以上,实现秒级全球气象预报。

盘古气象大模型核心技术特点:

- 3D高分辨率的神经网络

首次采用3D高分辨率的神经网络(3D Earth-Specific Transformer):与二维的神经网络和低分辨率的神经网络相比,盘古气象大模型水平空间分辨率达到0.25∘×0.25∘,约28公里x28公里,可以精准地预测细粒度气象特征。在时间维度上,盘古气象大模型将预测频率从6小时/次提升至1小时/次,使气象预测结果更准确;

- 层次化时域聚合策略

使用层次化时域聚合策略:训练了4个不同预报间隔的模型(分别为1小时间隔、3小时间隔、6小时间隔、24小时间隔),使得预测特定时间气象状况的迭代次数最小,从而减少迭代误差,也避免了由递归训练带来的训练资源消耗。

华为云盘古气象大模型在极端天气过程(如台风)的预报中已展现出精准、快速的优势:

- 2022年8月,盘古气象大模型实现秒级预测台风“马鞍”的轨迹和登陆时间,准确率达90%,远超行业平均水平。

- 今年5月22日至23日,今年第2号台风“玛娃”在24小时内,中心附近最大风力从38米/秒(台风级)迅速加强到60米/秒(超强台风级)。

中央气象局指出,华为云盘古大模型在“玛娃”的路径预报中表现优异,提前五天预报出其将在台湾岛东部海域转向路径。

人工智能触发的产业变革正在改变每一个行业,人工智能也在越来越多的行业场景发挥重要价值。华为云以“AI for industries”为发力点,提升大模型通用能力,贴近客户业务场景的现实需求,让人工智能开发标准化、可复制、批量化生产,加速AI深入千行百业,推动人类社会进入智能世界。华为开发者大会2023 ( Cloud )大会将于7月7日在东莞拉开帷幕,华为云盘古大模型将迎来重大升级,敬请期待!

号外

7月7日,华为开发者大会2023 ( Cloud )将拉开帷幕,并将在国内30多个城市、海外10多个国家开设分会场,诚邀您参加这场不容错过的年度开发者盛会,让我们一起开启探索之旅!

我们将携手开发者、客户、合作伙伴,为您呈现华为云系列产品服务与丰富的创新实践,并与您探讨AI、大数据、数据库、PaaS、aPaaS、媒体服务、云原生、安全、物联网、区块链、开源等技术话题,展开全面深入的交流。

大会将汇聚全球科学家、行业领袖、技术专家、社区大咖,开设200多场开发者专题活动,为全球开发者提供面对面交流与合作的机会,共同探讨技术创新和业务发展。

大会官网:https://developer.huaweicloud.com/HDC.Cloud2023.html

参会购票:https://www.vmall.com/product/10086352254099.html?cid= 211761

参与开发者社区活动,观赏技术大咖秀、玩转技术梦工厂,有机会赢取4000开发者礼包!

欢迎关注“华为云开发者联盟”公众号,获取大会议程、精彩活动和前沿干货。

关注,第一时间了解华为云新鲜技术~

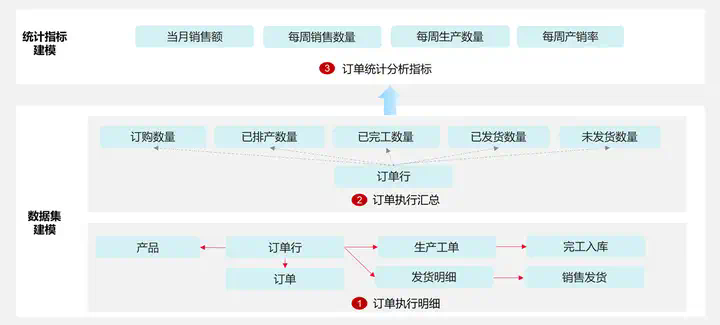

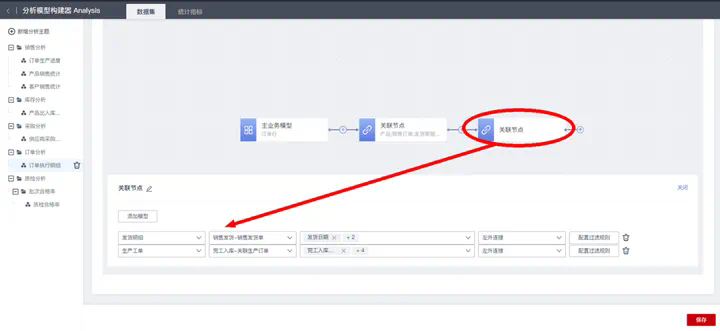

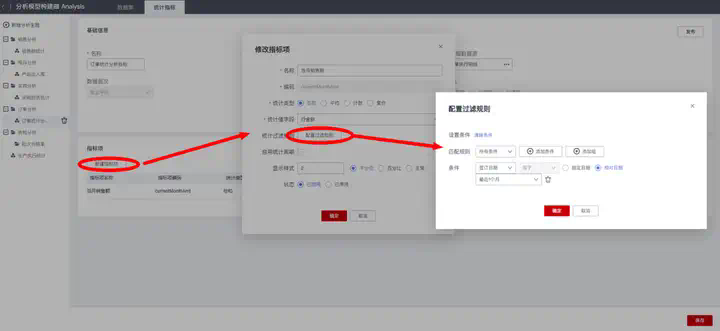

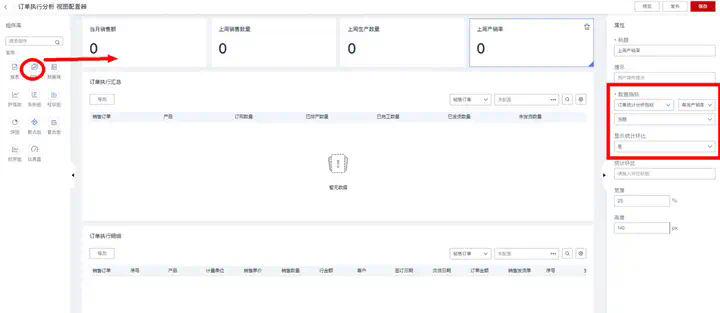

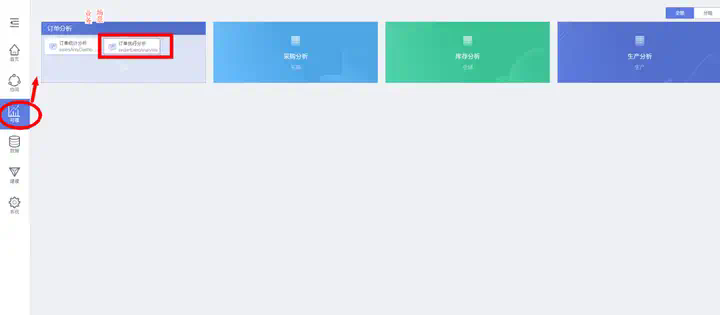

摘要:本期结合示例,详细介绍华为云数字工厂平台的数据分析模型和数据图表视图模型的配置用法。

本文分享自华为云社区《数字工厂深入浅出系列(六):数据分析与图表视图模型的配置用法》,作者:云起MAE 。

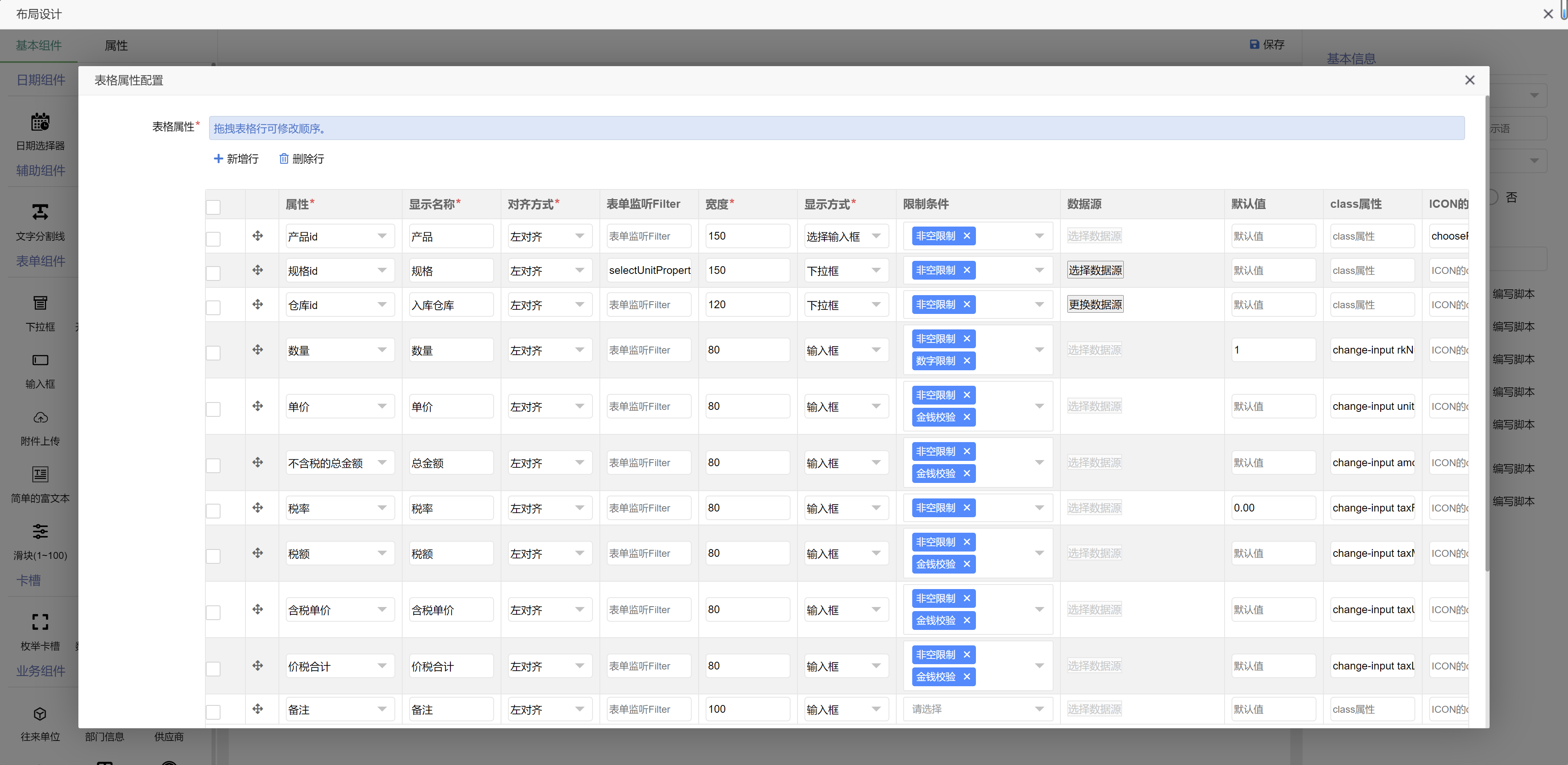

华为云数字工厂平台基于“数据与业务一体化”理念,提供统一的制造全域数据平台底座,内置轻量级制造数据分析引擎与可视化工具,支持IT/OT全域多模态数据的动态建模、采集、存储、分析和可视化应用,提供图形化的数据分析模型配置器,自动读取数字工厂平台的9类业务信息模型及其数据关联关系,能够让不懂技术的业务人员也可以自助式完成数据分析建模。数据分析模型,可搭配平台提供的视图模型配置器,快速搭建数据图表与看板,实现数据分析结果的可视化呈现。

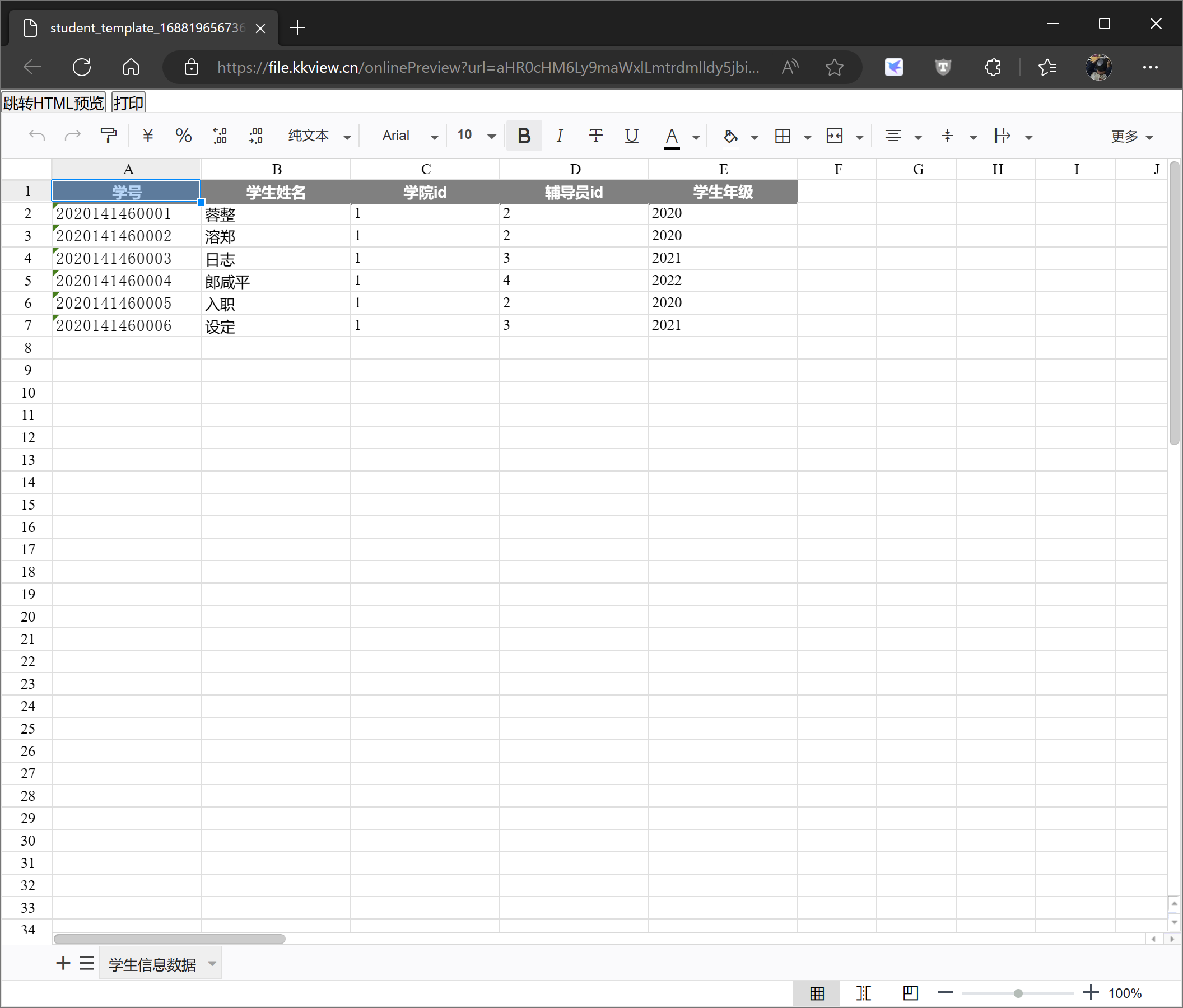

华为云数字工厂平台的数据分析模型目前支持两类:

- 数据集:用于关联聚合多个业务模型的数据,支持多层关联、数据计算和多维度聚合统计;也支持手工创建外部数据集,来存储从外部系统采集的数据,以及进一步实现数据可视化或者与数字工厂平台的业务模型数据进行关联分析;

- 统计指标:用于实时统计或者周期性统计业务数据,业务数据可来自原始业务模型的实例数据字段值,也可来自分析模型的某个数据集字段;支持复合指标建模,即引用已有的统计指标进行组合计算。

本期结合示例,详细介绍华为云数字工厂平台的数据分析模型和数据图表视图模型的配置用法。

(一)示例场景说明

本期通过配置实现以下3个数据分析建模示例,来详细介绍分析模型的使用方法:

(1)“订单执行明细”数据集:以销售订单行为主线,串联后续生产工单、完工入库、销售发货等业务环节数据,透视订单的执行进度明细。通过该分析模型示例,介绍分析数据集模型的“关联分析”节点组件的用法;

(2)“订单执行汇总”数据集:基于订单行数据串联生产工单、完工入库和销售发货数据,然后以销售订单和订购产品为维度,汇总统计工单排产数量、完工入库数量、销售发货数量,并计算未发货数量。通过该分析模型示例,介绍分析数据集模型的“聚合分析”和“计算分析”节点组件的用法;

(3)“订单统计分析”指标集:基于订单和生产工单数据,实时统计当月销售额,按周统计每周销售数量、生产数量、产销率。通过该分析模型示例,介绍“实时统计”、“周期性统计”和“复合性”指标模型的配置用法。

(二)详细步骤说明

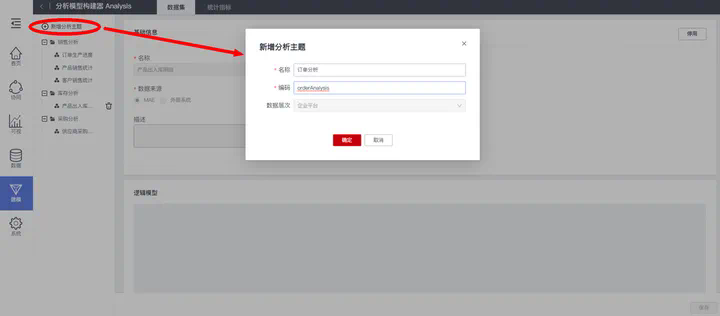

1.“订单执行明细”数据集建模

使用华为云数字工厂企业平台的“建模工作台>分析模型”系统功能,可创建与配置数据分析模型。

首先新建分析主题“订单分析”,方便分组管理与使用检索:

然后在“订单分析”主题下,创建数据集“订单执行明细”:

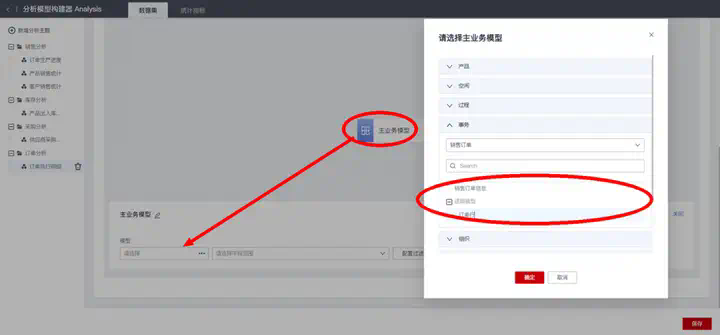

接下来需要编排数据集的取数逻辑模型:

- 配置主业务模型

“主业务模型”是数据集的数据逻辑起点,用于指定数据集的数据主线维度,即指定以哪个模型的数据为基准来关联分析相关数据,比如我们需要以订单行数据为基准,来串联透视后续业务环节数据,则数据集的“主业务模型”选择“订单”事务模型的子模型“订单行”:

选择主业务模型后,进一步勾选配置所需的数据字段范围以及数据过滤规则。

- 增加关联分析节点

在当前主业务模型节点后面可添加“关联分析”节点,用来串联获取与当前模型存在“关联或者被关联关系”的相关模型数据。“关联分析”节点可配置多个关联模型,实现同时串联到多个相关数据。

当前示例中,主业务模型“订单行”需要:

a.关联“订单”模型获取“订单金额”、“客户”、“交货日期”等字段信息;

b.关联“产品”模型获取“规格”、“库存量”等字段信息;

c.关联“生产工单”模型获取“生产工单号”、“计划产量”、“实际产量”等字段信息;

d.关联“销售发货明细”模型获取“发货数量”等字段信息。

其中配置关联模型时,默认使用“左外连接”的关联类型,即在返回的数据集结果中关联模型数据无论是否存在不影响主业务模型数据,可按需切换为“全连接”,即在返回的数据集结果中如果主业务模型数据的关联模型数据不存在,则相应的主业务模型数据会一并丢弃。

- 增加二级关联节点

在某个关联节点之后,可再添加关联节点,实现数据多级关联与追溯。

当前示例中,主业务模型“订单行”关联“生产工单”模型数据后,需要进一步:

a.通过“生产工单”关联追溯“完工入库”模型获取“入库数量”、“入库日期”等字段信息;

b.通过“销售发货明细”关联追溯“销售发货”模型获取“发货日期”等字段信息。

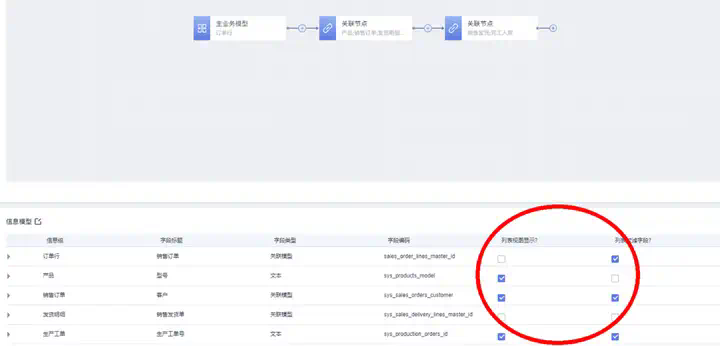

数据集配置完成后,右上角的“发布”按钮,自动生成相应的数据分析模型:

其中分析信息模型的“列表视图显示”和“列表过滤字段”两列支持编辑,用来设置分析模型在被报表视图组件使用时,相应字段是否作为报表显示列字段和查询字段。

2.“订单执行汇总”数据集建模

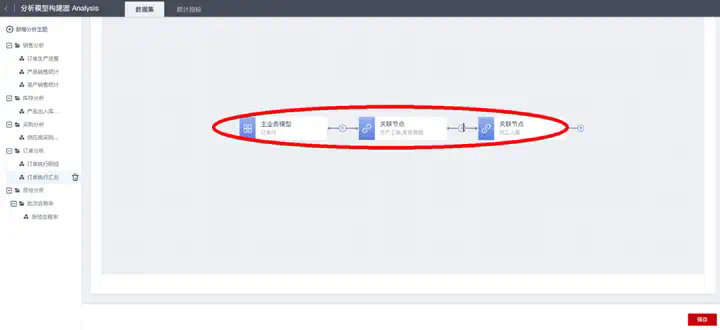

在“订单分析”主题下,创建数据集“订单执行汇总”,然后编排数据集的逻辑模型:

- 准备明细数据

编排逻辑模型,准备订单执行汇总数据集所需的明细数据,即通过订单行串联生产工单、完工入库和销售发货数据:

- 聚合汇总数据

通过添加“聚合分析”节点,实现以销售订单和产品为维度,汇总统计工单排产数量、完工入库数量和销售发货数量,配置示例如下:

- 补充计算字段

通过添加“计算分析”节点,实现计算未发货数量=订购数量-已发货数量,配置示例如下:

“订单执行汇总”数据集的逻辑模型配置结果如下:

数据集配置完成后,右上角的“发布”按钮,自动生成相应的数据分析模型。

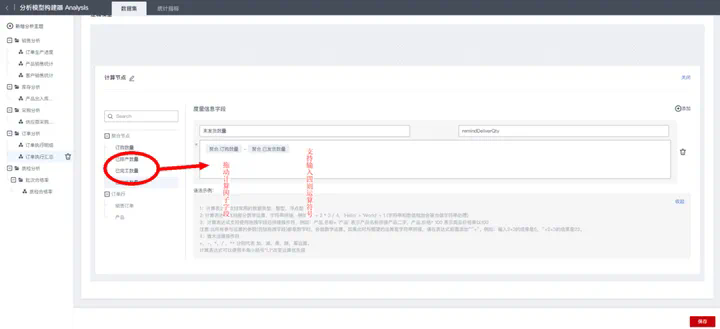

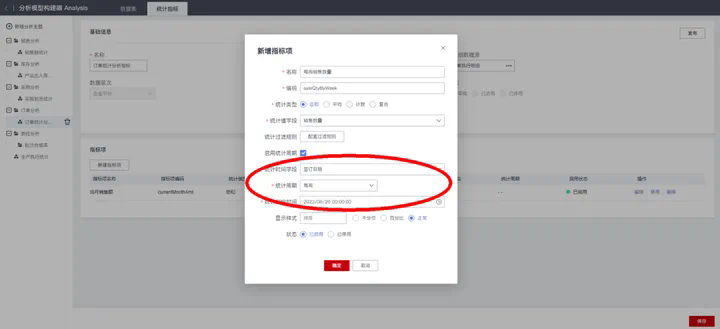

3.“订单统计分析”指标集建模

在“订单分析”主题下,切换到“统计指标”页签,然后创建指标集“订单统计分析指标”:

“统计指标集”需要指定统计的来源明细数据模型,可选择原始业务模型,也可选择已发布的分析“数据集”模型,示例这里选择前面步骤创建的分析数据集模型“订单执行明细”。

接下来,在统计指标集下新建与配置所需的指标项:

- 实时性统计指标:“当月销售额”

对于“当天”、“当月”等实时性统计指标,在新建指标项时需要取消勾选“启用统计周期”,然后选择“统计类型”和“统计值字段”(即统计对象字段),最后配置“统计过滤规则”的条件:条件字段选择统计依据的日期字段,条件值类型选择“相对日期”,最后选择相应的日期区间,比如当天、昨天、最近1周(当周)、最近1个月(当月)等。

当前示例“当月销售额”的配置结果如下:

- 周期性统计指标:“每周销售数量”、“每周生产数量”

对于“每天”、“每周”、“每月”等周期性统计指标,在新建指标项时默认勾选“启用统计周期”,然后选择“统计类型”、“统计值字段”(即统计对象字段)、“统计时间字段”(即统计周期依据的日期字段)、“统计周期”(每小时/每天/每周/每月/每季度/每年)和“统计起始时间”(即统计指标第一个统计周期的起始时间,通常与“统计周期”有关,比如统计周期是“每周”,则统计起始时间通常选第一个统计周的周一的某个工作起始时间)。

当前示例“每周销售数量”的配置结果如下:

“每周生产数量”统计指标的配置方法同上,不再赘述。

- 复合性统计指标:“每周产销率”

在新建指标项时,“统计类型”选择“复合”,即可创建复合性统计指标。复合指标用于引用已发布的统计指标项作为原子指标进行组合计算,计算公式支持四则运算符。

复合性统计指标也分为两类:

a.周期性的复合指标:需要勾选“启用统计周期”,然后进一步选择“统计时间字段”(即统计周期依据的日期字段)、“统计周期”(每小时/每天/每周/每月/每季度/每年)和“统计起始时间”(即统计指标第一个统计周期的起始时间,通常与“统计周期”有关,比如统计周期是“每周”,则统计起始时间通常选第一个统计周的周一的某个工作起始时间);

b.实时性的复合指标:取消勾选“启用统计周期”即可。

对于比率性的复合指标,支持配置其数据显示样式:百分比或者常规数值。当前示例“每周产销率”的配置结果如下:

“订单统计分析”指标集的最终配置结果如下:

统计指标集配置完成后,右上角的“发布”按钮,自动生效相应的数据分析模型。

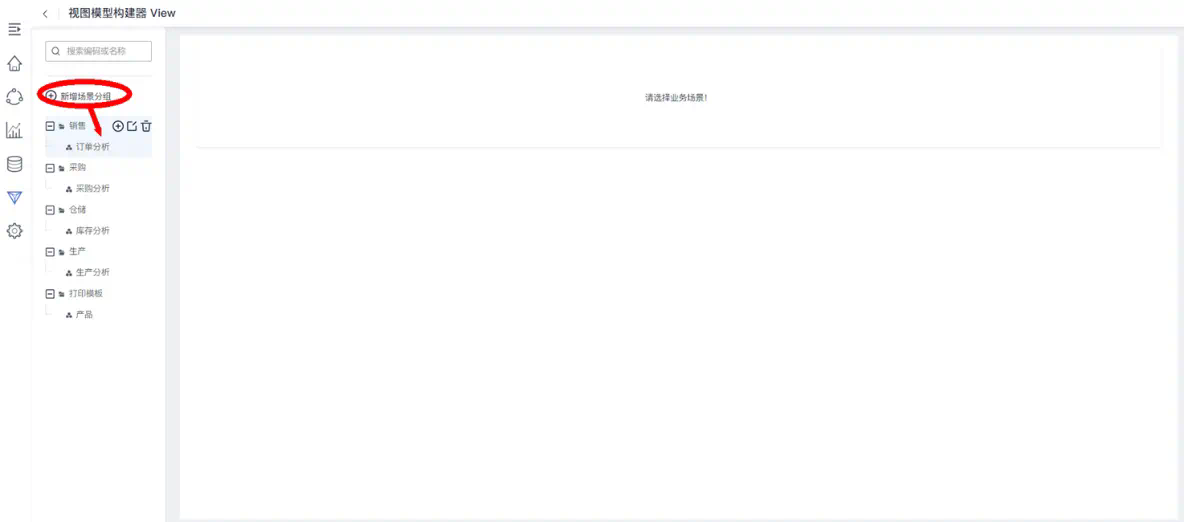

(三)配置数据图表视图,验证数据分析结果

1.创建视图模型

使用华为云数字工厂企业平台的“建模工作台>视图模型”系统功能,可创建与配置数据视图模型。

首先新建场景分组和业务场景“销售>订单分析”,在可视工作台会根据场景分组和业务场景来动态构建相应的数据应用卡片:

选中业务场景“销售>订单分析”,然后在“数据看板”页签下,新建视图模型“订单执行分析”:

其中“终端范围”用来设置视图模型在哪些终端展示,可选项为全部/PC端/移动端,默认选择“全部”。

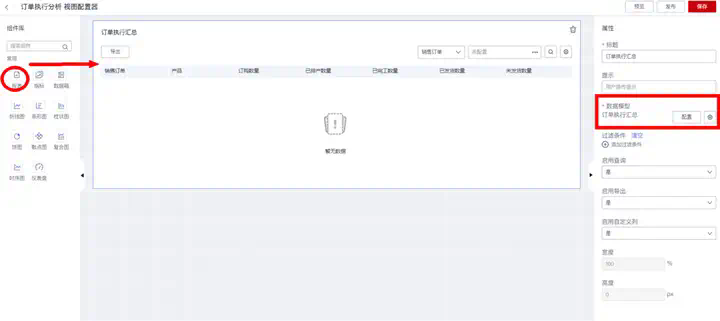

2.配置数据报表:展示订单执行明细与汇总数据集

从左侧“组件库”拖动“报表”组件到中间看板画布区,然后在右侧“属性栏”配置报表组件属性,其中:

“标题”:用来设置报表卡片的前端展示标题;

“数据模型”:用来选择报表的数据来源模型,当前示例选择前面步骤创建的数据集“订单执行汇总”或者“订单执行明细”。选定数据模型后,在右侧可进一步配置在数据报表中需要展示的字段列及其顺序;

“过滤条件”:用来设置所展示数据的过滤条件。

报表配置完成后,可右上角的“预览”按钮,查看与验证运行效果:

3.配置指标卡:展示订单统计分析指标集

从左侧“组件库”拖动“指标”组件到中间看板画布区,然后在右侧“属性栏”配置报表组件属性,其中:

“标题”:用来设置指标卡片的前端展示标题;

“数据指标”:用来选择指标卡片的数据来源指标,当前示例选择前面步骤创建的数据集“订单统计分析指标”下的相应指标项;

“显示统计环比”:针对“数据指标”选择了周期性统计指标项的情况,用来设置指标卡片上是否显示统计指标当期值与上期值的环比。

拖动指标卡片的边框可以调整其前端显示的宽度和高度,或者手工填写属性栏中的“宽度”、“高度”配置项来调整。

4.配置数据图表:每周产销率趋势图

从左侧“组件库”拖动“折线图”组件到中间看板画布区,然后在右侧“属性栏”配置报表组件属性,其中:

“标题”:用来设置折线图卡片的前端展示标题;

“数据模型”:用来选择折线图的数据来源模型,当前示例选择前面步骤创建的统计指标集“订单统计分析”;

“过滤条件”:用来设置所展示数据的过滤条件;

“维度”:用来选择折线图的X轴维度坐标值字段;

“指标字段”:用来选择折线图的Y轴指标坐标值字段;

“显示样式”:支持三种显示样式风格:普通折线、平滑线和梯形阴影折线。

拖动折线图卡片的边框可以调整其前端显示的宽度和高度,或者手工填写属性栏中的“宽度”、“高度”配置项来调整。

5.在可视工作台,使用数据图表看板

数据图表视图模型发布后,业务用户在 “可视工作台”的相应业务场景卡片下,可使用数据视图看板:

查看并验证前面配置的数据视图的使用效果:

数据视图模型也支持IoT设备时序数据可视化分析,提供时序趋势图和时间状态图两种组件:

华为云数字工厂平台,内置轻量级制造数据分析引擎与数据可视化工具,能够对制造过程的全域数据进行统一管理和分析,支持业务人员自助式开发数据可视化图表,满足中小型企业制造业务运营分析与洞察需求,实现基于数据持续驱动业务流程优化。

号外

7月7日,华为开发者大会2023 ( Cloud )将拉开帷幕,并将在国内30多个城市、海外10多个国家开设分会场,诚邀您参加这场不容错过的年度开发者盛会,让我们一起开启探索之旅!

我们将携手开发者、客户、合作伙伴,为您呈现华为云系列产品服务与丰富的创新实践,并与您探讨AI、大数据、数据库、PaaS、aPaaS、媒体服务、云原生、安全、物联网、区块链、开源等技术话题,展开全面深入的交流。

大会将汇聚全球科学家、行业领袖、技术专家、社区大咖,开设200多场开发者专题活动,为全球开发者提供面对面交流与合作的机会,共同探讨技术创新和业务发展。

大会官网:https://developer.huaweicloud.com/HDC.Cloud2023.html

参会购票:https://www.vmall.com/product/10086352254099.html?cid= 211761

参与开发者社区活动,观赏技术大咖秀、玩转技术梦工厂,有机会赢取4000开发者礼包!

欢迎关注“华为云开发者联盟”公众号,获取大会议程、精彩活动和前沿干货。

关注,第一时间了解华为云新鲜技术~

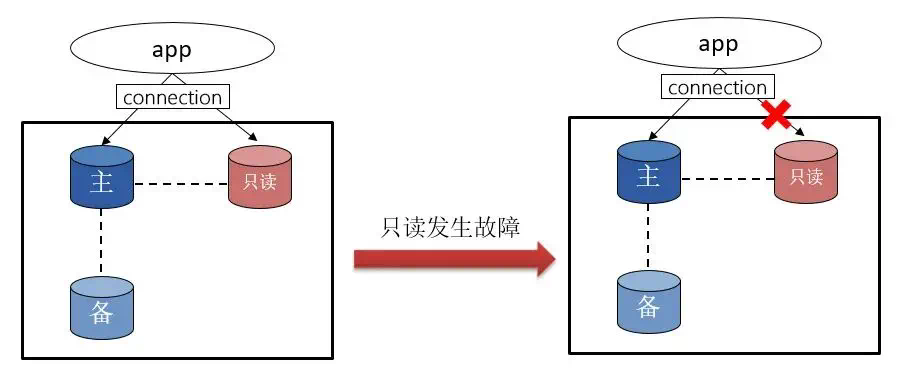

摘要:业务应用对数据库的数据请求分写请求(增删改)和读请求(查)。当存在大量读请求时,为避免读请求阻塞写请求,数据库会提供只读实例方案。通过主实例+N只读实例的方式,实现读写分离,满足大量的数据库读取需求,增加应用的吞吐量。

业务应用对数据库的数据请求分写请求(增删改)和读请求(查)。当存在大量读请求时,为避免读请求阻塞写请求,数据库会提供只读实例方案。通过主实例+N只读实例的方式,实现读写分离,满足大量的数据库读取需求,增加应用的吞吐量。

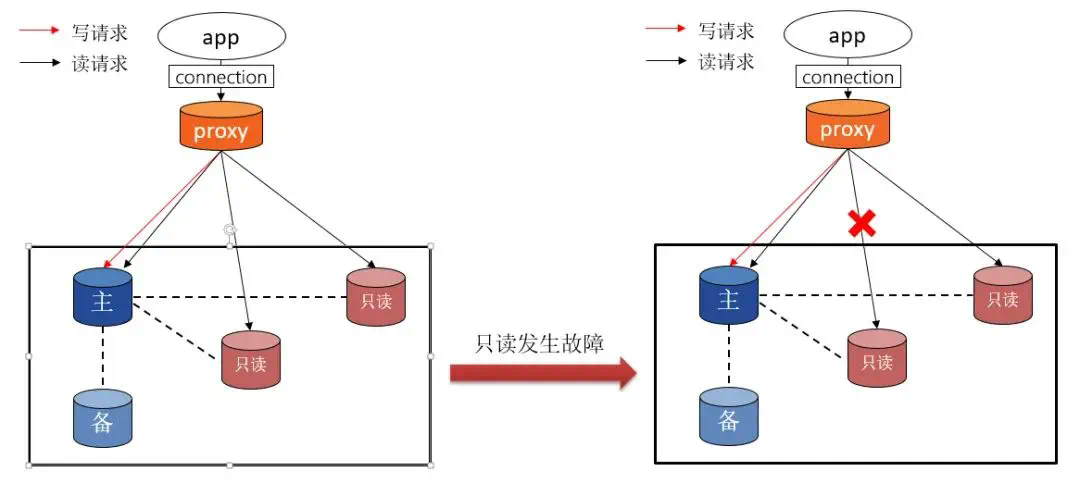

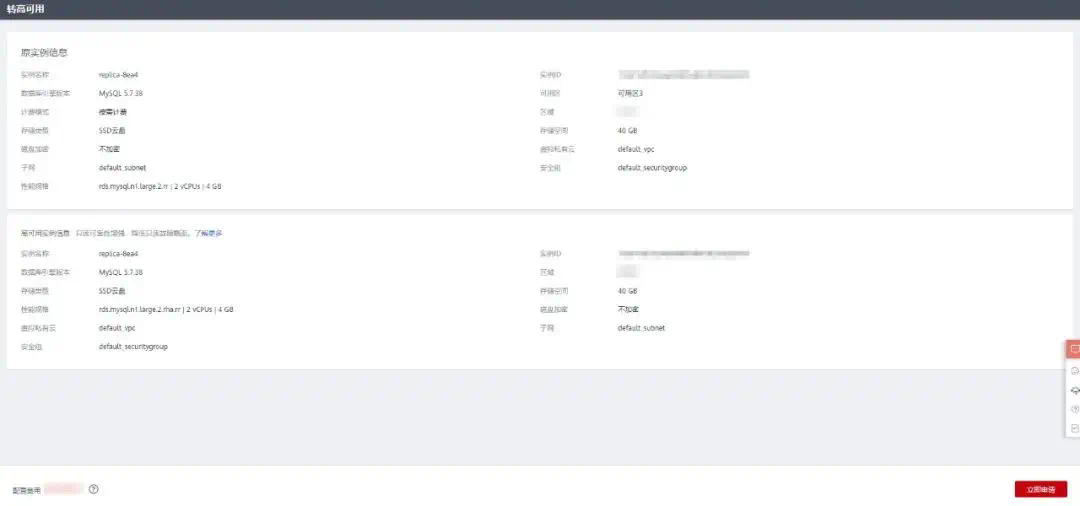

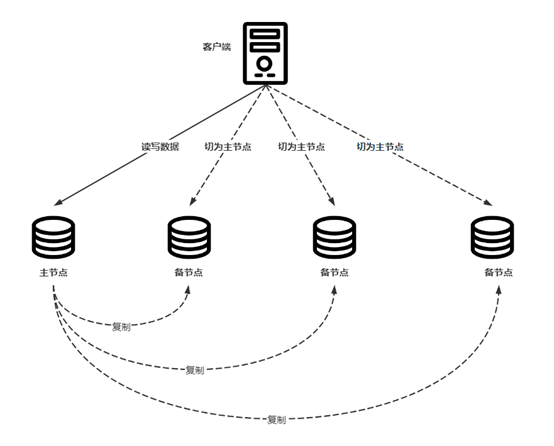

对于只读实例,如果采用单机无备节点作备份的方案,当实例出现故障或有重建需求的时候,会出现较长时间的不可用,通常需要客户做业务连接上的调整或是创建新只读实例等繁琐操作。单机只读架构如下所示,一旦单机只读发生故障,则业务中断,直至故障修复实例复位。

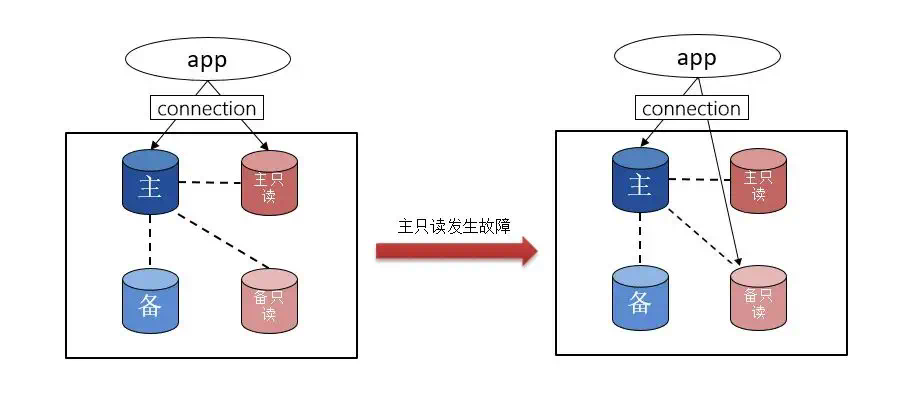

RDS for MySQL只读节点稳定性解决方案

为了保证业务的连续性及稳定性,RDS for MySQL在原来单机只读的基础上,推出了“高可用只读”。高可用只读在故障的容错能力、异常的应对能力方面具有比较大的优势。相比较单机只读动辄小时级的中断,高可用只读在故障倒换时,仅有秒级中断。

高可用只读架构图如下,异常发生时(比如数据库异常,虚拟机异常等),HA组件可将主只读节点的VIP(虚拟IP)自动切换到备只读节点上,从而快速恢复业务。

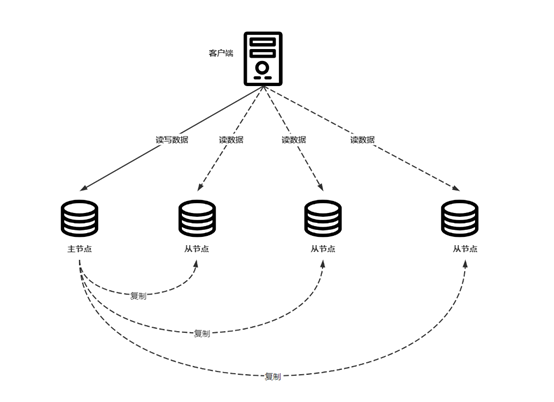

除高可用只读方案外,多只读实例Proxy轮询的方案也有相同效果。即购买多个只读实例,并开启数据库代理(proxy)的方案,在发生异常情况时,数据库代理自动把流量切换到其他正常只读实例,从而避免出现业务中断发生。Proxy方案架构图如下:

单机只读、高可用只读、多只读+ proxy,在应用并发连接数、异常反应、成本方面的对比如下:

以上的多方案给用户提供了灵活的可选择性,用户可以基于业务量、成本、业务运行效率等方面综合评估选择适合自己的方案。这篇文章中将重点介绍下高可用只读,未来我们还会基于proxy做一期介绍,敬请期待。

高可用只读使用办法

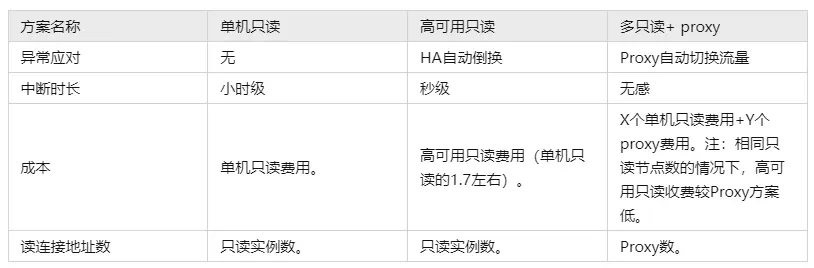

高可用只读在页面上的展示

如图所示,replica-86e2为单机只读实例,replica-bb17及replica-b947为高可用只读实例。需要注意的是,高可用只读实例是一组(主、备)实例,其底层会自动实现故障机制响应。

如何购买高可用只读

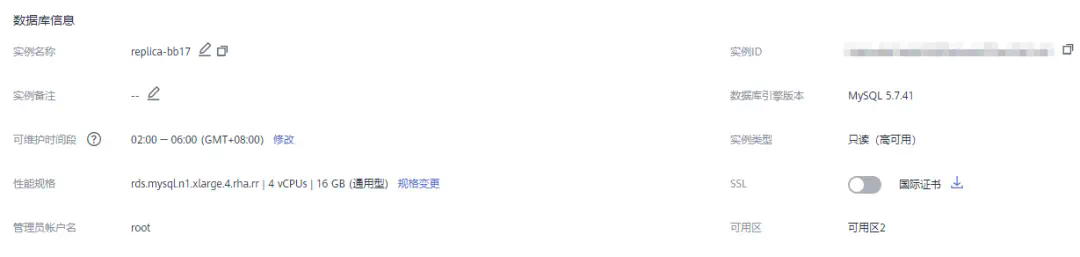

直接购买高可用只读

1.登录管理控制台。

2. 单击管理控制台左上角的符号,选择区域和项目。

3. 单击页面左上角的符号,选择“数据库 > 云数据库 RDS”。

4. 在“实例管理”页面,选择指定的实例,单击操作列的“更多 > 创建只读”,进入“创建只读”页面。

也可在实例的“基本信息”页面,单击实例拓扑图中,主实例下方的添加按钮,创建只读实例。

5. 在“创建只读”页面,只读模式选择“只读(高可用)”,填选实例相关信息后,单击“立即创建”。

6. 在“规格确认”页面,进行信息确认。如果需要重新选择,单击“上一步”,回到服务选型页面修改基本信息。对于按需计费的实例,信息确认无误后,单击“提交”,下发新增只读实例请求。对于包年/包月的实例,订单确认无误后,单击“去支付”,进入“付款”页面。

7. 高可用只读实例创建成功后,可以对其进行查看和管理。

只读实例转换为高可用只读

除了上述新建只读实例时选择高可用只读模式,RDS for MySQL也支持已有的单机只读升级为高可用只读,操作简单,无需进行老实例回收等操作。

说明:

非高可用只读可以转换为高可用只读实例,但高可用只读不允许转换为非高可用只读实例。

1. 登录管理控制台。

2. 单击控制台左上角的符号,选择区域和项目。

3. 单击页面左上角的符号,选择“数据库 > 云数据库 RDS”,进入RDS信息页面。

4. 在实例列表中,单击实例名称前的符号,单击非高可用只读实例的名称,进入实例的基本信息页面,即进入只读实例的管理页面。

5. 在转高可用页面,确认信息无误后,单击“立即申请”,即可将普通只读实例转换为高可用只读实例。

高可用只读使用注意事项

- 高可用只读支持的磁盘类型有:SSD云盘、本地盘以及极速型SSD;支持的规格类型有:通用型、独享型、鲲鹏通用增强型、x86通用型以及x86独享型。

- 不建议修改高可用只读实例的参数,否则会影响高可用只读的可靠性。

- 高可用只读不允许进行如下操作:修改端口、转换到非高可用只读实例。

- 创建高可用只读或是变更到高可用只读时,需要保证实例所在子网的IP充足。

关注,第一时间了解华为云新鲜技术~

在一个工程里,同时使用 Mongodb 和 MySQL, 可以吗? 不但可以,还可以使用一套 Dao 的代码。

Java ORM Bee 不但支持 JDBC 类型的数据库,还支持 Mongodb, 也支持Android,鸿蒙.

最新功能介绍:

V2.1.6 (2023・父亲节版)

1.添加开关closeDefaultParaResultRegistry,控制是否需要默认加载参数类型转换器和查询结果类型转换器

2.支持JAP新的API包jakarta.persistence.*

3.批量插入支持配置是否由框架捕获主键等异常catchModifyDuplicateException,默认不捕获

4.关闭UtilDotDateTypeConvert因少了 HH🇲🇲ss

5.fixed bug 更新配置的默认值

fixed bug NullPointerException for PreparedSql preparedValue

fixed bug for StringUtils

一行代码,即可完成某个表的分片配置:

上期发布:

支持 jdbc, android 和 NoSQL 数据库的 ORM Bee 2.1 LTS 版发布 (上传 Maven)

开发微服务更方便:

实例: https://my.oschina.net/u//blog/

Spring Cloud 微服务使用数据库更方便:Bee + Spring Boot; 轻松支持多数据源,Sharding, Mongodb.

更快的开发 Spring Cloud 微服务的新组合,Bee 整合 Spring Boot, 让你瞬间拥有两样快速开发利器!

Bee,互联网新时代的 Java ORM 工具,更快、更简单、更自动,开发速度快,运行快,更智能

Spring Boot 是用来简化新 Spring 应用的初始搭建以及开发过程。该框架使用了特定的方式来进行配置,

从而使开发人员不再需要定义样板化的配置。通过这种方式,Spring Boot 可以帮助我们进行快速应用开发。

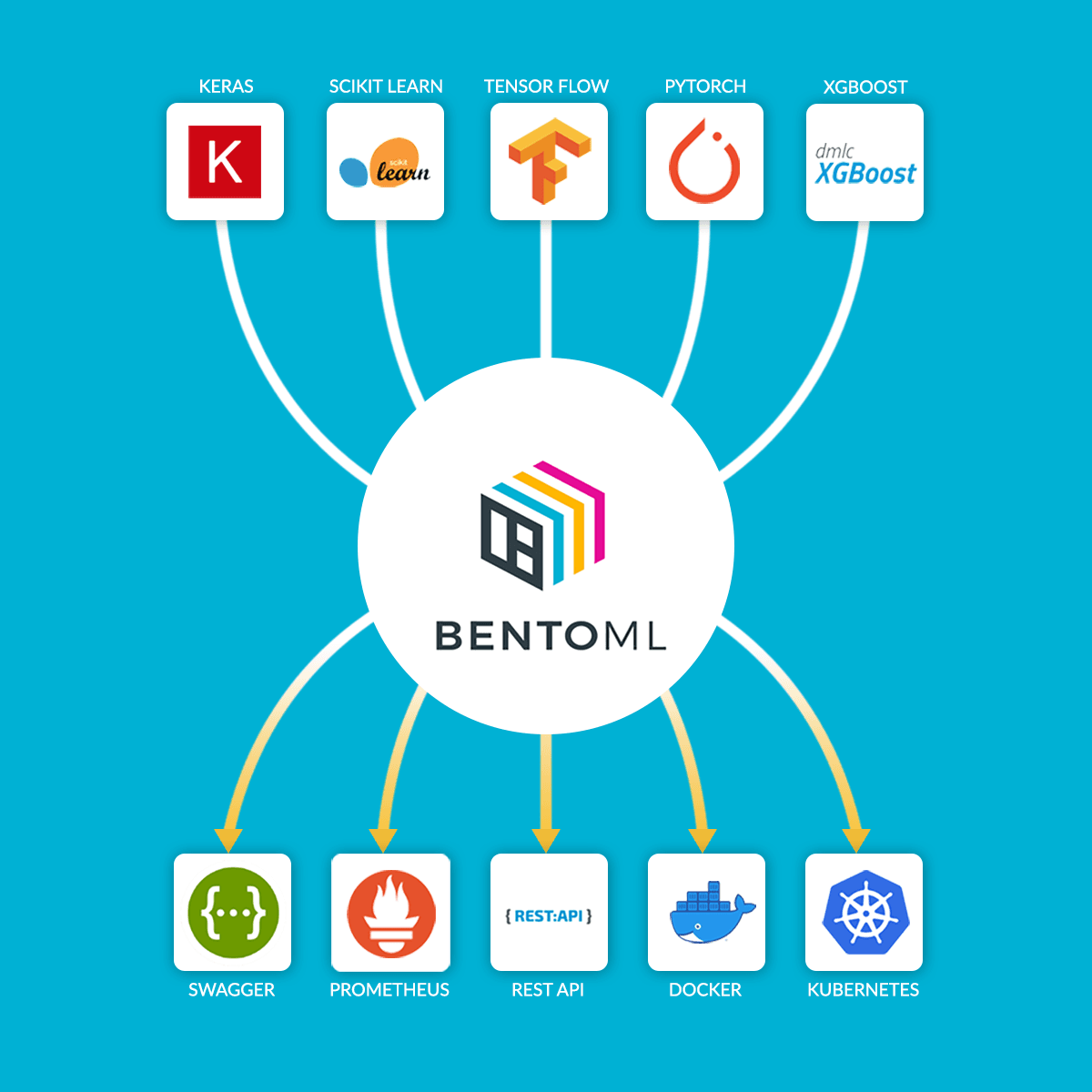

Mongodb ORM (Bee) 详细功能列表

更多实例,请参考 Bee-exam 实例工程:

https://gitee.com/automvc/bee-exam

———————————————————————

Bee,互联网新时代的 Java ORM 框架,支持 Sharding;JDBC,Android,HarmonyOS;支持多种关系型数据库,还支持 NoSQL 的 Cassandra,Mongodb 等;更快、更简单、更自动,开发速度快,运行快,更智能!

支持多种关系型数据库:MySQL,MariaDB,Oracle,H2,SQLite,PostgreSQL,SQL Server,Access 等。

下期功能预告:

你还想添加什么功能,请到评论区告诉我们

项目首页:

https://gitee.com/automvc/bee

https://github.com/automvc/bee

https://gitee.com/automvc/bee-springboot

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

GIMP 团队最近结束了为期一周的线下“GIMP 贡献者会议”,会议地点由 Blender 基金会总部提供。

▲ GIMP 核心开发者

虽然 GIMP 3.0 的发布计划仍存在很多变数,但开发团队透露应该会在今年发布 GIMP 3.0 首个 RC——进入候选版本阶段。

目前他们正在开发 GIMP 2.99.16 版本,如果一切顺利,这个版本发布后就是 GIMP 3.0 的第一个 RC。

GIMP 3.0 最显著的变化之一是从 GTK2 过渡到 GTK3 工具包,团队在年初宣布 GIMP 的 GTK3 移植已正式完成。

GIMP 即 GNU Image Manipulation Program(GNU 图像处理程序)的首字母组成,是一个自由开源的位图图像编辑器,用于图像照片润饰及编辑、自由绘图、调整大小、裁剪、照片蒙太奇、装换图像格式以及其他专业任务。

GIMP 几乎拥有所有图象处理所需的功能,号称 Linux 下的 Photoshop。

延伸阅读

- GIMP 3.0 计划今年推出

Vitess 是一个用于部署、扩展和管理大型 MySQL 实例集群的数据库解决方案。Vitess 集 MySQL 数据库的很多重要特性和 NoSQL 数据库的可扩展性于一体。它的架构设计使得用户可以像在物理机上一样在公有云或私有云架构中有效运行。它结合并扩展了许多重要的 MySQL 功能,同时兼具 NoSQL 数据库的可扩展性。

Vitess 17 近日正式发布,在这个版本中,Vitess 引入了一些重要的改进措施,以提高系统的兼容性、性能和可用性。

GA 公告

在 v15 版本中引入的 VTTablet 设置连接池功能,在这个版本中现在默认启用。该功能简化了系统设置的管理和配置,为用户提供了更加精简和便的体验。

新的基于 Tablet Throttler 的 Topology Service 现在已 GA 并默认启用。

MySQL 兼容性改进

Vitess 现在支持额外的语句,例如 、 和 以及许多附加函数,包括比较运算符、数字函数、日期和时间函数、 函数等。

查询计划器经历了一些改进,带来了更有效的查询计划,特别是复杂的操作,如聚合、分组和排序,从而提高查询性能。执行查询时使用的评估引擎也得到了显著的改进,带来了超过 2 倍的性能改进。新版本还添加了一个基于新虚拟机的引擎,它将最终取代基于 AST 的引擎,并提供更大的性能改进(在 v17 中默认没有启用)。

在这个版本中,模式跟踪也得到了加强,使 Vitess 查询计划器能够快速检测到数据库模式的任何变化。这确保了查询能够保持最新的模式修改,提高了整体数据的一致性。

复制增强功能

Vitess 现在支持在与 Vitess 分片相对应的每个复制集中更有效的 MySQL 复制。

新版本已经为 类型增加了支持。如果你使用 TEXT、BLOB 或 JSON 列,这可以大大减少你的二进制日志的整体大小,减少磁盘 I/O 和存储以及网络 I/O 和相关 CPU 的开销。

新版本还为 MySQL 8.0 中新增加的二进制日志事务压缩增加了支持。用于压缩每个 的内容,然后将压缩的事件存储到二进制日志中。这也大大减少了磁盘 I/O 和存储以及网络 I/O,不过代价是读写日志时会有一些额外的 CPU 开销。

其他

- 流量限制改进

- VTorc 改进

- VTAdmin 改进

更多详情可查看:https://github.com/vitessio/vitess/releases/tag/v17.0.0

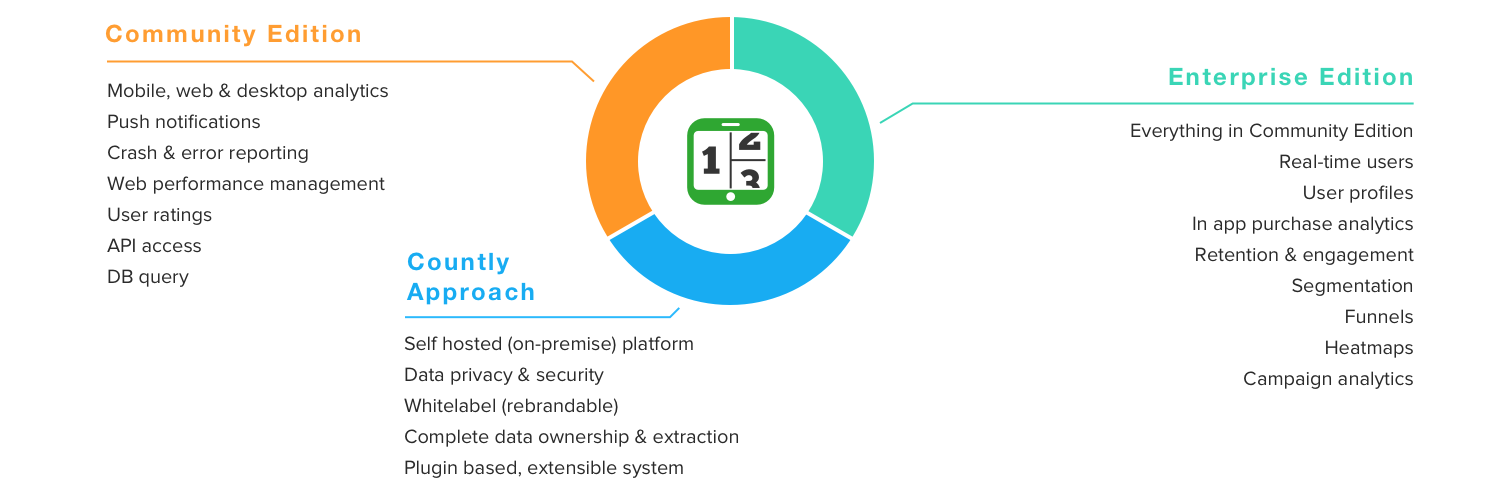

实时移动和 web 分析报告平台 Countly 23.06.1 发布了。

Countly 是一个创新、实时、开源的移动和 web 分析,推送通知和崩溃报告平台,为超过 2500 个网站和 12000 个移动应用提供支持。 它从手机、平板电脑、Apple Watch 和其他互联网连接的设备收集数据,并可视化此信息以分析应用使用情况和终端用户行为。

新版更新内容主要有:

修复:

- [核心] 在会话分析中添加了缺失的 %

- [核心] 添加了报表迁移到书签的脚本

- [核心] 修复了安装时的 mongodb 配置

- [仪表板] 空仪表板的本地化和样式修复

- [依赖] xml2js 修复

- [成员] 编辑成员时设置权限

企业修复:

- [cohorts] 修复了仪表板小部件与上一时期相比显示无效百分比的问题。

- [核心] 修复CE标签版本更新

- [drill] 修复“细分过滤器未显示群组”的问题

- [drill] 在书签中存储可视化类型

- [drill] byVal 查询的默认图表类型为“bar”

- [flows] 数据请求的权限检查。

- [push] 通过推送令牌和消息查询用户个人资料

- [users] 修复空白值格式

更新公告:https://github.com/Countly/countly-server/releases/tag/23.06.1

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

Karafka v2.1.6 现已发布。Krafka 是一个用于简化基于 Apache Kafka 的 Ruby 应用开发的框架,它允许开发者在使用异步 Kafka 消息时使用类似于标准 HTTP 约定(params 和 params_batch)的方法。Karafka 不仅可以处理传入的消息,而且还提供了用于构建接收和发送消息的复杂数据流应用程序的工具。

此版本更新内容如下:

- [改进] 为迭代器提供时间支持

- [改进] 为admin 提供时间支持

- [改进] 为consumer 提供时间支持。

- [改进] 删除客户端操作不再需要的锁。

- [改进]尝试迭代不存在的主题时引发。

- [改进] 确保 Kafka 多命令操作在 mutex 下一起运行。

- [更改] 要求

- [更改] 要求

- [重构] 清理迭代器代码。

- [修复] 提高 Rails 应用程序开发环境中的性能 (juike)

- [修复] 重命名为以与其他 errors 的命名保持一致。

- [修复] 修复不稳定的规范。

- [修复] 修复运行 LRJ 时自动会覆盖用户手动搜索的情况。

- [修复] 确保用户直接的和操作优先于系统操作。

- [修复] 确保和在一个底层连接不会出现 race-condition。

更新说明:https://github.com/karafka/karafka/releases/tag/v2.1.6

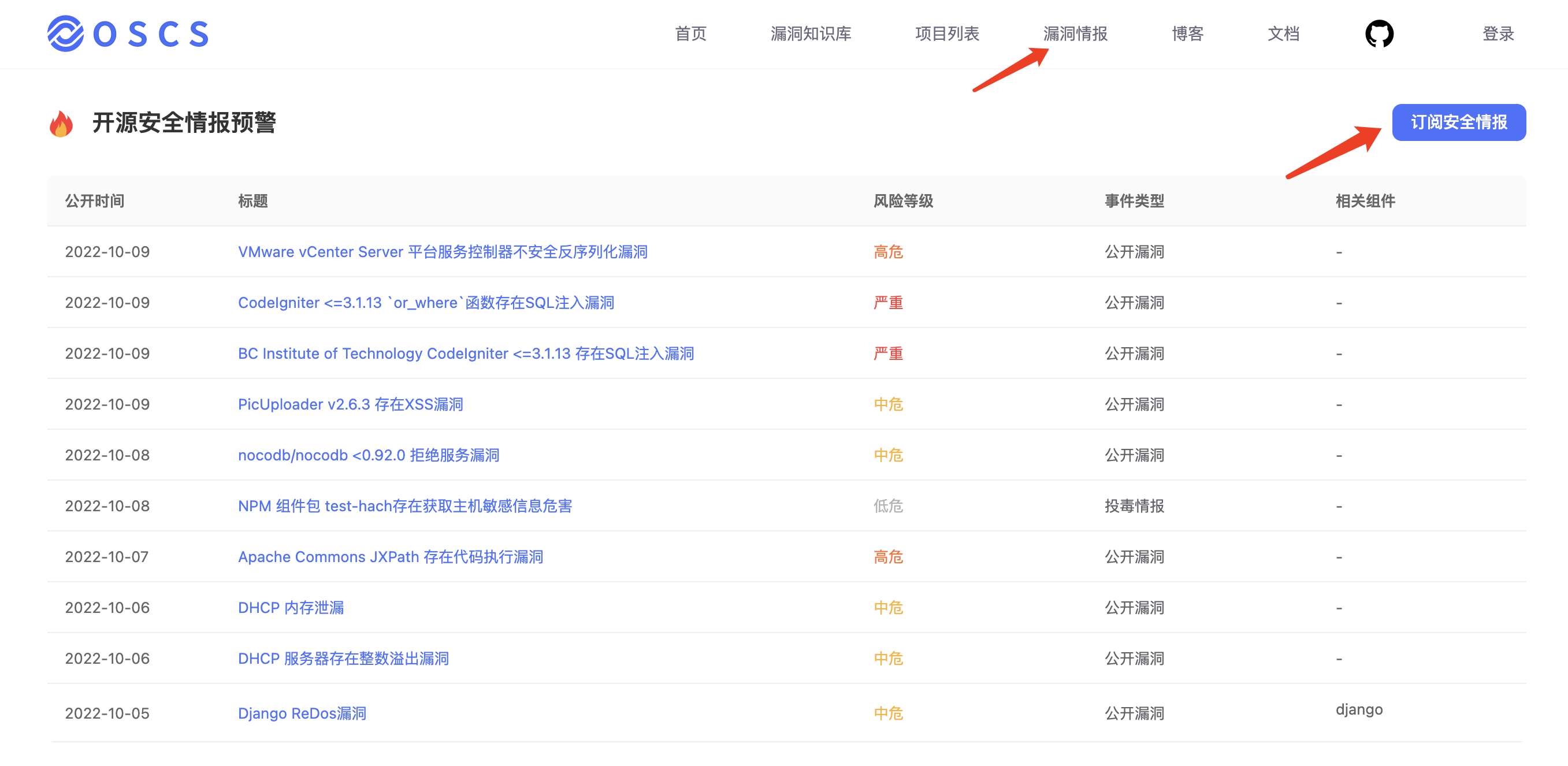

漏洞描述

Parse Server 是一个用于构建移动应用程序和Web应用程序开源框架,使用了 MongoDB 进行数据存储,通过 MongoDB BSON 解析器来解析和处理 BSON 数据。

受影响版本中,由于 DatabaseController#update 方法未对用户可控的参数进行过滤,攻击者可将恶意代码注入到 BSON 数据的 _bsontype 属性中(如:foo: { _bsontype: ‘Code’, code: ‘shell’ }),当 MongoDB BSON 解析器解析恶意 BSON 数据时远程执行恶意代码。

影响范围

parse-server@[6.0.0, 6.2.1)

parse-server@[1.0.0, 5.5.2)

修复方案

官方已发布 MongoDB BSON 解析器过滤恶意字符的补丁:https://github.com/parse-community/parse-server/commit/3dd99dd80e27e5e1d99bd90c7aa90

升级parse-server到 5.5.2 或 6.2.1 或更高版本

参考链接

https://www.oscs1024.com/hd/MPS-6zr0-bcsh

https://nvd.nist.gov/vuln/detail/CVE-2023-36475

https://github.com/parse-community/parse-server/security/advisories/GHSA-462x-c3jw-7vr6

https://github.com/parse-community/parse-server/commit/3dd99dd80e27e5e1d99bd90c7aa90

免费情报订阅&代码安全检测

OSCS是国内首个开源软件供应链安全社区,社区联合开发者帮助全球顶级开源项目解决安全问题,并提供实时的安全漏洞情报,同时提供专业的代码安全检测工具为开发者免费使用。社区开发者可以通过配置飞书、钉钉、企业微信机器人获取一手的情报。

免费代码安全检测工具: https://www.murphysec.com/?src=osc

免费情报订阅: https://www.oscs1024.com/cm/?src=osc

具体订阅方式详见: https://www.oscs1024.com/docs/vuln-warning/intro/?src=osc

漏洞描述

GitLab 是一个开源的代码托管平台。

GitLab Premium/Ultimate的受影响版本中,如果启用了Merge Request的批准设置(approval settings),当用户在分支中提交Merge Request后的5-10秒内,用户在该支中新的提交仍然会添加到Merge Request中,具有审批权限的用户同意合并后新的提交代码将会合并到受保护分支中,攻击者可利用该漏洞向Gitlab仓库中注入任意代码。

影响范围

GitLab Premium/Ultimate@[15.9, 15.9.4)

GitLab Premium/Ultimate@[15.10, 15.10.1)

GitLab Premium/Ultimate@[15.7, 15.8.5)

修复方案

升级GitLab Premium/Ultimate到 15.8.5 或 15.9.4 或 15.10.1 或更高版本

关闭Merge Request的批准设置(approval settings)功能

参考链接

https://www.oscs1024.com/hd/MPS-2022-65252

https://nvd.nist.gov/vuln/detail/CVE-2022-4143

https://gitlab.com/gitlab-org/gitlab/-/issues/

https://hackerone.com/reports/

免费情报订阅&代码安全检测

OSCS是国内首个开源软件供应链安全社区,社区联合开发者帮助全球顶级开源项目解决安全问题,并提供实时的安全漏洞情报,同时提供专业的代码安全检测工具为开发者免费使用。社区开发者可以通过配置飞书、钉钉、企业微信机器人获取一手的情报。

免费代码安全检测工具: https://www.murphysec.com/?src=osc

免费情报订阅: https://www.oscs1024.com/cm/?src=osc

具体订阅方式详见: https://www.oscs1024.com/docs/vuln-warning/intro/?src=osc

导读

经过近几年的技术演进,语义模型在百度搜索场景中被广泛地应用,消耗了大量的GPU资源,模型压缩技术也随之得到大量研究和实践。通过兼顾推理性能、业务效果和迭代效率的优化目标,我们成功地将INT8量化技术大面积地应用到了搜索场景中,极大地提高了资源效能。此外,目前大模型正在被研究和应用,算力资源已经成为瓶颈,如何以更低的成本进行落地是一个非常热点的问题。基于对模型压缩技术的实践和积累,我们能够更好地助力大模型的探索和应用。

全文6287字,预计阅读时间16分钟。

01 搜索语义模型现状

ERNIE: Enhanced Representation through Knowledge Integration是百度在2019年4月的时候,基于BERT模型做的进一步优化,在中文的NLP任务上得到了state-of-the-art的结果。

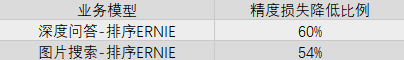

近年来,ERNIE 1.0/2.0/3.0等语义模型在搜索各个重点业务场景下得到了广泛应用,包括相关性、排序等多个子方向,消耗了大量GPU资源。每个业务方向一般由多个模型组成链路来完成最终计算,整体搜索业务所涉及的模型数量多、迭代快。目前,线上全流量模型超过几百个,月级迭代近百次。语义模型的大量应用对搜索产生了巨大影响,相关业务指标对模型精度的变化非常敏感。总的来说,在模型压缩技术的工程实践中,推理性能、业务指标和迭代效率三者的优化目标应当统一考虑:

1、推理性能:采用INT8量化,ERNIE模型的性能加速平均达25%以上。其主要影响因素包含输入数据量大小(batch size、sequence length等)、隐藏节点数、非标准网络结构与算子融合优化。

2、业务指标:以某相关性场景下的ERNIE模型为例,模型输出在数值上的diff率不超过1%,在离线测试集上的评价指标达到几乎无损。

3、迭代效率:离线量化达小时级,流水线式快速产出量化模型,不阻塞模型全生命周期的相关环节(如模型多版本迭代、小流量实验、全量化推全等)。

02 模型量化简述

简而言之,模型量化就是将高精度存储(运算)转换为低精度存储(运算)的一种模型压缩技术。优势如下:

-

更少的存储开销与带宽需求:如每层权重量化后,32位比特压缩到8比特甚至更低比特,模型占用空间变小;内存访问带宽的压力自然也会变小。

-

更快的计算速度:单位时间内执行整型计算指令比浮点计算指令更多;另,英伟达安培架构芯片还有专用INT8 Tensor core。

如果我们从不同的技术角度来看待它,那么:

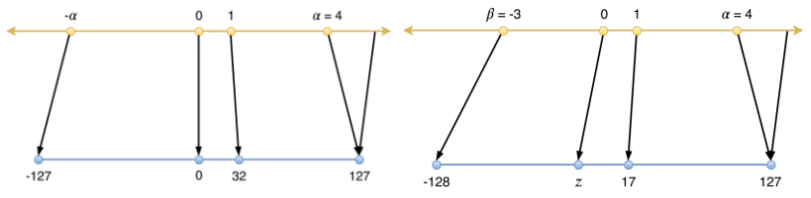

-

从映射函数是否是线性,分为线性和非线性。非线性量化计算较为复杂,一般主要研究线性量化,其公式如下:

Q = clip(round(R/S) + Z),其中R: high precision float number,Q:quantized integer number,s:scale,z:zero point。

-

从零点对应位置区分,线性量化又分为对称和非对称。

△1:对称与非对称量化

以矩阵乘为例,计算公式如下:

𝑹𝟏𝑹𝟐 = 𝒔𝟏𝑸𝟏𝒔𝟐𝑸𝟐 = 𝒔𝟏𝒔𝟐𝑸𝟏𝑸𝟐

𝑹𝟏𝑹𝟐 = 𝒔𝟏(𝑸𝟏 − 𝒛𝟏) 𝒔𝟐(𝑸𝟐 − 𝒛𝟐) = 𝒔𝟏𝒔𝟐𝑸𝟏𝑸𝟐 − 𝒔𝟏𝒔𝟐𝒛𝟐𝑸𝟏 − 𝒔𝟏𝒔𝟐𝒛𝟏𝑸𝟐 + 𝒔𝟏𝒔𝟐𝒛𝟏𝒛𝟐

在实际应用中,两者精度差异不大,对称量化在推理上更容易实现、计算更快。

-

从量化粒度上,分为逐层量化、逐组量化和逐通道量化。第一种在推理上最易实现,性能更好,一般应用在输入矩阵。第二和第三种在推理上难实现,但业务精度好,一般应用在权重矩阵。

-

从浮点矩阵中统计最大值是否截断上,分为饱和量化和非饱和量化。一般权重采用非饱和量化;输入/输出矩阵数据分布不均匀,采用饱和量化。

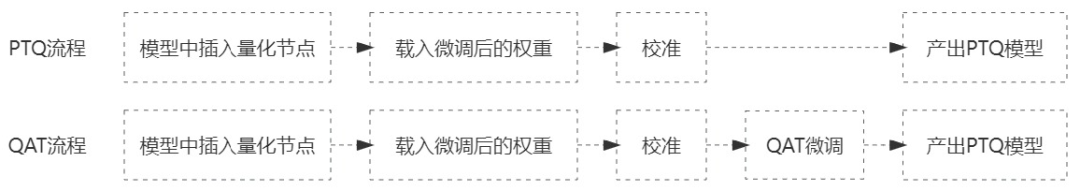

-

从是否参与训练上,分为训练后量化(Post-Traning Quantization,PTQ)和量化感知训练(Quantization Aware Training, QAT)。从实践上看,前者性价比最高,在精度损失可接受范围内能够快速产出量化后模型,并获得不错的性能加速;后者需要结合训练来看,往往是在PTQ造成精度损失过大时采取的进一步手段。

△图2:PTQ与QAT流程

- 从是否在推理中动态生成尺度因子,分为在线(动态)量化和离线(静态)量化。在线量化需要在推理过程中根据实际激活计算量化参数,会影响推理速度。

03 训练后量化

结合实际的应用场景,我们率先对训练后INT8量化技术进行了细致研究和大规模实践。本文中涉及到的硬件测试环境为GPU A10,CUDA 11.2,TensorRT8,工具链包括PaddlePaddle、PaddleInference、PaddleSlim等。

3.1 量化损失的精细化分析

低精度表示空间远远小于高精度表示空间,无论采用何种校准方法和校准数据,量化一定会带来不同程度上的数值误差。为了尽可能的减小误差、不影响模型业务指标,那么误差的来源和解决方案应当被全面细致地探究与分析。比如,哪些算子适合量化,每个算子量化后带来的端到端误差如何衡量,能否将误差较大的部分算子不作量化等问题。

3.1.1 量化算子的选择

通常情况下,应该优先对计算密集型算子(如mul、matmul;conv2d、depthwise_conv2d;pooling(pool2d);concat;elementwise_add等)进行量化,对非线性算子(如softmax,tanh,sigmoid,GeLU等)和非计算密集layer的算子不做量化。

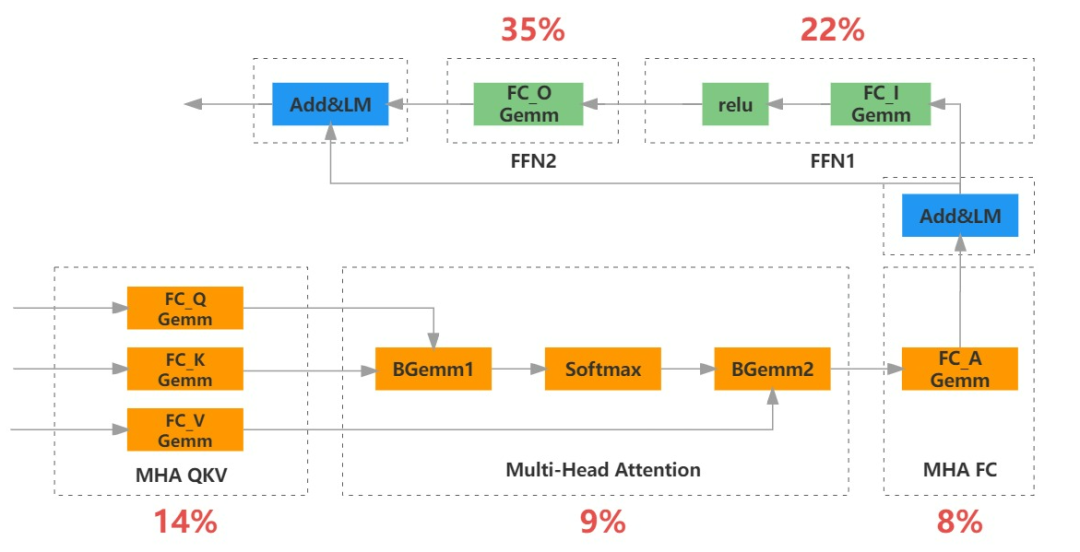

△图3:ERNIE模型经过算子融合后的FP16推理耗时占比情况

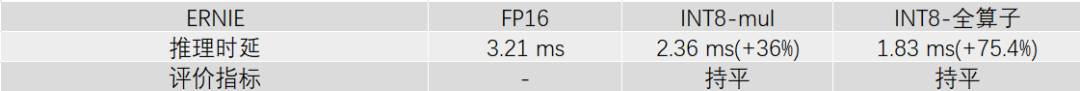

在ERNIE模型推理时,利用性能分析工具(nsight等)观察会发现,FC(对应paddle中mul)相关kernel耗时占比超过70%,BGEMM(对应paddle中matmul)相关kernel占比接近10%。因此可以重点从这两类算子入手进行量化,某线上ERNIE模型(输入数据batch size=10,max sequence length=128)的测试情况如下:

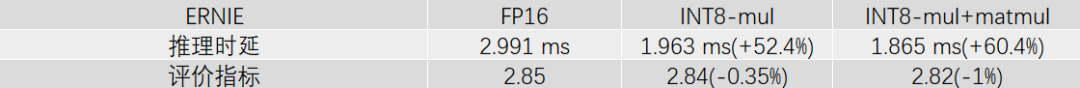

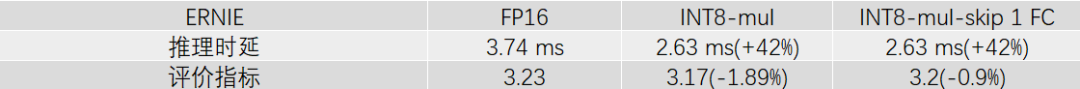

△图4:ERNIE模型FP16和INT8推理时性能加速与离线指标对比

对于FC,如果按照在推理时算子融合后网络中所处的位进行划分的话,可以人为地分成4类:

-

QKV FC:推理时Q、K、V位置的3个FC会被融合在1个kernel进行计算,后续将其作为一个整体来看待。

-

multi-head att-FC:经过多头注意力计算后的线性算子。

-

FFN FC:FFN中的2个FC,第1个FC和激活函数(如relu)会融合成1个kernel,第2个FC是独立的kernel。

-

业务FC(未体现在示意图中):在主体ERNIE结构后增加若干FC进行微调,应用于不同的业务场景。推理时可能也会有算子融合操作。

之所以按照上述方式进行划分:一是划分粒度更精细,便于观察和判定量化误差来源;二是尽可能与当前的推理实现逻辑保持一致,减少不必要的复杂改动。在算子类别+数量的多重组合下,更细粒度的量化,能更好地平衡性能加速和精度。

3.1.2 量化算子的敏感性

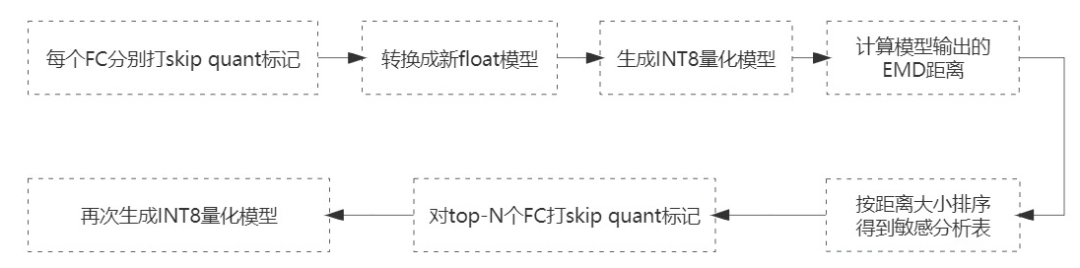

某层算子量化不当所带来的损失会在层间逐渐传递累积,模型层数越深、宽度越大,损失可能也会越大。每层内算子的量化误差对端到端指标的影响也是不一样的。在实践中,不同业务场景或者不同模型版本之间,量化后的业务指标损失不同,不一定都能在可接受范围内。这种情况下,最直接的方法是找出造成损失较大的算子,并将其跳过不做量化。被量化的算子减少,损失也会随之降低。一个12层ERNIE模型结构中至少有12*6个FC算子,绝大部分按INT8计算,只有几个仍按FP16计算,其性能加速变化不会大,模型指标损失却能更小。通过遍历每个FC算子对模型指标的敏感性大小,就能判定哪些FC可以不做量化。

△图5:量化算子的敏感性分析方法

其中,打skip quant标记的粒度与上一节中提到的FC划分方法保持一致,比如QKV内3个FC全量化或全不量化。EMD距离是指量化前后在某个小数据集上的输出值之间的分布距离,距离越小则被认为敏感性越强。

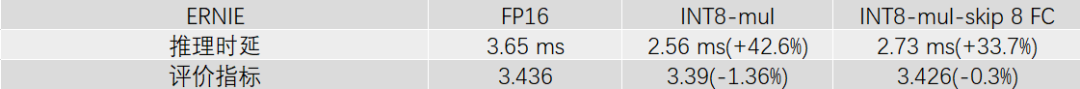

案例1:线上某ERNIE模型经过多次微调迭代后,全FC量化后的离线评价指标下降了约1.4%。利用敏感性分析方法后,跳过前8个敏感FC后,量化模型的离线评价指标损失已经很小,性能加速仍有30%以上。

△图6:全FC量化与跳过4个FC不作量化时的推理加速与离线指标对比

案例2:线上某ERNIE模型,全FC量化后的离线评价指标下降了2%左右。只跳过前1个敏感FC后,就很好地拉回了离线评价指标。

△图7:全FC量化与跳过1个FC不做量化时的推理加速与离线指标对比

通过这个方法,我们能很好地兼顾性能加速和模型精度。经过大量实验后发现,FFN内FC往往更加敏感,对业务指标的影响更大。

3.1.3 数值统计分析

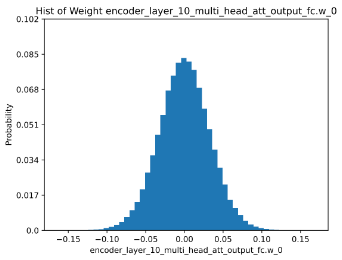

量化过程本质上是寻找合适的映射函数,让量化前后的输入/出矩阵或权重矩阵更加拟合。溯源分析,输入/出矩阵和权重矩阵分布情况从根本上决定了量化效果的好坏。对于量化效果极差的模型,一般会对相关矩阵再进行可视化地数值统计分析,这样我们能够发现是否存在大量异常点,校准算法是否适用等,进而倒推出更优的解决方法。

△图8:ERNIE模型某FC权重数值分布的直方图统计

3.2 校准数据增强

校准数据的优劣是决定量化损失大小的重要因素之一。

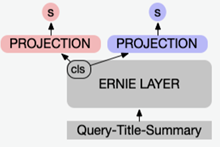

在搜索某资讯业务场景中,使用了多头输出(一个输出打分对应一个子任务)的ERNIE模型,如下:

△图9:多头输出的模型结构示意图

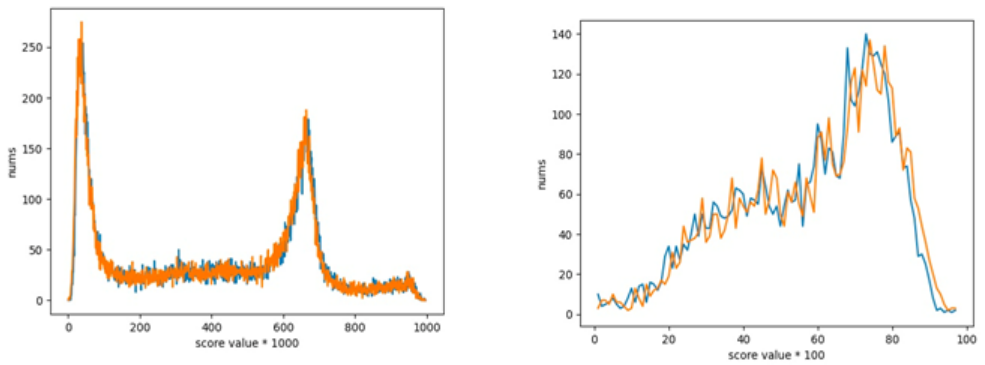

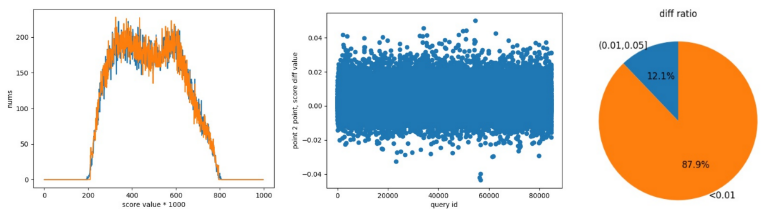

针对这个模型进行量化时,采用了训练时部分数据作为校准集,结果发现子任务二的离线效果变得很差。通过分析模型训练微调的过程后,将子任务一和子任务二的训练数据进行等比例混合随机后再作为校准集,量化后的离线效果均得到了满足。

△图10:数据增强前,子任务一和子任务二在测试集上的打分分布情况

△图11:数据增强后,子任务一和子任务二在测试集上的打分分布情况

校准数据是从训练/测试数据中抽取的一个小集合,应当尽可能地保持数据分布的一致性。有些模型的离线测试集并不完善,离线指标不能很好的反应量化损失,也可能会出现离线效果与在线实验评价不一致的情况,此时可以将在线数据混入离线数据共同作为校准数据。另外,模型迭代通常是在解决bad case,校准数据中也应当注意bad case的比例。

3.3 超参自动寻优

量化包括不同的校准算法(正在使用avg、abs_max、mse、KL、hist等)、校准数据量大小(batch size/num)、是否开启偏置校准等超参,不同模型采用一组相同的量化参数,其损失变化也不同,因此超参自动寻优是必不可少的。一方面,通过自动化可以提高迭代效率;另一方面,更大的搜索空间能够获得比人工调参更优的量化后模型。

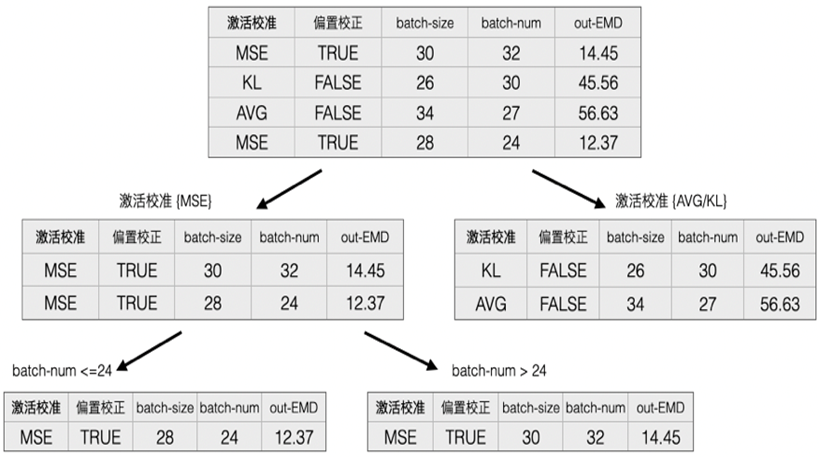

△图12:超参自动寻优方法

具体实现步骤:

-

选择初始若干组参数产出量化后模型,推理计算量化前后模型在校准集上的输出值之间的分布距离(earth mover’s distance,EMD)

-

根据超参和分布距离,构建随机树

-

随机采样若干组不同的参数组合,依次插入随机树内进行推理并计算相关距离

-

按照上一个步骤中分布距离最短的若干组参数进行实际量化

-

从第一步再循环执行,直到分布距离收敛

相比于人工调优,这种方法能够更快地搜寻到更优的量化后模型。比如:

△图13:超参自动寻优实践案例

实际上,同类型业务场景下,模型结构不会有很大变动,多次微调迭代后,超参自动寻优的参数往往会被锁定在一个小范围内。因此,我们会以类漏斗形式进行量化模型寻优,即优先在事先圈定的小范围参数内遍历量化,损失不满足要求后再进行大范围的搜索。

3.4 效果评估

搜索业务场景多种多样,离线评价方式各异。如果考虑量化方案的通用性和多维度评估能力,建设独立量化损失评价指标是必要的。类似于EMD的距离度量,打分分桶分布等方法可以作为辅助性指标来使用。

△图14:一组模型量化前后在测试集上打分/输出的数值diff情况

04 量化感知训练

相对于训练后量化,量化感知训练的模型精度更好,但流程较为复杂。一般情况下,量化感知训练作为改善训练后量化损失的进阶技术手段。

4.1 无侵入式量化训练

为了降低量化训练难度,实际上我们会采用无侵入式方法,即推理模型+训练数据。首先,对推理模型进行梯度恢复,转换成参数可训练的网络,并插入fake quant op再转换成量化后网络;然后使用量化推理模型对量化后网络进行块量化损失监督,进而降低量化损失。

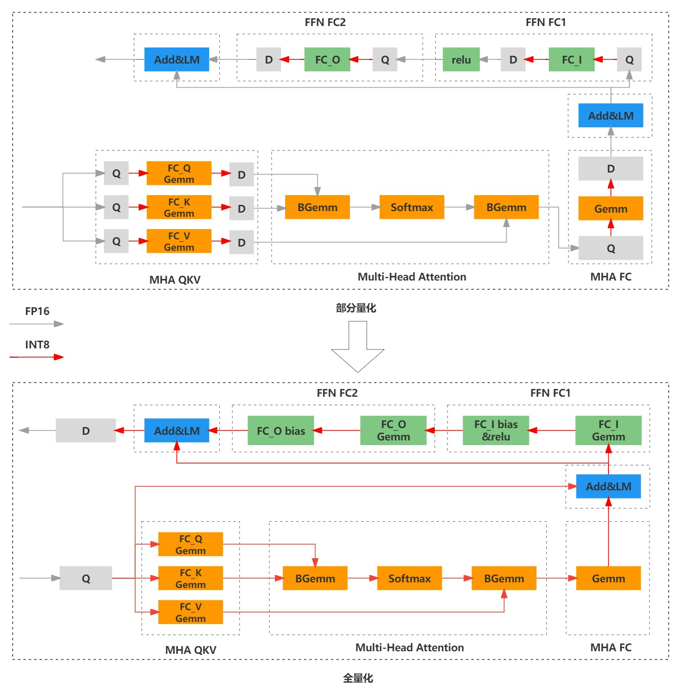

4.2 全算子量化

因为精度问题,训练后量化中一般只对部分算子做量化。进一步提升推理性能,对全算子量化的话,需要和量化感知训练结合起来。全算子量化是除了mul或者matmul算子进行量化外,又增加了layer norm相关算子和中间传参过程。

△全算子与部分算子INT8量化的模型网络示意图

全算子量化在中文场景下表现出一些特异性:

-

量化后激活分布异常值多,推理端量化累计误差变大。

-

QKV的输出激活scale值较大,推理端中间层输出为0,导致精度错误。

经过摸索,可行的解决方案如下:

-

先进行训练后量化,采用直方图校准方式,将激活scale值限制在某个较小范围内。

-

固定离线量化产出的激活scale值,再进行权重逐通道的量化训练。

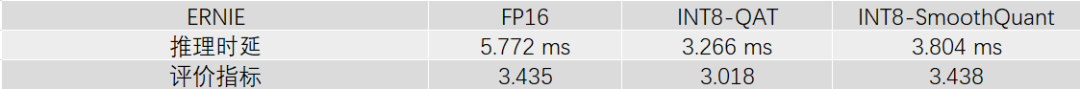

在搜索相关性某ERNIE模型上,输入数据batch size=20,max sequence length=128时,具体实验情况如下:

△图16:全算子INT8量化的性能加速与离线评价实验结果

4.3 SmoothQuant

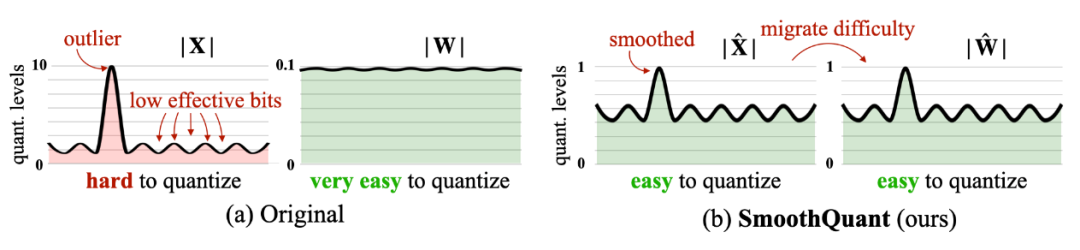

SmoothQuant是无训练、保持精度和通用的训练后量化方案,试图解决大模型(>6.7B)量化问题。简单来说,基于权重易量化、激活不易量化的事实,通过离线的数学等价变换将激活的难度迁移到权重上,将激活和权重都变得较容易量化。

△17:SmoothQuant核心原理 [1]

在某些量化损失较大的小模型上,我们采用量化感知训练+SmoothQuant进行了相关实验,也能有不错的表现。比如:

△图18:SmoothQuant实验结果

05 展望

目前INT8量化技术已经在线上大规模应用,使整体GPU资源利用效率得到了极大提升,也支撑了更多更复杂模型的演进。

通过总结大量实践经验和技术调研,更低比特量化(如INT4)、INT8量化+Token剪枝多压缩手段融合等正在实验和落地中。

因为线上业务子方向众多,模型多&迭代快,将实践经验抽象出通用方案势在必行,建设平台化、流水线式管理模型整个生命周期能够大幅度提高效率。同时,也可以将通用方法论应用到其他模型压缩技术的工程应用上。

近期,大模型相关技术方向的研究相当火热,模型压缩也是热点之一。初步调研后,在小模型上有效的技术手段有一部分是可以直接平迁到大模型上的,有一些则需要改进。比如,大模型训练相当复杂,量化感知训练看起来不是那么经济。根据相关业界动态,PTQ-Weight Only,LLM.int8(),SmoothQuant等技术正在被研究和使用。

——END——

参考资料:

[1]https://arxiv.org/pdf/2211.10438.pdf

推荐阅读:

如何设计一个高效的分布式日志服务平台

视频与图片检索中的多模态语义匹配模型:原理、启示、应用与展望

百度离线资源治理

百度APP iOS端包体积50M优化实践(三) 资源优化

代码级质量技术之基本框架介绍

基于openfaas托管脚本的实践

Xline是一个面向多集群的高性能分布式键值存储引擎。可以为多集群场景提供统一的数据管理,使相互访问、发现、修改变得简单方便。它还提供KV接口、多版本并发控制并兼容etcd和K8S。

Xline 是第一个基于 CURP(一种 WAN 共识协议,请阅读论文了解更多详细信息)的地理分布式一致性管理服务。它解决了跨云融合和一致性的挑战。

它提供以下功能:

- etcd 兼容 API。

- 地理分布式友好部署。

- 兼容K8s。

该项目针对多数据中心场景,旨在实现高性能的多云数据管理解决方案,这对于具有地域分布式、多活部署需求的企业至关重要。

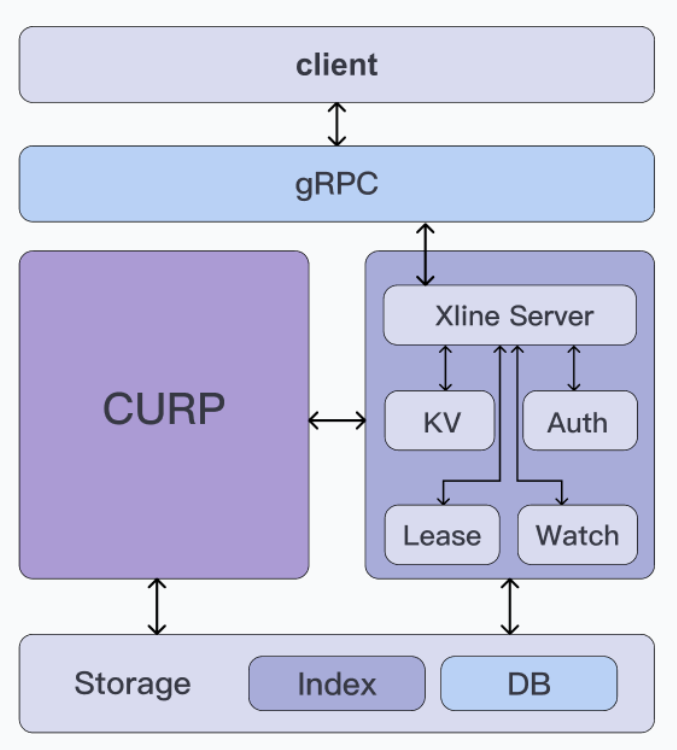

Xline 实例由以下层组成:

- 客户端层:提供简单易用的API供客户端使用,可以大大降低使用Xline进行业务的复杂度。后续版本将实现不同语言的 Xline 客户端,目前 Xline API 与 etcd 兼容,可以使用 etcdctl 发起请求。

- 接入层:接入层主要包括客户端到服务器或者服务器到服务器之间的通信协议。Xline API 基于 gRPC 协议。

- CURP协议层:CURP协议层实现了Leader选举、日志复制、快路径和慢路径等核心算法功能,用于保证Xline多节点之间的数据一致性,提高服务可用性。CURP协议是Xline的基石和亮点。

- 功能逻辑层:该层实现Xline业务逻辑,包括典型的KV Server、Auth Server、Lease Server和Watch Server等。Client通过接入层向Xline Server发送请求,Xline Server将请求调度到特定服务器执行。

- 存储层:该层包含两个组件,Index和DB,其中Index基于BTreeMap,DB主要负责数据的持久存储。目前Xline还处于开发初期,所以DB主要是基于内存实现的。我们将在下一版本中引入持久存储。

主要特点:

- 一种面向多集群的分布式KV存储引擎。多集群场景的数据统一管理,相互访问、发现、修改简单便捷。

- 统一的数据管理系统。通过将热点数据缓存在内存中进行跨云数据访问,并提供统一的数据管理,实现数据迁移和备份的自动化。

- 高性能多数据中心共识协议。它是第一个基于WAN共识协议的地理分布式一致性管理服务。它解决了跨云融合和一致性的挑战。

- 兼容ETCD接口。提供KV接口,多版本并发控制,兼容K8S。

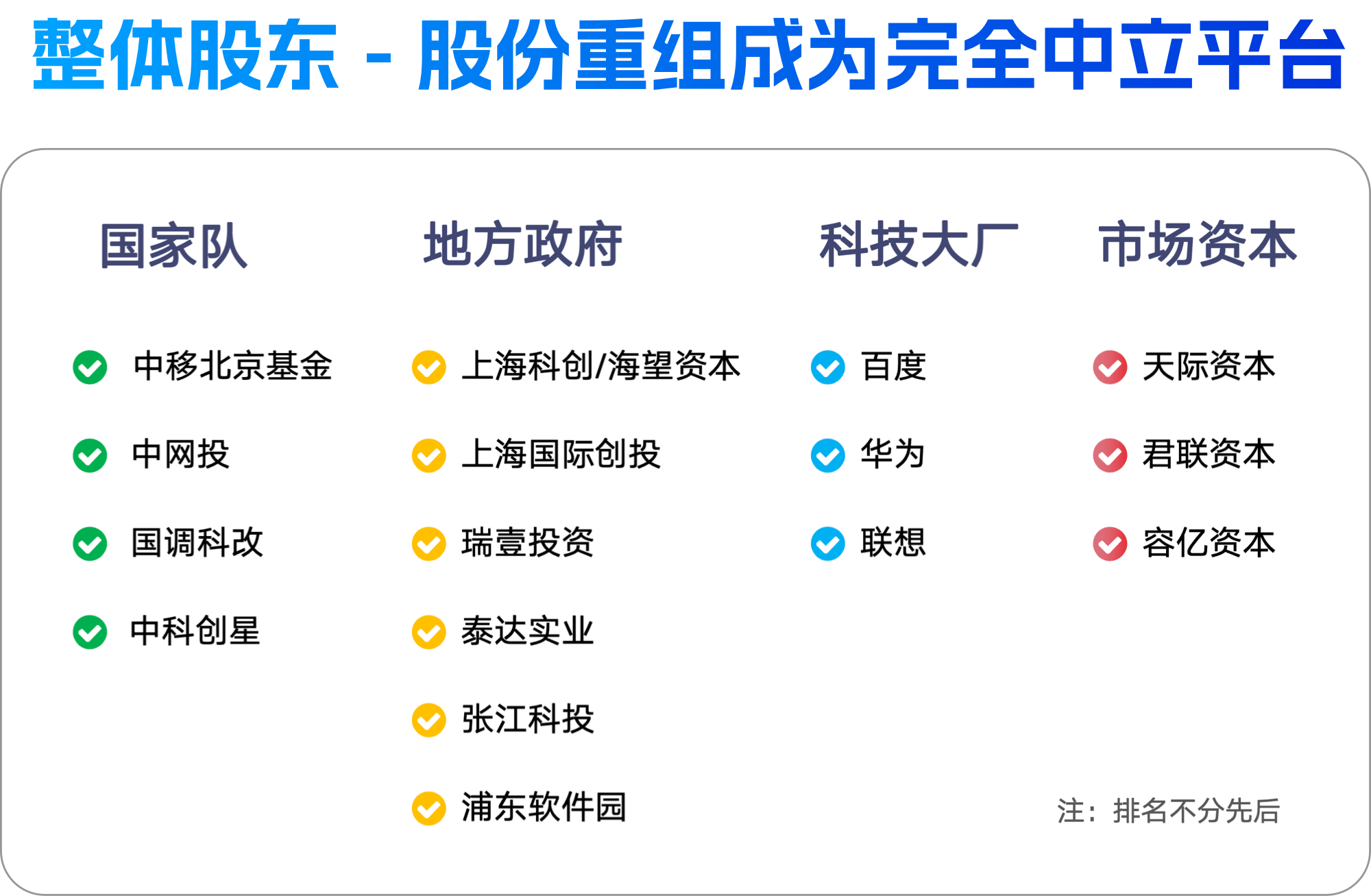

近日,开源共识(上海)网络技术有限公司(开源中国/Gitee)完成了 B+ 轮战略融资,此轮融资由天际资本领投,上海科创旗下海望资本联合泰达实业、浦东软件园及张江科投、君联资本、上海国际创投、瑞壹投资、容亿资本、中国移动旗下中移北京基金、中网投、国调科改、联想创投及上海科创共同出资,融资总额达 7.75 亿人民币。

至此,原股东百度(传课计算机系统〔北京〕有限公司)股比由51.54%降至14.04%,公司创始团队重新成为实际控制人,经此股份重组企业成为完全中立平台。

开源中国创立于2008年,收录全球知名开源项目近10万款,涉及几百个不同的分类,并于2022年发布了中国开源社区 Landscape,收录200+ 开源社区;同年收购日本老牌开源社区 OSDN,该社区前身为 Sourceforge.jp。

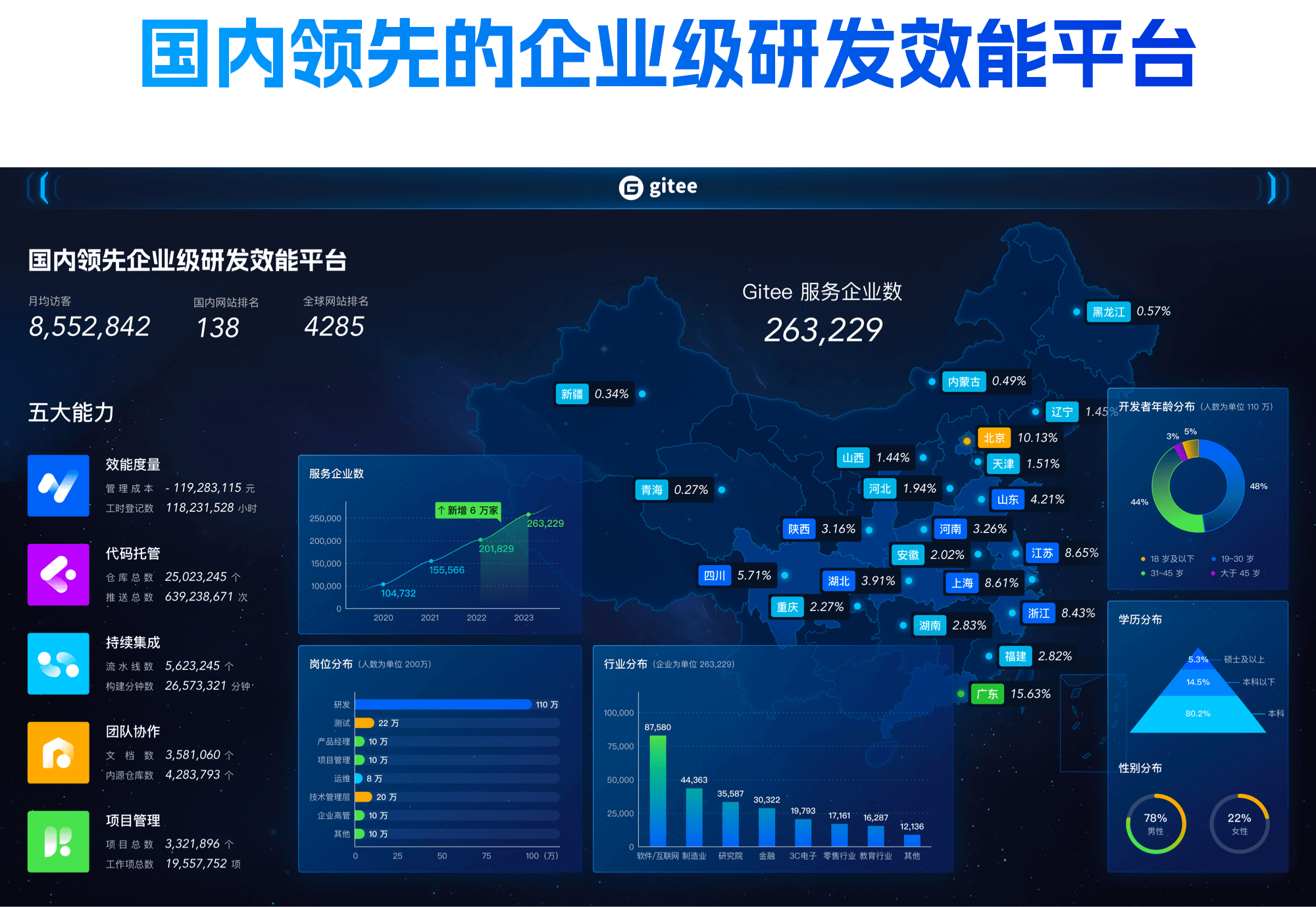

开源中国于2013年发布代码托管平台 Gitee,是目前国内领先的代码托管服务平台,并于2020年开始牵头建设工信部国家开源托管平台项目。Gitee 于2017年上线发布针对企业级的研发效能平台 Gitee 企业版。

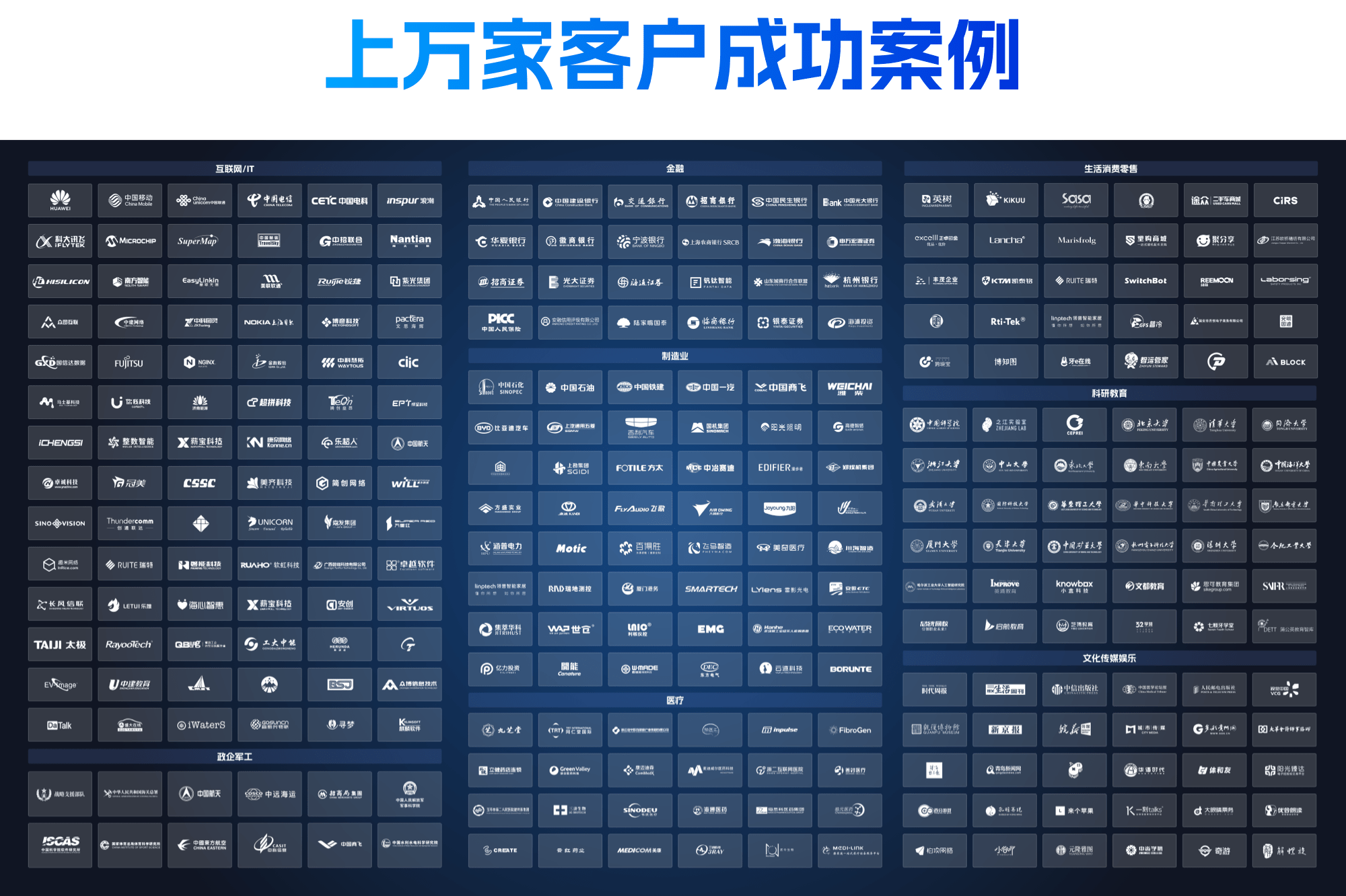

截至目前,Gitee已经服务1000 万开发者用户、26 万家企业(含1200 家中大型私有化部署企业)以及2000多家高等院校。

开源中国董事长马越对开源中国十五年来的发展表示:“我们经历了从开源社区,到开源代码托管平台,再到今天 DevOps 研发效能平台的演进,实现了从流量平台,到可闭环商业化平台的转变。这个过程中,不仅为中国开源生态贡献了价值,也为中国企业软件研发效能贡献了商业化力量。”

马越还提到,目前海外几家知名开发者工具服务商,其总市值共计可达千亿美以上,开源中国的目标是对标海外上市公司填补国内 A 股空白。

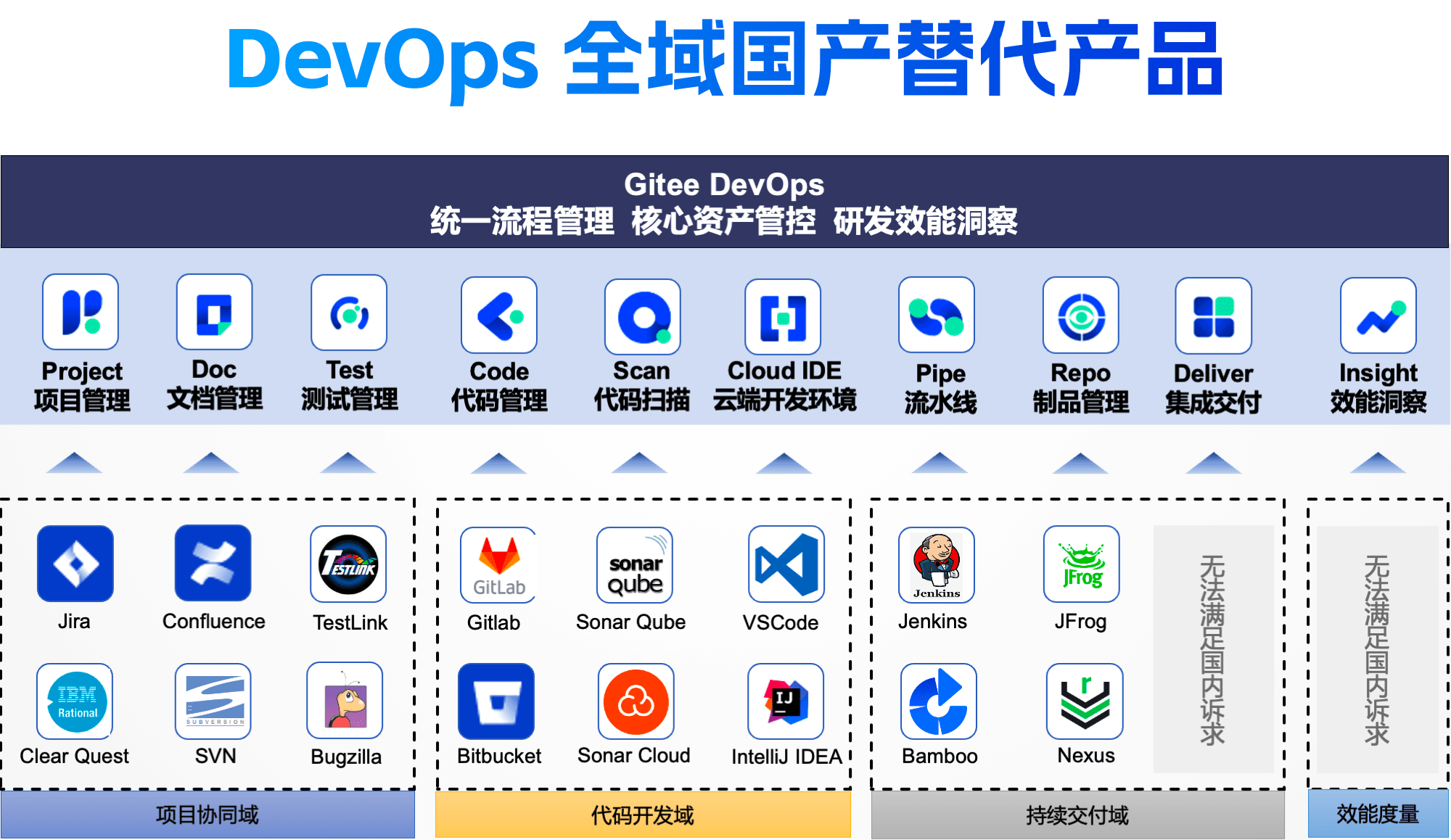

具体来说,除代码托管服务平台对标的 GitHub 外,其他对标厂商分别为美国Atlassian(市值500亿美,曾一度突破千亿美市值)、美国 GitLab(市值80亿美)、以色列 JFrog(市值30亿美)。其中,Atlassian 是全球最大的项目管理和解决方案提供商,旗下 Jira、Confluence、Trello 几乎已经成为海外互联网公司开发过程中的基础设施,GitLab 是开源代码管理平台,JFrog 是二进制制品管理仓库,三者都被全球开发者所熟知并使用。

想要同时对标这些产品,不仅单点产品要做好,更是要做好 DevOps 全生命周期 All-in-One 的整套产品,满足开发者的一体化需求。

为了达成该目标,开源中国自2020年就开始深耕相应产品的国产替代方案,在满足开发者需求的同时,打造出一个自主创新、安全可信的本土开源软件工具与生态,减少开发者对海外开源软件的过度依赖,构建安全可控的中国信息化体系——这也是开源中国最重要的商业化路径。

目前,Gitee产品矩阵已构建了完整替代解决方案:Gitee Team 替代 Jira,Gitee Code 替代 GitLab,Gitee Pipe 替代 Jenkins,Gitee Repo 替代 JFrog,系列产品覆盖了软件工程的需求管理、代码管理、协作管理、制品管理等流程。尤其是针对私有云部署需求,Gitee 能够给国家大量政府、军工、金融、制造业等大客户提供一站式开发服务。

在马越看来,Gitee 之所以要做一站式产品,就是因为在服务中国大部分国央企类企业时,他们更希望在同一个平台里使用工具,而并非对接好几个系统和供应商。

同时,在国产替代浪潮袭来的当下,研发数据也是国家的重要资源,使用国产工具更能保障其安全性。马越表示,在互联网时代,中国1000万开发者都是国家重要的发展力量,而开源中国要做的是中国开发者的“兵工厂”。

目前,开源中国研发团队规模占总员工的85%以上,在本次战略融资后,团队将把更多资金用于产品及 AI 领域研发和商业化拓展,在软件自主可控的时代背景下,期望用两到三年的时间,成为中国资本市场的软件/AI 工程工具厂商第一股。

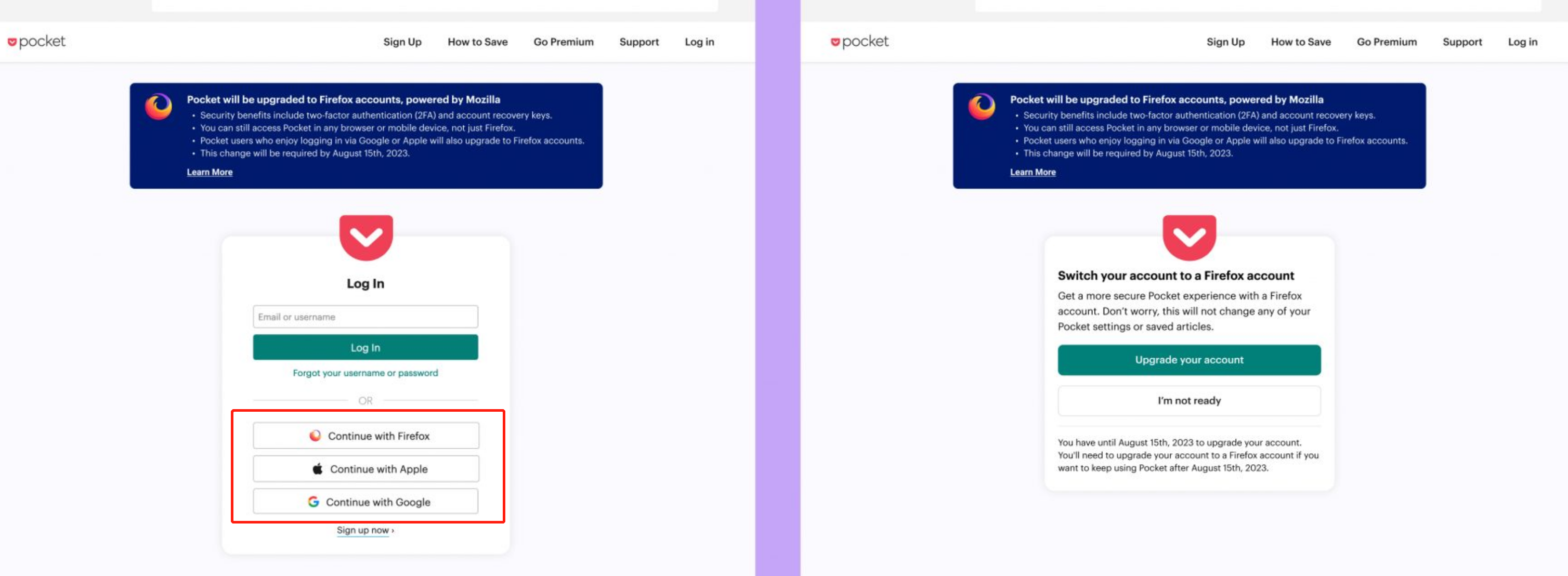

Mozilla 在博客中宣布:以后旗下的 Pocket 应用只能使用 Firefox 帐户登陆。

Pocket是一项免费的商业服务,允许用户保存在网络上找到的文章、对文章进行分类,以及阅读和收听这些文章。高级用户还可以获得无广告的体验、全文搜索选项等等。Pocket 还包括发现和推荐功能。

自 2017 年被收购以来,Pocket 一直是 Mozilla 产品系列的一部分。

之前 Pocket 用户有四种注册选项:可以使用 Firefox 帐户或创建一个帐户,或使用 Apple / Google 帐户登录,或使用其他电子邮箱进行注册。但使用第三方帐户登录的选项将在未来几个月内被删除,Firefox 帐户将成为唯一的选择。

从 2023 年 7 月 11 日开始,系统将提示 Pocket 用户转换到 Firefox 帐户。而在 2023 年 8 月 15 日之后,只有 Firefox 帐户才能登录。

Mozilla 对用户的疑问发布了详细的 QA 文档,里面详细解释了为何要限制仅 Firefox 登陆,以及 Apple / Google 帐户的内容如何迁移到 Firefox 帐户等内容。

ECMAScript 2023 现已获得 ECMA International 的批准。ECMAScript 是标准化的 JavaScript 语言,于 1997 年发布了第一版,现已发展成为世界上使用最广泛的通用编程语言之一。

本 Ecma 标准定义了 ECMAScript 2023 Language,是 ECMAScript 语言规范的第 14 版。

ECMAScript 2023,第 14 版,在和上引入了、、、和方法,以及上的方法;在文件开头增加了对注释的支持,以更好地促进 ECMAScript 文件的可执行;并允许在弱集合中使用大多数 Symbols 作为 keys 。

最终提案由 ECMA TC39 在 GitHub 上发布,详细阐述了今年将发布的四个功能:

Array find from last

该提案在和原型上增加了和 方法。这与 Array.prototype.find 和 Array.prototype.findIndex 的行为相同,但会从最后一个迭代到第一个

const array = [{ value: 1 }, { value: 2 }, { value: 3 }, { value: 4 }]; array.find(n => n.value % 2 === 1); // { value: 1 } array.findIndex(n => n.value % 2 === 1); // 0 // ======== Before the proposal =========== // find [...array].reverse().find(n => n.value % 2 === 1); // { value: 3 } // findIndex array.length - 1 - [...array].reverse().findIndex(n => n.value % 2 === 1); // 2 array.length - 1 - [...array].reverse().findIndex(n => n.value === 42); // should be -1, but 4 // ======== In the proposal =========== // find array.findLast(n => n.value % 2 === 1); // { value: 3 } // findIndex array.findLastIndex(n => n.value % 2 === 1); // 2 array.findLastIndex(n => n.value === 42); // -1

Hashbang Grammar

Hashbang,也称为 shebang,是可执行脚本开头的字符序列,用于定义要运行的程序的解释器。当 Unix 内核的程序加载器执行 JavaScript 程序时,主机会剥离 hashbang 以生成有效源,然后再将其传递给引擎。Hashbang Grammar 提案标准化了它的完成方式。

#!/usr/bin/env node // in the Script Goal 'use strict'; console.log(1);

#!/usr/bin/env node // in the Module Goal export {}; console.log(1);

Symbols as WeakMap keys

该提案扩展了 WeakMap API,以允许使用 unique Symbols 作为 keys。

const weak = new WeakMap(); // Pun not intended: being a symbol makes it become a more symbolic key const key = Symbol('my ref'); const someObject = { /* data data data */ }; weak.set(key, someObject);

Change Array by Copy

在和上提供了额外的方法,通过返回一个带有变化的新 copy 来实现对数组的改变。

const sequence = [1, 2, 3]; sequence.toReversed(); // => [3, 2, 1] sequence; // => [1, 2, 3] const outOfOrder = new Uint8Array([3, 1, 2]); outOfOrder.toSorted(); // => Uint8Array [1, 2, 3] outOfOrder; // => Uint8Array [3, 1, 2] const correctionNeeded = [1, 1, 3]; correctionNeeded.with(1, 2); // => [1, 2, 3] correctionNeeded; // => [1, 1, 3]

具体可查看:

- https://262.ecma-international.org/14.0/

- https://www.ecma-international.org/wp-content/uploads/ECMA-262_14th_edition_june_2023.pdf

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

ECharts 宣布诞生 10 周年。

ECharts 是一款基于 JavaScript 的开源可视化图表库,提供了开箱即用的 20 多种图表和十几种组件,并且支持各种图表以及组件的任意组合。

ECharts 最初由百度团队开源,并于 2018 年初捐赠给 Apache 基金会,成为 ASF 孵化级项目。

2021 年,Apache ECharts 顺利毕业晋升为 ASF 顶级项目。开源中国在 ECharts 从 ASF 毕业成为顶级项目时,对 ECharts 团队进行了专访,点此查看:专访 Apache ECharts 团队:从 ASF 毕业经历了什么?

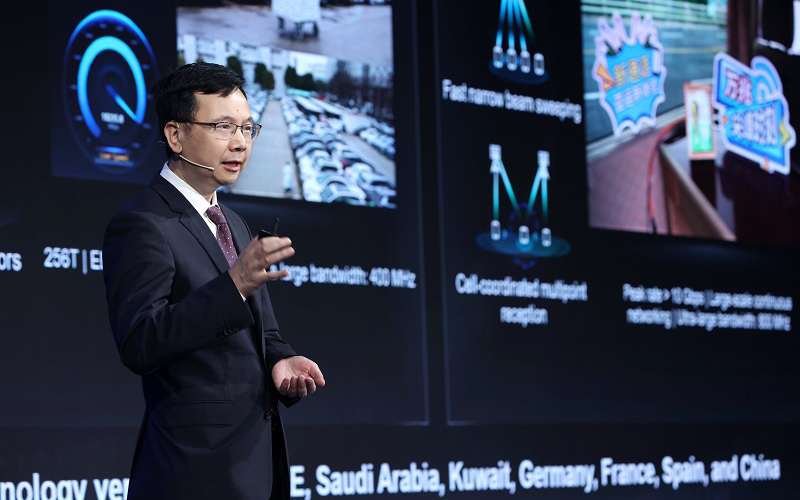

华为董事、ICT 产品与解决方案总裁杨超斌在 2023 MWC 上海展 5G Advanced 论坛上宣布:2024 年,华为将会推出面向商用的 5.5G 全套网络设备。这也标志着 ICT 行业即将迈入 5.5G 时代。

目前全球已经有超过260张5G商用网络,超过12亿5G用户,1.15亿F5G千兆用户。与此同时,新的业务形态与内容,也在持续地演进升级,包括裸眼3D等在内技术的突破,将个人沉浸式体验带上了新高度,这些新业务也对5G网络的能力提出了更高的要求。

华为倡导的5.5G时代,包含5.5G、F5.5G、Net5.5G等全面演进升级的端到端解决方案,5.5G时代一方面可以保护运营商的5G投资;另一方面将会带来10倍的网络性能提升。不仅实现下行万兆、上行千兆的峰值能力,以满足丰富多样的业务需求,同时还引入无源物联等全新技术以打开千亿物联新空间,开创新的产业愿景。

杨超斌表示:“面向5.5G时代的技术和商业验证均已就绪,标准节奏明确,5.5G时代正蓄势待发。2024年,华为将会推出面向商用的5.5G全套网络设备,为5.5G的商用部署做好准备! 华为期待和产业携手,共同开启5.5G时代新征程!”

2023年6月17日,中国开源软件推进联盟 PostgreSQL 分会在成都举办了数据库技术峰会。此次峰会以“新机遇、新态势、新发展”为主题,结合当下信创热潮、人工智能等产业变革背景,探讨 PostgreSQL 数据库在这些新机遇下的发展前景。峰会邀请众多行业大咖、学术精英、技术专家、技术爱好者等参加本次盛会,分享 PostgreSQL 数据库未来的发展机遇、新技术和新方向,推动 PostgreSQL 在中国的发展。

拓数派作为 PG 分会的生态伙伴受邀参与本次峰会。拓数派 PieCloudDB 产品经理陈金豹在活动中发表主题演讲《云原生虚拟数仓 PieCloudDB 的架构和关键模块实现》。

图为 拓数派 PieCloudDB 产品经理陈金豹

陈金豹认为公有云是未来数据库发展的重要方向之一,而以关系型数据库为基础的数据仓库缺乏弹性,难以利用公有云的优势;NoSQL 和数据湖的解决方案又缺乏对事务 ACID 的支持,且难以胜任复杂的数据分析场景。用户期望一个兼顾关系型数仓和公有云优势的产品,这也是 PieCloudDB Database 的设计目标。

PieCloudDB 在计算引擎方面提供了完备的 SQL 支持、ACID 事务支持以及高效的查询优化和执行器,完全胜任各种复杂的数据分析场景;而在公有云特性方面,PieCloudDB 实现存算分离,提供弹性的计算集群,用户可以按需为计算和存储付费,实现降本增效。

PieCloudDB 的云原生架构中包含了两条重要特性:弹性伸缩的集群和 Multi-Cluster。PieCloudDB 使用完全无状态的 Segment 节点提供极致的计算集群弹性;而多集群特性则是通过独立的系统表以及分布式锁和事务共同实现。最后,陈金豹介绍了未来 PieCloudDB 即将发布的一些关键特性:Time Travel、Branch、Data Sharing 以及已经发布的性能优化特性聚集下推和预聚集。

2023 PostgreSQL 数据库技术峰会成都站圆满结束。PostgreSQL 历经三十多年的发展,越来越受到用户的欢迎和认可,在 DB-Engines 稳定保持在前列。根据 Stack Overflow 2023 年度调查报告,PostgreSQL 取代 MySQL 位居第一,成为年度最受欢迎的数据库。这些无一不表明了 PostgreSQL 的生态优势,拓数派作为PostgreSQL 社区生态伙伴,秉持拥抱开放的企业文化,一直以代码贡献、讲师布道、会议赞助等多种形式参与到 PostgreSQL 的社区贡献中,在未来拓数派将继续为社区贡献一份力量。

进入拓数派B站官方账号,观看完整演讲视频。

2023年7月4日~5日,由中国信息通信研究院、中国通信标准化协会指导,中国通信标准化协会大数据技术标准推进委员会(CCSA TC601)主办的2023可信数据库发展会将于北京国际会议中心隆重召开。

大会以“自主·创新·引领”为主题,开设金融、电信、互联网、汽车四大行业分论坛以及云原生与开源数据库、搜索与分析型数据库、数据库运维及生态工具、时序时空及图数据库四大分论坛,邀请众多知名院士、行业协会领导、数据库学术大咖、产业链各环节数据库负责人、资深技术专家等共同论道新形势下数据库产业可持续、高质量发展的方法,并针对性解决上述产业发展中的痛点问题。

杭州拓数派科技发展有限公司(也称“OpenPie”)立足于国内,基础数据计算领域的高科技创新企业,也将参与本次大会。届时,拓数派 CTO 郭罡将于搜索与分析型数据库分论坛中与大家分享《PieCloudDB 云原生数仓虚拟化的演进与发展》。

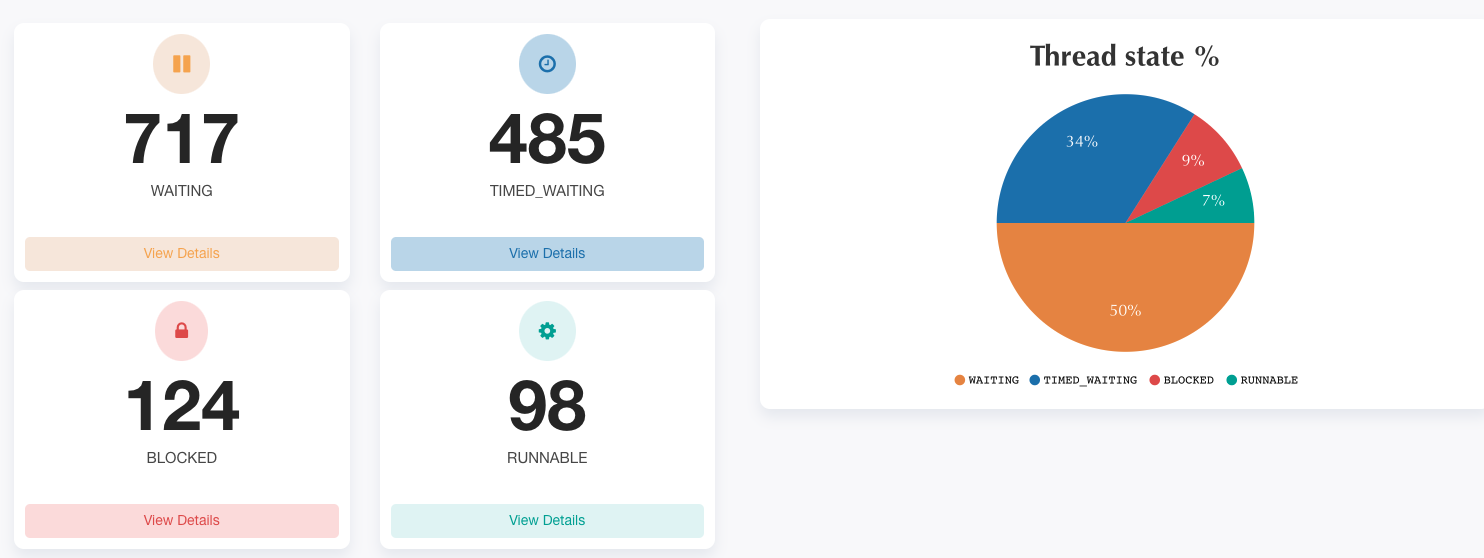

1 问题现象

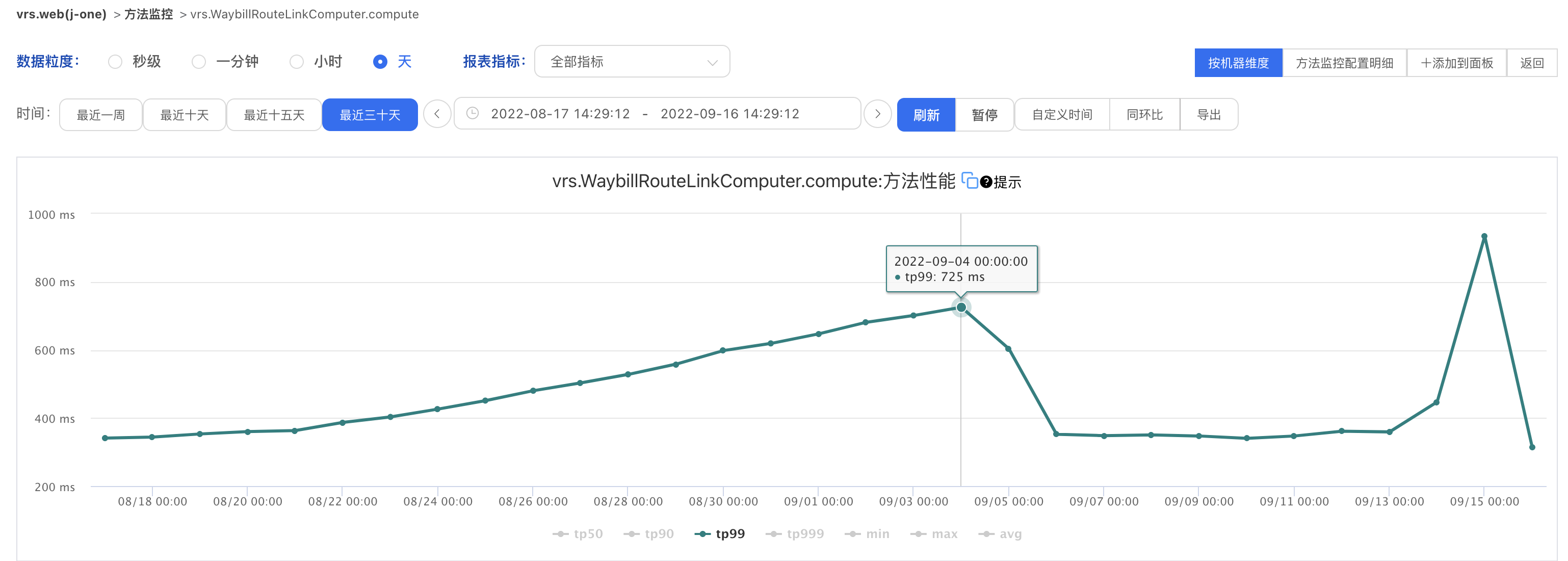

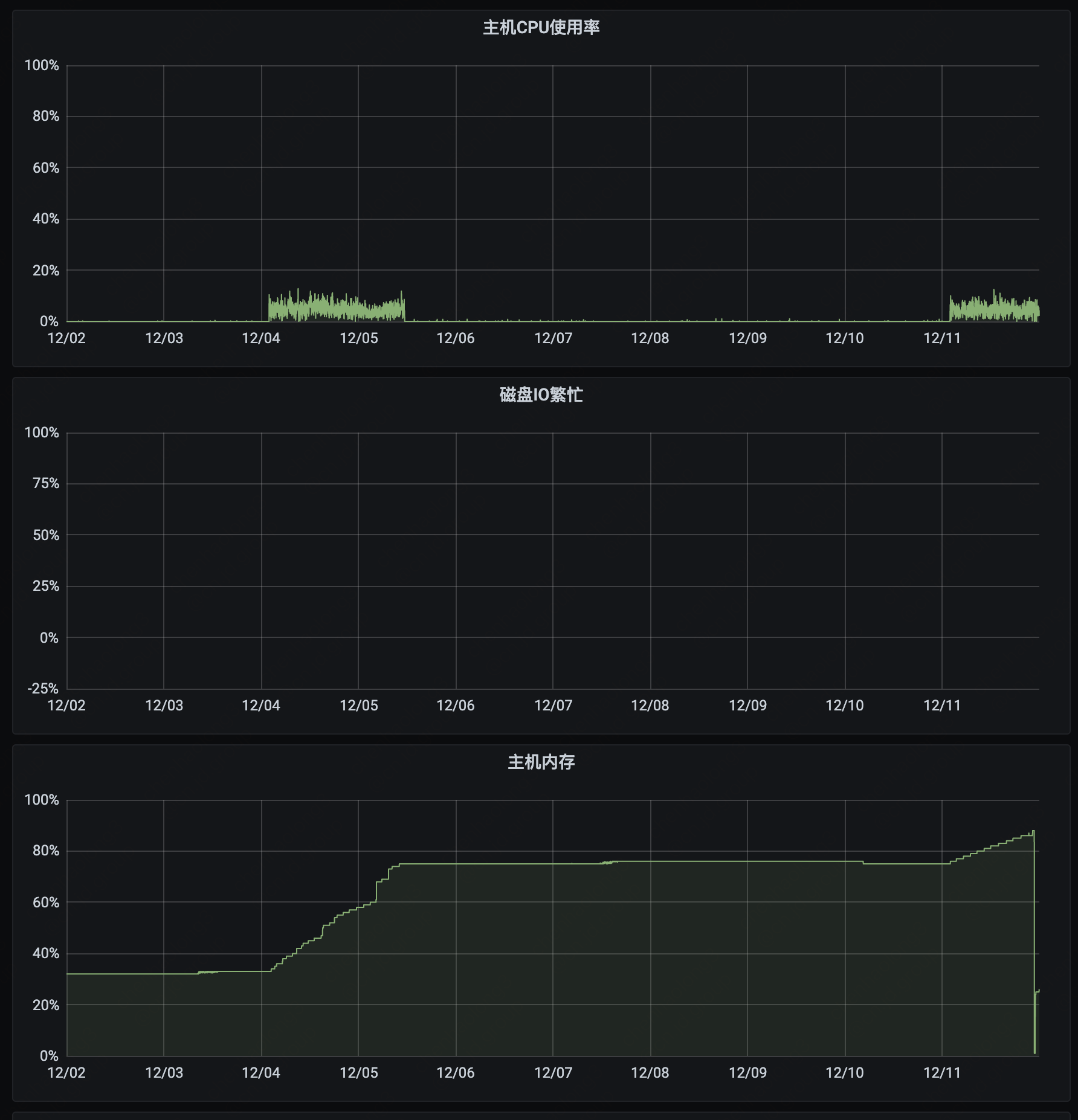

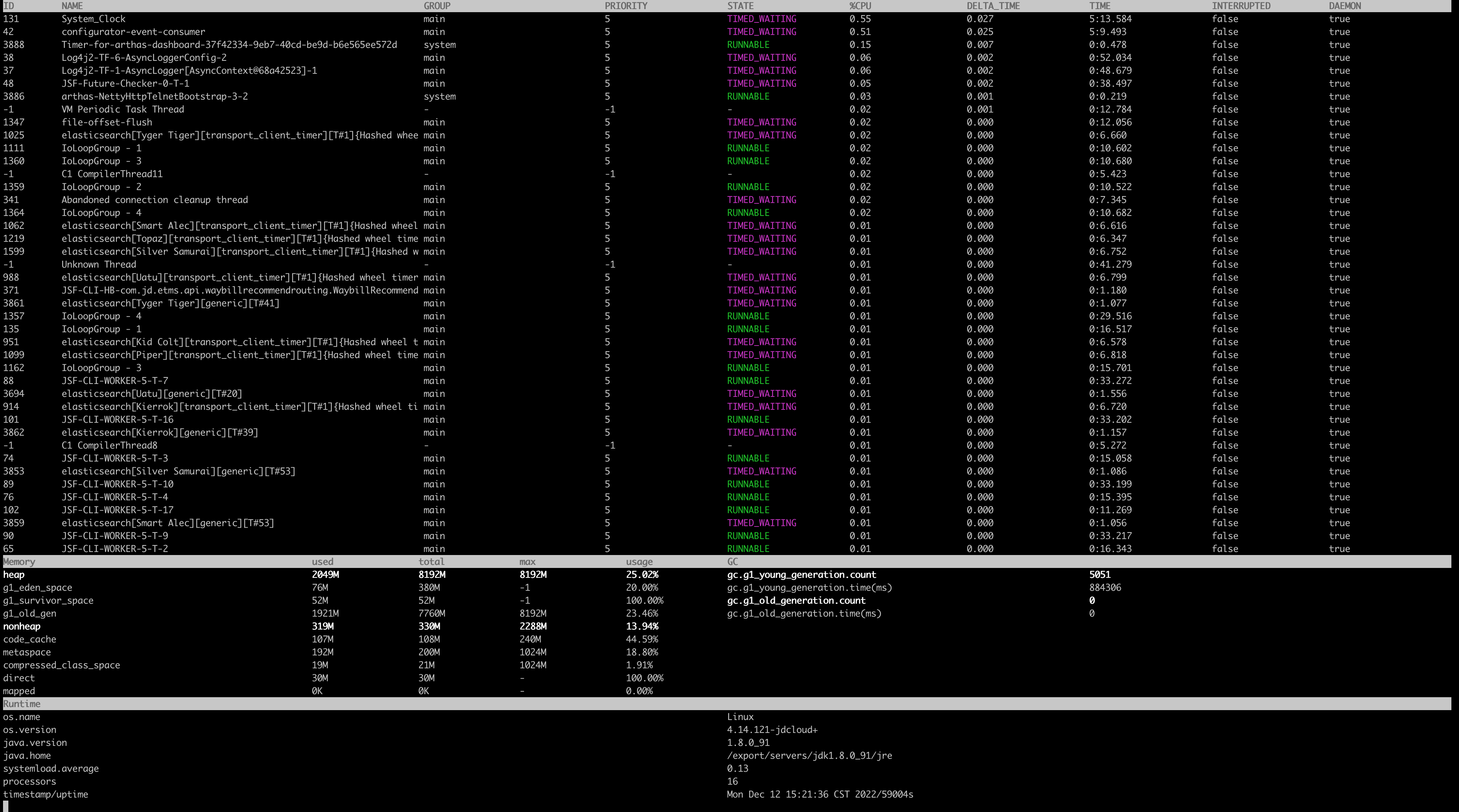

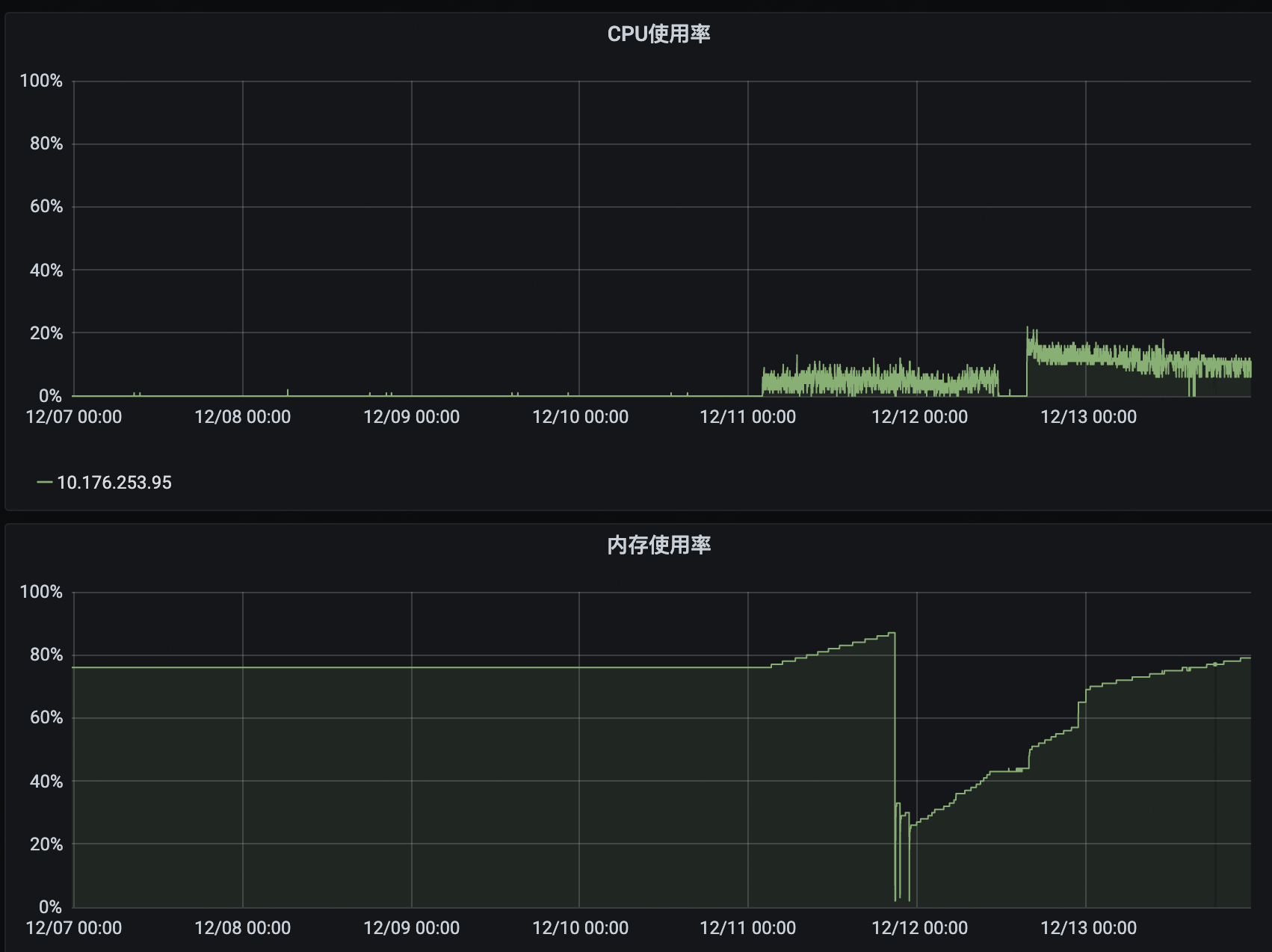

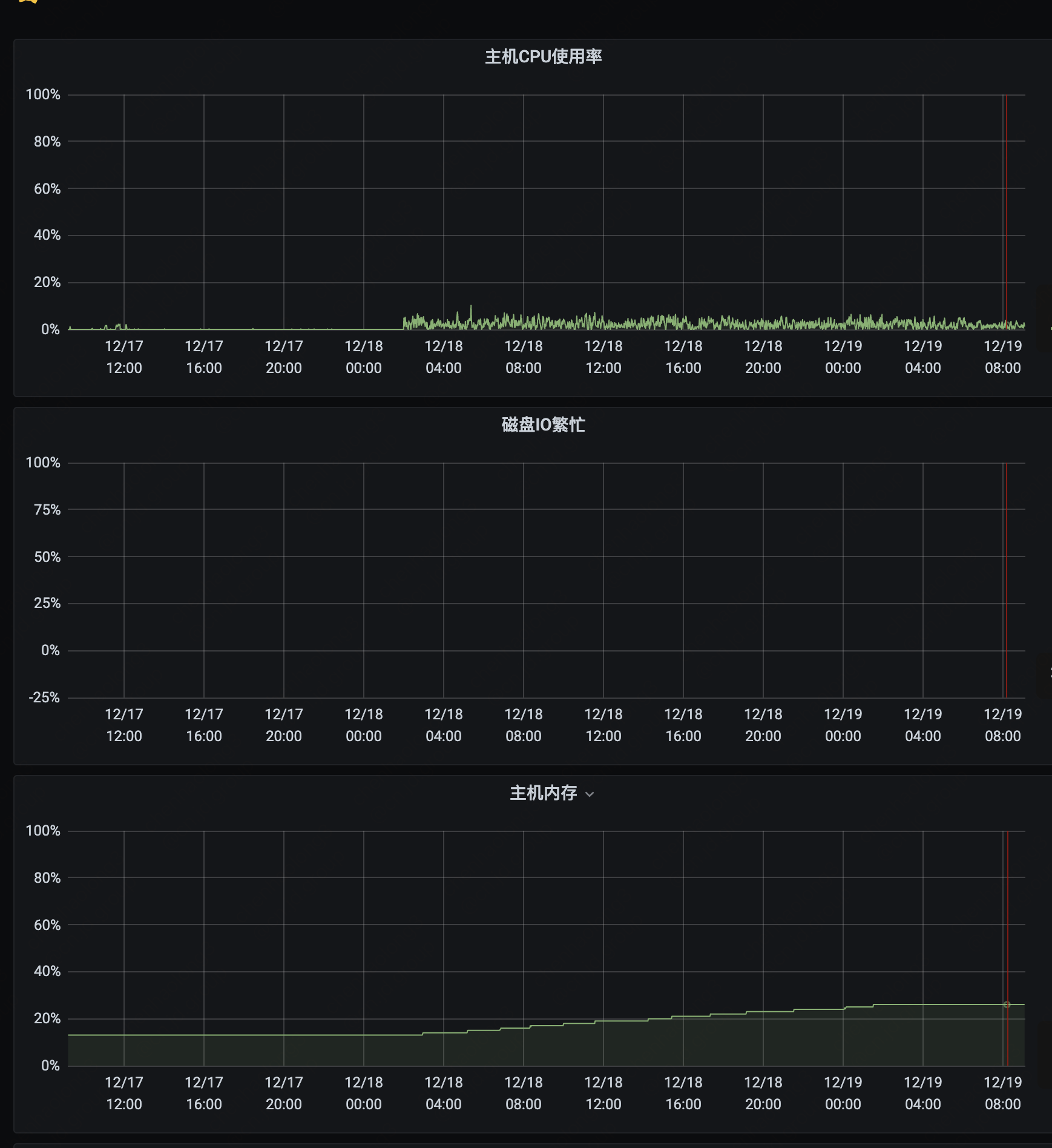

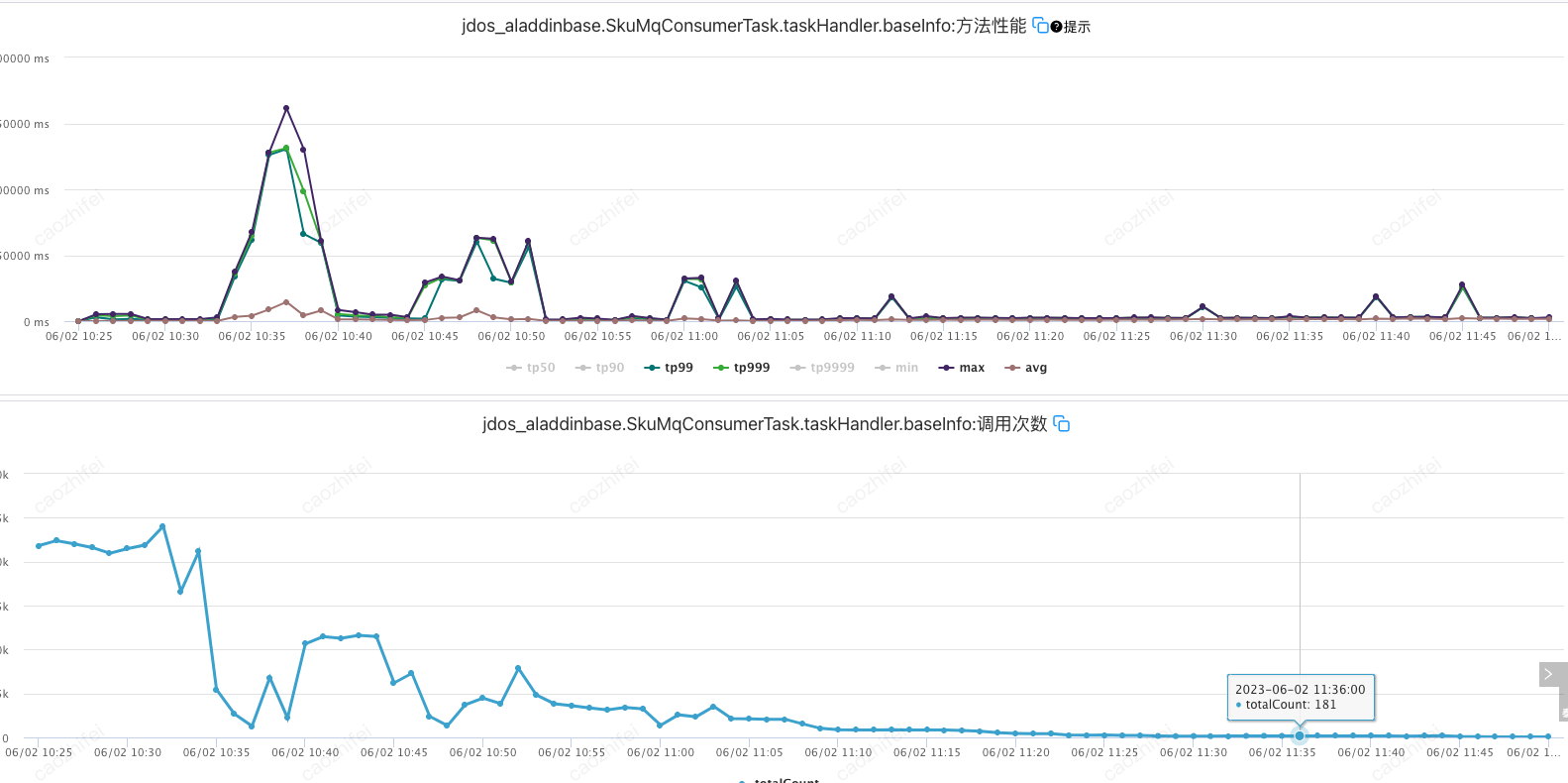

路由计算服务是路由系统的核心服务,负责运单路由计划的计算以及实操与计划的匹配。在运维过程中,发现在长期不重启的情况下,有TP99缓慢爬坡的现象。此外,在每周例行调度的试算过程中,能明显看到内存的上涨。以下截图为这两个异常情况的监控。

TP99爬坡

内存爬坡

机器配置如下

CPU: 16C RAM: 32G

Jvm配置如下:

-Xms20480m (后面切换到了8GB) -Xmx20480m (后面切换到了8GB) -XX:MaxPermSize=2048m -XX:MaxGCPauseMillis=200 -XX:+ParallelRefProcEnabled -XX:+PrintReferenceGC -XX:+UseG1GC -Xss256k -XX:ParallelGCThreads=16 -XX:ConcGCThreads=4 -XX:MaxDirectMemorySize=2g -Dsun.net.inetaddr.ttl=600 -Dlog4j2.contextSelector=org.apache.logging.log4j.core.async.AsyncLoggerContextSelector -Dlog4j2.asyncQueueFullPolicy=Discard -XX:MetaspaceSize=1024M -XX:G1NewSizePercent=35 -XX:G1MaxNewSizePercent=35

例行任务调度情况:

每周一凌晨2:00触发执行。上面截图,共包含了两个周期的任务。可以看到,在第一次执行时,内存直接从33%爬升至75%。在第二次执行时,爬坡至88%后,OOM异常退出。

2 问题排查

由于有两种现象,所以排查有两条主线。第一条是以追踪OOM原因为目的的内存使用情况排查,简称内存问题排查。第二条是TP99缓慢增长原因排查,简称性能下降问题排查。

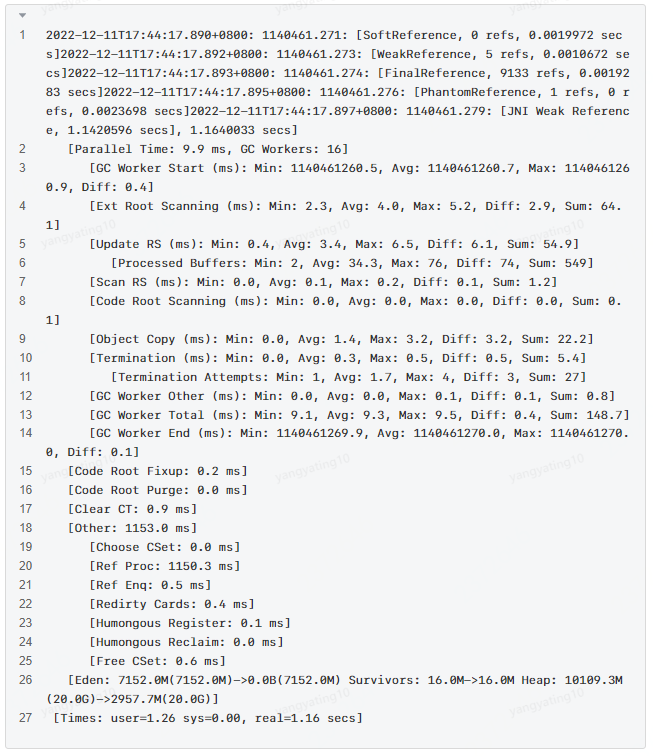

2.1 性能下降问题排查

由于是缓慢爬坡,而且爬坡周期与服务重启有直接关系,所以可以排出外部接口性能问题的可能。优先从自身程序找原因。因此,首先排查GC情况和内存情况。下面是经过长期未重启的GC log。这是一次YGC,总耗时1.16秒。其中Ref Proc环节消耗了1150.3 ms,其中的JNI Weak Reference的回收消耗了1.秒。而在刚重启的机器上,JNI Weak Reference的回收时间为0.0000162秒。所以可以定位到,TP99增加就是JNI Weak Reference回收周期增长导致的。

JNI Weak Reference顾名思义,应该跟Native memory的使用有关。不过由于Native memory排查难度较大。所以还是先从堆的使用情况开始排查,以碰碰运气的心态,看是否能发现蛛丝马迹。

2.2 内存问题排查

回到内存方面,经过建哥提示,应该优先复现问题。并且在每周触发的任务都会稳定复现内存上涨,所以从调度任务这个方向,排查更容易一些。通过@柳岩的帮助,具备了在试算环境随时复现问题的能力。

内存问题排查,仍然是从堆内内存开始。多次dump后,尽管java进程的总内存使用量持续上涨,但是堆内存使用量并未见明显增长。通过申请root权限,并部署arthas后,通过arthas的dashbord功能,可以明显看到,堆(heap)和非堆(nonheap)都保持平稳。

arthas dashboard

内存使用情况,存在翻倍现象

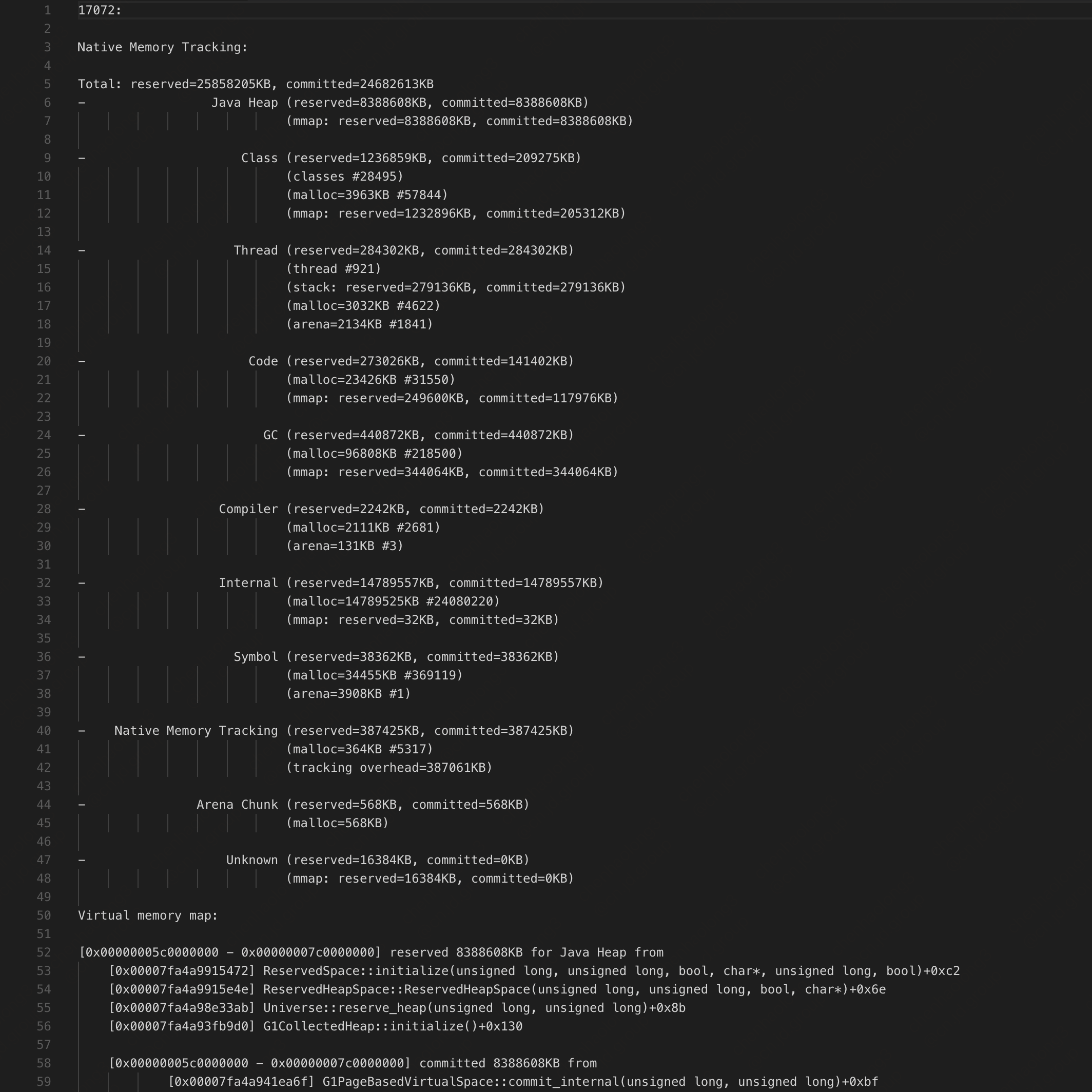

由此可以断定,是native memory使用量增长,导致整个java应用的内存使用率增长。分析native的第一步是需要jvm开启-XX:NativeMemoryTracking=detail。

2.2.1 使用jcmd查看内存整体情况

jcmd可以打印java进程所有内存分配情况,当开启NativeMemoryTracking=detail参数后,可以看到native方法调用栈信息。在申请root权限后,直接使用yum安装即可。

jcmd结果展示

上图中,共包含两部分,第一部分是内存总体情况摘要,包括总内存使用量,以及分类使用情况。分类包括:Java Heap、Class、Thread、Code、GC、Compiler、Internal、Symbol、Native Memory Tracking、Arena Chunk、Unknown,每个分类的介绍,可以看这篇文档;第二部分是详情,包括了每段内存分配的起始地址和结束地址,具体大小,和所属的分类。比如截图中的部分,是描述了为Java heap分配了8GB的内存(后面为了快速复现问题,heap size从20GB调整为8GB)。后面缩进的行,代表了内存具体分配的情况。

间隔2小时,使用jcmd dump两次后,进行对比。可以看到Internal这部分,有明显的增长。Internal是干什么的,为什么会增长?经过Google,发现此方面的介绍非常少,基本就是命令行解析、JVMTI等调用。请教@崔立群后,了解到JVMTI可能与java agent相关,在路由计算中,应该只有pfinder与java agent有关,但是底层中间件出问题的影响面,不应该只有路由一家,所以只是问了一下pfinder研发,就没再继续投入跟进。

2.2.2 使用pmap和gdb分析内存

首先给出此方式的结论,这种分析由于包含了比较大的猜测的成分,所以不建议优先尝试。整体的思路是,使用pmap将java进程分配的所有内存进行输出,挑选出可疑的内存区间,使用gdb进行dump,并编码可视化其内容,进行分析。

网上有很多相关博客,都通过分析存在大量的64MB内存分配块,从而定位到了链接泄漏的案例。所以我也在我们的进程上查看了一下,确实包含很多64MB左右的内存占用。按照博客中介绍,将内存编码后,内容大部分为JSF相关,可以推断是JSF netty 使用的内存池。我们使用的1.7.4版本的JSF并未有内存池泄漏问题,所以应当与此无关。

pmap:https://docs.oracle.com/cd/E56344_01/html/E54075/pmap-1.html

gdb:https://segmentfault.com/a/35739

2.2.3 使用strace分析系统调用情况

这应该算是碰运气的一种分析方法了。思路就是使用strace将每次分配内存的系统调用输出,然后与jstack中线程进行匹配。从而确定具体是由哪个java线程分配的native memory。这种效率最低,首先系统调用非常频繁,尤其在RPC较多的服务上面。所以除了比较明显的内存泄漏情况,容易用此种方式排查。如本文的缓慢内存泄漏,基本都会被正常调用淹没,难以观察。

2.3 问题定位

经过一系列尝试,均没有定位根本原因。所以只能再次从jcmd查出的Internal内存增长这个现象入手。到目前,还有内存分配明细这条线索没有分析,尽管有1.2w行记录,只能顺着捋一遍,希望能发现Internal相关的线索。

通过下面这段内容,可以看到分配32k Internal内存空间后,有两个JNIHandleBlock相关的内存分配,分别是4GB和2GB,MemberNameTable相关调用,分配了7GB内存。

通过对比两个时间段的jcmd的输出,可以看到JNIHandleBlock相关的内存分配,确实存在持续增长的情况。因此可以断定,就是JNIHandles::make_weak_global 这部分内存分配,导致的泄漏。那么这段逻辑在干什么,是什么导致的泄漏?

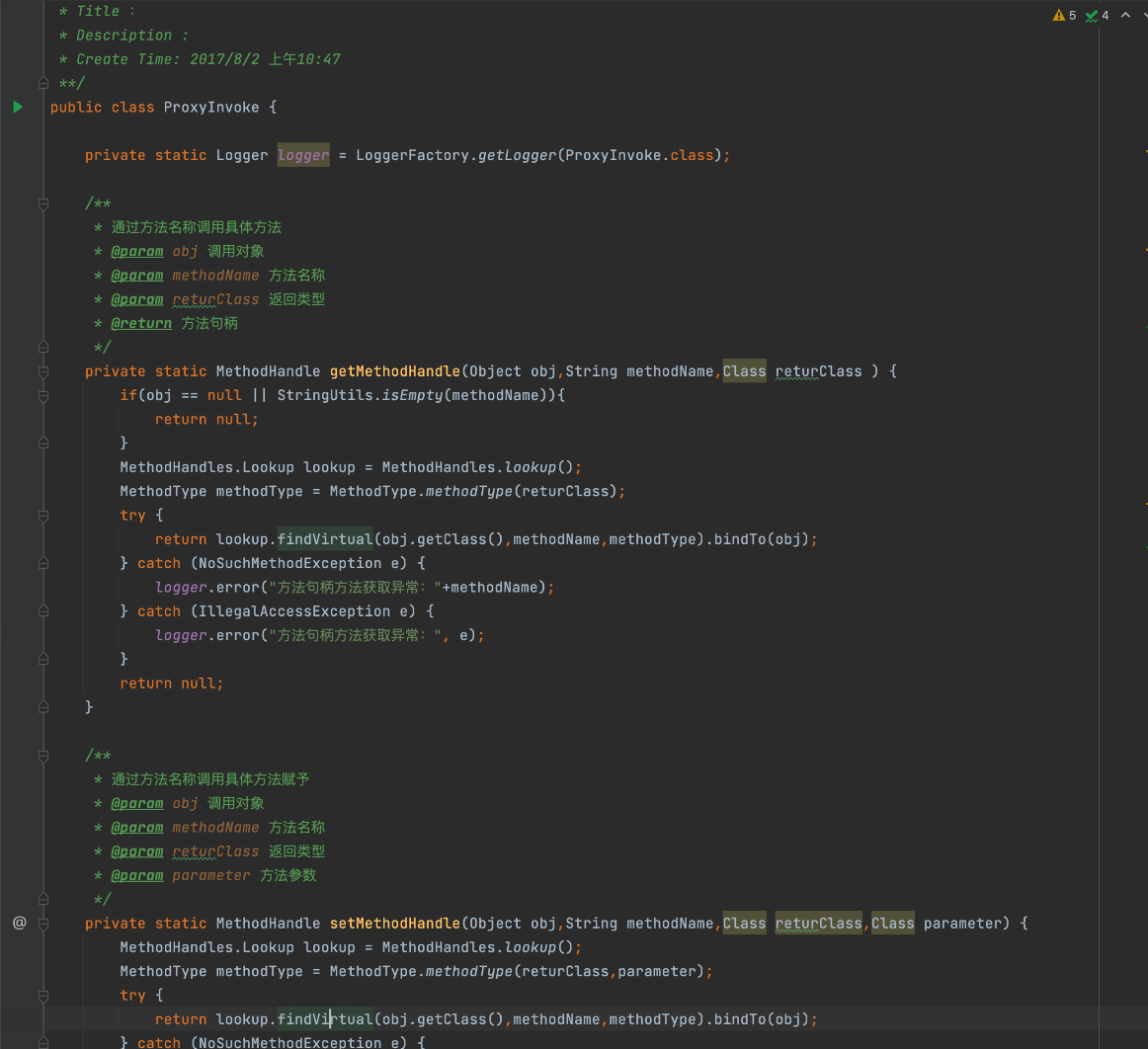

通过Google,找到了Jvm大神的文章,为我们解答了整个问题的来龙去脉。问题现象与我们的基本一致。博客:https://blog.csdn.net/weixin_/article/details/

其中,寒泉子给出了一个复现问题的代码。在我们的代码中有一段几乎一摸一样的,这确实包含了运气成分。

jvm bug:https://bugs.openjdk.org/browse/JDK-

就是上面这个bug,频繁使用MethodHandles相关反射,会导致过期对象无法被回收,同时会引发YGC扫描时间增长,导致性能下降。

3 问题解决

由于jvm 1.8已经明确表示,不会在1.8处理这个问题,会在java 重构。但是我们短时间也没办法升级到java 。所以没办法通过直接升级JVM进行修复。由于问题是频繁使用反射,所以考虑了添加缓存,让频率降低,从而解决性能下降和内存泄漏的问题。又考虑到线程安全的问题,所以将缓存放在ThreadLocal中,并添加LRU的淘汰规则,避免再次泄漏情况发生。

最终修复效果如下,内存增长控制在正常的堆内存设置范围内(8GB),增涨速度较温和。重启2天后,JNI Weak Reference时间为0.0001583秒,符合预期。

4 总结

Native memory leak的排查思路与堆内内存排查类似,主要是以分时dump和对比为主。通过观察异常值或异常增长量的方式,确定问题原因。由于工具差异,Native memory的排查过程,难以将内存泄漏直接与线程相关联,可以通过strace方式碰碰运气。此外,根据有限的线索,在搜索引擎上进行搜索,也许会搜到相关的排查过程,收到意外惊喜。毕竟jvm还是非常可靠的软件,所以如果存在比较严重的问题,应该很容易在网上找到相关的解决办法。如果网上的内容较少,那可能还是需要考虑,是不是用了过于小众的软件依赖。

在开发方面,尽量使用主流的开发设计模式。尽管技术没有好坏之分,但是像反射、AOP等实现方式,需要限制使用范围。因为这些技术,会影响代码的可读性,并且性能也是在不断增加的AOP中,逐步变差的。另外,在新技术尝试方面,尽量从边缘业务开始。在核心应用中,首先需要考虑的就是稳定性问题,这种意识可以避免踩一些别人难以遇到的坑,从而减少不必要的麻烦。

作者:京东物流 陈昊龙

来源:京东云开发者社区

本篇文章中我们将对机器学习做全面的了解与介绍,其中第一章 初识机器学习分为上下两个小章节,对机器学习是什么、机器学习由来以及机器学习的理论等展开说明。目的是能让即便完全没接触过机器学习的人也能在短时间对机器学习有一个全面了解。后续将推出机器学习的进阶内容,包括经典基础篇(线性模型、决策树、集成学习、聚类等),实战进阶篇(特征工程、模型训练与验证、融合与部署等)。本篇为第一章 初识机器学习(上),我们从这里开始,开启一个全新的学习旅程。

1 机器学习描述

1.1 机器学习是什么?

机器学习(Machine Learning,ML)是使用统计(或数学)技术从观察到的数据中构建模型(或系统)的一个计算机科学领域。机器学习用计算机程序模拟人的学习能力,从样本数据中学习得到知识和规律,然后用于实际的推断和决策。

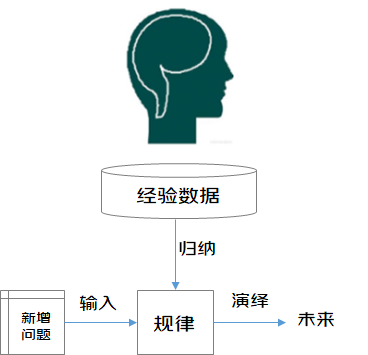

从广义上来说,机器学习能够赋予“机器”学习的能力,使其实现直接编程无法完成的工作。但从实践意义上来说,机器学习是利用数据训练出模型,并使用模型进行预测的一种方法。“训练”与“预测”是机器学习的两个过程,“模型”则是过程中间的输出结果,“训练”产生“模型”,“模型”指导 “预测”。接下来我们把机器学习的过程与人类对历史经验归纳演绎的过程做个比对。

机器学习中的“训练”与“预测”过程可以对应到人类的“归纳”和“演绎”过程。通过这样的对应,我们可以发现,机器学习的思想并不复杂,仅仅是对人类在生活中学习成长的一个模拟。由于机器学习不是基于编程形成的结果,因此它的处理过程不是因果的逻辑,而是通过归纳思想得出的相关性结论。

人类对历史经验归纳过程

人类在成长、生活过程中积累了很多的历史与经验。人类定期地对这些经验进行“归纳”,获得了生活的“规律”。当人类遇到未知的问题或者需要对未来进行“推测”的时候,人类将使用这些“规律”,对未知问题与未来进行“演绎”,从而指导自己的生活和工作。

1.2 机器学习的应用范围

机器学习应用广泛,在各方面都有其施展的空间,包括:数据分析与挖掘、模式识别、虚拟助手和交通预测等。从行业来看,在金融领域(检测信用卡欺诈、证券市场分析等)、互联网领域(自然语言处理、语音识别、搜索引擎等)、医学领域、自动化及机器人领域(无人驾驶、信号处理等)、游戏领域、刑侦领域等也都有所涉及。

1.2.1 数据分析与挖掘

“数据挖掘”和”数据分析”通常被相提并论,但无论是数据分析还是数据挖掘,都是在帮助人们收集与分析数据,使之成为信息并做出推测与判断。因此可以将这两项合称为数据分析与挖掘。数据分析与挖掘是机器学习技术和大数据存储技术结合的产物,利用机器学习手段分析海量数据,同时利用数据存储机制实现数据的高效读写。机器学习在数据分析与挖掘领域中拥有无可取代的地位,2012年Hadoop进军机器学习领域就是一个很好的例子。

1.2.2 模式识别

模式识别的应用领域广泛,包括计算机视觉、医学图像分析、光学文字识别、自然语言处理、语音识别、手写识别、生物特征识别、文件分类、搜索引擎等,而这些领域也正是机器学习大展身手的舞台,因此模式识别与机器学习的关系越来越密切。

1.2.3 虚拟助手

Siri,Alexa,Google Now都是虚拟助手。在交互过程中,虚拟助手会协助查找信息,搜索相关历史行为,或向其他资源(如电话应用程序)发送命令收集更多信息,以满足人们提出的需求。

1.2.4 交通预测

生活中我们经常使用GPS导航服务,机器学习能够帮助我们预测交通堵塞。当前高德地图,腾讯地图等都应用了机器学习技术,识别拥挤路段,规划最优路线。

2 机器学习发展史

2.1 浅层学习阶段

- 1957年,Rosenblatt发明了感知机(Perceptron),是神经网络的雏形,同时也是支持向量机的基础,在当时引起了不小的轰动。

- 1959年,IBM的写出了可以学习的西洋棋程序,并在 IBM Journal of Research and Development期刊上发表了一篇名为《Some Studies in Machine Learning Using the Game of Checkers》的论文中,定义并解释了一个新词——机器学习(Machine Learning,ML)。将机器学习非正式定义为“在不直接针对问题进行编程的情况下,赋予计算机学习能力的一个研究领域”。

- 1960年,Widrow发明了Delta学习规则,即如今的最小二乘问题,立刻被应用到感知机中,并且得到了一个极好的线性分类器。

- 1970年,Seppo Linnainmaa首次完整地叙述了自动链式求导方法(Automatic Differentiation,AD),是著名的反向传播算法(Back Propagation,BP)的雏形,但在当时并没有引起重视。

- 1974年,Werbos首次提出把BP算法的思想应用到神经网络,也就是多层感知机(Multilayer Perception,MLP),并在1982年实现,就是现在通用的BP算法,促成了第二次神经网络大发展。

- 1985-1986年,Rumelhart,Hinton等许多神经网络学者成功实现了实用的BP算法来训练神经网络,并在很长一段时间内BP都作为神经网络训练的专用算法。

- 1986年,J.R.Quinlan提出了另一个同样著名的ML算法—决策树算法(Iterative Dichotomiser 3,ID3),决策树作为一个预测模型,代表的是对象属性与对象值之间的一种映射关系,而且紧随其后涌现出了很多类似或者改进算法,如ID4,回归树,CART等。

- 1995年,Yan LeCun提出了卷积神经网络(Convolution Neural Network,CNN),受生物视觉模型的启发,通常有至少两个非线性可训练的卷积层,两个非线性的固定卷积层,模拟视觉皮层中的V1,V2,Simple cell和Complex cell,在手写字识别等小规模问题上,取得了当时世界最好结果,但是在大规模问题上表现不佳。

- 1995年,Vapnik和Cortes提出了强大的支持向量机(Support Vector Machine,SVM),主要思想是用一个分类超平面将样本分开从而达到分类效果,具有很强的理论论证和实验结果。至此,ML分为NN和SVM两派。

- 1997年,Freund和Schapire提出了另一个坚实的ML模型AdaBoost,该算法最大的特点在于组合弱分类器形成强分类器,可以形象地表述为:“三个臭皮匠赛过诸葛亮”,分类效果比其它强分类器更好。

- 2001年,随着核方法的提出,SVM大占上风,它的主要思想就是通过将低维数据映射到高维,从而实现线性可分。至此,SVM在很多领域超过了NN模型。除此之外,SVM还发展了一系列针对NN模型的基础理论,包括凸优化、范化间隔理论和核方法。

- 2001年,Breiman提出了一个可以将多个决策树组合起来的模型随机森林(Random Forest,RF),它可以处理大量的输入变量,有很高的准确度,学习过程很快,不会产生过拟合问题,具有很好的鲁棒性。

- 2001年,Hochreiter发现使用BP算法时,在NN单饱和之后会发生梯度损失(梯度扩散)。简单来说就是训练NN模型时,超过一定的迭代次数后,容易过拟合。NN的发展一度陷入停滞状态。

2.2 深度学习阶段

二十一世纪初,学界掀起了以“深度学习”为名的热潮。所谓深度学习?狭义地说就是“很多层”的神经网络。在若干测试和竞赛上,尤其是涉及语音、图像等复杂对象的应用中,深度学习技术取得了优越性能。以往机器学习技术在应用中要取得好性能,对使用者的要求较高;而深度学习技术涉及的模型复杂度非常高,以至于只要下工夫“调参”,只要把参数调节好,性能往往就好。因此,深度学习虽缺乏严格的理论基础,但它显著降低了机器学习应用者的门槛,为机器学习技术走向工程实践带来了便利。那么它为什么此时才热起来呢?有两个原因,一是数据量增大了,二是计算能力强了。深度学习模型拥有大量参数,若数据样本少,则很容易“过拟合”。如此复杂的模型、如此大的数据样本,若缺乏强力计算设备,根本无法求解。恰恰人类进入了大数据时代,数据储量与计算设备都有了大发展,才使得深度学习技术又焕发一春。

- 2006年,Hinton和他的学生在《Nature》上发表了一篇深度置信网络(Deep Belief Network,DBN)的文章,从此开启了深度学习(Deep Learning,DL)阶段,掀起了深度神经网络即深度学习的浪潮。

- 2009年,微软研究院和Hinton合作研究基于深度神经网络的语音识别,历时两年取得成果,彻底改变了传统的语音识别技术框架,使得相对误识别率降低25%。

- 2012年,Hinton又带领学生在目前最大的图像数据库ImageNet上,基于深度神经网络对图分类问题取得了惊人的结果,将Top5错误率由26%大幅降低至15%。(ImageNet 是一个计算机视觉系统识别项目,是目前世界上图像识别最大的数据库。是美国斯坦福的计算机科学家,模拟人类的识别系统建立的。能够从图片识别物体。)

- 2012年,由人工智能和机器学习顶级学者Andrew Ng和分布式系统顶级专家Jeff Dean领衔的梦幻阵容,开始打造Google Brain项目,用包含16000个CPU核的并行计算平台训练超过10亿个神经的深度神经网络,在语音识别和图像识别等领域取得了突破性的进展。该系统通过分析YouTube上选取的视频,采用无监督的方式训练深度神经网络,可将图像自动聚类。在系统中输入“cat”后,结果在没有外界干涉的条件下,识别出了猫脸。

- 2012年,微软首席研究官Rick Rashid在21世纪的计算大会上演示了一套自动同声传译系统,将他的英文演讲实时转换成与他音色相近、字正腔圆的中文演讲。同声传译需要经历语音识别、机器翻译、语音合成三个步骤。该系统一气呵成,流畅的效果赢得了一致认可,深度学习则是这一系统中的关键技术。

- 2013年,Google收购了一家叫DNN Research的神经网络初创公司,这家公司只有三个人,Geoffrey Hinton和他的两个学生。这次收购并不涉及任何产品和服务,只是希望Hinton可以将深度学习打造为支持Google未来的核心技术。同年,纽约大学教授,深度学习专家Yann LeCun加盟Facebook,出任人工智能实验室主任,负责深度学习的研发工作,利用深度学习探寻用户图片等信息中蕴含的海量信息,希望在未来能给用户提供更智能化的产品使用体验。

- 2013年,百度成立了百度研究院及下属的深度学习研究所(Institute of Deep Learning,IDL),将深度学习应用于语音识别和图像识别、检索,以及广告CTR预估(Click-Through-Rate Prediction,CTR),其中图片检索达到了国际领先水平。

- 2014年,谷歌宣布其首款成型的无人驾驶原型车制造完毕,将会在2015年正式进行路测。

- 2016年,谷歌旗下DeepMind公司开发的人工智能程序AlphaGo击败围棋职业九段选手李世石。

- 2017年,DeepMind团队公布了最强版AlphaGo,代号AlphaGo Zero,它能在无任何人类输入的条件下,从空白状态学起,自我训练的时间仅为3天,自我对弈的棋局数量为490万盘,能以100:0的战绩击败前辈。

3 易混淆领域梳理

3.1 机器学习与人工智能

人工智能(Artificial Intelligence,AI)是计算机科学的一个分支,它企图了解智能的本质,生产出一种能比肩人类,并做出智能反应的机器。我们都知道机器学习是人工智能最重要的一种实现方法,但机器学习并不是人工智能一开始就采用的方法。人工智能的发展主要经历了逻辑推理,专家系统,机器学习三个阶段。

- 第一阶段的重点是逻辑推理,例如数学定理的证明,这类方法采用符号逻辑来模拟人类智能。

- 第二阶段的重点是专家系统,这类方法为各个领域的问题建立专家知识库,利用这些知识来完成推理和决策。比如将医生的诊断经验转化成一个知识库,然后用这些知识对病人进行诊断。

- 第三阶段的重点即为机器学习,如今的人工智能主要依赖的不再是逻辑推理和专家系统,而是建立在机器学习的基础上解决复杂问题。无论是基于数学的机器学习模型,还是基于神经网络的深度学习模型,都活跃在如今大多数人工智能应用程序之中。

3.2 机器学习与深度学习

深度学习(Deep Learning,DL)是机器学习的一个重要分支,深度学习和机器学习的关系属于继承和发展的关系。在很多人工智能问题上,深度学习的方法加上大数据的出现以及计算机运行速度的提高,更突出了人工智能的前景。比如,自动驾驶汽车,足以彻底改变我们的出行方式,它的实现就需要深度学习的图像识别技术,需要用到卷积神经网络(Convolutional Neural Networks, CNN)来识别马路上的行人、红绿灯等。

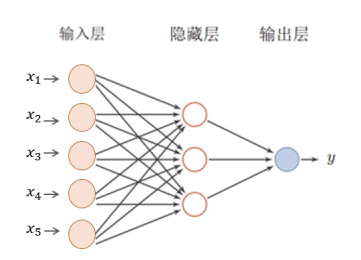

为了更清晰的认识深度学习,我们首先介绍神经网络(Neural Networks, NN),顾名思义,它是一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型。神经网络有输入层、隐藏层(中间层)以及输出层,其中输入层负责神经网络的输入,输出层负责产生输入的映射。机器学习中的逻辑回归,可以看作是一层的神经网络,即除了输入层、输出层之外只有一个隐藏层。

而深度学习,就是指神经网络使用了很多隐藏层。

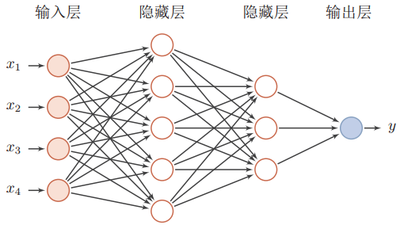

那么深度学习的每一层都在学什么??

当你输入一张脸部的照片时,神经网络的第一中间层,可以看成是一个特征探测器或者边缘探测器,它会去找这张照片的各个边缘(第一张图片);第二中间层又把照片里组成边缘的像素们放在一起看,然后它可以把被探测到的边缘组合成面部的不同部分(第二张图片),有眼睛、鼻子等;最后再把这些部分放在一起,比如鼻子眼睛嘴巴,就可以识别或者探测不同的人脸(第三张图片)。

3.3 机器学习与数据挖掘

数据挖掘(Data Mining,DM)是指从大量的数据中搜索隐藏于其中信息的过程。机器学习是数据挖掘的重要工具之一,但数据挖掘不仅仅要研究、拓展、应用一些机器学习方法,还要通过许多非机器学习技术解决大规模数据与数据噪音等实际问题。大体上看,数据挖掘可以视为机器学习和大数据的交叉,它主要利用机器学习提供的技术来分析海量数据,利用大数据技术来管理海量数据。

3.4 机器学习与统计学

1.统计学简述

统计学(Statistics)是基于数据构建概率统计模型并运用模型对数据进行分析与预测的一门学科。统计学依托背后的数学理论,在远早于机器学习大爆发的几十年,率先从解释因果的角度,努力寻找最优函数(或模型)。统计学里最重要的两个部分是回归分析和假设检验。其他的方法或者技术在统计学这个大框架下,最终也是为了这两者服务的。回归分析提供了解释因果的武器,假设检验则给这项武器装上了弹药。单纯的线性回归用最小二乘法求解逼近事实的真相,再使用显著性检验,检测变量的显著性、模型的显著性、模型的拟合精度。当然是否属于线性,也可以使用假设检验的方法检测。非线性回归的问题,使用极大似然估计或者偏最小二乘回归求解模型,后续的显著性检验仍然是一样的思路。

2.机器学习与统计学对比

统计学是个与机器学习高度重叠的学科,统计学近似等于机器学习。但是在某种程度上两者是有分别的,这个分别在于:统计学是理论驱动,对数据分布进行假设,以强大的数学理论解释因果,注重参数推断,侧重统计模型的发展与优化;机器学习是数据驱动,依赖于大数据规模预测未来,弱化了收敛性问题,注重模型预测,侧重解决问题。

3.5 机器学习算法与“普通”算法的异同

这里我们以《算法导论》中所诠释的算法作为机器学习算法的比较对象。其相同点,两者的目的都是通过制定目标,增加约束,求得最优的模型。不同点是《算法导论》里的“算法”,本质上是如何更有效率地求解具有精确解的问题。效率,可以是计算时间更短,也可以是计算过程所需要的空间更少。而机器学习算法要解决的问题一般没有精确解,也不能用穷举或遍历这种步骤明确的方法求解。这里需要强调的是“学习”这个属性,即希望算法本身能够根据给定的数据或变化的计算环境而动态地发现新的规律,甚至改变机器学习算法的逻辑和行为。

作者:京东物流 星火团队

来源:京东云开发者社区

2023年5月,由 Stackoverflow 发起的2023年度开发者调查数据显示,PostgreSQL 已经超越 MySQL 位居第一,成为开发人员首选。PostgreSQL 在国内的热度也越来越高。6月17日,PostgreSQL 数据库技术峰会在成都顺利召开。本次大会以“新机遇、新态势、新发展”为主题,邀请众多行业大咖参与本次活动。PieCloudDB 产品总监陈金豹也受邀在大会中发表演讲《云原生虚拟数仓 PieCloudDB 的架构和关键模块实现》。

随着云计算时代的到来,云平台提供了近似无限丰富的计算资源,同时也使得计算成本极大的降低,释放出数据计算产生智能的更多机会。早在2019年,Gartner 便做出预测:数据库市场的未来在云上。随着云计算技术的发展,企业也都在向这一趋势靠拢,越来越多的将自己的业务数据往云上迁移。我们相信数据库的未来在云上,这也是我们打造 PieCloudDB 这款云原生数据仓库的原因。

PieCloudDB 于2022年10月正式问世。它是一款云原生分布式数据仓库,提供完备的 SQL 语言支持,高效的分布式计算能力和完备的事务支持。同时又实现了单一数据集的多集群,秒级的弹性和只为必要的计算和存储付费的能力。

1. Why We Need PieCloudDB?

1.1 NoSQL 和数据湖已不能满足用户的分析需求

在过去的很长一段时间里,NoSQL + 数据湖解决方案在数据分析领域占据了主流市场,而 Hadoop、HDFS 等 NoSQL 数据库也是主要的数据分析平台。然而,随着 Cloudera 宣布停止对 CDH 技术支持,对 Hadoop 等 NoSQL 平台的质疑声音也越来越大。

这一现象正是因为 NoSQL + 数据湖体系在复杂查询支持、高并发隔离性和一致性等重要数据分析特性方面存在明显不足,现有基于标准 SQL 的 BI 工具难以集成,且 NoSQL 本身对高级分析(如图形分析、地理信息分析等)的支持较弱。因此,NoSQL 开始被人们贴上“过时”的标签,不再占据数据分析领域的主要市场份额。

此外,基于 NoSQL 和数据湖的基础设施所需的分析工具不容易集成和部署。使用数据湖进行数据分析需要整合部署多个组件,而这需要大量的开发工作。由于缺乏对 ANSI SQL 的支持,用户通常需要具备专门的技术技能,并且需要承担较高的技术和成本要求。此外,平台所需的专用引擎/工具(如图形数据库)往往难以与记录系统集成,降低了数据分析的可操纵性和创新性。

这些限制和挑战推动了对更强大、更易于集成、更易于使用的数据分析平台的需求。企业和组织越来越倾向于采用基于标准 SQL 的分析平台,这些平台能够满足用户广泛的分析功能、易于集成和部署等需求,并且与现有的数据存储和处理技术相兼容,对技术和成本的要求更低。

1.2 以关系型数据库为基础的数据仓库很难适应云环境

包括 Teradata、Greenplum 等众多主流传统数据仓库都是以关系模型来组织数据的关系型数据库。这些数据仓库具有许多优点,包括良好的 SQL 兼容性、高效运行复杂查询以及支持事务 ACID 特性。然而,这些传统的 MPP 数据库也存在一些缺陷,例如弹性性能较差、高可用性方面不够满足要求、数据孤岛等问题。

这些问题导致传统的数据仓库在云环境中无法充分利用公有云的优势。公有云相对于私有环境具有许多优势,其中最显著的两个是:

- 近乎无限的弹性计算资源:公有云提供了弹性计算资源,用户可以根据实际需求按需分配资源,并根据需要进行弹性扩缩容。用户可以根据业务需求申请所需的计算资源,而不需要维护和管理自己的硬件基础设施。

- 廉价且无限容量的对象存储:公有云提供廉价且具有几乎无限容量的对象存储。对象存储的价格相对较低,可以为用户提供大规模的存储容量,帮助用户降低成本并提高效率。

为了更好地适应云环境并充分利用公有云的优势,新一代的数据仓库逐渐崛起。新一代云原生数据仓库具有云原生的架构设计,能够更好地利用公有云的弹性计算和对象存储能力。它们可以在公有云中快速部署和扩展,并提供高性能的数据处理和分析能力,以满足现代数据分析的需求。

1.3 一个兼顾关系型数仓和公有云优势的产品

用户需要一个能够兼顾关系型数仓和公有云优势的产品,来适应云时代的到来。计算引擎方面,需要具有关系型数仓的众多优势,能够具备支持完备的 SQL 语言,具有高效的分布式计算能力,且能够具有完备的事务 ACID 特性。公有云特性方面,实现存算分离,提供弹性的计算集群,让用户得以只为必要的计算付费,充分利用公有云带来的优势。这就是 PieCloudDB 的设计目标。

2. PieCloudDB 能给用户带来什么?

作为新一代的云原生数据仓库,PieCloudDB 实现了云上数仓计算与存储的分离,兼顾了传统关系型数仓的众多优势和公有云带来的众多利好。

2.1 对 SQL 的完备支持

PieCloudDB 对 PostgreSQL 进行了重大改进,实现了分布式计算和存算分离的功能。并对锁、事务、日志、系统表和用户表的存储等模块进行了彻底重写,带来了颠覆性的变革。同时,PieCloudDB 也保留了 PostgreSQL 对 SQL 标准的完整支持,包括复杂查询如聚合(Agg)、子计划(Subplan)、子链接(Sublink)、外连接查询(Outer Join)、窗口聚合函数(Window agg)和物化视图(Materialized View)等。这些改进使得 PieCloudDB 能够提供更高效、更强大的查询功能,同时保持与 SQL 标准的兼容性。

2.2 高效的查询优化和与之匹配的执行器

PieCloudDB 实现了专为复杂查询设计的优化器和与之匹配的高效执行器。

- 专为复杂查询设计的优化器

PieCloudDB 的优化器提供了一系列全面的逻辑优化功能,其中包括谓词下推、子查询子连接提升和外连接消除等。此外,优化器基于纯粹的代价模型进行深度优化,在多阶段聚集过程中对每个节点进行代价估算,并利用动态规划等算法生成多条路径,最终选择代价最低的路径来执行查询。这些功能旨在提高查询性能和效率,从而优化 PieCloudDB 的查询执行过程。

作为一款分布式数据库,PieCloudDB 需要实现众多分布式运算,包括多次数据重分布(reshuffle)和分布式聚合运算(agg)。为了能够在跨表查询时进行高效的分布式表连接,PieCloudDB 的优化器需要全面描述数据分布特性,以便进行分布式代价估算。

通过全面的数据分布特性描述,PieCloudDB 的优化器能够考虑到数据在不同节点上的分布情况,从而更准确地估算跨表查询的代价。这使得优化器能够生成高效的查询计划,避免不必要的数据重分布操作,提高查询性能和效率。

- 分布式环境高效执行器