IntelliJ IDEA 2023.1 EAP 3 现已发布,包括了新 UI 增强功能以及对 Kubernetes 和 Docker 功能的多项改进。具体更新内容包括:

用户体验

新 UI 中工具窗口的垂直拆分

在新 UI 中引入了拆分工具窗口区域的选项,方便用户进行窗口排列。

新 UI 的 Compact Mode

引入了 Compact Mode 以改善用户在小屏幕上使用 IntelliJ IDEA 的新 UI 的体验。由于工具栏和工具窗口标题的高度降低、间距和填充缩小以及图标和按钮缩小,因此提供了一个更统一的外观和感觉。

Docker

合并所有 Docker-compose 容器的日志

Docker-compose 节点的仪表板选项卡现在将来自每个 Docker-compose 容器的日志汇总在一起,并将它们全部显示在一个地方,实时更新。

支持 Azure Container Registry

现在可以轻松连接到 Azure Container Registry。

Kubernetes

新 Kubernetes 资源弹出窗口中的文件模板

向 File | New menu 添加了一个新操作,以便更轻松地创建新的 Kubernetes 文件。选择 New Kubernetes Resource 选项后,将出现一个弹出窗口,其中包含最流行的资源类型列表,例如 Pod、Deployment、ConfigMap 等。

创建新 Kubernetes Secret 的操作

引入了一个新对话框来创建 Kubernetes Secrets。要定义新的 Secret,可以手动输入键和值。或者可以指定一个文件,其内容将用作生成的 Secret 的值。

从集群加载的 Kubernetes 资源的 gutter 中的 Color-coded 更改标记

当你对集群中的资源使用 View YAML 操作并在打开的文件中进行任何更改时,IDE 会在 gutter 中使用 color-coded 标记高亮显示你的所有编辑。这样可以确保在将更改应用回集群之前对资源的所需部分进行了更改。

此外,使用 Compare with Cluster 图标,你可以打开一个完整的差异视图,该视图将从集群中获取资源的当前版本并将其与本地版本进行比较。

改进了 kubeconfig 文件的用户体验

改进了使用 kubeconfig 文件的用户体验。现在可以在服务视图中轻松访问 kubeconfig 文件并在编辑器中打开它。

如果你在 IntelliJ IDEA 之外更改 kubeconfig 文件,IDE 将检测到这一点并自动在服务工具窗口中刷新其配置。

此外,IDE 现在支持 kubeconfig 文件的代码高亮显示和补全。

能够为 Service view 中的操作分配自定义快捷方式

现在可以在 Service view 中为大多数 Kubernetes 操作分配快捷方式,例如 Forward Ports、Delete Resource 和 Describe Resource等。

其他

Docker debug deprecation Docker 调试弃用

Docker 调试功能已被弃用。要使用 Docker 容器调试应用程序,需改用 Run targets。

Cairo 1.17.8 版本已发布,Cairo 是一个开源的图形库,为软件开发者提供了一个基于矢量图形、独立于设备的 API。Cairo 支持输出到一些不同的后端,后端支持包括 X11、Apple Quartz、Win32,以及 PNG、PDF、PostScript、DirectFB 和 SVG 等文件格式。

近年来 Cairo 的开发停滞不前,2018 年底推出了 Cairo 1.16 稳定版,然后就没有了消息。接着就是当前最新的 Cairo 1.17.8 版本,Cairo 1.17.8 修复了各种错误,改进了对 macOS 和 Windows 的支持,支持渲染 COLRv1 字体,删除了 Autotools 构建系统以专注于 Meson。

此外,该版本还删除了 OpenGL/GLES 支持,因为该后端大约十年没有得到维护。

macOS 和 Windows 的支持改进涉及大量错误修复和构建更改,详情可查看更新公告。

cairo 使用 C 语言撰写的,但使用 cairo 时支持许多其他语言,包括有 C++、C#、Java、Python、Perl、Ruby、Scheme、Smalltalk 以及许多种语言,cairo 在 GPL 与 Mozilla Public License 两个开源许可证下发布。

摘要:物联网是现在比较热门的软件领域,众多物联网厂商都有自己的物联网平台,而物联网平台其中一个核心的模块就是Mqtt网关。

本文分享自华为云社区《一文带你掌握物联网mqtt网关搭建背后的技术原理》,作者:张俭。

前言

物联网是现在比较热门的软件领域,众多物联网厂商都有自己的物联网平台,而物联网平台其中一个核心的模块就是Mqtt网关。这篇文章的目的是手把手教大家写书写一个mqtt网关,后端存储支持Kafka/Pulsar,支持mqtt 连接、断链、发送消息、订阅消息。技术选型:

- Netty java最流行的网络框架

- netty-codec-mqtt netty的子项目,mqtt编解码插件

- Pulsar/Kafka 流行的消息中间件作为后端存储

核心pom依赖如下

软件参数设计

软件参数可谓是非常常见,复杂的开源项目,参数甚至可以达到上百个、配置文件长达数千行。我们需要的配置有

MqttServer监听的端口

监听端口的配置即使是写demo也非常必要,常常用在单测试中,由于单测试跑完之后,即使网络服务器关闭,操作系统也不会立即释放端口,所以单测试的时候指定随机端口非常关键,在java中,我们可以通过这样的工具类来获取一个空闲的端口。未配置的话,我们就使用mqtt的默认端口1883。

后端存储配置

我们的mqtt网关是没有可靠的存储能力的,依赖后端的消息中间件来做持久化处理。后端规划支持Pulsar、Kafka两种类型。定义枚举类如下

对应的KafkaProcessorConfig、PulsarProcessorConfig比较简单,包含基础的连接地址即可,如果后续要做性能调优、安全,这块还是会有更多的配置项

启动netty MqttServer

我们通过netty启动一个mqttServer,添加mqtt解码器

MqttserverStarter.java

我们写一个简单的main函数用来启动mqttServer,方便调测

客户端使用eclipse mqtt client进行测试

然后我们先运行MqttServer,再运行MqttClient,发现MqttClient卡住了

这是为什么呢,我们通过抓包发现仅仅只有客户端发送了Mqtt connect信息,服务端并没有响应

但是根据mqtt标准协议,发送Connect消息,必须要有ConnAck响应

所以我们需要在接收到Connect后,返回connAck消息。我们创建一个MqttHandler,让他继承ChannelInboundHandlerAdapter, 用来接力MqttDecoder解码完成后的消息,这里要重点继承其中的channelRead方法,以及channelInactive方法,用来释放断链时需要释放的资源

然后把这个handler加入到netty的职责链中,放到解码器的后面

在mqtt handler中插入我们的代码

打印出connectMessage如下

通常,mqtt connect message中会包含qos、用户名、密码等信息,由于我们启动客户端的时候也没有携带用户名和密码,这里获取到的都为null,我们先不校验这些消息,直接给客户端返回connack消息,代表连接成功

我们再运行起Server和Client,随后可以看到已经走过了Connect阶段,进入了publish message过程,接下来我们再实现更多的其他场景

附上此阶段的MqttHandler代码

我们当前把所有的逻辑都放在MqttHandler里面,不方便后续的扩展。抽象出一个MqttProcessor接口来处理具体的请求,MqttHandler负责解析MqttMessage的类型并分发。MqttProcess接口设计如下

我们允许这些方法抛出异常,当遇到极难处理的故障时,把mqtt连接断掉(如后端存储故障),等待客户端的重连。

MqttHandler中来调用MqttProcessor,相关MqttHandler代码如下

这里的代码,主要是针对MqttMessage的不同类型,调用MqttProcessor的不同方法,值得一提的有两点

- 提前判断了一些解码异常,fast fail

- 全局捕获异常,并进行断链处理

维护MqttSession

维护Mqtt会话的session,主要用来持续跟踪客户端会话信息,跟踪在系统中占用的资源等,考虑到无论是何种后端实现,都需要维护Mqtt的Session,我们构筑一个AbstractMqttProcessor来维护MqttSession

可以看到,这里的AbstractProcessor主要是维护了MqttSessionKey,校验MqttSessionKey,并拦截publish中不支持的Qos2、Failure。同时,也影响了mqtt心跳请求。同样的,我们允许在onPublish、onSubscribe中抛出异常。

基于消息队列实现的mqtt网关的基础思想也比较简单,简而言之就是,有publish消息的时候向消息队列中生产消息。有订阅的时候就从消息队列中拉取消息。由此延伸出来,我们可能需要维护每个mqtt topic和producer、consumer的对应关系,因为像kafka、pulsar这些消息中间件的消费者都是区分topic的,片段通用代码如下:

kafka processor实现

处理MqttPublish消息,MqttPublish消息包含如下几个关键参数

其中

- qos代表这条消息的质量级别,0没有任何保障,1代表至少一次,2代表恰好一次。当前仅支持qos0、qos1

- topicName就是topic的名称

- ByteBuffer就是消息的内容

根据topic、qos发送消息,代码如下

处理订阅消息,我们暂时仅根据订阅的topic,创建topic进行消费即可,由于kafka原生客户端建议的消费代码模式如下

我们需要切换到其他线程对consumer进行消息,书写一个KafkaConsumerListenerWrapper的wrapper,转换为listener异步消费模型

在上述的代码中,有一个需要通篇注意的点:日志打印的时候,注意要将关键的信息携带,比如:topic、mqtt username、mqtt clientId等,在写demo的时候没有感觉,但是海量请求下需要定位问题的时候,就知道这些信息的关键之处了。

使用BountInt这个简单的工具类来生成从0~65535的packageId,满足协议的要求

pulsar processor实现

pulsar相比kafka来说,更适合作为mqtt协议的代理。原因有如下几点:

- pulsar支持百万topic、topic实现更轻量

- pulsar原生支持listener的消费模式,不需要每个消费者启动一个线程

- pulsar支持share的消费模式,消费模式更灵活

- pulsar消费者的subscribe可确保成功创建订阅,相比kafka的消费者没有这样的语义保障

处理publish消息

处理subscribe消息

集成测试

kafka

我们可以通过embedded-kafka-java这个项目来启动用做单测试的kafka broker。通过如下的group引入依赖

我们就可以通过如下的代码启动基于kafka的mqtt broker

kafka端到端测试用例,比较简单,通过mqtt client publish一条消息,然后消费出来

pulsar

我们可以通过embedded-pulsar-java这个项目来启动用做单测试的pulsar broker。通过如下的group引入依赖

我们就可以通过如下的代码启动基于pulsar的mqtt broker

pulsar端到端测试用例,比较简单,通过mqtt client publish一条消息,然后消费出来

性能优化

这里我们简单描述几个性能优化点,像一些调整线程数、buffer大小这类的参数调整就不在这里赘述了,这些需要具体的性能压测来决定参数的设置。

在linux上使用Epoll网络模型

通过Epollo.isAvailable,以及在指定channel类型的时候通过判断group的类型选择对应的channel类型

关闭tcp keepalive

由于mqtt协议本身就有心跳机制,所以可以关闭tcp的keepalive,依赖mqtt协议层的心跳即可,节约海量连接下的性能。配置ChannelOption.SO_KEEPALIVE为false即可

超时时间调短

默认情况下,无论是单测试中mqtt,还是pulsar producer和kafka producer的生产超时时间,都相对较长(一般为30s),如果在内网环境部署,可以将超时时间调整到5s。来避免无意义的超时等待

使用多个KafkaProducer来优化性能

单个KafkaProducer会达到tcp链路带宽的瓶颈,当有海量请求,而延时在kafka生产比较突出的情况下,可以考虑启动多个KafkaProducer。并根据mqtt协议的特点(链路多,单个链路上qps不高),用mqttSessionKey的哈希值来决定使用那个KafkaProducer发送消息

在KafkaProcessorConfig中添加如下配置,生产者个数,默认为1

在初始化的时候,初始化Producer数组,而不是单个Producer

封装一个方法来获取producer

结语

本文的代码均已上传到github。我们这里仅仅只实现了基础的mqtt 连接、发布、订阅功能,甚至不支持暂停、取消订阅。想要实现一个成熟商用的mqtt网关,我们还需要用户隔离、对协议的更多支持、可靠性、可运维、流控、安全等能力。如有商用生产级别的mqtt需求,又无法快速构筑成熟的mqtt网关的,可以选择华为云IoTDA服务,提供稳定可靠的mqtt服务,支持海量设备连接上云、设备和云端消息双向通信能力。

关注,第一时间了解华为云新鲜技术~

1、直接docker部署项目: docker run -d --name "open-anpr" -p 56790:8080 divenswu/open-anpr:1.0.0 2、若想禁用swagger: docker run -d --name "open-anpr" -p 56790:8080 -e VISUAL_SWAGGER_ENABLE=false divenswu/open-anpr:1.0.0 3、若想挂载日志目录到本地: docker run -d --name "open-anpr" -p 56790:8080 -v open-anpr/logs:/app/open-anpr/logs divenswu/open-anpr:1.0.0 4、服务访问: swagger接口文档: http://127.0.0.1:56790/doc.html

基于订阅的密码管理器和数字钱包 Dashlane 宣布开源其 Android 和 iOS 应用程序代码,采用 Creative Commons Attribution-NonCommercial 4.0 许可。此举旨在增加其运作的透明度,以及促进更加协作和开放的开发方式。

透明度和信任是我们公司价值观的一部分,我们努力在我们所做的每一件事中体现这些价值观。我们希望对我们的代码库保持透明将增加客户对我们产品的信任。我们还相信一个更加开放的数字世界,开发者可以在其中轻松参与并相互联系。这是我们对这一雄心壮志的贡献,也是朝着这个方向迈出的又一步。

通过开源,该公司希望收到更多社区关于改进其移动应用代码的反馈,以及网络安全研究人员提供的的安全漏洞报告。Dashlane 有一个 HackerOne 漏洞赏金计划,报告漏洞的用户可获得最高达 5000 美的赏金。

开源还可以在内部促使工程团队提高代码质量,提升代码可读性。Dashlane 计划每三个月在 GitHub 更新一次代码快照,但如果相关流程得到相应的增强,更新频率可能还会更加频繁。

值得注意的是,Dashlane 目前还不能接受来自社区的直接贡献。该公司表示未来或将有让外部贡献者可以直接在 GitHub 中提出改进建议的相关规划,但此举还需另一个层次的内部组织。此外,源代码发布仅涉及 Android 和 iOS 的客户端应用程序,因此 macOS 和 Windows 的客户端应用程序仍然是闭源。

Dashlane 承诺将采取更多措施,接下来将开源其 Web 扩展代码库。不过在此之前,其需要先完成一个满足 Google Chrome MV3 要求的迁移工作。

更多详情可查看官方公告。

Asahi Linux “AGX”Gallium3D 驱动程序已将一些补丁合并到Mesa 23.1 ,其中最重要的是合并了了磁盘着色器缓存支持,在对 Apple Silicon M1/M2 图形的开源 OpenGL 支持方面取得进展。

据外媒 Phoronix 介绍,通过开发人员 Rose Hudson 的合并,现在 Asahi Linux 已可以为 Gallium3D 启用着色器磁盘缓存,以便将 GLSL 着色器缓存到磁盘,加快后续游戏加载速度,并避免可能正在编译着色器的 OpenGL 游戏卡顿情况。

目前 Asahi 的 Gallium3D 仍处于OpenGL 2.x 环境,但随着更多 OpenGL 3.x/4 的支持,此着色器磁盘缓存功能将变得更加重要,它和基于 Rust 的 DRM 内核驱动程序结合在一起,允许在 Linux 上使用 Apple M1/M2 硬件获得高性能的 OpenGL 游戏体验。

但目前 Asahi AGX Mesa 驱动程序仍处于 Linux 内核驱动树外,对于那些想要试用 Asahi AGX Mesa 驱动程序的人来说,则需要等待约三个月后发布的 Mesa 23.1 。

如果你这周没刷到类似 “npub1sg6plzptd64u62a878hep2kev88swjh3tw00gjsfl8f237…” 的一串字符,那就说明本期 GitHub Trending 周榜的内容非常适合你。这是前推特创始人多次推荐的去中心的社交网络 App Damus 的个人主页名片,而支撑这个一周就排名到 iOS 应用榜单前十 App,它背后的协议便是 nostr (同名开源项目)。

除了去中心化社交热点之外,本周其他项目同往常一样,是一些比较实用的工具,比如 root Android 的 KernelSU、提高语音识别精度的 WhisperX、协作平台 APITable、类 ChatGPT 的 AI 对话工具 Open-Assistant,以及 K8s 入门到精通的 kubernetes-learning-path。

以下内容摘录自微博@HelloGitHub 的 GitHub Trending 及 Hacker News 热帖(简称 HN 热帖),选项标准: | | ,根据项目 release 时间分类,发布时间不超过 14 day 的项目会标注 ,无该标志则说明项目 release 超过半月。由于本文篇幅有限,还有部分项目未能在本文展示,望周知 🌝

- 本文目录

- 1. 本周特推

- 1.1 协作平台:apitable

- 1.2 语音识别:whisperX

- 2. GitHub Trending 周榜

- 2.1 Windows 包管理:winget-cli

- 2.2 AI 对话:Open-Assistant

- 2.3 去中心化协议:nostr

- 2.4 K8s 学习路径:kubernetes-learning-path

- 2.5 Android root:KernelSU

- 3. 往期回顾

- 1. 本周特推

1. 本周特推

1.1 协作平台:apitable

主语言:TypeScript、Java

APITable 一个面向 API 的低代码平台,可用来代替 Airtable 来管理日常的协作事项。Airtable 是款协作平台,可以把文本、图片、链接等资源集中起来,来管理日常工作、生活事项。同 Airtable 类似的 APITable 具有以下特性:

- 实时协作;

- 自动表单,可自动同步相关字段;

- API 优先的面板;

- 不设上限的跨表连接;

- 强大的行列权限;

- 支持内嵌,可在你自己的管理系统中嵌入 APITable;

GitHub 地址→https://github.com/apitable/apitable

1.2 语音识别:whisperX

主语言:Python

单词级别的语音识别工具,它用 forced alignment 来提高语音识别的时间戳精度。WhisperX 基于 OpenAI 的 Whisper 模型,通过强制对齐方式与语音模型 ASR(比如:wav2vec2.0)来改进了 Whisper 的时间戳精度。

GitHub 地址→https://github.com/m-bain/whisperX

2. GitHub Trending 周榜

2.1 Windows 包管理:winget-cli

本周 star 增长数:600+,主语言:C++、C

Windows 包管理客户端的源码,基于这个仓库你可以安装包管理工具,也可以参与包管理工具的相关开发工作。

GitHub 地址→https://github.com/microsoft/winget-cli

2.2 AI 对话:Open-Assistant

本周 star 增长数:4,800+,主语言:Python、TypeScript

基于聊天的 AI 助手,它能理解对话任务、与第三方系统交互,并动态检索信息。

GitHub 地址→https://github.com/LAION-AI/Open-Assistant

2.3 去中心化协议:nostr

本周 star 增长数:1,400+

近期热点的 Twitter 替代品,免审核、去中心的网络社交 App Damus 采用的去中心化协议 nostr。同所有去中心化协议类似,nostr 不依赖任何中心服务器,有加密键和签名来防篡改记录。

GitHub 地址→https://github.com/nostr-protocol/nostr

2.4 K8s 学习路径:kubernetes-learning-path

本周 star 增长数:1,800+

kubernetes-learning-path 提供了从初级到高级的 K8s 学习路径,下图展示了高级 Kubernetes 架构以及外部服务是如何连接到集群的。此外,本周 GitHub 热榜有一个基于 K8s 部署 PaaS / DevOps 的完整演示教程,你也可以 pick 下 https://github.com/ben/k8s_PaaS。

GitHub 地址→https://github.com/techiescamp/kubernetes-learning-path

2.5 Android root:KernelSU

本周 star 增长数:350+,主语言:C、Kotlin

一个 Android 上基于内核的 root 方案。特性:

- 基于内核的 su 和权限管理;

- 基于 overlayfs 的模块系统;

GitHub 地址→https://github.com/tiann/KernelSU

3. 往期回顾

往期回顾:

- 让人眼前一亮的应用「GitHub 热点速览」

- 2023 年该学点什么技术?「GitHub 热点速览」

以上为 2023 年第 5 个工作周的 GitHub Trending 🎉如果你 Pick 其他好玩、实用的 GitHub 项目,来 HelloGitHub 和大家一起分享下哟 🌝

作者:京东科技 文涛

前言

GC是Garbage Collection的缩写,顾名思义垃圾回收机制,即当需要分配的内存空间不再使用的时候,JVM将调用垃圾回收机制来回收内存空间。

那么JVM的垃圾机制是如何工作的呢?

第一步识别出哪些空间不再使用(识别并标记出哪些对象已死);

第二步回收不再使用空间(清除已死对象 )

判断对象是否已死

判断对象是否已死通常有两种方式 ,引用计数法和可达性分析法

引用计数法

给对象中添加一个引用计数器,每当有一个地方引用它时,计数器值就加1:当引用失效时,计数器值就减1;任何时刻计数器为0的对象就是不能再被使用的。

简单高效,但无法解决循环引用问题,a=b,b=a

引用计数法并没有在产品级的JVM中得到应用

可达性分析法

这个算法的基本思路就是通过一系列的称为“ GC Roots”的对象作为起始点,从这些节点开始向下搜索,搜索所走过的路径称为引用链( Reference Chain),当一个对象到 GC Roots没有任何引用链相连(用图论的话来说,就是从 GC Roots到这个对象不可达)时,则证明此对象是不可用的。

不过可达性算法中的对象并不是立即死亡的,对象拥有一次自我拯救的机会,对象被系统宣告死亡至少要经历两次标记过程,第一次是经过可达性分析之后没有与GC Roots相连的引用链,第二次是在由虚拟机自动建立的Finalize队列中判断是否需要执行finalize()方法。

HotSopt虚拟机采用该算法。

清除已死对象的方式

标记清除算法

先标记再清除

不足:1 效率问题,标记和清除效率都不高。2 空间问题,产生大量空间碎片

复制算法

内存分两块,A,B

A用完了,将存活对象拷贝到B,A清理掉

代价:内存少了一半。

HotSopt虚拟机用此算法回收新生代。将新生代内存划分为8:1:1的Eden和Survivor解决复制算法内存使用率低的问题

标记整理算法

老年代使用,方式和标记清除类似,只是不直接清除,而是将后续对象向一端移动,并清理掉边界以外的内存。

分代收集算法

分代收集是一个算法方案,整合了以上算法的优点,一般是把Java堆分为新生代和老年代,在新生代中,使用复制算法老年代“标记一清理”或者“标记一整理”

历代垃圾收集器简介

通过上文我们了解了怎样识别垃圾,怎样清理垃圾,接下来,讲ZGC之前,我们回顾一下历代垃圾回收是怎样做的,主要是想给读者一种历史的视角,任何技术都不是凭空产生的,更多的是在前人成果之上进行优化整合

我们先看一个历代JDK垃圾收集器对比表格,以下表格着重说明或引出几个问题:

1 CMS从来未被当作默认GC,且已废弃

2 CMS的思想其实部分被ZGC吸收,CMS已死,但他的魂还在

3 JDK11、JDK17为长期迭代版本,项目中应优先使用这两个版本

发布时间

默认收集器

事件

jdk1.3

2000-05-08

serial

jdk1.4

2004-02-06

ParNew

jdk1.5/5.0

2004-09-30

Parallel Scavenge/serial

CMS登场

jdk1.6/6.0

2006-12-11

Parallel Scavenge/Parallel Old

dk1.7/7.0

2011-07-28

Parallel Scavenge/Parallel Old

G1登场

jdk1.8/8.0

2014-03-18

Parallel Scavenge/Parallel Old

jdk1.9/9.0

2014-09-8

G1

CMS废弃

jdk10

2018-03-21

G1

jdk11

2018-09-25

G1

ZGC登场

jdk12

2019-3

G1

Shenandoah

jdk13

2019-9

G1

jdk14

2020-3

G1

CMS移除

jdk15

2020-9-15

G1

ZGC、Shenandoah转正

jdk16

2021-3-16

G1

jdk17

2021-09-14

G1

ZGC分代

jdk18

2022-3-22

G1

jdk19

2022-9-22

G1

GC分类

我们经常在各种场景听到以下几种GC名词,Young GC、Old GC、Mixed GC、Full GC、Major GC、Minor GC,他们到底什么意思,本人进行了以下梳理

首先GC分两类,Partial GC(部分回收),Full GC

Partial GC:并不收集整个GC堆的模式,以下全是Partial GC的子集

Young GC:只收集young gen的GC

Old GC:只收集old gen的GC。只有CMS的concurrent collection是这个模式

Mixed GC:只有G1有这个模式,收集整个young gen以及部分old gen的GC。

Minor GC:只有G1有这个模式,收集整个young gen

Full GC:收集整个堆,包括young gen、old gen、perm gen(如果存在的话)等所有部分的模式。

Major GC:通常是跟full GC是等价的

serial收集器

单线程收集器,“单线程”的意义并不仅仅说明它只会使用一个CPU或一条收集线程去完成垃圾收集工作,更重要的是在它进行垃圾收集时,必须暂停其他所有的工作线程,直到它收集结束。它依然是虚拟机运行在 Client模式下的默认新生代收集器。它也有着优于其他收集器的地方:简单而高效(与其他收集器的单线程比),对于限定单个CPU的环境来说, Serial I收集器由于没有线程交互的开销,专心做垃圾收集自然可以获得最高的单线程收集效率。

下图彩色部分说明了它的算法,简单粗暴

1 停止用户线程

2 单线程垃圾回收新生代

3 重启用户线程

ParNew收集器

Parnew收集器其实就是 Serial l收集器的多线程版本。它是许多运行在 Server模式下的虚拟机中首选的新生代收集器,其中有一个与性能无关但很重要的原因是,除了 Serial 收集器外,目前只有它能与CMS收集器配合工作。Pardew收集器在单CPU的环境中绝对不会有比 Serial收集器更好的效果。它默认开启的收集线程数与CPU的数量相同,在CPU非常多(臂如32个)的环境下,可以使用-XX: ParallelGCThreads参数来限制垃圾收集的线程数。

ParNew收集器追求降低GC时用户线程的停顿时间,适合交互式应用,良好的反应速度提升用户体验.

下图彩色部分说明了它的算法,同样简单粗暴

1 停止用户线程

2 多线程垃圾回收新生代

3 重启用户线程

Parallel Scavenge 收集器

Parallel Scavenge收集器是一个新生代收集器,它也是使用复制算法的收集器,又是并行的多线程收集器。算法的角度它和ParNew一样,在此就不画图解释了

Parallel Scavenge收集器的目标则是达到一个可控制的吞吐量( Throughput)

吞吐量是指用户线程运行时间占CPU总时间的比例

通过以下两种方式可达到目的:

1.在多CPU环境中使用多条GC线程,从而垃圾回收的时间减少,从而用户线程停顿的时间也减少;

2.实现GC线程与用户线程并发执行。

Serial Old收集器

Serial Old是 Serial 收集器的老年代版本,它同样是一个单线程收集器,使用“标记整理”算法。这个收集器的主要意义也是在于给 Client模式下的虚拟机使用。

如果在 Server模式下,那么它主要还有两大用途:

一种用途是在JDK1.5以及之前的版本中与 ParallelScavenge收集器搭配使用,

另一种用途就是作为CMS收集器的后备预案,在并发收集发生Concurrent Mode Failure时使用

下图彩色部分说明了它的算法,同样简单粗暴

1 停止用户线程

2 单线程垃圾回收老年代

3 重启用户线程

Parallel Old收集器

Paralle Old是 Parallel Scavenge收集器的老年代版本,一般它们搭配使用,追求CPU吞吐量,使用多线程和“标记一整理”算法。

下图彩色部分说明了它的算法,同样简单粗暴

1 停止用户线程

2 多线程垃圾回收老年代

3 重启用户线程

CMS收集器

以上5种垃圾回收原理不难理解,算法之所以如此简单个人理解在当时使用这种算法就够了,随着JAVA的攻城略地,有一种垃圾回收需求出现,即使用尽量短的回收停顿时间,以避免过久的影响用户线程,CMS登场了。

CMS( Concurrent Mark Sweep)收集器是一种以获取最短回收停顿时间为目标的收集器。

想要达到目的,就要分析GC时最占用时间的是什么操作,比较浪费时间的是标记已死对象、清除对象,那么如果可以和用户线程并发的进行,GC的停顿基本就限制在了标记所花费的时间。

如上图,CMS收集器是基于“标记一清除”法实现的,它的运作过程分为4个步骤

初始标记( EMS initial mark) stop the world

并发标记( CMS concurrent mark)

重新标记( CMS remark) stop the world

并发清除( CMS concurrent sweep)

初始标记的作用是查找GC Roots集合的过程,这个过程处理对象相对较少,速度很快。(为什么要进行初始标记:枚举根结点。https://www.zhihu.com/question/)

并发标记是实际标记所有对象是否已死的过程,比较耗时,所以采用并发的方式。

重新标记主要是处理并发标记期间所产生的新的垃圾。重新标记阶段不需要再重新标记所有对象,只对并发标记阶段改动过的对象做标记即可。

优点:

并发收集、低停顿

缺点:

CMS收集器对CPU资源非常敏感。

CMS收集器无法处理浮动垃圾( Floating Garbage),可能出现“Concurrent ModeFailure”失败而导致另一次 Full GC的产生。

“标记一清除”法导致大量空间碎片产生,以至于老年代还有大量空间,却没有整块空间存储某对象。

G1收集器

G1是一款面向服务端应用的垃圾收集器。下文会简单讲解一下它的“特点”和“内存分配与回收策略”,有基础或不感兴趣的同学直接跳到“G1垃圾回收流程”

特点

并行与并发

G1能充分利用多CPU、多核环境下的硬件优势,使用多个CPU(CPU或者CPU核心)来缩短Stop-The- World停顿的时间,部分其他收集器原本需要停顿Java线程执行的GC动作,G1收集器仍然可以通过并发的方式让Java程序继续执行。

分代收集

与其他收集器一样,分代概念在G1中依然得以保留。虽然G1可以不需要其他收集器配合就能独立管理整个GC堆,但它能够采用不同的方式去处理新创建的对象和已经存活了一段时间、熬过多次GC的旧对象以获取更好的收集效果。

空间整合

与CMS的“标记一清理”算法不同,G1从整体来看是基于“标记一整理”算法实现的收集器,从局部(两个 Region之间)上来看是基于“复制”算法实现的,但无论如何,这两种算法都意味着G1运作期间不会产生内存空间碎片,收集后能提供规整的可用内存。这种特性有利于程序长时间运行,分配大对象时不会因为无法找到连续内存空间而提前触发下一次GC。

可预测的停顿

这是G1相对于CMS的另一大优势,降低停顿时间是G1和CMS共同的关注点,但G1除了追求低停顿外,还能建立可预测的停顿时间模型,能让使用者明确指定在一个长度为M毫秒的时间片段内,消耗在垃圾收集上的时间不得超过N毫秒,这几乎已经是实时Java(RTSJ)的垃圾收集器的特征了。

在G1之前的其他收集器进行收集的范围都是整个新生代或者老年代,而G1不再是这样。使用G1收集器时,Java堆的内存布局就与其他收集器有很大差别,它将整个Java堆划分为多个大小相等的独立区域( Region),虽然还保留有新生代和老年代的概念,但新生代和老年代不再是物理隔离的了,它们都是一部分 Region(不需要连续)的集合

内存分配与回收策略

对象优先在Eden分配

大多数情况下,对象在新生代Eden区中分配。当Eden区没有足够空间进行分配时,虚拟机将发起一次 Minor[ˈmaɪnə(r)] GC

大对象直接进入老年代

所谓的大对象是指,需要大量连续内存空间的Java对象,最典型的大对象就是那种很长的字符串以及数组。大对象对虚拟机的内存分配来说就是一个坏消息(比遇到一个大对象更加坏的消息就是遇到一群“朝生夕灭”的“短命大对象”写程序的时候应当避免),经常出现大对象容易导致内存还有不少空间时就提前触发垃圾收集以获取足够的连续空间来“安置”它们。

长期存活的对象将进入老年代

虚拟机给每个对象定义了一个对象年龄(Age)计数器。如果对象在Eden出生并经过第一次 Minor GC后仍然存活,并且能被 Survivor容纳的话,将被移动到 Survivor空间中,并且对象年龄设为1。对象在 Survivor区中每“熬过”一次 Minor GC,年龄就增加1岁,当它的年龄增加到一定程度(默认15岁)会被晋升到老年代中。对象晋升老年代的年龄阈值,可以通过参数据-XX : MaxTenuringThreshold设置

动态对象年龄判定

为了能更好地适应不同程序的内存状况,虚拟机并不是水远地要求对象的年龄必须达到了 MaxTenuringThreshold才能晋升老年代,如果在 Survivor空间中相同年龄所有对象大小的总和大于 Survivor空间的一半,年龄大于或等于该年龄的对象就可以直接进入老年代,无须等到 MaxTenuringThreshold中要求的年龄。

空间分配担保

在发生 Minor GC之前,虚拟机会先检査老年代最大可用的连续空间是否大于新生代所有对象总空间,如果这个条件成立,那么 Minor GC可以确保是安全的。如果不成立,则虚拟机会查看 HandlePromotionFailure设置值是否允许担保失败。如果允许,那么会继续检查老年代最大可用的连续空间是否大于历次晋升到老年代对象的平均大小,如果大于,将尝试着进行一次 Minor GC,尽管这次 Minor GC是有风险的;如果小于,或者HandlePromotionFailure设置不允许冒险,那这时也要改为进行一次 Full GC.

为什么要担保:

Minor GC后还有大量对象存活且空间不够存放新对象,就要直接在老年代存放

为什么是历次晋升到老年代对象的平均大小:

取平均值进行比较其实仍然是一种动态概率的手段,也就是说,如果某次 Minor GCd存活后的对象突增,远远高于平均值的话,依然会导致担保失败( HandlePromotionFailure)如果出现了 HandlePromotionFailure失败,那就只好在失败后重新发起一次 Full GC。虽然担保失败时绕的子是最大的,但大部分情况下都还是会将 HandlePromotionFailure开关打开,避免 Full GC过于频繁。

eden的大小范围默认是 =【-XX:G1NewSizePercent,-XX:G1MaxNewSizePercent】=【整堆5%,整堆60%】

humongous如果一个对象的大小已经超过Region大小的50%了,那么就会被放入大对象专门的Region中,这种Region我们叫humongous

G1垃圾回收流程

网上对G1的回收阶段有不同的说法,参考Oracle JVM工程师的一个说法:

他把整个 G1 的垃圾回收阶段分成了这么三个,第一个叫 Minor GC,就是对新生代的垃圾收集,第二个阶段呢叫 Minor GC + Concurrent Mark,就是新生代的垃圾收集同时呢会执行一些并发的标记,这是第二个阶段,第三个阶段呢它叫 Mixed GC 混合收集,这三个阶段是一个循环的过程。刚开始是这个新生代的垃圾收集,经过一段时间,当老年代的内存超过一个阈值了,它会在新生代垃圾收集的同时进行并发的标记,等这个阶段完成了以后,它会进行一个混合收集,混合收集就是会对新生代、幸存区还有老年代都来进行一个规模较大的一次收集,等内存释放掉了,混合收集结束。这时候伊甸园的内存都被释放掉,它会再次进入新生代的一个垃圾收集过程,那我们先来看看这个新生代的收集 Minor GC。

Minor GC的回收过程(eden满了回收)

选定所有Eden Region放入CSet,使用多线程复制算法将CSet的存活对象复制到Survivor Region或者晋升到Old Region。

下图分7步演示了这个过程

1 初始状态,堆无占用

2 Eden Region满了进行标记

3 将存活对象复制到Survivor Region

4 清理Eden Region

5 Eden Region又满了进行再次标记,此时会连带Survivor Region一起标记

6 将存活对象复制到另一个Survivor Region

7 再次清理Eden Region和被标记过的Survivor Region

Minor GC结束后自动进行并发标记,为以后可能的Mixed GC做准备

Mixed GC的回收过程(专注垃圾最多的分区)

选定所有Eden Region和全局并发标记计算得到的收益较高的部分Old Region放入CSet,使用多线程复制算法将CSet的存活对象复制到Survivor Region或者晋升到Old Region。

当堆空间的占用率达到一定阈值后会触发Mixed GC(默认45%,由参数决定)

Mixed GC它一定会回收年轻代,并会采集部分老年代的Region进行回收的,所以它是一个“混合”GC。

下图分3步演示了这个过程

1 并发标记所有Region

2 并发复制

3 并发清理

ZGC

ZGC(Z Garbage Collector) 是一款性能比 G1 更加优秀的垃圾收集器。ZGC 第一次出现是在 JDK 11 中以实验性的特性引入,这也是 JDK 11 中最大的亮点。在 JDK 15 中 ZGC 不再是实验功能,可以正式投入生产使用了。

目标低延迟

保证最大停顿时间在几毫秒之内,不管你堆多大或者存活的对象有多少。

可以处理 8MB-16TB 的堆

通过以上历代垃圾回收器的讲解,我们大致了解到减少延迟的底层思想不外乎将stop the world进行极限压缩,将能并行的部分全部采用和用户线程并行的方式处理,然而ZGC更”过分”它甚至把一分部垃圾回收的工作交给了用户线程去做,那么它是怎么做到的呢?ZGC的标记和清理工作同CMS、G1大致差不多,仔细看下图的过程,和CMS特别像,这就是我在上文说的CMS其实并没有真正被抛弃,它的部分思想在ZGC 有发扬。

ZGC 的步骤大致可分为三大阶段分别是标记、转移、重定位。

标记:从根开始标记所有存活对象

转移:选择部分活跃对象转移到新的内存空间上

重定位:因为对象地址变了,所以之前指向老对象的指针都要换到新对象地址上。

并且这三个阶段都是并发的。

初始转移需要扫描 GC Roots 直接引用的对象并进行转移,这个过程需要 STW,STW 时间跟 GC Roots 成正比。

并发转移准备 :分析最有回收价值GC分页(无STW) 初始转移应对初始标记的数据

并发转移应对并发标记的数据

除了标记清理过程继承了CMS和G1的思想,ZGC要做了以下优化

并发清理(转移对象)

在 CMS 和 G1 中都用到了写屏障,而 ZGC 用到了读屏障。

写屏障是在对象引用赋值时候的 AOP,而读屏障是在读取引用时的 AOP。

比如 ,这个过程就会触发读屏障。

也正是用了读屏障,ZGC 可以并发转移对象,而 G1 用的是写屏障,所以转移对象时候只能 STW。

简单的说就是 GC 线程转移对象之后,应用线程读取对象时,可以利用读屏障通过指针上的标志来判断对象是否被转移。

读屏障会对应用程序的性能有一定影响,据测试,对性能的最高影响达到 4%,但提高了 GC 并发能力,降低了 STW。这就是上面所说的ZGC“过分”地将部分垃圾回收工作交给用户线程的原因。

染色指针

染色指针其实就是从 64 位的指针中,拿几位来标识对象此时的情况,分别表示 Marked0、Marked1、Remapped、Finalizable。

0-41 这 42 位就是正常的地址,所以说 ZGC 最大支持 4TB (理论上可以16TB)的内存,因为就 42 位用来表示地址

也因此 ZGC 不支持 32 位指针,也不支持指针压缩。

其实对象只需要两个状态Marked,Remapped,对象被标记了,对象被重新映射了,为什么会有M0,M1,用来区分本次GC标记和上次GC标记

以下是标记转移算法说明:

1 在垃圾回收开始前:Remapped

2 标记过程:

标记线程访问

发现对象地址视图是 Remapped 这时候将指针标记为 M0

发现对象地址视图是 M0,则说明这个对象是标记开始之后新分配的或者已经标记过的对象,所以无需处理

应用线程

如果创建新对象,则将其地址视图置为 M0

3 标记阶段结束后

ZGC 会使用一个对象活跃表来存储这些对象地址,此时活跃的对象地址视图是 M0

4 并发转移阶段

转移线程:

转移成功后对象地址视图被置为 Remapped(也就是说 GC 线程如果访问到对象,此时对象地址视图是 M0,并且存在或活跃表中,则将其转移,并将地址视图置为 Remapped )

如果在活跃表中,但是地址视图已经是 Remapped 说明已经被转移了,不做处理。

应用线程:

如果创建新对象,地址视图会设为 Remapped

5 下次标记使用M1

M1 标识本次垃圾回收中活跃的对象

M0 是上一次回收被标记的对象,但是没有被转移,且在本次回收中也没有被标记活跃的对象。

下图展示了Marked,Remapped的过程,

初始化时A,B,C三个对象处于Remapped状态

第一次GC,A被转移,B未被转移,C无引用将被回收

第二次GC,由于A被转移过了(Remapped状态),所以被标记M1,此时恰好B为不活跃对象,将被清理

第三次GC,A又被标记成M0

多重映射

Marked0、Marked1和Remapped三个视图

ZGC为了能高效、灵活地管理内存,实现了两级内存管理:虚拟内存和物理内存,并且实现了物理内存和虚拟内存的映射关系 在ZGC中这三个空间在同一时间点有且仅有一个空间有效,利用虚拟空间换时间,这三个空间的切换是由垃圾回收的不同阶段触发的,通过限定三个空间在同一时间点有且仅有一个空间有效高效的完成GC过程的并发操作

支持NUMA

NUMA是非一致内存访问的缩写 (Non-Uniform Memory Access,NUMA)

早年如下图:SMP架构 (Symmetric Multi-Processor),因为任一个 CPU 对内存的访问速度是一致的,不用考虑不同内存地址之间的差异,所以也称一致内存访问(Uniform Memory Access, UMA )。这个核心越加越多,渐渐的总线和北桥就成为瓶颈,那不能够啊,于是就想了个办法。

把 CPU 和内存集成到一个单上,这个就是非一致内存访问 (Non-Uniform Memory Access,NUMA)。

ZGC 对 NUMA 的支持是小分区分配时会优先从本地内存分配,如果本地内存不足则从远程内存分配。

ZGC优劣

综上分析,ZGC在战略上沿用了上几代GC的算法策略,采用并发标记,并发清理的思路,在战术上,通过染色指针、多重映射,读屏障等优化达到更理想的并发清理,通过支持NUMA达到了更快的内存操作。但ZGC同样不是银弹,它也有自身的优缺点,如下

优势:

1、一旦某个Region的存活对象被移走之后,这个Region立即就能够被释放和重用掉,而不必等待整个堆中所有指向该Region的引用都被修正后才能清理,这使得理论上只要还有一个空闲Region,ZGC就能完成收集。

2、颜色指针可以大幅减少在垃圾收集过程中内存屏障的使用数量,ZGC只使用了读屏障。

3、颜色指针具备强大的扩展性,它可以作为一种可扩展的存储结构用来记录更多与对象标记、重定位过程相关的数据,以便日后进一步提高性能。

劣势:

1、它能承受的对象分配速率不会太高

ZGC准备要对一个很大的堆做一次完整的并发收集。在这段时间里面,由于应用的对象分配速率很高,将创造大量的新对象,这些新对象很难进入当次收集的标记范围,通常就只能全部当作存活对象来看待——尽管其中绝大部分对象都是朝生夕灭的,这就产生了大量的浮动垃圾。如果这种高速分配持续维持的话,每一次完整的并发收集周期都会很长,回收到的内存空间持续小于期间并发产生的浮动垃圾所占的空间,堆中剩余可腾挪的空间就越来越小了。目前唯一的办法就是尽可能地增加堆容量大小,获得更多喘息的时间。

2、吞吐量低于G1 GC

一般来说,可能会下降5%-15%。对于堆越小,这个效应越明显,堆非常大的时候,比如100G,其他GC可能一次Major或Full GC要几十秒以上,但是对于ZGC不需要那么大暂停。这种细粒度的优化带来的副作用就是,把很多环节其他GC里的STW整体处理,拆碎了,放到了更大时间范围内里去跟业务线程并发执行,甚至会直接让业务线程帮忙做一些GC的操作,从而降低了业务线程的处理能力。

总结

综上,其实ZGC并不是一个凭空冒出的全新垃圾回收,它结合前几代GC的思想,同时在战术上做了优化以达到极限的STW,ZGC的优秀表现有可能会改变未来程序编写方式,站在垃圾收集器的角度,垃圾收集器特别喜欢不可变对象,原有编程方式鉴于内存、GC能力所限使用可变对象来复用对象而不是销毁重建,试想如果有了ZGC的强大回收能力的加持,是不是我们就可以无脑的使用不可变对象进行代码编写

参考:

《深入理解java虚拟机》

《JAVA性能权威指南》

JDK 发展至今的垃圾回收机制

全网最全JDK1~JDK15十一种JVM垃圾收集器的原理总结

为什么CMS需要初始标记?

一步一图带你理清G1垃圾回收流程

美团面试官问我:ZGC 的 Z 是什么意思?

ZGC有什么缺点?

ZGC 原理是什么,它为什么能做到低延时?

本文档示意图原型:https://www.processon.com/view/link/63771dbb3a840c4027

送福利啦!开源中国社区带着30张“开放原子开源基金会OpenHarmony技术峰会”门票正大步走来!

欢迎各位开发者积极报名,我们将筛选出30位报名的开发者送出免费参会资格。

开发者可以得到:

(1)参会门票

(2)自助午餐

(3)活动伴手礼(帆布袋、T恤)

(4)大咖深度面对面

赠送活动报名截止时间2月18日,机不可失时不再来哦!

报名地址:【赠票来啦!】OpenHarmony Tech Summit • 技术峰会 – 活动详情页 – OSCHINA – 中文开源技术交流社区

一、活动简介

开放原子开源基金会OpenHarmony技术峰会,以“技术构筑万物智联”为主题,汇聚学术界、产业界前沿技术,分享当下技术成果,探索下一代技术方向。

本次技术峰会特邀全球开源操作系统技术领袖、前沿实践专家及高校技术导师,面向全球展示OpenHarmony操作系统的技术革新,设置有OpenHarmony高校技术俱乐部、OS内核及视窗、生态与互联、安全及机密计算、编程语言及应用框架、开发者工具6大分论坛,并通过互动展区展示OpenHarmony生态社区的阶段性成果。此外,峰会还将发布OpenHarmony高校技术俱乐部星光计划。

期待更多的伙伴、开发者与贡献者加入OpenHarmony生态社区,共同构筑万物智联的美好世界。

活动官网:OpenAtom OpenHarmony

二、活动时间

2023年2月25日9:00-18:00

三、论坛峰会安排

四、演讲嘉宾(待更新)

五、参与方式

六、组织单位

写在前面: 面对全面放开后多样的消费机会,开发者们如何在保障品质生活的同时,借助开源工具,全面、科学地规划和管理个人财务,把握资金动向,避开消费陷阱?

LigaAI 特邀我司 Nerd4me 大佬分享其个人财务管理经验,系列共分「概念篇」和「实战篇」。本篇「实战篇」,将展开介绍开发者如何使用 Beancount 系统且便捷地记账。

Beancount 是一个基于纯文本的开源记账软件,提供了一系列开箱即用的命令行工具,以及一套简洁、实用且美观的 Web UI。

其核心记账逻辑是「复式记账法」,即每一笔交易至少关联两个交易账户,一借一贷,数额相等。特别的是, 复式记账法规定「收入为负,支出为正」 —— 在《「钞能力养成指北」前传》中,我们也详细解释了这点,大家可以按需补课。

👉新手指南:Why Beancount?

市面上有非常多成熟、知名的记账工具,为什么我仍强烈推荐使用 Beancount?出于以下几点考虑:

Beancount 采用改良版的复式记账方案,「正负」代替「借贷」 对非会计专业的朋友更友好;

可直接在本地运行。相比基于云端的工具,数据安全更有保障,无需担心个人账务泄漏;

纯文本文件管理账目,便于记录和存储。 基于 Beancount 语法生成的文件,很容易阅读;

提供完整的命令行工具集和可视化工具 (内含大量财报模板),支持基于类 SQL 查询,可轻松生成各种复杂的报表数据;

账本既是用户的输入文件,也是软件的「数据库」,可实现数据和工具的「无痛搬家」。

Beancount 是 Ledger-Like 家族的杰出成员。对比背靠 的 Ledger,基于 的 Beancount 应用轻便,新增插件或二次开发更简单;多货币支持等丰富而强大的功能,能够很好地覆盖各种记账、查账场景。

事实上,Beancount 并不知道什么是「货币」。它只是记录了「通货 Commodity」的变化,而通货完全由用户定义。 因此,Beancount 可以记录含货币在内任何东西的变化,如年假天数、股票、航空里程、信用卡积分……

当然,也可以用来数豆子——这也是「Beancount」名字的由来 >A<

👉 英勇黄铜:基本环境搭建

迈出「Beancount 记账」的第一步,需要安装 环境和对应包。

使用下列命令,生成一个官方提供的示例。

通过 命令运行 Web UI 。默认情况下的 Web UI 会运行在 中。

👉 不屈白银:Beancount 语法入门

环境搭建后,我们需要制作账本来承载账目信息。Beancount 作者在 Beancount User’s Manual 中提供了非常详尽的使用说明,大家可以根据实际需求自行创建。

下面以《「钞能力养成指北」前传》中「老王煎饼摊」为例,逐步演示如何使用 Beancount 编写账本并制成报表。

1. 制作账本

新建一个纯文本文件并保存为 。在任意文本编辑器打开,只需简单两步就能完成账本内容的编写。

第一步:设立交易账户

使用 open 命令设立交易账户,语法结构为。

其中,开户时间应早于该账户关联的首笔交易产生的时间;同时,在复式记账法中,交易账户分为五大类型:

-

Assets – 资产类账户:现金、存款、基金、股票、房子、车子、借出账款等;

-

Liabilities – 负债类账户:信用卡、贷款、花呗、向他人借款等;

-

Income – 收入类账户:工资、奖金、专利、投资收益等;

-

Expenses – 费用类账户:衣食住行等一切花销、过年发出的红包等;

-

Equity – 权益类账户:记账前已有的资产或负债,一般在账户初始化时设置。

第二步:编写交易记录

Beancount 是复式记账工具,其账目分录至少包含三行信息:交易详情、支出详情和收入详情。

交易详情记录了交易时间、收款人信息和交易备注,格式为 。

- *「 /! 」为对账标识符: * 表示该交易已确认,! 表示该交易存疑/待确认。

- 双引号中的为选填内容,分别记录「收款人 Payee」和「交易备注 Narration」。

支出/收入详情记录出/进账的账户名称、交易数额和货币类型,出账为负,进账为正,正负金额相加为零。

把「老王煎饼摊」的账本补充完整,就会得到下面这个 文件。

2. 生成财务报表

使用 Beancount 命令行工具集中的 命令,可以实现各类财务报表的自动生成。

比如, 子命令能生成损益表, 可以统计资产负债情况, 用于查询各账户余额等。

账户余额表指出,老王持有 1,000 的固定资产、在食材上花费 400 、煎饼营业收入 1,000 、信用卡欠款 400 。

对许多非技术背景的朋友来说,用命令行呈现的数据有点不太好阅读。没关系,Beancount 自己会出手:Beancount 为我们提供了一个可视化工具 。

安装 后,使用 命令启动 Web UI 服务。在浏览器中打开 ,就可以获得表格式的报表数据。

👉 荣耀黄金:进阶场景说明

在现实生活中,除了「一对一」交易,我们还会遇到很多涉及多个账户的「一对多」和「多对多」的情况。下面几个场景展示了 Beancount 和复式记账法在处理复杂交易方面的优势。

场景 1 :发工资

应聘谈薪,我们关心「税前工资」和「到手工资」。那么,每月发放的工资、奖金,缴纳的五险一金和个人所得税等费用,在 Beancount 中应该如何入账呢?

不难看出,复式记账法的优势之一是能够清晰地展示同一笔交易中,资金在各个账户之间的流动关系,反映资金运动的来龙去脉。

场景 2 :记录房产

对于房产、车辆等固定资产,我们不只关心其购入时的价值,也同样在乎其后续的升/贬值情况,即当前市场估值。

Beancount 不预先定义任何货币,我们可以创建人民币 的变种货币 ,赋予房子一个人民币变种价格(即估值价格) 。

这样,在以人民币 展示总资产时,我们既能在价格页查看房子的当前市值估值,也不会影响总资产的统计。

场景 3 :AA 制消费分摊

AA 制的费用分摊、信用卡分期还款等交易记账是典型的「一对多」场景。

小红和小明外出吃饭一共花费 500 ,由小红先行支付;小明几天后想起,将 AA 的费用转账还给小红。在小红的账本中,这笔钱应该这样记录:

场景 4 :货币转换

出入境限制全面放开,许多好友也都选择出国游玩散心。在消费记账时,Beancount 如何处理不同货币之间的汇率转化关系?

在登记交易时,使用 即可连接两种互相转换的货币。本例中,信用卡支出的 650 人民币正是由 100 美转换而来。

场景 5 :使用 DSL 进行复杂查询

除了 命令外,Beancount 还提供 工具,支持 语句查询,以满足更复杂的数据统计。感兴趣的朋友可以在 Beancount – Query Language 文档中了解。

这里分享一下让 Beancount 回答「我都在哪些加油站加过几次油」的操作指令。

👉 超凡大师:最佳实践分享

看到这里的朋友们,恭喜你们已经学会了 Beancount 复式记账的常用语法和操作。它们可以满足生活中绝大多数消费和交易的记账需求。下面分享的是一些个人实践的经验总结,希望能更好地帮你开启「Beancount 之旅」。

1. 账本编辑器的选择

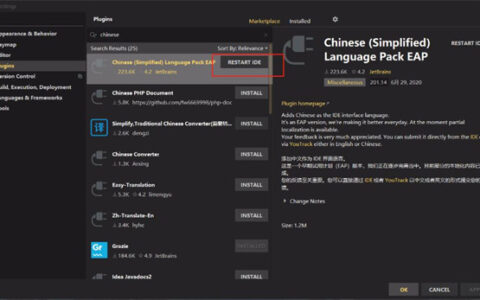

我选择 作为账本文件编辑器,搭配 插件一起使用,可以自动为 或者 文件加上语法高亮、补全账户名,还可以实现金额数据的自动对齐。

具体的配置操作请查看作者在 上提供的帮助文档了解。

2. 账户开户日期的设立

前面提到,交易账户的开设日期应早于该账户首笔交易产生的时间。这里也补充一些比较有意思的开户事件,供诸位参考。

- Expenses 账户可以使用自己的出生日期作为开户日期;

- Income 账户可以按来源分类后再选择日期,如 的开户时间是该公司的入职日期;

- Assets 和 Liabilities 账户中的借/贷记卡的开设日期,与银行的开户日期保持一致。

3. 分割账本文件结构

记账是一个长期习惯,但是随着时间累积,账本文件越变越大,只在一个文件中编写和记录就会变得极其不便。

因此,在创建账本时,我们可以提前规划账本分类,使用 Beancount 的 语法对账本进行结构分割。这样就可以在一个 Beancount 文件中包含其他的文件,就像下面这样:

4. 定期对账

账本的定期对账(或称定期断言,Balance Assertion)就像写代码时的「Ctrl + S」或「Command + S」,无事发生自动隐形,关键时刻出手「救命」。

断言就是告诉 Beancount,在某个日期前,这个账户有多少余额(设值为 A) 。如果 Beancount 计算的该时间点前的交易余额 B,与余额 A 不相等,那它就会报错。此时,我们只需检查两次断言日期之间的交易,就能快速定位错账。

使用 命令标记某个日期前的账户余额(区分 命令中的 子命令),让 Beancount 自动核对账本中的账户余额是否与实际金额相等。

需要注意,断言声明的是所给日期开始前的余额,即当日的交易不算在内。也就是说,上面的断言表示,在 2023 年旦前,即截止至 2022 年 12 月 31 日,工商银行储蓄账户余额为 10,000 。

👉后记

在 wzyboy 的《Beancount——命令行复式簿记》一文中,我第一次了解到「记账神器 Beancount」;2022 年 9 月前后,我正式使用 Beancount 管理个人财务。如今睡前打开 记录当天的资金变动,已经成为固定活动,而在每日的记账、查账中,我也获益良多。

本文分享的 Beancount 入门级操作指令,可以满足(个人)日常记账的简单需求;Beancount 还有许多证券投资、基金净值更新等高级应用,大家可以自行挖宝~

新的一年,坚持记账,搞钱发财!

编者语:# 编程之外 是 LigaAI 开设的全新栏目。在这里,我们将与开发者朋友们一起发现和分享生活中的「技术时刻」,并通过极具创意与实用的「生活代码」,感受「技术改善生活」的真谛。如果你也对「代码提升幸福感」感兴趣,欢迎关注 LigaAI@oschina。

LigaAI 是新一代智能研发协作平台,我们关注研发协作与效率,重视开发者个人的价值创造。往期文章中,我们分享了许多敏捷开发、项目管理、个人成长与提升的文章,欢迎朋友们阅读交流。

体验新一代智能研发协作,请 这里 展开了解。LigaAI 助力开发者扬帆远航,期待与你一路同行!

作者:京东零售 秦浩然

引子

举个栗子,众所周知,我们是可以在京东上购买机票的。 但机票是航司提供的,我们本质上是代理销售而已。

那为什么航司要让我们代理销售呢?

我们又是如帮他做代理的呢?

别急,本文将展开说说他们之间的关系。。。

一个有梦想的航司

从前有个航司打算开展线上销售机票业务,于是设计了如下系统。系统完成后,业务正常开展了。。。

航司销售机票的接口:

航司销售机票的接口实现类:

测试:

测试结果:

业务蒸蒸日上,问题接踵而至

随着业务发展的越来越好,新的问题出现了。

黄牛天天爬接口,系统风险出现了;卖完票没有统计结果,卖成啥样也不知道。

于是航司想增加售前风控、售后统计。加上这些功能后,业务又继续稳步发展了。。。

航司销售机票的接口:

航司销售机票的接口实现类:

测试:

测试结果:

人员捉襟见肘,业务被迫拆分

后来航司发现,就这么点人,又想做风控,又想卖机票,又想做统计,根本忙不过来。

那怎么解决呢? 航司只想专心卖票,不想做这些跟卖票无关的工作,那只能找个代理公司了。

于是,航司找到了JD代替自己做这些工作,自己就负责专心卖票。。。

航司销售机票的接口:

航司销售机票的接口实现类:

JD平台代理航司销售机票实现类:

测试:

测试结果:

朴素的一对一合作方式,静态代理

以上流程对与航司而言,由JD帮助自己关注风控、统计,自已可以专心的卖票,看着很好的样子。

但是JD平台只能给航司卖票,其余的也干不了,航司与JD的关系属于静态绑定的关系,即:被代理类与代理类属于静态绑定的关系,称之为“静态代理”。

据此,我们可以给代理模式下个定义:

保险出现,代理公司高瞻远瞩

某天,保险公司也被风控、统计逻辑搞的焦头烂额,听说航司找了个代理,于是也找到了JD,让JD给他们做代理。

JD想:总不能谁来找我,我就给谁做一套代理系统吧,那我得做多少套,反正他们都是找我做风控、统计的,那我能不能做一套系统,给他们所有的人用呢,说干就干。。。

保险公司销售保险的接口:

保险公司销售保险的接口实现类:

JD平台代理的风控、统计实现类:

测试:

测试结果:

进阶的一对多合作方式,动态代理

到这里航司、保险公司都找到了自己的代理,JD平台也完成了风控、统计代理平台的搭建。再有人来找自己,JD平台都可以满足代理需求,现在看来,已经很完美了。

被代理的商家与JD属于动态绑定的关系,即:被代理类与代理类属于动态绑定的关系,称之为“动态代理”,由于此代理功能依赖JDK提供的Proxy、InvocationHandler类,也成为“JDK动态代理”。

据此,我们可以补充代理模式的定义:

酒店出现,代理公司意外降临

平静的日子没过多久,一天某酒店找来了,要求给他们做代理,做就做呗。轻车又熟路。。。

酒店销售房间:

测试:

测试结果:

怎么回事,平台不好用了!代理公司闭关修炼,查一下问题。。。

优秀代理公司的自我修养

以前给别人代理都好使,这次给酒店代理为何就不行了呢? 一个优秀的代理,有问题就要解决问题。。。

先看异常,代理类不能被强转为目标类型,但是为何之前的都好使?

思考:只有生成的代理类属于目标类型,才能强转,那就需要代理类实现目标类的接口,那问题就可能是这样了,验证一下。

原理分析:JDK代理对象是如何实现的?

让我们先看下源码:

上面分析一堆,那我们来了看看得到的代理类到底是啥,为啥他就能执行那个我们的目标类的方法。同时,还得目标类实现接口?

将我们的字节码文件在此反编译:http://javare.cn,得到我们的代理类:

到此为止真相大白了,原来代理类继承了Proxy父类,同时实现了目标类的接口,这就将我们的目标方法与定义的事件处理器联系起来了。

同时,由于java的单继承模式,导致了代理类只能继承Proxy类,那这样的话,就只好通过目标类的接口来关联目标类了。

小结:JDK动态代理

据此,我们可以再次补充代理模式的定义:

好的合作伙伴就是不抛弃不放弃

到这里,问题是搞明白了,就是酒店的问题,但是好的合作伙伴就是应该不抛弃,不放弃。

酒店跟我们合作,我们就要帮助他们解决困难。那怎么办呢?酒店没接口,JDK代理又非要接口,那我们就不用JDK代理了!

这时,基于类的代理方式就应运而生了—— cglib为我们提供了基于类的动态代理模式。

导Jar包:cglib-3.2.5.jar(cglib核心包)、asm-3.3.1.jar(字节码处理框架)

测试

测试结果

原理分析:cglib代理对象是如何实现的?

那为啥cglib就不用目标类实现接口了呢?让我们看看代理类。

反编译结果

到此,我们知道cglib代理是帮我们新建了一个代理类,此代理类继承自目标类获取目标方法,同时重写了目标方法。

再通过我们定义的拦截器调用我们的目标方法,以此来达到代理目标方法的目的。

总结:JDK、cglib动态代理

据此,我们可以总结代理模式的定义:

代理模式的使用场景

我们知道,Spring的AOP就是依赖于动态代理模式实现的,那我们在日常的开发中有哪些地方能用到代理呢?

•事物

•日志

•监控

•统计

•鉴权

•限流

•缓存

•环境隔离

作者:京东物流 李振 康睿 刘斌 王北永

一 、 规则引擎业务应用背景

业务逻辑中经常会有一些冗长的判断,需要写特别多的if else,或者一些判断逻辑需要经常修改。这部分逻辑如果以java代码来实现,会面临代码规模控制不住,经常需要修改逻辑上线等多个弊端。这时候我们就需要集成规则引擎对这些判断进行线上化的管理

二、规则引擎选型

目前开源的规则引擎也比较多,根据原有项目依赖以及短暂接触过的规则引擎,我们着重了解了一下几个

drools:

-社区活跃,持续更新

-使用广泛

-复杂

-学习成本较高

https://github.com/kiegroup/drools

easy-rule:

-简单易学

-满足使用诉求

-长时间未发布新版

https://github.com/j-easy/easy-rules

easycode:

-京东物流同事维护的平台

-基于flowable dmn实现

-配置简单直观

-已有大量系统使用

总结:

- 简单配置型规则可以接入easycode,平台提供配置页面,通过jsf交互。

<!—->

- 复杂规则,需要动态生成规则,easycode目前还不支持。drools从流行度及活跃度考虑,都比easy-rule强,所以选择drools。

三、 drools简单示例

3.1 引入依赖

3.2 写drl文件

我们写一个简单的demo

规则为:

匹配一个sku对象

0<价格<=100 10积分

100<价格<=1000 100积分

1000<价格<=10000 1000积分

在resources文件夹下新增 rules/skupoints.drl 文件 内容如下

3.3 使用起来

3.4 输出

3.5 总结

如上,我们简单使用drools,仅需要注意drl文件语法。根据drl文件生成规则的工作内存,通过或者与工作内存交互。整个流程并不复杂。注意 仅是在演示中简单使用,demo中包含使用bean来管理容器的方式,即便在简单使用场景也不应通过 来重复加载规则。

但是,这样并不能满足我们线上化判断,或者频繁更改规则的诉求。于是我们在实践中需要对drools更高阶的使用方式。

四、 drools动态化实践

从以上简单demo中我们可以看出,规则依赖drl文件存在。而业务实际使用中,需要动态对规则进行修改,无法直接使用drl文件。

以下是我了解过的四种动态的方案:

- drt文件,创建模板,动态生成drl文件,也是我们目前所用的方式。

<!—->

- excel文件导入,实际上和模板文件类似,依然无法直接交给业务人员来使用。

<!—->

- 自己拼装String,动态生成drl文件,网上大多数博文使用方式,过于原始。

<!—->

- api方式,drools的api方式复杂,使用需要对drl文件有足够的了解。

最后介绍以下drools在项目中的实际使用方式

4.1 配置规则

我们的业务场景可以理解为多个缓冲池构成的一个网状结构。

示例如下:

上图中每个方块为一个缓冲池,每条连线为一条从A缓冲池流向B缓冲池的规则。实际场景中缓冲池有数百个,绝大多数都有自己的规则,这些规则构成一张复杂的网络。基于业务诉求,缓冲池的流向规则需要经常变动,我们需要在业务中能动态改变这些连线的条件,或者改变连线。在这种情况下,如果使用静态的drl文件来实现这些规则,需要数百规则文件,维护量大,且每次修改后使规则生效的代价较大。在此背景下,我们尝试drools高阶应用,既规则动态化实践。

我们在创建缓冲池的页面中加入了流向规则的创建环节。每个缓冲池维护自己的流向规则,即为自己的一根连线。如下图:

4.2 动态生成drl

drt文件内容:

(实际业务模板中比这个复杂,有一定校验及业务逻辑,此处做了简化)

生成drl内容: 根据一个队列及模板的路径进行drl内容的生成

4.3 加载drl

上边的简单示例中,我们使用了 来加载规则文件至工作内存中。实际上我们不可能在每次匹配中重新加载所有规则文件,所以我们可以单例的使用规则容器,通过以下方式或者也可以使用等方式来管理容器。

通过将内容写入 然后重新加载整个 即可重新加载规则,但是这种行为比较重,代价较大

也可以通过 新增一个文件来进行加载,代价小,但是同步各个实例的代价较大。

4.4 匹配

通过 与规则引擎交互

如果使用 则需要在使用完成后进行关闭

在执行规则的过程中可以加入各种监听器对过程中各种变化进行监听。篇幅原因交给各位去探索。

五、 总结

从上边的流程中我们体验了动态规则的创建以及使用。动态规则满足了我们规则动态变化,规则统一管理的诉求。

我也总结了在这种使用方式下drools的几个优缺点。

优点:

-

规则动态化方便

-

在工作内存中匹配规则性能好

-

几乎可以满足所有的规则需求

-

内置方法丰富完善

缺点:

-

分布式一致性需要自行处理

-

需要研发了解drl语法

-

学习曲线陡峭

-

匹配过程监控手段需要自行实现

新年快乐,兔飞猛进! 根据最近 CNCF 对2000多名 IT 专业人士的 2022 年度调查,WebAssembly 将成为云原生技术栈的一个关键部分。 该调查主要发现

容器是新常态,而WebAssembly是未来的趋势。

WasmEdge 项目是一个开源的 WebAssembly 运行时,为云原生应用场景进行了优化。已经与 Docker Desktop 和 Fedora / Red Hat Linux 集成并分发。通过带薪的 LFX / CNCF 实习计划为 WasmEdge 做出贡献,为你的简历和技能加上闪亮一笔!

通过 LFX Mentorship 计划为像 WasmEdge 这样的CNCF托管的项目做贡献,你将获得:

- 丰厚报酬。金额从3000美到6600美不等,取决于你的所在地区

- 通过一对一的指导学习新的开发技能。如果你被选中,将分配到一个来自 WasmEdge 项目的经验丰富的 Mentor。

- 有机会获得顶级软件公司的工作机会

- 加入繁荣的开源社区,获得自豪感和成就感

现在就申请加入 WasmEdge 的 LFX Mentorship 计划,在开源领域做出成绩,并获得从3000到6600美不等的报酬!

WasmEdge 简介

WasmEdge 是一个WebAssembly 运行时,特别为服务器端和云原生应用优化。它提供了许多独特的功能,对云计算至关重要。例如,支持

- 完整的 WebAssembly 规范,以及新兴的规范,如线程、GC 和组件模型。

- Advanced networking 如 HTTP/S 客户端和服务器,数据库连接,消息队列连接。

- 基于流行框架的AI推理,如 Tensorflow,OpenVino,PyTorch

- 高级语言应用,包括 JavaScript、Python、PHP和 Ruby。开发者可以运行完整的node.js应用程序。

- 多种 APIs 用 Rust, Go,C/C++, JavaScript 创建 Wasm 应用。

- 多种 SDKs,将 WasmEdge 嵌入到现有的以其他语言编写的应用程序。

此外,WasmEdge 提供了一个灵活的插件架构 允许开发者为其添加更多功能,并通过广泛的开源合作伙伴充分发掘众多集成和分发渠道。通过我们的技术亮点发现 WasmEdge 的全部潜力。

WasmEdge 得到了云原生生态中主要开发者工具和部署平台的支持。例如,WasmEdge 与 Docker Desktop 集成并分发,覆盖超过 1000 万开发者。 Fedora、Red Hat Linux 和 OpenShift 容器平台上的默认 WebAssembly 运行时。

加入我们,共建云原生技术栈的未来!

LFX Mentorship 项目 (2023 年 3 月至 5 月)

这次我们有四个 mentee 空缺。

为了更好地协作,每个申请者需先完成预测试,本次预测试的截止时间是2月20日。

1. Stream data processing with WasmEdge

这个项目中,你将使用 WasmEdge Rust SDK 将 WasmEdge 嵌入到用 Rust 编写的 Fluvio 项目中。这是两个很棒的开源项目之间的合作。我们寻找的 mentee 需了解 Rust 和 WebAssembly Rust SDK 。

详情 | 预测试 | 申请链接

2. A Rust library crate for mediapipe models for WasmEdge NN

AI 训练和推理等计算密集型任务始终适用于 Rust 和 WebAssembly。WasmEdge 希望构建一个 Rust 库 crate,从而在 WasmEdge 应用程序中轻松集成 Mediapipe 模型。在这个项目中,你应该为Mediapipe的每个模型建立至少一套库函数。每个库函数都接受一个 media 对象并返回推理结果。我们寻找的 mentee 需要有 Rust 知识和一些机器学习经验。

详情 | 预测试 | 申请链接

3. WasmEdge C++ SDK

这个项目中,你将帮助添加基于 WasmEdge C API的 WasmEdge C++ SDK。WasmEdge C++ SDK 让开发者能轻松地将 WasmEdge 嵌入到他们的 C++ host app 里。我们寻找的 mentee 需要有 C++ 和 WebAssembly 的知识。

详情 | 预测试 | 申请链接

4. Unified WasmEdge tools

命令行是开发软件最常用的工具,WasmEdge 提供了两个工具供开发者使用: 和 。可是提供太多的工具会导致使用起来比较麻烦。因此在本项目中,你需要使用 帮助统一 WasmEdge 工具。这项工作将影响所有 WasmEdge 用户。他们将使用你开发的命令行来运行 Wasm 应用程序。我们寻找的 mentee 需要有 C++ 和 WebAssembly 的知识。

详情 | 预测试 | 申请链接

下一步是遵循mentee 指南,在2023年2月14日前完成申请并在2月20日前完成 pretest。 期待你的加入!

如有问题可公众号后台留言或者加入我们的 Discord。 同时,可以加入2月7日的 WasmEdge 社区会议,议题之一是 LXF mentorship 答疑。

延伸阅读

- 了解 sonder-joker’s journey on WasmEdge LFX mentorship

- 了解 gusye1234’s journey on WasmEdge LFX mentorship

目录

10.1 openGauss全量备份技术

10.1.1 gs_basebackup备份工具

10.1.2 gs_basebackup备份交互流程

本文主要介绍openGauss的备份恢复原理和技术。备份恢复是数据库日常维护的一个例行活动,通过把数据库数据备份到另外一个地方,可以抵御介质类的损坏,增加数据库数据的可靠性。数据库的备份恢复主要分为逻辑备份恢复和物理备份恢复。

逻辑备份是把数据库中的数据导出为文本文件,这些文本文件内容一般来说是SQL语句。恢复数据时再把文本文件中的SQL语句导入数据库中恢复。逻辑备份比较灵活,可以支持库级、模式级和表级备份,但逻辑备份只读取了某个时间点的数据库快照对应的数据,很难实现增量备份,恢复时也无法恢复到指定的时间点。在openGauss中实现逻辑备份恢复的工具为gs_dump/gs_restore,具体使用方法参考openGauss官网《管理员指南》手册。

物理备份是直接复制数据库的物理文件,性能比较高,对应用的约束比较少,但只能对整个库进行备份。物理备份又分为全量备份和增量备份。增量备份又有两种方式,一种是结合数据库的脏页跟踪实现的增量备份,另外一种是根据redo日志的增量实现的增量备份。根据脏页进行的增量备份可以和历史上的备份进行合并,减少存储空间的占用,恢复时可以恢复到增量备份的时间点,无法恢复到任意时间点。根据redo日志进行的增量备份在恢复时可以恢复到指定时间点,但所有的redo日志都需要进行备份,占用的存储空间较大。

逻辑备份主要用于异构数据库的迁移,物理备份主要用于保障数据库数据的可靠性。本章主要介绍openGauss的物理备份机制,包括全量备份技术和增量备份技术。

10.1 openGauss全量备份技术

openGauss有两个备份工具gs_basebackup和gs_probackup。gs_basebackup只能进行全量备份,gs_probackup既可进行全量备份,也可进行增量备份。gs_probackup全量备份的原理和gs_basebackup是类似的,本节以gs_basebackup工具为例介绍全量备份的原理。

10.1.1 gs_basebackup备份工具

gs_basebackup是一个独立的二进制程序,有自己的主函数,代码在src/bin/pg_basebackup目录下。在备份时,gs_basebackup通过指定的IP地址连接openGauss数据库服务器,openGauss数据库服务器把需要备份的数据文件和redo日志文件发送给备份工具gs_basebackup,gs_basebackup收到后把文件存放到本地指定的目录,从而完成数据库的备份。

gs_basebackup主要有两种备份格式:plain普通格式和tar压缩包格式。普通格式就是以通常的数据文件进行备份,tar压缩包格式就是把备份文件打包进行备份。openGauss的tar包头是2048字节,文件名最长支持1024个字节长度,不是标准的tar,所以需要openGauss自己解包,实现解包的命令为GsTar。

gs_basebackup的主干处理流程比较简单,首先对支持的命令行参数进行解析,主要的命令行参数请参照表1。参数解析后进入备份主函数BaseBackup,BaseBackup参照后面详细介绍。在主函数之后是free_basebackup,释放前面分配的内存资源,整个备份流程就结束了。

表1 命令参数

参数

描述

-D

备份的目的路径

-F

备份的文件格式,plain普通格式和tar压缩包格式

-X

是否进行流复制模式,当前要求必须采用流复制模式,保证备份数据的正确性

-Z

压缩级别

-c

备份时是否做快速检查点

-h

进行备份的数据库服务器监听IP地址

-p

进行备份的数据库服务器监听端口号

-U

进行备份时连接数据库服务器的用户名

-W

进行备份时连接数据库服务器的密码

-s

备份时状态更新时间间隔

-v

是否显示备份详细信息

– P

是否显示备份进度信息

10.1.2 gs_basebackup备份交互流程

1. plain普通格式备份

普通格式备份的主函数为BaseBackup,具体交互流程如图1所示。

图1 备份交互流程

从图1可以看出,数据库物理全量备份主要包括两个流程,一个是数据文件的备份,一个是XLOG文件的备份。详细过程如下。

(1) gs_basebackup在BaseBackup函数中创建数据传输的连接。

(2) 执行IDENTIFY_SYSTEM命令,获取时间线和系统标识符。

(3) 执行BASE_BACKUP LABEL备份命令,获取XLOG的存放路径和备份开始时日志的位置。然后从数据库服务器获取表空间的路径,创建对应的路径。

(4) 在拷贝数据文件之前,创建一个单独的子进程用于日志传输。日志传输处理的主函数为StartLogStreamer,在StartLogStreamer函数中,先调用GetConnection函数创建一个日志传输的连接,然后调用fork函数创建子进程,在子进程内部通过LogStreamerMain函数调用ReceiveXlogStream执行实际的日志传输。在ReceiveXlogStream中,也是先调用IDENTIFY_SYSTEM获取系统标识并且进行校验和前面获取的系统标识是否一致。接着执行START_REPLICATION,通知数据库服务器日志传输的起始位置。调用createHeartbeatTimer启动心跳线程,保证能够实时监控传输过程中的连接状态。接下来进行日志接收循环,接收数据库服务器传输的日志,写入本地日志路径,直到接收到通知的日志停止位置。

(5) 在主进程创建日志接收子进程之后,调用ReceiveAndUnpackTarFile进行数据文件的拷贝,在这个函数中,有一个while (1)循环,循环接收数据库服务器传输的数据文件,直到接收完数据库服务传输的全部数据文件。数据库文件传输完毕后,数据库服务器会返回一个备份结束时的日志位置。

(6) 主进程接收这个位置,把这个位置通过管道发送给日志接收子进程,日志接收子进程把这个位置与当前日志传输位置相比较,如果达到了这个位置,则日志接收结束,日志子进程退出。主进程等到日志传输子进程退出后,数据库备份的主流程就基本结束了。这个过程保证了redo日志覆盖到整个数据库文件的复制过程,即使在复制数据文件时可能由于数据库的并发刷盘导致数据页可能不一致,但这些不一致可以通过redo日志进行恢复,从而保证整个数据库备份数据的一致性。

(7) 后面两个函数,一个是FetchMotCheckpoint函数,这个函数备份MOT内存表的数据文件,流程和前面基本相似;还有一个是backup_dw_file函数,在backup_dw_file文件中,删除存在的双写文件,然后写入一个空的数据页,这个只是一个空文件,避免启动时的文件检查异常。最后释放前面获得的系统标识符,至此,客户端工具完成整个备份流程。

在数据库服务器端,备份主要在HandleWalReplicationCommand函数中进行,该函数主要接收客户端命令,并根据命令标识符进行处理。

(1) IDENTIFY_SYSTEM命令对应的标识符为T_IdentifySystemCmd,处理函数为IdentifySystem,在IdentifySystem中,构造systemid和timeline的数据组,返回给客户端备份工具。

(2) BASE_BACKUP LABEL命令对应的标识符为T_BaseBackupCmd,对应的主要处理函数为SendBaseBackup,在SendBaseBackup函数中,首先调用parse_basebackup_options解析备份的命令参数,包括备份标签(label)、备份进度(progress)、快速检查点(fast)、是否等待(nowait)、是否包括redo日志(wal)等选项参数,最后调用send_xlog_location函数发送日志文件的路径,接着调用perform_base_backup函数执行数据文件的备份。在perform_base_backup函数中,首先调用do_pg_start_backup执行备份权限检查,根据备份命令行参数决定是否请求检查点(RequestCheckpoint函数),然后生成备份标签文件backup_label,backup_label是备份的重要文件,这个文件包括的内容如下。

① START WAL LOCATION:备份开始时日志的位置。

② CHECKPOINT LOCATION:检查点的位置。

③ BACKUP METHOD:备份方法,pg_start_backup方式还是streamed方式。pg_start_backup没有指定备份标签文件,整个数据库只能同时运行一个备份。streamed方式有备份标签文件,可以同时运行多个备份。

④ BACKUP FROM:备份源standby还是master。

⑤ START TIME:备份开始的物理时间。

⑥ LABEL:备份标签。

backup_label文件最重要的作用是记录数据库恢复的起始位置,在数据库恢复时使用,其次是对本次备份的一个标识及记录一些备份的参考信息。

最后调用SendXlogRecPtrResult函数把备份开始时的日志位置发送给客户端。

perform_base_backup函数在/* Collect information about all tablespaces */while ((de = ReadDir(tblspcdir, “pg_tblspc”)) != NULL) 循环读取每个表空间的数据文件,通过sendTablespace调用sendDir,把表空间目录下的数据文件发送给客户端备份工具。在把全部文件发送给客户备份工具后,调用do_pg_stop_backup进行停止备份的处理,在do_pg_stop_backup函数中,先解析原来备份的backup_label文件,获取备份起始的XLOG位置,写入XLOG_BACKUP_END到日志文件,然后调用RequestXLogSwitch进行XLOG文件段切换,方便归档快速完成。请求一次新的检查点RequestCheckpoint,写当前备份的历史文件“Backup”.文件,调用CleanupBackupHistory清除历史备份文件。如果需要等待归档则等待日志归档完成,do_pg_stop_backup停止备份结束后,调用SendXlogRecPtrResult把备份结束的XLOG位置发送给客户端备份工具,服务器端备份命令的处理流程就结束了。

START_REPLICATION对应的标识符为T_StartReplicationCmd,处理函数为StartReplication,在StartReplication函数中,首先给客户端工具发送CopyBothResponse响应消息,然后调用WalSndSetPercentCountStartLsn设置流复制开始位置,然后设置replication_started为true,启动正式的流复制过程。

2. tar压缩包格式备份

tar压缩包格式备份的处理函数为ReceiveTarFile,具体过程如下。

(1) 根据备份内容(全部还是具体表空间)和是否压缩,确定文件名称是base.tar[.gz]还是<tablespaceoid>.tar[.gz]。

(2) 打开tar文件,接收数据库服务器发送的COPY数据流,写入tar文件,直到复制完整个内容。数据库服务器往GsBaseBackup发送的数据流就是一个压缩后的tar流。

如前所述,openGauss的tar包格式是自定义的,所以需要实现解包。解包的命令为GsTar,主要有两个命令行参数。

① -D, –destination=DIRECTORY,解压后的文件存放路径;

② -F, –filename=FILENAME,需要解压的tar包。

以上内容为备份恢复机制:openGauss全量备份技术的相关内容,后续将接着分享“openGauss增量备份技术”的精彩内容,敬请期待!

END

智能制造一体化管理系统 [SpringBoot2 – 快速开发平台],适用于制造业、建筑业、汽车行业、互联网、教育、政府机关等机构的管理。包含文件在线操作、工作日志、多班次考勤、CRM、ERP 进销存、项目管理、EHR、拖拽式生成问卷、日程、笔记、工作计划、行政办公、薪资模块、动态表单、知识库、公告模块、企业论坛、云售后模块、生产模块、系统模块化同步模块等多种复杂业务功能。

智能制造一体化 v3.9.1 发布 ,更新内容如下:

- 新增业务对象管理

- 删除动态表单相关功能,融入到业务对象管理中

- 新增工作流属性设置功能

- 用品采购、用品领用整改为工作流低代码服务

- 新增属性扩展字段

- 布局新增属性控制

- 新增操作管理

- 重磅新闻:基础模块 (源代码) 针对星球内部用户开放,具体包含功能可查看:https://sigusoft.com/sheet/DYWZWUWZQUkFTcmh2?tab=BB08J2

erp: https://gitee.com/doc_wei01/erp-pro

OA: https://gitee.com/doc_wei01/skyeye

报表:https://gitee.com/doc_wei01/skyeye-report 有问题可以联系作者,详情请看开发计划。

效果图

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

Apollo 2.1.0 已发布,包含了诸如 Spring Boot 3.0 支持、管理员工具页面增强、配置项的类型支持、支持数据库作为注册中心等重大更新。

01 Highlights

Spring Boot 3.0 支持

Apollo Java 客户端已支持 Spring Boot 3.0 版本。

管理员工具页面增强

用户管理页面增加了列表视图:

系统配置页面增加了 PortalDB 和 ConfigDB 所有配置项的列表视图:

开放平台权限管理页面增加了第三方应用列表视图:

配置项的类型支持

用户现在可以修改配置项的类型,Apollo 将根据类型进行基本类型检查,现在可用的类型有 String(默认)、Number、Boolean 和 JSON。

非 Properties 的 Namespace 比较功能

支持非 Properties 的 Namespace 比较不同集群/环境间的配置。

支持数据库作为注册中心

Apollo 现在支持使用数据库作为服务注册中心,无需依赖第三方服务注册中心,如 Eureka、Consul、ZooKeeper 等。

不兼容更新

Flyway 数据库迁移工具从新版本开始不再支持。

02 What’s Changed

功能增强

-

添加配置以调整属性源覆盖行为

-

添加 Config Service Load Balancer Client 的 spi

-

添加一个新的 API 以使用分页加载项目

-

apollo-client 支持 Spring Boot 3.0

-

apollo-client-config-data 支持 Spring Boot 3.0

-

添加 apollo-plugin-log4j2 模块以支持 log4j2.xml 集成

-

允许用户为 ApolloConfigChangeListener 配置以逗号分隔的命名空间

-

为 MessageProducerManager 和 Injector SPI 添加 Ordered 接口

-

优化 Spring-Security 防火墙拒绝请求响应 400 的问题

-

允许用户一次关联多个公共命名空间

-

优化开放平台授权管理 UI 体验

-

比较配置项时添加搜索键

-

添加一个新的 API 以使用分页加载项目

-

阿波罗门户用户友好的用户管理页面

-

将 Spring Session 序列化方式切换为 JSON 以兼容 Spring Security 版本更新

-

对命名空间进行多线程排序

-

允许用户删除 AppNamespace

-

为 Apollo Portal 开发人员添加配置处理器

-

添加潜在的 JSON 值检查功能

-

支持非 Properties Namespace 比较

-

为自定义 OIDC userDisplayName 添加一个选项

-

为配置项添加基本类型支持

-

一个用户友好的 Apollo 门户配置管理页面

-

支持使用数据库作为注册中心

-

用户可以在不重新编译项目的情况下更改 spring.profiles.active 的值

-

为 Eureka 开启登录认证

问题修复

-

修复 openapi item with url illegalKey 400 错误

-

修复 ApolloBootstrapPropertySources 优先级问题

-

修复 beanName2SpringValueDefinitions 缓存问题

-

修复当 openapi key 的参数包含 “a[0]” 时出现 400 错误请求

-

升级 mysql-connector-java 版本,修复可能的事务回滚失败问题

-

修复 ‘openjdk:8-jre-alpine’ 可能导致错误的 cpu 核心数

-

修复覆盖 JSON 类型配置为空的问题

-

修复 deletedAt 时间戳问题

-

修复 openapi item with url illegalKey 400 错误

-

修复 @Transactional 无效案例

-

修复灰度发布/回滚命名空间时出现的异常

-

修复 LDAP 集成的 JSON 序列化问题

-

修复 Apollo 检查 YAML 格式接口 Response Code = 500

-

修复 create namespace with single dot 500 错误

-

修复(安全):将 fastjson 升级到 1.2.83

-

修复获取包含删除项命名空间信息的 openapi 接口

-

运行测试时禁用 Spring Cloud Discovery 以加快测试过程并减少错误日志

-

修复灰度版本的配置长度限制无法与其主版本同步的问题

-

修复删除最后一项配置后出现空白项的问题

更多内容可以左下角阅读原文或直接访问以下链接:

-

https://github.com/apolloconfig/apollo/releases/tag/v2.1.0

-

https://github.com/apolloconfig/apollo-java/releases/tag/v2.1.0

升级后如有问题,可以反馈至 https://github.com/apolloconfig/apollo/issues。

欢迎加入我们

Apollo 社区欢迎大家以任何形式为社区做出贡献,包括但不限于文档改进、提交 issue/bug、贡献代码、Review PR、技术讨论等,一起促进开源生态的发展。

-

Apollo 官方网站:

https://www.apolloconfig.com/

-

Apollo 仓库地址:

https://github.com/apolloconfig/apollo

-

Apollo 公共邮箱:

apollo-config@googlegroups.com

关于 Apollo

Apollo 项目于 2016 年在携程框架研发部诞生,初衷是为了解决公司内部配置管理尤其是中间件公共配置的管理难题,秉持着开源开放的精神,项目从第一行代码开始就在 GitHub 上开源,可以说是一个完全开放的项目。经过多年的发展,Apollo 以其功能丰富、简单易用等特性,得到了社区开发者的欢迎,也已在数百家公司中得到广泛使用。

ip2region (2.0 – xdb) 是一个离线的 IP 数据管理框架和定位库,支持亿级别的 IP 断管理,10 微秒级别的查询性能,提供了很多主流编程语言的 xdb 数据格式的生成和查询实现。

ip2region 2.10.0 更新如下:

1、增加 erlang binding 实现:https://github.com/lionsoul2014/ip2region/tree/master/binding/erlang

默认的 bench 测试结果如下:

2、优化 python binding maker 数据检测的实现:https://github.com/lionsoul2014/ip2region/pull/286

解析ip段出错时,抛出异常结束程序,方便查找问题。

3、修复 java binding 的 getInt2 实现的 bug:https://github.com/lionsoul2014/ip2region/issues/287

当 region 信息超过 一定长度后会触发这个 bug 导致查询读取的 region 信息不完整,最新 maven 地址:

ip2region 2.11.1 下载地址:

1、Gitee:https://gitee.com/lionsoul/ip2region/tree/v2.11.1

2、Github:https://github.com/lionsoul2014/ip2region/releases/tag/v2.11.1

作者: 京东零售 NutUI

- NutUI 4.0 Github 地址:github.com/jdf2e/nutui

- NutUI 4.0 官网:nutui.jd.com

前言

技术日异月新、发展创新、持续的迭代已成为常态。NutUI 虽经过 v1.0、v2.0、v3.0 三次技术蜕变,仍面临很多兼容、破坏性调整的需求。随着我们自身承接业务的多样性变化及社区诉求日渐增多,大调整和升级势在必行,经过团队及社区开发者 3 个多月的开发和自测,在 2023 辞旧迎新之际我们正式发布 NutUI 4.0。

NutUI 4.0 带来了 、、、、,围绕组件丰富性、轻量化、易用性力求将组件的质量和体验提升一个台阶。

新功能

CSS Variables 动态主题

NutUI 4.0 新增 CSS Variables 动态主题,在项目运行时,通过 CSS 变量覆盖默认样式,完成定制主题、动态切换主题、暗黑模式等换肤功能,提升产品易用性。

CSS Variables 本质是一系列的样式属性,默认值被定义在 节点上,与 NutUI 3 的定制主题、在线主题定制功能相比,用户无需新建自定义 Scss 变量文件,只需通过 ConfigProvider 组件实现实时动态主题切换,使用方式更加简洁、灵活。

NutUI 4.0 保留原有的主题定制、在线主题定制功能,开发中根据项目的实际需求进行综合考量,按需选取适合业务场景的换肤方式。

专属图标库

NutUI 4.0 新增专属图标库。@nutui/icons-vue H5 图标包与 @nutui/icons-vue-taro Taro 图标包,专属图标库是将原 NutUI Icon 组件剥离,从而减少 NutUI 包体积 464kB,提升了轻量化体验。

专属图标库保持京东风格,使用方式包括 IconFont 全量引入,新增 SVG 按需引入方式。

按需使用

全量使用

随着专属图标库的诞生,NutUI 4.0 中所有组件内置图标的使用方式也发生了变化,都可以通过插槽进行自定义,图标样式、大小、颜色均由开发者配置,灵活度大幅提升。

自动按需引入

NutUI 4.0 新增更高效的自动按需引入方式。通过 实现按需引入,移除 、 插件。

与 、 相比, 支持在 Vite、Webpack、Vue CLI 等项目中自动引入组件,按需引入样式也不再强依赖于 babel,开发者可以选择 SWC、esbuild 等其他效率更高的编译工具,进而提升编译效率,Taro 小程序的开发体验也随之提升。

为了适配 插件,NutUI 4.0 对部分组件的名称与使用方式进行了调整

- nut-fixednav -> nut-fixed-nav

- nut-checkBoxgroup -> nut-checkBox-group

- … …

更多组件名称调整可参考官网 从 v3 升级到 v4。

组件更完善

NutUI 4.0 除新增功能外,也加强了组件的易用性、丰富性,力求组件更高效、涵盖更多的业务场景。

新组件

NutUI 4.0 新增 2 个组件,为 NutUI 注入”新鲜血液”。

我们坚信 80 绝对不是组件库的数量极限,挖掘更多新组件,让组件库更丰富,是我们持续不断在做的事情。

-

Tour

新增 Tour 组件,用于引导用户了解产品功能。

-

PullRefresh

新增 PullRefresh 组件,用于下拉刷新的交互操作。

易用性提升

NutUI 4.0 对 20+ 个组件做了破坏性变更,提升组件灵活度、复用率、扩展性。

NutUI 致力于打造一款好用的组件库,4.0 期间对组件进行深度优化改造,诸如功能设计不合理、灵活度不高、场景覆盖不全、扩展性不强等问题。

- ShortPassword 不再依赖原生键盘,Demo 演示中键盘替换为 Numberkeyboard 组件,自由组合使用,灵活度更高

- 精简 Input 组件 Props ,使其具备与 Form 组件互相搭配使用的能力,提升组件复用率

- InfiniteLoading 组件删除下拉刷新功能,组件功能定位更加清晰,功能更加纯粹

- Picker 组件删除内置 Popup 功能,平铺展示,满足更多的使用场景。同时也修改基于 Picker 派生出的 DatePicker 组件。

- … …

更多组件 API 调整可参考官网 从 v3 升级到 v4

轻量化

NutUI 一直以来以为核心理念,在组件体积、NPM 依赖、构建产物等方面持续进行优化。相较于 NutUI 3.3.1,NutUI 4.0 的安装体积由 14MB 下降至 8MB,减少 42%。

注:上述数据来自于 packagephobia

NutUI 4.0 在包体积上也有了明显的下降,由 3.81MB 下降至 2.3MB,减少 39%。

组件瘦身

NutUI 4.0 对 10+ 个组件进行了优化,通过重构、逻辑修改、公共函数提取等方式,不仅加强了组件的健壮性,提高扩展性,也使 NutUI 的压缩前体积减少了 50kB。

- Popover 组件进行重构,去掉第三方依赖包,实现 0 外部依赖

- 优化 H5 与 Taro 共同需要编译函数,实现每端代码包的每行代码都是不可或缺的

- 提取公共函数 5 个,减少冗余代码

- … …

图标瘦身

NutUI 4.0 新增专属图标库,不仅安装包体积减少 595kB。

同时,NutUI 4.0 删除 125 个字体图标的 font 文件,包体积减少 464kB。

另外,专属图标库提供按需引入方式,在使用了 NutUI 的项目打包时,也只会引入组件内置图标,不会全量引入,项目包体积平均减少 50+ kB。

副作用清除

NutUI 4.0 优化打包策略,nutui.es.js 由全量引入改为按需加载,其文件体积由 624kB 下降至 11.9kB,减少 612kB。同时,避免了副作用的产生。

技术升级

NutUI 4.0 进行了底层架构升级来支撑不断加入的新功能,共建亦有全新体验。

-

构建工具升级

NutUI 4.0 将底层构建工具从 Vite 2 升级到 Vite 4,构建时间减少了 10 秒

-

库类型声明升级

NutUI 4.0 开始,不在使用第三方插件 ,改用 vue 官方推荐的 生产类型声明文件。同时,与 Volar 插件两者结合实现检查类型错误能力。

未来

NutUI 发展至今,我们一直在学习一直在思考,除了提供更加丰富的组件、优化现有组件外,还需要做哪些事情才能服务到更多的开发者,真正做到高效、灵活、好用。

NutUI 作为移动端组件库,4.0 开始会分为 与 两个方向。针对基础组件,开发方向拆分为 H5、小程序、APP,丰富更多的 “端” 需求。

在过去,NutUI 沉淀了与高级组件库,在 NutUI 4.0 迭代同时,我们总结过往开发业务组件的经验,梳理并推出业务组件,包括商品类、优惠券类、订单类、发票类共计出 20+ 个高级组件。目前正紧张开发中,不久将与大家见面,敬请赐候~

最后

NutUI 的持续迭代离不开使用者和开发者的长期反馈和支持,特别感谢本次为 NutUI 4.0 做出贡献的社区开发者:@Coffee-C、@gyt95、@jxt776、@kasonyang、@mikasayw、@sjx12、@thx125、@xiaosifeng。愿大家在开源的道路上步履不停~

大家在开发中遇到任何问题,可以在 GitHub 与我们联系,或者邮件至 nutui@jd.com,也欢迎大家为 NutUI Star。

相关链接:

- NutUI GitHub

- NutUI 4.0 官网

- 京东小程序官网

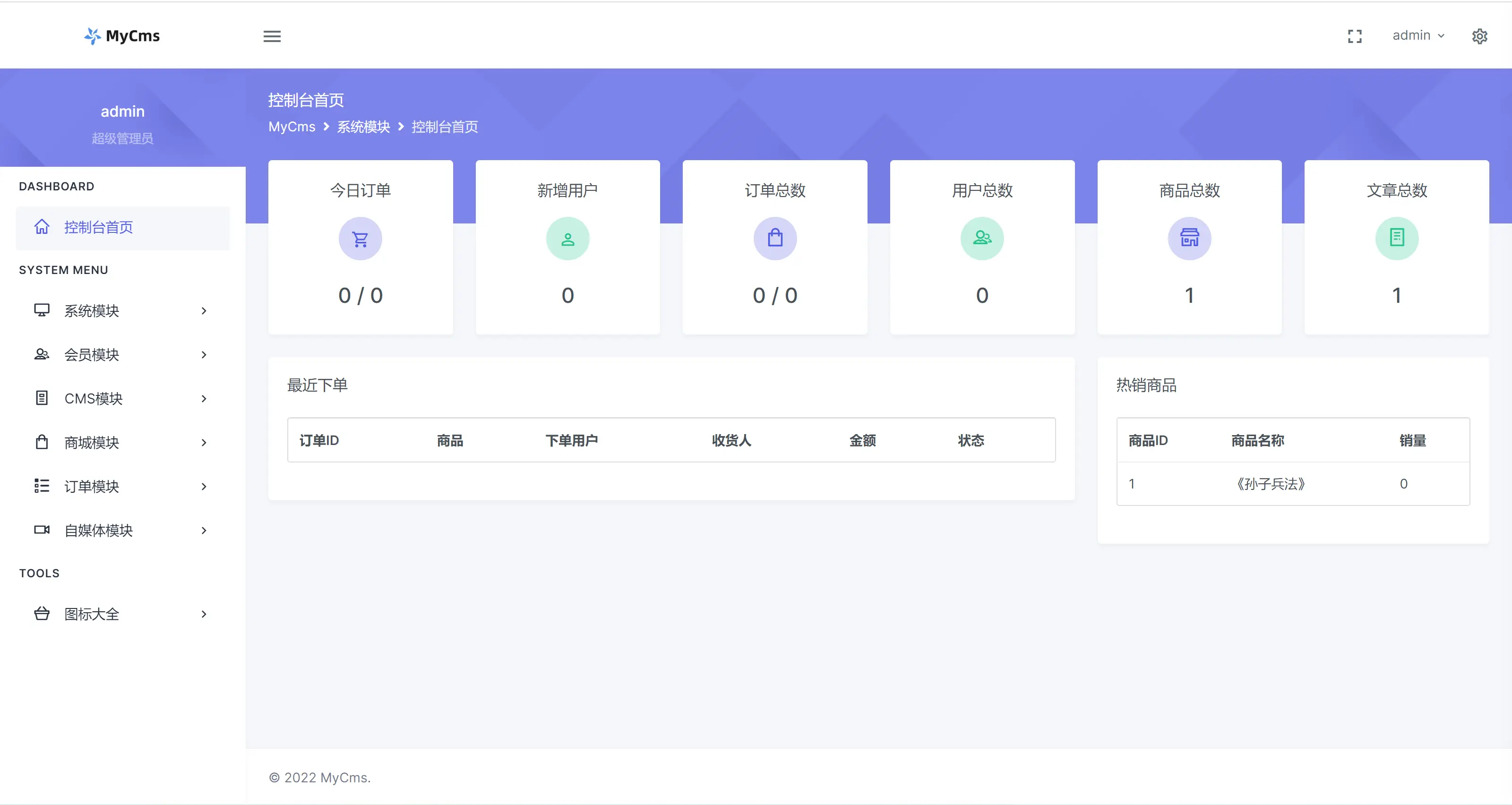

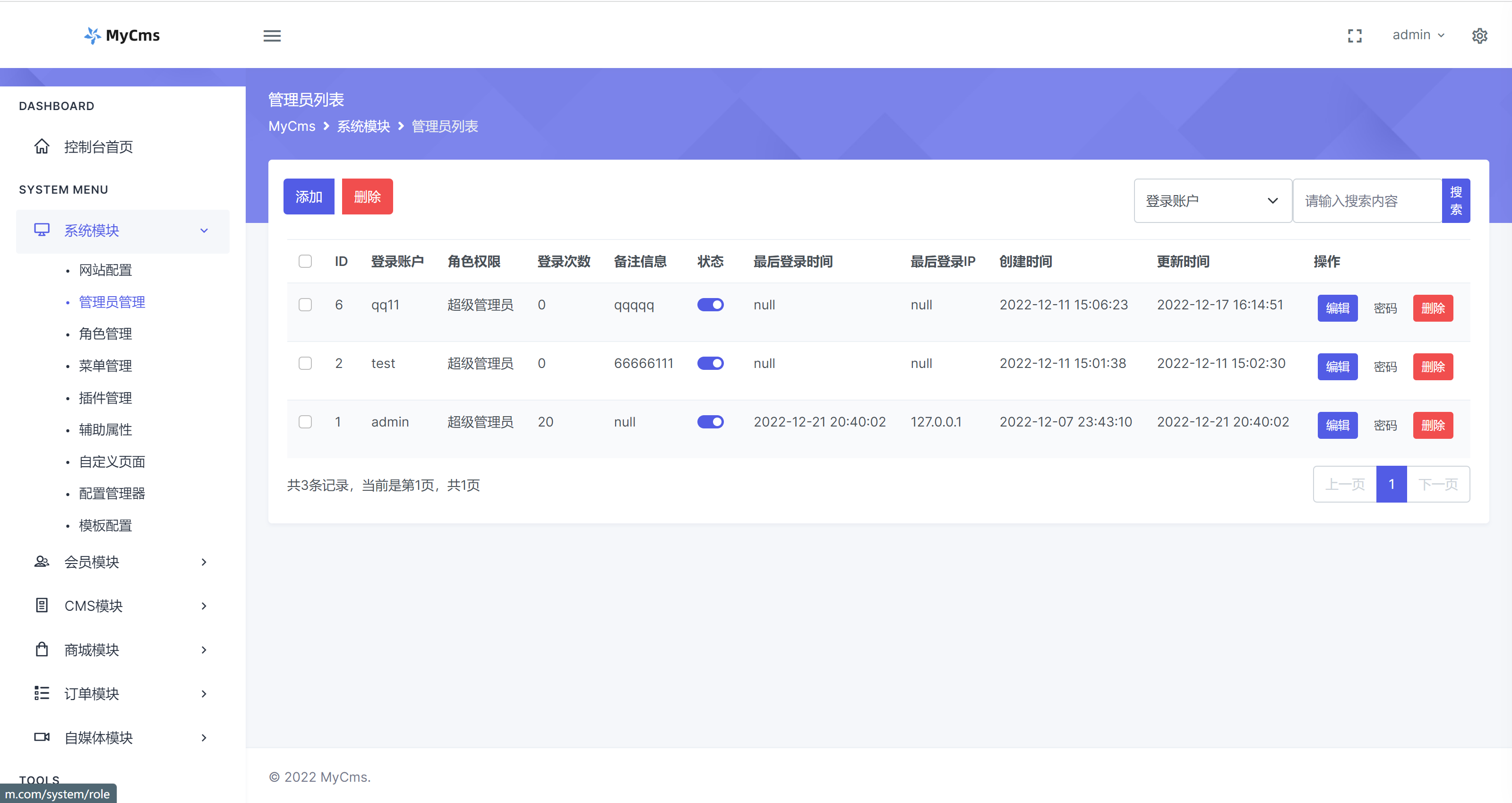

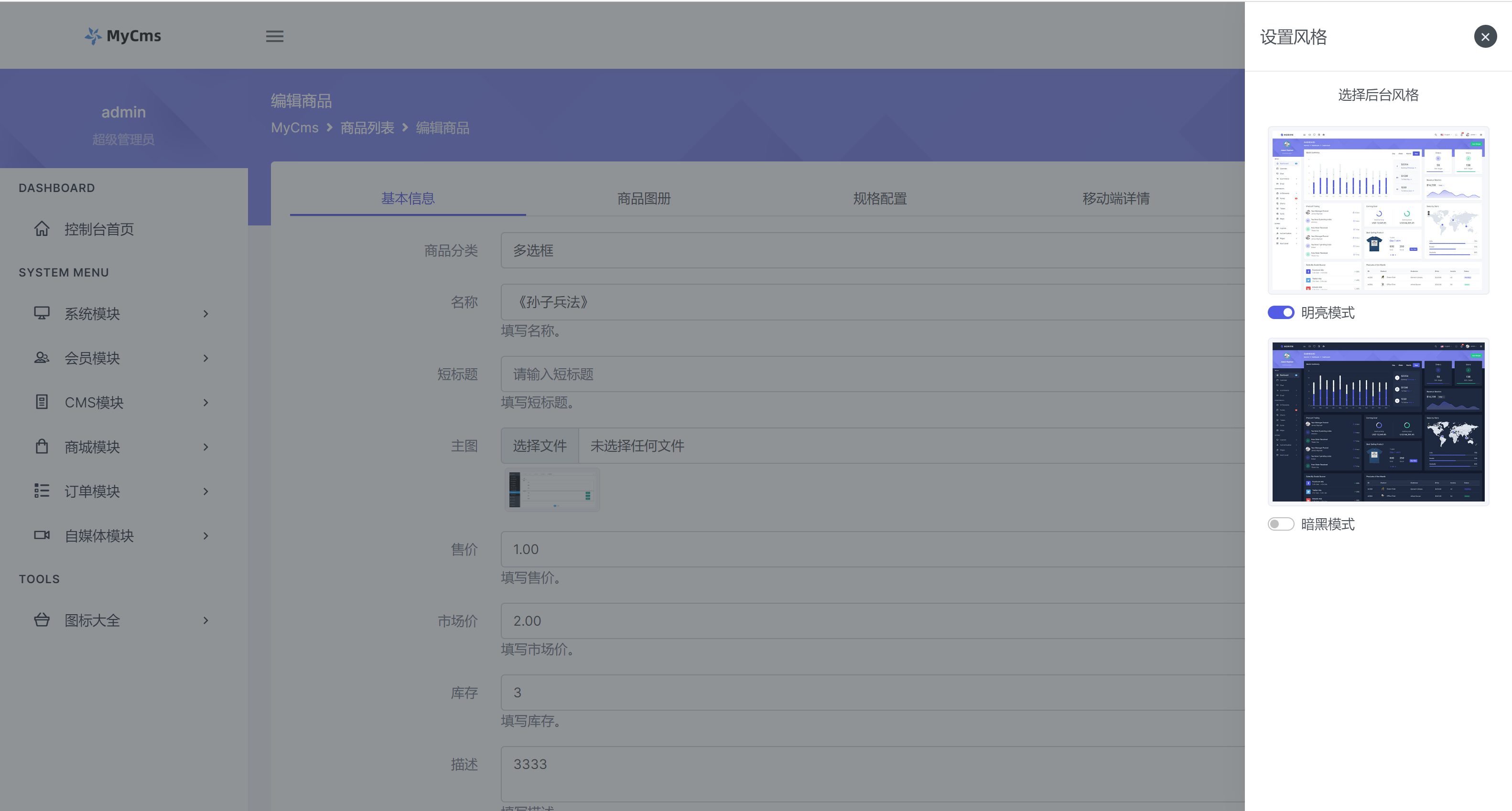

v3.2.0 更新内容:

1、修复文章管理未填写文章导读数据提交异常问题;

2、变更数据库名为:rxthinkcmf.evtp6.pro,跟其他版本保持统一的风格;

3、配置管理表新增配置编码字段(code)、备注字段(note);

4、更新前端系统启动脚本,本地启动命令更新为:npm run serve

5、完善系统架构细节,优化用户使用体验;

6、修复近期用户反馈的BUG;

一款 PHP 语言基于 ThinkPhp6.x、Vue、ElementUI 等框架精心打造的一款模块化、插件化、高性能的前后端分离架构敏捷开发框架,可用于快速搭建前后端分离后台管理系统,本着简化开发、提升开发效率的初衷,目前框架已集成了完整的 RBAC 权限架构和常规基础模块,前端 Vue 端支持多主题切换,可以根据自己喜欢的风格选择想一个的主题,实现了个性化呈现的需求;为了敏捷快速开发,提升研发效率,框架内置了一键 CRUD 代码生成器,自定义了模块生成模板,包括后端 PHP 文件模块和前端 Vue 端个性化模板,可以根据已建好的表结构 (字段注释需规范) 快速的一键生成整个模块的所有代码和增删改查等等功能业务,真正实现了低代码开发,极大的节省了人力成本的同时提高了开发效率,缩短了研发周期,是一款真正意义上实现组件化、低代码敏捷开发框架。

软件信息

- 软件名称:RXThinkCMF 敏捷开发框架 ThinkPhp6.x+EleVue 版本

- 官网网址:https://www.rxthink.cn

- 文档网址:http://docs.thinkphp6.elevue.rxthink.cn

- 演示地址:http://manage.thinkphp6.elevue.rxthink.cn

特别鸣谢

感谢 ThinkPHP、Vue、ElementUI 等优秀开源项目。

EventMesh 动态事件驱动的应用程序运行时,能够用动态插件式基础服务对系统进行解耦,支持不同技术栈的混合多云、复杂分布的拓扑结构等广泛用例。以事件驱动为核心,增强事件处理能力,优化编排协调过程,并提供联邦治理机制。为企业实现数字化转型提供了应用进程间通信的全套解决方案,帮助企业降低系统复杂度,节约开发维护成本。

EventMesh v1.8.0 是进入 Apache 孵化后更新的第 7 个版本,继 v1.7.0 版本提供了 workflow 能力后,本次版本最主要的功能特性是,EventMesh Dashboard 提供了与 workflow 的集成与交互,可以通过 EventMesh Dashboard 对 workflow 进行编排与配置,初步实现了界面化的交互设计,如下图所示:

同时,为大家带来了 12 个新增特性,完善修复了 3 个可能的安全问题,具体有哪些,请大家下滑获取。关于使用分布式应用框架进行提效的深度解读、如何实现数据联合治理?等话题的解决方案,欢迎加入社区详细了解!

GitHub repo:https://github.com/apache/incubator-eventmesh

Gitee repo:https://gitee.com/WeBank/EventMesh

Website:https://eventmesh.incubator.apache.org/

小助手 ID:EventMesh

EventMesh v1.8.0 特性

- 特性 #2888 Complete EventCatalog features

- 特性 #2894 Complete Dashboard Workflow Features

- 特性 #2865 Dashboard-add workflow swagger docs

- 特性 #2866 Dashboard-add event catalog swagger docs

- 特性 #2790 Jaeger tracing plugin docs

- 特性 #2867 Dashboard-add workflow controller cmd module

- 特性 #2868 Dashboard-add event catalog controller cmd module

- 特性 #2808 Dashboard-Add event catalogs

- 特性 #2807 Dashboard – Add Workflows

- 特性 #2806 Dashboard – New style for the navigation menu

- 特性 #2789 Jaeger tracing plugin service

- 特性 #2788 Jaeger tracing plugin config

EventMesh v1.8.0 增强

- 增强 #2576 Enhancement of the config management for the project

- 增强 #2894 Optimize workflow save interface

- 增强 #2880 Optimize workflow dashboard controller module

- 增强 #2181 Workflow Feature Implementation: Catalog Management

- 增强 #2180 Workflow Feature Implementation: Workflow Management

- 增强 #2863 eventmesh-server-go module add golangci-lint command in Makefile

- 增强 #2852 optimize code to reduce almost the same code for updating clients and subscriptions in different processor

- 增强 #2702 Some optimizations for collections

- 增强 #2693 SendAsyncEventProcessor judgment blanks can be simplified

- 增强 #2691 Interface methods are public by default so you can remove the public

- 增强 #2642 go sdk common util module add test case

- 增强 #2640 Refine rabbitmq connector unit test

- 增强 #2638 refactor go sdk id module test

- 增强 #2196 Workflow Feature Implementation: Workflow execution metrics

- 增强 #2190 Workflow Feature Implementation: Event Filter/Validate

- 增强 #2192 Workflow Feature Implementation: Integrate EM, implement queue based on MQ

EventMesh v1.8.0 修复

- 漏洞 #2855 eventmesh-sdk-go test error

- 漏洞 #2849 TCP Server will throw stack overflow error when subscribing because of calling self method recursively

- 漏洞 #2845 Fix IOException in SSLContextFactory

Scala.js 团队发博客庆祝该项目走过第一个十年。

Scala.js 是一个将 Scala 语言编译成 JavaScript 的工具,可以直接在浏览器上使用 Scala 编写程序。

最初的Scala.js 是 EPFL LAMP 的一个单人项目,于 2013 年 2 月 5 日迎来了首次提交,并在 2013 年 6 月的 Scala Days 上首次展示,当时受到了热烈欢迎 —— 虽然它输出了 16 MB 大小的“Hello world”。随后一小群早期的爱好者聚集在一个邮件列表中,为该项目提供有价值的早期反馈,随着讨论的增加,一个人的项目很快成长为一个两人核心团队以及几十个爱好者。

起初 Scala 生态系统的大多数库都不支持 Scala.js,只有一些核心用户使用 Scala.js 构建了新的库和测试框架。但随着 Scala.js 0.6.0 脱离了实验性环境,转为生产可用,Scala.js 的采用显著增长, Scala 生态系统中越来越多的库开始支持 Scala.js。如今,大多数不专门针对 JVM-only 特性的库都为 Scala/JVM 和 Scala.js 交叉发布。在 2021 年 8 月发布的 Scala.js 1.7.0 以来,Scala.js 的每个版本的已知错误都是 0 ,覆盖了整个核心存储库:编译器后端和 Scala 链接器。

回想发布之初,将 Scala 编译成 JavaScript 还像一个梦想,但如今它已成为一种日常。如今 Scala.js 已经是一项非常成熟的技术,具有稳定核心、充满活力的库生态以及热情的用户和贡献者社区。在 Jetbrains 2022 开发者调查和 Scala 2022 现状调查中, Scala 开发者分别有 12% 和 17% 的 Scala.js 用户。 在 Maven Central 统计报告中,Scala.js 核心工件每月的下载量超过 100,000 次。

为推动社区繁荣发展,打造开源操作系统创新生态, openKylin社区根据领域划分了不同的SIG组,并积极开展各种技术研究和创新。截至目前,社区新增共有57个SIG组在运行,接下来,让我们一起盘点2023年1月份openKylin社区SIG组的最新技术进展:

openKylin社区技术进展与成果

一、UKUI SIG

UKUI(Ultimate Kylin User Interface) SIG小组致力于桌面环境相关软件包的规划、维护和升级工作,满足各种设备和用户需求的桌面环境程序,主要包含程序启动器(开始菜单)、用户配置、文件管理、登录锁屏、桌面、网络工具、快捷配置等,为用户提供基本的图形化操作平台。桌面核心组件开发工具以Qt、C++为主,宗旨是始终如一地提升系统的操作体验,提供集稳定性、美观性、流畅性和便捷性为一体的桌面环境。1月进展如下:

- 分级冻结:进行第二轮提测,同步demo和用例;

- 企业WIFI新增LEAP、FAST和PWD三种认证方式;

- 解决控制面板、网络、触摸、会话管理器、日历、文管、睡眠唤醒、多语言等问题;

- 修复版权信息、电源适配器、无法删除用户、快捷键、电源管理、通知中心、全局搜索、控制面板、托盘电源、任务栏、侧边栏等问题。

欢迎各位感兴趣的社区开发者加入我们,一起打造openKylin桌面系统稳定易用的桌面环境!

二、RISC-V SIG

本SIG组主要负责RISC-V架构开源软件包的维护,发布openKylin的RISC-V版本,进行软件包构建、系统构建等工作。1月份RISC-V SIG组进展如下:

- 制作并提测openKylin0.9.5-beta版本的hifive、visionfive、曳影1520三个镜像;

- 修复了桌面显示、系统安装卸载、tty显示、打印机报错等问题;

- 开发板适配解决cpu占用100%问题;

- 适配visionfive2开发板。

欢迎所有对RISC-V开发平台技术方向感兴趣的爱好者加入到RISC-V SIG!

三、Release SIG

Release SIG主要负责协调各个SIG组,把控版本开发进度和风险,制定版本发布计划,完成版本发布工作等。Release SIG组1月主要进展如下:

- 0.9.5 RC版本提测(x86,riscvRISC-V);

- 完成0.9.5版本发布相关工作:里程碑bug以及RISC-V和arm版本等问题修复;

- 0.9.5版本阶段总结复盘,后续工作计划讨论;

- 完成5个高危安全漏洞修复更新推送。

欢迎所有对openKylin社区版本集成、版本管理、版本发行等工作感兴趣的爱好者加入到Release SIG!

四、Packaging SIG

Packaging SIG负责维护openKylin社区的软件包打包规范,维护公共软件包,以及协调和决策社区版本发布过程中的包依赖问题。1月主要进展如下:

- paddle、libzstd-1.5.2、Perl 5.36.0编译处理,编写perl特性说明文档;

- 解决docker运行失败、cryptsetup编译问题;

- 从上游社区自主构建containerd, runc, libseccomp,libqapt,abseil,openldap;

- 修复ukui-power-manage、gcc-defaults、libsoup2.4、accountsservice 0.6.55问题;

- 上传kylin-sso-client,kylin-software-center,kylin-kmre-window,paddlepaddle、libzstd、isl、gmp、autoconf2.6等;

- 新增自主构建软件包13个。

欢迎所有对openKylin社区软件自主选型、编译打包工作感兴趣的社区爱好者加入我们!

五、Framework SIG

Framework SIG致力于为openKylin社区提供集程序编辑、编译、调试、发布、分析等全套开发功能的编程环境,涵盖通用集成开发环境、编译工具链、运行时环境、类库等。SIG初期重点研制高效率、跨平台、插件化、易调试的通用集成开发环境,支持C、C++、Java、Go、Fortran、Python、JavaScript等多种标准编程语言,涵盖编码、编译、调试、性能分析、软件交付等一整套开发流程,满足openKylin平台上软件开发需求。1月主要进展如下:

- 项目创建插件优化c语言项目创建模板,调整创建过程的逻辑和相应的修改数据功能。

欢迎所有对openKylin社区应用集成开发环境感兴趣的爱好者加入到Framework SIG!

六、GPU SIG

openKylin GPU SIG组致力于GPU驱动相关技术研究,包括OpenGL、OpenCL、Vulkan、VDPAU和VAAPI等。提供GPU相关软件包的技术规划、设计、开发、维护和升级服务,共同推动国产GPU技术发展。GPU SIG组1月份进展如下:

- 和格兰菲、象帝先等GPU企业交流合作,并完成加入GPU SIG组流程。

欢迎所有对CPU驱动、国产GPU技术、显示等相关领域感兴趣的社区小伙伴加入GPU SIG组!

七、InternationalPromotion SIG

本SIG组负责openKylin操作系统的国际化推广,开展国际交流会议,提升国产操作系统国际影响力,致力于世界各地爱好者加入openKylin社区建设。1月份进展如下:

- 举办社区首届国际交流活动,与南开大学留学生交流讨论社区国际推广相关合作。

欢迎国内外对openKylin操作系统国际推广工作感兴趣的小伙伴加入到InternationalPromotion SIG,共同推动openKylin迈向国际!

八、Infrastructure SIG

Infrastructure SIG负责openKylin社区的基础平台系统功能的开发、维护。1月主要进展如下:

- CI平台增加PR提示,解决了检查结果404报错、版本号对比错误等问题;

- 数字看板增加外部开发者总积分排名接口。

欢迎所有对openKylin社区基础设施平台开发维护感兴趣的爱好者加入到Infrastructure SIG!

九、QA SIG

QA SIG组致力于提升openKylin社区版本质量,包括社区版本测试、质量保障等。1月主要进展如下:

- RC版本回归测试;

- bug复现协助确认;

- 处理码云issue2个,计算贡献值;

- RC版本0105-0109版本测试、release版本测试、RISC-V架构测试、更新升级测试;

- 输出0.9.5版本公测方案。

欢迎所有对openKylin社区版本测试、质量管理感兴趣的社区爱好者加入我们!

十、Security Governance SIG

openKylin SecurityGovernance SIG通过接收和响应openKylin社区的产品安全问题报告、提供社区安全指导,开展安全治理等活动提升社区产品的安全性。1月主要进展如下:

- 调研CodeCheck代码扫描工具;

- “诊脉”漏扫框架(genmai),调试dbus漏洞扫描模块,加载POC验证;

- 完成漏洞检测工具baseline框架开发,以及添加了9个poc;

- 安全编码规范:调研了CodeCheck代码扫描工具的规则配置,规则文件导入导出功能。

欢迎所有对openKylin版本安全全漏洞挖掘/验证、安全漏洞修复等安全方面工作感兴趣的社区爱好者加入我们!

关于openKylin社区SIG

openKylin(开放麒麟)社区是一个自由开放的社区,社区中所有的SIG小组都是开放的,任何人和组织都可以参与。你可以选择加入已有SIG,也可以选择创建新的SIG。截至目前,openKylin社区已有57个SIG在运行,包括Architecture、Infrastructure、Release、Kernel、Security、Compatibility等。

如果您对此感兴趣,想要加入openKylin(开放麒麟)社区,参与SIG贡献,可 “https://www.openkylin.top/sig/index-cn.html ” 了解更多详细内容。

关于openKylin社区

openKylin(开放麒麟)社区旨在以“共创”为核心,在开源、自愿、平等、协作的基础上,通过开源、开放的方式与企业构建合作伙伴生态体系,共同打造桌面操作系统顶级社区,推动Linux开源技术及其软硬件生态繁荣发展。

社区首批理事成员单位包括麒麟软件、普华基础软件、中科方德、麒麟信安、凝思软件、一铭软件、中兴新支点、心科技、中国电科32所、技德系统、北京麟卓、先进操作系统创新中心等13家产业同仁和行业机构。

来源:openKylin

审核:openKylin

2023年1月26日,Apache 软件基金会 (ASF) 官方宣布 Apache bRPC 正式毕业,成为 Apache 顶级项目 (TLP)。

Apache bRPC 是由百度初始创立并持续贡献的工业级别 RPC 开源项目,在 2018 年正式贡献给 Apache 软件基金会进行项目孵化,2022年12月24日经过 Apache 董事会集体投票表决,Apache bRPC 项目顺利毕业,成为 Apache 软件基金会顶级项目(TLP),这是百度继 ECharts 和 Doris 之后,又一里程碑式的开源项目。

Apache ECharts 顺利毕业,成为 ASF 顶级项目

Apache Doris 从 Apache 基金会毕业,正式成为 Apache 顶级项目!

关于 Apache bRPC

bRPC于2014年诞生于百度基础架构部,用C++编写的工业级RPC框架,常用于搜索、存储、机器学习、广告、推荐等高性能系统。2017年正式在 GitHub 进行开源,并于2018年11月正式捐献给全球顶级开源社区 Apache 软件基金会(ASF),对外开源版本的名称为 Apache bRPC,成为 ASF 孵化级项目。

据介绍,bRPC以功能全、可扩展、高性能等特性得到越来越多用户的认可和使用,经过四年多的孵化,bRPC开发者数量增长数倍、在GitHub上的Star数也超过14.4K,目前已覆盖了互联网、人工智能、搜索、推荐、电商和教育等多个行业和领域,被百度、爱奇艺、作业帮、字节跳动、京东、拼多多、滴滴、B站、vivo、小红书、第四范式、欢聚时代、shopee等公司广泛使用并对该项目进行持续贡献,线上服务实例数已超过600W,现已成为业界广受欢迎的开源RPC框架之一。

Apache bRPC 成长史

-

2014年,baidu-rpc在百度基础架构部诞生

-

2016年,baidu-rpc在百度得到大规模落地和实践

-

2017年,bRPC在GitHub上正式开源

-

2018年,百度将 bRPC 捐献给 Apache 软件基金会并命名为 Apache bRPC,进入孵化器

-

2021年,bRPC社区发布第一个正式版本 1.0.0

-

2022年,正式完成商标捐赠,推动 Apache bRPC 完成毕业,成为 Apache 软件基金会顶级项目(TLP)

截至2023年1月,Apache bRPC 已在GitHub上获得14.4K Stars ,拥有超过130名贡献者,成为国内最活跃的开源社区之一。

Apache bRPC 社区官方链接

- Apache bRPC官方网站:https://brpc.apache.org/

- Apache bRPC GitHub:https://github.com/apache/brpc

- Apache bRPC 开发者邮件组:dev@brpc.apache.org

- 订阅 Apache bRPC 邮件列表

发送任意主题和内容到 dev-subscribe@brpc.apache.org

根据回复完成订阅

作者:vivo 互联网前端团队- Yang Kun

本文是上篇文章《Node.js 应用全链路追踪技术——全链路信息获取》的后续。阅读完,再来看本文,效果会更佳哦。

本文主要介绍在Node.js应用中, 如何用全链路信息存储技术把全链路追踪数据存储起来,并进行相应的展示,最终实现基于业界通用 OpenTracing 标准的 Zipkin 的 Node.js 方案。

一、背景

目前业界主流的做法是使用分布式链路跟踪系统,其理论基础是来自 Google 的一篇论文 《大规模分布式系统的跟踪系统》。

论文如下图所示:

(图片来源:网络)

在此理论基础上,诞生了很多优秀的实现,如 zipkin、jaeger 。同时为了保证 API 兼容,他们都遵循 OpenTracing 标准。那 OpenTracing 标准是什么呢?

OpenTracing 翻译为开发分布式追踪,是一个轻量级的标准化层,它位于应用程序/类库和链路跟踪系统之间的一层。 这一层可以用下图表示:

从上图可以知道, OpenTracing 具有以下优势:

-

统一了 API ,使开发人员能够方便的添加追踪系统的实现。

-

OpenTracing 已进入 CNCF ,正在为全球的分布式链路跟踪系统,提供统一的模型和数据标准。

大白话解释下:它就像手机的接口标准,当今手机基本都是 typeC 接口,这样方便各种手机能力的共用。因此,做全链路信息存储,需要按照业界公认的 OpenTracing 标准去实现。

本篇文章将通过已有的优秀实现 —— zipkin ,来给大家阐述 Node.js 应用如何对接分布式链路跟踪系统。

二、zipkin

2.1 zipkin 是什么?

zipkin 是 Twitter 基于 Google 的分布式追踪系统论文的开发实现,其遵循 OpenTracing 标准。

zipkin 用于跟踪分布式服务之间的应用数据链路。

2.2 zipkin 架构

官方文档上的架构如下图所示:

为了更好的理解,我这边对架构图进行了简化,简化架构图如下所示:

从上图可以看到,分为三个部分:

第一部分:全链路信息获取,我们不使用 zipkin 自带的全链路信息获取,我们使用 zone-context 去获取全链路信息

第二部分:传输层, 使用 zipkin 提供的传输 api ,将全链路信息传递给 zipkin

第三部分: zipkin 核心功能,各个模块介绍如下:

-

collector 就是信息收集器,作为一个守护进程,它会时刻等待客户端传递过来的追踪数据,对这些数据进行验证、存储以及创建查询需要的索引。

-

storage 是存储组件。zipkin 默认直接将数据存在内存中,此外支持使用 ElasticSearch 和 MySQL 。

-

search 是一个查询进程,它提供了简单的 JSON API 来供外部调用查询。

-

web UI 是 zipkin 的服务端展示平台,主要调用 search 提供的接口,用图表将链路信息清晰地展示给开发人员。

至此, zipkin 的整体架构就介绍完了,下面我们来进行 zipkin 的环境搭建。

2.3 zipkin 环境搭建

采用 docker 搭建, 这里我们使用 docker 中的 docker-compose 来快速搭建 zipkin 环境。

docker-compose.yml 文件内容如下:

在上面文件所在的目录下执行 docker-compose up -d 即可完成本地搭建。

搭建完成后,在浏览器中打开地址 http://localhost:9411 ,会看到如下图所示页面:

接着打开地址 http://localhost:9200 ,会看到如下图所示页面:

至此, zipkin 的本地环境就搭建好啦。 下面我就将介绍 Node.js 应用如何对接 zipkin。

三、Node.js 接入 zipkin

3.1 搞定全链路信息获取

这个我在 《Node.js 应用全链路追踪技术——全链路信息获取》 文章中,已经详细阐述了,如何去获取全链路信息。

3.2 搞定传输层

因为 zipkin 是基于 OpenTracing 标准实现的。因此我们只要搞定了 zipkin 的传输层,也就搞定了其他主流分布式追踪系统。

这里我们用到了 zipkin 官方提供的两个 npm 包,分别是:

-

zipkin

-

zipkin-transport-http

zipkin 包是官方对支持 Node.js 的核心包。 zipkin-transport-http 包的作用是将数据通过 HTTP 异步发送到 zipkin 。

下面我们将详细介绍在传输层,如何将将数据发送到 zipkin 。

3.3 传输层基础封装

核心代码实现和相关注释如下:

至此,传输层的基础封装就完成了,我们抽离了 baseRecorder 出来,下面将会把全链路信息接入到传输层中。

3.4 接入全链路信息

这里说下官方提供的接入 SDK ,代码如下:

上面的方式缺点比较明显,需要额外去传递一些东西,这里我们使用上篇文章提到的 Zone-Context , 代码如下:

对比两者,明显发现, Zone-Context 的实现方式更加的隐式,对代码入侵更小。这也是单独花一篇文章介绍 Zone-Context 技术原理的价值体现。

自此,我们完成了传输层的适配, Node.js 应用接入 zipkin 的核心步骤基本完成。

3.5 搞定 zipkin 收集、存储、展示

这部分中的收集、展示功能, zipkin 官方自带完整实现,无需进行二次开发。存储这块,提供了 MySQL 、 Elasticsearch 等接入方式。可以根据实际情况去做相应的接入。本文采用 docker-compose 集成了 ElasticSearch 。

四、总结

自此,我们已经完成基于业界通用 OpenTracing 标准实现的 zipkin 的 Node.js 方案。希望大家看完这两篇文章,对 Node.js 全链路追踪,有一个整体而清晰的认识。

参考资料:

-

zipkin 官网

四是无 Sidecar 模式的服务网格可供选择。Istio 推出了 Ambient 部署模式,这是一种新的 Istio 数据平面模式,旨在简化操作、扩大应用兼容性并降低基础设施成本。用户可以选择将 Ambient Mesh 集成到其基础设施的网格数据平面,放弃 sidecar 代理,同时保持 Istio 的零信任安全、遥测和流量管理等核心功能。

五是 WebAssembly 崛起。WebAssembly 正在发展成为云原生环境中跨平台、多语言的沙箱环境,甚至可以替代容器运行时,在 Kubernetes 中编排调度。 WasmEdge、KubeEdge、Istio 等项目可以从控制平面无缝编排 Wasm 工作负载。

DPDK 全称为 Data Plane Development Kit ,是近年来在高速网络通信行业中炙手可热的一种网络报文处理加速框架。DPDK 从十年前诞生直至发展到今天已经可以支持业界主流的高端网卡以及各类加速硬件设备,同时也支持主流的各个CPU 体系结构(可以运行于 X86, Arm, Power 等平台)。同时也可以运行于 Linux/FreeBsd/Windows 等主流操作系统之上。DPDK因为其优异的性能指标被广泛的应用于网关/负载均衡/SDN/虚拟交换的各个场景。

本文主要介绍 DPDK 中的 libgraph 设计思想以及实现,libgraph 的设计思想源自于开源项目 Vector Packet Processor(VPP)。VPP 中的向量包处理优化方案是 libgraph 的参照对象。因为 VPP 项目整体是一个非常全面的解决方案,从中剥离核心的设计框架为其它轻量级项目所用就变得很有意义。这也是 Libgraph 的产生背景。虽然它目前还是DPDK 中相对比较新的 lib,但是其优秀的设计思想还是值得学习参考。

下面将首先介绍 libgraph 架构的核心概念:标量和向量包处理(scalar vs vector packet processing)以及它们之间的区别。然后再介绍 libgraph 中的核心组件,以及它们之间的联系和交互方式。最后,我们将介绍 libgraph 的具体用例以及优缺点。

背景

DPDK libgraph 是一个向量包处理的框架。与传统的标量包处理模型(一系列函数负责处理一个数据包,重复直到所有数据包处理完毕)相比,向量数据包处理模型的差别则在于一系列的函数处理一批数据包。这种方法的主要目的是解决当 pipeline 变复杂时所遇到 i-cache miss 较高的问题。

<p align=center>标量处理模型 vs 向量处理模型</p>

标量处理模型在性能上不如向量处理模型的另一个原因,就是在不同处理函数(业务逻辑)之间,报文传递到下一个处理函数的方式上有所不同。前者只是简单地用 pointer assignment 的方法来传递,若处理基于不同批次的情况下,由于低效的 pointer assignment,会导致处理一批报文时性能低下。

而对于向量包处理模型而言,向量包处理模型反而可以减少上述标量处理模型因批处理而导致性能不理想的情况。这是因为在向量模型中,报文在业务逻辑之间的传输除了可以通过最原始的 pointer assignment 之外,也可以通过优化的 memory copy,最优情况下可以仅仅交换pointer。它不仅消除了标量处理模型会遇到的问题,而且在设计 pipeline 时还可以实现更优的内存分配并与业务逻辑解耦。

图片來源:https://fd.io/gettingstarted/technology/

<p align=center>向量处理模型,graph 有 1 个起点(dpdk-input, n packets)以及 7 个业务逻辑</p>

Graph 框架优点

总体而言,与传统的标量处理模型相比,以下概括了 graph 框架主要的优势

- 更好的 i-cache 管理,更好的icache locality。

- 灵活的 pipeline 模型(pipeline 框架是从业务逻辑中抽象出来的)

- 减少 pointer 复制

- Node 可以累积多个先前 node 所传递的报文,因此批处理性能更好

- 表驱动节点调度(便于支持QoS)而不是 hardcode pipeline

Graph 工作流程

现在来说一下整体上 graph 框架的工作流程。如上图所述的一样,一个 graph 是由不同的节点 (node) 所组成的。与传统的标量模型相比,两个框架其实都包含一样的逻辑。最大的不同是 graph 框架中 node 节点在运行时与其他 node节点的交互方式,或者具体地来说,是报文在node节点中的传递方式。

一个 node 中的 报文 传送到不同的 node,home run 情况 (优化案例) 以及正常 enqueue情况;动态增加 node 的 objects 队列 大小

Node 的 Object 队列大小

默认情况下,每个 node 都有一个 RTE_GRAPH_BURST_SIZE 大小(node->size)的 object 队列,它定义了该 node 中可以容纳和处理的报文数量。如果一个 node 试图将报文排队到下一个 node,但下一个 node 已经有报文在排队并且已满(例如在 l3fwd 中,用户可以有多个接收队列/ node 排队到同一个下一个 node pkt_cls),node 的 object 队列大小将会被动态的加倍。这意味着 node 具有批处理的优势,因为它可以累积报文。

注意:当前 API 不支持 node 的 object 队列大小在增大后再缩小

Objs 的传递 — ‘home run’/normal enqueue

报文转换有两种类型,一种是正常的 enqueue,另一种是优化情况,“home run”。

Normal enqueue

在上面介绍 node 的 object 队列大小部分,我们提到将报文排队到下一个 node 的概念。对于普通的 enqueue,就是简单的将当前 node 中处理好的报文,通过使用 rte_memcpy / pointer assignment 作为传递方法, enqueue 到下一个可能的 node。

Home run

Home run 则是一种优化的情况,它不像普通的 enqueue 把报文复制到下一个 node,而是简单地交换当前 node 和下一个 node 之间的有关于报文的指针(例如报文、报文数目),从而消除 memory copy / pointer assignment 的开销。当满足以下条件时,home run 才会被触发:

- 所有已处理好的报文都将前往同一个 node

- 下一个 node 的 object 队列没有任何需要处理的报文 (node 的 object 队列为空)

Graph 遍历 node的流程

注意:rte_graph_walk 调用 struct rte_graph 的内存布局以及 circular buffer (cir_start) 可以参考后面组件的介绍

graph walk 的概念简单明了,它总是有次序地去完成一系列操作:

- 21行:定位下一个需要处理的 node

- 23行:准备下一个需要处理的 node 的 objects /报文

- 29行:处理定位好的 node

- 32行:检查 graph walk 是否完成

在 graph walk 层面来看,最重要的就是第一步:定位下一个要处理的 node。DPDK 的 graph 框架利用了 circular buffer 和附带的 head 和 tail 指针定位下一个 node,如果 head 不等于 tail 指针,这就代表了 circular buffer 里有需要处理的 node,而在 libgraph 库中,这些待处理的 node 也被称为 pending stream。

回到第一步,它是以一个 circular buffer (cir_start[head++]) 的 head 来定位,或者更详细地从 graph walk 的始点说起,由于 graph->head 在初始化的时候被指定为 -src_node_count (负的 source node 数量,可以参考下一部分 rte_graph 的内存布局),所以 cir_start[head] 其实就是第一个 source node。那么 tail 的作用是什么?libgraph 是如何利用它来动态修改 circular buffer 和 pending stream 帮助 node 的定位呢?

在回答这些问题之前,我们首先来了解下面两个 API 函数,分别是 和 。

每次当前 node 需要将报文 enqueue 到任何下一个 node 时,都需要调用 去检查以下内容:

- 下一个 node 是否已被添加到 pending stream (待处理的 node)

- 是否需要为下一个 node 分配内存

其中变量 idx 和 space 分别表示下一个 node 已有的报文数目,以及当前 node 想要enqueue的数目。

而API 函数 目的就是调整 tail 把下一个 node 放到 pending stream 里。

下图展示了报文的传递跟 node 是如何被加到 pending stream 的关系。

注意一下 node 添加到 pending stream 的顺序取决于处理报文时的顺序。例如,如果报文 1 和 3 到 node2,而 报文 2 和 4 到 node3,那么 circular buffer/pending stream 中 node1 和 node2 的顺序将被交换。

组件

libgraph 的核心组件是 graph 和 node。graph 作为调度 node 的全局数据结构,而 node 则是用来封装业务逻辑。

Graph

<p align=center>3 个node; 1 个 source node (源节点)和 2 个 node (非源节点)的 graph 结构</p>

上图显示了具有 3 个节点的 graph 结构,包含以下关键组件:

graph_list

存储所有创建成功的 graph。如果 graph 创建成功,graph 会被添加到 graph_list 中。与传统的 main loop 设计相比(把函数直接挂载到 CPU 核上),用户可以透过这种管理模式把 graph_list 中的 graph 映射到不同的 CPU 核上。

graph->node_list

每个创建成功的 graph 中的 node_list 都包含了先前添加到 graph 中的 node。注意此处使用的是 graph_node 结构,其中包含了本身的 node(struct node* node)以及其相邻的 node。

struct graph_node vs struct node

struct node 结构体的用法仅仅是用来描述对应的 node,和 graph 是没有关系的。而 struct graph_node 其实就是把 struct node 包装了一层,主要目的就是强调这个 node 在一个 graph 中。

struct rte_graph

接下来介绍 struct rte_graph(rte_*: runtime 时所用到的数据结构)的内存布局,建议先把先前的 graph walk 部分浏览一遍,以更好了解 rte_graph 是如何被使用。

<p align=center>rte_graph 内存布局。 注意此例除有 3 个 source node,而待处理的流 (pending stream)中有 2 个节点。</p>

现在可以更清楚地看到 struct graph 及其子组件 struct node 的目的是保存内部数据/用于设计,而 struct rte_graph 和 struct rte_node 是用于 runtime。runtime 的内存布局包含了所有必需的组件,比如所有source node、non-source nodes 以及 pending steam 的 node(从cir_start 开始)。

先前我们提到在 graph walk 时需要从 source node 开始,以及需要利用 circular buffer 来定位待处理的node。现在透过分析内存布局的帮助下,我们能更好地去想象 graph walk 是如何从 cir_start[-src_node_count] 开始,直到再没有任何 pending stream (head 等于 tail)为止。

struct node

理解了 graph 的运作原理后,我们现在讨论一下底层的关键组件 node。先前我们已经提到 graph_node 和 node 的部分区别,其实关键区别在于 node 实际包含了什么信息。

<p align=center>Struct node 结构体 (lib/graph/graph_private.c)</p>

向量包处理的概念是一次处理一个向量/一批报文,所以一个节点其实就是代表一个function,只不过处理对象是一批报文。

一个节点除了包含相邻 node 的信息外,还包含有助于识别 node 的基本信息,例如 id、parent_id、flags、name 等。最重要的是,除了核心处理函数 rte_node_process_t process 以外,它还包含了在创建、销毁 graph 时运行的 init 和 fini 函数。 init 函数的一些实际可以是配置路由表、定义 ACL 规则等。

Node 的注册

node 的注册是通过 contructor scheme 的 (attribute((constructor)))来完成的。下面显示了一个非常简单的 node 注册示例。需要强调的是: .process 的函数定义突出了向量数据包处理的概念 (需要处理的报文 (objs) 及其数量 (nb_objs))。

构造一个 print Hello World 的 source node

source node vs non-source node

在任何处理模型都必须有一个起点,而在 libgraph 中每个 graph pipeline 都必须从 source node 开始。而对于非 source node 来说,它们则是依赖于先前 node 是否会将报文排队到它们的节点,因此它们只会出现在动态的 pending stream 中。

总结

本文介绍了 DPDK graph API 的框架以及它内部是如何实现的。 graph 框架的优势在于减少 i-cache miss 、更好的抽象业务逻辑,以及提高用户设计 pipeline 的灵活度,但 graph 框架也同时带来下列缺点:

- 引入潜在内存安全风险

- 复杂的代码逻辑,需要大量的测试工作

- 初学者学习曲线陡峭

总体而言,与传统的 pipeline 模式相比,graph 框架也会出现 tradeoff。使用者需要考虑其业务逻辑的复杂程度,才能有计划地设计出可管理的 graph pipeline。graph 模型更适用于 pipeline 比较复杂的场景。有兴趣的读者可以持续关注后期即将发布的《DPDK Graph Pipeline 框架示例和性能分析》,以更好地理解 DPDK libgraph 的性能和实际用途。

今天故事的主角还是大家熟识的二狗子。二狗子拿到了一笔项目奖金,在好好犒劳了自己一顿后,决定把剩下的钱在银行存个定期。

他用浏览器访问了 www.bank.com,输入了用户名和密码后,成功登录。

bank.com 返回了 cookie 用来标识二狗子这个用户。

不得不说,浏览器是个认真负责的工具,它会把这个 cookie 记录下来,以后二狗子每次向 bank.com 发起 HTTP 请求,浏览器都会准确无误地把 cookie 加入到 HTTP 请求头部中,一起发送到 bank.com,这样 bank.com 就知道二狗子已经登陆过了,就可以按照二狗子的请求来做事情,比如查看余额、转账取钱。

二狗子存完钱,看着账户余额,心中暗喜。于是,他打开了 www.meinv.com,去看自己喜欢的电影。

但二狗子不知道的是,浏览器把 meinv.com 的 HTML、JavaScript 都下载到本地,开始执行。而其中某个 JavaScript 中,偷偷创建了一个 XMLHttpRequest 对象,然后向 bank.com 发起了 HTTP 请求 。

浏览器严格按照规定,把之前存储的 cookie 也添加到 HTTP 请求中。但是 bank.com 根本不知道这个 HTTP 请求是 meinv.com 的 JavaScript 发出的,还以为是二狗子发出的。bank.com 检查了cookie,发现这是一个登录过的用户,于是兢兢业业地去执行请求命令,二狗子的个人信息就泄露了。(ps. 实际中实施这样一次攻击不会这么简单,银行网站肯定是做了其他很多安全校验的措施,本故事只是用来说明基本原理。)

可怜的二狗子还不知道发生了什么,已经遭受了钱财损失。那我们来帮他复盘一下为什么会发生这种情况。

首先,每当访问 bank.com 的时候,不管是人按钮访问链接,还是通过程序的方式,存储在浏览器的 bank.com 的 cookie 都会进行传递。

其次,从 meinv.com 下载的 JavaScript 利用 XMLHttp 访问了 bank.com。

第一点我们是无法阻止的,如果阻止了,cookie 就丧失了它的主要作用。

对于第二点,浏览器必须做出限制,不能让来自 meinv.com 的 JavaScript 去访问 bank.com。这个限制就是同源策略。

同源策略

浏览器提供了 fetch API 或 XMLHttpRequest 等方式,它们可以使我们方便快捷地向后端发起请求,取得资源,展示在前端上。而通过 fetch API 或 XMLHttpRequest 等方式发起的 HTTP 请求,就必须要遵守同源策略 。 那什么是同源策略呢?同源策略(same-origin policy)规定了当浏览器使用 JavaScript 发起 HTTP 请求时,如果是请求域名同源的情況下,请求不会受到限制。但如果是非同源的请求,则会强制遵守 CORS (Cross-Origin Resource Sharing,跨源资源共享) 的规范,否则浏览器就会将请求拦截。

那什么情况下是同源呢?同源策略非常严格,要求两个 URL 必须满足下面三个条件才算同源:

1、协议(http/https)相同;

2、域名(domain)相同;

3、端口(port)相同。

举个例子:下列哪些 URL 地址与 https://www.bank.com/withdraw.html 属于同源?

-

https://www.bank.com/save.html (✅)

-

http://www.bank.com/withdraw.html (❌,协议不同)

-

https://bank.com/login.html (❌,域名不同)

-

https://www.bank.com:8080/withdraw.html (❌,端口不同)

因此,当我们请求不同源的 URL 地址时,就会产生一个跨域 HTTP 请求(cross-origin http request)。

例如想要在 https://www.upyun.com 的页面上显示来自 https://opentalk.upyun.com 的资讯内容,我们使用浏览器提供的 fetch API 来发起一个请求:

这就产生了一个跨域请求,跨域请求则必须遵守 CORS 的规范。

当请求的服务器没有配置允许 CORS 访问或者不允许来源地址的话,请求就会失败,在 Chrome 的开发者工具台上就会看到以下的经典错误:

那在实际应用中,我们该如何正确地设定 CORS 呢?

什么是 CORS

CORS 是针对不同源(域)的请求而制定的规范。浏览器在请求不同域的资源时,被跨域请求的服务端必须明确地告知浏览器其允许何种请求。只有在服务器允许范围内的请求才能够被浏览器放行并请求,否则会被浏览器拦截,访问失败。

在 CORS 规范中,跨域请求主要分为两种:简单请求(simple request)和非简单请求(not-so-simple request)。

简单请求

简单请求必须符合以下四个条件,实际开发中我们一般只关注前面两个条件:

(1)使用 GET、POST、HEAD 其中一种方法;

(2)只使用了如下的安全请求头部,不得人为设置其他请求头部:

-

Accept

-

Accept-Language

-

Content-Language

Content-Type 仅限以下三种:

-

text/plain

-

multipart/form-data

-

application/x-www-form-urlencoded

(3)请求中的任意 XMLHttpRequestUpload 对象均没有注册任何事件监听器,XMLHttpRequestUpload 对象可以使用 XMLHttpRequest.upload 属性访问;

(4)请求中没有使用 ReadableStream 对象。

不符合以上任一条件的请求就是非简单请求。浏览器对于简单请求和非简单请求,处理的方式也不一样。

对于简单请求,浏览器会直接发出 CORS 请求。具体来说,就是在请求头信息中,自动地增加一个Origin (来源)字段。

Origin 的值中,包含请求协议、域名和端口三个部分,用于说明本次请求来自哪个源。服务器可以根据这个值,决定是否同意这次请求。例如下面的请求头报文:

如果 Origin 指定的源不在服务器允许范围内,服务器会返回响应一个正常的 HTTP,浏览器发现回应头部中,如果没有包含 Access-Control-Allow-Origin 字段,就会抛出错误。需要注意的是,这种错误无法通过状态码识别,HTTP 响应的状态码有可能是 200。

如果 Origin 指定的源在允许范围内的话,响应头部中,就会有以下几个字段:

大家可能也看出来了一个特点,与 CORS 请求相关的字段,都以 Access-Control- 开头。

如果跨域请求是被允许的,那么响应头部中是必须有 Access-Control-Allow-Origin 头部的。它的值要么是请求时 Origin 字段的值,要么是一个 *,表示接受任意域名的请求。

Access-Control-Allow-Credentials 是一个可选字段,它的值是一个布尔值,表示是否允许发送Cookie。如果发起跨域请求时,设置了 withCredentials 标志为 true,浏览器在发起跨域请求时,也会同时向服务器发送 cookie。如果服务器端的响应中不存在 Access-Control-Allow-Credentials 头部,浏览器就不会响应内容。

特别需要说明的是,如果请求端设置了 withCredentials ,Access-Control-Allow-Origin 的值就必须是具体的域名值,而不能设置为 *,否则浏览器也会抛出跨域错误。

Access-Control-Expose-Headers 也是一个可选头部。当进行跨域请求时,XMLHttpRequest 对象的 getResponseHeader()方法只能拿到 6 个基本响应字段:

-

Cache-Control

-

Content-Language

-

Content-Type

-

Expires

-

Last-Modified

-

Pragma

而如果开发者需要获取其他响应头部字段,或者一些自定义响应头部,服务器就可以通过设置 Access-Control-Expose-Headers 头部来指定发起端可访问的响应头部。

非简单请求

非简单请求往往是对服务器有特殊要求的请求,比如请求方法为 PUT 或 DELETE,或者 Content-Type 字段类型是 application/json。

对于非简单请求的 CORS 请求,浏览器会在正式发起跨域请求之前,增加一次 HTTP 查询请求,我们称为预检请求(preflight)。浏览器会先询问服务器,当前的域名是否在服务器的许可名单之中,以及可以使用哪些 HTTP 请求方法和请求头部字段。只有得到肯定答复,浏览器才会发出正式的跨域请求,否则就会报错。

比方说我们使用代码发起一个跨域请求:

浏览器会发现这是一个非简单请求,它会自动发送一个 OPTIONS 的预检请求,其中核心内容有两部分,Access-Control-Request-Method 表示后面的跨域请求需要用到的方法,Access-Control-Request-Headers 表示后面的跨域请求头内会有该内容。

服务器收到预检请求后,检查这些特殊的请求方法和头自己能否接受,如果接受,会在响应头部中包含如下信息:

上面的 HTTP 响应中,关键的是 Access-Control-Allow-Origin 字段,* 表示同意任意跨源请求都可以请求数据。部分字段我们在简单请求中解释过了,这里挑几个需要注意的头部解释一下。

-

Access-Control-Allow-Methods,这是个不可缺少的字段,它的值是逗号分隔的一个字符串,表明服务器支持的所有跨域请求的方法。

-

Access-Control-Allow-Headers 字段为一个逗号分隔的字符串,表明服务器支持的所有请求头部信息字段,不限于浏览器在预检中请求的字段。

-

Access-Control-Max-Age:该字段可选,用来指定本次预检请求的有效期,单位为秒。上面结果中,有效期是 1 天(86400 秒),在此期间,不用再发出另一条预检请求。

又拍云 CORS 配置

以上就是对 CORS 的一个简单介绍。如果您使用了又拍云的 CDN 或者云存储服务, 在访问中遇到跨域问题,是可以非常快速便捷的进行 CORS 配置的。

登陆服务控制台,依次进入:服务管理 > 功能配置 > 访问控制 > CORS 跨域共享,【管理】按钮即可开始配置。如下图所示:

相信您看完本篇文章,对配置界面的各个字段都不再陌生啦。

推荐阅读

网络安全(一):常见的网络威胁及防范

【白话科普】从“熊猫烧香”聊聊计算机病毒

最后,Linux 基金会具备成熟的社区治理和社区运营经验,这将帮助 PyTorch 得到更广泛的应用和更好的发展。

PyTorch 基金会的成立,将给 PyTorch 带来更广泛的影响力和更广阔的想象空间,甚至有望成为类似 K8S 一样的工业界默认标准。随之而来的是,国内的几大机器学习框架的生存空间受到更大的挤压,迎来了更大的挑战。是不是可以采取一些类似的竞和手段来避免重复投入? 这也是我作为国内 AI 从事者希望看到的。

谭中意第四范式架构师,LF AI & Data TAC 成员,PaddlePaddle 首部官方中文书作者,星策社区发起人。

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。

持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

转载内容版权归作者及来源网站所有,本站原创内容转载请注明来源。

介绍

dbVisitor 是一个全功能数据库访问 ORM 工具,提供对象映射、丰富的类型处理、动态 SQL、存储过程、 内置分页方言 20+、 支持嵌套事务、多数据源、条件构造器、INSERT 策略、多语句 / 多结果。并兼容 Spring 及 MyBatis 用法。 它不依赖任何其它框架,因此可以很方便的和任意一个框架整合在一起使用。

依赖

修复

- 修复 Mapper模式下,未指定 namespace 时,space 为 null,导致Map.containsKey 空指针异常。

- 指定 namespace 时,在执行时 dynamicId 截取错误。

感谢 tomato0228 的贡献。

相关链接

官方网站:https://www.dbvisitor.net/

源码地址:https://gitee.com/zycgit/dbvisitor

Spring Boot 整合手册,https://www.dbvisitor.net/docs/integration/with-springboot

快速上手:https://www.dbvisitor.net/docs/guides/quickstart

2023年1月26日,Apache 软件基金会(ASF)官方宣布 Apache bRPC 正式毕业,成为 Apache 顶级项目(TLP)。

以上截图来自Apache官网

Apache官网原文链接:https://news.apache.org/foundation/entry/the-apache-software-foundation-announces-new-top-level-project-apache-brpc

Apache bRPC是由百度初始创立并持续贡献的工业级别RPC开源项目,在2018年正式贡献给 Apache 软件基金会进行项目孵化,2022年12月24日经过 Apache 董事会集体投票表决,Apache bRPC 项目顺利毕业,成为 Apache 软件基金会顶级项目(TLP),这是百度继 ECharts 和 Doris 之后,又一里程碑式的开源项目,也是百度长期坚持和践行开源理念的重要里程碑。

关于 Apache bRPC

bRPC于2014年诞生于百度基础架构部,用C++编写的工业级RPC框架,常用于搜索、存储、机器学习、广告、推荐等高性能系统。2017年正式在 GitHub 进行开源,并于2018年11月正式捐献给全球顶级开源社区 Apache 软件基金会(ASF),对外开源版本的名称为 Apache bRPC,成为 ASF 孵化级项目。

一路走来,bRPC以功能全、可扩展、高性能等特性得到越来越多用户的认可和使用,经过四年多的孵化,bRPC开发者数量增长数倍、在GitHub上的Star数也超过14.4K,目前已覆盖了互联网、人工智能、搜索、推荐、电商和教育等多个行业和领域,被百度、爱奇艺、作业帮、字节跳动、京东、拼多多、滴滴、B站、vivo、小红书、第四范式、欢聚时代、shopee等公司广泛使用并对该项目进行持续贡献,线上服务实例数已超过600W,现已成为业界广受欢迎的开源RPC框架之一。

Apache bRPC 成长史

-

2014年,baidu-rpc在百度基础架构部诞生

-

2016年,baidu-rpc在百度得到大规模落地和实践

-

2017年,bRPC在GitHub上正式开源

-

2018年,百度将 bRPC 捐献给 Apache 软件基金会并命名为 Apache bRPC,进入孵化器

-

2021年,bRPC社区发布第一个正式版本 1.0.0

-

2022年,正式完成商标捐赠,推动 Apache bRPC 完成毕业,成为 Apache 软件基金会顶级项目(TLP)

截至2023年1月,Apache bRPC 已在GitHub上获得14.4K Stars ,拥有超过130名贡献者,成为国内最活跃的开源社区之一,并于2022年12月获得《2022 中国开源项目社区健康案例》奖项。

以上截图来自开源中国官网

毕业寄语(按姓氏首字母排序)

在这个激动人心的时刻我们也收到了各界人士发来的美好寄语: